基于跨視圖原型非對比學習的異構圖嵌入模型

摘 要:

基于非對比學習(NCL)的異構圖嵌入模型不依賴負樣本學習數(shù)據(jù)的內在特征和模式,可能導致模型無法有效地學習節(jié)點之間的區(qū)分度。提出了一種基于跨視圖原型非對比學習的異構圖嵌入模型(XP-NCL),通過尋找額外的正樣本提供更多關于源節(jié)點的上下文信息,并重新考慮了正樣本之間的相似性,從而為下游任務學習更高效的節(jié)點表征。該模型首先設計了一種基于異構圖隨機游走的樹型結構,通過篩選出滿足局部結構約束的隨機游走路徑,從而構建正樣本的有向篩選樹(DFT),該樹包含豐富的鄰居信息和語義信息;其次針對異構圖的特性,定義了跨視圖原型指數(shù)(ISDR)和峰值算子(peak operator),從多個維度考慮了同類樣本在數(shù)量和數(shù)值上的對齊;在此基礎上,模型利用停止梯度更新進行訓練。最后,在ACM、DBLP和freebase數(shù)據(jù)集上,實驗驗證了節(jié)點的分類和聚類性能,結果表明,即使不使用負樣本,XP-NCL表征與其他同構圖和異構圖基線相比,很多情況下都可以呈現(xiàn)出更優(yōu)越的性能。

關鍵詞:異構圖嵌入;非對比學習;有向篩選樹正樣本采樣;交對稱差比;峰值算子

中圖分類號:TP181 文獻標志碼:A 文章編號:1001-3695(2024)09-007-2611-09

doi:10.19734/j.issn.1001-3695.2024.01.0016

Heterogeneous graph embedding based on cross-view prototype non-contrastive learning

Zhang Min, Yang Yuqing, He Yanting, Shi Chenhui

(School of Computer Science & Technology, Taiyuan University of Science & Technology, Taiyuan 030024, China)

Abstract:

Heterogeneous graph embedding models based on non-contrastive learning (NCL) do not rely on negative sampling to learn the intrinsic features and patterns, which may cause the model fail to efficiently learn the differences between vertexes. This paper proposed a heterogeneous graph embedding model based on cross-view prototype non-contrastive learning (XP-NCL), which learnt better node representations for downstream tasks by finding additional positive samples with more contextual information, and reconsidered the similarity between positive samples. The model firstly designed a tree structure based on random walks in heterogeneous graph. This directed filtering tree (DFT) about positive samples contained rich neighboring and semantic information by filtering out random walk paths that satisfied local structural constraints. Secondly, to achieve the alignment of similar samples in terms of numerical and quantitative from multiple dimensions, XP-NCL defined the cross-view prototype index (ISDR) and peak operator based on the characteristics of heterogeneous graphs. Furthermore, the model trained using stop-gradient updating. Finally, experiments verify the classification and clustering performance of the node on ACM, DBLP and freebase datasets, and the results show that even without the negative samples, the XP-NCL representation can achieve superior performance in many cases compared to other homogeneous and heterogeneous graph baselines.

Key words:heterogeneous graph embedding; non-contrastive learning; directed filtering tree positive sampling; intersection to symmetric difference ratio; peak operator

0 引言

非對比學習通常使用一些技術來實現(xiàn)下游任務的良好表示,如梯度更新策略[1,2]和額外的預測操作[3~5]等。與對比學習(CL)相比,非對比學習不依賴負樣本對,這使得它們在許多情況下更容易實現(xiàn),訓練過程也更加簡單和直觀。例如,當沒有明確的負樣本定義時,非對比學習可能更適用。另一方面,選擇高質量的負樣本是一個挑戰(zhàn),負樣本應該與正樣本在語義上不相關,但在實踐中,確定哪些樣本不相關常常是困難的,不恰當選擇的負樣本可能導致模型的性能下降。如果負樣本的數(shù)量遠遠大于正樣本,模型可能會過度關注于負樣本,而忽略了正樣本的精確識別,且非對比學習通常具有更強的泛化能力。由于非對比學習不依賴于對比學習樣本,在許多應用場景中能夠更好地適應不同分布的數(shù)據(jù)集。特別是在包含復雜的多類型節(jié)點和關系的異構圖(如真實的生物網(wǎng)絡、社交網(wǎng)絡和引文網(wǎng)絡)中,其中的正樣本通常是具有相似語義或相關性的節(jié)點對,而負樣本則是隨機采樣的,與正樣本之間可能存在較大的語義鴻溝,這種語義鴻溝可能會影響模型的學習效果。因此,在本文中,利用非對比學習對異構圖進行表示。有關異構圖表示學習的相關技術及應用,可以參考文獻[6~9]。

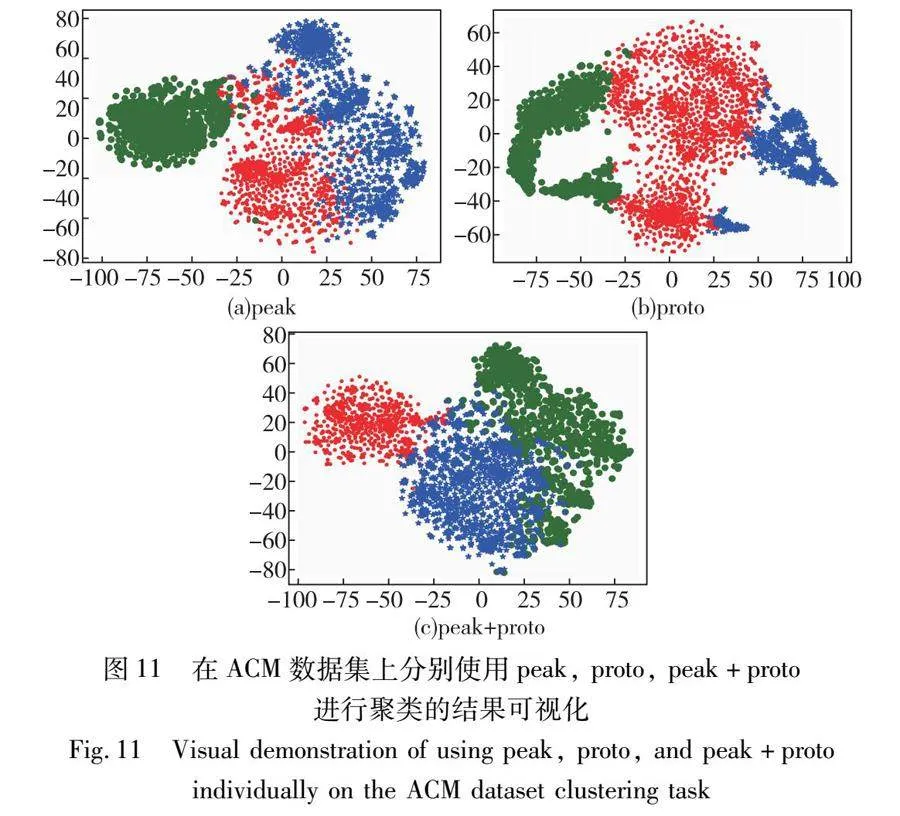

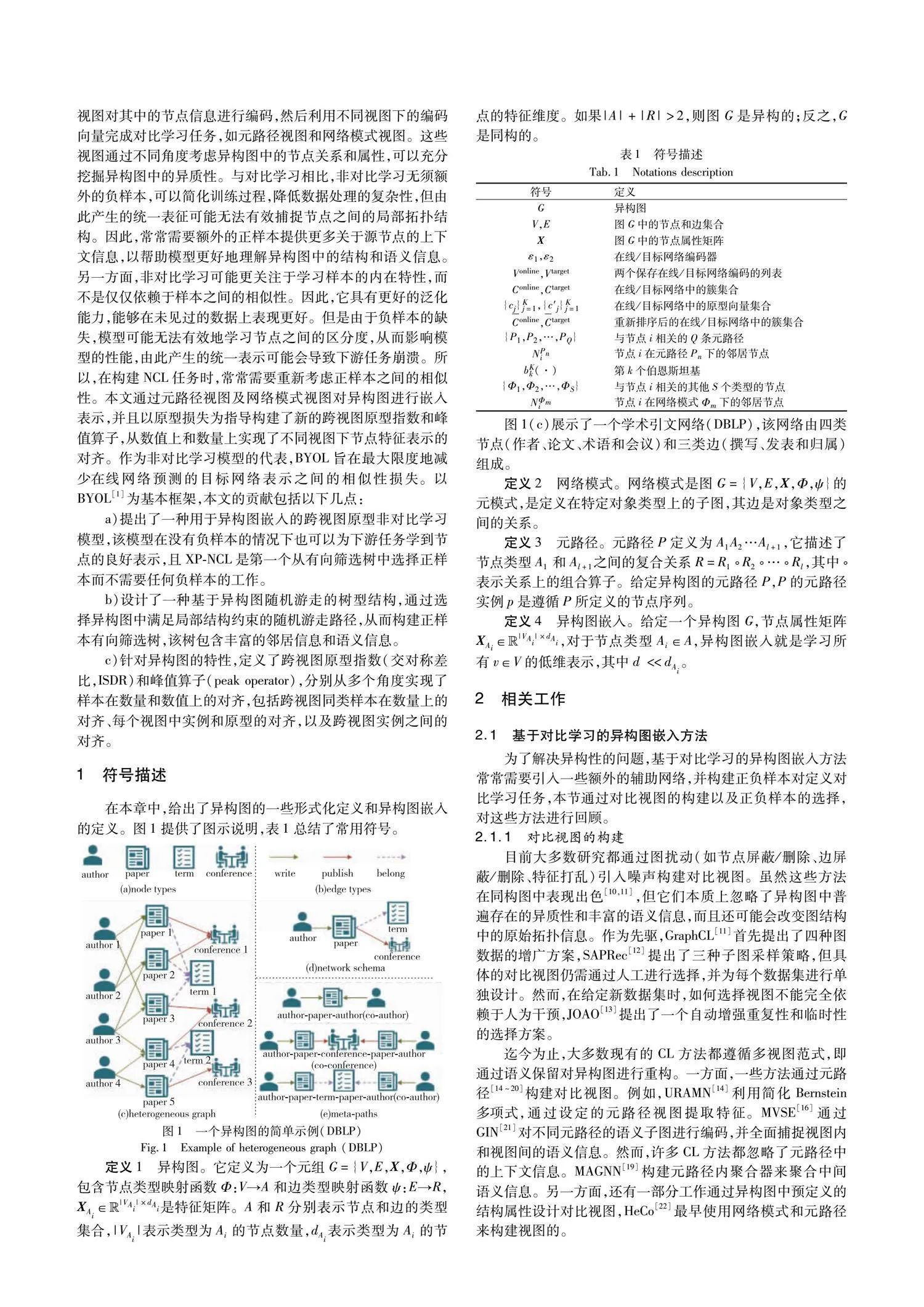

然而,目前基于NCL的異構圖嵌入模型仍處于早期階段,存在一些局限性。特別是,異構圖中不同類型和數(shù)量的節(jié)點和邊表示了各種各樣的關系,這種復雜性使得對其進行統(tǒng)一的表示變得困難。在異構圖非對比學習任務中,常常通過構建多個視圖對其中的節(jié)點信息進行編碼,然后利用不同視圖下的編碼向量完成對比學習任務,如元路徑視圖和網(wǎng)絡模式視圖。這些視圖通過不同角度考慮異構圖中的節(jié)點關系和屬性,可以充分挖掘異構圖中的異質性。與對比學習相比,非對比學習無須額外的負樣本,可以簡化訓練過程,降低數(shù)據(jù)處理的復雜性,但由此產(chǎn)生的統(tǒng)一表征可能無法有效捕捉節(jié)點之間的局部拓撲結構。因此,常常需要額外的正樣本提供更多關于源節(jié)點的上下文信息,以幫助模型更好地理解異構圖中的結構和語義信息。另一方面,非對比學習可能更關注于學習樣本的內在特性,而不是僅僅依賴于樣本之間的相似性。因此,它具有更好的泛化能力,能夠在未見過的數(shù)據(jù)上表現(xiàn)更好。但是由于負樣本的缺失,模型可能無法有效地學習節(jié)點之間的區(qū)分度,從而影響模型的性能,由此產(chǎn)生的統(tǒng)一表示可能會導致下游任務崩潰。因此,在構建NCL任務時,常常需要重新考慮正樣本之間的相似性。本文通過元路徑視圖及網(wǎng)絡模式視圖對異構圖進行嵌入表示,并且以原型損失為指導,構建了新的跨視圖原型指數(shù)和峰值算子,從數(shù)值上和數(shù)量上實現(xiàn)了不同視圖下節(jié)點特征表示的對齊。作為非對比學習模型的代表作,BYOL旨在最大限度地減少在線網(wǎng)絡預測的目標網(wǎng)絡表示之間的相似性損失。以BYOL[1]為基本框架,本文的貢獻包括以下幾點:

a)提出了一種用于異構圖嵌入的跨視圖原型非對比學習模型,該模型在沒有負樣本的情況下,也可以為下游任務學到節(jié)點的良好表示,且XP-NCL是第一個從有向篩選樹中選擇正樣本而不需要任何負樣本的工作。

b)設計了一種基于異構圖隨機游走的樹型結構,通過選擇異構圖中滿足局部結構約束的隨機游走路徑,從而構建正樣本有向篩選樹,該樹包含豐富的鄰居信息和語義信息。

c)針對異構圖的特性,定義了跨視圖原型指數(shù)(交對稱差比,ISDR)和峰值算子(peak operator),分別從多個角度實現(xiàn)了樣本在數(shù)量和數(shù)值上的對齊,包括跨視圖同類樣本在數(shù)量上的對齊,每個視圖中實例和原型的對齊,以及跨視圖實例之間的對齊。

1 符號描述

在本章中,給出了異構圖的一些形式化定義和異構圖嵌入的定義。圖1提供了圖示說明,表1總結了常用符號。

4 實驗

在本章中,將通過實驗來證明XP-NCL在異構圖嵌入方面的作用。實驗旨在回答以下幾個問題:

Q1:XP-NCL在節(jié)點分類方面表現(xiàn)如何?

Q2:XP-NCL在節(jié)點聚類方面表現(xiàn)如何?

Q3:上述各部分損失的影響是什么?

Q4:不同動態(tài)加權方式對下游任務的影響如何?

4.1 數(shù)據(jù)描述

實驗使用了三種常見的異構圖,以評估XP-NCL與其他基線相比的性能。具體來說,使用ACM、DBLP和freebase數(shù)據(jù)集進行節(jié)點分類和聚類測試,表3提供了這些數(shù)據(jù)集的簡單統(tǒng)計信息。

a)ACM:該數(shù)據(jù)集提取了發(fā)表在KDD、SIGMOD、SIGCOMM、MobiCOMM和VLDB上的論文,并將論文分為三類(數(shù)據(jù)庫、無線通信和數(shù)據(jù)挖掘)。每篇論文都有與之相關的作者和術語,這些關系由元路徑集{PAP, PSP}表示。

b)DBLP:這是一個計算機科學書目網(wǎng)站。采用的是文獻[22]提取的DBLP子集。最終的任務是將作者分為數(shù)據(jù)庫、數(shù)據(jù)挖掘、人工智能和信息檢索四個研究領域。

c)freebase:該數(shù)據(jù)集的目標節(jié)點是電影,并將其分為三類。采用了文獻[37]中的一個子集。在實驗中,考慮了元路徑{MAM、MDM、MWM}。

4.2 對比算法

將XP-NCL與不同類型的圖嵌入模型(包括無監(jiān)督同構圖和異構圖嵌入模型)進行了比較。

a)無監(jiān)督同構圖嵌入方法:DGI[5]最大化節(jié)點局部表示和全局表示之間的互信息來學習節(jié)點的表示。GraphCL[11]提出了一種圖對比學習框架,用于學習圖數(shù)據(jù)的無監(jiān)督表示。

b)無監(jiān)督異構圖嵌入方法:HERec[38]基于元路徑的隨機游走策略來學習節(jié)點表示。MetaGraph2Vec[39]使用元圖進行隨機游走的生成,并學習多類型異構圖節(jié)點的潛在表示。DMGI[23]引入了正則化框架,以最小化特定關系類型節(jié)點嵌入之間的不一致性。HeCo[22]首次使用網(wǎng)絡模式和元路徑來構建對比視圖。

c)對比實驗設置:對于同構圖嵌入方法{DGI、GraphCL},測試了它們的所有元路徑,并報告了最佳性能。在DGI和DMGI中,將epoch設為1 000,學習率設為0.000 5。其他參數(shù)保持默認值。在GraphCL和HeCo中,設置提前停止的patience為20。在MetaGraph2Vec中,設置每個節(jié)點的游走次數(shù)為10,每次隨機游走的長度為100。對于所有基線,在模型運行結束后都會保留其嵌入結果,并使用相同的分類和聚類方法對其進行驗證。

4.3 實驗設計

至于本文提出的模型,實驗是在Python 3.7環(huán)境下使用PyTorch 1.10.2實現(xiàn)的。所有實驗均在配備80 GB顯存的NVIDIA A800 GPU上進行。實驗采用Adam優(yōu)化器訓練模型,并從{8E-4, 9E-4, 1E-3, 1E-2}中微調學習率。在線網(wǎng)絡和目標網(wǎng)絡中的投影頭和預測頭的參數(shù)設計:在線網(wǎng)絡中,同時包含投影頭和預測頭,投影頭為兩層全連接網(wǎng)絡,其輸入維度、中間層維度、輸出維度分別為64、384、64;預測頭為兩層全連接層,其輸入維度、中間層維度、輸出維度分別為64、128、64;在目標網(wǎng)絡中,僅包含投影頭,其輸入維度、中間層維度、輸出維度分別為64、384、64。起初,鄰近樣本的數(shù)量通過HeCo選擇,并對其進行了微調。對于正樣本屏蔽,從{0.1, 0.2, 0.3}中選擇比例。為進行公平比較,將嵌入維度設為64,并隨機運行10次實驗。在測試分類任務模塊時,學習率設定為0.01;在測試聚類任務時,應用K-means,最大迭代次數(shù)設為500。

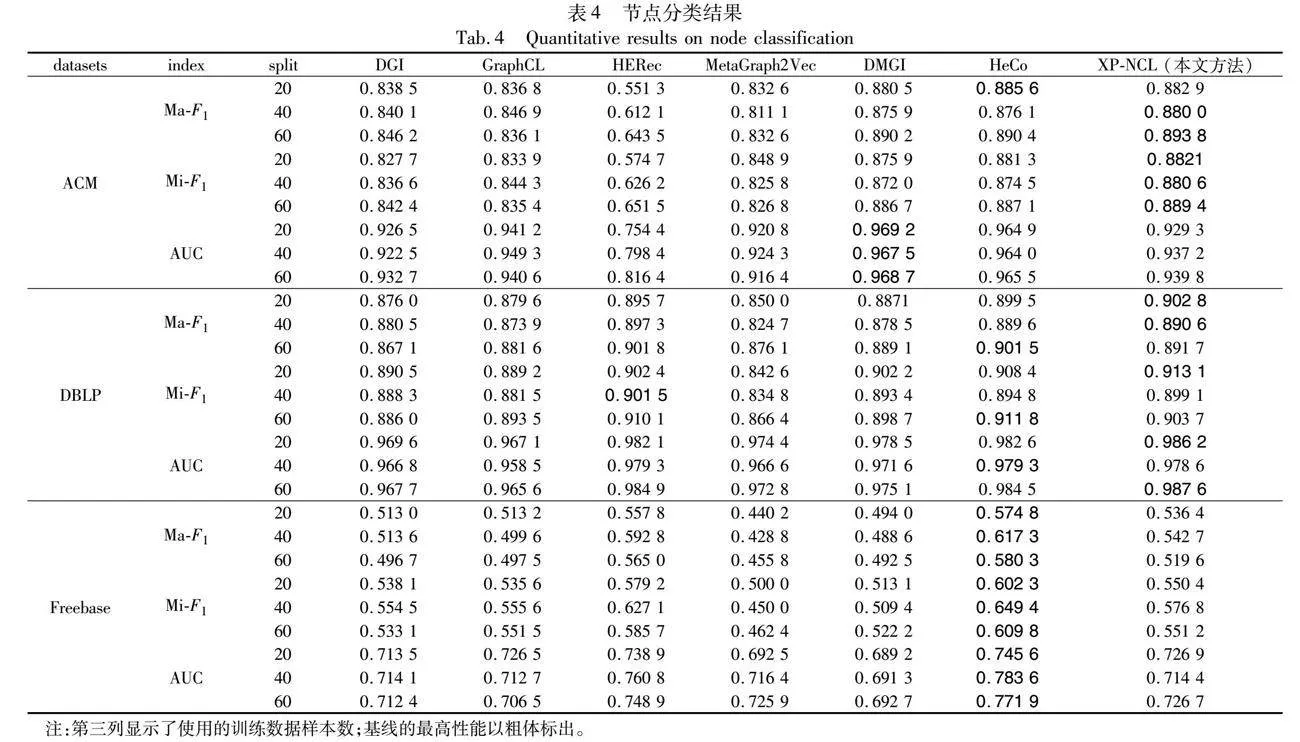

4.4 分類結果

使用學習到的表示來訓練線性分類器,在每個數(shù)據(jù)集中,隨機選擇每類20、40、60個標記節(jié)點作為訓練集,1 000個節(jié)點作為驗證集,1 000個節(jié)點作為測試集,并使用macro-F1、micro-F1和AUC作為評估指標。表4列出了所有結果,這些結果都是在α=cos(θ/2)-θ/2-1/2取得的。從表4中可以看出,XP-NCL在很多情況下都取得了最佳性能。通過對結果的分析,得出以下結論:

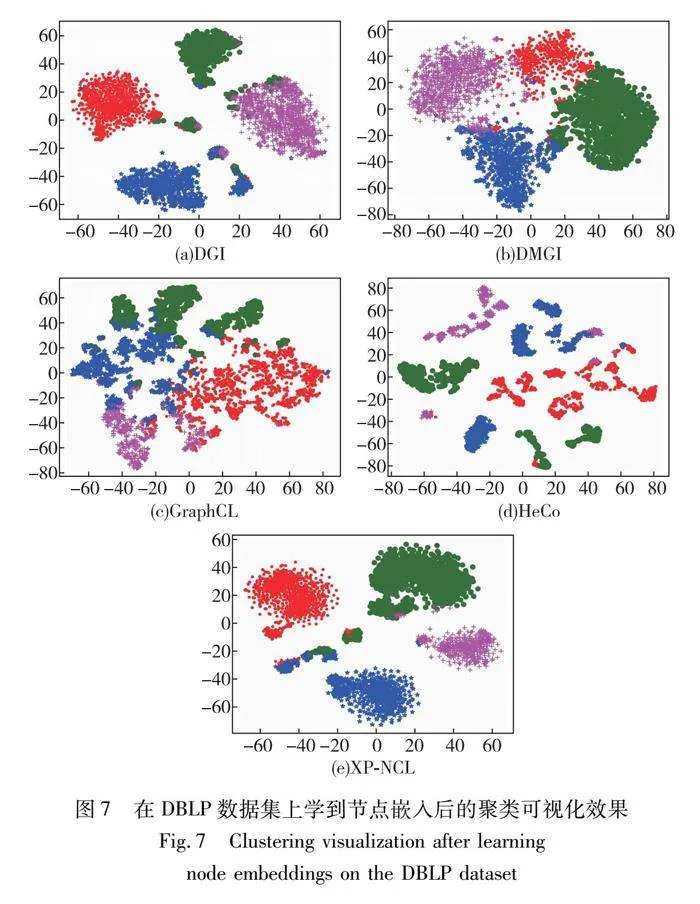

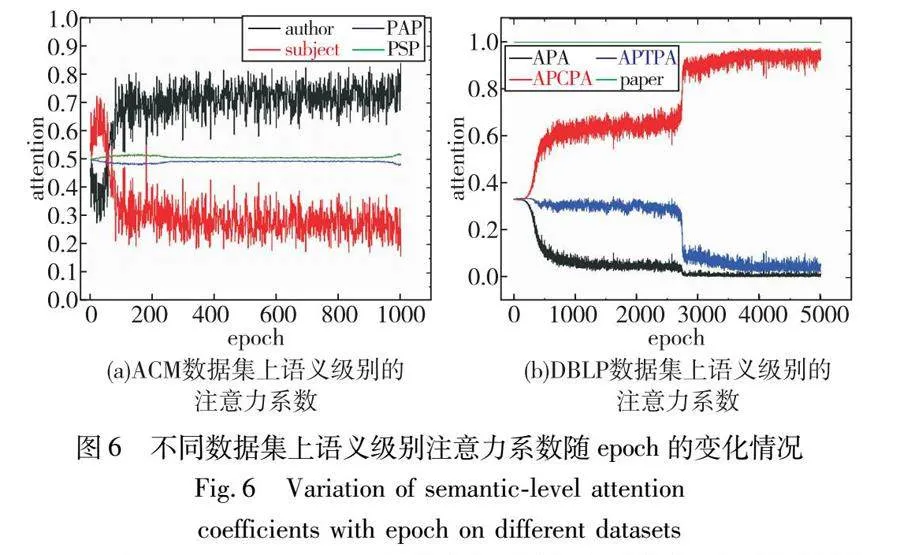

a)在所有基線中,異構圖表示方法的整體結果要比同構圖更好一些,這表明充分挖掘異構圖中的豐富語義信息是十分必要的。如圖6所示,對在線網(wǎng)絡和目標網(wǎng)絡在模型訓練過程中的語義級注意力系數(shù)進行了可視化。在ACM數(shù)據(jù)集中,每個論文節(jié)點有一個主題和多個作者鄰居,因此隨著模型的訓練,作者類節(jié)點的注意力系數(shù)越來越大。與節(jié)點級語義信息相比,基于元路徑的語義信息的注意力系數(shù)變化較小。這說明在模型訓練的初始階段,元路徑通常包含更豐富的語義信息。在DBLP數(shù)據(jù)集中,作者只與論文有邊連接,因此關于論文的節(jié)點級注意力系數(shù)總是1。隨著模型的訓練,元路徑APCPA的權重越來越大,這是因為大部分會議中本身就包含了術語的信息。

b)從AUC指標來看,在ACM數(shù)據(jù)集中,XP-NCL的結果比其他算法要差一些,但在BDLP數(shù)據(jù)集中卻取得了最好的結果。這一現(xiàn)象可能與數(shù)據(jù)集中樣本類別的數(shù)量分布有關系,在ACM數(shù)據(jù)集中,最多的一類節(jié)點數(shù)量是最少一類節(jié)點數(shù)量的二倍。

c)與HeCo相比,本文的方法在很多情況下取得了更好的結果。這表明,即使沒有負樣本,XP-NCL仍然有效,也就是說,負樣本在對比學習框架中并不是必需的。

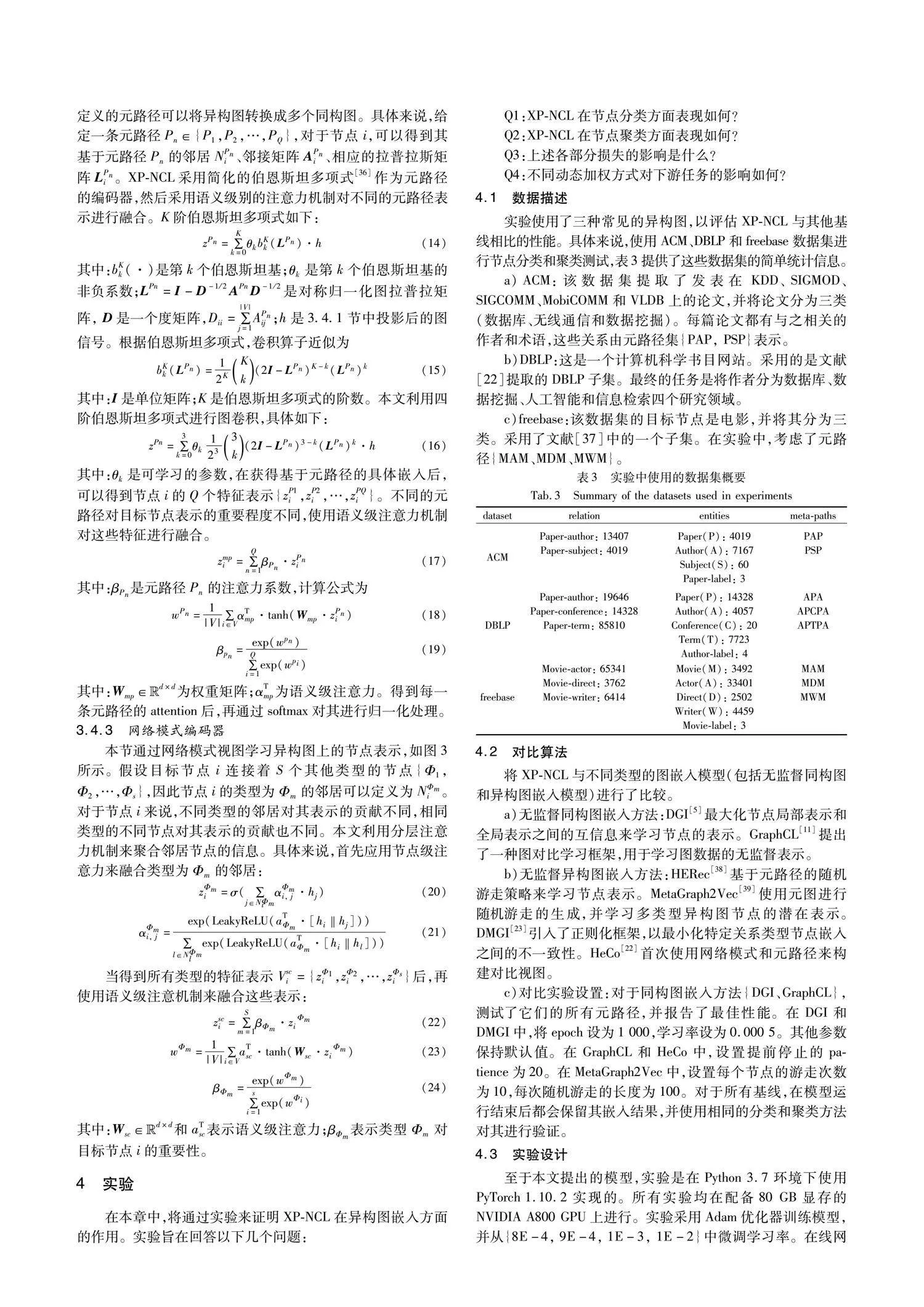

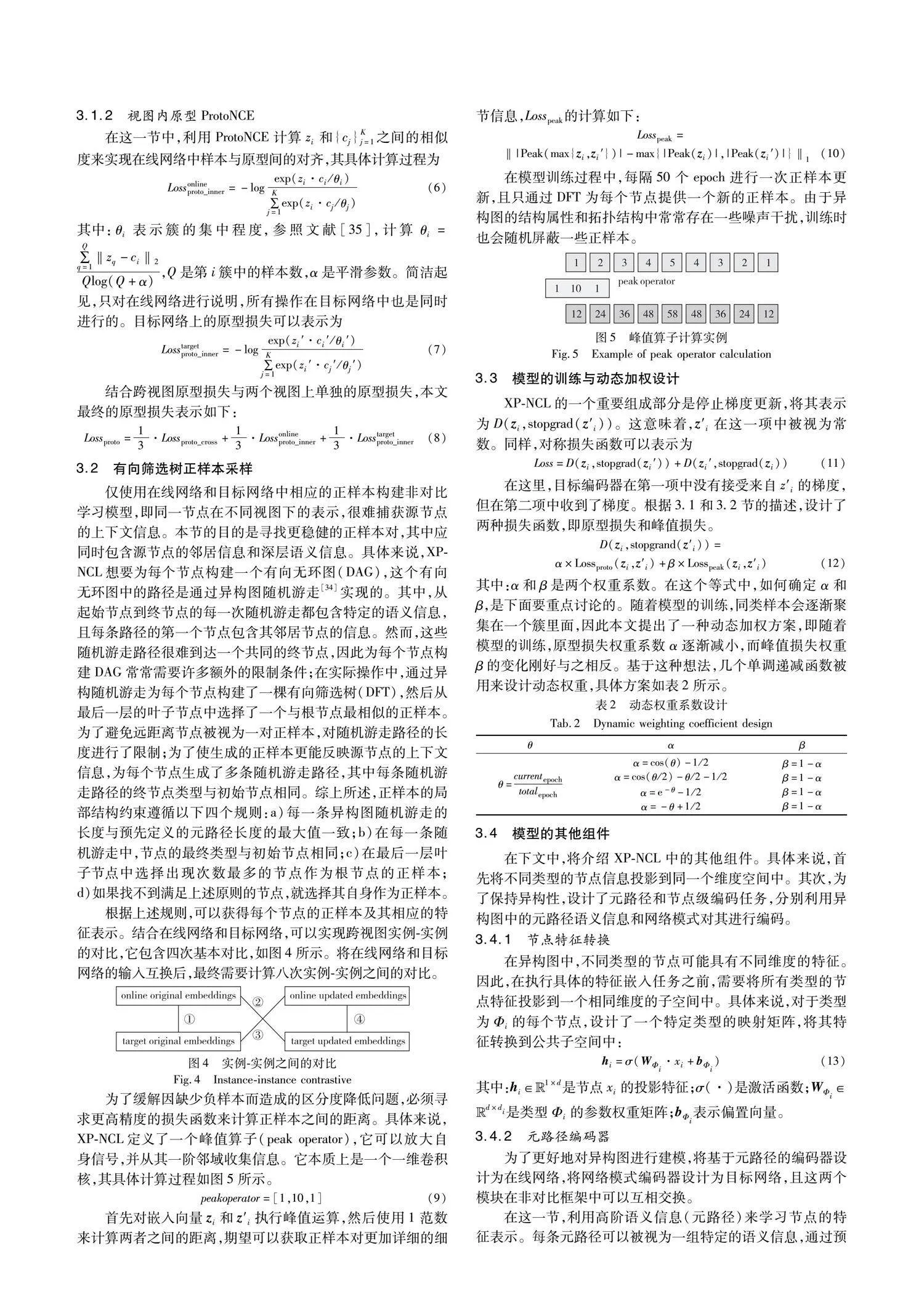

總的來說,通過實驗驗證了XP-NCL在三個真實異構圖上的分類性能,可以看出,XP-NCL表征與同構圖和異構圖基線相比,呈現(xiàn)出更優(yōu)越的性能。以DBLP數(shù)據(jù)集為例,該數(shù)據(jù)集包含四類節(jié)點(paper, author, conference, term)和三類邊(write, publish, belong),這些節(jié)點之間的多種關系構成了異構圖。通過應用本文研究的異構圖嵌入方法,可以將這些復雜的異構圖轉換為低維的向量表示,從而挖掘節(jié)點之間的潛在關聯(lián)。在本文中,將這些向量表示作為特征輸入到機器學習模型中,用于節(jié)點的分類和聚類任務中。在表4中,展示了使用模型對author類節(jié)點的分類結果,結果表明,XP-NCL表征與同構圖和異構圖基線相比,很多情況下都可以呈現(xiàn)出更優(yōu)越的性能。圖7(e)展示了XP-NCL在DBLP數(shù)據(jù)集上的聚類結果,從聚類結果可以看出,本文方法聚類結果更加緊湊,且無法區(qū)分的樣本大多分布在簇邊緣部分。

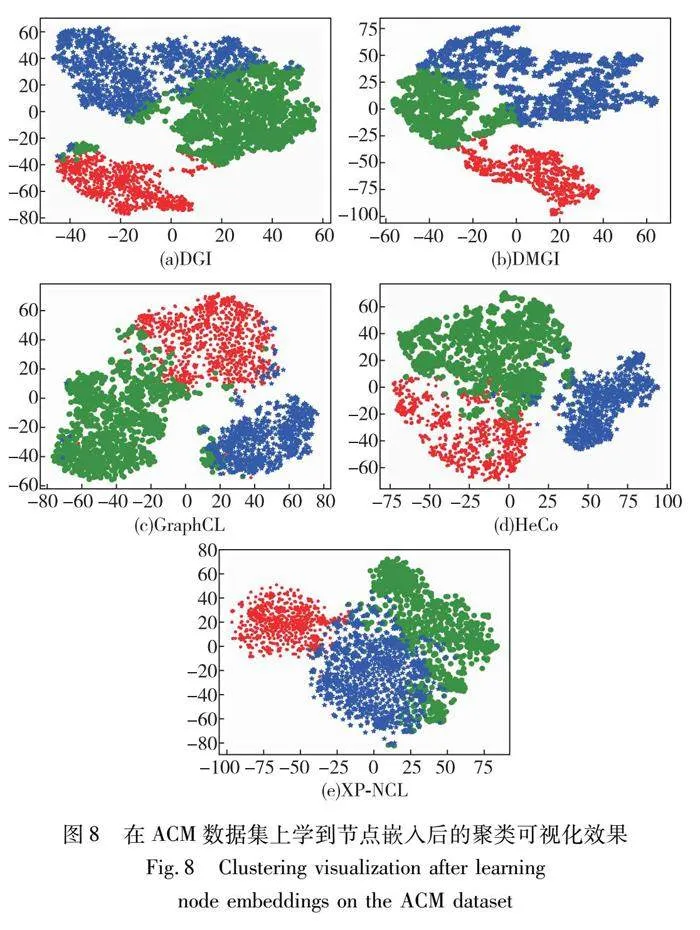

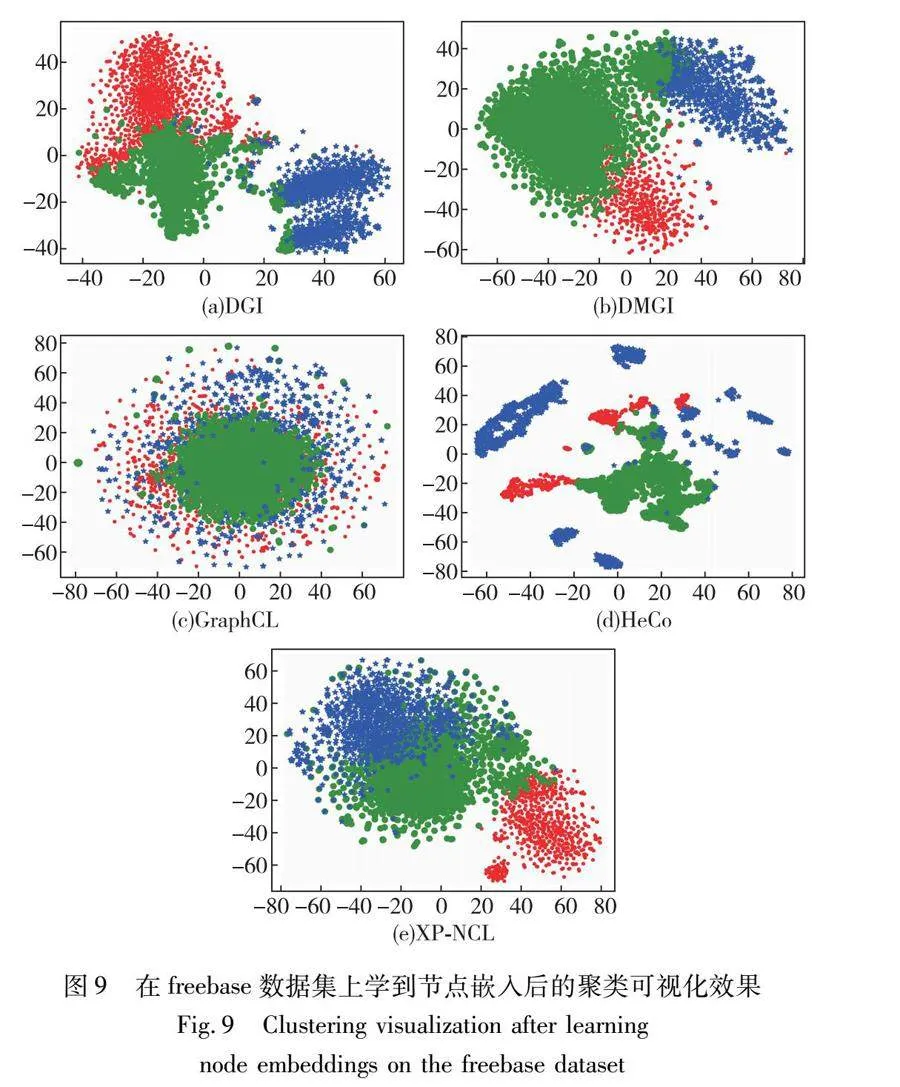

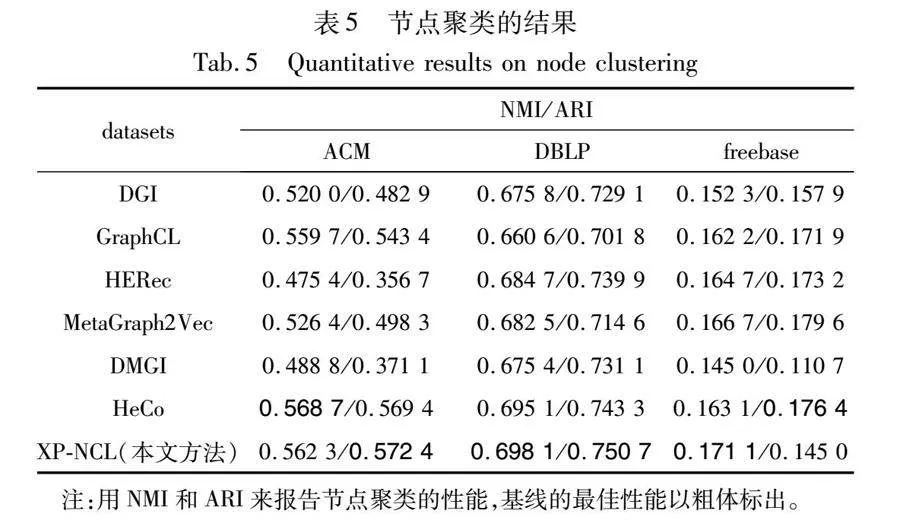

4.5 聚類結果

在這項任務中,進一步使用學習到的表示進行K-means聚類,以驗證所學節(jié)點嵌入的質量。采用NMI和ARI作為評價指標,結果如表5所示。為了緩解初始聚類中心不同帶來的不穩(wěn)定性,重復了10次聚類實驗,并匯報了平均結果。可以看出,XP-NCL在大多數(shù)情況下都表現(xiàn)良好。尤其是在DBLP數(shù)據(jù)集上,本文方法獲得了最好的結果,證明了模型的優(yōu)越性。這得益于原型損失的設計,其促使節(jié)點在同一簇中的表示更加緊湊,從而有助于提高聚類效果。

為了提供更直觀的評估,對三個數(shù)據(jù)集聚類后的結果進行了可視化。使用t-SNE繪制了DGI、DMGI、GraphCL、HeCo和XP-NCL的學習嵌入,結果如圖7~圖9所示,不同顏色代表不同的類別。相比于其他方法,XP-NCL得到的簇更加緊湊,且誤分的樣本通常只存在于簇邊界部分。這一點得益于該模型不需要負樣本和局部結構約束的正樣本選擇策略,且只有少量的樣本無法進行區(qū)分。

4.6 損失函數(shù)分析

在本節(jié)中,將分別使用原型和峰值作為損失函數(shù),然后討論將這兩個部分結合的必要性。實驗在三個模型上進行:a)去掉了原型損失,因此模型被稱為peak;b)去掉了峰值損失,模型被稱為proto;c)文中提出的模型peak+proto。

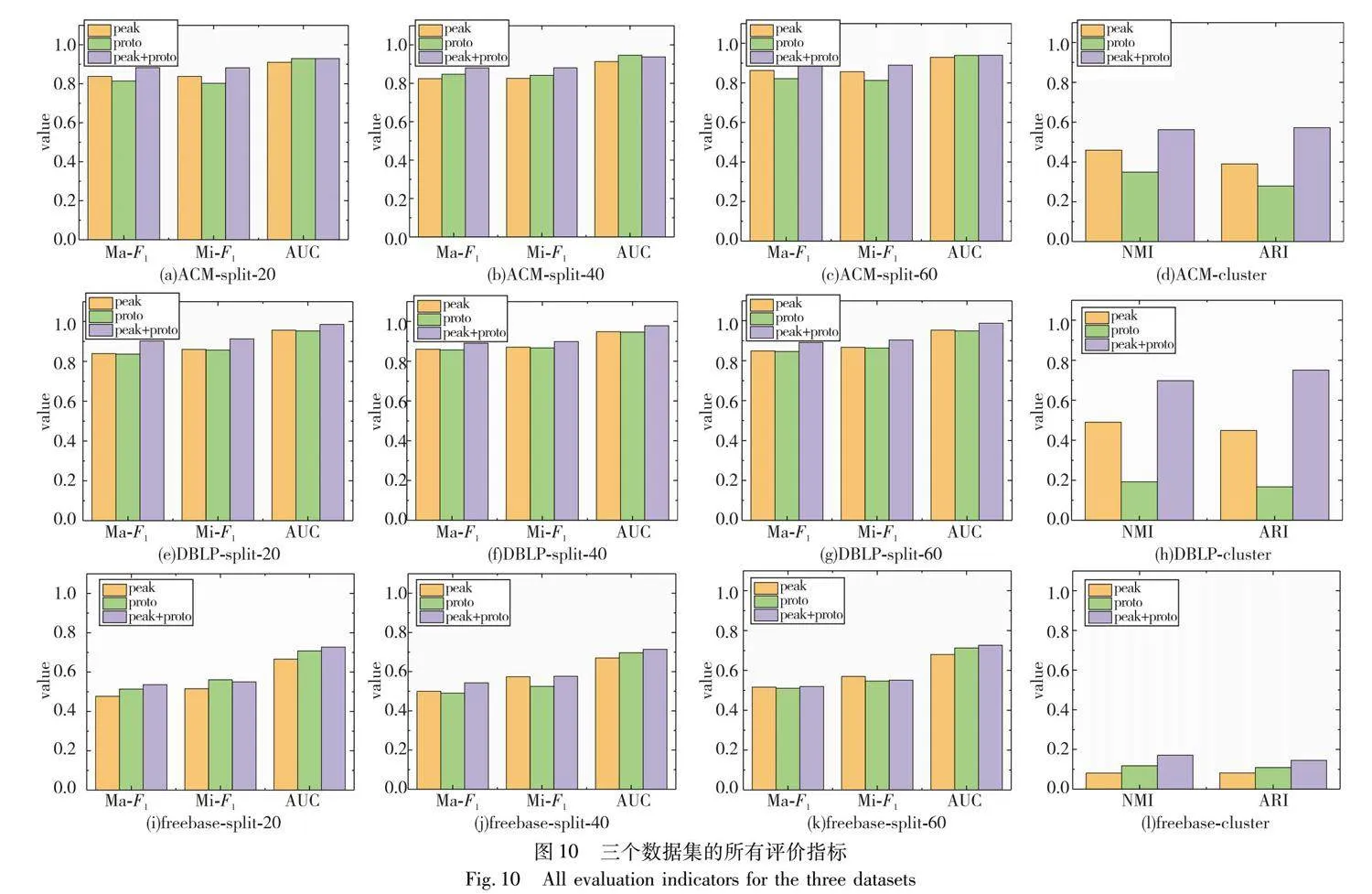

圖10分別顯示了三個數(shù)據(jù)集的所有評價指標,從第一行到第三行分別為ACM、DBLP和freebase數(shù)據(jù)集在不同采樣情況下的原型、峰值和原型+峰值損失對模型評價指數(shù)的影響。可以看到,無論是分類任務還是聚類任務,總體結果在大多數(shù)

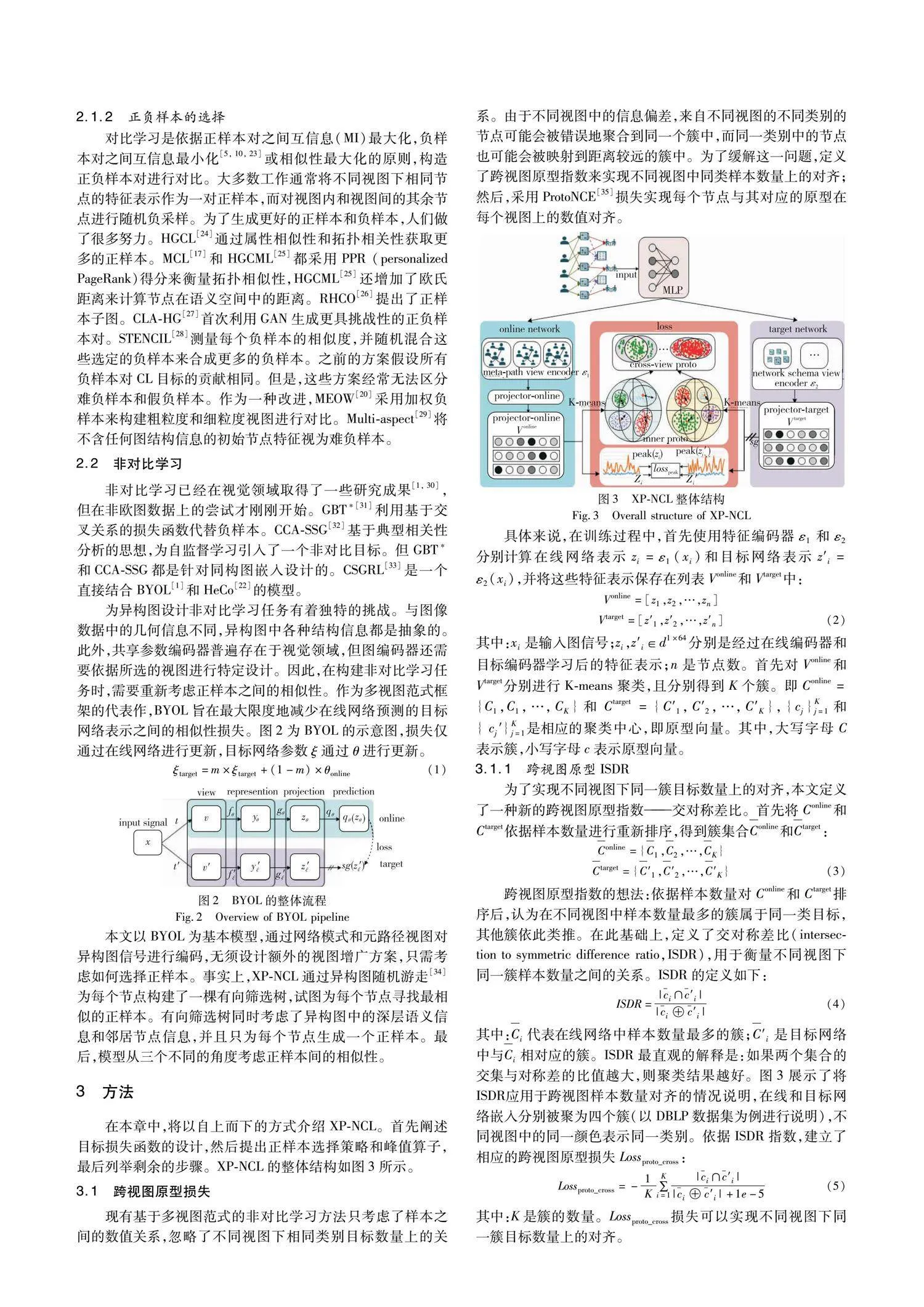

情況下都是peak+proto>peak>proto。以ACM數(shù)據(jù)集為例,在圖11中更加直觀地使用t-SNE展示了單獨使用每種損失后的聚類結果。通過聚類結果發(fā)現(xiàn):a)proto主要用于將同類樣本聚類在一起,但聚類的最終形狀很難保持一致,例如可能是球狀或帶狀;b)peak則是將正樣本之間的距離拉得更近,讓簇更緊密。

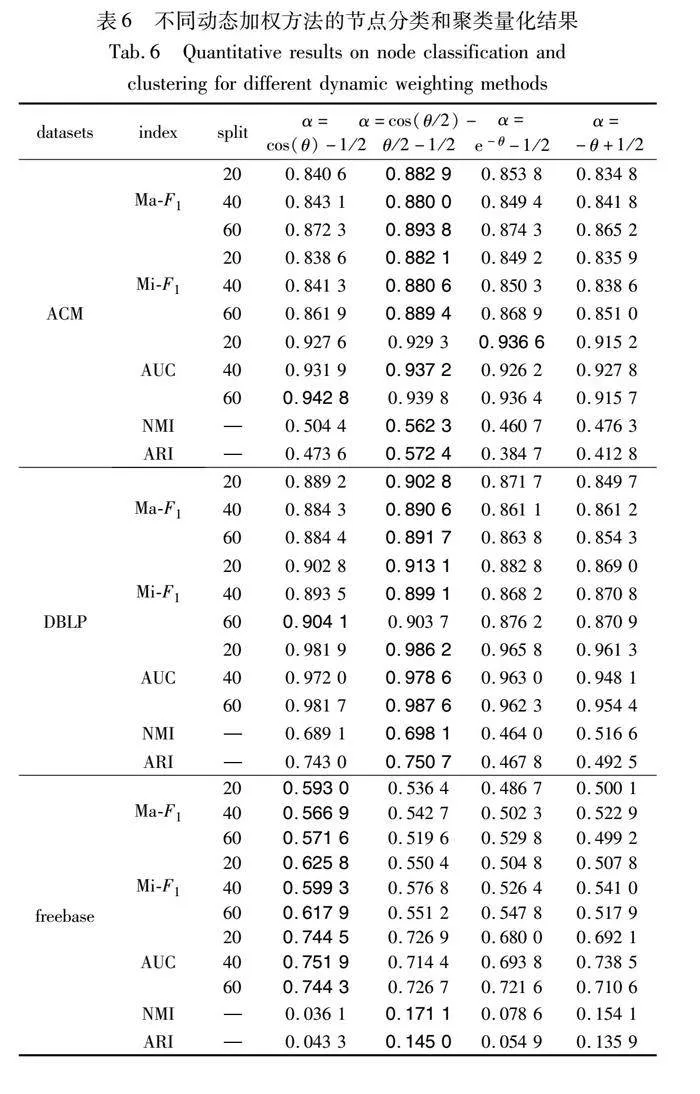

4.7 動態(tài)加權方案分析

在3.3節(jié)中,設計了四種不同類型的動態(tài)加權方案,表6列出了所有實驗結果,最高性能以粗體標出。結果表明,當選α=cos(θ/2)-θ/2-1/2時,在ACM和DBLP數(shù)據(jù)集中得到了最好的結果,而在α=cos(θ)-1/2,freebase數(shù)據(jù)集中得到了最好的結果。但是在freebase數(shù)據(jù)集中,聚類任務中學習到的嵌入效果很差,這可能與數(shù)據(jù)集本身有關。

5 結束語

本文提出了一個基于跨視圖原型非對比學習的異構圖嵌入模型。該模型不使用負樣本,而是通過有向篩選樹為每個節(jié)點選擇一個最相似的正樣本。在此基礎上,定義了交對稱差比與峰值算子來重構跨視圖特征對齊,并設計了動態(tài)損失加權方案。當設計非對比學習模型時,從多個維度考慮不同視圖之間的對齊是至關重要的,更多的對齊方案即將發(fā)布。在異構圖非對比學習中,如何選擇更好的正樣本也是下一步要解決的問題。

參考文獻:

[1]Grill J B,Strub F,Altché F,et al. Bootstrap your own latent-a new approach to self-supervised learning [C]//Advances in Neural Information Processing Systems. 2020: 21271-21284.

[2]Tang Shixiang,Su Peng,Chen Dapeng,et al. Gradient regularized contrastive learning for continual domain adaptation [C]// Proc of AAAI Conference on Artificial Intelligence. 2021: 2665-2673.

[3]He Kaiming,F(xiàn)an Haoqi,Wu Yuxin,et al. Momentum contrast for unsupervised visual representation learning [C]// Proc of IEEE/CVF Conference on Computer Vision and Pattern Recognition. 2020: 9729-9738.

[4]Chen Xinlei,F(xiàn)an Haoqi,Girshick R,et al. Improved baselines with momentum contrastive learning [EB/OL]. (2020). https://arxiv.org/abs/2003. 04297.

[5]Velikovic' P,F(xiàn)edus W,Hamilton W L,et al. Deep graph infomax [EB/OL]. (2018).https://arxiv.org/abs/1809. 10341.

[6]Wang Xiao,Bo Deyu,Shi Chuan,et al. A survey on heterogeneous graph embedding: methods,techniques,applications and sources [J]. IEEE Trans on Big Data,2022,9(2): 415-436.

[7]Liu Xiao,Zhang Fanjin,Hou Zhenyu,et al. Self-supervised learning: generative or contrastive [J]. IEEE Trans on Knowledge and Data Engineering,2021,35(1): 857-876.

[8]Balestriero R,Ibrahim M,Sobal V,et al. A cookbook of self-supervised learning [EB/OL].(2023).https://arxiv.org/abs/2304. 12210.

[9]吳相帥,孫福振,張文龍,等. 基于圖注意力的異構圖社交推薦網(wǎng)絡 [J]. 計算機應用研究,2023,40(10): 3076-3081,3106. (Wu Xiangshuai,Sun Fuzhen,Zhang Wenlong,et al. GAT based heterogeneous graph neural network for social recommendation [J]. Application Research of Computers,2023,40(10): 3076-3081,3106.)

[10]Zhou Zhichao,Hu Yu,Zhang Yue,et al. Multiview deep graph infomax to achieve unsupervised graph embedding [J]. IEEE Trans on Cybernetics,2022,53(10):6329-6339.

[11]You Yuning,Chen Tianlong,Sui Yongduo,et al. Graph contrastive learning with augmentations [C]// Advances in Neural Information Processing Systems. 2020: 5812-5823.

[12]Yu Ruiyun,Yang Kang,Wang Zhihong,et al. Multimodal interaction aware embedding for location-based social networks [J]. AI Communications,2023,36(1): 41-55.

[13]You Yuning,Chen Tianlong,Shen Yang,et al. Graph contrastive learning automated [C]//Proc of International Conference on Machine Learning. 2021: 12121-12132.

[14]Zhang Rui,Zimek A,Schneider-Kamp P. Unsupervised representation learning on attributed multiplex network [C]// Proc of the 31st ACM International Conference on Information & Knowledge Management. New York:ACM Press,2022: 2610-2619.

[15]Shang Jingbo,Qu Meng,Liu Jialu,et al. Meta-path guided embedding for similarity search in large-scale heterogeneous information networks [EB/OL]. (2016). https://arxiv.org/abs/1610. 09769.

[16]Zhao Jianan,Wen Qianlong,Sun Shiyu,et al. Multi-view self-supervised heterogeneous graph embedding [C]//Proc of Joint European Conference on Machine Learning and Knowledge Discovery in Databases. Cham: Springer International Publishing,2021: 319-334.

[17]Li Qi,Chen Wenping,F(xiàn)ang Zhaoxi,et al. A multi-view contrastive learning for heterogeneous network embedding [J]. Scientific Reports,2023,13(1): 6732.

[18]Zhong Hongwei,Wang Mingyang,Zhang Xinyue. Unsupervised embedding learning for large-scale heterogeneous networks based on metapath graph sampling [J]. Entropy,2023,25(2): 297.

[19]Fu Xinyu,Zhang Jiani,Meng Ziqiao,et al. MAGNN: metapath aggregated graph neural network for heterogeneous graph embedding [C]// Proc of Web Conference. 2020: 2331-2341.

[20]Yu Jianxiang,Li Xiang. Heterogeneous graph contrastive learning with meta-path contexts and weighted negative samples [C]// Proc of SIAM International Conference on Data Mining. 2023: 37-45.

[21]Xu Keyulu,Hu Weihua,Leskovec J,et al. How powerful are graph neural networks? [EB/OL]. (2018). https://arxiv.org/abs/ 1810. 00826.

[22]Wang Xiao,Liu Nian,Han Hui,et al. Self-supervised heterogeneous graph neural network with co-contrastive learning [C]// Proc of the 27th ACM SIGKDD Conference on Knowledge Discovery & Data Mining. 2021: 1726-1736.

[23]Park C,Kim D,Han J,et al. Unsupervised attributed multiplex network embedding [C]// Proc of AAAI Conference on Artificial Intelligence. 2020: 5371-5378.

[24]Jin Di,Huo Cuiying,Dang Jianwu,et al. Heterogeneous graph neural networks using self-supervised reciprocally contrastive learning [EB/OL]. (2022).https://arxiv.org/abs/2205. 00256.

[25]Wang Zehong,Li Qi,Yu Donghua,et al. Heterogeneous graph con-trastive multi-view learning [C]// Proc of SIAM International Confe-rence on Data Mining. 2023: 136-144.

[26]Wan Ziming,Wang Deqing,Ming Xuehua,et al. RHCO: a relation-aware heterogeneous graph neural network with contrastive learning for large-scale graphs [EB/OL]. (2022).https://arxiv.org/abs/ 2211. 11752.

[27]Qian Yiyue,Zhang Yiming,Chawla N,et al. Malicious repositories detection with adversarial heterogeneous graph contrastive learning [C]// Proc of the 31st ACM International Conference on Information & Knowledge Management. New York:ACM Press,2022: 1645-1654.

[28]Zhu Yanqiao,Xu Yichen,Cui Hejie,et al. Structure-enhanced heterogeneous graph contrastive learning [C]// Proc of SIAM International Conference on Data Mining.2022: 82-90.

[29]Che Feihu,Tao Jianhua,Yang Guohua,et al. Multi-aspect self-supervised learning for heterogeneous information network [J]. Know-ledge-Based Systems,2021,233: 107474.

[30]Chen Xinlei,He Kaiming. Exploring simple siamese representation learning [C]// Proc of IEEE/CVF Conference on Computer Vision and Pattern Recognition. 2021: 15750-15758.

[31]Bielak P,Kajdanowicz T,Chawla N V. Graph barlow twins: a self-supervised representation learning framework for graphs [J]. Know-ledge-Based Systems,2022,256: 109631.

[32]Zhang Hengrui,Wu Qitian,Yan Junchi,et al. From canonical correlation analysis to self-supervised graph neural networks [C]//Advances in Neural Information Processing Systems. 2021: 76-89.

[33]Park M. Cross-view self-supervised learning on heterogeneous graph neural network via bootstrapping [EB/OL]. (2022). https://arxiv.org/abs/2201. 03340.

[34]Dong Yuxiao,Chawla N V,Swami A. metapath2vec: scalable representation learning for heterogeneous networks [C]// Proc of the 23rd ACM SIGKDD International Conference on Knowledge Discovery and Data Mining. New York:ACM Press,2017: 135-144.

[35]Li Junnan,Zhou Pan,Xiong Caiming,et al. Prototypical contrastive learning of unsupervised representations [EB/OL]. (2020).https://arxiv.org/abs/2005. 04966.

[36]He Mingguo,Wei Zhewei,Huang Zengfeng,et al. BernNet: learning arbitrary graph spectral filters via bernstein approximation [C]//Advances in Neural Information Processing Systems. 2021: 14239-14251.

[37]Li Xiang,Ding Danhao,Kao Ben,et al. Leveraging meta-path contexts for classification in heterogeneous information networks [C]// Proc of IEEE 37th International Conference on Data Engineering. Pisca-taway,NJ:IEEE Press,2021: 912-923.

[38]Shi Chuan,Hu Binbin,Zhao W X,et al. Heterogeneous information network embedding for recommendation [J]. IEEE Trans on Knowledge and Data Engineering,2018,31(2): 357-370.

[39]Zhang Daokun,Yin Jie,Zhu Xingquan,et al. MetaGraph2Vec: complex semantic path augmented heterogeneous network embedding [C]//Proc of the 22nd Pacific-Asia Conference on Knowledge Discovery and Data Mining. Berlin:Springer International Publishing,2018: 196-208.

收稿日期:2024-01-12;修回日期:2024-03-20 基金項目:國家自然科學基金資助項目(U1931209);山西省科技合作交流專項區(qū)域合作項目(202204041101037,202204041101033);太原科技大學研究生教育創(chuàng)新項目(BY2023015)

作者簡介:張敏(1998—),男,山西長治人,碩士研究生,主要研究方向為數(shù)據(jù)挖掘與機器學習;楊雨晴(1992—),女,湖南常德人,講師,博士,主要研究方向為數(shù)據(jù)挖掘與機器學習;賀艷婷(1988—),女(通信作者),山西晉城人,講師,博士研究生,主要研究方向為機器學習(yantinghe@tyust.edu.cn);史晨輝(1998—),男,河南周口人,博士研究生,主要研究方向為數(shù)據(jù)挖掘與機器學習.