改進YOLOv5s的蝗蟲識別系統

摘要:為準確有效識別寧夏荒漠草原地區蝗蟲種類,基于YOLOv5s網絡模型提出一種復雜背景下蝗蟲目標檢測模型YOLOv5s-CG,在主干網絡使用CoTNet保留復雜背景下的蝗蟲特征信息,同時在頸部網絡中融入GAM全局注意力機制提高檢測模型的特征融合能力。結果表明,在對寧夏荒漠草原蝗蟲進行識別時,模型YOLOv5s-CG 精確率為92.5%,平均精度均值為93.2%,相比原始模型分別提高4.8個百分點和5.3個百分點,與 Fast R-CNN、YOLOv3、YOLOv4、YOLOv5s、YOLOv6s、YOLOv7模型相比,YOLOv5s-CG網絡模型對寧夏荒漠草原蝗蟲具有更好的檢測性能。基于YOLOv5s-CG,開發寧夏荒漠草原蝗蟲識別APP系統,實現寧夏荒漠草原地區復雜背景下的蝗蟲在線識別檢測,為寧夏荒漠草原地區蝗蟲的監管防控和綜合治理提供數據支持。

關鍵詞:蝗蟲識別;深度學習;自注意力機制;全局注意力機制

中圖分類號:S435 文獻標識碼:A 文章編號:2095?5553 (2024) 11?0189?07

Locust identification system based on improved YOLOv5s

Ma Hongxing, Dong Kaibing, Ding Yuheng, Sheng Tielei, Zhang Wei

(College of Electrical and Information Engineering, North Minzu University, Yinchuan, 750021, China)

Abstract: In order to accurately and effectively identify locust species in the Ningxia desert grassland region, a locust target detection model YOLOv5s-CG was proposed based on the YOLOv5s network model in a complex context, by using Contextual Transformer Networks (CoTNet) in the backbone network to retain locust feature information in the complex context, while incorporating the global attention mechanism in the neck network to improve the feature fusion capability of the detection model. The experimental results showed that the model YOLOv5s-CG had a precision of 92.5% and a mean average precision of 93.2% in locust identification in Ningxia desert grassland, which was 4.8 percentage points and 5.3 percentage points higher than the original model, respectively. Compared with the Fast R-CNN, YOLOv3, YOLOv4,YOLOv5s, YOLOv6s and YOLOv7 models, the YOLOv5s-CG network model had better detection performance for locusts in Ningxia desert grassland. Finally, based on the YOLOv5s-CG, a locust identification APP system was developed to achieve online locust identification and detection in the complex background of the Ningxia desert grassland region, providing data support for the supervision, prevention, control and comprehensive management of locusts in the Ningxia desert grassland region.

Keywords: locust identification; deep learning; self?attention mechanisms; global attention mechanism

0 引言

目前,我國蝗蟲常年發生面積1.87×107 hm2次左右,分布在20個省(區、市),其中草原蝗蟲常年發生1.2×107 hm2次左右。現有的遙感、地理信息系統等技術,可以對蝗蟲生活環境的植被或氣象信息進行監測,間接獲取蝗蟲分布信息,不受地域限制,但監測精度不高[1?3]。近年來,部分學者利用機器學習等新一代電子信息技術,在微觀方面對蝗蟲識別進行了研究。

Kasinathan等[4]以樸素貝葉斯(NB)、支持向量機(SVM)、K-最近鄰(KNN)和多層感知器(MLP)作為基礎分類器,對田間的昆蟲進行分類。Lima等[5]提出了將蟲類特征與支持向量機SVM(Support Vector Machine)相結合的方法,構建能分類64科的昆蟲分類系統,識別準確率可達93%。Lu等[6]提出了一種基于蝗蟲圖像分割、蝗蟲特征變量提取和支持向量機(SVM)分類的半自動蝗蟲種類和齡期信息檢測模型,識別準確率可達96.16%。Ye等[7]提出的ResNet-Locust-BN模型能夠識別三齡幼蟲,識別準確率為77.20%、識別五齡幼蟲準確率為88.40%、識別成蟲準確率93.8%。Liu等[8]使用改進的PraNet網絡可以對蝗蟲進行精確的定位分割。Cao等[9]基于VGG19卷積神經網絡進行遷移學習,昆蟲識別準確率達到97.39%。武英潔等[10]提出了基于Faster R-CNN的野外蝗蟲快速識別網絡,對野外的蝗蟲精確率為75.6%。李林等[11]設計了K-SSD-F算法,對東亞飛蝗的視頻數據進行檢測,精度為88.94%。馬宏興等 [12]基于YOLOv5網絡,將ConvNext和YOLOv5結合,對寧夏草原三類蝗蟲進行識別,識別精度為96%。

以上方法雖能有效對昆蟲和蝗蟲進行識別分類,但仍然存在不足:支持向量機針對高維度數據難以有效應用;K最近鄰需要大量數據集,蝗蟲數據集構建復雜,而且占用內存大,難以對蝗蟲進行有效分類識別;圖像分割需要對數據集進行預處理;Faster R-CNN、SSD和ConvNext目標檢測模型推理速度慢,難以做到實時有效的識別。

因此,基于YOLOv5s網絡,提出一種復雜背景下蝗蟲目標快速檢測識別模型。該模型使用CoTNet(Contextual Transformer Networks)[13]來保留復雜背景下的蝗蟲特征,使用GAM(Global Attention Mechanism)[14]注意力結構增強網絡特征融合的能力,同時將改進后的網絡模型應用于寧夏荒漠草原蝗蟲識別系統,以方便草原工作人員對蝗蟲分布狀態進行普查。

1 蝗蟲數據集

1.1 蝗蟲數據采集

寧夏荒漠草原中常見蝗蟲有亞洲小車蝗(Oedaleus decorus asiaticus)、短星翅蝗(Calliptamus abbreviatus Ikonnikov)、中華劍角蝗(Acrida cinerea)、黃脛小車蝗(Oedaleus infernalis Sauss)和赤翅皺膝蝗(Angaracris rhodopa)等,主要分布在寧夏中衛、鹽池、海源、同心和彭陽等地[15]。在自然環境下,蝗蟲的關鍵特征信息與背景存在高度的相似性,難以對蝗蟲特征進行有效的提取與分析,因此,為了豐富樣本數據,提高識別模型泛化能力,使用手機距離蝗蟲20~30 cm,并在不同光照環境、不同角度下采集了寧夏荒漠草原地區的蝗蟲圖像5類共874幅,蝗蟲圖像示例如圖1所示。

同時考慮到密集場景下的蝗蟲目標檢測,捕捉部分蝗蟲,將蝗蟲放置在捕蟲網、仿真草皮和粘蟲板,并在不同角度下進行拍攝蝗蟲目標,如圖2所示。

1.2 數據預處理

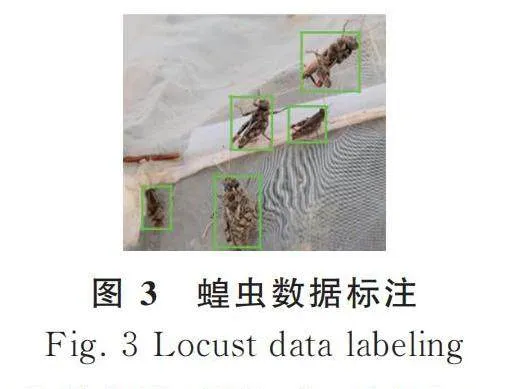

為了提高模型輸出的準確性,使得網絡模型能夠準確學習到蝗蟲的特征與位置信息,需要對圖像中的蝗蟲進行標注。標注時使用Labelimg工具,圖3為數據標注示例。

將標注好的數據集制作成通用的VOC格式,文件中包含蝗蟲名稱和位置信息。原始圖像和標注文件均用于模型的訓練和驗證。

1.3 數據增強

由于采集到蝗蟲圖像數據有限,為提高模型的魯棒性和泛化能力,采用馬賽克數據增強和傳統圖像增強相結合的方法,擴展蝗蟲圖像樣本的豐富度(圖4)。

2 模型設計

2.1 改進模型

蝗蟲的特征是全身通常為綠色、灰色、褐色或黑褐色,在自然條件下,與背景高度相似,因此,對檢測網絡提出了更高的要求。針對蝗蟲圖像背景復雜等問題,以YOLOv5s為模型進行改進,改進后的網絡模型命名為YOLOv5s-CG,如圖5所示。

通過將YOLOv5s原主干網絡部分C3改進為CotNet網絡,提高主干網絡層對蝗蟲小目標特征提取能力;同時,在Neck部分融入GAM全局注意力機制結構,提高模型的特征融合能力。通過這些改進,有效提升網絡模型對于復雜背景下的蝗蟲目標識別能力。

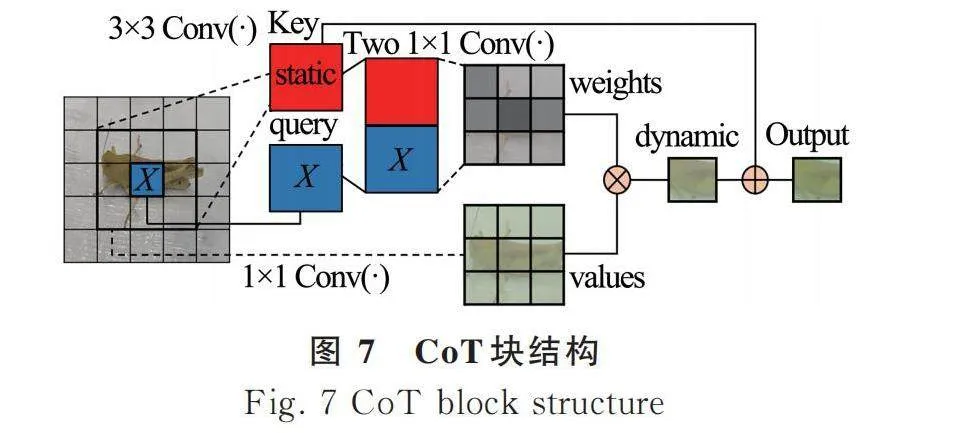

2.2 CoTNet主干網絡

YOLOv5s主干特征提取網絡為C3網絡,由于蝗蟲圖像背景復雜,并且蝗蟲的特征信息與背景特征信息存在高度的相似性,使用C3只能捕獲局部信息,而不能建立全局圖像的長距離連接。為了擴大圖像的感受野,獲取更多上下文信息(指與目標像素周圍像素相關的信息),在此引入CoTNet結構,提高模型特征提取能力。CoTNet是一種基于Transformer[16]的結構,通過CoT塊替換ResNet結構中的3×3卷積構成,其結構如圖6所示。

其中,CoTNet的核心模塊CoT塊結構如圖7所示。

在CoT塊中,首先通過對3×3網格中的所有相鄰鍵執行3×3卷積來進行上下文鍵的表示,上下文鍵特性視為輸入特征的靜態表示,反映本地鄰居之間的靜態上下文;其次,將上下文鍵特征和輸入查詢的拼接輸入到兩個連續的1×1卷積中,生成注意矩陣,這一過程利用每個查詢和所有鍵之間的相互關系,在靜態上下文的指導下進行自注意學習,進一步利用學習的注意矩陣聚合所有輸入值,實現輸入的動態上下文表示;最后將靜態和動態上下文結合作為CoT塊的最終輸出。CotNet同時捕獲輸入鍵之間的兩種空間上下文,即通過3×3卷積獲取靜態上下文和基于自注意的動態上下文,以提高蝗蟲特征的學習。

在YOLOv5s中使用CoTNet,可以利用卷積有效地從圖像中學習抽象的低分辨率特征圖,同時也使用自注意力來處理和聚合卷積捕獲特征圖中包含的信息,擴展模型專注于不同位置的能力,提高模型對于蝗蟲特征信息的提取。

2.3 GAM注意力結構

注意力機制作為提高神經網絡性能的一種有效方法,使目標更加關注于重要的特征信息,已經成為目標檢測領域的一個重要概念,目前在自然語言處理、統計學習、語音和計算機視覺等領域有著大量的應用。

受背景特征信息的影響,在網絡模型的訓練過程中,蝗蟲的特征信息會隨著網絡模型的加深而變得更高級,造成小目標關鍵信息的丟失;同時,背景信息卷積迭代會積累無效信息,導致蝗蟲目標信息淹沒。因此,為提高模型對于蝗蟲類別和位置信息的預測,選擇GAM全局注意力機制融入Neck網絡層,可以抑制無關的特征信息。

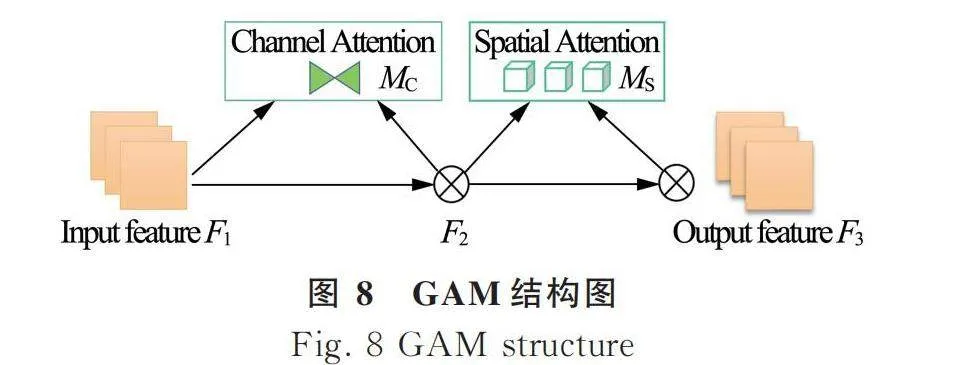

GAM全局注意力實現過程如圖8所示,輸入特征F1經過通道注意力模塊和空間注意力模塊,最后輸出為一個新的特征F3。

給定輸入特征映射[F1∈RC×H×W], 其中中間狀態[F2]計算如式(1)所示。

[F2=MC(F1)?F1] (1)

輸出[F3]計算如式(2)所示。

[F3=MS(F2)?F2] (2)

式中: [MC]、[MS]——通道注意力模塊和空間注意力模塊;

[?]——按元素進行乘法操作。

其中通道注意模塊(Channel Attention)如圖9所示。

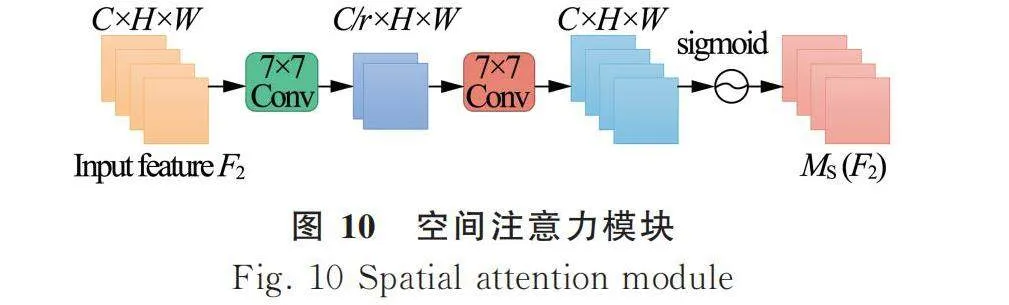

通道注意力模塊先對輸入的蝗蟲圖像使用3排列操作來保留圖像三維信息,然后將輸出通過1個2層MLP來放大跨維通道,再對輸出使用逆向3D進行排列,并使用sigmoid激活函數處理,最后得到新卷特征圖[MC(F1)]。空間注意力模塊(Spatial Attention)如圖10所示。

在空間注意力模塊中,首先將獲取的蝗蟲特征使用兩個7×7的卷積層進行空間融合,獲取空間信息,最后經過sigmoid激活函數得到新的蝗蟲特征圖[MS(F2)]。

在改進模型YOLOv5s-CG中,通過融入GAM全局注意力機制,提升模型對蝗蟲關鍵信息的特征融合能力,解決無效信息會降低蝗蟲識別準確率問題。

3 試驗分析

3.1 試驗環境

模型在服務器上完成訓練,服務器配置為Intel(R) Xeon(R) Gold 6330 CPU,RTXA5000 GPU。模型訓練環境為PyTorch(1.11.0),Python 3.8(ubuntu20.04),Cuda(11.3)。訓練參數配置如表1所示,同時,使用馬賽克增強,啟用早停機制(訓練50個epoch之后,如果模型效果未提升,則模型提前停止訓練)。

蝗蟲數據集共874幅,按6∶2∶2比例隨機劃分數據集,用于模型的訓練、驗證和測試。

3.2 識別結果

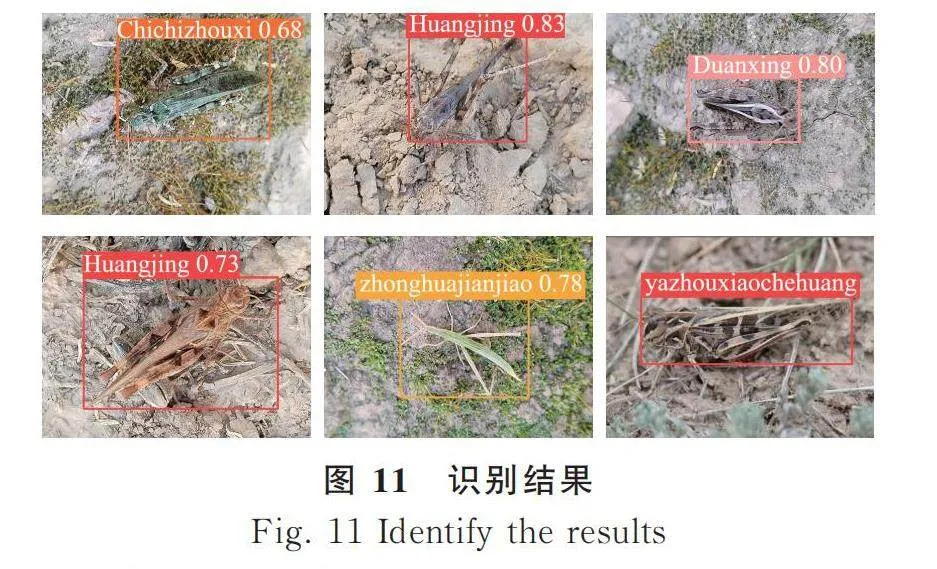

采用改進模型YOLOv5s-CG對測試集中的5類蝗蟲進行識別,試驗結果如圖11所示。從圖11可以看出,YOLOv5s-CG能夠對圖像中的蝗蟲類別和位置信息進行準確識別和定位。

3.3 蝗蟲數據集測試與分析

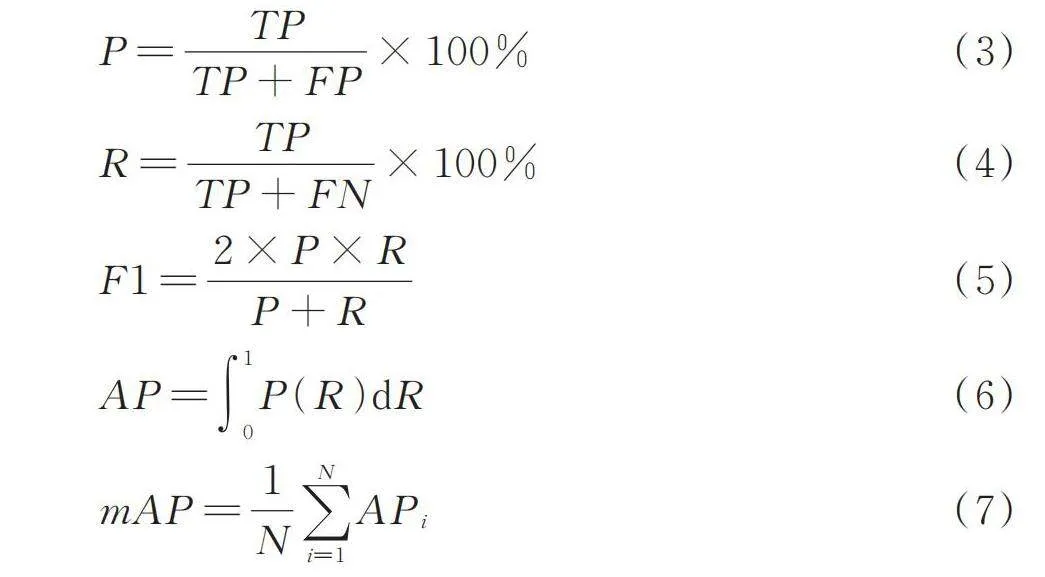

為了測試改進模型YOLOv5s-CG的性能,選取精確率P(Precision)、召回率R(Recall)、平均精度均值mAP(mean Average Precision)、綜合評價指標F1和模型推理時間T作為識別精度評價指標。

[P=TPTP+FP×100%] (3)

[R=TPTP+FN×100%] (4)

[F1=2×P×RP+R] (5)

[AP=01P(R)2b30fef9a289a07b72c209ffe8d050e53c14f4ba9e34bf5965d32d675fe3f60cdR] (6)

[mAP=1Ni=1NAPi] (7)

式中: FP——檢測到的真實蝗蟲類別與目標蝗蟲類別不一致的樣本數量;

TP——檢測到的真實蝗蟲類別與目標蝗蟲類別一致的樣本數量;

FN——未被網絡檢測出來的真實蝗蟲目標存在的樣本數量;

N——蝗蟲的類別數。

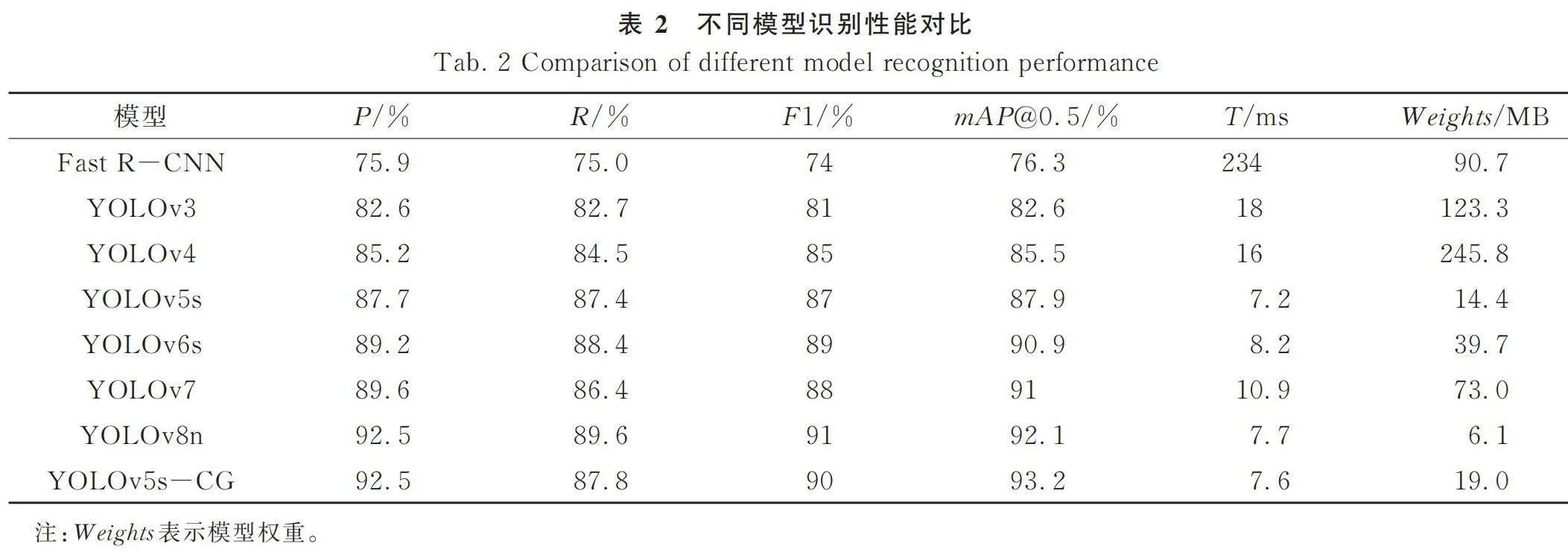

為有效評估YOLOv5s-CG的先進性,選取Fast R-CNN(Resnet) [17]、YOLOv3[18]、YOLOv4[19]、YOLOv6s[20]、 YOLOv7[21]、YOLOv8n和YOLOv5s與改進模型進行比較,結果如表2所示。

由表2可知,在對采集的五類草原蝗蟲識別時,與Fast R-CNN、YOLOv3、YOLOv4、YOLOv5s、YOLOv6s和YOLOv7相比,YOLOv5s-CG的精確率、召回率、平均精度均值和綜合評價指標均為最優,其中,平均精度均值比Fast R-CNN提高16.9個百分點,比YOLOv3提高10.6個百分點,比YOLOv4提高7.7個百分點,比YOLOv5s網絡提高5.3個百分點,比YOLOv6s網絡提高2.3個百分點,比YOLOv7網絡提高2.2個百分點。在模型推理時間相比Fast R-CNN、YOLOv3、YOLOv4、YOLOv6s、YOLOv7有大幅度提升,而由于改進模型引入了Transformer結構,增加了網絡的計算量,導致推理速度變慢,但是相比原始模型慢0.4 ms,產生的影響可以忽略不計。

與YOLOv8n相比,召回率下降1.8個百分點,綜合評價指標降低1個百分點,但是精確率相同,平均精度均值提高1.1個百分點,綜合來看,改進模型性能仍然優于YOLOv8n。

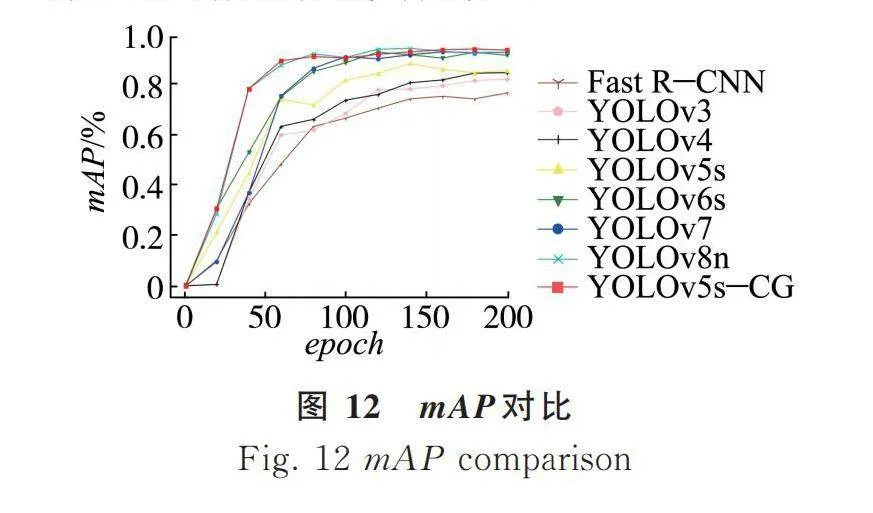

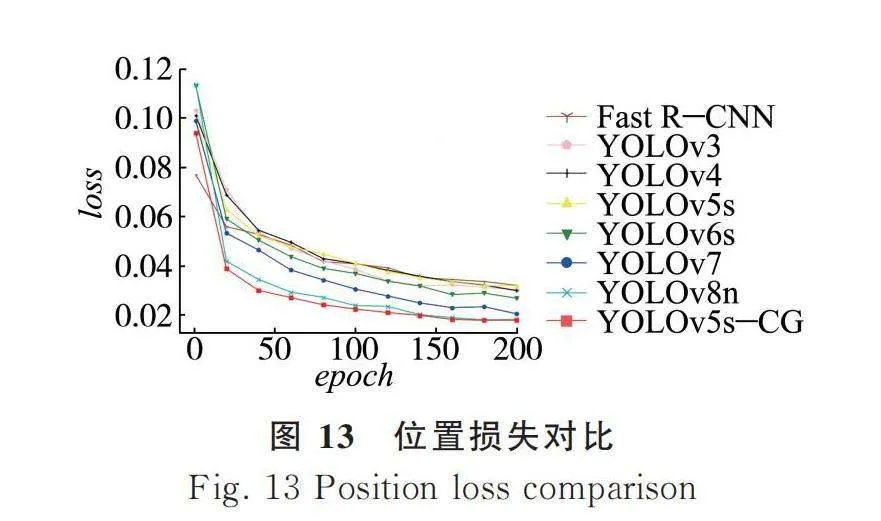

為了直觀比較模型的性能,繪制Fast R-CNN、YOLOv3、YOLOv4、YOLOv5s、YOLOv6s、YOLOv7和改進模型在訓練過程中的精確率—召回率曲線和位置損失曲線,分別如圖12和圖13所示。由圖12和圖13可知,改進模型YOLOv5s-CG引入了CoTNet網絡和GAM結構之后,最終的平均精度均值和收斂結果均優于原始網絡和其他模型。

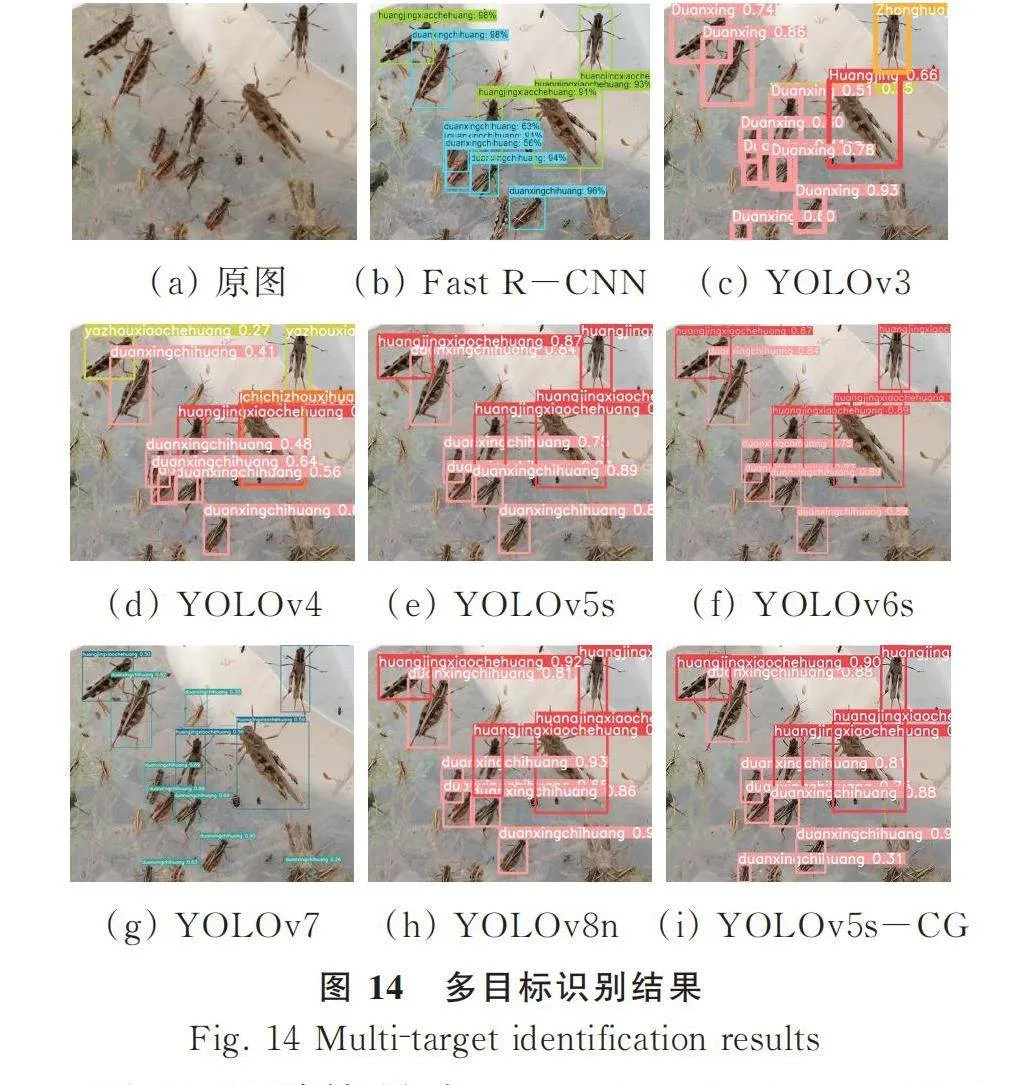

為了進一步驗證模型改進的有效性,選擇各標準模型與本文改進模型YOLOv5s-CG對多目標圖像進行識別,識別結果如圖14所示。

圖14識別結果中,Fast R-CNN、YOLOv3、YOLOv4對于多目標的蝗蟲圖像存在明顯的漏檢、錯檢和重復檢測現象,YOLOv5s、YOLOv6s和YOLOv8能檢測出蝗蟲目標,但存在漏檢現象,而YOLOv7雖能檢測出小目標,但對小目標存在錯檢現象,而改進模型YOLOv5s-CG性能最優,可以準確識別圖像中的小目標圖像。

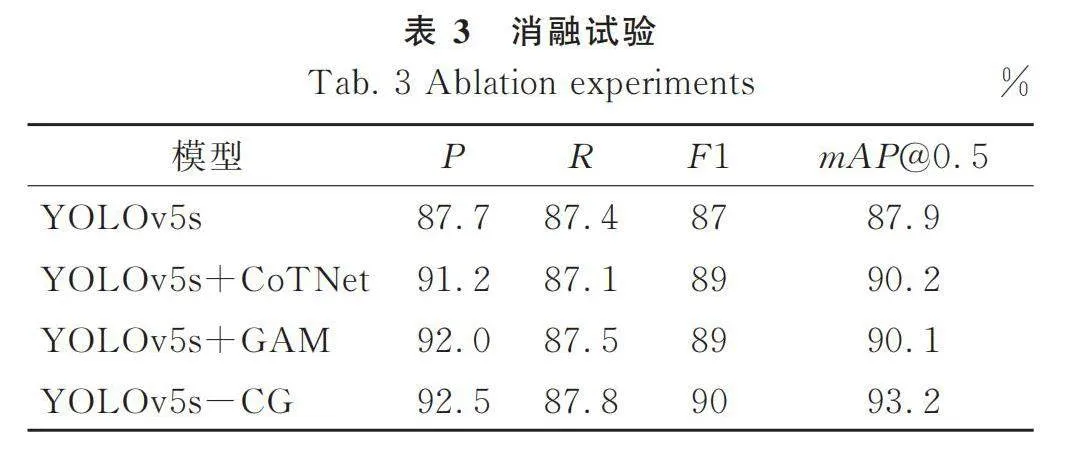

3.4 消融試驗

為了驗證改進模型YOLOv5s-CG的有效性,使用消融試驗進行驗證。由表3可知,相比YOLOv5s,改進主干網絡后的模型精確率提高3.5個百分點,平均精度均值提高2.3個百分點,說明采用CoTNet絡,能夠較好地提取小目標特征,有效提高網絡模型對蝗蟲的檢測性能。相比YOLOv5s,在Neck層融入注意力后的模型在精確率提高4.3個百分點,平均精度均值提高2.2個百分點,說明采用GAM注意力機制結構,可提高模型的的特征融合能力,提高模型的性能。相比YOLOv5s,改進主干網絡和特征融合網絡的模型精確率提高4.8個百分點,平均精度均值提高5.3個百分點,說明本文改進方法YOLOv5-CG可以更好地進行復雜背景下蝗蟲的識別。

4 蝗蟲識別系統設計

4.1 系統開發原理

隨著智能手機的廣泛普及,科研人員或者蟲害研究人員使用手機軟件隨手拍攝圖片,通過系統軟件進行快速高效的識別,是指導農業病蟲害研究預防的有效手段[20?22]。

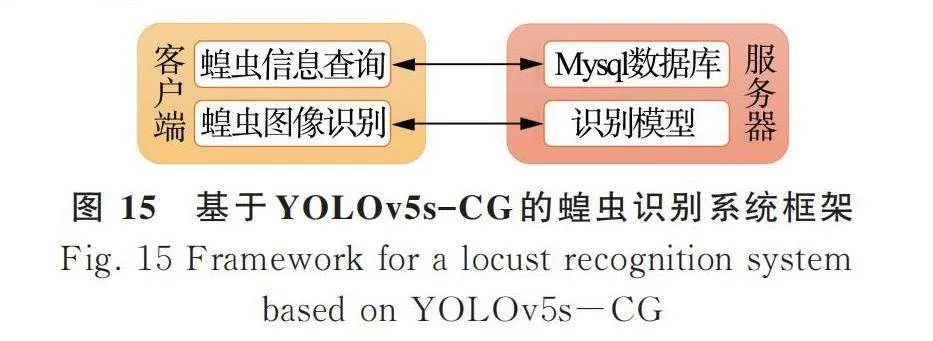

蝗蟲識別系統采用阿里云服務器部署,使用Nginx和Flask作為服務器代理,同時使用Mysql數據庫,開發平臺借助于 Windows和Linux平臺,選擇B/S開發模式,前端采用Vue和Uni?app開發界面,后端采用基礎開發框架SpringBoot+Mybatics。

基于YOLOv5s-CG的蝗蟲識別系統設計框架如圖15所示。

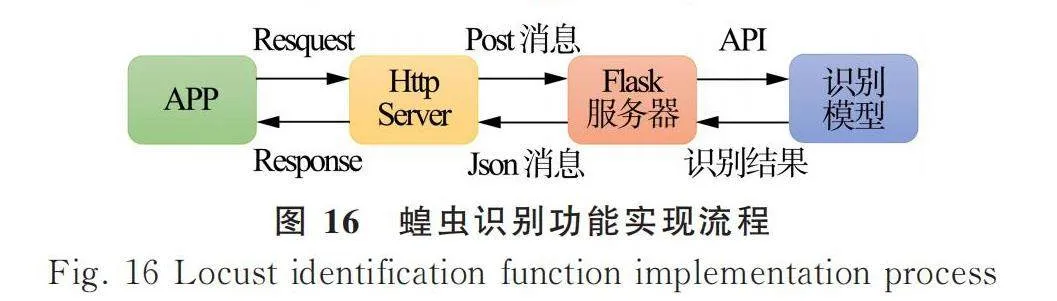

由圖15可知,APP實現主要功能為寧夏荒漠草原地區常見蝗蟲數據庫的管理和蝗蟲圖像的識別,其中,蝗蟲識別模型模塊與后端蝗蟲數據庫模塊獨立部署。后端數據庫模塊采用SpringBoot框架常用的4層結構,分別是DAO層、Entity層、Service層和Controller層,其中DAO層結合Mybatics框架實現蝗蟲數據庫的資源交互。蝗蟲識別模塊通過Flask框架進行部署,蝗蟲圖像識別具體實現流程如圖16所示。

在圖16中,將訓練好的YOLOv5s-CG模型部署到linux服務器,在服務器端配置模型需要的Anaconda、Pytorch和Python環境,最后使用Flask框架生成API接口,手機端通過API調用服務器端的模型實現蝗蟲圖像的識別。

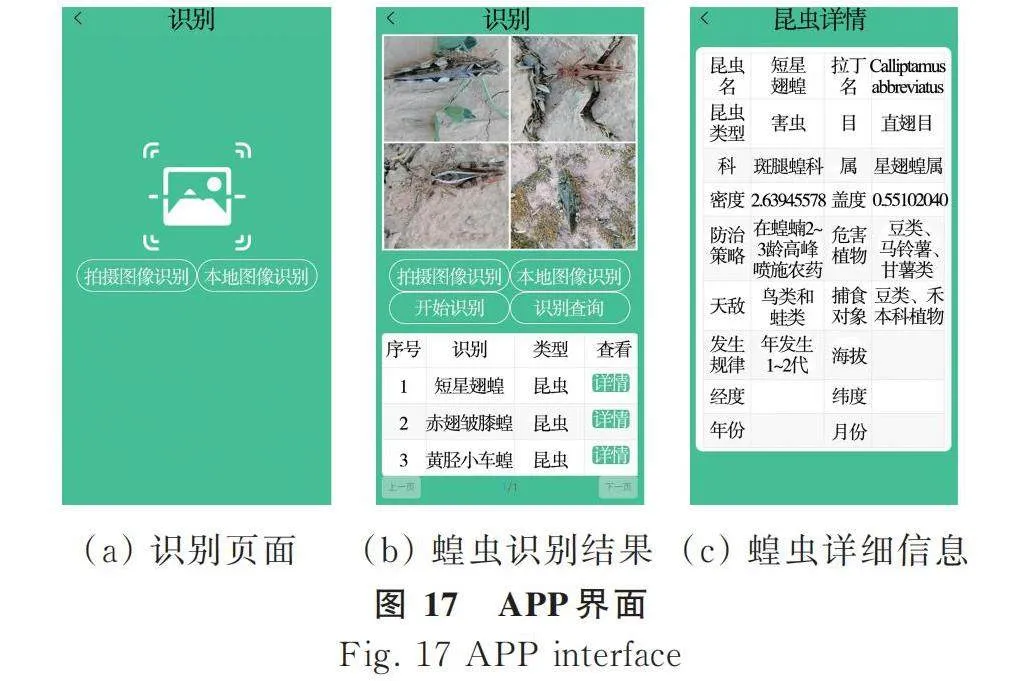

4.2 系統實現

蝗蟲識別系統如圖17所示。選擇本地蝗蟲圖像或者拍攝蝗蟲圖像進行識別,識別完成之后,點擊詳情可以查看蝗蟲的詳細信息(包括名稱、類型、科、目、危害植物、分布信息、防治策略等),然后可以根據系統提供的詳細信息,針對性做出防治策略,保護作物。同時,為測試識別系統的識別速度,使用Apifox在線調試工具對圖像識別的響應時間進行測試,在實際測試中,識別3 000像素×4 000像素的圖像,服務器平均響應時間為369 ms。

5 結論

1) 為解決復雜背景下寧夏荒漠草原蝗蟲識別問題,首先通過人工采集蝗蟲圖像,構建寧夏荒漠草原蝗蟲數據集,并制作成標準VOC格式數據集。

2) 提出蝗蟲檢測模型YOLOv5s-CG,在模型主干網絡中引入CoTNet保留蝗蟲特征信息,頸部網絡中引入GAM提升蝗蟲特征融合能力,識別精確率為92.5%,召回率為87.8%,綜合評價指標為0.90,平均精度均值為93.2%。與Fast R-CNN、YOLOv3、YOLOv4、YOLOv5s、YOLOv6s、YOLOv7模型相比,YOLOv5s-CG網絡模型對寧夏荒漠草原蝗蟲具有更好的檢測性能。

3) 為方便移動端收集寧夏荒漠草原蝗蟲數據,基于YOLOv5s-CG設計并開發蝗蟲識別系統,可實現對寧夏荒漠草原蝗蟲圖像的快速準確識別,識別速度在1 s之內,可為蝗蟲防治提供數據支持和決策依據。

參 考 文 獻

[ 1 ] 馬志寧, 俞鴻千, 王穎, 等. 寧夏草原蝗蟲多樣性及其對環境因子的響應[J]. 中國生物防治學報, 2022, 38(6): 1459-1472.

Ma Zhining, Yu Hongqian, Wang Ying, et al. Diversity of grassland grasshoppers and responses to environmental factors in Ningxia [J]. Chinese Journal of Biological Control, 2022, 38(6): 1459 -1472.

[ 2 ] 王廣君, 李貝貝, 田野. 主要蝗蟲生態治理策略在我國的實踐應用[J]. 植物保護學報, 2021, 48(1): 84-89.

[ 3 ] 黃文江, 董瑩瑩, 趙龍龍, 等. 蝗蟲遙感監測預警研究現狀與展望[J]. 遙感學報, 2020, 24(10): 1270-1279.

[ 4 ] Kasinathan T, Uyyala S R. Machine learning ensemble with image processing for pest identification and classification in field crops [J]. Neural Computing & Applications, 2021, 33: 7491-7504.

[ 5 ] Lima M C F, Leandor M E D D A, Valero C, et al. Automatic detection and monitoring of insect pests-A review [J]. Agriculture, 2020, 10(5): 161.

[ 6 ] Lu S H, Ye S J. Using an image segmentation and support vector machine method for identifying two locust species and instars [J]. Journal of Integrative Agriculture, 2020, 19(5): 1301-1313.

[ 7 ] Ye S J, Lu S H, Bai X S. ResNet-Locust-BN network?based automatic identification of east asian migratory locust species and instars from RGB images [J]. Insects, 2020, 11(8): 458.

[ 8 ] Liu L M, Liu M, Meng K X, et al. Camouflaged locust segmentation based on PraNet [J]. Computers and Electronics in Agriculture, 2022, 198: 107061.

[ 9 ] Cao X, Wei Z Y, Gao Y J, et al. Recognition of common insect in field based on deep learning [J]. Journal of Physics: Conference Series, 2020, 1634: 012034.

[10] 武英潔, 房世波, Piotr Chudzik, 等. 基于 Faster R-CNN 的野外環境中蝗蟲快速識別[J]. 氣象與環境學報, 2020, 36(6): 137-143.

[11] 李林, 柏召, 刁磊, 等. 基于 K-SSD-F的東亞飛蝗視頻檢測與計數方法[J]. 農業機械學報, 2021, 52(S1): 261-267.

Li Lin, Bai Zhao, Diao Lei, et al. Video detection and counting method of east Asian migratory locusts based on K-SSD-F [J]. Transactions of the Chinese Society for Agricultural Machinery, 2021, 52(S1): 261-267.

[12] 馬宏興, 張淼, 董凱兵, 等. 基于改進YOLO v5的寧夏草原蝗蟲識別模型研究[J]. 農業機械學報, 2022, 53(11): 270-279.

Ma Hongxing, Zhang Miao, Dong Kaibing, et al. Research of locust recognition in Ningxia grassland based on improved YOLOv5 [J]. Transactions of the Chinese Society for Agricultural Machinery, 2022, 53(11): 270-279.

[13] Li Y H, Yao T, Pan Y W, et al. Contextual transformer networks for visual recognition [J]. arXiv preprint arXiv: 2107. 12292, 2021.

[14] Liu Y C, Shao Z, Hoffmann N. Global attention mechanism: Retain information to enhance channel?spatial interactions [J]. arXiv preprint arXiv: 2112. 05561, 2021.

[15] 朱猛蒙, 黃文廣, 張蓉, 等. 寧夏草原蝗蟲適生區和分布區劃分[J]. 植物保護學報, 2021, 48(1): 237-238.

[16] Liu Z, Lin Y T, Cao Y, et al. Swin transformer: HierarchicalsHelIni7P04Qy0Xbt0g3fw== vision transformer using shifted windows [C]. Proceedings of the IEEE/CVF International Conference on Computer Vision, 2021: 10012-10022.

[17] Girshick R. Fast R-CNN [J]. arXiv preprint arXiv: 1804. 02767, 2018.

[18] Redmon J, Farhadi A. YOLOv3: An incremental improvement [J]. arXiv preprint arXiv: 1504. 08083, 2015.

[19] Bochkovskiy A, Wang C Y, Liao H Y M. YOLO v4: Optimal speed and accuracy of object detection [J]. arXiv preprint arXiv: 1504. 08083, 2015.

[20] 馬宏興, 董凱兵, 王英菲, 等. 基于改進YOLOv5s的輕量化植物識別模型研究[J]. 農業機械學報, 2023, 54(8): 267-276.

Ma Hongxing, Dong Kaibing, Wang Yingfei, et al. Research on lightweight plant recognition model based on improved YOLOv5s [J]. Transactions of the Chinese Society for Agricultural Machinery, 2023, 54(8): 267-276.

[21] 羅小權, 潘善亮. 改進YOLOV3的火災檢測方法[J]. 計算機工程與應用, 2020, 56(17): 187-196.

Luo Xiaoquan, Pan Shanliang. Improved YOLOV3 fire detection method [J]. Computer Engineering and Applications, 2020, 56(17): 187-196.

[22] 高菊玲. 基于多視圖特征融合的植物病害識別算法[J]. 中國農機化學報, 2020, 41(12): 147-152.

Gao Juling. Recognition algorithm of plant disease based on multi?view feature fusion [J]. Journal of Chinese Agricultural Mechanization, 2020, 41(12): 147-152.