融合卷積神經網絡與顏色分割的青菜雜草識別

摘要:雜草種類繁多且分布隨機導致雜草識別難度大、準確率低和實時性差。為此,提出一種基于深度卷積神經網絡的青菜雜草識別方法。首先,利用深度卷積神經網絡模型對切分后的網格圖像進行青菜識別,以此排除青菜網格圖像。進而運用圖像處理技術對不包含青菜的網格進行圖像分割,識別出不含綠色像素的背景網格圖像,并將剩下的網格圖像標記為雜草圖像。試驗結果表明:DenseNet模型、RegNet模型和ShuffleNet模型在測試集識別青菜的總體準確率均高于0.965,展現良好的識別效果。識別速度方面,ShuffleNet模型具有最高的計算效率,識別單張原始圖像僅耗時14.12 ms,相應幀率為70.84 fps,滿足實時雜草識別應用需求。識別青菜進而區分雜草與土壤,有效降低雜草識別的復雜度,同時提高雜草識別準確率。

關鍵詞:青菜;雜草識別;卷積神經網絡;深度學習;顏色分割

中圖分類號:S634; TP391.41 文獻標識碼:A 文章編號:2095?5553 (2024) 11?0215?06

Identification of vegetable weeds by using convolutional neural networks and

color segmentation

Jin Huiping1, Zhu Wenpeng2, Liu Teng3, Yu Jialin3, Jin Xiaojun3, 4

(1. Engineering Training Center,Nanjing Forestry University, Nanjing, 210037, China;

2. School of Computer Science, Universiti Sains Malaysia, Penang, 11800, Malaysia;

3. Institute of Advanced Agricultural Sciences, Peking University, Weifang, 261325, China;

4. College of Mechanical and Electronic Engineering, Nanjing Forestry University, Nanjing, 210037, China)

Abstract: A wide variety and random distribution of weed species made weed identification challenging, resulting in low accuracy and poor real?time performance. In order to address this issue, a method based on deep convolutional neural networks for identifying spinach weeds was proposed. Initially, a deep convolutional neural network model was used to recognize spinach in segmented grid images, which helped in excluding grid images containing spinach. Subsequently, image processing techniques were applied to segment grid images without spinach, and background grid images lacking green pixels were identified, leaving the remaining grid images marked as weed images. Experimental results showed that the DenseNet model, RegNet model, and ShuffleNet model achieved overall spinach recognition accuracy above 0.965 on the test set, demonstrating excellent identification performance. Regarding recognition speed, the ShuffleNet model exhibited the highest computational efficiency, taking only 14.12 ms to recognize a single original image, corresponding to a frame rate of 70.84 fps, meeting the demands of real?time weed identification applications. By distinguishing spinach and differentiating weeds from soil, the complexity of weed identification was effectively reduced, while the weed identification accuracy was also enhanced.

Keywords: vegetable; weed identification; convolutional neural network; deep learning; color segmentation

0 引言

青菜是我國農業種植中僅次于糧食作物的第2大農作物[1]。雜草與青菜爭奪生長資源,導致青菜減產。據統計,青菜田間雜草約有1 400余種,其中對青菜造成嚴重危害的雜草有130多種[2]。雜草防控是農業生產中的重要環節,對提高作物產量與品質至關重要。當前雜草防除方法仍然主要依賴人工除草。人工除草耗時費力,不僅推高了農作物的種植成本,同時也限制了農業產業的發展[3, 4]。

我國正處于傳統農業向現代農業轉型的關鍵時期,在人工智能技術及物聯網技術的大背景下,農業將實現全面自動化和智能化。其中,自動化精準除草是未來農業發展的必然趨勢[5, 6],而快速精準的作物和雜草識別是實現精準除草的前提。近年來,眾多科研工作者對雜草識別進行了廣泛研究[7?9],Herrmann等[10]使用高光譜成像技術獲取麥田圖像,通過最小二乘法分類器區分小麥與雜草。Nieuwenhuizen等[11]結合顏色與紋理特征,采用自適應貝葉斯分類器對固定光照和變化光照條件下的甜菜進行分類,識別率分別為89.8%和67.7%。鄧立苗等[12]通過提取玉米葉片的顏色、形狀和紋理3類共48個特征,利用支持向量機SVM(Support Vector Machines)進行模型的設計和識別。傳統雜草識別方法通常根據顏色、形狀、紋理和空間分布等特征或這些特征的組合使用小波分析、貝葉斯判別模型和支持向量機等區分作物和雜草[13, 14],此類方法需要人工選取特征,多依賴設計者的經驗,易受小樣本和人為主觀因素的影響。由于光照變化、背景噪聲、目標形態多樣性等因素,難以設計出適應性好、穩定性高的特征提取模型。隨著深度學習技術的發展,深度卷積神經網絡(Deep Convolutional Neural Network,DCNN)在機器視覺領域得到廣泛應用并取得良好的效果。Adel等[15]利用支持向量機(Support Vector Machine,SVM)和人工神經網絡,以甜菜及其伴生的4種常見雜草為研究對象,融合多形狀特征實現雜草識別,準確率達95%。王璨等[16]提出基于移位窗口Transformer網絡的識別方法,可用于識別苗期玉米和雜草。其采用4種模型進行實時識別,平均識別率高達95.04%。孫哲等[17]采用Faster R-CNN模型對自然環境下的西蘭花幼苗進行識別,平均精度為91.73%。基于深度卷積神經網絡的雜草識別方法需要采集大量不同種類雜草的圖像進行模型訓練,雜草種類眾多,訓練集數據庫搭建成本極其高昂。以往研究表明,即便采用深度學習方法,也只能精準識別有限種類的雜草[18?20]。

為降低雜草識別復雜度,同時提高雜草識別精度,本文提出一種基于深度卷積神經網絡的青菜雜草識別方法。以苗期青菜及其伴生雜草為研究對象,首先將相機采集的原始圖像均勻劃分為若干網格圖像,利用深度卷積神經網絡模型識別出包含青菜的網格圖像,剩余的網格圖像再根據圖像處理結果進一步區分為雜草網格和土壤背景網格。

1 材料與方法

1.1 圖像采集

試驗圖像分兩批采集自江蘇省南京市棲霞區某青菜種植園內。圖像采集設備為佳能EOS600D數碼相機,采用垂直拍攝方式,相機距離地面約60 cm,圖像分辨率1 792像素×1 344像素,格式為JPEG。為保證神經網絡模型訓練樣本的多樣性,采集了不同播種時間的青菜田,以及晴天、陰天等不同光線狀態下的樣本實體。

1.2 數據集劃分

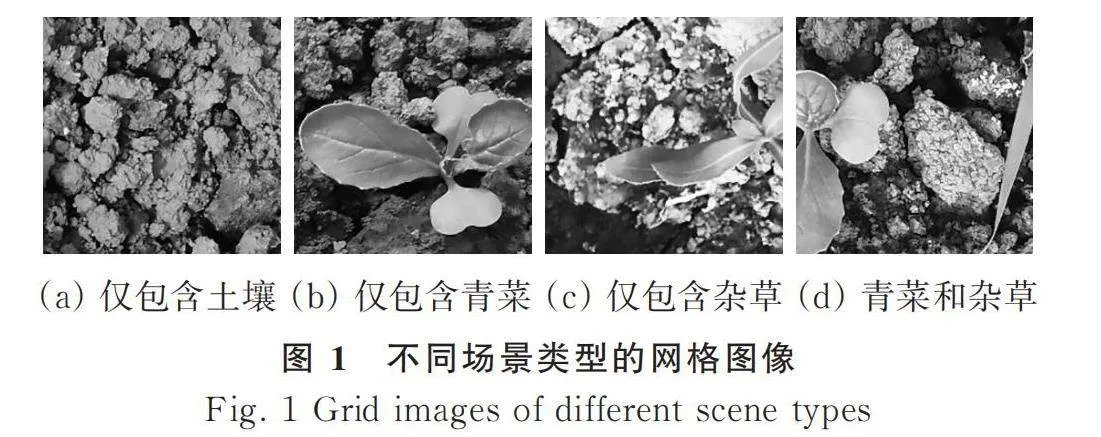

將原始圖像數據切分成網格子圖像,經人工分類共計12 400張。切分后的網格圖像可歸類為4種類別(圖1):僅包含土壤、僅包含青菜、僅包含雜草、既包含青菜又包含雜草。將僅包含青菜和既包含青菜又包含雜草的網格圖像歸類為正樣本(青菜),將僅包含土壤和僅包含雜草的網格圖像歸類為負樣本(背景)。采用分離驗證法,將數據樣本按照比例隨機分為訓練集、驗證集和測試集,劃分后訓練集青菜和背景網格圖像各5 000張,驗證集青菜和背景網格圖像各600張,測試集樣本數量同驗證集。

1.3 試驗方法

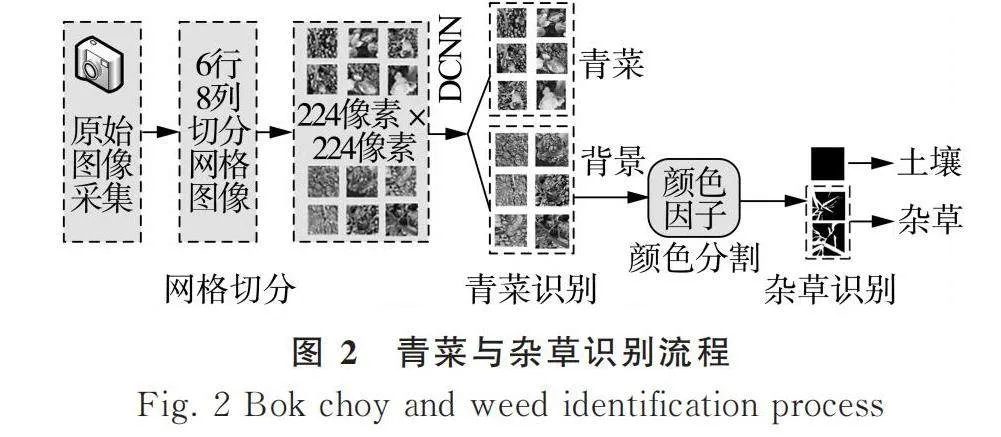

不同于以往研究中利用神經網絡模型直接識別雜草,先將圖像進行網格劃分,使用神經網絡模型識別并排除包含青菜的網格圖像,之后,剩余包含雜草以及不包含綠植的土壤背景網格則使用圖像處理方法,根據顏色特征進行區分,最終實現圖像中包含雜草區域的精準識別。雜草識別流程如圖2所示,共分為3個階段:(1)網格切分。將采集到的青菜田原始數據圖像每張按照6行8列均勻切分成48張網格圖像,每張網格圖像的分辨率為224像素×224像素。(2)青菜識別。訓練深度卷積神經網絡模型,識別出所有包含青菜的網格圖像。(3)雜草識別。利用顏色特征識別出不含綠色像素的土壤背景圖像,剩余網格圖像即為雜草。

1.4 神經網絡模型

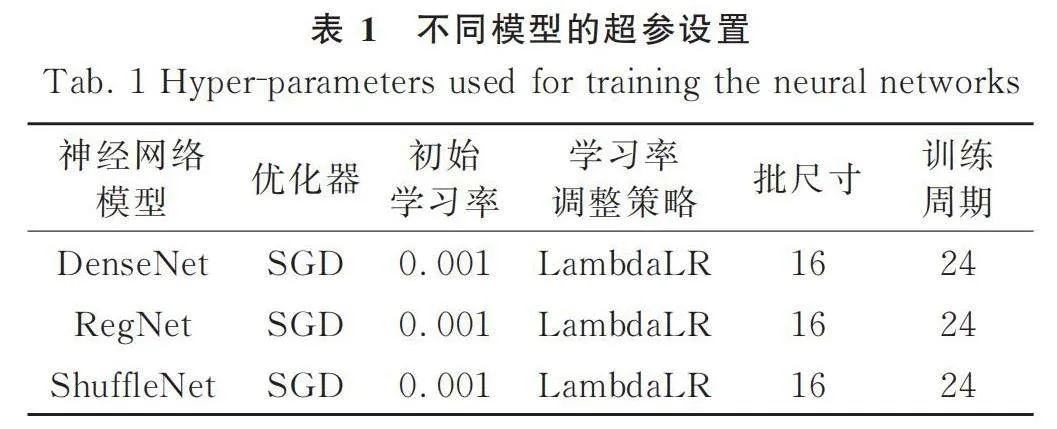

當前目標檢測算法主要基于深度卷積神經網絡(DCNN),分別選取DenseNet模型、RegNet模型和ShuffleNet模型對網格圖像中的青菜進行識別并分類。DenseNet模型[21]是一種端到端的網絡模型,其特點是在網絡層之間引入“密集連接”(Dense Connections),可以大幅減輕梯度消失問題和模型退化現象,增強了信息的傳遞效率。在DenseNet模型中,每個層都接收所有來自先前層的特征圖作為輸入,并將自己的特征圖發送到所有后續層,因此DenseNet模型從頭到尾始終保持高度連接狀態。RegNet模型[22]由Facebook AI研究團隊提出,其設計旨在通過規律化結構,提高模型的泛化性能和可擴展性。RegNet模型采用了一種“通道組合”(Channel Grouping)的結構,將每個層中的通道數分成多個細分組,通過在這些細分組之間進行分組卷積,實現了網絡的高效并行計算。ShuffleNet模型[23]是曠視科技設計的高效卷積神經網絡模型,其特點是引入了“通道重排”(Channel Shuffling)操作,利用適當的卷積操作和通道交錯結構實現高效的計算和較低的模型復雜度,另外,ShuffleNet模型還引入了“組卷積”(Group Convolution)操作,在減少參數數量的同時,增加模型可訓練性和魯棒性。各模型的默認超參設置如表1所示。

1.5 評價指標

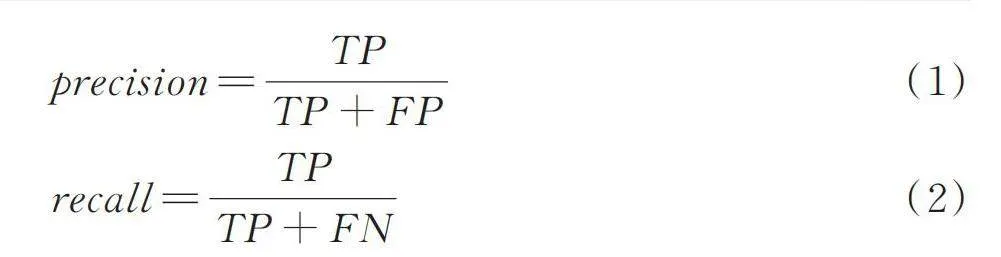

采用精度([precision])、召回率([recall])、[F1]值以及總體準確率([Overall?accuracy])作為神經網絡模型識別的評價指標。[precision]表示正確檢測出青菜目標與預測為青菜目標的比值,[recall]表示所有青菜目標被正確預測的比例。

[precision=TPTP+FP] (1)

[recall=TPTP+FN] (2)

式中: [TP]——被正確劃分為正樣本的數量;

[FP]——被錯誤劃分為正樣本的數量;

[FN]——被錯誤劃分為負樣本的數量。

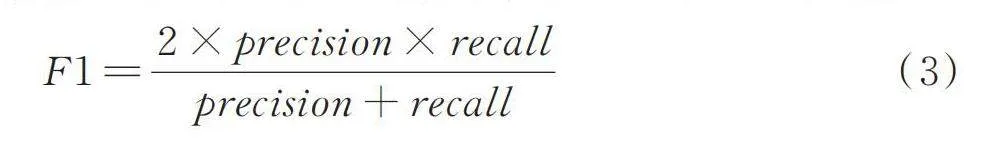

[F1]值是圖像分類中基于精度與召回率的綜合評價指標。計算方法為取精度與召回率的調和平均數。

[F1=2×precision×recallprecision+recall] (3)

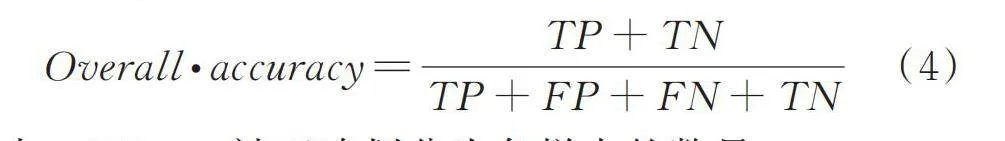

總體準確率([Overall?accuracy])是神經網絡模型預測正確的數量與總體數量之間的比值。

[Overall?accuracy=TP+TNTP+FP+FN+TN] (4)

式中: [TN]——被正確劃分為負樣本的數量。

2 試驗結果與分析

2.1 神經網絡青菜識別

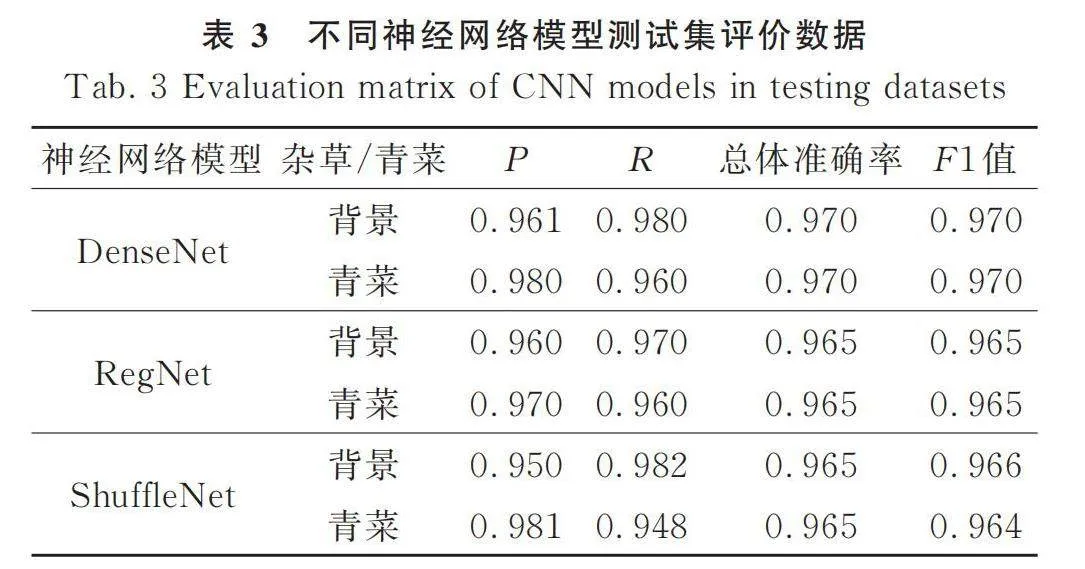

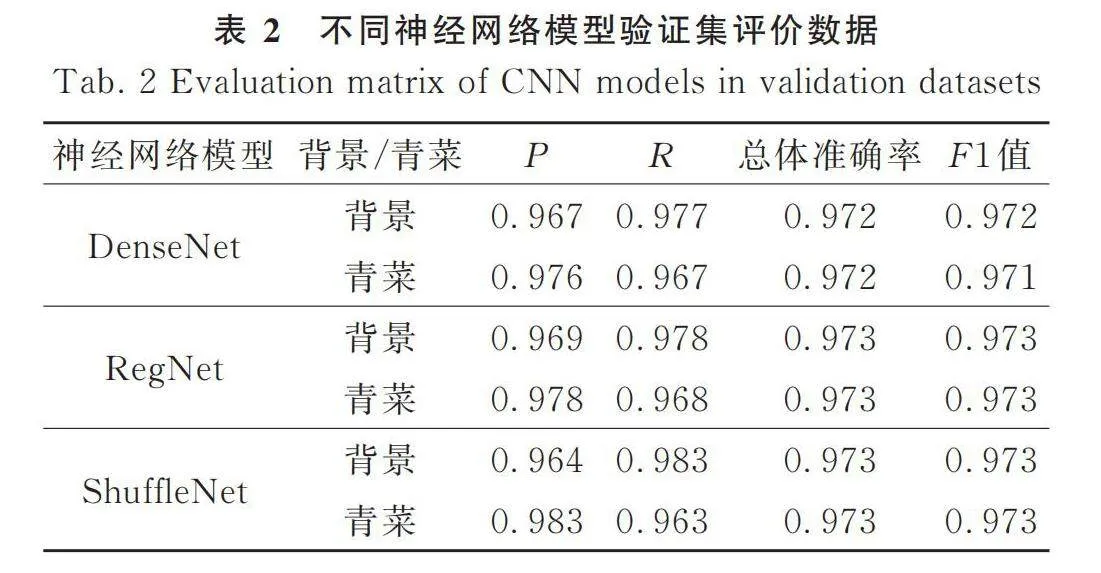

神經網絡模型識別青菜和背景的驗證集評價數據如表2所示。由表2可知,ShuffleNet模型識別青菜的精度最高(0.983),精度值越高表示其對青菜的誤識別率越低。召回率方面,ShuffleNet模型對于背景的召回率高達0.983。進一步觀察總體準確率和F1值,所有模型的總體準確率與F1值都高于0.971,表明深度卷積神經網絡可以很好地區分青菜與背景。其中,RegNet模型和ShuffleNet模型的總體準確率和F1值最高,為0.973。

表3為神經網絡模型在測試集的評價數據。相較于驗證集的結果,測試集的數據都略有下降,但各模型的總體準確率和F1值仍然高于0.964,表明神經網絡模型識別青菜具有較高的泛化能力。其中,DenseNet模型對于青菜識別的總體準確率為0.970,展現了最佳的識別效果。

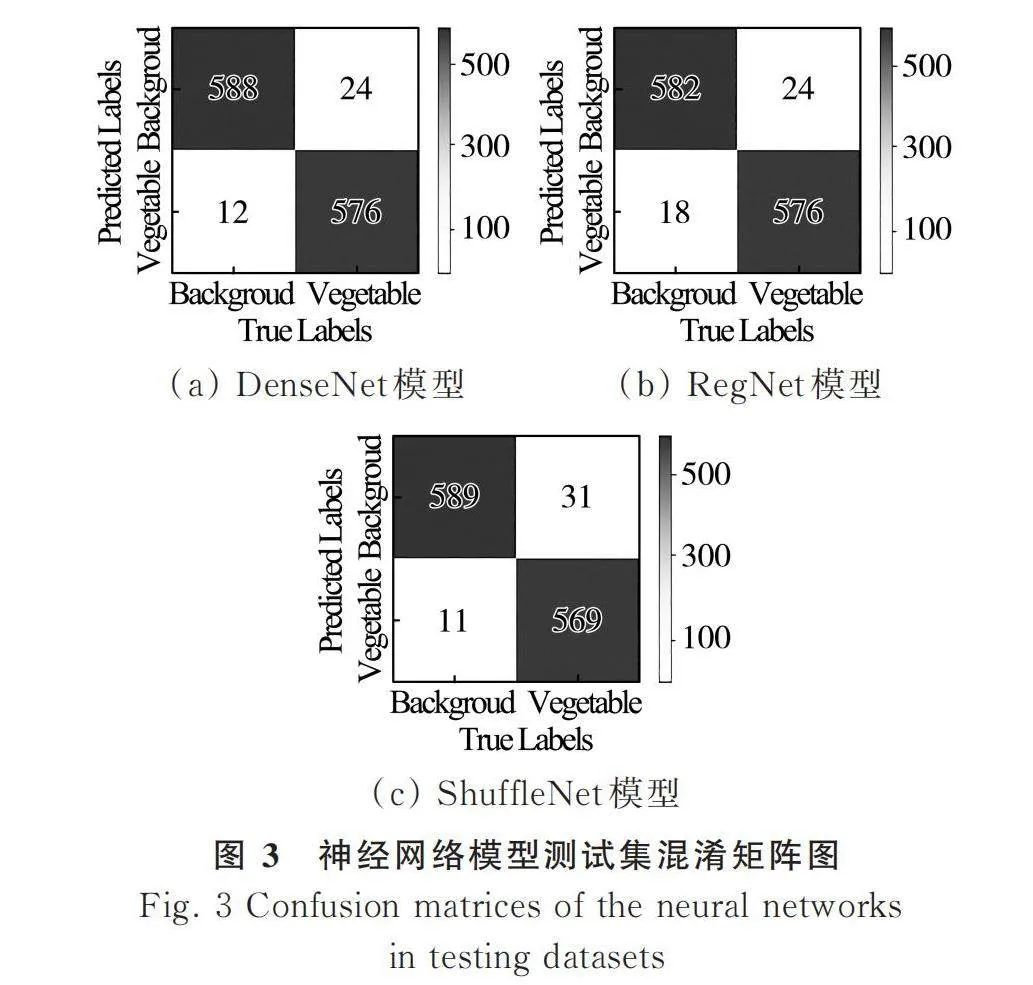

圖3為DenseNet模型、RegNet模型和ShuffleNet模型在測試集的混淆矩陣圖。可知,DenseNet模型和RegNet模型在識別青菜時,錯誤地將24張青菜圖像識別為背景圖像,且RegNet模型將18張背景圖像誤認為青菜圖像。相比較識別青菜,ShuffleNet模型更善于識別背景,僅有11張背景圖片被誤識別為青菜,而青菜被誤識別為背景的數量則有31張。

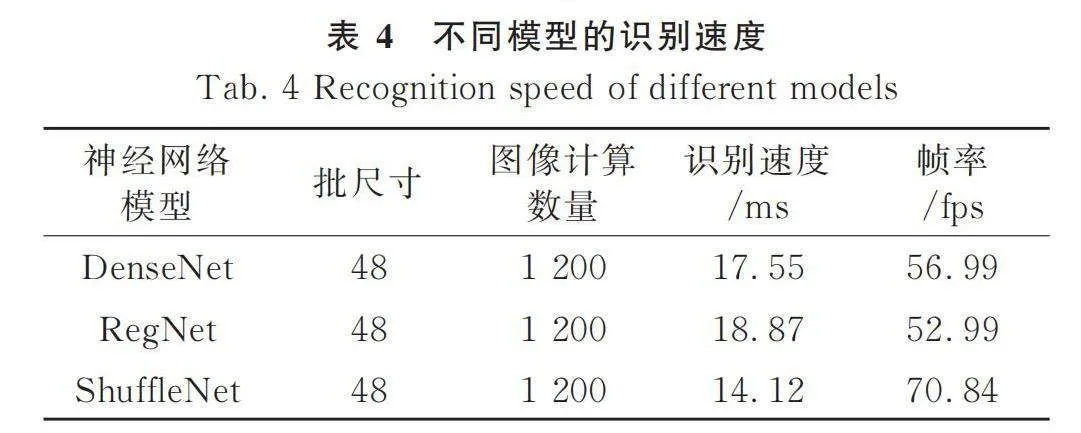

表4為DenseNet模型、RegNet模型和ShuffleNet模型的識別速度。識別速度取測試集圖像(1 200張)識別速度的平均值。由于網格圖像為相機拍攝的原始圖像按照6行8列均勻切分所得(每張原圖劃分為48張網格圖像),因而在計算識別速度時可將批尺寸設置為48,如此所得數值即為原始圖像的識別速度。

從表4可知,DenseNet模型和RegNet模型的識別速度相近,處理一張原始圖像耗時均低于18.87 ms,相應的識別幀率高于52.99 fps。相較于DenseNet和RegNet模型,ShuffleNet模型展現了最高的識別效率,其識別單張圖像僅需14.12 ms,幀率則高達70.84 fps。該試驗數據也驗證了ShuffleNet模型兼具識別精度與速度的架構特點。通常情況下,幀率高于30 fps即可認為具備實時圖像處理的能力[26],因而本研究中,所有模型均擁有實時青菜識別的能力。

2.2 顏色分割

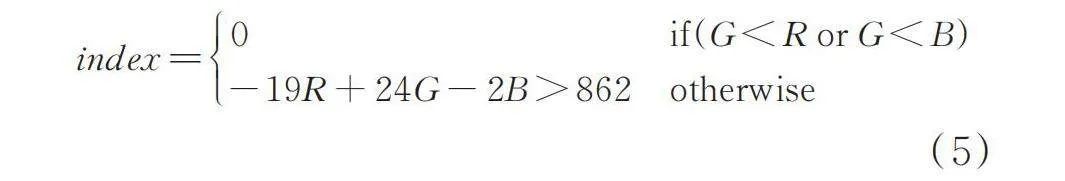

雜草與青菜顏色相近,但與土壤背景顏色差異較大。神經網格模型識別出包含青菜的網格圖像后,利用顏色分割技術將僅包含土壤的圖像和僅包含雜草的圖像進行區分,以實現最終的雜草識別。青菜和雜草在圖像中呈綠色,土壤呈黃褐色,研究采用Jin等[24]提出的超綠因子對綠色植物進行分割,并在此基礎上進行條件式改造,以進一步提升圖像分割效果。如式(5)所示,在RGB顏色空間中,青菜和雜草的G(綠色)分量大于R(紅色)分量或B(藍色)分量,遍歷網格圖像中的每個像素點,首先判斷其G分量是否小于R分量或B分量,若是,則將其像素值置為0(背景),反之,根據表達式[-19R+24G-2B>862]進行像素值計算。

[index=0if(G<R or G<B)-19R+24G-2B>862otherwise] (5)

圖像處理過程中,由于背景顏色值的影響,分割后的圖像會存在若干噪點。本研究采用面積濾波對分割后的圖像進行濾波操作以消除噪點,提升分割效果。通過計算并標記像素連通區域,將低于面積閾值的區域標記為噪點,并從圖像中移除。

2.3 雜草識別應用

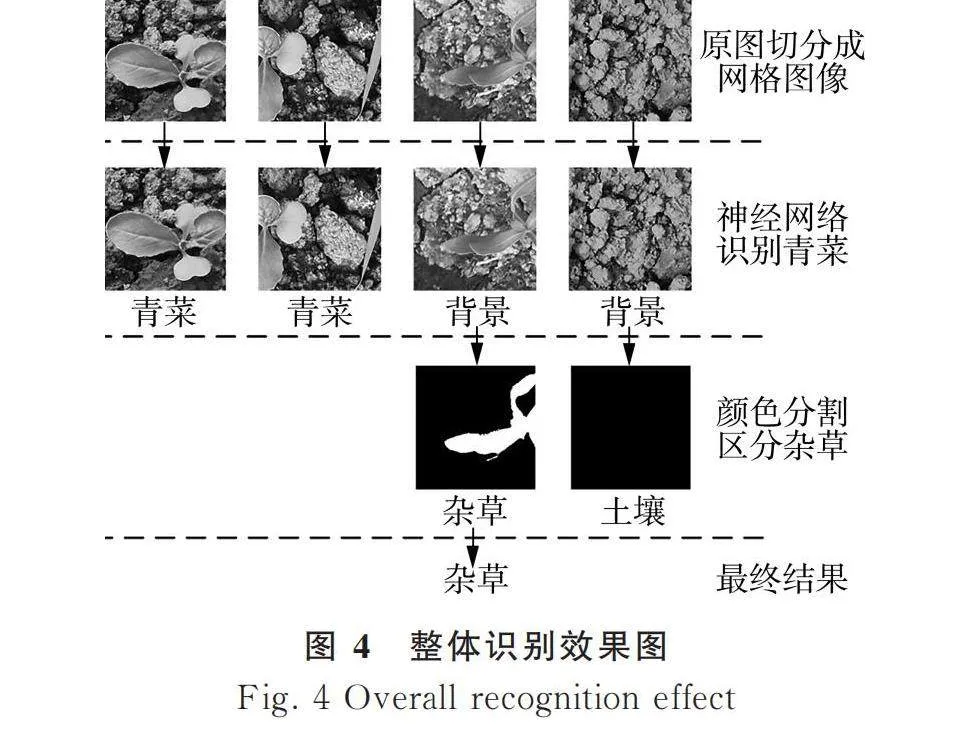

自然環境下,雜草與青菜顏色相似,極易誤識別。且兩者之間時有交錯生長,難以準確定位單顆雜草或青菜植株。本研究另辟蹊徑,將原圖劃分為若干與除草執行器作業范圍相同的網格圖像,通過識別網格圖像是否包含雜草從而實現雜草識別。整體應用流程與效果如圖4所示。

將劃分的網格圖像進行逐一識別,每個網格圖像可分為4種場景:僅包含青菜、僅包含雜草、既包含青菜又包含雜草,以及僅包含土壤。利用神經網絡模型識別并排除包含青菜的網格圖像(圖4中第1列和第2列網格圖像),剩余包含雜草和僅包含土壤背景的圖像則進一步利用顏色分割技術進行區分。由圖4可知,顏色因子以極佳的效果分割出包含綠色像素(雜草)的目標區域,而僅包含土壤的網格圖像則無任何分割效果。由此,可判定第3列為包含雜草的網格圖像。

3 討論

相較于目標檢測網絡,分類神經網絡通常精度更高,識別速度更快。但后者只能對圖像進行分類,無法判斷目標在圖像中的位置。在雜草識別中,目標檢測網絡雖能夠識別出雜草在圖像中的位置,并在目標處繪制邊界框(bounding box),然而該識別方式難以直接集成至除草執行系統。雜草大小不一,故邊界框的尺寸亦變化不定,而除草執行器的單位除草范圍往往是固定的,需要進一步將識別位置和尺寸與除草執行器的工作范圍相匹配。

本研究使用分類神經網絡識別青菜和雜草,通過識別網格圖像從而間接確定青菜和雜草的位置。每張原圖劃分為若干張網格圖像,網格尺寸確定后,其在圖像中的位置可通過計算獲取。因此,識別出所有包含雜草的網格圖像等同于識別出雜草在原圖中的區域。換而言之,本研究將雜草在原圖中的位置轉換為網格圖像在原圖中的位置,而后者的位置為已知信息。除草設備移動到雜草網格位置即可對該區域進行除草工作。在實際應用中,可根據除草機械執行器的工作范圍或噴施器的的覆蓋范圍設置網格圖像尺寸,使得除草執行器單次工作范圍為一個網格區域的尺寸。

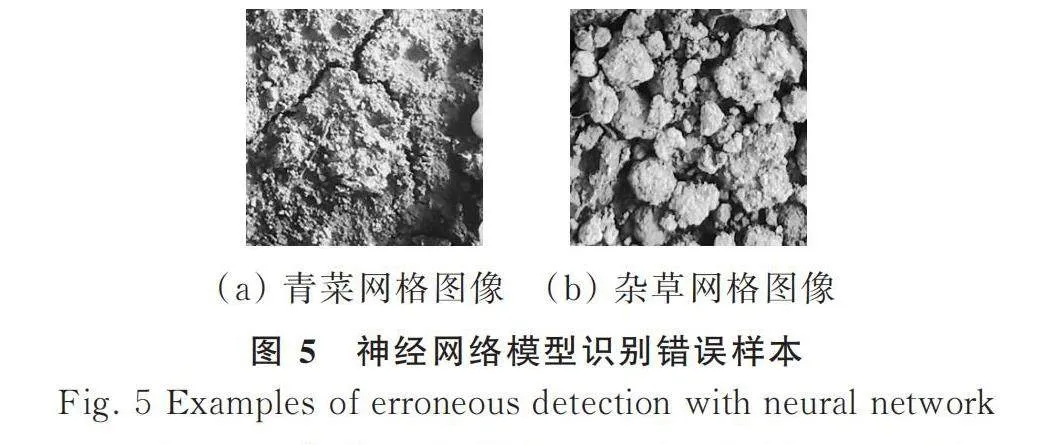

查看并分析深度卷積神經網絡模型識別錯誤的圖像,當青菜或雜草只占圖像極小部分時(圖5),模型難以正確區分其歸屬。

該場景雖降低了青菜的識別率,但并不會對除草應用產生較大影響。若青菜被誤識別為雜草,因其目標區域極小,除草執行器不會對青菜產生實質傷害;若雜草被誤識別為青菜,則該區域的雜草部分會被忽略,但處于另一網格的雜草主體部分會被識別。另外一方面,可通過提高圖像處理時的面積濾波閾值,以濾除占比較小的青菜和雜草圖像,統一作為無需除草作業的網格區域。

在利用卷積神經網絡模型識別青菜時,將網格圖像分為青菜和背景兩類。如此,只需訓練模型識別網格圖像中是否包含青菜,青菜之外的目標均為背景。即使圖像中包含種類繁多的雜草或背景物,也不會影響模型識別青菜的效果。雜草和背景雖形態多變,但青菜種類唯一,模型僅需專注并正確識別青菜即可。通過利用神經網絡模型識別青菜,而非直接識別雜草,可有效降低識別雜草的復雜度,并能夠提升神經網絡模型的識別穩健性。

按照本研究的方法,若網格圖像中既包含青菜又包含雜草,該圖像會被識別為青菜圖像。青菜,尤其是有機青菜,通常不使用除草劑噴施除草。在實際應用中,若采用機械除草方式對該區域進行除草作業會傷害作物。因此,可通過多次作業、拍攝不同位置的原圖使青菜和雜草處于不同網格中,或設置更小尺寸的網格圖像以實現更精細化的識別。

4 結論

結合深度卷積神經網絡和圖像處理技術,提出一種聚焦青菜識別進而間接區分雜草和青菜的識別方法。試驗表明,提出的雜草識別方法具有高度的可行性和極佳的應用效果,且具有降低雜草識別復雜度、減少訓練樣本庫成本和增強識別穩健性三方面的優勢。

1) DenseNet模型、RegNet模型和ShuffleNet模型均能有效區分青菜和背景目標。其中DenseNet模型在測試集的總體準確率最高,為97%。

2) DenseNet模型和RegNet模型的識別速度相近,處理一張原始圖像耗時均低于18.87 ms。ShuffleNet模型的識別速度最高,單張圖像耗時14.12 ms,相應幀率為70.84 fps。

參 考 文 獻

[ 1 ] 莫開孟, 石麗芬. 新時代背景下我國蔬菜產業發展策略分析[J]. 農村科學實驗, 2019(8): 35-36.

Mo Kaimeng, Shi Lifen. Analysis of the development strategy of China's vegetable industry in the context of the new era [J]. Scientific Experiment in Countryside, 2019(8): 35-36.

[ 2 ] 強勝. 我國雜草學研究現狀及其發展策略[J]. 植物保護, 2010, 36(4): 1-5.

Qiang Sheng. Current status and development strategy for weed science in China [J]. Plant Protection, 2010, 36(4): 1-5.

[ 3 ] Zhang Y, Staab E S, Slaughter D C, et al. Automated weed control in organic row crops using hyperspectral species identification and thermal micro?dosing [J]. Crop Protection, 2012, 41: 96-105.

[ 4 ] 李香菊. 近年我國農田雜草防控中的突出問題與治理對策[J]. 植物保護, 2018, 44(5): 77-84.

Li Xiangju. Main problems and management strategies of weeds in agricultural fields in China in recent years [J]. Plant Protection, 2018, 44(5): 77-84.

[ 5 ] 毛文華, 張銀橋, 王輝, 等. 雜草信息實時獲取技術與設備研究進展[J]. 農業機械學報, 2013, 44(1): 190-195.

Mao Wenhua, Zhang Yinqiao, Wang Hui, et al. Advance techniques and equipments for real?time weed detection [J]. Transactions of the Chinese Society for Agricultural Machinery, 2013, 44(1): 190-195.

[ 6 ] Saha D, Cregg B M, Sidhu M K. A review of non?chemical weed control practices in Christmas tree production [J]. Forests, 2020, 11(5): 554.

[ 7 ] Onyango C M, Marchant J A. Segmentation of row crop plants from weeds using colour and morphology [J]. Computers and Electronics in Agriculture, 2003, 39(3): 141-155.

[ 8 ] Cho S I, Lee D S, Jeong J Y. AE?automation and emerging technologies: Weed?plant discrimination by machine vision and artificial neural network [J]. Biosystems Engineering, 2002, 83(3): 275-280.

[ 9 ] 陳樹人, 沈寶國, 毛罕平, 等. 基于顏色特征的棉田中鐵莧菜識別技術[J]. 農業機械學報, 2009, 40(5): 149-152.

Chen Shuren, Shen Baoguo, Mao Hanping, et al. Copperleaf herb detection from cotton field based on color feature [J]. Transactions of the Chinese Society for Agricultural Machinery, 2009, 40(5): 149-152.

[10] Herrmann I, Shapira U, Kinast S, et al. Ground?level hyperspectral imagery for detecting weeds in wheat fields [J]. Precision Agriculture, 2013, 14: 637-659.

[11] Nieuwenhuizen A T, Hofstee J W, Van Henten E J. Adaptive detection of volunteer potato plants in sugar beet fields [J]. Precision Agriculture, 2010, 11: 433-447.

[12] 鄧立苗, 唐俊, 馬文杰. 基于圖像處理的玉米葉片特征提取與識別系統[J]. 中國農機化學報, 2014, 35(6): 72-75.

Deng Limiao, Tang Jun, Ma Wenjie. Feature extraction and recognition system of maize leaf based on image processing [J]. Journal of Chinese Agricultural Mechanization, 2014, 35(6): 72-75.

[13] García?Santillán I D, Montalvo M, Guerrero J M, et al. Automatic detection of curved and straight crop rows from images in maize fields [J]. Biosystems Engineering, 2017, 156: 61-79.

[14] Bakhshipour A, Jafari A, Nassiri S M, et al. Weed segmentation using texture features extracted from wavelet sub?images [J]. Biosystems Engineering, 2017, 157: 1-12.

[15] Bakhshipour A, Jafari A. Evaluation of support vector machine and artificial neural networks in weed detection using shape features [J]. Computers and Electronics in Agriculture, 2018, 145: 153-160.

[16] 王璨, 武新慧, 張燕青, 等. 基于移位窗口Transformer網絡的玉米田間場景下雜草識別[J]. 農業工程學報, 2022, 38(15): 133-142.

Wang Can, Wu Xinhui, Zhang Yanqing, et al. Recognizing weeds in maize fields using shifted window Transformer network [J]. Transactions of the Chinese Society of Agricultural Engineering, 2022, 38(15): 133-142.

[17] 孫哲, 張春龍, 葛魯鎮, 等. 基于Faster R-CNN的田間西蘭花幼苗圖像檢測方法[J]. 農業機械學報, 2019, 50(7): 216-221.

Sun Zhe, Zhang Chunlong, Ge Luzheng, et al. Image detection method for broccoli seedlings in field based on Faster R-CNN [J]. Transactions of the Chinese Society for Agricultural Machinery, 2019, 50(7): 216-221.

[18] Hasan A S M M, Sohel F, Diepeveen D, et al. A survey of deep learning techniques for weed detection from images [J]. Computers and Electronics in Agriculture, 2021, 184: 106067.

[19] Meeradevi, Sindhu N, Monica R M. Machine learning in agriculture application: Algorithms and techniques [J]. International Journal of Innovative Technology and Exploring Engineering, 2020, 9(6): 1140-1146.

[20] Osorio K, Puerto A, Pedraza C, et al. A deep learning approach for weed detection in lettuce crops using multispecthsjeHXRT9AxLuv0wPZvJ1Q==ral images [J]. AgriEngineering, 2020, 2(3): 471-488.

[21] Huang G, Liu Z, Van Der Maaten L, et al. Densely connected convolutional networks [C]. Proceeding of the IEEE Conference on Computer Vision and Pattern Recognition, 2017: 4700-4708.

[22] 林海濤, 鄭群浩, 林嘉儀, 等. 基于RegNet網絡的巖石圖像模式識別[J]. 現代信息科技, 2022, 6(14): 63-66.

[23] Zhang X, Zhou X, Lin M, et al. ShuffleNet: An extremely efficient convolutional neural network for mobile devices [C]. Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2018: 6848-6856.

[24] Jin X, Che J, Chen Y. Weed identification using deep learning and image processing in vegetable plantation [J]. IEEE Access, 2021, 9: 10940-10950.

[25] Lee R B. Realtime MPEG video via software decompression on a PA-RISC processor [C]. Digest of Papers. COMPCON'95. Technologies for the Information Superhighway. IEEE, 1995: 186-192.