基于深層神經(jīng)網(wǎng)絡(luò)的信道編碼類型盲識別

摘 要:

為了解決當(dāng)前識別算法只能識別一種或者兩種碼字類型以及人工提取特征復(fù)雜的問題,提出了兩種基于深層神經(jīng)網(wǎng)絡(luò)模型的信道編碼類型識別器,即卷積神經(jīng)網(wǎng)絡(luò)(convolutional neural network, CNN)識別器和遞歸CNN (recursive CNN, RCNN)識別器,用于識別接收數(shù)據(jù)中不同類型的信道碼字。將待識別的軟解調(diào)序列作為自然語言處理中文本分類問題的句子向量進(jìn)行處理,輸入到預(yù)先訓(xùn)練好的深層神經(jīng)網(wǎng)絡(luò)識別器中進(jìn)行識別,并分析了字長度對識別準(zhǔn)確率的影響,得出了最合適的字長度。實(shí)驗(yàn)結(jié)果表明,兩種識別器都能夠有效識別接收數(shù)據(jù)中多種類型的信道編碼,且在信噪比為3 dB時(shí)CNN識別器的識別準(zhǔn)確率能夠達(dá)到99%以上,而RCNN識別器在1 dB時(shí)就能夠達(dá)到99%以上的識別準(zhǔn)確率。

關(guān)鍵詞:

深層神經(jīng)網(wǎng)絡(luò); 信道編碼識別器; 盲識別; 字長度

中圖分類號:

TN 911.7

文獻(xiàn)標(biāo)志碼: A""" DOI:10.12305/j.issn.1001-506X.2024.05.35

Blind identification of channel coding types based on deep neural networks

YANG Zongfang1,2,*, ZHANG Tianqi1,2, MA Kunran1,2, ZOU Han1,2

(1. School of Communication and Information Engineering, Chongqing University of Posts and Telecommunications,

Chongqing 400065, China; 2. Chongqing Key Laboratory of Signal and Information Processing,

Chongqing University of Posts and Telecommunications, Chongqing 400065, China)

Abstract:

In order to solve the problem that the current recognition algorithm can only recognize one or two code types and the complexity of manually extracting features, two channel coding type recognizers based on the deep neural network model are proposed, namely, convolutional neural network (CNN) recognizer and recursive CNN (RCNN) recognizer, used to identify different types of channel codewords in received data. The soft demodulation sequence to be recognized is treated as the sentence vector of text classification in natural language processing, input into the pre trained deep neural network recognizer for recognition, and analyze the influence of word length on recognition accuracy, and obtain the most appropriate word length. The experimental results show that both types of recognizers can effectively recognize various types of channel codes in the received data, and the recognition accuracy of the CNN recognizer can reach over 99% when the signal-to-noise ratio is 3 dB, while the RCNN recognizer can achieve over 99% recognition accuracy at 1 dB.

Keywords:

deep neural networks; channel code recognizer; blind identification; word length

0 引 言

信道碼的盲識別技術(shù)[1-2]是信道編碼領(lǐng)域的一個(gè)重要難題。在數(shù)字通信過程中,接收端合作方由于知道先驗(yàn)信息可以對信道傳輸過來的信息進(jìn)行解調(diào)、譯碼等操作恢復(fù)出發(fā)送方傳輸?shù)男畔ⅰH欢诜呛献髑闆r下,信道編碼的類型是未知信息。這就給研究人員帶來了一個(gè)挑戰(zhàn),即如何對信道碼類型進(jìn)行識別,以保證后續(xù)能夠正確譯碼。深層神經(jīng)網(wǎng)絡(luò)可以用來處理一維序列多分類問題,例如文本分類問題[3],由于碼字具有一維序列的特性,因此可以將深層神經(jīng)網(wǎng)絡(luò)應(yīng)用到碼字序列的多分類任務(wù)當(dāng)中。

在當(dāng)前的信道編碼盲識別的研究中,大多數(shù)學(xué)者都只研究各種碼字的參數(shù)識別問題,如文獻(xiàn)[4]提出了使用基于對數(shù)似然比(log likelihood ratio, LLR)的方法來識別閉集下的低密度奇偶校驗(yàn) (low density parity check, LDPC)碼。文獻(xiàn)[5]通過尋找最小碼字重量的方法來識別開集中的LDPC碼。文獻(xiàn)[6]結(jié)合伽羅華域的特點(diǎn),重點(diǎn)研究了BCH(Bose-Chaudhuri-Hocquenghem)碼的識別。文獻(xiàn)[7]和文獻(xiàn)[8]都通過極化碼的特征來識別不同極化碼的碼長、信息位數(shù)等參數(shù)。目前,國內(nèi)外針對碼字類型識別的研究較少,文獻(xiàn)[9]通過計(jì)算接收信號矩陣的秩比來區(qū)分線性分組碼、卷積碼,但該方法不能確定來自相同碼族的信道碼的類型。所以說大多數(shù)傳統(tǒng)方法只能識別一種或者兩種碼字類型,而且需要復(fù)雜的人工提取碼字特征的過程。

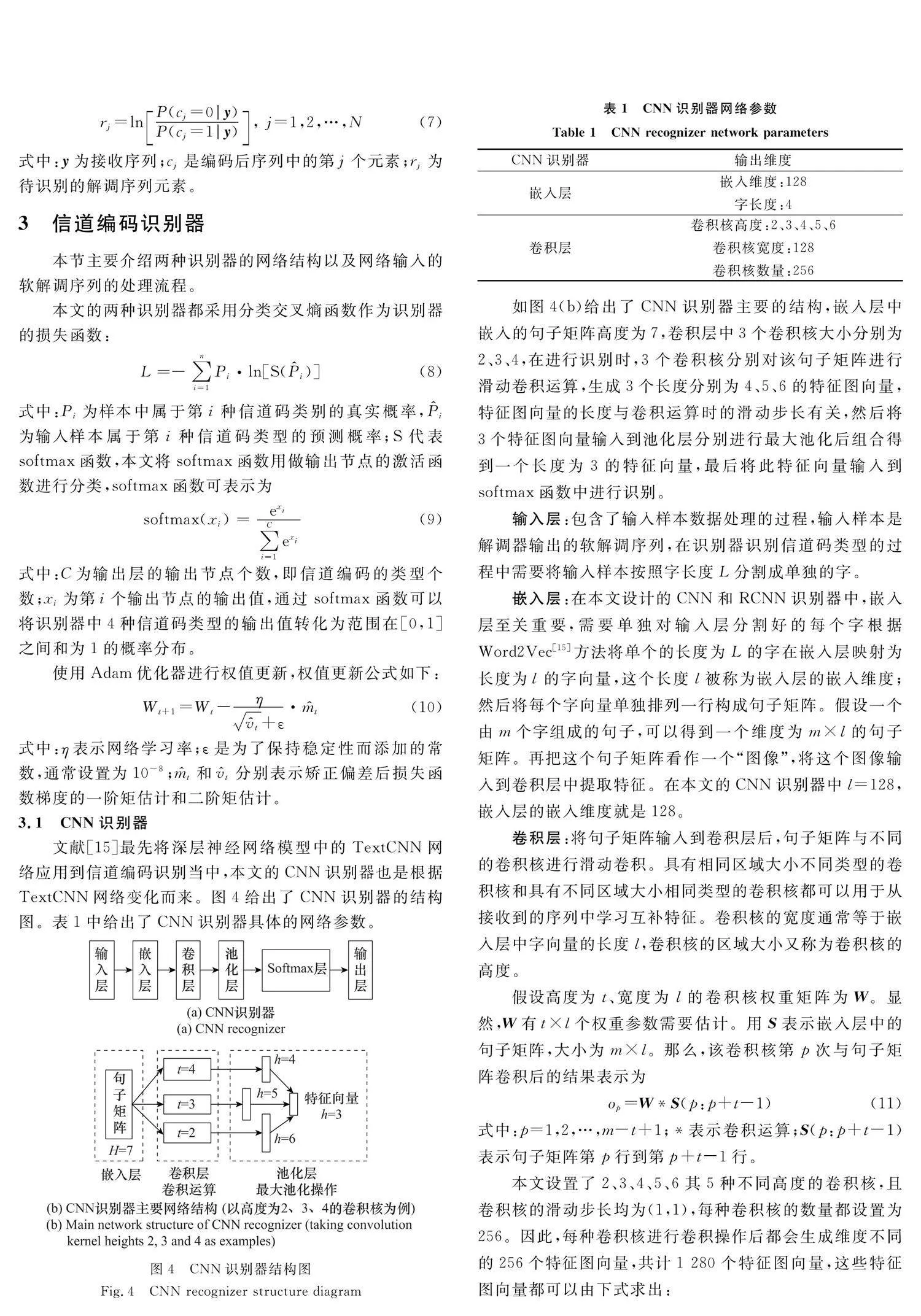

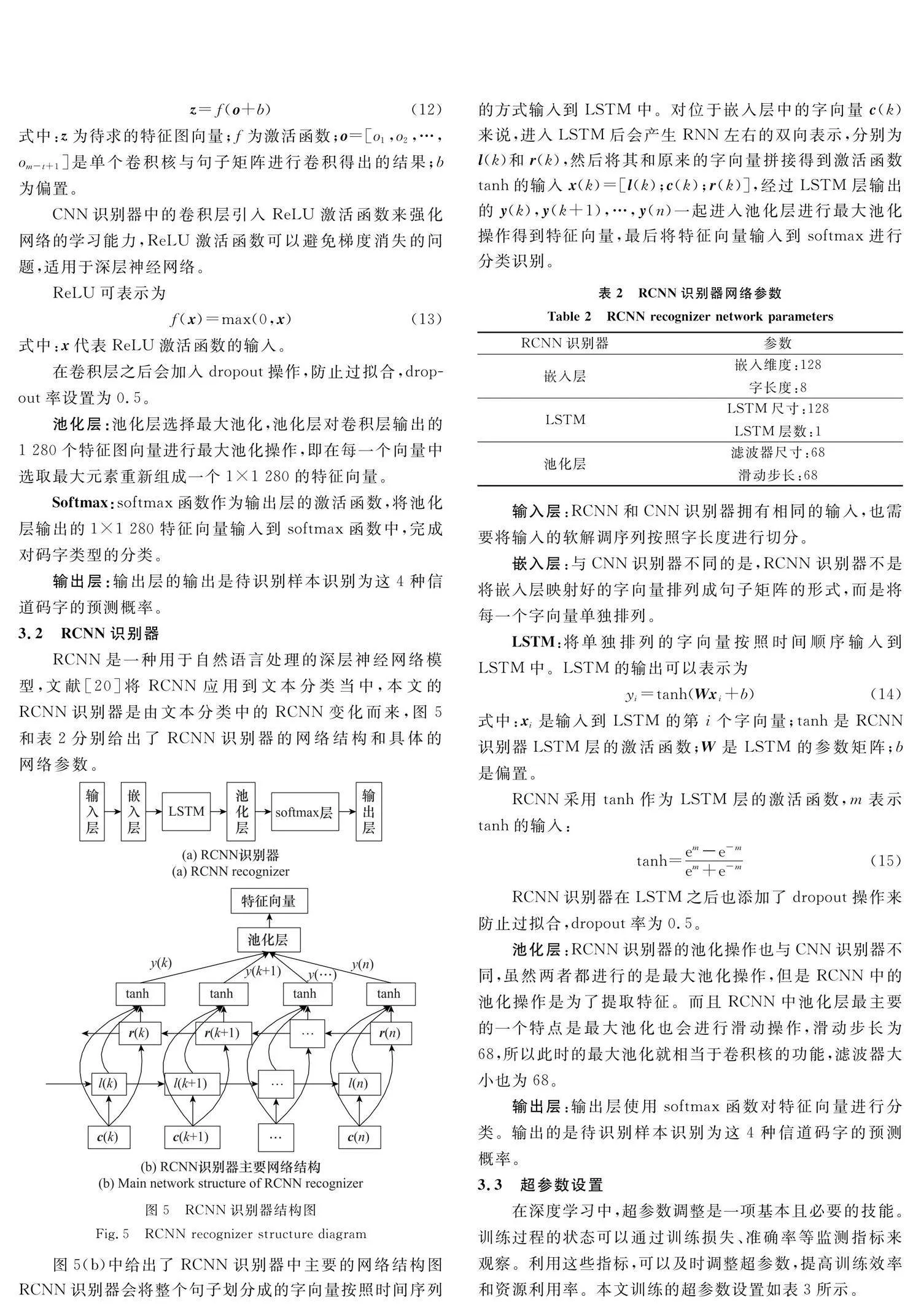

文獻(xiàn)[10]利用深度學(xué)習(xí)中的時(shí)序卷積網(wǎng)絡(luò),將碼字作為時(shí)間序列進(jìn)行分析,完成對卷積碼的閉集識別。雖然該方法不需要復(fù)雜的人工提取碼字特征的過程,但是仍然只識別了一種信道碼字。文獻(xiàn)[11-12]通過設(shè)置多個(gè)神經(jīng)網(wǎng)絡(luò)識別器來識別不同的信道編碼類型以及編碼參數(shù),雖然能識別兩種以上的碼字,但是所需的識別器數(shù)量也是線性增加。文獻(xiàn)[13]將雙向長短時(shí)記憶網(wǎng)絡(luò)(bidirectional long short term memory, BiLSTM)和卷積神經(jīng)網(wǎng)絡(luò)(convolutional neural network, CNN)結(jié)合,對3種不同的信道碼字進(jìn)行了有效識別。文獻(xiàn)[14]對傳統(tǒng)循環(huán)神經(jīng)網(wǎng)絡(luò)(recurrent neural network, RNN)進(jìn)行了改進(jìn),改進(jìn)后的網(wǎng)絡(luò)能夠有效識別4種不同的碼字類型。文獻(xiàn)[15]最先將文本分類網(wǎng)絡(luò)應(yīng)用到信道編碼盲識別中,將接收到的序列視為句子,用TextCNN模型對卷積碼進(jìn)行識別,識別效果優(yōu)于傳統(tǒng)方法。文獻(xiàn)[16]在此基礎(chǔ)上分析了TextCNN塊機(jī)制和嵌入維度對信道碼分類精度的影響。本文考慮到信道碼字與文本分類中的字向量都具有一維序列的特性,因此將信道編碼識別的任務(wù)轉(zhuǎn)化為用深層神經(jīng)網(wǎng)絡(luò)進(jìn)行分類的問題,對輸入的軟解調(diào)序列按照字長度進(jìn)行分段,將分段后的序列視為句子,將該句子輸入到神經(jīng)網(wǎng)絡(luò)中進(jìn)行分類識別,本文提出了基于深層神經(jīng)網(wǎng)絡(luò)模型的CNN和遞歸型CNN(recursive CNN, RCNN)識別器來對4種不同的信道編碼類型進(jìn)行識別,這4種信道編碼分別是5G新無線(5G new radio, 5G-NR)中的LDPC碼、卷積碼、極化碼、Turbo碼。實(shí)驗(yàn)結(jié)果表明,這兩種識別器都能夠有效識別4種碼字,并且識別精度優(yōu)于現(xiàn)有的神經(jīng)網(wǎng)絡(luò)識別器。

1 4種信道碼字

1.1 5G-NR中LDPC碼編碼

LDPC碼屬于線性分組碼,常用(n, k)表示。5G-NR中LDPC碼采用準(zhǔn)循環(huán)LDPC,其中基矩陣BG是LDPC對應(yīng)的奇偶校驗(yàn)矩陣設(shè)計(jì)的前提。BG矩陣有兩個(gè),BG1大小為46×68,適用于長碼塊高碼率的LDPC碼;BG2大小為42×52,適用于短碼塊低碼率的LDPC碼。可以通過下式來確定LDPC的BG矩陣:

4 實(shí)驗(yàn)及結(jié)果分析

4.1 數(shù)據(jù)集生成

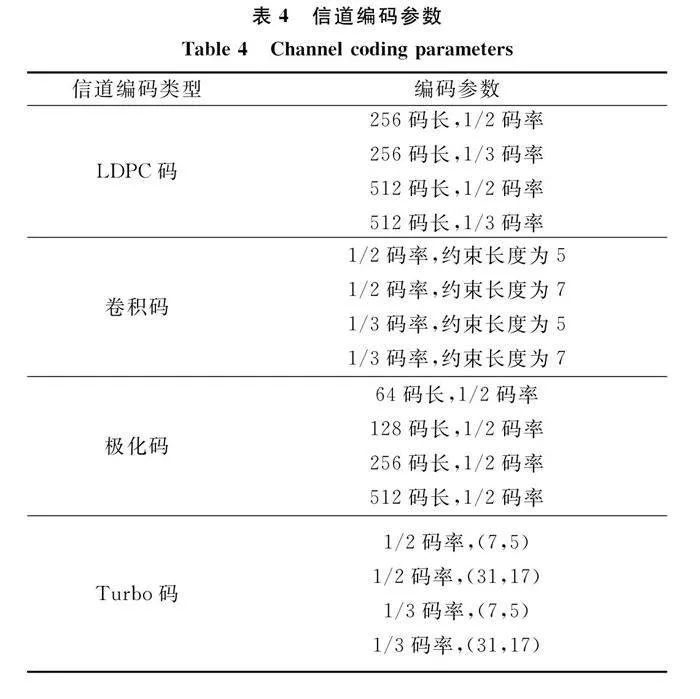

深度學(xué)習(xí)可以定義為數(shù)據(jù)和模型驅(qū)動(dòng)的算法,其識別性能會(huì)受到數(shù)據(jù)集大小和數(shù)據(jù)分布多樣性的影響。首先構(gòu)造待識別的信道碼候選集合Θ={C0,C1,C2,C3},其中集合Θ由4種不同類型的信道碼組成,分別為LDPC碼、卷積碼、極化碼和Turbo碼,表4給出了不同碼字具體的編碼參數(shù)。本文使用仿真軟件生成具有這4種類型信道碼的編碼數(shù)據(jù)集用于仿真,數(shù)據(jù)集生成主要包括3個(gè)步驟:首先,本文使用表4所示的編碼參數(shù)對隨機(jī)信息序列進(jìn)行編碼,Turbo碼參數(shù)中的(7,5)和(31,17)代表不同的生成多項(xiàng)式。然后,對編碼后的信號進(jìn)行二進(jìn)制相移鍵控(binary phase shift keying, BPSK)調(diào)制,并通過AWGN信道進(jìn)行傳輸。最后,利用BPSK解調(diào)器對信道接收信號進(jìn)行解調(diào),解調(diào)后的軟信息序列構(gòu)成數(shù)據(jù)集。單個(gè)樣本的信噪比(signal to noise ratio, SNR)為-4~10 dB的隨機(jī)值。

其中每種類型信道碼解調(diào)后的序列生成80 000個(gè)長度為540的樣本,共320 000個(gè)樣本,保證每一個(gè)樣本都是從碼字起點(diǎn)開始生成。將這些樣本按照8∶2的比例分為訓(xùn)練集和驗(yàn)證集。然后在相同的條件下生成SNR為-4~10 dB的測試集,每個(gè)信噪比下生成64 000個(gè)樣本來進(jìn)行測試。

4.2 訓(xùn)練損失圖

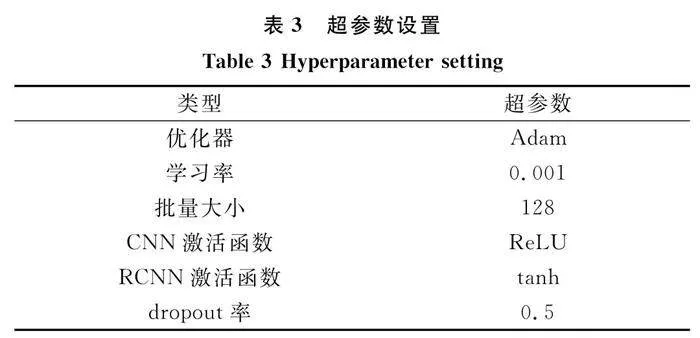

將生成的數(shù)據(jù)集分別送入兩種識別器中進(jìn)行訓(xùn)練和驗(yàn)證。圖6給出了CNN和RCNN兩種識別器的訓(xùn)練損失曲線。從圖中可以看出,在訓(xùn)練630個(gè)批量之前,CNN損失曲線要比RCNN損失曲線收斂更快;630個(gè)批量之后,RCNN損失曲線收斂更快。最終RCNN率先達(dá)到訓(xùn)練終止條件(1 000個(gè)批量訓(xùn)練后測試損失不再減小),損失曲線不再收斂。

4.3 評價(jià)指標(biāo)

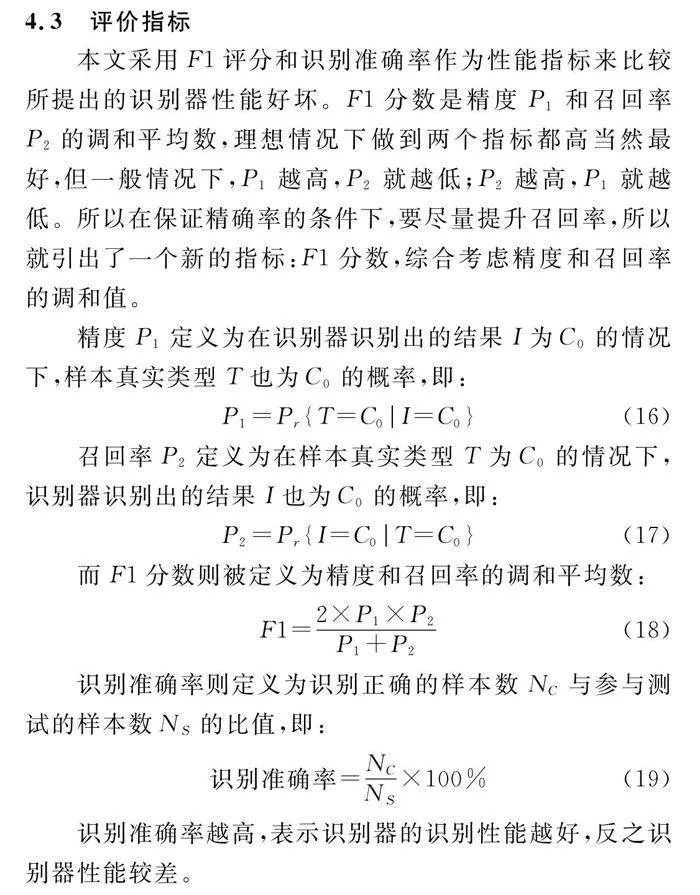

本文采用F1評分和識別準(zhǔn)確率作為性能指標(biāo)來比較所提出的識別器性能好壞。F1分?jǐn)?shù)是精度P1和召回率P2的調(diào)和平均數(shù),理想情況下做到兩個(gè)指標(biāo)都高當(dāng)然最好,但一般情況下,P1越高,P2就越低;P2越高,P1就越低。所以在保證精確率的條件下,要盡量提升召回率,所以就引出了一個(gè)新的指標(biāo):F1分?jǐn)?shù),綜合考慮精度和召回率的調(diào)和值。

精度P1定義為在識別器識別出的結(jié)果I為C0的情況下,樣本真實(shí)類型T也為C0的概率,即:

P1=Pr{T=C0|I=C0}(16)

召回率P2定義為在樣本真實(shí)類型T為C0的情況下,識別器識別出的結(jié)果I也為C0的概率,即:

P2=Pr{I=C0|T=C0}(17)

而F1分?jǐn)?shù)則被定義為精度和召回率的調(diào)和平均數(shù):

F1=2×P1×P2P1+P2(18)

識別準(zhǔn)確率則定義為識別正確的樣本數(shù)NC與參與測試的樣本數(shù)NS的比值,即:

識別準(zhǔn)確率=NCNS×100%(19)

識別準(zhǔn)確率越高,表示識別器的識別性能越好,反之識別器性能較差。

4.4 字長度選擇

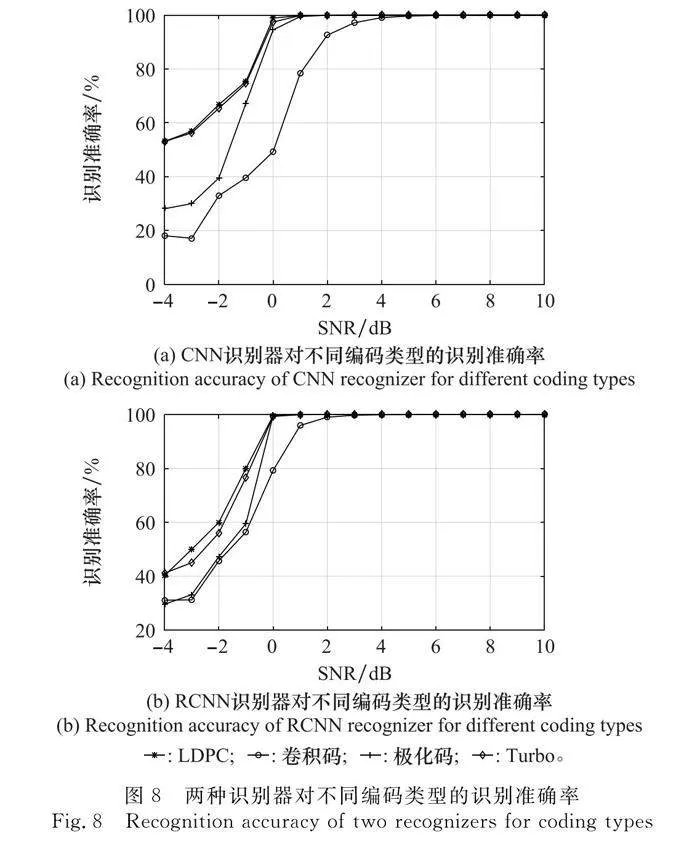

與直接使用軟解調(diào)序列作為輸入的傳統(tǒng)深度學(xué)習(xí)方法不同的是,文本分類網(wǎng)絡(luò)使用以最小單元字構(gòu)成的句子作為網(wǎng)絡(luò)的輸入,因此如何將軟解調(diào)序列切割成“字”對網(wǎng)絡(luò)訓(xùn)練的準(zhǔn)確性有很大的影響。本文將分析從1到10這10種不同的字長度。如圖7所示。為了更加嚴(yán)謹(jǐn),本文將采用實(shí)驗(yàn)驗(yàn)證的方法,對從1到10不同字長度L在SNR為-4~10 dB的情況下對兩種識別器的識別準(zhǔn)確率進(jìn)行比較,以探究字長度對識別器性能的影響。

如圖7所示,除字長度L=1外,所有字長度曲線的識別準(zhǔn)確率都隨著SNR的增加而提高。結(jié)果表明,當(dāng)SNR為3 dB時(shí),字長度為4的CNN識別器比其他字長度的CNN識別器更早達(dá)到99%的識別準(zhǔn)確率;當(dāng)SNR為1 dB時(shí),字長度為8的RCNN識別器比其他字長度的RCNN識別器更快達(dá)到99%以上的識別準(zhǔn)確率。從整體上來看,RCNN識別器在不同字長度下(L=1除外)基本上都能夠達(dá)到98%以上的識別率,而CNN識別器只有在字長度L為4、6、8、10時(shí)才能夠達(dá)到98%以上的識別率,所以從識別準(zhǔn)確率上來看CNN識別器性能略低于RCNN識別器。

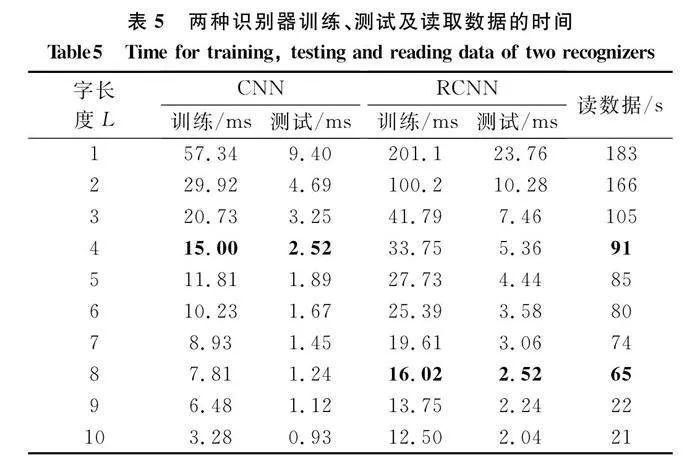

此外,本文還將對不同字長度下的識別器的訓(xùn)練、測試及讀取數(shù)據(jù)所需的時(shí)間進(jìn)行比較,以探究字長度對識別器時(shí)間復(fù)雜度的影響。表5給出了兩種識別器在不同字長度下進(jìn)行訓(xùn)練單個(gè)樣本、測試單個(gè)樣本和訓(xùn)練時(shí)讀取所有數(shù)據(jù)所需要的時(shí)間。

由表5可知,訓(xùn)練、測試以及讀取數(shù)據(jù)的時(shí)間都會(huì)隨著字長度的增加而減少。由圖7可知CNN在L=4時(shí)識別性能最好,RCNN識別器在L=8時(shí)識別性能最好,而在表5中CNN在L=4時(shí)的訓(xùn)練和測試時(shí)間與RCNN在L=8時(shí)的訓(xùn)練和測試時(shí)間非常接近,并且在達(dá)到最高準(zhǔn)確率的情況下兩個(gè)識別器的訓(xùn)練及測試時(shí)間都在可接受范圍內(nèi)。綜上分析,本文選擇字長度L=4為CNN識別器的最優(yōu)字長度,字長度L=8作為RCNN識別器的最優(yōu)字長度。

4.5 兩種識別器對于不同編碼類型的識別性能

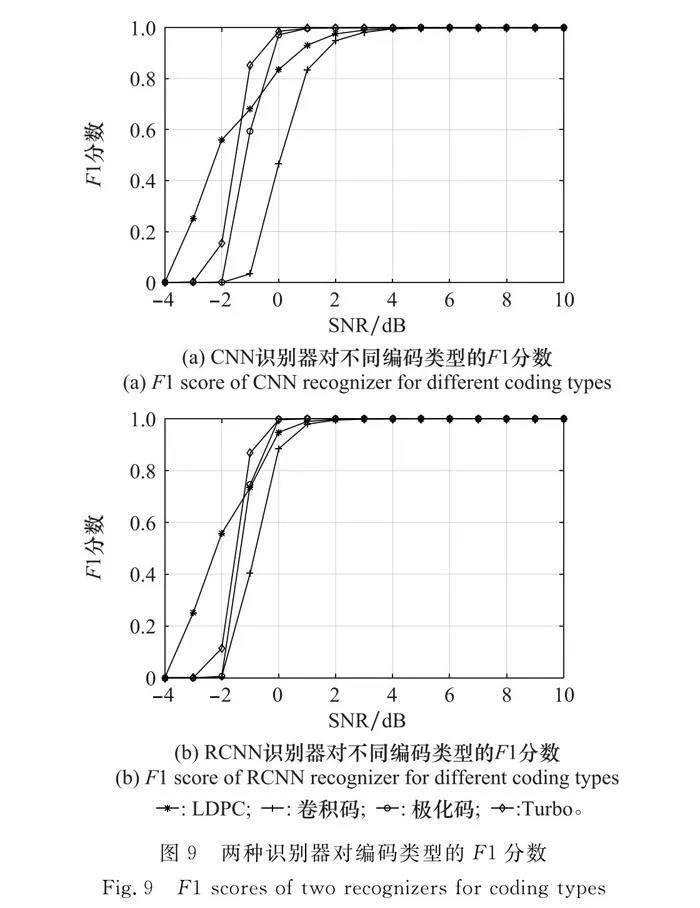

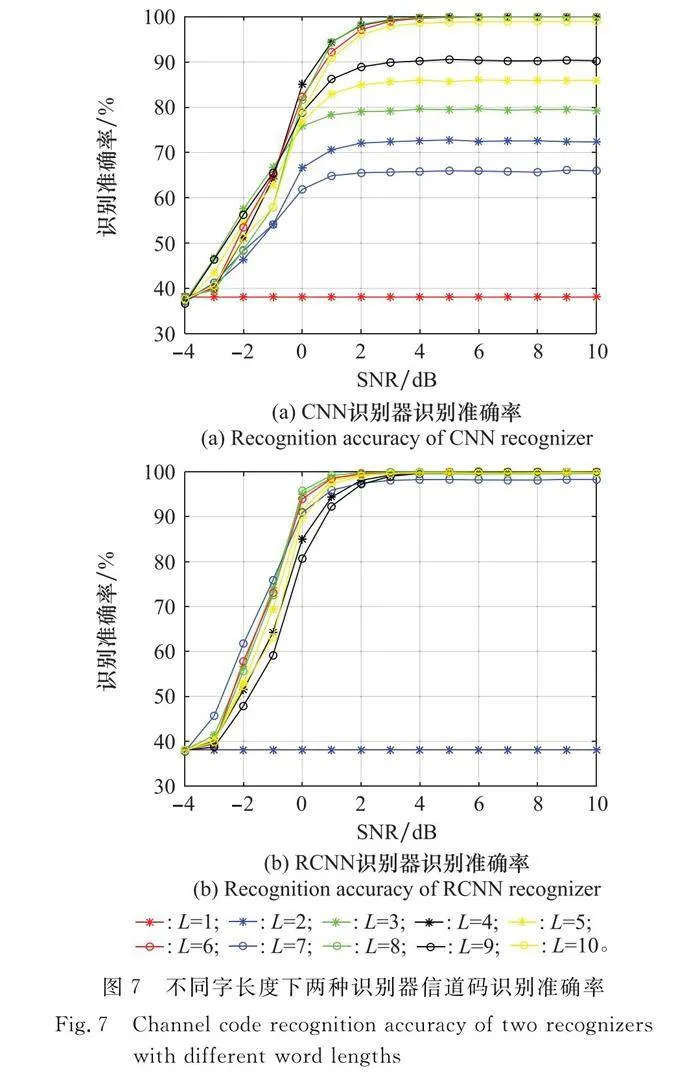

本文通過識別準(zhǔn)確率和F1分?jǐn)?shù)來比較兩種編碼器對不同編碼類型信道碼的識別性能,首先根據(jù)表4中的參數(shù)生成在SNR為-4~10 dB不同類型的64 000個(gè)信道碼樣本來進(jìn)行測試,圖8和圖9分別表示了兩種識別器對不同編碼類型信道碼的識別準(zhǔn)確率和F1分?jǐn)?shù)隨著SNR變化的曲線。

分析圖8可知,對于兩種識別器來說,不同類型的信道碼識別準(zhǔn)確率都會(huì)隨著SNR的增加而增加,并且都能夠達(dá)到99%以上的準(zhǔn)確率,這表明了兩種識別器對識別不同類型信道碼的有效性。在低SNR區(qū)域,LDPC碼的識別準(zhǔn)確率都要高于其他類型的碼字,這是因?yàn)楸疚闹蠰DPC的碼字較長,且碼字的校驗(yàn)位分布較為規(guī)律,所以這兩種識別器都能夠較好地識別出LDPC碼。對比圖8(a)和圖8(b)可以發(fā)現(xiàn),CNN識別器在SNR為1 dB時(shí)LDPC碼、極化碼和Turbo碼的識別準(zhǔn)確率能夠達(dá)到99%以上,卷積碼在4 dB時(shí)準(zhǔn)確率能夠達(dá)到99%以上;而RCNN在SNR為0 dB時(shí)前3種碼字的識別率就能夠達(dá)到99%以上,卷積碼在SNR為2 dB時(shí)也能夠達(dá)到99%以上。

F1分?jǐn)?shù)可以評估識別器的性能好壞,F(xiàn)1分?jǐn)?shù)越高,識別器性能就越好。圖9給出了兩種識別器的F1分?jǐn)?shù)。由圖(9)中可以看出F1分?jǐn)?shù)也會(huì)隨著SNR的增加而增加,SNR在-2 dB以下時(shí),LDPC碼的F1分?jǐn)?shù)較高,這也可以從識別準(zhǔn)確率中看出,SNR在-2 dB以下時(shí),LDPC碼的準(zhǔn)確率要略高于其他碼字。隨著SNR的增加,Turbo碼的F1分?jǐn)?shù)最先到達(dá)最高,且CNN識別器在4 dB時(shí)所有編碼類型都能夠達(dá)到最高的F1分?jǐn)?shù),RCNN識別器在2 dB時(shí)所有類型的信道碼就能夠達(dá)到最高的F1分?jǐn)?shù)。

綜上分析,CNN和RCNN兩種識別器都能夠有效地識別出不同編碼類型的信道碼,根據(jù)兩者識別準(zhǔn)確率和F1分?jǐn)?shù)的對比可以發(fā)現(xiàn)RCNN識別器的性能要優(yōu)于CNN識別器性能。

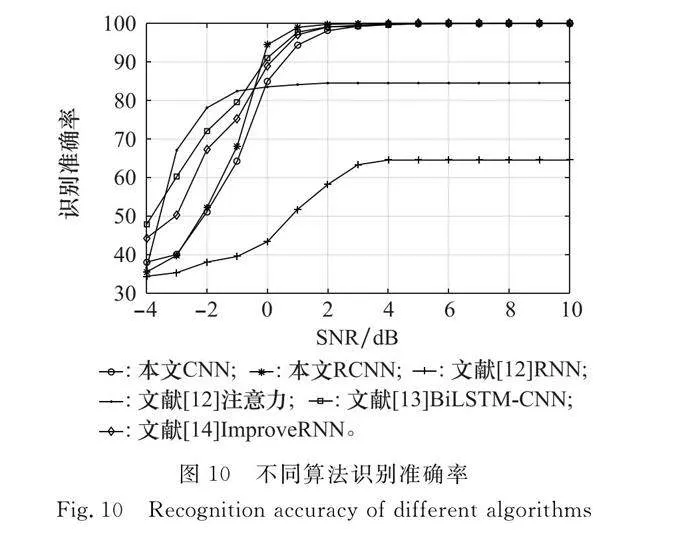

4.6 不同算法的性能對比

將本文提出的兩種識別器與文獻(xiàn)[12]中提出的其中兩種識別器(RNN識別器和注意力識別器)、文獻(xiàn)[13]中的BiLSTM-CNN和文獻(xiàn)[14]中的ImproveRNN進(jìn)行對比。圖10給出了4種識別器的平均識別準(zhǔn)確率隨SNR增加的曲線。

由圖10分析可知,本文CNN、本文RCNN均優(yōu)于文獻(xiàn)[12]中RNN性能。在低SNR區(qū)域時(shí)本文提出的CNN和RCNN識別器的平均識別準(zhǔn)確率要低于文獻(xiàn)[12]的注意力識別器,但SNR大于0 dB的情況下均高于注意力識別器。文獻(xiàn)[13]的BiLSTM模型和文獻(xiàn)[14]的ImproveRNN性能要優(yōu)于本文CNN。SNR在0 dB以下時(shí),注意力識別器模型、BiLSTM模型和ImproveRNN網(wǎng)絡(luò)模型的識別率都會(huì)大于本文提出的兩種識別器模型。但是SNR在0 dB以上的區(qū)域內(nèi),本文提出的RCNN識別性能更好,并且能更快到達(dá)99%的平均識別準(zhǔn)確率。本文提出的兩種識別器準(zhǔn)確率隨著SNR的提高都能夠達(dá)到99%以上的識別率。需要注意的是CNN識別器達(dá)到99%以上的識別率是在SNR為3 dB時(shí),而RCNN識別器在1 dB時(shí)就能夠達(dá)到99%以上的識別率。鑒于在低SNR區(qū)域這幾種識別器的識別準(zhǔn)確率都較低,并不能夠進(jìn)行良好的識別,而較高SNR下本文RCNN準(zhǔn)確率要高于其他的識別器,所以本文提出的RCNN識別器識別準(zhǔn)確率要優(yōu)于其他的網(wǎng)絡(luò)模型。

接下來分析幾種網(wǎng)絡(luò)模型的時(shí)間復(fù)雜度,表6給出了4種識別器訓(xùn)練單個(gè)樣本、測試單個(gè)樣本和讀取輸入數(shù)據(jù)所需的時(shí)間。

根據(jù)表6分析可以得到對于讀取數(shù)據(jù)來說其他網(wǎng)絡(luò)模型所耗費(fèi)的時(shí)間相同且都少于本文提出的識別器,這是因?yàn)楸疚奶岢龅倪@兩種識別器會(huì)對輸入的樣本先進(jìn)行字長度切割,然后對每一個(gè)字進(jìn)行128維的嵌入操作,這會(huì)使原本的樣本變成一個(gè)句子矩陣,相當(dāng)于擴(kuò)大了樣本的特征,這也是本文提出的兩種識別器要優(yōu)于文獻(xiàn)[12]RNN和注意力識別器的一個(gè)原因,當(dāng)然嵌入操作導(dǎo)致增加維度之后就會(huì)使讀取數(shù)據(jù)所需的時(shí)間增加。文獻(xiàn)[12]的注意力識別器以及文獻(xiàn)[13]、文獻(xiàn)[14]不論是訓(xùn)練還是測試樣本的時(shí)間都要多于本文提出的兩種識別器。RNN識別器雖然在訓(xùn)練和測試所消耗的時(shí)間上有很大優(yōu)勢,但是根據(jù)圖10可知RNN識別器在整個(gè)SNR增加的過程中識別正確率并未超過70%;反觀CNN和RCNN識別器的訓(xùn)練和測試時(shí)間都要比注意力識別器少,并且從識別正確率來看本文提出的兩種識別器也要優(yōu)于注意力識別器。

5 結(jié)束語

本文提出了兩種基于文本分類網(wǎng)絡(luò)的識別器,通過利用CNN和RCNN的特征提取能力,選擇這兩種網(wǎng)絡(luò)作為信道編碼類型識別的模型,進(jìn)一步分析了字長度對識別性能的影響,并且為這兩種識別器都選擇了最合適的字長度。由實(shí)驗(yàn)分析可知,這兩種識別器都能夠有效地識別出4種不同類型的碼字,并且避免了復(fù)雜的人工提取特征的過程。與其他神經(jīng)網(wǎng)絡(luò)模型相比,本文的CNN和RCNN識別器的識別性能更好。在接下來的工作中可以將CNN和RCNN識別器應(yīng)用到信道編碼參數(shù)識別和信道編碼類型與調(diào)制方式聯(lián)合識別當(dāng)中。

參考文獻(xiàn)

[1] 閆華. 信道編碼盲識別技術(shù)研究[D]. 長沙: 國防科技大學(xué), 2018.

YAN H.Research on blind identification technology of channel coding[D]. Changsha: National University of Defense Technology, 2018.

[2] 解輝, 黃知濤, 王豐華. 信道編碼盲識別技術(shù)進(jìn)展[J]. 電子學(xué)報(bào), 2013, 41(6): 1166-1176.

XIE H, HUANG Z T, WANG F H. Research progress of channel coding blind identification technology[J]. Journal of Electronics, 2013, 41(6): 1166-1176.

[3] YANG S, TANG Y. Text classification based on convolutional neural network and attention model[C]∥Proc.of the International Conference on Artificial Intelligence and Big Data, 2020: 67-73.

[4] XIA T, WU H C. Novel blind identification of LDPC codes using average LLR of syndrome a posteriori probability[J]. IEEE Trans.on Signal Processing, 2014, 62(3): 632-640.

[5] 于沛東, 彭華, 鞏克現(xiàn), 等. 基于尋找小重量碼字算法的LDPC碼開集識別[J]. 通信學(xué)報(bào), 2017, 38(6): 108-117.

YU P D, PENG H, GONG K X, et al. LDPC code open set reco-gnition based on searching for low-weight codeword algorithm[J]. Journal of Communications, 2017, 38(6): 108-117.

[6] WU G, ZHANG B N, WEN X, et al. Blind recognition of BCH code based on Galois field Fourier transform[C]∥Proc.of the International Conference on Wireless Communications amp; Signal Processing, 2015.

[7] 王垚, 王聰, 王翔, 等. 一種基于軟判決的非刪余極化碼參數(shù)識別算法[J]. 系統(tǒng)工程與電子技術(shù), 2023, 45(10): 3291-3299.

WANG Y, WANG C, WANG X, et al. A parameter recognition algorithm for non censored polarization codes based on soft decision[J]. Systems Engineering and Electronic Technology, 2023, 45(10): 3291-3299.

[8] 劉鑒興, 張?zhí)祢U, 柏浩鈞, 等. 基于信息矩陣估計(jì)的極化碼參數(shù)盲識別算法[J]. 系統(tǒng)工程與電子技術(shù), 2022, 44(2): 668-676.

LIU J X, ZHANG T Q, BAI H J, et al. Blind identification algorithm for polarization code parameters based on information matrix estimation[J]. Systems Engineering and Electronic Technology, 2022,44(2): 668-676.

[9] SWAMINATHAN R, MADHUKUMAR A S. Classification of error correcting codes and estimation of interleaver parameters in a noisy transmission environment[J]. IEEE Trans.on Broadcasting, 2017, 63(3): 463-478.

[10] 陶志勇, 閆明豪, 劉影. 基于時(shí)序卷積網(wǎng)絡(luò)的信道編碼閉集識別[J]. 華中科技大學(xué)學(xué)報(bào)(自然科學(xué)版), 2022, 50(3): 12-17.

TAO Z Y, YAN M H, LIU Y. Channel coding closed set reco-gnition based on temporal convolutional network[J]. Journal of Huazhong University of Science and Technology (Natural Science Edition), 2022, 50(3): 12-17.

[11] SHEN B X, HUANG C, XU W J, et al. Blind channel codes recognition via deep learning[J]. IEEE Journal on Selected Areas in Communications, 2021, 39(8): 2421-2433.

[12] SHEN B X, WU H Y, HUANG C. Blind recognition of channel codes via deep learning[C]∥Proc.of the IEEE Global Conference on Signal and Information Processing, 2019.

[13] HUANG X R, SUN S J, YANG X, et al. Recognition of channel codes based on BiLSTM-CNN[C]∥Proc.of the 31st Wireless and Optical Communications Conference, 2022: 151-154.

[14] MEI F, CHEN H, LEI Y K. Blind recognition of forward error correction codes based on recurrent neural network[J]. Sensors, 2021, 21(11): 3884.

[15] QIN X F, PENG S L,YANG X, et al. Deep learning based channel code identification using TextCNN[C]∥Proc.of the IEEE International Symposium on Dynamic Spectrum Access Networks, 2019.

[16] LI S D, ZHOU J, HUANG Z P, et al. Recognition of error correcting codes based on CNN with block mechanism and embedding[J]. Digital Signal Processing, 2021, 111: 102986.

[17] ARIKAN E, TELATAR E. On the rate of channel polarization[C]∥Proc.of the IEEE International Symposium on Information Theory, 2009: 1493-1495.

[18] ARIKAN E. Channel polarization: a method for constructing capacity-achieving codes for symmetric binary-input memoryless channels[J]. IEEE Trans.on Information Theory, 2009, 55(7): 3051-3073.

[19] WOODARD J P, HANZO L. Comparative study of turbo decoding techniques: an overview[J]. IEEE Trans.on Vehicular Technology, 2000, 49(6): 2208-2233.

[20] LAI S W, XU L H, LIU K, et al. Recurrent convolutional neural networks for text classification[C]∥Proc.of the AAAI Conference on Artificial Intelligence, 2015.

作者簡介

楊宗方(1998—),男,碩士研究生,主要研究方向?yàn)樾诺谰幋a盲識別技術(shù)研究。

張?zhí)祢U(1971—),男,教授,博士,主要研究方向?yàn)橥ㄐ判盘柕恼{(diào)制解調(diào)與盲處理、圖像與語音信號處理、神經(jīng)網(wǎng)絡(luò)實(shí)現(xiàn)、現(xiàn)場可編程邏輯門陣列實(shí)現(xiàn)和超大規(guī)模集成電路實(shí)現(xiàn)。

馬焜然(1999—),男,碩士研究生,主要研究方向?yàn)閿?shù)字水印、信息隱藏。

鄒 涵(1998—),男,碩士研究生,主要研究方向?yàn)橥ㄐ判盘柮ぬ幚怼?/p>