TRNet:基于遙感影像的三通道區域增強變化檢測網絡

摘 要:遙感影像變化檢測任務是遙感領域的研究重心之一,目前大多為深度學習方法,主要采用單通道或孿生網絡提取特征,能夠較為有效地提取變化特征。但是隨著遙感影像分辨率的不斷升高,單一化的特征提取方式易受無關細節信息的影響,從而導致檢測結果中變化和未變化區域分割能力不足。為此,提出一種全新的三通道區域增強變化檢測網絡,從多個角度增強特征提取能力。首先構建了三通道區域增強編碼器,利用三個特征提取通道定向提取相似性信息、全面性信息和差異性信息,并且在編碼器每個層級使用區域分離增強模塊,能夠將通道1和3增強通道2,有利于取得更好的變化區域分割效果;其次設計了層級交互指導融合解碼器,通過高層級特征和低層級特征之間的交互指導,實現不同層級特征間的有效融合;最后使用基于信息熵的自適應權重來優化損失函數,通過給高熵區域更多的關注,來改善網絡模型的訓練過程。在常用數據集上的實驗結果表明,與對比網絡相比,所提網絡能夠取得更優的檢測精度。

關鍵詞:遙感; 變化檢測; 深度學習; 區域增強; 層級交互

中圖分類號:TP751.1 文獻標志碼:A

文章編號:1001-3695(2024)11-041-3484-06

doi: 10.19734/j.issn.1001-3695.2024.01.0067

TRNet: triple-channel region-enhancement network for change detection based on remote sensing image

Shi Weichaoa, b, Song Baoguia, b, Guan Zongshenga, b, Qin Daolonga, b , Shao Pana, b?

(a. Hubei Key Laboratory of Intelligent Vision Based Monitoring for Hydroelectric Engineering, b. College of Computer amp; Information Technology, China Three Gorges University, Yichang Hubei 443002, China)

Abstract:Remote sensing image change detection is one of the research focuses in the field of remote sensing. At present, most of them are deep learning methods, which mainly use single channel or siamese network to extract features, which can effectively extract change features. However, with the increasing resolution of remote sensing images, the single feature extraction method is susceptible to the influence of irrelevant details, which leads to the insufficient segmentation ability of the changed and unchanged regions in the detection results. Therefore, this paper proposed a fire-new triple-channel region-enhancement change detection network to enhance feature extraction capability from multiple perspectives. Firstly, the method constructed a triple-channel region-enhancement encoder, and used three feature extraction channels to extract similarity information, comprehensiveness information and difference information in a directional manner. At every scales of the encoder, region-separation enhancement modules were able to augment channel 2 with channels 1 and 3, which was beneficial to obtain better effect of changing region segmentation. Secondly, it designed a layer interaction-guidance fusion decoder, and used the interactive guidance between higher-level and lower-level features. So the decoder fused effectively the different-level features by the mutual guidance between high-level features and low-level features. Finally, it used an adaptive weight based on information entropy, which gave more attention to high entropy regions, to optimize loss function. Then, the new loss function improved the training process of the network model. The results of experiment on common datasets show that this network achieves better detection accuracy than the contrast networks.

Key words:remote sensing; change detection; deep learning; region enhancement; layer interaction

0 引言

遙感變化檢測任務通過分析同一空間維度不同時間維度的遙感影像,來獲取地表變化信息,常被應用于土地規劃、國防安全、資源檢測、森林監測等[1~4]領域。遙感變化檢測是遙感領域的研究重心之一,在過去的幾十年中,已有許多變化檢測技術和方法被提出[5]。傳統變化檢測一般是基于手工設計特征實施變化檢測。然而,由于手工設計特征對遙感影像的表征能力較弱,且泛化能力不強,導致傳統變化檢測的檢測效果有時不夠理想。隨著深度學習技術的快速發展,基于深度學習的變化檢測已成為遙感變化檢測研究的主流方法。

目前依據兩期影像結合階段的不同,基于深度學習的變化檢測方法大致可分為基于前期結合的方法[6~9]和基于后期結合的方法[4,10~16]兩類。基于前期結合的方法首先對兩期影像進行通道維度的級聯,而后再輸入至網絡中進行變化檢測。比如Daudt等人[6]以U-Net[17]為基礎提出了FC-EF網絡,通過跳躍鏈接集成高級特征和低級特征來提升變化檢測精度;Peng等人[18]改進UNet++[19]結構,搭建了DDCNN,利用具有豐富類別信息的深層特征指導淺層特征的選擇;Song等人[9]使用卷積神經網絡(convolutional neural network, CNN)和Transformer兩個并行網絡對級聯后的兩期影像提取特征,集成了CNN和Transformer各自的優勢。基于后期結合的方法首先通過孿生網絡提取兩期影像特征,再進行特征融合和變化檢測。比如Fang等人[20]和朱節中等人[15]將孿生網絡和UNet++結構進行結合;Zhang等人[21]利用深度監督策略改進孿生編碼器-解碼器,提出變化檢測網絡IFN。鄭劍等人[12]提出了LGC-BGNet網絡,其孿生編碼器每個層級均存在CNN和Transformer兩個分支,然后分支提取特征后對局部特征和全局特征進行耦合,從而生成兼顧局部細節和全局空間信息的多層級特征。Feng等人[16]使用結合自注意力和交叉注意力兩種機制的模塊,將孿生網絡提取的多層級特征進行有效融合。韋春桃等人[14]提出了一種聯合空間約束與差異特征聚合的變化檢測網絡,利用孿生網絡生成多層級特征,然后使用改進的坐標注意力模塊和CBAM[22]進行增強。

然而隨著航空航天和遙感技術的進步,遙感影像分辨率越來越高,細節信息更為豐富,比如復雜紋理信息、地物陰影和季節變化等。但是這些細節信息并不一定與變化檢測任務相關,無關細節對檢測結果將產生不利影響。基于前期結合和后期結合的方法受限于單一的特征提取模式,無法有效排除無關信息的干擾,導致像素級變化檢測的能力受限,尤其是所檢測地物的邊緣區域。另一方面,隨著分辨率增長,信息處理和利用的難度也隨之升高,變化檢測任務對研究者提出了更高的要求。而傳統的編解碼過程對于高層級特征和低層級特征未能充分利用,缺少對于空間分辨率信息和高級語義信息的互補性融合,難以解決高分辨率影像和高判別性檢測結果之間的矛盾。

基于對上述問題的分析,本文提出了三通道區域增強網絡(triple-channel region-enhancement network, TRNet),主要包括以下方面:a)構建了三通道區域增強編碼器(triple-channel region-enhancement encoder,TRE),顯式構建出融合通道、級聯通道和差值通道,從多個角度提取特征,通過兩期影像的融合特征及差值特征來增強級聯特征;同時創新性地提出區域分離增強模塊(region-separation enhancement module, REM),通過增強變化信息和抑制相似信息,來促進變化和未變化區域的分割;b)設計一種層級交互指導融合解碼器 (layer interaction-guidance fusion decoder, LIFD),通過高層級特征和低層級特征之間的相互指導,促進解碼過程中語義信息的重建和空間分辨率的恢復,實現不同層級特征之間的有效融合;c)利用基于信息熵的自適應權重優化損失函數,使得網絡更加關注信息熵值更高、預測不太準確的區域,從而優化網絡模型的訓練過程。

1 三通道區域增強網絡TRNet

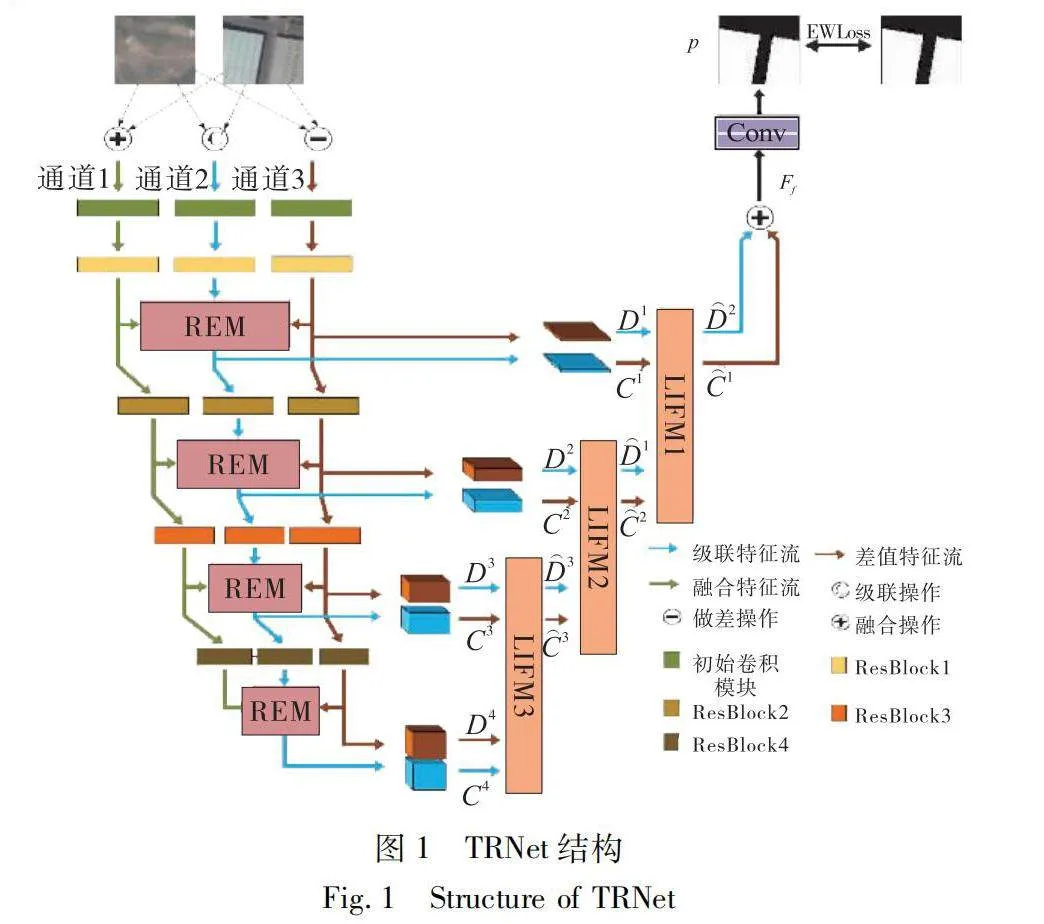

如圖1所示, 所提出的三通道區域增強檢測網絡TRNet采用編碼器-解碼器架構,主要包含三部分:

a)三通道區域增強編碼器TRE:構建了融合通道(通道1)、級聯通道(通道2)、差值通道(通道3)三個特征提取通道,從相似性、全面性和差異性三個角度提取兩期影像的四個層級特征。在每個層級提取特征后,三個通道均輸入區域分離增強模塊REM,使得通道1和3輔助增強通道2,促進通道2特征中變化和未變化區域更好地分離。

b)層級交互指導融合解碼器LIFD:從TRE得到四個層級的級聯特征和差值特征,通過三個層級交互指導融合模塊(layer interaction-guidance fusion module)LIFM1、LIFM2和LIFM3,由高到低逐層進行層級間的相互指導和融合,生成融合特征后經過分類處理,得到最終變化概率預測圖。

c)基于信息熵的自適應加權損失函數EWLoss:利用基于信息熵的自適應權重優化損失函數,從而優化網絡模型訓練過程。

1.1 三通道區域增強編碼器

傳統變化檢測網絡基本上采用前期結合或后期結合的方法,使用單一通道或孿生網絡導致特征提取方式單一化。隨著遙感影像分辨率的提升,繁雜的無關細節干擾到檢測結果,所以遙感研究領域迫切需要能夠更加專注于變化目標的網絡。由于傳統方法只考慮遙感影像自身,無法定向提取任務相關信息,容易忽略兩期影像的時空先驗知識,缺少差異性和相似性建模,從而使得變化區域和未變化區域的分割受限。因此,本文提出了三通道區域增強編碼器TRE(圖1),從多個角度促進變化檢測的提取結果。TRE對三個通道進行顯式建模,從而捕獲相似性信息、全面性信息和差異性信息。然后利用提出的區域分離增強模塊REM,通過通道1和3對通道2進行增強,過濾相似性信息并增強差異性信息,進而提升變化和未變化區域的分割效果。

首先將兩期遙感影像記作X1∈R3×H×W和X2∈R3×H×W,將X1和X2分別進行融合、級聯和做差操作,得到兩期融合影像FI∈R3×H×W、兩期級聯影像CI∈R6×H×W和兩期差值影像DI∈R3×H×W,具體公式如下:

CI=Concat(X1,X2)DI=|X1-X2|FI=X1+X2-DI(1)

其中:Concat表示級聯操作。兩期影像相加后減去差值,能夠突出影像之間的差異性,而差異性與變化區域更加相關;兩期影像相加后減去差值會突出影像之間的相似性,而相似性與未變化區域更加相關。編碼階段通過抑制兩期影像的相似性,來過濾變化無關的噪聲干擾,降低未變化區域的影響;突出兩期影像的差異性,來凸顯變化區域。TRE對變化和未變化區域的雙向推動,能夠促進變化和未變化區域在特征空間中分離,達到更優的檢測效果。

隨后FI、CI和DI被送入編碼器TRE,TRE骨干網絡由ResNet50[23]改進而來,構建了三個通道:通道1(融合通道)、通道2(級聯通道)和通道3(差值通道),三個通道均由一個初始卷積模塊和四個層級的殘差塊ResBlock1、ResBlock2、ResBlock3和ResBlock4堆疊而成,并且在每個層級的殘差塊后面插入了REM模塊,參照圖1。其中初始卷積模塊依次包括步長為2的7×7卷積、批量標準化(batch normalization,BN)、ReLU函數和步長為2的最大池化操作。

對于通道1,先將融合影像FI輸入初始卷積模塊進行初步處理,而后依次經過ResBlock1、ResBlock2、ResBlock3和ResBlock4,提取每個殘差塊的輸出,得到四個層級的特征F={Fl|l=1,2,3,4},其中Fl表示第l層級的融合特征;對于通道3,先將差值影像DI輸入初始卷積模塊進行初步處理,而后依次經過ResBlock1、ResBlock2、ResBlock3和ResBlock4,提取每個殘差塊的輸出得到四個層級的特征D={Dl|l=1,2,3,4},其中Dl表示第l層級的差值特征;對于通道2,先將級聯影像CI輸入初始卷積模塊進行初步處理,而后依次經過ResBlock1、REM1、ResBlock2、REM2、ResBlock3、REM3、ResBlock4和REM4。具體地,在第l(l=1,2,3,4)層級的殘差塊ResBlockl提取特征后,得到初步級聯特征Cl。將初步級聯特征Cl和通道1提取的融合特征Fl、通道2提取的差值特征Dl一起輸入到REMl中,利用特征Fl和特征Dl輔助增強特征Cl,得到增強后級聯特征Cl。當l等于1、2或3時,Cl繼續沿通道2輸入下一層級殘差塊ResBlockl+1進行編碼。 最終通道2得到四個層級增強后的特征C={Cl|l=1,2,3,4},其中Cl表示第l層級的級聯特征。四個層級特征的大小分別是64像素×64像素×256通道、32像素×32像素×512通道、16像素×16像素×1 024通道和8像素×8像素×2048通道。

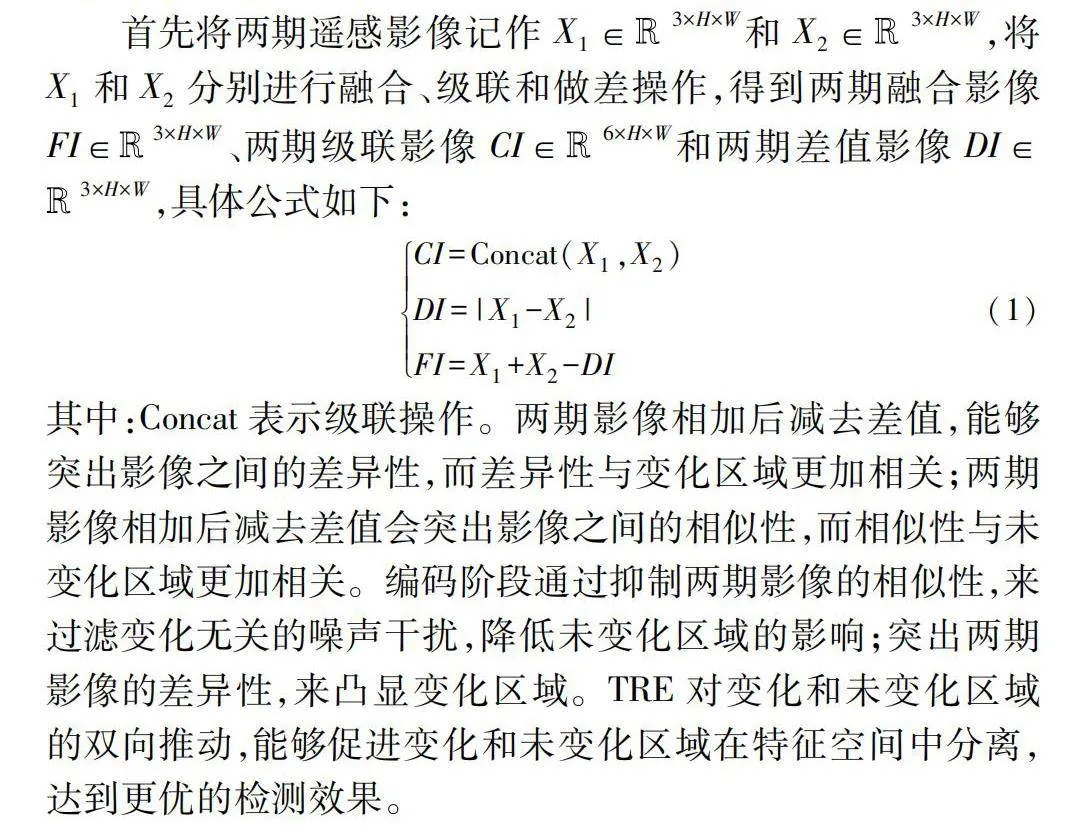

REM具體過程如圖2所示,輸入為特征Fl、Cl和Dl,通過空間注意力機制實現對于級聯特征中變化信息的增強和相似信息的抑制,生成變化和未變化區域分離效果更佳的級聯特征C。

REM首先將融合特征F∈Rc×h×w和差值特征D∈Rc×h×w分別經過1×1卷積進行降維,并特征維度重塑成一維向量f∈Rhw和d∈Rhw。再將向量f和d分別經過softmax函數生成注意力向量f′和d′,而后將f′和d′又重塑為二維空間注意力圖Sd∈Rh×w和Sf∈Rh×w。對于注意力圖Sf,因為經過softmax函數,所以圖中每個數值取值為0~1,使用1減去Sf生成新空間注意力圖S′f。最后Sd和Sf同時對特征C進行加權,經過ReLU激活函數,得到增強后的級聯特征C,具體公式如下:

C=ReLU((1-Sf)×C-+Sd×C-+C-)(2)

其中:ReLU表示ReLU激活函數,×表示矩陣逐像素相乘操作。通過特征維度重塑方式對整個二維圖像進行softmax計算,使得注意力圖的生成經過了全局計算,綜合考慮了不同像素概率之間的關聯性,從而使得關注區域與其他區域的區分更為明顯。同時Sd含有大量差異信息,能夠突出變化區域;Sf含有大量相似性信息,使用1減去Sf而生成的注意力圖能夠更好地過濾無關噪聲干擾,從而抑制未變化區域。

1.2 層級交互指導融合解碼器LIFD

高層級特征包含更多的語義信息,但缺少空間細節信息;低層級特征具有豐富的空間細節信息,但缺少語義信息。然而在以U-Net[17]和FPN[24]為代表的經典網絡的解碼過程中采用的特征融合方式較為簡單,使得高層級特征的空間分辨率恢復和低層級特征的語義重構效果不夠理想。因此,本文提出一種層級交互指導融合解碼器LIFD,通過高層級特征語義信息對低層級特征進行指導,低層級特征空間細節信息對高層級特征進行指導,從而促進解碼過程中語義信息的重建和空間分辨率的恢復,實現不同層級間特征的有效融合。與此同時,LIFD保留了差值特征和級聯特征的數據流(圖1),通過綜合考慮兩種數據流信息來充分提取變化信息,從而提升變化檢測性能。LIFD的具體細節如下:

首先將編碼器TRE生成的四個層級特征的級聯特征C={Cl|l=1,2,3,4}和差值特征D={Dl|l=1,2,3,4}輸入到LIFD,通過LIFD的三個層級交互指導融合模塊LIFM1、LIFM2和LIFM3從高到低逐步進行層級交互指導和融合,得到層級融合特征C)l和D)l。然后將融合后的特征C)l和D)l相加,得到融合特征Ff。最后對融合特征Ff進行3×3卷積操作和1×1卷積操作,將維度壓縮到兩通道。然后進行雙線性插值上采樣至原始影像尺寸,并通過softmax層,得到解碼器LIFD最終輸出的變化概率預測圖p(圖1)。

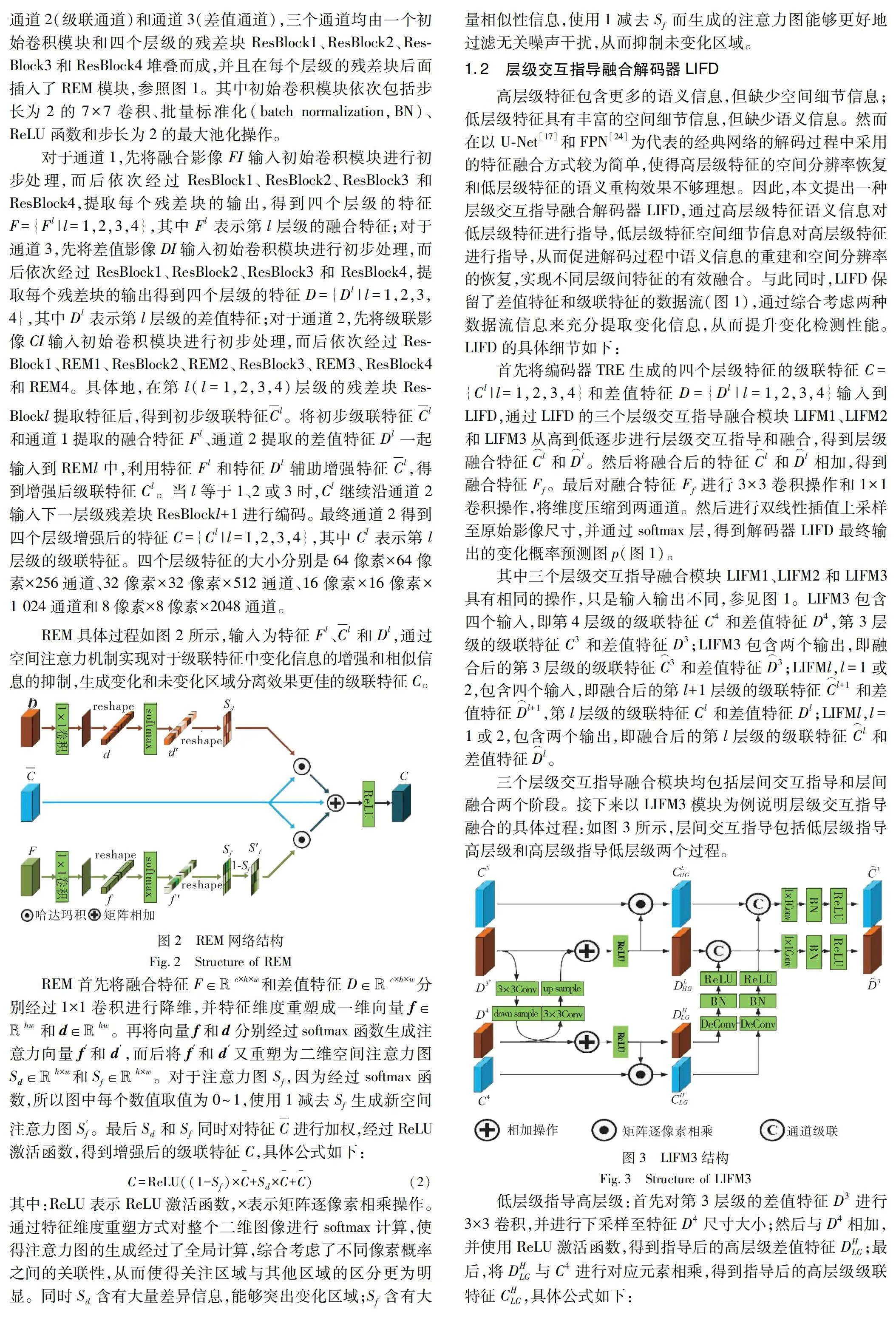

其中三個層級交互指導融合模塊LIFM1、LIFM2和LIFM3具有相同的操作,只是輸入輸出不同,參見圖1。LIFM3包含四個輸入,即第4層級的級聯特征C4和差值特征D4,第3層級的級聯特征C3和差值特征D3;LIFM3包含兩個輸出,即融合后的第3層級的級聯特征C)3和差值特征D)3;LIFMl,l=1或2,包含四個輸入,即融合后的第l+1層級的級聯特征C)l+1和差值特征D)l+1,第l層級的級聯特征Cl和差值特征Dl;LIFMl,l=1或2,包含兩個輸出,即融合后的第l層級的級聯特征C)l和差值特征D)l。

三個層級交互指導融合模塊均包括層間交互指導和層間融合兩個階段。接下來以LIFM3模塊為例說明層級交互指導融合的具體過程:如圖3所示,層間交互指導包括低層級指導高層級和高層級指導低層級兩個過程。

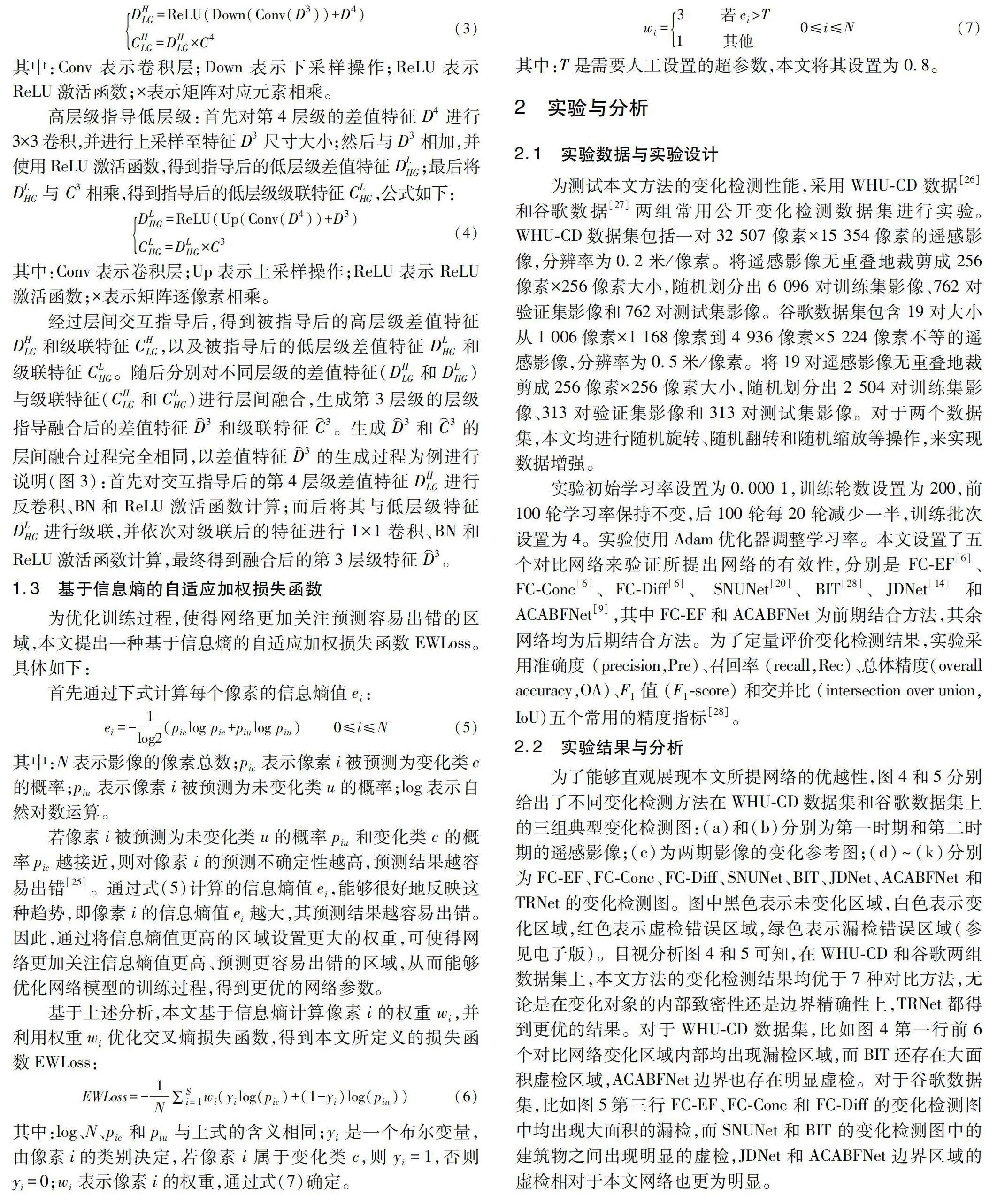

低層級指導高層級:首先對第3層級的差值特征D3進行3×3卷積,并進行下采樣至特征D4尺寸大小;然后與D4相加,并使用ReLU激活函數,得到指導后的高層級差值特征DHLG;最后,將DHLG與C4進行對應元素相乘,得到指導后的高層級級聯特征CHLG,具體公式如下:

DHLG=ReLU(Down(Conv(D3))+D4)CHLG=DHLG×C4(3)

其中:Conv表示卷積層;Down表示下采樣操作;ReLU表示ReLU激活函數;×表示矩陣對應元素相乘。

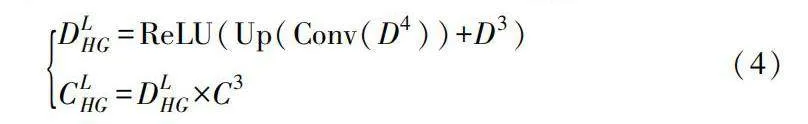

高層級指導低層級:首先對第4層級的差值特征D4進行3×3卷積,并進行上采樣至特征D3尺寸大小;然后與D3相加,并使用ReLU激活函數,得到指導后的低層級差值特征DLHG;最后將DLHG與 C3相乘,得到指導后的低層級級聯特征CLHG,公式如下:

DLHG=ReLU(Up(Conv(D4))+D3)CLHG=DLHG×C3(4)

其中:Conv表示卷積層;Up表示上采樣操作;ReLU表示ReLU激活函數;×表示矩陣逐像素相乘。

經過層間交互指導后,得到被指導后的高層級差值特征DHLG和級聯特征CHLG,以及被指導后的低層級差值特征DLHG和級聯特征CLHG。隨后分別對不同層級的差值特征(DHLG和DLHG)與級聯特征(CHLG和CLHG)進行層間融合,生成第3層級的層級指導融合后的差值特征D⌒3和級聯特征C⌒3。生成D⌒3和C⌒3的層間融合過程完全相同,以差值特征D⌒3的生成過程為例進行說明(圖3):首先對交互指導后的第4層級差值特征DHLG進行反卷積、BN和ReLU激活函數計算;而后將其與低層級特征DLHG進行級聯,并依次對級聯后的特征進行1×1卷積、BN和ReLU激活函數計算,最終得到融合后的第3層級特征D⌒3。

1.3 基于信息熵的自適應加權損失函數

為優化訓練過程,使得網絡更加關注預測容易出錯的區域,本文提出一種基于信息熵的自適應加權損失函數EWLoss。具體如下:

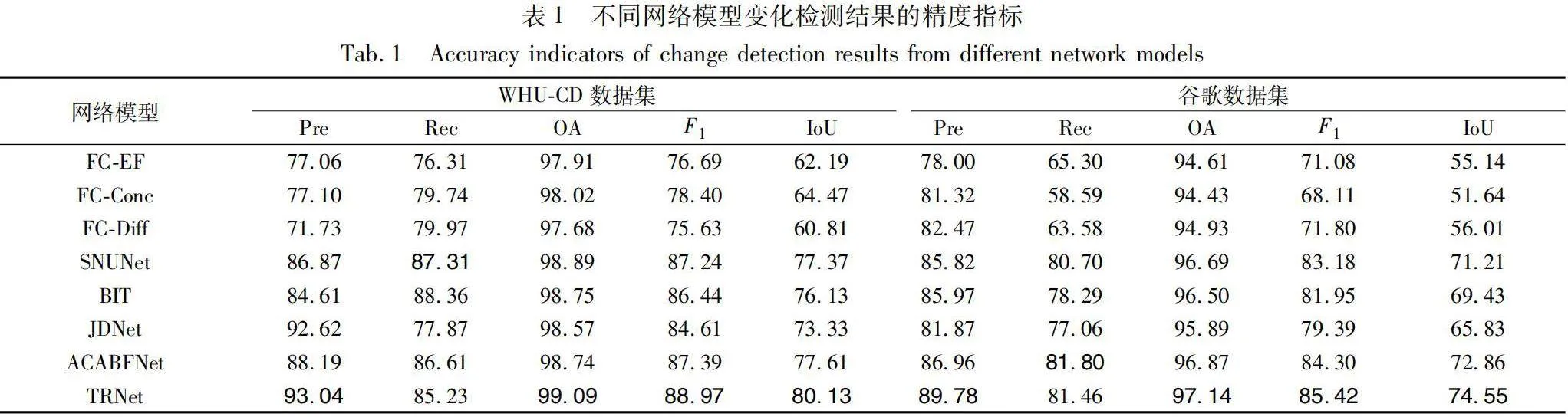

首先通過下式計算每個像素的信息熵值ei:

ei=-1log2(piclog pic+piulog piu)

0≤i≤N(5)

其中:N表示影像的像素總數;pic表示像素i被預測為變化類c的概率;piu表示像素i被預測為未變化類u的概率;log表示自然對數運算。

若像素i被預測為未變化類u的概率piu和變化類c的概率pic越接近,則對像素i的預測不確定性越高,預測結果越容易出錯[25]。通過式(5)計算的信息熵值ei,能夠很好地反映這種趨勢,即像素i的信息熵值ei越大,其預測結果越容易出錯。因此,通過將信息熵值更高的區域設置更大的權重,可使得網絡更加關注信息熵值更高、預測更容易出錯的區域,從而能夠優化網絡模型的訓練過程,得到更優的網絡參數。

基于上述分析,本文基于信息熵計算像素i的權重wi,并利用權重wi優化交叉熵損失函數,得到本文所定義的損失函數EWLoss:

EWLoss=-1N∑Si=1wi(yilog(pic)+(1-yi)log(piu))(6)

其中:log、N、pic和piu與上式的含義相同;yi是一個布爾變量,由像素i的類別決定,若像素i屬于變化類c,則yi=1,否則yi=0;wi表示像素i的權重,通過式(7)確定。

其中:T是需要人工設置的超參數,本文將其設置為0.8。

2 實驗與分析

2.1 實驗數據與實驗設計

為測試本文方法的變化檢測性能,采用WHU-CD數據[26]和谷歌數據[27]兩組常用公開變化檢測數據集進行實驗。WHU-CD數據集包括一對32 507 像素×15 354像素的遙感影像,分辨率為0.2米/像素。將遙感影像無重疊地裁剪成256像素×256像素大小,隨機劃分出6 096對訓練集影像、762對驗證集影像和762對測試集影像。谷歌數據集包含19對大小從1 006像素×1 168像素到4 936像素×5 224像素不等的遙感影像,分辨率為0.5米/像素。將19對遙感影像無重疊地裁剪成256像素×256像素大小,隨機劃分出2 504對訓練集影像、313對驗證集影像和313對測試集影像。對于兩個數據集,本文均進行隨機旋轉、隨機翻轉和隨機縮放等操作,來實現數據增強。

實驗初始學習率設置為0.000 1,訓練輪數設置為200,前100輪學習率保持不變,后100輪每20輪減少一半,訓練批次設置為4。實驗使用Adam優化器調整學習率。本文設置了五個對比網絡來驗證所提出網絡的有效性,分別是 FC-EF[6]、FC-Conc[6]、FC-Diff[6]、 SNUNet[20]、BIT[28]、JDNet[14]和ACABFNet[9],其中FC-EF和ACABFNet為前期結合方法,其余網絡均為后期結合方法。為了定量評價變化檢測結果,實驗采用準確度 (precision,Pre)、召回率 (recall,Rec)、總體精度(overall accuracy,OA)、F1值 (F1-score) 和交并比 (intersection over union,IoU)五個常用的精度指標[28]。

2.2 實驗結果與分析

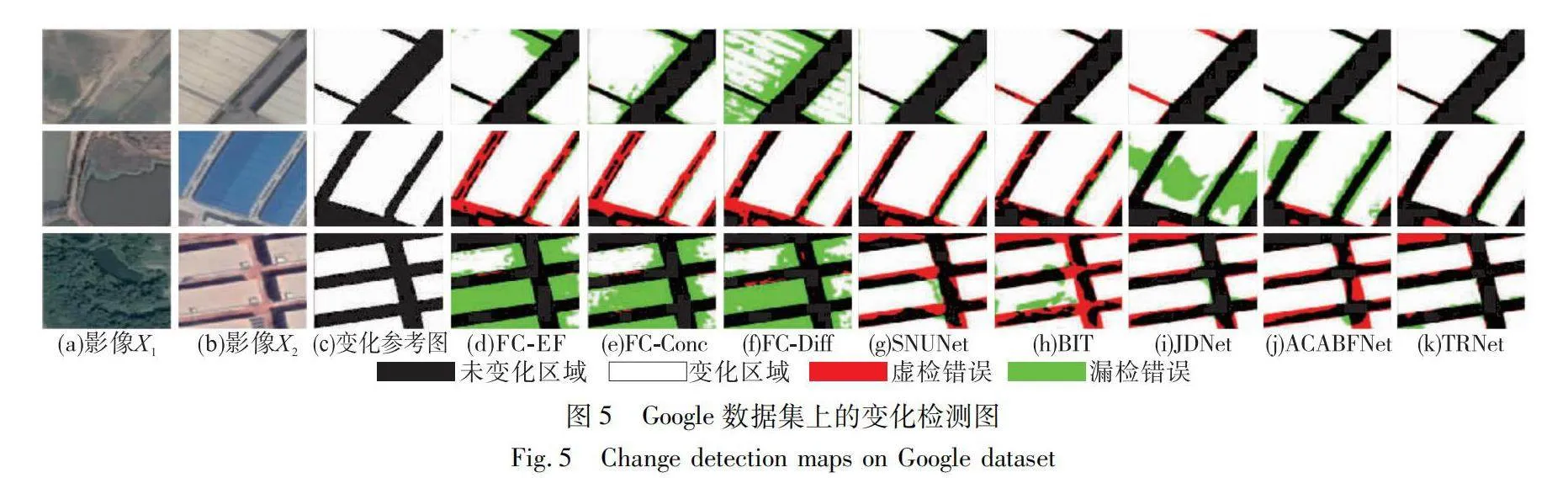

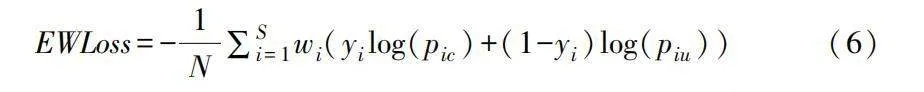

為了能夠直觀展現本文所提網絡的優越性,圖4和5分別給出了不同變化檢測方法在WHU-CD數據集和谷歌數據集上的三組典型變化檢測圖:(a)和(b)分別為第一時期和第二時期的遙感影像;(c)為兩期影像的變化參考圖;(d)~(k)分別為FC-EF、FC-Conc、FC-Diff、SNUNet、BIT、JDNet、ACABFNet和TRNet的變化檢測圖。圖中黑色表示未變化區域,白色表示變化區域,紅色表示虛檢錯誤區域,綠色表示漏檢錯誤區域(參見電子版)。目視分析圖4和5可知,在WHU-CD和谷歌兩組數據集上,本文方法的變化檢測結果均優于7種對比方法,無論是在變化對象的內部致密性還是邊界精確性上,TRNet都得到更優的結果。對于WHU-CD數據集,比如圖4第一行前6個對比網絡變化區域內部均出現漏檢區域,而BIT還存在大面積虛檢區域,ACABFNet邊界也存在明顯虛檢。對于谷歌數據集,比如圖5第三行FC-EF、FC-Conc和FC-Diff的變化檢測圖中均出現大面積的漏檢,而SNUNet和BIT 的變化檢測圖中的建筑物之間出現明顯的虛檢,JDNet和ACABFNet邊界區域的虛檢相對于本文網絡也更為明顯。

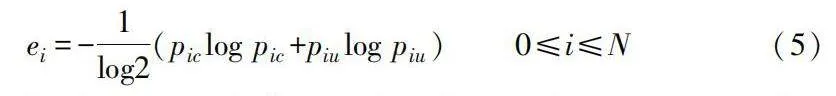

為更加客觀地展示本文TRNet的有效性,表1給出不同方法在兩組數據集上變化檢測結果的百分比定量指標。從表1可知,在兩組數據集上,本文方法的變化檢測結果取得最優的定量指標,各個指標的最優值均用加粗字體表示。

對于WHU-CD數據集,本文方法除了在指標Rec上取得第二優,在其他指標上均取得最優值。比如本文方法F1和IoU的取值分別為88.97%和80.13%,比其他方法至少提高1.58和2.52百分點。對于谷歌數據集,本文方法同樣除了在指標Rec上取得第二優,在其他指標上均取得最優值。比如對于指標F1和IoU,本文方法的取值分別為85.42%和74.55%,比其他方法至少提高1.12和1.69百分點。

2.3 消融實驗

本文TRNet的創新主要包括三通道區域增強編碼器TRE、層級交互指導融合解碼器LIFD和基于信息熵的自適應加權損失函數EWLoss三部分。為驗證上述三部分創新的有效性,本文以谷歌數據集為例進行消融實驗。給出以下三種本文方法的變種網絡:a)TRNet-noREM,其他結構保持不變,去掉所提出編碼器TRE中的區域分離增強模塊REM,如去掉REM,則通道1將失去作用,所以此變種網絡也可視為去掉通道1;b)TRNet-noLIFM,其他結構保持不變,去掉所提出解碼器LIFD中的層級交互指導融合模塊,僅采用簡單的特征融合方法;c)TRNet-noW:其他結構保持不變,去掉所提出損失函數EWLoss中基于信息熵的權重。通過對比以上三種網絡和本文方法的變化檢測結果,分析本文三部分創新的有效性。表2給出上述三種網絡和本文方法檢測結果的百分比定量指標。

對比表2前三行和最后一行結果可知,本文方法的三部分創新均能有效提升變化檢測性能。比如,對比第二行和最后一行中結果可知,去掉解碼器LIFD中的層級交互指導融合模塊后,本文方法的F1和IoU值分別降低2.13和3.19百分點。因此,本文提出的TRE、LIFD和EWLoss均對變化檢測結果具有重要作用。

為更加直觀地展示EWLoss的效果,圖6給出谷歌數據集中兩組典型區域的變化檢測結果:(a) ~ (e) 分別表示第一時期影像X1、第二時期影像X2、兩期影像的變化參考圖、TRNet-noW和TRNet的變化檢測圖。對比圖 (d) 和 (e) 可知,基于信息熵的自適應加權損失函數EWLoss能夠有效提升對檢測結果中高熵區域和預測易出錯區域的檢測精度。

3 結束語

針對高分辨率遙感影像帶來的挑戰,本文提出一種全新的三通道區域增強變化檢測網絡TRNet。首先利用三通道區域增強編碼器TRE,從兩期影像相似性和差異性的角度增強特征提取過程,進而有效分割變化和未變化區域;其次給出一種層級交互指導融合解碼器,使得解碼過程中能夠保留更豐富的語義信息和更精準的空間信息;最后通過基于信息熵的自適應權重優化損失函數,使得網絡更加關注預測容易出錯的區域,從而優化網絡訓練過程。在WHU-CD數據集和谷歌數據集上的定性和定量實驗結果表明,本文所創新構建的三通道區域增強變化檢測網絡TRNet取得了更優的變化檢測結果。今后將進一步利用遙感變化檢測任務的時空先驗知識,創造更貼合任務目標的網絡架構。

致謝 本文受到三峽大學先進計算中心(Advanced Computing Center,China Three Gorges University)資助支持。

參考文獻:

[1]羅灣, 林偉, 張紅波. 熱含量不變量的SAR圖像點特征變化檢測 [J]. 自動化學報, 2014, 40 (6): 1126-1134. (Luo Wan, Lin Wei, Zhang Hongbo. A change detection method of SAR image using point signature based on heat content invariants [J]. Acta Automatica Sinica, 2014, 40 (6): 1126-1134.)

[2]邵攀, 任東, 董婷. 顧及沖突分析的模糊積分非監督變化檢測 [J]. 自動化學報, 2021, 47 (9): 2250-2263. (Shao Pan, Ren Dong, Dong Ting. Unsupervised change detection based on fuzzy integral considering conflict analysis [J]. Acta Automatica Sinica, 2021, 47 (9): 2250-2263.)

[3]葉沅鑫, 孫苗苗, 周亮, 等. 面向建筑物變化檢測的主體邊緣分解與重組神經網絡 [J]. 測繪學報, 2023, 52 (1): 71-81. (Ye Yuanxin, Sun Miaomiao, Zhou Liang, et al. Main body, edge decomposition and reorganization network for building change detection [J]. Acta Geodaetica et Cartographica Sinica, 2023, 52 (1): 71-81.)

[4]Liu Mengxi, Chai Zhuoqun, Deng Haojun, et al. A CNN-transformer network with multiscale context aggregation for fine-grained cropland change detection [J]. EEE Journal of Selected Topics in Applied Earth Observations and Remote Sensing, 2022,15: 4297-4306.

[5]張祖勛, 姜慧偉, 龐世燕, 等. 多時相遙感影像的變化檢測研究現狀與展望 [J]. 測繪學報, 2022, 51 (7): 1091-1107. (Zhang Zuxun, Jiang Huiwei, Pang Shiyan, et al. Review and prospect in change detection of multi-temporal remote sensing images [J]. Acta Geodaetica et Cartographica Sinica, 2022, 51 (7): 1091-1107.)

[6]Daudt R C, Saux B L, Boulch A. Fully convolutional siamese networks for change detection [C]// Proc of the 25th IEEE International Conference on Image Processing. Piscataway, NJ: IEEE Press, 2018: 4063-4067.

[7]顧煉, 許詩起, 竺樂慶. 基于FlowS-Unet的遙感圖像建筑物變化檢測 [J]. 自動化學報, 2020, 46 (6): 1291-1300. (Gu Lian, Xu Shiqi, Zhu Leqing. Detection of building changes in remote sen-sing images via FlowS-Unet [J]. Acta Automatica Sinica, 2020, 46 (6): 1291-1300.)

[8]Peng Daifeng, Zhang Yongjun, Guan Haiyan. End-to-end change detection for high resolution satellite images using improved UNet++ [J]. Remote Sensing, 2019, 11 (11): 1382.

[9]Song Lei, Xia Min, Weng Liguo, et al. Axial cross attention meets CNN: bibranch fusion network for change detection [J]. IEEE Journal of Selected Topics in Applied Earth Observations and Remote Sensing, 2022, 16: 21-32.

[10]Chen Hao, Shi Zhenwei. A spatial-temporal attention-based method and a new dataset for remote sensing image change detection [J]. Remote Sensing, 2020, 12 (10): 1662.

[11]Zhang Xiaokang, Yu Weikang, Pun M O, et al. Cross-domain landslide mapping from large-scale remote sensing images using prototype-guided domain-aware progressive representation learning [J]. ISPRS Journal of Photogrammetry and Remote Sensing, 2023, 197: 1-17.

[12]鄭劍, 柴嵐康, 于祥春. 基于局部-全局特征耦合與邊界引導的遙感圖像建筑物變化檢測 [J]. 計算機應用研究,2024,41(6):1888-1892. (Zheng Jian, Chai Lankang, Yu Xiangchun. Building change detection in remote sensing images based on local-global feature coupling and boundary guidance [J]. Application Research of Computers,2024,41(6):1888-1892.

[13]Wang Wei, Tan Xinai, Zhang Peng, et al. A CBAM based multiscale transformer fusion approach for remote sensing image change detection [J]. IEEE Journal of Selected Topics in Applied Earth Observations and Remote Sensing, 2022, 15: 6817-6825.

[14]韋春桃, 龔成, 周永緒. 一種聯合空間約束與差異特征聚合的變化檢測網絡 [J]. 測繪學報, 2023, 52 (9): 1538-1547. (Wei Chuntao, Gong Chen, Zhou Yongxu. A change detection network with joint spatial constraints and differential feature aggregation [J]. Acta Geodaetica et Cartographica Sinica, 2023, 52 (9): 1538-1547.)

[15]朱節中, 陳永, 柯福陽, 等. 基于SIAM-UNet++的高分辨率遙感影像建筑物變化檢測 [J]. 計算機應用研究, 2021, 38 (11): 3460-3465. (Zhu Jiezhong, Chen Yong, Ke Fuyang, et al. Building change detection from high resolution remote sensing imagery based on SIAM-UNet++ [J]. Application Research of Computers, 2021, 38 (11): 3460-3465.)

[16]Feng Yuchao, Jiang Jiawei, Xu Honghui, et al. Change detection on remote sensing images using dual-branch multilevel intertemporal network [J]. IEEE Trans on Geoscience and Remote Sensing, 2023, 61: 1-15.

[17]Ronneberger O, Fischer P, Brox T. U-Net: convolutional networks for biomedical image segmentation [C]// Proc of Medical Image Computing and Computer-Assisted Intervention.Berlin: Springer, 2015: 234-241.

[18]Peng Xueli, Zhong Ruofei, Li Zhen, et al. Optical remote sensing image change detection based on attention mechanism and image difference [J]. IEEE Trans on Geoscience and Remote Sen-sing, 2021, 59 (9): 7296-7307.

[19]Zhou Zongwei, Siddiquee M M R, Tajbakhsh N, et al. UNet++: a nested U-Net architecture for medical image segmentation [C]// Proc of Deep Learning in Medical image Analysis and Multimodal Learning for Clinical Decision Support. Berlin:Springer, 2018: 3-11.

[20]Fang Sheng, Li Kaiyu, Shao Jinyuan, et al. SNUNet-CD: a densely connected Siamese network for change detection of VHR images [J]. IEEE Geoscience and Remote Sensing Letters, 2021, 19: 1-5.

[21]Zhang Chenxiao, Yue Peng, Tapete D, et al. A deeply supervised image fusion network for change detection in high resolution bi-temporal remote sensing images [J]. ISPRS Journal of Photogrammetry and Remote Sensing, 2020, 166: 183-200.

[22]Woo S, Park J, Lee J,et al. CBAM: convolutional block attention module [C]// Proc of European Conference on Computer Vision. Berlin: Springer, 2018: 3-19.

[23]He Kaiming, Zhang Xianyu, Ren Shaoqing, et al. Deep residual learning for image recognition [C]// Proc of the 34th IEEE Confe-rence on Computer Vision and Pattern Recognition. Piscataway, NJ: IEEE Press, 2016: 770-778.

[24]Lin T Y,Dollár P, Girshick R, et al. Feature pyramid networks for object detection [C]// Proc of the 35th IEEE Conference on Compu-ter Vision and Pattern Recognition. Piscataway, NJ: IEEE Press, 2017: 2117-2125.

[25]Vu T H, Jain H, Bucher M, et al. ADVENT: adversarial entropy minimization for domain adaptation in semantic segmentation [C]// Proc of the 37th IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway, NJ: IEEE Press, 2019: 2517-2526.

[26]Ji Shunping, Wei Shiqing, Lu Meng. Fully convolutional networks for multisource building extraction from an open serial and datellite ima-gery data set [J]. IEEE Trans on Geoscience and Remote Sensing, 2019, 57 (1): 574-586.

[27]Peng Daifeng, Bruzzone L, Zhang Yongjun, et al. SemiCDNet: a semisupervised convolutional neural network for change detection in high resolution remote-sensing images [J]. IEEE Trans on Geoscience and Remote Sensing, 2021, 59 (7): 5891-5906.

[28]Chen Hao, Qi Zipeng, Shi Zenwei. Remote sensing image change detection with transformers [J]. IEEE Trans on Geoscience and Remote Sensing, 2022, 60: 1-14.