基于改進YOLOv7 的農作物蟲害識別

摘要:為提高農作物蟲害檢測的準確率和效率,提出了一種基于YOLOv7的農作物蟲害識別模型。首先,使用信息聚集?分發機制改進YOLOv7的特征融合模塊,增強了不同層級之間的特征融合能力;其次,將損失函數替換為最小點距離交并比來計算邊界框回歸損失,更好地對齊預測框和真實目標框,提高了邊界框回歸的準確性;最后,通過在SPPCSPC層后添加感受野增強模塊,增強了模型對小尺度害蟲的識別能力。實驗結果表明,改進后的YOLOv7模型平均準確度為80.4%,精確率為85.3%,召回率為75.1%,較改進前分別提升了3.4%、3.2%、2.6%。該模型對農業害蟲具有更好的識別效果和魯棒性,為農業害蟲監測與防治提供了更準確和可靠的工具。

關鍵詞:圖像處理;YOLOv7;農作物蟲害;目標檢測

doi:10.13304/j.nykjdb.2024.0036

中圖分類號:S126 文獻標志碼:A 文章編號:10080864(2024)11010710

農業害蟲對我國農作物產量和質量造成了嚴重的威脅。據全國農作物病蟲害測報網監測和專家會商分析,2023年小麥、水稻、玉米等糧食作物病蟲害呈重發態勢,預計發生面積2.1億hm2,同比增加24%,產量損失風險在1.8 億t以上[1]。玉米和水稻作為重要的農作物,降低蟲害造成的損失對保證全年糧食豐收乃至經濟可持續發展都有非常重要的意義。

傳統的農作物蟲害監測主要依靠在種植區域內專人巡查,通過肉眼觀察、手捉等方式來檢測種植區域內的害蟲情況[2]。這種方法不僅耗費大量的人力,而且誤差較大,難以滿足現實中的蟲害防控需求。隨著圖像處理技術的發展,計算機視覺逐漸被用于自動化蟲害識別。通過拍攝受危害的農作物圖像,然后使用圖像處理算法來分析圖像中的形狀、顏色、紋理等特征,可以對害蟲進行準確的分類和識別[3]。然而,傳統的機器學習方法通常需要手工提取圖像特征,檢測效果并不理想[4]。

隨著人工智能技術的快速發展,基于深度學習的目標檢測算法可以直接從原始數據中自動學習數據特征并完成相應的識別任務,因而在農作物蟲害識別領域得到了廣泛的應用。蘇鴻等[5]采用R-CNN模型對廣西柑橘病蟲害進行識別,識別效果優于傳統的機器學習方法。Ali等[6]設計了一種改進的Faster-RCNN算法,以MobileNet為基礎網絡,對害蟲樣本進行調整以識別各種類別的作物害蟲。姜敏等[7]使用深度學習模型對水稻害蟲進行識別,識別精度和速度相比SSD模型、Faster-RCNN都有所提高。近年來,YOLO系列算法更是以其高效、實時的特性開始展現它的優勢。郭陽等[8]采用YOLOv3模型對水稻害蟲進行預測,引入Darknet-53網絡和多尺度融合,對小目標害蟲實現精準預測。施杰等[9]利用改進的YOLOv5s模型對玉米作物害蟲進行檢測,通過削弱復雜背景和無關信息的干擾,在定位、識別效果和置信度方面都有顯著提升。Likith等[10]使用YOLO和CNN算法來檢測和分類圖像中的害蟲,能夠精準地檢測和分類圖像中的多種害蟲。盡管這些研究在其數據集上有所提升,但并沒有充分考慮到不同害蟲之間的尺寸差異問題,而在現實環境中不同種類的害蟲體型差異過大,需要模型去有效地結合不同尺度的特征信息,除此之外,小尺寸害蟲的識別率也一直有待提高。

YOLOv7是一種用于目標檢測的深度學習模型,因較快的運行速度和較高的準確率被廣泛應用。YOLOv7算法采用多尺度的特征融合方法,能夠提高對不同尺寸害蟲的識別能力,并且作為YOLO系列的新成員,YOLOv7在繼承前代算法優點的基礎上進一步提升了檢測精度和速度,能夠在實時場景中迅速識別農作物蟲害[11]。因此,本文選擇YOLOv7作為基礎模型,將Gold-YOLO[12]中的信息聚集-分發機制融入原有的特征融合方法,進一步增強模型對不同尺寸害蟲的識別能力,然后添加感受野增強模塊[13],解決小尺寸害蟲識別率不高的問題,最后使用最小點距離交并比[14]損失函數重新計算邊界框回歸損失,更準確地將目標害蟲框選出來。通過分析3種改進策略融合在模型中的訓練結果,并與其他目標檢測模型進行對比,充分驗證了本文改進YOLOv7模型的優越性,實現了多種農作物蟲害的精確識別。

1 材料與方法

1.1 數據集

本研究所用數據取自公開的大規模害蟲數據集——IP102數據集[15],該數據集包含了102個類別的7.5萬多幅害蟲圖像。根據我國農作物的蟲害實際情況,從IP102數據集中選取出收錄在一類農作物病蟲害名錄(2023 年)[16]中的草地貪夜蛾、飛蝗、稻飛虱、稻縱卷葉螟、玉米螟共5類主要害蟲的4 200幅圖像建立數據庫,數據集部分圖像如圖1 所示。按照YOLO 數據集格式,使用LabelImg 標注工具對圖像邊界框和類別進行標注,生成TXT 類型的標注文件。將數據集按照7∶2∶1的比例隨機劃分為訓練集、驗證集和測試集。訓練集用于訓練模型的參數,在驗證集上評估模型的性能及時調整參數,測試集檢驗最終得到的模型性能,并對結果進行對比。

1.2 網絡模型及改進

1.2.1 整體結構 本研究提出的改進YOLOv7網絡模型整體結構由骨干網絡(backbone)、頸部網絡(neck)和頭部網絡(head)組成,如圖2所示。在處理中,圖像首先被輸入模型中,經過數據增強等一系列操作進行預處理后,送入骨干網絡進行特征提取;之后將提取到的特征經過頸部網絡進行特征融合處理得到大、中、小3種尺寸的特征;融合后的特征被送入頭部網絡進行目標檢測和定位,得出檢測結果。

本研究中改進YOLOv7網絡模型的骨干網絡和頭部網絡延用原始模型的設計。在骨干網絡之后添加感受野增強模塊,增強網絡對小尺寸害蟲的識別能力。在頸部網絡融合信息聚集?分發機制,將不同尺寸的特征信息聚集在一起,然后統一分發到各個層級上進行特征融合,增強網絡對不同尺寸大小害蟲的識別能力。

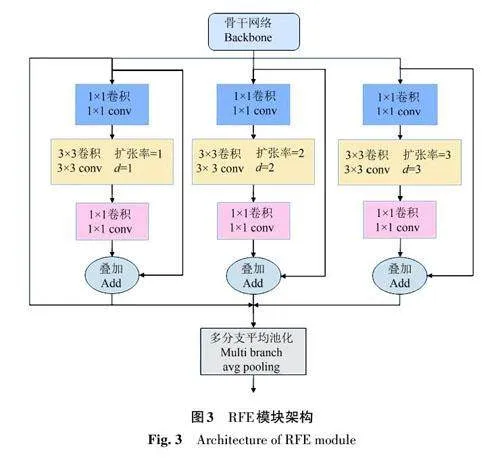

1.2.2 感受野增強模塊 感受野增強模塊(receptive field enhancement, RFE)是通過使用空洞卷積以充分利用特征圖中感受野優勢的一種設計[17]。空洞卷積的擴張率是指卷積核中各個元素之間的間隔大小,RFE采用了3個不同擴張率的空洞卷積分支。通過使用不同擴張率(d)的空洞卷積,每個分支可以感知到不同尺寸的特征。更小的擴張率能夠捕獲較為局部的信息,而較大的擴張率則能夠捕獲更廣闊的上下文關系。所有的分支共享權重唯一的區別是它們的感受野大小不同。這種設計既減少了參數數量,降低了潛在的過擬合風險,又充分利用了每個樣本中包含的信息。

RFE模塊的結構如圖3所示,其包含基于空洞卷積的多分支和信息的聚集與加權。多分支部分分別取用1、2、3作為空洞卷積的擴張率,并且都使用固定大小為3×3的卷積核。此外,還添加了殘差連接以防止訓練過程中的梯度爆炸和消失問題。信息的聚集與加權部分用于從不同分支中聚集信息并對每個分支的特征信息進行加權,通過加權操作來平衡不同分支的表示。

1.2.3 信息聚集?分發機制 原始YOLOv7的特征金字塔網絡結構由于其層層遞進的信息融合模式,使得相鄰層的信息能夠充分融合,但當需要跨層進行信息交互時,由于沒有直連的交互通路,只能依靠中間層充當“中介”進行融合,因而存在跨層信息交互困難和信息損失的問題。本文在YOLOv7 中引入信息聚集? 分發 (gather-anddistribute,GD)機制,使用特征對齊模塊 (featurealignment module, FAM)聚集和對齊來自各個層次的特征信息,然后使用信息融合模塊 (informationfusion module, IFM)融合對齊后的特征生成全局信息,最后由信息注入模塊 (information injectionmodule, Inject)將全局信息分發到各個層級上完成信息的交互融合。GD機制的總架構如圖4所示,為了增加模型檢測不同尺寸目標的能力,進一步提出了Low-GD和High-GD 2個分支,B2、B3、B4、B5是從骨干網絡提取出的不同尺寸的特征。引入GD機制后增強了網絡的信息融合能力,有效降低了信息丟失造成的影響,大大提高了識別不同尺寸害蟲的能力。

Low-GD 的架構如圖5所示。首先在低層特征對齊模塊中,對特征B2和B3進行平均池化,特征B4保持不變,特征B5進行雙線性插值,從而將所有特征的尺寸大小對齊到B4的尺寸,再進行拼接得到對齊特征Falign。之后在低層信息融合模塊中使用多層重參數化卷積塊,先將對齊特征Falign與權重向量進行卷積,然后將卷積結果乘以尺度因子得到特征Ffuse。之后使用分割操作沿著通道維度將特征Ffuse劃分成2個子特征,得到全局信息Finj_P3 和Finj_P4,作為后續信息注入模塊的輸入,與不同層級的特征進行融合。

信息注入模塊的架構如圖6所示,其輸入包含2個特征信息:x_global(信息融合模塊中輸出的全局信息)和x_local(在當前層級中想要進行信息交互的本地信息)。信息注入模塊將輸入x_global的全局信息分為2個分支操作:第1個分支先對輸入特征進行卷積操作,然后通過Sigmoid激活函數操作后使用雙線性插值或平均池化調整尺寸大小得到特征F1;第2個分支將輸入特征經過卷積操作后直接使用雙線性插值或平均池化調整尺寸大小得到特征F2,之后將輸入x_local的本地信息Bi 與特征F1 進行特征乘積操作后與特征F2進行特征加和操作,最后經過多層重參數化卷積塊輸出特征Pi。例如,想要特征B2與B4進行跨層信息交互,可以在Low-GD 部分將特征B2、B3、B4、B5 的信息聚集融合,然后得到全局信息Finj_P4輸入x_global中,再將特征B4 作為本地信息輸入x_local中,通過信息注入模塊完成信息的交互融合得到特征P4。

High-GD的架構如圖7所示,與Low-GD過程類似,高層特征對齊模塊聚集和對齊P3、P4、P5的特征,高層信息融合模塊融合對齊特征后生成全局信息。不同的是,在高層特征對齊模塊中是將特征P3和P4的尺寸大小使用雙線性插值下采樣對齊到P5的尺寸,拼接后得到對齊特征Falign。由于特征尺寸的縮小,為了充分融合全局信息,在高層信息融合模塊使用transformer[18]中的多頭注意力機制和前饋網絡替換多層重參數化卷積塊,完成信息的融合得到特征Ffuse,經過1×1的卷積統一通道數后使用分割操作沿著通道維度將特征Ffuse分成2個子特征,得到全局信息Finj_N4和Finj_N5。之后再次通過信息注入模塊將全局信息分發到各個層級上完成信息的交互融合,最后輸出N3、N4、N5的特征,送入頭部網絡進行目標檢測和定位,得出檢測結果。