基于視覺顯著搜索與AdaBoost算法的遙感目標檢測

尹 輝,谷 峰,岳劍飛,張洪順

(1.空軍航空大學,長春 130022;2.解放軍66347部隊,保定 071000)

0 引 言

針對遙感圖像目標檢測任務,圖像分辨率的提高一方面可以分辨出地物目標內部更為精細的結構,清楚地描述地物目標的特征分布及相互之間的空間關聯;另一方面目標內部一致性減弱、差異性增強以及復雜背景干擾等也給目標檢測任務提出了新的挑戰。如何提高高分辨率圖像信息處理的時效性和準確性,突破圖像數據向有價值信息轉化的瓶頸成為遙感圖像理解、機器視覺、人工智能等領域研究的熱點。飛機作為一類重要的、典型的人造目標檢測對象,受到廣泛關注。

本質上,對飛機目標的檢測,都是基于這樣一種假設,即飛機目標與背景的反差較大。這種反差表現為以下2個方面:

第一,飛機的形狀。與背景中的建筑物、草地、停機坪、道路相比,飛機在機身與機翼、機身與尾翼的交接處存在一定的凹陷,對于這種結構可以考慮用目標外接矩形充滿程度的緊湊度來描述,結合目標的面積、周長、長寬比等特征進行目標分析[1]。此外,針對飛機這種凹凸形狀,角點特征是一種很有效的描述子。文獻[2]利用Harris角點來檢測飛機這種形狀的差異,然后通過核聚類方法將角點進行合并,角點之間滿足一定規則即為目標。這類方法的拓展大都是對角點描述字的選取。如為了增加角點的放射、尺度不變性,提取Harris-Affine、最小核值相似區(SUSAN)角點,但無論哪種角點都對噪聲比較敏感,最后飛機目標檢測結果受角點之間聚類規則限制,而通常聚類后的誤檢不容易剔除。

第二,飛機與背景對光的反射率不同,表現在圖像上為不同的紋理區域。不少學者提出了利用區域特征來檢測飛機目標。典型的算法有高效斑點檢測、區域檢測等。其中,高效斑點檢測利用圖像中目標的局部不變性特征,如:尺度不變特征變換(SIFT),主成分分析(PCA)-SIFT,快速魯棒性尺度不變特征提取(SURF),梯度位置方向直方圖(GLOH)通過匹配技術來完成目標檢測,其中Lowe提出的SIFT特征是現在公認的最好的特征描述字。

然而,該方法計算復雜度高,只適用于幾何形狀單一的目標檢測,飛機目標的多樣性使得其應用受到了限制。此外,區域檢測方法中最穩定極值區域(MSER)檢測器在視角變換下結構型圖像和紋理型圖像均能展現十分明顯的優越性。實際上,以上基于這種假設的飛機目標檢測與通用的目標檢測方法相類似,不同的是要建立針對飛機目標的規則與模型。而飛機的種類多種多樣,形狀也各不相同,加上遙感圖像中各類背景噪聲的干擾,很難通過建立一種規則或者一個模型來枚舉所有的目標。

為了解決這一難題,借鑒計算機視覺領域的機器學習理論,現有的遙感目標自動檢測系統都是基于大量的樣本學習[3-4]實現的,這樣可以充分利用樣本學習的優勢,較好地擺脫了受遙感圖像數據量大、目標特性多變、背景復雜等因素的制約。

然而,不同于普通自然場景下的目標檢測問題,在對大幅高分辨率遙感圖像進行精細化目標檢測時,還應重點考慮2個方面:一是如何降低錯檢、漏檢的概率,提高檢測效果的問題;二是檢測過程中的效率問題,這也是文本撰寫的出發點。

本文的主要創新工作是將基于視覺顯著計算模型與基于AdaBoost級聯學習分類的目標檢測方法相結合,提出一種基于視覺顯著計算的搜索策略。一方面,該方法利用機器學習方法,提高目標檢測的準確性;另一方面,利用視覺注意模型去除冗余搜索,減少檢測時的計算量,快速搜索目標的潛在區域,盡早排除明顯不存在目標的區域,這樣在保證檢測效果的同時兼顧了檢測效率,使得檢測器在檢測速度和檢測性能方面得到了很好的平衡。

1 AdaBoost級聯分類器

AdaBoost級聯分類器最成功的應用是Viola和Jones[5]提出的利用Haar特征和AdaBoost分類器實時人臉檢測方法,這是實時人臉檢測技術的分水嶺。AdaBoost算法同時也是Boosting家族中最具代表性的算法,其他的擴展模型還包括Real Ada-Boost、Gentle AdaBoost、Modest AdaBoost等。

在構建AdaBoost分類器時并沒有規定弱分類器的種類,較為常用的是Haar特征。除此之外常用的弱分類器特征還有聯合類Haar、PCA、局部二進制模式(LBP)、Gabor特征等。

一般情況下,類Haar特征判別能力一般,但計算速度快;PCA特征判別能力強,但計算速度較慢。考慮到飛機通常在圖像中表現為小尺度目標,而Haar特征的優勢在于可以捕捉大范圍的空間對比度特征,并能通過積分圖像快速進行計算,非常適用于大尺寸遙感圖像中的小尺度目標檢測,因而本文采用的是Haar特征。

1.1 Haar弱分類器

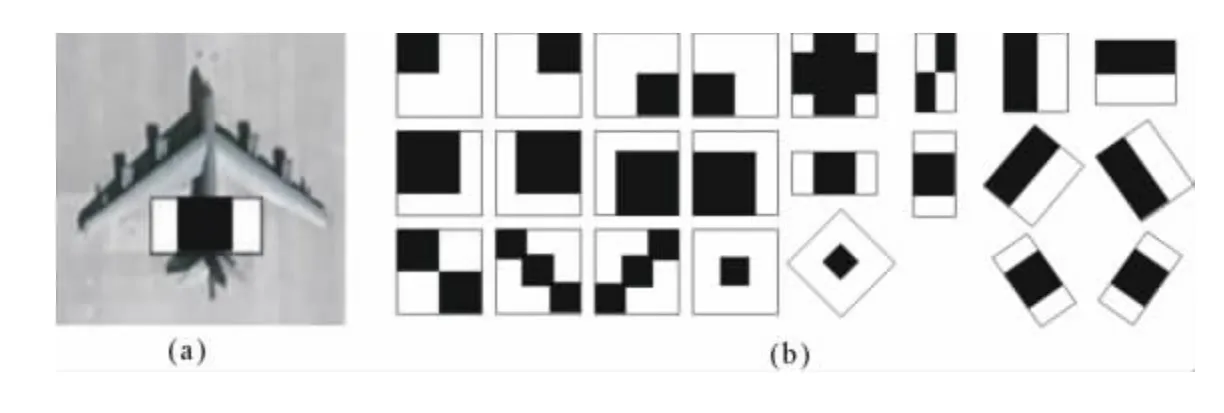

如圖1(a)所示,應用Haar弱分類器對圖像中的一個區域進行特征判別,白色矩形中的像素與減去黑色矩形中的像素和即為Haar特征,所得結果與設定閾值進行比較:

式中:1表示該區域為目標;0為非目標。

為減小區域圖像對亮度變化的敏感,按公式(2)對其進行歸一化處理:

式中:gj為特征函數;M為子圖像中像素個數;msi為子圖像均值;σ2為子圖像方差。

每個弱分類器(由圖1(b)所示的典型Haar特征算子組成)按照上述處理訓練正、負樣本集,并從正確分類的所有弱分類器中選取錯分率最小的一個。

1.2 強分類器

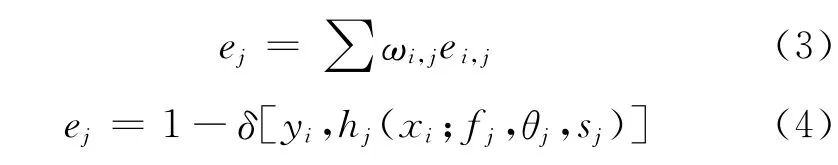

上述弱分類器的性能僅僅優于隨機猜測的結果,但這可以通過訓練多個弱分類器得到1個強分類器來提升算法性能。AdaBoost算法是通過將每個樣本的權重調整作為其在每個階段是否被正確分類的函數,然后用每個階段的平均分類錯誤率在弱分類器中間決定最終權重值。算法描述如下:

圖1 典型Haar特征算子示例

(1)輸入訓練的正樣本和負樣本以及它們的標簽{(xi,yi)},其中yi=1表示正樣本(飛機),yi=-1是負樣本。

(2)初始化樣本權重w=1/N,其中N是訓練樣本的數目。

(3)對訓練的每一步j=1,…,M,進行如下4個步驟更改權重:

(a)重新歸一化權重,使其加起來為1。

(b)通過找到最小化加權分類錯誤率來選擇最好的分類器:

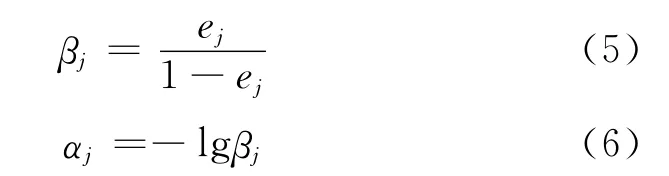

(c)計算修正誤差率βj和分類器的權重αj:

(d)根據分類錯誤率ei,j更新權重:

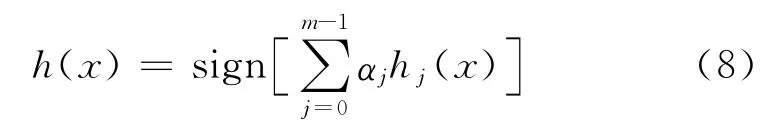

(4)最終的分類器設置為:

1.3 級聯強分類器

為進一步提高檢測器的速度,可以建立一個級聯結構,構成級聯強分類器。重復采用AdaBoost算法訓練強分類器,采用這種策略對每個子窗口圖像都使用一系列的弱分類器計算,在級聯分類器的第1級使用很少的弱分類數目就可以去除大量的非目標子窗口,后面采用相對較多的弱分類器進一步去除背景。

隨著級聯分類器層數的深入,候選飛機子窗口的數量急劇減少,當子窗口圖像通過了所有的強分類器才被認為是目標。這樣使得大部分非目標圖像在經過開始的幾級分類器后就被拒絕,從而大大提高了檢測效率。級聯分類器的性能通過如下2個指標衡量。

(1)檢測率,即:

式中:ri為第i級強分類器的檢測率;K為總級聯數。

因此,對于一個10級的級聯強分類器,為了達到0.9的總檢測率,每級強分類器的檢測率要求為0.99左右。

(2)誤檢率,即:

式中:fi為第i級的誤檢率;K為級聯數。

為了獲得盡可能低的總誤檢率,要求級聯強分類器的每級誤檢率為0.401 0,顯然級聯強分類器的總誤檢率遠遠低于單個強分類器。

訓練好分類器后,就進入到檢測階段,經典的搜索策略是檢測窗自左向右、自上而下地掃描整幅圖像,通常圖像中的目標尺度并不一致,一般戰斗機的尺寸比較小,長度和翼展在十幾米左右,面積約為幾十個像素;運輸機的尺寸比較大,長度和翼展為30~40m,面積約為幾百個像素。

為實現多尺度檢測,檢測器在每個位置將在不同的尺度上進行縮放。整個搜索過程受縮放因子和平移步長的影響。

傳統的搜索策略是一種貪心的遍歷。假設一副1 000×1 000的遙感圖像,從20×20像素大小窗口開始,以1.25倍為尺度步進,平移步長取1.5倍的尺度因子大小,直至檢測窗口超出原始圖像大小。經計算需要產生約110萬個子窗口,而每個子窗口提取的Haar特征數目也是非常巨大的,顯然這種搜索不僅給分類器增加負擔,也使檢測效率大幅下降,是不可取的。

針對如何消除遍歷搜索中的冗余計算問題,文獻[6]提出通過迭代來簡化計算,使運算速度有了很大提高。文獻[7]提出了基于視差梯度的可變搜索策略,算法工作量減少了28%,算法速度提高了3.5倍。

針對這種情況,本文通過詳細分析基于視覺顯著性的目標檢測方法與搜索范圍的聯系,提出了基于視覺顯著計算的搜索策略,根據飛機目標在圖像中表現的顯著特征,將大幅遙感圖像分為幾個小的飛機目標潛在區域,從而快速去除冗余搜索區域,提高了檢測效率。

2 基于視覺顯著計算的飛機潛在區域提取

2.1 視覺顯著區域的生成

利用視覺顯著性來輔助目標檢測實際上就是讓計算機模仿人的判讀作業過程,當觀察一副圖像時,人眼總是優先關注那些“不同”的區域,比如高亮度區域,顏色、形狀與周圍環境反差較大的區域。而這種特性正是在前面引言提到的飛機目標檢測的基礎假設。本文選取亮度、顏色作為提取飛機顯著區域的特征。除此之外,擴展算法還有其它更復雜的改進模型如基于梯度特征[8],基于普殘差[9]的方法等,本文主要是驗證方法的可行性,所以選擇一種最具代表性的計算模型,利用文獻[10]中的方法來生成視覺顯著圖。

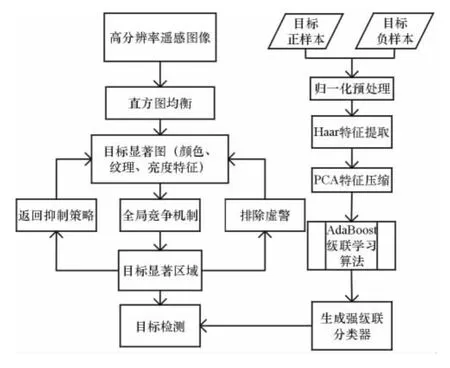

2.2 本文檢測算法流程

如圖2所示,本文方法分為兩部分:一部分是級聯分類器的設計,另一部分是目標顯著區域提取。重點在飛機目標顯著區域的提取,首先對輸入的待檢測圖像進行直方圖均衡化,去除光照的影響,提取顏色、亮度特征生成視覺顯著圖;再利用視覺注意的全局競爭機制和返回抑制策略來快速搜索顯著圖,生成目標的待檢測區域,送入設計好的分類器中。

其中值得說明的是,在分類器設計階段,本文訓練樣本進行了直方圖均衡化預處理,并將樣本歸一化到128×128大小。本文采用的學習特征是計算簡單、速度快的Haar特征,為減輕分類器的負擔,本文采用PCA方法對特征進一步壓縮。

3 實驗結果與分析

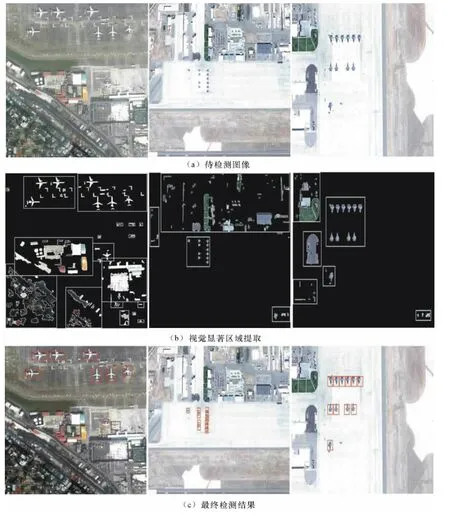

實驗數據來自公開的Google earth衛星圖像,內容為美軍25個主要的空軍基地,共80幅遙感圖像,涉及目前美軍主要作戰飛機。其中,訓練樣本60幅,測試樣本20幅。為了更好適應實際檢測時非目標本體引起的多樣性,訓練集中正樣本的采集為手工裁剪的2 000個不同光照條件(有陰影/無陰影)、不同旋轉角度(60幅原始圖像中以45°步進旋轉8個方向)、不同尺度大小的飛機目標切片,部分正樣本如圖3所示。

圖2 本文算法流程

圖3 部分飛機目標正樣本切片

負樣本包括了4 500個非飛機目標樣本,需要特別說明的是,訓練集中負樣本的選取并非任意非飛機目標區域,主要是基于飛機機場內的典型負樣本,如跑道、停機坪、草地、房屋等,這樣才能真正體現正負樣本之間的差異,提高級聯分類器的檢測率,降低誤檢率。

為了將本文方法與傳統的遍歷搜索目標檢測方法相比,選取了3幅機場圖像進行驗證,如圖4(a)所示,從左至右,第1幅大小為590×661像素,后2幅大小為988×659像素。從圖4(b)后2幅圖中可以清楚地看到,飛機目標區域被準確地提取出來,將顯著圖中非目標區域剔除,計算剩下的區域面積與原始圖像的比值,發現本文方法搜索區域是原圖像的1/3左右,而且目標全部包含在搜索區域當中,這說明該方法是可行的,減少了60%的工作量。但該方法也存在一些弊端,當背景過于復雜時,如圖4(b)第1幅圖像所示,基于視覺顯著圖模型的方法沒有將全部的飛機目標定位出來。圖中黑色方框標注區域為漏檢目標,白色方框為誤檢目標。分析漏檢的原因在于:第一,當目標與周圍背景反差不大時(本文是基于亮度、顏色),本算法的第1步將目標區域當作背景剔除掉;第二,受機場停機坪及周圍房屋、道路影響,本算法沒有很好地將目標鎖定在停機坪內,導致基于視覺顯著搜索的方法只排除掉很少的部分。同時,對于存在的誤檢是因為背景中有部分建筑物存在與飛機機翼相似的結構,而這種情況是需要進一步增加規則來排除的。

圖4 實驗結果圖

綜上所述,本文提出的方法在一定程度上依賴于圖像的內容,這主要受顯著模型的限制。但基于這樣的搜索策略加上基于統計學習的方法,還是可以保證實際的需要,由顯著區域搜索的大小可以判定本文提出的方法平均可以提高50%的檢測效率。

4 結束語

隨著成像分辨率的提高,自然場景圖像和遙感場景圖像原本存在的尺度差異正在逐漸縮小,這為將機器視覺方法引入到高分辨率遙感圖像目標檢測任務中提供了良好的可行性。

針對如何權衡檢測效果與檢測率的問題,本文提出了基于視覺顯著搜索的方法完成了飛機圖像粗定位,去除了圖像中大部分明顯不存在目標的區域,減少了不必要的目標搜索空間,與高檢測率的Ada-Boost級聯分類器相結合,在保證高檢測率的同時,提高了檢測效率,降低了誤檢率。

但基于統計學習的方法,檢測效果受學習樣本的影響較大,不同樣本集合對算法的性能也有一定的影響,本文主要適用于目標受少量光照、陰影的影響,對于目標存在放射變換、視點變換的情況沒有考慮。下一步工作是結合特征縮放和平移算法來進一步提高目標的檢測率。

[1] 王樹國,黃勇杰,張生.可見光圖像中飛機目標的特征選取及提取[J].哈爾濱工業大學學報,2010(7):1056-1059.

[2] 王鵬偉,吳秀清,余珊.基于角點特征和自適應核聚類算法 的 目 標 識 別 [J].計 算 機 工 程,2007,33(6):179-181.

[3] 張正,王宏琦,孫顯,等.基于部件的自動目標檢測方法研究[J].電子與信息學報,2010(5):1017-1022.

[4] 孫顯.基于對象的Boosting方法自動提取高分辨率遙感圖像中建筑物目標[J].電子與信息學報,2009,31(1):177-181.

[5] Viola P,Jones M.Rapid object detection using a boosted cascade of simple features[A].IEEE Vision and Pattern[C],2001:511-518.

[6] 張國云,張兢.基于Gabor小波的多尺度PCA支持向量機人臉識別方法[J].數據采集與處理,2009,24(4):437-442.

[7] 郭龍源,盧阿麗,楊靜宇.基于視差梯度的快速區域匹配方法[J].計算機科學,2007,4(4):239-240.

[8] Liu T,Sun J,Lowe D G.Learning to detect a salient object[A].IEEE Conference on Computer Vision and Pattern Recognition[C],2007:466-474.

[9] 周偉,關鍵,張國華.高分辨率遙感圖像感興趣目標的提取算法[J].光電工程,2011(2):115-121.

[10]Achanta R,Hemami S,Estrada F,et al.Frequencytuned salient region detection[A].IEEE International Conference on Computer Vision and Pattern Recognition[C],2009:1597-1604.