基于差異的視差估計方法研究

高 強,盧云朋,楊紅葉

(華北電力大學 電氣與電子工程學院,河北 保定 071003)

基于差異的視差估計方法研究

高 強,盧云朋,楊紅葉

(華北電力大學 電氣與電子工程學院,河北 保定 071003)

視差估計在立體圖像編碼、視頻檢索、立體圖像分割等領域有重要的應用,是進行圖像、視頻分析的基礎。首先,基于模糊隸屬度提出了一種基于差異的視差估計方法;其次,引入模糊隸屬度,把圖像灰度轉換為差異值;然后,分析了多塊匹配的優越性;提出了基于多塊匹配的視差估計方法;最后,在Middlebury網站上的測試結果證明了該方法的有效性。

視差;隸屬度;立體;差異

在雙目立體視覺系統中,視差是空間中的一點投影到左右雙目成像平面上的成像點的位置差矢量,間接反映了景物的深度信息[1-2]。目前,基于窗口的視差估計方法逐漸受到大多數學者的青睞[3-4]。在該類算法中,窗口的選擇是獲得精準視差圖的關鍵,窗口既要大到保證在低紋理區域能涵蓋足夠的灰度信息,又要小到保證在視差不連續區域獲得光滑視差場。目前還沒有一種黃金標準用以衡量這兩者之間的矛盾。為了克服窗口選擇的困難,出現了自適應窗口和自適應權重的視差估計方法[5-6]。

在塊匹配中,相似性測度的選擇也是決定視差估計效果的關鍵因素。在基于窗口的方法中大多采用的測度有SAD(Sum of Absolute Differences)、SSD(Sum of Squared Difference)、NCC(Normalized Cross-Correlation)[7]。以上測度是基本也是經典的,通常能夠獲得較稠密的視差圖,但在視差不連續及低紋理區域的表現能力較差。針對這個不足很多學者對測度因子進行了改進。將模糊理論引入到相似性測度中,能夠降低由于圖像采集過程中帶來的遮擋、光照、反射、陰影等一系列問題的影響[8-9]。本文基于模糊數學中的隸屬度,提出了一種新的視差估計方法。

1 基于差異的視差估計方法

1.1 差異值的定義式

根據直觀經驗知:某個對象和某個等級(如優、良等)的差異與這個對象屬于這個等級的隸屬度密切相關。如果某個對象屬于某個等級的隸屬度越大,則該對象與該等級的差異就會越小;反之,與該等級的差異越大。顯然差異D與隸屬度u之間的關系具有如下的性質:

1) 差異D是隸屬度u的函數,即D=f(u)。

2) 差異D是隸屬度u的單調遞減函數,即u→1時,D→0;u→0時,D→1。

3) 如果u(x,y)=u(x)·u(y),則D(x,y)=D(x)+

D(y)。

4) 差異D具有模糊性、可加性、單調性和非負性等屬性。

引理[10],如果實函數滿足以下條件:

1) f(x)≥0;

2) f(x)是嚴格單調增函數,即x≥y?f(x)≥f(y);

3) f(x·y)=f(x)+f(y)。

則f(x)=c·logax。

1.1.1 定理1

差異值與隸屬度之間的關系為

(1)

式中:u(0≤u≤1)為屬于某個等級(如優、良、中等)的隸屬度;D(D≥0)為與之對應的某個等級(如優、良、中等)的差異;c(c∈R)為系數;a(a>1)為底數。

結合備注1與引理1即可證明定理1。

定義1:為了方便,將定理1的公式定義為u(0≤u≤1)為屬于某個等級(如優、良、中等)的隸屬度;D(D≥0)為與之對應的某個等級(如優、良、中等)的差異,c(c=1)為系數,a(a=10)為底數時,差異的單位為“階”。

(2)

定義2:假設兩個不同的對象屬于某個等級(如優、良、中、差)的隸屬度分別為u1(0≤u1≤1),u2(0≤u2≤1),與之對應的差異分別為D1(D1≥0),D2(D2≥0),則將兩者之間的差異值定義為

(3)

Dd滿足距離的公理化定義:

1) 0≤Dd(A,B)<∞;

2)A=B?Dd(A,B)=0;

3)Dd(A,B)=Dd(B,A);

4)Dd(A,C)=Dd(A,B)+Dd(B,C)。

1.1.2 定理2

設矩陣A=(aij)n×n,矩陣B=(bij)n×n,矩陣C=(cij)n×n,C=A-B,則

(4)

式中:aij(aij∈R)(i,j=1,2,…,n);bij(bij∈R)(i,j=1,2,…,n)是對象差異值。

證明:由以上可知

cij=aij-bij

(5)

由三角關系

(6)

可得

(7)

即

(8)

(9)

1.2 新的視差估計方法的建立

1.2.1 隸屬度函數

隸屬度函數的選擇,對圖像模糊化效果產生影響。

(10)

圖1為本文中使用隸屬度函數曲線。在選擇隸屬度函數上,本文考慮利用單調隸屬度函數,即灰度值和隸屬度一一對應,因此本文選擇戒上型隸屬度函數,灰度值、隸屬度和差異值一一對應。典型隸屬度函數中的戒上型可表達為

(11)

式中:a,b,c為參數。在本文中,令a=1,b=3,c=0。

圖1 戒上型隸屬度函數

1.2.2 差異值和測度SD(Sum of Differences)的建立

本文基于SAD的思想提出一種新的基于隸屬度測度。IR(x,y)為基準圖中點(x,y)的灰度值,IL(x+d,y)為對準圖中點(x+d,y)的灰度值;W為以點(m,n)為中心的匹配窗口。則兩個窗口的SAD的算法表達式為

(12)

式中:d為視差。基于SAD的表達式,可得差異測度的表達式為

(13)

式中:u(IR(x,y))和u(IL(x+d,y))分別是右圖像中點(x,y)和左圖像中點(x+d,y)的隸屬度;lgu(IR(x,y))和lgu·(IL(x+d,y))是相應隸屬度的差異值。

SAD視差估計方法是基于窗口的,處理過程中只是針對圖像灰度進行處理,對處于視差不連續區域邊界上灰度值進行匹配時,圖2中兩個匹配窗口的中心點恰好匹配。若中心點向右移動,則會出現圖3中兩個窗口的中心點原則上匹配,但通過觀察看到兩個矩形窗口內灰度值和差別很大,實際匹配過程無法正確匹配,造成誤匹配。本文提出的基于模糊隸屬度的視差估計算法,利用隸屬度函數將圖像灰度值轉化為模糊化的差異值,將圖像的差異值矩陣轉換到0~255范圍(見圖4)。由圖4可知,經過轉換后,原圖像灰度值都被放大,但在低灰度值區域被放大的倍數要遠大于在高灰度區域的倍數,即縮小了低灰度區域與高灰度區域之間的差距。當出現圖3的情況時,由于低灰度區域被放大得很多,高灰度區域被放大得很少,能夠使得兩個窗口內的差異值和基本一致,從而正確匹配,提高在視差不連續區域的穩健性。

圖2 窗口處于視差連續區邊界

圖3 窗口處于視差不連續區域

圖4 窗口處于視差不連續區域

1.2.3 多塊匹配

假定Ai(i=1,2,3,4)分別代表圖5a中以像素點ai(i=1,2,3,4)為中心的窗口W(n×n)內像素的均值;Bi(i=1,2,3,4)分別代表圖5b中以像素點bi(i=1,2,3,4)為中心的窗口W(n×n)內像素的均值。

圖5 左、右圖像4塊匹配示意圖

在基于塊匹配的視差估計方法中通常采用單個塊之間的匹配為:A1→B1或A2→B2或A3→B3或A4→B4。

如圖5所示,匹配過程中如果滿足

(14)

(15)

(16)

(17)

式中:th為設定的閾值,則認為其相似度較大,即判定對應塊匹配。對應這樣的匹配可以找到對應的塊,但是匹配精度過低。若采用A1A2A3A4→B1B2B3B4之間的匹配,即4個塊之間合起來進行相似性的比較,即

(18)

式中:TH為設定的閾值,根據上文定理2,單個塊之間分別判定相似度與多個塊聯合再判斷相似度滿足下列條件

(19)

式(19)說明單個塊之間的差值的和大于多個塊之間和的差,由于SAD/SD屬于最小距離測度,距離越小,相似度越大,利用多個塊進行匹配比利用單個塊進行匹配具有更高的可靠性根本原因是多塊匹配利用了塊與塊之間的關聯信息。

基于多塊匹配的算法流程如下:

1)以右圖像為參考圖像,在右圖像中選定一個窗口。

2)在左圖中選定同一大小的窗口。

3)根據立體匹配外極限約束,兩個匹配的窗口在同一水平線上,因此移動左圖中的窗口,找到與右圖像中最相似的子窗口,則用單塊匹配原則判定這兩個窗口的中心點為對應匹配點,將這兩個子窗口做好標記。

4)移動右圖中的窗口使其中心點到下一像素點,重復步驟2)、3),找到另外兩個對應的子窗口,做好標記。

5)找到的被標記兩對子窗口,利用多塊匹配方法判斷其相似性,若判斷為相似,則保留這兩對子窗口;若不相似,則放棄這兩對子窗口的匹配結果。

2 實驗結果與分析

在為了驗證基于差異的視差估計方法的正確性及有效性,借助標準圖像對比較基于差異視差估計算法與其他方法的性能。

2.1 與基于SAD的視差估計方法及參數不同的新方法的直觀比較

本文提出的SD測度因子是基于SAD測度因子的思想,因此本文首先與SAD的方法進行比較。圖6為Tsukuba的左視圖像與真實視差圖,圖7為SAD與SD的比較結果。圖7中第1行為基于SAD的視差估計方法所得結果,第2行為基于SD的視差估計方法所得結果,其中參數為a=0.1,b=3,c=0。從圖7中可看到基于SD的視差估計方法誤匹配點較少(圖中黑點代表誤匹配點),即提高了匹配精度。

2.2 實驗數據對比與分析

圖6 Tsukuba圖像

圖7 基于SAD與基于SD的視差估計方法視差圖對比圖

上文從直觀角度說明了基于差異的視差估計方法的正確性與有效性,在本節中將從實驗數據上分析本文提出方法的正確性與有效性。同時為了比較本文提出的算法與其他區域立體匹配算法的優劣,本文利用middlebury網站提供的SSD+MF[11]和SAD-IGMCT[12]兩種方法做了比較,這兩種算法都是以區域匹配算法SAD或SSD作為獲取初始視差圖的方法,而后再利用其他理論的聯合視差估計算法。

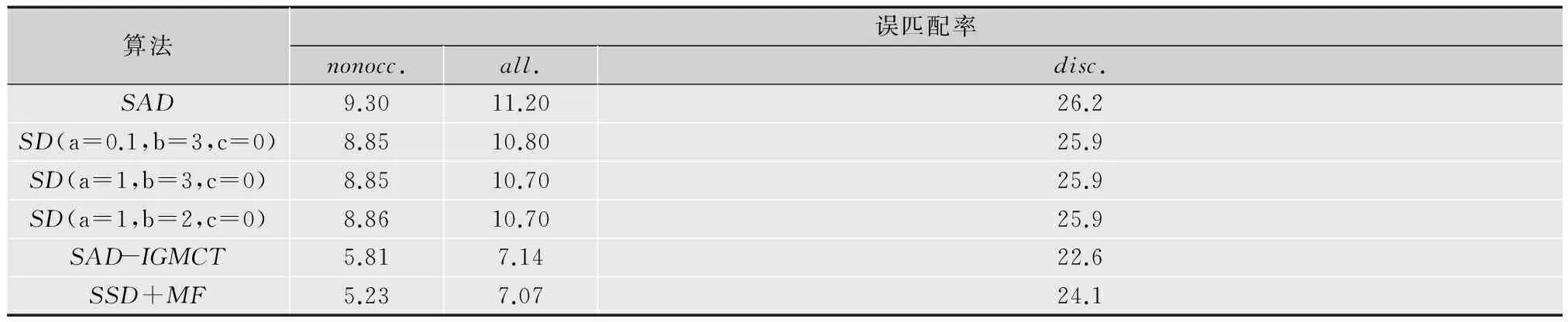

如表1所示,實驗數據為在middlebury網站測試結果,其中nonocc代表未遮擋區域誤匹配率,all代表全部區域誤匹配率,disc代表視差不連續區域誤匹配率。從表1實驗數據可得以下結論:

1)本文提出的基于差異的視差估計方法與基于SAD的視差估計方法性能有一定提升,主要表現在非遮擋區(nonocc)誤匹配率由原來的9.3%下降到8.85%;全局(all)由原來的11.2%下降到10.8%;尤其是在視差不連續區(disc)由原來的26.2%下降到25.9%,說明了本方法能夠提升視差不連續區域的匹配精度,即具有很好的穩健性。

2)基于差異的方法中隸屬度函數參數不同時匹配精度略有不同。

3)由表中與SAD-IGMCT的聯合視差估計方法相比,基于SD的算法性能仍需進一步提高。

表1 Tsukuba圖像在基于SAD及SD視差估計方法的誤匹配率 %

3 結論

本文提出了一種基于差異的視差估計方法。在相似性測度因子中引入了模糊隸屬度,分析了隸屬度的選擇對視差估計方法的影響,分析了利用多塊匹配代替單塊配的優越性。本文提出的方法在視差不連續區域具有良好的穩健性,適合于邊界模糊的立體圖像的初始視差估計。本方方法與聯合視差估計方法相比匹配精度較低,結合其他理論以提高匹配精度是今后研究的重點。

[1]段軍,何明一,戴玉超.基于線段分割的圖割立體匹配[J].電視技術,2012,36(11):15-18.

[2]吳方,王沛.一種改進的自適應權重立體匹配算法與校正[J].電視技術,2012,36(11):19-23.

[3]GUPTARK,CHOSY.Window-basedapproachforfaststereocorrespondence[J].IETComputerVision,2013,7(2):123-134.

[4]SUX,KHOSHGOFIAARTM.Arbitrarily-shapedwindowbasedstereomatchingusingthego-lightoptimizationalgorithm[C]//Proc.IEEEInternationalConferenceonImageProcessing,2007(ICIP2007).[S.l.]:IEEEPress,2007:556-559.

[5]DE-MAEZTUL,VILLANUEVAA,CABEZAR.Stereomatchingusinggradientsimilarityandlocallyadaptivesupport-weight[J].PatternRecognitionLetters,2011,32(13):1643-1651.

[6]GUZ,SUX,LIUY,etal.Localstereomatchingwithadaptivesupport-weight,ranktransformanddisparitycalibration[J].PatternRecognitionLetters,2008,29(9):1230-1235.

[7]MEIX,SUNX,ZHOUM,etal.Onbuildinganaccuratestereomatchingsystemongraphicshardware[C]//Proc.IEEEInternationalConferenceonComputerVisionWorkshops,2011(ICCVWorkshops2011).[S.l.]:IEEEPress,2011: 467-474.

[8]DUTTAA,KARA,CHATTERJIBN.Anovelapproachtocornermatchingusingfuzzysimilaritymeasure[C]//Proc.7thInternationalConferenceonAdvancesinPatternRecognition,2009(ICAPR′09).[S.l.]:IEEEPress,2009:57-60.

[9]GALARM,FERNANDEZJ,BELIAKOVG,etal.Interval-valuedfuzzysetsappliedtostereomatchingofcolorimages[J].IEEETrans.ImageProcessing,2011,20(7):1949-1961.

[10]SAFFEB,SNIDERAD.Fundamentalsofcomplexanalysiswithapplicationstoengineering,science,andmathematics[M].NJ:PrenticeHall,2003.

[11]SCHARSTEIND,SZELISKIR.Ataxonomyandevaluationofdensetwo-framestereocorrespondencealgorithms[J].InternationalJournalofComputerVision,2002,47(1):7-42.

[12]AMBROSCHK,KUBINGERW.Accuratehardware-basedstereovision[J].ComputerVisionandImageUnderstanding,2010(11):1303-1316.

責任編輯:時 雯

New Disparity Estimation Method Based on Difference Measurement

GAO Qiang,LU Yunpeng,YANG Hongye

(SchoolofElectricalandElectronicEngineering,NorthChinaElectricPowerUniversity,HebeiBaoding071003,China)

Disparity estimation is a basic analytic method for images and video and is highly used in fields like stereo image coding,video retrieval and stereo image segmentation.A new disparity estimation method based on the membership degree in fuzzy mathematics is proposed.In this paper,the membership degree is introduced,gray values of the image are transformed to difference values.Meanwhile,the superiority of the multi-block matching is analyzed.The new method based on the idea of block matching constructs a multi-block matching algorithm.The experimental results based on the Middlebury stereo datasets demonstrate that this method can achieve a better performance.

disparity;membership degree; stereo; difference

【本文獻信息】高強,盧云朋,楊紅葉.基于差異的視差估計方法研究[J].電視技術,2015,39(3).

TN911.73;TP391.4

A

10.16280/j.videoe.2015.03.006

2014-02-09