融合句義結構模型的短文本推薦算法研究

原玉嬌 羅森林 林 萌 潘麗敏

(北京理工大學信息與電子學院 北京 100081)

?

融合句義結構模型的短文本推薦算法研究

原玉嬌 羅森林 林 萌 潘麗敏

(北京理工大學信息與電子學院 北京 100081)

(571033195@bit.edu.cn)

傳統(tǒng)的基于協(xié)同過濾的推薦系統(tǒng)需要收集用戶興趣喜好等相關數(shù)據(jù),在一定程度上涉及到用戶的個人隱私,當前信息安全和隱私保護是數(shù)據(jù)挖掘領域的熱點之一,為了有效避免用戶信息泄露帶來的安全問題,提出一種融合句義結構模型的短文本推薦方法.該方法以句子為研究對象,首先利用LDA主題模型構建文章-主題矩陣,劃分子主題,然后利用句義結構模型抽取句子的語義格得到句子的語義特征,基于LDA主題模型使用句義結構計算句子兩兩之間的語義相似度,構建相似度矩陣,融合句子的語義特征和關聯(lián)特征綜合加權得到句子權值,以文章內最高單句權值衡量文章權值,將文章權值統(tǒng)一進行排序,按照排序順序去冗余后依次推薦.在壓縮比為0.5%的條件下,ROUGE-1值達到31.388%,ROUGE-SU*達到15.701%.實驗結果表明,以句子為粒度的短文本推薦算法能豐富文本的特征信息、深化語義分析層次,在數(shù)據(jù)處理過程中未收集用戶信息,從而有效避免用戶信息泄露等安全問題,實現(xiàn)更加安全、快速向用戶推薦文本.

微博;短文本推薦;主題模型;自然語言處理;信息安全

在信息推薦和檢索領域,推薦系統(tǒng)的研究非常熱門.而文本推薦又是推薦系統(tǒng)眾多應用中使用最廣泛、研究最熱門的方向之一.推薦系統(tǒng)要解決的問題是按照一定的方法對待推薦的個體內容(如電影、書籍、文本等)進行打分,個體內容得分越高,其在最后的推薦結果中排名越靠前.系統(tǒng)將這些個體按得分從高到低依次推薦給用戶.

隨著互聯(lián)網(wǎng)的飛速發(fā)展,Web平臺上的各類資源呈現(xiàn)出幾何級數(shù)的增長,文本資源更是如此.以新浪微博為例,用戶點擊某一熱門話題,得到的是按照熱門程度或發(fā)表時間排序的所有相關微博.然而,由于數(shù)量龐大,一方面用戶需要花大量時間在結果中尋找自己真正關心需要的信息,另一方面用戶得到的信息經(jīng)常是不全面的,甚至是不相關的或者是重復的,信息獲取的效率很低.因此對微博這種短文本信息進行推薦能大大提高信息獲取的效率.

現(xiàn)有的文本推薦模型一般基于對文本集分析或者用戶日志分析進行推薦.這些模型分別可進行基于聚類的推薦、關聯(lián)規(guī)則推薦、協(xié)同過濾推薦,主要是基于規(guī)則和統(tǒng)計的并未充分考慮文本的語義信息,對于微博這種篇幅短小,特征詞稀疏,缺失結構信息的短文本,必然出現(xiàn)推薦結果單一、覆蓋不全面、準確率不高的問題.所以解決推薦的文本與話題相關度差的問題具有十分重要的意義.

1 相關工作

推薦算法經(jīng)過多年的發(fā)展已經(jīng)有了很多方法和技術.代表性的方法有基于協(xié)同過濾的推薦算法[1]、基于內容的推薦算法[2]、基于圖結構的推薦算法以及混合推薦結構的算法.

基于內容推薦是最早被使用的推薦方法.它根據(jù)分析用戶行為,為用戶推薦相似的項目,最早主要應用在信息檢索系統(tǒng)當中,很多信息檢索及信息過濾里的方法都能用于基于內容推薦中,算法的根本在于內容的獲取和定量分析,微博篇幅短小,關鍵詞特征稀疏,并且單條微博內關鍵詞的重復率不明顯,傳統(tǒng)的基于內容的推薦算法在處理微博數(shù)據(jù)時面臨著數(shù)據(jù)稀疏性問題、可擴展性問題、特征提取等問題,因此需要結合微博特性與傳統(tǒng)推薦算法的優(yōu)點來進行文本推薦.基于協(xié)同過濾推薦算法從盡量考慮用戶的偏好轉為追求推薦高效率的商業(yè)推薦.在常見的電子商務網(wǎng)站中,協(xié)同過濾算法是通過參考用戶對商品的喜好程度和評分來實現(xiàn)推薦的.協(xié)同過濾算法的核心思想就是將用戶、商品和評價三者之間建立聯(lián)系,這種推薦算法不太適合處理短文本信息.

近年來,針對微博的推薦系統(tǒng)也取得了一些成果,2009年Netflix比賽冠軍Koren等人首次引入矩陣分解技術應用于協(xié)同過濾推薦系統(tǒng),矩陣分解模型是目前為止在評分預測方向做得最好的基礎模型[3].2013年Bian等人[4]提出融合微博多媒體信息生成可視化推薦文本.SumBasic[5]是一種基于詞頻統(tǒng)計的多文檔摘要技術,Inouye等人[6]在Sharifi研究的基礎上提出一種基于聚類的Hybird TF-IDF摘要方法,這種方法計算詞的TF(term frequency)值是該詞在語料庫中出現(xiàn)的次數(shù)除以語料庫中出現(xiàn)的詞數(shù),而計算IDF(inverse document frequency)值時,又將每篇微博作為一個單獨的文檔對待,計算方法為出現(xiàn)該詞的微博總篇數(shù)除以語料中的微博總數(shù).實驗證明將此方法應用在推薦系統(tǒng)文本相似度計算中取得了很好的實驗效果.在國內也有一些個性化推薦系統(tǒng)方面的研究成果:2009年北京大學楊建[7]利用LDA模型,結合網(wǎng)絡新聞的特點,提出了一種新聞個性化推薦系統(tǒng);清華大學的路海明等人[8]提出基于多Agent 混合智能實現(xiàn)個性化推薦;清華大學的馮翱等人[9]提出了基于Agent的個性化信息過濾系Open Bookmark等.

針對微博推薦的系統(tǒng)大多基于詞形詞頻等統(tǒng)計信息進行特征抽取,忽略了文本內句子的成分信息以及語句之間的關聯(lián)性,對文本語義信息分析不全面,因此導致僅僅基于詞形匹配的相似度計算方法無法真實反映內容相似度;同時在計算文章權值時,未充分利用文章所處的子主題信息,導致推薦的文章與子主題的相關性較差.本文針對以上問題提出一種融合句義結構模型[10]的短文本推薦方法.

2 算法原理

針對現(xiàn)有方法推薦文本冗余度高的問題,一方面從語義內容分析的角度出發(fā),利用句義結構模型分析語義項之間的依存關系擴充語義維度,利用句義特征準確表達語句信息及句子內容的相似性.針對現(xiàn)有推薦方法文章話題性差的問題,本文一方面通過LDA主題模型計算得到文章-主題矩陣,用聚類劃分子主題的方法解決由于數(shù)據(jù)稀疏性導致子主題發(fā)現(xiàn)不全面的問題,另一方面從挖掘句子之間的隱藏語義聯(lián)系及子主題信息的角度出發(fā),提出一種抽取句子關聯(lián)特征的方法.關聯(lián)特征表示句子與話題的語義聯(lián)系度,利用關聯(lián)特征增強相似語句的語義聯(lián)系.綜合加權句子的語義特征和關聯(lián)特征,計算文章權值實現(xiàn)推薦文章.

本文方法首先將文檔集合分句、句子清洗、分詞和詞性標注得到預處理結果,然后對預處理結果分別計算語義權值和關聯(lián)權值.計算語義權值時,統(tǒng)計預處理結果中所有實詞出現(xiàn)的句子頻率,按句子頻率從大到小排序,選擇前N個詞作為主題詞的種子詞,加入哈爾濱工業(yè)大學的同義詞林擴展版(HIT IR-Lab Tongyici Cilin (Extended))進行擴展,得到擴展后的主題詞表.結合主題詞表,分析句子的語義特征,包括詞性詞法特征以及句義結構特征,對各個特征線性加權,得到句子的語義權值.計算關聯(lián)權值時,需要先對預處理結果進行句子相似度計算,得到句子兩兩之間的語義相似值,構建相似度矩陣,利用句子兩兩之間的語義相似值,計算句子與類內及類外其他句子的語義相似度,得到句子的關聯(lián)權值.通過LDA主題模型計算得到文章-主題矩陣聚類劃分子主題,最后對句子的語義權值和關聯(lián)權值綜合加權,得到句子權值.每篇文章中把單句最高權值作為文章的權值,最后依次選擇子主題內權重最大的文章推薦,通過去除冗余操作確保最終推薦的文章質量.算法原理圖如圖1所示:

圖1 算法原理圖

圖2 預處理原理圖

2.1 預處理

分句、句子清洗是預處理的第1步,將微博中噪音數(shù)據(jù)進行處理.使用中國科學院的ICTCLAS分詞系統(tǒng)對文檔進行分詞處理.將有效詞數(shù)(名詞、動詞、形容詞、數(shù)詞、時間詞等實詞)小于4的句子去除.最后,對分詞后的結果去除中英文停頓詞(stopwords).預處理原理圖如圖2所示.

2.2 LDA子主題劃分

LDA模型是一種常用的主題模型,由Blei等人[11]于2003年提出.它是一個生成性的3層貝葉斯網(wǎng)絡,將詞和文檔通過潛在的主題相關聯(lián).類似于很多概率模型,LDA中也做了詞袋(bag of words)假設,即在模型中不考慮詞匯的順序而只考慮它們的出現(xiàn)次數(shù).

LDA 模型假設主題由詞項以特定概率組成,文檔集共同擁有這些主題,每個文檔表示為主題的概率分布,概率分布由Dirichlet分布產(chǎn)生.圖3 中外層的大矩陣表示文檔集中的每一篇文檔抽取主題概率分布θm,內層的小矩陣表示從主題分布中反復抽取得到該篇文檔的詞.

圖3 LDA圖模型

LDA由文檔層的參數(shù)(α,η)確定,α反映文檔集中隱含主題間的相對強弱,代表了所有隱含主題自身的概率分布.θm是文檔-主題分布代表文檔中各隱含主題的比重,β表示主題-詞分布[12],Zm,n表示文檔分配在每個詞上的隱含主題比重,Wm,n是文檔的詞向量表示.其中K為主題個數(shù),N表示該文檔的詞總數(shù),M為文檔集中文檔個數(shù).θm的概率密度公式如下:

(1)

其中,參數(shù)α是一個k維且αi>0的向量,Γ(x)是Gamma函數(shù),k維Dirichlet隨機變量θ是一個k-1維的單形.Dirichlet分布屬于指數(shù)族,是一種簡單的單形分布.

LDA文檔的生成過程是:首先使用Dirichlet分布選擇主題的概率分布,基于選出的主題選擇文檔的詞:

1) 從Dirichlet先驗η中為每個主題k抽取多項式分布βk,共抽取k個分布;

2) 從Dirichlet先驗數(shù)α中第m篇文檔抽取多項式分布θm,共抽取M個分布;

3) 對語料庫中的第m篇文檔和文檔中的詞匯wm,n:

① 從多項式變量θm中抽取主題zm;

② 從多項式變量βk中抽取詞wm,n.

單條微博通常涉及一個或多個主題,微博的這個特征正好和LDA主題模型匹配,同時LDA主題模型是完全概率生成模型,可以直接利用成熟的概率算法來訓練模型,模型使用方法也比較簡單.LDA主題模型的參數(shù)空間規(guī)模是固定的,與文本集自身規(guī)模無關,更適用于大規(guī)模文本集.因此本文采用LDA主題模型來推斷微博的主題分布.

實驗使用Gibbslda++工具計算LDA主題模型得到文檔-主題概率分布,對其進行聚類劃分子主題.在壓縮比為0.5%情況下,實驗選取一個話題調整聚類個數(shù),ROUGE-1取值變化如圖4所示:

圖4 子主題參數(shù)選擇實驗

子主題是圍繞中心主題發(fā)生的現(xiàn)象、后果以及原因等的說明是對中心主題不同側面的描述,在LDA主題模型計算得到文章-主題矩陣之后聚類劃分子主題.

2.3 語義權值計算

通過分析句子的語義特征,挖掘句子的內容信息最終映射到文章的語義表達,目前對句子語義特征提取的主要方法是基于詞法句法分析,本文在傳統(tǒng)詞法句法分析的基礎上,融入句子的句義結構特征,深化了句子分析的深度,能夠更好地挖掘文本的語義信息,以句子為單位進行語義挖掘能夠更加準確、深入地表達文章信息.

編號1,2的特征項是對句子有效詞的統(tǒng)計特征.一般認為名詞(noun)、動詞(verb)比其他詞性更重要,賦權重為2,其余詞性權重為1.話題、謂詞、述題特征是句子的核心內容,若該句的以上特征在主題詞表內,則說明該句的核心內容跟主題相關,出現(xiàn)的詞數(shù)越多則該句與主題聯(lián)系越緊密,越能表達主題中心的意義.一般項的句義功能是描述基本項和謂詞,對其表達的內容做進一步說明和補充.因此,本文也將句子一般格中包含的主題詞選為特征,作為對一般項和謂詞的補充.句子的語義權重值計算方法如式(2)所示:

(2)

pcon(Sk)是句子Sk的語義權重值,F(xiàn)i和ui分別代表語義特征的值和該特征的加權系數(shù).本文使用的語義特征如表1所示:

表1 句子語義特征

2.4 聯(lián)系權值計算

通過句子相似度計算出句子兩兩之間的語義相似值,構建句子的n維空間向量表示,形式如式(3)所示,空間中的每一維wk,j是句子Sk對Sj的相似度值:

V(Sk)=(wk,1,wk,2,…,wk,n).

(3)

句子的關聯(lián)特征表示句子與話題的語義聯(lián)系度,通過加權計算該句與不同子主題中其他句子的語義重合度得出.句子Sk對Sj的語義重合度C(Sk,Sj)定義為句子Sj的語義權重值Pcon(Sj)與Sj對Sk的句子相似度值S(Sk,Sj)的乘積,如式(4)所示:

C(Sk,Sj)=Pcon(Sj)×S(Sk,Sj).

(4)

構建無向圖G(S,E),圖中的每個節(jié)點S對應一個語句,邊E(Si,Sk)表示語句Si與Sk的句子相似度值.節(jié)點S的度d是與S相連的邊的數(shù)目,反映了S包含信息的重要程度:d越大則對應語句所關聯(lián)的語句數(shù)目越多,那么這個句子所包含的信息越重要;反之亦成立.另一方面,如果一個節(jié)點的度比較大,那么與之相關聯(lián)的語句也相應的比較重要.令節(jié)點S的初始值為句子的內容權重值,通過計算其他句子對該句的語義重合度得到句子的聯(lián)系權重值.考慮到同一個子主題下句子聯(lián)系緊密,設加權系數(shù)為1,不同子主題下句子的加權系數(shù)由子主題的平均句子內容權重得出.

2.5 文章權值計算

文章拆分成句子集合,文章權值大小取決于句子權值大小,目前計算句子重要性大部分都僅僅偏重于挖掘句子本身的內容,而忽略了句子所處“環(huán)境”的影響.一個值得推薦的文章,內容上不僅要緊扣主題,同時也應該與語料庫中的其他文章聯(lián)系緊密.本文所使用的句子權重計算方法不僅考慮了句子的語義信息同時也考慮了句子的關聯(lián)特征.句子權值的計算公式如下:

P(Si)=α×Pcon(Si)+β×Prel(Si),α+β=1,

(5)

P(Si)是句子Si的最終權值,Pcon(Si)是句子Si的語義權值,Prel(Si)是句子Si的聯(lián)系權值,參數(shù)α調整語義權值和聯(lián)系權值的權重.

2.6 文本選擇

在得到熱點話題下所有子主題內每篇文章權值后通過計算子主題重要性確定文章推薦的順序以及數(shù)目,其中子主題重要性與2個方面因素有關:子主題包含的文章數(shù)目以及子主題內文章的平均權重. 如果子主題內包含的文章數(shù)目越多、文章的平均權值越大說明該子主題越重要,被推薦的可能性越大.子主題重要程度計算公式如下:

(6)

其中,S(Ci)表示子主題Ci的得分,Pave(Ci)表示子主題Ci的文章的平均權值,k表示子主題個數(shù),Ni表示子主題Ci包含的文章個數(shù).參數(shù)θ調整子主題內文章的平均權值和文章數(shù)目的權重,一般認為兩者同樣重要,本文θ取0.5.

(7)

其中,TCi表示子主題Ci的文章抽取個數(shù),S(Ci)表示子主題Ci的得分,k表示子主題個數(shù),R代表壓縮比的值,在這里R取0.5%,Nj表示不同子主題內文章的數(shù)目.

推薦文章時,選擇的文章不僅要與主題的相關度高,同時在內容上與其他待推薦文章的冗余度盡可能小,在推薦的過程中通過計算文章的相似性大于指定閾值則排除確保推薦的文章能從不同側面反映熱點話題的內容.

3 實驗分析

3.1 數(shù)據(jù)源

實驗數(shù)據(jù)采用NLP&&CC會議2013年中文微博觀點要素抽取評測語料.該語料包含2013年3月的微博話題,類別樣本不平衡,實驗數(shù)據(jù)的具體描述如表2所示.其中,文本有效長度是指經(jīng)過分詞去除停用詞后每篇微博包含的詞的個數(shù).由北京理工大學信息系統(tǒng)及安全對抗實驗中心的博士、碩士對每個話題生成壓縮比為0.5%的標準推薦文本.其生成過程如下:首先每3人對同一話題文本集提取不同壓縮比的人工摘要,然后由自然語言處理小組的10名博士、碩士對3份人工摘要進行評價并計算平均得分,將平均得分最高的摘要作為標準摘要放入標準摘要集,如果得分相同則都放入標準摘要集中.

表2 實驗數(shù)據(jù)

3.2 評價方法

本文采用多文檔摘要的通用評價方法ROUGE[13]toolkit(v1.5.5)作為評價標準.ROUGE方法通過計算候選摘要與標準摘要的詞單元重合度來區(qū)分候選摘要的質量,計算的值包括ROUGE-N,ROUGE-W(本文w取1.2)和ROUGE-SU等.具體計算公式如下:

(8)

(9)

(10)

其中,n代表n-gram的長度,S表示文檔,其中下標ref表示文檔屬于標準摘要,下標candi表示文檔屬于待評價摘要,Countmatch(gramn)表示同時出現(xiàn)在待評價摘要和標準摘要的n-gram的個數(shù),Count(gramn)為標準文摘中的n-gram個數(shù).

3.3 對比實驗

為了驗證本文方法的有效性,建立了2個對照方法與本文方法進行對比實驗.

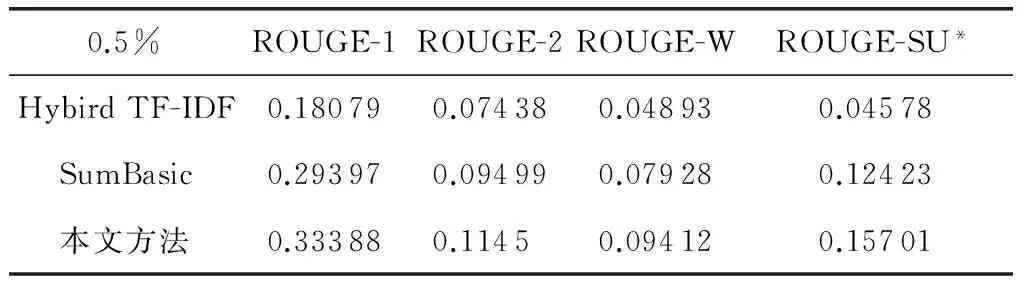

Hybird TF-IDF[6]是Inouye于2011年提出的一種基于聚類的微博話題摘要方法,該方法計算詞的TF(term frequency)值是該詞在語料庫中出現(xiàn)的次數(shù)除以語料庫中出現(xiàn)的詞數(shù),而計算IDF(inverse document frequency)值時,又將每篇微博作為一個單獨的文檔對待,計算方法為出現(xiàn)該詞的微博總篇數(shù)除以語料中的微博總數(shù).并已被證明比一些主流的多文檔摘要方法效果要好.SumBasic[5]是經(jīng)典的基于詞頻統(tǒng)計的多文檔摘要方法,在DUC06測評大會上按代表性指標排序排名第三,并已取得實用.把這2種方法應用到微博推薦系統(tǒng)中,在壓縮比分別為0.5%的條件下,3組系統(tǒng)的實驗結果如圖5、表3所示,圖6、表4展示了本文方法處理6組話題ROUGE指標值.

圖5 對比實驗結果

0.5%ROUGE-1ROUGE-2ROUGE-WROUGE-SU*HybirdTF-IDF0.180790.074380.048930.04578SumBasic0.293970.094990.079280.12423本文方法0.333880.11450.094120.15701

圖6 不同話題的ROUGE值

0.5%ROUGE-1ROUGE-2ROUGE-WROUGE-SU*毒玩具0.325280.142860.099940.12633查韋斯0.291310.052910.081020.1176曼聯(lián)vs皇馬0.300610.070510.075530.12728王語嫣0.339170.075370.09310.16558錘子ROM0.35730.138240.086740.17275中國方言式英語0.389610.207110.128430.23254

4 結 論

本文提出一種融合句義結構模型文本推薦方法.在數(shù)據(jù)處理過程中未收集用戶信息從而有效避免用戶信息泄露等安全問題,同時能夠產(chǎn)生較優(yōu)的推薦結果,以滿足推薦系統(tǒng)的需要.本方法首先利用LDA主題模型計算得到文章-主題矩陣劃分子主題,用句義結構模型分析句子的語義特征得到語義權值,基于LDA主題模型使用句義結構計算句子內容相似值,得到句子的關聯(lián)特征.最后綜合加權句子內部語義特征和外部關聯(lián)特征得到句子權值,通過計算得到文章權值.實驗證明通過LDA主題模型劃分子主題的方法,可以有效解決由于微博文本數(shù)據(jù)稀疏導致的子主題發(fā)現(xiàn)不全面的問題,分別計算句子的語義權值和關聯(lián)權值深化語義分析層層次,提高了語義挖掘的深度使得文章相似性計算更準確,考慮文章與主題的相關性,從而使得推薦文章與子主題相關性更高.

下一步研究的重點是引入句子結構項之間的依存關系作為特征,完善句義結構模型的特征體系,計算文章權值時引入新的特征性,從而生成更高質量的推薦系統(tǒng).

[1]Wang J, Li Z, Yao J, et al. Adaptive User Profile Model and Collaborative Filtering for Personalized News[M]. Berlin: Springer, 2006: 474-485

[2]Barranco MJ, Martinez L. A method for weighting multi-valued features in content-based filtering[G]LNAI. Berlin: Springer, 2010

[3]Koren Y, Bell R. Recommender Systems Handbook[M]. Berlin: Springer, 2011: 145-186

[4]Bian J, Yang Y, Chua T. Multimedia summarization for trending topics in microblogs[C]Trends in Applied Intelligent Systems. New York: ACM, 2013: 1807-1812

[5]Vanderwende L, Suzuki H, Brockett C, et al. Beyond SumBasic: Task-focused summarization with sentence simplification and lexical expansion[J]. Information Processing and Management, 2007, 43(6): 1606-1618

[6]Inouye D, Kalita J K. Comparing Twitter summarization algorithms for multiple post summaries[C]Proc of the 3rd IEEE Int Conf on Privacy, Security, Risk and PASSATSocialcom2011. Los Alamitos, CA: IEEE Computer Society, 2011

[7]楊建. 基于LDA模型的新聞個性化推薦系統(tǒng)后臺的設計與實現(xiàn)[D]. 北京: 北京大學, 2009

[8]路海明, 盧增祥. 基于多Agent混合智能實現(xiàn)個性化網(wǎng)絡信息推薦[J]. 計算機科學, 2000, 27(7): 32-34

[9]馮翱, 劉斌, 盧增祥, 等. Open Bookmark——基于Agent的信息過濾系統(tǒng)[J]. 清華大學學報: 自然科學版, 2001, 41(3): 85-88

[10]羅森林, 韓磊, 潘麗敏, 等. 漢語句義結構模型及其驗證[J]. 北京理工大學學報, 2013, 33(2): 166-171

[11]Blei D M, Ng A Y, Jordan M I. Latent dirichlet allocation[J]. Journal of Machine Learning Research, 2003, 3(45): 993-1022

[12]楊瀟, 馬軍, 楊同峰, 等, 主題模型LDA的多文檔自動文摘[J]. 智能系統(tǒng)學報, 2010, 5(2): 169-176

[13]Harabagiu S M, Hickl A. Relevance modeling for microblog summarization[C]Proc of the 5th Int AAAI Conf on Weblogs and Social Media. Menlo Park, CA: AAAI, 2011

原玉嬌

碩士研究生,主要研究方向為文本安全、中文信息處理.

yuanyujiao@bit.edu.cn

羅森林

教授,博士生導師,主要研究方向為信息安全、媒體計算、生物信息處理.

luosenlin@bit.edu.cn

林 萌

碩士研究生,主要研究方向中文摘要、文本信息處理.

lemon0919@bit.edu.cn

潘麗敏

工程師,主要研究方向為圖像處理、信息安全.

panlimin@bit.edu.cn

Research on Short Text Recommendation Merging Sentential Semantic Structure Model

Yuan Yujiao, Luo Senlin, Lin Meng, and Pan Limin

(SchoolofInformation&Electronics,BeijingInstituteofTechnology,Beijing100081)

Based on the collaborative filtering traditional recommendation system need to collect relevant data of user’s interests and p

, to a certain extent involved in the user’s personal privacy, current information security and privacy protection is one of the hot field of data mining, in order to avoid disclosure of user information with to security issues, In this paper, we propose a new short text recommendation method based on sentential semantic structure model. We fist use topic model structure text-theme matrix to several subtopics. We employ sentential semantic structure model to extract semantic features to get sentential semantic features. Then LDA topic model fusing sentential semantic structure model is used to calculate the pairwise sentence similarities and construct the similarity matrix. Then we acquire sentential relationship features. At last, combining both sentential semantic features and relationship features, the most informative text are extracted from each subtopic. Experimental results demonstrate the improvement of our proposed framework, ROUGE-1 value is 31.388% while ROUGE-SU*value is 15.701% on compress ratio at 0.5%.The results indicate that introducing sentential semantic structure model can better understand sentential semantic and using both sentential semantic features and relationship features can also enrich the features representation.

microblog; short text recommendation; topic model; natural language processing; information security

2015-07-30

國家242信息安全計劃資助項目(2005C48);北京理工大學科技創(chuàng)新計劃重大項目培育專項(2011CX01015)

TP391