基于概率語義分布的短文本分類

馬成龍 顏永紅,2

基于概率語義分布的短文本分類

馬成龍1顏永紅1,2

在短文本分類中,面對特征稀疏的短文本,如何充分利用文本中的每一個詞語成為關鍵.本文提出概率語義分布模型的思想,首先通過查詢詞矢量詞典,將文本轉換為詞矢量數據;其次,在概率語義分布模型的假設下利用混合高斯模型對無標注的文本數據進行通用背景語義模型訓練;利用訓練數據對通用模型進行自適應得到各個領域的目標領域語義分布模型;最后,在測試過程中,計算短文本屬于領域模型的概率,得到最終的分類結果.實驗結果表明,本文提出的方法能夠從一定程度上利用短文本所提供的信息,有效降低了對訓練數據的依賴性,相比于支持向量機(Support vector machine,SVM)和最大熵分類方法性能相對提高了17.7%.

短文本分類,詞矢量,語義分布,高斯混合模型

近年來,隨著社交網絡和電子商務的飛速發展,微博、Twitter、即時信息、商品評價等短文本形式的文字充斥著互聯網.這些短文本包含了用戶的潛在需求、興趣點、意圖傾向等,如何能夠從這些短文本中獲取信息從而更好地為用戶提供服務成為關鍵.然而,這些短文本通常都有長度限制,如微博字數限制在140字以內,短消息限制在70字以內,如何能夠從只言片語中挖掘出目標信息成為了一大挑戰.在使用傳統的向量空間模型(Vector space model, VSM)將短文本數字向量化時,該向量會很稀疏[1],特別是在測試階段,由于訓練數據的不充分,會造成很多有用特征因未被模型捕獲過而被忽略的情況,因此使用傳統的文本分類方法將導致分類結果不理想.

為了充分利用短文本所蘊含的信息,已有很多相關研究.一種方案是計算短文本之間的相似性,文獻[2]提出使用外部數據作為一個橋梁,如果預測文檔和訓練文檔同時和某一外部文檔相似,那么領域標簽信息也應該一樣,但搜集的外部數據必須和實驗數據相關;文獻[3]提出使用搜索引擎返回的結果來衡量兩個詞語之間的相似度,但是需要等待搜索引擎返回結果,比較耗時,不利于在線實時應用;文獻[4]提出使用固定的資源維基百科作為知識庫進行搜索.另一種解決方案是在短文本稀疏特征的基礎上擴展相關語義特征,文獻[5]提出使用Lucene[6]對維基百科建立索引,在原有特征基礎上增加Lucene返回的搜索結果作為額外特征;文獻[7]提出使用短文本隱藏的主題作為額外特征集,在相關數據上使用LDA(Latent Dirichlet allocation)[8]獲得主題模型,針對短文本首先進行推理得到主題特征,與原始特征融合用于訓練和分類.上述研究都是基于利用外部相關數據對原始文本進行相似度估計或者特征擴展,并且取得了不錯的效果,但是對外部數據的相關性要求較高,而這些相關數據通常是根據領域知識,人工干預下進行收集的,在實際應用中獲取相關領域的外部數據有時比較困難.上述方法最終將文本轉換為空間向量,統計特征的共現權重,簡單來說是一種計數原理.隨著神經網絡模型在自然語言處理中的廣泛應用,文獻[9]提出將詞矢量作為輸入特征,利用卷積神經網絡進行模型訓練.為了得到句子層級的矢量表示,文獻[10]提出將變長文本訓練為固定維度的段落矢量(Paragraph vector)的概念,文獻[11]提出動態卷積神經網絡,不依賴于句法解析樹,而是利用動態k-max pooling提取全局特征.

基于文獻[7],為了擺脫對外部相關數據的過度依賴,本文從句子語義層面出發,深度挖掘短文本所表達的語義.本文利用詞矢量作為輸入特征表征語義.詞矢量是指將詞語映射成空間中的一個低維實數向量,向量之間的距離描述了詞與詞之間的語義關系,語義相近的詞語在空間中成群出現,提高了文字表示的泛化能力.為了更好地利用詞矢量,本文提出了概率語義分布模型,利用詞矢量來表征語義分布,在一定程度上避免了數據的稀疏性問題,實驗結果表明,本文所提出的方法準確率相對于傳統的分類器提高了17.7%.

本文結構如下:第1節簡要介紹連續空間詞矢量,第2節描述了本文提出的概率語義分布模型,第3節介紹了在概率語義分布模型的假設下,本文提出了一種基于通用語義背景模型的短文本分類方法,第4節為實驗及結果分析,第5節給出總結.

1 連續空間詞矢量

近幾年,越來越多的學者開始關注利用低維實數向量來表征一個詞、短語或者句子.例如,LSA (Latent semantic analysis)[12]和LDA模型將文本映射成主題模型里的一個低維向量.隨著神經網絡的廣泛應用,人們可以利用神經網絡對大規模語料進行語言模型訓練,同時能夠得到描述語義和句法關系的詞矢量.其中,文獻[13]提出的Skip-gram模型便是一種能夠高效得到詞矢量的訓練模型,通過訓練無標注語料將每個詞映射成低維實數向量,每一維都代表了詞的淺層語義特征[14].同時,文獻[15]發現上述模型訓練得到的詞矢量能夠通過余弦距離描述詞與詞之間的語義和句法關系,并且相同的余弦距離表征了同樣關系,例如,向量“Man”與向量“King”之間的距離近似于向量“Woman”與向量“Queen”之間的距離.因此,本文利用詞矢量上述特性,結合短文本的特點,提出了概率語義分布模型,應用于短文本分類中.

2 概率語義分布模型

不同于傳統的文本分類算法,本文認為短文本是在貝葉斯框架下各個領域里的一個抽樣.本文假設短文本數據產生于一個概率語義分布模型,不同領域數據來自于不同的語義分布模型,并且我們可以利用已知的文本數據去估計這些模型.得到這些模型之后,對于新的測試數據,計算來源于各個模型的概率,根據貝葉斯原理選擇類別標簽作為預測結果.

假設訓練數據包含一系列的短文本文檔, D={d1,d2,d3,···,dn},di表示一條短文本,共n條訓練數據,分別屬于C={c1,c2,c3,···,cm}, cj為領域標記,共m 個領域.本文假設同一領域短文本文檔產生于同一個語義分布模型(模型參數為λ).一條短文本數據di的產生,首先根據先驗概率p(cj|λ)選擇語義分布模型,然后根據該領域模型的模型參數p(di|cj;λ)產生文檔di.因此文檔di的產生概率為p(di|λ):

類似于一元語言模型,認為短文本中詞與詞之間是互相獨立的,不依賴于前文信息,dik表示短文本di中位置為k的單詞,|di|表示文本中單詞的個數,則有

假設已通過訓練數據計算得到模型參數?λ,針對測試數據,可以分別計算各個分布模型產生該數據的概率.根據貝葉斯原理,由式(1)和(2)得到

根據上述提出的概率語義分布模型假設,本文認為可以選擇合適的模型去近似描述每個領域內的詞語分布.由于混合高斯模型能夠描述任意形狀的概率分布,因此本文選用混合高斯模型.由于訓練數據的不充分,直接使用混合高斯模型進行多高斯訓練時會產生欠擬合,因此本文在混合高斯模型的基礎上提出了一種基于通用語義背景模型的短文本分類方法.

3 基于通用語義背景模型的短文本分類

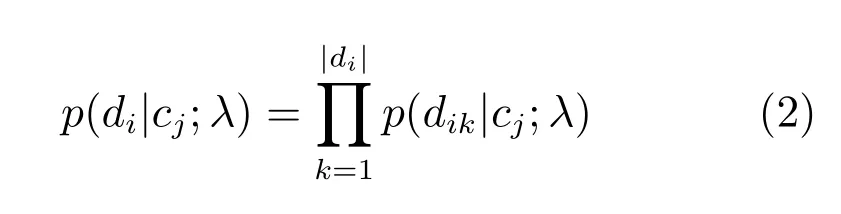

在實際應用中,由于自然語言表達的靈活性,獲取足夠多的標注數據是一件費時費力的事情,如何能夠充分利用已有數據進行短文本分類成為關鍵.在圖像處理、說話人識別系統中,高斯混合–通用背景模型[16?17]便是一種能夠在訓練數據不足的情況下,由一個通用的背景模型根據少量的訓練數據自適應到目標模型上,并且取得了很好效果.因此,借鑒于高斯混合–通用背景模型,在概率語義分布模型的假設下,首先利用混合高斯構建通用概率語義背景分布模型,然后根據訓練數據自適應得到目標領域概率語義分布模型,如圖1所示.

圖1 基于通用語義背景模型的短文本分類Fig.1 Short text classification based on universal semantic background model

3.1 詞匯特征

在連續空間詞矢量表示中,通過向量之間的空間距離來表征詞與詞之間的特定關系,并且文獻[18]指出從大量無標記文本數據訓練得到的詞矢量要比隨機初始化的矢量性能要好.在短文本分類中,我們應該首先訓練得到詞矢量.然而,詞矢量的訓練通常需要耗費很長時間,并且已有許多學者將訓練好的詞矢量進行了開源.本文的實驗直接使用文獻[19]提供的詞矢量詞典,該詞典是利用大概十億單詞數量的谷歌新聞數據訓練得到的維度為300的詞矢量.

3.2 高斯混合模型

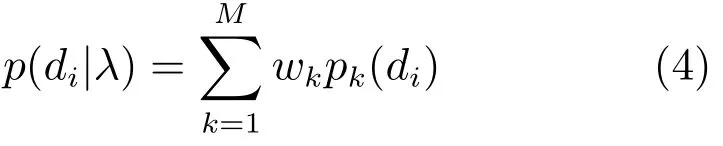

高斯混合模型 (Gaussian mixture model, GMM)作為一種通用的概率模型,只要高斯數足夠大,便能有效地模擬多維矢量的連續概率分布,因而很適合去表征語義分布.高斯混合模型是一系列高斯分布的加權組合.一個由M 個高斯分量組成的高斯混合密度函數是M 個高斯密度函數的線性加權和:

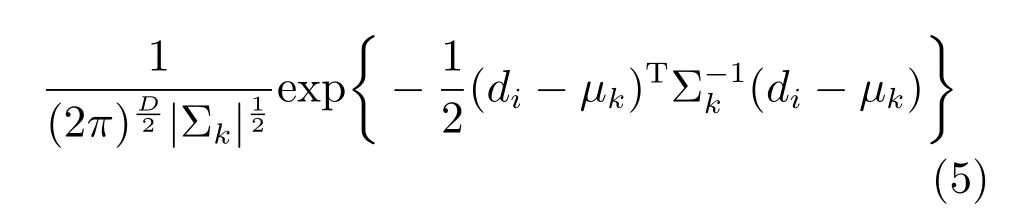

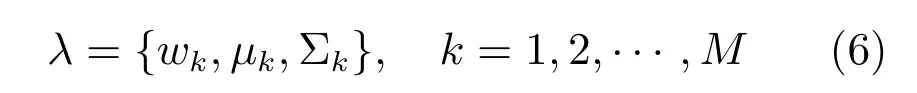

上式中λ為GMM模型參數,pk(di),k=1,···,M是高斯分量密度函數.wk,k=1,···,M 是各個高斯分量的權重,滿足每個高斯分量的概率密度函數公式pk(di)表示如下:

這里μk是第k個高斯分量的均值矢量,Σk為相應的協方差矩陣,D是特征矢量的維度.這樣,GMM模型便可以由以下參數集合表示:

使用GMM對概率語義分布建模主要基于兩個出發點:1)GMM的高斯分量能夠描述一定詞矢量的分布;2)線性加權的高斯密度函數可以逼近任意形狀的概率分布,因此選用GMM對語義分布進行描述.

3.3 最大后驗模型自適應

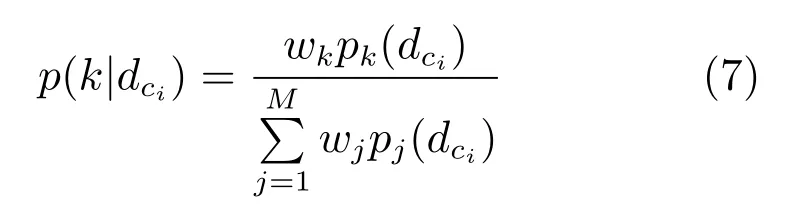

利用高斯混合模型在無標注文本數據上訓練得到通用概率語義背景分布模型,再用帶有標記的訓練數據進行模型自適應得到目標模型.最大后驗概率(Maximum a posteriori,MAP)是一種典型的貝葉斯估計,它首先計算訓練數據相對于通用背景模型的各個統計量,然后用一個相關系數將通用背景模型參數與相關統計量聯合,得到目標模型.給定通用背景模型:λ={wk,μk,Σk},k=1,2,···,M,以及某一特定領域內的短文本訓練數據Dcj={dc1,···,dci,···,d|cj|},對每一條訓練數據計算其在各高斯分量上的占有率,即后驗條件概率:

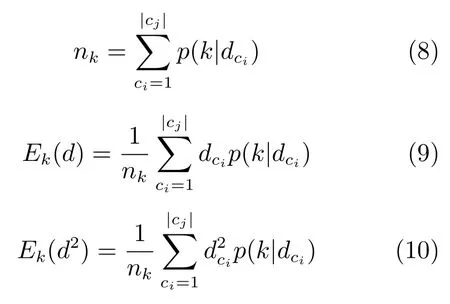

然后便可計算出與權重相關的零階統計量nk,與均值相關的一階統計量Ek(d)以及與協方差矩陣相關的二階統計量Ek(d2):

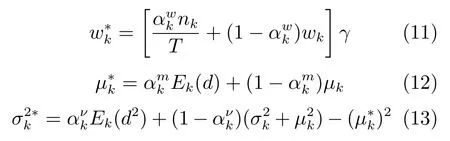

用以上計算得到的統計量對通用背景模型的各個高斯分量的權重、均值和協方差進行自適應,得到新的模型參數:

其中γ用來平衡高斯分量的權值,以保證更新后各分量的權值和為1.是調整新舊模型參數平衡的自適應系數,通常使用同一個自適應系數.為了能夠確定上述參數,本文在訓練集上使用5折交叉驗證來確保參數的可靠性.

4 實驗結果與分析

為了驗證所提出方法的有效性,本文利用文獻[7]提供的短文本數據,首先驗證背景模型和高斯數對分類性能的影響,其次與基線系統進行比較,最后驗證所提出的方法對訓練數據的依賴性.

4.1 實驗數據與評價標準

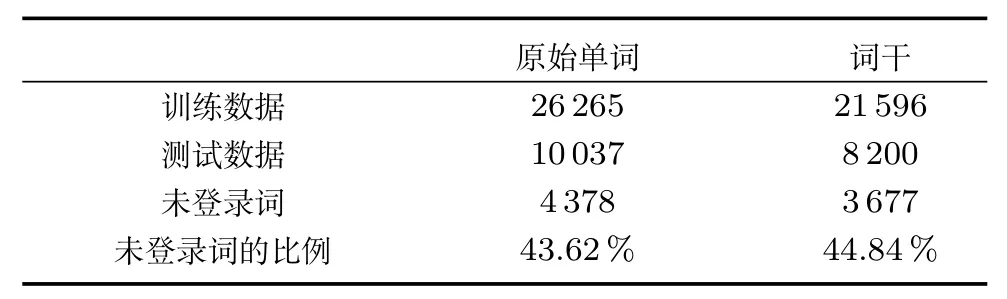

本文選擇文獻[7]提供的網頁搜索片段數據作為實驗數據,網頁搜索片段數據集是將特定領域詞送入谷歌搜索引擎得到的搜索結果片段,為了保證領域的特定性,通常選取前20~30個片段作為引用數據.例如計算機類,選取60個計算機領域的詞語,分別送入谷歌搜索引擎,每次抽取搜索結果的前20條數據作為訓練數據,則可以得到1200條數據,數據分布如表1.為了區分訓練數據和測試數據,在生成測試數據時所使用的領域詞不同于訓練數據.如表2所示,無論是英文單詞未經提取詞干還是經過提取詞干(Porter stemming)[20]之后,都會有超過40%的未登錄詞(未登錄詞通常是指未在詞典中出現的詞[21])出現在測試集中,這極大地增加了分類的難度.

表1 網頁搜索片段數據分布Table 1 Statistics of web snippets data

表2 未登錄詞分布Table 2 Statistics of unseen words

在實驗過程中,本文使用精度(Precision,P)、召回率(Recall,R)、F1值和準確率(Accuracy,A)作為評價標準.

4.2 實驗

4.2.1 參數設置

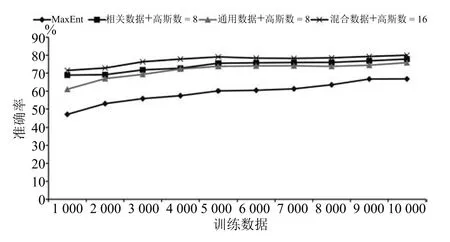

如何選擇背景數據進行通用背景語義模型訓練以及不同的背景模型對性能如何影響,混合高斯模型中的高斯數如何確定,這些參數都需要通過實驗進行驗證.本文選擇:1)相關數據:去掉標注的訓練數據作為背景數據;2)通用數據:選取語言資源聯盟(Linguistic Data Consortium)提供的新聞數據[22],本文僅選取標簽Headline下的文本;3)混合數據:相關數據和通用數據的混合,分別作為背景數據進行背景模型訓練,實驗結果如圖2所示.

當我們不斷增加高斯數時,混合高斯能夠很好地擬合特征分布,但是當高斯數過高時,由于數據的稀缺,會出現過擬合現象,正如圖2中當使用訓練數據1)進行背景模型訓練時,高斯數達到256時無法擬合出混合高斯模型.在圖2中,直接使用無標注的訓練數據進行通用背景模型訓練,在低維混合高斯下能夠快速地提高分類性能,但是由于數據有限,無法進行高維高斯擬合,高斯數為128時準確率達到78.6%;使用通用數據,由于數據量較大,能夠進行高維高斯擬合,并且在高維混合高斯的情況下能夠達到直接使用訓練數據的分類性能,高斯數為8時準確率達到最高75.83%;當使用無標注的訓練數據+通用數據時,高斯數為16,短文本分類準確率達到最高值80%.

圖2 不同的背景數據和高斯數對分類結果的影響Fig.2 Influence of background data and the number of GMM

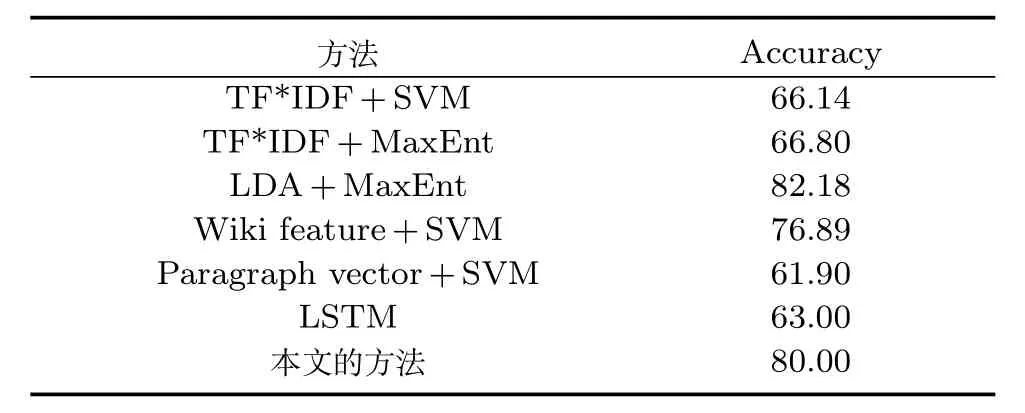

4.2.2 與基線系統相比

為了驗證本文所提方法的有效性,本文選擇以下方法作為基線系統:

1)TF*IDF+SVM/MaxEnt:特征值采用TF*IDF進行計算,利用支持向量機(Support vector machine,SVM)或最大熵(MaxEnt)作為分類器.

2)LDA+MaxEnt:在文獻[7]中,利用LDA對文本進行主題特征提取,與文本特征進行合并,利用MaxEnt進行分類模型的訓練.

3)Wiki feature+SVM:對維基百科數據1http://download.wikipedia.com/enwiki/進行去除網頁標簽、網頁鏈接等預處理之后,使用Lucene對其建立索引,對每一條短文本實驗數據進行檢索.在檢索結果中,類似文獻[5]中提出的方法,將維基百科數據的標題作為額外的文本特征擴充到原始短文本數據中.不同于文獻[5]中所描述的聚類任務,我們將融合后的文本用于短文本分類.

4)Paragraph vector+SVM:文獻[10]提出了一種無監督的方法,利用定長數學向量表征不定長文本.該模型認為當前詞語的選擇不僅由上下文決定,還由隱藏的文本矢量共同決定.該隱藏文本矢量可以看做為文本的隱藏主題[23].

5)LSTM(Long short term memory):對文獻[24]中提出的LSTM模型進行修改,組成結構為單一的LSTM層、均值池化層(Average pooling layer)和邏輯回歸層(Logistic regression layer),使其能夠進行文本類別預測[23].

在傳統的文本分類方法中,通常是利用詞袋模型(Bag of words,BoW)將文本離散化,計算特征權重,轉換為向量空間模型中的特征權重向量,每個詞被轉換為字典中的索引數字.這種方法降低了計算復雜度,但是對于未登錄詞的處理能力大幅度降低.

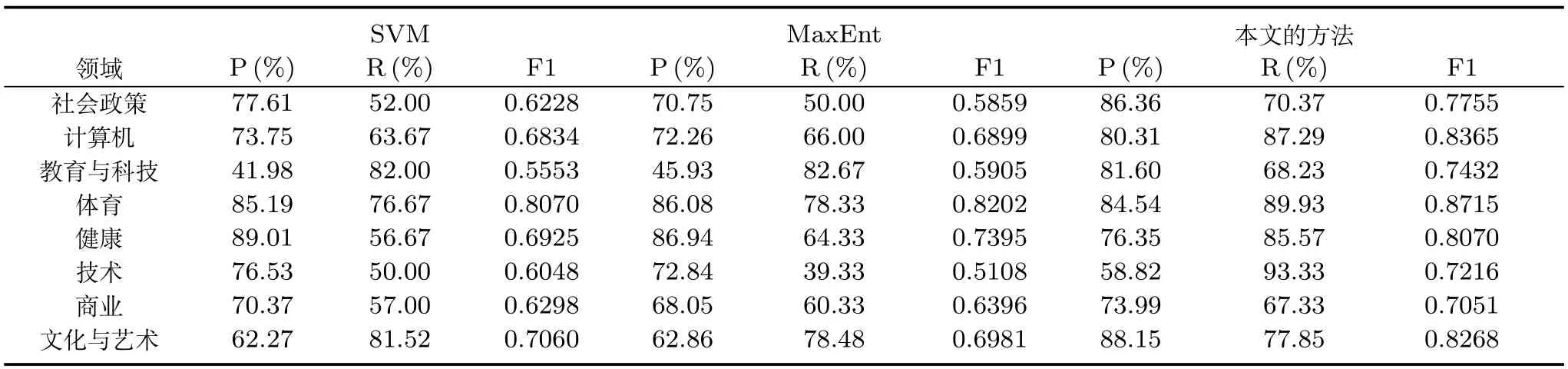

由于在訓練的過程中,分類模型未捕捉到未登錄詞對分類結果的貢獻能力,在測試階段,未登錄詞通常會被忽略.尤其是在該測試集中會出現超過40% 的未登錄詞,這極大地增加了分類難度.因此,在表3中傳統的文本分類方法SVM和Max-Ent性能均不是很高.以維基百科作為搜索庫,利用Lucene的搜索結果進行原始短文本擴展,在一定程度上降低了特征稀疏性,對分類性能有所提升.本文的方法利用詞矢量將文本向量化,詞矢量體現了一定的語言泛化能力,充分利用了訓練數據里的每一個有用詞語,使得準確率相對傳統方法提高了17.7%,并且如表4所示每一領域的分類結果F1值均優于傳統的分類結果.在Paragraph vector和LSTM這兩種模型中,都使用到了詞矢量,但都未能有效地捕獲到語句中的語義信息.

表3 與基線系統對比實驗結果(%)Table 3 Experimental results of the proposed method against other methods(%)

文獻[7]提到的方法需要根據領域知識額外準備大概470000篇維基百科數據,共計3.5GB的相關數據進行主題模型訓練,增加了收集數據的難度.本文在使用混合數據時準確率達到80%,略低于文獻[7]中的82.18%,但是本文有效地避免了收集相關數據的困難.本文選用維基百科數據,對其進行去除網頁標簽、鏈接等預處理之后,用于LDA主題模型訓練和詞矢量訓練.在主題模型訓練過程中,主題數目選擇為50、100、200、300、400等,在訓練集上利用五折交叉驗證確定最優主題數.針對詞矢量的訓練,使用開源工具word2vector2http://word2vec.googlecode.com/svn/trunk/訓練得到維度為300的詞矢量.在使用相同外部數據的情況下,本文方法取得79.93%的性能,略高于基于LDA+MaxEnt方法的79.89%.從這一點可以看出,在使用外部數據進行主題模型訓練時,外部數據與實驗數據的相關性,是影響主題特征貢獻能力的一個重要因素.因此,當面對一個新的分類任務時,文獻[7]中的方法需要根據領域知識重新挑選大量相關語料進行主題模型訓練,從一定程度來講,本文的方法更易實現.

表4 SVM、MaxEnt和本文方法的實驗結果Table 4 Evaluations of SVM,MaxEnt and the proposed method

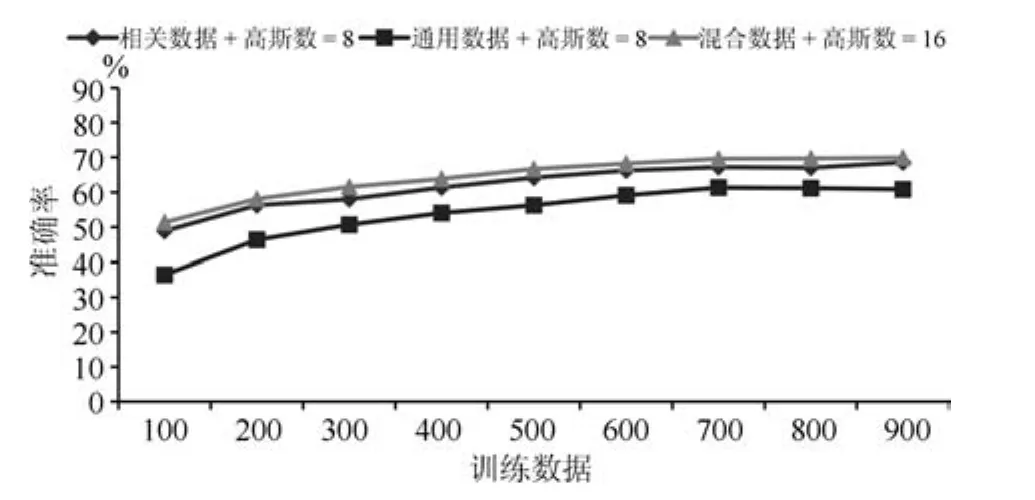

4.2.3 訓練數據大小對分類效果的影響

為了驗證本文方法對訓練數據的依賴性,本文將訓練數據保持原領域數據的分布比例不變平均分成10份,每次增加1份進行試驗,在同一測試集上進行測試,得到10組實驗結果,如圖3所示.由于SVM和MaxEnt的分類效果相差不大,因此僅選擇了MaxEnt作為基線系統.隨著訓練數據的減少,測試集中未登錄詞的比重會逐漸加大,MaxEnt的分類效果變化幅度較大,對訓練數據的依賴性比較大.在訓練數據稀缺的情況下(僅占原訓練數據的1/10),本文方法能夠將正確率從47.06%提高到71.54%(相對提高52%).從另一角度說明如何充分利用詞匯信息成為分類的關鍵,而這也是本文方法的關鍵.

圖3 訓練數據大小對分類效果的影響(1)Fig.3 Influence of training set size(1)

為了進一步檢驗訓練數據對本文方法的影響,本文繼續將訓練數據數量縮小,如圖4所示.在僅有100條訓練數據的情況下,本文所提出的方法準確率能夠達到51.4%,高于MaxEnt在1000條訓練數據下的47.06%,這對于獲取訓練數據比較困難的應用來說,可以大大地降低對訓練數據的依賴性.

圖4 訓練數據大小對分類效果的影響(2)Fig.4 Influence of training set size(2)

5 結論

本文摒棄了傳統的文本向量空間表示模型,提出概率語義分布模型,認為短文本是來自于概率語義模型的一個抽樣,利用詞矢量將文本數字化,通過無標記數據構建通用語義背景模型,利用訓練數據進行自適應得到目標模型.實驗結果驗證了本文所提出方法的可行性,利用能夠表征語義和句法關系的詞矢量有效地降低了訓練數據不充分所帶來的影響,短文本分類性能明顯優于傳統的文本分類方法,降低了對訓練數據的依賴性.雖然本文的實驗結果略低于基于主題模型的短文本分類系統的結果,但明顯優于基于SVM和最大熵的分類算法,并且本文的方法無需準備大量的相關數據,在一定程度上本文方法更易實現.

1 Wang B K,Huang Y F,Yang W X,Li X.Short text classification based on strong feature thesaurus.Journal of Zhejiang University Science C,2012,13(9):649?659

2 Zelikovitz S,Hirsh H.Improving short text classification using unlabeled background knowledge to assess document similarity.In:Proceedings of the 17th International Conference on Machine Learning.San Francisco,USA:Morgan Kaufmann,2000.1183?1190

3 Bollegala D,Matsuo Y,Ishizuka M.Measuring semantic similarity between words using web search engines.In:Proceedings of the 16th International Conference on World Wide Web.New York,USA:ACM,2007.757?766

4 Gabrilovich E,Markovitch S.Computing semantic relatedness using Wikipedia-based explicit semantic analysis.In: Proceedings of the 20th International Joint Conference on Artificial Intelligence.San Francisco,USA:Morgan Kaufmann,2007.1606?1611

5 Banerjee S,Ramanathan K,Gupta A.Clustering short texts using Wikipedia.In:Proceedings of the 30th Annual International ACM SIGIR Conference on Research and Development in Information Retrieval.New York,USA:ACM, 2007.787?788

6 Lucene[Online],available:https://lucene.apache.org/,May 3,2016.

7 Phan X H,Nguyen L M,Horiguchi S.Learning to classify short and sparse text&web with hidden topics from largescale data collections.In:Proceedings of the 17th International Conference on World Wide Web.New York,USA: ACM,2008.91?100

8 Blei D M,Ng A Y,Jordan M I.Latent Dirichlet allocation. Journal of Machine Learning Research,2003,3:993?1022

9 Kim Y.Convolutional neural networks for sentence classification.In:Proceedings of the 2014 Conference on Empirical Methods in Natural Language Processing.Doha,Qatar:Association for Computational Linguistics,2014.1746?1751

10 Le Q,Mikolov T.Distributed representations of sentences and documents.In:Proceedings of the 31st International Conference on Machine Learning.Beijing,China:JMLR, 2014.1188?1196

11 Kalchbrenner N,Grefenstette E,Blunsom P.A convolutional neural network for modelling sentences.In:Proceedings of the 52nd Annual Meeting of the Association for Computational Linguistics.Baltimore,USA:Association for Computational Linguistics,2014.655?665

12 Landauer T K,Foltz P W,Laham D.An introduction to latent semantic analysis.Discourse Processes,1998,25(2?3): 259?284

13 Mikolov T,Chen K,Corrado G,Dean J.Efficient estimation of word representations in vector space.arXiv:1301.3781, 2013.

14 Turian J,Ratinov L,Bengio Y.Word representations:a simple and general method for semi-supervised learning.In: Proceedings of the 48th Annual Meeting of the Association for Computational Linguistics.Uppsala,Sweden:Association for Computational Linguistics,2010.384?394

15 Mikolov T,Yih W T,Zweig G.Linguistic Regularities in Continuous Space Word Representations.In:Proceedings of the 2013 Conference of the North American Chapter of the Association for Computational Linguistics:Human Language Technologies.Atlanta,Georgia:Association for Computational Linguistics,2013.746?751

16 Reynolds D A.Speaker identification and verification using Gaussian mixture speaker models.Speech Communication, 1995,17(1?2):91?108

17 Reynolds D A,Quatieri T F,Dunn R B.Speaker verification using adapted Gaussian mixture models.Digital Signal Processing,2000,10(1?3):19?41

18 Collobert R,Weston J,Bottou L,Karlen M,Kavukcuoglu K,Kuksa P.Natural language processing(almost)from scratch.Journal of Machine Learning Research,2011,12: 2493?2537

19 Mikolov T,Sutskever I,Chen K,Corrado G S,Dean J.Distributed representations of words and phrases and their compositionality.In:Proceedings of the 2013 Advances in Neural Information Processing Systems.Lake Tahoe,Nevada, USA:Curran Associates,Inc.,2013.3111?3119

20 Porter M F.An algorithm for suffix stripping.Readings in Information Retrieval.San Francisco:Morgan Kaufmann, 1997.313?316

21 LingG C,AsaharaM,MatsumotoY.Chineseunknown word identification using character-based tagging and chunking.In:Proceedings of the 41st Annual Meeting on Association for Computational Linguistics.Sapporo, Japan:Association for Computational Linguistics,2003. 197?200

22 ParkerR,GraffD,Kong J B,Chen K,Maeda K.English Gigaword Fifth Edition[Online],available: https://catalog.ldc.upenn.edu/LDC2011T07,May 3,2016.

23 Wang P,Xu B,Xu J M,Tian G H,Liu C L,Hao H W. Semantic expansion using word embedding clustering and convolutional neural network for improving short text classification.Neurocomputing,2016,174:806?814

24 Hochreiter S,Schmidhuber J.Long short-term memory. Neural Computation,1997,9(8):1735?1780

馬成龍 中國科學院聲學研究所博士研究生.2011年獲得山東大學(威海)通信工程學士學位.主要研究方向為自然語言處理,口語理解,情感分析,深度學習.本文通信作者.

E-mail:machenglong@hccl.ioa.ac.cn

(MACheng-Long Ph.D.candidate at the Institute of Acoustics,Chinese Academy of Sciences.He received his bachelor degree from Shandong University,Weihai in 2011.His research interest covers natural language processing,spoken language understanding,sentiment analysis and deep learning.Corresponding author of this paper.)

顏永紅 中國科學院聲學研究所語言聲學與內容理解重點實驗室教授.1990年在清華大學獲得學士學位,1995年8月于美國俄勒岡研究院(Oregon Graduate Institute,OGI)獲得計算機科學和工程博士學位.他曾在OGI擔任助理教授(1995年),副教授(1998年)和副主任(1997年).主要研究方向為語音處理和識別,語言/說話人識別和人機界面.

E-mail:yanyonghong@hccl.ioa.ac.cn

(YAN Yong-Hong Professor at The Key Laboratory of Speech Acoustics and Content Understanding,Chinese Academy of Sciences.He received his bachelor degree from Tsinghua University in 1990,and Ph.D.degree from Oregon Graduate Institute(OGI),USA.He worked in OGI as assistant professor(1995),associate professor(1998)and associate director(1997)of Center for Spoken Language Understanding.His research interest covers speech processing and recognition,language/speaker recognition,and human computer interface.)

Short Text Classification Based on Probabilistic Semantic Distribution

MA Cheng-Long1YAN Yong-Hong1,2

In short text classification,it is critical to deal with each word because of data sparsity.In this paper, we present a novel probabilistic semantic distribution model.Firstly,words are transformed to vectors by looking up word embeddings.Secondly,the universal background semantic model is trained based on unlabelled universal data through mixture Gaussian models.Then,target models are obtained by adapting the background model for each domain training data.Finally,the probability of the test data belonging to each target model is calculated.Experimental results demonstrate that our approach can make best use of each word and effectively reduce the influence of training data size. In comparison with the methods of support vector machine(SVM)and MaxEnt,the proposed method gains a 17.7% relative accuracy improvement.

Short text classification,word embedding,semantic distribution,Gaussian mixture model

馬成龍,顏永紅.基于概率語義分布的短文本分類.自動化學報,2016,42(11):1711?1717

Ma Cheng-Long,Yan Yong-Hong.Short text classification based on probabilistic semantic distribution.Acta Automatica Sinica,2016,42(11):1711?1717

2015-05-19 錄用日期2016-05-03

Manuscript received May 19,2015;accepted May 3,2016

國家高技術研究發展計劃 (863計劃)(2015AA016306),國家重點基礎研究發展計劃(973計劃)(2013CB329302),國家自然科學基金(11461141004,61271426,11504406,11590770,11590771, 11590772,11590773,11590774),中國科學院戰略性先導科技專項(XDA06030100,XDA06030500,XDA06040603)和新疆維吾爾自治區科技重大專項(201230118-3)資助

Supported by National High Technology Research Program of China(863 Program)(2015AA016306),National Basic Research Program of China(973 Program)(2013CB329302),National Natural Science Foundation of China(11461141004,61271426, 11504406,11590770,11590771,11590772,11590773,11590774), the Strategic Priority Research Program of the Chinese Academy of Sciences(XDA06030100,XDA06030500,XDA06040603),and the Key Science and Technology Project of the Xinjiang Uygur Autonomous Region(201230118-3)

本文責任編委趙鐵軍

Recommended by Associate Editor ZHAO Tie-Jun

1.中國科學院聲學研究所語言聲學與內容理解重點實驗室 北京100190 2.新疆民族語音語言信息處理實驗室烏魯木齊830011

1.The Key Laboratory of Speech Acoustics and Content Understanding,Institute of Acoustics,Chinese Academy of Sciences,Beijing 100190 2.Xinjiang Laboratory of Minority Speech and Language Information Processing,Urumchi 830011

DOI 10.16383/j.aas.2016.c150268