基于機器學習的奶牛深度圖像身體區域精細分割方法

趙凱旋 李國強 何東健

(西北農林科技大學機械與電子工程學院, 楊凌 712100)

基于機器學習的奶牛深度圖像身體區域精細分割方法

趙凱旋 李國強 何東健

(西北農林科技大學機械與電子工程學院, 楊凌 712100)

奶牛目標各區域的精細分割和識別能夠提供精確的奶牛形體細節信息,是奶牛體形評價、姿態檢測、行為分析和理解的前提和基礎。為實現深度圖像中奶牛頭、頸、軀干和四肢等身體區域的精確分割,提出一種基于深度圖像特征和機器學習的奶牛目標各區域精細分割方法。該方法以每個像素點在不同采樣半徑下的帶閾值LBP序列為深度特征值,設置分類約束條件,用決策樹森林機器學習方法實現奶牛各區域的精細分類。對10頭奶牛的288幅側視深度圖像進行試驗,結果表明,當采樣半徑分段數為30,決策樹訓練至20層時,奶牛整體各像素點的平均識別率為95.15%,較傳統深度圖像特征值有更強的細節信息提取能力,可以用較少參數實現對復雜結構的精確識別。

奶牛; 目標檢測; 肢干分割; 深度圖像; 機器學習

引言

視頻分析技術能夠對動物的行為進行自動監測和理解,是提高養殖管理智能化水平的重要手段[1],已越來越多地應用于奶牛智能化養殖[2-4]。近年來,奶牛疫病檢測[5-7]、身體評分[8-9]、行為信息智能獲取[10-13]等受到了研究人員的廣泛關注。奶牛目標捕捉是行為理解、智能監控等領域的技術基礎和前提[14]。然而受環境背景、光照變化等因素的影響[15-16],目標檢測仍是一個具有挑戰性的課題[17]。近年來發展的深度圖像為實現奶牛目標跟蹤與分割提供了新的思路和方法。微軟公司發布的基于結構光技術的多傳感器3D圖像采集設備Kinect,能夠同時獲取目標像素點RGBD數據。由于其具有成本低、精度高、布設方便等優點,已在奶牛姿態檢測和識別等相關研究中應用[18]。

用深度圖像進行姿態檢測和識別時,首先需要分割頭部、頸、軀干、四肢等區域,然后觀測頭部和四肢的動作,并對前后肢進行更細致的分析以識別姿態和行為。此外,奶牛身體區域的精細分割能夠提高奶牛體形評價的自動化程度和精度。因此,需要一個魯棒性強的奶牛肢干分割算法以區分奶牛身體各部分區域。目前針對奶牛的目標檢測方法只能將視頻圖像中的奶牛作為一個整體進行分割[17],奶牛身體區域的精細識別未見報道。人體區域精細分割的相關研究為解決這一問題提供了思路。SHOTTON等[19]提出一種基于深度圖像的人體肢干檢測方法,該方法用預設的像素點深度值約束算子訓練隨機森林,然后預測未知像素點所屬的身體區域,最后用mean shift方法估計人體關節并繪制骨架。ANTONIO等[20]對上述方法進行了補充,使用圖割理論(Graph-cuts theory)對隨機森林算法得到的肢干分類結果進行了優化,且將時間和空間上鄰近數據點的深度值用于確定目標邊界。

上述2種算法中均使用同一種深度圖像特征進行像素點識別,圖像特征值原理簡單易于實現,但每個特征值均包含4個未知量,每個像素點均需要多組偏置量進行約束性檢測,因此導致分類器中可變參數較多、訓練收斂速度慢。且該特征不具備旋轉不變性,為得到較好的識別效果,需要大量不同姿態人體圖像對模型進行訓練。

為降低奶牛肢干分割與識別過程中模型訓練的難度并提高識別精度,本文提出一種基于局部二值模式(Local binary patterns,LBP)原理的深度圖像特征,該特征使用深度歸一化后的帶閾值LBP序列,具有深度圖像目標細節信息提取能力。首先計算每個像素點在不同采樣半徑下的統一LBP序列值,并以此作為分類條件,用決策樹森林方法實現奶牛肢干的精細分類。

1 材料和方法

1.1 深度圖像采集

2015年8月在陜西楊凌科元克隆股份有限公司奶牛養殖場,以荷斯坦奶牛為對象獲取試驗圖像。奶牛擠奶結束后經過窄道行走至飲水池飲水,窄道兩側有高度為1.4 m的欄桿,奶牛、攝像機與圍欄的相對位置如圖1所示。在窄道一側欄桿處布設Kinect V2體感器(Microsoft, 美國),Kinect V2安裝于三角架上,傳感器中心距離地面1.45 m,且深度圖像傳感器與奶牛行走方向平行。沿窄道邊放置高度為0.1 m的長條形導向阻擋物,以保證奶牛行走至視野中心時與攝像機的距離約為2.5 m。由于奶牛從擠奶室行走至飲水池過程中已形成直線行走的習性,因此奶牛通過視野時始終與攝像機平行。阻擋物對后續圖像分析與處理的影響可忽略不計。

圖1 試驗設置與攝像機位置示意圖Fig.1 Sketch of experiment setup and location of video camera

在室外晴天20:00—20:30時段對奶牛進行拍攝。通過便捷式計算機用Microsoft公司提供的Kinect Studio v2.0軟件控制Kinect攝像機錄制深度數據。奶牛個體全部出現在視頻左側時開始采集,持續采集到奶牛行走至視野右側邊緣。采集得到的碼流數據保存在計算機硬盤內,該數據流文件中包含了每幀中顏色、深度、紅外圖像等信息。視頻幀率為20 幀/s,深度圖像分辨率為512像素(水平)×424像素(垂直)。

數據處理計算機處理器為Intel Core I5-2400,主頻為3.2 GHz,8 GB內存,500 GB硬盤。首先在Visual Studio 2012平臺上將Kinect采集的數據流解析成深度數據文件并保存在硬盤中,然后用Matlab 2012a讀取數據文件并進行后續算法的開發。

1.2 供試數據

對不同體形的奶牛,拍攝其在直線行走過程中的深度圖像,奶牛經過通道耗時2 s左右。由于幀率為20 幀/s,每頭奶牛通過視野過程中將產生約40幅圖像。拍攝持續7 d,挑選出無異常行為并連續行走的10頭奶牛,剔除奶牛進入和離開視野時不完整的圖像,最終共得到奶牛側視深度圖像288幅,平均每頭奶牛約30幅。10頭奶牛中高大體形有2頭、中等體形5頭和矮小體形3頭;嚴重跛行1頭,中等跛行3頭,正常行走6頭。奶牛橫穿攝像機視野的過程中,奶牛在圖像中所處的位置以及四肢相對位置均不斷發生變化。因此采集的數據對于奶牛體形、姿態和在圖像中的位置均具有一定的多樣性。

深度圖像中奶牛與攝像機的距離固定為2.5 m左右,且攝像機與目標之間無前景遮擋。因此使用深度閾值分割出奶牛整體目標。然后參照奶牛肢體分類方法手工將288幅圖像中的奶牛標識為頭、頸、前肢(包括左前肢和右前肢)、后肢(包括左后肢和右后肢)、尾巴、軀干等區域,從中隨機選取150幅作為訓練集樣本,其余圖像作為測試集樣本。

1.3 傳統的深度圖像特征

傳統方法中,用被檢測像素點2個偏移位置的深度差值作為該像素點的特征值[19-20],其計算公式為

(1)

式中dI(x)——圖像I中像素點x處的深度u、v——2個相對于x的偏置向量φ——u和v的一組值

圖2為2個特征在不同像素點上的檢測原理。圖中特征值fφ1向上檢測該像素點與鄰近點的關系。假設背景點的深度為+∞,由于偏移點分別在目標和背景上,則fφ1的值為+∞。fφ2能夠檢測出類似于四肢的細長形結構,對于圖中檢測薄片結構的fφ2特征值,2個偏移點均落到背景上,因此fφ2的值為零。但對于同一特征值,當奶牛肢體發生旋轉時,其值將發生變化,因此傳統的深度圖像特征值不具備旋轉不變性。此外,傳統方法中u、v值的選取具有很強的盲目性,通常使用隨時數生成其取值空間里的可能值,然后對其進行檢視和篩選,以確定有效的u、v,選取過程耗時耗力。

圖2 傳統深度圖像特征值的檢測原理Fig.2 Detection principle of original depth image features

由式(1)可知,該深度圖像特征值包含2個偏置向量共4個變量,用以計算目標像素點鄰近的2個點的深度差值,以評估目標像素點所在的身體區域。結合式(1)和圖2可知,傳統的圖像特征值只能提供目標區域的微弱信息,對分類器的性能要求較高,且需要大量訓練數據以覆蓋各結構的不同旋轉角度,模型訓練成本較高,難以保證精度。

1.4 基于LBP的深度圖像特征

考慮到式(1)中傳統深度圖像特征值不具備旋轉不變性,且采樣精度難以實現細小結構的識別,為更有效地提取深度圖像中的像素點信息,本文提出使用基于LBP原理的深度圖像局部二值模式(Deep image LBP,DILBP)。LBP是一種典型的紋理特征值,其衡量了某一點鄰近區域內灰度值跳變的模式[16],原始的LBP算子定義為:在采樣半徑p×p的窗口內,以窗口中心像素為閾值,將相鄰的2p個像素的灰度與其進行比較,若周圍像素值大于中心像素值,則該像素點的位置被標記為1,否則為0。

本文對原始LBP中的判定原則加以改進以提高LBP對幾何結構的敏感性,同時對采樣半徑進行深度歸一化處理,使其具有深度不變性。改進后的DILBP為

(2)

式中DP,R——深度圖像局部二值模式(DILBP)P——采樣點數R——采樣半徑dp——第p個采樣點的深度dc——中心點的深度s——判定函數

由于攝像機成像平面與奶牛側身基本平行,因此在深度圖像中屬于奶牛同一身體區域像素點的深度差異較小,而目標與背景之間的差值較大。故本文用帶閾值的判定函數,以判定采樣點與中心點是否同屬于奶牛身體區域。

(3)

式中T——同一身體區域內的深度差異度閾值

本文使用統一的LBP模式,因此特征值計算結果為58個固定的模式之一[21]。DILBP模式中的采樣半徑為

(4)

式中Rt——真實空間內的采樣半徑

真實空間內的半徑Rt乘以1/dI(x)以確保圖像特征具有深度不變性,能夠消除目標與攝像機之間距離對檢測結果的影響。本文DILBP序列中的1和0分別表示該采樣點與中心點是否屬于同一肢干。如圖3所示,對于某一肢干,其內部的像素點在特定的采樣半徑R下,計算得到的DILBP序列基本相同。然而不同肢干之間,其特定的采樣半徑和DILBP序列均不同。因此,多個采樣半徑下的DILBP序列值,能夠將不同身體區域內的像素點進行分類。

圖3 基于DILBP模式的深度圖像特征檢測原理Fig.3 Detection principle of depth image features based on DILBP

由圖3可知,當被檢測的四肢發生旋轉時,特定的采樣點總是落在肢干區域內,由于統一的LBP模式計算LBP序列內0和1的跳變次數,因此本文提出的基于LBP的深度圖像特征值繼承了LBP的旋轉不變性。

傳統的深度圖像特征使用4個參數檢測目標點與鄰近2個偏置點的位置關系。而本文提出的DILBP圖像特征僅通過一個參數即可對目標點周圍的8個點進行檢測,且檢測結果為固定的58個模式值,降低了參數值的選取難度。

1.5 隨機決策森林

隨機決策森林是一種經典的機器學習方法。考慮到奶牛目標肢干分割屬于先驗的模式識別問題,因此用DILBP特征構建隨機決策森林。對于給定的帶分類標簽的奶牛目標深度圖像,決策樹的構建過程如下[20]:

(1)決策樹中第i個分支節點包含一組判定參數Ri和Li,其值為各自取值空間內的隨機數。決策樹訓練完成后,每個分支節點參數的R和L將取得最優值,能夠將流入該節點的樣本點劃分成2組,且分類前后的熵增益最大。

(2)設Q為訓練圖像數據集中所有參與訓練樣的像素點的集合,Q對于分類標簽c的概率分布計算公式為

(5)

式中hQ(c)——集合Q相對于標簽c的直方圖 |Q|——集合Q中元素的個數PQ——集合Q的概率分布函數C——Q中的標簽集合

(3)對于第i個未被處理的節點,若該節點內的樣本點屬于同一類,說明該節點是葉子節點,直接跳過處理;否則該節點為分支節點。假設流入該節點的樣本集為Qi,則隨機選取一組R和L參數值將Qi劃分為QL和QR2部分,即

(6)

式中 DILBPP,R(I,x)——按式(2)計算圖像I中像素點x處的深度圖像局部二值模式特征值

CQi(QL)——計算QL在Qi中補集的函數

然后用式(5)分別計算QL和QR的概率分布函數得到PQL和PQR。

(4)估計當前節點的最佳分類參數φ*,該參數保證分類前后的信息熵增益取得最大值。分類前后的信息熵增益計算公式為

(7)

式中H(Q)——集合Q的信息熵GQ(φ)——使用參數φ對集合Q進行劃分前后的信息熵增益

將φ的所有可能值代入式(7),最終通過比較得到最佳的分類參數φ*,其值使得GQ(φ)在其定義域內取得最大值。

(5)在每個新生成的節點中執行步驟(3)、(4),直到決策樹層數達到預設值時中止訓練,未處理的節點視為葉子節點,并保存該節點樣本的概率分布函數。

一旦訓練完成,對于某一個待識別的像素點,從樹的根節點開始,根據式(6)和該節點所保存的分類參數判定該像素點的路徑,直到該像素點到達某一葉子節點,并得出分類結果。

當參與決策樹訓練的樣本數過多時,訓練過程將消耗大量的計算資源。故將訓練數據隨機劃分為奇數組,分別訓練多個決策樹構成決策森林。將待檢測樣本分別輸入每個決策樹,得到每棵樹最終葉子節點處的概率分布函數,然后對其進行合并

(8)

式中Pt(c|I,x)——圖像I中像素點x在第t棵樹中最終達到的葉子節點所保存概率分布函數

最終,樣本的識別結果為合并后的概率分布函數中所占比例最大的類。

2 試驗結果與分析

2.1 奶牛各區域識別結果

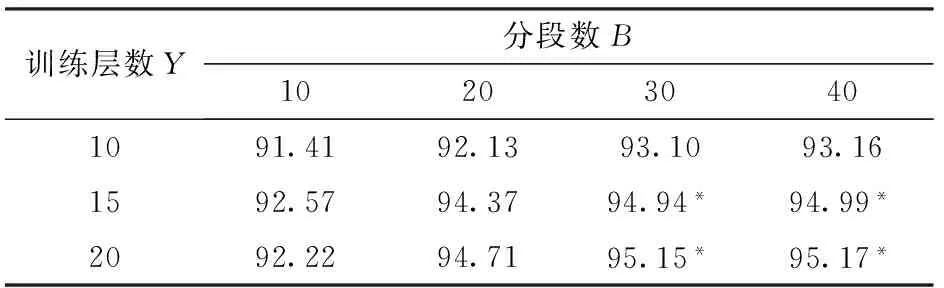

將訓練集中150幅圖像平均分成3組分別訓練3棵決策樹,每幅圖像中奶牛目標上的像素點均參與訓練。測試集圖像中每個像素點均進入3棵樹進行決策得到的結果按式(8)進行合并后,得到最終的分類結果。構建決策樹過程中,采樣半徑的最大值為奶牛的體高,采樣半徑的分段數B決定了深度特征值的精度。分段數最大,候選的分類含參數越多。決策樹的最大層數Y決定了分類的精度,層數越大則決策樹對于訓練樣本的識別精度越高,但決策樹的泛化能力將會降低。為確定最優訓練參數,對不同參數組合進行了比較試驗,表1為本文算法在不同參數下的平均識別率。

表1 本文算法在不同參數組合下的平均識別率

注:*識別率最高的前4種組合。

由表1可知,提高采樣半徑R的分段數B能提高檢測精度,但在訓練層數為10層時,分段數40相對分段數30的識別效果提升并不明顯。這是由于分段數較多導致決策樹中待訓練的參數增加,而較淺的決策樹難以訓練出最優分類參數。為進一步分析分段數和訓練層數對識別結果的影響,表2給出了平均識別率最高的前4種組合下的奶牛身體各區域識別結果。

由表2可知,當決策樹由15層訓練到20層后,奶牛頭部識別精度有微小提升,頸、軀干等簡單粗大結構的識別率均有所下降,前肢、后肢和尾巴等細小復雜結構的識別率得到明顯提升。尤其是尾巴的識別率提高超過10個百分點。表明多層決策樹對細小結構的識別能力較強,但對粗大結構的泛化能力受到影響。

表2 4種組合下奶牛各區域的識別結果

在相同的訓練層數下,分段數分別為30和40時,各區域的識別精度差異很小,然而后肢的識別率反而下降,表明分段數越多,決策樹泛化能力隨層數的下降速度越快。

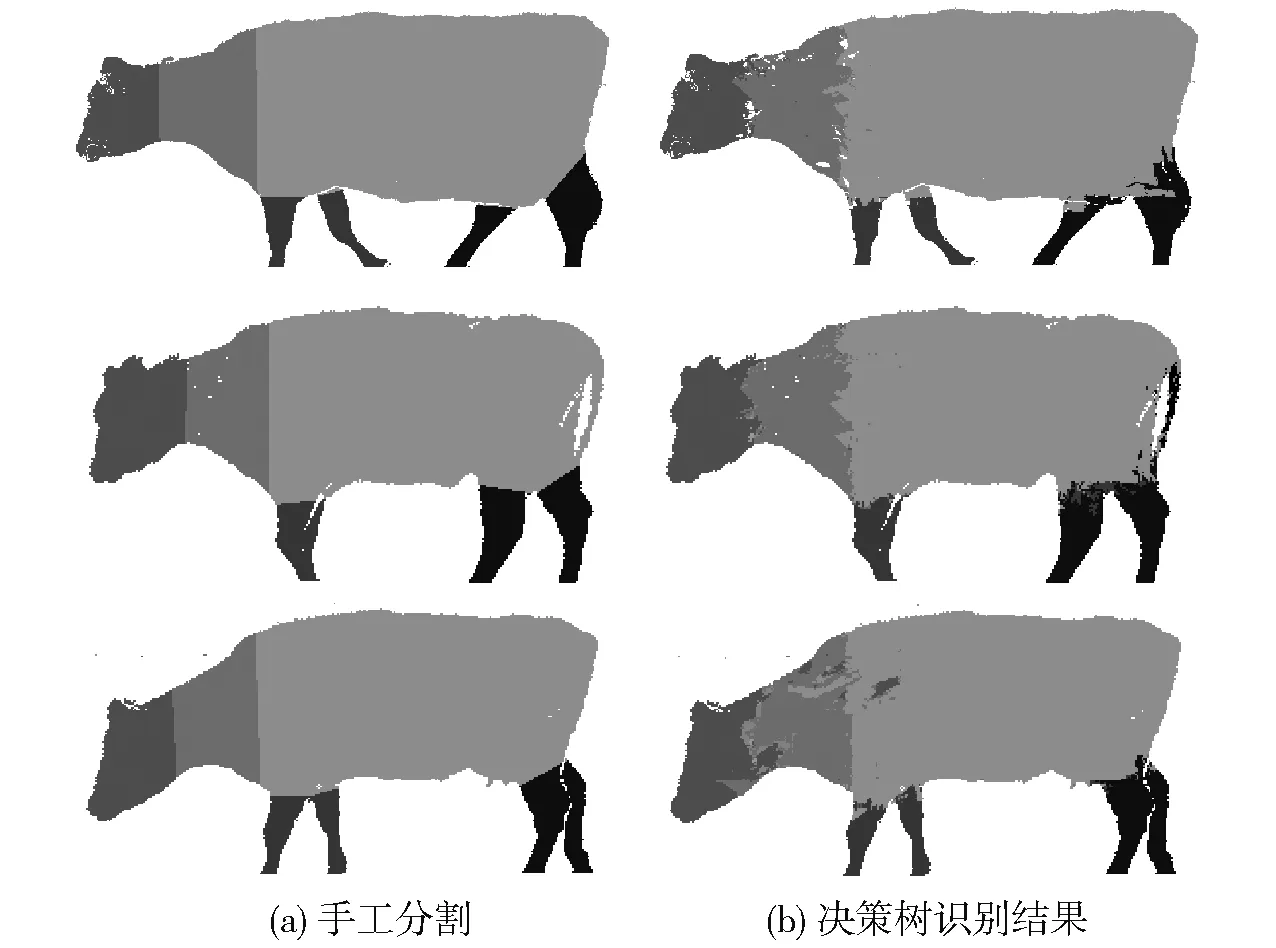

由于尾巴所包含的奶牛身體及行為信息較少,故本文以分段數為30、層數為20作為最優參數,進一步研究決策樹的分割性能。圖4為對不同體形和姿態下的奶牛各肢干人工分割及決策樹分割結果。從上到下分別為高體深壯碩正常行走奶牛A、低體深瘦小中等跛行奶牛B、樣本中較少的嚴重跛行奶牛C。

圖4 不同奶牛的分割效果示例圖Fig.4 Recognition results of different cows

圖4中A、C奶牛尾巴已經被人工去除,而奶牛B由于尾巴過于靠近軀干,故人工分割時均未將其分割出來。但決策樹能正確地將奶牛B大部分尾巴像素點識別出來。奶牛A、B、C體深、頭部位置均不同,用決策樹均得到較高的識別精度,表明本文算法對于奶牛的體形、姿態具有很好的魯棒性。四肢錯誤識別的像素點主要集中于四肢與軀干接合處的過渡區域。

2.2 識別率與各區域樣本比例的關系

表3為奶牛身體各區域的識別率與該區域所占奶牛整體目標比例的比較結果。

由表3可知,奶牛身體各區域所占比例和識別率呈正相關關系,占奶牛目標比例最大的軀干區域識別率最高;占奶牛目標比例最小的尾巴區域識別率最低。這是由于在訓練分類器時,各個類別內樣本數分布不均造成的。當訓練決策樹時,訓練圖像中所有像素點均參與訓練,因此流入第1個節點的數據中軀干區域樣本點比例最大,由于決策樹總是以最大熵增加值作為評估依據,因此占絕對數量的軀干類將在前幾層被優先分割出來。雖然頸部所占比例略高于頭部,但識別率比頭部低4.21個百分點。這是由于頸部作為頭部和軀干的連接區域,形狀復雜且變形度較大,同時頸部靠近軀干區域,受大容量樣本的影響大,因此識別率低于頭部。后肢受尾巴的影響,識別率略低于前肢。此外,由于四肢、尾巴等區域自身的像素點數較少,少量錯誤識別的像素點即會導致較大的識別錯誤率。

表3 奶牛身體各區域所占比例和識別率

尾巴區域的識別率低于55%,這是由于參與訓練的尾巴區域的像素點太少所致。

2.3 與Kinect原始方法的比較

為比較本文方法相對于Kinect原始方法的目標分割效果,根據文獻[14]中的深度圖像特征值,用相同的訓練數據和測試數據進行對比試驗。為保證與本文算法相近的參數數量,試驗中傳統方法的偏置點為40組,待比較閾值為20個。2種方法的分割結果如表4所示。

表4 傳統方法與本文方法識別結果比較

如表4所示,傳統方法中頭部的識別精度高于本文方法,軀干識別精度與本文接近。本文方法中頸、前肢的識別精度提高了10個百分點以上。尤其是尾巴識別精度由13.14%提高到54.97%。2種方法的識別效果示例如圖5所示。

圖5 傳統方法和本文方法識別效果示例Fig.5 Two examples of recognition results of two methods

由圖5可知,傳統方法中雖然頭部的識別精度較高,但頭與頸結合處出現了較多的交叉分割,不利于定位頭頸結合關節。兩頭奶牛的識別結果顯示,傳統方法均將尾巴錯誤識別為軀干。綜上所述,本文方法交叉識別少,較傳統方法具有更強的細節信息提取能力,能夠以較少的參數,實現對復雜結構的精確識別。

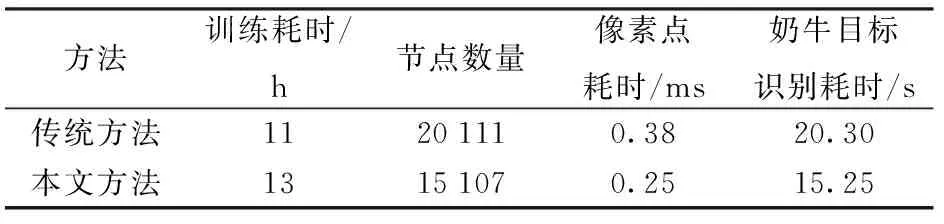

為比較傳統方法與本文方法的效率,每個像素點進入決策樹森林到得出識別結果所需要的時間定義為單個像素點的識別耗時,奶牛目標上的所有像素點的總體耗時定義為奶牛目標的識別耗時。傳統方法與本文算法的平均訓練耗時、決策樹節點數量以及平均識別耗時如表5所示。

表5 傳統方法與本文方法訓練與識別效率比較

由于本文方法中圖像特征較傳統方法復雜,因此訓練耗時較長。但由于參數利用率高,決策樹中的節點數量較少,因此能夠以較短路徑達到葉子節點,故識別效率更高。由于單幅圖像中所有的像素點均參與識別,故圖像的識別耗時為15 s左右。實際進行奶牛各區域實時檢測時,可隨機選取圖像中10%的像素點進行檢測,即可得到奶牛各區域的大體輪廓,則可將單幅圖像識別耗時降低至1.5 s,且用C++語言實現識別算法可進一步提高識別效率。

3 結論

(1)提出一種深度歸一化后的帶閾值LBP序列作為深度圖像特征,與傳統深度特征值[14]相比,該特征值具有平移和旋轉不變性,且參數利用率高,能以較少的訓練圖像實現較高識別精度。

(2)用本文深度圖像特征值作為分類條件構建決策樹森林,可實現奶牛肢干的精細分割和識別。奶牛各身體區域平均識別率為95.15%,除尾巴外的奶牛各個主要身體區域均保持較高的識別率。

(3)本文方法交叉識別少,較Kinect原始方法[14]具有更強的細節信息提取能力,能夠實現對復雜結構的精確識別。

1 何東健,劉冬,趙凱旋. 精準畜牧業中動物信息智能感知與行為檢測研究進展[J/OL]. 農業機械學報, 2016, 47(5): 231-244.http:∥www.j-csam.org/jcsam/ch/reader/view_abstract.aspx?flag=1&file_no=20160532&journal_id=jcsam.DOI: 10.6041/j.issn.1000-1298.2016.05.032. HE Dongjian, LIU Dong, ZHAO Kaixuan. Review of perceiving animal information and behavior in precision livestock farming[J/OL]. Transactions of the Chinese Society for Agricultural Machinery, 2016, 47(5): 231-244.(in Chinese)

2 HOFFMANN G, SCHMIDT M, AMMON C, et al. Monitoring the body temperature of cows and calves using video recordings from an infrared thermography camera[J]. Veterinary Research Communications, 2013, 37(2): 91-99.

3 CHAPINAL N, TUCKER C B. Validation of an automated method to count steps while cows stand on a weighing platform and its application as a measure to detect lameness[J]. Journal of Dairy Science, 2012, 95(11): 6523-6528.

4 BRUYERE P, HETREAU T, PONSART C, et al. Can video cameras replace visual estrus detection in dairy cows[J]. Theriogenology, 2012, 77(3): 525-530.

5 VIAZZI S, BAHR C, SCHLAGETER-TELLO A, et al. Analysis of individual classification of lameness using automatic measurement of back posture in dairy cattle[J]. Journal of Dairy Science, 2013, 96(1): 257-266.

6 PLUK A, BAHR C, POURSABERI A, et al. Automatic measurement of touch and release angles of the fetlock joint for lameness detection in dairy cattle using vision techniques[J]. Journal of Dairy Science, 2012, 95(4): 1738-1748.

7 POURSABERI A, BAHR C, PLUK A, et al. Real-time automatic lameness detection based on back posture extraction in dairy cattle: shape analysis of cow with image processing techniques[J]. Computer and Electronics in Agriculture, 2010, 74(1): 110-119.

8 AZZARO G, CACCAMO M, FERGUSON J D, et al. Objective estimation of body condition score by modeling cow body shape from digital images[J]. Journal of Dairy Science, 2011, 94(4): 2126-2137.

9 BEWLEY J M, PEACOCK A M, LEWIS O, et al. Potential for estimation of body condition scores in dairy cattle from digital images[J]. Journal of Dairy Science, 2008, 91(9): 3439-3453.

10 PORTO S M C, ARCIDIACONO C, ANGUZZA U, et al. A computer vision-based system for the automatic detection of lying behaviour of dairy cows in free-stall barns[J]. Biosystems Engineering, 2013, 115(2): 184-194.

11 MIEDEMA H, COCKRAM M, DWYER C, et al. Behavioural predictors of the start of normal and dystocic calving in dairy cows and heifers[J]. Applied Animal Behaviour Science, 2011, 132(1-2): 14-19.

12 CANGAR O, LEROY T, GUARINO M, et al. Automatic real-time monitoring of locomotion and posture behaviour of pregnant cows prior to calving using online image analysis[J]. Computers and Electronics in Agriculture, 2008, 64(1): 53-60.

13 趙凱旋,何東健,王恩澤. 基于視頻分析的奶牛呼吸頻率與異常檢測[J/OL]. 農業機械學報, 2014, 45(10): 258-263.http:∥www.j-csam.org/jcsam/ch/reader/view_abstract.aspx?flag=1&file_no=20141040&journal_id=jcsam.DOI:10.6041/j.issn.1000-1298.2014.10.040. ZHAO Kaixuan, HE Dongjian, WANG Enze.Detection of breathing rate and abnormity of dairy cattle based on video analysis[J/OL]. Transactions of the Chinese Society for Agricultural Machinery, 2014, 45(10): 258-263.(in Chinese)

14 趙凱旋,何東健. 基于卷積神經網絡的奶牛個體身份識別方法[J]. 農業工程學報, 2015, 31(5): 181-187. ZHAO Kaixuan, HE Dongjian. Recognition of individual dairy cattle based on convolutional neural networks[J]. Transactions of the CSAE,2015, 31(5): 181-187. (in Chinese)

15 劉冬,趙凱旋,何東健. 基于混合高斯模型的移動奶牛目標實時檢測[J/OL]. 農業機械學報, 2016, 47(5): 288-294.http:∥www.j-csam.org/jcsam/ch/reader/view_abstract.aspx?flag=1&file_no=20160539&journal_id=jcsam.DOI:10.6041/j.issn.1000-1298.2016.05.039. LIU Dong, ZHAO Kaixuan, HE Dongjian.Real-time target detection for moving cows based on gaussian mixture model[J/OL]. Transactions of the Chinese Society for Agricultural Machinery, 2016, 47(5): 288-294. (in Chinese)

16 何東健,孟凡昌,趙凱旋,等. 基于視頻分析的犢牛基本行為識別[J/OL]. 農業機械學報, 2016, 47(9): 294-300.http:∥www.j-csam.org/jcsam/ch/reader/view_abstract.aspx?flag=1&file_no=20160940&journal_id=jcsam.DOI:10.6041/j.issn.1000-1298.2016.09.040. HE Dongjian, MENG Fanchang, ZHAO Kaixuan, et al.Recognition of calf basic behaviors based on video analysis[J/OL]. Transactions of the Chinese Society for Agricultural Machinery, 2016, 47(9): 294-300. (in Chinese)

17 ZHAO K, HE D. Target detection method for moving cows based on background subtraction[J]. International Journal of Agricultural and Biological Engineering, 2015, 8(1): 42-49.

18 VIAZZI S, BAHR C, Van HERTEM T, et al. Comparison of a three-dimensional and two-dimensional camera system for automated measurement of back posture in dairy cows[J]. Computers and Electronics in Agriculture, 2014, 100(1): 139-147.

19 SHOTTON J, SHARP T, KIPMAN A, et al.Real-time human pose recognition in parts from single depth images[J]. Communications of the ACM, 2013, 56(1): 116-124.

20 ANTONIO H V, NADEZHDA Z, ALEXANDER M, et al. Graph cuts optimization for multi-limb human segmentation in depth maps[C]∥2012 IEEE Conference on Computer Vision & Pattern Recognition,2012:726-732.

21 NANNI L, BRAHNAM S, LUMINI A. A simple method for improving local binary patterns by considering non-uniform patterns[J].Pattern Recognition, 2012, 45(10): 3844-3852.

Fine Segment Method of Cows’ Body Parts in Depth Images Based on Machine Learning

ZHAO Kaixuan LI Guoqiang HE Dongjian

(CollegeofMechanicalandElectronicEngineering,NorthwestA&FUniversity,Yangling,Shaanxi712100,China)

The recognition of cows’ body parts is essential for providing accurate details of the cows’ shape, which is the fundamental prerequisite for locomotion scoring, posture detection and behavioral quantifications. The objective was to develop a robust depth feature in order to reduce the difficulty in building the classifier and detect cows’ body parts with higher accuracy. Therefore, a method for segmenting cows’ body parts was proposed, including the head, neck, body, forelimbs, hind limbs and tail, with high accuracy on the basis of depth image processing and machine learning. The local binary patterns of each pixel under several sampling radii were used as the features with which the filtering rules were designed, and a decision forest was trained and tested to classify the pixels into six groups. Furthermore, totally 288 depth images were captured from 30 cows; 150 images were randomly selected to build three decision trees, and the rest images were used for testing. The results showed that when the number of sampling radii and training layers were 30 and 20, respectively, the recognition rate reached 95.15%. Among the cows’ body parts, the recognition rate of tail was 54.97%, and the minimum recognition rate of other parts was 89.22%. In some cases that tail was too close to trunk to segment tail from trunk by human marker, the decision trees recognized the tail successfully. The average recognition time for pixel were 0.38 ms and 0.25 ms, and the recognition time for cow target were 20.30 s and 15.25 s for the conventional method and new method, respectively. This LBP-based depth image feature was translation-invariant and rotation-invariant and had fewer parameters. The results showed that the new method proposed was more effective in recognizing small and complex structures of the cow target with higher accuracy. Compared with the typical depth image features, the new feature employed was capable of extracting the details of cows’ body and recognizing complex parts more accurately with fewer parameters and simple model.

cows; target detection; body segment; depth image; machine learning

10.6041/j.issn.1000-1298.2017.04.023

2017-01-02

2017-02-11

國家自然科學基金項目(61473235)

趙凱旋(1989—),男,博士生,主要從事基于圖像處理的動物行為分析方法研究,E-mail: zkx@nwsuaf.edu.cn

何東健(1957—),男,教授,博士生導師,主要從事生物圖像分析及識別、智能化檢測與控制研究,E-mail: hdj168@nwsuaf.edu.cn

S24; S823.9+1

A

1000-1298(2017)04-0173-07