面向閱讀教學的眼動數據可視化批注方法

,

(浙江工業大學 計算機科學與技術學院,浙江 杭州 310023)

面向閱讀教學的眼動數據可視化批注方法

程時偉,孫煜杰

(浙江工業大學 計算機科學與技術學院,浙江 杭州 310023)

學生在論文閱讀過程中往往無法把握重點、理解全文結構和段落關系,導致閱讀理解水平較低.因此,為了提高學生的閱讀理解水平,研究閱讀過程中的眼動行為,記錄注視點和眼跳等眼動數據,提取相關的閱讀特征,在此基礎上生成眼動數據可視化批注.主要利用灰色陰影表示段落閱讀速度、段落邊框表示重復閱讀的次數以及段落間連線表示相互之間的轉換頻率.在具體的閱讀教學課堂測試中,記錄教師閱讀論文時的眼動數據并生成可視化批注,然后分享給學生被試用戶,進而對學生閱讀理解水平進行客觀和主觀評價.結果表明:實驗組學生的閱讀理解客觀答題得分和主觀小結撰寫得分,其平均值分別比控制組學生的平均得分提高了31%和57%,驗證了眼動可視化批注能有效提高學生的閱讀理解水平.

眼動跟蹤;注視點;閱讀;社會計算;人機交互

人們在閱讀紙質書籍和文檔時常做一些批注,批注不僅能幫助人們標記重要的、有趣的或者較難理解的段落,還能在再次閱讀時或者他人閱讀時,通過強調或提示來提高理解水平[1-2].讀者在閱讀一篇文檔時,如果可以利用以前讀者的經驗,就能在閱讀過程更加集中注意力,從而提高閱讀效率.然而,傳統的手工批注也有其局限性,例如,通過劃線來強調一句話或者添加一段注釋,通常會增加體力和認知負荷;而且手工批注也不能揭示讀者的視覺注意力行為.另一方面,近年來也出現了一些閱讀輔助工具,例如,Markup是一個眾包閱讀工具,它可以在紙質文檔上呈現不同用戶標注的數字化批注,使人們可以在協同環境下進行閱讀,在一個群體協作的機制下受益[1].然而,這樣的批注工具需要特定的硬件配置,限制了其在實際中的應用和推廣.相比之下,眼動(Eye movement)數據可以表征人們的視覺注意力以及視覺搜索績效[3].現代心理學家認為眼動是視覺過程的直接反應,由此發展而來的眼動跟蹤技術被廣泛應用于閱讀研究[4].涉及閱讀過程大腦認知加工的眼動主要包括三類:1) 注視點(Fixation),用于獲取閱讀信息;2) 眼跳(Saccade),從一個注視點運動到另一個注視點,用于閱讀過程的持續進行;3) 回視(Regressive eye movement),用于將注視點返回以進一步獲取閱讀信息[5].在有效的閱讀過程中,讀者的注視點需要處于恰當位置,同時加長眼跳距離,以及避免不必要的回視和采取有效回視等來提高閱讀效率和閱讀理解水平[6].

眼動數據的可視化可以用來作為一種新的批注方式.Text2.0框架根據眼動數據實時創建批注,當用戶注視相關文字時顯示批注[7].利用眼動跟蹤技術可以檢測讀者閱讀的文字字數和文檔類型[8-9].結合眼動跟蹤和光學字符識別(Optical character recognition, OCR)技術,還可以用于判斷用戶正在閱讀哪一行文字,進而自動生成一些簡單的批注,例如,顯示截止當前位置所耗費的閱讀時間[10].然而,尚未有人探索如何利用眼動數據生成的批注來提高閱讀理解水平.為此,筆者分析閱讀過程中的視覺注意行為特征,基于眼動數據進行可視化表達,生成相應的批注,并在課堂閱讀教學過程中,讓學生查看教師的眼動數據可視化批注,研究學生的閱讀理解水平是否得到提高.

1 基于眼動數據的閱讀特征提取

將英文論文作為閱讀材料,將論文中的每個標題(或副標題)、段落(包括參考文獻),以及插圖等作為感興趣區(Area of interest, AOI).論文的其他地方是空白區域或很少被讀者關注的區域,因此不將它們考慮在內.記錄閱讀過程中讀者在AOI中的眼動數據,進而提取相關的閱讀特征,用以衡量讀者對文本段落的理解程度[11].定義兩類閱讀特征:1) AOI內特征包括單個AOI的閱讀速度和單個AOI的閱讀次數;2) AOI間特征是指兩個AOI之間的轉換頻率,用于分析一篇文檔不同部分之間的語義關系,可以為主動閱讀過程中的導航提供有益的支持[2].下面對各特征做具體描述.

1.1 單個AOI的閱讀速度

閱讀速度可以反映讀者的閱讀興趣,例如,讀者可能很快瀏覽完文檔中不感興趣或者易于理解的部分.單個AOI的閱讀速度的計算式為

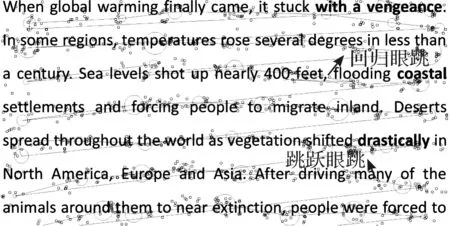

式中:Lk為當前AOIi中的每一段眼跳長度;TAOIi為當前AOIi的駐留時間(Dwell time,表示視線在一個AOI內停留的總時間).如圖1所示,這里的一段文本為一個AOI(線條為眼跳,稍大的圓圈為注視點,稍小的圓圈為原始采樣點),讀者的視線從左到右、從上到下進行逐行閱讀,其中眼跳包括回歸眼跳(即反向的視線跟蹤)和跳躍眼跳(即前向的視線跟蹤),它們可以幫助用戶更好的理解信息[11-12].

圖1 單個AOI內的眼動特征示例Fig.1 Example of eye movement features in a single AOI

定義“AOI內時間閾值”為p(例如1 s),如果TAOIi>p,就記錄下這段駐留時間內的閱讀速度,因為過短的駐留時間通常意味著僅僅是一瞥而過,對閱讀并沒有實質幫助.例如,讀者常常會上下滾動瀏覽器,在這個過程中,雖然他們的注視點會在很多AOI內非常短暫的停留,但是沒有具體的閱讀活動發生.不僅可以使用時間閾值過濾噪聲數據,也用它來調整可視化批注.例如,降低閾值p會產生更多的可視化批注,這樣會分散讀者的注意力,導致讀者過多關注不重要的段落.

1.2 單個AOI的閱讀次數

對于一個特定的AOI,統計讀者視線在該區域的累計閱讀次數.如果讀者視線從該AOI離開,移動到其他AOI,那么離開的時間應該大于閾值p(即在其他AOI內進行了有效閱讀),才能在視線返回原AOI的時候,重新計算為一次新的閱讀.閱讀次數可以表征段落的理解難易程度或重要程度,因為通常難于理解或重要的段落會被反復閱讀[13].

1.3 兩個AOI之間的轉換頻率

如果讀者的視線駐留在一個AOI的時間超過閾值p,那么這個AOI就定義為“源AOI”;然后,如果視線移到另外一個AOI,且駐留時間也超過閾值p,那么這個AOI就定義為“目標AOI”.這樣就可以過濾數據,排除無效的視線轉換.例如,讀者的視線會無意識地轉移到其他AOI(因為自底向上的視覺認知干擾造成[14],例如,被顯著的標題所吸引),并停留短暫時間,然后又轉換到原來的AOI.此外,通常兩個在內容上有緊密聯系的AOI也會相距較近.定義“AOI間時間閾值”為q(例如10 s),如果視線離開源AOI到目標AOI這中間的時間小于q,就認為這些AOI之間是相關的,并將這兩個AOI之間的轉換頻率計數加1.

2 閱讀特征的可視化

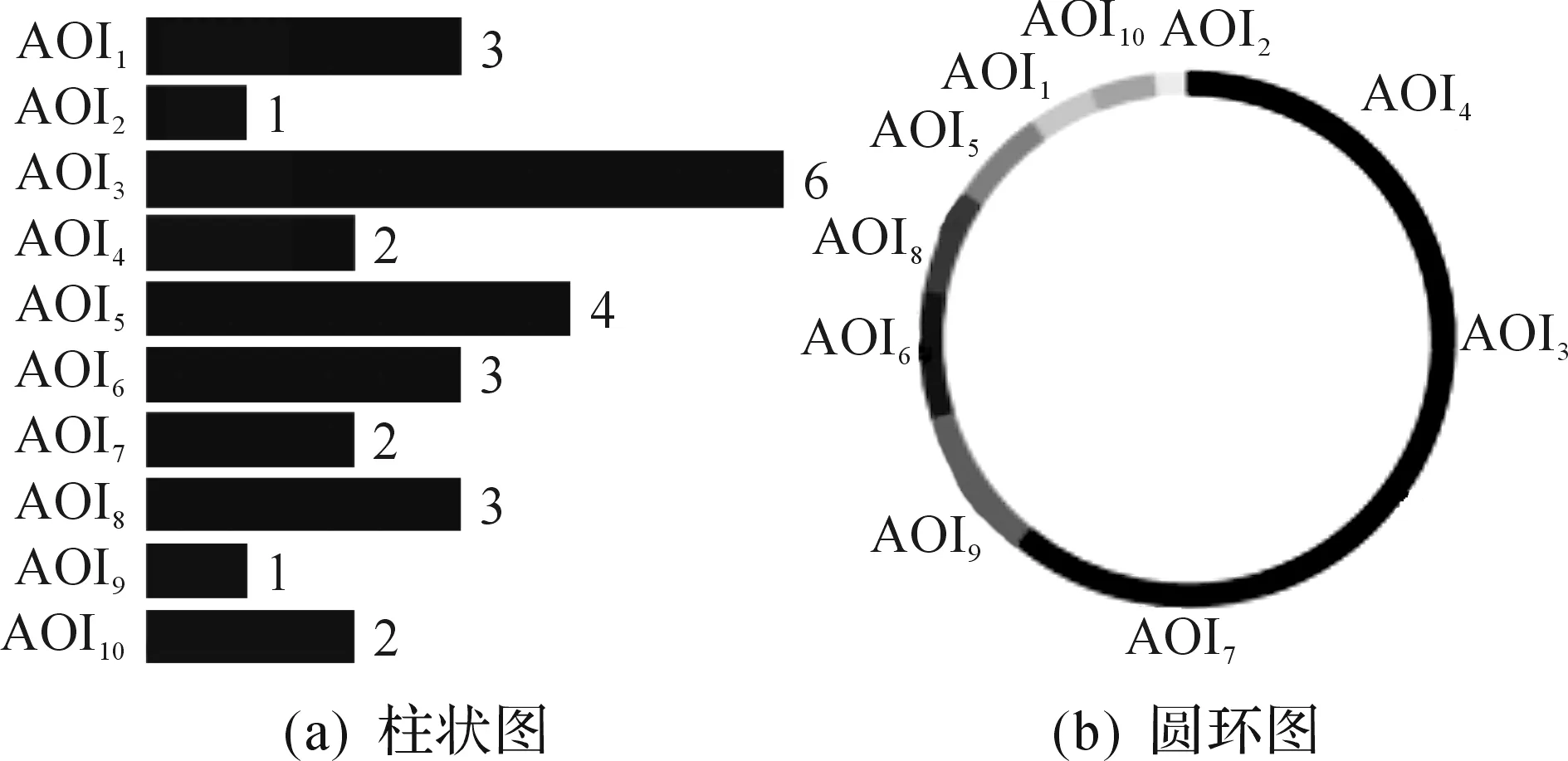

如圖2所示,提出3種具體的可視化形式對上文所述的閱讀特征進行可視化編碼:1) 灰色陰影表示用戶閱讀某個AOI的速度,顏色越深表示閱讀速度越快;2) 邊框寬度表示讀者閱讀某個AOI的次數,AOI的邊框越粗,表示閱讀次數越多;3) 連線寬度表示讀者在兩個不同AOI之間轉換頻率,連接兩個AOI的線條越粗,表示轉換頻率越高,且不同顏色表示不同AOI對之間的聯系.可以動態配置可視化參數,例如:時間閾值(例如p,q)、透明度、隱藏或顯示不同的閱讀特征等,使之呈現最佳的可視化效果.

圖2 閱讀特征可視化示例Fig.2 Example of reading feature visualization

此外,還對用戶在主要AOI的駐留時間進行了可視化編碼,包括柱狀圖和圓環圖,如圖3所示.以圓環圖為例,隨機用不同顏色在圓環的圓弧上表示每個AOI的駐留時間,每個AOI對應的圓弧圓心角為

式中:TAOIi為當前AOIi的駐留時間;AngleAOIi為AOIi對應的圓心角.在此基礎上通過圓心角計算每段圓弧的弧長.

圖3 AOI駐留時間可視化示例Fig.3 Example of visualization for dwell time on AOI

3 用戶測試

3.1 被試用戶

被試用戶分為兩類:一類是大學教師,包括1名女性和3名男性,年齡在35~40歲,學科背景、專業水平和英文閱讀水平相近;另一類是大學生,包括11名女性,25名男性,年齡在18~25歲,平均年齡22.8歲,英文閱讀水平相近,均通過大學英語4級考試.所有被試用戶都沒有任何視力障礙,且均具有計算機相關專業背景,每周至少閱讀一篇英文學術論文.

3.2 測試儀器

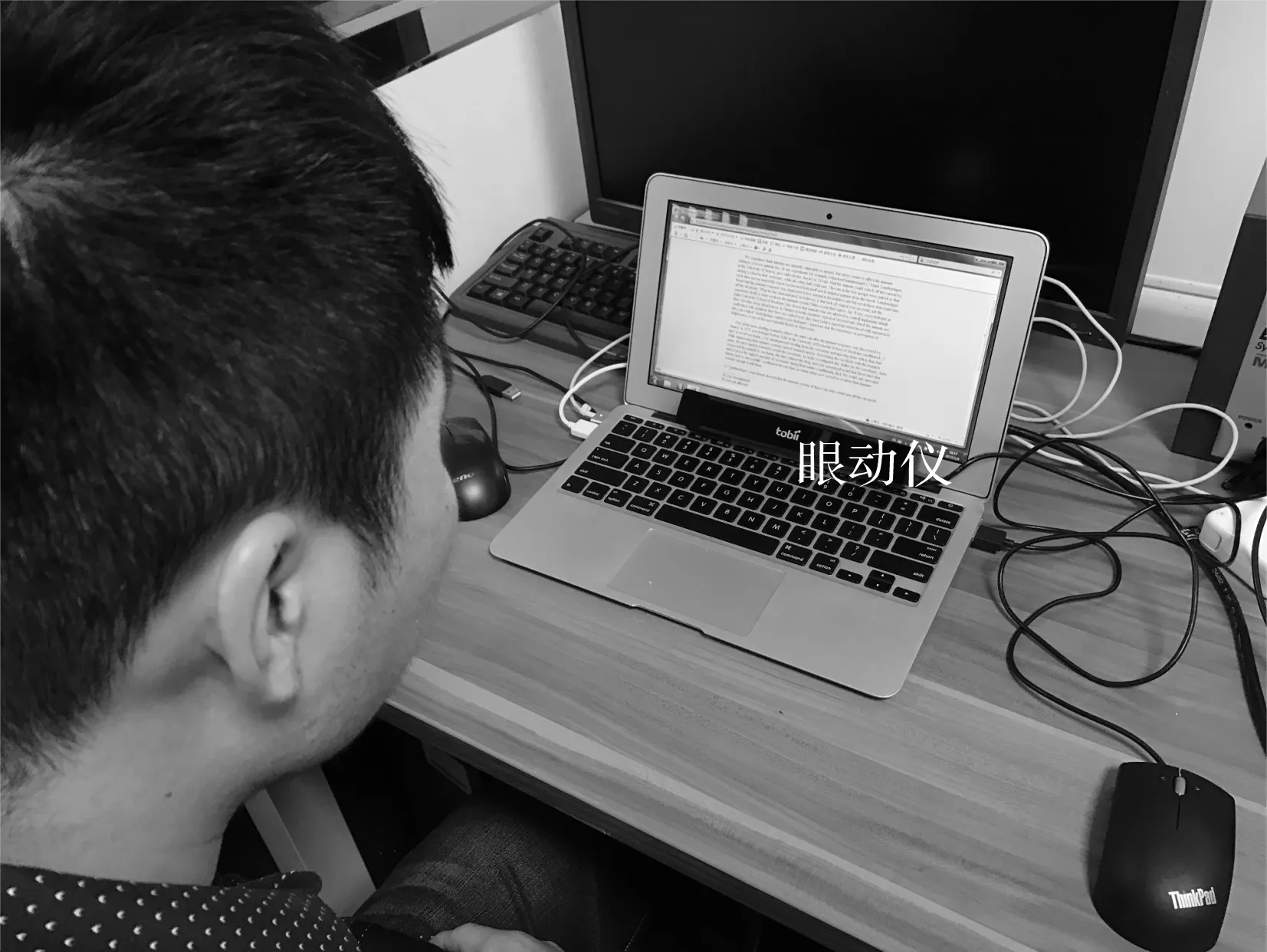

如圖4所示,使用Tobii公司的X2-60型眼動儀(眼動跟蹤采樣頻率設置為60 Hz)記錄眼動數據,它的操作距離(用戶眼睛與屏幕之間的距離)大約為40~50 cm,支持頭部自由運動,對眨眼引起的數據丟失可進行即時補償,眼動跟蹤平均精度為0.4度視角.閱讀材料來自計算機專業領域的論文數據庫,是一篇4頁篇幅的英文論文,該論文有清晰而緊密的邏輯結構和布局,易于進行眼動數據的記錄和可視化.這篇論文顯示在分辨率為1 366×768的11.6英寸的筆記本電腦顯示屏上.

圖4 眼動測試場景Fig.4 User study scenario of eye tracking

3.3 測試過程

測試過程分為預測試和正式測試兩個階段.

3.3.1 預測試階段

每個大學生被試閱讀一篇2頁長度的英文學術論文(相關內容不在正式測試中出現),然后從其中排除閱讀速度過快(例如小于6 min)和過慢(例如大于30 min)的用戶.這樣做的原因是降低大學生被試用戶在閱讀經驗和閱讀能力方面的差異性,從而減少個體差異性對實驗結果的影響;此外,還向被試用戶介紹各種可視化批注的含義與用途,使其對可視化批注有基本的了解,并獲取他們對可視化批注的初步反饋.結果顯示:91%的被試用戶反饋表示柱狀圖和圓環圖的用處不大,且需要對照各具體AOI(如文章段落)才能理解其含義,使用不方便.針對其他幾種可視化批注,都有超過50%的用戶反饋表示這些批注形式可以幫助閱讀,且易于理解.因此,在正式測試中將柱狀圖和圓環圖刪去,不再進行測試.

3.3.2 正式測試階段

教師被試用戶在沒有時間限制的情況下首先閱讀這篇論文,然后獨自寫一個論文總結,并回答一份問卷調查,以評估他們的閱讀理解水平.同時,記錄他們在閱讀過程中的眼動數據,并將這些眼動數據轉化成可視化批注信息.選擇組間測試方法來研究這些批注對學生閱讀理解的影響.學生被試用戶被隨機分成實驗組和控制組,然后交換個別學生,以平衡兩組成員的年齡和性別.所有學生被試者所閱讀的論文與教師被試閱讀的相同.測試也沒有時間限

制,每個學生按個人的正常速度進行閱讀.控制組內的學生閱讀的論文沒有任何批注,而實驗組內的學生閱讀的論文會疊加教師眼動數據的可視化批注.學生被試閱讀結束后,采用客觀和主觀兩種方法來評價他們的閱讀理解水平.首先,學生被試需要回答5個關于這篇論文的閱讀理解問題(客觀評價);此外,還要針對這篇文章寫一段總結,該總結將被教師用于評價閱讀理解質量(主觀評價).

3.4 測試結果

進行閱讀理解水平的客觀評價,要求大學生被試用戶回答5個關于論文內容方面(多選)的理解問題,其答案包含在論文相關章節.例如,其中一道題是“這篇論文的主要貢獻是什么”,這題的答案可以在論文引言部分找到.每題回答正確記1分,全部題目答對可得5分.對實驗組和控制組的得分差異性進行分析,設定零假設為“實驗組和控制組的平均分數相同”.結果顯示,控制組平均得分為2.9分,標準差1.4分;實驗組平均得分為3.8分,標準差為0.9分,采用曼-惠特尼U檢驗,得到U=62.1,p<0.05,因此拒絕零假設,說明實驗組和控制組的平均得分存在顯著差異,且實驗組得分較高.

進行閱讀理解水平的主觀評價,要求教師用戶分別獨立地對學生寫的總結質量進行評價,以5分制進行評分(1分表示最差,5分表示最好).4位老師對學生總結的評價基本保持一致,計算他們給出的平均分.對實驗組和控制組的總結評價得分進行假設檢驗,設定零假設為“實驗組和控制組的平均分數相同”.結果顯示,控制組平均得分為2.3分,標準差為1.2分;實驗組平均得分3.6分,標準差為1.1分,通過曼-惠特尼U檢驗,U=57.0,p<0.05,因此,拒絕零假設,說明實驗組和控制組的平均得分存在顯著差異,且實驗組得分較高.上述檢驗結果說明:老師的眼動數據可視化注釋幫助學生提高了他們的閱讀理解能力.

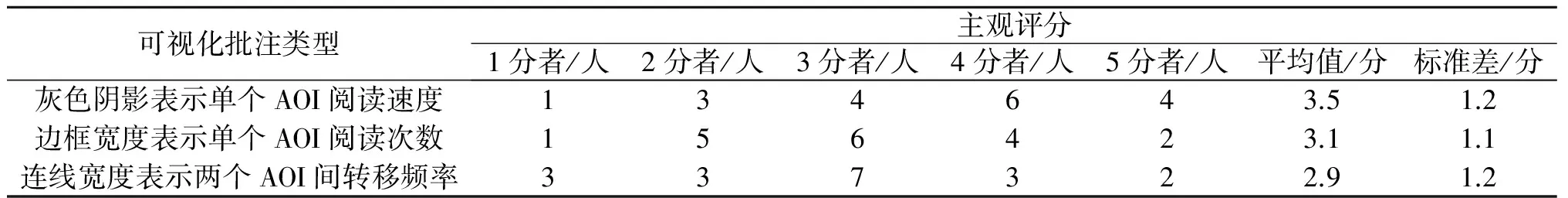

此外,還通過調查問卷分析了學生被試用戶的主觀反饋.實驗組的被試者(18個被試者)對每種類型的可視化批注進行評分(5分制:1分=完全沒有幫助;2分=沒幫助;3分=不確定是否有幫助;4分=有幫助;5分=非常有幫助),結果如表1所示.

表1 被試學生用戶對不同可視化批注的主觀評分Table 1 The subjective evaluation from student participants for different annotations

進一步對實驗組被試用戶進行了訪談.針對表示閱讀速的灰色陰影批注,其中一些被試學生用戶說“閱讀速讀可視化批注在視覺上最直觀”“灰色陰影區分了不同段落的重要性”“教師的閱讀速度對于某個段落是否重要是一個很好的指標,快速閱讀的部分代表教師很重視,較慢閱讀的部分表示比較重要”.針對利用眼動數據批注撰寫總結,一些被試學生用戶說“眼動數據批注展示了這篇論文的重點”“如果我和老師都認為某一段是重要的,那么我就會將它寫進我的論文總結中”.

3.5 結果討論

這里討論筆者方法的一些不足和改進方法.有一位被試學生說“人們重復閱讀一段文字,到底是因為它重要呢,還是只是因為這段文字表達不清楚而難以理解?而且有些人也可以快速地閱讀一個段落,并不是因為這個段落不重要而是因為讀者本身對這段內容很熟悉”.為了處理這種模糊性,將進一步和文檔本身的語義分析相結合,從而可以確定哪些段落是難于理解的,例如,有很多專業術語和公式;或者是重要的,例如,包含較多與文檔主題相關的關鍵詞.

教師和學生之間閱讀行為的差異也可能會降低筆者方法的有效性.正如一位被試學生所言,“教師具有一些專業背景知識,因此他們會跳過一些段落,所以導致學生有時會漏掉一些重要段落”.所以在今后的研究中,會繼續探討學生與學生之間的眼動數據可視化批注的共享,因為學生之間的個體差異通常要相對較小.

當教師通過學生撰寫的總結來評價學生的閱讀理解水平時,他們是根據自己的經驗和標準來判斷的,因此會有一些主觀判斷成分.例如,如果一個學生抓住了文章的重點,但是這個重點并未被教師所重視,那么這個學生的閱讀能力所得評分就會較低.下一步,將對閱讀理解水平的評價指標進行改進.此外,在實驗中,4位教師的的閱讀風格比較類似,所以先融合了4位教師的眼動數據可視化批注,然后再展示給學生.所以在后續工作中,將研究如何將多個不同閱讀風格的教師眼動數據可視化批注融合在一起,或者將風格差異較大的可視化批注展同時展現給學生,并讓學生進行自由選擇.

4 結 論

記錄用戶閱讀過程中的眼動數據,并根據相關閱讀特征將它們可視化.將教師閱讀文章的眼動數據可視化批注分享給閱讀這篇文章的學生,結果發現,眼動數據可視化批注有助于提高學生的閱讀理解能力,為今后進一步開展閱讀教學方法改革提供了一條有益的途徑.

本文得到浙江工業大學教學改革項目(JG201620)和浙江工業大學研究生教學改革項目(2016114)的資助.

[1] CHIRCOP L, RADHAKRISHNAN J, SELENER L, et al. Markitup: crowdsourced collaborative reading[C]//Extended Abstracts on Human Factors in Computing Systems. New York: ACM Press,2013:2567-2572.

[2] TASHMAN C, EDWARDS W. Active reading and its discontents: the situations, problems and ideas of readers[C]// Proceedings of the SIGCHI Conference on Human Factors in Computing Systems. New York: ACM Press,2011:2927-2936.

[3] 湯洪濤,蘇丹丹,蘭秀菊,等.基于眼動的多目標視覺搜索績效研究[J].浙江工業大學學報,2017,45(1):108-113.

[4] RAYNER K. Eye movements in reading and information processing[J]. Psychological bulletin,1978,85:618-660.

[5] 范琳,劉振前.閱讀理解過程的眼動研究[J].外語與外語教學,2007,217(4):35-40.

[6] DUSSIAS P E. Uses of eye-tracking data in second language sentence processing research [J]. Annual review of applied linguistics,2010,30:149-166.

[7] BIEDERT R, BUSCHER G, SCHWARZ S, et al. Text2.0[C]//Extended Abstracts on Human Factors in Computing Systems. New York: ACM Press,2010:4003-4008.

[8] KUNZE K, IWAMURA M, KISE K, et al. Activity recognition for the mind: toward a cognitive “quantified self”[J]. Computer,2013,46(10):105-108.

[9] KUNZE K, UTSUMI Y, SHIGAY K, et al. I know what you are reading: recognition of document types using mobile eye tracking [C]//Proceedings of the International Symposium on Wearable Computers. New York: ACM Press,2013:113-116.

[10] BUSCHER G, DENGEL A, ELST L, et al. Generating and using gaze-based document annotations [C]//Extended Abstracts on Human Factors in Computing Systems. New York: ACM Press,2008:3045-3050.

[11] BIEDERT R, DENGEL A, ELSHAMY M, et al. Towards robust gaze-based objective quality measures for text [C]//Proceedings of the Symposium on Eye Tracking Research and Applications. New York: ACM Press,2012:201-204.

[12] VO T, MENDIS B S U, GEDEON T. Gaze pattern and reading comprehension[C]//International Conference on Neural Information Processing. Berlin: Springer-Verlag,2010:124-131.

[13] LENZNER T, KACZMIREK L, GALESIC M. Seeing through the eyes of the respondent: an eye-tracking study on survey question comprehension [J]. International journal of public opinion research,2011,23(3):361-373.

[14] CONNOR C E, EGETH H E, YANTIS S. Visual attention: bottom-up versus top-down [J]. Current biology,2004,14(19):850-852.

Eyemovementdatavisualizationbasedannotationforreadingteaching

CHENG Shiwei, SUN Yujie

(College of Computer Science and Technology, Zhejiang University of Technology, Hangzhou 310023, China)

In the process of reading articles, students often can not grasp the focus, understand the full text structure and paragraph relationship, it results a lower level of reading comprehension. In order to improve students’ reading comprehension, research in this paper focus on eye gaze movement behavior during reading process was conducted, and features related to reading were extracted with eye movement data, such as gaze fixations and saccades. Then the eye movement data was visualized as reading annotations. These annotations mainly included three kinds of visualizations: gray shading to indicate reading speed, borders to indicate frequency of re-reading, and lines to indicate transitions between sections of a document. Through a user study in reading class, we recorded teachers’ eye movement data and generated visual annotations, and then shared the annotations to their students. Finally, the evaluation results showed that, the average scores on reading comprehension quiz and summary from students in experimental group is higher than the students in control group with 31% and 57% respectively, and it validated that the annotations could improve students’ reading comprehension.

eye tracking; fixation; reading; social computing; human-computer interaction

2017-02-14

國家重點研發計劃項目(2016YFB1001403);國家自然科學基金資助項目(61272308);浙江省自然科學基金資助項目(LY15F020030)

程時偉(1981—),男,湖北黃石人,副教授,工學博士,研究方向為人機交互技術,E-mail:swc@zjut.edu.cn.

TP391

A

1006-4303(2017)06-0610-05

(責任編輯:陳石平)