卷積神經網絡及其在手寫體數字識別中的應用

馬媛媛,史加榮

( 西安建筑科技大學 理學院,陜西 西安 710055)

卷積神經網絡及其在手寫體數字識別中的應用

馬媛媛,史加榮*

( 西安建筑科技大學 理學院,陜西 西安 710055)

深度學習是機器學習領域的研究熱點,它使機器學習更加接近人工智能。作為深度學習的一類經典模型,卷積神經網絡已被廣泛應用于語音識別、圖像識別和自然語言處理等領域中。本文探討了卷積神經網絡的基本原理、實現及應用。首先回顧了卷積神經網絡的發展歷史,闡述了它的基本原理,研究了卷積層和下采樣層;其次總結了卷積神經網絡的三大重要特性:稀疏連接、權值共享和池采樣,并將卷積神經網絡應用在MNIST手寫體數字識別任務中;最后指出了卷積神經網絡未來的重點研究方向。

卷積神經網絡;深度學習;卷積;下采樣;手寫體數字識別

人工智能是一門研究開發模擬、延伸和擴展人類智能的技術,其主要研究內容可歸納為四個方面:機器感知、機器思維、機器行為和機器學習[1]。而機器學習是利用計算機、概率論、統計學等知識,通過給計算機程序輸入數據,讓計算機能夠學習新知識和新技能,其最初的研究動機是為了讓計算機系統具有人的學習能力以便實現人工智能[2]。深度學習是基于學習特征的更廣泛的機器學習方法,它試圖在多個層次中進行學習,其中較高層次的概念是從較低層次的概念中定義的,而較低層次的概念可以幫助定義許多更高層的概念[3]。

隨著研究的不斷深入,深度學習技術已經被應用到數以百計的實際問題中,且超出了傳統的多層神經網絡的內涵。2006年機器學習領域泰斗Hinton教授提出了利用受限的玻爾茲曼機進行預訓練的方法[4-5],主要觀點為:人工神經網絡模型的層數越深,其特征學習能力越強;可通過“逐層訓練”的學習算法解決深度神經網絡在訓練上的難題。該方法引發了深度學習在研究和應用領域中的浪潮。同年,Hinton等人還提出了一種貪婪的逐層學習算法:深度置信網絡,該網絡先采用無監督學習對整個網絡進行預訓練,再采用監督學習對整個網絡進行反向微調[6]。此后,深度學習的各種模型被相繼提出,主要包括:自編碼器[7]、稀疏自編碼器[8]、卷積神經網絡[9]、循環神經網絡[10]等,其中,卷積神經網絡(Convolutional Neural Network, CNN)是深度學習的一種較為經典的神經網絡模型。

卷積神經網絡是一類特殊的用于數據處理的神經網絡,它受視覺系統結構的啟發,由生物學家Hubel和Wiesel于1962年提出。他們通過對貓的實驗發現:人的視覺系統的信息處理是分級的,初級視覺皮層提取邊緣特征,中級視覺皮層提取形狀或者目標,更高層的視覺皮層得到特征組合[11]。受此啟發,Lecun等人[12]于1989年提出了卷積神經網絡。此后,卷積神經網絡被廣泛地應用于圖像處理、語音識別和時間序列分析[13]等領域中,并衍生出許多改進模型。

2012年,Krizhevsky等[14]提出了AlexNet模型,該模型為包含8個學習層的卷積神經網絡,并在該年ImageNet[15]國際計算機視覺挑戰賽中奪得冠軍,這使卷積神經網絡成為學術界關注的焦點。此后,每年的ImageNet挑戰賽中都出現了新的卷積神經網絡模型,這些模型不斷地刷新著AlexNet在ImageNet上創造的記錄。深度卷積神經網絡已成為眾多學科研究的熱點,被廣泛地應用于圖像識別[16]、語音識別[17]和自然語言處理[18]等領域中。

1 卷積神經網絡的基本原理

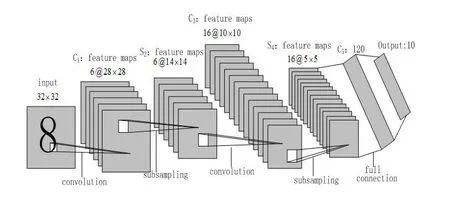

卷積神經網絡是一類特殊的深度前饋神經網絡,主要由輸入層、隱層、全連接層和輸出層組成,而隱層是由卷積層和下采樣層交替連接的。一個經典的卷積神經網絡模型如圖1所示,該模型共七層,其中包括一個輸入層、兩個卷積層、兩個采樣層、一個全連接層和一個輸出層。卷積層通過卷積操作提取特征,再通過下采樣操作將提取的特征組合成更加抽象的特征,接著將組合的特征輸入到一個或多個全連接層,而全連接層的每一個神經元與前一層的所有神經元進行全連接,最后一個全連接層連接到輸出層。下面分別介紹卷積神經網絡的各個模塊[19]。

圖1 卷積神經網絡架構圖

1.1輸入層與輸出層

在輸入層中,一般輸入數據是圖像。對于灰度圖像或RGB圖像,像素的取值范圍為0~255,它代表像素灰度。輸出層一般采用softmax邏輯回歸函數進行分類。

1.2卷積層

卷積是數學分析中一種重要的線性運算,是兩個變量在某范圍內逐點相乘求和的結果[20-21]。在圖像處理中,圖像通常表示成二維矩陣的形式。因此只考慮離散序列情形,且只對二維卷積做闡述。圖2給出了一個二維卷積操作的例子(不包含卷積核的翻轉)。在圖2中,左上角為輸入數據(4×4矩陣),右上角為卷積核(2×2濾波器),下方為卷積操作結果(3×3矩陣)。由該圖可以看出,卷積核被重復地應用于整個輸入數據中,最終得到卷積的輸出結果。

圖2 二維卷積運算示意圖

(1)

1.3下采樣層

下采樣層也稱池化層[19-24],它可以大大減少神經元的個數,在一定程度上降低網絡的擬合程度。下采樣層旨在通過降低特征維數來獲得具有空間不變性的特征。池化就是將輸入圖像進行縮小,這在一定程度上保留了一些重要或者突出的信息。常用的池化方法有最大池化(max pooling)或均值池化(average pooling)[24-25]。最大池化是指取采樣區域中的最大值作為像素值,該方法特別適用于分離特別稀疏的特征的情形。圖3給出了最大池化運算示意圖。在圖3中,9×9的原始數據按2×2的大小大致被分成3×3的分塊矩陣,而每個子塊矩陣用其最大值來代替。通過最大池化運算,9×9的矩陣被縮小為3×3的矩陣。

圖3 最大池化運算示意圖

均值池化是指取采樣區域內所有值的均值作為結果的輸出值,該方法用到了采樣區域內所有的采樣點。圖4給出了均值池化運算示意圖,其左邊為輸入數據,右邊為經過均值池化運算后的輸出矩陣。在進行均值池化運算時,取輸入圖像中每一個大小為2×2的子塊的平均值作為輸出像素值,如果子塊大小不足 ,則用0補充。經過均值池化操作后,一幅圖像大約也縮小為原來的四分之一。

圖4 平均池采樣運算示意圖

(2)

1.4全連接層

全連接層可以整合卷積層或者下采樣層中具有類別判別性的局部信息[26]。為了提升卷積神經網絡的性能,全連接層的每個神經元的激勵函數可采用ReLU函數[27]或者其他非線性函數,其中,ReLU函數為f(x)=max(0,x)。與sigmoid、tanh等函數相比,ReLU的數學公式簡單,且只有一個閾值0,因此它可以避免梯度彌散現象。全連接層的主要目的是維度變換,即把高維分布式特征表示變成低維的樣本標記。在這個過程中,有用的信息被保留下來,但會損失特征的位置信息。

2 卷積神經網絡的重要特性

卷積神經網絡有三大重要特性:稀疏連接、權值共享和池采樣,它們可以幫助改善機器學習系統。這些特性使卷積神經網絡在一定程度上具有平移、縮放和扭轉不變性。

2.1稀疏連接

卷積神經網絡是對BP神經網絡的改進,它們都采用信號的正向傳播計算輸出值,且使用誤差的反向傳播對模型進行監督訓練。但卷積神經網絡的相鄰層之間并不是全連接,而是稀疏連接或部分連接,即某個神經元的感知區域來自于上層的部分神經元。例如,在處理圖像時,輸入圖像可能具有數千甚至數百萬個像素,但偵測到有意義的特征只占很小的一部分,如內核邊緣只占據幾十或幾百個像素。換言之,我們需要存儲更少的參數,既能減少模型的內存需求,又能提高統計效率[19,24,27]。卷積神經網絡采用稀疏連接的方法,從而限制了每個輸出可能具有的連接數。假設有m個輸入節點和n個輸出節點,全連接方法需要m×n個參數;而稀疏連接的方法限制了每個輸出可能具有的連接數k(k遠遠小于m),有k×n個參數。圖5給出了神經元之間的全連接示意圖, 圖6給出了神經元之間的稀疏連接示意圖。以輸入節點x3及輸出節點S為例,全連接中的所有輸出節點都受到x3的影響,而稀疏連接只有三個輸出節點受x3影響。

圖5 全連接示意圖

圖6 稀疏連接示意圖

2.2權值共享

在傳統的神經網絡中,當計算某層的輸出時,權值矩陣的每個元素只被使用了一次。而在卷積神經網絡中,卷積核共享相同的參數,即相同的權值矩陣和偏置。權值共享是卷積核的參數共享,參數共享并不影響前向傳播的計算復雜度,并且還降低了網絡復雜度[19,24,28]。

2.3池化

卷積層在獲得圖像特征之后,可以利用所提取的特征進行分類器訓練,但這通常會產生極大的計算量。因此,在獲取圖像的卷積特征后,通過池化方法對卷積特征進行降維,且在一定程度上保留了一些重要或者突出的信息[24,29]。當下采樣區域為特征映射的連續區域時,得到的下采樣單元具有平移不變性。

3 卷積神經網絡在MNIST數據集中的應用

3.1 MNIST數據集簡介

MNIST數據集是一個非常簡單的手寫體數字識別數據集(http://yann.lecun.com/exdb/mnist/),包含0~9共10類手寫體數字圖像,每幅圖像大小為28×28。將此數據集分成60000個訓練樣本和10000個測試樣本[30-31]。本文的算法在Matlab R2014a版本中編碼,并在具有2.9GHz CPU的電腦上運行。本文參考DeepLearnToolbox的代碼[31],其網址如下:

https://github.com/rasmusbergpalm/DeepLearnToolbox

手寫體數字識別是字符識別領域中最具挑戰性的課題,有很大的難度,主要原因如下。由于書寫者的因素,字符圖像的隨意性很大;對于同一個數字而言,寫法有很大的不同且有很大的區域性,故很難有較高的識別率;在銀行和金融等實際應用中,對數字識別率的要求比文字要苛刻很多。

3.2實驗設計

使用MNIST數據集來驗證卷積神經網絡的有效性。除輸入層和輸出層外,將卷積神經網絡設置為一個四層的神經網絡,即兩個卷積層和兩個下采樣層。第一個卷積層(C1)有6個卷積核,大小均為5×5,經卷積后得到6張特征圖;第一個下采樣層(S2)的采樣核大小為2×2;第二個卷積層(C3)有12個卷積核,大小均為5×5,經卷積之后得到12張特征圖;第二個下采樣層(S4)的采樣核大小為2×2。

卷積神經網絡的訓練參數設置如下:

opts.batchsize=50;

%每次選擇50個樣本進行更新

opts.alpha=1; %學習率

opts.numpochs=50; %最大迭代次數

卷積神經網絡的設置和訓練程序如下:

cnn=cnnsetup(cnn, train_x, train_y);

% 對各層參數進行初始化,包括權重和偏置

cnn=cnntrain(cnn, train_x, train_y, opts);

% 開始訓練,包括BP算法及迭代過程

式中,train_x為訓練數據集,train_y為測試數據集,第一個輸入的cnn表示將其設置傳遞給cnnsetup,據此構建一個完整的CNN網絡,第二個輸入的cnn表示CNN網絡結構的初始化, 再根據訓練樣本來更新CNN網絡。

3.3實驗結果與分析

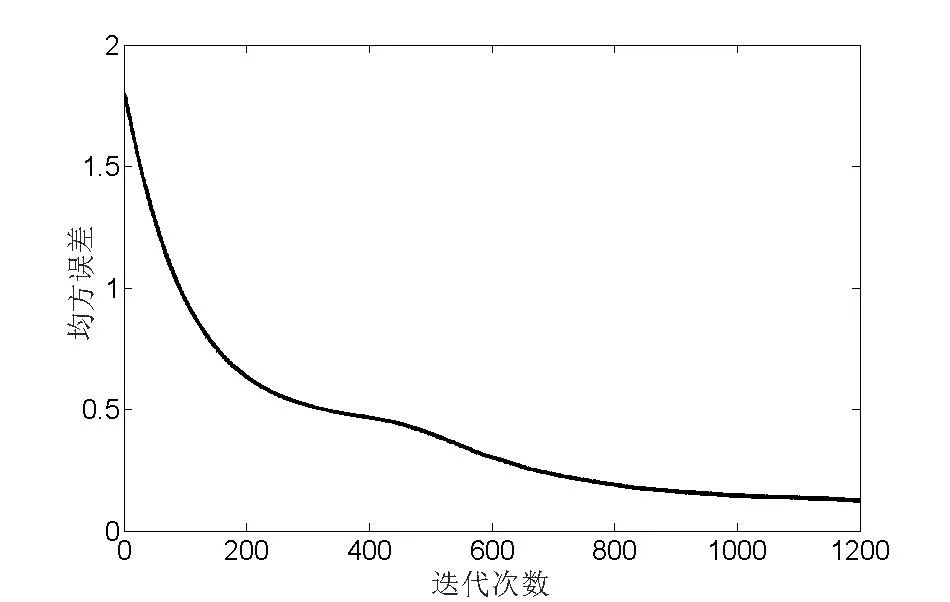

圖7繪出了卷積神經網絡在MNIST數據集上的均方誤差圖,其中橫坐標是網絡訓練過程中的迭代次數,縱坐標是該網絡模型在訓練過程中對MNIST數據集的均方誤差。由于在網絡設置時選擇了50個樣本為一批進行更新,且共有60000個樣本,所以迭代了1200次。

圖7 CNN在MNIST數據集上的均方誤差

從圖7可以看出,在進行了1200次迭代后,該網絡的均方誤差達到0.11,之后趨于穩定狀態,因此可以認為達到了算法的終止條件。卷積神經網絡的1200次迭代共用時間139秒,網絡的識別率為98.62%,而人工神經網絡的識別率為93.46%,卷積神經網絡比人工神經網絡的識別率大約提高了5%。

4 卷積神經網絡的研究展望

作為一種深度學習技術,卷積神經網絡的發展極其迅速,是近幾年來研究和應用最為廣泛的深度神經網絡。但卷積神經網絡也面臨著更多的挑戰,主要體現在以下幾個方面。

4.1理論研究

卷積神經網絡是受生物學啟發而提出的,其本身是對生物視覺成像的一種模擬。但目前的研究還未對卷積神經網絡的運作機理給出詳細的闡述。Nguyen等通過進化算法將原始圖像處理成人們完全無法識別和解釋的一種形式,但卷積神經網絡卻對轉化后的圖像形式給出了非常準確的物體類別判斷[32]。這種卷積神經網絡出現的被“欺騙”現象引起了人們對卷積神經網絡特征提取的完備性關注。

與傳統的神經網絡相比,卷積神經網絡在提取特征時受網絡結構、學習算法以及訓練集等多種因素影響,對其原理的分析與解釋比人工設計特征更加抽象和困難[33]。2017年,Levine等學者發現深度卷積算術電路所實現的函數與量子多體波函數之間存在某種等價性[34],但是否可用物理學打開深度學習的黑箱還有待進一步研究。學術界普遍采用的是以實驗為導向的研究方式,這導致卷積神經網絡的發展缺乏理論研究的支持。因此,卷積神經網絡的相關理論研究是目前最為匱乏、最有研究價值的內容。

4.2應用領域

經過多年的發展,卷積神經網絡的應用領域已從最初的手寫體識別和人臉識別,逐漸擴展到一些更為廣泛的領域,如:自然語言處理、語音識別和目標檢測等。在目標檢測應用中,許多卷積神經網路的改進模型相繼被提出,如R-CNN[35]、Fast-CNN[36]和Faster-CNN[37],這些模型在一定程度上突破了卷積神經網絡的瓶頸。在人工智能領域,AlphaGo成功地利用了卷積神經網絡對圍棋的盤面形勢進行判斷[37]。在語音識別方面,Abdel-Hamid等人將語音信息建模成符合卷積神經網絡的輸入模式,并結合了隱馬爾科夫模型[17]。

4.3開源框架

近年來,卷積神經網絡的研究熱潮持續高漲,各種開源工具層出不窮。代表性的開源工具包括Caffe[38]、Tensorflow[39]和Theano[40]等。作為深度學習框架之一,Caffe基于C++語言編寫,并且具有BSD開源代碼,可以在CPU及GPU上運行,且支持Matlab和Python接口。Caffe提供了一整套的數據流程,如數據預處理、訓練、測試、微調等。Tensorflow是谷歌公司在2015年底發布的開源人工智能系統,此系統架構靈活,在很多平臺上都可以使用,支持一個或多個CPU。與Tensorflow相似,Theano系統的架構也比較靈活,它由LISA實驗室在蒙特利爾大學開發,是深度學習較早的庫之一。Theano實際上是一個Python庫,允許用戶定義、優化和計算數學表達式,特別是提高多維數組的運算性能。這些工具的使用雖然加快了深度學習的發展,但仍然存在一些遺留的框架問題,比如:Caffe不善于處理循環神經網絡問題,且靈活性較差;Tensorflow在單個GPU上的性能不如其它幾個框架; Theano不能直接進行卷積神經網絡的預訓練。

4.4網絡結構

卷積神經網絡的層數越深,實驗結果可能越好,在實際應用中網絡層數已多達上千層。隨著網絡傳播深度的增加,模型的參數也會相應增加,此時網絡需求大量的有標簽數據,否則可能導致網絡的過擬合;而相應的網絡權重會越來越小,出現網絡的權重衰減。這些問題使卷積神經網絡難以在普通設備上應用[41-42]。因此,網絡結構設計上的優化需符合應用,注重模型架構中的分支數量,而不是繼續增加網絡的深度等。

5 結束語

本文從卷積神經網絡的基本原理和重要特性來研究卷積神經網絡理論。首先回顧了卷積神經網絡的重要組成部分:卷積層、下采樣層和全連接層,接著討論了卷積神經網絡的三大特性:稀疏連接、權值共享、池采樣,然后將卷積神經網絡應用于手寫體數字識別上,最后展望了卷積神經網絡未來的研究。如何避免過擬合現象、提高網絡的學習能力和設置合理的參數將是卷積神經網絡今后亟待解決的問題。

[1] 陳雯柏. 人工神經網絡原理與實踐[M]. 西安:西安電子科技大學出版社, 2016.

[2] Arel I, Rose D C, Karnowski T P. Deep machine learning-a new frontier in artificial intelligence research[J]. IEEE Computational Intelligence Magazine, 2010, 5(4): 13-18.

[3] Deng L, Yu D. Deep learning: methods and applications[J]. Foundations and Trends in Signal Processing, 2014, 7(3): 197-387.

[4] Hinton G E, Salakhutdinov R R. Reducing the dimensionality of data with neural networks[J]. Science, 2006, 313(5786): 504-507.

[5] Bengio Y, Lamblin P, Popovici D,et al. Greedy layerwise training of deep networks[C]// Advances in neural information processing systems. 2007: 153-160.

[6] Hinton G E, Osindero S, Teh Y W. A fast learning algorithm for deep belief nets[J]. Neural Computation, 2006, 18(7): 1527-1554.

[7] Deng L, Seltzer M L, Yu D, et al. Binary coding of speech spectrograms using a deep auto-encoder[C]//Eleventh Annual Conference of the International Speech Communication Association. 2010: 1692-1695.

[8] Bengio Y, Courville A, Vincent P. Representation learning: A review and new perspectives[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2013, 35(8): 1798-1828.

[9] Abdel-Hamid O, Deng L, Yu D. Exploring convolutional neural network structures and optimization techniques for speech recognition[C]//Interspeech, 2013: 3366-3370.

[10] Martens J, Sutskever I. Learning recurrent neural networks with hessian-free optimization[C]// International Conference on International Conference on Machine Learning. Omnipress, 2011:1033-1040.

[11] Hubel D H, Wiesel T N. Receptive fields, binocular interaction, and functional architecture in the cat’s visual cortex[J]. Journal of Physiology,1962, 160(1):106-154.

[12] Lecun Y, Bottoy L, Bingio Y, et al. Gradient-based learning applied to document recognition [J].Proceedings of the IEEE,1998, 86(11): 2278-2324.

[13] LeCun Y, Bengio Y. Convolutional networks for images, speech, and time series[J]. The Handbook of Brain Theory and Neural Networks, 1995, 3361(10): 255-258.

[14] Krizhevsky A,Sutskever I ,Hinton G E.ImageNet classification with deep convolutional neural networks[C]//Advances in Neural Information Processing Systems,2012,1097-1105.

[15] Deng J,Dong W, Socher R, et al.Imagenet:a large-scale hierarchical image database[C]//Proceedings of IEEE Conference on Computer Vision and Pattern Recognition (CVPR), 2009:248-255.

[16] Simonyan K, Zisserman A. Very deep convolutional networks for large-scale image recognition[J].arXiv preprint arXiv:1409.1556, 2014.

[17] Abdel-Hamid O, Mohamed A, Jiang H, et al. Convolutional neural networks for speech recognition[J]. IEEE/ACM Transactions on Audio, Speech, and Language Processing, 2014, 22(10):1533-1545.

[18] Kalchbrenner N, Grefenstette E, Blunsom P. A convolutional neural network for modelling sentences[J]. arXiv preprint arXiv: 1404.2188, 2014.

[19] 鄧力,俞棟.深度學習方法及應用[M].北京:機械工業出版社,2015.48-57.

[20] Bouvrie J. Notes on Convolutional Neural Networks[J]. Neural Nets, 2006.

[21] Bengio Y. Learning deep architectures for AI[J]. Foundations and Trends in Machine Learning, 2009, 2(1): 1-127.

[22] 周飛燕,金林鵬,董軍.卷積神經網絡研究綜述[J]. 計算機學報, 2017,40(6):1229-1251.

[23] 馬世龍,李小平.大數據與深度學習綜述[J].智能系統學報, 2016,11(6): 728-742.

[24] Goodfellow L, Bengio Y, Courvile A. Deep learning[M].MIT press,2016.

[25] Sainath T N, Mohamed A, Kingsbury B, et al. Deep convolutional neural networks for LVCSR[C]// IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP).2013: 8614-8618.

[26] O’Shea K, Nash R. An introduction to convolutional neural networks[J]. arXiv preprint arXiv: 1511.08458,2015.

[27] 焦李成, 趙進, 楊淑媛,等. 深度學習、優化與識別[M].北京:清華大學出版社,2017: 100-120.

[28] Yu D, Deng L. Deep learning and its applications to signal and information processing [J]. IEEE Signal Processing Magazine, 2011, 28(1): 145-154.

[29] Zeiler M D, Fergus R.Visualizing and understanding convolutional networks[C]//European Conference on Computer Vision. Springer, Cham, 2014: 818-833.

[30] Deng L. The MNIST database of handwritten digit images for machine learning research[J]. IEEE Signal Processing Magazine, 2012, 29(6): 141-142.

[31] Palm R B. Prediction as a candidate for learning deep hierarchical models of data[J]. Technical University of Denmark, 2012(5).

[32] Nguyen A, Yosinski J, Clune J. Deep neural networks are easily fooled: high confidence predictions for unrecognizable images[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. 2015: 427-436.

[33] 李彥冬, 郝宗波, 雷航.卷積神經網絡研究綜述[J].計算機應用, 2016, 36(9):2508-2515.

[34] Levine Y, Yakira D, Cohen N, et al. Deep learning and quantum physics: a fundamental bridge[J]. arXiv preprint arXiv: 1704.01552, 2017.

[35] Girshick R, Donahue J, Darrell T, et al. Rich feature hierarchies for accurate object detection and semantic segmentation[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2014: 580-587.

[36] Girshick R. Fast r-cnn[C]//Proceedings of the IEEE International Conference on Computer Vision, 2015: 1440-1448.

[37] Ren S, He K, Girshick R, et al. Faster R-CNN: towards real-time object detection with region proposal networks[C]//Advances in Neural Information Processing Systems, 2015: 91-99.

[38] Jia Y, Shelhamer E, Donahue J, et al. Caffe: Convolutional architecture for fast feature embedding[C]//Proceedings of the 22nd ACM International Conference on Multimedia, 2014: 675-678.

[39] Abadi M, Barham P, Chen J, et al. TensorFlow: a system for large-scale machine learning[C]//OSDI. 2016, 16: 265-283.

[40] 孫志軍,薛磊,許陽明, 等.深度學習研究綜述[J].計算機應用研究, 2012, 29(8):2806-2810.

[41] Schmidhuber J. Deep learning in neural networks: An overview[J].Neural networks, 2015, 61: 85-117.

[42] Ba J, Frey B. Adaptive dropout for training deep neural networks[C]//Advances in Neural Information Processing Systems, 2013: 3084-3092.

(責任編輯:熊文濤)

ConvolutionNeuralNetworkandItsApplicationinHandwrittenDigitsRecognition

Ma Yuanyuan, Shi Jiarong*

(SchoolofScience,Xi′anUniversityofArchitectureandTechnology,Xi′an,Shaanxi710055,China)

Deep learning is a new research focus in the field of machine learning and its emergence makes machine learning closer to the goal of artificial intelligence. As a classical model in deep learning, convolution neural network has been widely applied in the fields of speech recognition, image recognition, natural language processing, etc. This paper discussed the basic principle, realization and applications of convolution neural network. Firstly, it reviewed the history of convolution neural network and elaborated its basic principle of convolution neural network and investigated the convolution layer and the sub-sampling layer. Secondly, it summarized the three important characteristics of convolution neural network, i.e., sparse connection, weight sharing and sub-sampling. The handwritten digits recognition task of convolution neural network was also realized in the MNIST database. Finally, it gave future key research directions for convolution neural network.

convolution neural network; deep learning; convolution; sub-sampling; handwritten digits recognition

TP183

A

2095-4824(2017)06-0066-07

2017-08-15

國家自然科學基金青年科學基金(61403298);中國博士后科學基金(2017M613087)

馬媛媛(1991- ),女,陜西富平人,西安建筑科技大學理學院碩士研究生。

史加榮(1979- ),男,山東東阿人,西安建筑科技大學理學院副教授,博士,本文通信作者。