全卷積神經(jīng)網(wǎng)絡(luò)用于遙感影像水體提取

王 雪,隋立春,2,鐘棉卿,李頂萌,黨麗麗(. 長(zhǎng)安大學(xué),陜西 西安 7005; 2. 地理國(guó)情監(jiān)測(cè)國(guó)家測(cè)繪地理信息局工程技術(shù)研究中心,陜西 西安 7005; . 西安國(guó)際港務(wù)區(qū)規(guī)劃局,陜西 西安 70026; . 咸陽(yáng)職業(yè)技術(shù)學(xué)院,陜西 咸陽(yáng) 72000)

隨著遙感技術(shù)的發(fā)展,利用遙感影像提取水體信息是進(jìn)行水資源調(diào)查和監(jiān)測(cè)的重要手段和方法。水體提取的方法較多:基于影像光譜特征的提取方法,如畢海蕓等[1]利用的單波段閾值法、基于閾值的多波段譜間關(guān)系法、基于閾值的水體指數(shù)法等;基于影像紋理特征的提取方法,如李小濤等[2]利用變差函數(shù)來(lái)描述影像的紋理特征,根據(jù)水體的紋理特征對(duì)水體進(jìn)行提取;還有一類(lèi)綜合考慮影像的光譜特征、空間特征和紋理特征的面向?qū)ο蟮奶崛》椒ǎ缫髞喦锏萚3]把影像分割成不同的對(duì)象,利用影像的光譜信息和空間信息,在對(duì)象層次上進(jìn)行水體的提取。

近年來(lái),隨著人工智能、大數(shù)據(jù)、機(jī)器學(xué)習(xí)技術(shù)的發(fā)展,一些新型目標(biāo)提取算法和技術(shù)不斷出現(xiàn),基于全卷積神經(jīng)網(wǎng)絡(luò)(FCN)的遙感影像水體的提取就是其中之一。卷積神經(jīng)網(wǎng)絡(luò)(CNN)[4]的優(yōu)點(diǎn)在于其多層結(jié)構(gòu)能自動(dòng)學(xué)習(xí)的特征,并且可以學(xué)習(xí)到多個(gè)層次的特征;較淺的卷積神經(jīng)網(wǎng)絡(luò)感知域較小,可以學(xué)習(xí)到一些局部區(qū)域的特征,較深的卷積層具有較大的感知域,能夠?qū)W習(xí)到更加抽象的特征。目前,卷積神經(jīng)網(wǎng)絡(luò)不僅在全圖式的分類(lèi)上有所提高[5-7],也在局部任務(wù)上,如目標(biāo)檢測(cè)上取得了進(jìn)步[8-11]。

本文提出的全卷積神經(jīng)網(wǎng)絡(luò)算法用于水體目標(biāo)提取,可以從抽象的特征中恢復(fù)出每個(gè)像素所屬的類(lèi)別,使從圖像級(jí)別的分類(lèi)進(jìn)一步延伸到像素級(jí)別的分類(lèi)。因此,本文提出的算法相對(duì)于傳統(tǒng)的目標(biāo)提取算法有更高的可信度和穩(wěn)健性。

1 全卷積神經(jīng)網(wǎng)絡(luò)的基本原理

卷積神經(jīng)網(wǎng)絡(luò)是包含卷積層的深度神經(jīng)網(wǎng)絡(luò)模型。卷積神經(jīng)網(wǎng)絡(luò)模型較多,經(jīng)典的模型有2012年ImageNet比賽冠軍的模型AlexNet[5]、2014年ImageNet競(jìng)賽的雙雄VGG[6]模型和GoogleNet模型[7]。這些典型的CNN模型中,開(kāi)始幾層都是卷積層(CONV)和池化層(pool,即下采樣)的交替,然后在最后一些層(靠近輸出層)則是全連接(FC)的一維網(wǎng)絡(luò),這樣將卷積層產(chǎn)生的特征圖就映射成一個(gè)固定長(zhǎng)度的特征向量。這些典型CNN結(jié)構(gòu)適合于圖像級(jí)的分類(lèi)和回歸任務(wù)。由于最后得到的是整個(gè)輸入圖像的一個(gè)數(shù)值描述的概率值,它會(huì)將原來(lái)二維的矩陣(圖像)壓扁成一維的,從而使后半段沒(méi)有空間信息。那么,如何從抽象的特征中恢復(fù)出每個(gè)像素的所屬類(lèi)別,即從圖像級(jí)別的分類(lèi)進(jìn)一步延伸到像素級(jí)別的分類(lèi),Jonathan Long等提出了全卷積神經(jīng)網(wǎng)絡(luò)(FCN)[12]。

FCN模型將傳統(tǒng)的CNN模型的全連接層轉(zhuǎn)化成一個(gè)個(gè)卷積層,這樣所有的層都是卷積層,故稱(chēng)為全卷積網(wǎng)絡(luò)。FCN的構(gòu)建包括卷積化、上采樣(反卷積)和跳層結(jié)構(gòu)。

1.1 卷積化

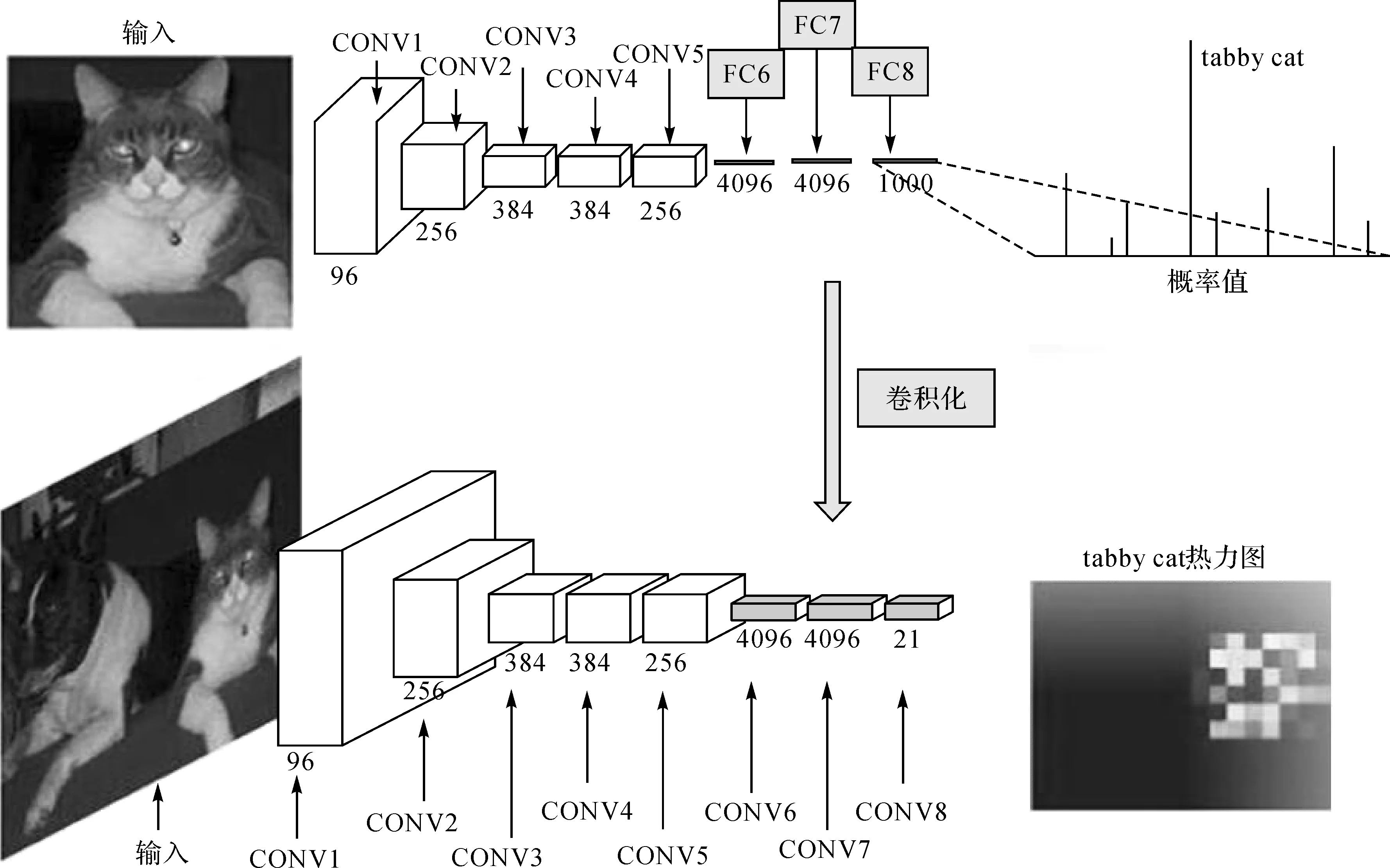

卷積化即將傳統(tǒng)的CNN全連接層轉(zhuǎn)化成一個(gè)個(gè)卷積層,輸出低分辨率的分割圖像。如圖1所示,以AlexNet模型為例。

圖1 卷積神經(jīng)網(wǎng)絡(luò)構(gòu)建全卷積神經(jīng)網(wǎng)絡(luò)示意圖

圖1中,CONV1—CONV5為卷積層,同時(shí)每層下采樣,圖像尺寸每層降2倍,全連接層FC6、FC7、FC8分別進(jìn)行了1×1的卷積,卷積化后的核尺寸(通道數(shù)、寬、高)分別變?yōu)?4096,1,1)、(4096,1,1)和(類(lèi)別數(shù)N,1,1)。

在卷積神經(jīng)網(wǎng)絡(luò)中,卷積計(jì)算需要矩陣化[13],若卷積參數(shù)輸入為4×4圖像,輸出為2×2圖像,卷積核尺寸為3×3,邊界填充補(bǔ)零為0,步長(zhǎng)為1。則矩陣乘就是將輸入展開(kāi)為16維向量x,輸出展開(kāi)為4維向量y,則卷積計(jì)算公式如下

y=Cx

(1)

變換后的稀疏陣C由卷積核C′變換而來(lái),C和C′的表達(dá)式如下

通過(guò)式(1)即可以進(jìn)行卷積計(jì)算。

1.2 上采樣(反卷積)

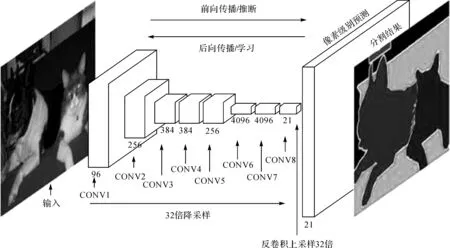

由于卷積化后輸出的為低分辨率的圖像,前五卷積層降采樣下降32倍,為了解決低分辨率的問(wèn)題,將低分辨率圖像進(jìn)行上采樣,輸出同分辨率的分割圖像。上采樣的方法選用雙線(xiàn)性插值反卷積[14]計(jì)算。圖2為上采樣示意圖。

圖2 上采樣示意圖

與卷積化一樣,反卷積操作也需要矩陣化,若卷積參數(shù)輸入為2×2圖像,輸出為4×4圖像,卷積核尺寸為3×3,邊界填充補(bǔ)零為2,步長(zhǎng)為1,則矩陣乘就是輸出展開(kāi)為4維的向量y,輸入展開(kāi)為16維的向量x,反卷積計(jì)算公式如下

x=CTy

(2)

1.3 跳層結(jié)構(gòu)

由于從32倍下采樣的圖像直接上采樣插值到原始圖像大小,信息量損失較大,結(jié)果較粗糙,只能表示出對(duì)象的大致形狀。為了解決這個(gè)問(wèn)題,本文提出跳層結(jié)構(gòu),以精化分割提取的圖像。

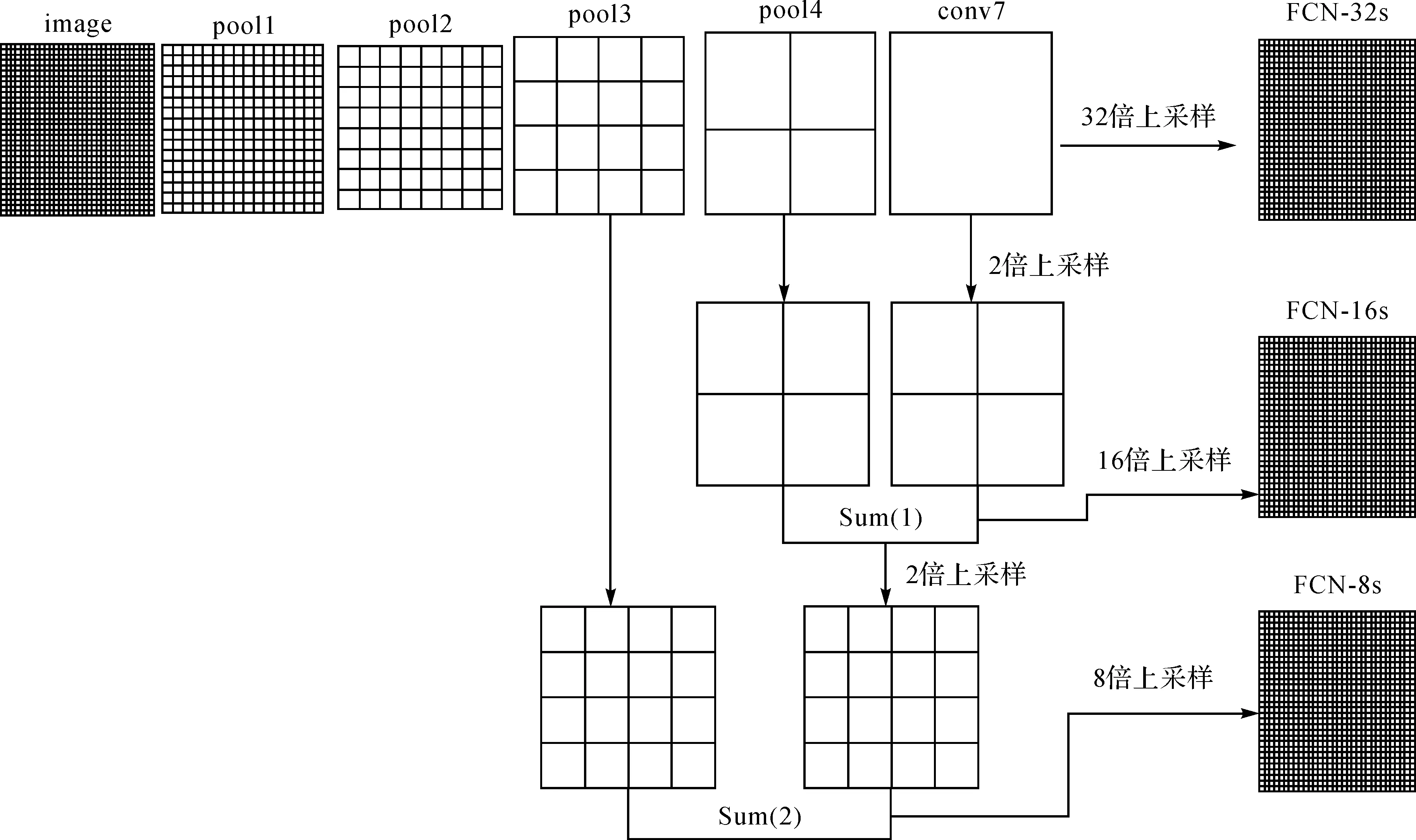

3種模型的構(gòu)建如圖3所示。第1種模型是FCN-32s,是在第7卷積層(CONV7)后直接采用上采樣32倍的結(jié)果;第2種模型是FCN-16s,是在第4池化層(pool4)后增一個(gè)1×1的卷積層,同時(shí)把第7層上采樣2倍,再將二者融合。融合方法是直接進(jìn)行矩陣對(duì)應(yīng)位置相加,然后對(duì)融合的結(jié)果Sum(1)進(jìn)行16倍的上采樣,獲得FCN-16模型;第3種模型是FCN-8s,是在第3池化層(pool3)后增加一個(gè)1×1的卷積層,同時(shí)對(duì)Sum(1)進(jìn)行2倍上采樣,二者再進(jìn)行融合得到Sum(2),對(duì)Sum(2)再進(jìn)行8倍上采樣獲得FCN-8s模型。

2 全卷積神經(jīng)網(wǎng)絡(luò)的模型構(gòu)建和試驗(yàn)數(shù)據(jù)

本文選用VGG16為基本網(wǎng)絡(luò)模型來(lái)構(gòu)建FCN模型,使用VGG16作為初始網(wǎng)絡(luò),保留參數(shù);舍棄最后的2個(gè)全連接層換為全卷積層,同時(shí)追加一個(gè)預(yù)測(cè)卷積層,按照跳層結(jié)構(gòu)的原理,分別構(gòu)建出FCN-32s網(wǎng)絡(luò)模型、FCN-16s網(wǎng)絡(luò)模型和FCN-8s網(wǎng)絡(luò)模型。

本文的試驗(yàn)數(shù)據(jù)包括訓(xùn)練數(shù)據(jù)和測(cè)試數(shù)據(jù)。訓(xùn)練數(shù)據(jù)是從遙感影像中裁剪出帶有水體的187幅約為500×500像素大小的影像,分辨率約為4 m,為了增加樣本量,進(jìn)行90°、180°、270°旋轉(zhuǎn),總共獲取748幅影像;同時(shí)對(duì)這748幅影像的水體進(jìn)行標(biāo)注,除水體外其他標(biāo)注為背景,共兩類(lèi)目標(biāo),作為標(biāo)簽數(shù)據(jù);然后對(duì)748幅影像數(shù)據(jù)和標(biāo)簽數(shù)據(jù)的70%作為訓(xùn)練集,30%作為驗(yàn)證集,引入VGG16構(gòu)建的FCN-32s、FCN-16s和FCN-8s網(wǎng)絡(luò)模型,進(jìn)行推理和學(xué)習(xí),通過(guò)參數(shù)微調(diào),獲取3種先驗(yàn)?zāi)P停螖?shù)均為50 000次。

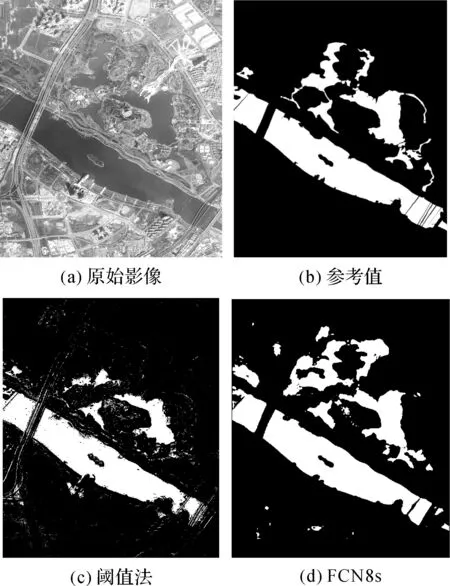

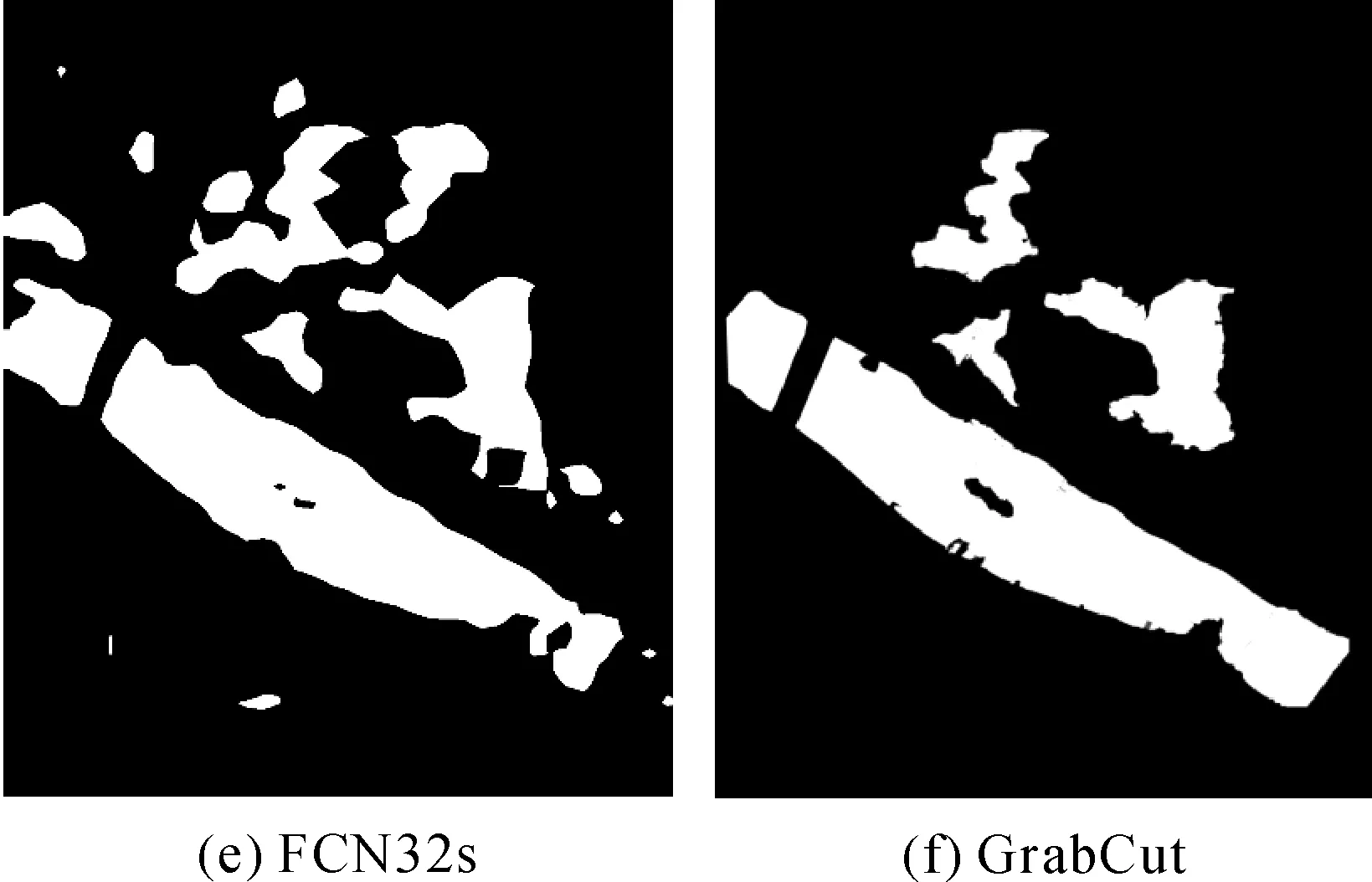

測(cè)試數(shù)據(jù)是在遙感地圖上裁剪的2幅圖像,這兩幅圖像與訓(xùn)練數(shù)據(jù)來(lái)自不同區(qū)域。一幅背景較簡(jiǎn)單,水體形狀比較規(guī)則;另外一幅背景比較復(fù)雜,水體形狀不規(guī)則,如圖4(a)所示。

圖3 FCN 3種模型的構(gòu)建

3 試驗(yàn)結(jié)果及分析

全卷積神經(jīng)網(wǎng)絡(luò)由前文直接獲取的3種先驗(yàn)?zāi)P瓦M(jìn)行測(cè)試;閾值法的閾值通過(guò)隨機(jī)在水體區(qū)域選取分布均勻的15個(gè)點(diǎn),確定出閾值的范圍進(jìn)行水體提取;Grabcut[15]通過(guò)人機(jī)交互界面粗略地畫(huà)出前景和背景線(xiàn),來(lái)自動(dòng)構(gòu)建高斯混合模型,進(jìn)行水體提取。幾種方法提取結(jié)果如圖4所示。

圖4 幾種方法試驗(yàn)結(jié)果

圖4所列為試驗(yàn)結(jié)果,其中圖4(a)為原始影像,圖4(b)為人工判讀的結(jié)果,作為理想的水體區(qū)域參考值,圖4(c)為閾值法結(jié)果,雖然能提取出水體,速度比較快,方法簡(jiǎn)單,但是噪聲比較多,邊緣也不是特別明顯。另外不同的影像閾值是不固定的,每幅影像要重新選擇閾值,通用性差。圖4(d)和(e)均為全卷積神經(jīng)網(wǎng)絡(luò)提取水體,選擇FCN8s和FCN32s兩種模型的測(cè)試結(jié)果,可以看出FCN8s提取的邊界更清晰,提取得更精細(xì)一些,而FCN32s提取結(jié)果雖然位置正確,但是比較粗略。圖4(f)為GrabCut提取結(jié)果,GrabCut對(duì)背景簡(jiǎn)單的提取效果比對(duì)背景復(fù)雜的要好,但是在提取時(shí)需要人工交互選取前景和背景,工作量大,泛化能力較差,精度也不是很高,漏掉的比較多,對(duì)于水體提取,該方法還需要改進(jìn)。因此,全卷積神經(jīng)網(wǎng)絡(luò)尤其是FCN8s模型提取水體自動(dòng)化程度高,效果較好。

4 結(jié)論與展望

本文提出了一種全卷積神經(jīng)網(wǎng)絡(luò)模型用于水體目標(biāo)提取的方法,通過(guò)3種模型FCN32s、FCN16s和FCN8s,對(duì)遙感影像上的水體目標(biāo)進(jìn)行分割提取試驗(yàn),通過(guò)與傳統(tǒng)的閾值法和基于圖論的GrabCut算法提取水體對(duì)比,全卷積神經(jīng)網(wǎng)絡(luò)的FCN8s模型提取結(jié)果穩(wěn)健性較強(qiáng),泛化能力較好。

隨著人工智能和大數(shù)據(jù)的崛起,若能利用遙感影像的高光譜數(shù)據(jù)的特征,并增加基礎(chǔ)地理信息的面狀和線(xiàn)狀地圖信息,構(gòu)成大數(shù)據(jù)進(jìn)行訓(xùn)練,筆者相信深度卷積神經(jīng)網(wǎng)絡(luò)將在測(cè)繪遙感領(lǐng)域發(fā)揮出更大的優(yōu)勢(shì)。

參考文獻(xiàn):

[1] 畢海蕓,王思遠(yuǎn),曾江源,等.基于TM影像的幾種常用水體提取方法的比較和分析[J].遙感信息,2012,27(5):77-82.

[2] 李小濤,黃詩(shī)峰,郭懷軒.基于紋理特征的SPOT5影像水體體取方法研究[J].人民黃河,2010,32(12):5-6.

[3] 殷亞秋,李家國(guó),余濤,等.基于高分辨率遙感影像的面向?qū)ο笏w提取方法研究[J].測(cè)繪通報(bào),2015(1):81-85.

[4] 吳岸城.神經(jīng)網(wǎng)絡(luò)與深度學(xué)習(xí)[M].北京:電子工業(yè)出版社,2016.

[5] KRIZHEVSKY A,SUTSKEVER I,HINTON G E.ImageNet Classification with Deep Convolutional Neural Networks[C]∥International Conference on Neural Information Processing Systems.Nevada:Curran Associates Inc,2012:1097-1105.

[6] SIMONYAN K,ZISSERMAN A.Very Deep Convolutional Networks for Large-scale Image Recognition[J].Computer Science,2014(9):1409-1456.

[7] SZEGEDY C,LIU W,JIA Y,et al.Going Deeper with Convolutions[C]∥IEEE Conference on Computer Vision and Pattern Recognition.Santiago:IEEE Computer Society,2015:1-9.

[8] GIRSHICK R,DONAHUE J,DARREL T,et al.Rich Feature Hierarchies for Accurate Object Detection and Semantic Segmentation[J].Computer Science,2013(6):580-587.

[9] GIRSHICK R.Fast R-CNN[C]∥International Conference on Computer Vision.Santiago:IEEE,2015:1440-1448.

[10] REN S,HE K,GIRSHICK R,et al.Faster R-CNN:Towards Real-time Object Detection with Region Proposal Networks[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2017,39(6):1137-1149.

[11] HE K,ZHANG X,REN S,et al.Spatial Pyramid Pooling in Deep Convolutional Networks for Visual Recognition[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2015,37(9):1904-1916.

[12] LONG J,SHELHAMER E,DARREL T.Fully Convolutional Networks for Semantic Segmentation[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2017,39(4):640-651.

[13] DUMOULIN V,VISIN F.A Guide to Convolution Arithmetic for Deep Learning[J].Stat,2016,1050:23.

[14] ZEILER M D,F(xiàn)ERGUS R.Visualizing and Understanding Convolutional Networks[C]∥European Conference on Computer Vision.Zurich :Springer, 2014:818-833.

[15] ROTHER C,KOLMOGOROV V,BLAKE A.“GrabCut”:Interactive Foreground Extraction Using Iterated Graph Cuts[J].IEEE Transactions on Graphics,2004,23(3):309-314.

[16] GARCIAGARCIA A,ORTSESCOLANO S,OPREA S,et al.A Review on Deep Learning Techniques Applied to Semantic Segmentation[J].Computer Science,2017(4):1704.