基于三維殘差稠密網絡的人體行為識別算法

郭明祥 宋全軍 徐湛楠 董俊 謝成軍

摘 要:針對現有的人體行為識別算法不能充分利用網絡多層次時空信息的問題,提出了一種基于三維殘差稠密網絡的人體行為識別算法。首先,所提算法使用三維殘差稠密塊作為網絡的基礎模塊,模塊通過稠密連接的卷積層提取人體行為的層級特征;其次,經過局部特征聚合自適應方法來學習人體行為的局部稠密特征;然后,應用殘差連接模塊來促進特征信息流動以及減輕訓練的難度;最后,通過級聯多個三維殘差稠密塊實現網絡多層局部特征提取,并使用全局特征聚合自適應方法學習所有網絡層的特征用以實現人體行為識別。設計的網絡算法在結構上增強了對網絡多層次時空特征的提取,充分利用局部和全局特征聚合學習到更具辨識力的特征,增強了模型的表達能力。在基準數據集KTH和UCF-101上的大量實驗結果表明,所提算法的識別率(top-1精度)分別達到了93.52%和57.35%,與三維卷積神經網絡(C3D)算法相比分別提升了3.93和13.91個百分點。所提算法框架有較好的魯棒性和遷移學習能力,能夠有效地處理多種視頻行為識別任務。

關鍵詞:人體行為識別;視頻分類;三維殘差稠密網絡;深度學習;特征聚合

中圖分類號: TP391.41(圖形圖像識別)文獻標志碼:A

Human behavior recognition algorithm based on three-dimensional residual dense network

GUO Mingxiang1,2, SONG Quanjun 1*, XU Zhannan1, DONG Jun 1, XIE Chengjun1

(1. Institute of Intelligent Machines, Chinese Academy of Sciences, Hefei Anhui 230031, China;

2. University of Science and Technology of China, Hefei Anhui 230026, China)

Abstract: Concerning the problem that the existing algorithm for human behavior recognition cannot fully utilize the multi-level spatio-temporal information of network, a human behavior recognition algorithm based on three-dimensional residual dense network was proposed. Firstly, the proposed network adopted the three-dimensional residual dense blocks as the building blocks, these blocks extracted the hierarchical features of human behavior through the densely-connected convolutional layer. Secondly, the local dense features of human behavior were learned by the local feature aggregation adaptive method. Thirdly, residual connection module was adopted to facilitate the flow of feature information and mitigate the difficulty of training. Finally, after realizing the multi-level local feature extraction by concatenating multiple three-dimensional residual dense blocks, the aggregation adaptive method for global feature was proposed to learn the features of all network layers for realizing human behavior recognition. In conclusion, the proposed algorithm has improved the extraction of network multi-level spatio-temporal features and the features with high discrimination are learned by local and global feature aggregation, which enhances the expression ability of model. The experimental results on benchmark datasets KTH and UCF-101 show that, the recognition rate (top-1 recognition accuracy) of the proposed algorithm can achieve 93.52% and 57.35% respectively, which outperforms that of Three-Dimensional Convolutional neural network (C3D) algorithm by 3.93 percentage points and 13.91 percentage points respectively. The proposed algorithm framework has excellent robustness and migration learning ability, and can effectively handle multiple video behavior recognition tasks.

Key words: human behavior recognition; video classification; three-dimensional residual dense network; deep learning; feature aggregation

0 引言

視頻理解是計算機視覺領域極具挑戰性的一項任務,視頻中的人體行為識別是其中重要的分支,隨著研究的深入,目前已經取得了很大的進展。根據視頻序列提取特征的方式不同,文獻[1-3]提出行為識別方法可以分為兩類:基于手工構造特征的方法和基于自動學習特征的方法。早期的人體行為識別算法中,通常采用手工構造的特征描述視頻中的局部時空變化,如尺度不變特征變換(Scale-Invariant Feature Transform, SIFT)[4]、方向梯度直方圖(Histogram of Oriented Gradients, HOG)/HOF(Histogram of Oriented Optical Flow)[5]、運動邊界直方圖(Motion Boundary Histogram, MBH)[6]、輪廓[7-8]、動作屬性[9]和密集軌跡特征[10-11]等。在眾多的手工構造的特征描述符中,由法國國家信息與自動化研究所(Institut National de Recherche en Informatique et en Automatique, INRIA)[10-11]提出的基于改進的密集軌跡特征(Improved Dense Trajectories, IDT),它通過Fisher Vector特征編碼方式在動作識別中表現出優越的性能。手工構造的特征通常仿照人類視覺特點及其他先驗知識來設計特征本身,它主要針對某一特定任務設計,往往無法適應所有場景,且計算復雜。隨著深度學習算法的興起,基于自動學習特征的方式逐步取代了傳統精心設計特征的過程,同時模型自主學習適用于當前任務的特征,網絡能夠端到端地訓練,都使得模型的計算更具效率。在眾多的深度學習網絡結構中,卷積神經網絡(Convolutional Neural Network, CNN)的運用最為廣泛。

CNN在靜態圖像領域獲得了很大的成功[12-16]。它在研究視頻處理方面也具有很大的優勢。為了在深度卷積模型中同時對空間和時間信息進行編碼,Ji等[17]對2D卷積網絡進行了簡單而有效的擴展,提出了三維卷積神經網絡模型,用于學習動態連續的視頻序列,深入學習時空特征。Tran等[18]經過系統研究找到了三維卷積神經網絡的最佳卷積核大小,并提出了適用于大規模數據集的三維卷積神經網絡(Three-Dimensional Convolutional neural network, C3D),并利用C3D提取視頻時空特征,提取到的特征具有很強的通用性,且計算高效。此外,Tran等[19]在深度殘差網絡框架中進行了三維卷積神經網絡改進,提出了Res3D網絡,改進網絡在運算速度、識別精度等方面都優于C3D。Hara等[20]提出Kinetics數據集具有足夠的數據訓練深的三維卷積網絡,并且經過Kinetics數據集預訓練的簡單三維體系結構優于復雜的二維體系結構。Tran等[21]又將三維卷積網絡中的三維卷積運算都分解成兩個獨立的連續運算——二維空間卷積和一維時間卷積,提出了R(2+1)D網絡,該網絡與C3D相比有效地增加了模型的容量,同時有利于網絡的優化。三維卷積網絡由于其簡單有效的策略受到了廣泛的關注和應用,但網絡也存在一些缺陷,比如:由于其巨大的網絡參數而導致網絡收斂非常困難,Chen等[22]提出了一種輕量級的多纖維網絡架構,顯著地降低3D網絡的計算復雜度,同時提高了模型的識別性能。Yang等[23]提出了非對稱三維卷積神經網絡模型,除降低參數量和計算成本外,引入了多源增強輸入和多尺度 3D卷積分支來處理視頻中不同尺度的卷積特征,通過融合RGB和光流幀的有效信息顯著提高模型的表達能力。此外,三維卷積網絡在時空特征建模方面與最先進的基線方法有一定差距。Diba等[24]在ResNext等基礎架構中引入了時空通道相關塊(Spatio-Temporal Channel correlation block, STC) 作為其新的殘差模塊,能夠有效地捕獲整個網絡層中的時空信道相關性信息。Hussein等[25]側重關注行為識別中的時間線索,為了對長時程范圍內的復雜動作建模,提出了Timeception卷積層改進的3D卷積網絡,它使用了多尺度時間卷積,通過關注短時程細節來學習長時程依賴性。

為了補充對視頻時間維度信息的建模,文獻[26-27]采用兩個CNN分別對原始單幀RGB圖像和視頻幀的光流圖像進行特征學習,最后對輸出進行信息融合,設計了學習時空特征的雙流網絡架構。Wang等[28]結合了稀疏時間采樣策略和視頻片段融合,引入時間片段網絡(Temporal Segment Network, TSN)來提高對視頻的長程時間結構建模能力。還有一系列研究集中在利用時間和空間網絡之間的相關性來提高識別性能,例如:Feichtenhofer等[29]提出使用殘差連接來進行雙流網絡之間的時空交互;Feichtenhofer等[30]又在模型中引入fusion 信息,具體分析了網絡不同融合特征對識別結果的影響;Carreira等[31]將雙流網絡的卷積和池化內核都擴展為三維形式,提出了一種雙流I3D(Inflated 3D ConvNet)模型,通過大型數據集Kinetics上進行預訓練,它取得了多個數據集上的最先進結果(在UCF-101的識別率為97.9%,在HMDB-51的識別率為80.7%)。

雙流網絡及其衍生的模型形成了強大的基線,但由于其稠密采樣策略和光流場的計算復雜且耗時,限制了其在現實世界中的應用。Ma 等[32]提出的循環神經網絡——長短期記憶(Long Short-Term Memory, LSTM)網絡對視頻長時序結構建模是另一種主流的方法。Donahue等[33]提出了卷積層和長時序遞歸結合的長時序遞歸神經網絡,可用來學習可變長度輸入,并模擬復雜的動態時序。Ng等[34]提出通過在每幀卷積特征上連接多個堆疊LSTM來計算全局視頻級特征。Wu等[35]研究表明通過LSTM進行多流長時序建模可以提高行為識別的性能。Carreira等[31]提出LSTM網絡能夠對視頻長時段以及高層運動變化進行建模,但卻不能捕捉重要的精細底層運動,并且網絡訓練也較為耗時。

1.2 三維殘差稠密網絡

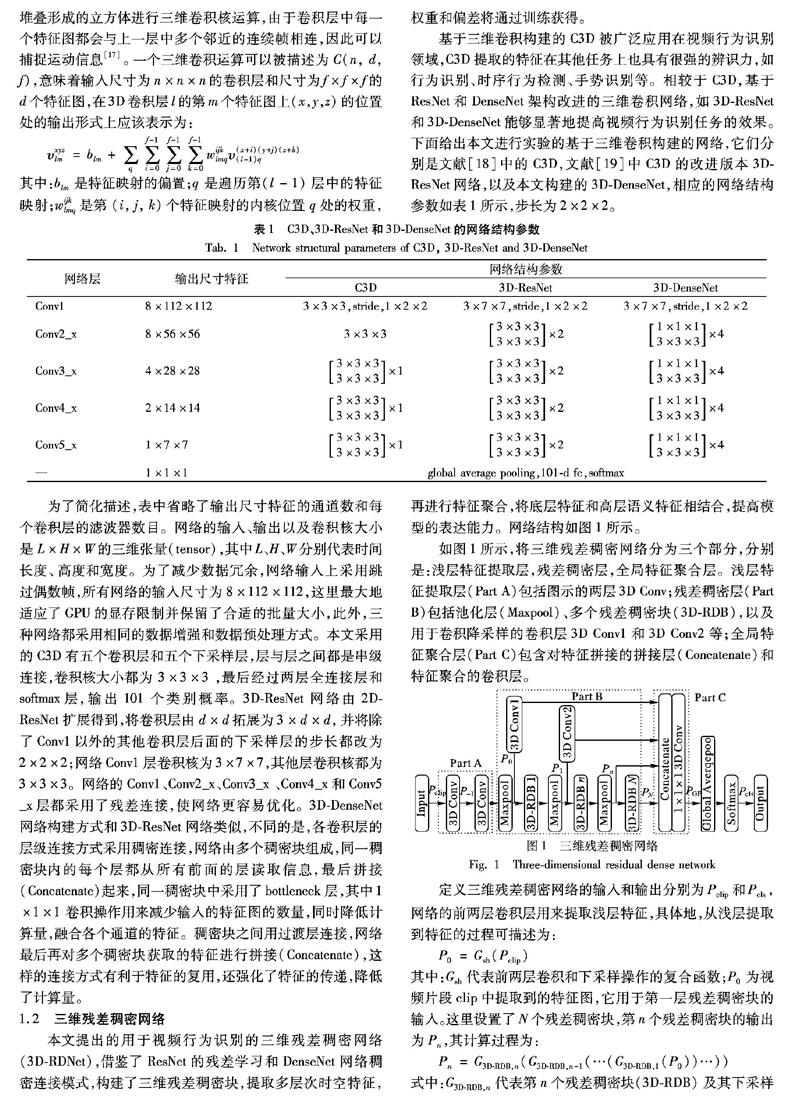

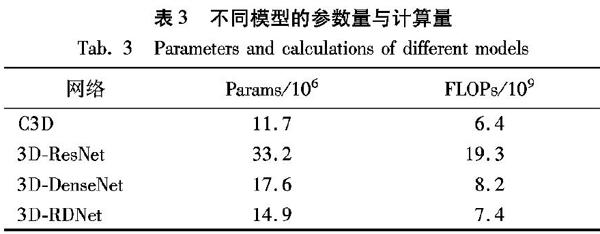

本文提出的用于視頻行為識別的三維殘差稠密網絡(3D-RDNet),借鑒了ResNet的殘差學習和DenseNet網絡稠密連接模式,構建了三維殘差稠密塊,提取多層次時空特征,再進行特征聚合,將底層特征和高層語義特征相結合,提高模型的表達能力。網絡結構如圖1所示。

如圖1所示,將三維殘差稠密網絡分為三個部分,分別是:淺層特征提取層,殘差稠密層,全局特征聚合層。淺層特征提取層(Part A)包括圖示的兩層3D Conv;殘差稠密層(Part B)包括池化層(Maxpool)、多個殘差稠密塊(3D-RDB),以及用于卷積降采樣的卷積層3D Conv1和3D Conv2等;全局特征聚合層(Part C)包含對特征拼接的拼接層(Concatenate)和特征聚合的卷積層。

定義三維殘差稠密網絡的輸入和輸出分別為Pclip和Pcls,網絡的前兩層卷積層用來提取淺層特征,具體地,從淺層提取到特征的過程可描述為:

P0=Gsh(Pclip)

其中:Gsh代表前兩層卷積和下采樣操作的復合函數;P0為視頻片段clip中提取到的特征圖,它用于第一層殘差稠密塊的輸入。這里設置了N個殘差稠密塊,第n個殘差稠密塊的輸出為Pn,其計算過程為:

Pn=G3D-RDB,n(G3D-RDB,n-1(…(G3D-RDB,1(P0))…))

式中:G3D-RDB,n代表第n個殘差稠密塊(3D-RDB)及其下采樣(Maxpool)的計算操作,而當n=N時,G3D-RDB,N只包含殘差稠密塊的計算操作。G3D-RDB,n是復合運算函數,包括了多層卷積和整流線性單位。由于Pn是由第n個殘差稠密塊內的多個卷積層運算產生的,可以將Pn視為局部稠密特征。

3D-RDNet通過多個3D-RDB提取到多層次局部稠密特征之后,進一步進行全局特征聚合(Global Feature Aggregation, GFA),GFA充分利用了前面所有層的特征。具體地,將輸入的不同層次的特征Pn都卷積采樣為1×7×7特征圖Xn,并進行l2范數歸一化,然后用拼接層(Concatenate)對來自不同層次的局部稠密特征Xn進行拼接,再用1×1×1的卷積進行特征聚合和通道調整,得到全局特征聚合的特征圖。其中對局部稠密特征拼接的過程可描述為:

PGFA=GGFA([X0,X1,…,XN])

其中:PGFA是經過全局特征聚合輸出的特征圖;GGFA是1×1×1卷積的復合函數,它用于自適應地融合來自不同層的特征;[X0,X1,…,XN]是指N個經過三維殘差稠密塊和卷積采樣后的特征圖的拼接。

綜合上述操作,網絡從輸入clip中提取到淺層特征,然后經過多個殘差稠密塊得到豐富的局部特征,再經過全局特征聚合得到全局特征,最后通過softmax分類器得到各個種類的分數。整個網絡3D-RDNet計算過程可表示為:

Pcls=GRDNet(Pclip)

其中:GRDNet為3D-RDNet整個網絡的運算操作;Pcls為網絡的輸出。

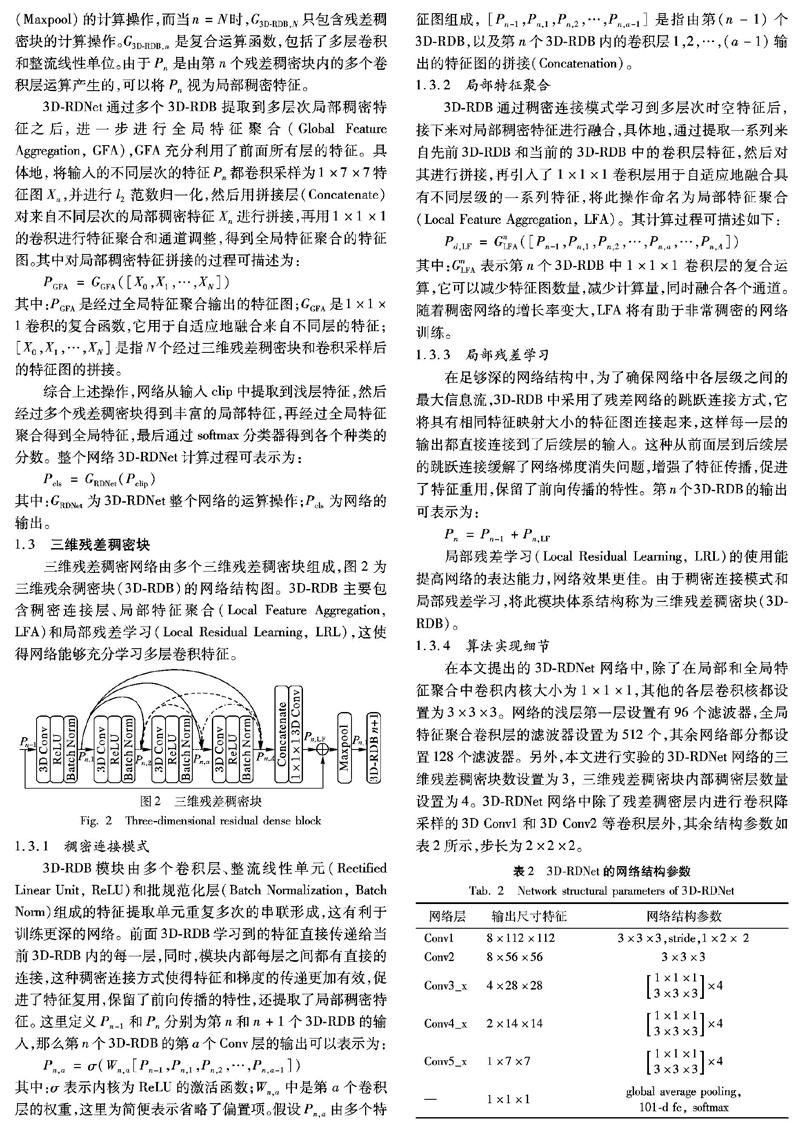

1.3 三維殘差稠密塊

三維殘差稠密網絡由多個三維殘差稠密塊組成,圖2為三維殘余稠密塊(3D-RDB)的網絡結構圖。3D-RDB主要包含稠密連接層、局部特征聚合(Local Feature Aggregation, LFA)和局部殘差學習(Local Residual Learning, LRL),這使得網絡能夠充分學習多層卷積特征。

1.3.1 稠密連接模式

3D-RDB模塊由多個卷積層、整流線性單元(Rectified Linear Unit, ReLU)和批規范化層(Batch Normalization, Batch Norm)組成的特征提取單元重復多次的串聯形成,這有利于訓練更深的網絡。前面3D-RDB學習到的特征直接傳遞給當前3D-RDB內的每一層,同時,模塊內部每層之間都有直接的連接,這種稠密連接方式使得特征和梯度的傳遞更加有效,促進了特征復用,保留了前向傳播的特性,還提取了局部稠密特征。這里定義Pn-1和Pn分別為第n和n+1個3D-RDB的輸入,那么第n個3D-RDB的第a個Conv層的輸出可以表示為:

Pn,a=σ(Wn,a[Pn-1,Pn,1,Pn,2,…,Pn,a-1])

其中:σ表示內核為ReLU的激活函數;Wn,a中是第a個卷積層的權重,這里為簡便表示省略了偏置項。假設Pn,a由多個特征圖組成, [Pn-1,Pn,1,Pn,2,…,Pn,a-1]是指由第(n-1)個3D-RDB,以及第n個3D-RDB內的卷積層1,2,…,(a-1)輸出的特征圖的拼接(Concatenation)。

1.3.2 局部特征聚合

3D-RDB通過稠密連接模式學習到多層次時空特征后,接下來對局部稠密特征進行融合,具體地,通過提取一系列來自先前3D-RDB和當前的3D-RDB中的卷積層特征,然后對其進行拼接,再引入了1×1×1卷積層用于自適應地融合具有不同層級的一系列特征,將此操作命名為局部特征聚合(Local Feature Aggregation, LFA)。其計算過程可描述如下:

Pd,LF=GnLFA([Pn-1,Pn,1,Pn,2,…,Pn,a,…,Pn,A])

其中:GnLFA表示第n個3D-RDB中1×1×1 卷積層的復合運算,它可以減少特征圖數量,減少計算量,同時融合各個通道。隨著稠密網絡的增長率變大,LFA將有助于非常稠密的網絡訓練。

1.3.3 局部殘差學習

在足夠深的網絡結構中,為了確保網絡中各層級之間的最大信息流,3D-RDB中采用了殘差網絡的跳躍連接方式,它將具有相同特征映射大小的特征圖連接起來,這樣每一層的輸出都直接連接到了后續層的輸入。這種從前面層到后續層的跳躍連接緩解了網絡梯度消失問題,增強了特征傳播,促進了特征重用,保留了前向傳播的特性。第n個3D-RDB的輸出可表示為:

從表4中可以看出:在KTH數據集上的準確率,三維卷積網絡相較其他算法有較大的優勢;同時三維卷積的改進網絡3D-ResNet和3D-DenseNet都較C3D取得了更好的結果,準確率分別比C3D提高了1.61個百分點和2.08個百分點;而且本文提出的三維殘差稠密網絡相較C3D高出了3.93個百分點。

將在KTH訓練集上訓練好的模型對整個數據集進行測試,可得到如圖6所示的混淆矩陣,其中,圖片右側的顏色刻度代表的含義為顏色越深(越接近1.0)行為分類精度越高。從混淆矩陣可以看出,3D-RDNet網絡在KTH數據集上的整體識別率很高,但模型對奔跑、慢跑以及散步等行為的辨別不是很好,一方面是因為這些動作相似度較高,另一方面還有視頻本身的分辨率較低,容易造成誤判。總體來說,3D-RDNet網絡對KTH數據集有較好的識別效果,在KTH訓練集上訓練好的模型對整個數據集進行測試,得到了97.2%的識別率。

2.4 UCF-101和真實場景數據集實驗

本文還對UCF-101數據集和建立的真實場景數據集進行了測試,兩個數據集在實驗過程中的設置基本相同。實驗從頭開始訓練,網絡的輸入為從每段視頻中提取的連續16幀視頻片段clip,將視頻幀寬和高resize為171×128,經過數據預處理,將輸入尺寸裁剪為8×112×112。在網絡優化方面,采用帶動量的隨機梯度下降法,網絡初始學習率設置為0.01,動量參數為0.9,學習率衰減率為10-4,目標函數為交叉熵損失函數,網絡訓練周期為25,批量處理大小設置為16。

4種網絡C3D、3D-ResNet、3D-DenseNet和3D-RDNet等人體行為識別算法在UCF-101和真實場景數據集的實驗結果如表5所示。其中,準確率都是基于視頻連續16幀片段clip計算的,即Clip top-1。

從表5中可以看出:1)在UCF-101數據集上,本文模型(3D-RDNet)網絡相較3D-ResNet和3D-DenseNet的人體行為識別率分別提高了11.87個百分點和10.52個百分點,同時較C3D提高了13.91個百分點,表明在復雜數據集上結合了稠密連接和殘差學習思想的3D-RDNet網絡依然比單一網絡結構更優異,并且在識別準確率上遠優于它們,驗證了本文設計網絡的有效性和優越性能。2)在真實場景數據集上,本文模型的識別效果也優于其他網絡,取得了94.66%的識別率。綜上表明3D-RDNet網絡依然能夠勝任真實場景下的任務,網絡具有較好的魯棒性和遷移學習能力。

3 結語

針對傳統的3D卷積神經網絡算法缺乏對網絡多層次卷積特征充分利用的問題,本文提出了一種基于視頻的人體行為識別的三維殘差稠密網絡架構,并在公共數據集和真實場景數據集上驗證了算法的有效性。本文的主要工作在于:1)改進了三維卷積神經網絡,提出了三維殘差稠密網絡,在保證網絡準確率的同時降低了模型的復雜度;2)提出了一種網絡構建模塊——三維殘差稠密塊,通過稠密連接模式、局部特征聚合和局部殘差學習強化了網絡充分學習多層卷積特征的能力,降低了原有視頻信息在網絡訓練過程中丟失的風險;3)所提算法使用多個三維殘差稠密塊提取多層次時空特征,再經過全局特征聚合,將底層特征和高層語義特征相結合,提高了模型的表達能力。此外,文中采用的預處理和數據增強方法也可顯著地防止網絡訓練過程中的過擬合現象,通過在公共數據集和真實場景數據集進行實驗,驗證了所提算法優于多數傳統算法以及三維卷積同類型的方法,顯著地提高了視頻行為識別任務的準確率。

本文的研究也存在一定的不足,所提算法在模型的輸入方面依然采用傳統的視頻短時程時序信息,即每次輸入是一個連續16幀的視頻clip,這樣帶來的問題是網絡只能處理短期(short-term)運動,同時訓練有較大的計算開銷,在未來的研究工作中可以引入文獻[28]所提TSN中采用的稀疏時間采樣方法來學習視頻長時程的時序結構,增加網絡對長期(long-range)運動的時間結構理解。由于計算資源有限,本文針對UCF-101和KTH等數據集的實驗都是從頭開始訓練,為了得到更好的識別效果,可以讓模型在Kinetics和Sports-1M等行為識別大型數據集上進行預訓練,然后進行遷移學習到其他的數據集上。同時,網絡的基礎架構也很重要,為了得到更強識別效果的模型,一種思路是可以借鑒文獻[31]所提的I3D網絡思想,即在經典的雙流網絡中引入3D-ResNet網絡架構,將有助于有效地提高模型的識別率。另外,還可以探索三維卷積神經網絡與長短時記憶網絡的融合架構,從而將顯著的時間信息加入到網絡中,進一步提升模型的表達能力。最后,將傳統的特征描述符與深度學習方法相結合也是一種有效提高模型識別率的途徑。

參考文獻 (References)

[1]ZHU F, SHA L, XIE J, et al. From handcrafted to learned representations for human action recognition: a survey [J]. Image and Vision Computing, 2016, 55: 42-52.

[2]GUANGLE Y, TAO L, JIANDAN Z. A review of convolutional-neural-network-based action recognition [J]. Pattern Recognition Letters, 2019, 118: 14-22.

[3]李瑞峰,王亮亮,王珂.人體動作行為識別研究綜述[J].模式識別與人工智能,2014,27(1):35-48.(LI R F, WANG L L, WANG K. A survey of human body action recognition [J]. Pattern Recognition and Artificial Intelligence, 2014, 27(1): 35-48.

[17]JI S, XU W, YANG M, et al. 3D convolutional neural networks for human action recognition [J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2013, 35(1): 221-231.

[18]TRAN D, BOURDEV L, FERGUS R, et al. Learning spatiotemporal features with 3D convolutional networks [C]// Proceedings of the 2015 IEEE International Conference on Computer Vision. Piscataway: IEEE, 2015: 4489-4497.

[19]TRAN D, RAY J, SHOU Z, et al. ConvNet architecture search for spatiotemporal feature learning [J]. Computer Vision and Pattern Recognition, 2017, 17 (8): 65-77.https://arxiv.org/pdf/1708.05038.pdf.

[20]HARA K, KATAOKA H, SATOH Y. Can spatiotemporal 3D CNNs retrace the history of 2D CNNs and ImageNet? [C]// Proceedings of the 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2018: 6546-6555.

[21]TRAN D, WANG H, TORRESANI L, et al. A closer look at spatiotemporal convolutions for action recognition [C]// Proceedings of the 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2018: 6450-6459.

[22]CHEN Y, KALANTIDIS Y, LI J, et al. Multi-fiber networks for video recognition [C]// Proceedings of the 2018 European Conference on Computer Vision, LNCS 11205. Berlin: Springer, 2018: 364-380.

[23]YANG H, YUAN C, LI B, et al. Asymmetric 3D convolutional neural networks for action recognition [J]. Pattern Recognition, 2019, 85: 1-12.

[24]DIBA A, FAYYAZ M, SHARMA V, et al. Spatio-temporal channel correlation networks for action classification [C]// Proceedings of the 2018 European Conference on Computer Vision, LNCS 11208. Cham: Springer: 284-299.

[25]HUSSEIN N, GAVVES E, SMEULDERS A W M, et al. Timeception for complex action recognition [C]// Proceedings of the 2019 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2019: 254-263.https://arxiv.org/pdf/1812.01289v1.pdf.

[26]SIMONYAN K, ZISSERMAN A. Two-stream convolutional networks for action recognition in videos [C]// Proceedings of the 2014 International Conference on Neural Information Processing Systems. New York: Curran Associates Inc., 2014: 568-576.

[27]WANG L, XIONG Y, WANG Z, et al. Towards good practices for very deep two-stream convents [EB/OL]. [2019-03-31]. https://arxiv.org/pdf/1507.02159.pdf.

[28]WANG L, XIONG Y, WANG Z, et al. Temporal segment networks: towards good practices for deep action recognition [C]// Proceedings of the 2016 European Conference on Computer Vision, LNCS 9912. Cham: Springer, 2016: 20-36.

[29]FEICHTENHOFER C, PINZ A, WILDES R P. Spatiotemporal residual networks for video action recognition [C]// Proceedings of the 2016 International Conference on Neural Information Processing Systems. New York: Curran Associates Inc., 2016: 3468-3476.

[30]FEICHTENHOFER C, PINZ A, ZISSERMAN A. Convolutional two-stream network fusion for video action recognition [C]// Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2016: 1933-1941.

[31]CARREIRA J, ZISSERMAN A. Quo vadis, action recognition? A new model and the kinetics dataset [C]// Proceedings of the 2017 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2017: 4724-4733.

[32]MA S, SIGAL L, SCLAROFF S. Learning activity progression in LSTMs for activity detection and early detection [C]// Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2016: 1942-1950.

[33]DONAHUE J, HENDRICKS L A, GUADARRAMA S, et al. Long-term recurrent convolutional networks for visual recognition and description [C]// Proceedings of the 2015 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2015: 2625-2634.

[34]NG J Y H, HAUSKNECHT M, VIJAYANARASIMHAN S, et al. Beyond short snippets: deep networks for video classification [C]// Proceedings of the 2015 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2015: 4694-4702.

[35]WU Z, WANG X, JIANG Y, et al. Modeling spatial-temporal clues in a hybrid deep learning framework for video classification [C]// Proceedings of the 23rd ACM International Conference on Multimedia. New York: ACM, 2015: 461-470.

[36]SCHULDT C, LAPTEV I, CAPUTO B. Recognizing human actions: A local SVM approach [C]// Proceedings of the 17th International Conference on Pattern Recognition. Piscataway: IEEE, 2004: 32-36.

[37]DOLLAR P, RABAUD V, COTTRELL G, et al. Behavior recognition via sparse spatio-temporal features [C]// Proceedings of the 2005 IEEE International Workshop on Visual Surveillance and Performance Evaluation of Tracking and Surveillance. Piscataway: IEEE, 2005: 65-72.

[38]TAYLOR G W, FERGUS R, LECUN Y, et al. Convolutional learning of spatio-temporal features [C]// Proceedings of the 2010 European Conference on Computer Vision, LNCS 6316. Berlin: Springer, 2010: 140-153.

This work is partially supported by the National Key Research and Development Program of China (2017YFC0806504), the Science and Technology Strong Police Project of Anhui Province (201904d07020007).

GUO Mingxiang, born in 1995, M. S. candidate. His research interests include computer vision, intelligent robot.

SONG Quanjun, born in 1974, Ph. D., professor. His research interests include service robot, intelligent human computer interaction.

XU Zhannan, born in 1987, M. S., assistant research fellow. His research interests include robot intelligent control, human-computer interaction.

DONG Jun, born in 1973, Ph. D., associate research fellow. His research interests include computer vision, artificial intelligence.

XIE Chengjun, born in 1979, Ph. D., associate research fellow. His research interests include computer vision, pattern recognition, machine learning.

收稿日期:2019-06-21;修回日期:2019-09-14;錄用日期:2019-09-18。

基金項目:國家重點研發計劃項目(2017YFC0806504);安徽省科技強警項目(201904d07020007)。

作者簡介:郭明祥(1995—),男,四川達州人,碩士研究生,主要研究方向:計算機視覺、智能機器人; 宋全軍(1974—),男,安徽宿州人,教授,博士,主要研究方向:服務機器人、智能人機交互; 徐湛楠(1987—),男,河南南陽人,助理研究員,碩士,主要研究方向:機器人智能控制、人機交互; 董俊(1973—),男,安徽合肥人,副研究員,博士,CCF會員,主要研究方向:計算機視覺、人工智能; 謝成軍(1979—),男,安徽全椒人,副研究員,博士,主要研究方向:計算機視覺、模式識別、機器學習。

文章編號:1001-9081(2019)12-3482-08DOI:10.11772/j.issn.1001-9081.2019061056