CNN多位置穿戴式傳感器人體活動識別?

鄧詩卓,王波濤,楊傳貴,王國仁

1(東北大學 計算機科學與工程學院,遼寧 沈陽 110819)

2(北京理工大學 計算機學院,北京 100081)

近年來,隨著智能生活概念的普及和可穿戴終端設備技術的快速發展,大量的時序傳感器數據為普適計算、人工智能等領域帶來了新的研究熱點,因此,基于傳感器數據的人體活動識別(human activity recognition,簡稱HAR)[1,2]得到了廣泛關注.基于傳感器數據的HAR能夠有效地避免基于視頻數據動作識別[3,4]帶來的隱私泄露等問題[5],且計算復雜度比視頻數據低,使得基于傳感器的HAR研究更加具有現實意義.目前,HAR的研究應用包括健康監控[6-8]、智慧家庭[9-11]、工業環境[12]和運動員監測[13]等,例如:老人通過佩戴智能手環檢測是否有走路姿態異常;工人通過佩戴傳感器來記錄和規范操作動作.因此,準確地識別和記錄人體的活動姿態,能夠為人們提供更為精確的服務.面對多形態多位置的復雜傳感器數據,如何利用傳感器數據特點提取具有良好判別力的特征以提高基于傳感器數據的的HAR準確率,是具有研究價值和現實意義的研究問題.

基于傳感器數據的HAR特征提取方法包括傳統特征提取和深度學習特征表達兩種方法[1,2].傳統方法需人工對劃分的數據抽取統計學意義特征向量,包括時域特征[14-16]、頻域特征[17]以及其他特征向量[16,18].但是傳統方法所抽取的特征都是淺層的,深度學習技術可以直接從原始數據自動地抽取更復雜的深層的特征[19,20],無需人工干預;同時,深度學習可以有效地解決類內差異和類間相似的問題.卷積神經網絡(convolutional neural network,簡稱 CNN)是深度學習方法中研究較多的特征抽取方法[2,21].文獻[19]的理論分析和實踐證明了 HAR中基于傳感器的CNN可以更有效地抽取數據隱藏的特征.

本文基于多位置的傳感器數據特點,利用深度學習中卷積神經網絡技術,從原始數據中抽取有效的特征來提高 HAR識別準確率.現有的基于傳感器的 CNN抽取特征方法根據卷積核維度分為一維卷積核方法1DCNN[13,22-28]和二維卷積核方法 2DCNN[29-37].1DCNN即提取基于時間依賴的特征,在時間軸上面進行卷積.雖然通過一維卷積核可以抽取具有良好分辨能力的特征,但是一維卷積核忽略了原始數據的不同位置傳感器之間的空間依賴性.因此研究人員提出了基于傳感器數據的二維卷積核,綜合考慮了時間依賴性和空間依賴性.但是,這些 2D-CNN方法僅僅是樸素地將不同類別傳感器羅列拼接,或者利用一定算法構建傳感器動作圖片(activity image)作為二維卷積核的輸入,并沒有考慮不同位置三軸向傳感器(三軸加速度、三軸陀螺儀等)的相同軸向數據之間隱藏的空間依賴性.

針對以上不足,為了進一步利用不同位置的三軸傳感器之間的相同軸向多位置傳感器原始數據的空間依賴性,本文提出了新穎的 CNN二維卷積的輸入動作圖片構建方法,進而提出了卷積網絡結構.為了優化網絡結構,進一步提出了卷積層參數優化方法.本文的主要貢獻如下:

(1) 提出了基于多位置三軸向傳感器二維卷積核輸入動作圖片構建方法T-2D(triaxial 2 dimension).該方法對來自不同位置傳感器的原始數據按照不同軸向劃分,生成 3張動作圖片.每一軸向動作圖片構成二維卷積的輸入;在T-2D基礎之上,針對非三軸傳感器提出M-2D(mixed 2 dimension),構建非三軸傳感器數據一維卷積核輸入的動作圖片,以抽取時間依賴特征,共生成4張動作圖片;

(2) 提出了基于T-2D和M-2D多層卷積神經網絡模型T-2DCNN和M-2DCNN,將M-2D得到一維特征和T-2D得到的二維特征合并成高層次特征向量,實現了人體活動識別功能;為了減少卷積層訓練參數數量,對卷積網絡進行優化,進一步提出了基于參數共享的卷積網絡TS-2DCNN和MS-2DCNN;

(3) 在公開數據集上進行了對比實驗,驗證了基于本文所提出的特征抽取方法的 HAR模型識別效果,同時驗證了共享參數卷積網絡在參數數量減少的情況下,可依然保持其識別效果;從傳感器數量變化以及每個類別識別準確性的角度,分別驗證了本文所提出的兩種卷積輸入動作圖片構建方法的有效性和穩定性.

本文第1節介紹現有基于CNN的HAR中基于穿戴式傳感器的兩種典型特征抽取方法,并進行分析對比.第2節描述二維卷積核輸入動作圖片的兩種構建方法和基于本文方法的 HAR模型的卷積網絡結構及其優化網絡.第3節通過實驗和對比分析,證明本文提出的二維卷積輸入構建方法的良好性能.最后是總結與展望.

1 相關工作

卷積神經網絡已經廣泛并成功地應用于圖像識別[38,39]和語音識別[40],在無需知道專業領域知識(domain knowledge)的前提下,自動地抽取具有高分辨能力的特征.近年來,CNN在基于傳感器數據的人體活動識別方面也取得了一定進展.與圖像識別的原始數據不同,在HAR中的原始數據大多為時間序列數據、一維數據.在文獻[19]中,從局部依賴(local dependency)和尺度不變性(scale invariance)這兩個角度描述了在動作識別領域應用CNN的優勢.本文主要從卷積核維度以及對應的輸入構造方法對現有工作進行總結和分析.

1.1 HAR中一維卷積核1D-CNN應用

一維卷積核應用于一維時間序列數據,抽取具有時間依賴性的特征.盡管基于可穿戴設備傳感器類型多種多樣,包括加速度計、陀螺儀等,但是傳感器數據或者傳感器各通道數據都是一維時序數據,例如加速度計中每一個軸向的時序數據代表一個通道.圖1(a)描述了大部分一維卷積核的卷積方式,數據包含具備三軸屬性的傳感器數據,同時也有可能包含不具備三軸屬性的傳感器數據,例如心率等.輸入矩陣是由滑動窗口(sliding window)大小T和傳感器通道總數Chan_num構成的矩陣,一維卷積核方式在各通道數據上面進行卷積操作,因此在滑動窗口固定的情況下,能夠自動抽取動作特征.但在具體相關文獻中,傳感器的選擇以及 CNN 的結構略有不同.文獻[19]中,作為早期的CNN在HAR中的應用,將三軸加速度計的3個軸向數據看成3個通道,分別在各軸向數據上沿時間軸進行卷積和池化,最后合并成該窗口的特征向量,并提出了局部共享權重的CNN卷積方式.該文獻使用一對卷積層和池化層,因此抽取特征屬于淺層特征.文獻[22]同樣利用單一加速度計的三軸向原始數據作為卷積網絡的輸入,但是通過改變卷積核的大小來適應三軸加速度信號特點.類似地,文獻[13]提出了利用手腕傳感器采集的三軸加速度識別排球動作.文獻[23,24]利用加速度計三軸向數據和陀螺儀三軸向數據組成六通道,對輸入使用一維卷積核,多卷積層和池化層抽取深層特征提高了識別準確率.文獻[25]中除了使用了三軸加速計和多種傳感器數據,將 3個通道擴展成多通道,利用兩層一維卷積核和池化抽取特征.文獻[26]中提出了將 CNN和長短期記憶循環網絡(long short-term memory,簡稱 LSTM)結合的深度學習模型,利用多層CNN一維卷積核自動抽取特征,且沒有池化層,使用 LSTM 進行分類識別,在通用數據集上取得了良好的效果.文獻[27]采用一維卷積核抽取特征,結合VGG和LSTM組合模型.文獻[28]利用三軸加速度性質,將三軸加速度分看成深度為3的一維輸入,經過卷積之后生成180個特征映射,以此來捕捉數據之間的依賴性.

Fig.1 Architecture of convolutional neural network based on multiple channels圖1 基于多通道時序數據的卷積結構

綜上所述,一維卷積核的輸入通常為一維的原始信號數據.一維卷積核在抽取特征過程中能夠較好地挖掘一維信號的時間依賴性,但是往往忽略了不同類別傳感器或者是同一傳感器不同軸向數據之間的空間依賴性,影響人體動作的識別效果.

1.2 HAR中二維卷積核2D-CNN應用

針對一維卷積核 HAR的不足,絕大多數 2D-CNN對原始數據進行重新排列,形成類似圖片一樣的輸入矩陣,即動作圖片.在該矩陣上使用二維卷積核以及相應的池化操作,利用二維卷積核抽取時空依賴性,如圖1(b)所示,之后結合不同的學習模型.文獻[29]將原始數據多通道輸入看作一張圖片,第 1層使用二維卷積核,在整張圖片上進行卷積形成一維特征映射,再次進行卷積時,應用一維卷積核.文獻[30]利用不同位置的相同類型傳感器按三軸順序排序,并以零矩陣填充來分隔不同類型的傳感器,同一張動作圖片上面包含所有軸,在此輸入結構基礎上使用二維卷積核.該文獻實現了時間依賴性和空間依賴性結合.在文獻[30]二維卷積核的基礎之上,文獻[31]對 CNN卷積核應用了局部權重共享和全局權重共享兩種卷積方式.不同于圖1(b),文獻[32]利用傅里葉變換將一維原始信號數據生成頻譜,對三軸加速度計和三軸陀螺儀信號形成頻譜,將頻譜視為動作圖片作為輸入進行卷積操作.類似地,文獻[33]提出一種算法,可將一維信號轉換為二維圖片信號,其目的在于讓每一通道信號都可以與其他通道信號相連,即使是不同類型的通道信號,抽取每兩個信號之間的依賴性.受文獻[33]的啟發,文獻[34]修改了輸入圖片構造算法,同時調整了同一時刻不同類型三軸傳感器之間(x,y,z)軸的數據排列順序,確保該時刻所有不同類型的傳感器數據兩兩相鄰,以及同一類型傳感器內的不同軸向數據兩兩相鄰.文獻[35]針對單一位置傳感器,使用滑動窗口折疊法分別生成三軸動作圖片,在每個動作圖片上分別卷積.文獻[36,37]同樣針對手機上傳感器中的三軸加速度計,將滑動窗口內三軸數據直接生成同一張方形動作圖片,之后采用卷積網絡.

相比于一維卷積核只考慮時間域上面的依賴性,二維卷積核應用的角度更多,可以更大限度地利用傳感器數據的空間依賴性.基于二維卷積核的HAR依賴于輸入數據的組織構造形式,但是現有的工作僅僅是不同傳感器數據按照通道樸素排列并直接進行二維卷積或是對三軸向傳感器的同一位置的三軸數據進行簡單粗暴地排列組合.盡管相較于傳統的基于統計學特征的 HAR和基于一維卷積核的 HAR,現有的二維卷積方式可以提高準確率和精確率等評價指標,但是并沒有充分利用不同位置的三軸向傳感器數據的特點以及充分挖掘空間依賴性,如三軸加速度計.因此,本文根據三軸傳感器的數據特點,充分挖掘相同軸向數據之間的空間依賴性和時間依賴性,設計新穎的輸入組織形式構造多張動作圖片來提高HAR的識別效果.

2 基于二維卷積核的多位置三軸向傳感器HAR模型

本文提出了基于二維卷積核的多位置三軸向穿戴式設備HAR模型,該模型雖然沿用了HAR問題中的二維卷積應用的思想,但是增強了對時序數據的空間依賴性的挖掘.因此,結合三軸向傳感器特點,本文提出了一種新穎的二維卷積核輸入的動作圖片構建方法及其改進方法,利用不同位置的三軸向傳感器的相同軸向數據構成輸入動作圖片,將原始數據分別構建成3個或4個動作圖片,基于輸入動作圖片構建卷積神經網絡,分別抽取原始數據各軸向數據內部的時空依賴性,進而得到更加具有分辨能力的特征向量,提高模型識別準確率.為了簡化模型參數,對卷積網絡進行參數優化,提出了基于共享參數的HAR模型.

2.1 問題描述與定義

本文研究的根本問題是如何學習一個具有良好識別效果的人體活動識別模型,即模型參數;關鍵問題是如何從原始標簽數據中抽取具有高分辨能力的特征;核心問題是如何構造用于二維卷積核輸入的動作圖片,原因在于不同的動作圖片組織形式會導致二維卷積核抽取的特征具有不同的依賴性和表達能力.為了方便描述問題,形式化定義如下:

定義1(動作圖片).相對于一維時序數據,動作圖片是對一維信號通過一定規律進行升維操作所生成的二維信號數據.動作圖片是卷積核的輸入.

定義2(滑動窗口).滑動窗口是動作圖片的時間窗口,是時序傳感器數據的時間處理單元,令ws表示滑動窗口大小,如圖1中所示,ws=T.

定義3(模型 M).給定時序數據長度N,每時刻原始訓練數據X={(l1,x1),…,(lN,xN)}為帶有標簽數據,時刻數據標簽li,其中,i∈[1,N].假設覆蓋率為0且ws=T,用于訓練的實例數量為N′=N/T,其中,j∈[1,N′].用于訓練模型M的數據為D={(t1,d1),…,d1(tN′,dN′)},則:

其中,A,B分別為模型M的權重參數矩陣和偏置參數矩陣,Loss函數為損失函數.即:在輸入數據D的條件下求取使得損失函數最小的模型參數A和B.

2.2 HAR模型二維動作圖片構建

2.2.1 基于多位置三軸傳感器二維動作圖片構建原理

傳感器形態多樣化可分為傳感器種類多樣化和傳感器位置多樣化[30],本文中構造二維卷積輸入的前提是傳感器位置多樣化.傳感器種類多樣化是基于多種類別傳感器的動作識別,例如基于加速度計、陀螺儀、磁力計等傳感器的識別.傳感器位置多樣化是基于多種位置的相同類型傳感器或者不同類型傳感器的動作識別.本文結合三軸向傳感器特點,舍棄同一傳感器三軸之間的空間依賴性,選擇不同傳感器的相同軸向數據的空間依賴性,并構建用于卷積網絡輸入的動作圖片,從理論和數據分析兩個角度闡釋本文動作圖片構建原理.

(1) 理論分析

以三軸加速度計為例,其三軸向傳感器數值代表了 3個相互垂直方向的加速度值,從空間角度上講,同一傳感器三軸向加速度在加速度方向上是相互獨立的,相關性較弱,不同傳感器的不同軸向之間相關性更弱.而不同傳感器的相同軸向加速度值大致描繪的是同一個方向的整體加速度變化,類比于圖片分類中的RGB三通道,每一個軸向具有相同的意義表達,描述的是一個動作在同一個軸向上所有傳感器的加速度變化,基于同一個軸方向的加速度矩陣可以通過卷積操作提取更加具有分辨能力的特征,提高識別準確率.

(2) 數據分析

在理論分析的基礎上,對原始數據同一傳感器不同軸向數據和不同傳感器同一軸向數據進行相關性分析.相關系數絕對值在0.3以下為極弱相關性,該相關系數矩陣極弱相關性比例遠遠高于多傳感器同一軸向各個傳感器加速度之間的比例.取本文實驗中的測試數據集SKODA的5個三軸傳感器計算相關性,如圖2所示,在105對數據中,該矩陣極弱相關性系數比例達到18.09%;而同一軸向所有傳感器數據共有10對數據,3個單軸向的所有傳感器中則有30對數據,在30對數據中極弱相關性系數比例僅有6.67%.這是因為該矩陣中存在大量的同一傳感器的三軸之間和不同傳感器的不同軸之間的相關性計算.

Fig.2 Correlation coefficient matrix of different axises of accelerometer sensors圖2 不同軸向數據相關系數矩陣

2.2.2 基于多位置三軸傳感器二維動作圖片構建方法

根據多位置三軸傳感器動作圖片構建原理,本文提出了基于多位置三軸傳感器輸入構建方法T-2D和基于多位置混合傳感器輸入構造算法M-2D.

(1) 基于多位置三軸傳感器輸入構建方法算法T-2D.

圖3描述了基于多位置三軸傳感器動作圖片構建方法T-2D.原始時序數據來自于n個位置三軸傳感器,將所有位置傳感器的數據根據(x,y,z)三軸方向進行抽取,分別得到全部x軸時序數據、全部y軸時序數據和全部z軸時序數據,并且分別對這3組數據進行歸一化處理.根據定義2,分別對3組數據以滑動窗口T和預設覆蓋率進行滑動窗口劃分,獲取時序傳感器數據的處理單元,該時間單元的傳感器數據為動作圖片.

3個動作圖片均作為二維卷積神經網絡的輸入,并用于抽取不同位置傳感器的相同軸向數據的時間依賴性和空間依賴性.目前,三軸加速度計是在人體活動識別過程中使用較為普遍的傳感器,大多數設備中都包含三軸加速度計,如手環、手機等,因此,本文三軸向傳感器使用三軸加速度計.

Fig.3 T-2D based on multi-location 3D accelerometer sensors圖3 基于多位置三軸傳感器輸入構建方法T-2D

(2) 基于多位置混合傳感器二維輸入構建方法M-2D.

大部分設備內置三軸加速度計的同時,也配有其他的傳感器,這些傳感器一部分與三軸加速度計一樣具有三軸特性的,例如陀螺儀、磁力計等;而有一些就是簡單的時序數據,例如心率計.因此,針對這種更為實際且廣泛存在的情況,在 T-2D的三軸加速度計輸入構造算法的基礎上,本文擴充了一種混合傳感器數據輸入構造算法M-2D,在生成三軸加速度的3個動作圖片的同時,對其他傳感器數據按序排列,構成第4個動作圖片.由于該動作圖片在卷積過程中采用一維卷積核而非二維卷積核,僅抽取這些時序數據的時間依賴性.

2.2.3 算法實現

算法1描述了本文提出的基于多位置混合傳感器二維輸入動作圖片構建方法M-2DCNN,由于M- 2DCNN是 T-2DCNN的擴充方法,其不同之處在于增加了算法 1中的第 4行和第 7行.算法 1輸入為X={(l1,x1),…,(lN,xN)},其中,每個時刻數據xi=(xi1,yi1,zi1,…,xin,yin,zin,ri1,…,rim),n為三軸傳感器數量,xin,yin,zin分別表示三軸數據,rim表示非三軸傳感器.該算法返回的結果是對輸入數據按照滑動窗口大小進行分割之后的動作圖片以及相應的標簽.

算法1.基于二維輸入動作圖片構造方法M-2D.

輸入:X={(l1,x1),…,(lN,xN)},ws;

輸出:所有分割好的動作圖片以及該組動作圖片對應標簽List((Ximag,Yimag,Zimag,Rimag),t).

2.3 基于二維卷積核的HAR模型

在基于傳感器時序數據的活動識別領域,與傳統基于統計學特征不同,CNN能夠在無需專業領域知識的前提下自動地從原始數據中提取具有高分辨能力的特征,因此,CNN在該領域得到了廣泛應用.本文在構建動作圖片的基礎上,使用卷積神經網絡提取特征并分類.

2.3.1 二維卷積網絡結構

由于基于多位置混合傳感器的二維卷積結構是基于多位置加速度計傳感器二維卷積結構的改進方法,圖4既可以描述T-2DCNN又可以描述M-2DCNN卷積模型結構,虛線框內為T-2DCNN的二維卷積操作.

Fig.4 M-2DCNN architecture of 2D CNN based on multi-location mixed sensors圖4 基于多位置混合傳感器的二維卷積模型網絡結構M-2DCNN

該網絡結構包括輸入層在內共11層,其中,卷積層4層,池化層1層,數據轉化層2層,全連接層2層,連接分類器 1層.本文中,卷積層和全連接層的 feature map的數量同文獻[26],為 C(64)-C(64)-C(64)-C(64)-D(128)-D(128).多層卷積可以提取出更加具有分辨能力的特征,二維卷積核是為了得到原始數據每個軸向的時間和空間的依賴性,再使用一維卷積核降低參數數量.同時增設最大值池化層用來減少特征數量和訓練參數,抽象數據輪廓特征.如圖4所示,

· 第1層為輸入層,從上到下依次為x軸、y軸和z軸數據構成的3個動作圖片,其中,T為滑動窗口大小,TriSen_num為三軸加速度計的數量;

· 第2層~第5層均為卷積層,其中,前兩層使用二維卷積核,卷積核(過濾器)大小為Kh×Kw,針對每一個動作圖片分別進行卷積操作時,提取原始數據時間和空間的依賴性;同時,為了減少參數數量,第4層和第5層采用一維卷積核,卷積核大小為Kh×1;

· 卷積之后進行池化(第6層),本文采用最大值池化可降低由于卷積層參數誤差引起的估計均值的偏移;

· 第7層和第8層均為對池化后的矩陣進行重新整理和融合特征,第7層將池化后的矩陣數據沿時間軸方向將特征映射進行拼接,池化層每個軸向數據尺寸為64@hl×wl,則第7層數據尺寸為64@hl×(wl×3);第 8層將數據平鋪變成一維向量,作為全連接層的輸入(第 9層),兩層全連接層抽取更為抽象的特征,實現特征非線性組合,方便連接分類器Softmax(第11層).

如圖4所示,當處理非三軸加速度計數據時(虛線外),基于M-2D共生成4個動作圖片.在卷積層,針對由非三軸全部使用一維卷積核,其工作同文獻[25]卷積操作類似.當傳感器中也包含三軸向數據時,將該數據看做 3個通道,依次排列.由于各個卷積層使用的卷積核在時間維度上的尺寸是相同的,因此在第7層串聯時,可以與三軸加速度計產生的3個特征映射在時間軸上面進行拼接,此時,第7層特征維度為64@hl×(wl×3+Sen_num),其中,Sen_num為第4張動作圖片的傳感器數量,之后的操作則與多位置加速度計傳感器二維卷積結構的后四層操作相同.

2.3.2 基于參數共享二維卷積網絡結構

盡管卷積網絡與傳統全連接網絡相比極大地降低了參數數量,但 M-2DCNN和 T-2DCNN在訓練過程中,卷積操作依然產生大量的參數,原因在于每一張動作圖片都需要單獨的卷積操作.

每一個動作圖片的前向傳播的卷積過程如圖5所示,其中,卷積核大小為,第l層共有個feature maps,第l-1層共有個feature maps.

Fig.5 Computation of 2D CNN kernals圖5 二維卷積計算過程

因此,每一個動作圖片卷積過程中的第l-1層和第l層之間需要訓練的參數見公式(2):

根據圖4所示的卷積網絡訓練模型,每個動作圖片的卷積操作過程中模型參數都是獨立的,那么 3個動作圖片的每層卷積操作中共需要3×Pnum數量的參數,且參數數量是隨著卷積核大小以及feature map數量的增加而增加的.

因此,本文在T-2DCNN和M-2DCNN的基礎上提出了基于共享卷積層參數的卷積網絡模型TS-2DCNN和MS-2DCNN.結合本文中動作圖片單一軸向數據的特點以及模型的特點,將利用共享同一組參數對 3組動作圖片進行特征提取,即:在圖4之中的x_axis,y_axis和z_axis這3個方向使用同一組模型參數取代之前的3組模型參數.可以共用同一組參數的原因在于該卷積操作中訓練 3組不同參數與同一組參數都可以達到在各個方向上提取數據特征的目的,因此可在保證識別效果的同時減少訓練參數數量.采用表4中的卷積核參數,利用公式(2),對圖4的網絡結構中卷積層之間的參數數量進行計算,見表1,其中,Input_X表示輸入層中X軸的動作圖片,Cov2_X表示通過X軸動作圖片獲取的第2層卷積層,則第2層中Cov2_X與上一層Input_X之間需要訓練的參數數量為3×3×64+64=640,以此類推.TS-2DCNN和MS-2DCNN在卷積層能夠將參數數量縮減至原來的三分之一.

Table 1 Comparison of the number of the CNN parameters表1 卷積層參數數量對比

2.3.3 模型訓練與實現

· 前向傳播過程

本文中使用了二維卷積核和一維卷積.結合圖5,二維卷積在前向傳播過程中的計算見公式(3):

第kl個特征映射的輸出為

其中,σ(x)為激活函數.為了加快求導數速度并防止梯度彌散,本文中使用修正線性單元 ReLU(rectified linear unit)作為激活函數,在池化層,即子采樣層,選取卷積層子區域內所有神經元的最大值構成池化層神經元.

· 反向傳播過程

本文中的神經網絡結構中包含兩種情況:卷積層連接卷積層和卷積層連接池化層.當l層為卷積層時,第l-1層第特征映射的殘差項來自于l層的所有神經元單元,定義?為卷積操作,那么第特征映射中坐標為(i,j)的殘差項為

在得到殘差項計算公式之后,第l-1層的第個特征映射神經元卷積核的梯度公式為

· 模型實現

算法2描述了基于二維卷積動作圖片的HAR模型訓練過程:分別對每個動作圖片進行4次卷積和一次池化操作(第4行、第5行),并將特征映射進行串聯拼接和扁平處理(第6行).第7行、第8行對應全連接層和輸出層的操作,全連接層的輸入為第6行處理之后的一維特征向量.第9行包含對所有層反向傳播計算,當參數變化小于閾值或者訓練完全部數據時,可以得到該模型的參數.值得注意的是:在實際運算過程中,是將訓練數據劃分成批次,以矩陣形式進行計算.

算法2.基于二維卷積輸入動作圖片的HAR模型訓練.

算法 3描述 HAR模型預測過程.對于輸入無標簽數據,使用 M-2DCNN(MS-2DCNN)或者 T-2DCNN(TS-2DCNN)方法對輸入進行處理生成相應動作圖片,利用訓練好的參數預測每個時間窗口數據的標簽類別pi.

算法3.HAR模型預測過程.

3 實驗與分析

為了驗證本文提出的兩種二維輸入構造算法 T-2DCNN(TS-2DCNN)和 M-2DCNN(MS-2DCNN)的特征提取的有效性,本文在公開數據集上對比了現有典型且特征提取效果較好的兩種算法的姿態識別效果,即傳統的一維卷積輸入 1DCNN[26]和現有的二維卷積輸入 2DCNN[30].文獻[26,30]中所述的兩種卷積方式是目前在相同公開數據集上表現較好且利用不同數據組織形式和卷積方式提取特征的方法,具有一定代表性.此外,本文重心不是測試現有 CNN網絡結構以及 CNN和不同分類模型融合的混合模型,而是側重于對特征的提取效果的驗證,因此選取1DCNN和2DCNN兩種對比方法.同時,分類模型全部使用softmax進行分類.

3.1 實驗數據集描述

在基于傳感器信號的人體活動識別領域,根據傳感器位置,用于測試的公開數據集通常分為兩類:一種是僅用測試者身上的傳感器收集的數據;另一種是包含周邊環境和物體傳感器的數據,例如在抽屜、茶杯之類的物品上面放置傳感器,結合身上的傳感器一起識別動作.本文中使用的公開數據集屬于第 1種類型的數據——OPPORTUNITY[41]數據集和SKODA數據集[42].

· OPPORTUNITY數據集(https://archive.ics.uci.edu/ml/datasets/opportunity+activity+recognition)

OPPORTUNITY數據集收集場景為日常生活,主要活動范圍在廚房.該數據集數共有 4名測試者,3種類型傳感器分別為:測試者身上傳感器(body-worn sensors)、物體傳感器(object sensors)和周圍環境傳感器(ambient sensors).本文利用身上傳感器識別測試者的動作,包括7個IMU(inertial measurement unit)、12個三軸加速度傳感器,其分布見表2.對于每一個測試者記錄了6個文件,其中5個ADL和1個Drill.ADL是測試者在自然狀態下的活動記錄,包括在椅子上躺著、在房間走動以及準備咖啡、三明治等一些列活動;Drill是對一系列動作的20次重復,包括開關冰箱、開關抽屜等活動.對于活動類別,該數據進行了等級劃分,分為運動模式識別(modes of locomotion)和姿態識別(gesture recognition),姿態識別分為高層次活動[43]、中層次活動[25,26]和低層次活動[44].高層次活動為抽象活動,例如咖啡時間、三明治時間等;中層次活動為高層次活動細化,例如咖啡時間中包含開關抽屜等活動;低層次活動為中層次活動的活動單元.本文選擇中層次動作作為識別的標簽.而運動模式識別中描述運動的狀態,如站立、躺、坐等.為了描述實驗方便,用GR和 LM來代表姿態識中層次標簽識別任務和運動模式標簽識別任務,標簽描述見表3.在原始數據中存在很多缺失值,因此利用線性插值對缺失數據進行填充.數據采樣頻率為30HZ.

Table 2 Location of the sensors in OPPORTUNITY dataset表2 OPPORTUNITY數據集傳感器位置分布

Table 3 Details of OPPORTUNITY and SKODA表3 OPPORTUNITY 和 SKODA數據集描述

· SKODA數據集(http://www.ife.ee.ethz.ch/research/activity-recognition-datasets.html)

SKODA數據集描述汽車工人對汽車進行操作的場景,該數據集總共包含19個USB傳感器,每個傳感器包含三軸加速度傳感器,其中,在右臂和左臂上分別放置10個和9個傳感器,其具體位置見文獻[42].在本文中,我們僅適用右臂中的10個傳感器進行測試,傳感器編號從手腕到大臂依次為{2,27,16,29,1,18,14,24,22, 21},該數據集包含10類標簽,具體動作見表3.

3.2 實驗設置

· 參數設置

本文實驗環境為Google Colaboratory提供的GPU.編程語言為Python 2.0,框架為Keras.本文中實驗過程所需參數見表4.為了驗證本文所提算法在不同滑動窗口下的性能,因此設計了滑動窗口參數范圍,在沒有明確指出滑動窗口參數時缺省值為24,即24個時刻數據作為一個數據單元進行訓練和預測,該窗口最后一個時刻數據作為該數據單元的標簽,窗口覆蓋率為 50%.由于 SKODA采樣頻率較大,為了實現實驗參數共享并且方便與OPPORTUNITY數據集對比,對SKODA數據進行降采樣,降采樣之后頻率為32HZ,與OPPORTUNITY數據集采樣頻率相當.當滑動窗口為24時,OPPORTUNITY數據集和SKODA數據集各類訓練樣本數量見表3,并對各類標簽進行了符號化表示.結合數據傳感器類型特點,本文利用 OPPORTUNITY數據集驗證 M-2DCNN(MS-2DCNN)識別效果,利用SKODA驗證T-2DCNN(TS-2DCNN)識別效果.

Table 4 Experiment parameters表4 實驗參數

同時,本文從傳感器數量角度對提出的卷積網絡模型以及共享參數模型的特征抽取效果進行了驗證,對于OPPORTUNITY數據集,添加部分IMU傳感器并按照傳感器在人體分布情況逐次添加傳感器,總共有4組傳感器,默認缺省值為最后一組包含16類傳感器.類似地,對于SKODA數據集,按照傳感器分布位置區域進行添加,共有3組:第1組包含小臂傳感器3類,第2組包含大小臂傳感器8類,最后一組包含10類,默認為最后一組.

在使用OPPORTUNITY和SKODA數據集的文獻中,由于各種參數設置不同以及衡量標準不同,無法統一衡量,因此本文結合參考文獻中的方法,統一了輸入數據參數進行對比實驗.結合第 2.3節中所提出的卷積框架,卷積層和池化層的卷積核參數見表4.對于第2層和第3層卷積層,該結構在梯度下降過程中學習速率為0.01.本文中用于對比實驗的一維卷積 1DCNN輸入構造和網絡結構來自文獻[26],為了使實驗對比結果更加令人信服,將原文獻中前兩個卷積層的卷積核定義3×1,網絡架構與原文相同.二維卷積2DCNN輸入構造來自文獻[30],還原了文獻中的二維卷積輸入構造和卷積網絡結構.

· 評價指標

本文使用F1值作為識別效果的評價指標,F1同時受到精確率和召回率的影響,計算公式為

其中,Pi和Ri分別為第i類的精確率和召回率,wi為該類樣本占所有樣本比例,目的是解決類間樣本數量不平衡問題.

· 訓練集和測試集選取

對于SKODA數據集,訓練集和測試集比例為4:1.對于OPPORTUNITY數據集,結合文獻中的實驗源碼,訓練數據包括測試者1的所有ADL和Drill、測試者2和測試者3的ADL1,ADL2,ADL3和Drill,測試數據為測試者2和測試者3的ADL4和ADL5.所有數據均沒有進行數據類間均衡.在OPPORTUNITY數據集中,盡管IMU傳感器數據中包含多維度數據,我們僅僅抽取其中的三軸加速度與ACC的三軸加速度結合,按照三軸方向構造3組二維輸入,IMU傳感器剩余數據包括三軸陀螺儀和磁力器均作為一維卷積輸入.

3.3 實驗結果與分析

·F1對比分析

表5和表6分別描述了本文提出的兩種輸入構造法以及經過優化參數的網絡在OPPORTUNITY數據集和SKODA數據集上面的表現.對于OPPORTUNITY數據中GR標簽和LM標簽,均分為兩種情況:一種是包含Null class類,一種是不包含Null class類.

Table 5 F1-value on OPPORTUNITY dataset表5 OPPORTUNITY數據集F1值

Table 6 F1-value on SKODA dataset表6 SKODA數據集F1值

在表5中,加粗數字表示同等實驗參數和環境下最高F1值.通過表5亦可知:滑動窗口取48時,GR和 GR(null)的F1值與窗口為24時相比均有降低.無論窗口取24還是48,基于本文提出的輸入構造方法的卷積神經網絡M-2DCNN和MS-2DCNN與現有方法1DCNN和2DCNN的F1值相比,在絕大多數情況下表現效果良好.這是因為 OPPORTUNITY傳感器遍布全身且動作具有連續性,本文所述動作圖片構建方法能夠有效地卷積出單一軸方向上的數據特征,其時空特征表現良好.在默認參數情況下,針對4種分類任務,利用2DCNN實現GR分類時,MS-2DCNN的F1提升值最大為6.68%,M-2DCNN次之為6.07%;在利用1DCNN實現GR(null)時,F1提升值最小,為0.38%.而在窗口取48時,LM(null)分類效果中,本文方法略占劣勢,與最高值相比經降低了1.57%.其原因在于1DCNN和 2DCNN更依賴于時序數據的時間特征,而本文方法需要較多的訓練樣本.在這 4種方法中,LM識別F1值總體上比GR的高.這是因為LM識別種類少,包括Null class在內共5種類別,而GR包含Null class在內共有18種類別,相比于LM,GR類間差異會相對不明顯,因此整體F1值低于LM.在GR中,由于Null class數量相對于其他類別數據數量明顯增多,占GR樣本總數的71.9%,因此包含Null class的GR的識別效果要好于不包含Null class的GR.在LM(null)識別任務中,Null class僅占總樣本數17.2%,Null class的加入會造成整體F1值降低.

表6描述了本文算法在SKODA數據集上的表現,由表可知:T-2DCNN和TS-2DCNN表現良好,在默認參數情況下,T-2DCNN的F1高達95.18%,與相同條件下使用樸素2DCNN0相比提高了1.09%.該數量級F1值提升非常有意義,說明本文提出的二維卷積輸入構建方法可以更高層次地抽取傳感器數據之間的空間依賴性;同樣與1DCNN相比,比單純的抽取時間依賴性提高了0.27%.當超過采樣頻率之后即窗口取 48時,在默認傳感器數量情況下,整體F1值有所下降.其原因在于訓練樣本隨著窗口增加而減少,訓練樣本不足導致.同時, T-2DCNN和TS-2DCNN依然保持優勢.這是因為樣本不足時,1DCNN時間特征不足,2DCNN空間特征表達沒有 T-2DCNN和TS-2DCNN明顯.

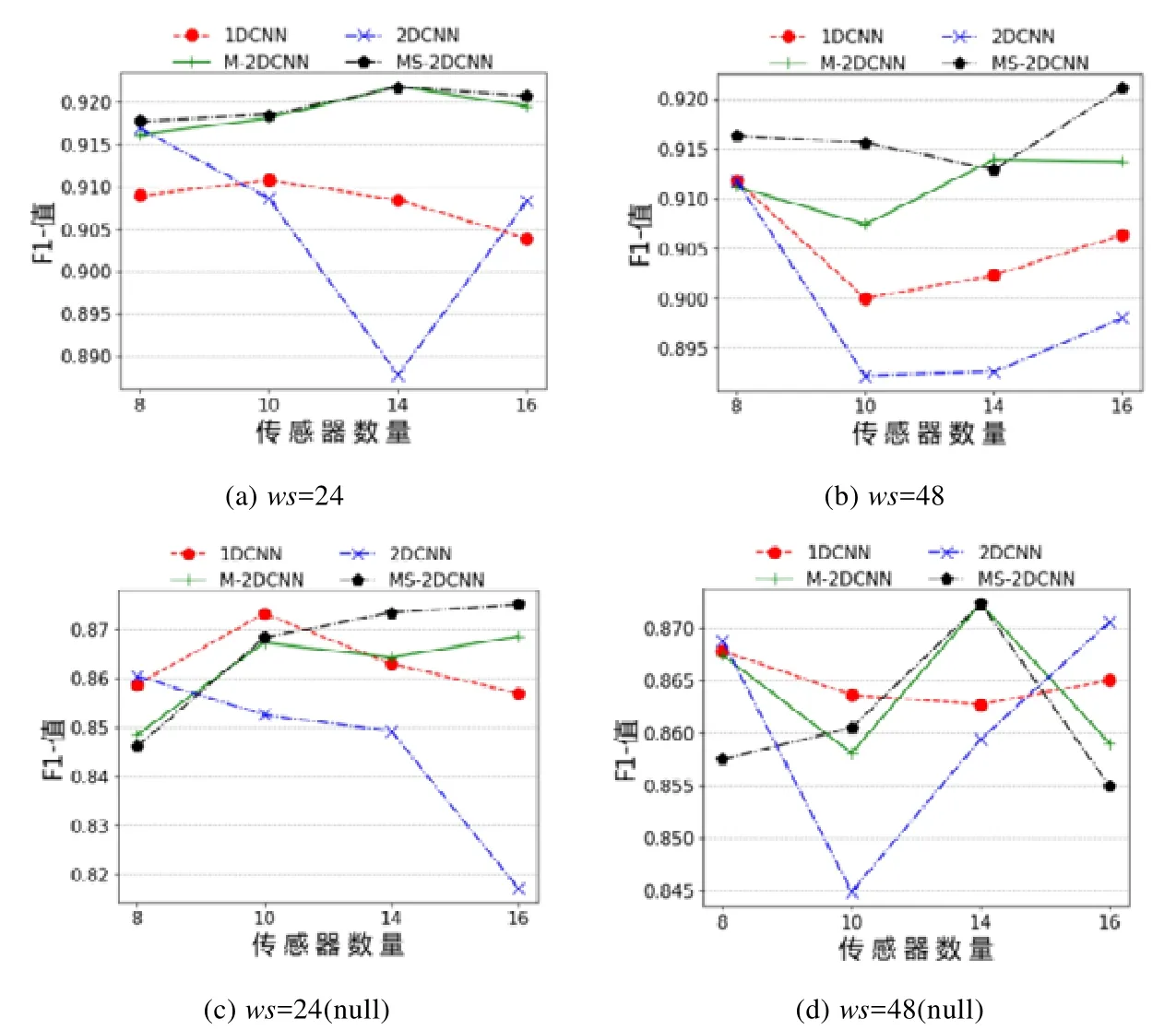

· 傳感器數量與F1關系分析

為了更好地說明本文提出的輸入組織形式可以有效地抽取數據的空間依賴特征和時間依賴特征,并在不同傳感器數量以及輸入數據窗口的情況下保持整體的平均識別效果,本節從傳感器數量角度出發,采用表4中傳感器數量參數,對基于4種卷積網絡的識別效果進行驗證.OPPORTUNITY數據集和SKODA數據集傳感器添加方式均是將不同區域的傳感器按照逐一區域添加.

圖6描述了OPPORTUNITY中GR和GR(null)F1傳感器數量之間的關系.隨著傳感器數量增加,不同滑動窗口大小的F1趨勢不同,甚至出現反復現象.由此可以說明傳感器數量越多,其計算效果不一定越好.原因在于識別效果和傳感器空間分布以及滑動窗口的變化有關,同時,傳感器較多容易引起過擬合,如ws=48時 GR中M-2DCNN,1DCNN和2DCNN.從整體上講,GR中的M-2DCNN和MS-2DCNN可以有效地兼顧數據時間和空間的特征,在傳感器數量較少時,能夠有從單一軸向動作圖片中挖掘時間依賴性;在傳感器數量較多時,本文描述的動作圖片可以挖掘同一軸向上的不同位置傳感器的空間依賴性.相對于1DCNN和2DCNN的F1提升較大.但在 GR(null)中,雖然F1值也有提升,但提升沒有 GR中明顯.其原因在于 null類在訓練過程中所占比例較高.隨著傳感器數量增多,F1值先下降后上升,這是因為新加入的傳感器屬性能夠更好地表達特征,降低了之前加入傳感器數造成的數據干擾.

Fig.6 F1-values of GR with different number of sensors on OPPORTUNITY圖6 OPPORTUNITY數據集不同數量傳感器的GR任務的F1值

圖7描述了OPPORTUNITY中LM和LM(null)中的動作識別效果隨著傳感器數量變化的的趨勢.在LM中,M-2DCNN和MS-2DCNN在窗口為24時的F1值整體上隨著傳感器數量增加而提高,在窗口為48時小范圍波動,而其他兩種方法在窗口為24時整體低于M-2DCNN和MS-2DCNN并呈現下降趨勢.這說明M-2DCNN和MS-2DCNN在小窗口時可以有效地從少量多個位置、多種傳感器中抽取空間特征.當 LM(null)分類任務窗口為48時,1DCNN識別效果較為穩定,這說明1DCNN能夠在大窗口傳感器數據中得到時間特征.而2DCNN的F1值范圍波動較大,M-2DCNN和MS-2DCNN也有小范圍波動,說明在該窗口下數據空間特征受傳感器分布影響較大,不能夠在逐一區域添加傳感器過程中得到穩定的時空特征.當加入null class之后,4種方法對于特征學習能力下降,這是因為在LM標簽中null class學習樣本較少,增大了誤差.

Fig.7 F1-values of LM with different number of sensors on OPPORTUNITY圖7 OPPORTUNITY數據集不同數量傳感器的LM任務的F1值

圖8描述了SKODA數據集上不同滑動窗口情況下F1隨著傳感器數量變化.

Fig.8 F1-values of recognition with different number of sensors on SKODA圖8 SKODA數據集不同數量傳感器的活動識別F1值

隨著傳感器數量的增加,T-2DCNN,TS-2DCNN呈現上升趨勢.這是因為動作圖片構建需要一定數量的傳感器,在不受噪音傳感器干預的情況下,傳感器數量越多,則在每一個軸向的動作圖片中所提取動作的空間依賴性越強.在窗口為48時,1DCNN和2DCNN呈現了先上升后下降的趨勢,其原因是在該參數情況下,訓練數據較少,且傳感器數量較多,產生了過擬合現象.同時可觀測到,TS-2DCNN和T-2DCNN在傳感器數量為3時F1值很低.這是由于該數量傳感器構成的3個動作圖片的空間特征分辨力不足,但隨著傳感器數量增多,F1值逐漸提高.

為了更加清晰地描述基于這4種方法的在各種傳感器分布情況下的卷積網絡效果,我們對圖6~圖8獲取最高F1值的方法出現的次數進行了統計,見表7和表8.該統計的目的在于說明這4種方法在不具體指出傳感器位置分布的情況下的總體識別效果,即該算法的通用性,而不針對于某一種情況下作比較.在 OPPORTUNITY上,M-2DCNN和MS-2DCNN獲取最高F1值的頻次較高;SKODA數據集上,本文所述方法頻次最高.因此說明我們提出的方法對實驗參數和數據集的變化具有較好的的適應能力,可以有效地從多位置傳感器組合中抽取有效的特征.同時,通過圖6~圖8也可以看出:基于共享參數的卷積網絡MS-2DCNN和TS-2DCNN與M-2DCNN和T-2DCNN達到同等效果,即使F1在某些情況下略有降低,但整體好于2DCNN和1DCNN.

Table 7 Frequency of the largestF1-value on OPPORTUNITY表7 OPPORTUNITY數據集最高F1值次數

Table 8 Frequency of the largest F1-value on SKODA表8 SKODA數據集最高F1值次數

· 相同類別F1值對比分析

本文未采用混淆矩陣對每一類的識別效果進行分析,而是縱向對比了每一類采用不同方法的F1差值.可以更清晰和直觀地觀測到不同的輸入構造和卷積對每一類識別效果的影響.圖9描述了 OPPORTUNITY中M-2DCNN和MS-2DCNN每個類別F1值與待對比方法法F1值差異,橫坐標為類別標簽符號,其符號與類別之間對應關系見表3,縱坐標為不同方法F1值之間的差值.

Fig.9 F1-values’ difference of GR in different CNN architectures on OPPORTUNITY (ws=24)圖9 OPPORTUNITY數據集GR各類別不同輸入構造方法F1值差異(ws=24)

在GR的17類動作中,M-2DCNN在11個動作中的識別效果均優于其他兩種方法,完全低于其他兩種方法的有4類動作(G3,G6,G10和G17).在MS-2DCNN中,不存在完全低于其他兩種方法的動作標簽,對于類間差異較小的動作,如開關不同的抽屜和門,本文方法能夠有效地進行區分,同時說明了OPPORTUNITY數據集中傳感器分布使得同一軸向的動作圖片數據特征表達較好,即使共享卷積參數,依然在各類別的識別過程中表現良好.但對于G17(clean table)的動作識別效果不如2DCNN,這是因為G17不同于其他動作,該動作持續時間長,因此在同一軸向小窗口數據上的空間依賴性表達不如2DCNN明顯.

圖10描述了 SKODA數據集中,默認情況下使用 T-2DCNN和 TS-2DCNN與待對比方法F1值的差異.T-2DCNN在9種動作中的識別效果均優于其他兩種方法;TS-2DCNN可以較好地識別出8種動作;而1DCNN在第6類動作識別效果略好,這是因為S6動作樣本數量較少,且該動作完全由左臂完成,文中所使用SKODA傳感器均佩戴在右臂,在完成動作時右臂動作幅度不大,使用一維卷積核時能夠完整地抽取傳感器各個軸向的時間特征,該動作空間特征不明顯,出現了本文方法識別效果不如1DCNN,但卻優于2DCNN的現象.

Fig.10 F1-Values’ difference in different CNN architectures on SKODA (ws=24)圖10 SKODA數據集各類別不同輸入構造方法F1值差異(ws=24)

4 結 論

本文針對現有二維卷積輸入構建方法中對多位置三軸向傳感器相同軸向數據之間的空間依賴性挖掘不足的現象進行研究并提出解決方案.本文提出了 T-2DCNN和 M-2DCNN兩種網絡結構,其核心是利用 T-2D和M-2D構建方法將多個位置的三軸加速度計的數據劃分成 3張獨立的動作圖片用于二維卷積核的輸入,同時,結合非三軸傳感器構建一維卷積核輸入的動作圖片,融合多張動作圖片所得的特征映射來抽取高層次特征,實現了以本文所提方案為特征抽取方法的HAR模型.同時,提出了基于共享參數TS-2DCNN和MS-2DCNN的網絡結構,在保證識別準確率的同時,減少了卷積層訓練參數數量,并通過設置不同實驗參數驗證了本文所述方法的識別效果.在未來研究工作中,將結合項目研究組采集的數據對真實環境建模和動作識別.