基于李雅普諾夫優化的容器云隊列在線任務和資源調度設計

李磊 薛洋 呂念玲 馮敏

摘 要:為在保證任務服務質量(QoS)的條件下提高容器云資源利用率,提出一種基于李雅普諾夫的容器云隊列任務和資源調度優化策略。首先,在云計算服務排隊模型的基礎上,通過李雅普諾夫函數分析任務隊列長度的變化;然后,在任務QoS的約束下,構建資源功耗的最小化目標函數;最后,利用李雅普諾夫優化方法求解最小資源功耗目標函數,獲得在線的任務和容器資源的優化調度策略,實現對任務和資源調度進行整體優化,從而保證任務的QoS并提高資源利用率。CloudSim仿真結果表明,所提的任務和資源調度策略在保證任務QoS的條件下能獲得高的資源利用率,實現容器云在線任務和資源優化調度,并且為基于排隊模型的云計算任務和資源整體優化提供必要的參考。

關鍵詞:云計算;資源調度;建模與分析;服務質量保證;功耗優化;李雅普諾夫優化

中圖分類號: TP393.09

文獻標志碼:A

Abstract: To improve the resource utilization with Quality of Service (QoS) guarantee, a task and resource scheduling method under Lyapunov optimization for container cloud queue was proposed. Firstly, based on the queueing model of cloud computing, the Lyapunov function was used to analyze the variety of the task queue length. Secondly, the minimum energy consumption objective function was constructed under the task QoS guarantee. Finally, Lyapunov optimization method was used to solve the minimum cost objective function to obtain an optimization scheduling policy for the online tasks and container resources, improving the resource utilization and guaranteeing the QoS. The CloudSim simulation results show that, the proposed task and resource scheduling policy achieves high resource utilization under the QoS guarantee, which realizes the online task and resource optimization scheduling of container cloud and provides necessary reference for cloud computing task and resource overall optimization based on queuing model.

Key words: cloud computing; resource scheduling; modeling and analysis; Quality of Service (QoS) guarantee; energy consumption optimization; Lyapunov optimization

0 引言

2011年美國國家標準和技術研究院(National Institute of Standards and Technology, NIST)的Mell等[1]對云計算作出了如下定義:云計算能通過網絡以隨時隨地、便利的、按需付費的方式提供高可用資源(包括網絡、服務器、存儲和應用服務等),這些資源來自一個共享的、可配置的資源池,同時可以自動地完成資源的啟動和釋放,節省了人力物力。該定義清晰地闡述了云計算特點,這些特點使得云計算成為了當前互聯網的重要基礎設施之一,通過云計算資源彈性構建和按需付費等特點,使用者和開發人員可以通過網絡便利、按需地從一個共享的、可配置的資源池中獲取包括計算、存儲、網絡等資源,節約了使用者和開發人員對于基礎設施的資源投入,并實現了應用的快速部署和上線運行[2-4]。如文獻[5]所述,在實際的使用過程中,大多數的云計算使用者和開發人會員為了滿足不確定的網絡任務需求,以超量資源(所提供的資源大于最大的實際資源需求)方式進行資源的規劃,這種方式造成資源的大量浪費和資源功耗,同時降低了服務的收益。因此在面對不同時刻隨機的網絡任務負載需求時,如何發揮云計算的特點,按照負載任務需求進行資源的動態伸縮,使得資源能符合不同時刻網絡負載任務需求,從而在保證任務的服務質量(Quality of Service, QoS)的前提下有效減少容器云冗余資源的功耗、提高資源利用率,已經成為了云計算技術領域的研究熱點之一。

然而,資源動態調整技術研究不僅包括云計算的資源調度,也包括了任務調度和服務質量等問題,目前主要分為兩種方式,即主動資源調整方式和被動資源調整方式。其中主動資源調整方式通過對負載和任務進行在線的預測,根據預測的結果對云計算的資源提前進行調度,實現資源和負載需求的動態匹配。如:Sladescu等[6]研究了常用的預測方法,包括自回歸積分滑動平均模型(AutoRegressive Integrated Moving Average model, ARIMA)、人工神經網絡(Artificial Neural Network, ANN)和支持向量回歸 (Support Vector Regression, SVR),以及負載預測在服務質量方面的影響;Islam等[7]提出并研究了基于ANN的云計算負載研究技術;Calheiros等[8]在ARIMA基礎上提出了任務負載預測和資源的主動調度策略;Pacheco-Sanchez等[9]研究了基于馬爾可夫模型的云計算負載預測技術;徐達宇等[10]提出了一種改進灰狼搜索算法優化支持向量機的短期云計算資源負載預測模型;趙宏偉等[11]設計并實現了一種基于徑向基函數(Radial Basis Function, RBF)神經網絡和粒子群算法的云計算資源動態調度系統;李丹程等[12]基于OpenStack平臺提出了資源動態調度算法,將計算任務遷移到更合適的服務器,達到提高集群計算能效的目的。而被動資源調度方式主要是通過當前時刻負載的信息完成對云計算資源的調度和調整。

如Zhu等[13]基于多輸入多輸出框架提出了一種自適應的云計算資源調度系統,在時間的限制下獲得最大的服務質量;Bonvin等[14]以最大集中收益為目標提出了一種云計算的資源調度策略;Khazaei等[15]提出了一種基于排隊論的云計算模型,并通過該模型分析云資源的擴展性。一些最優化計算方法也被用于云計算任務和資源調度的優化,例如李騰耀等[16]基于遺傳算法提出了一種云任務調度算法;朱海等[17]提出一種能耗優化的資源分配調度體系架構,并基于此架構設計了一個滿足實時用戶服務保障(Service-Level Agreement, SLA)的能耗優化模型,該優化模型從系統級和部件級兩個層次進行能耗優化。

上述兩種資源調整方式有各自的優點和缺點:主動資源調整方式的優點是能夠提前對云計算資源進行調整,避免了資源與負載需求之間的時間延遲;缺點是受限于預測或者回歸模型的精度,當預測出現誤差時會造成資源冗余或者不足,從而影響任務的服務質量。被動資源調整方式的優點是直接對當前的負載任務進行處理,能精確地分配資源;缺點是網絡任務調度和資源調度相互獨立,同時由于傳統虛擬機,如內核虛擬機(Kernel-based Virtual Machine, KVM)啟動速度的影響,資源的調度滯后于任務的負載變化。

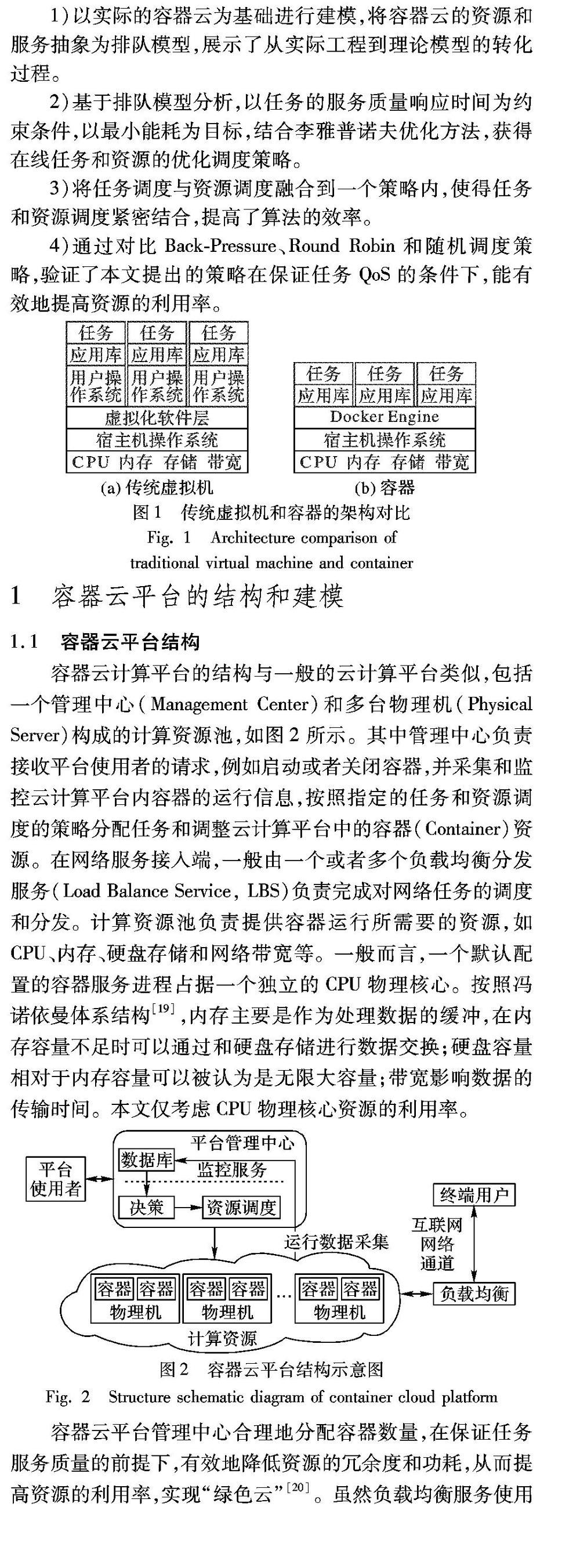

如文獻[18]所述,如圖1所示,容器(Container)(如Docker軟件服務)與傳統的虛擬機(如KVM)采用了不同的資源虛擬化技術,通過直接在宿主操作系統中的資源隔離避免了虛擬軟件層帶來的性能損耗開銷,同時不需要在容器中另外安裝用戶操作系統,可以看作是一個輕量級的虛擬化技術實現資源的隔離,使得容器在云計算平臺的啟動等待時間可以忽略不計。因此,采用容器云不僅避免了由虛擬機啟動時間延遲造成的任務負載變化和資源調度延遲,同時進一步提高了云計算平臺的性能。然而,目前的被動資源調整方式主要以單次或者靜態的任務和資源調度為主要的研究對象,很少考慮任務到來的時間先后和隊列的緩沖。因此,本文以動態任務到達為研究背景,并以實際的容器云架構為基礎進行建模,通過理論分析并結合李雅普諾夫優化方法設計了一種在線的任務和資源調度算法,不需要提前獲取網絡任務的任何負載信息,以當前任務到達強度和容器的負載信息驅動任務和資源的調度,使得服務系統隊列保持穩定,并在保證任務的服務質量的前提下,減少虛擬機的運行數量,從而提高資源的利用率。本文的主要工作包括:

1)以實際的容器云為基礎進行建模,將容器云的資源和服務抽象為排隊模型,展示了從實際工程到理論模型的轉化過程。

2)基于排隊模型分析,以任務的服務質量響應時間為約束條件,以最小能耗為目標,結合李雅普諾夫優化方法,獲得在線任務和資源的優化調度策略。

3)將任務調度與資源調度融合到一個策略內,使得任務和資源調度緊密結合,提高了算法的效率。

4)通過對比Back-Pressure、Round Robin和隨機調度策略,驗證了本文提出的策略在保證任務QoS的條件下,能有效地提高資源的利用率。

1 容器云平臺的結構和建模

1.1 容器云平臺結構

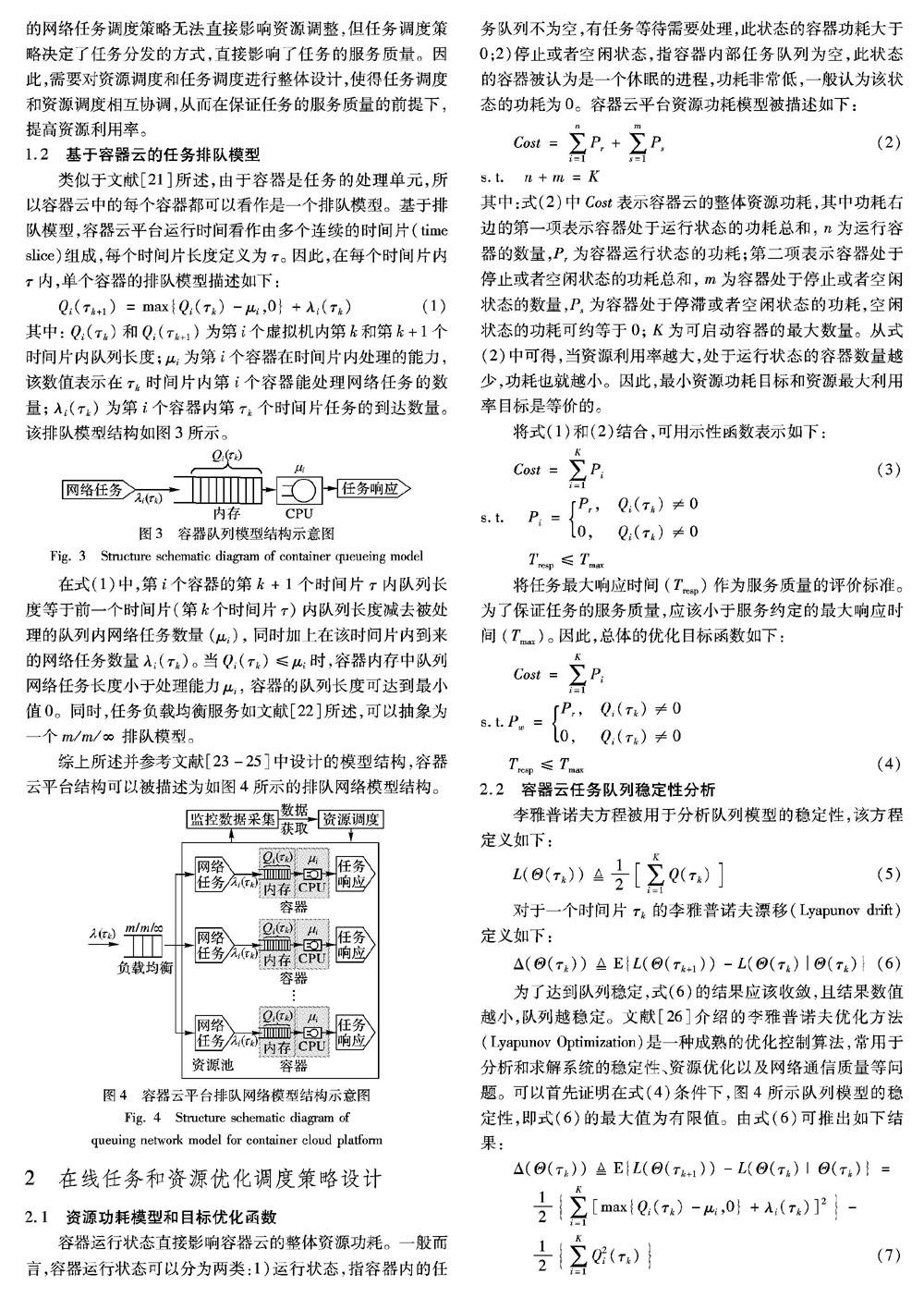

容器云計算平臺的結構與一般的云計算平臺類似,包括一個管理中心(Management Center)和多臺物理機(Physical Server)構成的計算資源池,如圖2所示。其中管理中心負責接收平臺使用者的請求,例如啟動或者關閉容器,并采集和監控云計算平臺內容器的運行信息,按照指定的任務和資源調度的策略分配任務和調整云計算平臺中的容器(Container)資源。在網絡服務接入端,一般由一個或者多個負載均衡分發服務(Load Balance Service, LBS)負責完成對網絡任務的調度和分發。計算資源池負責提供容器運行所需要的資源,如CPU、內存、硬盤存儲和網絡帶寬等。一般而言,一個默認配置的容器服務進程占據一個獨立的CPU物理核心。按照馮諾依曼體系結構[19],內存主要是作為處理數據的緩沖,在內存容量不足時可以通過和硬盤存儲進行數據交換;硬盤容量相對于內存容量可以被認為是無限大容量;帶寬影響數據的傳輸時間。本文僅考慮CPU物理核心資源的利用率。

容器云平臺管理中心合理地分配容器數量,在保證任務服務質量的前提下,有效地降低資源的冗余度和功耗,從而提高資源的利用率,實現“綠色云”[20]。雖然負載均衡服務使用的網絡任務調度策略無法直接影響資源調整,但任務調度策略決定了任務分發的方式,直接影響了任務的服務質量。因此,需要對資源調度和任務調度進行整體設計,使得任務調度和資源調度相互協調,從而在保證任務的服務質量的前提下,提高資源利用率。

1.2 基于容器云的任務排隊模型

類似于文獻[21]所述,由于容器是任務的處理單元,所以容器云中的每個容器都可以看作是一個排隊模型。基于排隊模型,容器云平臺運行時間看作由多個連續的時間片(time slice)組成,每個時間片長度定義為τ。因此,在每個時間片內τ內,單個容器的排隊模型描述如下:

2 在線任務和資源優化調度策略設計

2.1 資源功耗模型和目標優化函數

容器運行狀態直接影響容器云的整體資源功耗。一般而言,容器運行狀態可以分為兩類:1)運行狀態,指容器內的任務隊列不為空,有任務等待需要處理,此狀態的容器功耗大于0;2)停止或者空閑狀態,指容器內部任務隊列為空,此狀態的容器被認為是一個休眠的進程,功耗非常低,一般認為該狀態的功耗為0。容器云平臺資源功耗模型被描述如下:

3 在線任務和資源優化調度策略設計

為了驗證提出的在線任務和資源調度策略的效果,對比了以下幾種傳統的調度策略:

1)Back-Pressure策略[27]:該策略按照系統前一級節點和后一級節點的隊列差值決定任務的分發調度,優先將任務調度到差值最大的后一級節點。在容器云中,該策略可等效為優先將任務調度到任務隊列最短的容器內。

2)Round Robin策略[28]:該策略采用輪循的機制進行任務的調度。在容器云中,該算法等效于平均任務調度策略。

3)隨機調度策略[29]:該策略按照概率隨機選擇容器進行任務的調度。

3.1 實驗環境

實驗物理機配置為:Intel E3-1505 4核心CPU,32GB DDR4內存,1TB SSD硬盤存儲器。本文采用文獻[30]介紹的CloudSim 4.0云仿真軟件進行策略的仿真和對比。

為了獲得在真實情況下算法的性能和效果,實驗采用真實的維基媒體云計算服務網絡任務負載數據(http://dumps.wikimedia.org/other/pagecounts-raw)進行仿真,該數據實時記錄了每個小時網絡終端用戶訪問維基媒體云服務的任務數量。其中具體的實驗參數設置如下:

1)隨機選取了24個小時的維基媒體云計算服務網絡任務負載數據作為仿真的任務輸入數據(λ(τk))。

2)CloudSim設置為每臺容器最大內存緩沖能力為50000,最大可分配100臺容器;每臺容器在單位時間(1s)內可處理100個網絡任務(μi=100)。

3)任務服務質量的最大響應時間最大值為1s(Tmax=1s)。

3.2 實驗結果與分析

實驗通過以下4個主要的指標對不同策略的性能進行評估和分析:1)任務平均最大等待時間(Tmaxmean),代表整個運行時間任務的最長平均延遲時間,數值越大則越難以保證任務服務質量;2)任務最大響應時間(Tmaxresp),代表任務的最大響應時間,數值越低說明容器云越能保證任務服務;3)容器最大平均任務隊列長度(Qmaxmean),代表集群內運行時間最長的容器負載情況,該指標越大說明在整個運行時間內容器的負載越大;4)容器在線運行的時間總數(NTotal),代表整個運行時間內容器運行時間的總和,數值越大資源利用率越低,資源功耗越高。實驗結果如表1所示。

3.3 Tmaxmean和Tmaxresp分析

任務平均最大等待時間(Tmaxmean)指在運行的全部時間片內,容器云平臺中各個容器任務隊列的任務等待平均時間的最大值,該指標越大說明任務的排隊的時間越長。由于Round Robin調度策略采用了輪詢的調度機制,它會將任務平均地調度到全部容器內,因此從實驗結果可知,該策略的任務平均最大等待時間指標最小(0.18s)。隨機調度機制采用了平均概率分布將任務調度到容器云中的可啟動和使用的容器,在一定的時間內會造成任務集中調度在少部分容器內的情況,因此任務平均最大等待時間為160s。而Back-Pressure調度策略在每個時間片重新對所有的容器負載進行排序,并優先將任務調度到負載最輕的容器內,因此,任務平均最大等待時間為342.71s,為所對比策略中最大的。隨機調度和Back-Pressure調度策略使得容器云的任務平均最大響應時間大于其他策略,無法保證任務的服務質量。MaxWS-QoS和MinWS-QoS調度策略在最大響應時間的約束下,將任務調度集中到QoS保證條件下所允許的容器內,因此,任務平均最大等待時間被限制到一個可允許的范圍內,分別為0.51s和0.51s,稍大于Round Robin調度策略的指標數值0.18s,遠小于隨機調度和Back-Pressure調度策略的任務平均最大等待時間。

類似,任務最大響應時間(Tmaxresp)指在運行的全部時間片內,容器云平臺中各個容器任務隊列的任務處理時間的最大值,該指標與任務平均最大等待時間成正比。隨機調度和Back-Pressure調度策略使得容器云的任務最大響應時間高于其他策略。MaxWS-QoS和MinWS-QoS調度策略受限于最大響應時間限制,因此,該指標為1s,略大于Round Robin調度策略的0.35s,但小于隨機調度策略和Back-Pressure調度策略的數值(319.99s, 685.41s)。但最大平均等待時間和響應時間僅考慮了任務的服務質量,負載和資源利用率也是容器云平臺性能的一個重要指標。

3.4 Qmaxmean和NTotal分析

最大平均隊列長度(Qmaxmean)指在運行的全部時間片內,容器云平臺中各個容器任務隊列的平均長度的最大值,該指標越大說明任務的排隊的時間越長,單個容器的負載越大;該指標越小,說明容器資源分配越充分,但資源利用率越低。由于Round Robin調度策略采用了輪詢的調度機制,該調度策略會將任務平均地調度到全部的容器內,因此,Round Robin調度策略的最大平均任務隊列長度指標最小(30),該策略能使容器平臺內容器的平均負載達到最低,但資源利用率也最低。隨機調度機制采用了平均概率分布將任務調度到容器云中可啟動和使用的容器,在一定時間內會造成任務集中調度在少部分容器內的情況,因此最大平均隊列長度為14745;

Back-Pressure調度策略在每個時間片重新對所有的容器負載進行排序,并優先將任務調度到負載最輕的容器內,因此,最大平均隊列長度為33866,為所對比策略中最大的。

隨機調度和Back-Pressure調度策略使得容器云的負載高于其他策略。MaxWS-QoS和MinWS-QoS調度策略在最大等待時間的約束下,同時考慮了資源利用率,將任務調度集中到在任務服務質量保證條件下所允許的容器內,因此,最大平均隊列長度被限制到一個可允許的范圍內,分別為45和33。其中,MaxWS-QoS調度策略下的Qmaxmean比Back-Pressure調度策略下的Qmaxmean提高了(45-30)/30=50%,MinWS-QoS調度策略下的Qmaxmean比Back-Pressure調度策略的Qmaxmean提高了(33-30)/30=10%,但保證了任務的最大響應時間和最大平均響應時間均小于1s。

容器在線運行的時間總數(NTotal)指在運行時間內容器云平臺在線運行容器資源的時間總和,該指標數值越大說明資源分配越多,資源利用率越低。由于Round Robin調度策略采用了輪詢的調度機制,當任務數量大于容器云中可啟動容器的最大數量上限時,每個容器都會被分配任務并啟動運行,因此,Round Robin策略使得容器在線運行的時間總數最大(2400),資源利用率最低、功耗最大。Back-Pressure調度策略在每個時間片重新對所有的容器負載進行排序,并優先將任務調度到負載最輕的容器內,因此在整個運行時間內,Back-Pressure調度策略將任務分配到負載較輕的容器內,因此,容器在線運行的時間總數同樣會達到最大(2400)。隨機調度策略采用均勻分布的概率進行任務調度,在整個運行時間內,任務也會被調度到所有容器內,使得容器在線運行的時間總數(NTotal)也會達到最大(2400)。MaxWS-QoS和MinWS-QoS調度策略在最大等待時間的約束下,同時考慮了資源利用率,將任務調度集中到服務質量保證條件下所允許的容器內,因此,容器在線運行的時間總數(857,857)減小到約為原來的857/2400×100%≈36%,提高了容器云平臺資源的利用率。另外,在相同容器在線運行時間總數(NTotal)情況下,MinWS-QoS調度策略有限考慮非空的低負載容器,因此,MinWS-QoS調度策略下的Qmaxmean比MaxWS-QoS調度策略下的Qmaxmean減小了(45-33)/45≈27%,從而進一步保證了容器運行的穩定性和任務的服務質量。

綜上可知,本文提出的MaxWS-QoS和MinWS-QoS調度策略同時考慮到了服務質量保證和資源利用率,能在保證任務服務質量約束的條件下,有效地提高容器云平臺的資源利用率。

4 結語

針對云計算技術領域的研究熱點問題(任務和資源調度優化),以實際的容器云結構為基礎進行建模,結合李雅普諾夫優化方法從理論上分析,提出了兩種在線任務和資源調度策略,即任務服務質量保障最大負載排序資源調度策略和任務服務質量保障最小負載排序資源調度策略。實驗結果表明,提出的調度策略可以在保證任務服務質量的條件下有效地降低容器云在冗余資源,提高資源的利用率,降低容器云的資源功耗。

然而本文提出的排隊模型還需要完善,增加包括底層硬件資源的約束,實現容器的調度時對宿主選擇的約束和優化,從而進一步提高資源的利用率,并使得模型能更加切合實際容器云的結構和特點。同時,我們將進一步結合李雅普諾夫優化方法構建以時間為單位的虛擬資源任務隊列,考慮任務等待的延遲,實現調度策略在時間延遲方面的優化,提高任務的服務質量。

參考文獻:

[1] MELL P M, GRANCE T. The NIST definition of cloud computing, SP 800-145 [R]. Gaithersburg, MD: National Institute of Standards & Technology, 2011: 2-4.

[2] SERRANO D, BOUCHENAK S, KOUKI Y, et al. SLA guarantees for cloud services [J]. Future Generation Computer Systems, 2016, 54: 233-246.

[3] RODRIGUES E, ASSUNCAO R, PAPPA G L, et al. Exploring multiple evidence to infer users location in Twitter [J]. Neurocomputing, 2016, 171: 30-38.

[4] CHEN T, GAO X, CHEN G. The features, hardware, and architectures of data center networks: a survey [J]. Journal of Parallel and Distributed Computing, 2016, 96: 45-74.

[5] CHIANG Y-J, OUYANG Y-C, HSU C-H. An optimal cost-efficient resource provisioning for multi-servers cloud computing [C]// Proceedings of the 2013 International Conference on Cloud Computing and Big Data. Washington, DC: IEEE Computer Society, 2013: 225-231.

[6] SLADESCU M, FEKETE A, LEE K, et al. Event aware workload prediction: a study using auction events [C]// WISE 2012: Proceedings of the 2012 International Conference on Web Information Systems Engineering. Berlin: Springer-Verlag, 2012: 368-381.

[7] ISLAM S, KEUNG J, LEE K, et al. Empirical prediction models for adaptive resource provisioning in the cloud [J]. Future Generation Computer Systems, 2012, 28(1): 155-162.

[8] CALHEIROS R N, MASOUMI E, RANJAN R, et al. Workload prediction using ARIMA model and its impact on cloud applications QoS [J]. IEEE Transactions on Cloud Computing, 2015, 3(4): 449-458.

[9] PACHECO-SANCHEZ S, CASALE G, SCOTNEY B, et al. Markovian workload characterization for QoS prediction in the cloud [C]// CLOUD 11: Proceedings of the 2011 IEEE International Conference on Cloud Computing. Washington, DC: IEEE Computer Society, 2011: 147-154.

[10] 徐達宇,丁帥.改進GWO優化SVM的云計算資源負載短期預測研究[J]. 計算機工程與應用, 2017, 53(7): 68-73. (XU D Y, DING S. Research on improved GWO-optimized SVM-based short-term load prediction for cloud computing[J]. Computer Engineering and Applications, 2017, 53(7): 68-73.)

[11] 趙宏偉,申德榮,田力威.云計算環境下資源需求預測與調度方法的研究[J]. 小型微型計算機系統,2016,37(4):659-663. (ZHAO H W, SHEN D R, TIAN L W. Research on resources forecasting and scheduling method in cloud computing environment[J]. Journal of Chinese Computer Systems, 2016, 37(4): 659-663.)

[12] 李丹程,王曉晨,宋曉雪,等.基于OpenStack的資源負載預測方法研究[J]. 計算機應用研究,2014,31(7):2178-2182. (LI D C, WANG X C, SONG X X, et al. Study on load prediction method based on OpenStack[J]. Application Research of Computers, 2014, 31(7):2178-2182.)

[13] ZHU Q, AGRAWAL G. Resource provisioning with budget constraints for adaptive applications in cloud environments [J]. IEEE Transactions on Services Computing, 2012, 5(4): 497-511.

[14] BONVIN N, PAPAIOANNOU T G, ABERER K. Autonomic SLA-driven provisioning for cloud applications [C]// CCGRID 11: Proceedings of the 2011 IEEE/ACM International Symposium on Cluster, Cloud and Grid Computing. Washington, DC: IEEE Computer Society, 2011: 434-443.

[15] KHAZAEI H, MISIC J, MISIC V B. A fine-grained performance model of cloud computing centers [J]. IEEE Transactions on Parallel & Distributed Systems, 2013, 24(11): 2138-2147.

[16] 李騰耀,張鳳琴,王夢非.使用遺傳算法改進的兩階段云任務調度算法研究[J].小型微型計算機系統,2017,38(6):1305-1310. (LI T Y, ZHANG F Q, WANG M F. Improved two period cloud task scheduling algorithm with genetic algorithm [J]. Journal of Chinese Computer Systems, 2017, 38(6): 1305-1310.)

[17] 朱海,王洪峰,廖貅武.云環境下能耗優化的任務調度模型及虛擬機部署算法[J]. 系統工程理論與實踐,2016,36(3):768-778. (ZHU H, WANG H F, LIAO X W. Task scheduling model and virtual machine deployment algorithm for energy consumption optimization in cloud computing [J]. Systems Engineering — Theory & Practice, 2016, 36(3): 768-778.)

[18] ANDERSON C. Docker [Software engineering] [J]. IEEE Software, 2015, 32(3): 102-c3.

[19] ENTICKNAP N. Von Neumann architecture [J]. Computer Jargon Explained, 1989 (Suppl 2): 128-129.

[20] KUMAR S, BUYYA R. Green cloud computing and environmental sustainability [M]// Harnessing Green IT: Principles and Practices. Hoboken: John Wiley & Sons, 2012: 315-339.

[21] CHIANG Y-J, OUYANG Y-C, HSU C-H. An efficient green control algorithm in cloud computing for cost optimization [J]. IEEE Transactions on Cloud Computing, 2015, 3(2): 145-155.

[22] CALHEIROS R N, RANJAN R, BUYYA R. Virtual machine provisioning based on analytical performance and QoS in cloud computing environments [C]// ICPP 11: Proceedings of the 2011 International Conference on Parallel Processing. Washington, DC: IEEE Computer Society, 2011: 295-304.

[23] LI S, ZHOU Y, JIAO L, et al. Towards operational cost minimization in hybrid clouds for dynamic resource provisioning with delay-aware optimization [J]. IEEE Transactions on Services Computing, 2015, 8(3): 398-409.

[24] LU P, SUN Q, WU K, et al. Distributed online hybrid cloud management for profit-driven multimedia cloud computing [J]. IEEE Transactions on Multimedia, 2015, 17(8): 1297-1308.

[25] KHAZAEI H, MISIC J, MISIC V B. Performance analysis of cloud computing centers using M/G/m/m+r queuing systems [J]. IEEE Transactions on Parallel and Distributed Systems, 2012, 23(5): 936-943.

[26] NEELY M. Stochastic Network Optimization with Application to Communication and Queueing Systems [M]. Williston, VT: Morgan and Claypool Publishers, 2010: 15-16.

[27] LIU J, STOLYAR A L, CHIANG M, et al. Queue back-pressure random access in multihop wireless networks: optimality and stability [J]. IEEE Transactions on Information Theory, 2009, 55(9): 4087-4098.

[28] RASMUSSEN R V, TRICK M A. Round robin scheduling — a survey [J]. European Journal of Operational Research, 2008, 188(3): 617-636.

[29] ATIEWI S, YUSSOF S, RUSLI M E. A comparative analysis of task scheduling algorithms of virtual machines in cloud environment [J]. Journal of Computer Science, 2015, 11(6): 804-812.

[30] CALHEIROS R N, RANJAN R, BELOGLAZOV A, et al. CloudSim: a toolkit for modeling and simulation of cloud computing environments and evaluation of resource provisioning algorithms [J]. Software Practice & Experience, 2011, 41(1): 23-50.