基于殘差密集網(wǎng)絡(luò)的單幅圖像超分辨率重建

謝 雪 晴

(重慶工業(yè)職業(yè)技術(shù)學(xué)院信息工程學(xué)院 重慶 401120 )

0 引 言

圖像超分辨率重構(gòu)是數(shù)字圖像處理領(lǐng)域中的研究熱點之一。圖像超分辨率是指把分辨率比較低的圖像通過某種算法得到分辨率較高的圖像,使獲得的高分辨率圖像具有更加清晰的顏色、紋理等信息。提高低質(zhì)量圖像質(zhì)量的方法一般有兩種:一是改善硬件設(shè)備,二是圖像超分辨率重建技術(shù)。然而在實際應(yīng)用中,由于比較高的工程成本和制作流程,大多數(shù)場合一般不會采用分辨率較高的相機(jī)來采集數(shù)字圖像。而是利用超分辨率重建技術(shù)來得到具有更加豐富的顏色紋理等信息的高分辨率圖像。目前,常見的超分辨率重建技術(shù)分為三類:基于插值的方法、基于重建的方法、基于學(xué)習(xí)的方法。

基于插值的方法包括最近鄰插值和三次插值,優(yōu)點是算法復(fù)雜度較低,缺點是很容易出現(xiàn)階梯鋸齒狀現(xiàn)象以及產(chǎn)生邊緣模糊。

基于重建的方法使用了強(qiáng)制約束平滑和下采樣技術(shù),使得低分辨率圖像和高分辨率圖像保持一致性,由于該方法過分地依賴高分辨率圖像的先驗知識,當(dāng)縮小或放大圖像的時候,重建質(zhì)量就會下降,重建的結(jié)果就會缺失重要的細(xì)節(jié)信息。

近年來,深度學(xué)習(xí)在圖像超分辨率重建領(lǐng)域表現(xiàn)出巨大的潛力。文獻(xiàn)[1]首次提出基于卷積神經(jīng)網(wǎng)絡(luò)的圖像超像素重建方法,第一次用深度學(xué)習(xí)來解決SISR問題。該網(wǎng)絡(luò)共三層卷積層:第一層提取輸入的低分辨率圖像的特征;第二層將提取的低分辨率圖像的特征映射到高分辨率圖像的特征;第三層為高分辨率圖像的重建。損失函數(shù)為簡單的MSE損失。文獻(xiàn)[2]提出了基于學(xué)習(xí)的圖像超分辨率算法,利用樣本先驗知識來重建圖像,相較于其他重建方法有明顯的優(yōu)勢,也是近年來研究的熱點。本文首先分析了影響圖像重建質(zhì)量的原因,然后對基于深度學(xué)習(xí)的超分辨率重建算法[1]提出了兩點改進(jìn):用隨機(jī)線性糾正單元(Randomized rectified linear unit,RReLU)來避免原有網(wǎng)絡(luò)學(xué)習(xí)中對圖像某些重要的信息的過度壓縮,同時用NAG(Nesterov’s accelerated gradient)方法來加速網(wǎng)絡(luò)的收斂,進(jìn)而避免了在梯度更新時產(chǎn)生較大的震蕩。目前,圖像超分辨率方法難以同時滿足運算速度快和生成的圖像高質(zhì)量這一問題,文獻(xiàn)[3]提出一種基于卷積的快速的圖像超分辨率方法。此方法首先提取卷積特征,然后利用去卷積層對提取的特征放大膨脹,再以池化層對特征進(jìn)行濃縮,提煉更魯棒的特征,進(jìn)而獲得高分辨率圖像。文獻(xiàn)[4]提出了一種基于GAN網(wǎng)絡(luò)的超分辨率重建。文中,作者論證了PSNR不能作為評價超分辨的標(biāo)準(zhǔn),因為它和人對圖片的感受結(jié)果不一致,并采用了MOS進(jìn)行評價;另外作者在loss函數(shù)上進(jìn)行了改進(jìn),更好地恢復(fù)出細(xì)節(jié)的紋理信息。文獻(xiàn)[5]提出了用于圖像超分辨率任務(wù)的新方法,分別是增強(qiáng)深度超分辨率網(wǎng)絡(luò)EDSR和一種新的多尺度深度超分辨率MDSR,在減小模型大小的同時實現(xiàn)了比當(dāng)前其他方法更好的性能。文獻(xiàn)[6]提出了一個非常深的循環(huán)殘差網(wǎng)絡(luò)用于圖像超分辨率,這個網(wǎng)絡(luò)高達(dá)52層。文獻(xiàn)[7]提出了一種多階段級聯(lián)殘差卷積神經(jīng)網(wǎng)絡(luò)模型。該模型分為兩階段來進(jìn)行超分辨率圖像重建,首先重建2倍超分辨率圖像,然后重建4倍超分辨率圖像。第一階段和第二階段都使用殘差層,對兩階段分別構(gòu)建多任務(wù)損失函數(shù),利用第一階段的損失來指導(dǎo)第二階段的損失,進(jìn)而提高網(wǎng)絡(luò)訓(xùn)練的速度。文獻(xiàn)[8]針對經(jīng)典的基于卷積神經(jīng)網(wǎng)絡(luò)的超分辨率(SRCNN)方法存在重建圖像紋理結(jié)構(gòu)模糊以及網(wǎng)絡(luò)模型訓(xùn)練收斂過慢等問題,提出了一種多通道卷積的圖像超分辨率(MCSR)方法。該方法通過增加殘差鏈接,加快了模型收斂速度。同時利用多通道映射來提取更加豐富的特征,進(jìn)而增強(qiáng)超分辨率重構(gòu)效果。文獻(xiàn)[9]提出了一種維度拉長策略,將模糊和噪聲作為輸入,可以應(yīng)對多倍和空間改變的退化模型,提高了實用性。實驗結(jié)果表明,提出的網(wǎng)絡(luò)結(jié)構(gòu)在多種多樣的退化采樣后,依然能生成比較好的結(jié)果。近年來,隨著深度學(xué)習(xí)的快速發(fā)展,出現(xiàn)了很多基于神經(jīng)網(wǎng)絡(luò)的超分辨率算法。深度卷積網(wǎng)絡(luò)在圖像超分辨率重建方面取得了卓越的成就,但是參數(shù)數(shù)量往往非常巨大。文獻(xiàn)[10]提出了一種簡潔緊湊型遞歸殘差網(wǎng)絡(luò)結(jié)構(gòu)。該網(wǎng)絡(luò)通過局部殘差的學(xué)習(xí)來減輕訓(xùn)練深層網(wǎng)絡(luò)的困難;引入遞歸結(jié)構(gòu)保證增加深度的同時控制模型參數(shù)數(shù)量;采用可調(diào)梯度裁剪方法來防止梯度消失。在網(wǎng)絡(luò)末端使用反卷積層直接上采樣圖像,進(jìn)而得到超分辨率圖像。

然而,這些方法只是用了某些卷積層的信息,而沒有用全部的卷積層的信息。圖像中的物體有不同的尺度、視角和長寬比,深度卷積神經(jīng)網(wǎng)絡(luò)中的層次特征對于圖像重構(gòu)有很大的幫助。因此,本文提出了一個殘差密集網(wǎng)絡(luò)結(jié)構(gòu)用于圖像超分辨率。

1 殘差網(wǎng)絡(luò)和密集網(wǎng)絡(luò)

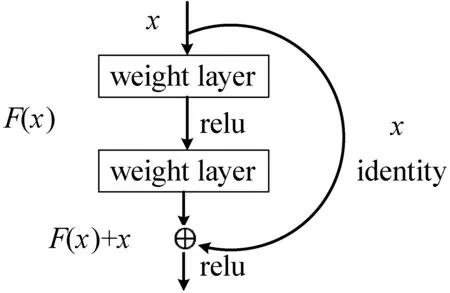

在訓(xùn)練的過程中,深度神經(jīng)網(wǎng)絡(luò)容易遇到梯度消失問題,在塊的歸一化中,我們將輸入數(shù)據(jù)由激活函數(shù)的收斂區(qū)調(diào)整到梯度較大的區(qū)域,在一定程度上緩解了這種問題。不過,當(dāng)網(wǎng)絡(luò)的層數(shù)急劇增加時,BP算法導(dǎo)數(shù)的累乘效應(yīng)很容易讓梯度慢慢減小直至消失。為了從根本上解決這個問題,文獻(xiàn)[11]提出了一種深度殘差網(wǎng)絡(luò),簡化那些非常深的網(wǎng)絡(luò)的訓(xùn)練過程,使得層能根據(jù)其輸入來學(xué)習(xí)殘差函數(shù)而非原始函數(shù)。實驗表明,這些殘差網(wǎng)絡(luò)的優(yōu)化過程比較簡單,能夠使得網(wǎng)絡(luò)結(jié)構(gòu)有更深的層,而且能獲得更加高的性能。文獻(xiàn)[11]在ImageNet數(shù)據(jù)集上使用了一個152層的網(wǎng)絡(luò)結(jié)構(gòu)來評估所提出的殘差網(wǎng)絡(luò),雖然它相當(dāng)于8倍深的VGG網(wǎng)絡(luò),但是在所提出的框架中仍然有非常低的復(fù)雜度。這些殘差網(wǎng)絡(luò)的一個組合模型,在ImageNet測試集上的錯誤率僅為3.57%。此結(jié)果在2015年的ILSVRC分類任務(wù)上獲得了第一名的好成績。每一個殘差塊如圖1所示。

圖1 殘差塊

其中:x是輸入。假設(shè)H(x)是映射函數(shù),我們不期望得到近似的H(x),而是把它們近似為一個殘差函數(shù)F(x):F(x):=H(x)-x。因此,原始的函數(shù)H(x):=F(x)+x。

對每幾個堆棧層都應(yīng)用殘差學(xué)習(xí),殘差塊可以被表示為如下形式:

y=F(x,{Wi})+x

(1)

式中:x和y分別為輸入和輸出;函數(shù)F(x,{Wi})表示學(xué)習(xí)到的殘差映射。對于圖1所示的殘差塊,總共為兩層,F(xiàn)=W2σ(W1x),其中,σ為ReLU。

2 方法設(shè)計

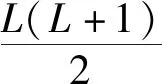

2.1 整體流程

本文提出了一種殘差密集網(wǎng)絡(luò)結(jié)構(gòu)用于圖像超分辨率,整體流程圖如圖2所示。該網(wǎng)絡(luò)結(jié)構(gòu)包括三部分:淺層的特征提取,殘差密集塊以及上采樣操作。

圖2 殘差密集網(wǎng)絡(luò)結(jié)構(gòu)

我們用兩層卷積層來提取淺層的特征,第一層卷積層提取輸入的低分辨率圖像(Low Resolution,LR)的特征,表示為:

F-1=HSF1(ILR)

(2)

式中:HSF1(·)表示卷積操作。F-1可以進(jìn)一步用于淺層特征的提取,因此,可以依次類推得到F0:

F0=HSF2(F-1)

(3)

式中:HSF2(·)表示第二個特征提取層的卷積操作。特征F0作為殘差密集塊的輸入。假設(shè)我們有D個殘差密集塊。第d層殘差密集塊的輸入Fd可以表示為:

Fd=HRDB,d(Fd-1)=HRDB,d(…HRDB,0(F0))

(4)

式中:HRDB,d(·)表示第d個殘差密集塊(Residual Dense Block,RDB)的操作,它可以表示為復(fù)合函數(shù)運算,例如卷積層和Rectified Linear Units(ReLU)層。最后,所有的特征可以表示:

Fall=H(F-1,F0,F1,…,FD)

(5)

在提取了局部和全局的特征Fall之后,我們用一個上采樣的網(wǎng)絡(luò),來得到高分辨率圖像(High Resolution,HR)。

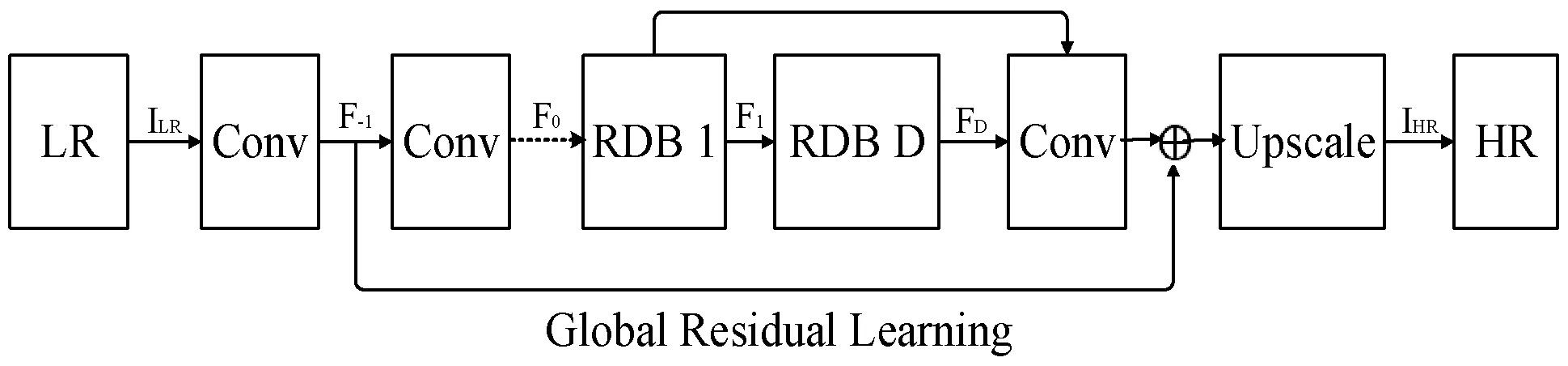

2.2 殘差密集塊

殘差密集網(wǎng)絡(luò)結(jié)構(gòu)包括密集的連接層、局部特征融合層,如圖3所示。

圖3 殘差密集塊

令Fd-1和Fd分別表示第d個殘差密集塊的輸入和輸出。那么,第d個殘差密集塊中的第c個卷積層的輸出可以表示為:

Fd,c=σ(Wd,c[Fd-1,Fd,1,…,Fd,c-1])

(6)

式中:σ為ReLU激活函數(shù),Wd,c是第c個卷積層的權(quán)重。

本文所提出的殘差密集網(wǎng)絡(luò)生成高質(zhì)量的超分辨率圖像的方法,充分利用了原始低分辨率圖像的每一層的特征。殘差密集塊不僅可以通過連續(xù)記憶機(jī)制從前一個殘差密集塊讀取狀態(tài),還可以通過局部密集連接充分利用其中的所有層的信息。然后通過局部特征融合自適應(yīng)地保留累積的特征。此外,還利用全局殘差學(xué)習(xí),將淺層特征和深層特征結(jié)合在一起,從原始LR圖像中得到全局密集特征。

3 實 驗

3.1 數(shù)據(jù)集和評價指標(biāo)

為了評估本文提出的方法的有效性,本文訓(xùn)練模型用文獻(xiàn)[1]提到的91幅圖像。對于測試,本文用四個基準(zhǔn)的數(shù)據(jù)集:Set5、Set14、B100和Urban100。Set5共包括5幅圖像,Set14包括14幅圖像。

圖像超分辨率重構(gòu)常用的客觀評價指標(biāo)主要包括峰值信噪比(Peak Signal to Noise Ratio,PSNR)和結(jié)構(gòu)相似性(Structural Similarity Index Method,SSIM)。

峰值信噪比是一種簡單且廣泛使用的SISR測量方法,它通過均方差(MSE)進(jìn)行定義。PSNR可以定義為:

(7)

式中:MAX表示圖像顏色的最大數(shù)值,8 bit圖像的最大取值為255。MSE為均方差,定義為:

(8)

式中:I和K分別是原始圖像和處理后的圖像,圖像的大小為m×n。

SSIM評價指標(biāo)采用更加直接的方法來比較重建圖像和參考圖像的結(jié)構(gòu),表示為:

(9)

式中:μx和μy表示圖像所有像素的平均值,σx和σy表示圖像像素值的方差,C1和C2為常數(shù)。

PSNR值越大,說明效果越好;SSIM值越小,說明效果越好。

3.2 實驗結(jié)果與分析

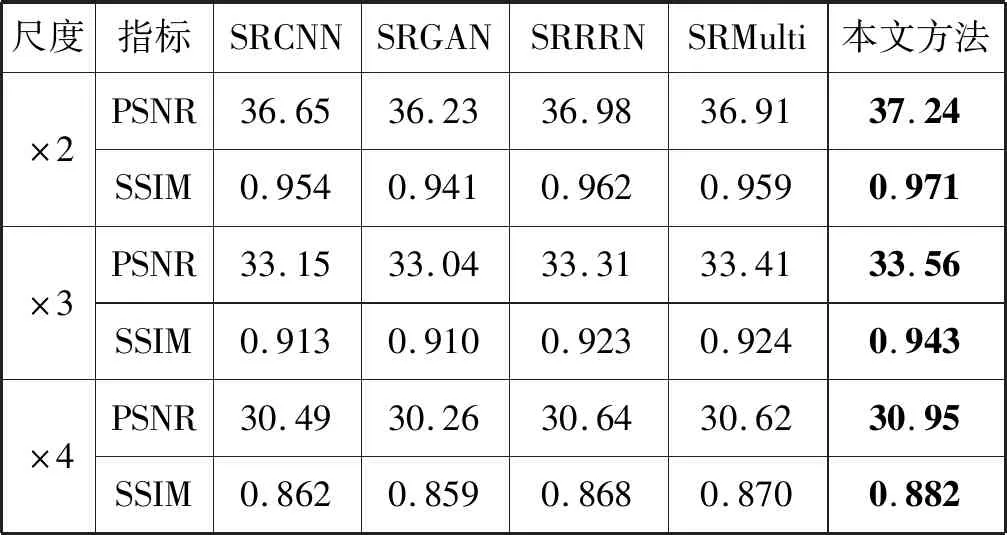

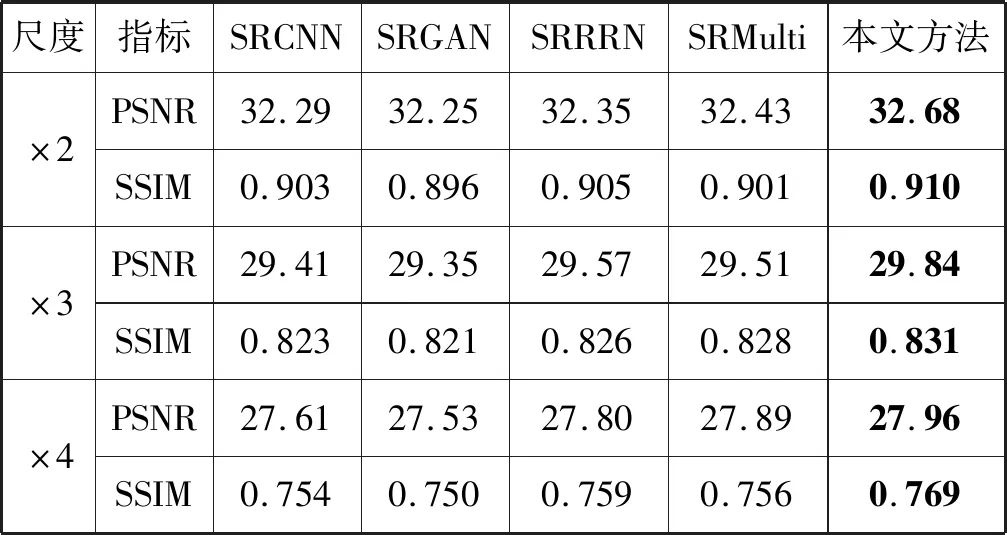

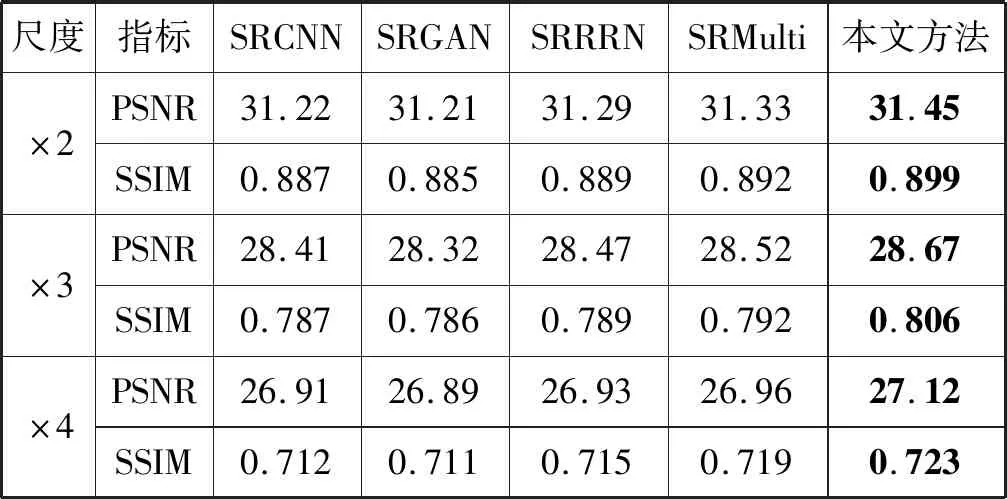

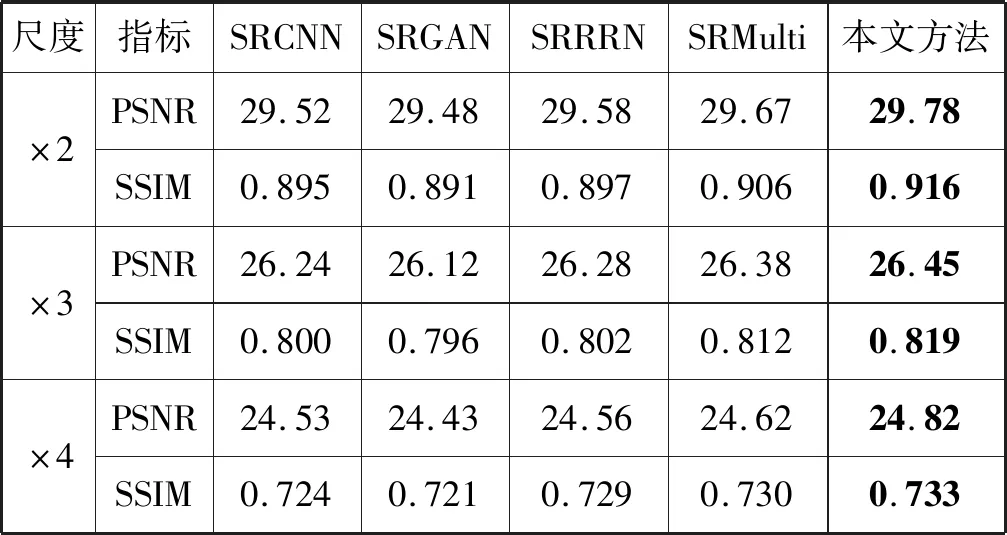

對于每一個超分辨率的尺度(×2、×3和×4),本文分別訓(xùn)練獨立的模型。將本文方法與SRCNN[1]方法、SRGAN[4]方法、SRRRN[6]方法、SRMulti[9]方法分別在數(shù)據(jù)集Set5、Set14、B100和Urban100上進(jìn)行對比,實驗結(jié)果如表1-表4所示。可以看出,本文方法更加有效。

表1 本文方法和其他先進(jìn)的方法在Set5數(shù)據(jù)集上的比較

表2 本文方法和其他先進(jìn)的方法在Set14數(shù)據(jù)集上的比較

表3 本文方法和其他先進(jìn)的方法在B100數(shù)據(jù)集上的比較

表4 本文方法和其他先進(jìn)的方法在Urban100數(shù)據(jù)集上的比較

本文除了對提出的方法進(jìn)行定量的比較,還進(jìn)行了定性的比較,如圖4所示,為了得到更好的視覺效果,對標(biāo)出的長方形框內(nèi)的區(qū)域進(jìn)行放大。圖4中第一列是原始的圖像,第二至第五列分別為比較先進(jìn)的超分辨率方法,最后一列是本文提出的方法。可以看出,本文提出的方法可以更好地恢復(fù)出細(xì)節(jié),進(jìn)而得到更加清晰的高分辨率圖像。

(a) (b) (c) (d) (e) (f)圖4 超分辨率的定性比較

4 結(jié) 語

本文提出了一種殘差密集深度網(wǎng)絡(luò)用于圖像超分辨率,該方法充分利用了每一層的特征,得到了紋理等細(xì)節(jié)更清晰的超分辨率圖像。在四個公共的數(shù)據(jù)集上進(jìn)行了定量的實驗,用常用的評價指標(biāo)進(jìn)行評價,實驗結(jié)果表明,本文的方法更有效。此外,本文進(jìn)行了定性的比較,通過直觀的視覺觀察可以看出,本文的方法相比其他相對先進(jìn)的方法可以得到更加清晰的高分辨率圖像。