基于深度學習的行人重識別研究進展

羅浩 姜偉 范星 張思朋

行人重識別(Person re-identification)也稱行人再識別,被廣泛認為是一個圖像檢索的子問題,是利用計算機視覺技術判斷圖像或者視頻中是否存在特定行人的技術,即給定一個監控行人圖像檢索跨設備下的該行人圖像.行人重識別技術可以彌補目前固定攝像頭的視覺局限,并可與行人檢測、行人跟蹤技術相結合,應用于視頻監控、智能安防等領域.

在深度學習技術出現之前,早期的行人重識別研究主要集中于如何手工設計更好的視覺特征和如何學習更好的相似度度量.近幾年隨著深度學習的發展,深度學習技術在行人重識別任務上得到了廣泛的應用.和傳統方法不同,深度學習方法可以自動提取較好的行人圖像特征,同時學習得到較好的相似度度量.當然深度學習相關的行人重識別方法也經歷了一個從簡單到復雜的發展過程.起初研究者主要關注用網絡學習單幀圖片的全局特征,根據損失類型的不同可以分為表征學習(Representation learning)和度量學習(Metric learning)方法.而單幀圖片的全局特征遇到性能瓶頸之后,研究者引入局部特征和序列特征進一步發展行人重識別研究.最近因為生成對抗網絡(Generative adversarial nets,GAN)[1]的逐漸成熟,一些基于GAN 的行人重識別研究工作表明:GAN 在擴充數據集、解決圖片間的偏差等問題上也有不錯的效果.雖然目前大量工作仍然是屬于監督學習(Supervised learning)的范疇,但是遷移學習、半監督學習和無監督學習也同樣是一個值得研究的方向.

本文分析了近幾年深度學習相關的方法在行人重識別問題上的發展,歸納整合了該領域的一些優秀算法,并探討了未來可能的研究焦點.

本文剩余內容安排如下:第1 節簡要回顧了行人重識別的發展歷程.第2 節介紹一些常見的行人重識別數據集,并分析一下主要的研究難點.第3 節著重介紹近幾年比較典型的基于深度學習的行人重識別方法,并按照一定的發展歷程進行歸納整合.第4 節我們展示目前一些方法在主流數據集上的性能表現.第5 節簡要探討一下未來可能的研究焦點.

1 行人重識別發展簡述

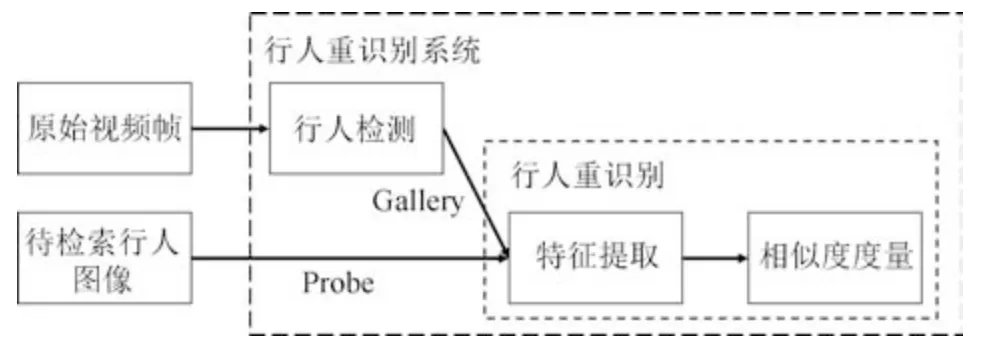

行人重識別可以應用到刑事偵查、視頻監控、行為理解等多個方面,但據我們所知,其在學術界的研究最先追溯到跨攝像頭多目標跟蹤(Multi-target multi-camera tracking,MTMC tracking)問題上.早在2005 年,文獻[2]探討了在跨攝像頭系統中,當目標行人在某個相機視野中丟失之后如何將其軌跡在其他相機視野下再次關聯起來的問題.該文獻利用一個貝葉斯網絡根據行人特征(顏色、時空線索)的相似度將行人軌跡關聯起來.而如何提取行人特征以及如何進行特征相似度度量就是行人重識別需要解決的核心問題,也可以合稱為行人跨攝像頭檢索.因此行人重識別被研究者從MTMC 跟蹤問題里抽取出來,作為一個獨立的研究課題.行人重識別領域知名學者鄭良博士在論文[3]中將行人重識別系統總結為行人檢測加上行人重識別,如圖1 所示.隨著深度學習的發展,行人檢測技術已逐漸成熟,本文不再做具體闡述.目前大部分數據集直接將檢測出來的行人圖片作為訓練集和測試集,并且剔除了一些遮擋較嚴重的低質量圖片.行人重識別技術將行人檢測結果作為先驗知識,直接對行人圖片進行跨攝像頭檢索.

圖1 行人重識別系統Fig.1 Person ReID system

行人重識別任務主要包含特征提取和相似度度量兩個步驟.傳統的方法思路為手工提取圖像特征,例如:顏色、HOG (Histogram of oriented gradient)[4]、SIFT (Scale invariant feature transform)[5]、LOMO (Local maximal occurrence)等.之后,利用XQDA (Cross-view quadratic discriminant analysis)[6]或者KISSME (Keep it simple and straightforward metric learning)[7]來學習最佳的相似度度量.然而,傳統的手工特征描述能力有限,很難適應復雜場景下的大數據量任務.并且,在數據量較大的情形下,傳統的度量學習方法求解也會變得非常困難.

近年來,以卷積神經網絡為代表的深度學習在計算機視覺領域取得了極大的成功,在多項任務上都擊敗傳統的方法,甚至一定程度上超越了人類的水平[8?9].在行人重識別問題上,基于深度學習的方法可以自動學習出復雜的特征描述,并且用簡單的歐氏距離進行相似度度量便可以取得很好的性能.換句話說,深度學習可以端對端地實現行人重識別任務,這使得任務變得更加簡單.目前,基于深度學習的行人重識別方法已經在性能上大大超越了傳統的方法.這些優勢使得深度學習在行人重識別領域變得流行,大量相關研究工作發表在高水平的會議或者期刊上,行人重識別的研究也進入了一個新的階段.

2 相關數據集介紹

由于CNN 網絡的訓練依賴大量訓練數據,所以行人重識別研究從傳統的手工特征(Hand-crafted feature)方法發展為如今深度學習自提特征的方法,離不開大規模數據集的發展.近年來,涌現出了越來越多的大規模行人重識別數據集,數據集特點也各自不同,這也反映了該領域蓬勃的發展趨勢和巨大的現實需求.

目前常用于深度學習方法的行人重識別數據集有:

1)VIPeR[10]數據集是早期的一個小型行人重識別數據集,圖像來自2 個攝像頭.該數據集總共包含632 個行人的1 264 張圖片,每個行人有兩張不同攝像頭拍攝的圖片.數據集隨機分為相等的兩部分,一部分作為訓練集,一部分作為測試集.由于采集時間較早,該數據集的圖像分辨率非常低,所以識別難度較大.

2)PRID2011[11]是2011 年提出的一個數據集,圖像來自于2 個不同的攝像頭.該數據集總共包含934 個行人的24 541 張行人圖片,所有的檢測框都是人工手動提取.圖像大小的分辨率統一為128×64的分辨率.

3)CUHK03[12]在中國香港中文大學采集,圖像來自2 個不同的攝像頭.該數據集提供機器自動檢測和手動檢測兩個數據集.其中檢測數據集包含一些檢測誤差,更接近實際情況.數據集總共包括1 467 個行人的14 097 張圖片,平均每個人有9.6 張訓練數據.

4)Market1501[13]是在清華大學校園中采集的數據集,圖像來自6 個不同的攝像頭,其中有一個攝像頭為低分辨率.同時該數據集提供訓練集和測試集.訓練集包含12 936 張圖像,測試集包含19 732張圖像.圖像由檢測器自動檢測并切割,所以包含一些檢測誤差(接近實際使用情況).訓練數據中一共有751 人,測試集中有750 人.所以在訓練集中,平均每類(每個人)有17.2 張訓練數據.

5)CUHK-SYSU[14]是中國香港中文大學和中山大學一起收集的數據集.該數據集的特點是提供整個完整的圖片,而不像其他大部分數據集一樣只提供自動或者手動提取邊框(Bounding box)的行人圖片,圖片來源于電影和電視.該數據集總共包括18 184 張完整圖片,內含8 432 個行人的99 809張行人圖片.其中訓練集有11 206 張完整圖片,包含5 532 個行人.測試集有6 978 張完整圖片,包含2 900 個行人.

6)MARS[15]數據集是Market1501 的擴展.該數據集的圖像由檢測器自動切割,包含了行人圖像的整個跟蹤序列(Tracklet).MARS 總共提供1 261個行人的20 715 個圖像序列,和Market1501 一樣來自同樣的6 個攝像頭.和其他單幀圖像數據集不一樣的地方是,MARS 是提供序列信息的大規模行人重識別數據集.需要特別注意的是,MARS 和Market1501 的訓練集和測試集存在重疊,因此不能夠混在一起訓練網絡.

7)DukeMTMC-reID[16]在杜克大學內采集,圖像來自8 個不同攝像頭,行人圖像的邊框由人工標注完成.該數據集提供訓練集和測試集.訓練集包含16 522 張圖像,測試集包含17 661 張圖像.訓練數據中一共有702 人,平均每個人有23.5 張訓練數據.該數據集是ICCV2017 會議之前最大的行人重識別數據集,并且提供了行人屬性(性別/長短袖/是否背包等)的標注.

除了以上幾個已經開源的常用數據集以外,目前還有幾個比較新的數據集,其中比較典型的有:1)中山大學采集的紅外ReID 數據集SYSUMM01[17],可以實現夜間的行人重識別.2)北京航空航天大學等采集的LPW 數據集[18],包含2 731個行人的7 694 個軌跡序列,總共有56 萬多張圖片,該數據集的特點是有多個獨立的場景,每個場景都可以作為一個獨立的數據集,訓練集和測試集按照場景分開,因此更加接近真實使用情況.3)北京大學采集的MSMT17 數據集[19],包含室內室外15 個相機的12 萬多張行人圖片,有4 千多個行人ID,是目前最大的單幀ReID 數據集.4)北京大學和微軟研究院聯合采集的LVreID 數據集[20],包含室內室外15 個相機的3 千多個行人ID 的序列圖片,總共14 943 個序列的3 百多萬張圖片,尚未開放下載鏈接.

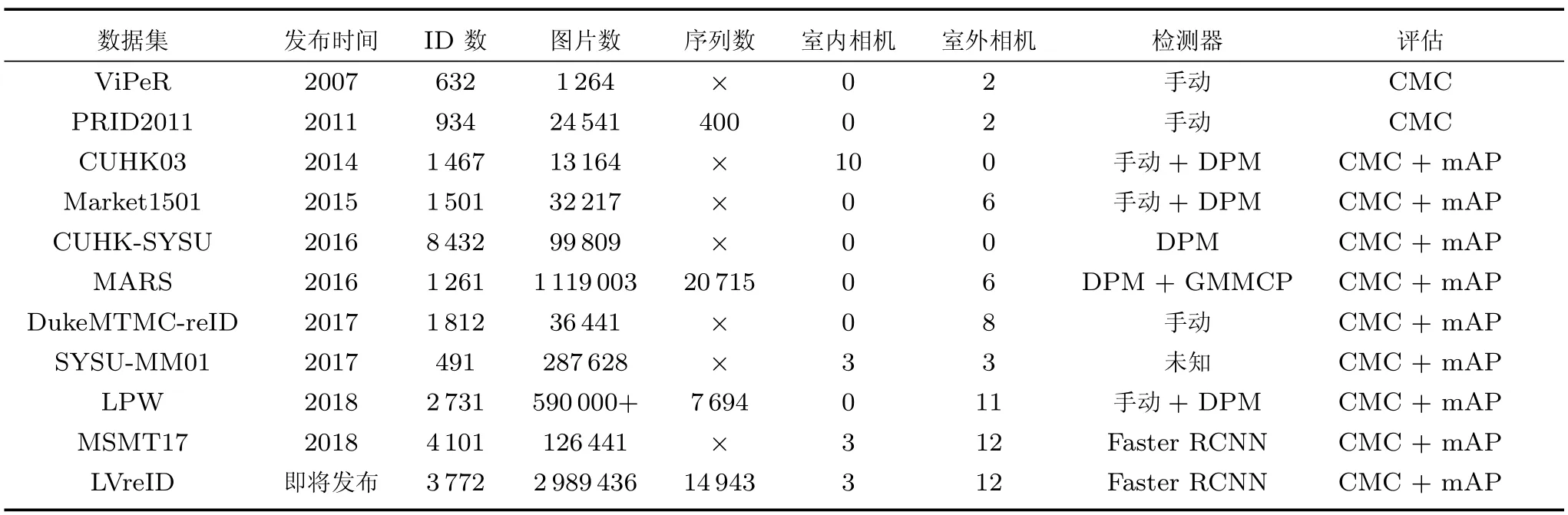

以上數據集的細節可以在表1 中查閱,其中大部分數據集使用DPM (Deformable part-based model)或者手動標注的方法[21]檢測行人,兩個還未開放下載的同源數據集MSMT17 和LVreID 使用了最新的Faster RCNN 檢測器[22],MARS 在提取序列的時候還輔助了GMMCP (Generalized maximum multi clique problem)跟蹤器[23].幾乎目前主流的數據集都使用累計匹配(Cumulative match characteristics,CMC)曲線和平均準確度(Mean average precision,mAP)評估.由于ReID 的數據集數目繁多,本文也只能列舉一些比較常用的典型數據集,更多數據集的信息可以查閱文獻[24].

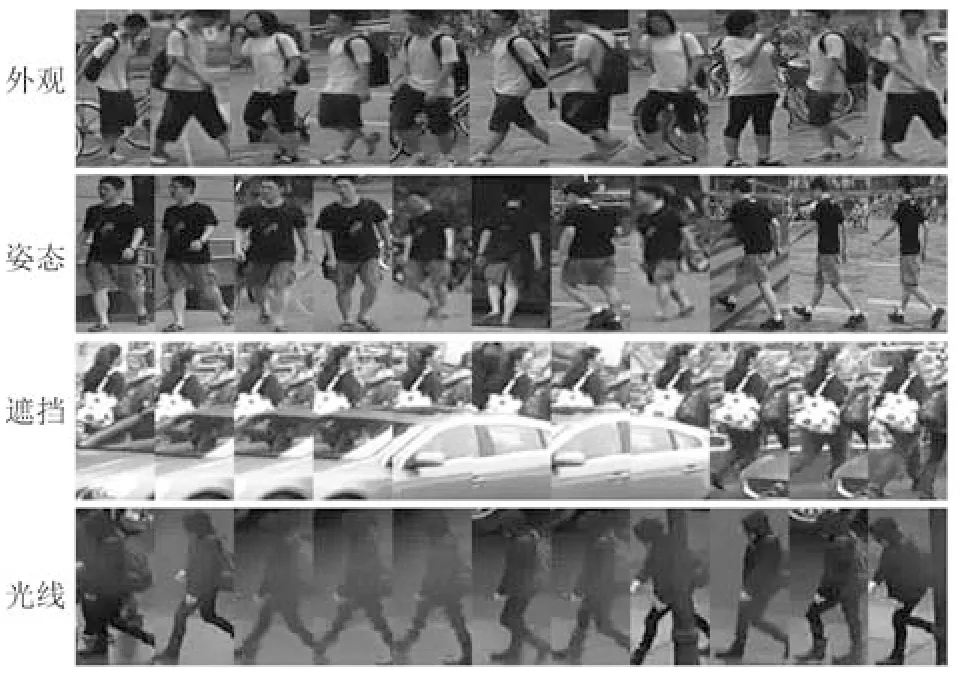

圖2 展示了一些行人重識別數據集的圖片,從圖中可以看出,行人重識別是一個非常有挑戰性的問題.其中最主要的難點有:不同行人之間的外觀可能高度相似,而相同的行人在不同的時空下姿態也可能不同,行人主體遭遇遮擋以及不同相機拍攝的光線條件差異等.這些難點也使得行人重識別和一般的圖像檢索問題有所不同,目前深度學習的方法除了擴大訓練數據和改善網絡結構以外,也會針對于這些難點設計專用于ReID 任務的算法.

表1 典型行人重識別數據集Table 1 Typical ReID datasets

圖2 行人重識別數據集圖片及難點示例Fig.2 The examples of images and challenge of person ReID datasets

3 行人重識別深度學習方法

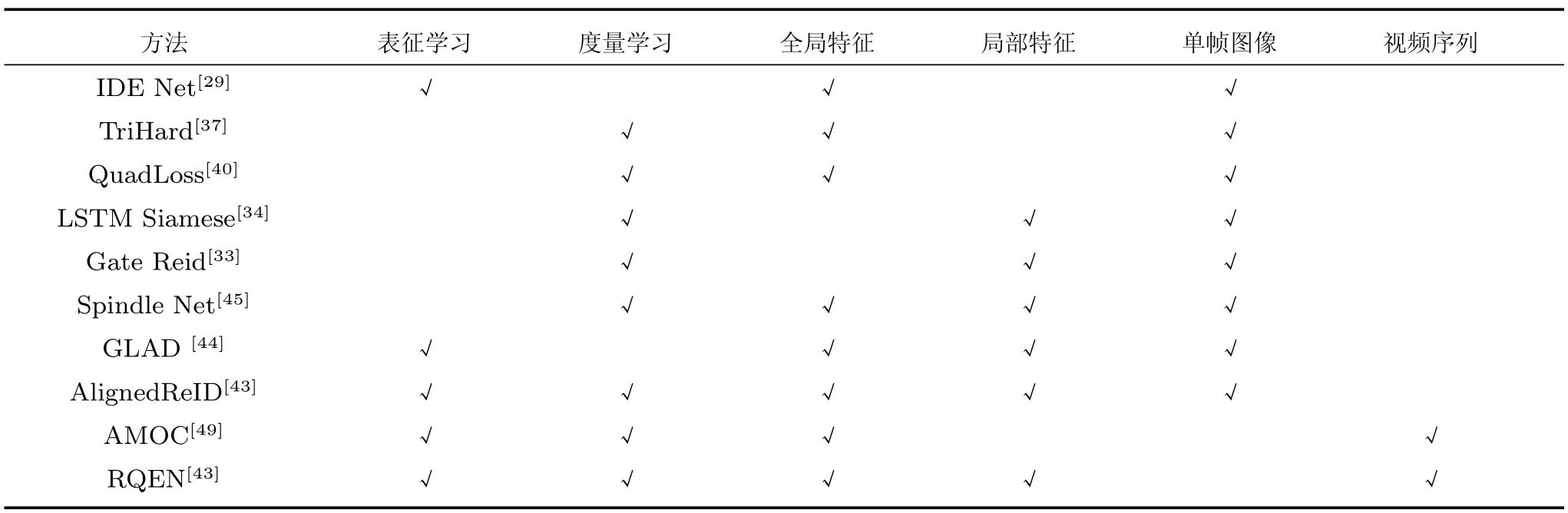

本小節總結概述基于深度學習的行人重識別方法.該類方法根據訓練損失可以分為基于表征學習和度量學習,根據特征是否考慮局部特征可以分為基于全局特征和基于局部特征,根據數據不同可以分為基于單幀圖像和基于視頻序列的方法.此外,還有一類基于GAN 的方法利用GAN 生成數據來解決一些行人重識別的難點.在本小節的最后,我們還總結概述了一下這些方法的優缺點以及如何結合這些方法來實現一個更好的行人重識別算法.

3.1 基于表征學習的方法

基于表征學習(Representation learning)的方法是一類非常常用的行人重識別方法[3,25?31].雖然行人重識別的最終目標是為了學習出兩張圖片之間的相似度,但是表征學習的方法并沒有直接在訓練網絡的時候考慮圖片間的相似度,而把行人重識別任務當做分類(Classification)問題或者驗證(Verification)問題來看待.這類方法的特點就是網絡的最后一層全連接(Fully connected,FC)層輸出的并不是最終使用的圖像特征向量,而是經過一個Softmax 激活函數來計算表征學習損失,前一層(倒數第二層)FC 層通常為特征向量層.具體言之,分類問題是指利用行人的ID 或者屬性等作為訓練標簽來訓練模型,每次只需要輸入一張圖片;驗證問題是指輸入一對(兩張)行人圖片,讓網絡來學習這兩張圖片是否屬于同一個行人.

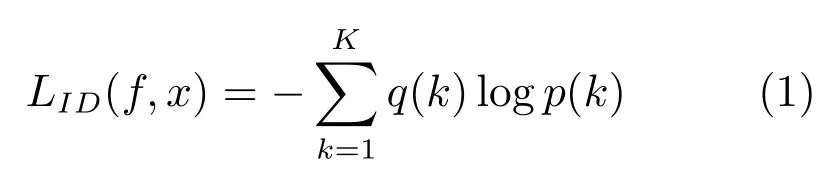

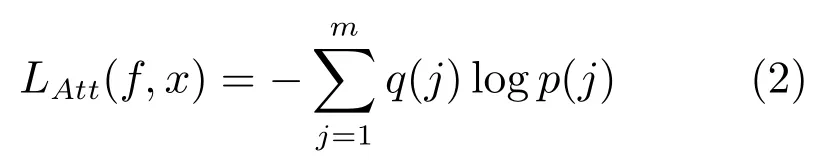

分類網絡常用的兩種損失分別是行人ID 損失(Identification loss)和屬性損失(Attribute loss).文獻[3,29]將每一個行人當做分類問題的一個類別,用行人的ID 作為訓練數據的標簽來訓練CNN網絡,這個網絡損失被稱為ID 損失,而這種網絡被稱為IDE (ID embedding)網絡.IDE 網絡是行人重識別領域非常重要的baseline 基準.假設訓練集擁有K個行人的n張圖片,將圖片x輸入IDE 網絡f,網絡最后一層輸出該圖片的ID 預測向量z[z1,z2,···,zk]RK.因此,圖片x屬于第k(1,2,3,···,K)個行人ID 的概率為為了方便描述,本文此后忽略k和x的相關性,默認用p(k)來代表p(k|x).于是IDE 網絡的ID 損失為:

其中q(k)通過圖片x的ID 標簽得到,若圖片x的ID 標簽為y,則q(k)1,yk,而對于任何的都有q(k)0.

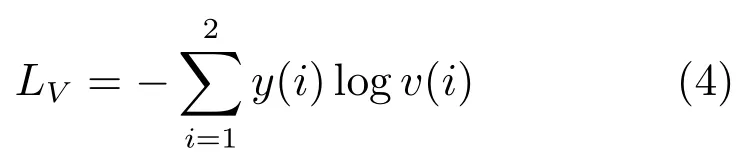

后來部分研究者認為,光靠行人的ID 信息不足以學習出一個泛化能力足夠強的模型.因此,他們利用了額外標注的行人圖片的屬性信息,例如性別、頭發、衣著等屬性,通過引入行人屬性標簽計算屬性損失.訓練好的網絡不但要準確地預測出行人ID,還要預測出各項行人屬性,這大大增加了網絡的泛化能力,多數論文也顯示這種方法是有效的[3,26?27].圖3 是其中一個示例,從圖中可以看出,網絡輸出的特征后面引出兩個分支.一個分支用于計算ID 損失LID,此分支和上文一致;另一個分支用于計算屬性損失LAtt.假設圖片x有M個屬性標注,我們針對于其中每一個屬性計算一個損失.若某個屬性共有m種類型,類似地我們可以計算圖片x屬于第j(j1,2,3,···,m)的概率為了方便描述同樣記作為p(j).因此該屬性的屬性損失為:

同理,q(j)是根據圖片x的該屬性標注ym得到,若ymj,則q(j)1,而對于任何的ymj都有q(j)0.最終網絡的總損失由ID 損失和M個屬性損失組成,即:

其中,λ是平衡兩個損失的權重因子,是第i個屬性的損失值.該網絡提取的圖像特征不僅用于預測行人的ID 信息,還用于預測各項行人屬性.通過結合ID 損失和屬性損失能夠提高網絡的泛化能力.

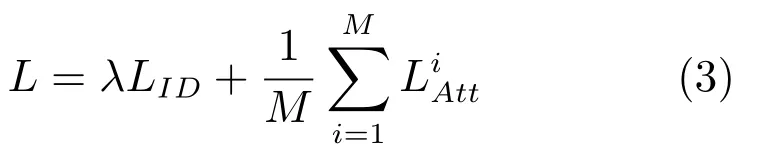

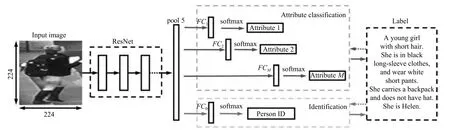

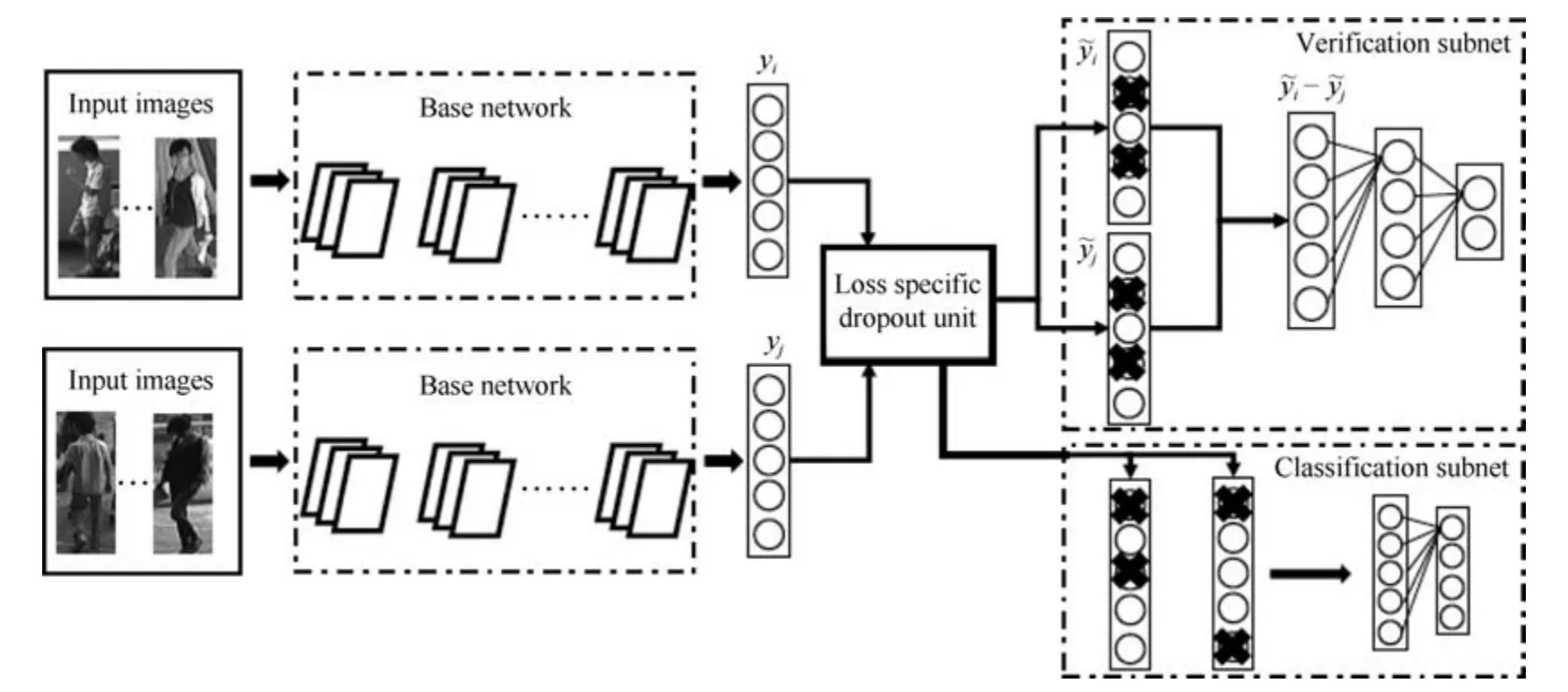

驗證網絡是另外一種常用于行人重識別任務的表征學習方法[25,31].和分類網絡不同之處在于,驗證網絡每次需要輸入兩張圖片,這兩張圖片經過一個共享的CNN 網絡,將網絡輸出的兩個特征向量融合起來輸入到一個只有兩個神經元的FC 層,來預測這兩幅圖片是否屬于同一個行人.因此,驗證網絡本質上是一個多輸入單輸出的二分類網絡.通常,僅僅使用驗證損失訓練網絡是非常低效的,所以驗證損失會與ID 損失一起使用來訓練網絡.圖4 是一個使用融合驗證損失和ID 損失的行人重識別網絡.網絡輸入為若干對行人圖片,包括分類子網絡(Classification subnet)和驗證子網絡(Verification subnet).分類子網絡對圖片進行ID 預測,根據預測的ID 來計算ID 損失LID,這部分和前文一致.驗證子網絡融合兩張圖片的特征,判斷這兩張圖片是否屬于同一個行人,該子網絡實質上等于一個二分類網絡.假設網絡輸入一對圖像對X{xa,xb},他們的ID 標簽分別為ya和yb.網絡輸出一個2 維的向量v,則驗證損失為:

若yayb則y{1,0},反之若yayb則y{0,1}.最終網絡的總損失為LLID+LV.經過足夠數據的訓練,在推理階段再次輸入一張測試圖片,網絡將自動提取出一個特征,這個特征用于行人重識別任務.

3.2 基于度量學習的方法

度量學習(Metric learning)是廣泛用于圖像檢索領域的一種方法.不同于表征學習,度量學習旨在通過網絡學習出兩張圖片的相似度.在行人重識別問題上,表現為同一行人的不同圖片間的相似度大于不同行人的不同圖片.具體為,定義一個映射f(x):RF →RD,將圖片從原始域映射到特征域,之后再定義一個距離度量函數D(x,y):RD×RD →R,來計算兩個特征向量之間的距離.最后通過最小化網絡的度量損失,來尋找一個最優的映射f(x),使得相同行人兩張圖片(正樣本對)的距離盡可能小,不同行人兩張圖片(負樣本對)的距離盡可能大.而這個映射f(x),就是我們訓練得到的深度卷積網絡.

圖3 結合ID 損失和屬性損失網絡示例[26]Fig.3 The example network with identification loss and attribute loss[26]

圖4 結合驗證損失和ID 損失網絡示例[25]Fig.4 The example network with verification loss and identification loss[25]

為了實現端對端訓練,如今深度度量學習方法和傳統的度量學習方法相比已經有所變化.關于包含XQDA、KISSME 等在內的傳統度量學習方法到深度學習度量方法的過渡與集成時期的研究,可以查閱論文[32].本文著重討論近幾年基于深度學習的度量學習方法研究.

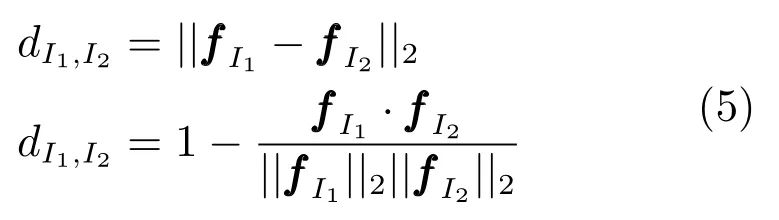

常用的度量學習損失方法包括對比損失(Contrastive loss)[33?35]、三元組損失(Triplet loss)[36?39]、四元組損失(Quadruplet loss)[40].首先,假如有兩張輸入圖片I1和I2,通過網絡的前向傳播我們可以得到它們(歸一化后)的特征向量和之后我們需要定義一個距離度量函數,這個函數并不唯一,只要能夠在特征空間描述特征向量的相似度/差異度的函數均可以作為距離度量函數.然而,為了實現端對端(End-to-end)訓練的網絡,度量函數盡可能連續可導,通常我們使用特征的歐氏距離或者余弦距離作為度量函數,即兩張圖片在特征空間的距離定義為:

當然曼哈頓距離、漢明距離、馬氏距離等距離也可以作為度量學習的距離度量函數,本文對此不做過多討論.

對比損失用于訓練孿生網絡(Siamese network).孿生網絡的輸入為一對(兩張)圖片Ia和Ib,這兩張圖片可以為同一行人,也可以為不同行人.每一對訓練圖片都有一個標簽y,其中y1 表示兩張圖片屬于同一個行人(正樣本對),反之y0 表示它們屬于不同行人(負樣本對).之后,對比損失函數寫作:

其中,(z)+max(z,0),α是根據實際需求設置的訓練閾值參數.

三元組損失是一種被廣泛應用的度量學習損失,之后的大量度量學習方法也是基于三元組損失演變而來.顧名思義,三元組損失需要三張輸入圖片.和對比損失不同,一個輸入的三元組(Triplet)包括一對正樣本對和一對負樣本對.三張圖片分別命名為固定圖片(Anchor)a,正樣本圖片(Positive)p和負樣本圖片(Negative)n.圖片a和圖片p為一對正樣本對,圖片a和圖片n為一對負樣本對.則三元組損失表示為:

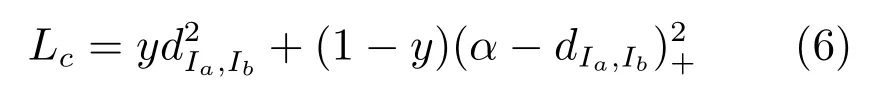

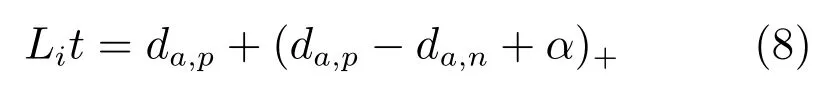

文獻[36]認為式(7)只考慮正負樣本對之間的相對距離,而并沒有考慮正樣本對之間的絕對距離,為此提出改進三元組損失(Improved triplet loss):

式(8)添加da,p項,保證網絡不僅能夠在特征空間把正負樣本推開,也能保證正樣本對之間的距離很近.

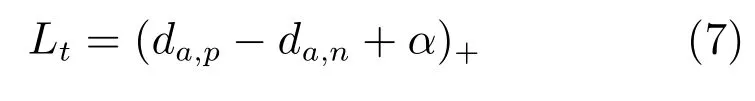

四元組損失是三元組損失的另一個改進版本.顧名思義,四元組(Quadruplet)需要四張輸入圖片,和三元組不同的是多了一張負樣本圖片.即四張圖片為固定圖片a,正樣本圖片p,負樣本圖片1n1 和負樣本圖片2n2.其中n1 和n2 是兩張不同行人ID 的圖片.則四元組損失表示為:

其中,α和β是手動設置的正常數,通常設置β小于α,前一項稱為強推動,后一項稱為弱推動.其中前一項和三元組損失一樣,只考慮正負樣本間的相對距離,共享了固定圖片a.因此在推開負樣本對a和n1 的同時,也會直接影響a的特征,造成正樣本對a和p的距離不好控制.改進三元組損失通過直接約束a和p之間的距離來解決這個問題.而四元組通過引入第二項弱推動實現,添加的第二項中負樣本對和正樣本對不共享ID,所以考慮的是正負樣本間的絕對距離,在推開負樣本對的同時不會太過直接影響a的特征.因此,四元組損失通常能讓模型學習到更好的表征.

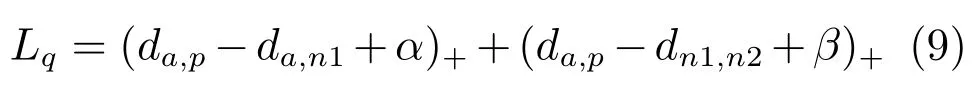

以上度量學習方法樣本示例如圖5 所示,這些方法在計算度量損失時,樣本對都是從訓練集中隨機挑選.隨機挑選樣本對的方法可能經常挑選出一些容易識別的樣本對組成訓練批量(Batch),使得網絡泛化能力受限.為此,部分學者提出了難樣本采樣(Hard sample mining)的方法,來挑選出難樣本對訓練網絡[37,41].常用的思路是挑選出一個訓練Batch 中特征向量距離比較大(非常不像)的正樣本對和特征向量距離比較小(非常像)的負樣本對來訓練網絡.難樣本采樣技術可以明顯改進度量學習方法的性能,加快網絡的收斂,并且可以很方便地在原有度量學習方法上進行擴展,是目前廣泛采用的一種技術.

度量學習可以近似看作為樣本在特征空間進行聚類,表征學習可以近似看作為學習樣本在特征空間的分界面.正樣本距離拉近的過程使得類內距離縮小,負樣本距離推開的過程使得類間距離增大,最終收斂時樣本在特征空間呈現聚類效應.度量學習和表征學習相比,優勢在于網絡末尾不需要接一個分類的全連接層,因此對于訓練集的行人ID 數量并不敏感,可以應用于訓練超大規模數據集的網絡.總體而言,度量學習比表征學習使用的更加廣泛,性能表現也略微優于表征學習.但是目前行人重識別的數據集規模還依然有限,表征學習的方法也依然得到使用,而同時融合度量學習和表征學習訓練網絡的思路也在逐漸變得流行.

圖5 度量學習方法樣本符號示例圖Fig.5 Thelabel of metric learning

3.3 基于局部特征的方法

從網絡的訓練損失函數上進行分類可以分成表征學習和度量學習,相關方法前文已經介紹.另一個角度,從抽取圖像特征進行分類,行人重識別的方法可以分為基于全局特征(Global feature)和基于局部特征(Local feature)的方法.全局特征比較簡單,是指讓網絡對整幅圖像提取一個特征,這個特征不考慮一些局部信息.正常的卷積網絡提取的都是全局特征,因此在此不做贅述.然而,隨著行人數據集越來越復雜,僅僅使用全局特征并不能達到性能要求,因此提取更加復雜的局部特征成為一個研究熱點.局部特征是指手動或者自動地讓網絡去關注關鍵的局部區域,然后提取這些區域的局部特征.常用的提取局部特征的思路主要有圖像切塊、利用骨架關鍵點定位以及行人前景分割等.

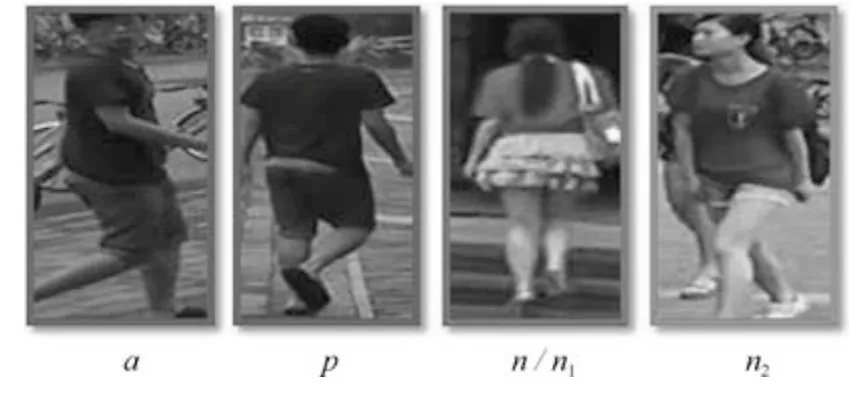

圖片切塊是一種很常見的提取局部特征方式[34,42?43].因為人體結構的特殊性,通常研究者會將圖片從上到下均分為幾等份(頭部、上身、腿部等).圖6 是圖片切塊的一個典型示例,網絡采用的是經典的孿生網絡,損失函數為度量學習的對比損失,輸入的兩幅圖片均分為若干等分.之后,被分割好的若干塊圖像塊按照順序送到一個長短時記憶網絡(Long short term memory network,LSTM),最后的特征融合了所有圖像塊的局部特征.圖片切換方法的缺點在于對圖像對齊的要求比較高,如果兩幅圖像沒有上下對齊,那么很可能出現頭和上身對比的現象,反而使得模型判斷錯誤.因此Zhang 等設計了一種動態對齊網絡AlignedReID[43],可以在不需要額外信息的情況下實現圖片塊從上到下的自動對準.

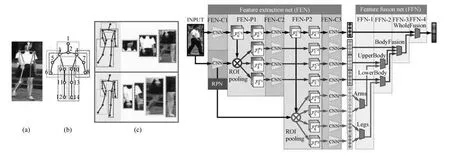

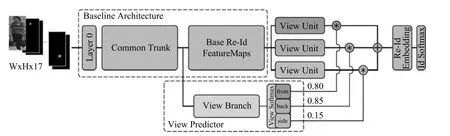

利用人體姿態關鍵點進行局部特征對齊是另外一種常見的方法[44?46].一些論文利用一些先驗知識先將行人進行對齊,這些先驗知識主要是預訓練的人體姿態(Pose)和骨架關鍵點模型.其中,CVPR17 的Spindle Net[45]是該類方法的一個典型代表.Spindle Net 網絡如圖7 所示,首先通過骨架關鍵點提取的網絡提取14 個人體關鍵點,之后利用這些關鍵點提取7 個人體結構ROI.這7 個ROI 區域和原始圖片進入同一個CNN 網絡提取特征.原始圖片經過完整的CNN 得到一個全局特征,三個大區域經過FEN-C2 和FEN-C3 子網絡得到三個局部特征,四個四肢區域經過FEN-C3 子網絡得到四個局部特征.之后這8 個特征按照圖示的方式在不同的尺度進行聯結,最終得到一個融合全局特征和多個尺度局部特征的行人重識別特征.

與Spindle Net 不同,論文[46]先用姿態估計的模型估計出行人的關鍵點,然后用仿射變換使得相同的關鍵點對齊.論文[44]提出了一種全局–局部對齊特征描述子(Global-local-alignment descriptor,GLAD).GLAD 利用提取的人體關鍵點把圖片分為頭部、上身和下身三個部分.之后將整圖和三個局部圖片一起輸入到一個參數共享CNN網絡中,最后提取的特征融合了全局和局部的特征.為了適應不同分辨率大小的圖片輸入,網絡利用全局平均池化(Global average pooling,GAP)來提取各自的特征.和Spindle net 略微不同的是四個輸入圖片各自計算對應的損失,而不是融合為一個特征計算一個總的損失.

圖6 利用圖片切塊提取局部特征示例[34]Fig.6 The example of extracting local features with image blocks[34]

圖7 利用姿態點提取局部特征示例[45]Fig.7 The example of extracting local features with pose points[45]

行人的局部特征在最近逐漸被證明是一種有效的特征,可以一定程度上解決行人姿態多樣化的問題.因此,融合全局和局部特征在行人重識別領域也漸漸變得流行,圖片切塊的方法簡單但是需要圖片比較規范化,利用姿態點信息比較精確但是需要額外的姿態估計模型.高效且低耗的局部特征提取模型依然是該領域一個值得研究的切入點.

3.4 基于視頻序列的方法

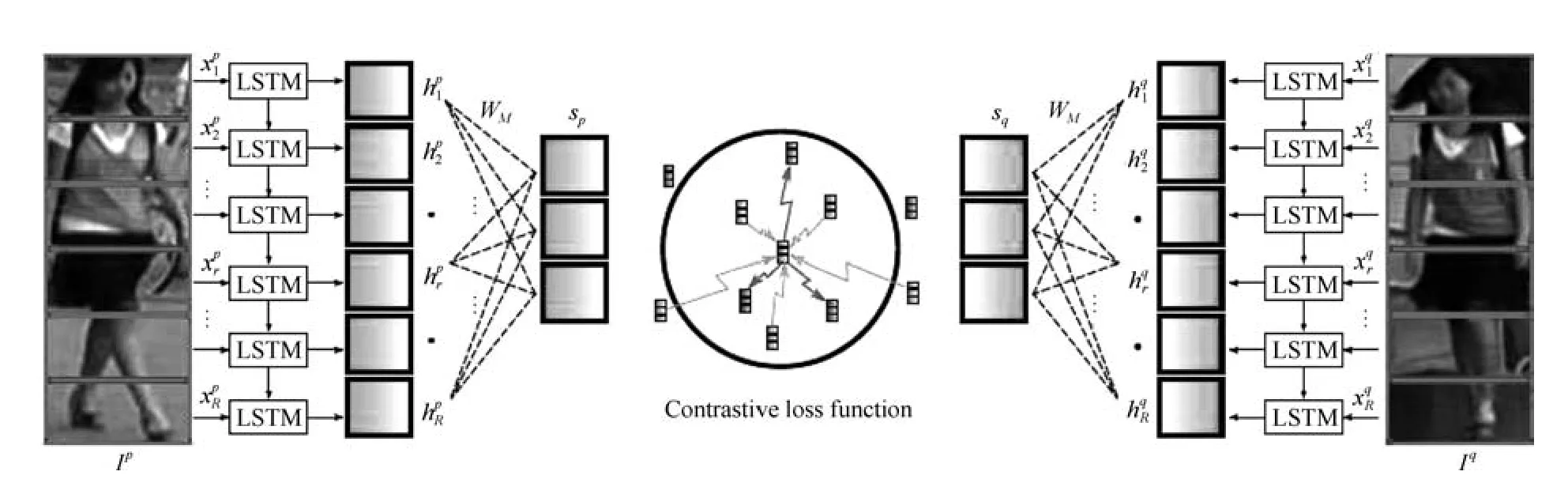

目前主流的行人重識別方法大部分是基于單幀圖像的,然而單幀圖像給予的信息終究是有限的.此外,單幀的方法要求圖像質量很高,這對于相機的布置和使用的場景是一個非常大的限制,因此研究基于序列的方法便顯得十分重要.基于單幀圖像的ReID 方法可以通過一個簡單方法擴展到視頻序列,即用所有序列圖像特征向量的平均池化或者最大池化作為該序列的最終特征.但是仍然有很多工作在研究如何更好地利用視頻序列來進行行人重識別[47?58].這類方法除了考慮了圖像的內容信息,還會考慮:1)幀與幀之間的運動信息;2)更好的特征融合;3)對圖像幀進行質量判斷等.總體來說,基于序列的方法核心思想為通過融合更多的信息來解決圖像噪聲較大、背景復雜等一系列質量不佳的問題.本節將會著重介紹幾個典型方法,以點帶面的形式來總結該類方法.

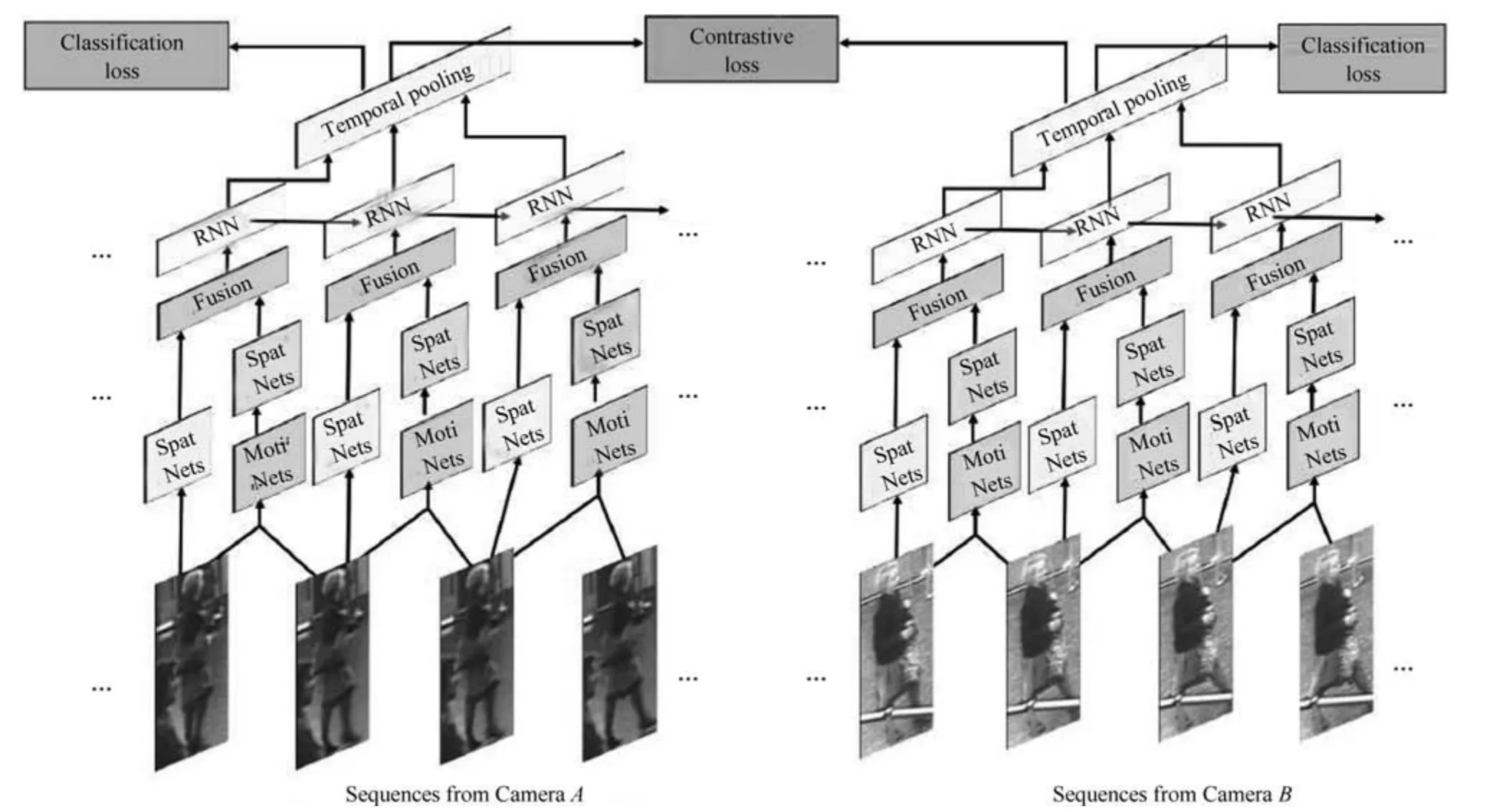

融合圖像內容信息和運動信息是一種常見的思路,因為運動信息里面可能包含了步態等信息輔助識別任務,最早的序列類方法的關注點就在于運動信息上[49,51,56].主要思想是利用CNN 來提取空間特征的同時利用遞歸循環網絡(Recurrent neural networks,RNN)來提取時序(運動)特征.典型代表是累計運動背景網絡(Accumulative motion context network,AMOC)[49].AMOC 的輸入包括原始的圖像序列和提取的光流序列(運動特征).其核心思想在于網絡除了要提取序列圖像的特征,還要提取運動光流的運動特征,其網絡結構圖如圖8所示.AMOC 擁有空間信息網絡(Spatial network,Spat Nets)和運動信息網絡(Motion network,Moti Nets)兩個子網絡.圖像序列的每一幀圖像都被輸入到Spat Nets 來提取圖像的全局內容特征.而相鄰的兩幀將會送到Moti Nets 來提取光流圖特征.之后空間特征和光流特征融合后輸入到一個RNN來提取時序特征.通過AMOC 網絡,每個圖像序列都能被提取出一個融合了內容信息、運動信息的特征.網絡采用了分類損失和對比損失來訓練模型.融合了運動信息的序列圖像特征能夠提高行人重識別的準確度.

序列圖像每一幀都可以提取一個特征,通常每一幀貢獻的信息是不同的,因此如何更好地融合每一幀的特征也是一個研究熱點[47?48].該類方法的一個代表工作是DFGP (Deep feature guided pooling)[48].DFGP 先用一個深度學習模型對每一幀提取一個深度特征,之后用平均池化得到序列圖像的平均特征,這與大部分工作一致.之后DFGP 提出一個最穩定幀算法(Maximally stable video frame,MSVF).MSVF 通過計算每一幀圖像特征與平均特征之間的距離,挑出距離最小的那一幀為該序列的最穩定幀.如果某一幀與最穩定幀越接近,則被賦予權重越大.實現方式為計算每一幀的特征與最穩定幀特征的距離,距離越近權重最大,只要滿足所有幀的權重和為1 即可.DFGP 是一種手動實現特征融合的方法,當前另一種流行的思路是利用深度學習的注意力機制,來自動地給每一幀圖像賦予一個權重[47].當然這個權重是由網絡自動學習出來,解釋性不如手動提取方法.

圖8 融合內容信息和運動信息的AMOC 網絡[49]Fig.8 The AMOC network which fusions context information and motion information[49]

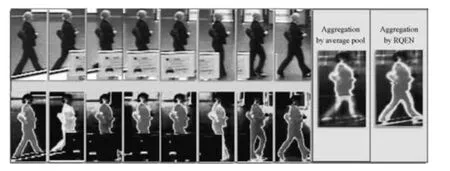

序列方法另外一個思路就是對圖像幀進行質量判斷,往往序列中并不是每一幀圖像都是完整的高質量圖像,遮擋、姿態、分辨率等因素都是可能造成圖像不佳的因素.因此保留更多的高質量圖像的特征便顯得比較重要,RQEN (Region-based quality estimation network)就是一個對遮擋圖像進行質量判斷的工作[18].RQEN 認為在遮擋較嚴重的情況下,如果用一般的平均池化會造成遮擋區域的特征丟失很多.而RQEN 以姿態估計點為先驗知識,對每幀進行一個質量判斷,姿態完整的圖像被認為是高質量的圖像,反之姿態不完整的圖像即存在遮擋的圖像是低質量的圖像.將這個先驗結果輸入到網絡,誘導網絡學習更多高質量圖像幀的信息,給高質量圖像幀打上高權重,然后對特征圖進行一個線性疊加.圖9 顯示了平均池化和RQEN 方法的注意力圖,可以看出在存在遮擋的情況下,平均池化在遮擋區域會丟失很多信息,而融合質量判斷的RQEN 網絡依然可以得到較好的結果.

基于視頻序列的行人重識別技術是該領域未來急需解決的一個問題.總體而言,和單幀方法相比,序列方法無論是從思路的多樣性上,還是從結果性能上,都還存在一定的差距.

圖9 RQEN 與平均池化注意力圖對比[18]Fig.9 The attention maps of RQEN and average pooling[18]

3.5 基于GAN 的方法

GAN 在近幾年得到了蓬勃的發展,其中一個應用就是圖片生成.深度學習的方法需要依賴大量訓練數據,而目前行人重識別的數據集總體來說規模還是比較小.因此,利用GAN 來做行人重識別任務逐漸開始變得流行.傳統的GAN 生成圖片是隨機的,后來發表的CycleGAN[59]、DualGAN[60]和DiscoGAN[61]實現了圖片風格的轉換,進一步地促進了GAN 在行人重識別領域的應用.

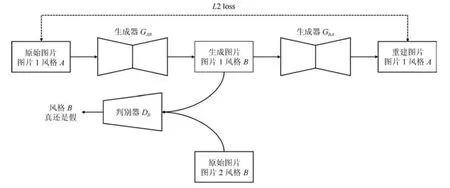

第一篇引入GAN 做ReID 的論文[19]發表在ICCV17 會議上,論文使用傳統的GAN 隨機生成行人圖片,因此生成的圖片是不可控的,僅僅作為IDE 網絡訓練數據的增廣,提高IDE 網絡的性能.為了解決這個問題,一些文獻[19,62?65]使用(改進的)CycleGAN 來進行兩個域的行人圖片轉換,從而減小圖片間的風格差異.雖然每個算法使用CycleGAN 的細節各自不同,但是流程可以統一概括.圖10 顯示了利用CycleGAN 將圖片1 從風格A轉換為風格B的網絡訓練流程圖,網絡輸入兩張不同風格的圖片.生成器GAB將圖片從風格A轉化為風格B,而GBA將圖片從風格B轉化為風格A,判別器DB用來判斷生成圖片是否接近真實的風格B.圖10 只展示了CycleGAN 的從A →B風格轉換,實際的CycleGAN 是對稱結構,而B →A方向的轉換在此不做贅述.通過最小化判別損失和重建L2損失,CycleGAN 的生成器和判別器不斷對抗互相提高直至收斂.推理階段只需要給對應的生成器輸入一張圖片,便可以將圖片從一個風格轉換為另外一個風格.與傳統的GAN 網絡不同,CycleGAN 一個非常好的優點是生成的圖片保留了原始圖片的ID信息.

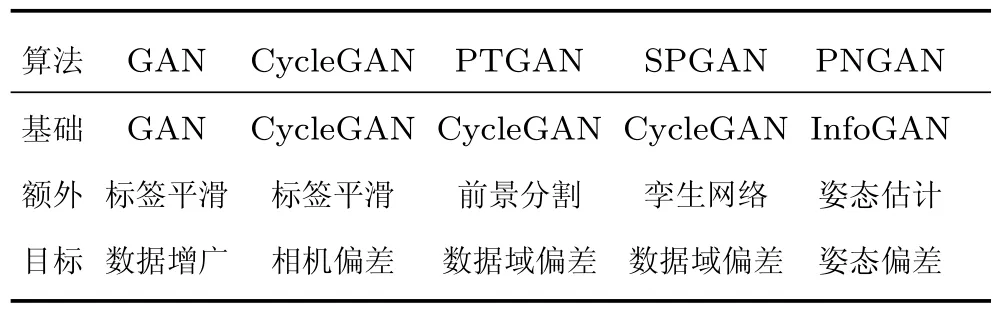

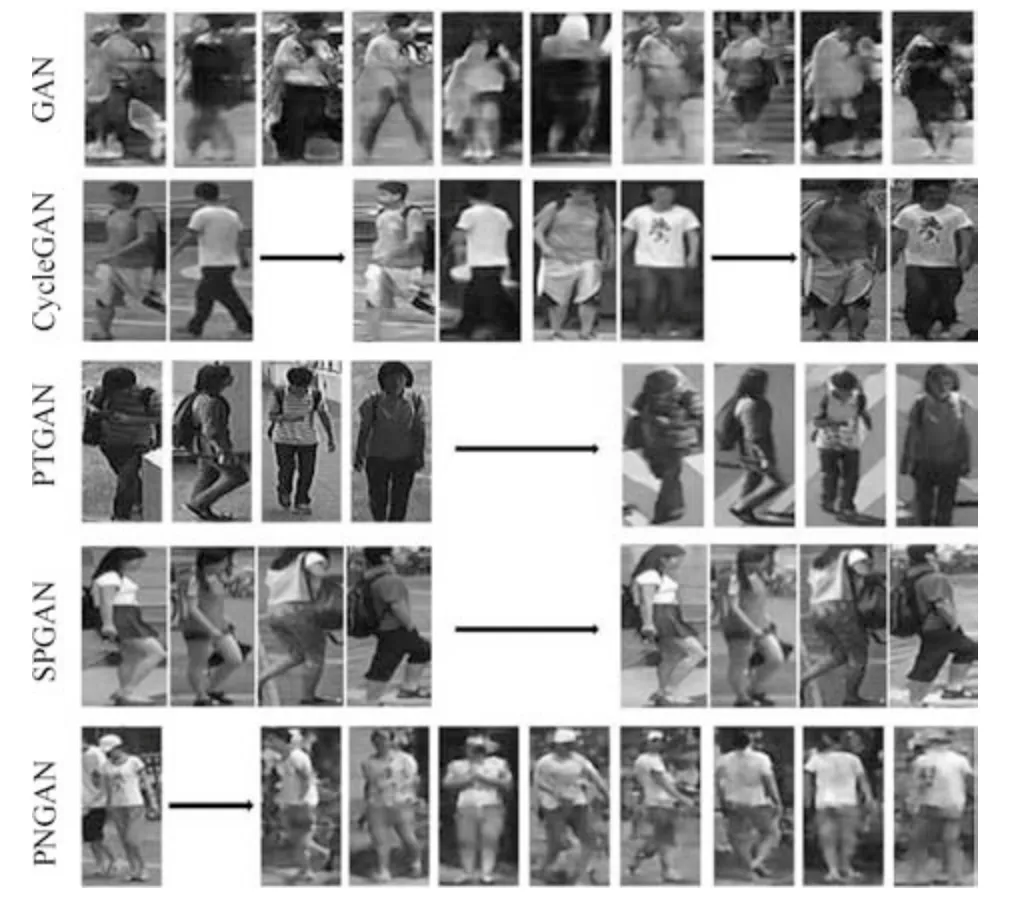

由于相機的光線、角度等可能不同,不同相機拍攝的圖片存在風格偏差,Zhong 等[65]使用CycleGAN 來實現相機風格的遷移,從而減小相機間的風格偏差.另外,由于不同數據集之間存在場景域之間的偏差,通常在一個數據集訓練的網絡在另外一個數據集上性能不會很好.PTGAN (Person transfer GAN)[19]和SPGAN (Similarity preserving GAN)[62]分別改進CycleGAN 來實現圖片數據域之間的轉換.PTGAN 主要思想為保持生成圖片的行人前景盡可能不變,而圖片背景為目標域的風格,因此采用一個前景分割網絡先把前景區域分割出來,在訓練網絡時加入前景約束,盡可能多地保護行人外觀信息.SPGAN 和PTGAN 類似,也是利用CycleGAN 實現數據集風格的轉換,與之不同的是SPGAN 將CycleGAN 與孿生網絡結合,生成圖片的同時加入了ReID 模型的約束,使之更加適應任務需求.PNGAN (Pose-normalization GAN)[64]是另外一篇非常典型的工作,行人重識別任務其中一個難點就是行人的姿態存在偏差,而PGNAN 的主要動機就是解決姿態偏差.為了實現行人姿態的遷移,PNGAN 將InfoGAN[66]和人體姿態點估計模型結合起來,加入了姿態點損失約束,使得生成圖片的行人姿態與期望姿態盡可能一致.之后為了消除姿態偏差,PNGAN 定義了8 個姿態模板,每一張行人圖片都轉化為8 張固定姿態的圖片,在進行重識別任務時融合這9 張圖片的特征,達到消除姿態偏差的目的.據我們所知,PNGAN 在Market1501和DukeMTMC-reID 數據集上達到了目前最高的Rank1 準確度.這些典型GAN 網絡生成的圖片如圖11 所示,根據目標的不同,GAN 網絡圖片生成的外觀細節和側重點也各自不同,這就是這一類方法的特點所在.

表2 基于GAN 網絡的方法比較Table 2 The comparison of GAN based methods

3.6 各方法總結比較

前文按照分類介紹一些基于深度學習的行人重識別方法,本節將對這些方法進行總結與比較.基于GAN 的方法更多是作為一種圖像增廣或者解決圖像域偏差的技術而較為獨立.

圖10 CycleGAN 進行圖片風格轉換流程圖(A →B)Fig.10 The pipeline of image style transfer using CycleGAN (A →B)

表3 基于深度學習的行人重識別方法總結比較Table 3 Comparison of deep learning based ReID methods

圖11 GAN 網絡生成行人圖片示例Fig.11 The examples of pedestrian images generated by GAN

從訓練深度網絡的角度,我們將從三個方面來分析:表征學習與度量學習、全局特征與局部特征、單幀圖像與視頻序列.如表3 所示,前文提到的代表算法所對應的類型都已標記出.有的方法只使用了一種類型的損失函數或者特征類型,而有的方法融合了多種損失函數或者特征類型來達到更高的性能水平.具體細節我們將在后文詳細討論.

3.6.1 基于表征學習與度量學習的方法

按照網絡訓練損失分類,行人重識別的方法可以分為表征學習和度量學習兩類.表征學習的優點在于數據集量不大的時候收斂容易,模型訓練魯棒性強,訓練時間短.然而表征學習是將每一個ID 的行人圖片當做一個類別,當ID 數量增加到百萬、千萬甚至更多的時候,網絡最后一層是一個維度非常高的全連接層,使得網絡參數量巨大并且收斂困難.由于直接計算特征之間的距離,度量學習的優點在于可以很方便地擴展到新的數據集,不需要根據ID數量來調整網絡的結構,此外也可以非常好地適應ID 數目巨大的訓練數據.然而,度量學習相對來說收斂困難,需要比較豐富的訓練經驗來調整網絡參數,另外收斂訓練時間也比表征學習要長.

表征學習和度量學習擁有各自的優缺點,目前學術界和工業界逐漸開始聯合兩種學習損失[18,43,49].聯合的方式也比較直接,在傳統度量學習方法的基礎上,在特征層后面再添加一個全連接層進行ID 分類學習.網絡同時優化表征學習損失和度量學習損失,來共同優化特征層.如圖8 所示,AMOC 同時聯合了ID 損失和對比損失,特征層之后分出了兩個分支分別優化表征學習損失和度量學習損失.

3.6.2 基于全局特征與局部特征的方法

按照網絡輸出特征類型,行人重識別方法可以分為基于全局特征與局部特征的方法.全局特征一般是卷積網絡的特征圖直接通過一個全局池化層得到,推理階段計算快速,適合于需要幀率較高的實際應用.然而由于全局池化層會使得圖像的空間特征信息丟失,因此在姿態不對齊、行人圖片不完整、只有局部細節不相似等情況下,全局特征容易出現誤識別.而局部特征的優點在于可以一定程度上解決這些問題,當然局部特征也有它自己的缺點.對于分塊的局部特征優點在于不需要引入額外的計算量,但是通常并不能特別好地解決姿態不對齊的問題.而利用姿態點估計模型估計出行人的姿態點,然后再進行局部特征匹配可以較好地解決姿態不對齊的問題,但是卻需要一個額外的姿態點模型.總體來說,全局特征和局部特征是兩個比較互補的特征類型,通常不會單獨使用局部特征.廣義上講,分塊局部特征把所有的分塊特征融合起來也包含了全局圖像信息.因此在不考慮推理階段計算耗時的前提下,融合全局特征和局部特征是目前一種提高網絡性能非常常用的手段.

目前融合全局特征和局部特征常用的思路是對于全局模塊和局部模塊分別提取特征,之后再將全局特征和局部特征拼接在一起作為最終的特征.如圖7 所示,Spindle net 就提取了全局特征和7 個不同尺度的局部特征,然后融合成最終的圖像特征用于進行最后的相似度度量.AlignedReID 給出了另外一種融合方法,即分別計算兩幅圖像全局特征距離和局部特征距離,然后加權求和作為最終兩幅圖像在特征空間的距離.RQEN 則是利用一個姿態點模型來估計行人的可視性部分,然后融合多幀信息得到一個較好的最終特征,也可以看作是一個全局特征和局部特征融合的過程.如何探究更好的全局特征和局部特征方法也是行人重識別未來一個重要的研究分支.

3.6.3 基于單幀圖像與視頻序列的方法

按照網絡輸入數據,行人重識別方法可以分為基于單幀圖像與視頻序列的方法.這兩類方法并沒有太多重合的地方,只是針對于不同的應用選擇不同類型的網絡輸入.基于單幀圖像的方法訓練簡單,使用方便,推理階段耗時時間短.然而它的缺點在于單幀圖像信息有限,對于圖像質量要求較高,一旦出現檢測框錯誤或者行人遮擋等情況,算法效果會大幅度下降.基于視頻序列的方法可以解決單幀圖像信息不足的缺點,并且可以融入運動信息加強魯棒性,然而由于每次要處理多張圖像,因此計算效率較低.當然基于視頻序列的方法大部分都是單幀圖像方法的擴展延伸,因此發展單幀圖像的方法對于發展視頻序列的方法也是有益的.

4 典型算法比較

本節我們通過比較一些典型算法的性能,來回顧一下近幾年行人重識別方法的發展趨勢.由于行人重識別相關數據集非常多,我們無法展示每個數據集的結果.考慮到算法的優劣一般與數據集相關性不是特別大,而多數論文都會在Market1501 上做評測,因此我們選擇Market1501 數據集作為示例數據集.

本文挑選了近幾年比較有代表性的十余種基于深度學習的行人重識別方法,首先挑選頂級會議上發表且在當時準確度較高的方法.然后根據第3 節挑選出準確度較高且方便歸類的預印版文獻方法.為了方便比較,我們還挑選了一個可以代表最高準確度的傳統方法和無監督學習方法作為參考基準.

表4 總結比較了這十余種深度學習方法的性能、基本網絡,并簡單描述了算法特性和發表狀況.行人重識別最主要的兩個性能指標是一選準確率(rank-1)和平均準確率(mAP).表格給出的結果均由論文中給出,一些代表性的算法沒有在Market1501 上進行評測因此沒有展示.除非算法本身是基于重排序的研究,否則本文默認都是使用歐氏距離的無重排序結果.為了方便比較,表格第一行給出了比較好的傳統方法的結果,作為傳統方法的基準.第二部分是強監督的深度學習方法,可以看出基準網絡里面ResNet50[69]、GoogleNet[70]和自定義的CNN 網絡使用較多,損失函數方面分類損失和度量損失均可以取得很好的性能.在已經發表的方法中,DML[28]、CamStyle[65]、GLAD[44]均取得了接近90.0% 的一選準確率.而在還未接受的預印版文獻里,AlignedReID[43]、PNGAN[64]已經超越了90.0% 的一選準確率,代表了目前行人重識別領域Market1501 數據集的最高準確度.在第三部分的無監督學習方法方面,大部分無監督學習方法都還是基于傳統特征的研究.而CVPR2018 剛接收的SPGAN[62]是比較具有代表性的基于深度學習的無監督行人重識別方法,同時在Market1501 數據集上也擊敗了目前已有的無監督學習方法.

總的看來,基于深度學習的行人重識別方法近幾年來發展迅速,每年以大概15% 的一選準確率速度在增長,并且各種方法百花齊放,并沒有哪種方法相比于其他方法存在巨大的優勢.而趨勢方面,方法從早期的單網絡單損失逐漸發展為現在的多損失多網絡以及多尺度多特征的融合,即一個由簡到繁的發展過程.表4 給出的均是基于單幀圖像方法的結果,而基于視頻序列的方法目前還沒有特別多代表性的方法和結果,因此本文不再做整理.

5 挑戰與未來

5.1 目前的重要挑戰

行人重識別雖然近幾年取得了高速的發展,然而目前依然面臨著許多挑戰.目前學術界已存的數據集是清理之后的高質量圖像,然而在真實場景下行人重識別會遇到跨視角造成的姿態多變、分辨率變化、行人遮擋以及圖像域變化等問題.這些問題逐漸受到學者的重視,本小節將會簡單介紹一些克服這些挑戰的代表性.

1)跨視角造成的姿態多變問題:由于不同攝像頭架設的角度、位置不一,拍攝圖片中的行人姿態也十分多變.目前已經有不少代表性的工作從不同角度上來解決這個問題,而這些方法主要是依靠一個預訓練的姿態模型來實現姿態的對齊.除了第3.3 節中介紹的GLAD 和SpindleNet 等工作以外,CVPR2018 提出的姿態敏感嵌入方法(Posesensitive embedding,PSE)[71].如圖12 所示,PSE利用一個預訓練的姿態模型估計行人的姿態點,然后將姿態點信息輸入到網絡,網絡的視角分支會估計行人的朝向及其概率.另一方面,PSE 的特征分支分別得到前向、背向和側向三個視角的特征圖,之后與估計的視角概率加權得到最終的全局特征.通過使用對齊后的全局特征,可以更好地處理視角多變的行人圖片.

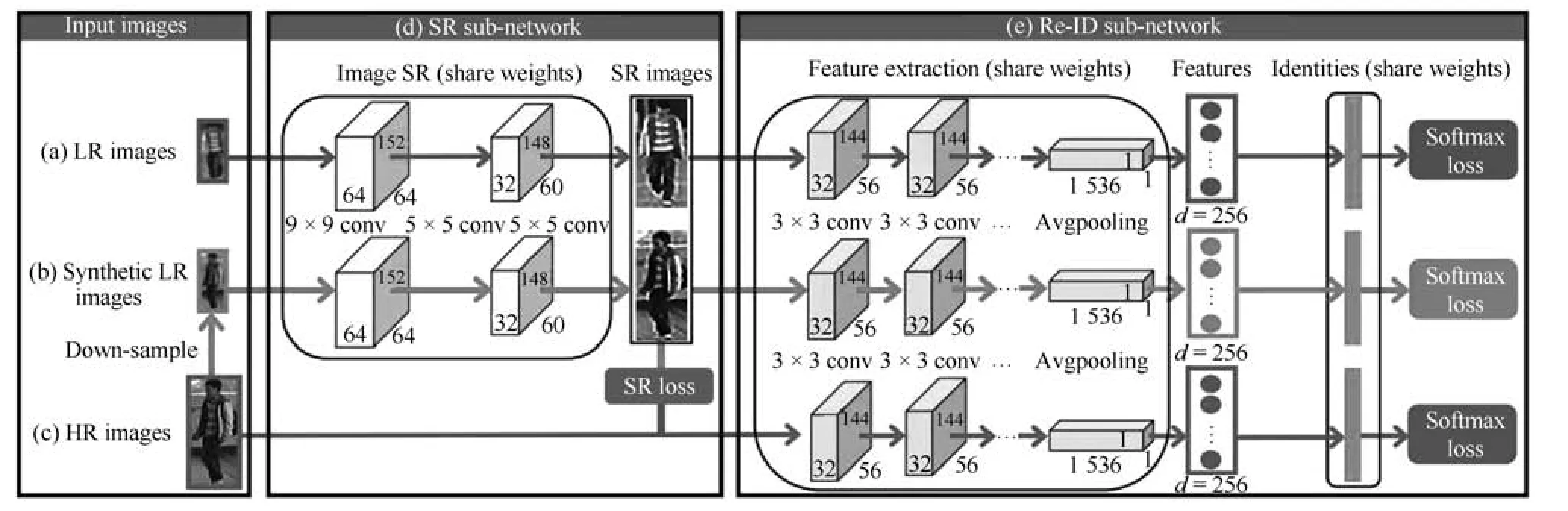

2)行人圖片分辨率變化:由于攝像頭中目標拍攝距離不一致,拍攝的行人圖片分辨率也不一樣.目前專門解決這個問題的方法較少,論文[72]提出了一個新的圖像超分辨和行人身份識別聯合學習(Super-resolution and identity joint learning,SING)的方法.如圖13 所示,SING 通過聯合學習圖片的超分辨率和行人重識別的問題,既能夠提升低分辨率圖片的分辨率,又能提高低分辨率圖片行人重識別任務的準確度.為了得到低分辨率的圖片,SING 先用高分辨率圖片降采樣得到一批低分辨率圖片.之后,網絡優化聯合學習圖像超分辨的重構損失和行人身份識別損失函數.低分辨率圖片經過網絡高分辨率處理后再進行特征提取,而正常分辨率圖像則是直接進行特征提取.由于不同分辨率的圖片經過不同的方式提取特征,因此SING 網絡能夠較好地應對分辨率變化的問題.

表4 典型行人重識別方法在Market1501 上性能比較Table 4 Comparison of the performance of typical ReID methods on Market1501

圖12 PSE 網絡流程圖[71]Fig.12 The pipeline of PSE network[71]

圖13 圖像超分辨和行人身份識別聯合學習模型示意圖[72]Fig.13 Illustration of model structure of image super resolution and person identity joint learning[72]

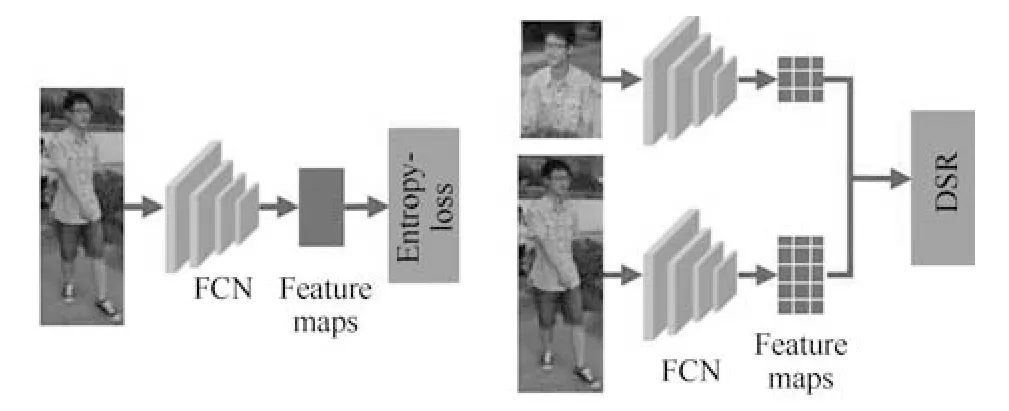

3)行人圖片遮擋問題:目前學術界的行人重識別數據集大多數清洗過的高質量圖像.然而在真實的使用場景,行人經常會被移動目標或者靜態物體所遮擋,造成行人圖片的不完整.由于失去了部分行人特征而引入了很多干擾特征,使得很多基于全局特征的行人重識別算法效果大大下降.為了解決這個問題,一個思路是利用行人姿態模型來估計行人圖像的可視部分,然后對可視部分進行局部特征提取、融合[18].而CVPR2018 的論文[73]提出深度空間特征重建方法(Deep spatial feature reconstruction,DSR)來進行不完整圖片和完整圖片的匹配.如圖14 所示,DSR 利用一個訓練好的ReID網絡對圖片進行特征提取,并且不對原圖進行尺度變換的操作.不同尺寸的圖片經過網絡后得到不同尺寸大小的特征圖,而兩個不同尺寸的特征圖并不能直接地進行相似度計算.為了解決這個問題,DSR利用空間特征重建(Spatial feature reconstruction)的方法計算出兩幅特征圖之間的稀疏表達系數.完整圖片的特征圖經過乘以稀疏表達系數便可以與不完整圖片的特征圖進行歐氏距離的度量.從而實現不同尺寸圖片的特征圖相似度的計算.

圖14 深度空間特征重建方法示意圖[73]Fig.14 Illustration of deep spatial feature reconstruction method[73]

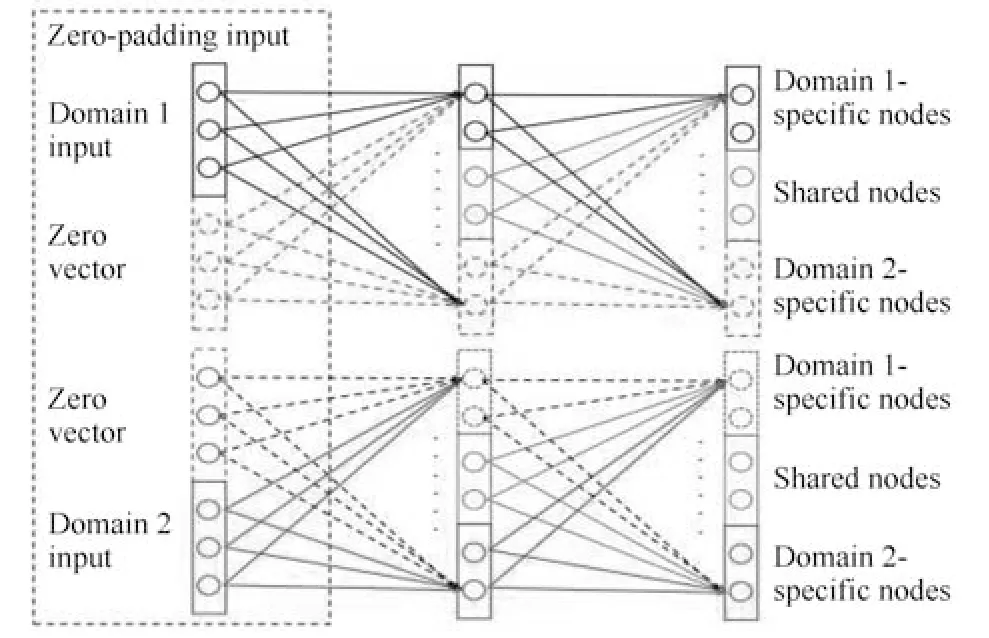

4)圖像域變化的跨模態重識別.圖像域的變化是行人重識別應用上非常普遍的一個挑戰.圖像域變化的類型也多種多樣,例如不同相機、不同天氣、不同時間、不同城市拍攝的圖像風格均可能不同.此外,夜晚RGB 相機也會失效,使用紅外相機拍攝的圖片沒有顏色信息,因此RGB 圖片與紅外圖片的行人重識別也是個典型的跨模態問題.目前基于GAN網絡生成圖像來解決圖像域偏差是一個很流行的思路,例如前文介紹的CamStyle 解決不同相機的圖像域問題,PTGAN 解決不同城市的圖像域問題.而RGB 與紅外圖片域的跨模態重識別問題逐漸開始受到關注,ICCV17 接受的一篇論文[17]提出了深度零填充模型(Deep zero padding model)首次利用深度網絡來解決這一問題.如圖15 所示,該方法的核心思想是在網絡輸入圖片的時候,對于不同域的圖片在不同的通道上用零填充.零填充通道記錄了圖像來源于哪個圖像域的信息,促使深度網絡根據圖像域來自適應提取不同的特征,從而實現更好的跨模態行人重識別.

圖15 深度零填充模型詳解[17]Fig.15 Explanation of deep zero padding model[17]

5.2 未來的研究方向

隨著深度學習的快速發展,近幾年行人重識別的發展也非常迅速.在最流行的數據集Market1501、CUHK03、DukeMTMC-ReID 上,最高的一選(rank-1)準確率都達到了90%~95%.雖然這個準確度離人臉識別還有一定距離,但是已經有了超越人類水平的趨勢[43].不過行人重識別技術要從學術研究走向成熟應用,依然還有一些需要解決的問題.關于未來的研究方向,我們認為可以從以下幾個方面進行考慮,并且給出了一些可能的解決思路:

1)構建更加適應真實環境的高質量標準數據庫:目前最大的行人重識別數據集依然在幾千個行人ID 的程度,這與人臉的百萬級數據庫還有著一定差距.并且目前的數據集場景豐富度也不夠高,通常就是在一個環境下一個較短時間間隔采集的數據.目前行人重識別數據集之間的偏差依然很大,而不同地域、空間、時間環境下的行人著裝也各有不同,一個數據集訓練的網絡在另外一個數據集下性能會下降相當多.只有足夠大的高質量標準數據集的出現,才能更好地證明算法的魯棒性.目前MSMT17數據集[19]和LVreID 數據集[20]將行人重識別的數據集進一步擴大.除此之外,一些基于GAN 的方法[19,62?65]也能夠生成一些接近真實場景下的圖片,來解決目前數據量較少的問題.

2)半監督、無監督和遷移學習的方法:采集的數據終究是有限的,而標注數據的成本代價也很高.因此半監督和無監督學習的方法雖然在性能上可能比不上監督學習方法,但是性價比很高.遷移學習也是一個值得研究的方向.行人重識別技術的應用場景是無限的,針對于每一個使用場景都訓練一個專用模型是非常低效的.如何通過遷移學習的方法將一個場景訓練的模型適應新的場景是一個有價值的研究問題.而半監督、無監督以及遷移學習的深度學習行人重識別技術已經有一些研究工作[25,50,74],不過還有很大的提升空間.

3)構造更加強大的特征:提高行人重識別的性能主要是從特征提取和圖像檢索兩個角度切入.一些重排序技術可以用消耗時間為代價提高檢索準確度[75],而一個好的特征可以更加經濟提高性能.具體而言,行人重識別任務要想構造一個更好的特征,需要網絡能夠關注到更加關鍵的局部信息,即更加合理的局部特征.而利用更加豐富的序列特征也是構造特征的一個思路.

4)豐富場景下的行人重識別:目前行人重識別數據集以視野廣闊的室外場景為主,幾個包含室內場景的數據集也能夠保證行人是完整的全身.但是在一些場景下,例如無人超市、商場、地鐵內等,會存在非常多的半身圖片.而半身–半身、全身–半身的“部分”行人重識別技術便顯得非常重要,第一篇研究該問題的深度學習論文已經被CVPR2018 會議接受[73].而夜間光照不佳情況下的行人重識別也是一個值得研究的問題.目前的主流思路還是用紅外相機在黑暗條件下采集圖片,隨之引申出來的是紅外行人重識別.紅外圖片幾乎只有輪廓,失去了顏色信息給重識別任務帶來了非常大的挑戰.除了以上列舉的例子,其他場景的一些跨域行人重識別也值得關注.

5)深度網絡的可解釋性:雖然深度學習的方法在行人重識別任務上取得了很好的性能,但是在準確度不斷被刷高的背后,很少有研究工作表明哪些信息對行人的識別影響更大.無論是全局特征還是局部特征,單幀圖像還是序列圖像,我們都在設計更加合理的網絡結構或者網絡損失來學習更加有效的特征.然而,到底是顏色信息還是輪廓信息對識別影響更大,或者姿態如何對齊、光線如何矯正對性能提升更大我們都不甚明確.隨著深度學習可視化技術的提升,行人重識別網絡的可解釋性會在將來取得突破.

6)行人重識別與行人檢測、行人跟蹤的結合:目前大部分的方法是在已經檢測出行人的先驗條件下進行的.但是這需要一個非常魯邦的行人檢測模型,如果行人重識別與行人檢測結合起來,則更加符合實際的應用需求.這方面的研究工作很少,ICCV2017 的一篇工作可以給予一定啟示[76].此外,行人重識別最直接的一個應用便是跨攝像頭多目標跟蹤(Multi-target multi-camera tracking,MTMC tracking).因此融合行人重識別和MTMC 跟蹤的問題也是行人重識別研究未來的一個延伸.

6 結束語

行人重識別是計算機視覺領域的一個熱門研究課題,而深度學習的發展極大地促進了該領域的研究.近幾年的頂級會議ICCV、CVPR 和ECCV 上,每年都有十篇以上的行人重識別研究發表,并且絕大部分都是基于深度學習的工作.本文總結了近年來基于深度學習的行人重識別方法,從表征學習、度量學習、局部特征、視頻序列和GAN 網絡為切入點,進行了詳細的討論,并展望了該領域未來可能的研究方向.