基于深度圖及分離池化技術的場景復原及語義分類網絡

林金花 姚禹 王瑩

在客觀物質世界中,目標實體的客觀存在形式通常取決于其所占用的三維空間位置.機器系統識別客觀實體的語義及其拓撲存在性需要精準的神經網絡模型.在機器視覺感知系統中,魯棒重建三維場景以及識別目標語義至關重要,能夠實現機器系統對目標區域信息的有效捕捉與精準定義,有效地識別出目標場景形狀及其語義信息,語義識別與場景重建相互作用以確保機器視覺系統能夠魯棒識別并復原目標場景.傳統方法一般分別完成這兩項工作,例如,二維識別方法一般僅對二維圖像進行分類處理,不會重建目標拓撲結構[1?2];相反,幾何重建方法僅復原三維結構信息,而不識別目標語義.針對這一問題,本文構建了一種場景重建與語義識別相互結合的深度卷積神經網絡模型,同時實現了對三維場景的重建與語義分類功能.

為了高效訓練本文的模型,使用監督式學習方法完成卷積神經網絡的訓練過程,進而實現場景重建與語義識別功能.本文方法對深度數據進行重新表示,使用截斷式帶符號距離函數(Truncated signed distance function,TSDF)編碼方式對目標場景進行三維體素重定義,每個體素包含:被占用體素與空閑體素兩種含義.如何從不完整的目標場景中識別其語義以及不可見區域的語義標注問題是本文需要解決的關鍵問題.

針對上述問題,本文構造了一種上下文區域拓展網絡,增加了接收區域場景的體素信息,使得目標語義識別面更廣.另一方面,本文構建了一種有效的用于深度學習的數據集,并對其完成了體素標注.

1 相關工作

在機器視覺系統中,魯棒完成三維場景的語義分割任務至關重要,常用任務包括機器人路徑規劃、人員協調輔助以及智能監控等.近年來,為了滿足視覺系統需求,實現對目標場景的語義分割任務,深度學習神經網絡得到廣泛應用,深度神經網絡通過學習大規模場景數據,生成訓練標簽,進而實現目標場景理解任務.然而,對于大多數的視覺處理任務,真實場景數據是有限的,并且受深度感知技術和語義分類方法的限制,使得構建高效的深度學習網絡并不容易.

深度神經網絡被廣泛用于解決對象分類和目標檢測問題[3?4].然而受數據規模、存儲介質和計算能力的限制,深度神經網絡的復雜程度也隨之提高,限制了深度神經網絡的適用范圍.這種限制主要出于兩個方面:1)隨著模型尺度的增大,網絡的復雜度也隨之增加,例如Googlenet 數據集的50 MB 模型,Resnet-101 的200 MB 模型,Alexnet 的250 MB 和VGG-net 的500 MB 模型;2)復雜神經網絡通常需要超高性能的處理器的支持,即高配置的GPU 高速并行處理單元的支持,這使得研究人員致力于模型的壓縮,以減小神經網絡的內存和處理單元占用率[5?6].例如,Ren 等[7]對遮擋目標場景魯棒地完成重建過程,將大權重矩陣分解為幾個可分離小矩陣來減少冗余,重建效果較好,但無法實現語義識別功能.對于神經網絡的完全連接層,這種方法已被證明非常有效.科研工作者給出了多種基于連接限幅的語義重建方法,刪除了預訓練和再訓練模型的冗余連接.這些方法將模型參數的數量減少了一個數量級,而不會對分類精度造成重大影響,但三維重建精度會隨著降低[8?11].另一種語義重建策略是限制模型本身的架構.例如,去除完全連接的層,使用小尺寸的卷積濾波器等,目前較先進的深層網絡,如Nin、Googlenet 和Resnet 都采用這種架構.然而這種方法對重建場景的幾何拓撲細節表示不佳影響了重建分辨率[12?13].Zheng 等[14]使用固定點表示來量化預訓練神經網絡的權重,以加快網絡在CPU上的運行時間,同時使用空間預測方法來推斷遮擋場景信息.Kim 等[15]提出了替代量化方法來減小模型尺寸,在保證最小精度損失的情況下,使用k級均值矢量量化實現了4~8 倍的重建精度,然而引起網絡訓練時間的增加.Hane 等[16]和Blaha 等[17]使用綁定更新優化策略來保證重建視覺的多樣性,以此加強網絡的重建精度.

針對上述問題,本文給出了一種適用于大尺度場景重建與語義識別的深度卷積神經網絡模型,將目標幾何信息與目標上下文語義信息相結合,進而完成對目標場景的魯棒重建與識別.另外,本文建立了一種用于三維場景學習的數據集,可用于對RGB圖像的語義分割過程[18?21].

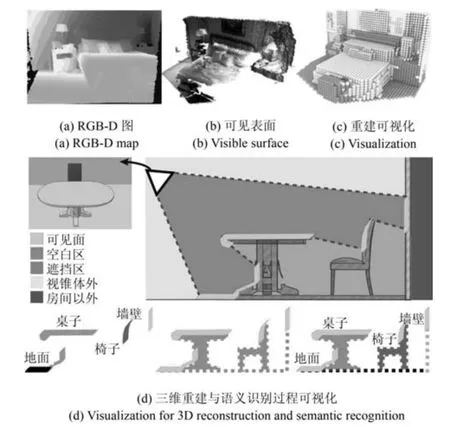

2 語義場景復原網絡

本文的深度卷積神經網絡由多個層次的處理單元組成,關鍵核心是完成攝像機視錐體劃分范圍里的空間體素分配到一系列語義類別標注,假設C{c0,···,cN+1},其中,N表示目標場景包含的類別總數,c0代表未被占用的體素.每個神經單元的激勵函數如下:zg(wwwTx),其中,Rc×w×h為權重向量,Rc×w×h為輸入向量,g(·)為非線性函數.本文卷積神經網絡實現了由這些單元構成的多個層,并用張量Rc×w×h來表示權重.c,w和h分別用來定義濾波器通道的數量,寬度和高度.由于這種基本運算在整個網絡中重復,且神經網絡通常由繁多的處理單位組成,式(1)的表示方式是決定整個網絡模型復雜程度的主要因素.網絡的復雜程度主要與兩個因素有關:1)存儲權重www需要巨大的內存開銷;2)大量的點積運算wwwTx需要高成本的計算開銷.當權重和點積運算為浮點值時,上述兩個方面的開銷會劇增,導致實際應用能力差[22].因此本文所提的低精度卷積神經網絡更適用于解決實際三維重建與語義分類問題.本文網絡的場景重建與語義識別過程如圖1 所示.下面分節闡述本文網絡模型的構造與重建過程.

圖1 本文深度卷積神經網絡的場景重建與語義分類過程Fig.1 3D reconstruction and semantic classification of our depth convolutional neural network

2.1 體素數據編碼及分離池化方法

首先,對三維場景的語義分類原理進行分析,構建基于改進的TSDF 編碼以及細粒度池化特性的深度卷積神經網絡模型;其次,提出估計算法對三維語義感知特性參數進行估計,解決TSDF 編碼下具有細粒度池化層的深度卷積神經網絡的模型優化問題;最后,建立考慮改進的TSDF 編碼下三維語義場景的語義分類性能評價體系,預測網絡對三維場景的語義分類性能,改善機器系統對三維場景的語義感知性能,為具有三維語義感知能力的機器視覺系統在軍用和民用上的應用提供理論依據.

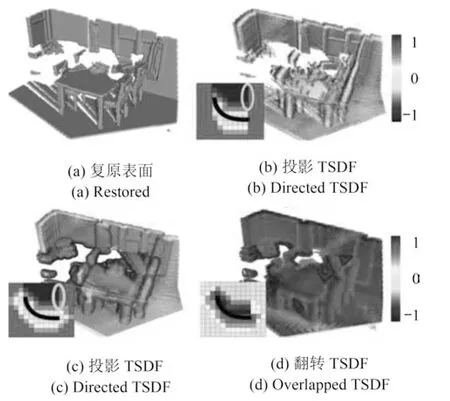

本文對TSDF 進行了改進,使之適應于場景重建與語義分類的混合卷積神經網絡模型.一般情況下,深度卷神經網絡模型使用距離相機位置最近投影直線的方式來獲取場景關鍵點.然而,該方法在節省重建投影視覺的同時,卻以關鍵點捕獲精度為代價,影響了對三維場景的最終重建精度以分類性能.為提高重建精度及語義分類性能,本來采用了一種隨機選取池化層內部表面點的方式來提取關鍵點,改善了TSDF 距離的計算時間,同時保證了重建與分類精度.分離池化后的特征區域本身具有細粒度空間幾何拓撲結構的特性,當隨機采用發生時,平均池化粒度值基本保持不變,因此確保了隨機采用的平均精準度,以此構建的TSDF 的精度也隨之增加.本文采用池化技術的體素編碼方式如圖2 所示.

2.2 復原網絡結構

圖2 常用的TSDF 編碼可視化結果Fig.2 Visualization of several encoding TSDF

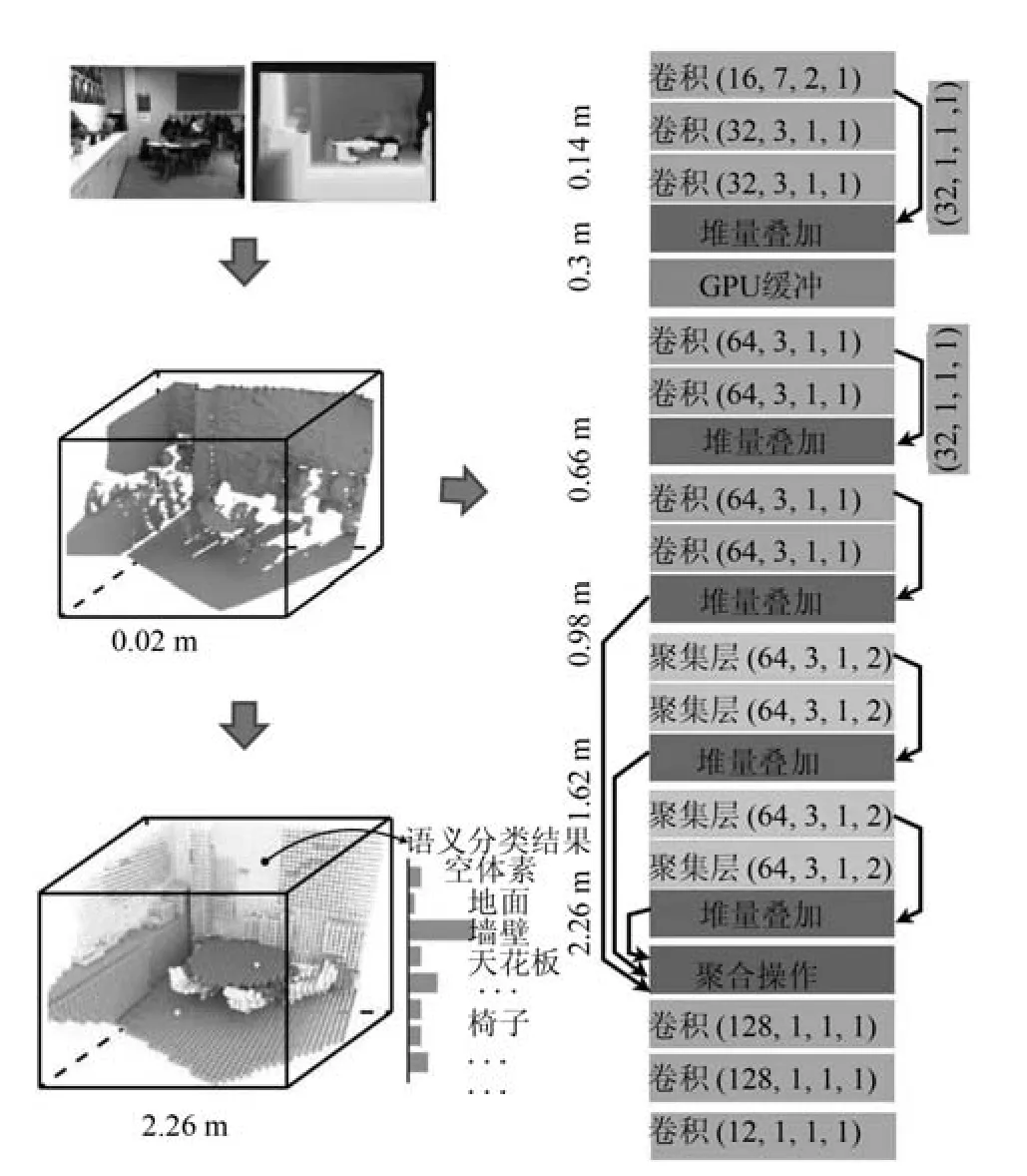

三維場景語義分類問題是機器視覺領域的熱點研究問題.本文考慮結合TSDF 編碼與分類池化技術的三維場景重建與語義分類網絡模型如圖3 所示.下面分五個方面闡述本文深度卷積神經網絡的場景復原與語義分類過程.

圖3 本文所提深度卷積神經網絡模型Fig.3 Our depth convolutional neural network

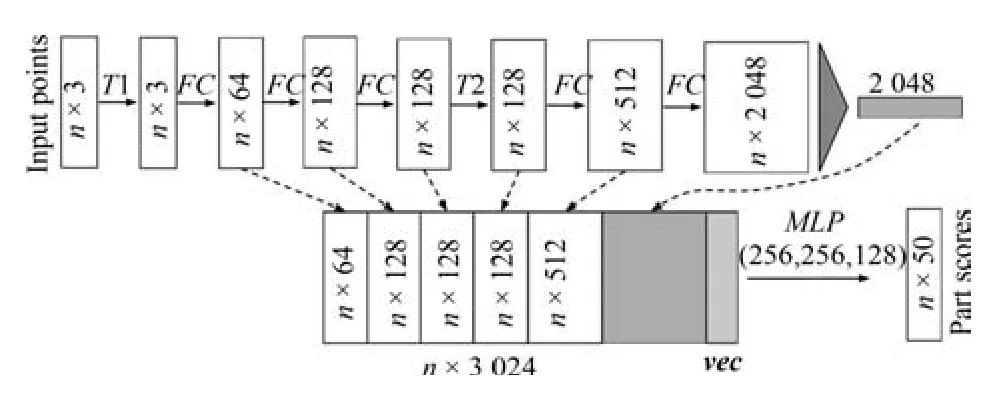

1)本文構建了一種以RGB-D 深度圖作為輸入的深度學習網絡框架.一個點云由一組三維點數據構成,即{Pi|i1,···,n},每個三維點Pi由五維向量表示.對于對象分類任務,輸入點云直接從目標形狀采樣,或者從一個場景點云預分割得到.對于語義分割,輸入可以是用于部分區域分割的單個對象,或者用于對象區域分割的三維場景子體積.本文網絡將為n個點和m個語義子類別中的每一個輸出n × m個分數.圖4 給出了本文語義分類網絡架構.T1 和T2 是輸入點和特征的對稱轉換網絡.FC是完全連接的層在每個點上操作.MLP是每個點上的多層感知器.vec是大小為16 的向量,指示輸入形狀的類別.本文網絡能夠預測體素數量,如圖4 中的左下角曲線圖所示,這表明本文復原網絡能夠從本地鄰域獲取信息,對區域分割具有魯棒性.

圖4 本文語義分類的卷積流程Fig.4 Convolutional streamline of our semantic classification

2)本文語義復原網絡從訓練LS-3DDS 合成數據集中,直接學習接收域信息來獲取條件概率矩陣,即在三維場景語義分類中,條件概率p(Ai|Cn)表示在語義類別Cn中出現的語義對象Ai的比率來計算概率分布

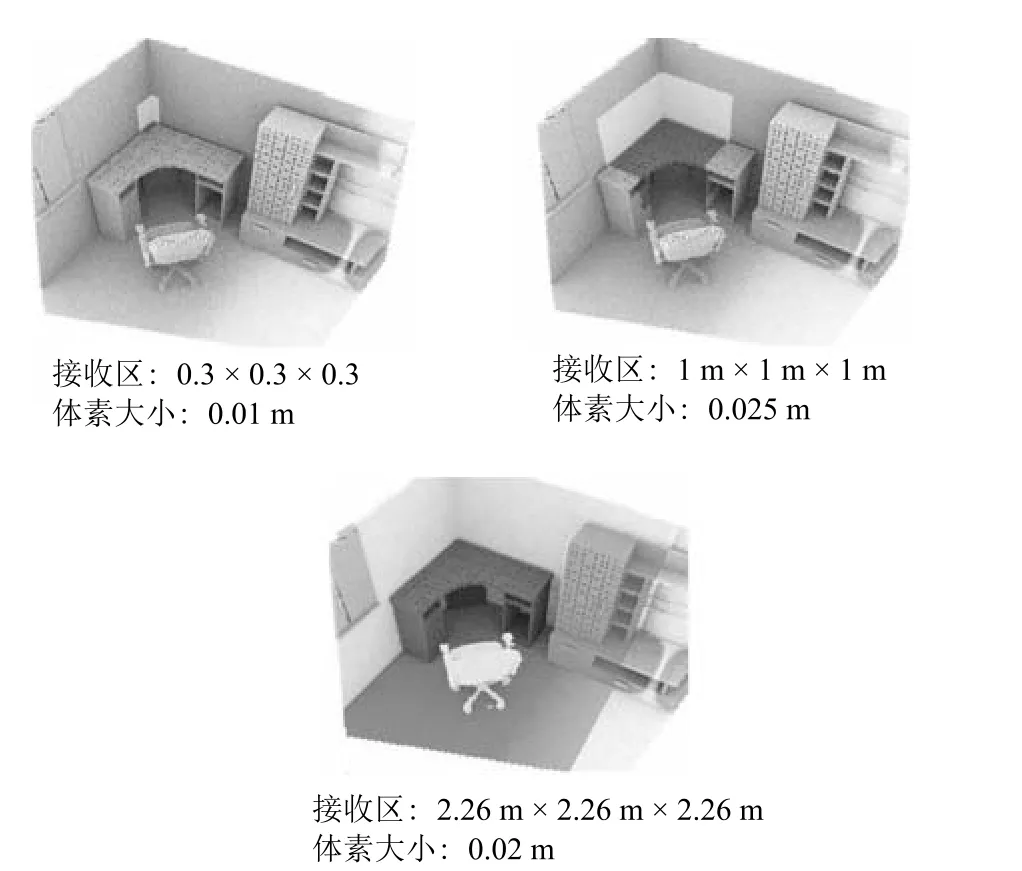

其中,Cn表示 LS-3DDS 數據集中屬于類別Cn的場景個數,且i p(Ai|Cn)1.本文的三維場景語義類別個數N,對象個數為M,語義對象條件概率矩陣為N ×M階矩陣,即這里通過計數隨機事件的出現頻率來估計概率分布,需要大量的真實觀測數據.使用本文構建的LS-3DDS數據集訓練語義神經網絡模型,由于合成數據集規模較大且手動標記標簽精準,使得計算得出的條件概率較準確,保證了本文語義場景復原網絡的精準度,如圖5 所示,接收區域的增大提高了本文網絡的上下文語義識別精準度.

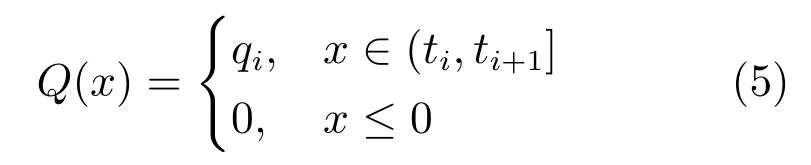

3)本文神經網絡的池化器采用分段常值函數,定義為

該池化器將量化間隔(ti,ti+1]內的所有x,并將其映射為量化級別qiR,其中,i1,···,m,且t1?∞,tm+1+∞.這將泛化符號函數,將其看作是1 位池化器.一個均勻池化器需要滿足以下條件:

其中,?是恒定量化步長.受精度降低的約束,量化級qi作為激勵x的重構值.因為對于任意x,該池化器足以存儲式(2)的量化索引i以恢復量化級別qi,所以非均勻池化器需要log2m比特的存儲空間來存放激勵x.然而,在算術運算過程中,通常需要超過log2m比特來表示x,并使用qi代替索引i.對于均勻池化器,?是通用縮放因子,通常以log2m比特來存儲激勵x而不存索引.本文在卷積運算中也同樣采用這種存儲策略.

圖5 本文攝像頭接收范圍直接影響網絡性能Fig.5 Our camera receiving range directly affects performance of network

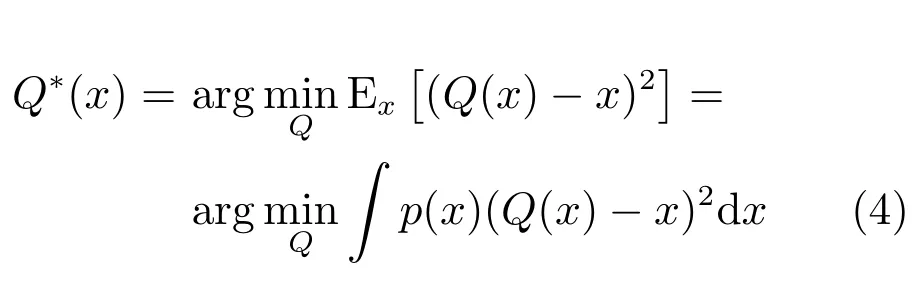

4)設計最優池化器以保證三維重建精度與語義分類準確率,需要將池化器定義在均值誤差范圍內,即

其中,p(x)是x的概率密度函數.因此,式(2)中點積的最優池化器取決于它們的統計值.雖然式(4)的最優解Q?(x)通常是不均勻的,但通過將式(3)的約束代入式(4),可以得到均勻解Q?(x).給定點積樣本,式(4)的最優解可以通過勞埃德算法獲得.這是一個迭代算法.由于每個網絡單元必須設計不同的池化器,并且該池化器隨反向傳播迭代而改變,因此該過程的直接計算實現是較繁瑣且有難度的.

5)本文使用半波高斯池化器來實現反向近似操作,通過利用深層網絡激勵的統計結構來的克服池化器隨反向傳播迭代而改變的問題.文獻[23?24]證明了點積近似具有接近高斯分布的對稱、非稀疏分布特性.考慮到ReLU 是半波整流器,本文使用半波高斯池化器(Half wave Gauss pool,HWGP)來實現反向近似操作,定義如下:

其中,qiR+,i1,···,m,tiR+,i1,···,m+1,t10,tm+1∞;qi和ti是高斯分布的最優量化參數.SGNN 保證了這些參數僅取決于點積分布的均值和方差.然而,因為這些參數在不同的單元之間變化,所以無法消除網絡上勞埃德算法的重復使用.

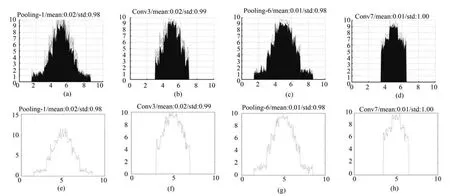

這個問題可以通過批量歸一化方法來緩解,這迫使網絡的每個層的響應都具有零均值和單位方差.本文將這種歸一化操作應用于點積運算,結果如圖6所示.盡管點積分布不完全符合高斯分布,它們之間存在微小差異,但二者都接近高斯分布,且平均值和單位方差為零.因此,最佳量化參數和在神經網絡的單元、層和反向傳播迭代過程中大致相同.因此,勞埃德算法在整個網絡上僅使用一次即可.實際上,由于所有分布都近似于零均值和單位方差的高斯分布,因此可以從該分布的樣本中設計池化器.本文從零均值和單位方差的標準高斯分布中抽取了106個樣本,并通過勞埃德算法獲得了最優量化參數.在點積批量歸一化之后,再將所得到的參數和用于參數化在所有層中使用的SGNN.

3 實驗結果與分析

為測試本文卷積神經網絡的重建精度與語義分類性能,本節采用攝像機捕獲的三維場景數據以及合成數據對網絡進行訓練與測試.

在使用真實場景數據進行訓練時,本文使用NYU 數據集訓練深度卷積神經網絡模型,該數據集由1 449 個RGB-D 深度圖.本文針對由Guo 等[25]提出的帶有幾何標注的三維體積模型,捕獲了大量的三維真實場景數據信息.另外,同時采用了Sun等[26]的采樣策略捕獲了多種三維場景對象數據.通常情況下,當語義標注信息與實際網絡拓撲信息不完全對應時,數據集中的深度信息與幾何信息也會出現不匹配的現象.針對這一問題,Silberman 等[3]等采用繪制RGB-D 圖的方式對目標三維場景的三維物理位置信息進行標記.然而在標記的過程中不可避免的影響原有三維拓撲結構,使得三維重建場景的本地特性未能較好地保留.為此,本文結合了上述幾種重建數據集的構造方式,對本文神經網絡進行測試.

圖6 帶有二進制權值和量化激勵的網絡層點積分布圖.(a),(b),(c),(d)分別為下采樣層1、卷積層3、下采樣層6、卷積層7 的點積分布圖(具有不同的均值和標準偏差);(e),(f),(g),(h)分別為下采樣層1、卷積層3、下采樣層6、卷積層7 對應的點積誤差分布曲線Fig.6 Dot product distribution of network with binary weights and quantitative activation.(a),(b),(c)and (d)are the point product distribution maps of the pooling layer 1,the convolution layer 3,the pooling layer 6 and the convolution layer 7,respectively,they share a different mean and standard deviation;(e),(f),(g)and (h)are the dot product error distribution curves corresponding to the pooling layer 1,the convolution layer 3,the pooling layer 6 and the convolution layer 7,respectively.

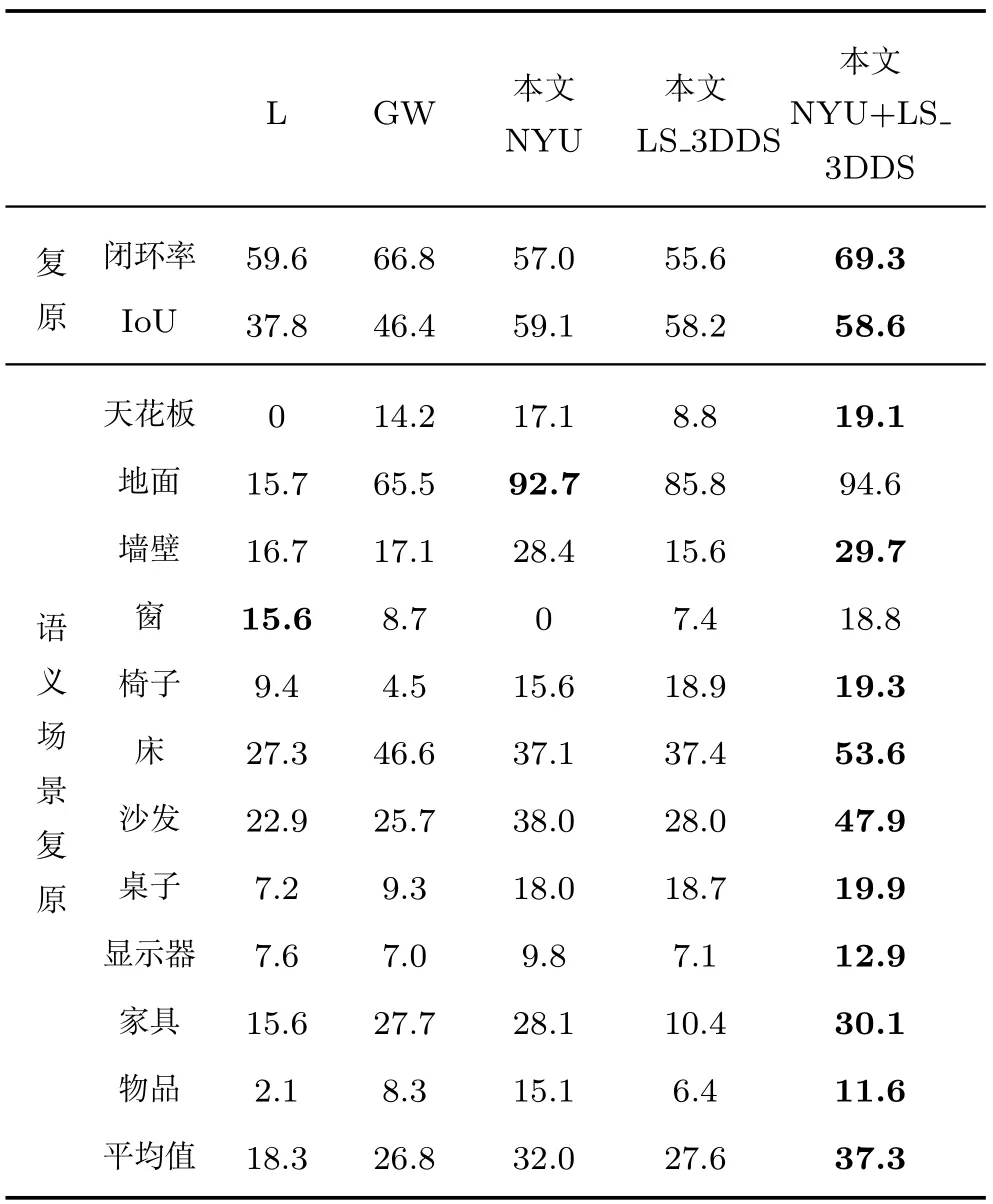

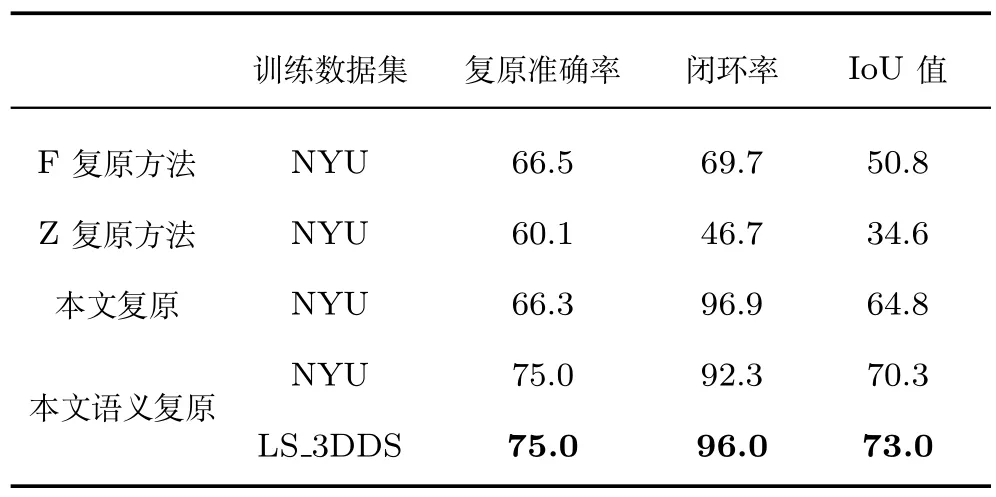

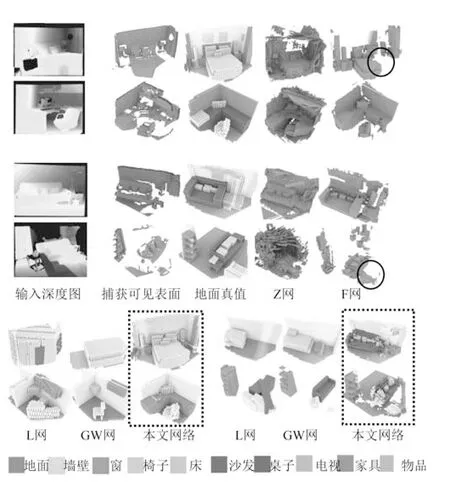

本文在表1 和表2 中展示了對神經網絡性能的定量分析,同時在圖7 中給出了網絡的定性分析結果.在表1 中,將本文網絡模型與Lin 等[12]以及Gupta 等[8]和Wang 等[21]提出的網絡模型展開對比,為方便引用,文中下述段落將上述幾種網絡重命名為L 網、GW 網.這兩種網絡模型采用深度輸入幀為神經網絡的輸入數據,同時在目標場景的體素級網絡上生成語義標注.L 網采用包圍盒以及超平面近似的方式標記全部體素網格.GW 網對場景進行測試的同時搜索RGB-D 數據信息,進而完成對全局場景的重建測試.以上兩種網絡能夠在較小的訓練數據集上重構精準的三維場景幾何結構模型,對應關系的匹配方法較精準.與之不同,本文網絡采用單一深度圖作為輸入,同時結合分離池化技術對特征采用關鍵點進行優化處理,生成細節豐富的TSDF 編碼方法,另外無需附加網絡來協調測試過程,提高了重建性能.因此,本文深度卷積神經網絡模型能夠生成更加精準的重建模型,同時保證了語義分類精度.本文深度卷積神經網絡的三維場景復原精度值為30.5%,GW 網的精度百分比為19.6%.由圖7 給出的重建對比圖可知,這兩種網絡模型同時將沙發對象語義標記為床,然而,本文網絡模型能夠準確識別目標對象語義,并采用虛線方框來標記,本文方法的語義標記精準度更高,同時,本文網絡無需對目標場景進行預處理,三維場景復原與語義分類同時完成,在保證重建精度的同時,節省了對三維目標場景的重建時間已經語義分類開銷.

表1 本文網絡與L、GW 網絡的復原與分類性能比較(%)Table 1 Comparison of three networks for performance of reconstruction and semantic classification (%)

表2 本文網與F 網、Z 網的重建性能對比數據(%)Table 2 Comparison of our network reconstruction performance with F and Z networks (%)

圖7 幾種復原網絡的可視化性能對比圖Fig.7 Visualization performance comparison for several completion neural networks

本文對卷積神經網絡進行訓練,進而檢測三維體素的空間占用比率,首先將單個體素數據進行編碼,未被占用的體素用二進制字符“0”來標記,已經被占用的體素項目用字符“1”來標記.表2 給出了使用以上數據集訓練完成的網絡模型的性能對比數據.使用本文網絡對場景進行重建復原,同時使用Silberman 等[3]和Zheng[14]等提出的網絡對場景重建復原,為方便引用,文中下述段落將上述幾種網絡重命名為F 網、Z 網.這兩種方法采用RGB-D圖作為網絡的輸入,實現對三維場景的復原處理,然而二者皆不具有語義分類標注功能.本文網絡針對上述兩種網絡完成了整合改進,將場景復原與語義分類融合到統一的深度卷積神經網絡模型中.本文網絡首先在測試階段,采用200 張輸入深度圖,同時采用NYU 體系來平均本文網絡的重建與分類性能.F 網實現了對大規模場景的三維重建過程,并且重建的精度較高,然而,當場景的目標語義較復雜,遮擋現象嚴重時,網絡的重建精度受到限制,三維場景的重建效果受到影響.例如,在圖7 中第4 行的椅子復原失敗(如圖中藍色圓圈所示).然而,使用本文網絡來重建目標場景時,由于結合了上下文語義評價體系,改善了語義重建的精準度.從本組實驗結果可以看出,本文的將重建與語義分類相結合的方法,在提高三維重建精度的同時,避免了不必要的語義檢測失效問題.

本文訓練了一種用于三維重建與語義分類的統一架構深度卷積神經網絡模型,本文對未被遮擋的場景表面幾何進行具體的語義標注,同時采用聯合策略對目標網絡模型進行訓練,并對比起重建結果.然而,當本文網絡對未被遮擋的表面進行測試是,采用三維場景重建結合語義分類來訓練三維神經卷積神經網絡模型的效果由于僅使用幾何表面語義訓練的網絡模型,實驗結果表明帶有幾何標注的三維場景重建精準度為52.3%,然而,聯合兩種網絡得到的三維場景重建精準度為55.3%.因此,本文提出的重建與語義分類相互結合的網絡模型,具有互相協作相互促進的優勢.

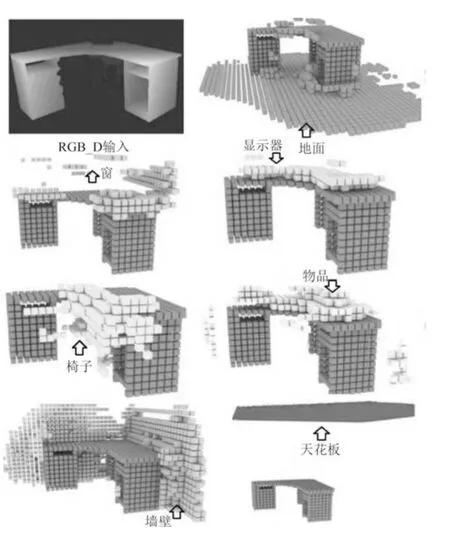

在圖8 中,本文網絡對未知區域的場景語義及幾何形狀進行了預測.當桌子場景周邊的目標場景未出現在攝像頭捕獲范圍內時,使用本文網絡仍然能夠較精準的預測出目標場景的上下文語義信息,從預測結果可見,本文網絡的重建精度較好,語義分類預測出的對象標注信息較準確.例如,在圖8 中出現的第1 張深度圖中,該圖中的周邊對象均不可見,然而,即便信息被完全遮擋,依據本文的池化技術仍然能夠精準的預測出上下文語義,擴大了語義識別的目標場景面積,本文網絡的重建性能從39.0% 提高到45.3%.

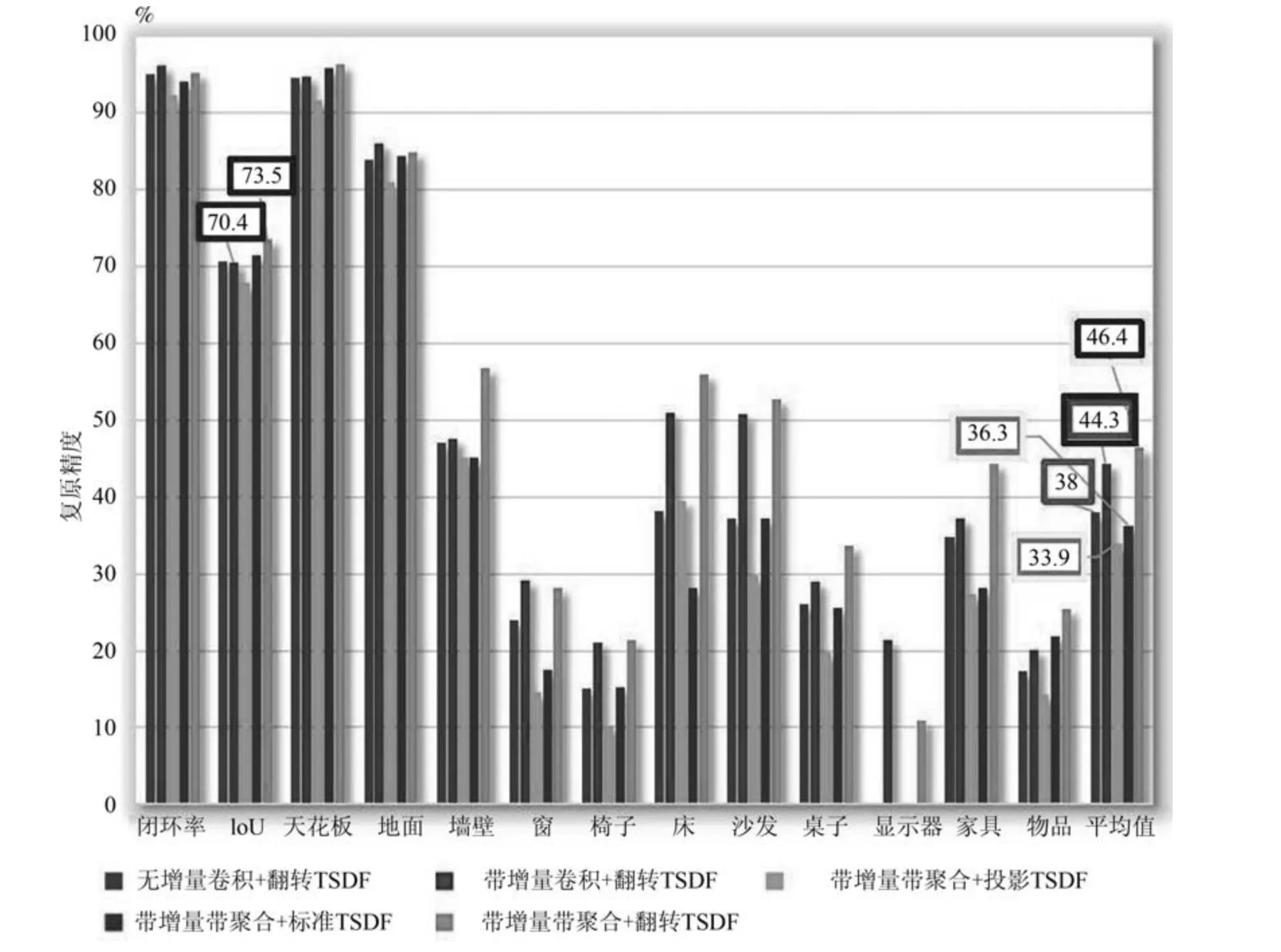

圖9 給出了不同體素編碼方式對復原網絡性能的影響.無增量卷積和帶增量卷積網格具有相同數量的參數,而在帶增量卷積網絡結構中,三個卷積層被增量卷積取代(如圖3 所示),將接收域從1.62 m增加到2.26 m (如圖5 所示).增加接收區域使網絡能夠獲得更豐富的上下文信息,并將網絡性能從38.0% 提高到44.3%.將帶有和不帶有聚合層的兩種網絡進行性能比較,如圖9 所示,結果表明帶有聚合層的模型對場景復原和語義分類都產生較高的IoU 值,分別增漲3.1% 和2.1%.

圖8 本文網絡預測出的周圍對象Fig.8 Prediction of surrounding object by our network

圖9 中給出了采用不同體素編碼方式的網絡性能,即投影TSDF,標準TSDF 和翻轉TSDF (改進后)三種編碼方式的比較.實驗結果顯示,使用標準TSDF 可以消除攝像機視角的依賴性,并使得IoU值提高了2.4%;而使用翻轉TSDF 時,梯度變化集中在表面上,IoU 值比標準TSDF 提高了10.1%,比投影TSDF 提高了12.5%.

4 結束語

本文提出了一種基于深度圖與分離池化技術的深度卷積神經網絡模型,將深度圖作為輸入并使用分離池化方法提取深度特征,進而完成對三維場景的幾何結構重建及語義分類任務.同時,構建了一種用于訓練本文網絡模型的三維合成數據集,增強了神經網絡的學習能力.實驗結果表明,本文網絡兼具復原與分類功能為一體,與單一形式的網絡模型相比,本文網絡的重建精度提高了2.1%.本文網絡采用分離池化技術及語義豐富的訓練數據集,優化了傳統單一類型網絡的性能,實現了對三維場景的魯棒重建與分類.

圖9 改進的TSDF 編碼對語義場景復原性能的影響Fig.9 Effect of improved TSDF on semantic scene completion