一種基于細節層分離的單曝光HDR 圖像生成算法

張紅英 朱恩弘 吳亞東

高動態范圍成像(High dynamic range imaging,HDRI)是一項近年來十分流行的技術,簡單地說就是讓圖像表現出更大的明暗差別,高光不過曝,暗調不欠曝,使所有的層次和細節都很清楚.動態范圍是環境中光照亮度級的最大值與最小值之比.現實世界真正存在的亮度差,即最亮的物體亮度與最小的物體亮度之比為108,而人類的眼睛所能看到的范圍是105左右,一般的顯示器、照相機能表示的只有256 種不同的亮度.因此,為了在普通顯示器上顯示HDR 圖像,必須將其動態范圍進行壓縮,目前普遍采用色調映射算子(Tone mapping operators,TMOs)進行圖像亮度的壓縮[1?3].

隨著顯示器技術的發展,比傳統顯示器具有更高動態范圍的顯示設備已稍具雛形,同時更多高動態范圍的圖像和視頻也因為相關技術的成熟而逐漸容易獲得.然而現有的圖像和視頻大多還是在低動態范圍的數位格式中保存,因此如何利用反色調映射算子(Inverse tone mapping operator,ITMO)擴展亮度,使之能夠得到接近真實世界的動態范圍是近年來圖像處理領域熱門的研究課題.反色調映射算子是實現由單幅低動態范圍(Low dynamic range,LDR)圖像生成一幅HDR 圖像的方法,該類方法對單幅的LDR 圖像進行直接的轉化,不僅能實現靜態HDR 圖像的拍攝,還能進行HDR 視頻的錄制.與此同時,采用這種方法還可以將現有的大量LDR 圖像或視頻資源生成HDR 資源,能夠很好地解決HDR 圖像或視頻資源匱乏的問題,這些都是基于傳統多曝光技術的HDR 圖像生成方法無法實現的.目前國內外對于單曝光HDR 圖像生成技術的研究已經取得了一定成果[4?8].但該技術在處理效果和處理效率上仍有相當的研究空間.

目前,單幅LDR 圖像到HDR 圖像擴展的算法分為5 類[9]:外形修整函數[10?11]、全局模型[12?14]、分類模型[15?16]、擴展映射模型[17?18]、基于用戶的模型[19]以及其他一些比較特別的方法[20?23].文獻[10?11]采用外形修整模型,將LDR 圖像和視頻中8 bit 數據擴展到10 bit,同時在擴展的變換域中將偽輪廓去除.采用這種方法擴展后的圖像視頻為中動態范圍的圖像視頻.該方法并沒有特別關注過曝光和欠曝光區域,目前該模型由于擴展范圍的局限性,研究進展較緩慢;文獻[12?14]中的全局模型就是對圖像或視頻中的每個像素都運用相同的全局擴展函數,該類算法復雜度通常較低,對高質量LDR圖像處理效果較好,但往往不對壓縮或量化產生的偽像作相應處理,不能保證對壓縮過的LDR 圖像處理的質量.而在實際應用中,平時拍攝的圖像或視頻通常都進行過壓縮處理,這種情況下就需要更精確的擴展方法來避免壓縮帶來的偽像,該模型的優點在于處理效率較高,但缺點是處理圖像要求高,否則成像效果不好;文獻[15?16]提出的分類模型是嘗試對LDR 圖像中的內容進行分區,然后再對不同區域采取不同的策略進行處理.該模型通常是對圖像中不同光源曝光程度進行分區;文獻[15]提出一種增強LDR 視頻亮度的交互系統,主要思想是將1 個場景分成散射區、反射區和光源區3 個部分,只增強反射區和光源區部分,認為增強散射部分會產生偽像,該系統是非線性的.目前采用分類模型的算法普遍存在著算法復雜度較高,需要進行額外訓練的問題.為提高算法效率,往往需要從硬件上著手解決.擴展映射模型首先對輸入的圖像進行線性化,然后采用反色調映射算子對圖像的范圍進行擴展[17?18],再采用光源采樣、濾波后亮度增強等方法對圖像的過曝光區域進行重建.該模型是目前研究較為廣泛的一種模型,在擴展映射后還需要采用多種方法來提升圖像中的信息量,主要限制在于對過曝光區域太大的圖像效果不理想;文獻[19]是基于用戶的模型的代表算法,該算法基于圖像中存在過曝光和欠曝光區域類似結構的高質量塊的假,首先將LDR 圖像進行線性化,然后通過查找圖像中相似的高質量塊對過曝光和欠曝光區域進行增強.對過曝光和欠曝光的修復分為自動和基于用戶兩種方式,需要用戶對圖像進行修復.該模型與其他模型相比,由于需要用戶參與,導致只能用于單幀圖像而不能對視頻進行HDR 轉換,而且存在無法找到傳遞圖像細節信息的塊的情況.

除了以上5 類常見的模型外,還有一些比較特別的方法.文獻[20]首先采用自適應直方圖分離方法將原圖構造出欠曝光和過曝光圖像,然后分別對過曝光和欠曝光圖像進行處理,最后采用多曝光圖像融合的方法生成HDR 圖像;文獻[21]首先利用HVS 對光的感應及理解特性,構建HVS 的局部自適應模型并對其求逆,然后建立圖像中每個像素點的局部亮度信息求取模型,最后將每個像素的局部亮度信息運用于局部自適應模型的反函數中實現圖像比特深度擴展,在保證圖像對比度的同時,實現圖像細節信息增強;文獻[22]提出一種基于光源采樣的單曝光HDR 圖像生成算法,通過對圖像中存在的可能的光源信息進行采樣,模擬光線衰減效應,有效地還原了高光部分的細節信息.值得注意的是,由于單曝光LDR 圖像本身圖像信息不足,圖像中的一些細節在生成HDR 圖像的過程中仍然缺失.因此,本文提出一種基于細節層分離的單曝光HDR 圖像生成方法,根據人眼視覺系統模型,首先對圖像的亮度分量進行分離,并進行伽馬校正;然后對伽馬校正后的亮度分量分離細節層,并在反色調映射后對細節層進行融合得到新的亮度分量;最后將圖像亮度分量與色度、飽和度分量融合得到最終的HDR 圖像.大量對比實驗表明,本文提出的方法可以有效地提高圖像的動態范圍,并挖掘出LDR 圖像中部分隱藏的細節信息,一定程度上彌補了單曝光LDR 圖像細節信息不足的缺點,處理效果較好,運行效率高,具有較好的魯棒性.

1 算法框架

單曝光LDR 圖像本身的信息不足,主要體現在:1)正常曝光狀態下畫面細節不足;2)過曝光或欠曝光導致的連續像素點的飽和現象.針對正常曝光的畫面細節不足,可以通過構建反色調映射方法及其他常見方法解決;而針對連續飽和區域的處理,則是單曝光HDR 生成算法的處理難點.目前,常用的光學數字成像過程是將真實場景的光輻射值通過圖像傳感器(CCD 或CMOS)轉化為電信號,再通過A/D (模/數轉換器)轉換成數字信號,并以數字圖像的方式保存下來.CCD 使用一種高感光度的半導體材料制成,能把光線轉變成電荷,CCD 的每個感光單位感應到的光線,都是外界光線的集合,最后反映到計算機能夠處理的數字圖像上的每個像素上.由于圖像中每個像素點上像素值是受到映射到該點所有光線的影響,故可以確定,在單曝光LDR圖像中包含了場景的細節信息,只是因為壓縮編碼和CCD 表面感光單元數量限制等原因,部分被其他信息所掩蓋,而只要能夠分離出這部分的細節信息,則能夠更真實地還原HDR 圖像.

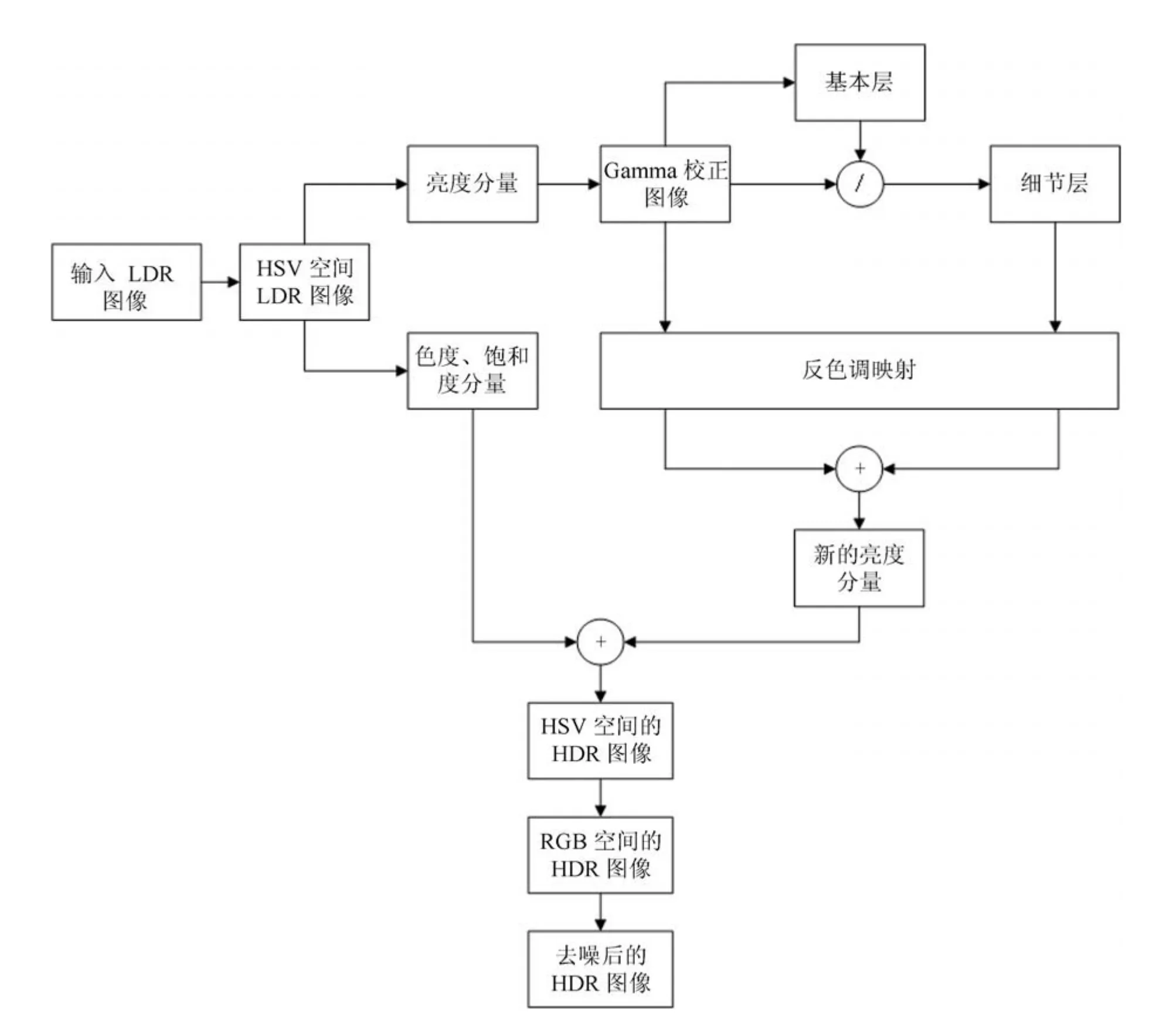

基于以上分析,本文提出一種基于細節層分離的單曝光HDR 圖像生成算法,總體框圖如圖1 所示.主要思路是先分離細節層以盡可能多地挖掘出過曝光和欠曝光區域的細節信息,再對各層分別進行相應操作來擴展圖像的動態范圍.算法包括3 部分:1)由于人眼視覺系統中視網膜上錐狀和桿狀細胞對亮度和色度信息敏感度不同,HSV 顏色空間更符合人眼的視覺感受,因此,對圖像進行預處理及細節層的分離,包括RGB 空間到HSV 空間的轉變,分離出亮度分量和色度分量;然后基于某一像素點的值可能被環境光所影響的分析,對亮度分量進行伽馬校正后作保邊濾波操作,提取出亮度分量的基本層來模擬環境光,再對基本層和伽馬校正后的亮度分量進行遍歷運算,得到亮度分量的細節層.2)構造反色調映射算子,對伽馬校正后的亮度分量和細節層分別進行亮度擴展,使亮度分量和分離的細節層的動態范圍得以擴展.3)由于需要將從圖像中挖掘出來的細節層與其他各層融合到一起才能獲得更多細節信息,所以最后融合擴展后的亮度分量色度分量得到RGB 空間的HDR 圖像,對之進行去噪處理得到最終的HDR 圖像.

圖1 算法總體框圖Fig.1 Block diagram of the algorithm

2 算法具體實現過程

2.1 細節層分離

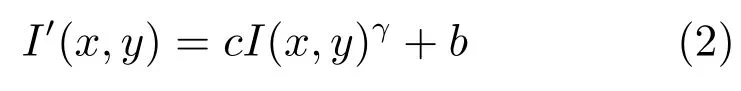

基于人眼視覺系統模型,首先將獲得的RGB 圖像轉換到HSV 顏色空間上,采用的轉換式如下:

其中,R、G、B分別為RGB 空間中3 個分量的像素值,H、S、V 分別為HSV 空間中3 個分量的值,max 表示取括號中像素值的最大值,min 表示取括號中像素值的最小值.因為在HSV 空間中H 分量用角度表示,故當H <0 時,需要將H 分量加上360.

基于細節層分離的算法,首先需要對分離出來的亮度分量進行細節層的分離,然后對不同層進行反色調映射處理,最后再將各層及圖像各個分量相融合,這使得該算法在算法邏輯上比之前的方法更為復雜.為了保證算法運行的效率,使算法能夠達到實時運行,在反色調映射函數的構建上選用了更為簡單快速的方法,但這也導致在反色調映射過程中,對LDR 圖像的亮度處理更為粗糙,缺少對低亮度值像素點重新線性化的過程,影響反色調映射效果,因此需要在反色調映射之前額外增加伽馬(Gamma)校正,對圖像進行預處理.

2.1.1 伽馬校正

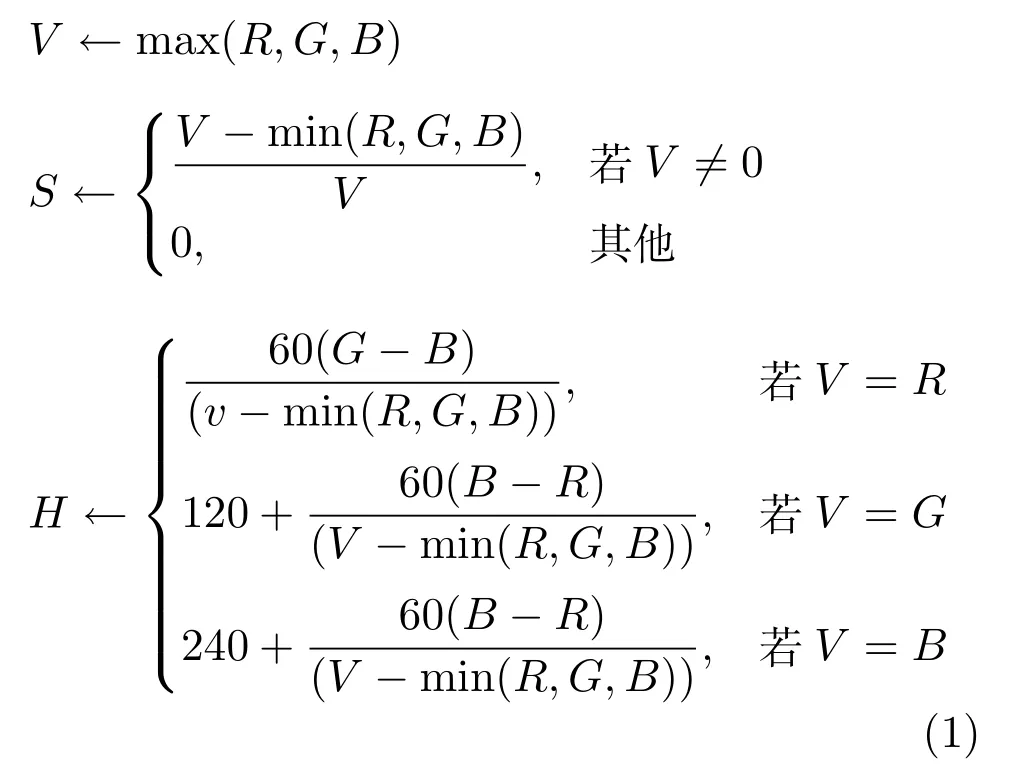

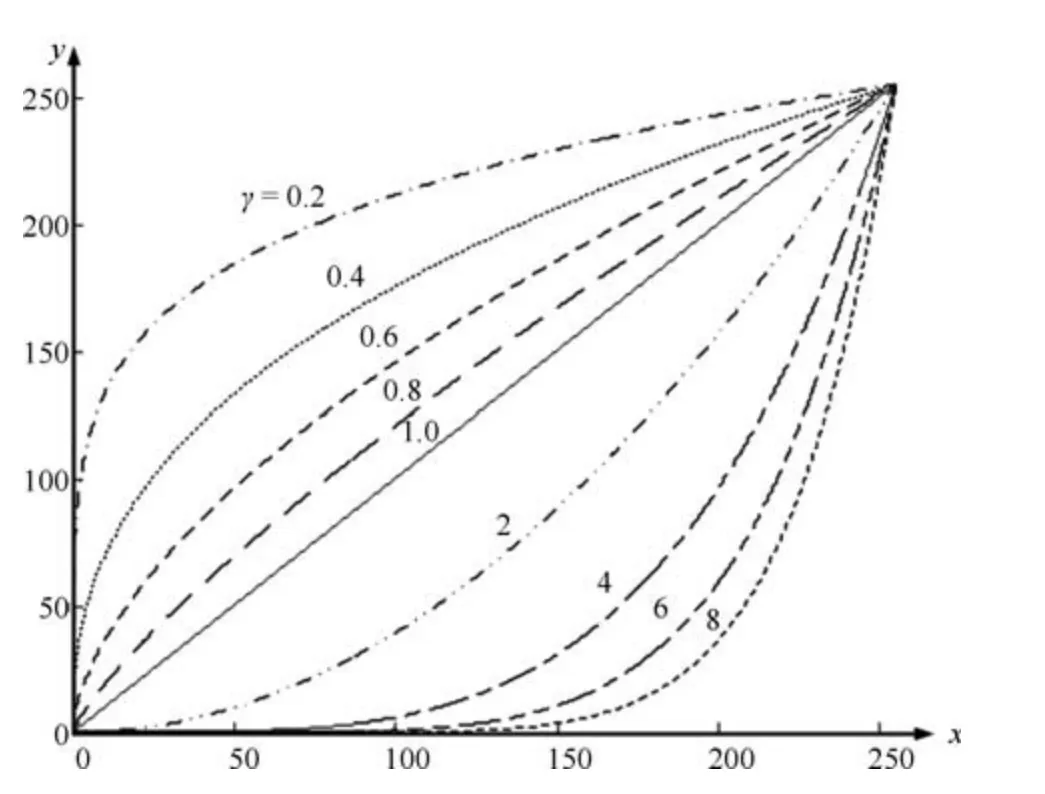

伽馬校正指利用指數運算對圖像亮度曲線進行校正的過程,伽馬校正公式為

圖2 伽馬變換函數Fig.2 Gamma transform function

人眼視覺系統對光的敏感度在不同亮度下是不同的,根據斯蒂文思冪定律人眼對低亮度部分更為敏感,對較亮的亮度值之間的感知力明顯減弱,人眼對亮度的感知曲線類似于伽馬值為1/2.2 時的曲線.故為了貼合人眼視覺的感知程度,本文選用1/2.2 作為伽馬值.

2.1.2 細節層分離

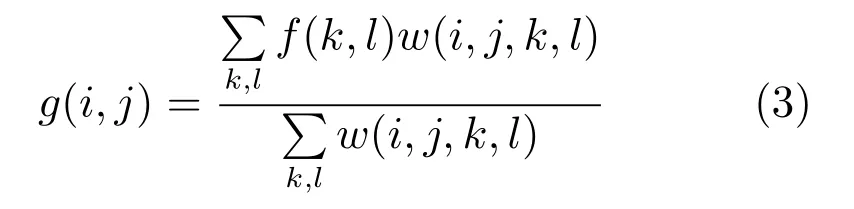

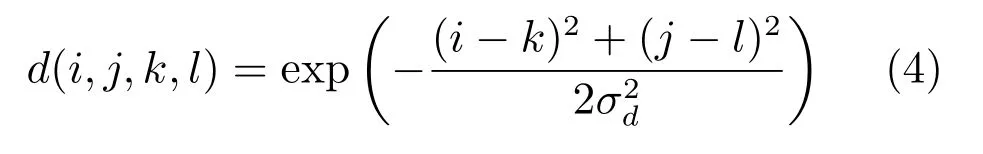

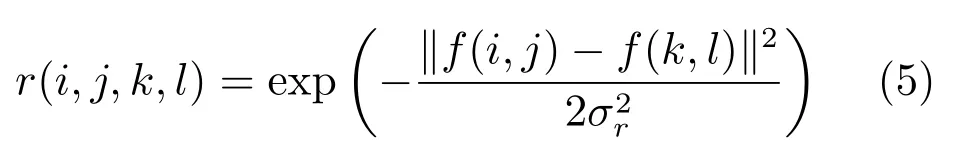

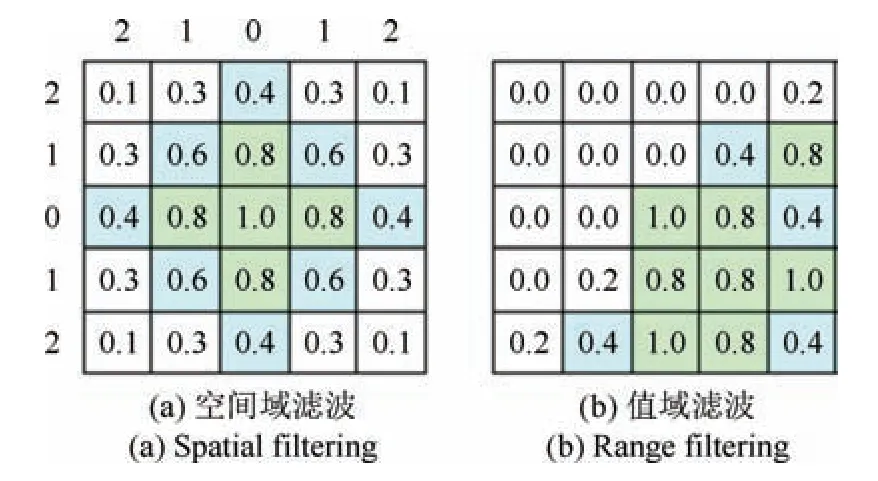

在基于細節層分離的單曝光HDR 圖像生成算法中,很重要的一步是通過選用濾波器來得到基本層,濾波器的選用直接關系到細節層所含細節的效果如何.不同的濾波操作得到的基本層數據也不盡相同.高斯濾波為

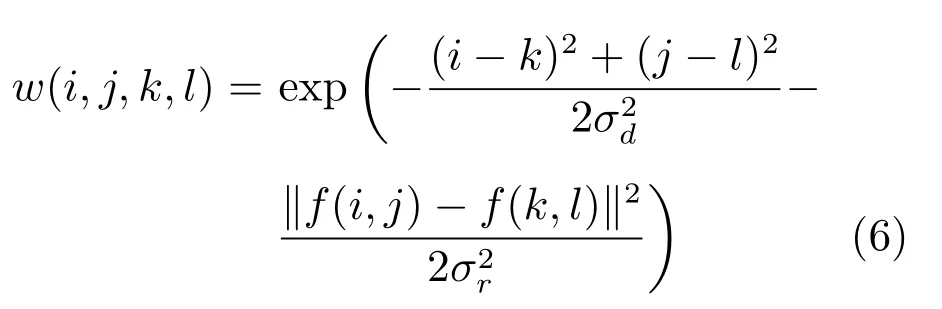

其中,i,j為對應像素點的行列坐標,k,l分別為空間域和值域的鄰域范圍內像素點的坐標,加權系數w(i,j,k,l)取決于空間域核和值域核的乘積,分母的計算結果為一個歸一化常數.

空間域核表示為

值域核表示為

空間域濾波和值域濾波的對應圖示如圖3 所示.

圖3 空間域濾波和值域濾波對應圖示Fig.3 Corresponding figure of spatial filtering and range filtering

兩者相乘后,就會產生依賴于數據的雙邊濾波權重函數,如下:

由于雙邊濾波的濾波器系數同時由幾何空間距離和像素差值決定,所以是一種典型的保邊濾波方法,主要對圖像的內容進行濾波,而對圖像的邊緣濾波效果較弱.圖像中的細節部分也往往出現在非邊緣區域,所以采用雙邊濾波能夠達到分離圖像細節層的目的.

對伽馬校正后的圖像進行雙邊濾波操作可以得到圖像的基本層.由于為獲得圖像的基本層,主要是對圖像包含大量細節信息區域進行了濾波操作,正好保留了場景中主要光源的輻射范圍,通過伽馬校正圖像與基本層進行對應像素相減,可以將原圖中的細節層分離出來,即

其中,Ib(x,y)表示圖像的細節層,Id(x,y)表示圖像的基本層.由于直接采用伽馬校正圖像與基本層之差得到的細節層,高光區域在融合過程中容易出現塊效應,為避免塊效應的出現,本文采用細節層除以基本層的方法對細節層進行壓縮,因為細節層非細節部分像素值為零,除以基本層不會對細節層非細節部分產生影響.而塊效應通常發生在高光區域,基本層中不同區域像素值大小不同,高光區域像素值更大,暗區域像素值更小,這樣可以對亮暗不同區域細節進行不同比例的壓縮,同時,也符合人眼視覺系統對暗區域亮度更敏感的特性,即

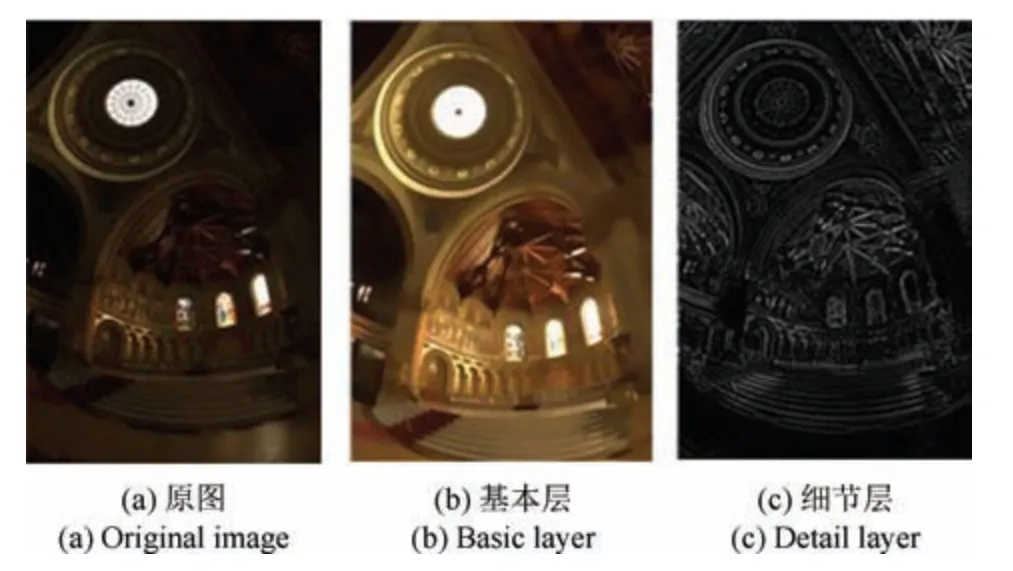

其中,Ib(x,y)表示基本層圖像的像素值,Id(x,y)表示得到的細節層的像素值.采用雙邊濾波處理得到的細節如圖4 所示,可以看出,用本文方法可以很好地分離出圖像的基本層和細節層.

圖4 細節層分離結果圖Fig.4 Results of the detail layer separation

2.2 反色調映射算子的構造

選用基于Schlick 的色調映射方法[24]來構造反色調映射算子.色調映射方法如下:

其中,LC和Lw分別表示顯示亮度和現實世界的亮度值,Lmax表示場景中亮度的最大值,參數p是一個常數值作為一個調整參數.由式(9)可知,該色調映射算法是通過某一像素點與最亮點的比值來進行壓縮映射.參數p越大,Lmax在映射過程中影響越小,壓縮比例越小.反之則越大.其值可由被映射的亮度范圍確定,當被映射的亮度范圍較小時,其亮度值的分辨率較小,需要更大地壓縮亮度值,反之壓縮程度較小.因此,參數p可以由下面公式得到:

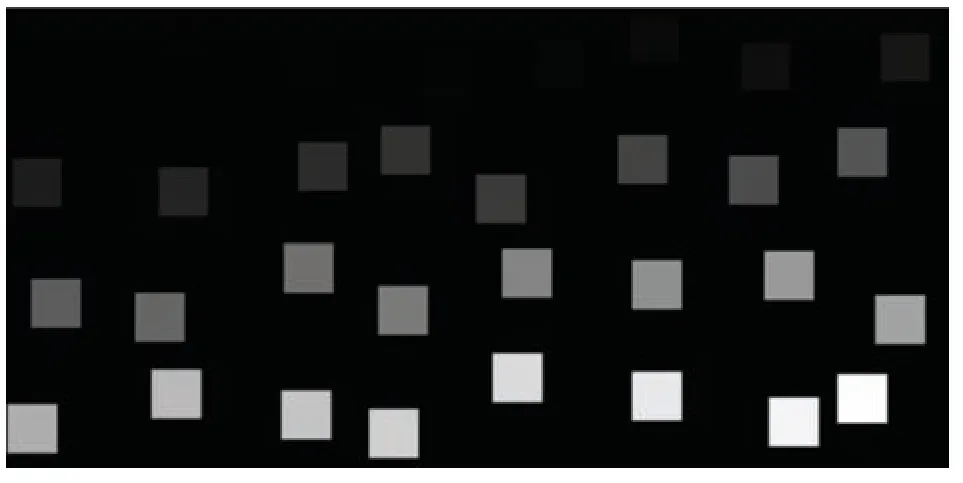

其中,θ為調整參數,可以取值為1.L0表示背景為純黑色時剛好可以被人眼察覺到變化的窗口的差值相加,N為窗口的個數,即求取其平均值.換句話說,p可以被看作在色調映射之前不是黑色的最小值.而如Schlick 所述[24],可以通過簡單的實驗來確定L0,利用顯示在黑色背景上的隨機位置處具有不同亮度的斑塊.可以觀察到不同于黑色的最小值為L0.通過試驗,本文采用類似的方法來直接獲取L0的值,這里采用圖5 來進行試驗.

圖5 試驗用圖Fig.5 Test image

首先在圖5 中找到能區分出來的最低亮度斑塊,之后確認其像素值,得到需要的結果.經過多次試驗,在未歸一化的[0,255]的像素值域中,根據顯示設備和觀察狀態的不同,L0的值約為5~9,本文取值為5,歸一化后約為0.02.這里的Lmax和Lmin分別表示人眼對現實世界場景中能感知到的瞬時最大和最小亮度.雖然這個值隨場景而改變.但Lmax/Lmin可以看作一個場景的對比度.考慮到人眼在非極限條件下,瞬時動態范圍為3 階[10,24],因此本文選擇Lmax/Lmin為103,進而可得出p的值.

利用式(9)和式(10)可以直接推出反色調映射函數如下:

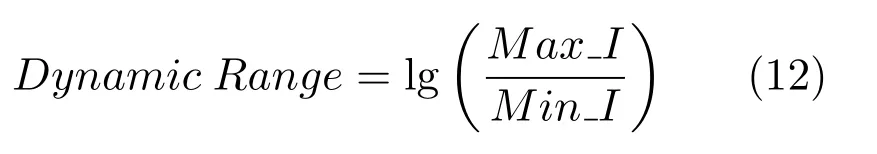

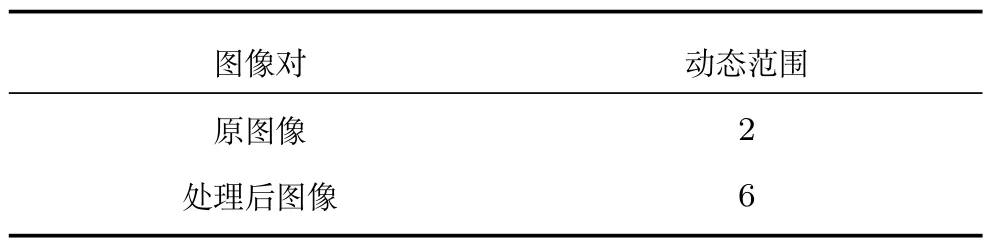

通過前面的推導可知,目前唯一沒有得到的參數為Lmax.在式(11)中,Lmax表示現實中某一場景的最大值,而在反色調映射函數中,可以將之設置為HDR 顯示設備的最大像素值.經過反色調映射后的處理圖如圖6 所示,左側為原圖,右側為反色調映射結果圖,表1 展示了處理前后圖像動態范圍對比結果,動態范圍的計算方法為

其中,Max-I表示圖像中最亮點的亮度值,Min-I表示圖像中最暗點的亮度值.從表1 可以看出,經過反色調映射后,圖像的動態范圍得到擴展,由低動態范圍圖像擴展成為高動態范圍圖像.

表1 處理前后動態范圍對比Table 1 Comparisons of dynamic range

圖6 反色調映射處理對比圖Fig.6 Comparison image after the inverse tone mapping

2.3 圖像融合

將得到的新的亮度分量圖像與色度、飽和度分量圖像融合,得到HSV 空間下的HDR 圖像,再轉化為RGB 空間下的HDR 圖像,最后進行去噪操作,得到去噪后的HDR 圖像.在整個處理過程中,引入的噪聲通常為高斯噪聲或椒鹽噪聲,這里的去噪操作可以采用高斯去噪等常用去噪方法,當椒鹽噪聲占絕大多數時,則采用中值濾波.

經過前面的處理后,將得到的兩幅反色調映射圖像進行融合.由于在LDR 圖像中,暗區往往存在較多的噪聲,而在分離細節層的過程中雖然進行了一定的壓縮,但仍不能完全消除.因此在進行圖像融合時,對圖像暗區域進行簡單處理.

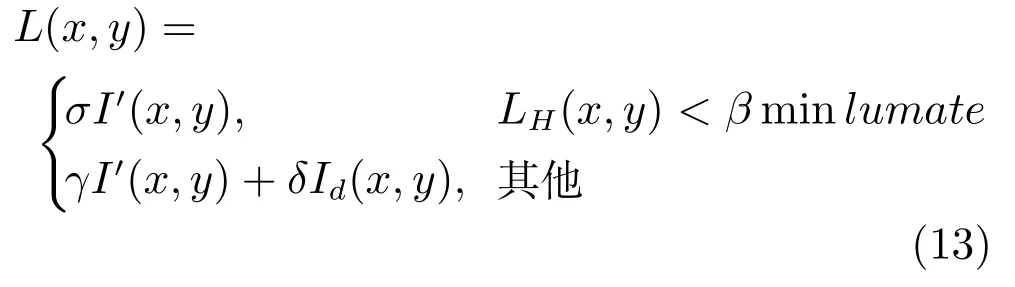

基于算法計算效率的考慮,本文采用的融合方法與基于光源采樣[22]的融合方法類似,但針對融合圖像的不同而進行了參數的調整,以得到更好的效果.采用式(13)對獲得的兩幅反色調映射圖像進行融合.

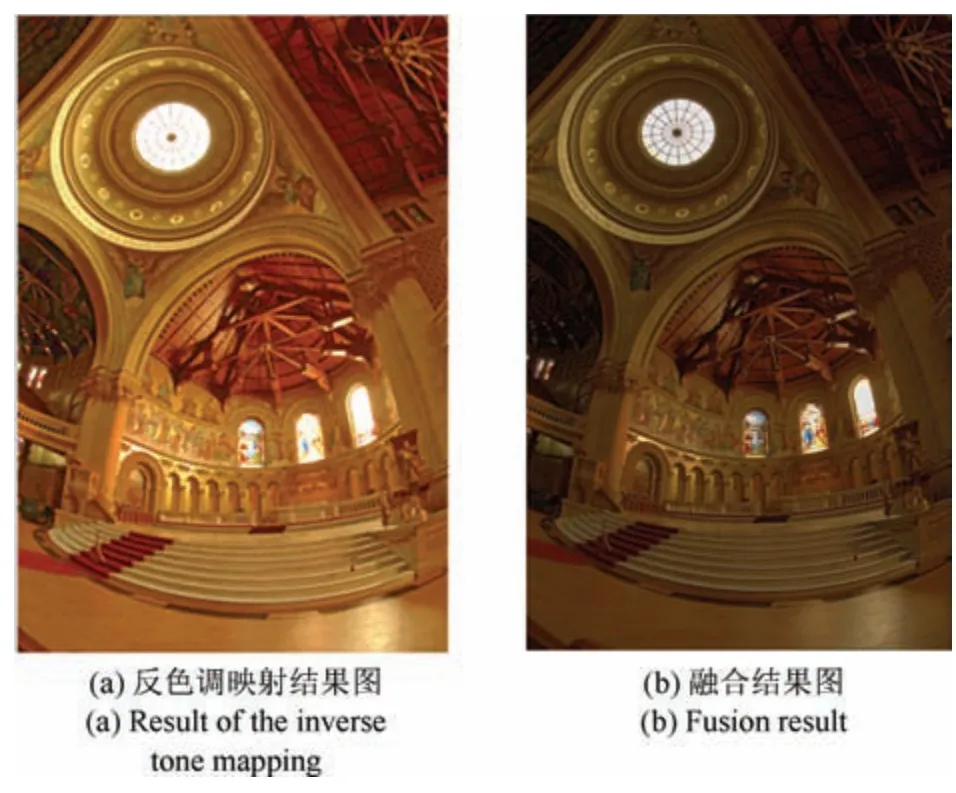

其中,L(x,y)為新的亮度分量圖像素值,和Id(x,y)分別為伽馬校正后的亮度圖像和細節層的反色調映射圖,σ、β、γ、δ為融合參數,當反色調映射圖像中的像素點小于最小亮度值的β倍時,圖像最終亮度為此時不融合細節層信息,以減少噪聲的影響,否則為與Id(x,y)的加權相加.本文取值分別為σ0.5,β1.5,γ0.8,δ0.2.圖像融合結果如圖7 所示.

圖7 融合結果對比Fig.7 Comparison result

本文算法的具體步驟如下:

步驟1.將輸入的LDR 圖像從RGB 顏色空間轉換為HSV 顏色空間,分離出H (色度)、S (飽和度)和V (亮度)分量.

步驟2.對分離出的亮度分量圖像進行伽馬校正.

步驟3.對步驟2 中得到的伽馬校正圖像進行濾波操作得到圖像基本層.

步驟4.通過對伽馬校正圖像與基本層進行遍歷運算操作,得到細節層.

步驟5.構造反色調映射函數,分別對步驟4 獲得的細節層和步驟2 獲得的伽馬校正圖像進行反色調映射操作,得到各自的反色調映射后的圖像.

步驟6.融合步驟5 中得到的兩幅反色調映射圖像,得到新的亮度分量圖像.

步驟7.將步驟1 分離的飽和度S、色度分量H與步驟6 新得到的亮度分量進行融合的到HSV 顏色空間中的HDR 圖像.

步驟8.將步驟7 得到的HSV 顏色空間下的HDR 圖像轉換到RGB 顏色空間.

步驟9.將步驟8 獲得的圖像進行去噪處理,消除噪聲,得到最終的HDR 圖像.

3 仿真與分析

在CPU 為Pentium(R)D,3.30 GHz,內存為8 GB 的計算機上,使用vs2013+OpenCV2.4.11對基于細節層分層的單曝光HDR 圖像生成算法進行實驗驗證,并將本算法實驗結果與經典的Akyuz算法[13]、Banterle 算法[12]、Huo 算法[4]和Zhu 算法[22]進行對比,對得出的實驗結果分別給出了主觀和客觀評價分析.

3.1 主觀評價

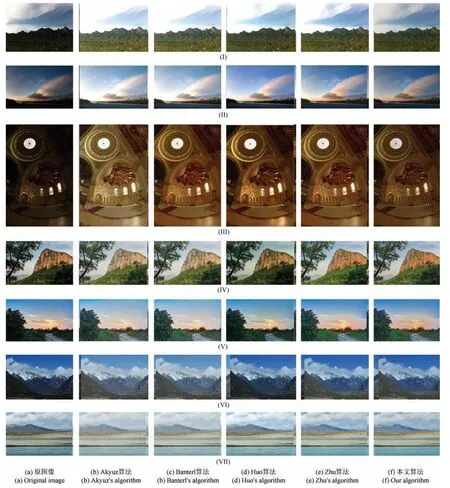

圖8 是幾種算法的運算結果,為便于展示,將HDR 圖像色調映射到普通顯示屏顯示范圍上比較.從左到右圖像序列依次為原圖像、Akyuz 算法、Banterle 算法、Huo 算法、Zhu 算法以及本文算法的處理結果.從幾種算法的結果可以看出,Akyuz 算法和Banterle 算法存在著色彩信息偏移問題,圖像整體偏白,而Huo 算法在擴展過程中,色彩信息保持較好,但在圖像的細節信息上有一定損失,圖像部分區域涂抹感較嚴重,例如圖中支架結構及穹頂內圖案部分(圖8(a)).Zhu 算法色彩保持較好,但某些地方細節對比度有減弱的情況.而本文提出的算法,由于采用了細節層分離,使圖像中的細節信息在圖像生成過程中得到了較好的還原,特別是過曝光和欠曝光區域與其他幾種算法相比有了較大的進步.

目前生成HDR 圖像常見的方法是采用多曝光圖像序列(如圖9 所示)進行合成.本文采用hdrsoft 圖像處理工具對多曝光圖像序列進行合成得到HDR 圖像,并將獲得的圖像作為真實世界動態范圍相近的影像實測數據(Ground truth),同時采用圖像序列中的一幅圖片作為原始LDR 圖像來生成HDR 圖像.

圖10 是本文算法與多曝光融合HDR 圖像的對比圖,為便于顯示,同樣采用了色調映射處理.最左側圖像為本文算法處理的單曝光LDR 圖像,中間圖像為多曝光圖像序列融合而成的HDR 圖像,最右側為本文算法的處理結果圖.

從圖10 可以看出,采用多曝光圖像融合而成的HDR 圖像相較于本文提出的基于細節層分離的單曝光圖像生成算法而言,對比度更大,色彩表現力更強.但與此同時,由于采用多曝光融合的方法,在一些原本色調統一的區域,經過處理后可能出現色彩分布不均勻的現象,例如白色建筑的天空區域.而兩種算法除去對比度的不同以外,在圖像細節信息上表現基本一致.

3.2 客觀評價

圖8 幾種算法結果對比Fig.8 Comparison results of several algorithms

圖9 白頂建筑LDR 圖像序列Fig.9 LDR image sequences of white top architecture

圖10 本文算法處理與實測數據對比Fig.10 Comparisons of our algorithm and ground truth

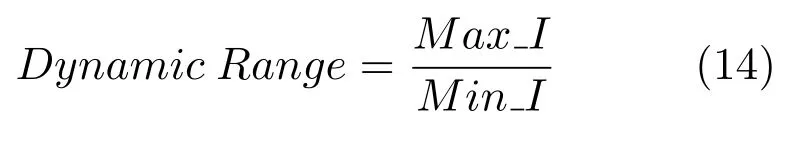

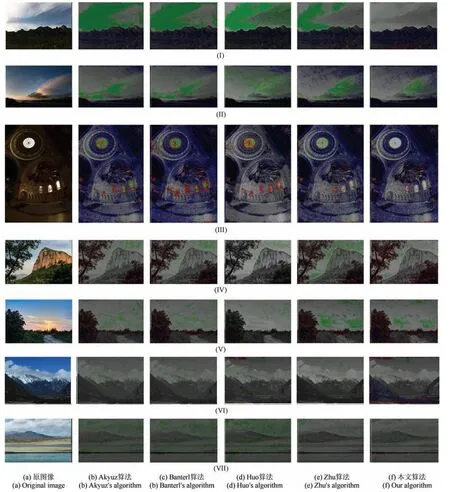

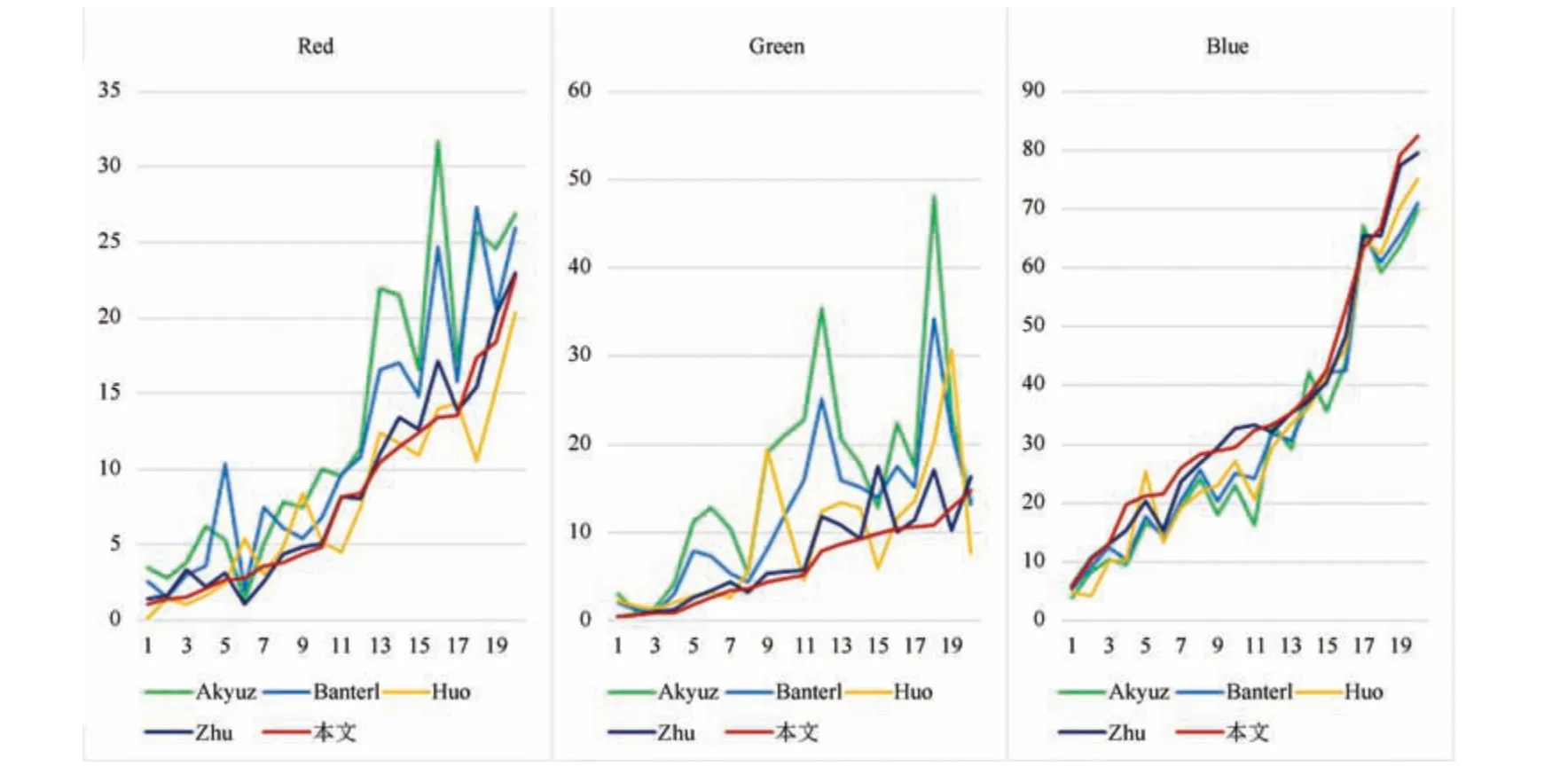

采用DRIM (Dynamic range independent image quality metric)[25]對算法進行客觀評價.DRIM 將原LDR 圖像與處理后的HDR 圖像進行對比,來得到3 種不同類型的失真,分別用紅、綠、藍3 種顏色表示.紅色表示對比度翻轉(HDR 圖像的對比關系在該部分與相應LDR 圖像相反).綠色表示對比度丟失(LDR 圖像可見的信息在HDR 圖像中丟失).藍色表示對比度增強(LDR 圖像中不可見或不容易看見的信息在HDR 圖像中被增強為可見信息).DRIM 對比圖如圖11 所示,從左到右圖像列分別為原圖像、Akyuz、Banterl、Huo、Zhu 以及本文算法的DRIM 結果圖.通過圖11 可以直觀地看出不同算法的各種效果.表2 是3 種色彩所占圖像像素點的比例.DRIM 的結果表明,本文基于細節層分離的單曝光HDR 圖像生成算法提升了圖像的動態范圍,在增強圖像細節信息的同時,盡可能少地減少了圖像細節信息的丟失,在保留圖像細節信息上,總體表現為幾種算法中最好的一種.

圖12 是DRIM 對隨機選取的20 幅不同單曝光HDR 生成圖像的評價結果折線圖.從左到右分別為紅、綠、藍3 種顏色像素點所占百分比,每幅圖的縱坐標為像素所占百分比,橫坐標表示每一幅生成的HDR 圖像.從圖12 可以看出,除了在紅色像素點,Huo 算法比本文提出的兩種算法在個別圖像中表現更好以外,在綠色像素點本文提出的兩種算法所占百分比總體都低于其他3 種對比算法.藍色像素點部分本文提出的兩種算法同樣優于對比算法.

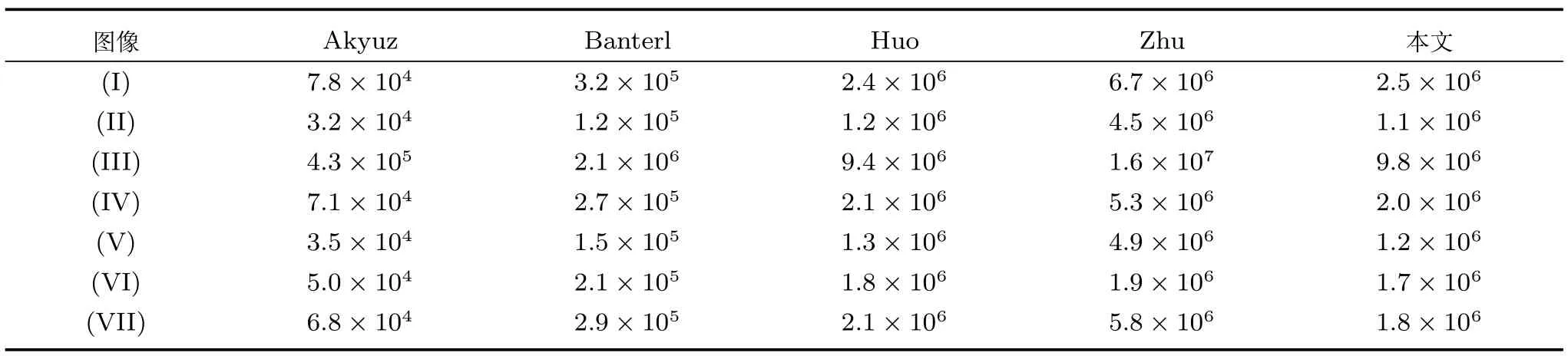

表3 是5 種算法對圖8 中的7 幅圖像處理后的圖像動態范圍.由于處理結果中會出現動態范圍數量級相同,但具體數值不同的情況,因此為了更清晰地反映算法性能差別,在表達動態范圍時不作對數處理,此處采用的動態范圍的計算方法為

表2 DRIM 對比圖中紅、綠、藍各像素點所占百分比(%)Table 2 Percentage of red pixel,green pixel and blue pixel in DRIM (%)

圖11 幾種算法DRIM 對比圖Fig.11 DRIM comparisons of several algorithms

其中,Max-I表示圖像中最亮點的亮度值,Min-I表示圖像中最暗點的亮度值.從表3 可以看出,Zhu算法的基于光源采樣的單曝光HDR 圖像生成算法,由于對光源的采樣和模擬,動態范圍表現最好,其次為基于細節層分離的單曝光HDR 圖像生成算法與Huo 算法.

3.3 運算時間

對于分辨率為600 像素×400 像素的圖片,Akyuz 算法所用平均時間為0.03 s,Banterl 算法為4.13 s,Huo 算法為0.15 s,Zhu 算法為0.106 s,而本文算法耗時為0.058 s,滿足了對標清圖像進行實時處理的要求.

表3 圖像處理后動態范圍對比Table 3 Comparisons of dynamic range

圖12 DRIM 紅、綠、藍百分比折線圖Fig.12 Line charts of red,green and blue percentage in DRIM

4 結論

針對單曝光LDR 圖像細節信息不足的問題,本文提出了一種基于細節層分離的單曝光HDR 圖像生成算法.該算法結合HVS 模型,將LDR 圖像分離出亮度分量和色度分量.對分離出來的亮度分量進行Gamma 校正,之后再對Gamma 校正后的圖像采用雙邊濾波操作,進行基本層與細節層分離;然后將分離出來的細節層與Gamma 校正后的亮度分量分別進行反色調映射后進行融合得到新的亮度分量;最后將各圖像分量進行融合去噪得到最終的HDR 圖像.通過與其他3 種經典的單曝光HDR 圖像生成算法比較,本文算法可以有效地提高圖像的動態范圍,并挖掘出LDR 圖像中部分隱藏的細節信息,在一定程度上彌補了單曝光LDR 圖像細節信息不足的缺點,但對于存在極大面積飽和區域像素點的圖像處理效果不佳,與此同時,為了算法效率考慮,在反色調映射過程中,犧牲了一定的擴展效果,下一步需要對算法效率進一步提高,并改善反色調映射算子.