基于眼優(yōu)勢的非對稱失真立體圖像質(zhì)量評價

唐祎玲 江順亮 徐少平 劉婷云 李崇禧

由于立體圖像質(zhì)量評價(Stereoscopic image quality assessment,SIQA)算法能夠為各類圖像處理系統(tǒng)的參數(shù)設置及性能優(yōu)化提供可靠的依據(jù),受到了研究者廣泛的關(guān)注[1?4].目前,絕大部分SIQA算法主要針對左右視點圖像失真類型相同、失真程度相近的對稱失真立體圖像.然而在實際應用中,左右視點圖像容易出現(xiàn)失真程度不同或失真類型不同的非對稱失真的情況,許多SIQA 算法在評價非對稱失真立體圖像時效果不佳.如何充分利用立體圖像中包含的非對稱失真信息,提高SIQA 算法對非對稱失真立體圖像的評價準確性是亟待解決的問題.

早期的SIQA 算法主要利用已有的2D 全參考圖像質(zhì)量評價算法預測立體圖像左右視點的質(zhì)量值,并將兩個視點的質(zhì)量均值作為立體圖像最終的質(zhì)量值[5].然而,人類視覺系統(tǒng)(Human visual system,HVS)主要是依賴大腦的初級視覺皮質(zhì)對雙目視覺輸入進行處理并建立立體認知的[6?7],其處理過程的生理機制非常復雜[8],并非是簡單的左和右眼輸入質(zhì)量的平均效果.因此,當左右視點圖像出現(xiàn)非對稱失真的情況時,算法的評價準確性會明顯下降.

近年來,一些學者模擬HVS 中雙目競爭的工作原理,采用將左右視點圖像的質(zhì)量值或特征進行加權(quán)平均的方式來提高立體圖像質(zhì)量的預測準確性.例如,Wang 等[9]提出一種基于信息內(nèi)容和失真權(quán)重的結(jié)構(gòu)相似性(Information content and distortion weighted structural similarity,IDWSSIM)算法,將左右視點圖像的質(zhì)量預測值的加權(quán)平均值作為立體圖像質(zhì)量值.Shao 等[10]使用字典學習方法計算左右視點的特征權(quán)重,并采用加權(quán)平均的方式融合左右視點的多種特征值.另一些學者基于HVS 中簡單細胞和復雜細胞的工作原理,建立了雙目能量響應[11?12]、獨眼圖像(Cyclopean image,CI)[13]等多種融合模型來提高SIQA 算法的性能.例如,Chen 等[14?15]采用Gabor 濾波響應對雙目視覺刺激強度進行建模,生成獨眼圖像,構(gòu)造了全參考的Chen FR[14]和無參考的Chen NR[15]算法.Su 等[16]合成了收斂獨眼圖像(Convergent cyclopean)來構(gòu)造無參考SIQA 算法.Shen 等[17]基于深度圖、顯著圖(Saliency map)以及獨眼圖像來實現(xiàn)無參考SIQA 算法.Liu 等[18]則提出立體整合質(zhì)量(S3D integrated quality,SINQ)算法,基于左右視點圖像的空間活動度量(Spatial activity)來獲得獨眼圖像實現(xiàn)SIQA.盡管上述基于一幅融合圖像的SIQA 算法部分地模擬了雙目信息在人腦中的匯聚過程,部分地提高了算法的評價準確性,但這類算法只是以左視點或右視點圖像中的一幅作為主視圖,將另一幅圖像與主視圖進行融合,不能全面地描述立體圖像中所有的失真信息,在評價非對稱失真立體圖像的質(zhì)量時準確性仍然不能令人滿意.

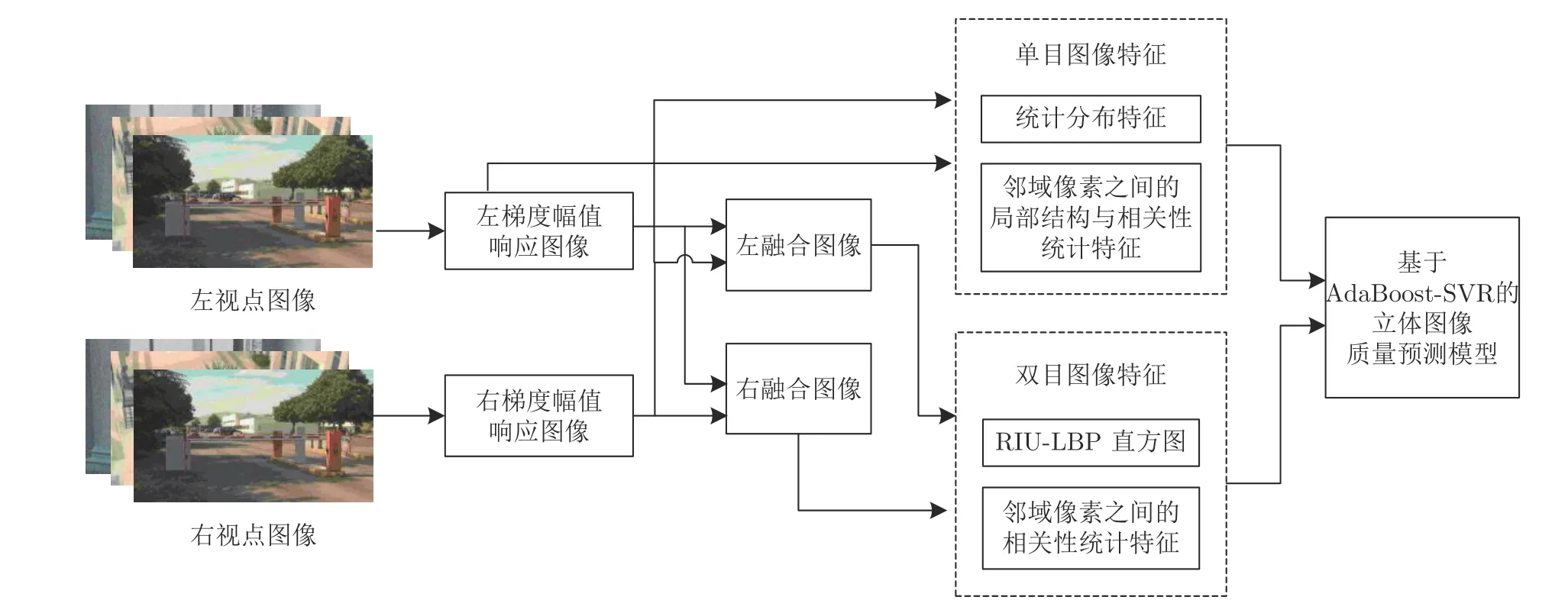

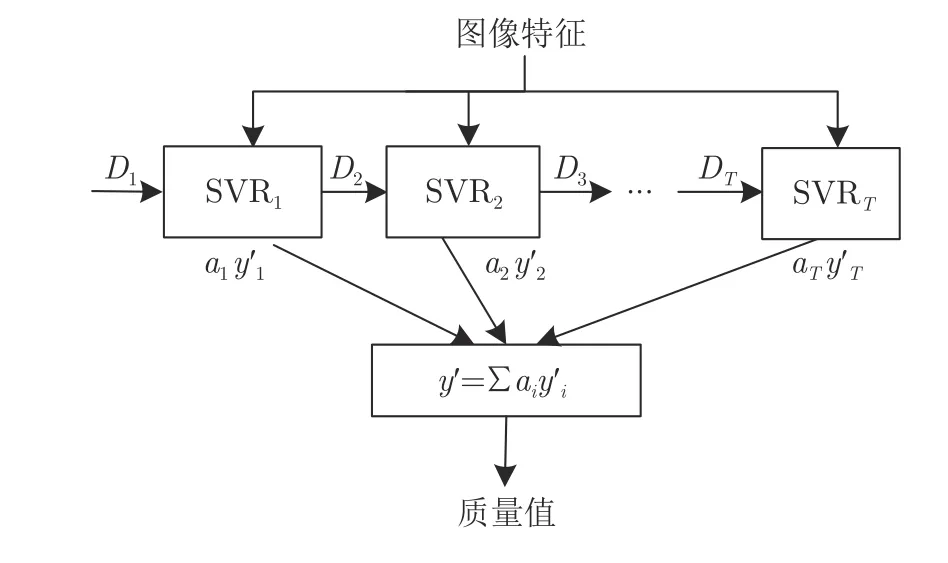

為此本文基于Hubel 和Wiesel[7]發(fā)現(xiàn)的眼優(yōu)勢(Ocular dominance)現(xiàn)象,即視覺皮層中存在兩類分別對左眼和右眼輸入產(chǎn)生更為強烈響應的雙目細胞(Binocular cells)[8],提出一種基于眼優(yōu)勢的非對稱失真(Ocular dominance based asymmetrically distorted,ODAD)SIQA 算法.分別以左和右視點圖像作為主視圖生成兩幅不同的融合圖像,來模擬視覺皮層的左和右眼優(yōu)勢柱對雙眼信息的處理.ODAD 算法的模型如圖1 所示.

圖1 基于眼優(yōu)勢的非對稱失真立體圖像質(zhì)量評價算法框圖Fig.1 The diagram of asymmetrically distorted SIQA algorithm based on ocular dominance

與使用單幅基于Gabor 濾波響應獨眼圖像的SIQA 算法[13?18],以及使用左右眼優(yōu)勢之間的差異及視差補償?shù)腟IQA 算法[19?20]不同,ODAD 算法利用失真圖像的梯度幅值響應圖像(Gradient magnitude response image,GMRI)來模擬人類視覺輸入刺激,分別以左和右視點圖像作為主視圖,合成兩幅融合圖像(左和右融合圖像)來增強算法對非對稱失真圖像的評價準確性和魯棒性.在提取雙目圖像特征時,利用旋轉(zhuǎn)不變統(tǒng)一局部二值模式(Rotation invariant uniform local binary patterns,RIU-LBP)[21]直方圖描述左右融合圖像的特點和差異,利用皮爾遜線性相關(guān)系數(shù)(Pearson linear correlation coefficient,PLCC)獲取融合圖像鄰域像素之間的相關(guān)性變化.同時,采用非對稱廣義高斯(Asymmetric generalized Gaussian distribution,AGGD)模型擬合單目圖像的GMRIs 及其鄰域像素之間乘積圖的統(tǒng)計分布,并利用PLCC 來量化GMRIs 鄰域像素之間的相關(guān)程度.最終,利用自適應增強的支持向量回歸(Support vector regression,SVR)算法將雙目與單目圖像的感知特征值映射為立體圖像質(zhì)量值,并在多個基準測試數(shù)據(jù)庫上驗證所提出算法的性能和執(zhí)行效率.

1 梯度幅值響應圖像

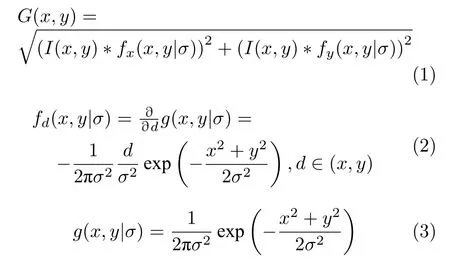

經(jīng)典的Gabor 濾波器因其可以通過在頻域的多個尺度和多個方向上的圖像信息來描述圖像輪廓,在許多SIQA 算法[14?16]中被使用.但是Gabor變換是一種非正交變換,其不同特征分量中存在較多冗余信息,且計算所耗費的時間和存儲空間較大,會使算法的效率降低.而圖像中局部梯度幅值最大的像素點也可以形成物體的輪廓,能夠描述人眼感知系統(tǒng)非常敏感的圖像局部語義結(jié)構(gòu)信息[22?23].因此,本文使用圖像的梯度幅值響應來模擬人類視覺刺激輸入強度.

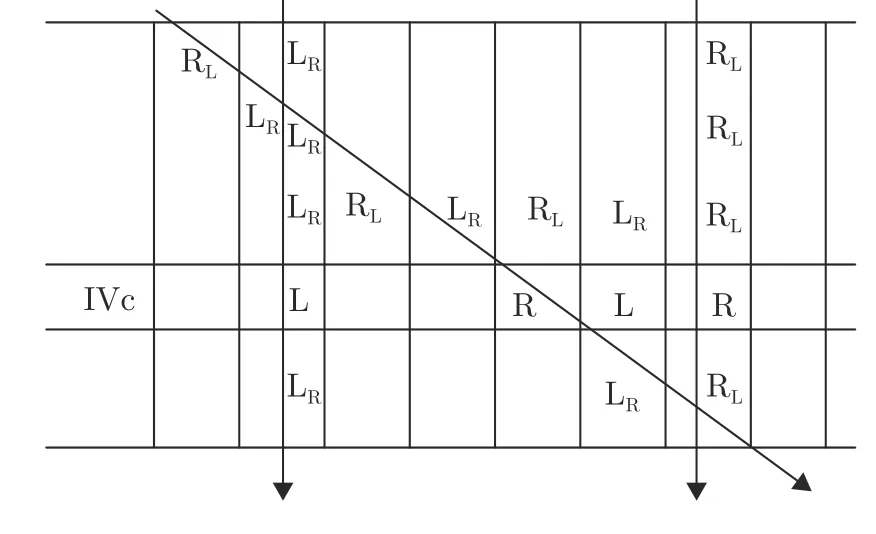

對給定的圖像I(x,y),可以使用高斯偏導數(shù)濾波器計算GMRI(G(x,y)),具體計算公式如下:

其中,?是卷積操作,fd(x,y|σ)是應用在圖像水平和垂直方向的高斯偏導濾波器,g(x,y|σ)是各向同性高斯函數(shù),σ是高斯函數(shù)的尺度參數(shù).

為了說明GMRI 和Gabor 濾波圖像的不同,圖2以一幅失真圖像為例,給出該圖像及其GMRI 和Gabor 濾波圖像[14?15].從圖2 可以看出,盡管Gabor濾波響應更為明亮一些,但Gabor 濾波圖像的邊緣較為模糊,而GMRI 的邊緣信息更加清晰,說明梯度幅值響應能夠更好地測量局部區(qū)域的亮度強度變化,刻畫出圖像的結(jié)構(gòu)信息.此外,以LIVE Phase I 數(shù)據(jù)庫[14]中的10 幅 640×360 的圖像為例,計算10 幅圖像的GMRIs 的平均時間只需要0.0103 s,僅是計算Gabor 濾波圖像[14?15]平均時間4.6516 s的0.22 %,說明了使用梯度幅值的高效性.

圖2 失真圖像及其GMRI 和Gabor 濾波圖像Fig.2 The distorted image,the GMRI,and the Gabor response image

2 左右融合圖像的生成

2.1 眼優(yōu)勢柱的視覺原理

Hubel 和Wiesel 在研究貓和獼猴的視覺皮層時發(fā)現(xiàn)視覺皮層中存在著多種工作機制不同的細胞[7,24].其中,有一些細胞只能被左眼或右眼所驅(qū)動,即是被單目(Monocular)驅(qū)動的.還有一些細胞能夠被雙目(Binocular)同時驅(qū)動,且兩眼輸入對雙目細胞的影響并不完全相同,存在眼優(yōu)勢現(xiàn)象,即雙目細胞對某一只眼的輸入存在偏好,更多地根據(jù)該眼的輸入強度來產(chǎn)生響應信號.

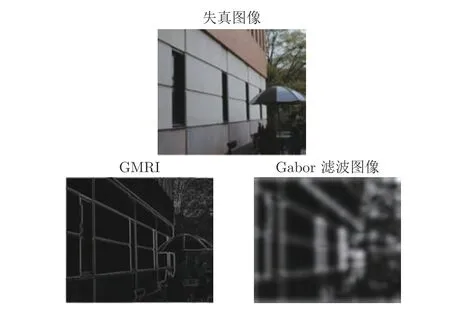

圖3 獼猴視覺皮層的橫截面示意圖Fig.3 A cross section through striate cortex in macaque monkey

圖3 以獼猴視覺皮層的一個橫截面示意圖[7]來說明眼優(yōu)勢現(xiàn)象.其中,截面的上邊界是視覺皮層的表面,下邊界是視覺皮層V1 層與腦白質(zhì)(White matter)之間的邊界.Hubel 和Wiesel 將電極沿垂直方向和斜向方向插入視覺皮層,來檢測視覺皮層不同區(qū)域的細胞對左右眼輸入的響應情況.當從視覺皮層垂直方向插入電極時,檢測到的所有雙目細胞只對左眼或右眼的輸入存在更為強烈的響應;將電極斜插入視覺皮層,會交替檢測到對左眼或右眼輸入響應更為強烈的雙目細胞.圖3 將對左眼與對右眼輸入響應更為強烈的區(qū)域分別標記為 LR和 RL,則可以看到在視覺皮層的水平方向上存在著交替相鄰的 RL和 LR區(qū)域.視覺皮層的第4 層(IVc 層)還包含了只對左眼與只對右眼輸入產(chǎn)生響應的區(qū)域,分別標記為L 和R.Hubel 和Wiesel 將這些水平方向相鄰的垂直條帶區(qū)域稱之為眼優(yōu)勢柱,眼優(yōu)勢柱內(nèi)所有細胞都只對來自于左眼或來自于右眼的輸入產(chǎn)生更強的響應.1997 年,Menon 等[8]通過功能磁共振成像的方法證實了人類的視覺皮層中同樣存在眼優(yōu)勢現(xiàn)象及眼優(yōu)勢柱.

2.2 左右融合圖像的生成

由眼優(yōu)勢的視覺原理可以看出,眼優(yōu)勢柱中存在兩種不同的雙目細胞.然而,目前大部分基于單幅獨眼圖像的SIQA 算法[13?18]僅僅模擬了人類視覺皮層中左眼優(yōu)勢柱中雙目細胞的功能,忽略了右眼優(yōu)勢柱中的雙目細胞.因此,本文分別以左和右視點圖像作為主視圖,合成兩幅融合圖像來模擬視覺皮層中左和右眼優(yōu)勢柱中兩類雙目細胞的功能,實現(xiàn)非對稱的立體圖像質(zhì)量評價.

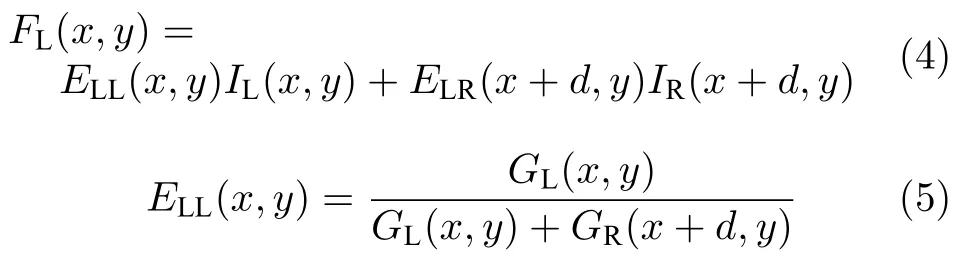

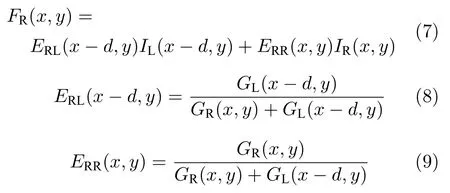

以左視點圖像作為主視圖生成左融合圖像的計算方法為:

其中,FL(x,y)為左融合圖像,IL(x,y) 和IR(x+d,y)表示左視點圖像和經(jīng)過移位后的右視點圖像,ELL(x,y)和ELR(x+d,y)表示左和右眼視覺刺激的刺激強度(權(quán)重系數(shù)),GL(x,y)為左GMRI,GR(x+d,y)為根據(jù)視差d移位后的右GMRI,d為左和右視點圖像之間的視差,采用Chen 等在文獻[14]中所使用的滑動窗口SSIM[25]算法來計算.

以右視點圖像作為主視圖生成右融合圖像的計算方法為:

其中,FR(x,y)為右融合圖像,IL(x?d,y)和IR(x,y)表示經(jīng)過移位后的左視點圖像和右視點圖像,ERL(x?d,y)和ERR(x,y)表示左和右眼視覺刺激的權(quán)重系數(shù),GL(x?d,y)和GR(x,y)分別對應移位后的左GRMI 和右GRMI,d為左右視點圖像之間的視差.

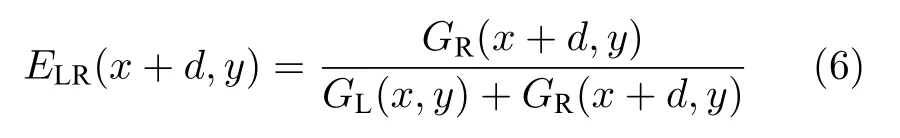

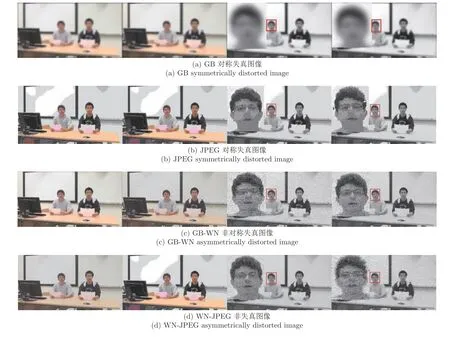

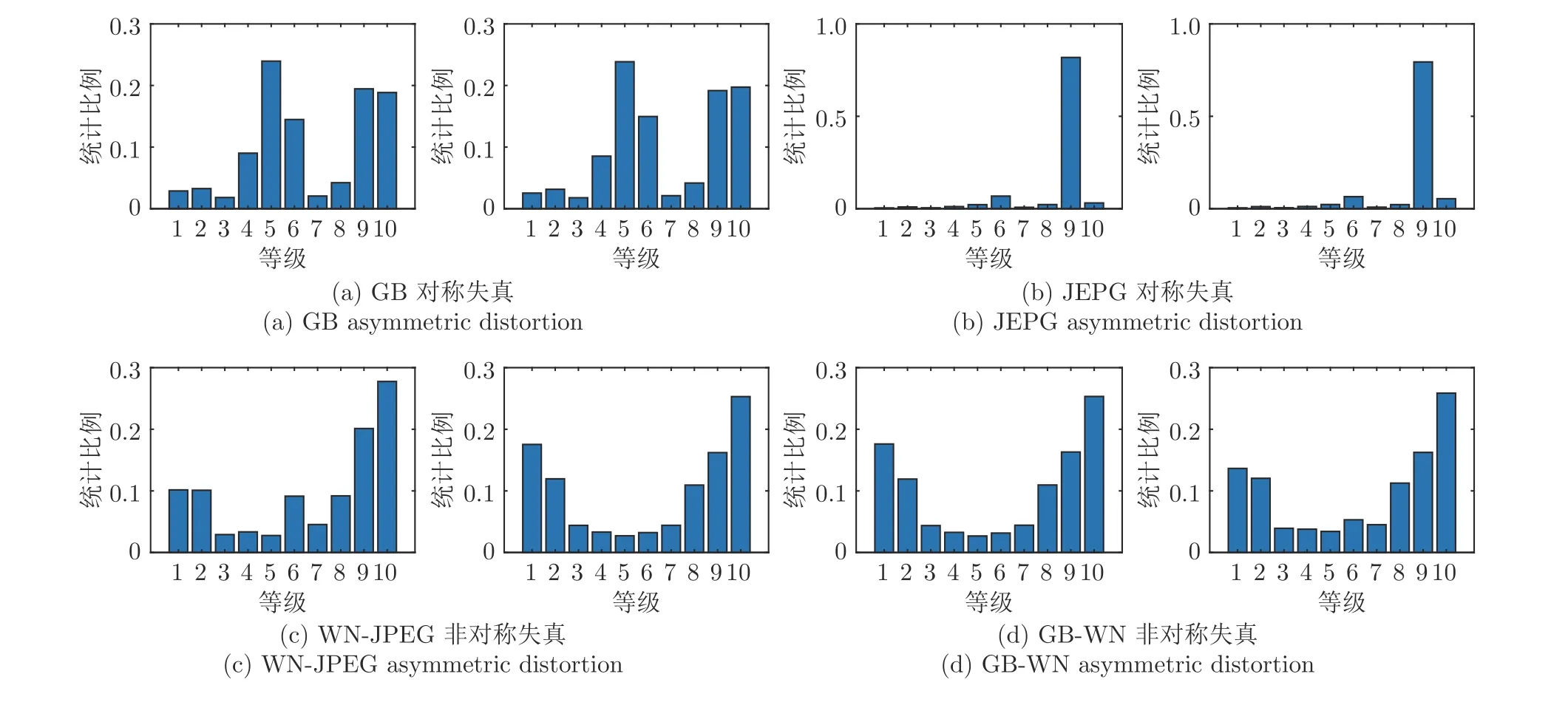

為了說明左和右兩幅融合圖像的特點和差異,從WATERLOO-IVC 3D IQA Phase II 數(shù)據(jù)庫[26](以下簡稱為IVC Phase II 數(shù)據(jù)庫)中選取4 類失真圖像作為示例,在圖4 中給出這些失真圖像及其左右融合圖像.其中包括高斯模糊(Gaussian blur,GB)對稱失真、JPEG 對稱失真、左視點為白噪聲(White noise,WN)失真右視點為JPEG 失真的非對稱失真以及左視點為GB 失真右視點為WN 失真的非對稱失真圖像.圖4 中將融合圖像中用矩形框所圈的人的頭像部分放大顯示,以便展示更多融合圖像的細節(jié)信息.

從圖4(a)和4(b)可以看出,GB 對稱失真以及JPEG 對稱失真圖像的左和右融合圖像較為相似.從圖4(c)可以看出,GB-WN 失真圖像的右融合圖像更多顯示出WN 失真的特性,而左融合圖像相比于右融合圖像更為模糊.此外,圖4(d)所示的WN-JPEG 失真圖像也有著類似的特性.由此可見,當立體圖像為對稱失真圖像時,其左和右融合圖像十分近似;當左右視點圖像失真類型不同時,左和右融合圖像存在著明顯的差異,左融合圖像與左視點圖像更為相近,右融合圖像與右視點圖像更為相近.

圖4 各類失真圖像及其左右融合圖像(從左至右的圖像依次為左視點、右視點、左融合和右融合圖像)Fig.4 The distorted images and their left and right fusion images for various distortion types (Images from left to right are left view,right view,left fusion image,and right fusion image)

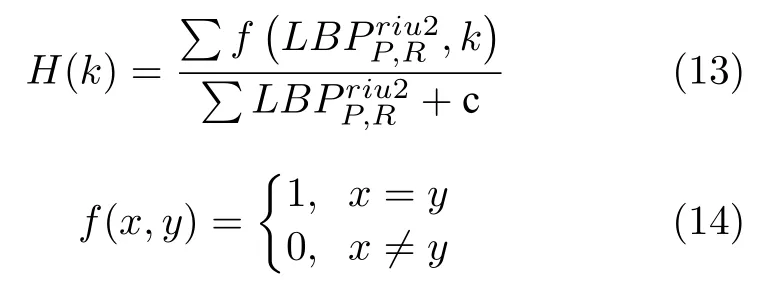

為了量化這種眼優(yōu)勢效果,選取WATERLOO-IVC 3D IQA Phase I 數(shù)據(jù)庫[9](以下簡稱為IVC Phase I 數(shù)據(jù)庫)中的100 幅失真立體圖像(其中包括對稱失真圖像26 幅,非對稱失真圖像74 幅),計算各圖像的左右融合圖像(記為FI-L 和FIR)與左右視點圖像(記為I-L 和I-R)之間的相關(guān)性及相似性,將所有圖像的相似性與相關(guān)性的中值列在表1 中.其中,相關(guān)性用兩幅圖像之間的PLCC 值來表示,相似性用SSIM 算法來計算.從表1 可以看出,無論是對稱失真還是非對稱失真圖像,FI-L 與I-L 之間的相似性和相關(guān)性比FI-L 與I-R 之間的相似性和相關(guān)性取值更大,而FI-R 與IR 之間的相似性和相關(guān)性取值也明顯大于FI-R 與I-L 之間的相似性和相關(guān)性.其原因在于左和右融合圖像分別是以左和右視點圖像作為主視圖生成的,分別包含了更多左視點和右視點圖像的信息,模擬了眼優(yōu)勢的效應.

3 圖像質(zhì)量特征提取與評價模型

視覺信息的處理是一個十分復雜的過程,雙目視覺實現(xiàn)了兩眼信息的融合,而單目視覺信息為立體視覺提供了最基本的保障[7].因此,本文從模擬HVS 雙目匯聚特性的左右融合圖像和描述圖像單目特性的左右GMRIs 中提取多種圖像質(zhì)量特征,用于立體圖像質(zhì)量預測.

3.1 雙目圖像特征提取

失真立體圖像的左和右融合圖像之間存在著細微的差別,這種差別在非對稱失真立體圖像的左右融合圖像中尤為突出.本文利用RIU-LBP 算子[21]和鄰域像素之間的相關(guān)系數(shù),來獲取左右融合圖像中能夠描述這些細微差別、反映圖像質(zhì)量改變的特征作為雙目統(tǒng)計特征.

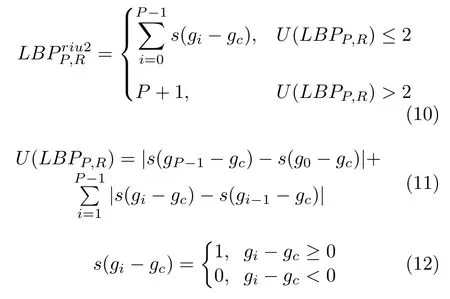

LBP 是一種經(jīng)典的描述圖像局部結(jié)構(gòu)信息的紋理算子.RIU-LBP 是一種擴展的LBP 編碼,用于提高LBP 的描述能力,其基本思想是以中心像素為閾值,在半徑為R的圓形鄰域內(nèi),選取P個與中心像素距離相等的點gi(i=0,1,···,P?1)與中心像素gc的灰度值進行比較,并通過統(tǒng)一化處理編碼,使編碼種類降低到P+2 種,以獲取圖像中的大尺寸結(jié)構(gòu)特征.RIU-LBP 的定義為:

其中,P為鄰域像素的個數(shù),R為鄰域像素的半徑,U指空間轉(zhuǎn)換時0-1 和1-0 轉(zhuǎn)換的次數(shù),s(gi?gc)是融合圖像的一個局部區(qū)域內(nèi)鄰域像素gi(i=0,1,···,P?1)與中心像素gc的比較函數(shù).最終,將左右融合圖像的RIU-LBP 直方圖統(tǒng)計作為圖像的雙目特征.RIU-LBP 直方圖定義為:

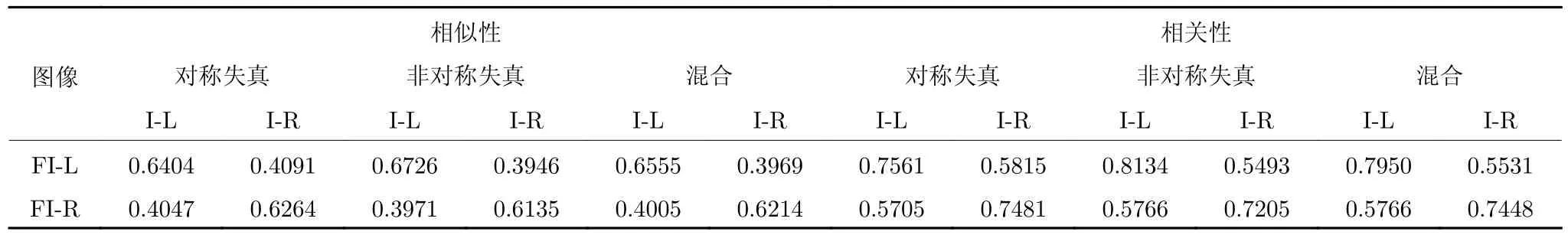

其中,k∈[0,P+1],P+1是RIU-LBP 中包含的編碼最大值,c為常量,用于避免為零的情況出現(xiàn).本文設置P=8,R=1,則可以得到0-9 共十種編碼的統(tǒng)計直方圖.

圖5 給出了圖4 所示四種失真立體圖像的左右融合圖像RIU-LBP 直方圖.從圖5 可以看出,對稱失真立體圖像的左右融合圖像的RIU-LBP 直方圖分布近似相同,而非對稱失真立體圖像的左右融合圖像的RIU-LBP 直方圖存在明顯差異,說明RIU-LBP 直方圖能較好地描繪出左右融合圖像中所包含的差異信息.

表1 失真立體圖像的兩幅融合圖像與左右視點圖像之間的相似性和相關(guān)性Table 1 The similarity and correlation between the two fusion images and the stereo pair

圖5 各類失真圖像的左右融合圖像的RIU-LBP 直方圖Fig.5 RIU-LBP histograms of the left and right fusion images for different distortion types

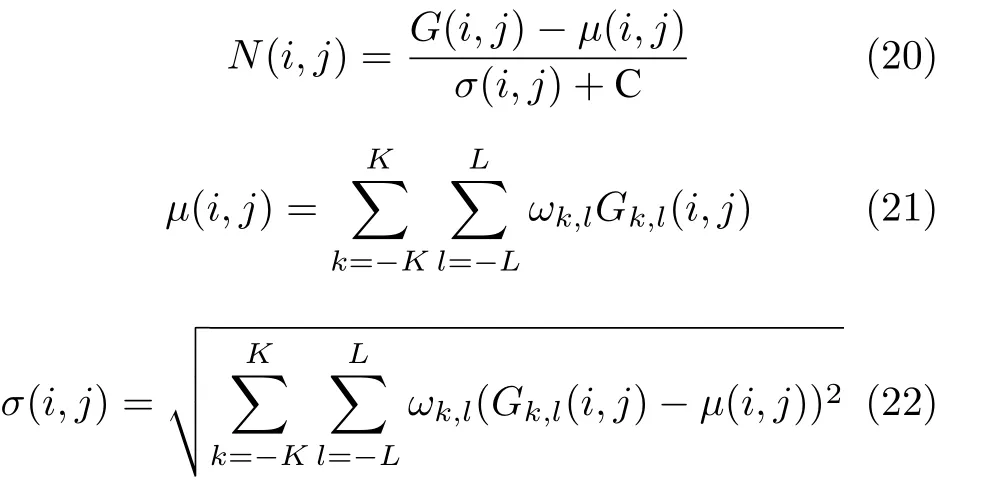

另外,自然圖像中各像素與其鄰域像素之間存在著緊密地聯(lián)系,當圖像結(jié)構(gòu)因為失真而發(fā)生改變時,鄰域像素之間的密切關(guān)聯(lián)性會發(fā)生改變[27].為了量化失真對融合圖像相鄰像素之間關(guān)聯(lián)性的改變程度,本文計算了左右融合圖像在水平(ρh)、垂直(ρv)、主對角線(ρm)和次對角線(ρs)方向上鄰域像素之間PLCC 值.PLCC 的計算方法具體如下:

其中,F是尺寸為W ×L的左右融合圖像,X和Y是各轉(zhuǎn)換圖像中的子塊,子塊大小為M ×N,m=1,2,···,M和n=1,2,···,N是像素索引,和分別是X和Y的均值,P(X,Y)為X和Y的PLCC 計算函數(shù).PLCC 的取值范圍為[?1,1],其絕對值越大表示鄰域像素之間的相關(guān)性越強.

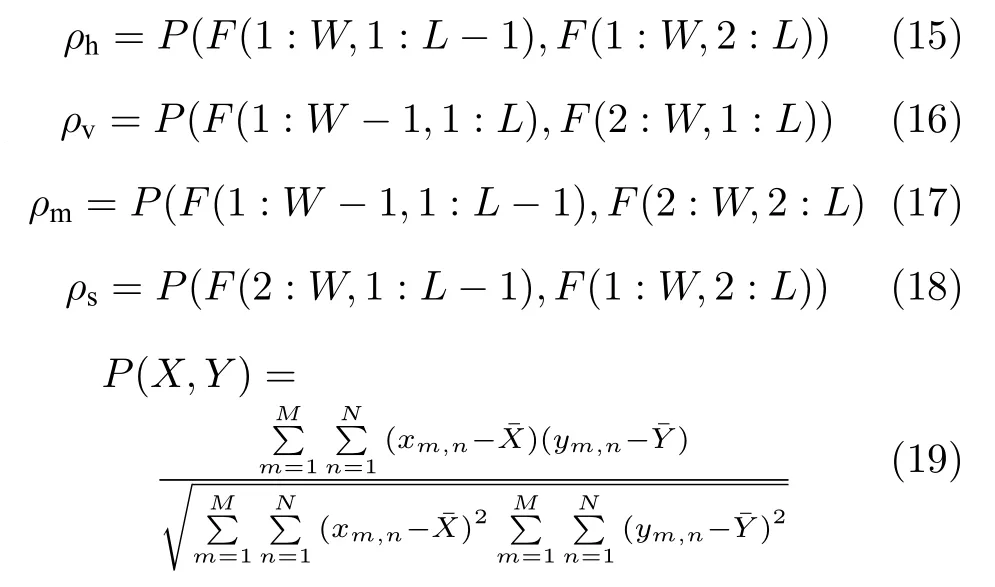

為了說明融合圖像在四個方向上鄰域像素之間的PLCC 值與立體圖像質(zhì)量的關(guān)系,從LIVE 3D IQA Phase II 數(shù)據(jù)庫[28](以下簡稱為LIVE Phase II 數(shù)據(jù)庫)中選取4 幅主觀評價差值(Difference mean opinion score,DMOS)值不同的失真立體圖像作為示例,圖6 給出了各圖像的左右融合圖像在四個方向上鄰域像素之間的PLCC 取值變化圖.其中,PLCC 根據(jù)DMOS 值按從大到小的順序排列,DMOS 值越大表示圖像質(zhì)量越差.可以看出,盡管所選立體圖像的失真較為復雜,各失真圖像的左和右融合圖像在四個方向上的PLCC 取值都會隨著DMOS 值的減小而減小,說明鄰域像素相關(guān)性特征可以描述圖像質(zhì)量的改變.

3.2 單目圖像特征提取

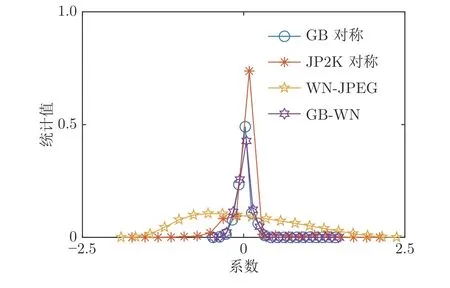

單目圖像特征從左右視點的GMRIs 中獲取,具體包括統(tǒng)計分布特征、鄰域像素乘積圖統(tǒng)計分布特征以及鄰域像素之間的相關(guān)性特征.首先采用均值減損對比度歸一化方法[27]對左右視點的GMRIs進行處理,使GMRIs 具有顯著的統(tǒng)計特性,便于提取感知特征.具體歸一化方法為:

圖6 左和右融合圖像的鄰域像素之間PLCC 值取值變化圖Fig.6 The variation of the PLCC values between neighboring pixels in the left and right fusion images

其中,G(i,j)是尺寸為M ×N的GMRI,i=1,2,···,M,j=1,2,···,N;μ(i,j)和σ(i,j)分別為GMRI 的局部均值和方差;C 為常量,用于避免出現(xiàn)局部方差為零的情況;ωk,l是長和寬分別為(2K+1)和(2L+1)的二維高斯加權(quán)函數(shù),K=L=3.

圖7 歸一化GMRIs 的統(tǒng)計分布(以右視點為例)Fig.7 The distribution of normalized GMRIs (take the right view as an example)

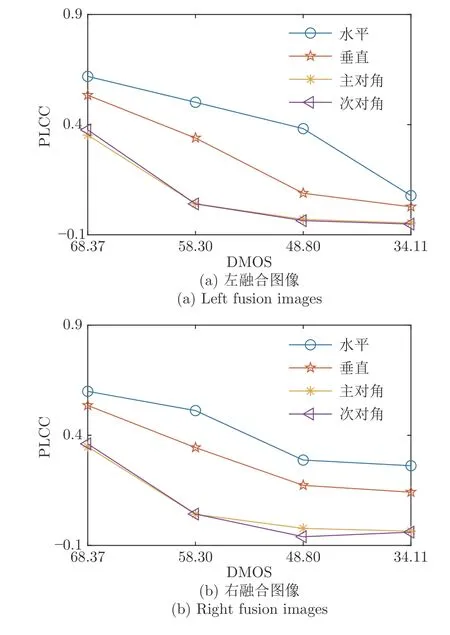

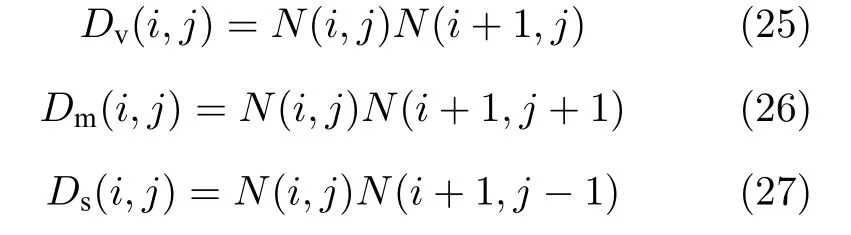

歸一化GMRI 的分布具有一定的統(tǒng)計規(guī)律.以IVC Phase I 數(shù)據(jù)庫中的失真立體圖像為例,圖7給出了GMRIs 的統(tǒng)計分布圖(限于篇幅僅給出右視點的GMRIs).可以看出,JPEG 對稱失真、GB 對稱失真以及GB-WN 非對稱失真圖像的GMRIs 的分布具有拉普拉斯分布的特點,且分布的左右拖尾長度不一致;WN-JPEG 非對稱失真圖像的GMRI 的分布更趨近于高斯分布,且分布存在明顯的偏移,即分布的均值不為零.因此,本文使用非零均值的AGGD 模型來擬合這些統(tǒng)計分布.

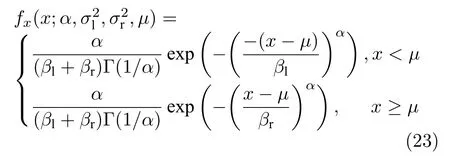

非零均值A(chǔ)GGD 模型參數(shù)的具體計算方法為:

其中,α是AGGD模型的形狀參數(shù),和反映分布在左右兩側(cè)的衰減程度,μ是均值,當μ0時,說明分布存在偏移.記將左和右GMRIs的統(tǒng)計分布參數(shù) (α,σ2,μ)作為單目圖像特征之一.

左右GMRIs 的相鄰像素之間的關(guān)聯(lián)性改變也可以用來衡量圖像質(zhì)量的變化.一方面,利用圖像鄰域像素之間乘積圖的統(tǒng)計分布來描述失真帶來的圖像局部結(jié)構(gòu)的變化情況.另一方面,通過GMRIs 鄰域像素之間的PLCC 來度量失真對圖像鄰域像素之間關(guān)聯(lián)性的改變程度.

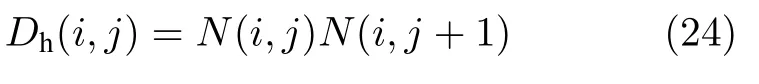

歸一化的GMRI 在水平(Dh)、垂直(Dv)、主對角線(Dm)和次對角線(Ds)方向上鄰域像素之間的乘積圖定義為:

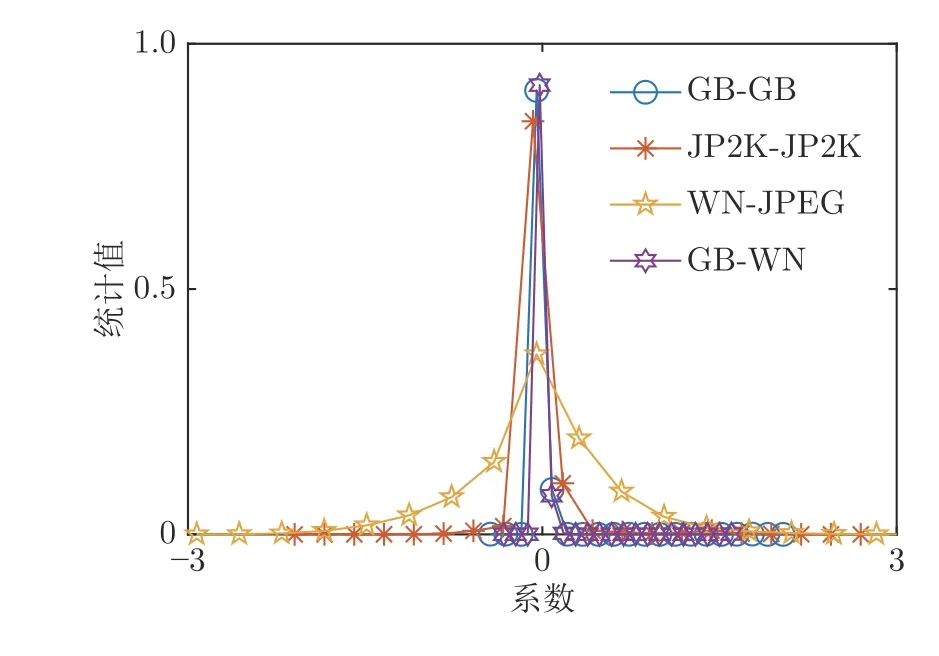

其中,N(i,j)是經(jīng)過歸一化處理的GMRI.為了說明鄰域像素乘積圖的統(tǒng)計特性,圖8 給出了IVC Phase I 數(shù)據(jù)庫中4 類失真圖像的GMRIs 在水平方向鄰域像素之間乘積圖的統(tǒng)計分布.

圖8 GMRI 在水平方向的鄰域像素乘積圖統(tǒng)計分布(以右視點為例)Fig.8 The distribution of the neighboring products of GMRI along horizontal direction (take the right view as an example)

從圖8 可以看出,GMRIs 的鄰域像素乘積圖的統(tǒng)計分布符合零均值非對稱廣義高斯分布的特點,因此本文采用零均值A(chǔ)GGD 模型來擬合其分布[27].零均值A(chǔ)GGD 模型參數(shù)可以利用式(23)來計算,計算時將式(23)中的μ設置為0.計算所得的α是零均值A(chǔ)GGD模型的形狀參數(shù),表示分布在左右兩側(cè)的衰減程度.另外,計算η=(βr?βl)Γ(2/α)/Γ(1/α),將左右GMRIs 在四個鄰域方向的(α,σl2,σr2,η)作為單目圖像特征之一.

此外,本文還利用式(15)~(18)計算兩幅GMRIs 在水平、垂直、主對角線和次對角線四個方向上鄰域像素的PLCC 值作為單目圖像質(zhì)量特征之一.

3.3 總體評價模型

ODAD 算法從左和右融合圖像分別提取的雙目統(tǒng)計特征包括:10 維RIU-LBP 直方圖特征和4 維鄰域像素的相關(guān)性特征.從左和右GMRIs 中分別提取的單目圖像特征包括:3 維統(tǒng)計分布特征,4 維鄰域像素的相關(guān)性特征,以及16 維鄰域像素乘積圖的統(tǒng)計分布特征.為了獲取最終用于圖像質(zhì)量預測的感知特征,本文基于視覺特征整合作用假說[29]對上述特征做了進一步的整合.通過計算左和右GMRIs 特征的均值,來模擬視覺皮層單目細胞之間的相互作用.通過計算左和右融合圖像特征的均值,來模擬不同眼優(yōu)勢柱之間的相互作用.這樣,在一個尺度上可以得到37 個經(jīng)過整合的視覺特征.考慮到多尺度方法可以獲得更多對圖像質(zhì)量變化敏感的特征,本文最終在2 個尺度上提取了74 個特征值來描述圖像質(zhì)量.

在將感知特征映射為圖像質(zhì)量值時,最常使用的方法是訓練SVR 預測模型.SVR 是針對小樣本統(tǒng)計估計和預測學習準確性較高的回歸模型,其預測準確性和泛化能力很大程度依賴于其核心函數(shù)的參數(shù)選擇.通常來說,使用單一的SVR 預測模型就可以在單個測試數(shù)據(jù)庫上得到非常高的預測準確性.然而,在不同測試數(shù)據(jù)庫上執(zhí)行交叉驗證實驗時,使用單一的SVR 預測模型穩(wěn)定性并不高.為了保證預測模型在單個測試數(shù)據(jù)庫上的預測準確性,并提高預測模型在交叉驗證實驗中的穩(wěn)定性,本文利用AdaBoost 算法以及多個不同的SVR 構(gòu)成一個穩(wěn)定性更高的預測模型,簡記為AdaBoost-SVR.

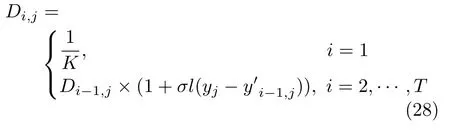

AdaBoost-SVR 質(zhì)量預測模型的結(jié)構(gòu)如圖9 所示.算法的基本思想是訓練多個弱學習算法來構(gòu)成一個更加穩(wěn)定的準確性高的強學習算法,在訓練過程中不同的學習算法可以跟蹤訓練集的分布,并自適應地根據(jù)弱假設誤差率調(diào)整每個樣本的權(quán)重.

圖9 中,將T個SVR 作為AdaBoost 算法中的多個學習模型.Di為第i個SVR 的分布,ai為第i個SVR 的權(quán)重,i=1,2,···,T.對特征向量為X的圖像,第i個SVR 預測的質(zhì)量值為計算多個預測值的加權(quán)和就可以得到立體圖像的質(zhì)量值.為了訓練AdaBoost-SVR 預測模型,首先利用LIBSVM[30]軟件包在測試數(shù)據(jù)庫上訓練單一的SVR 預測模型(使用徑向基核函數(shù)作為核函數(shù)),記錄多組使單一SVR 具有較優(yōu)預測準確性的參數(shù),然后選取T組參數(shù)訓練T個SVR.

圖9 基于Adaboost-SVR 的預測模型Fig.9 AdaBoost-SVR based prediction model

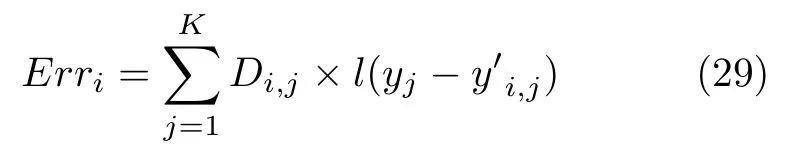

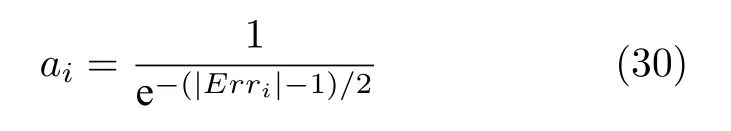

對于包含K 個訓練樣本的訓練集{(X1,y1),···,(Xj,yj),···,(XK,yK)},yj ∈R,yj為第j幅圖像的真實質(zhì)量值,Xj為每幅圖像的特征向量,為第i個SVR 預測出的第j幅圖像的質(zhì)量值.利用訓練集數(shù)據(jù)依次訓練T個SVR,第i個SVR 的分布Di計算如下

其中,l(x)是一個二元指示函數(shù),當x大于閾值t時,l(x)為1,否則l(x)為0,σ是一個在[0,1]之間的常量,本文中設置T=3,σ=0.1 .結(jié)合圖像質(zhì)量預測值與其真實質(zhì)量值之間的差值與對應的分布Di,j,計算第i個SVR 的誤差

為了使錯誤率較高的SVR 權(quán)重較低,錯誤率較低的SVR 的權(quán)重較高,第i個SVR 的權(quán)重ai計算公式為

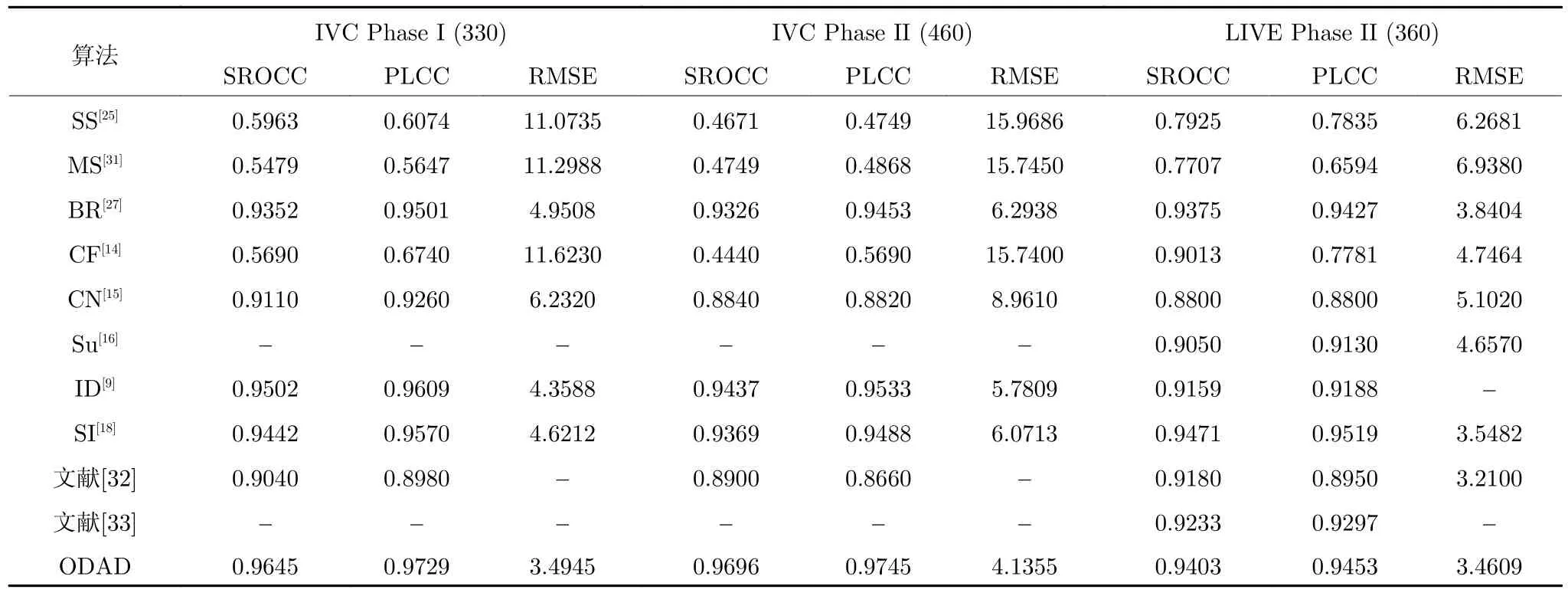

最終的圖像質(zhì)量值計算公式為

4 實驗結(jié)果與分析

4.1 實驗環(huán)境配置

本文所提出的算法在IVC Phase I[9]、IVC Phase II[26]、LIVE Phase II[28]和LIVE Phase I 數(shù)據(jù)庫[14]上執(zhí)行了測試.其中,IVC Phase I、IVC Phase II 和LIVE Phase II 數(shù)據(jù)庫為對稱與非對稱失真混合數(shù)據(jù)庫,分別包含330 幅、460 幅和360 幅失真立體圖像;LIVE Phase I 為對稱失真數(shù)據(jù)庫,包含365 幅失真立體圖像.對比算法包括:全參考算法SSIM[25]、MSSSIM[31]、IDW-SSIM[9]和Chen FR[14]算法,無參考算法Chen NR[15]、Su[16]、SINQ[18]和BRISQUE[27]算法,以及文獻[32]和文獻[33]新近提出的算法,其中文獻[33]算法是基于卷積神經(jīng)網(wǎng)絡的S I Q A 算法.為了描述簡便,下文將SSIM 算法簡寫為SS,MSSSIM 算法簡寫為MS,BRISQUE 算法簡寫為BR,IDW-SSIM 算法簡寫為IDW,Chen FR 算法簡寫為CF,Chen NR 算法簡寫為CN,SINQ 算法簡寫為SI.由于CN[15]、Su[16]、文獻[32]和文獻[33]算法代碼未公開,實驗數(shù)據(jù)均來自對應文獻.IDW[9]在IVC Phase I 和IVC Phase II 數(shù)據(jù)庫的實驗數(shù)據(jù)來自于文獻[9]的2017 年擴展版算法的實驗結(jié)果.將各算法預測的圖像質(zhì)量值與DMOS 或平均主觀值(Mean opinion scores,MOS)之間的斯皮爾曼秩相關(guān)系數(shù)(Spearman rank order correlation coefficient,SROCC),PLCC 和均方根誤差(Root mean squared error,RMSE)作為預測準確性指標.實驗的硬件平臺為Intel i7-6820HQ、2.7 GHz CPU,16 GB 內(nèi)存,編程環(huán)境為MATLAB 2014b.

4.2 算法的準確性與魯棒性

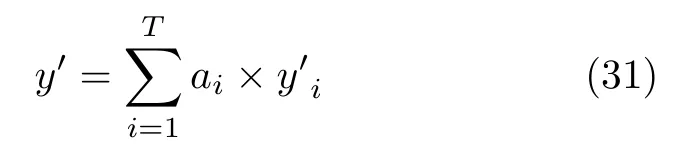

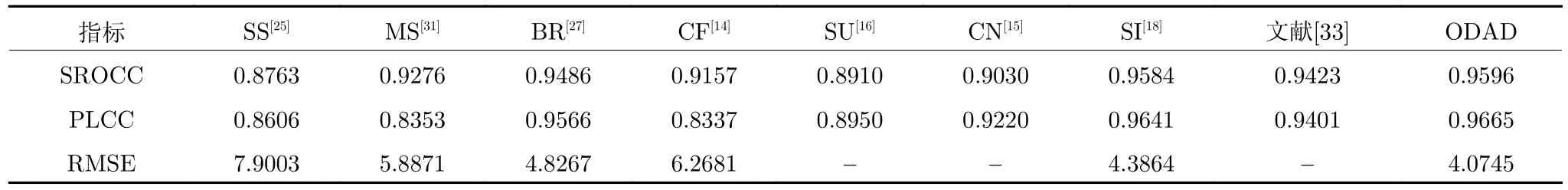

為了說明ODAD 算法評價非對稱失真立體圖像的準確性,在IVC Phase I、IVC Phase II 和LIVE Phase II 數(shù)據(jù)庫的非對稱失真圖像部分進行測試,測試結(jié)果列于表2.這三個數(shù)據(jù)庫分別包含252、330 和280 幅非對稱失真圖像.實驗中,所有無參考SIQA 算法采用8:2 的比例將測試數(shù)據(jù)庫隨機分配為訓練集和測試集,保證兩個子集無重疊,并以1 000 次實驗的SROCC、PLCC 和RMSE 中值進行比較.從表2 可以看出,ODAD 和IDW[9]在IVC Phase I 和IVC Phase II 數(shù)據(jù)庫的準確性最高,在LIVE Phase II 數(shù)據(jù)庫上SI[18]和ODAD 的評價準確性最高.由于IVC Phase I 和IVC Phase II 數(shù)據(jù)庫中包含了兩個視點失真類型不同的復雜非對稱失真圖像,絕大部分對比算法在這兩個數(shù)據(jù)庫上的評價準確性都較低,但ODAD 的SROCC 和PLCC 均達到0.95 以上,且RMSE 取值最低,說明ODAD 在預測非對稱失真立體圖像質(zhì)量時具有最好的評價準確性.

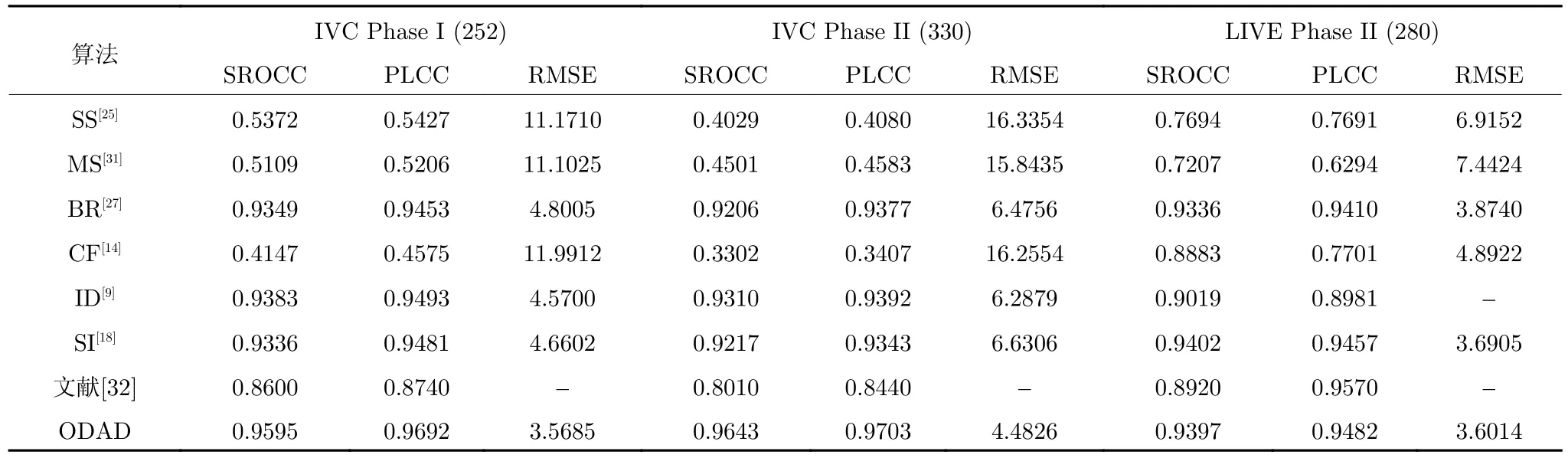

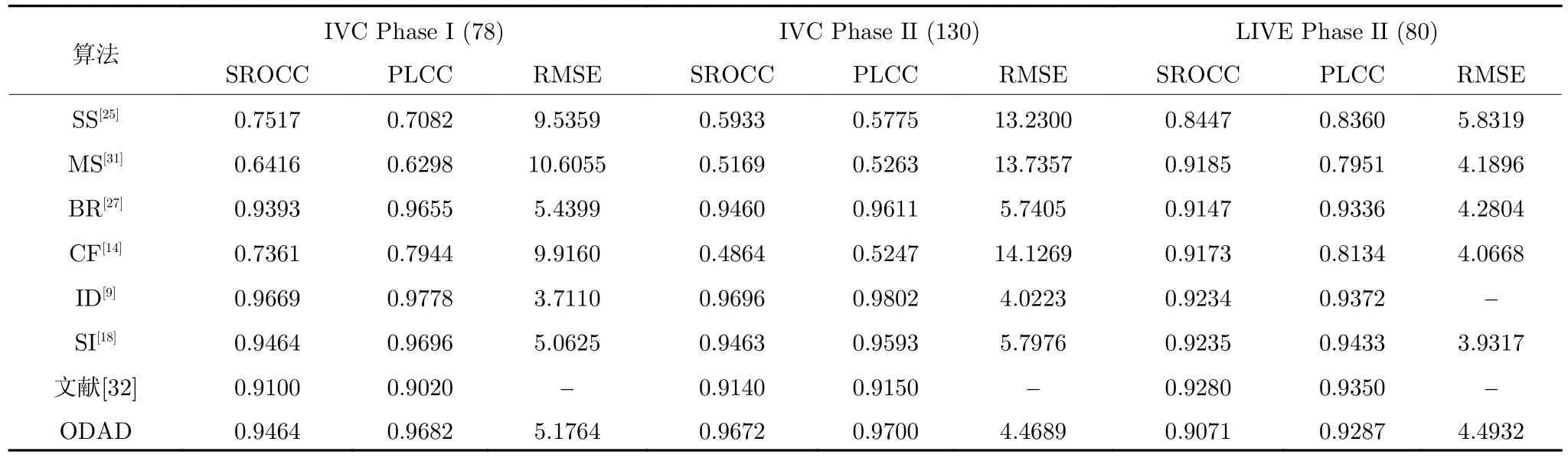

表3 和表4 還分別列出了各算法在IVC Phase I、IVC Phase II 和LIVE Phase II 數(shù)據(jù)庫的對稱失真圖像和整體數(shù)據(jù)庫上的測試結(jié)果.實驗時,無參考算法仍然采用8:2 的比例將數(shù)據(jù)庫中各部分的圖像分為無重復圖像的訓練集和測試集,將1 000 次重復實驗結(jié)果的中值進行對比.

表2 各算法在基準測試數(shù)據(jù)庫中的非對稱失真圖像部分預測結(jié)果比較Table 2 The comparison between SIQA algorithms on the asymmetrically distorted images in benchmark databases

表3 各算法在基準測試數(shù)據(jù)庫中的對稱失真圖像部分預測結(jié)果比較Table 3 The comparison between SIQA algorithms on the symmetrically distorted images in benchmark databases

從表3 可以看出,ODAD 算法在IVC Phase I 和IVC Phase II 數(shù)據(jù)庫上的三個評價指標明顯優(yōu)于大部分對比算法,僅在LIVE Phase II 數(shù)據(jù)庫的對稱失真圖像部分評價準確性稍低,說明該算法在評價對稱失真圖像時也可以獲得較高的評價準確性.從表4 可以看出,在混合了對稱與非對稱失真圖像的整體數(shù)據(jù)庫測試中,ODAD 算法的各項性能指標均優(yōu)于其他算法的指標,說明ODAD 算法的準確性和魯棒性相對最好.

此外,表5 還給出各算法在經(jīng)典的對稱失真立體圖像數(shù)據(jù)庫LIVE Phase I 數(shù)據(jù)庫上的測試結(jié)果.從表5 可以看出,ODAD 算法在LIVE Phase I 數(shù)據(jù)庫上的SROCC 和PLCC 達到0.96 以上,明顯優(yōu)于其他對比算法,且RMSE 最低,這也進一步說明ODAD 在評價對稱失真立體圖像時可以獲得較高的準確性,具有較好的魯棒性.

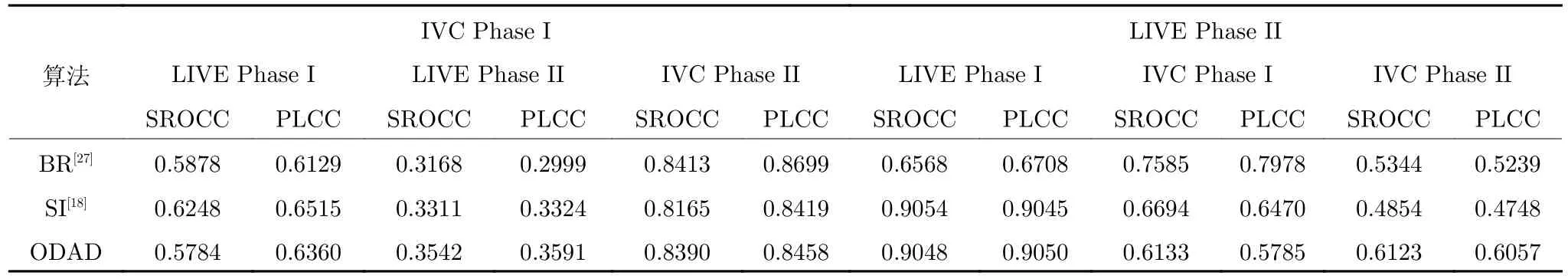

4.3 交叉驗證實驗

為了進一步驗證ODAD 算法的通用性,執(zhí)行交叉驗證實驗.以IVC Phase I 數(shù)據(jù)庫和LIVE Phase II 數(shù)據(jù)庫為例,分別將這兩個數(shù)據(jù)庫作為訓練集,將另外三個數(shù)據(jù)庫作為測試集(僅對無參考的BR[27]、SI[18]和ODAD 算法進行比較).表6 列出了各算法預測值與人類主觀評價值之間的SROCC和PLCC.可以看出,由于交叉實驗中訓練集和測試集包含的失真圖像的內(nèi)容、失真類型、失真程度等差異較大,各算法的評價準確性都不是特別高.相對來說,ODAD 算法訓練的預測模型對不同的測試數(shù)據(jù)庫仍具有較好的適應性,說明本文所提取的圖像特征及預測模型具有較好的泛化能力.

表4 各算法在對稱與非對稱失真數(shù)據(jù)庫上的預測結(jié)果比較Table 4 The comparison between SIQA algorithms on the symmetrically and asymmetrically distorted databases

表5 各算法在LIVE Phase I 數(shù)據(jù)庫上的SROCC、PLCC 和RMSE 比較Table 5 The comparison between SIQA algorithms in terms of SROCC,PLCC,and RMSE on LIVE Phase I database

表6 交叉驗證實驗結(jié)果Table 6 The experimental results on cross database tests

4.4 算法的一致性

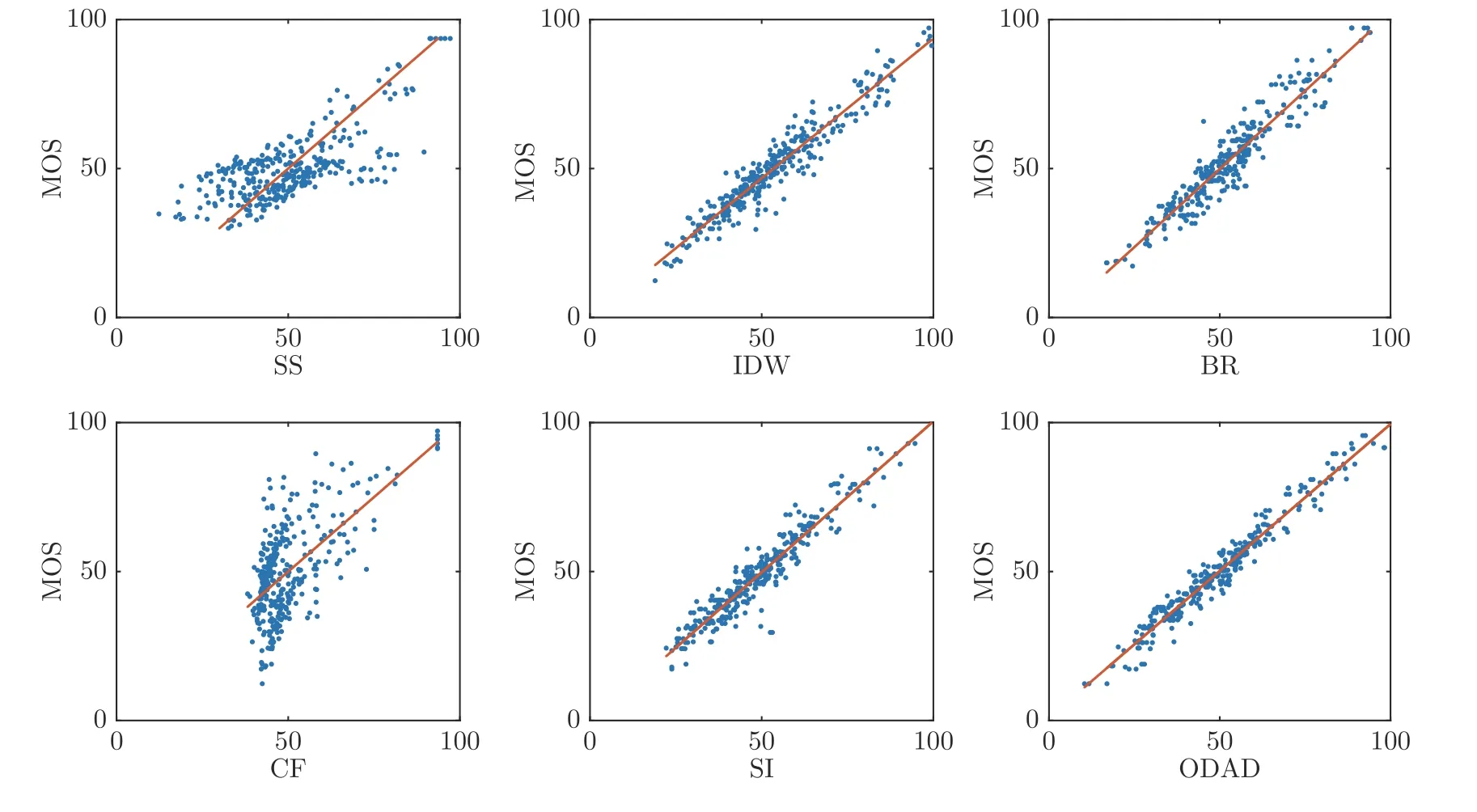

為了對比各算法預測值與人類主觀評價值的一致程度,以IVC Phase I 數(shù)據(jù)庫為例進行實驗.其中,全參考算法SS[25]、IDW[9]和CF[14]算法直接計算出所有圖像的質(zhì)量值;無參考算法BR[27]、SI[18]及ODAD 算法采用8:2 的比例將數(shù)據(jù)庫隨機分為訓練集和測試集,用訓練集圖像訓練預測模型,然后預測測試集圖像的質(zhì)量值,取5 次重復實驗的結(jié)果進行對比.各算法的預測值與圖像MOS 值對比的散點圖如圖10 所示.可以看出,ODAD 算法的散點分布較其他算法的聚集更為緊密均勻,說明該算法預測結(jié)果與人類感知的一致性更高.

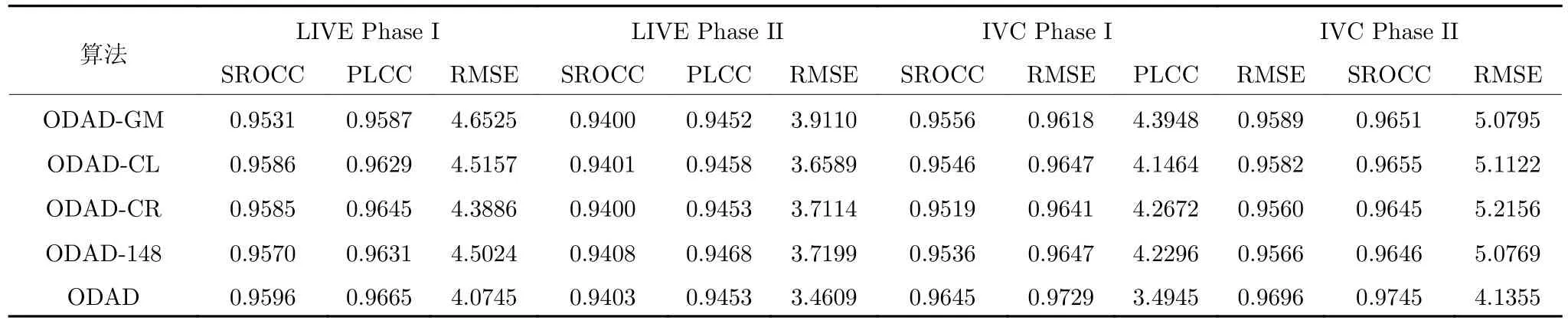

4.5 不同特征對算法性能的影響

ODAD 算法通過整合從立體圖像的左右融合圖像、左右GMRIs 中提取的多種感知特征,實現(xiàn)了圖像質(zhì)量預測.為了詳細地分析使用不同特征對算法評價準確性的影響,表7 列出了使用不同特征組合的ODAD 算法在各數(shù)據(jù)庫上的實驗結(jié)果.將僅使用左右GMRIs 的圖像特征的算法記為ODADGM;在ODAD-GM 基礎(chǔ)上增加了左融合圖像特征的算法記為ODAD-CL;在ODAD-GM 基礎(chǔ)上增加了右融合圖像特征的算法記為ODAD-CR;ODAD-148 表示直接使用四幅轉(zhuǎn)換圖像特征的算法;ODAD 表示使用整合的74 維特征的算法.從表7可以看出,盡管ODAD-GM 算法僅包含單目圖像特征,算法的預測準確性較采用經(jīng)典NSS 特征的算法的預測準確性已有大幅的提升,說明本文采用的基于非零均值A(chǔ)GGD 模型和PLCC 所提取的單目圖像特征具有更強的描述能力,可以更好地反映圖像質(zhì)量變化.ODAD-CL 和ODAD-CR 算法包含了部分融合圖像特征,評價準確性較ODAD-GM 有所提升.同時,由于ODAD-CL 和ODAD-CR 算法只使用了一幅融合圖像的特征,兩個算法的評價準確性較為接近.

圖10 各對比算法在IVC Phase I 數(shù)據(jù)庫上預測值與MOS 值的散點分布圖Fig.10 The scatter plots of the MOS values versus the quality scores predicted by the competing algorithms on IVC Phase I database

表7 各部分特征對ODAD 算法性能影響Table 7 The influence of each part of features on the performance of ODAD

ODAD-148 和ODAD 算法因為采用了兩幅融合圖像的特征,在大部分測試數(shù)據(jù)庫上獲得了更好的評價準確性.而ODAD 對四幅轉(zhuǎn)換圖像的特征做了進一步整合,在包含了復雜非對稱失真圖像的IVC Phase I 數(shù)據(jù)庫和IVC Phase II 數(shù)據(jù)庫上測試時,獲得了最高的評價準確性.綜上可知,ODAD算法同時使用兩幅融合圖像的特征,并采用特征整合的方式可以更加準確地描述失真立體圖像的特性,有利于提高算法的評價準確性和魯棒性.

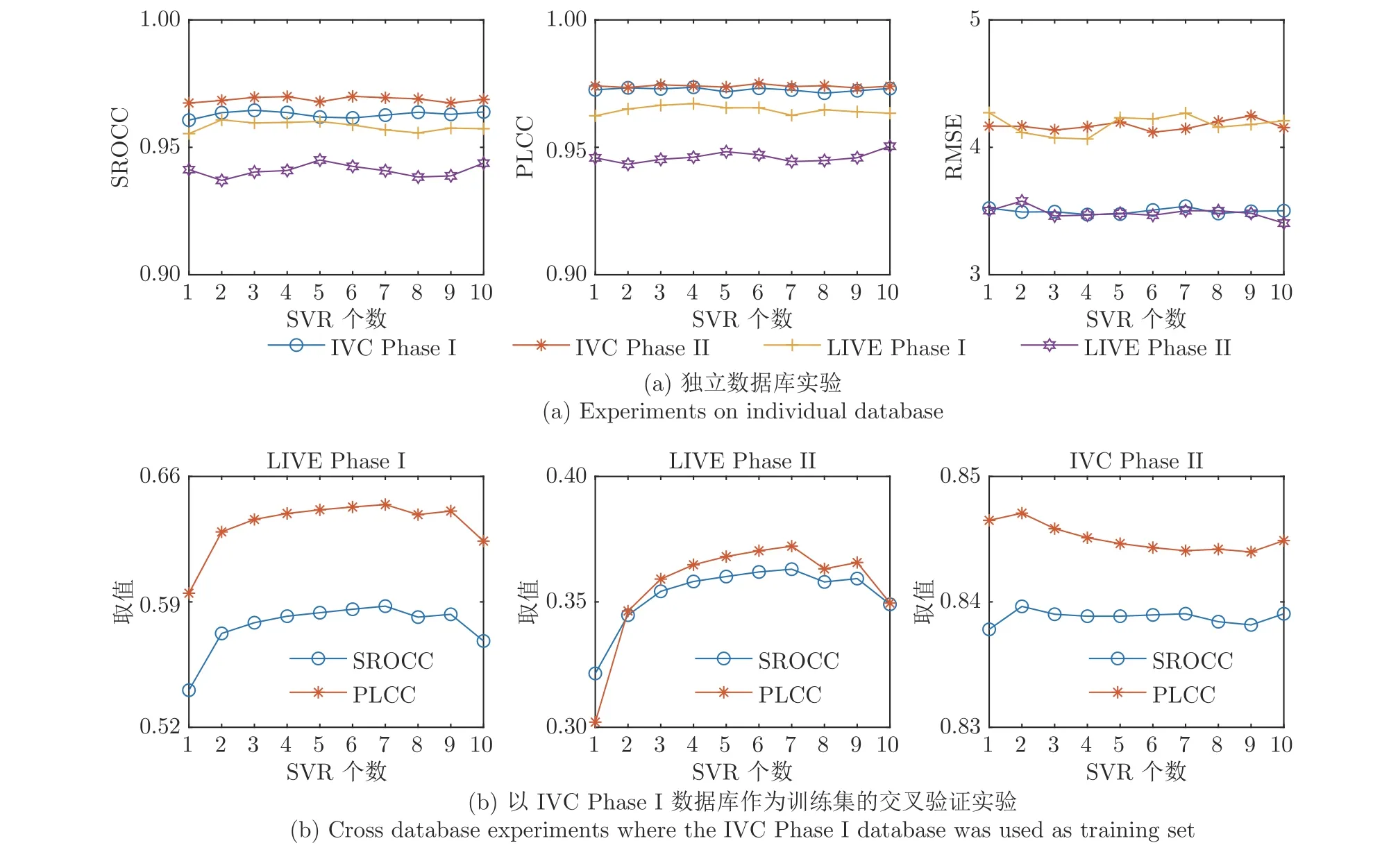

4.6 SVR 個數(shù)對算法性能的影響

為了比較使用不同個數(shù)的SVR 對算法評價準確性的影響,本文對比了使用不同個數(shù)SVR 的AdaBoost-SVR 預測模型執(zhí)行獨立數(shù)據(jù)庫和交叉數(shù)據(jù)庫實驗的測試結(jié)果,實驗結(jié)果對比如圖11 所示,其中SVR 個數(shù)為1 時的AdaBoost-SVR 相當于傳統(tǒng)的SVR 預測模型.

從圖11(a)給出的獨立數(shù)據(jù)庫實驗結(jié)果可以看出,隨著SVR 的個數(shù)增加,算法的預測準確性存在明顯的變化,當SVR 個數(shù)為3 和10 時,算法在各數(shù)據(jù)庫上的預測準確性相對都更高.圖11(b)給出將IVC Phase I 數(shù)據(jù)庫作為訓練集其他數(shù)據(jù)庫為測試集的對比結(jié)果.可以看出,由于訓練集和測試集所包含的圖像差異很大,對于大多數(shù)測試集來說,隨著SVR 個數(shù)的增多,算法的預測準確性會明顯的提高,但當SVR 的個數(shù)大于一定數(shù)值時,預測準確性又會下降.總體來說,采用AdaBoost-SVR 來映射圖像質(zhì)量,有助于提高算法的預測準確性和穩(wěn)定性.

4.7 算法復雜度與執(zhí)行時間比較

假設單目圖像包含N個像素,采用窗口尺寸為d1×d1的高斯偏導濾波計算左右視點圖像在2 個方向上的梯度值的時間復雜度為:計算視差圖時,如果滑動窗口的寬度置為d2,SSIM 算法中采用的局部窗口尺寸為d3×d3,則所需時間大約為生成兩幅融合圖像的時間復雜度為O(12N).從兩幅融合圖像中提取RIU-LBP 特征時間復雜度為 O(2PN),其中P為使用的鄰域像素個數(shù);計算融合圖像在4 個方向的鄰域像素之間相關(guān)性特征的時間復雜度為 O(8N);在歸一化GMRIs時,設高斯窗口尺寸為d4×d4,則歸一化所需時間為O從GMRIs中特征提取統(tǒng)計分布特征和鄰域像素相關(guān)性特征的時間為O(18N).綜上所述,本文算法總的時間復雜度為,仍保持在線性階.

圖11 采用不同個數(shù)SVR 在獨立數(shù)據(jù)庫和交叉數(shù)據(jù)庫驗證的結(jié)果對比Fig.11 The comparison of experiments on individual and cross database tests when using different numbers of SVR

為了和其他算法進行詳細對比,本文計算了各算法在LIVE Phase II 數(shù)據(jù)庫上提取330 幅失真圖像特征或預測圖像質(zhì)量值所花費的平均時間(s).由于2D 算法SS[25],MS[31]和BR[27]算法無需計算視差圖,也無需進行圖像融合,他們所需的執(zhí)行時間分別為0.079 s,0.113 s 和0.071 s.而CF[14]、SI[18]和ODAD 算法需要計算視差圖,并生成融合圖像,所需的特征提取時間分別為:16.485 s、4.149 s和4.538 s.相對來說,ODAD 算法比使用Gabor濾波的CF[14]算法的計算時間少近12 s.

5 結(jié)論

本文提出一種基于眼優(yōu)勢的非對稱失真SIQA算法ODAD.該算法在模擬立體圖像的視覺刺激強度時,采用梯度幅值響應來減少圖像轉(zhuǎn)換時間,提高了算法的效率.在對雙目視覺進行建模時,分別基于左和右視點圖像生成兩幅融合圖像,更好地模擬了人類視覺皮層中的眼優(yōu)勢效應原理.在提取圖像特征時,使用RIU-LBP 直方圖,鄰域像素之間的PLCC 值,以及非零均值A(chǔ)GGD 模型,獲得了描述能力較強的感知質(zhì)量特征.建立評價模型時,采用AdaBoost-SVR 算法提高了評價模型的穩(wěn)定性.在4 個立體圖像基準測試數(shù)據(jù)庫上實驗結(jié)果表明,所提出的算法較經(jīng)典SIQA 算法評價獲得了更高的評價結(jié)果,尤其是在評價各種非對稱失真立體圖像的質(zhì)量時準確性最高.同時,所提出算法的執(zhí)行效率也較高,能更好地滿足實際應用的需求.