光學(xué)遙感圖像飛機目標(biāo)識別算法

胡楠 李潤生 王載武

摘要:光學(xué)遙感圖像中蘊含著大量信息,更新速度非常快。使用人工方法對光學(xué)遙感圖像進行判讀和目標(biāo)的識別顯然早已達不到現(xiàn)代社會各領(lǐng)域的需求。實時、高效地從光學(xué)遙感圖像中識別出感興趣目標(biāo)具有非常重要的意義。本文對基于人工智能的圖像飛機識別研究現(xiàn)狀進行了總結(jié),方便后續(xù)學(xué)者研究。

關(guān)鍵詞:遙感圖像;深度學(xué)習(xí);飛機識別;Faster R-CNN

中圖分類號:TP7 文獻標(biāo)識碼:B DOI:10?郾3969/j.issn.1001-0270.2020.02.19

Abstract: Optical remote sensing images contain a lot of information and update very fast. It is obvious that the use of artificial methods to interpret and identify optical remote sensing images can not meet the needs of modern society in all fields. Real-time and efficient recognition of interested objects from optical remote sensing images is of great significance. In this paper, the research status of AI-based image aircraft recognition is summarized for the convenience of follow-up scholars.

Key Words: Remote Sensing Image; In-depth Learning; Aircraft Recognition; Faster R-CNN

1 引言

深度學(xué)習(xí)首先由Hinton[1]等人于2006年提出。經(jīng)過研究,卷積神經(jīng)網(wǎng)絡(luò)的深度學(xué)習(xí)模型憑借其優(yōu)異性能,成功用于人臉識別等。在2012年,Geoffrey Hinton教授在基于深度學(xué)習(xí)中的卷積神經(jīng)網(wǎng)絡(luò)在ILSVRC中,將傳統(tǒng)檢測算法的top-5錯誤率降低到15.3%[2]。在2014年,region proposal+CNN算法框架出現(xiàn),使深度學(xué)習(xí)在目標(biāo)檢測中性能取得重大突破。region proposal+CNN算法在PASCAL VOC 2012數(shù)據(jù)集上的平均檢測精度達到了53.3%[3]。2015年,空間金字塔池化網(wǎng)絡(luò)結(jié)構(gòu)[4]完成了任意圖像尺寸的輸入。同年,R-CNN的加速版本Fast R-CNN,完成了單級訓(xùn)練過程的端對端和損失函數(shù)的多任務(wù)形式,使得訓(xùn)練速度大大加快。在2016年,任少卿[5]等人為了解決目標(biāo)檢測中,生成候選框區(qū)域的時間過長的困難,提出了進一步改進后的網(wǎng)絡(luò)架構(gòu)Faster R-CNN。

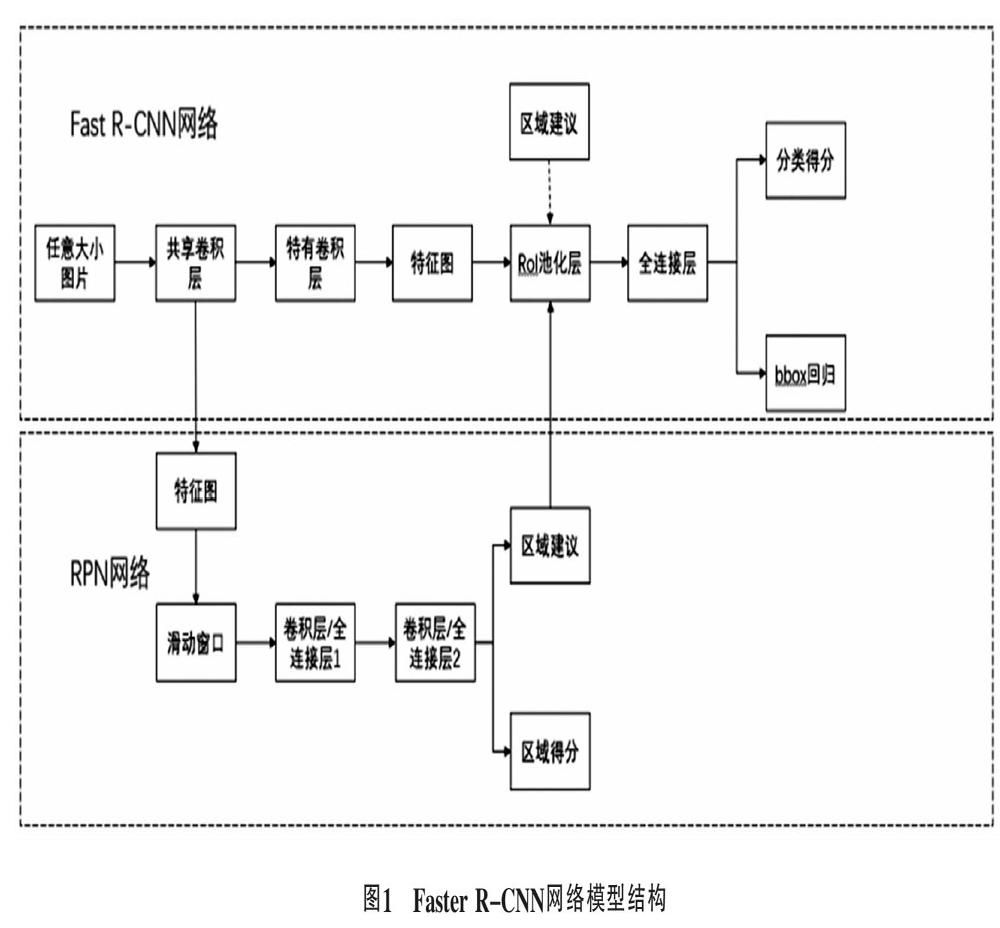

2 Faster R-CNN網(wǎng)絡(luò)模型

基于候選區(qū)域的目標(biāo)檢測算法的過程為,候選區(qū)域生成、特征提取、感興趣目標(biāo)的檢測與識別定位[6]。Faster R-CNN經(jīng)過了R-CNN以及Fast R-CNN的發(fā)展,整個步驟已經(jīng)統(tǒng)一到了一個深度學(xué)習(xí)網(wǎng)絡(luò)框架之內(nèi),能夠在GPU中完成,神經(jīng)網(wǎng)絡(luò)的訓(xùn)練和目標(biāo)的檢測速度都得到了大幅度提升。Faster R-CNN網(wǎng)絡(luò)模型的結(jié)構(gòu)整個計算過程為:①向ZF網(wǎng)絡(luò)輸入任意大小圖片。②經(jīng)過ZF網(wǎng)絡(luò)前向傳播至最后共享的卷積層,分成兩路。一路繼續(xù)前向傳播至特有卷積層,產(chǎn)生更高維的特征圖;另一路傳送到RPN網(wǎng)絡(luò)的輸入特征圖。③傳送到RPN網(wǎng)絡(luò)輸入的特征圖經(jīng)過RPN網(wǎng)絡(luò)得到區(qū)域建議和區(qū)域得分,并對區(qū)域得分采用非極大值抑制,輸出Top-N得分的區(qū)域建議給 RoI Pooling層。④步驟二中得到的高維特征圖和步驟三得到的區(qū)域建議同時送到RoI Pooling層,提取對應(yīng)區(qū)域建議的特征。⑤步驟四中得到的區(qū)域建議特征通過全連接層后,輸出該區(qū)域的得分以及回歸后的bounding-box。

2.1 建議區(qū)域提取

Faster R-CNN模型使用的RPN來實現(xiàn)目標(biāo)候選區(qū)域的生成。RPN的核心思想是使用卷積神經(jīng)網(wǎng)絡(luò)直接生成建議區(qū)域,這種方法只需在最后的卷積層上滑動一遍,利用錨點機制和邊框回歸巧妙地得到了多尺度和多長寬比的建議區(qū)域。首先是3×3的卷積,然后通過1×1卷積輸出分為兩路,其中一路輸出是目標(biāo)和非目標(biāo)的概率,另一路輸出box相關(guān)的四個參數(shù),包括box的中心坐標(biāo)x和y,box寬w和長h。

anchor是RPN網(wǎng)絡(luò)的核心。它的形式是(x1,y1,x2,y2),表示矩形的左上角和右下角的點的坐標(biāo)。其實,RPN最終就是在原圖尺度上,設(shè)置了密密麻麻的候選anchor。然后用CNN去判斷哪些anchor里是有目標(biāo)的foreground anchor,哪些是沒有目標(biāo)的background anchor。

在softmax前后各接一個reshape,結(jié)合caffe基本數(shù)據(jù)結(jié)構(gòu)blob的形式,更有利于softmax分類。框回歸操作用于將原始的anchor經(jīng)過一定的變換,映射到一個更接近真實框中。這樣,就得到了修正過后的anchor位置。在得到每一個候選區(qū)域的anchor的修正參數(shù)之后,就計算出較為精確的anchor,然后按照飛機的區(qū)域得分從大到小對得到的anchor進行排名,剔除一些明顯不符的anchor,以及附加其他的過濾條件,取前N的anchor,然后作為候選框輸出。

2.2 訓(xùn)練網(wǎng)絡(luò)模型

Faster R-CNN目前擁有ZF、VGG_CNN_M_1024、 VGG16三種訓(xùn)練網(wǎng)絡(luò)模型。本文選擇的是ZF模型。①特征提取過程,輸入圖像→卷積→Relu激活→最大池化→特征圖。②特征還原過程,特征圖→反池化→反Relu激活→反卷積→可視化圖像。卷積核的大小、步長等都需要人為設(shè)置,需要多次實驗尋求最佳設(shè)計。因為ZF網(wǎng)絡(luò)實現(xiàn)了特征可視化,我們可以根據(jù)可視化圖像進行分析,進而尋找最優(yōu)設(shè)計參數(shù)。同時,進行參數(shù)調(diào)整,能夠減小訓(xùn)練網(wǎng)絡(luò)所需要數(shù)據(jù)的規(guī)模,從而使小數(shù)據(jù)量的高分辨率遙感圖像也能夠視同F(xiàn)aster R-CNN進行多類目標(biāo)的分類。

3 結(jié)論

本文在Caffe深度學(xué)習(xí)框架之上構(gòu)建了基于ZF網(wǎng)絡(luò)的Faster R-CNN網(wǎng)絡(luò)模型,通過光學(xué)遙感圖像飛機目標(biāo)識別實驗,對模型的快速準(zhǔn)確識別進行了分析。實驗表明,模型能對某地點感興趣目標(biāo)的檢測精度進行估計,能夠完成不同場景下目標(biāo)的快速準(zhǔn)確檢測識別,能夠完成大范圍復(fù)雜場景下感興趣目標(biāo)的快速準(zhǔn)確檢測識別。

參考文獻:

[ 1 ]Hinton G E, Salakhutdinov R R. Reducing the Dimensionality of Data with Neural Networks[J]. Science, 2006,313(5786): 504-507.

[ 2 ]Krizhevsky A, Sutskever I, Hinton G E. Imagenet classification with deep convolution neural networks[A].//Advances in neural information processing systems[C].2012:1097-1105.

[ 3 ]Girshick R, Darrell J D T, Malik J. Rich feature hierarchies for accurate object detection and semantic segmentation[A]. //CVPR[C].2014:580-587.

[ 4 ]侯明偉.基于空間金字塔池化的卷積神經(jīng)網(wǎng)絡(luò)圖像分類算法[D].武漢:武漢大學(xué),2018.

[ 5 ]任少卿.基于特征共享的高效物體檢測[D].合肥:中國科學(xué)技術(shù)大學(xué),2016.

[ 6 ]林封笑.基于深度學(xué)習(xí)的目標(biāo)快速檢測方法研究[D].杭州:杭州電子科技大學(xué),2018.