基于機器學習的金融消費場景預測探索

摘要:隨著近年來人工智能產業和大數據技術的飛速發展,傳統金融行業逐漸向金融科技轉型。招商銀行信用卡中心提出依靠數據,預測用戶是否會購買掌上生活APP優惠券這一實際業務場景。依據這一實際問題,采用了各種機器學習方法,包括邏輯回歸、隨機森林、Xgboost、LightGBM,對這一問題進行探索。最后采用集成學習方法對最終結果進行融合。本文采用了上述幾種算法模型進行預測,對模型原理進行了分析,并在多個評價指標上衡量各個模型的表現,橫向對比了不同模型的優缺點,并對造成結果差異的原因進行了總結。

關鍵詞:金融科技;邏輯回歸;集成學習;隨機森林;Xgboost;lightGBM;分類

中圖分類號:F126.1?文獻識別碼:A文章編號:

2096-3157(2020)05-0153-03

一、引言

隨著近年來互聯網的迅猛發展,數據不斷累積,計算機算力不斷提高,如何挖掘數據背后的價值成為學術界和工業界共同關注的重要課題。機器學習作為一種統計學習方法,利用模型來自動學習數據背后隱藏的規律,成為挖掘數據潛在價值的重要手段,已經深入到人們生活的方方面面,機器學習的應用場景也逐漸深入到金融領域[1]。

機器學習領域可進一步分為監督學習、非監督學習及強化學習三大類,本文著力于研究有標注訓練數據的監督學習問題,基于招商銀行用戶信用卡數據,預測用戶是否購買掌上生活APP優惠券。在本研究中,探索了傳統的單模型機器學習算法,如邏輯回歸、決策樹,也探索了集成學習算法,包括隨機森林、GBDT、Xgboost、LightGbm等在金融消費領域的應用。

二、數據

1.數據集描述

本項目所使用的數據集主要分為以下三部分:一是個人屬性與信用卡消費數據;二是APP操作行為日志;三是標注數據。

2.數據預處理

為挖掘掌上生活APP數據背后隱藏的信息,做了如下預處理,提取了特征:

(1)傳統特征工程

傳統特征主要基于以下2個小類:①基礎統計特征。用戶點擊的總次數、用戶在各天(周)點擊的次數、用戶點擊行為的天數、用戶每天(周)點擊的平均數、最大值、最小值、眾數、方差、鋒度、偏度等。②時序相關特征。用戶點擊的時間間隔、用戶最大連續點擊天數,用戶最后一次點擊距離最后一天的間隔……

(2)TF-IDF特征

TF-IDF是信息檢索領域常用的一種文本的向量表示方法,用以評估一個字/詞在語料庫中的重要程度。依據這一假設,字/詞的重要性與它在該篇文章中出現的次數成正比,但和它在整個語料庫中的出現次數成反比。TF表示詞頻(Term?Frequency),IDF表示逆文本頻率指數(Inverse?Document?Frequency)。

TF-IDF=TF×IDF

TF=某個詞在文檔中的出現次數文檔的總詞數,IDF=long(詞料庫的文檔總數包含該詞的文檔數+1),

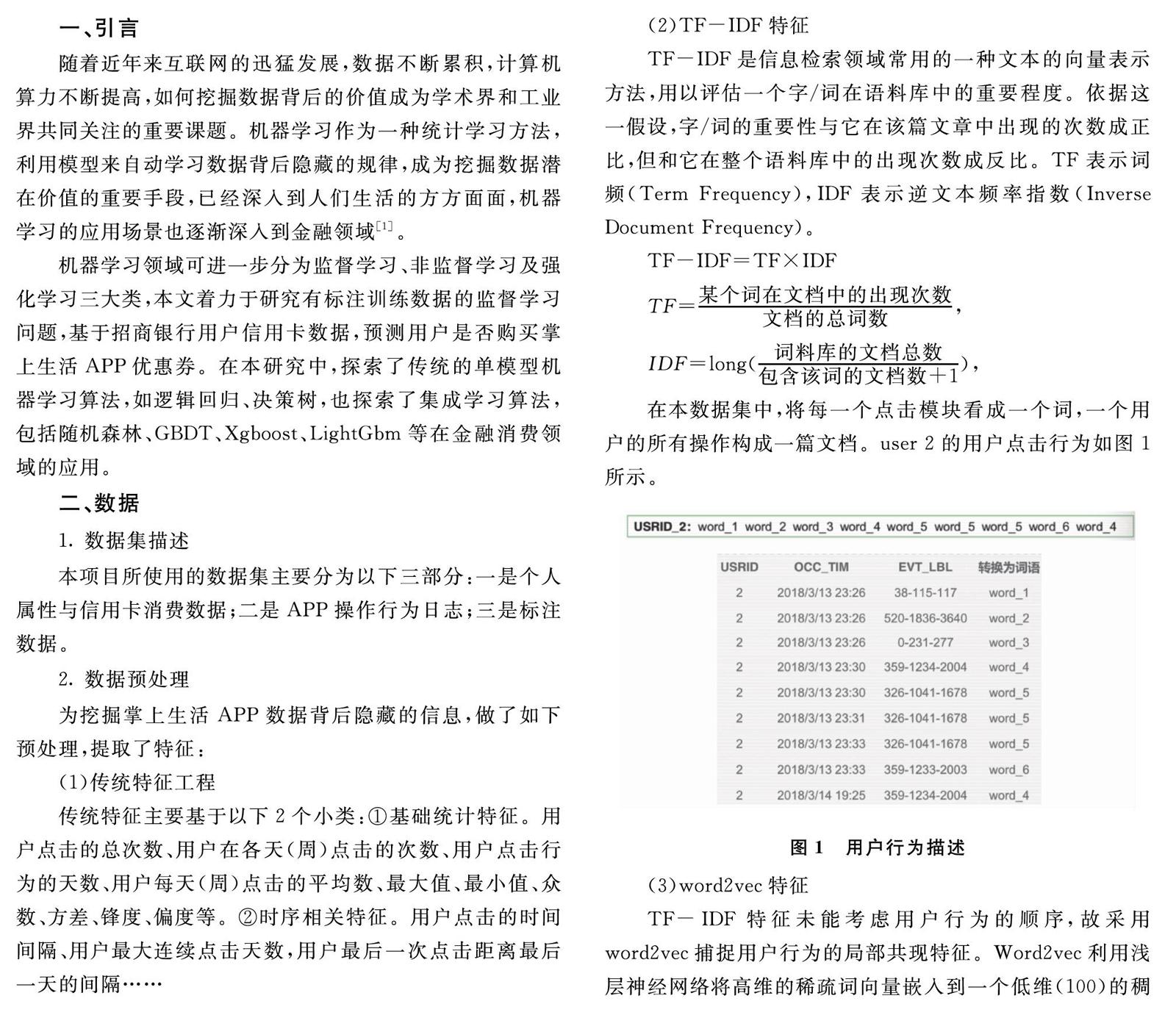

在本數據集中,將每一個點擊模塊看成一個詞,一個用戶的所有操作構成一篇文檔。user?2的用戶點擊行為如圖1所示。

圖1?用戶行為描述

(3)word2vec特征

TF-IDF特征未能考慮用戶行為的順序,故采用word2vec捕捉用戶行為的局部共現特征。Word2vec利用淺層神經網絡將高維的稀疏詞向量嵌入到一個低維(100)的稠密空間。用該向量來表示包含順序信息的用戶行為特征。

3.數據集劃分

招商銀行信用卡中心提供了3月份31天的數據,為貼合實際應用場景,按照時序切分數據——即將前28天的數據作為訓練數據,將最后3天的數據作為測試數據。

三、機器學習模型

1.邏輯回歸

Logistic?Regression[2](邏輯回歸)是機器學習中一個應用非常廣泛的分類模型,它將數據擬合到sigmoid函數,從而完成對事件發生概率的預測。

2.隨機森林

在集成學習方法中最主要的兩種方法為Bagging和Boosting,Bagging模型可以并行的學習多個基模型,并將基模型的結果投票求平均得到模型最終的結果。隨機森林[3](Random?Forest)是以CART[4]決策樹為基模型的一種典型的Bagging算法。為降低模型的方差,減小過擬合,集成學習算法需要增大基模型的差異性。隨機森林算法主要通過bootstrap采樣來增大訓練數據的差異性,以及通過特征抽樣來增大特征差異性。

3.Xgboost、LightGBM

Xgboost[5]模型和LightGBM[6]模型都是典型boosting算法,都是對GBDT模型的算法和工程改進。區別Bagging模型,基學習器可以并行,Boosting模型的基學習器間存在先后依賴。GBDT是一種提升樹模型,第m輪用一棵CART回歸樹擬合前m-1輪損失的負梯度,降低模型的bias。Xgboost相對于GBDT,對損失函數做了優化,引入二階導數信息,并加入正則項控制模型的復雜度;此外,雖然基模型的訓練存在先后順序,但每個基學習器內部的樹節點分裂可以并行,Xgboost對此進行了并行優化。LightGBM相較于Xgboost,提出Histogram算法,對特征進行分桶,減少查詢分裂節點的事件復雜度;此外,提出GOSS算法減少小梯度數據;同時,提出EFB算法捆綁互斥特征,降低特征維度,減少模型復雜度。

四、實驗結果比較

1.評價指標

在本實驗中,綜合使用accuracy、precision、recall、f1_score、AUC作為衡量指標。

(1)精確率、召回率、F1

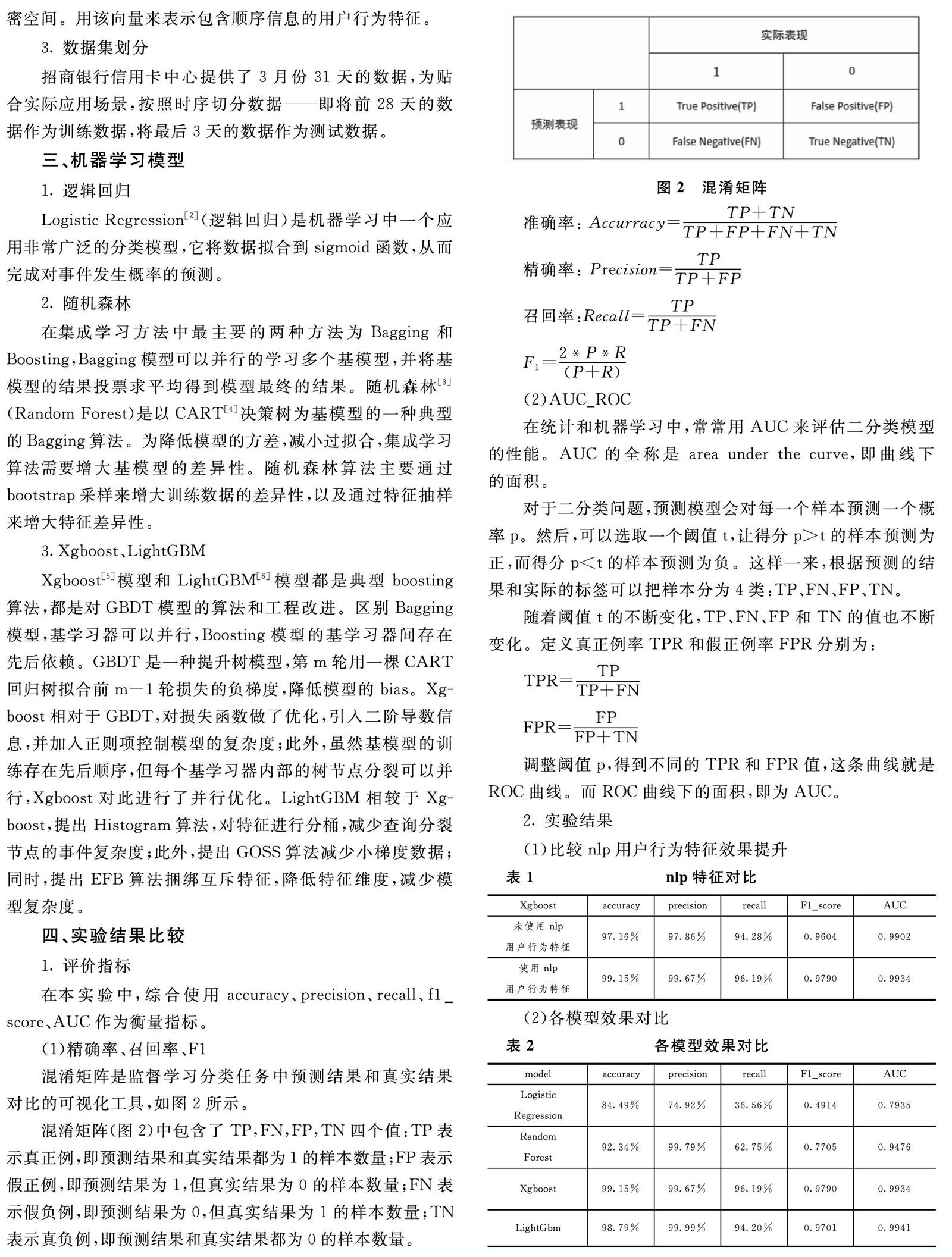

混淆矩陣是監督學習分類任務中預測結果和真實結果對比的可視化工具,如圖2所示。

圖2?混淆矩陣

混淆矩陣(圖2)中包含了TP,FN,FP,TN四個值:TP表示真正例,即預測結果和真實結果都為1的樣本數量;FP表示假正例,即預測結果為1,但真實結果為0的樣本數量;FN表示假負例,即預測結果為0,但真實結果為1的樣本數量;TN表示真負例,即預測結果和真實結果都為0的樣本數量。

準確率:?Accurracy=TP+TNTP+FP+FN+TN

精確率:?Precision=TPTP+FP

召回率:Recall=TPTP+FN

F1=2*P*R(P+R)

(2)AUC_ROC

在統計和機器學習中,常常用AUC來評估二分類模型的性能。AUC的全稱是?area?under?the?curve,即曲線下的面積。

對于二分類問題,預測模型會對每一個樣本預測一個概率p。然后,可以選取一個閾值t,讓得分p>t的樣本預測為正,而得分p 隨著閾值t的不斷變化,TP、FN、FP和TN的值也不斷變化。定義真正例率TPR和假正例率FPR分別為: TPR=TPTP+FN FPR=FPFP+TN 調整閾值p,得到不同的TPR和FPR值,這條曲線就是ROC曲線。而ROC曲線下的面積,即為AUC。 2.實驗結果 (1)比較nlp用戶行為特征效果提升 (3)實驗結果分析 ①對比表1、表2可知,通過引入TFIDF特征和Word2Vec特征獲取用戶行為特征,有助于模型更好地挖掘數據的規律,提高了模型表現的上線。②隨機森林、Xgboost、Lightgbm這類基于ensemble的模型在準確率、精確率、召回率、f1、AUC這些指標上均優于邏輯回歸,說明樹模型可能更適合該數據集及使用ensemble方法來融合弱分類器,其表現優于單個分類器。③基于Boosting的集成學習算法(Xgboost,Lightgbm)優于基于Bagging的集成學習算法(RandomForest),說明對該數據和特征而言,減少bias的重要性優于減少variance。 五、總結 在本項目中,通過機器學習方法對金融場景數據建模,預測招商銀行信用卡用戶是否購買掌上生活APP優惠券。通過實驗結果可知,基于GBDT的Xgboost模型和LightGBM模型在各項評價指標上均超過了0.9,驗證了機器學習模型的優異性。可用于實際CTR場景中,提升招行掌上生活APP的用戶體驗,幫助企業獲取更多利潤。 參考文獻: [1]羅素文,韓路,許勤,等.探索商業銀行在大數據挖掘技術領域的應用[J].計算機應用與軟件,2017,34(9):43~45+81. [2]Kleinbaum?D?G,Dietz?K,Gail?M,et?al.Logistic?regression[M].New?York:Springer-Verlag,2002. [3]Liaw?A,Wiener?M.Classification?and?regression?by?randomForest[J].R?news,2002,2(3):18~22. [4]Steinberg?D,Colla?P.CART:classification?and?regression?trees[J].The?top?ten?algorithms?in?data?mining,2009,9:179. [5]Chen?T,Guestrin?C.Xgboost:A?scalable?tree?boosting?system[C]//Proceedings?of?the?22nd?acm?sigkdd?international?conference?on?knowledge?discovery?and?data?mining.ACM,2016:785~794. [6]Ke?G,Meng?Q,Finley?T,et?al.Lightgbm:A?highly?efficient?gradient?boosting?decision?tree[C]//Advances?in?Neural?Information?Processing?Systems.2017:3146~3154. 作者簡介: 曾曉瑋,上海交通大學附屬中學學生。