一種高倍數細胞顯微圖像生成式對抗網絡

苗喬偉,楊 淇,李愛佳,羅文劼

(河北大學 網絡空間安全與計算機學院,河北 保定 071000)

0 概述

目前,許多疾病的診斷仍然依賴于高倍數顯微鏡對微觀細胞或結構進行觀測[1-3],然而現有的高倍數顯微鏡價格高,需要專業人員進行操作且操作步驟復雜,因此其不利于在落后地區進行大規模部署。

自蒙特利爾大學的GOODFELLOW等人提出了生成式對抗網絡[4](Generative Adversarial Network,GAN)的概念以來,GAN模型得到迅速發展和廣泛的應用,并形成了大量的變體。目前針對超分辨率領域和風格轉換方面有SRGAN[5]、StyleGAN[6-7]、CycleGAN[8-9]等。盡管多種GAN的變體[10-12]在風格遷移或者超分辨率方面取得了重要進展,并在衡量評分上不斷取得突破,但是在細胞圖像由低倍數顯微生成高倍數顯微圖像方面,單一類型網絡都不能達到較好的效果。主要是因為高低兩種倍數的顯微圖片具有如下差異:高倍數細胞顯微圖像與低倍數細胞顯微圖像風格不同,如對比在1 000倍顯微鏡拍攝的高倍數圖像與在400倍顯微鏡下采集的低倍數圖像,其圖像視野中明暗與細胞圖像的紋理、色彩、視覺模式有很大不同;高倍數顯微圖像中可以觀測到細胞內部的微觀結構,如細胞核等,而在低倍數顯微圖像中的微觀結構表現不明顯;在數據采集過程中,高倍數顯微圖像與低倍數顯微圖像往往是不配對的,即未必能采集到同一個細胞同一時間與同一環境下的高倍數顯微圖像與低倍數顯微圖像,從而造成訓練上的困難。

由于細胞圖像特性,單純的超分辨率方法只能放大細胞圖像而無法還原細胞內部結構信息,且模型訓練需要依賴大量的配對數據。單純風格轉換的模型雖然能推測還原圖像,但不能保證生成圖像的準確性。近年來基于CycleGAN的圖像重建網絡[13-15]在圖像到圖像轉換方面取得了較好應用。因此,本文提出基于CycleGAN的高倍數細胞顯微圖像生成式對抗網絡,旨在利用非配對的高倍數顯微圖像與低倍數顯微圖像數據集,準確地生成低倍數顯微圖像對應的高倍數顯微圖像。

1 相關工作

1.1 循環生成對抗網絡

生成式對抗網絡是近年來在無監督學習上具前景的一種深度學習模型。該模型構架至少包含兩個主要的模塊:生成器G與鑒別器D。其中,生成器G負責生成偽造圖像來迷惑鑒別器D,使鑒別器D無法判斷生成圖片真實與否。鑒別器D負責判斷輸入圖像是否為生成器G生成的偽造圖像。隨著生成器G與鑒別器D的不斷優化,最終對抗的過程達到一個動態平衡。傳統GAN為單向網絡,損失公式見式(1)與式(2)。

重建損失:

(1)

判別損失:

LGAN(GAB,DB,A,B)=

Eb~B[logaDB(b)]+Ea~A[loga(1-DB(GAB(a)))]

(2)

由于在風格轉換方面使用單純的GAN網絡需要大量的配對圖片作為訓練數據,然而這樣的配對的圖片難以采集。2017年,朱俊彥提出的CycleGAN網絡針對訓練數據非配對問題進行了有益探索。

CycleGAN本質上是一個B→A單向GAN加上一個A→B單向GAN,這樣兩個鏡像對稱的GAN構成了一個環形網絡。兩個GAN共享兩個生成器,并各自帶一個判別器,即共有兩個判別器和兩個生成器,同時還提出循環一致性損失,計算公式如下:

(3)

其中,F和G為CycleGAN要學習的兩個映射,要求F(G(y))≈y,G(F(x))≈x。CycleGAN最終損失由三部分組成,計算公式如下:

L=LGAN(F,DY,X,Y)+LGAN(G,DX,X,Y)+

λLcyc(F,G,X,Y)

(4)

通過訓練,不配對的訓練圖像可以通過生成器生成與自己配對的圖像,從而解決了數據集不配對的問題。同時隨著循環一致性損失的引入,對生成的配對圖像進行有效約束,保證了生成圖像與原圖像之間準確的對應關系。

本文應用類似的網絡結構來解決訓練數據集不配對的情況。但是單純CycleGAN結構只能根據低倍數顯微圖片生成高倍數顯微下細胞樣式的風格,并不能準確重建還原出細胞內部結構。針對該問題,本文引入了超分辨率中常用的感知損失[16],并將CycleGAN生成器結構參照適用于超分辨率挑戰的網絡結構進行優化,幫助生成器準確、真實地重建出細胞內部結構。

1.2 深度學習的風格轉化

使用深度學習進行風格轉化由文獻[12]提出,其可以將普通圖片轉化為名畫風格。風格轉化的主要目的是將一張參考圖片的風格應用到另一張原始圖片上,最后生成的圖片既保留原始圖片的大體內容,又能展現出參考圖片的風格。這里的風格是指一張圖片的紋理、色彩和視覺模式等,內容則是指圖片的宏觀構造。

在風格轉換網絡中,其核心在于最大程度地保持圖片原有構造的同時,對其目標風格進行學習,并應用于輸入圖像之上對圖像進行重建。風格轉換在高倍數細胞顯微圖像重建任務中非常重要,因為低倍數顯微下拍攝的細胞圖像與高倍數顯微下拍攝的同種細胞圖像,具有不同的紋理、色彩與視覺模式。風格轉換可以有效改善低倍數顯微圖像的質地,使其在整體的人體視覺感知上更接近于真實的高倍數顯微圖片。

本文使用循環生成對抗網絡結構,完成低倍數顯微圖片到高倍數顯微圖片的風格遷移任務。

2 高倍數細胞顯微圖像生成式對抗網絡

本文的目的是學習低倍數顯微圖片域X和高倍數顯微圖片域Y之間準確可信的映射關系。定義兩個域內的數據分布分別為x~pdata(x)和y~pdata(y)。高倍數細胞顯微圖像生成式對抗網絡包含兩個映射,分別是映關系G:X→Y和映射關系F:Y→X。此外,還包括兩個敵對的鑒別器Dx和Dy。Dx的目標是區分圖片{x}和圖片{F(y)}。與之類似,Dy的目標是區分圖片{y}和圖片{G(x)}。本文針對高倍數細胞顯微圖像重建任務的特殊性,引入對抗損失與循環一致性損失來加強對其高倍數顯微圖像風格的學習效率與質量,另外還提出了細節感知損失來保證生成圖片信息的有效性與真實性。

2.1 對抗損失

本文將對抗性質損失應用于G、F兩種映射。對于映射G:X→Y和鑒別器,其鑒別器Dy損失函數公式如下:

LGAN(G,DY,X,Y)=Ey~Pdata(y)[logaD(y)]+

Ex~Pdata(x)[loga(1-DY(G(x)))]

(5)

其中,G負責生成非常接近來自圖像域Y的圖像G(x),而Dy負責分辨出真實圖像y與生成的偽圖像G(x)。生成器G目標是使損失函數最小化,鑒別器D目標是使其最大化,計算公式如下:

minGmaxDYLGAN(G,DY,X,Y)

(6)

同理,將其引入本文中的映射方式F:Y→X與鑒別器Dx,便可得到與其類似的對抗性損失:

minGmaxDYLGAN(F,DX,Y,X)

(7)

2.2 循環一致性損失

從理論上講,單純使用對抗性損失可以使兩個生成器分別學習映射G和F,但如果容量足夠大,網絡可以將同一組輸入圖像映射到目標域中任意隨機排列的圖像,其中任何已知映射都可以誘導與目標分布匹配的輸出分布。因此,單純的循環一致性損失不能引導網絡學習到單個輸入xi到其期望的輸入yi。為進一步減少可能的映射函數空間,本文引入了循環一致性損失。對于每一張來自于源域X的圖像xi,在圖像xi經過兩個生成器的循環網絡之后,還能得到足夠接近原始圖像xi的輸出圖片,即x→G(x)→F(G(x))≈x,定義上述循環為正向循環。相似地,對于每一張來自于目標域Y的圖像yi,在圖像yi經過兩個生成器的循環網絡之后,還能得到足夠接近原始圖像yi的輸出圖片,即y→F(y)→G(F(y))≈y,定義上述循環為反向循環。因此,可以定義循環一致性損失來激勵此行為,損失公式如下:

(8)

本文嘗試使用L2范數來代替L1范數,但是經過實驗證明,并沒有顯著的視覺提升,而且其個別特征過于平滑,以至于其個別高頻特征往往被忽略。在經過多輪訓練之后,源域圖像經過正向循環,目標域圖像經過反向循環之后,均能與其自身圖像具有良好的匹配與對應關系。

2.3 細節感知損失

經過單一的循環網絡之后,只能確保生成圖像具有高倍數顯微圖像的風格與相應的細胞結構的重構還原,但是并不能有效確保肉眼感知的準確。通過對抗損失與循環一致性損失的優化只能保證其在矩陣數值上的優越性,然而人的感知是復雜且非計算性的,因此如何加強人體視覺感知在重建細胞高倍數顯微圖像問題中非常重要。

文獻[8]提出感知損失并在SRGAN中進行了擴展,感知損失先前被定義在預先訓練的深層網絡的激活層上。將生成圖片與目標圖片分別經過此深層網絡得到激活特征,并將兩者之間距離最小化。不過該方案有兩個缺點:1)被激活的特征是非常稀疏的,特別是在經過非常深的網絡后,矩陣的稀疏性會被得到加強,稀疏激活提供弱的監督,從而導致性能較差;2)使用激活后的特征會造成重建后的圖像亮度與真實圖像不一致。

本文定義感知損失公式如下:

LG=Lpercep+βL1

(9)

綜上,本文整體網絡損失計算公式如下:

L=LGAN+λLcyc+ηLG

(10)

其中,λ、η均為平衡各項損失的系數。

2.4 網絡結構

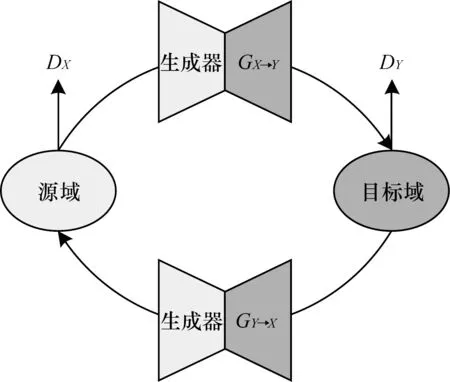

在本文實驗中,模型有兩個生成器GX→Y、GY→X與兩個鑒別器DX→Y、DY→X。其中,GX→Y與DX→Y組合成一個生成式對抗網絡GANX→Y進行學習映射G:X→Y,GY→X與DY→X組合成一個生成式對抗網絡GANY→X進行學習映射F:Y→X。兩個生成式對抗網絡組成一個循環結構,具體結構如圖1所示。

圖1 CycleGAN網絡結構

循環網絡分成正向循環與反向循環兩個階段。正向循環抽取源域的一張低倍數顯微圖片x通過GANX→Y生成一張偽高倍數顯微圖像fakey。隨后該fakey通過GANY→X生成一張近似于原始低倍數顯微圖像x的生成圖像fakex′,并對x與fakex′計算循環一致性損失。反向循環抽取目標域的一張高倍數顯微圖像y通過GANY→X生成一張偽低倍數圖像fakex。隨后該fakex通過GANX→Y生成一張近似于原始高倍數顯微圖像y的生成圖像fakey,并對y與fakey計算循環一致性損失。

經過此雙向循環后,即可得到真實低倍數顯微圖像x,x對應生成的偽高倍數顯微圖像fakey與真實高倍數顯微圖像y,y對應生成的偽低倍數顯微圖像fakex。本文使用經過imagenet[17],預訓練的Vgg16網絡作為特征提取器,將y、fakey同時傳入特征提取器得到y的特征向量fy與fakey的特征向量ffakey,利用fy、ffakey、y、fakey計算感知損失,并對GANX→Y進行優化。

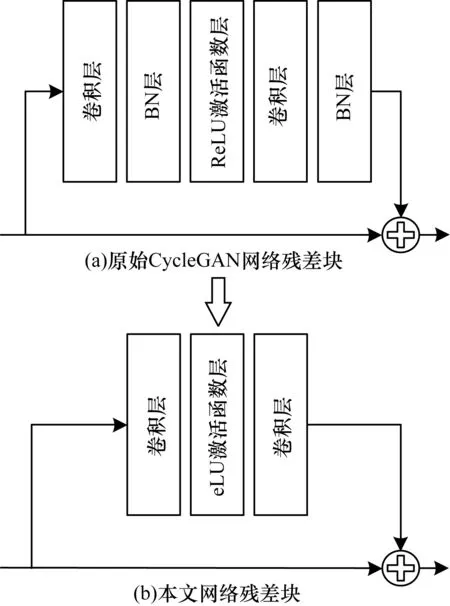

為加強生成器GX→Y、GY→X的生成效果,本文對其進行了以下優化:

1)去掉BN層。去掉BN層已經被證明有助于增強性能并減少計算復雜度,并且在超分辨率重建與去模糊重建方面取得了良好的效果。且BN層可能在深網絡和生成式對抗網絡的訓練時為生成圖片帶來偽影,這些偽影偶爾出現在迭代和不同設置之間,不能使網絡經過訓練之后的性能足夠穩定,因此去除了BN層。

2)提出全新激活函數。經過實驗,BN層可以顯著加快網絡學習速率,為保證去掉BN層之后網絡仍能具有較快的學習速率,同時為了克服現行主要激活函數ReLU和Reaky ReLU對特征矩陣中負數信息的弱化,因此本文提出了全新的激活函數——eLU激活函數:

(11)

其中,該函數可證明在定義域內連續且處處可導。其一階導數如下:

(12)

此函數關于原點呈中心對稱,絕對值相同的數字信息具有相同的信息重量,有效避免了負數信息被弱化甚至忽略的情況。函數將所有數據映射到[-1,1],完成了數據的歸一化,可以代替BN層實現數據歸一化。將激活函數應用于Resnet-50多分類問題、CycleGAN風格遷移問題上,僅將原網絡中的激活函數進行替換,并進行了一系列對比實驗,結果均證明eLU的有效性與高效性。

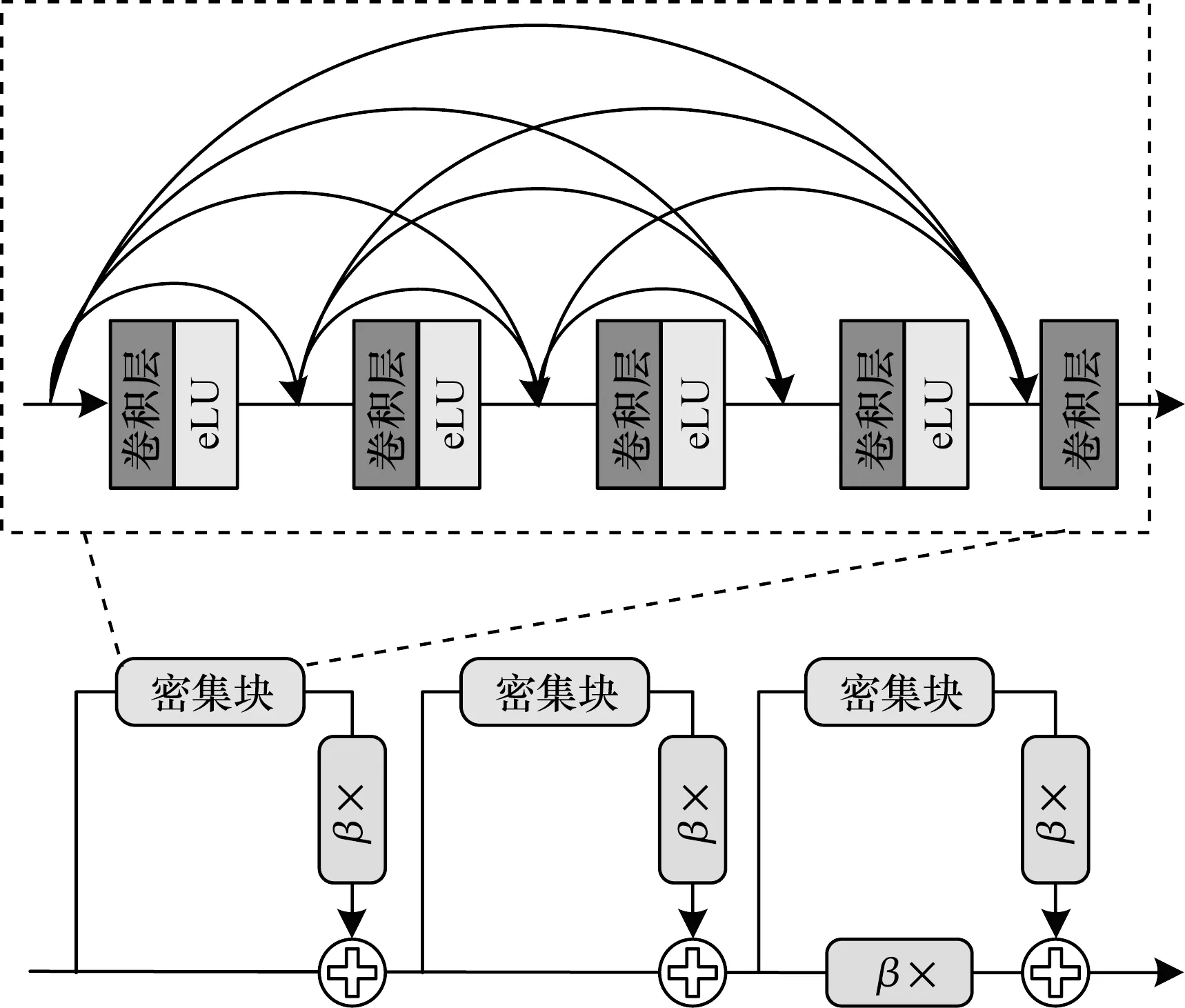

3)引入新的生成器結構。在原始CycleGAN生成器主體的結構上使用了新的密集殘差塊。根據過去的實驗,更多的層與連接總可以提升網絡的實際性能。隨著殘差密集塊的引入,可以將網絡中的密集連接變得更多,具體結構如圖2與圖3所示。

圖2 去除BN層的殘差塊結構

圖3 本文密集殘差塊

3 實驗結果與分析

3.1 數據集

在深度學習中,質量高且相關性高的數據集對于模型的訓練、驗證以及測試起著決定性的作用。一個合適的數據集往往決定了模型最終的效果。

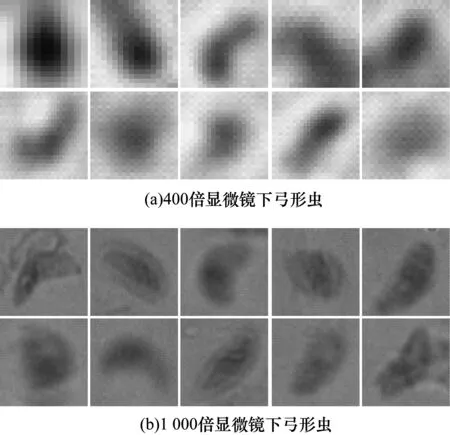

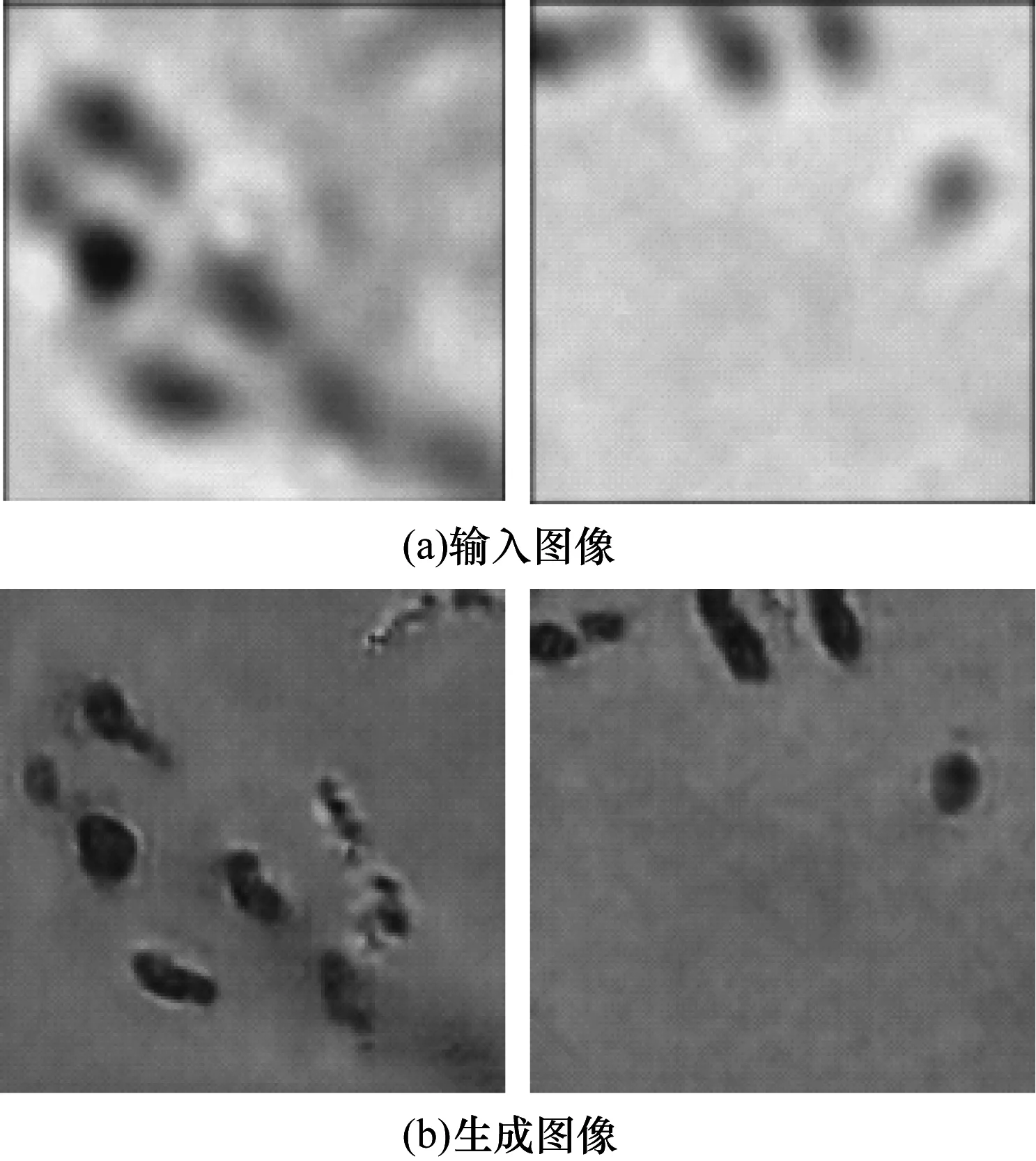

在顯微圖像中,本文選擇弓形蟲細胞數據作為實驗對象。因為弓形蟲病是我國乃至世界范圍內較為常見的人畜共患疾病,對人類具有健康威脅。因此,本文首先使用400倍醫用光學顯微鏡與1 000倍醫用光學顯微鏡分別對弓形蟲入侵圖像進行了圖像采集,如圖4所示。

圖4 弓形蟲數據集

首先對采集數據進行劃分,分別采集1 000張400倍顯微鏡下多個弓形蟲侵入細胞圖像與1 000張1 000倍顯微鏡下多個弓形蟲侵入細胞圖像作為多細胞數據集,并使用手工裁剪出單個細胞圖像作為單細胞數據集,將80%的400倍顯微圖像作為訓練源域Xtrain,20%的400倍顯微圖像作為測試源域Xtest。同理,將80%的1 000倍顯微圖像作為訓練源域Ytrain,20%的1 000倍顯微圖像作為測試源域Ytest。其中,訓練集負責訓練網絡,測試負責對網絡效果進行效果驗證。

3.2 圖像還原效果驗證

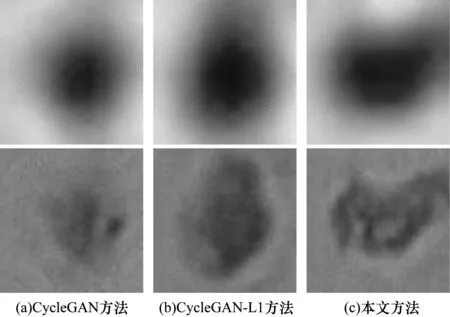

本節對本文方法、原始CycleGAN方法以及將原始CycleGAN第二范式損失函數更改為第一范式(原始CycleGAN-L1)這3種情況進行對比實驗。經過200輪訓練之后的實驗結果如圖5所示。

從圖5可以看出,原始CycleGAN方法還原信息不夠完善,胞膜還原不清晰,弓形蟲環形結構不明顯。使用第一范式后的CycleGAN方法雖然效果有所提升,但因缺少細節感知損失的約束,不能有效學習到細胞內部,尤其對于弓形蟲自身環形結構的還原重建效果仍有所欠缺。本文方法在圖像質量上,將弓形蟲環形結構與被侵入細胞的結構與形態進行了細致的還原,并且重建出諸多高倍數顯微下才能發現的圖像細節。

圖5 弓形蟲實驗結果對比

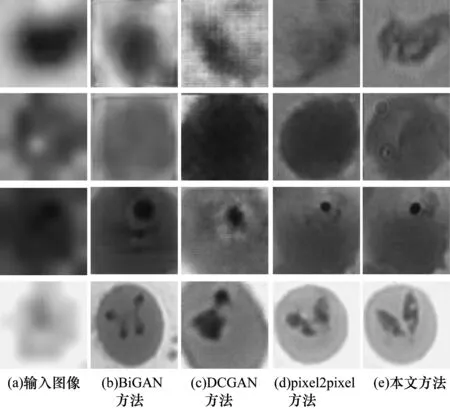

在證明本文方法使用非配對圖像訓練高倍數細胞顯微圖像重建具有顯著成效之后,本文還將高倍數細胞顯微圖像生成式對抗網絡與多種生成式對抗網絡進行了對比實驗,旨在證明本文網絡單獨生成器性能優于目前已知對生成式對抗網絡的生成器性能。

此外,本文還選用BiGAN[18]、DCGAN[19]、pixel2pixel[20]3種方法與HMGAN進行對比實驗。BiGAN根據隨機噪聲作為輸入,學習從隨機噪聲到高倍數細胞顯微圖像的映射。DCGAN與BiGAN同樣以隨機噪聲為輸入,但對噪聲到高倍細胞顯微圖像映射有更強約束。pixel2pixel為配對生成算法,以配對的高倍數與低倍數細胞顯微圖像作為輸入學習兩者映射關系。本文將高倍數顯微圖像進行下采樣獲得其對應的低倍數顯微圖像,將兩者作為輸入訓練pixel2pixel模型。對比實驗結果如圖6所示。其中,第1行為弓形蟲細胞,第2行為紅細胞,第3行為瘧原蟲細胞,第4行為巴貝斯蟲細胞。

圖6 弓形蟲、紅細胞、瘧原蟲、巴貝斯蟲細胞圖像實驗結果對比

從圖6可以看出多種GAN生成器性能之間的顯著差異。BiGAN方法生成的圖像不具有高倍數顯微下圖像的風格,且不能有效還原被入侵細胞內部結構。DCGAN方法生成圖像存在明顯的噪聲,細胞內部細節無法準確還原。pixel2pixel方法雖然可以較好地還原出高倍數顯微圖像,但是其細胞邊界不夠清晰,且弓形蟲環形結構仍然模糊。而本文方法對弓形蟲形態準確可信地進行了還原重建,具有微觀細節,人眼辨識度高。

此外,為檢驗網絡模型的通用性能,本文進一步分別對血細胞、瘧原蟲、巴貝斯蟲圖像進行訓練。瘧原蟲是瘧疾的病原體,巴貝斯蟲是一種人血寄生蟲,會引起人的巴貝斯蟲病,兩種寄生蟲的診斷均需要血液檢測。因此,選取血細胞、瘧原蟲、巴貝斯蟲3種圖像驗證本文模型的通用性能具有實際意義與衡量結果的可靠性。

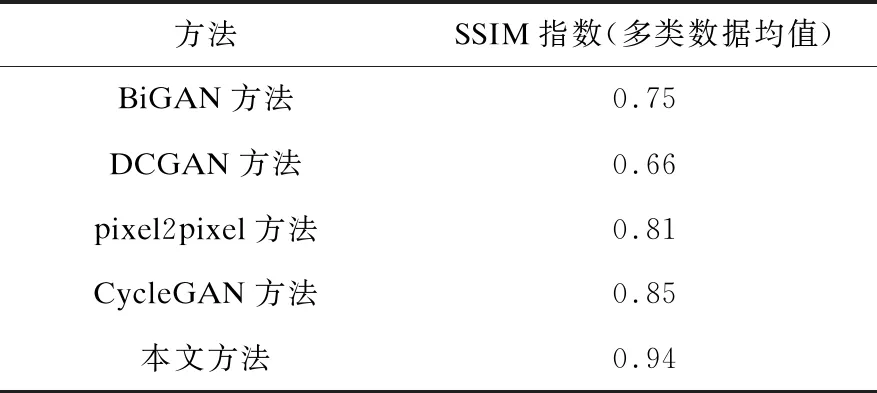

本文使用結構相似性指數(SSIM)作為衡量重建圖像顯示質量的標準。鑒于許多實驗結果顯示,峰值信噪比(PSNR)無法和人眼看到的視覺品質完全一致,有可能PSNR較高的反而比PSNR較低者差。結構相似度指數從圖像組成的角度將結構信息定義為獨立于亮度、對比度的反映場景中物體結構的屬性,并將失真建模為亮度、對比度和結構3個不同因素的組合。用均值作為亮度的估計,標準差作為對比度的估計,協方差作為結構相似程度的度量,其衡量得分與人眼視覺感知高度一致,因此使用SSIM更具可靠性。對比結果如表1所示。

表1 SSIM指數對比

上述實驗針對的是單個圖片的高倍數細胞顯微圖片的重建效果的測試。在實際的細胞圖像中,一張圖片中往往有多個細胞,本文對此情況也進行了測試,效果如圖7所示,本文方法對多細胞圖像有很好的重建效果。

圖7 多細胞圖像實驗結果對比

3.3 eLU性能測試

本文方法并未使用目前主流的激活函數,而是提出了一種新的激活函數——eLU激活函數。為證明eLU激活函數對模型的積極作用,本文對其進行了性能測試。通過Resnet-50六分類問題與CycleGAN風格轉換兩類領域的對比測試,評估eLU的綜合性能。

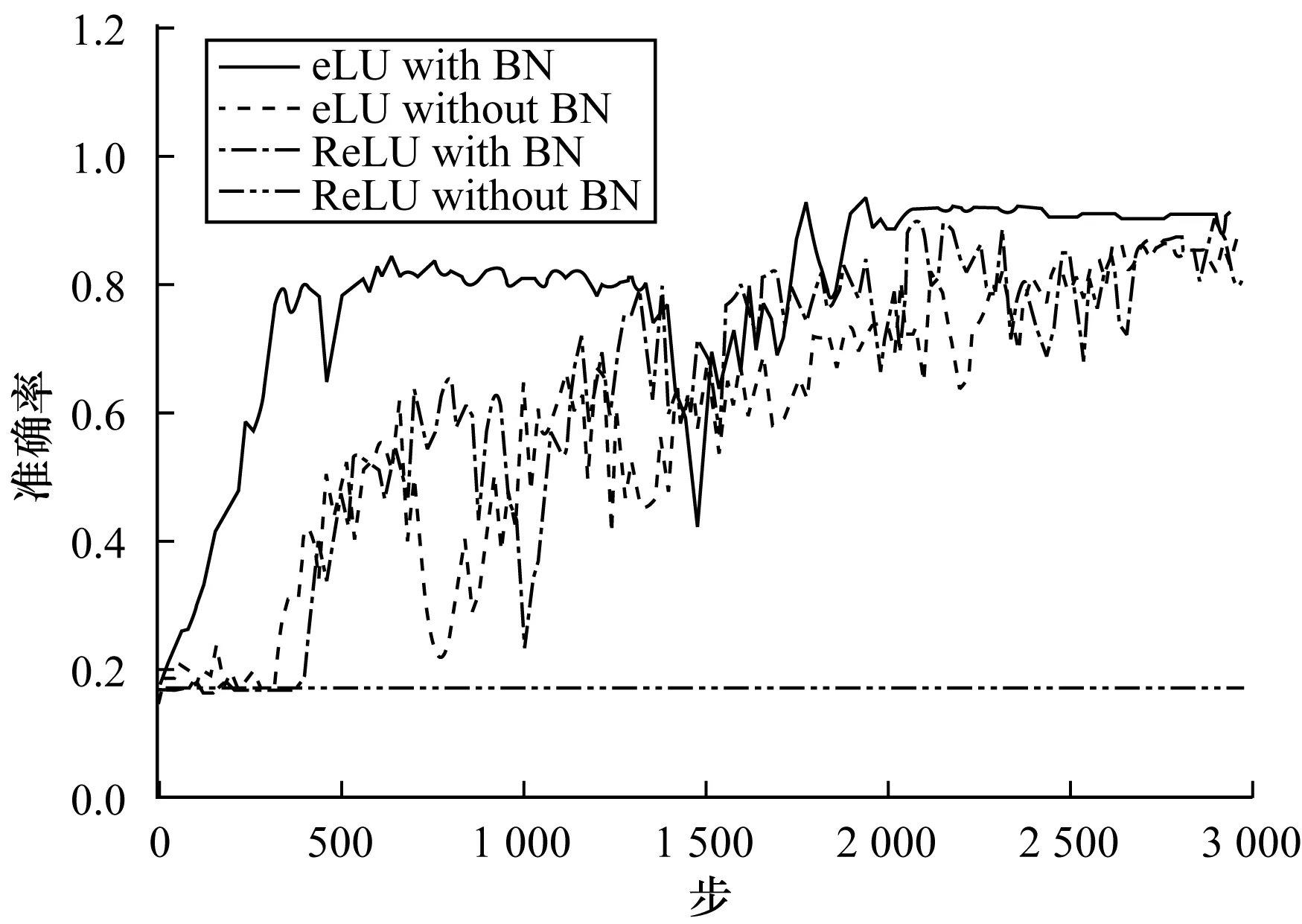

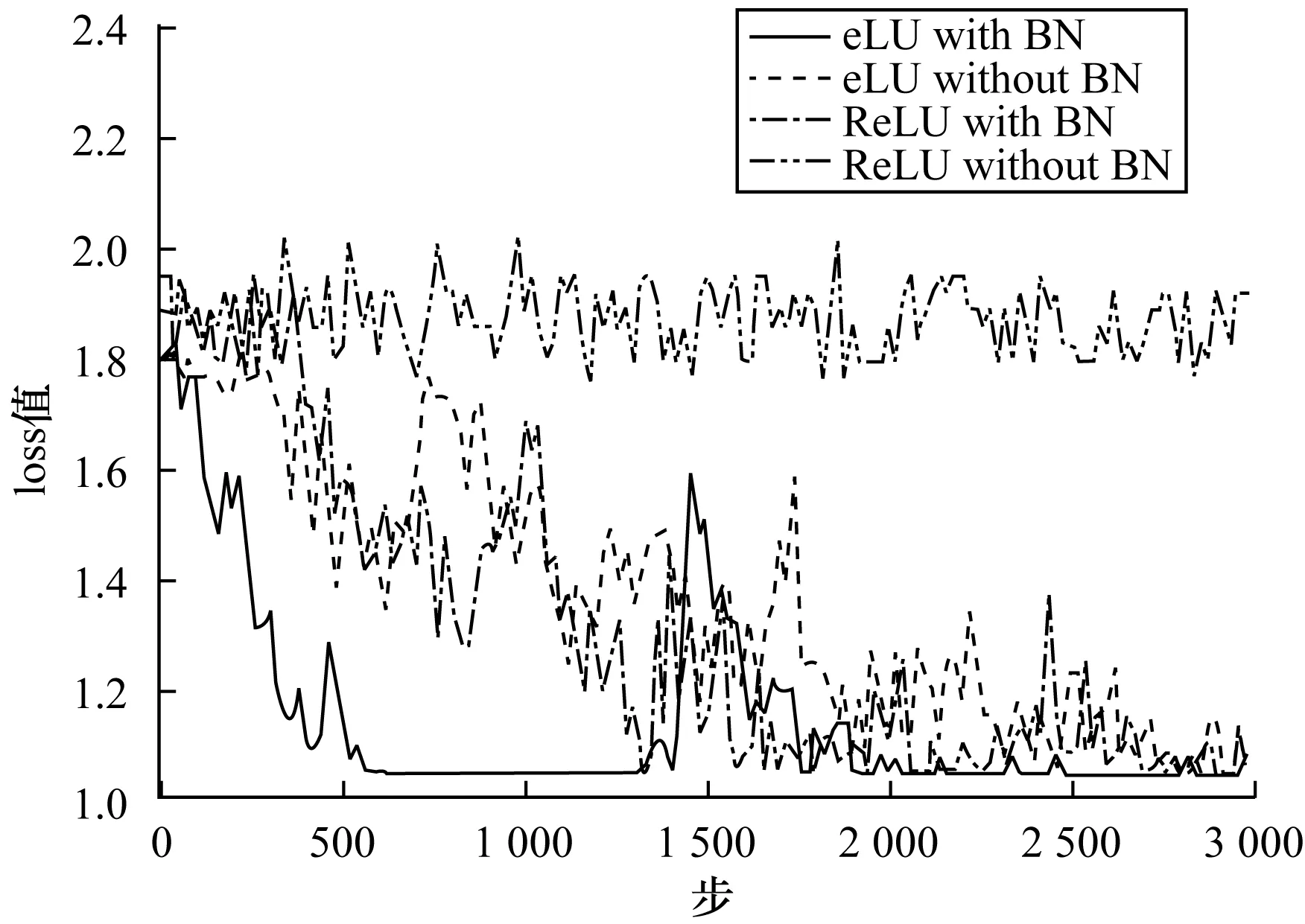

3.3.1 eLU多分類測試

本文使用人體六類手勢的數據集,隨機抽取80%作為訓練集,將剩余20%作為測試集。使用相同Resnet-50,分4個網絡分別作出如下改動:1)將原網絡激活函數換做eLU激活函數;2)將原網絡激活函數換做eLU激活函數并去掉BN層;3)將原網絡BN層去掉;4)保持原網絡不變。通過3 000步的訓練,對比效果如圖8和圖9所示。

圖8 準確率曲線

圖9 損失曲線

實驗結果表明,eLU不僅能加快網絡訓練速度,而且可以在一定程度上代替BN層,維持網絡處于可訓練的狀態。

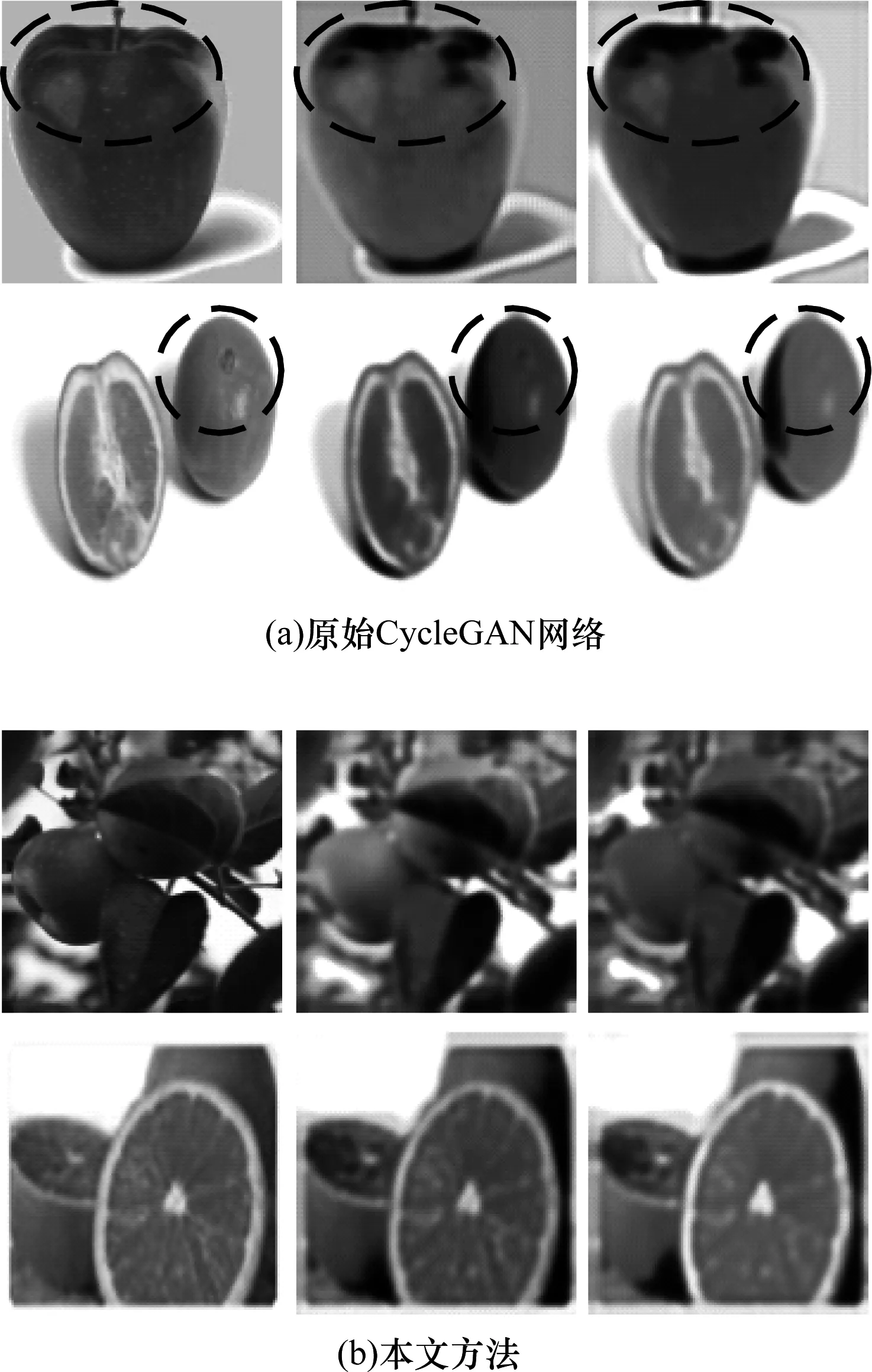

3.3.2 eLU風格轉換測試

同樣本文將eLU在CycleGAN上進行了對比測試。在經過15 000步之后,得到效果對比如圖10所示。從圖10中可以清晰地看出,原始CycleGAN網絡可能會出現重建缺失(見圓圈處)。而在相同的步數下,僅將原始CycleGAN網絡中的激活函數換為eLU即可獲得較好效果,且經過循環網絡后重建的圖像,與原始輸入圖像更具有一致性。

圖10 風格轉換實驗結果對比

可見,eLU在網絡訓練方面可以有效加快訓練速度,在圖像重建方面可以有效保留原始信息,使得人眼對生成圖像有了更真實可信的感受。

4 結束語

本文提出一種高倍數細胞顯微圖像生成式對抗網絡,在CycleGAN網絡基礎上,設計并使用新的激活函數eLU,將原始生成器去掉BN層,引入新的殘差塊結構。為加強高倍數細胞顯微圖像重建后圖像的真實性與可信度,給出細節感知損失,改善了高倍數顯微重建的效果。實驗結果表明,與BiGAN、DCGAN、pixel2pixel以及原始CycleGAN相比,本文方法在細胞超分辨率還原方面獲得更好的人眼感受。本文模型的開發可以減小細胞圖像檢測的時間與物質成本,并應用于生物、醫療等方面。如何利用該模型同時對多種顯微生物進行高倍數顯微重建,將是下一步的研究方向。