一種面向3D點(diǎn)云識(shí)別的新型卷積神經(jīng)網(wǎng)絡(luò)?

陳 盟 陳興華 鄒 鵬

(南京理工大學(xué)計(jì)算機(jī)科學(xué)與技術(shù)學(xué)院 南京 210094)

1 引言

無人平臺(tái)環(huán)境感知與理解是人工智能研究領(lǐng)域的重點(diǎn)和難點(diǎn)。激光雷達(dá)憑借其探測(cè)距離遠(yuǎn)、精度高和抗干擾能力強(qiáng)等優(yōu)點(diǎn),得到廣泛使用,其主要是利用光的收發(fā)時(shí)間差來獲得被反射物體的相對(duì)方位角和距離。這種對(duì)周圍環(huán)境物體表面稀疏采樣點(diǎn)的數(shù)據(jù)集合稱為點(diǎn)云。點(diǎn)云識(shí)別的研究存在三個(gè)重點(diǎn)問題:點(diǎn)云具有無序性、稀疏性和浮動(dòng)性。由于卷積神經(jīng)網(wǎng)絡(luò)對(duì)于圖像、點(diǎn)云等局部強(qiáng)關(guān)聯(lián)特征提取的高效性,對(duì)語義信息抽象能力的優(yōu)越性,廣泛應(yīng)用于環(huán)境感知任務(wù)中。在KITTI、Model?Net40和ShapeNet等點(diǎn)云數(shù)據(jù)集上,基于深度學(xué)習(xí)的檢測(cè)算法均處于主導(dǎo)地位。

本文重點(diǎn)研究ModelNet40點(diǎn)云數(shù)據(jù)集的目標(biāo)多分類任務(wù)。通過對(duì)點(diǎn)云三維空間位置進(jìn)行球坐標(biāo)下豎直與水平方向上的角度索引編碼,把點(diǎn)云轉(zhuǎn)換為緊密二維多通道點(diǎn)特征圖。作為卷積神經(jīng)網(wǎng)絡(luò)的輸入,以此解決點(diǎn)云無序性和浮動(dòng)性的問題;設(shè)計(jì)的新型卷積神經(jīng)網(wǎng)絡(luò),使用單點(diǎn)微型感知機(jī)對(duì)數(shù)據(jù)缺失空洞的魯棒性進(jìn)行點(diǎn)云局部特征抽象提高,并且使用跳躍連接結(jié)構(gòu)進(jìn)行不同層次間的特征補(bǔ)充,對(duì)點(diǎn)云進(jìn)行多層次特征的提取與融合;最后使用提取出的全局特征實(shí)現(xiàn)點(diǎn)云分類,并且與當(dāng)前主流方法進(jìn)行實(shí)驗(yàn)對(duì)比。

2 點(diǎn)云特征圖

點(diǎn)云處理與識(shí)別技術(shù)的發(fā)展可以概括為人為提取特征、經(jīng)典機(jī)器學(xué)習(xí)和深度學(xué)習(xí)三個(gè)階段。文獻(xiàn)[1]提出了基于貝葉斯理論的柵格占用估計(jì)實(shí)現(xiàn)背景點(diǎn)云分割;文獻(xiàn)[2]把點(diǎn)云映射到球坐標(biāo)系下;基于RANSAC[3]的方法提取點(diǎn)云輪廓特征。文獻(xiàn)[4]支持向量機(jī)(SVM)來識(shí)別障礙物,高斯混合模型(GMM)[5]和馬爾可夫隨機(jī)場(chǎng)(MRF)[6]在初步人為提取的點(diǎn)云特征下進(jìn)行訓(xùn)練。文獻(xiàn)[7]融合了單目視覺與雷達(dá)點(diǎn)云的多視圖信息;文獻(xiàn)[8~9]把點(diǎn)云的三維坐標(biāo)信息映射到球坐標(biāo)下,生成深度前視圖。文獻(xiàn)[10~11]對(duì)CAD模型和場(chǎng)景點(diǎn)云進(jìn)行體素(voxel)柵格劃分;文獻(xiàn)[12~13]建立基于三維體素柵格特征提取的實(shí)時(shí)檢測(cè)模型。文獻(xiàn)[14~15]提出直接提取點(diǎn)云特征的神經(jīng)網(wǎng)絡(luò);文獻(xiàn)[16]提出無序點(diǎn)云的X變換來獲得規(guī)則特征。

無人平臺(tái)場(chǎng)景點(diǎn)云感知任務(wù)中,提取點(diǎn)云多層次的空間特征尤為重要。本節(jié)對(duì)原始散亂稀疏點(diǎn)云進(jìn)行空間球坐標(biāo)下豎直角(仰角)、水平角(方位角)的角度索引編碼,把場(chǎng)景散亂稀疏點(diǎn)云轉(zhuǎn)換為有序緊密的多通道點(diǎn)特征圖,改善了原始點(diǎn)云無序性問題,方便卷積神經(jīng)網(wǎng)絡(luò)提取有效的局部關(guān)聯(lián)結(jié)構(gòu)特征與全局語義特征。

2.1 點(diǎn)云數(shù)據(jù)集ModelNet40

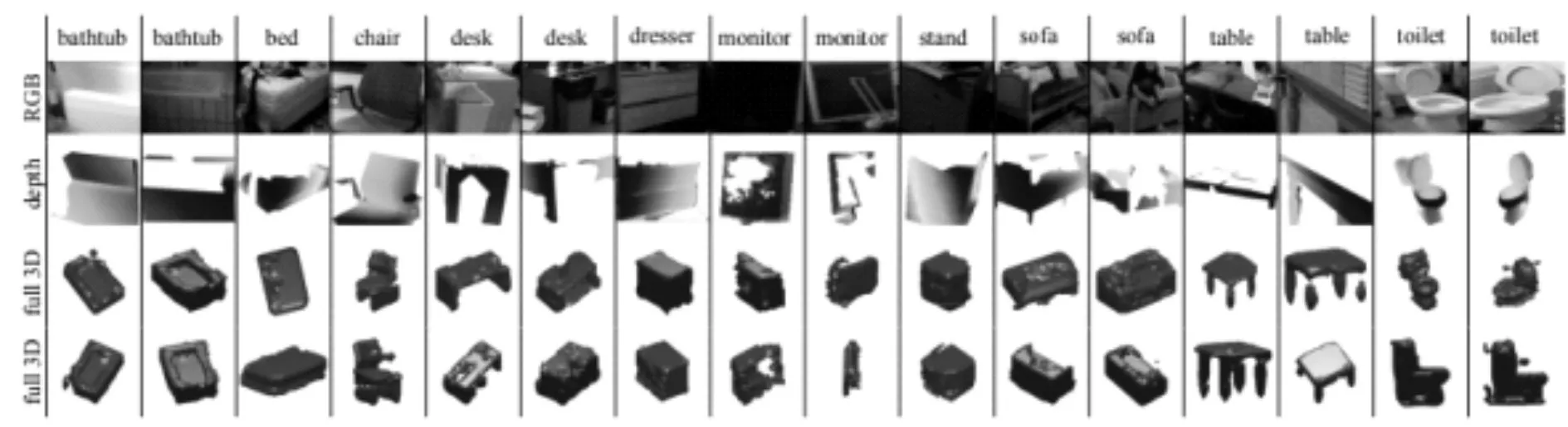

ModelNet40提供了如圖1所示的CAD模型點(diǎn)云,數(shù)據(jù)集共包含40個(gè)對(duì)象類別(如飛機(jī)、浴池、植物等),其中9843個(gè)實(shí)例點(diǎn)云模型作為訓(xùn)練集,另外2468個(gè)實(shí)例點(diǎn)云模型作為測(cè)試集驗(yàn)證算法模型的性能。

每個(gè)CAD模型點(diǎn)云提供每個(gè)描述點(diǎn)的三維坐標(biāo)(x,y,z) 并且包含四種分辨率:256/512/1024/2048,本文實(shí)驗(yàn)基礎(chǔ)均建立在2048分辨率的CAD模型點(diǎn)云上。

圖1 ModelNet40點(diǎn)云數(shù)據(jù)集

2.2 點(diǎn)云多通道點(diǎn)特征圖

對(duì)散亂無序的CAD模型點(diǎn)云數(shù)據(jù)進(jìn)行預(yù)處理,得到有序緊密的多通道點(diǎn)特征圖,該流程如下:

步驟1:讀取原始點(diǎn)云數(shù)據(jù),每個(gè)數(shù)據(jù)點(diǎn)包含三維直角坐標(biāo)(x,y,z) 及回波反射值intense;設(shè)定豎直、水平角度分辨率等相關(guān)參數(shù);讀取點(diǎn)云類別標(biāo)注信息。

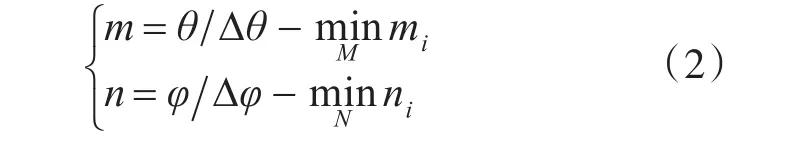

步驟2:數(shù)據(jù)點(diǎn)的三維直角坐標(biāo)(x,y,z) 轉(zhuǎn)換為空間球坐標(biāo)( )γ,θ,φ如式(1)所示;再根據(jù)豎直角分辨率?θ、水平角分辨率?φ劃分角度單位子空間,得到分辨率為m×n的空間緊密點(diǎn)特征圖見式(2)。

其中,ε為任意無窮小量。

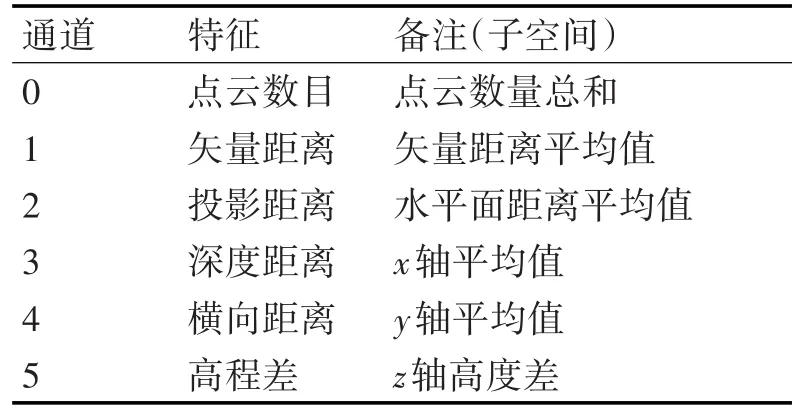

表1 點(diǎn)云單位子空間特征

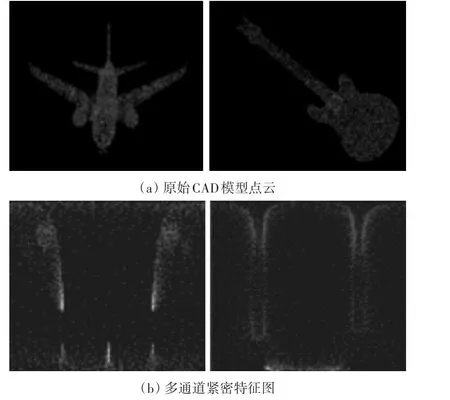

圖2 點(diǎn)特征圖生成

步驟3:構(gòu)造點(diǎn)云單位子空間內(nèi)數(shù)目、矢量距離等k個(gè)特征,見表1。按照步驟2中點(diǎn)云轉(zhuǎn)換后的m、n值對(duì)點(diǎn)云進(jìn)行有序排列,構(gòu)造大小為m×n×k的多通道點(diǎn)云特征圖,得到如圖2所示的從原始CAD散亂無序的模型點(diǎn)云,生成固定分辨率的多通道緊密特征圖。

3 點(diǎn)云多分類網(wǎng)絡(luò)

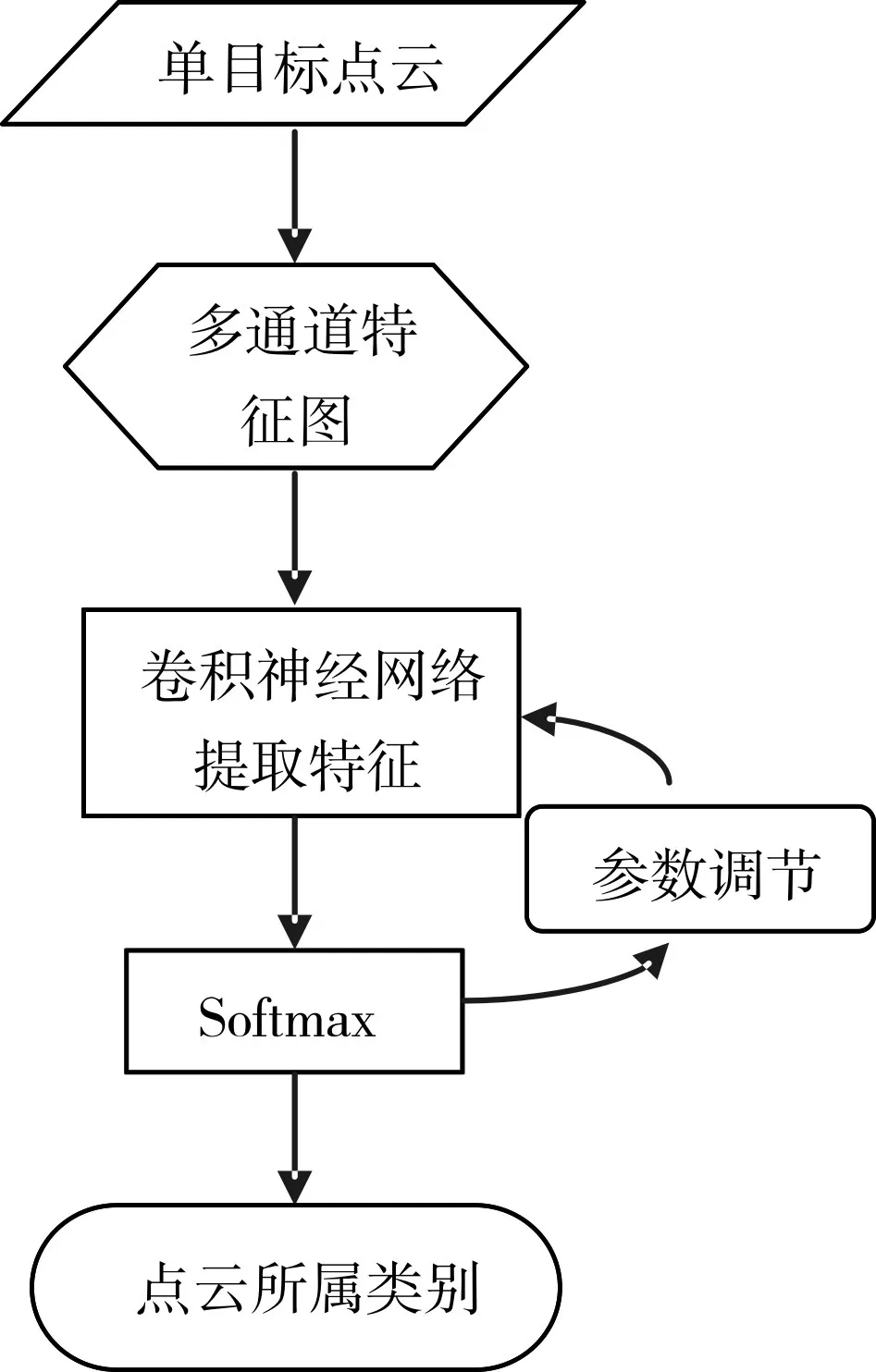

本節(jié)針對(duì)第2節(jié)點(diǎn)云預(yù)處理過后生成的多通道點(diǎn)特征圖,設(shè)計(jì)點(diǎn)云分類模型進(jìn)行單目標(biāo)點(diǎn)云全局語義特征的提取,完成目標(biāo)點(diǎn)云多分類任務(wù)(流程見圖3)。

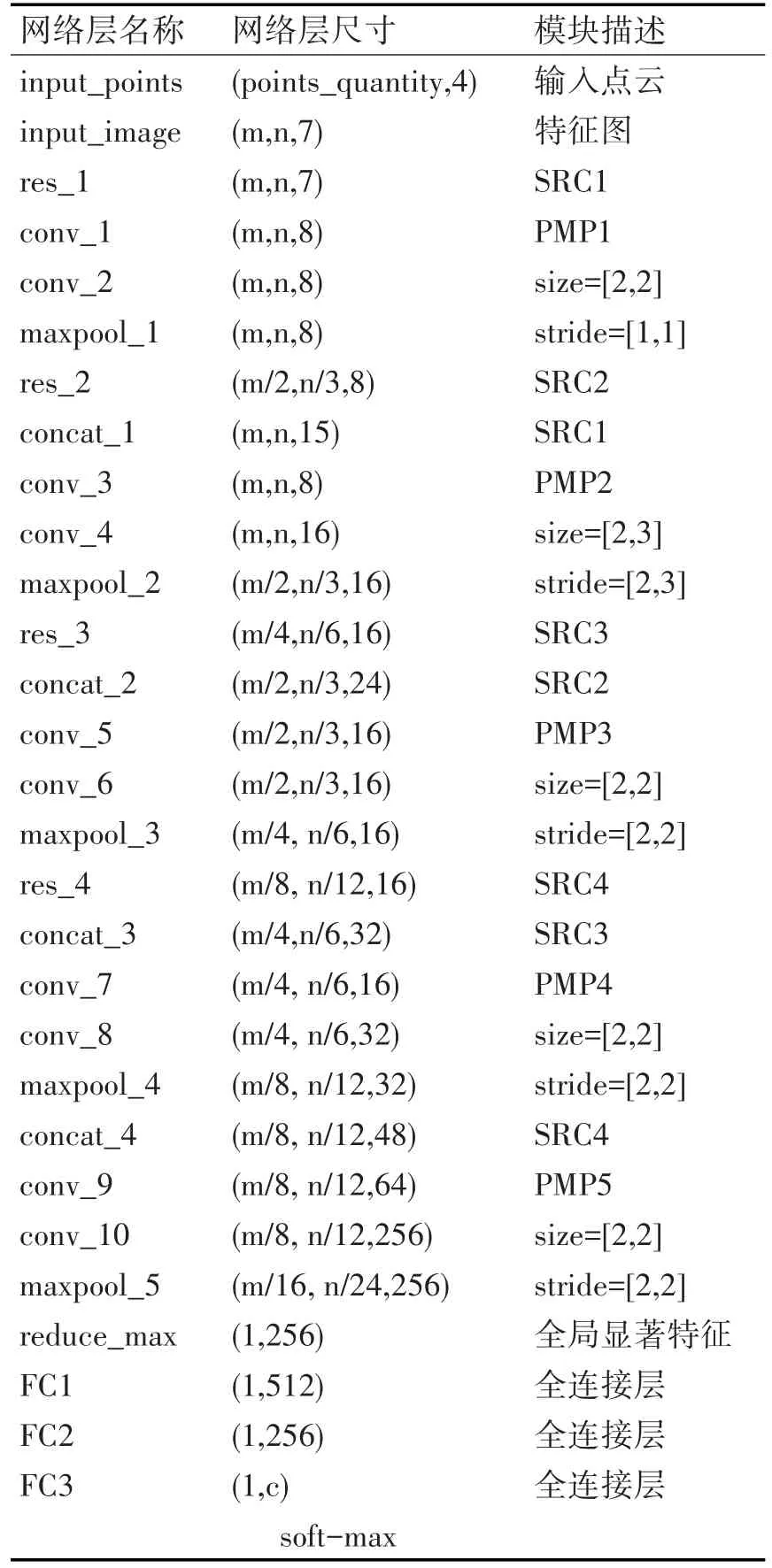

表2 分類網(wǎng)絡(luò)詳細(xì)結(jié)構(gòu)

本文針對(duì)場(chǎng)景點(diǎn)云的特點(diǎn),設(shè)計(jì)具有跳躍連接和點(diǎn)微型感知機(jī)等特殊結(jié)構(gòu)的卷積神經(jīng)網(wǎng)絡(luò)對(duì)點(diǎn)云多通道點(diǎn)特征圖進(jìn)行特征提取。

點(diǎn)云分類模型面向經(jīng)過歐式聚類分割后的單目標(biāo)點(diǎn)云對(duì)象(共c種類別),使用卷積神經(jīng)網(wǎng)絡(luò)對(duì)預(yù)處理后的多通道點(diǎn)特征圖(input_image)提取全局特征,利用全連接層對(duì)全局特征進(jìn)行降維變換,得到點(diǎn)云的c維logits列向量,再通過softmax得到輸入目標(biāo)點(diǎn)云屬于各個(gè)類別的概率,最后計(jì)算與點(diǎn)云目標(biāo)類別標(biāo)注的交叉熵得到預(yù)測(cè)類別與真實(shí)類別偏差損失,利用adam優(yōu)化算法進(jìn)行神經(jīng)網(wǎng)絡(luò)梯度反向傳播更新參數(shù)權(quán)重,使得預(yù)測(cè)類別偏差損失盡可能接近于0,得到能夠精確檢測(cè)單目標(biāo)點(diǎn)云所屬類別的分類模型。

圖3 點(diǎn)云識(shí)別方法流程

表2設(shè)計(jì)了點(diǎn)云分類模型的具體網(wǎng)絡(luò)結(jié)構(gòu)。根據(jù)2.1節(jié)所述的點(diǎn)云數(shù)據(jù),預(yù)處理過后轉(zhuǎn)化為分辨率為m×n的7通道特征圖作為模型輸入;先通過SRC模塊進(jìn)行概率隨機(jī)池化作為后續(xù)concat層的通道補(bǔ)充合并淺層特征,設(shè)計(jì)的SRC模塊實(shí)現(xiàn)相鄰最大池化層間特征跳躍連接,concat層把淺層特征合并到當(dāng)前池化層,作為當(dāng)前池化層的新特征通道;PMP層包含的點(diǎn)微型感知機(jī)均為兩層,并且相同PMP層中作用于每個(gè)點(diǎn)的兩層感知機(jī)參數(shù)共享,通過點(diǎn)微型感知機(jī)相當(dāng)于把單點(diǎn)的多通道特征進(jìn)行維度提升,隨著網(wǎng)絡(luò)越深提升的維度越高,能夠表達(dá)的抽象語義也越豐富;PMP層中的最大池化層提取相同通道內(nèi)的局部顯著特征,通過池化逐漸縮小特征圖尺寸,逐步擴(kuò)大顯著特征提取的感受野,得到不同層次的特征表達(dá);全局特征提取層(reduce_max)對(duì)經(jīng)過PMP5層輸出的最高層特征提取256個(gè)通道上的256個(gè)顯著通道特征作為全局特征,通過3層全連接層的全局特征維度變換得到點(diǎn)云分類的c維logits向量,最后通過softmax層輸出c個(gè)類別相應(yīng)概率,取最大概率對(duì)應(yīng)類別為輸入點(diǎn)云的類別。其中,網(wǎng)絡(luò)層名稱按實(shí)際網(wǎng)絡(luò)結(jié)構(gòu)生成時(shí)的順序命名,數(shù)據(jù)除了跳躍連接SRC模塊外均由淺層向深層傳輸;網(wǎng)絡(luò)層尺寸由該網(wǎng)絡(luò)層數(shù)據(jù)節(jié)點(diǎn)存儲(chǔ)矩陣大小表示;模塊描述表示相應(yīng)網(wǎng)絡(luò)層涉及到的不同結(jié)構(gòu),PMP中的size和stride均為池化參數(shù),PMP中的conv表示參數(shù)共享的MLP層的某1層,沒有特殊說明時(shí)conv的步長(zhǎng)與尺寸均為[1,1],神經(jīng)元非線性激活函數(shù)均為ReLU。

4 實(shí)驗(yàn)與對(duì)比分析

4.1 實(shí)驗(yàn)設(shè)計(jì)

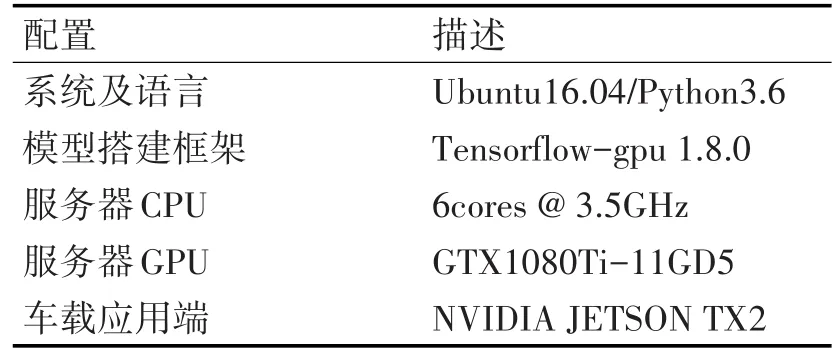

本文在本地深度學(xué)習(xí)平臺(tái)上進(jìn)行網(wǎng)絡(luò)模型的設(shè)計(jì)、訓(xùn)練與對(duì)比測(cè)試,實(shí)驗(yàn)環(huán)境如表3所示。

表3 實(shí)驗(yàn)環(huán)境配置

4.2 點(diǎn)云多分類

本節(jié)實(shí)驗(yàn)使用ModelNet40數(shù)據(jù)集進(jìn)行40個(gè)類別的單目標(biāo)點(diǎn)云分類,數(shù)據(jù)集包含12,311個(gè)已分類的CAD點(diǎn)云模型(每個(gè)模型共2048個(gè)三維采樣點(diǎn)),將其中9,843幀劃分為訓(xùn)練集,剩余2,468幀作為測(cè)試集,每遍歷一輪訓(xùn)練集數(shù)據(jù),測(cè)試一次當(dāng)前模型訓(xùn)練結(jié)果,對(duì)比評(píng)價(jià)各個(gè)主流點(diǎn)云算法的性能。實(shí)驗(yàn)中,訓(xùn)練集與測(cè)試集數(shù)據(jù)源均相同,記錄250輪訓(xùn)練中各算法模型總體分類準(zhǔn)確率與類別分類平均準(zhǔn)確率的測(cè)試結(jié)果,得到如表4結(jié)果(部分?jǐn)?shù)據(jù)來源于文獻(xiàn)[14])。其中,根據(jù)輸入點(diǎn)云的預(yù)處理方法分為二維柵格、三維空間體素、多視圖圖像、無預(yù)處理與本文使用的角度索引點(diǎn)云特征圖。

表4 ModelNet40分類結(jié)果

本文網(wǎng)絡(luò)設(shè)計(jì)基準(zhǔn)(baseline)為文獻(xiàn)[9]中提出的L05-Net,點(diǎn)云預(yù)處理方式都是角度索引,分類的全連接層共用本文設(shè)計(jì)的網(wǎng)絡(luò),由于其特征提取模型為簡(jiǎn)易的淺層網(wǎng)絡(luò),測(cè)試精度較低。MVCNN[7]在類別分類平均準(zhǔn)確率上表現(xiàn)最好,本文方法由于CAD模型點(diǎn)云生成角度索引特征圖時(shí),相同水平與豎直索引位置上有部分采樣點(diǎn)重合造成細(xì)節(jié)信息的損失,對(duì)于小部特殊分類別判斷不夠精確。

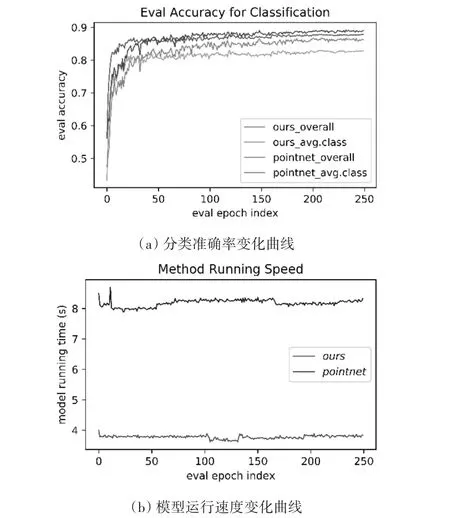

在總體分類準(zhǔn)確率上本文方法處于主流方法的第一梯隊(duì),相比表現(xiàn)最好的 PointNet[14],在相同測(cè)試環(huán)境下,本文使用ModelNet40相同訓(xùn)練與測(cè)試數(shù)據(jù)實(shí)驗(yàn)得到的測(cè)試結(jié)果對(duì)比曲線,模型算法運(yùn)行時(shí)間為tensorflow中搭建的計(jì)算圖運(yùn)行測(cè)試集2,468幀點(diǎn)云數(shù)據(jù)所消耗的時(shí)間,PointNet[14]平均每輪數(shù)據(jù)測(cè)試耗時(shí)8.18s(每幀3.31ms),本文方法耗時(shí)3.77s(每幀1.53ms),在運(yùn)行速度上具有很大優(yōu)勢(shì),更適用于實(shí)際工程,測(cè)試準(zhǔn)確率與算法運(yùn)行速度變化曲線見圖4。

圖4 分類模型性能評(píng)估

5 結(jié)語

本文提出了一種新的CAD模型點(diǎn)云多分類識(shí)別方法,針對(duì)點(diǎn)云數(shù)據(jù)的無序性、稀疏性和浮動(dòng)性等難點(diǎn),把原始點(diǎn)云轉(zhuǎn)化為角度索引點(diǎn)特征圖實(shí)現(xiàn)點(diǎn)云特征表達(dá)的緊密有序化,并且利用卷積神經(jīng)網(wǎng)絡(luò)思想設(shè)計(jì)了單目標(biāo)點(diǎn)云分類特征提取算法模型,通過在公有點(diǎn)云數(shù)據(jù)集上與多個(gè)典型點(diǎn)云識(shí)別算法相比較,證明了本文算法在保證檢測(cè)準(zhǔn)確率的同時(shí),有效地提高了算法實(shí)時(shí)性。算法目前已成功應(yīng)用在無人駕駛車上。