基于時序卷積網絡的情感識別算法

宋振振, 陳蘭嵐, 婁曉光

(華東理工大學化工過程先進控制和優化技術教育部重點實驗室,上海 200237)

情感識別作為情感研究的核心內容能夠使機器理解人的感性思維,影響著機器智能化的繼續發展,成為影響人機自然交互的關鍵要素。同時,情感識別融合多學科為一體,其發展將會帶動多學科的共同發展,其應用也會帶來巨大的經濟效益和社會效益,因此情感識別已成為研究的熱點。

早期對人類情感的研究通常是利用人的面部表情[1]或人的聲音信號[2]進行不同情感狀態的識別,這兩種人體信號雖然較易獲得,但也十分容易被偽裝,特別是當受試者不愿意被其他人察覺到自己的情感狀態時。由于生理信號不易被偽裝,因此有學者提出了利用人體生理信號,如腦電(Electroencephalogram,EEG)、心電、肌電、皮膚電阻、皮溫、呼吸信號等來判斷受試者的情感狀態。Healey 等[3]的研究結果證明了應用生理信號進行情感狀態辨別是可行的。在生理信號中,EEG 信號是一種比較敏感的客觀指標,能夠較為精確地反映出人的情感變化,因此近年來很多研究者開始使用EEG 信號進行情感識別。

深度學習是機器學習研究中的一個新領域,其目標在于建立、模擬人腦進行分析學習的神經網絡,這種神經網絡可以模仿人腦的機制來解釋諸如圖像、聲音和文本等不同類型的數據。目前已有很多學者將深度學習應用于腦電情感識別。文獻[4]使用深度置信網絡(Deep Belief Network, DBNS)對EEG 信號進行二分類情感識別,識別精度能夠達到86.08%;文獻[5]結合卷積神經網絡(Convolution Neural Network, CNN)和循環神經網絡(Recurrent Neural Network, RNN)網絡,對EEG 的正確識別率最高達到了74.12%;文獻[6]提出了一種具有子節點的特殊神經網絡對EEG 信號提取差分熵,最高正確率達到93.26%;文獻[7]提出并評估了一套深度信念網絡模型,并驗證了這些模型對分類精度有很大的提高。

目前深度學習應用領域中的兩大主流結構是CNN 和RNN。CNN 的特點之一是網絡的狀態僅依賴于輸入,但它并不適用于所有問題。例如對于具有時間屬性的數據而言,僅依靠當前時刻輸入的效果并不是很理想,因此有研究者開始將序列模型用于情感識別的研究中。如文獻[8]使用長短期記憶網絡(Long Short-Term Memory,LSTM)對腦電信號進行情感識別,取得了很好的效果。然而,傳統的序列模型都是在RNN 基礎上的演變,如LSTM[9]、門控單元循環網絡(Gate-Variants of Gated Recurrent Unit,GRU)[10]等,因此序列模型存在一個很大的問題就是它的訓練效率相對于CNN 來說較低。因為RNN 的結構特點,使得每一個時刻的狀態學習都依賴于前一個時刻的狀態,因此無法做到并行運算,從而導致計算效率大大降低。此外,深度學習在訓練模型過程中很容易陷入局部最優,很難得到全局最優值。針對以上問題,本文提出使用時序卷積網絡(Temporal Convolution Networks,TCN)[11]對腦電信號進行情感識別,該模型既具有時間序列的特性同時也保留了CNN 的可并行計算特點,在保持精度的同時提高了計算效率。同時本文還采用Snapshot 快照集成策略[12],通過調整學習率的方式盡可能地尋找到最接近全局最優的值。

1 情感識別模型

基于腦電信號的情感識別步驟一般包括:情感的誘發、腦電信號采集、信號預處理、腦電特征提取及情感學習分類。

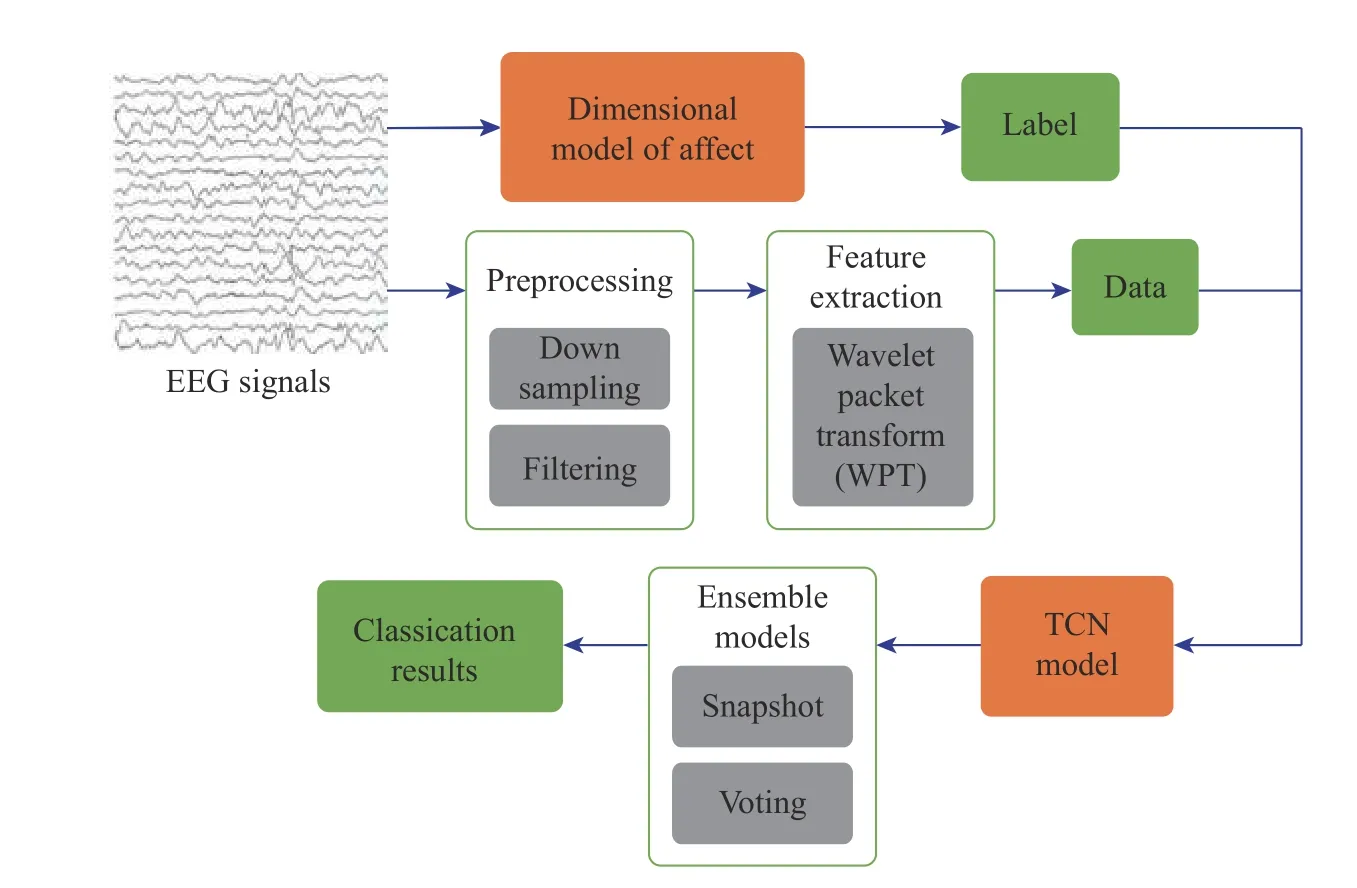

本文采用DEAP 數據集[13],使用TCN 模型進行情感識別,整體設計框架如圖1 所示。首先采用小波包變換的方法對預處理過的原始數據提取特征,同時構建情感分類模型,為每個樣本標注合適的情感標簽;然后以TCN 模型為主體,使用Snapshot 優化訓練方法選擇出最優的情感識別分類器。

圖1 基于腦電信號的情感識別算法總體框圖Fig.1 Overall block diagram of EEG-based emotion recognition algorithm

2 數據集及預處理

2.1 DEAP 數據集

DEAP 數據集是由英國倫敦瑪麗皇后大學的研究人員通過實驗開發的一個用于分析人類情感狀態的多模態數據集。該實驗選取了40 段音樂視頻(MV),每段音樂視頻的時間長度為63 s,其中前3 s是準備時間。受試者在觀看完每段視頻后對該視頻片段的效價、喚醒度、喜好程度和熟悉度等進行評分,分值為1~9。

該數據集記錄了32 個受試者的40 個導聯腦電生理信號。其中前32 個導聯采集腦電信號,腦電電極的安放位置采用國際腦電圖學會規定的10~20 系統電極放置法;后8 個導聯采集人體的外圍生理信號,包括眼電、肌電及皮膚電阻。本文僅使用了其中18名受試者的32 個導聯腦電信號和受試者對每個視頻片段的評價指標兩部分數據。

2.2 數據預處理

數據經過預處理后最終得到每個受試者的數據格式為40 × 32 × 8 064,其中40 表示40 個視頻片段,32 表示實驗采用的導聯數,8 064 表示對每個63 s 的視頻片段以128 Hz 的頻率進行采樣,每個視頻片段共采集得到63 × 128 = 8 064 個數據點。

3 情緒劃分模型

TCN 模型是有監督學習模型,所處理的數據格式是有標簽數據,而DEAP 數據集本身是沒有標簽的,所以在學習之前要給數據生成情感分類標簽。在DEAP 數據集中,給數據生成情感分類標簽主要是基于受試者對視頻片段的評價指標,因此涉及到了情感的分類模型。

研究者通常從兩種視角來建構和理解情感的分類模型:基本情感模型[14]和維度情感模型[15]。維度情感模型即情感狀態的“愉悅度-喚醒度-支配度”三維模型[16]。Valence(愉悅度)表示積極或消極的情緒狀態,如興奮、愛、平靜等積極情緒及羞愧、無趣、厭煩等消極情緒。Arousal(喚醒度)表示生理活動和心理警覺的水平差異,低喚醒如睡眠、厭倦、放松等;高喚醒如清醒、緊張等。

由于Valence 和Arousal 兩個維度就可以解釋絕大部分情緒變化,因此本文僅采用這兩個維度作為受試者的情感評價指標,即通過受試者對Valence和Arousal 的評分來判斷受試者當前的情緒狀態。本文對Valence 和Arousal 進行單獨的分類,即LV(Low Valence)表示消極的情緒;HV(High Valence)表示積極的情緒;LA(Low Arousal)表示平靜;HA(High Arousal)表示激動;由于Valence 和Arousal 之間具有關聯性,因此同時也考慮了結合Valence 和Arousal的分類,即HVHA、HVLA、LVHA、LVLA 4 種情緒狀態。在二分類任務中,由于只考慮某一項指標,得分較為均勻,因此可以取中間分數作為閾值為情緒進行劃分。本實驗的評分在1~9 之間,因此取5 作為閾值。而在四分類任務中,因同時考慮兩項指標,導致評價分數點不規則分布。如圖2 所示,每個受試者的得分點分布差異過大,若仍然采取閾值的方式進行情緒的劃分,會忽略受試者之間的差異性。本文采用K-均值(K-means)聚類方法自適應地將情緒聚成4 類,圖2 中的每種顏色分別代表不同的類別,黑色的十字符號表示聚類中心點,可以看出通過聚類的方法能夠將4 種情緒比較明顯地分隔開。

4 基于小波包分解的特征提取

4.1 小波包分解

特征提取是情感識別的關鍵環節,本文采用小波包分析方法[17]分解出腦電信號的各個頻段,在不同頻段上分別對人的情感變化進行識別。小波包分析是小波分析的延伸,其基本思想是讓信息能量集中,在細節中尋找有序性,把其中的規律篩選出來,為信號提供一種更加精細的分析方法。在小波包分解的基礎上,探討腦電信號的頻段與情感的聯系,并選取優勢頻段,提取相應小波包系數的能量值作為模型的輸入特征。

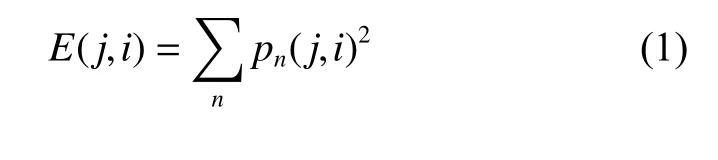

對DEAP 腦電數據采用db4 小波進行4 層分解。原始數據的采樣頻率為128 Hz,奈奎斯特頻率為64 Hz,則進行4 層分解時,共分為 24=16 個頻帶,每個頻帶的帶寬為64/16=4 Hz。選取每個頻帶節點利用 式(1)計算得到各個節點的能量值作為識別特征。

其中:E(j,i)表示在分解層次j上第i個節點的能量值;pn(j,i) 表示第j層第i個節點的n個小波包變換系數。每個樣本通過小波包4 層分解可以得到16 維特征,由于本文采取前32 個導聯的EEG 信號,因此最終得到的輸入序列特征維度為 1 6×32=512 。

4.2 基線(Baseline)處理

本文采用的每個視頻片段的基線長度為3 s。由于腦電信號的敏感性較強,因此正常生理活動下的腦電信號很容易對情緒變化時的腦電波造成影響。為了減小這個影響,需要對基線進行消除。通過小波包提取前3 s 數據即基線的特征,然后將后60 s數據的特征分別減去基線特征,以消除基線的影響。

5 基于Snapshot 集成的TCN 情感識別模型的構建

5.1 TCN 模型的架構

TCN 模型與普通CNN 模型的不同點主要在于該結構中的卷積是因果關系,任意一個時刻的狀態都考慮了之前的全部狀態。

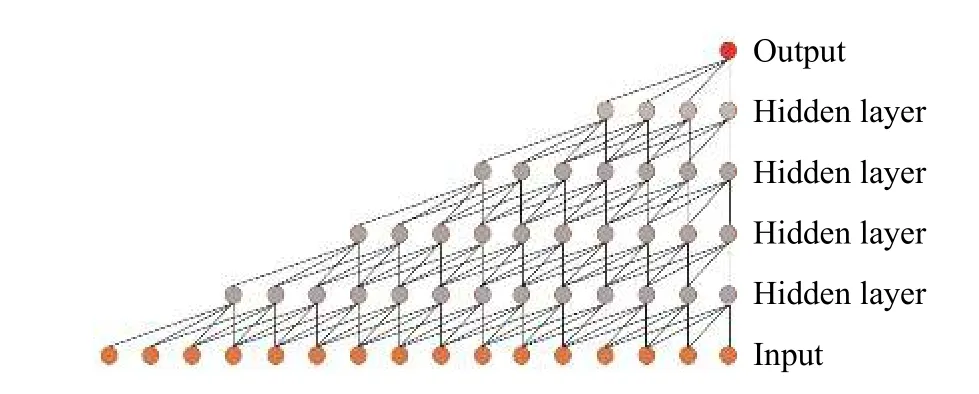

TCN 模型的結構如圖3 所示。該模型結構主要為時序卷積層和全連接層,其中M表示一維卷積核的數量,d表示每個卷積核的大小,T表示每秒鐘的序列長度,F表示輸入序列的特征維度,本文設F=32(導聯數) × 16(頻帶數)=512。輸入序列經過一維卷積核的作用得到T×M的時序特征序列,使用修整線性單元(Rectified Linear Unit, ReLU)作為激活函數應用于每一個元素。全連接層用于分類,使用softmax計算當前時刻屬于某一類別的概率。

圖3 TCN 結構圖Fig.3 TCN structure diagram

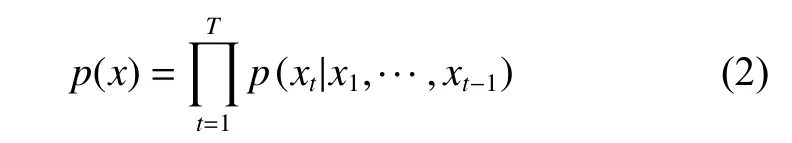

5.1.1 因果卷積(Casual convolution) 因果卷積首次在WaveNet[18]中提出,是用于處理序列問題而提出來的一種卷積模型。這種卷積模型在某時刻t的預測不能與任何未來時刻的信息相關,如式(2)所示:

其中:xt表示t時刻的信息。可以看出該時刻的狀態只與之前時刻的信息相關。因果卷積模型如圖4所示。

圖4 因果卷積模型Fig.4 Casual convolution model

可以看出使用因果卷積的每一個節點都只考慮在此之前的節點,可以很好地用來處理時間序列,但是如果需要考慮比較久遠的信息,那么卷積的層數就必須隨之增加,這樣就會導致深度學習中常見的梯度消失、訓練復雜、擬合效果差的問題,因此WaveNet 同時提出了擴張卷積(Dilated convolution)的概念。

圖5 一維擴張卷積Fig.5 One-dimensional expansion convolution model

本文的輸入數據是長度為16 的一維腦電序列X=[x1,x2,···,xi] ,設置步長s=1,卷積核fk=4,第k層的擴張率dk=3×4k?1。通過計算可以得到:當不使用擴張卷積時,若要使輸出考慮到該序列所有時刻狀態,需要4 層的隱藏層單元(如圖4 所示),而使用擴張卷積時只需要1 層的隱藏層單元(如圖5 所示)。5.1.3 殘差模塊(Residual block) 殘差模塊[19]是一種深度神經網絡,通過將前一層的信息跳層輸入下一層,使得后層的信息更加豐富,能夠很好地解決由于增加深度帶來的副作用(退化問題)。TCN 模型使用了殘差模塊。

5.2 Snapshot 快照集成

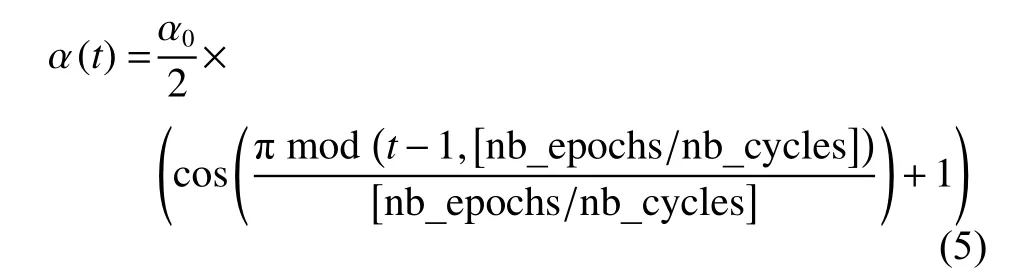

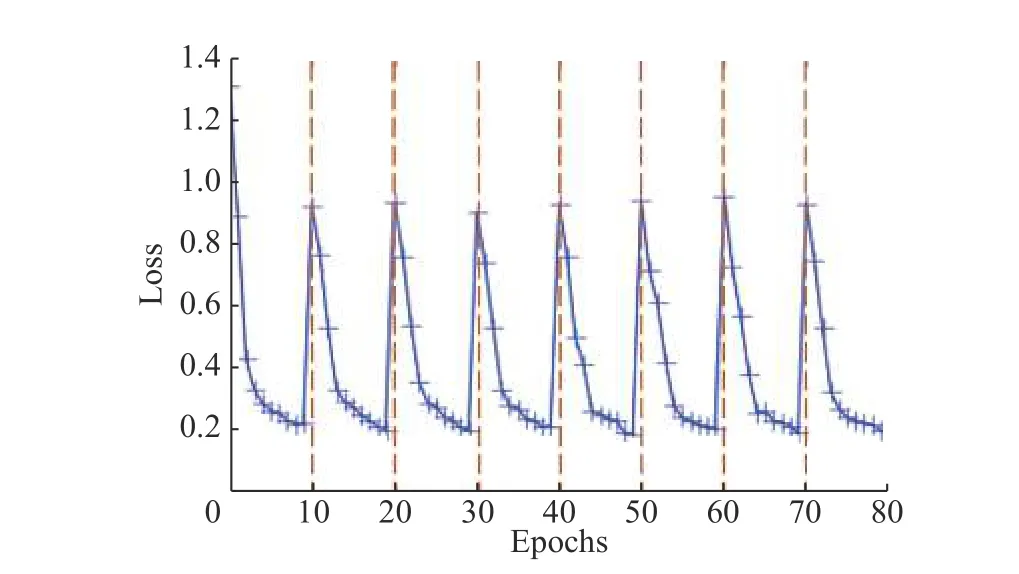

為了能夠更好地訓練TCN 模型,本文采用Snapshot 快照集成策略。該方法的原理是通過不斷重置學習率來逃避局部極點值。學習率的重置如式(5)所示:

其中: α (t) 表示第t次迭代的學習率; α0表示初始學習率;nb_epochs 表示訓練過程總的迭代次數;nb_cycles 表示循環次數,即學習率重置次數。

每次迭代結束時保存當前模型,然后重置學習率為初始學習率進行下一次迭代,如此反復多次,保存多個模型進行集成,如圖6 所示。圖中橫坐標為迭代次數,縱坐標為訓練過程的損失值。該訓練過程設置的迭代次數為80,循環次數為8,即每10 次迭代重置一次學習率。由圖6 可以看出,每次重置學習率都可以使訓練過程跳出當前極值,且都能得到不錯的收斂,保存訓練過程每次循環所產生的模型。

圖6 尋優過程圖Fig.6 Diagram of optimization process

5.3 投票集成策略

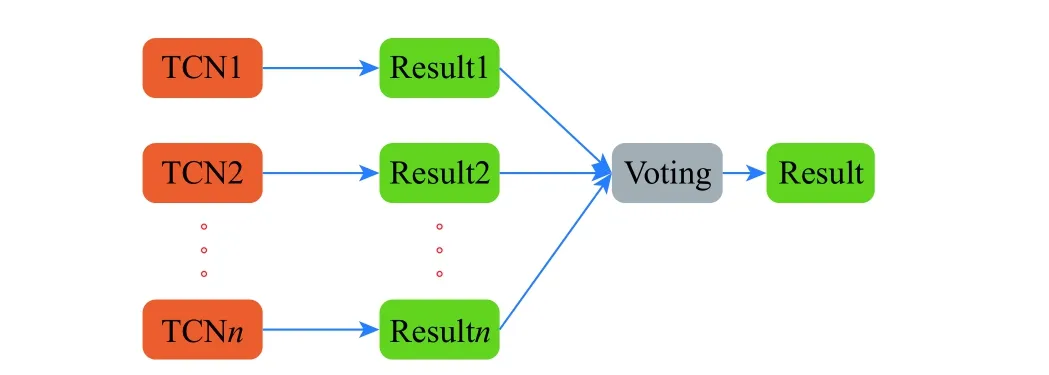

集成學習(Ensemble learning)通過構建并結合多個機器學習模型來完成學習任務,在分類任務中投票法(Voting)是最常用的集成方式。

在本文的模型尋優過程中,每一個局部極小值點的模型都進行了保存。由于這些模型之間存在差異性,因此采用投票集成的方法提高識別精度。如圖7 所示,通過Snapshot 方法訓練出來的n個TCN模型分別輸出各自的識別結果,如類別1、類別2,如果輸出類別1 的模型數量多于輸出類別2 的模型數量就采用類別1 作為最終識別結果,反之就采用類別2 作為最終結果。

圖7 投票集成過程Fig.7 Process of voting ensemble

6 實驗結果與分析

TCN 模型在Keras 框架下通過Python 編程實現。實驗環境Intel(R) Core(TM) I5-7700HQ CPU @2.80 Hz, 16 GB 內存,NVIDIA GeForce GTX 950 M 顯卡,64 位Windows10 系統。

6.1 不同頻段的情感識別

將每個受試者的數據分成5 份,每次取其中一份作為測試數據,其余作為訓練數據。取5 次交叉實驗的識別精度均值作為最終結果,并在訓練過程中再次將訓練數據隨機取出10%作為驗證集。

根據驗證集確定TCN 模型的部分參數,選擇時間窗為1 s,并將每段信號按順序每62.5 ms 進行一次特征提取,故每秒鐘的序列長度為16。此外,根據經驗將卷積核數量設為50,卷積核長度設為4,當損失函數連續10 次迭代都沒有發生優化時訓練終止。

腦電信號一般被分為5 個頻段,依次為Delta、Theta、Alpha、Beta 和Gamma,考慮到每個頻段可能對情緒狀態的敏感度不同,因此本文通過小波包分析提取出各個頻段,討論不同頻段對腦電情感的不同影響。

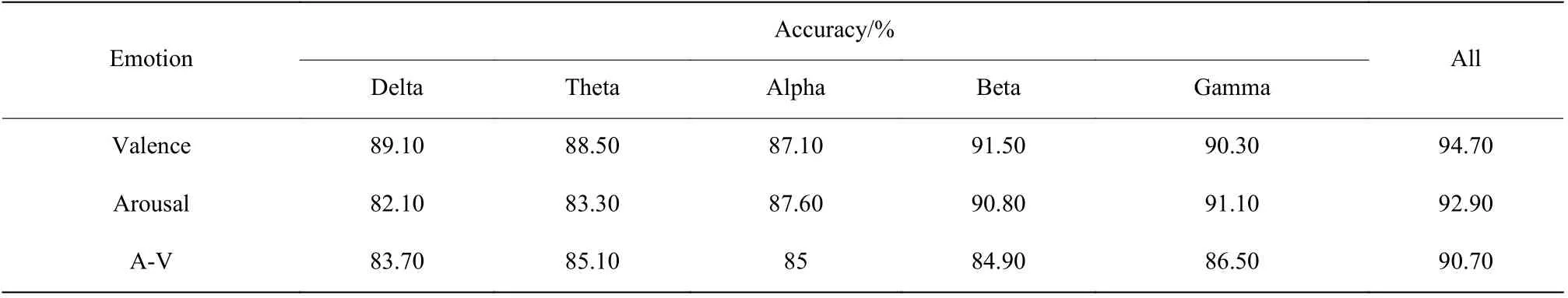

表1 示出了18 個受試者測試精度的平均值。可以看出對于Valence 和Arousal 二分類來說,Beta和Gamma 頻段相對于低頻段的信號來說對情緒的反應更加敏感,對于A-V 四分類來說Gamma 頻段更敏感,而當使用全部頻段信息時其識別精度最高。

6.2 不同算法的對比

由于支持向量機(SVM)是較為流行的非深度學習算法,而門控單元循環網絡(GRU)是比較具有代表性的深度時序模型,因此本文采用SVM 和GRU 模型與TCN 模型進行二分類和四分類的對比實驗。實驗結果表明,當懲罰因子C=2,核函數為線性核時,SVM模型驗證集分類效果較好。當時間窗設為1 s,隱層單元數為100 時,GRU 模型驗證集分類效果較好。

表1 各頻段信號的識別精度對比Table 1 Recognition accuracy of signals in each frequency band

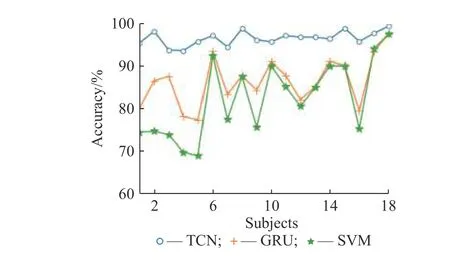

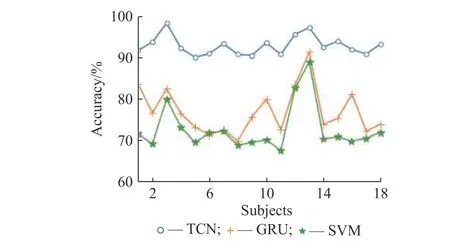

Valence 二分類和Arousal 二分類識別結果如圖8 和圖9 所示,圖中藍色、綠色和黃色折線分別表示TCN、SVM、GRU 模型在18 個受試者上的平均測試精度。可以看到TCN 模型的識別結果相對SVM 模型有明顯的提升,而GRU 模型對比SVM 模型也有一定的提升,但效果并不是特別明顯,說明序列模型更適合于腦電信號識別研究。對比GRU 模型,TCN 模型不僅在識別精度上有很大的提升,而且在時間復雜度上也具有比較大的優勢,其計算效率能夠達到GRU 模型的10~15 倍。

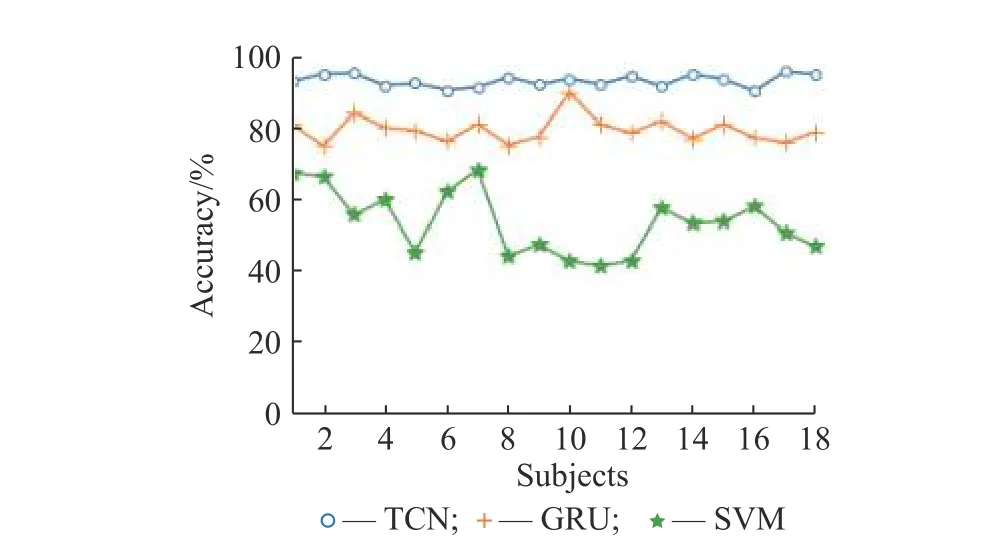

A-V 四分類識別結果如圖10 所示。可以看到在四分類問題中,SVM 模型的效果并不理想,GRU模型相對于SVM 模型有明顯的提高,而TCN模型相對于GRU 和SVM 模型都有比較大的提升。

圖8 Valence 二分類結果對比Fig.8 Comparison of valence two classification results

圖9 Arousal 二分類結果對比Fig.9 Comparison of arousal two classification results

圖10 A-V 四分類結果對比Fig.10 Comparison of A-V four classification results

6.3 Snapshot 尋優及集成策略

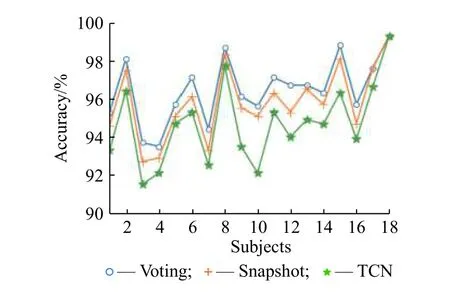

綜合考慮模型集成的效果和計算復雜度,選擇循環次數為8,即通過調整學習率得到8 個訓練模型,18 個受試者的測試結果如圖11 所示。圖中綠色折線表示不加任何集成策略的TCN 模型識別結果,黃色折線表示通過Snapshot 策略尋得的最優模型的識別結果,藍色折線表示將通過Snapshot 思想得到的各個模型進行集成得到的識別結果。可以看出Snapshot對識別精度有略微的提升,而投票集成方式的識別結果相對于Snapshot 尋得的最優模型也有一定的提高。

圖11 Valence 集成策略結果對比Fig.11 Comparison of valence ensemble strategy results

6.4 同類研究對比

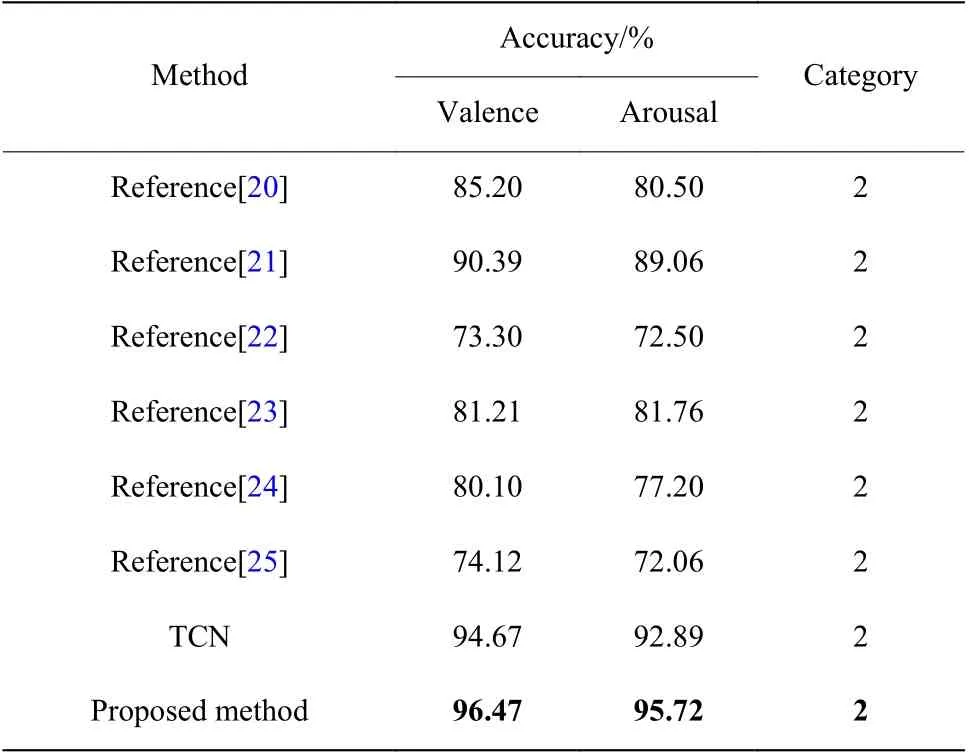

6.4.1 二分類研究對比 本文對比了其他采用DEAP數據集的情感識別研究,對比結果如表2 所示。文獻[20]通過自編碼機制,編碼階段將腦電數據與眼電數據分開建模,解碼階段再組合到一起,形成高階特征表示,使用SVM 作為分類器,最終對Valence 二分類達到了85.20%的識別精度,對Arousal 二分類達到了80.50%的識別精度;文獻[21]將使用殘差神經網絡(Residual Neural Network,ResNet)提取的特征融合線性頻率倒譜系數(Linear Frequency Cestrum Coefficient, LFCC)作為最終特征,使用KNN 作為分類器,最終對Valence 得到90.39%的精度均值,對Arousal 得到89.06%的精度均值;文獻[22]考慮了每個受試者對實驗音樂MV 的熟悉度,證明了熟悉度對分類結果的影響比較大,采用分形維度(FD)和功率譜密度(PSD)作為特征,采用決策樹對Valence 的平均準確率為73.30%,對Arousal 的平均準確率為72.50%;文獻[23]使用Relief 算法對32 個通道進行特征選擇,利用快速傅里葉變換(FFT)計算功率作為特征,使用概率神經網絡(Probabilistic Neural Networks,PNN)作為分類器對Valence 最終得到了81.21%的平均準確率,對Arousal 得到了81.76%的平均準確率;文獻[24]采用皮電、眼電等通道數據并為其單獨設計特征并且評估了個人因素對實驗的影響,提取PSD 特征,使用隨機森林算法,最終結果穩定在對Valence 的精度均值為80.10%,對Arousal 的精度均值為77.20%;文獻[25]通過小波變換提取特征,使用RNN 作為分類器,最后得到對Valence 的平均識別精度為74.12%,對Arousal的平均識別精度為72.06%。其中文獻[20,22,25]使用了非深度學習算法,文獻[21,23,24]應用了深度學習算法。

本文以5 作為閾值,在Valence 和Arousal 兩個維度上進行二分類,采用TCN 模型取得了最好的平均精度,并通過Snapshot 集成的思想對訓練過程進行優化,使得精度進一步提高,實驗結果驗證了本文方法的可行性。

表2 兩種情緒識別精度對比Table 2 Comparison of two emotion recognition accuracy

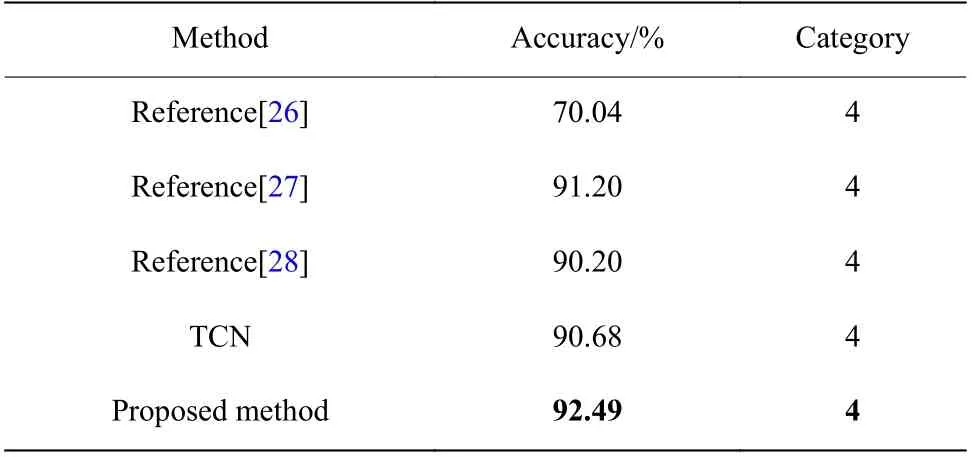

6.4.2 四分類研究對比 本文在4 種情緒的分類中也能夠取得比較明顯的效果,結果如表3 所示。文獻[26]去除了樣本間一致性差的視頻,共選取了17 個視頻作為實驗數據,將數據進行分段,求取每段的alpha 和beta 波段的能量、beta 和theta 波段的能量比率、3 個Hjorth 參數、C0 復雜度、方差和譜熵共計9 個特征,采用KNN 算法對4 類情緒得到了70.04%的識別精度;文獻[27]提出了一種針對腦電信號在HRI 領域中使用的實時情緒估計方法獲取與內在EEG 模式相關的有意義的特征,使用高斯過程分類器(Gaussian-Process Classifier,GPC)最終得到四分類的識別精度為91.20%;文獻[28]選取了所有通道中的15 個通道,采用小波變換的特征,通過SVM 和神經網絡對情感進行識別,通過SVM 得到了88.22%的識別精度,通過神經網絡得到了90.20%的識別精度。

表3 4 種情緒識別精度對比Table 3 Comparison of four emotion recognition accuracy

7 結 論

本文提出了一種基于時序卷積網絡的情感識別算法。該算法能夠適應腦電信號的時序特征,克服了傳統時序網絡的計算復雜度過大的缺點,既有RNN 的時序性又有CNN 的并行計算的特點。采用Snapshot 思想和集成思想對模型的訓練進行了進一步的提高。對比了不同波段對情感的敏感性,得出腦電信號各頻段間和情緒變化的關聯,并對比了同類研究結果。實驗結果表明本文方法在計算精度和算法復雜度上都有比較好的結果。