基于CycleGAN的圖像風(fēng)格遷移

馬赫 張濤 盧涵宇

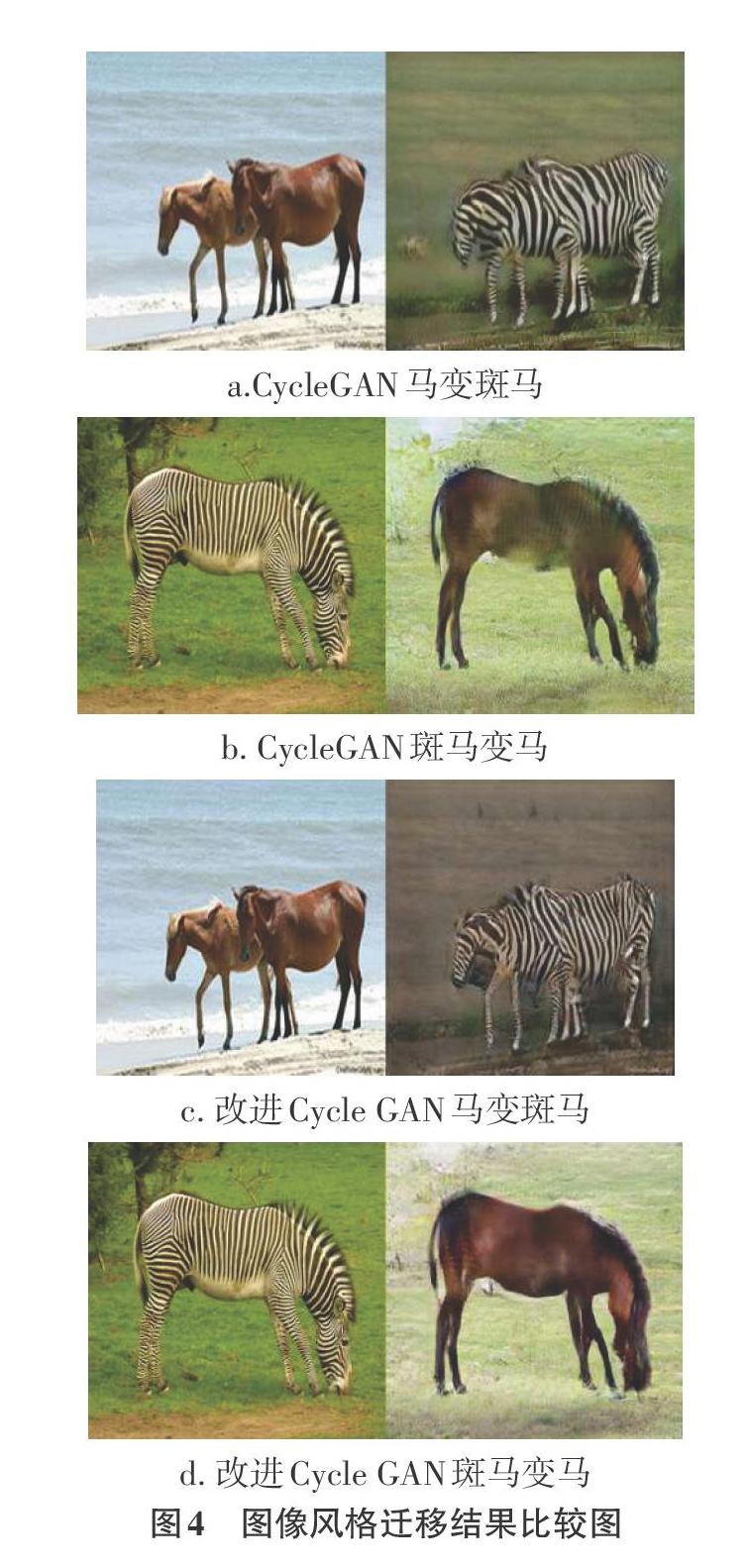

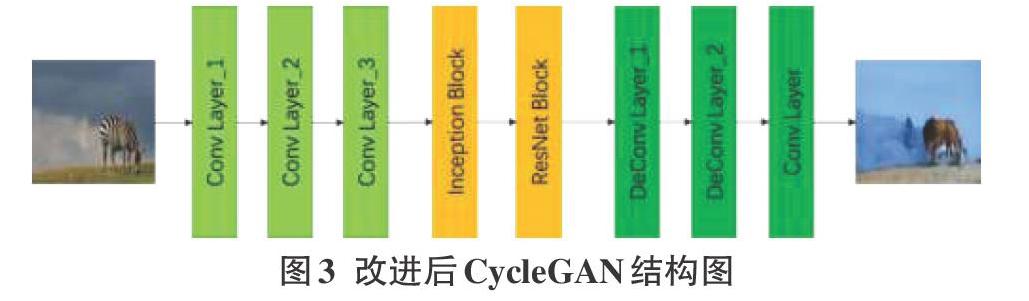

摘要:隨著深度學(xué)習(xí)的不斷發(fā)展與應(yīng)用,圖像到圖像的風(fēng)格遷移成了計算機視覺領(lǐng)域的研究熱點之一。該文運用Cycle-GAN網(wǎng)絡(luò)對圖像進行風(fēng)格遷移,能夠在無匹配的源圖像和風(fēng)格圖像的情況下進行。使得CycleGAN網(wǎng)絡(luò)中的生成器由編碼器、轉(zhuǎn)換器及解碼器組成,能起到保留原始圖像特征和轉(zhuǎn)換圖像數(shù)據(jù)的作用。該文嘗試通過Inception與ResNet進行結(jié)合,并與原CycleGAN網(wǎng)絡(luò)進行對比訓(xùn)練,結(jié)果表明,修改后的CycleGAN能夠比CycleGAN訓(xùn)練后得到更加逼真的圖像,具有更佳的視覺效果。

關(guān)鍵詞:CycleGAN;圖像風(fēng)格遷移;轉(zhuǎn)換器;ResNet模塊;深度學(xué)習(xí)

中圖分類號:TP183 文獻標(biāo)識碼:A

文章編號:1009-3044(2020)27-0018-03

開放科學(xué)(資源服務(wù))標(biāo)識碼(OSID):

隨著計算機技術(shù)和人工智能技術(shù)的發(fā)展,深度學(xué)習(xí)應(yīng)用越來越廣,其中計算機圖形學(xué)與深度學(xué)習(xí)的結(jié)合,產(chǎn)生了許多優(yōu)秀的算法,并在后來的圖像風(fēng)格遷移、圖像分割、自然語言生成等諸多領(lǐng)域得到廣泛應(yīng)用[1-4]。

隨著GAN網(wǎng)絡(luò)的應(yīng)用也產(chǎn)生了一系列如難以收斂、訓(xùn)練不穩(wěn)定、模型不可控等問題,促使了大量學(xué)者對該類問題的研究,如MARTIN等[5]針對GAN網(wǎng)絡(luò)訓(xùn)練不穩(wěn)定的問題,提出了WGAN(Wasserstein GAN),該方法使用Earth-Mover距離代替JS散度作為判別器D的目標(biāo)函數(shù),使得訓(xùn)練穩(wěn)定性得到有效提升。Zhu等[6]人為解決GAN網(wǎng)絡(luò)的一些限制,提出了循環(huán)一致性對抗網(wǎng)絡(luò)(CycleGAN)網(wǎng)絡(luò),該網(wǎng)絡(luò)能夠根據(jù)不成對的數(shù)據(jù)集訓(xùn)練出能夠滿足不同風(fēng)格的圖像的轉(zhuǎn)換;隨后,劉哲良等[7]針對采用CycleGAN網(wǎng)絡(luò)進行圖像風(fēng)格遷移中,表現(xiàn)出泛化能力差等問題,提出了一種FCN-CycleGAN的圖像風(fēng)格遷移方法,結(jié)論證明該方的網(wǎng)絡(luò)在穩(wěn)定性法具有較好的表現(xiàn)能力。……