基于紅外熱成像的夜間農田實時語義分割

易 詩,李俊杰,賈 勇

基于紅外熱成像的夜間農田實時語義分割

易 詩,李俊杰,賈 勇

(成都理工大學信息科學與技術學院(網絡安全學院、牛津布魯克斯學院),成都 610059)

農田環境實時語義分割是構成智能農機的視覺環境感知的重要環節,夜間農田語義分割可以使智能農機在夜間通過視覺感知農田環境進行全天候作業,而夜間無光環境下,可見光攝像頭成像效果較差,將造成語義分割精度的下降。為保證夜間農田環境下紅外圖像語義分割的精度與實時性,該研究提出了一種適用于紅外圖像的紅外實時雙邊語義分割網絡(Infrared Real-time Bilateral Semantic Segmentation Network,IR-BiSeNet),根據紅外圖像分辨率低,細節模糊的特點該網絡在實時雙邊語義分割網絡(Bilateral Semantic Segmentation Net,BiSeNet)結構基礎上進行改進,在其空間路徑上,進一步融合紅外圖像低層特征,在該網絡構架中的注意力提升模塊、特征融合模塊上使用全局最大池化層替換全局平均池化層以保留紅外圖像紋理細節信息。為驗證提出方法的有效性,通過在夜間使用紅外熱成像采集的農田數據集上進行試驗,數據集分割目標包括田地、行人、植物、障礙物、背景。經試驗驗證,提出方法在夜間農田紅外數據集上達到了85.1%的平均交并比(Mean Intersection over Union,MIoU),同時達到40幀/s的處理速度,滿足對夜間農田的實時語義分割。

智能農機;語義分割;紅外熱成像;紅外實時雙邊語義分割網絡;夜間農田數據集

0 引 言

對于智能農機的視覺導航與環境感知,語義分割能夠起到通過視覺圖像理解農機周圍環境的作用。然而在夜間或雨霧煙塵等成像條件惡劣的情況下,單一使用可見光圖像進行語義分割將導致智能農機視覺感知能力下降。紅外熱成像系統成像原理為物體的溫差,其不依賴光源,受天氣影響小,探測距離遠[1]。對夜間無光,存在雨霧等環境下成像更為清晰,穩定。使用紅外熱成像圖像進行農田環境實時語義分割可以協助智能農機在可見光成像條件不理想情況下感知所處的農田環境,使其在特定季節,特定環境進行全天候作業,提高農業生產效率與智能化程度。

目前實時語義分割技術主要用于自動駕駛領域,可以幫助自動駕駛汽車通過可見光視覺傳感器分割車道、車輛、人和其他感興趣目標或區域,以理解車輛所處環境。近年來應用于自動駕駛的語義分割方法在城市街道環境的可見光圖像上取得了良好的效果。Yang等[2]提出通過稠密金字塔特征提取結構(Dense Atrous Spatial Pyramid Pooling,DenseASPP)改進語義分割精度的語義分割網絡,通過金字塔特征提取結構優化了城市街景的語義分割精度,Chen等[3]提出通過編解碼網絡結構(Encoder-Decoder with Atrous Separable Convolution for Semantic Image Segmentation)提升語義分割精度網絡,通過編碼解碼結構進一步提升了自動駕駛環境下城市街景的語義分割精度,Wu等[4]提出的上下文柵格語義分割網絡(Context Grided Network,CGNet)使用輕量化構架與上下文聯合特征提高了街景語義分割的實時性,Li等[5]提出的基于輕量級主干網絡,多尺度特征提取的實時性語義分割網絡(Deep Feature Aggregation for real-time semantic segmentation Net,DFANet)分割城市道路街景,在各個公開城市道路街景上數據集上取得了語義分割精度與實時性的較好均衡。Yu等[6]提出的雙邊語義分割網絡(Bilateral Semantic segmentation Net,BiSeNet),該網絡采用空間路徑與上下文路徑雙邊結構,兼顧了語義分割精度與實時性,同時網絡結構簡單利于后期優化。

自動駕駛實時語義分割需要考慮夜間無光環境與雨霧等惡劣氣候條件下的成像系統,因此,運用紅外熱成像圖像進行夜間環境自動駕駛語義分割的研究工作近年來取得一定進展。王晨等[7]以深度卷積神經網絡為基礎,結合條件隨機場后處理優化模型,搭建端到端的紅外語義分割算法框架并進行訓練,對夜間街景紅外圖像進行語義分割能實現圖像的像素級分類,并獲得較高的預測精度。從而獲得紅外圖像中景物的形狀、種類、位置分布等信息,實現紅外場景的語義理解。吳駿逸等[8]針對夜間道路場景解析困難的問題,提出了一種聯合可見光與紅外熱像圖實現夜間場景語義分割的方法。對雙譜圖像進行自適應直方圖均衡及雙邊濾波,并利用基于雙譜圖像信息的稠密條件隨機場對語義分割結果進行優化,對夜間道路場景進行更準確的解析。

相對城市道路的自動駕駛語義分割技術,智能農機視覺感知中的語義分割技術發展較晚,且農田環境地形更為復雜,目前運用于農田環境中的實時語義分割處于起步階段,當前研究工作較少。李云伍等[9]研制了一種在丘陵山區田間道路上自主行駛的轉運車及其視覺導航系統。在其視覺導航模塊中,針對丘陵山區復雜的田間道路場景,提出了基于改進空洞卷積神經網絡的田間道路場景圖像語義分割模型,以有效地對丘陵地區田間地形進行分割。尚未出現使用紅外熱成像圖像的夜間農田環境實時語義分割技術方面研究,而使用紅外圖像對夜間農田復雜環境進行實時語義分割,將提高夜間智能農機的視覺感知能力與環境理解能力,有助于智能農機全天候智能化作業。使用紅外熱成像進行夜間田地環境實時語義分割主要涉及以下4個問題:1)農田環境的復雜性。2)紅外熱成像圖像分辨率低,細節特征模糊,缺乏色彩特征。3)語義分割網絡模型計算量大,難以達到實時性要求。4)缺乏公開夜間農田環境紅外數據集。為解決以上問題,本文使用戶外熱像儀采集制作適用于夜間農田環境視覺導航的紅外數據集,結合紅外熱成像夜間對田地環境的成像與基于深度學習的實時語義分割提出了一種夜間農田實時語義分割方法。針對紅外圖像分辨率低,細節特征模糊,缺乏色彩特征特點[10]以及智能農機視覺導航的實時性要求,在雙邊語義分割網絡結構基礎上改進提出適用于紅外圖像的紅外實時雙邊語義分割網絡(Infrared Real-time Bilateral Semantic segmentation Net,IR-BiSeNet)。該網絡根據紅外圖像特點進行改進,改進方法包括:1)根據參考文獻[11]中提到的全局最大池化層相對全局平均池化層更能有效保留圖像紋理信息,因此在網絡的注意力提升模塊,特征融合模塊上使用全局最大池化層替換全局平均池化層以保留紅外圖像紋理細節信息。2)在獲取空間信息路徑上進一步融合紅外圖像低層特征。

1 材料與方法

1.1 數據獲取

為進行夜間農田實時語義分割,需要大量夜間環境下農田紅外熱成像圖像建立數據集,而目前無公開的夜間農田環境紅外熱成像數據集,本文使用與智能農機相類似的采集平臺,即搭載于車輛前端的云臺+紅外熱成像儀進行夜間環境農田的紅外數據采集。通過該采集平臺獲取夜間農田紅外數據集包括各種夜間復雜農田環境的紅外圖像。為采集建立適用于智能農機夜間視覺導航中語義分割的紅外數據集,使用該平臺在2019年秋季夜間野外進行實地采集,采集地點為中國四川省農業大縣梓潼縣,鹽亭縣,劍閣縣以上區域的地形主要為丘陵山地農田,具有中國西南地區丘陵地形農田環境地形起伏,田間障礙物較多,植被種類較繁雜的典型性。

實地采集的農田環境紅外數據集包括60余個夜間農田典型場景下的9 000張實拍紅外熱成像圖像。為降低對計算機顯存的需求,將采集到的圖像像素全部縮放為512像素×512像素。

1.2 數據處理

為保證網絡模型訓練的魯棒性與泛化性,需通過數據集增廣方法獲取更大量的數據集。紅外數據集的增廣根據文獻[12]方法,將采集數據集進行水平、垂直方向上的反轉以及38°~56°的隨機旋轉處理,數據集增廣方法如圖1所示,采用這3種方式,每種方式可擴充2倍的數據量,對每個圖像樣本隨機采用上述一種增廣方式,由此將數據擴充為原始數據集的2倍。按7.5∶1.5∶1比例劃分訓練集、驗證集與測試集。其中驗證集與測試集使用原始圖像。

圖1 紅外數據集增廣方法

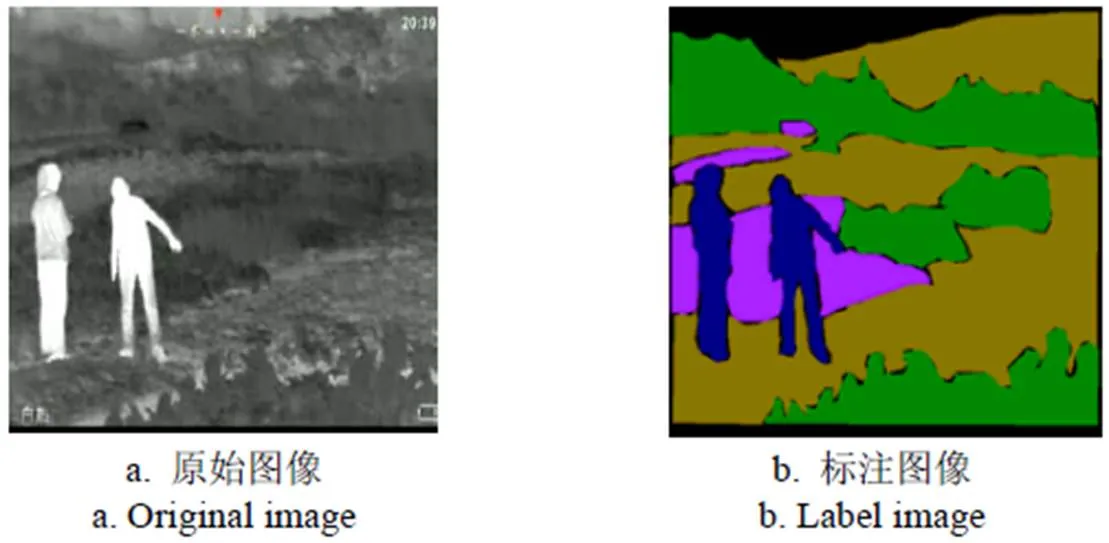

1.3 數據標注

根據智能農機視覺導航中主要需要分割目標,將數據集中夜間田間對象的分割類別分為:行人、植被、障礙物、田地、背景5個類別。在圖像縮放后使用Labelme工具[13]進行手工標注。語義分割任務在標注分割類別時,要求對需要分割的每個類別賦予不同顏色掩膜標簽(Mask),因此每種類別掩膜標簽對應不同標注色的RGB值對應的標注色如表1所示,類別標注圖像如圖2所示。

表1 各類別對應標注色

圖2 類別標注圖像

1.4 農田紅外圖像語義分割方法

本研究提出適用于紅外圖像的紅外實時雙邊語義分割網絡(IR-BiSeNet),該網絡根據紅外圖像分辨率低,細節模糊的特點在實時雙邊語義分割網絡(BiSeNet)結構基礎上進行改進,使其適用于夜間農田環境下紅外圖像的語義分割。

1.4.1 實時雙邊語義分割網絡結構

實時雙邊語義分割網絡(BiSeNet)結構如圖3所示,為保證不犧牲空間信息的前提下實現快速的實時分割,實時雙邊語義分割網絡(BiSeNet)結構劃分為2個分支:空間路徑(Spatial Path,SP)與上下文路徑(Context Path,CP)。

注:7×7、3×3、1×1代表為卷積核大小。下同。

SP結構用于提取高分辨率特征圖,獲取精確的空間信息。CP結構用于獲得大的感受野,為保證實時性,減少計算量,采用輕量特征提取網絡,如淺層殘差網絡(Residual Network-50,ResNet-50),結合全局池化操作,合并ResNet-50的中間結果(16倍下采樣、32倍下采樣)與全局池化的輸出,作為該部分輸出。

BiSeNet在上下文路徑中使用注意力提升模塊(Attention refinement model,Arm)以提高精度,注意力提升模型結構如圖3所示,其首先使用全局平均池化獲取注意力向量,對該向量進行1×1卷積操作、歸一化和非線性操作,并將該輸出與原特征圖相乘。對ResNet-50不同層特征進行提升,且并未增加過多參數與計算量。

BiSeNet使用特征融合模塊(Feature fusion module,Ffm)以結合SP與CP輸出的特征。特征融合模塊結構如圖3所示,該模塊首先將2個路徑輸出進行連接,并將連接的特征進行3×3卷積、批歸一化、線性整流操作,將該輸出全局平均池化獲取特征向量,經過1×1卷積、線性整流函數、S型函數。計算連接特征,如式(1)所示

式中為3×3卷積+批歸一化+線性整流輸出,為S型函數非線性輸出,得到FFM的輸出特征。

1.4.2 紅外實時雙邊語義分割網絡結構

在實時雙邊語義分割網絡結構基礎上,本文針對夜間農田紅外圖像語義分割提出紅外實時雙邊語義分割網絡結構(IR-BiSeNet)。

在實時雙邊語義分割網絡空間路徑上,根據參考文獻[14]處理紅外圖像的思路,提出了一種通過增加池化層,反卷積層,全連接層的方式融合紅外圖像低層特征,從而使網絡能更好恢復紅外圖像空間分辨率,提供更大的感受視野。紅外實時雙邊語義分割網絡結構如圖4所示。對實時雙邊語義分割網絡上下文路徑中的注意提升模型以及融合兩路特征的特征融合模塊,根據紅外圖像細節模糊、對比度低的特點,在模塊網絡構架的每個池化層部分使用全局最大池化層替換全局平均池化層以保留紅外圖像紋理細節信息。

考慮到紅外圖像特點以及系統實時性,上下文路徑采用ResNet-50特征提取網絡,結合全局池化操作,合并ResNet-50中間結果(16倍下采樣、32倍下采樣)與全局池化的輸出。

紅外實時雙邊語義分割網絡在上下文路徑中為提高精度所使用的紅外注意力提升模塊(IR-Attention refinement model,IR-Arm)如圖4所示。

紅外實時雙邊語義分割網絡融合空間路徑與上下文路徑輸出的特征所使用的紅外特征融合模塊(IR-Feature fusion module,IR-Ffm)如圖4所示。

1.4.3 紅外實時雙邊語義分割網絡損失函數

本文提出的紅外實時雙邊語義分割網絡使用主損失函數監督整個網絡的輸出,此外采用附加損失函數監督上下文路徑輸出[15-17]。

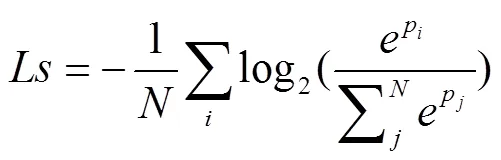

主損失函數采用Softmax損失函數,如式(2)所示

式中N為需要預測的類別總數,pi為樣本i的網絡預測輸出,pj為樣本j的網絡預測輸出。

監督上下文路徑輸出的輔助損失函數,如式(3)所示

式中l是全連接層的輸出損失函數,l為第階段的輔助損失函數其輸入為X,X為ResNet-50網絡第階段特征值。為聯合損失函數[18-21]。

1.5 性能評價指標

為驗證本文提出方法對夜間農田紅外圖像分割的有效性,設圖像中分割類別為1,p為本屬于類但被預測為類的像素數量,p為本屬于類但被預測為類的像素數量,p為真實像素數量,采用評價實時語義分割的指標如下:

1)平均交并比(Mean Intersection over Union,MIoU),即預測區域和實際區域交集除以預測區域和實際區域的并集[22-23],計算如式(4)所示

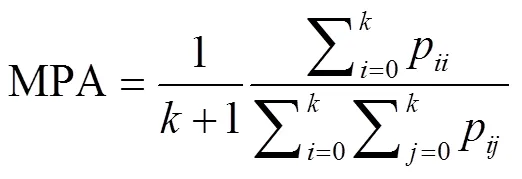

2)像素精度(Pixel Accuracy,PA),標注正確的像素占總像素的比例[24],計算如式(5)

3)平均像素精度(Mean Pixel Accuracy,MPA),所有類的平均像素精度[24-26],計算如式(6)

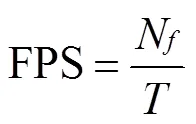

4)幀率(Frames Per Second,FPS),衡量語義分割算法實時性。計算如式(7)

式中N為視頻幀數,為消耗時間,s。

2 結果與分析

2.1 模型訓練

本文提出的紅外實時雙邊語義分割網絡(IR BiSeNet)在Win10+tensorflow1.9.0+CUDA9.2+VS2017+ opencv4.0/Core i7-8750H 2.2Ghz處理器+16GB內存+Geforce GTX 1080 8GB顯卡軟/硬件平臺上使用相同夜間農田語義分割紅外數據集進行訓練,采用ResNet-50預訓練模型初始化部分參數,RMSprop優化器優化所有參數,設置學習率為0.000 1,衰減率為0.995。隨機初始化深度網絡各層參數。訓練批次設置為200,一次訓練所選取的樣本數設置為5[27-30],在120批次(120 epochs)訓練后生成最佳語義分割模型。

2.2 方法對比

為驗證本文提出方法對夜間農田紅外圖像分割的優勢,將本文提出方法與現行5種可見光環境下代表性語義分割框架(BiSeNet、DenseASPP、DeeplabV3+、DFANet、CGNet)在同一數據集下,采用相同的訓練參數進行訓練,所生成的模型進行對比測試。

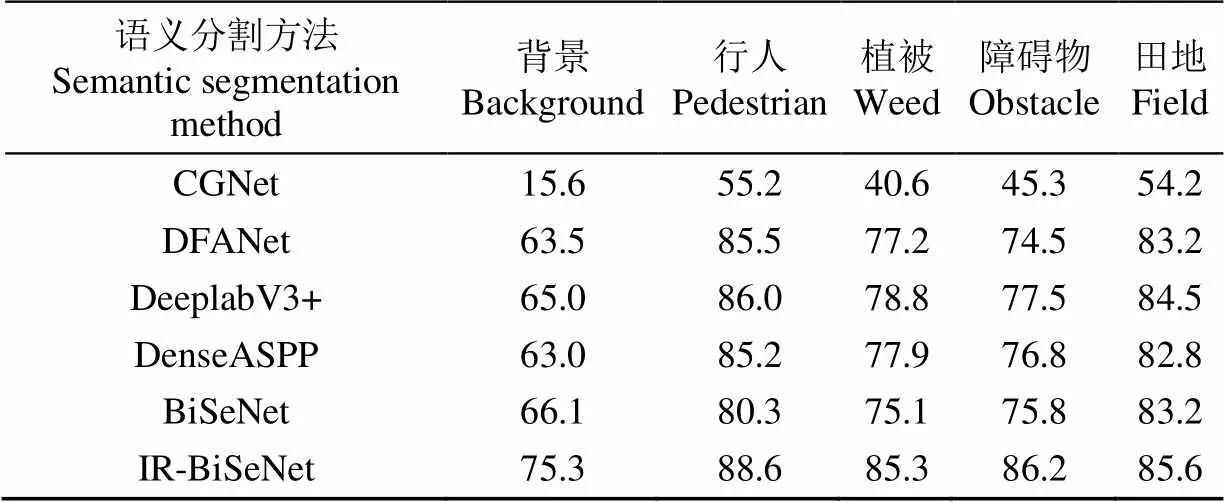

對于每一類需要分割的目標交并比(IoU),IR-BiSeNet相對其他5種方法在測試集上測試結果統計如表2所示。

由每一類別需分割目標交并比測試結果可知,IR- BiSeNet相對其他5種方法,對5類夜間農田環境需分割的目標上均取得最高的交并比,對背景、行人、植被、障礙物、農田的語義分割分別達到75.3%、88.6%、.3%、86.2%、85.6%的交并比。因此,本文提出的紅外實時雙邊語義分割網絡對夜間農田紅外圖像中各類目標的語義分割精度上具有優勢。

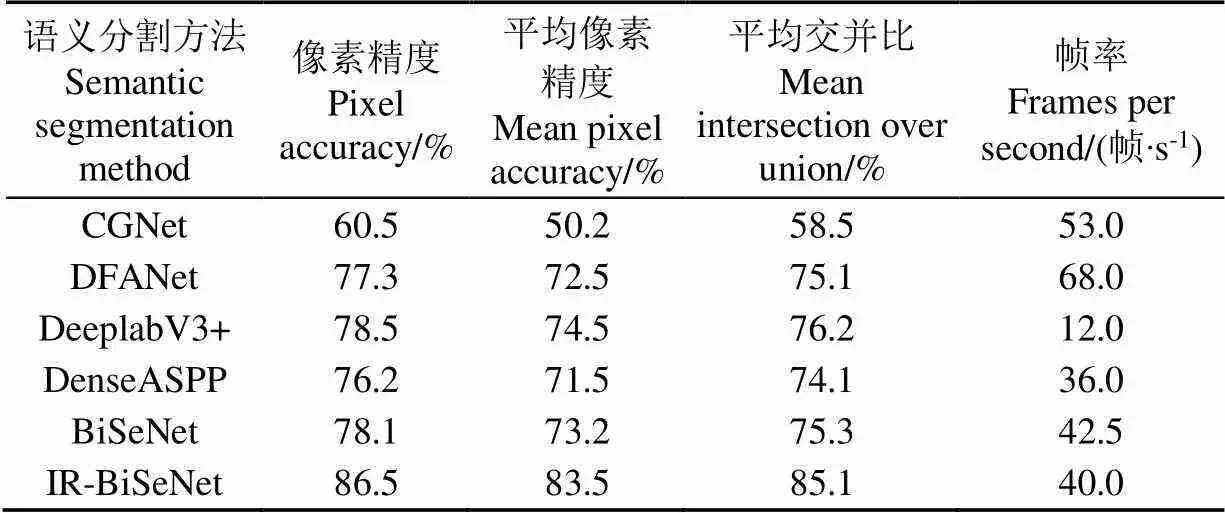

綜合測試環節,使用測試集中實拍的夜間農田紅外圖像進行對比測試,從像素精度(PA)、平均像素精度(MPA)、平均交并比(MIoU)、幀率(FPS)進行對比。本文提出方法相對其他5種方法的對比測試結果如表3所示。

表2 不同方法下不同類別的目標交并比(IoU)對比

注:CGNet為上下文柵格語義分割網絡;DFANet為多尺度特征提取的實時性語義分割網絡;DeeplabV3+為編解碼金字塔結構網絡語義分割網絡;DenseASPP為稠密金字塔特征語義分割網絡;BiSeNet為雙邊語義分割網絡;IR-BiSeNet為紅外實時雙邊語義分割網絡。

Note: CGNet: Context Grided Network; DFANet: Deep Feature Aggregation for real-time semantic segmentation Net; DeeplabV3+: Encoder-Decoder with Atrous Separable Convolution for Semantic Image Segmentation ; DenseASPP: Dense Atrous Spatial Pyramid Pooling; BiSeNet: Bilateral Semantic Segmentation Net; IR-BiSeNet: Infrared Real-time Bilateral Semantic Segmentation Network.

由表3的對比測試指標分析可以看出,在實時性方面,本文提出的IR-BiSeNet網絡與DenseASPP網絡和 DeeplabV3+網絡相比,幀率(FPS)分別提高4和28幀/s。由于加深了網絡深度,低于改進前BiSeNet網絡2.5幀/s,同時低于對實時性特別優化的DFANet網絡,CGNet網絡28和13幀/s,文獻[4-6]中提出,幀率達25幀/s以上即可認定算法具備實時性,因此本文提出方法可滿足語義分割的實時性要求。但在夜間農田語義分割精度方面,本文提出的IR-BiSeNet網絡在像素精度(PA),平均像素精度(MPA),平均交并比(MIoU)3項指標上與其他5種語義分割方法對比具有明顯優勢,例如與BiSeNet 網絡相比,本文提出方法在像素精度上提高了 8.4個百分點,在平均像素精度上提高了10.3個百分點,在平均交并比上提高了9.8個百分點。

表3 不同方法性能指標對比

IR-BiSeNet保留紅外圖像紋理特征方面做了優化,能夠保留更多夜間農田紅外圖像語義分割細節。與其他5種方法對測試集中夜間農田環境紅外圖像分割結果對比如圖5所示,由圖5可以看出對于夜間農田環境的各類分割目標細節分割效果,IR-BiSeNet分割結果相對其他方法分割效果更好,更接近于真實標注圖像。

圖5 不同語義分割方法效果對比

3 結 論

針對智能農機夜間視覺導航與視覺感知,本文提出了一種基于紅外熱成像的夜間農田實時語義分割網絡(IR-BiSeNet),該網絡在實時雙邊語義分割網絡(BiSeNet)結構基礎上,在其空間信息路徑上進一步融合紅外圖像低層特征,在其注意提升模型、特征融合模塊上使用全局最大池化層替換全局平均池化層。采集制作了夜間農田紅外數據集,在該數據集上,本文方法達到了85.1%的平均交并比(MIoU),同時達到40幀/s的處理速度,滿足對夜間農田的實時語義分割。在未來工作中,將采用更高效的語義分割網絡針對紅外圖像特點進行改進,同時擴充夜間農田紅外數據集,以達到更好的實時語義分割效果。

[1]崔美玉. 論紅外熱像儀的應用領域及技術特點[J]. 中國安防,2014(12):90-93. Cui Meiyu. On the application field and technical characteristics of infrared thermal imager[J]. China Security, 2014(12): 90-93. (in Chinese with English abstract)

[2]Yang Maoke, Yu Kun, Chi Zhang, et al. DenseASPP for semantic segmentation in street scenes[C]. IEEE Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE, 2018: 3684-3692.

[3]Chen L C, Papandreou G, Schro F, et al. Rethinking atrous convolution for semantic image segmentation[C].IEEE Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE, 2018.

[4]Wu Tianyi, Tang Sheng. CGNet: A Light-weight context guided network for semantic segmentation[C].IEEE Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE, 2018.

[5]Li Hanchao, Xiong Pengfei, Fan Haoqiang, et al. DFANet: Deep feature aggregation for real-time semantic segmentation[C].IEEE Conference on Computer Vision and Pattern Recognition. Long Beach: IEEE, 2019.

[6]Yu Changqian, Wang Jingbo, Peng Chao, et al. BiSeNet: bilateral segmentation network for real-time semantic segmentation[C]. IEEE Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE, 2018.

[7]王晨,湯心溢. 基于深度卷積神經網絡的紅外場景理解算法[J]. 紅外技術,2019,39(8):728-733. Wang Chen, Tang Xinyi. Infrared scene understanding algorithm based on deep convolutional neural network[J]. Infrared Technology, 2019, 39(8): 728-733. (in Chinese with English abstract)

[8]吳駿逸,谷小婧,顧幸生. 基于可見光/紅外圖像的夜間道路場景語義分割[J]. 華 東 理 工 大 學 學 報:自然科學版,2019,45(2):301-309. Wu Junyi, Gu Xiaojing, Gu Xingsheng. Night road scene semantic segmentation based on visible and infrared thermal images[J]. Journal of East China University of Science and Technology: Natural Science Edition, 2019, 45(2): 301-309(in Chinese with English abstract)

[9]李云伍,徐俊杰,劉得雄,等. 基于改進空洞卷積神經網絡的丘陵山區田間道路場景識別[J]. 農業工程學報,2019,35(7):150-159. Li Yunwu, Xu Junjie, Liu Dexiong, et al. Field road scene recognition in hilly regions based on improved dilated convolutional networks[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2019, 35(7): 150-159. (in Chinese with English abstract)

[10]易詩,李欣榮,吳志娟,等. 基于紅外熱成像與改進YOLOV3的夜間野兔監測方法[J]. 農業工程學報,2019,35(19):223-229. Yi Shi, Li Xinrong, Wu Zhijuan, et al. Night hare detection method based on infrared thermal imaging and improved YOLOV3[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2019, 35(19): 223-229. (in Chinese with English abstract)

[11]昌杰. 基于深度神經網絡的腫瘤圖像分析與處理[D]. 合肥:中國科學技術大學,2019. Chang Jie. Tumor Image Analysis and Processing Based on Deep Neural Network[D]. Hefei: University of Science and Technology of China, 2019. (in Chinese with English abstract)

[12]Li Xiangyuan, Cheng Cai, Zhang Ruifei, et al. Deep cascaded convolutional models for cattle pose estimation[J]. Computers and Electronics in Agriculture. 2019, 164: 104885.

[13]Russell B C, Torralba A, Murphy K P, et al. LabelMe: Adatabase and web-based tool for image annotation[J]. International Journal of Computer Vision, 2008, 77(1-3): 157-173.

[14]He Zewei, Cao Yanpeng, Dong Yafei et al. Single-image-based nonuniformity correction of uncooled long-wave infrared detectors: A deep-learning approach[J]. Applied Optics. 2018, 57(18):155-164.

[15]Amorim W P , Tetila E C , Pistori H , et al. Semi-supervised learning with convolutional neural networks for UAV imagesautomatic recognition[J]. Computers and Electronics in Agriculture. 2019, 164: 104932.

[16]Barth R , Ijsselmuiden J , Hemming J , et al. Synthetic bootstrapping of convolutional neural networks for semantic plant part segmentation[J]. Computersand Electronics in Agriculture. 2019, 161: 291–304.

[17]Axel-Christian G , Moulay A. Deep learning enhancement of infrared face images using generative adversarial networks[J]. Applied Optics, 2018, 57(18):98-105.

[18]Satoru K, Adam M, Abhijit M, et al. Three-dimensional integral imaging and object detection using long-wave infrared imaging[J]. Applied Optics, 2017, 56(9): 120-126.

[19]Kuang Xiaodong, Sui Xiubao, Liu Yuan, et al. Single infrared image enhancement using a deep convolutional neural network[J]. Neurocomputing, 2019, 332: 119-128.

[20]李云伍,徐俊杰,王銘楓,等. 丘陵山區田間道路自主行駛轉運車及其視覺導航系統研制[J]. 農業工程學報,2019,35(1):52-61. Li Yunwu, Xu Junjie, Wang Mingfeng, et al. Development of autonomous driving transfer trolley on field roads and its visual navigation system for hilly areas[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2019, 35(1): 52-61. (in Chinese with English abstract)

[21]Liu Zihao, Jia Xiaojun, Xu Xinsheng. Study of shrimp recognition methods using smart networks[J]. Computers and Electronics in Agriculture, 2019, 165: 104926.

[22] Tian Mengxiao, Guo Hao, Chen Hong, et al. Automated pig counting using deep learning[J]. Computers and Electronics in Agriculture., 2019, https: //doi. org/10. 1016/j. compag. 2019. 05. 049.

[23]孫哲,張春龍,葛魯鎮,等. 基于 Faster R-CNN 的田間西蘭花幼苗圖像檢測方法[J]. 農業機械學報,2019,50(7):216-221. Sun Zhe, Zhang Chunlong, Ge Luzhen, et al. Image detection method for broccoli seedlings in the field based on Faster R-CNN[J]. Transactions of the Chinese Society for Agricultural Machinery, 2019, 50(7): 216-221. (in Chinese with English abstract)

[24]Zhang Shanwen, Zhang Subing, Zhang Chuanlei, et al. Cucumber leaf disease identification with global pooling dilated convolutional neural network[J]. Computers and Electronics in Agriculture, 2019, 162: 422-430.

[25]Kounalakisa T, Triantafyllidisb G A, Nalpantidis L. Deep learning-based visual recognition of rumex for robotic precision farming[J]. Computers and Electronics in Agriculture, 2019, 165: 104973.

[26]Kapoor A J, Fan H, Sardar M S. Intelligent detection using convolutional neural network (ID-CNN)[C]. IOP Conference Series: Earth and Environmental Science, Hubei: IOP Publishing, 2019.

[27]Li X, Orchard M T. New edge-directed interpolation[J]. IEEE Transactions on Image Processing, 2001, 10(10): 1521-1527.

[28]Yu Yang, Zhang Kailiang, Yang Li, et al. Fruit detection for strawberry harvesting robot in non-structural environment based on Mask-RCNN[J]. Computers and Electronics in Agriculture, 2019, 163: 104846.

[29]Ye Xujun, Sakai K, Manago M, et al. Prediction of citrus yield from airborne hyperspectral imagery[J]. Precision Agriculture, 2007, 8(3): 111-125.

[30]Lin Tsung Yi, Maire M, Belongie S, et al. Microsoft COCO: Common objects in context[C]. Proceedings of the 13thEuropean Conference on Computer Vision, New York, USA: Springer, 2014: 740-755.

Real-time semantic segmentation of farmland at night using infrared thermal imaging

Yi Shi, Li Junjie, Jia Yong

((,),,610059,)

In intelligent agricultural machinery, automatic navigation, and visual perception technology have been developed rapidly in recent years, and they also play a vital role in intelligent modern agriculture. Therefore, real-time semantic segmentation of farmland environment become an important part of visual environment perception in the intelligent agricultural machinery. The visible light sensing equipment is mainly used for image collection. However, particularly in the dark environment at night, the deficient imaging effect of visible light cameras can result in a decrease in the accuracy of semantic segmentation. Infrared thermal imaging can offer an alternatively way in this case, due to this technology uses the temperature difference of the object for imaging, rather than the light source. Therefore, the infrared thermal imaging can be used to clearly capture the image in the dark night, rain, mist, smoke, and other visible light sensing equipment that is not suitable. In this study, a method for real-time semantic segmentation of infrared images of farmland environment at night was proposed using the infrared thermal imaging system. An infrared real-time bilateral semantic segmentation network (IR-BiSeNet) was also addressed suitable for infrared images, in order to ensure the accuracy and real-time performance of infrared image semantic segmentation in the farmland environment at night. According to the characteristics of low resolution and fuzzy details of infrared images, the network was improved based on the BiSeNet structure, and the low-level features of infrared images were further integrated in its spatial path. In the network, the global maximum pooling layer was used to replace the global average pooling layer in the attention enhancement and the feature fusion module, in order to preserve the texture details of infrared image. The infrared farmland data was collected by the infrared thermal imaging to create a dataset at night, thereby to train a semantic segmentation model suitable for the farmland environment in this case. The segmentation targets of dataset included the fields, pedestrians, plants, obstacles, backgrounds, using the data augmentation to produce the dataset of infrared night farmland. Five representative semantic segmentation methods were selected to verify the proposed method, including BiSeNet、DenseASPP、DeeplabV3+、DFANet, and CGNet. Experimental results showed that the proposed method can achieved the mean intersection over union of 85.1%, and the processing speed of 40 frames/s. The method proposed in this study can be used the infrared thermal imaging to perform real-time farmland environment semantic segmentation at night, which can greatly improve the visual perception of intelligent agricultural machinery at night.

intelligent agricultural machinery; semantic segmentation; infrared thermal imaging; infrared real-time bilateral semantic segmentation net; farmland dataset at night

易詩,李俊杰,賈勇. 基于紅外熱成像的夜間農田實時語義分割[J]. 農業工程學報,2020,36(18):174-180.doi:10.11975/j.issn.1002-6819.2020.18.021 http://www.tcsae.org

Yi Shi, Li Junjie, Jia Yong. Real-time semantic segmentation of farmland at night using infrared thermal imaging[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2020, 36(18): 174-180. (in Chinese with English abstract) doi:10.11975/j.issn.1002-6819.2020.18.021 http://www.tcsae.org

2020-04-27

2020-07-29

國家自然科學基金項目(61771096);國家大學生創新創業項目(201910616129)

易詩,高級實驗師,主要從事人工智能,紅外圖像處理研究。Email:549745481@qq.com

10.11975/j.issn.1002-6819.2020.18.021

TN919.5

A

1002-6819(2020)-18-0174-07