毫米波網(wǎng)絡(luò)中基于Q-Learning的阻塞感知功率分配

施 釗,孫長(zhǎng)印,江 帆

(西安郵電大學(xué) 通信與信息工程學(xué)院,西安 710121)

0 概述

在移動(dòng)通信領(lǐng)域,頻譜資源是承載無(wú)線業(yè)務(wù)的基礎(chǔ),是推動(dòng)產(chǎn)業(yè)發(fā)展的核心資源。目前低于6 GHz的頻譜幾乎已經(jīng)被分配殆盡,而6 GHz以上的頻譜資源非常豐富,由于其業(yè)務(wù)劃分與使用相對(duì)簡(jiǎn)單,能夠提供連續(xù)的大帶寬頻帶,因此已成為一種具有前景的替代方案[1]。其中,高頻段的毫米波(millimeter-Wave,mm-Wave)通信更被認(rèn)為是一種有效解決無(wú)線電頻譜稀缺問(wèn)題的方法,將會(huì)為未來(lái)無(wú)線蜂窩網(wǎng)絡(luò)提供顯著的容量增益[2-4]。

目前,毫米波頻段將用于5G移動(dòng)通信網(wǎng)絡(luò)已成為全球共識(shí)。在毫米波頻率下可提供的大帶寬有可能將網(wǎng)絡(luò)吞吐量提高10倍[3]。但是其面臨的信號(hào)衰耗大、覆蓋距離短和通信鏈路對(duì)阻塞敏感等問(wèn)題也不可忽視[5]。克服這些問(wèn)題的一種有效方法是增加接入點(diǎn)的密度[6-7],但是隨著接入點(diǎn)密度的增加,當(dāng)所有毫米波基站重用相同的時(shí)頻資源時(shí),小區(qū)間干擾會(huì)越來(lái)越嚴(yán)重,網(wǎng)絡(luò)管理的復(fù)雜度也越來(lái)越高[8-9],這將極大地限制毫米波小區(qū)的系統(tǒng)容量。對(duì)于毫米波信號(hào)衰耗大、覆蓋距離短的問(wèn)題,可以通過(guò)波束成形技術(shù)進(jìn)行最優(yōu)波束對(duì)準(zhǔn),提高系統(tǒng)和速率。對(duì)于毫米波通信鏈路高阻塞問(wèn)題,現(xiàn)場(chǎng)測(cè)量結(jié)果[3]表明,由于各種因素(如基站與其服務(wù)用戶之間的距離遠(yuǎn)近、不同障礙物阻擋等)引起的阻塞,毫米波鏈路的可用性可能是高度間歇性的,這進(jìn)一步惡化了超密集網(wǎng)絡(luò)由于復(fù)雜干擾導(dǎo)致的無(wú)線環(huán)境,對(duì)保證用戶業(yè)務(wù)質(zhì)量帶來(lái)嚴(yán)重挑戰(zhàn)。

針對(duì)上述問(wèn)題,研究者提出較多解決方案。文獻(xiàn)[8]通過(guò)使用Q-Learning算法,提出一種基于簇的分布式功率分配方案(Cluster based Distributed Power allocation using Q-Learning,CDP-Q)。該算法提升了系統(tǒng)容量,可滿足所有用戶所需的服務(wù)質(zhì)量(Quality of Service,QoS),但未考慮毫米波通信的鏈路阻塞問(wèn)題。文獻(xiàn)[10]方法通過(guò)協(xié)作Q-Learning算法來(lái)最大化毫微微蜂窩總?cè)萘?同時(shí)保證宏蜂窩用戶的容量水平。文獻(xiàn)[11]提出一種基于Q-Learning的下行鏈路容量?jī)?yōu)化資源調(diào)度方案,在保持宏小區(qū)用戶和毫微微小區(qū)用戶之間公平性的同時(shí),提高小區(qū)邊緣用戶的吞吐量。然而,在文獻(xiàn)[10-11]中,毫微微用戶的QoS均未被考慮。文獻(xiàn)[12]考慮了毫米波多跳通信以克服鏈路阻塞,在直視路徑被障礙物阻斷時(shí),通過(guò)中繼器繞開障礙物來(lái)提高可靠性,但這需要足夠高的節(jié)點(diǎn)密度以確保有合適的中繼節(jié)點(diǎn)可用。文獻(xiàn)[13]提出一種用于鏈路和中繼選擇的聯(lián)合優(yōu)化算法。考慮到包括反射路徑的鏈接的阻塞概率,該算法選擇的鏈接將預(yù)期的交付時(shí)間最小化,但并未考慮多路徑的聯(lián)合使用,并且在基站用戶隨機(jī)分布機(jī)制下,一條路徑被阻塞時(shí)則需切換路徑,這種切換機(jī)制會(huì)引入額外的等待時(shí)間。文獻(xiàn)[14]建立一種基于波束的模型來(lái)評(píng)估毫米波覆蓋概率,其不僅考慮視距傳輸,而且還考慮了一階反射徑的影響。在非視距情況下,反射徑能夠顯著提高覆蓋率,但該模型未考慮系統(tǒng)容量的影響。

本文針對(duì)毫米波通信鏈路高阻塞可能引起中斷的問(wèn)題,提出一種基于Q-Learning算法的功率分配方案。通過(guò)對(duì)鏈路阻塞問(wèn)題進(jìn)行分析,指出鏈路阻塞造成的影響有利有弊,因?yàn)殒溌纷枞锌赡苤袛嘤杏眯盘?hào),同時(shí)也可能會(huì)中斷干擾信號(hào),其與基站、用戶的隨機(jī)分布以及周圍環(huán)境等因素有關(guān)。在此基礎(chǔ)上,將鏈路阻塞因素引入最優(yōu)功率分配問(wèn)題求解模型,借助利己利他策略[15]對(duì)利弊情況區(qū)別對(duì)待,并利用Q-Learning算法學(xué)習(xí)訓(xùn)練利己利他最佳策略,從而減小干擾,提升系統(tǒng)總?cè)萘?同時(shí)為用戶提供所需QoS。

1 單智能體的Q-Learning算法

本節(jié)通過(guò)簡(jiǎn)單案例介紹Q-Learning算法的基本概念[16]。Q-Learning是一種無(wú)模型的強(qiáng)化學(xué)習(xí)方法,其主要解決的問(wèn)題是:一個(gè)能夠感知環(huán)境的智能體,通過(guò)與環(huán)境的交互反復(fù)學(xué)習(xí),以狀態(tài)為行,以行為為列構(gòu)建一張Q表來(lái)存儲(chǔ)Q值,根據(jù)Q值選取能夠獲得最大收益的動(dòng)作。本文將此問(wèn)題模型看作是馬爾科夫決策過(guò)程(Markov Decision Process,MDP)[17-18]。將MDP記為(A,S,Rt,St+1)元組,其包含以下元素:

1)智能體:執(zhí)行學(xué)習(xí)行為并與環(huán)境交互的行為主體。

2)A={a1,a2,…,an}:一組智能體可能采取的有限的動(dòng)作集合。

3)S={s1,s2,…,sn}:一組有限的狀態(tài)集合。基于t時(shí)刻的狀態(tài)st,智能體選擇動(dòng)作at∈A。

4)Rt=r(st,at):智能體在t時(shí)刻、狀態(tài)st下執(zhí)行特定動(dòng)作at后的回報(bào)值函數(shù),反映該動(dòng)作的好壞,從而確定下一狀態(tài)St+1=Φ(st,at)。

5)St+1:獎(jiǎng)勵(lì)被反饋給智能體,從而確定下一狀態(tài)St+1,并重復(fù)該過(guò)程,直至Q表不再有更新或者達(dá)到設(shè)定的收斂條件。

首先假定智能體處在某一環(huán)境下,并且它可以感知周邊的環(huán)境。其中,元素Q(st,at)就是在t時(shí)刻、st(st∈S)狀態(tài)下采取動(dòng)作at(at∈A)所得到的最大累積回報(bào)值。

顯然,策略的好壞不是由一次學(xué)習(xí)過(guò)程的回報(bào)值所決定的,而是由長(zhǎng)時(shí)間累積的回報(bào)值來(lái)決定,因此,定義評(píng)估函數(shù)為:

(1)

式(1)表示的是從初始狀態(tài)st不斷通過(guò)執(zhí)行策略π進(jìn)行學(xué)習(xí)獲得的累積回報(bào)值,其中,γ是折扣因子,γ∈[0,1],通過(guò)調(diào)節(jié)γ,可以控制后續(xù)回報(bào)值對(duì)累積回報(bào)值的影響,γ接近0表示智能體只在乎眼前的利益,做出的行為是為了最大化眼前的獎(jiǎng)勵(lì),γ接近1時(shí)表示智能體更看重長(zhǎng)遠(yuǎn)的利益,目的是使Vπ(st)最大化。

根據(jù)式(1)可以得出最佳策略π*為:

(2)

式(2)表示對(duì)于所有的狀態(tài)集合,使用策略π*可使累積回報(bào)值Vπ(s)達(dá)到最大。但在實(shí)際系統(tǒng)中,直接學(xué)習(xí)最佳策略π*是不切實(shí)際的[19]。使用評(píng)估函數(shù)來(lái)判斷動(dòng)作的優(yōu)劣更切合實(shí)際,評(píng)估函數(shù)定義如下:

Q(s,a)=r(s,a)+γV*(Φ(s,a))

(3)

由Vπ*(s)的定義和式(2)、式(3)可以得出:

(4)

將式(4)代入式(3)可得:

(5)

(6)

為控制之前學(xué)習(xí)效果對(duì)整體的影響,引入學(xué)習(xí)因子α(α∈[0,1]),其值接近0時(shí)表示幾乎不再進(jìn)行新的學(xué)習(xí),而接近1時(shí)表示更看重當(dāng)前的學(xué)習(xí)效果,而且學(xué)習(xí)因子會(huì)影響Q-Learning算法收斂的速度。因此,Q函數(shù)更新為:

γ(Φ(s,a),a′)-Q(s,a)}=

(1-α)Q(s,a)+α{r(s,a)+

γ(Φ(s,a),a′)}

(7)

文獻(xiàn)[16]證明了這種更新規(guī)則在某些條件下可以收斂到最優(yōu)Q值,其中一個(gè)條件是每個(gè)狀態(tài)-動(dòng)作對(duì)必須進(jìn)行無(wú)限次訪問(wèn)。如上所述,Q-Learning在學(xué)習(xí)中獲得獎(jiǎng)勵(lì)Rt,更新自己的Q值,并利用當(dāng)前Q值來(lái)指導(dǎo)下一步的行動(dòng),在下一步的行動(dòng)獲得回饋值之后再更新Q值,不斷重復(fù)迭代直至收斂。在此過(guò)程中,在已得到當(dāng)前Q表的情況下,如何選擇下一步的行為對(duì)完善當(dāng)前Q表最有利,即如何對(duì)探索和利用進(jìn)行折中最為重要。為此,本文引入一個(gè)隨機(jī)因子ε來(lái)調(diào)節(jié)智能體進(jìn)行學(xué)習(xí)的折中考慮,從而搜索到全局最優(yōu)值并快速達(dá)到收斂。

由上述背景介紹可知,單智能體強(qiáng)化學(xué)習(xí)所在環(huán)境是穩(wěn)定不變的,通常使用MDP來(lái)建模求解。然而,在多智能體系統(tǒng)中[20],每個(gè)智能體通過(guò)與環(huán)境進(jìn)行交互獲取獎(jiǎng)勵(lì)值來(lái)學(xué)習(xí)改善自己的決策,從而獲得該環(huán)境下的最優(yōu)策略。在多智能體強(qiáng)化學(xué)習(xí)中,環(huán)境是復(fù)雜的、動(dòng)態(tài)的,這給學(xué)習(xí)過(guò)程帶來(lái)很大困難。相比之下,對(duì)于單智能體面臨的維度爆炸、目標(biāo)獎(jiǎng)勵(lì)確定困難及不穩(wěn)定性等問(wèn)題,通常使用隨機(jī)博弈來(lái)建模求解。本文考慮這兩種方案的特點(diǎn),針對(duì)網(wǎng)絡(luò)模型隨機(jī)分布即適合分布式解決方案的特性,選擇單智能體解決方案。

2 系統(tǒng)模型與問(wèn)題描述

2.1 系統(tǒng)模型

本文基于5G典型場(chǎng)景之一的密集室外城市場(chǎng)景,考慮密集部署的毫米波基站下行鏈路。在網(wǎng)絡(luò)結(jié)構(gòu)上,假設(shè)毫米波基站位置遵循基于密度λBS的泊松簇過(guò)程(Poisson Cluster Process,PCP)[21-22]。PCP在實(shí)踐中也被稱為父子建模過(guò)程,其包含一個(gè)父過(guò)程和一個(gè)子過(guò)程,父過(guò)程形成簇的中心,子過(guò)程圍繞父過(guò)程分布在簇中心一定的范圍。本文假設(shè)共有M個(gè)簇,每個(gè)簇有N個(gè)毫米波基站,每個(gè)基站僅服務(wù)一個(gè)用戶,用戶以基站為中心、以h為半徑隨機(jī)拋灑,且每個(gè)基站天線數(shù)為NT、用戶天線數(shù)為NR。假設(shè)單個(gè)小區(qū)邊緣用戶與其相關(guān)聯(lián)基站之間的距離大于設(shè)定界點(diǎn)距離d時(shí)有一定的概率會(huì)導(dǎo)致中斷,此時(shí)用戶的QoS會(huì)受影響,同時(shí)假定目標(biāo)用戶在整個(gè)操作過(guò)程中保持靜止。

假設(shè)本文基站和用戶之間的信道模型為毫米波信道,基站i和用戶k之間的信道可以記為:Ii,k(d)×Hi,k。其中,Ii,k(d)是0-1布爾變量,表示基站i和用戶k之間的通信鏈路是否正常[23],d為設(shè)定的毫米波動(dòng)態(tài)鏈路高阻塞引起鏈路中斷概率的界點(diǎn)距離。用PI(x)表示Ii,k(d)鏈路是否正常的概率。將毫米波基站與其相關(guān)聯(lián)用戶之間基于2D距離x的可視線概率記為PI(x),其由3GPP城市微街道峽谷模型[24]獲得,如式(8)所示:

(8)

其中,xi,k為當(dāng)前毫米波基站i與其關(guān)聯(lián)用戶k之間的2D距離,當(dāng)x≤d時(shí),表示一定可視,鏈路無(wú)阻塞;當(dāng)x>d時(shí),表示有概率不可視,鏈路有概率被阻塞。

Li,k表示基站i和用戶k之間的路徑損耗,路徑損耗Li,k如式(9)所示:

Li,k=β1+10β2lgxi,k+Xζ

(9)

其中,β1和β2是用于實(shí)現(xiàn)最佳擬合信道測(cè)量因子,xi,k為當(dāng)前毫米波基站i與其關(guān)聯(lián)用戶k之間的2D距離,Xζ~Ν(0,ζ2)表示對(duì)數(shù)陰影衰落因子。

此時(shí)第k個(gè)用戶的信干噪比(Signal to Interference plus Noise Ratio,SINR)為:

(10)

Pk=10(Pk′-Lk,k)/10

(11)

其中,Pk為第k個(gè)基站發(fā)送到其服務(wù)用戶k的實(shí)際功率,Pk′為Q-Learning算法中基站k選定某一狀態(tài)所執(zhí)行的行為(功率),Lk,k為基站k到用戶k之間的路損,Dk為干擾基站的集合,σ2表示加性高斯白噪聲方差。因此,第Pk(Pk=Pk′-Lk,k)個(gè)用戶的歸一化容量為:

Ck=lb(1+SINRk)

(12)

2.2 問(wèn)題描述

本文旨在毫米波基站之間尋找最優(yōu)功率分配,為此,首先建立最大化問(wèn)題模型,然后通過(guò)問(wèn)題求解使系統(tǒng)總?cè)萘孔畲蠡?同時(shí)滿足所有用戶的QoS和功率約束。本文優(yōu)化問(wèn)題(P1)可以表述為:

(13)

s.t.

Pk≤Pmax,k=1,2,…,N

(14)

SINRk≥qk,k=1,2,…,N

(15)

其中:目標(biāo)函數(shù)(式(13))表示最大化網(wǎng)絡(luò)總?cè)萘?M為系統(tǒng)模型中劃分簇的個(gè)數(shù);N表示劃分的每個(gè)簇內(nèi)的毫米波基站的數(shù)量;約束條件(式(14))指的是每個(gè)毫米波基站的功率限制,表示從每個(gè)毫米波基站分配給用戶的功率不能超過(guò)最大功率Pmax;式(15)中的qk表示第k個(gè)用戶所需的最小SINR值,稱為閾值。P1優(yōu)化問(wèn)題為:在使整個(gè)系統(tǒng)總?cè)萘孔畲蟮耐瑫r(shí)要滿足每個(gè)用戶所需的QoS。

由于P1優(yōu)化問(wèn)題中SINR項(xiàng)的分母包含干擾項(xiàng),而在毫米波通信網(wǎng)絡(luò)中,干擾復(fù)雜不可忽略,因此,究其本質(zhì)為一個(gè)耦合問(wèn)題,此類優(yōu)化問(wèn)題是一個(gè)非凹函數(shù),無(wú)法直接求解。傳統(tǒng)的啟發(fā)式方案所求得的僅為次優(yōu)策略,與最優(yōu)解誤差較大。而本文所要解決的是一個(gè)耦合問(wèn)題,再加上考慮到毫米波鏈路阻塞特性導(dǎo)致的0-1布爾問(wèn)題,使得P1更加難以解決,因此,本文考慮使用Q-Learning算法來(lái)解決此問(wèn)題。

本文設(shè)計(jì)的P1的解決方案還具有以下特征:

1)由于設(shè)定場(chǎng)景為密集室外城市場(chǎng)景,毫米波基站和用戶數(shù)量眾多,干擾復(fù)雜多樣,沒(méi)有行之有效的中心管理機(jī)構(gòu),因此本文以分布式結(jié)構(gòu)來(lái)處理。

2)毫米波通信雖然帶來(lái)了顯著的容量增益,但其信號(hào)衰耗大、輻射范圍有限,因此,合理假設(shè)只有距離接近的毫米波基站彼此干擾。可使用聚類機(jī)制將設(shè)定場(chǎng)景中的基站劃分為多個(gè)集群,其中一個(gè)集群的干擾對(duì)其他集群的用戶來(lái)說(shuō)可以忽略不計(jì)。

3 PPCP-Q分配方案

本節(jié)介紹PCP網(wǎng)絡(luò)模型下基于Q-Learning算法的功率分配方案PPCP-Q。與其他強(qiáng)化學(xué)習(xí)算法相比,Q-Learning算法在復(fù)雜系統(tǒng)中具有非常好的學(xué)習(xí)性能。同時(shí)PCP還具有疊加性、稀釋性和映象性[19]等特性,非常適應(yīng)毫米波網(wǎng)絡(luò)的復(fù)雜結(jié)構(gòu)以及網(wǎng)絡(luò)環(huán)境的動(dòng)態(tài)變化,因此,本文采用PPCP-Q方案進(jìn)行功率分配。PPCP-Q算法分為PCP聚類和基于Q-Learning的分布式功率分配兩個(gè)部分。

3.1 毫米波基站的泊松簇過(guò)程

本文考慮系統(tǒng)模型具有分布式特性以及毫米波通信信號(hào)損耗大和覆蓋范圍較小的特性,假定在應(yīng)用場(chǎng)景中只有距離靠近的毫米波基站之間彼此干擾。本文基于PCP假設(shè)將毫米波基站劃分為簇,PCP過(guò)程是一種分布式聚類方法,并可生成非重疊簇。為具體說(shuō)明其過(guò)程,給出以下定義:

1)簇頭。基于PCP產(chǎn)生簇頭,在本文中,被選定為簇頭的毫米波基站與簇內(nèi)其余毫米波基站之間沒(méi)有優(yōu)先級(jí)之分。

2)入簇(In Cluster,IC)和簇外(Out Cluster,OC)節(jié)點(diǎn)。在PCP中,將IC距離定義為100 m,這是強(qiáng)干擾的表示。OC距離定義為200 m,其表示簇頭周圍簇的邊緣覆蓋范圍。若a點(diǎn)距某一簇頭在100 m范圍之內(nèi)則定義為IC;若a點(diǎn)處于此簇的OC距離(即大于100 m小于200 m的范圍),而此時(shí)又不屬于任何其他簇的IC距離,則將a點(diǎn)作為OC節(jié)點(diǎn)加入此簇;若a點(diǎn)距離多個(gè)簇頭的距離相同,此時(shí)隨機(jī)選擇一個(gè)簇加入即可。

3.2 基于Q-Learning的分布式功率分配

Q-Learning算法是強(qiáng)化學(xué)習(xí)的典型方法之一,已被證明具有收斂性。在PPCP-Q算法中,毫米波基站被認(rèn)為是Q-Learning算法的智能體。PPCP-Q是一種分布式方法,其中多個(gè)智能體旨在通過(guò)反復(fù)與環(huán)境交互來(lái)發(fā)現(xiàn)最佳策略(功率)以最大化網(wǎng)絡(luò)容量。

在多智能體的學(xué)習(xí)中,智能體可以合作學(xué)習(xí)(Cooperative Learning,CL)或獨(dú)立學(xué)習(xí)(Independent learning,IL)。在CL中,當(dāng)前智能體與其他合作智能體共享其Q表。在IL中,每個(gè)智能體獨(dú)立于其他智能體學(xué)習(xí)(即將其他智能體視為環(huán)境的一部分,忽略其行為),雖然這可能導(dǎo)致算法收斂時(shí)間變長(zhǎng),但與CL相比,智能體之間沒(méi)有通信開銷,因此,本文選擇IL。PPCP-Q算法描述如下:

算法1PPCP-Q算法

輸入狀態(tài)集合,動(dòng)作集合,學(xué)習(xí)因子α,折扣因子γ

輸出Q表

2.基于3.1節(jié)泊松簇過(guò)程對(duì)系統(tǒng)模型進(jìn)行分簇

3.for所有簇

4.for每一個(gè)簇內(nèi)智能體(毫米波基站)

5.for每一個(gè)智能體的訓(xùn)練次數(shù)episode

7.生成一個(gè)0~1之間的隨機(jī)數(shù)sigma

8.if sigma<ε

9.ε=ε×0.99

11.else

13.end

16.根據(jù)式(7)更新Q表

18.end for

19.end for

20.end for

Q-Learning算法的輸出為分配的功率,被表示為Q函數(shù),智能體的Q函數(shù)被稱為Q表,其中行是狀態(tài),列是行為(功率)。在Q-Learning算法中,行為、狀態(tài)和回報(bào)函數(shù)定義如下:

1)行為。每個(gè)智能體可執(zhí)行的動(dòng)作是簇內(nèi)毫米波基站可以使用的一組可能的功率。在仿真中,行為(分配的功率)集合A定義為A={a1,a2,…,an},它均勻地覆蓋了最小功率(a1=Pmin)和最大功率(an=Pmax)之間的范圍,步長(zhǎng)為1 dBm。

(16)

其中,i,k=1,2,…,N。xi,k小于等于設(shè)定的界點(diǎn)距離d表示鏈路正常通信,此時(shí)為狀態(tài)0;xi,k大于d表示有概率導(dǎo)致鏈路中斷,此時(shí)為狀態(tài)1。

選擇一個(gè)簇,即A1、A2,利己利他策略應(yīng)用示意圖如圖1所示。

圖1 利己利他策略示意圖Fig.1 Schematic diagram of egoistic and altruistic strategy

根據(jù)基站i與用戶k之間的2D距離xi,k,智能體在時(shí)刻t的狀態(tài)可分為以下3種情況:

情況1基站1與服務(wù)用戶1鏈路阻塞,基站1與被干擾用戶2、用戶3鏈路正常,即有用信號(hào)發(fā)生阻塞,用戶1考慮利他功率分配策略,此時(shí)應(yīng)最小化發(fā)射功率,避免對(duì)其他用戶干擾。

情況2基站2及其服務(wù)用戶2鏈路正常,基站2與用戶1鏈路正常,與用戶3鏈路中斷,即部分被干擾用戶鏈路阻塞,此時(shí)應(yīng)考慮利己利他功率分配策略,即按功率等級(jí)適量發(fā)射功率,均衡干擾同時(shí)提升系統(tǒng)容量。

情況3基站3及其服務(wù)用戶3鏈路正常,基站3與用戶1、用戶2鏈路中斷,即用戶3所產(chǎn)生干擾信號(hào)完全阻塞,此時(shí)應(yīng)考慮利己功率分配策略,最大化發(fā)射功率,提升系統(tǒng)容量。

(17)

其中,k=1,2,…,N,A1和A2分別為10 dBm和5 dBm。

3)回報(bào)函數(shù)。本文優(yōu)化問(wèn)題P1旨在最大化系統(tǒng)總?cè)萘?同時(shí)滿足用戶所需的QoS。回報(bào)函數(shù)的設(shè)計(jì)基于優(yōu)化目標(biāo),反映環(huán)境對(duì)智能體選擇動(dòng)作的滿意程度。回報(bào)函數(shù)定義如下:

(18)

(19)

回報(bào)函數(shù)的基本原理如下:

1)只有當(dāng)環(huán)境中毫米波基站最小和速率gt大于等于G倍的閾值時(shí),才能得到一個(gè)正的回報(bào)值,否則回報(bào)值為負(fù)值。

2)因?yàn)?Ct-Glb(1+qk))/Ct<1,并且Ct越大,該值越大,所以系統(tǒng)吞吐量越大,對(duì)應(yīng)回報(bào)值也越大。

此外,在學(xué)習(xí)過(guò)程中,需要設(shè)置一個(gè)隨機(jī)因子ε來(lái)調(diào)節(jié)智能體進(jìn)行隨機(jī)學(xué)習(xí)的比例,本文假設(shè)隨機(jī)因子ε的初值為0.9,且智能體每進(jìn)行一次隨機(jī)學(xué)習(xí),該值就更新為原值的0.99倍。基于此設(shè)置,智能體在初始學(xué)習(xí)時(shí)會(huì)頻繁地進(jìn)行隨機(jī)學(xué)習(xí),隨著學(xué)習(xí)次數(shù)的增加和學(xué)習(xí)經(jīng)驗(yàn)的累積,隨機(jī)因子的值會(huì)逐漸趨近于0,此時(shí)智能體會(huì)進(jìn)行經(jīng)驗(yàn)學(xué)習(xí),選擇每一步的最優(yōu)策略并快速達(dá)到收斂。

4 仿真與結(jié)果分析

本節(jié)對(duì)構(gòu)建的系統(tǒng)模型進(jìn)行系統(tǒng)級(jí)仿真,仿真程序在Matlab環(huán)境下實(shí)現(xiàn),以證明本文方案的有效性。

4.1 仿真環(huán)境與參數(shù)設(shè)置

考慮密集部署的毫米波基站的下行鏈路網(wǎng)絡(luò),在1 km2的區(qū)域內(nèi)分布2個(gè)~16個(gè)簇。簇頭基于泊松過(guò)程生成,每個(gè)簇內(nèi)基于半徑R范圍隨機(jī)分布N(N=5)個(gè)成員基站,依據(jù)成員基站與簇頭距離再劃分成員基站不重疊簇的歸屬。簇頭與簇內(nèi)成員之間沒(méi)有優(yōu)先級(jí)之分,且簇與簇之間相互獨(dú)立。簇內(nèi)每個(gè)基站基于半徑h隨機(jī)拋灑一個(gè)用戶,即每個(gè)基站支持一個(gè)用戶。用戶的QoS被定義為支持用戶服務(wù)所需的最低SINR,所有用戶均考慮閾值qk=10 dB。在Q-Learning算法中,學(xué)習(xí)率為α,折扣因子為γ,最大迭代次數(shù)被設(shè)置為50 000次。其他仿真參數(shù)如表1所示。

表1 仿真參數(shù)Table 1 Simulation parameters

4.2 結(jié)果分析

本文基于PCP設(shè)定的系統(tǒng)模型基站和用戶的分布情況如圖2所示,圖中以不同形狀分別表示簇頭、簇內(nèi)毫米波基站和相關(guān)聯(lián)的用戶。

圖2 PCP模型基站與用戶分布Fig.2 BSs and users distribution of PCP model

圖3所示為本文方案某個(gè)智能體在學(xué)習(xí)動(dòng)作上的收斂情況。由于PPCP-Q方案考慮阻塞概率,使系統(tǒng)更加動(dòng)態(tài)化,因此引入隨機(jī)因子ε對(duì)探索和利用進(jìn)行折中考量,調(diào)節(jié)智能體進(jìn)行隨機(jī)學(xué)習(xí)的比例,選擇集體最優(yōu)而非單次最優(yōu)的一串最優(yōu)動(dòng)作。隨著ε的值逐漸趨近于0,智能體會(huì)進(jìn)行經(jīng)驗(yàn)學(xué)習(xí),加快收斂速度。從圖3中可以看出,在前3 000次學(xué)習(xí)中,智能體進(jìn)行了大量的隨機(jī)動(dòng)作選擇,但是隨著迭代次數(shù)的增加,設(shè)定的隨機(jī)因子在逐漸減小,在3 000次~9 000次學(xué)習(xí)過(guò)程中隨機(jī)的動(dòng)作次數(shù)逐漸減小,在9 000次學(xué)習(xí)之后,智能體在學(xué)習(xí)過(guò)程中動(dòng)作的選擇逐漸達(dá)到收斂狀態(tài)。

圖3 Q-Learning算法動(dòng)作收斂情況Fig.3 Action convergence of Q-Learning algorithm

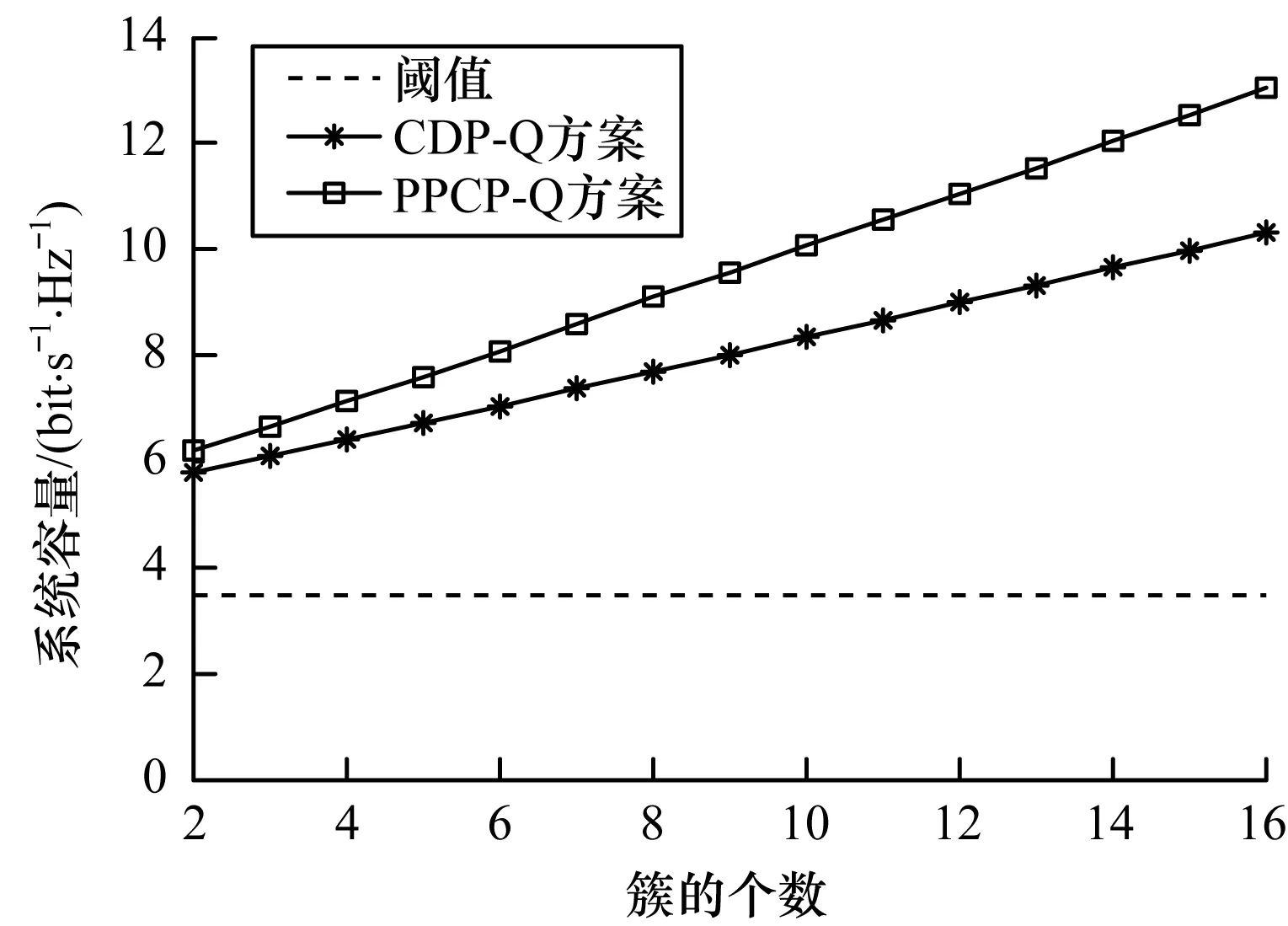

將本文PPCP-Q方案與文獻(xiàn)[8]的CDP-Q方案進(jìn)行比較,如圖4所示。可以看出,對(duì)于多種可能簇的大小,2種方案在系統(tǒng)總?cè)萘可系娜≈稻^(guò)閾值,均滿足用戶所需的QoS。圖5為PPCP-Q與CDP-Q兩種方案系統(tǒng)容量的CDF曲線對(duì)比。可以看出,PPCP-Q方案相較于CDP-Q方案提供了較為明顯的系統(tǒng)容量增益。增益機(jī)理分析如下:PPCP-Q方案考慮到毫米波鏈路可用性是高間歇性的,同時(shí)在Q-Learning算法狀態(tài)和回報(bào)函數(shù)設(shè)計(jì)中加入利己利他策略來(lái)求解目標(biāo)函數(shù),對(duì)有利有害情況區(qū)別對(duì)待并加以利用,在減小干擾的同時(shí)合理分配功率以最大化系統(tǒng)容量,同時(shí)滿足用戶的QoS。而文獻(xiàn)[8]的CDP-Q方案基于Q-Learning算法來(lái)訓(xùn)練智能體分配功率,其采用利己分配策略,但未根據(jù)毫米波通信鏈路阻塞特性施加不同功率分配策略,所以在系統(tǒng)性能角度上,其增益受到限制。總體而言,本文方案顯著提升了系統(tǒng)容量,而且隨著簇的個(gè)數(shù)增多,性能優(yōu)勢(shì)更為明顯。

圖4 多簇情況下兩種方案的系統(tǒng)總?cè)萘繉?duì)比Fig.4 Comparison of the total capacity of two schemesin the case of multiple clusters

圖5 兩種方案的系統(tǒng)容量CDF曲線對(duì)比Fig.5 Comparison of system capacity CDF curve of two schemes

5 結(jié)束語(yǔ)

隨著多媒體應(yīng)用的不斷發(fā)展和移動(dòng)流量的爆炸式增長(zhǎng),5G網(wǎng)絡(luò)中基站部署日趨密集,使毫米波通信在解決頻譜資源短缺和提升系統(tǒng)性能的同時(shí)也面臨高阻塞、大衰落和干擾復(fù)雜多變等問(wèn)題,影響了毫米波鏈路的可用性,而且基站用戶隨機(jī)分布,無(wú)規(guī)律可循,使得功率分配問(wèn)題更為復(fù)雜。對(duì)此,本文提出一種基于Q-Learning的功率分配方案。以毫米波基站為智能體,在狀態(tài)和回報(bào)函數(shù)設(shè)計(jì)中加入利己利他策略,考慮多種可能的鏈路阻塞情況,充分利用功率資源以最大化系統(tǒng)容量,同時(shí)保證用戶的QoS。仿真結(jié)果表明,本文方案能夠提升系統(tǒng)性能,實(shí)現(xiàn)優(yōu)化目標(biāo)。由于Q-Learning算法在狀態(tài)和行為設(shè)計(jì)上維度有限,因此下一步將考慮利用深度神經(jīng)網(wǎng)絡(luò)改進(jìn)該方案,并通過(guò)添加更多指標(biāo),同時(shí)實(shí)現(xiàn)多個(gè)系統(tǒng)優(yōu)化目標(biāo),提升系統(tǒng)的整體性能。