自適應模型的視覺跟蹤算法*

朱洪波

(廈門弘搏科技有限公司 廈門 362000)

1 引言

視覺跟蹤在視頻監控、自動駕駛、車輛導航和人機交互等領域有著廣泛的應用。但由于固有因素(如規模變化和變形)和外部因素(如光照變化、遮擋)。目標跟蹤方法可分為判別[5~9]或生成法[1~4]。其中生成方法學習可以通過提取的特征表示的外觀模型,然后制定跟蹤任務,如搜索與定義為目標的模型最相關的目標圖像區域。常見生成模型包括增量跟蹤器(IVT)[1]、跟蹤器[2]、多任務跟蹤器(MTT)[3]、稀疏表示[4]等。判別方法可以看作是二進制分類問題,通常可以稱為逐導檢測方法,其中一種是目標對象,另一個是周圍的背景。這些方法的主要任務是通過學習分類器來確定當前幀位置上的目標,從而區分目標和不斷變化的背景。一般判別模型已被提出包括多實例學習(MIL)[5]、支持向量跟蹤[6]、P-N學習[7]、壓縮傳感[8],所有相關過濾器為基礎跟蹤器。生成模型具有更全面的能力來描述目標對象的特征,但缺點是沒有考慮到目標對象周圍的背景信息。考慮到目標和背景信息的判別模型具有很高的判別能力,可以區分目標和復雜的背景,很容易導致過度擬合現象[10]。

目前,傳統的視覺跟蹤算法可以簡單地分為兩種方法,包括基于相關濾波器(CF)[13~20,27~29]和基于深度學習的[21~23,33~37]方法。這兩種方法都可以從不同的方面提高算法的性能。基于深度學習的跟蹤方法通常采用從卷積神經網絡(CNN)中提取的預先訓練的深高維特征來表示特征。雖然實現了理想的跟蹤結果,但在特征提取過程中增加了大量的計算復雜性,將嚴重影響實時性能。在跟蹤過程中,跟蹤模型的更新過程對于確定跟蹤是否準確至關重要。目前大多對跟蹤模型進行了從一個幀到下一個幀更新。這種更新方法存在缺點。當目標遇到顯著的外觀變化,如照明變化、遮擋、超出視圖,將產生錯誤的跟蹤信息。這些信息將被傳遞到下一幀,積累很長時間后,將增加跟蹤漂流的風險,最終會導致跟蹤失敗。

本文針對上述問題研究如何設計一個穩健的策略來更新模型,以進一步提高模型的質量。以前幀中的正確跟蹤信息可以及時傳遞到下一個幀,并且當目標對象經歷復雜的情況(如遮擋和照明變化)時,可以正確地更新模型,從而使模型保持隨后的視頻序列在一定程度上被惡化。

2 基于相關濾波器的跟蹤算法

2.1 基于判別相關濾波器的框架

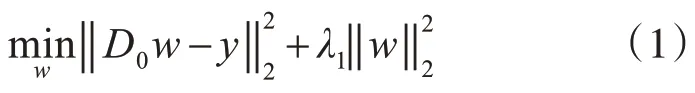

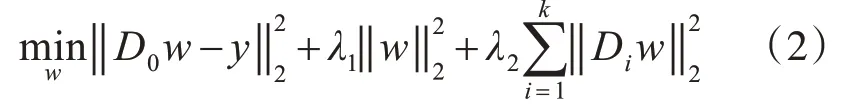

首先介紹了關于本文算法中使用的上下文感知相關濾波器框架的先驗知識,然后介紹了有關尺度相關濾波器如何集成到本文的算法。最常見的基于識別性相關的跟蹤器總是傾向于忽略周圍的上下文信息。然而,目標位置周圍的上下文區域在跟蹤性能方面發揮著重要作用。文獻[18]提出了基于判別相關濾波器的上下文感知框架,將全局上下文信息集成到學習濾波器中。目標是訓練一個對目標圖像補丁有較高響應和對上下文區域的響應接近于零的濾波器。在CACF框架中,主要目標是訓練最佳相關濾波器w,對于所有訓練樣本DO(DO包含由循環移位運算符和理想的回歸目標y生成的矢量化圖像補丁dO的所有循環轉換)(y是二維高斯的矢量化圖像),如式(1):

根據傅里葉域中循環矩陣性質,本文將訓練一個濾波器w,它對目標圖像補丁具有較高的置信度響應,對上下文補丁具有接近零的置信度響應。通過在標準配方中添加上下文補丁作為正則化術語如式(2):

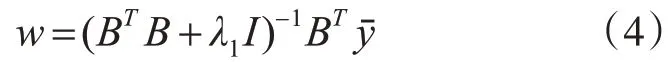

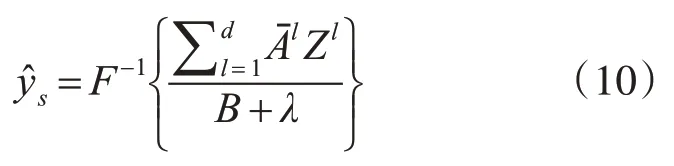

由于目標圖像補丁包含許多上下文圖像信息,并形成了一個新的數據矩陣B∈R(k+1)n×n,主目標函數(2)可以重寫如下:

其中B=and=,yˉ∈R(k+1)n∈R(k+1)n表示

新的理想回歸目標。由于目標函數是凸函數,可以通過派生操作將其最小化,如下所示:

2.2 尺度判別相關濾波器

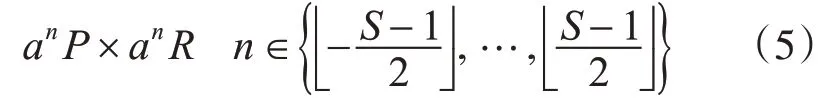

在跟蹤過程中,參考文獻[15]提出了一種基于判別相關濾波器的精確尺度估計方法。通過訓練一個尺度判別相關濾波器的規模金字塔表示,然后估計規模從最好的置信度框架。以用于比例估計的目標為中心的圖像補丁大小為

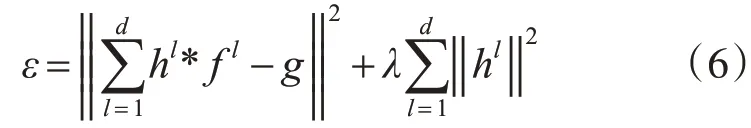

其中P和R分別表示當前幀中的寬度和高度,表示比例因子,s表示比例濾波器的大小。目標是通過最小化以下目標函數來獲得最佳的尺度相關濾波器h:

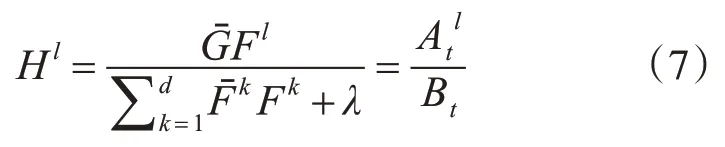

其中g表示理想的相關輸出,l表示特征的維度,是一個正則系數。上述頻域中的解決方案是通過以下方式給出的:

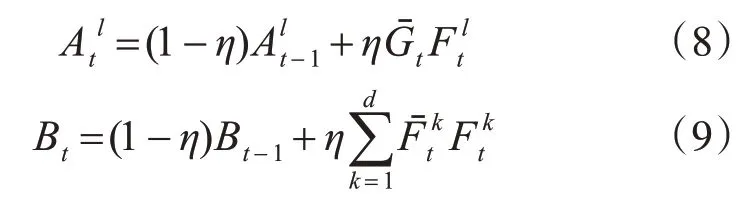

為了獲得準確的結果,H1中的分母分別更新如下:

η是一個學習速率參數。在下一幀中通過以下公式求解比例濾波器的響應:

3 本文提出跟蹤模型

3.1 多特征自適應融合策略

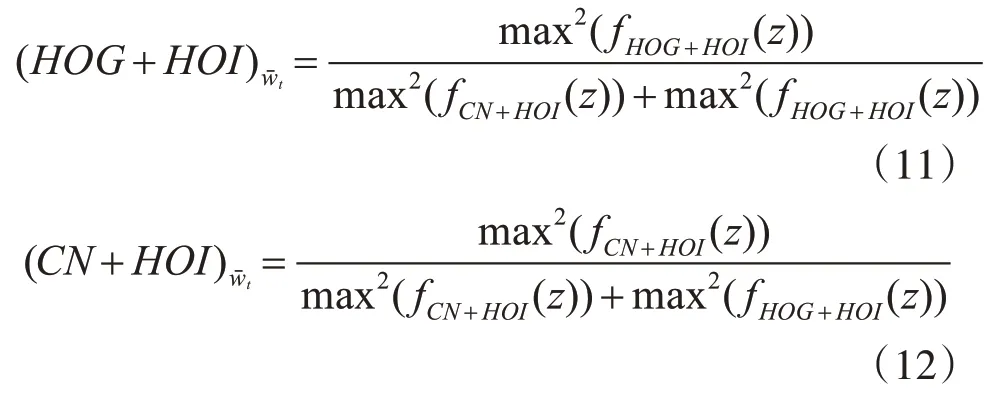

視覺特征表示是視覺跟蹤框架的重要組成部分。本文主要集中在手工制作的功能。常見的手工制作功能包括HOG功能和CN功能,兩個都有自己的優點和缺點。HOG功能被廣泛用于大多數現有的跟蹤器和對象檢測。通過計算和完成圖像貼片單元空間網格中梯度方向的統計直方圖來生成特征,使其與幾何變形和光學變形保持了優越的不變性。CN特征[27]描述符利用PCA技術進行降維。局部強度(HOI)[17]的直方圖是HOG特征的補充,通過計算局部強度的直方圖,使其對遮擋和運動模糊等劇烈的外觀變化更加穩健。為了實現卓越的特征表示,并補充了各自的優勢。本文考慮將上述分析的HOG、CN和HOI的兩個特征結合起來。本文首先在CACF框架的基礎上,分別計算HOG和CN分別與HOI集成所產生的相應的最大響應分數。每個要素的權重根據相應響應分數的比例進行分配。因此,下一幀中的視頻序列將被優先用于選擇權重較高的要素。在t-th框架中分別與HOI集成的HOG和CN特征的歸一化權重為

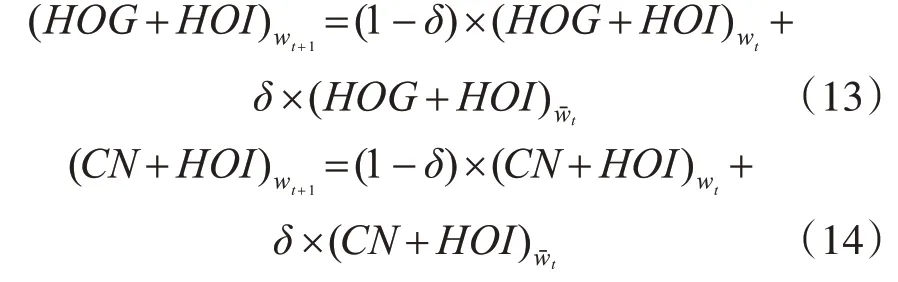

HOI表示像素強度直方圖特征,fHOG+HOI表示與像素強度直方圖特征集成的HOG特征的相應輸出響應分數,,fHOG+HOI表示CN特征與像素強度直方圖特征集成的相應輸出響應分數。t+1-th框架中的權重wt+1用于更新以前的要素權重wˉt:

本文根據響應分數的比例為所有要素分配權重。最終響應是由HOG和CN功能分別與HOI集成而生成的,響應分數Rt如下所示:

3.2 本文算法的自適應模型更新方法

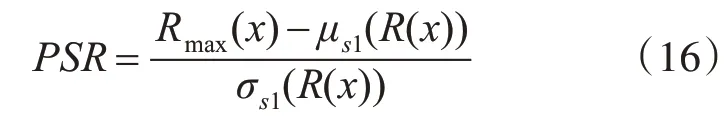

本文將響應圖的PSR及其響應圖作為跟蹤質量評估的高峰。表達式方程是通過以下方式給出的:

該模型可以根據每個不同視頻序列的最大響應分數自適應地判斷結果。只有當滿足特定條件時,PSR大于其最大響應峰值分數Rmax(x),轉換濾波器模型。在當前幀中,跟蹤結果是準確的。它有效地防止了不正確的更新信息被傳輸到后續幀,從而導致跟蹤漂移,從而創建了一種自適應的方式來更新比例模型和翻譯模型。該算法的總體流程如下所示。

初始化:確定第一幀要跟蹤目標狀態,設定更新閾值T為0.43

fort=1 toT(T為視頻總幀數)

ift>1

1)位置估計:

Step1:根據目標的狀態,采樣圖像塊,分別采用HOG和CN特征表達;

Step2:(H O G+H O I)W t、(CN+HOI)W t分別對HOG、CN特征表達的圖像塊進行相關濾波,求出響應圖

Step3:根據式(15)計算融合響應圖,估計當前幀的位置;

2)尺度估計:

Step4:根據式(16)求得最大尺度相關濾波得分,估計當前幀的尺度,并使用式(13)、(14)更新;

end

3)if max(Rt)>T

Step5:根據目標狀態,訓練和更新HOG和CN特征的濾波器模型(w t,x t)、尺度濾波模型(At,Bt);

Step6:根據式(13)(14)更新HOG和CN特征的融合權重;

end

end

4 實驗結果

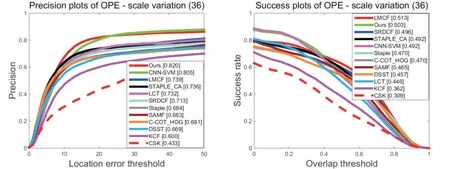

本文采用OTB基準數據集評估,并與目前主流的跟蹤方法包括SRDCF[16],LMCF[19],C-COT_HOG[39],LCT[17],KCF[14],CSK[13],SAMF[28],DSST[15],STAPLE_CA[18],DCF[18],SAMF_CA[18],MOSSE_CA[18]、CNSVM[41],數據集中的所有這些視頻都由包含不同挑戰性場景的11個屬性進行注釋:照明變化(IV)、比例變化(SV)、遮擋(OCC)、變形(DEF)、運動模糊(MB)、快速運動(FM)、平面旋轉(IPR)、超視點(OV)、背景離合器(BC)和低分辨率(LR)。圖1表明本文算法在幾個屬性挑戰中具有較好的距離精度和重疊成功率,并表明該方法在光照變化屬性(80.7、55.5)方面達到了優越的DP和OS,平面內旋轉(82.4,54.4%)、平面外旋轉(82.4,54.7%)、刻度變化(82%,50.3%)。結果表明本文更新方法和多重特征的融合策略大幅度提高跟蹤精度。

圖1 部分不同狀態的跟蹤結果(平面旋轉,平面外旋轉,規模變化)

5 結語

本文提出了一種基于判別相關濾波器的精確模型自適應更新方法。利用判別相關濾波器生成的響應峰值分數作為動態閾值,并與各幀響應圖的峰值側瓣比進行了比較,然后將比較結果作為實現平移濾波模型和尺度濾波器模型更新的差異化條件,實現自適應更新方法。為了實現較好的特征表示,提出了響應層中的HOG、CN和HOI等多種手工制作特征的自適應融合策略。實驗結果表明,該跟蹤器與最先進的基于濾波器的判別相關跟蹤器相比效果良好,在遮擋、尺度變化、變形、快速等復雜情況下表現良好的跟蹤效果。