基于EVPN實現云數據中心異地容災

廖峰

(中國聯合網絡通信有限公司廣東省分公司,廣東 廣州 510360)

1 引言

在廣東聯通信息化業務規模擴大及IT基礎設施云化的大趨勢下,相關信息化部門在廣州YJ、廣州XSK、江門BJ、東莞SSH 等多地建設了云數據中心,并致力于整合所有IT基礎設施。隨著業務的發展,數據中心內部的東西向流量越來越大。

云平臺的業務發展快速,對資源池的穩定和靈活性要求越來越高。應用大二層技術,我們可以為跨數據中心網絡的二層連接擴展,提供運營優化型解決方案。而EVPN作為通用技術協議,可以將兩個地理域的數據中心站點構建統一的虛擬計算資源群集,以實現兩地數據二層的通信,達到云平臺虛擬機跨節點在線遷移功能。

2 案例背景分析

隨著業務的發展,數據中心內部的東西向流量越來越大。為了不影響IT承載網其他關鍵應用的穩定性,通常不考慮直接在DCN 網絡上承載相關流量,在數據中心比較少的時候,兩個數據中心直接采用光纖直連的方式解決數據中心的數據通信問題,但是擴展性較差,而且容易導致網絡不穩定,多個數據中心不再能夠通過這種方式進行互聯,因此需要建設一張能夠承載大容量東西向流量的數據中心互聯網絡。項目一期在廣州XSK節點和東莞SSH節點分別新建一對思科NCS 5508 路由器,作為leaf 節點;在廣州新建一對思科NCS 5508路由器,作為spine節點,spine和leaf交叉互聯,實現XSK節點和SSH節點虛擬機在線雙向遷移。

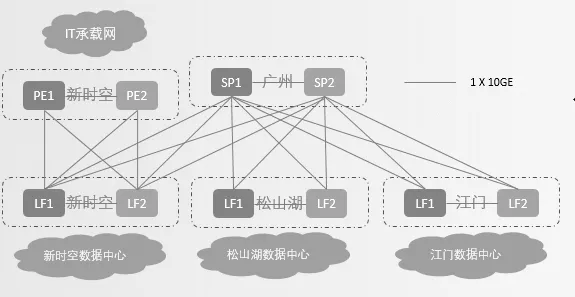

2.1 跨機房云平臺網絡拓撲

spine和leaf交叉互聯。基于當前業界的最佳實踐建議,DCI underlay 使用ISIS+SR 技術,overlay 使用BGP+EVPN+vpnv4技術,其中EVPN承載二層MAC表項,vpnv4承載三層路由表項。

跨機房云平臺網絡拓撲如圖1所示。

圖1 跨機房云平臺網絡拓撲

2.2 云平臺虛擬網絡

目前承載二層MAC表項的overlay 網絡主要有OTV 和EVPN兩種方案。其中OTV是思科公司私有的協議,鄰居的建立依賴于OSPF 等動態路由協議,EVPN 用BGP協議實現雙網關不沖突。EVPN通用技術協議,用三層路由攜帶虛擬機MAC地址完成跨機房尋址;雙網關部署在leaf 上或者匯聚交換機如N7K上,網關找不到MAC提供給leaf網絡。

云平臺采用Vmware虛擬化軟件Vsphere,該虛擬化平臺采用通用的OpenvSwitch虛擬交換機實現對物理機上不同網絡的劃分。物理機安裝Vsphere 后,系統為該物理機創建一個虛擬網絡,該網絡在虛擬機上的虛擬網絡接口(VIF)與物理機服務器上的網絡接口(NIC)所關聯的物理網絡接口(PIF)之間起橋接的作用。

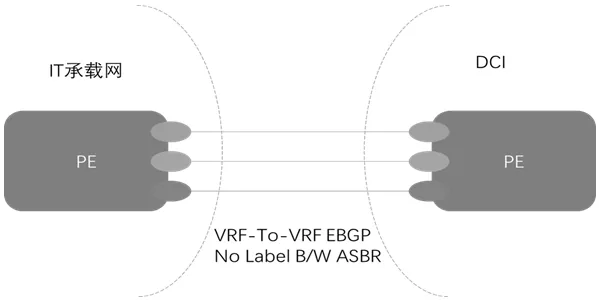

2.3 跨域VPN技術選擇

跨域方式主要有Option A 背靠背(back-to-back)VRF、Option B 單跳多協議MP-EBGP和Option C 多跳多協議MPEBGP三種。Option A的優勢在于配置簡單,ASBR之間不需要運行標簽協議,使用EBGP的路由策略也可以提供很好的安全性;缺點是當大量VRF需要互聯時,該方式配置量比較大,同時需要更多的IP 地址,擴展性比較差。本文只涉及3個VRF故選擇Option A。

Option A的互聯方式如圖2所示。

圖2 Option A的互聯方式

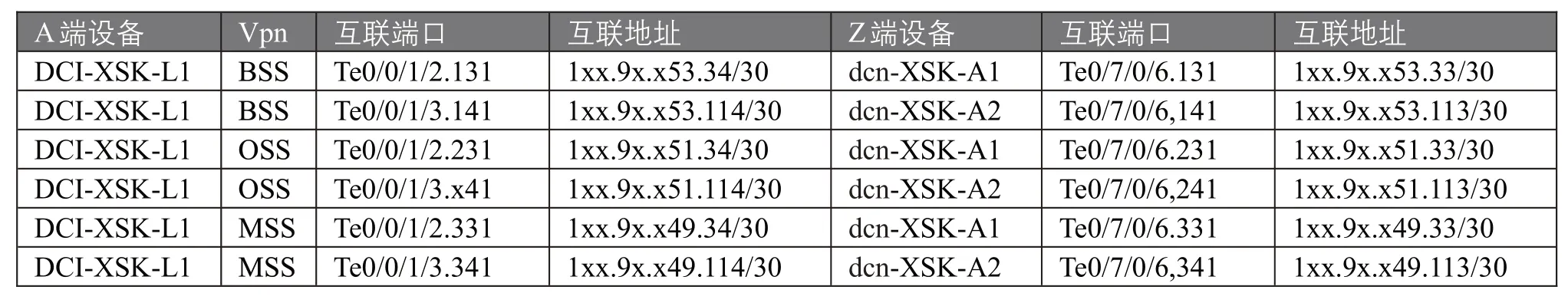

2.4 VPN端口互聯

本次互聯端口和IP地址(僅含A平面Leaf1)如表2所示。

表2 端口互聯與IP地址分配表

3 問題分析和解決方法

要完成遷移,需在IT承載網PE與DCI網的LF之間建立BGP路由協議,不涉及路由調整和流量變動,但修改BGP配置可能導致DCN-PE 的鄰居重置,可能引起業務閃斷,建議逐個平面操作。

3.1 業務接入通用配置

(1)配置VPN模板

配置設備:DCI所有LF1設備和LF2設備,兩種設備具體配置相同

配置vrf BSS以及import和export route-target值

配置vrf OSS以及import和export route-target值

配置router bgp ,啟用address-family l2vpn evpn,配置bgp implicit-import

l2vpn evpn 下,配置vrf BSS 以及rd以及redistribute connected

l2vpn evpn 下,配置vrf OSS 以及rd以及redistribute connected

(2)配置接口

配置設備:DCI所有LF1設備和LF2設備,兩種設備具體配置相同

配置聚合口Bundle-Ether100

配置子接口Bundle-Ether100.100和Bundle-Ether100.200,設定二層l2transport

配置物理接口TenGigE0/0/0/10和TenGigE0/0/0/11,加入聚合口Bundle-Ether100

配置BVI100,設定vrf BSS以及接口地址

配置BVI200,設定vrf OSS以及接口地址

(3)配置EVPN

配置設備:DCI所有LF1設備和LF2設備,兩種設備具體配置相同

在evpn 下,配置evi 100 的bgp,設置import 和export route-target值,并開啟廣播advertise-mac

在evpn 下,配置evi 200 的bgp,設置import 和export route-target值,并開啟廣播advertise-mac

(4)配置L2VPN

配置設備:DCI所有LF1設備和LF2設備,兩種設備具體配置相同

l2vpn evpn 下,配置bridge group GRP-BSS 和bridge-domain BD-BSS

在Bundle-Ether100.100 下將BVI100 的routed 目的指向evi 100

l2vpn evpn 下,配置bridge group GRP-OSS 和bridge-domain BD-OSS

在Bundle-Ether100.200 下將BVI200 的routed 目的指向evi 200

要完成虛擬機的跨資源池遷移,首先需利用虛擬數據中心VDC 技術,然后需要在主備spine 與各leaf 節點間建立BGP鄰居。

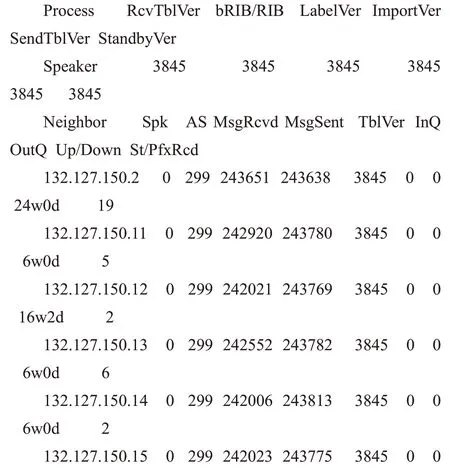

RP/0/RP0/CPU0:DCI-C1-GDGZ-N5508-XSK#show bgp l2vpn evpn summary

Sun Oct 31 17:05:44.635 UTC

BGP router identifier 132.127.150.1, local AS number 299---spine1地址

BGP generic scan interval 60 secs

Non-stop routing is enabled

BGP table state:Active

Table ID:0x0 RD version:0

BGP main routing table version 3845

BGP NSR Initial initsync version 10(Reached)

BGP NSR/ISSU Sync-Group versions 3845/0

BGP scan interval 60 secs

BGP is operating in STANDALONE mode.---spine1 上看到7個BGP鄰居信息

3.2 OptionA的實現方式

首先需配置IP 地址,根據表2 端口互聯與IP 地址分配表,在PE 和leaf 節點配置接口IP 地址。然后需配置BGP 路由策略:

配置設備:XSK-PE1 和XSK-PE2(策略按需調整),兩種設備具體配置相同

配置從DCI 網絡收取BSS 域路由的策略Route-policy Fr-DCI-BSS

配置向DCI 網絡發布BSS 域路由的策略Route-policy To-DCI-BSS

配置從DCI 網絡收取OSS 域路由的策略Route-policy Fr-DCI-OSS

配置向DCI 網絡發布OSS 域路由的策略Route-policy To-DCI-OSS

配置設備:XSK-LF1 和XSK-LF2(策略按需調整),兩種設備具體配置相同

配置從DCN 網絡收取BSS 域路由的策略Route-policy Fr-DCN-BSS

配置向DCN 網絡發布BSS 域路由的策略Route-policy To-DCN-BSS

配置從DCN 網絡收取OSS 域路由的策略Route-policy Fr-DCN-OSS

配置向DCN 網絡發布OSS 域路由的策略Route-policy To-DCN-OSS

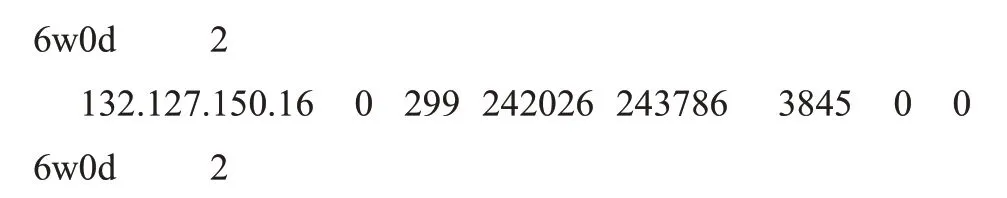

根據網絡設計,在PE和leaf節點配置BGP鄰居;兩個資源池是先后建立的,由于規劃的原因,它們使用的VLAN 是不同的。例如擬定為SSH 節點使用的VLAN112,再使用VLAN112部署在XSK節點,虛擬機部署成功后,網絡是不通的,因此,首先需要將測試VLAN導入到EVPN中。同時,虛擬機網絡使用內網VLAN112,物理機主機由Bond 聚合網絡組成,通過對不同資源池建立相同內網VLAN,由物理主機聚合網絡建立傳輸遷移介質,實現異地遷移從而達到異地容災的效果。資源池虛擬網絡信息如表3所示。

表3 資源池虛擬網絡配置詳情

3.3 測試VLAN虛擬網關的優化

配置分布式網關:

配置設備:XSK-PE1 和XSK-PE2(策略按需調整),兩種設備具體配置相同

配置子接口Bundle-Ether100.112,包含vlan112

配置物理接口FortyGigE0/0/0/12 和FortyGigE0/0/0/13,加入聚合口Bundle-Ether100

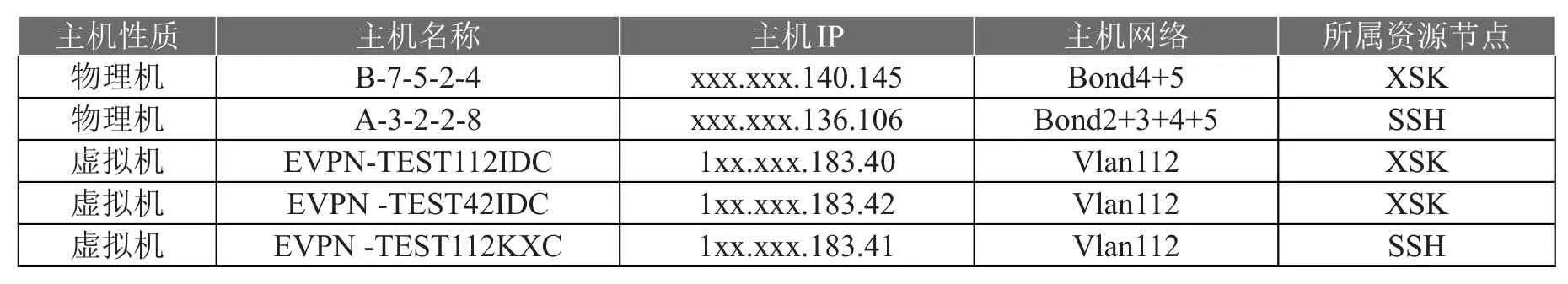

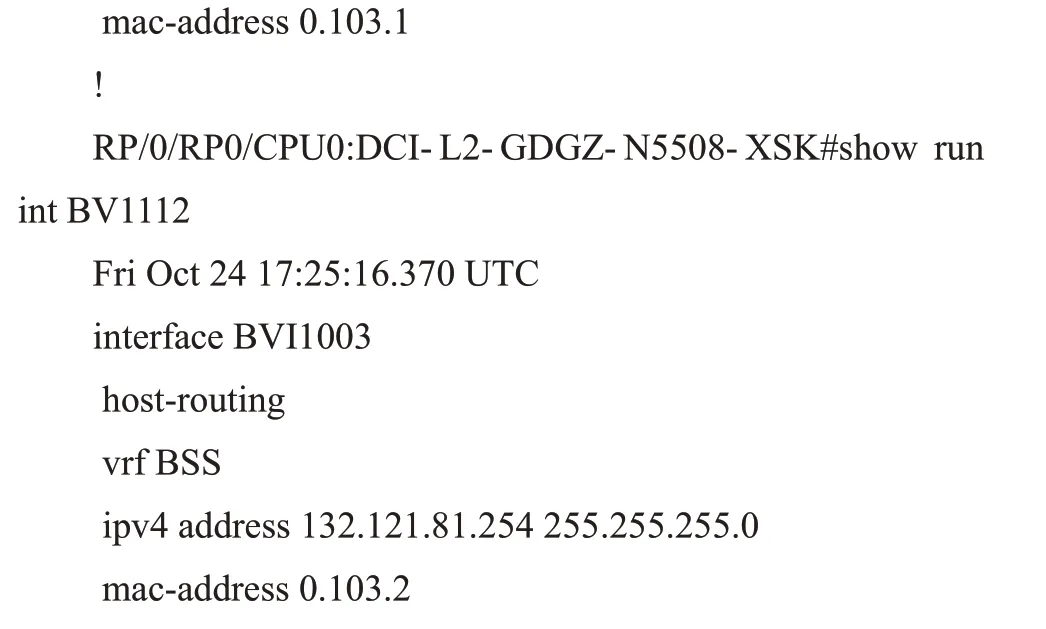

配置BVI112,設定vrf BSS以及網關地址130.51.9.x54和mac-address 0.112.1

在evpn 下,配置evi 112 的bgp,設置rd 209:102,import和export route-target 值都為209:112,并開啟廣播advertisemac

l2vpn evpn下,配置bridge group backup-system和bridgedomain backup-system

在Bundle-Ether100.112 下將BVI112 的routed 目的指向evi 112

為了方便測試,承載網絡將測試VLAN112 放通上層交換,同時虛擬機根據其所屬資源池通過虛擬網關與外界通信。由于需要將兩個資源池同時運行HSRP并設定相同的網關,要求網絡實現兩邊雙Active。

實現原理如下:通過在4 臺Leaf 設備上配置限制HSRP的VMAC、Hello 報文、ARP 解析,使HSRP 不會在SSH、XSK隨VLAN 互相透傳而達到隔離效果,最終實現兩邊雙Active。兩邊資源池(SSH、XSK)對于測試VLAN112,生成同一HSRP:132.121.81.254。

綜上所述,經驗證可以進行虛擬機遷移測試。

4 虛擬機遷移測試及經驗總結

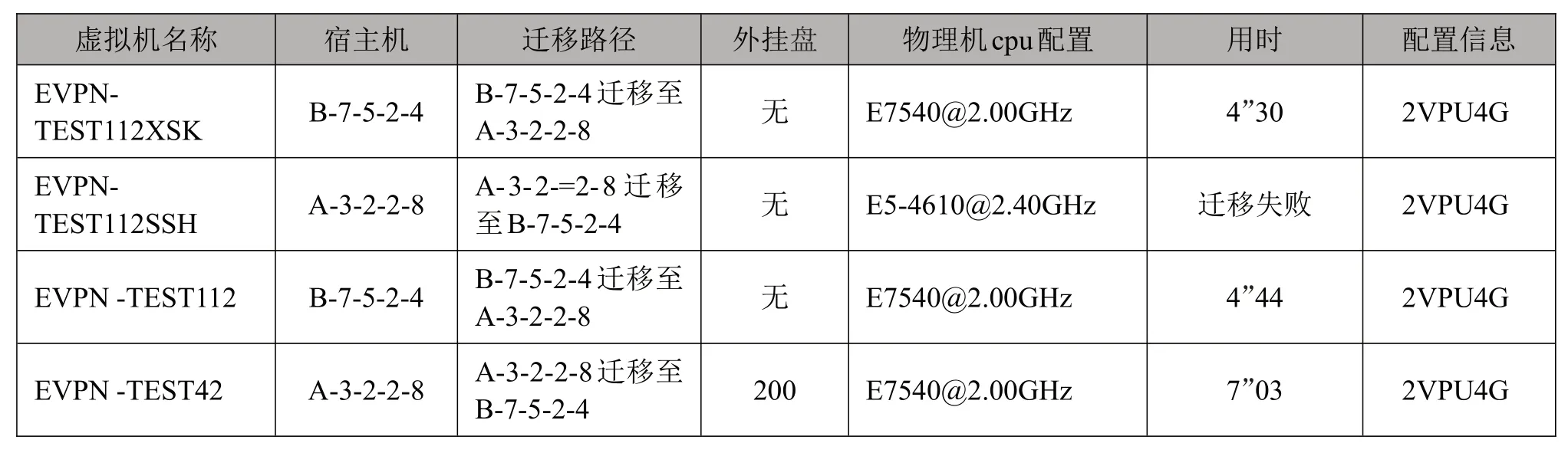

4.1 虛擬機跨資源池遷移

虛擬機原部署在CPU主頻較高的物理機向CPU主頻較低的物理上遷移,可成功,反向輕易也可成功。虛擬機原部署在CPU主頻較低的物理機向CPU主頻較高的物理機上遷移,無法實現跨池遷移。

4.2 虛擬機帶盤遷移測試

帶data 盤(200GB)的虛擬機遷移,用時7 分03 秒;裸機(不帶data盤,只有OS盤60GB)遷移虛擬機用時4分44秒。

測試具體結果如表4所示。

表4 遷移測試結果詳情

5 結語

通過在兩個leaf 節點分別建立兩個ID 相同的測試VLAN 和HSRP 默認網關,并部署兩臺測試虛擬機。在驗證網絡通訊正常后,SSH和XSK節點虛擬機在線雙向遷移測試均獲得成功。

本次測試驗證了DCI 技術在實現云平臺跨節點資源部署、異地遷移容災的功能,為后續廣東聯通云平臺新業務部署提供了強有力的支撐。

具體體現有如下幾點:

(1)解決了東西向的網絡流量的業務需求如:數據中心遷移和技術升級、數據中心POD之間的互聯、多站點之間的集群、東西向流量的牽引(比如firewall bypass)、新的業務類型如大數據可能帶來的不規律的浪涌流量;

(2)云平臺網絡資源無需考慮分配節點,打破局域網絡的現狀,網絡使用無局限;

(3)云平臺硬件資源打破異地的束縛,系統擴容、新增更加自由;

(4)云平臺業務系統平臺異地化,資源部署節點、服務器可以跨資源池資源域進行,能夠更加合理利用可用資源;

(5)較好實現云平臺異地容災的目的,通過此技術,業務系統冗余備份節點多樣化使得業務系統能夠在資源域中切換主備,大大降低了業務系統由于宕機或者網絡問題而影響業務的可能性;多數據中心高可用性和應用冗余(應用級熱備份數據中心)。

同時,實踐中也發現,虛擬機跨資源池遷移和管理存在一定的弊端,主要體現以下三點:

(1)由于DCI 主要用于跨機房容災和虛擬機遷移,實現配置自動化對云管平臺的兼容性要求較高,還涉及網絡控制器和云管平臺的對接;

(2)傳統資源分配的方式被打破,在業務系統分配資源時,需要考慮各資源池的網絡傳輸,要是物理機之間的網絡聚合不一致,可能會影響業務系統虛擬機之間的通訊質量及網絡傳輸速率;

(3)業務系統沒有資源域之分,資源信息相對比較紊亂,虛擬機等相關臺賬管理的難度加大。

下一步工作需推進數據中心網絡具備云網融合能力,通過部署云管平臺、SDN 控制器等,滿足云網絡自動開通、靈活部署、智能管控新型業務需求。