全景透視多模態學習分析的數據整合方法

穆肅 崔萌 黃曉地

摘要:多模態學習分析被認為是學習分析研究的新生長點,其中,多模態數據如何整合是推進學習分析研究的難點。利用系統文獻綜述及元分析方法,有助于為研究和實踐領域提供全景式的關于多模態數據整合的方法與策略指導。通過對國內外363篇相關文獻的系統分析發現:(1)多模態學習分析中的數據類型主要包含數字空間數據、物理空間數據、生理體征數據、心理測量數據和環境場景數據等5類。在技術支持的教與學環境中,高頻、精細、微觀的多模態學習數據變得可得、易得、準確。(2)多模態學習分析中的學習指標主要有行為、注意、認知、元認知、情感、協作、交互、投入、學習績效和技能等。隨著技術的發展和人們對學習過程的深刻洞察,學習指標也會變得更加精細化。(3)數據與指標之間展現出“一對一”“一對多”和“多對一”三種對應關系。把握數據與指標之間的復雜關系是數據整合的前提,測量學習指標時既要考慮最適合的數據,也要考慮其他模態數據的補充。(4)多模態學習分析中的數據整合方式主要有“多對一”“多對多”和“三角互證”三種,旨在提高測量的準確性、信息的全面性和整合的科學性。總之,多模態數據整合具有數據的多模態、指標的多維度和方法的多樣性等三維特性。將多模態數據時間線對齊是實現數據整合的關鍵環節,綜合考慮三維特性提高分析結果的準確性是多模態數據整合未來研究的方向。

關鍵詞:多模態學習分析;數據類型;學習指標;數據整合;系統文獻綜述

中圖分類號:G434? ?文獻標識碼:A? ? 文章編號:1009-5195(2021)01-0026-13? doi10.3969/j.issn.1009-5195.2021.01.003

基金項目:2018年度國家社科基金重大項目“信息化促進新時代基礎教育公平的研究”(18ZDA334)子課題“面向基礎教育精準幫扶的無縫學習體系研究”。

作者簡介:穆肅,教授,博士生導師,華南師范大學教育信息技術學院(廣東廣州 510631);崔萌(通訊作者),博士研究生,華南師范大學教育信息技術學院(廣東廣州 510631);黃曉地,副教授,澳大利亞查爾斯特大學計算機與數學學院(澳大利亞新南威爾士州奧爾伯里 2640)。

一、研究背景與問題

傳統的學習分析數據源通常是單維或單一模態的(Schwendimann et al.,2017),例如學習管理平臺(Learning Management System,LMS)記錄的學生日志數據。但是,并不是所有的學習過程都發生在LMS中,數據也不都是字符或數字,因而很多LMS之外的學習情況并沒有被記錄,但它們對于了解學習過程卻非常重要。同時,由于單維或單一模態數據僅能提供部分學習過程信息(Eradze et al.,2017),容易產生“路燈效應”,有可能會降低分析結果的準確性。而真實的學習過程往往是復雜多維的(Di Mitri et al.,2018),有可能是多平臺、多場所、多方式的混合。因此,為了更全面準確地了解學習過程,研究者必須盡可能收集學習過程中的聲音、視頻、表情、生理等多模態數據(牟智佳,2020)。

在此背景之下,多模態學習分析(Multimodal Learning Analytics,MMLA)成為學習分析領域新的研究分支(Blikstein,2013;Di Mitri et al.,2018)。多模態學習分析以學習機理為核心,利用多種分析技術對復雜學習過程中的多模態數據進行同步采集和整合處理,旨在全面準確地對學習特點和規律建模,為教與學提供支持(Worsley,2018)。多模態學習分析是典型的交叉學科研究,涉及教育技術、計算機科學、學習科學等多個學科領域(Di Mitri et al.,2018)。數據整合是多模態學習分析的重難點所在(張琪等,2020;Samuelsen et al.,2019),系統地理清數據整合的研究現狀具有重要意義。為此,本研究聚焦多模態學習分析中的數據整合問題,用系統文獻綜述方法進行相關文獻綜述,聚焦如下三個研究問題:

第一,多模態學習分析中的數據類型有哪些?學習指標有哪些?第二,數據與指標之間的對應關系如何?第三,多模態學習分析中數據整合的主要方式、關鍵環節以及主要特征有哪些?

二、研究設計與過程

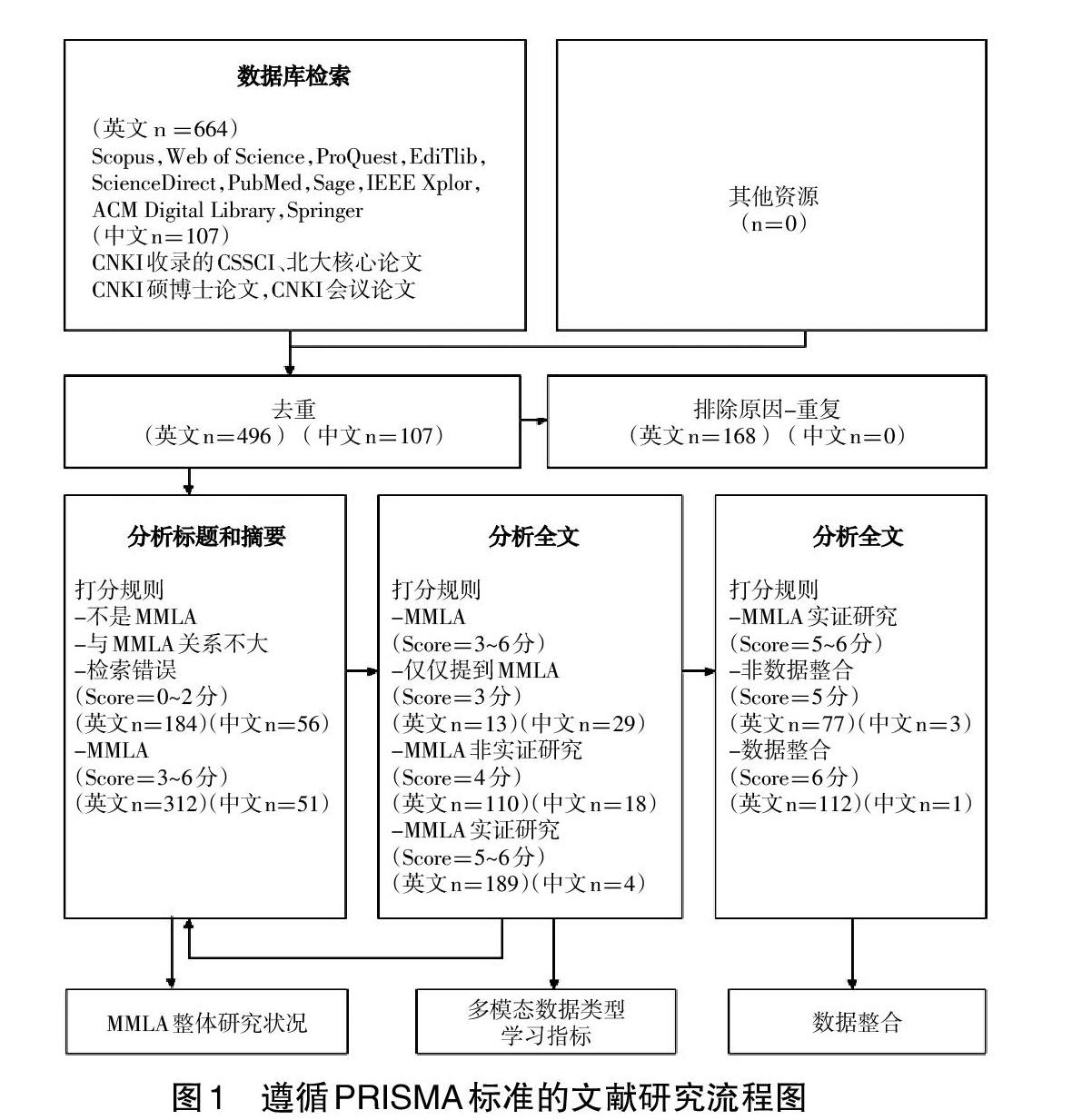

本研究遵循系統文獻綜述及元分析方法(Preferred Reporting Items for Systematic Reviews and Meta-Analyses,PRISMA)的研究理路進行文獻綜述。該方法是國際上常用的基于文獻證據的系統性綜述方法(Moher et al.,2009),其有標準化的文獻綜述流程和詳細的過程審查列表。根據PRISMA的流程和審核要求,本研究制定了如圖1所示的文獻分析流程。

文獻分析過程包括5個階段。第一是文獻檢索階段,即檢索與多模態學習分析相關的中英文文獻。第二是內容相關度評分階段,即運用制定的評分策略對文獻進行評分,將與多模態學習分析不相關文獻賦分為0~2分,將相關文獻賦分為3~6分。第三是初步分類階段,該階段將相關文獻分成三類:(1)提及多模態學習分析,(2)多模態學習分析的理論探討,(3)多模態學習分析的實證研究。第四是實證類研究分析階段,即通過對實證研究論文的分析找出多模態學習分析中的數據類型和學習指標,同時辨別出進行數據整合的論文。第五是數據整合情況的綜合分析階段,即聚焦數據整合的實證研究論文,整理其數據整合的方法和方案。

多模態學習分析整體研究現狀如圖2所示。圖中數據顯示,中文文獻(不限年份且相關度≥3的文獻有51篇)遠少于英文文獻(限定年份2017年之后且相關度≥3的文獻有312篇)。在“提及多模態學習分析”“多模態學習分析的理論研究”“多模態學習分析的實證研究”三類文獻的數量分布上,中文文獻分別有29篇、18篇和4篇,英文文獻分別有13篇、110篇和189篇。這表明國內多模態學習分析的研究更關注引介和理論探討;而國外對多模態學習分析的理論探討和實證研究都很重視。在研究內容方面,多模態學習分析的實證研究涉及“數據整合”與“非數據整合”的數量分別為:中文1篇與3篇、英文112篇與77篇,可見當前國際研究更加關注多模態學習分析中的數據整合。從檢索到的文獻來看,目前不論國內還是國外都沒有關于多模態數據整合分析的綜述文章,為此,為了給正在進行或有興趣開展這一領域研究的同行提供一個全面、有深度的全景分析,本研究對多模態數據整合分析的文獻進行系統分析并形成了元分析報告。

三、多模態學習分析中的數據類型、學習指 標及其對應關系

1.多模態學習分析中的數據類型

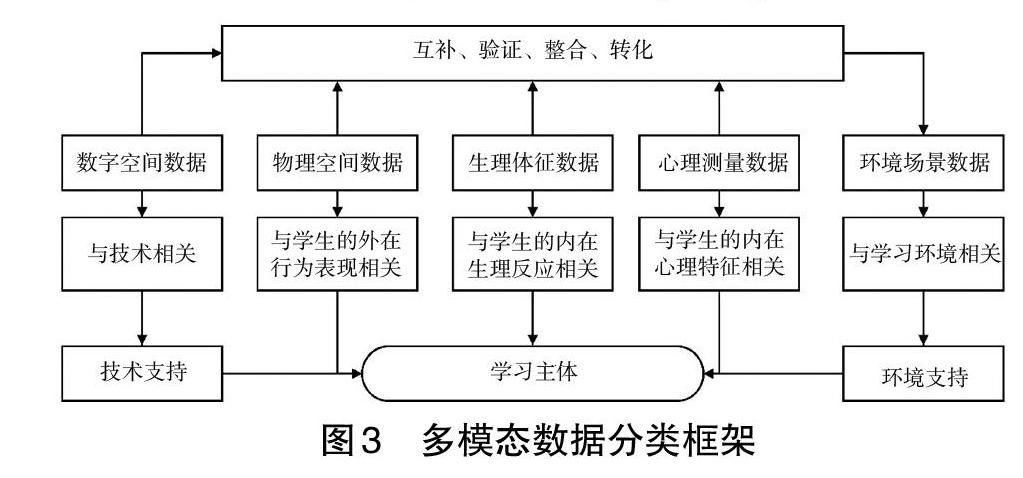

現有的多模態學習分析研究大都關注到“多模態數據類型”,但數據分類不盡相同。比較典型的數據分類有:(1)行為數據(如運動模態、生理模態)和情景數據(Di Mitri et al.,2018);(2)學習體征數據、人機交互數據、學習資源數據和學習情境數據(牟智佳,2020);(3)外顯數據、心理數據、生理數據和基礎數據(陳凱泉等,2019);(4)生理層數據、心理層數據、行為層數據和基本信息數據(鐘薇等,2018)。現有的數據分類結果各有優劣,大多數屬于理論總結。本研究嘗試從現有的實證研究中總結數據類型,并結合理論上的分類總結最終形成了如圖3所示的多模態數據分類框架。同時,本研究也列出了多模態數據分類編碼及其對應的實證研究文獻支撐(見表1)。為便于編碼分析,本研究除使用各類數據名稱常規的英文縮寫外,對沒有常規縮寫的數據名稱采用英文單詞首字母縮寫方式。例如,Electroencephalogram的常規縮寫為EEG,Body Language沒有常規縮寫,故將其縮寫為BL。

該分類框架根據數據產生的場域將多模態數據分為數字空間數據(Di Mitri et al.,2018)、物理空間數據(Martinez-Maldonado et al.,2018)、生理體征數據(Yin et al.,2017)、心理測量數據、環境場景數據(Di Mitri et al.,2019)5類。其中,(1)數字空間數據是指由技術平臺記錄的、在學習中產生的各類數字痕跡,如在線學習平臺(Monkaresi et al.,2017)、虛擬實驗平臺(Liu et al.,2019)、STEAM教育軟件(Spikol et al.,2018)平臺上學生進行操作的行為數據。(2)物理空間數據是指由各類傳感器獲得的、與人的外在可見行為表現相關的數據,如身體各部分在物理空間中的運動變化和位置等。伴隨傳感器技術的發展,能夠獲得且被應用到學習分析中的身體數據越來越細化,如頭部移動的角度(Cukurova et al.,2020)和手指在平板電腦上的移動數據等(Duijzer et al.,2017)。物理空間數據感知與分析對學習過程的解讀具有重要意義(劉智等,2018;Martinez-Maldonado et al.,2018),現已形成重要的研究分支,如具身認知理論與行為研究(Ibrahim-Didi et al.,2017)。(3)生理體征數據是指反映人的內在生理體征的數據,包括眼動、腦電、皮電、心電等,能夠更加客觀地反映在線學習的狀態(Yin et al.,2017)。(4)心理測量數據是指各類自我報告數據,能夠主觀反映學習者的心理狀態,是比較傳統的學習狀態數據來源。(5)環境場景數據是指學習者所處學習場景的環境數據,如溫度、天氣等。已有研究表明,學習環境對學習有不同程度的影響(Di Mitri et al.,2018),增加環境數據分析是多模態學習分析的趨勢之一。因此,如何獲取以上類型的多模態數據、合理利用這些數據、解釋描述學習狀態、根據分析結果為學習者提供相應學習服務已成為研究者面臨的現實問題(劉智等,2018)。

得益于物聯網、傳感器、可穿戴設備、云存儲以及大數據高性能計算等的發展,分布在每個空間里的各類高頻、精細、微觀的學習過程數據將得以準確獲取。由于多模態數據更能反映學生真實的學習狀態(Di Mitri et al.,2018),因此在進行多模態數據分析時,更應考慮多空間或單個空間里的多種模態數據,尤其在一些實踐性強的課程中更是如此。例如在教學過程中,學生通過表情、語言、肢體動作等多種方式與教學內容、學習同伴、教師和媒體平臺等進行交互,各類交互的數據對學習過程分析至關重要,需要全方位的有效獲取并整合。

各種類型數據可以實現互補、驗證、整合和轉化。數據互補性是多模態數據很重要的一個特性。任何一種模態的數據都能提供關于某一現象或過程的部分解釋,而這些解釋從其他模態的數據中可能無法獲得(鐘薇等,2018)。數據互補可通過不同數據來說明、描述或解釋同一研究對象和內容,有利于交互證實所得出的結果(Di Mitri et al.,2018)。除此之外,多模態數據整合可以充分利用各類數據的特點對學習過程或學習狀態進行更加全面而準確的分析,如將身體的移動、手勢等物理空間里的數據與數字平臺中的日志數據進行同步存儲,以便用于對學習過程的分析(Di Mitri et al.,2018)。數據轉化是指將一種空間中的數據轉化為另一空間的數據,如將物理空間數據轉化為數字空間數據(牟智佳,2020)。典型的研究有通過智能書寫筆技術將學生真實的書寫過程數字化,通過動態書寫特征數據預測學習績效(Oviatt et al.,2018);還有研究將學生復習紙質試卷的過程數字化,形成數字痕跡和數字腳注,以便用于分析真實的復習行為(Paredes et al.,2018)。這類研究的優勢在于能夠將學生學習最為真實的行為和狀態數據進行技術化處理,從而幫助人們更加深入地認識復雜的學習過程。

2.多模態學習分析中的學習指標

研究發現,多模態學習分析中所應用的學習指標主要包括行為、注意、認知、元認知、情感、協作(Cukurova et al.,2017)、交互(Schneider et al.,2018)、投入(張琪等,2019)、學習績效和技能等。部分學習指標還可進一步細化分類。例如,行為指標可分為在線學習行為(Oviatt et al.,2018;Paredes et al.,2018)、課堂學習行為(Watanabe et al.,2018)、具身學習行為(Gorham et al.,2019)、教師教學行為(Watanabe et al.,2018)等。注意指標可分為個人注意(Mudrick et al.,2019)和聯合注意(Sharma et al.,2019)。情感指標可分為自主學習中的情感(Munshi et al.,2019)和協作學習中的情感(Martin et al.,2019)。協作指標可分為面對面協作(Ding et al.,2017)和遠程協作(Andrade et al.,2019)。投入指標可分為在線自主學習投入(Monkaresi et al.,2017)和課堂學習投入(Aslan et al.,2019)。學習績效指標可分為結果性績效和過程性績效,既可涉及考試成績(Sriramulu et al.,2019;Dindar et al.,2020)、游戲得分(Giannakos et al.,2019)等較為簡單的數據,還可涉及協作學習質量、任務得分和學習效果(Dich et al.,2018)等復雜多元的數據。

從已有研究對學習指標的分析可知,學習指標的種類繁多證實了學習過程的復雜性。部分學習指標之間含義重疊交叉,如既可單獨分析協作(Reilly et al.,2018)和投入(Monkaresi et al.,2017),也可分析協作學習中的投入(Kim et al.,2020)。值得注意的是,學習指標的選擇也有一些規律可循,如協作學習的指標多關注協作特征(Cukurova et al.,2020)和協作交互(Malmberg et al.,2019),而自主學習指標則多關注注意、認知(Abdelrahman et al.,2017)和投入(Fwa et al.,2018);面對面協作的指標較多(Ding et al.,2017),而遠程協作的指標相對較少(DAngelo et al.,2017)。隨著學習過程洞察研究愈加深入,學習指標也會更加細致。例如針對在線學習,有研究者深入到微觀角度,利用眼動數據關注學習者在每個學習頁面中的學習路徑(Mu et al.,2019)。

3.多模態數據與學習指標的對應關系

多模態數據指向復雜的學習過程,能夠揭示數據和指標之間的復雜關系(Oviatt,2018)。從前文分析可知,數據與指標之間存在三種對應關系:一對一、多對一和一對多。“一對一”是指一類數據只適合度量一個學習指標,此類對應最為簡單且應用較為普遍。隨著研究的深入和技術的發展,數據分析的細粒度逐步增加(張琪等,2020),每一類數據的測量潛力被逐步挖掘,一對一的情況將越來越少。例如,傳統的認知過程測量方法是訪談和量表,而當生理測量技術發展起來之后,生理數據如腦電也被用于認知測量(Mills et al.,2017),由此便產生了第二類對應關系。“多對一”是指多個數據均可度量同一指標。例如,眼動、腦電和皮電都可用于測量學習投入(Sharmaet al.,2019)。“一對多”是指一類數據可度量多個學習指標。例如,眼動可以測量注意、認知(Sommer et al.,2017)、情感(Zheng et al.,2019)、協作和投入(Thomas,2018)等。

在數據和指標的對應關系中,一對多和多對一的情況已較為普遍。數據與指標之間對應關系多樣化的本質原因在于,在技術條件和相關理論的支持下,數據的測量范圍、測量準確性和對指標的表征能力有所差別。例如,眼動數據用于學習內容關注焦點的挖掘效果較好(Mu et al.,2018),在量化學習者認知狀態、注意力水平、信息加工過程(Minematsu et al.,2019)等方面具有優勢。表情數據對情感(Tzirakis et al.,2017)和投入(Thomas,2018)的測量效果較好,它對強烈的情感(如“喜悅”和“生氣”)有較好的測量效果。生理數據對微妙情感有較好的測量效果(Pham et al.,2018)。已有研究明確指出,一個學習指標既可用單一數據測量,也可用多模態數據測量(張琪等,2020;Pham et al.,2018)。因此,學習指標測量既要考慮到最優數據,也要考慮到其他數據的補充,這正是數據整合的意義所在。

四、多模態學習分析中的數據整合

為了進一步挖掘學習分析層面的數據融合情況,本研究從數據整合方式、數據類型、學習指標三方面對多模態數據整合分析的研究文獻進行了歸納。由表2可知,已有文獻中的數據整合方式既有跨類型的多模態數據整合,例如跨越數字空間數據和物理空間數據整合(Alyuz et al.,2017),跨越心理測量數據和生理體征數據整合(Dindar et al.,2020);也有非跨類型的多模態數據整合,例如生理體征數據類型中對具體數據的整合(Yin et al.,2017)。對于學習指標,數據整合既有關注單一指標的,如學習投入度(Thomas,2018);也有同時關注多個指標的,如同時關注協作、投入和學習績效(Worsley et al.,2018)。現有的數據整合方式主要有三類(見圖4):(1)多對一,即用多維度、多模態數據測量一個學習指標,以提高測量的準確性;(2)多對多,即用多維度、多模態數據測量多個學習指標,以提高信息的全面性;(3)三角互證,即通過多方數據互相印證來提高對某一問題闡釋的合理性,是進行整合研究的實證基礎。對比三類整合研究可發現,與單模態數據相比,數據整合的價值體現在整合能夠提高測量的準確性和信息的全面性,并帶來更有意義的研究結論,從而起到“1+1>2”的效果。只有做到“多對一”分析才算真正走向了數據整合。

1. “多對一”:提高測量的準確性

此類數據整合主要有兩大特點:一是有明確的數據整合算法模型,多模態數據(兩類以上)是模型輸入,學習指標(通常只有一個)是模型輸出。二是數據整合有助于提高學習指標測量的準確性。例如,聲音數據可以測情感(Cukurova et al.,2019),表情數據也可以測情感(Martin et al.,2019)。有研究用深度神經網絡算法將兩類數據進行整合,用以提高情感測量的準確性(Ez-zaouia et al.,2017)。

此類研究中,數據模態的增加、數據特征的選擇、數據整合比例劃分以及算法模型的選擇都會影響測量的準確性。有研究對比了單模態數據和多模態數據的研究效果,結果證明多模態數據的研究準確性較高(Cukurova et al.,2019)。在選擇用于分析的數據方面,有研究者直接選用原始數據進行分析(Tzirakis et al.,2017),也有研究者通過在原始數據基礎上篩選(Thomas et al.,2018)或構造與學習相關的數據進行分析,以期增加分析結果的教學可解釋性。值得注意的是,不同數據對同一學習指標測量的準確性有可能存在差異,例如有研究者證實了眼動和腦電數據在預測情感的準確性上就存在差異(Zheng et al.,2019)。總之,當采用“多對一”方式進行數據整合時,不是簡單的1:1整合,而是要根據各類數據的測量準確性、數據與學習指標的相關性等因素綜合采用數據和算法。高效的算法模型是此類研究的關注點(Tzirakis et al.,2017),大部分研究通常會對比幾種不同算法模型的應用效果,從而確定最優的算法模型。

2. “多對多”:提高信息的全面性

此類數據整合具有如下特點:一是包括多維度學習指標(兩個以上),二是數據與學習指標一一對應,三是沒有數據整合算法,四是數據整合能提高信息的全面性。例如,有研究者同時用眼動數據來測注意,用腦電數據來測認知(Tamura et al.,2019)。

多對多的數據整合分析需要多個學習指標,同時利用多方面的多模態數據進行整合分析,以期全面、準確地反映學習過程。當前能夠支持數據整合的分析系統有演講訓練系統(Schneider et al.,2019)、書寫訓練系統(Limbu et al.,2019)、醫學訓練系統(Di Mitri et al.,2019)、自然情景下的學習分析系統(Okada et al.,2020)、課堂監控整合系統(Anh et al.,2019)、跳舞訓練系統(Romano et al.,2019)等。現有研究中有不少是用一種數據來測量和分析多個學習指標,如用眼動數據來測量注意、期望和疲倦三個指標,用腦電數據來測量認知負荷、心理負荷和記憶負荷三個指標(Sharmaet al.,2019)。顯然,只用一種數據來同時測量多個指標會過于夸大單一數據的作用,在一定程度上也會降低結果解釋的準確性。因此,在條件允許的情況下,應盡量為每一個學習指標選擇最適合的數據。

3.三角互證:提高整合的科學性

數據整合的三角互證研究旨在通過多模態數據之間的互證分析來獲得更多有價值的結論。在已有研究中,對各種數據的分析是單獨和平行的,即用不同數據同時測量同一指標,通過對比分析不同數據對同一學習指標的測量效能,為“多對一”和“多對多”的數據整合研究提供實證依據。例如,有研究者收集了多模態數據進行協作學習分析(Starr et al.,2018),單獨分析了每一類數據對協作的測量情況,包括語言數據如何反應協作情況(Reilly et al.,2019),人體姿態中哪些數據能夠體現協作(Reilly et al.,2018),眼動數據如何測量協作(Schneider et al.,2019),生理數據如何反應協作時的狀態變化(Schneider et al.,2020)。也有研究者單獨分析了自我報告數據和眼動數據對學習投入的測量情況(Limbu et al.,2019)。還有研究者注重分析各類數據之間的互證關系(J?rvel? et al.,2019),如有研究重點分析生理數據和表情數據之間的互證關系;還有研究關注協作學習中生理數據與情緒數據之間的互證關系,即當由生理數據得到的覺醒發生時,學生情緒(通過表情數據測量得到)是如何變化的(Malmberg et al.,2019)。

4.整合方式的補充

以上是目前已開展的多模態數據整合的主要方式,隨著研究的深入和技術的發展,未來數據整合的方式將會更加豐富多樣。例如,在對學習過程進行分析時,可以根據不同的學習環境、階段和學習內容,選擇不同維度和類型的數據進行分析,然后整合形成完整的學習過程分析,這也是一種數據整合分析的思路(Mu et al.,2018)。在對在線學習過程進行分析時,有研究者先用日志數據對整體學習軌跡的時間線進行分析,根據具體學習階段確定需要深入分析的焦點時刻,然后用學習過程的錄屏視頻數據和語音數據對焦點時刻進行詳細分析(Liu et al.,2019)。再如,有研究者先用日志數據對整體學習路徑進行描述,然后用眼動數據和記錄學習過程的視頻數據對學習者觀看教學視頻和在線練習兩個關鍵學習環節進行微觀分析,從而實現對學習者學習過程的細致畫像(Mu et al.,2019)。

需要說明的是,同步采集不同時間和不同粒度的多模態數據是有效開展數據整合的前提,這就需要通過部署數據同步采集系統來實現。數據整合系統通常包含表情分析模塊(Thomas,2018)、VR模塊(Schneider et al.,2019)、人體姿態模塊(Zaletelj et al.,2017)和自我報告模塊等。如果在采集數據時沒能實現多模態數據的同步采集,則需要在數據清理時以時間為基線對各類數據進行時間線對齊處理。例如,STREAMS系統可將符合格式要求的日志數據與其他多模態數據進行整合處理(Liu et al.,2019)。可見,“時間線對齊”是數據整合的關鍵環節之一,也是數據清洗和整理的重點。

總之,數據整合分析既是多模態學習分析的核心,也是難點。多模態數據獲取相對容易,但真正整合起來進行分析則存在較多困難,而且費時費力(Liu et al.,2019)。另外,數據的整合采集也并不意味著一定存在整合分析,有些研究雖然利用了數據整合采集系統,如演講訓練系統(Schneider et al.,2019),但在具體分析中也只選擇了單一維度的數據進行分析,而并未做到基于多模態數據的整合分析。

五、總結與展望

多模態數據整合分析研究的特點可歸納為三點:數據的多模態、指標的多維度和方法的多樣性,如圖5所示。數據的多模態是最直觀的外在表現(X軸),指標的多維度體現了學習過程的復雜性(Y軸),方法的多樣性體現了分析技術的特點(Z軸)。現有的數據整合研究或考慮數據的準確性(A點),或考慮信息的全面性(B點),但最理想的應是準確性、全面性和多樣性共同作用下的分析,即C點。本研究認為,未來的數據整合需要不斷提高測量準確性和信息全面性,不斷建立有效的分析方法,以更智能、高效、準確、全面地反映學習者的學習過程,呈現學習者的學習狀態和規律,進而改進教與學的效果。例如,可以用眼動和行為數據共同測量認知,用表情數據且通過人工判斷和機器識別兩種方法整合測量情感,用訪談獲取元認知自省數據和用自我報告測量動機水平(Munshi et al.,2019)。

總體而言,多模態學習分析不僅關注收集各種類型的數據,而且注重對各類數據的整合分析,以期更準確、全面地體現學習過程的復雜性(鐘薇等,2018)。各類感知設備和技術將在無感情況下,獲取更多學習數據,豐富數據類型;對學習發生機理、腦科學和學習科學最新研究進展的教育追問將促進學習指標的持續更新;同時隨著指向學習指標的多模態數據整合分析技術的不斷發展,人工智能技術將為數據分析提供技術支撐(牟智佳,2020),并不斷提升數據整合分析的能力。因此,未來多模態學習分析如能緊緊把握數據整合這一難點問題并不斷嘗試新的解決方法和技術,將能凸顯數據多維整體、真實境脈、實時連續的優勢,實現對教學過程和教學效果更加即時、多維、直觀、全面的分析。

參考文獻:

[1]陳凱泉,張春雪,吳玥玥等(2019). 教育人工智能(EAI)中的多模態學習分析、適應性反饋及人機協同[J]. 遠程教育雜志, 37(5):24-34.

[2]劉智,劉三

[3]牟智佳(2020). 多模態學習分析:學習分析研究新生長點[J]. 電化教育研究, 41(5):27-32,51.

[4]張琪,王紅梅(2019). 學習投入的多模態數據表征:支撐理論、研究框架與關鍵技術[J]. 電化教育研究, 40(12):21-28.

[5]張琪,武法提,許文靜(2020). 多模態數據支持的學習投入評測:現狀、啟示與研究趨向[J]. 遠程教育雜志, 38(1):76-86.

[6]鐘薇,李若晨,馬曉玲等(2018). 學習分析技術發展趨向——多模態數據環境下的研究與探索[J]. 中國遠程教育, (11):41-49,79-80.

[7]Abdelrahman, Y., Velloso, E., & Dingler, T. et al. (2017). Cognitive Heat: Exploring the Usage of Thermal Imaging to Unobtrusively Estimate Cognitive Load[J]. Proceedings of the ACM on Interactive, Mobile, Wearable and Ubiquitous Technologies, 1(3):1-20.

[8]Ahonen, L., Cowley, B. U., & Hellas, A. et al. (2018). Biosignals Reflect Pair-Dynamics in Collaborative Work: EDA and ECG Study of Pair-Programming in a Classroom Environment[J]. Scientific Reports, 8(1):1-16.

[9]Alyuz, N., Okur, E., & Genc, U. et al. (2017). An Unobtrusive and Multimodal Approach for Behavioral Engagement Detection of Students[C]// Proceedings of the 1st ACM SIGCHI International Workshop on Multimodal Interaction for Education. UK, Glasgow:26-32.

[10]An, P., Bakker, S., & Ordanovski, S. et al. (2020). Dandelion Diagram: Aggregating Positioning and Orientation Data in the Visualization of Classroom Proxemics[C]// Proceedings of the Extended Abstracts of the 2020 CHI Conference on Human Factors in Computing Systems. Honolulu, HI:1-8.

[11]Andrade, A., Maddox, B., & Edwards, D. et al. (2019). Quantitative Multimodal Interaction Analysis for the Assessment of Problem-Solving Skills in a Collaborative Online Game[C]// Eagan, B., Misfeldt, M., & Siebert-Evenstone, A. (Eds.). Proceedings of the Advances in Quantitative Ethnography. Madison, WI:281-290.

[12]Anh, B. N., Son, N. T., & Lam, P. T. et al. (2019). A Computer-Vision Based Application for Student Behavior Monitoring in Classroom[J]. Applied Sciences, 9(22):4729.

[13]Aslan, S., Alyuz, N., & Tanriover, C. et al. (2019). Investigating the Impact of a Real-time, Multimodal Student Engagement Analytics Technology in Authentic Classrooms[C]// Proceedings of the 2019 CHI Conference on Human Factors in Computing Systems(CHI19). UK, Glasgow:1-12.

[14]Asadipour, A., Debattista, K., & Chalmers, A. (2017). Visuohaptic Augmented Feedback for Enhancing Motor Skills Acquisition[J]. The Visual Computer, 33(4):401-411.

[15]Blikstein, P. (2013). Multimodal Learning Analytics[C]// Proceedings of the Third International Conference on Learning Analytics and Knowledge. Leuven, Belgium:102-106.

[16]Burnik, U., Zaletelj, J., & Ko?ir, A. (2018). Video-Based Learners Observed Attention Estimates for Lecture Learning Gain Evaluation[J]. Multimedia Tools and Applications, 77(13):16903-16926.

[17]Cukurova, M., Kent, C., & Luckin, R. (2019). Artificial Intelligence and Multimodal Data in the Service of Human Decision-Making: A Case Study in Debate Tutoring[J]. British Journal of Educational Technology, 50(6):3032-3046.

[18]Cukurova, M., Luckin, R., & Millán, E. et al. (2017). The NISPI Framework: Analysing Collaborative Problem-Solving from Students Physical Interactions[J]. Computers & Education, 116:93-109.

[19]Cukurova, M., Zhou, Q., & Spikol, D. et al. (2020). Modelling Collaborative Problem-Solving Competence with Transparent Learning Analytics: Is Video Data Enough?[C]// Proceedings of the Tenth International Conference on Learning Analytics & Knowledge.Germany,Frankfurt:270-275.

[20]DAngelo, S., & Begel, A. (2017). Improving Communication Between Pair Programmers Using Shared Gaze Awareness[C]// Proceedings of the 2017 CHI Conference on Human Factors in Computing Systems. Denver, CO:6245-6290.

[21]Davidsen, J., & Ryberg, T. (2017). “This Is the Size of One Meter”: Childrens Bodily-Material Collaboration[J]. International Journal of Computer-Supported Collaborative Learning, 12:65-90.

[22]Di Mitri, D., Schneider, J., & Specht, M. et al. (2018). From Signals to Knowledge: A Conceptual Model for Multimodal Learning Analytics[J]. Journal of Computer Assisted Learning, 34(4):338-349.

[23]Di Mitri, D., Schneider, J., & Specht, M. et al. (2019). Detecting Mistakes in CPR Training with Multimodal Data and Neural Networks[J]. Sensors, 19(14):3099.

[24]Dich, Y., Reilly, J., & Schneider, B. (2018). Using Physiological Synchrony as an Indicator of Collaboration Quality, Task Performance and Learning[M]// Penstein-Rosé C. et al. (Eds.). Artificial Intelligence in Education. Switzerland,Cham, Springer International Publishing. 10947:98-110

[25]Dindar, M., Malmberg, J., & J?rvel?, S. et al. (2020). Matching Self-Reports with Electrodermal Activity Data: Investigating Temporal Changes in Self-Regulated Learning[J]. Education and Information Technologies, 25(3):1785-1802.

[26]Ding, Y., Zhang, Y., & Xiao, M. et al. (2017). A Multifaceted Study on Eye Contact Based Speaker Identification in Three-party Conversations[C]// Proceedings of the 2017 CHI Conference on Human Factors in Computing Systems. Denver, CO:3011-3021.

[27]Duijzer, C. A. C. G., Shayan, S., & Bakker, A. et al. (2017). Touchscreen Tablets: Coordinating Action and Perception for Mathematical Cognition[J]. Frontiers in Psychology, 8:144.

[28]Edwards, A. A., Massicci, A., & Sridharan, S. et al. (2017). Sensor-Based Methodological Observations for Studying Online Learning[C]// Proceedings of the 2017 ACM Workshop on Intelligent Interfaces for Ubiquitous and Smart Learning. Limassol, Cyprus:25-30.

[29]Eradze, M., & Laanpere, M. (2017). Lesson Observation Data in Learning Analytics Datasets: Observata[C]// Proceedings of the 12th European Conference on Technology-Enhanced Learning (EC-TEL 2017). Tallinn, Estonia:504-508.

[30]Ez-zaouia, M., & Lavoué, E. (2017). EMODA: A Tutor Oriented Multimodal and Contextual Emotional Dashboard[C]// Proceedings of the Seventh International Learning Analytics & Knowledge Conference (LAK17). Canada, Vancouver:429-438.

[31]Fwa, H. L., & Marshall, L. (2018). Modeling Engagement of Programming Students Using Unsupervised Machine Learning Technique[J]. GSTF Journal on Computing, 6(1):1-6.

[32]Gan, T., Li, J., & Wong, Y. et al. (2019). A Multi-sensor Framework for Personal Presentation Analytics[J]. ACM Transactions on Multimedia Computing, Communications, and Applications, 15(2):1-21.

[33]Giannakos, M. N., Sharma, K., & Pappas, I. O. et al. (2019). Multimodal Data as a Means to Understand the Learning Experience[J]. International Journal of Information Management, 48:108-119.

[34]Gorham, T., Jubaed, S., & Sanyal, T. et al. (2019). Assessing the Efficacy of VR for Foreign Language Learning Using Multimodal Learning Analytics[M]// Giannikas, C. N., Kakoulli-Constantinou, E., & Papadima-Sophocleous, S. (Eds.). Professional Development in CALL: ASelection of Papers. France, Voillans: Research-publishing.Net:101-116.

[35]Hassib, M., Khamis, M., & Friedl, S. et al. (2017). Brainatwork: Logging Cognitive Engagement and Tasks in the Workplace Using Electroencephalography[C]// Proceedings of the 16th International Conference on Mobile and Ubiquitous Multimedia. Germany, Stuttgart:305-310.

[36]Healion, D., Russell, S., & Cukurova, M. et al. (2017). Tracing Physical Movement During Practice-Based Learning Through Multimodal Learning Analytics[C]// Proceedings of the Seventh International Learning Analytics & Knowledge Conference (LAK17). Vancouver, BC:588-589.

[37]Henrie, C. R., Bodily, R., & Larsen, R. et al. (2018). Exploring the Potential of LMS Log Data as a Proxy Measure of Student Engagement[J]. Journal of Computing in Higher Education, 30:344-362.

[38]J?rvel?, S., Malmberg, J., & Haataja, E. et al. (2019). What Multimodal Data Can Tell Us about the Students Regulation of Their Learning Process?[J]. Learning and Instruction, 101203.

[39]Junokas, M. J., Lindgren, R., & Kang, J. et al. (2018). Enhancing Multimodal Learning Through Personalized Gesture Recognition[J]. Journal of Computer Assisted Learning, 34(4):350-357.

[40]Kim, Y., Butail, S., & Tscholl, M. et al. (2020). An Exploratory Approach to Measuring Collaborative Engagement in Child Robot Interaction[C]// Proceedings of the Tenth International Conference on Learning Analytics & Knowledge. Germany, Frankfurt:209-217.

[41]Larmuseau, C., Vanneste, P., & Cornelis, J. et al. (2019). Combining Physiological Data and Subjective Measurements to Investigate Cognitive Load During Complex Learning[J]. Frontline Learning Research, 7(2):57-74.

[42]Ibrahim-Didi, K., Hackling, M. W., & Ramseger, J. et al. (2017). Embodied Strategies in the Teaching and Learning of Science[M]// Hackling, M. W., Ramseger, J., & Chen, H.-L.S. (Eds.). Quality Teaching in Primary Science Education: Cross-Cultural Perspectives.Cham, Switzerland,Springer International Publishing:181-221.

[43]Limbu, B. H., Jarodzka, H., & Klemke, R. et al. (2019). Can You Ink While You Blink? Assessing Mental Effort in a Sensor-Based Calligraphy Trainer[J]. Sensors, 19(14):3244.

[44]Liu, R., Stamper, J., & Davenport, J. et al. (2019). Learning Linkages: Integrating Data Streams of Multiple Modalities and Timescales[J]. Journal of Computer Assisted Learning, 35(1):99-109.

[45]Loup-Escande, E., Frenoy, R., & Poplimont, G. et al. (2017). Contributions of Mixed Reality in a Calligraphy Learning Task: Effects of Supplementary Visual Feedback and Expertise on Cognitive Load, User Experience and Gestural Performance[J]. Computers in Human Behavior, 75:42-49.

[46]Malmberg, J., J?rvel?, S., & Holappa, J. et al. (2019). Going Beyond What Is Visible: What Multichannel Data Can Reveal about Interaction in the Context of Collaborative Learning?[J]. Computers in Human Behavior, 96:235-245.

[47]Martin, K., Wang, E. Q., & Bain, C. et al. (2019). Computationally Augmented Ethnography: Emotion Tracking and Learning in Museum Games[C]// Eagan, B., Misfeldt, M., & Siebert-Evenstone, A. (Eds.). Proceedings of the Advances in Quantitative Ethnography. Madison, WI: Springer International Publishing:141-153.

[48]Martinez-Maldonado, R., Echeverria, V., & Fernandez Nieto, G. et al. (2020). From Data to Insights: A Layered Storytelling Approach for Multimodal Learning Analytics[C]// Proceedings of the 2020 CHI Conference on Human Factors in Computing Systems. Honolulu, HI:1-15.

[49]Martinez-Maldonado, R., Echeverria, V., & Santos, O. C. et al. (2018). Physical Learning Analytics: A Multimodal Perspective[C]// Proceedings of the 8th International Conference on Learning Analytics and Knowledge (LAK18). Australia, Sydney:375-379.

[50]Mills, C., Fridman, I., & Soussou, W. et al. (2017). Put Your Thinking Cap on: Detecting Cognitive Load Using EEG During Learning[C]// Proceedings of the Seventh International Learning Analytics & Knowledge Conference (LAK17). Vancouver, BC:80-89.

[51]Minematsu, T., Tamura, K., & Shimada, A. et al. (2019). Analytics of Reading Patterns Based on Eye Movements in an e-Learning System[C]// Proceedings of the Society for Information Technology & Teacher Education International Conference.Waynesville,NC:1054-1059.

[52]Moher, D., Liberati, A., & Tetzlaff, J. et al. (2009). Preferred Reporting Items for Systematic Reviews and Meta-Analyses: The PRISMA Statement[J]. Open Medicine,3(2):123-130.

[53]Monkaresi, H., Bosch, N., & Calvo, R. A. et al. (2017). Automated Detection of Engagement Using Video-Based Estimation of Facial Expressions and Heart Rate[J]. IEEE Transactions on Affective Computing, 8(1):5-8.

[54]Mu, S., Cui, M., & Wang, X. J. et al. (2018). Learners Attention Preferences and Learning Paths on Online Learning Content: An Empirical Study Based on Eye Movement[C]// Proceedings of the 2018 Seventh International Conference of Educational Innovation Through Technology (EITT). New Zealand, Auckland:32-35.

[55]Mu, S., Cui, M., & Wang, X. J. et al. (2019). Learners Attention Preferences of Information in Online Learning: An Empirical Study Based on Eye-Tracking[J]. Interactive Technology and Smart Education,16(3):186-203.

[56]Munshi, A., & Biswas, G. (2019). Personalization in OELEs: Developing a Data-Driven Framework to Model and Scaffold SRL Processes[M]// Isotani, S., Millán, E., & Ogan, A. et al. (Eds.). Artificial Intelligence in Education. Switzerland, Cham: Springer International Publishing:354-358.

[57]Noel, R., Riquelme, F., & Lean, R. M. et al. (2018). Exploring Collaborative Writing of User Stories with Multimodal Learning Analytics: A Case Study on a Software Engineering Course[J]. IEEE Access.

[58]Okada, M., Kuroki, Y., & Tada, M. (2020). Multimodal Analytics to Understand Self-regulation Process of Cognitive and Behavioral Strategies in Real-world Learning[J]. IEICE Transactions on Information and Systems, E103.D(5):1039-1054.

[59]Ou, L., Andrade, A., & Alberto, R. et al. (2020). Using a Cluster-Based Regime-Switching Dynamic Model to Understand Embodied Mathematical Learning[C]// Proceedings of the Tenth International Conference on Learning Analytics & Knowledge. Germany, Frankfurt:496-501.

[60]Oviatt, S. (2018). Ten Opportunities and Challenges for Advancing Student-Centered Multimodal Learning Analytics[C]// Proceedings of the 20th ACM International Conference on Multimodal Interaction. Boulder, CO:87-94.

[61]Oviatt, S., Hang, K., & Zhou, J. et al. (2018). Dynamic Handwriting Signal Features Predict Domain Expertise[J]. ACM Transactions on Interactive Intelligent Systems, 8(3):1-21.

[62]Paredes, Y. V., Azcona, D., & Hsiao, I.-H. et al. (2018). Learning by Reviewing Paper-Based Programming Assessments[C]// Pammer-Schindler, V., Pérez-Sanagustín, M., & Drachsler, H. et al. (Eds.). Proceedings of the Lifelong Technology-Enhanced Learning. Switzerland, Cham: Springer International Publishing:510-523.

[63]Pham, P., & Wang, J. (2018). Predicting Learners Emotions in Mobile MOOC Learning via a Multimodal Intelligent Tutor[C]// Nkambou, R., Azevedo, R., & Vassileva, J. (Eds.). Proceedings of the Intelligent Tutoring Systems. Switzerland, Cham: Springer International Publishing:150-159.

[64]Pijeira-Díaz, H. J., Drachsler, H., & Kirschner, P. A. et al. (2018). Profiling Sympathetic Arousal in a Physics Course: How Active Are Students?[J]. Journal of Computer Assisted Learning,34(4):397-408.

[65]Paans, C., Molenaar, I., & Segers, E. et al. (2019). Temporal Variation in Childrens Self-Regulated Hypermedia Learning[J]. Computers in Human Behavior, 96:246-258.

[66]Praharaj, S., Scheffel, M., & Drachsler, H. et al. (2019). Group Coach for Co-located Collaboration[C]// Proceedings of the Transforming Learning with Meaningful Technologies. Netherlands, Delft:732-736.

[67]Prieto, L. P., Sharma, K., & Kidzinski, ?. et al. (2018). Multimodal Teaching Analytics: Automated Extraction of Orchestration Graphs from Wearable Sensor Data[J]. Journal of Computer Assisted Learning,34(2):193-203.

[68]Reilly, J. M., & Schneider, B. (2019). Predicting the Quality of Collaborative Problem Solving Through Linguistic Analysis of Discourse[C]// Proceedings of the 12th International Conference on Educational Data Mining (EDM 2019). Montréal, QC:149-157.

[69]Reilly, J. M., Ravenell, M., & Schneider, B. (2018). Exploring Collaboration Using Motion Sensors and Multi-Modal Learning Analytics[C]// Proceedings of the 11th International Conference on Educational Data Mining (EDM 2018). Buffalo, NY.

[70]Romano, G., Schneider, J., & Drachsler, H. (2019). Dancing Salsa with Machines-Filling the Gap of Dancing Learning Solutions[J]. Sensors, 19(17):3661.

[71]Rosen, D., Palatnik, A., & Abrahamson, D. (2018). A Better Story: An Embodied-Design Argument for Generic Manipulatives[M]// Calder, N., Larkin, K., & Sinclair, N. (Eds.). Using Mobile Technologies in the Teaching and Learning of Mathematics. Switzerland, Cham: Springer International Publishing:189-211.

[72]Samuelsen, J., Chen, W., & Wasson, B. (2019). Integrating Multiple Data Sources for Learning Analytics - Review of Literature[J]. Research and Practice in Technology Enhanced Learning, 14(1):11.

[73]Schneider, B., Dich, Y., & Radu, I. (2020). Unpacking the Relationship Between Existing and New Measures of Physiological Synchrony and Collaborative Learning: A Mixed Methods Study[J]. International Journal of Computer-Supported Collaborative Learning, 15(1):89-113.

[74]Schneider, B., Sharma, K., & Cuendet, S. et al. (2018). Leveraging Mobile Eye-Trackers to Capture Joint Visual Attention in Co-located Collaborative Learning Groups[J]. International Journal of Computer-Supported Collaborative Learning, 13(3):241-261.

[75]Schneider, J., Romano, G., & Drachsler, H. (2019). Beyond Reality - Extending a Presentation Trainer with an Immersive VR Module[J]. Sensors, 19(16):3457.

[76]Schwendimann, B. A., Rodríguez-Triana, M. J., & Vozniuk, A. et al. (2017). Perceiving Learning at a Glance: A Systematic Literature Review of Learning Dashboard Research[J]. IEEE Transactions on Learning Technologies, 10(1):30-41.

[77]Sharma, K., Papamitsiou, Z., & Giannakos, M. (2019). Building Pipelines for Educational Data Using AI and Multimodal Analytics: A “Grey-Box” Approach[J]. British Journal of Educational Technology, 50(6):3004-3031.

[78]Sommer, S., Hinojosa, L., & Traut, H. et al. (2017). Integrating Eye-Tracking Activities Into a Learning Environment to Promote Collaborative Meta-Semiotic Reflection and Discourse[C]// Proceedings of the 12th International Conference on Computer Supported Collaborative Learning. Philadelphia, PA:1-4.

[79]Spikol, D., Ruffaldi, E., & Dabisias, G. et al. (2018). Supervised Machine Learning in Multimodal Learning Analytics for Estimating Success in Project-Based Learning[J]. Journal of Computer Assisted Learning, 34(4):366-377.

[80]Sriramulu, A., Lin, J., & Oviatt, S. (2019). Dynamic Adaptive Gesturing Predicts Domain Expertise in Mathematics[C]// Proceedings of the 2019 International Conference on Multimodal Interaction (ICMI19). China, Suzhou:105-113.

[81]Montero, C. S., & Suhonen, J. (2014). Emotion Analysis Meets Learning Analytics: Online Learner Profiling Beyond Numerical Data[C]// Proceedings of the 14th Koli Calling International Conference on Computing Education Research. Koli, Finland:165-169.

[82]Tamura, K., Lu, M., & Konomi, S. et al. (2019). Integrating Multimodal Learning Analytics and Inclusive Learning Support Systems for People of All Ages[C]// Proceedings of the Cross-Cultural Design. Orlando, FL: 469-481.

[83]Thomas, C. (2018). Multimodal Teaching and Learning Analytics for Classroom and Online Educational Settings[C]// Proceedings of the 20th ACM International Conference on Multimodal Interaction. Boulder, CO:542-545.

[84]Tzirakis, P., Trigeorgis, G., & Nicolaou, M. A. et al. (2017). End-to-End Multimodal Emotion Recognition Using Deep Neural Networks[J]. IEEE Journal of Selected Topics in Signal Processing,11(8):1301-1309.

[85]Vrzakova, H., Amon, M. J., & Stewart, A. et al. (2020). Focused or Stuck Together: Multimodal Patterns Reveal Triads Performance in Collaborative Problem Solving[C]// Proceedings of the Tenth International Conference on Learning Analytics & Knowledge. Germany,Frankfurt:295-304.

[86]Watanabe, E., Ozeki, T., & Kohama, T. (2018). Analysis of Interactions Between Lecturers and Students[C]// Proceedings of the 8th International Conference on Learning Analytics and Knowledge (LAK18). Australia, Sydney:370-374.

[87]Worsley, M. (2018). Multimodal Learning Analytics Past, Present, and Potential Futures[C]// Proceedings of the 8th International Conference on Learning Analytics & Knowledge (LAK18). Australia, Sydney.

[88]Worsley, M., & Blikstein, P. (2018). A Multimodal Analysis of Making[J]. International Journal of Artificial Intelligence in Education, 28(3):385-419.

[89]Yin, Z., Zhao, M., & Wang, Y. et al. (2017). Recognition of Emotions Using Multimodal Physiological Signals and an Ensemble Deep Learning Model[J]. Computer Methods & Programs in Biomedicine, 140:93-10.

[90]Zaletelj, J., & Ko?ir, A. (2017). Predicting Students Attention in the Classroom from Kinect Facial and Body Features[J]. EURASIP Journal on Image and Video Processing, 2017:80.

[91]Zheng, W. L., Liu, W., & Lu, Y. et al. (2019). EmotionMeter: A Multimodal Framework for Recognizing Human Emotions[J]. IEEE Transactions on Cybernetics, 49(3):1110-1122.

收稿日期 2020-11-20 責任編輯 劉選

Data Fusion Method in Multimodal Learning Analytics: From a Panoramic Perspective

MU Su, CUI Meng, HUANG Xiaodi

Abstract: Multimodal data analysis helps us to understand the learning processes accurately. This paper systematically surveyed 312 articles in English and 51 articles in Chinese on multimodal data analysis and the findings show as follows. The analysis stages are collecting multimodal data in the learning process, converting multimodal data into learning indicators, and applying learning indicators to teaching and learning. High-frequency, fine-grained and micro-level multidimensional data in the learning processes are available, convenient and accurate, including digital data, physical data, physiological data, psychometric data and environment data. The learning indicators include behavior, cognition, emotion, collaboration and so on. The corresponding relationships between learning data and learning indicators are classified into one-to-one, one-to-many, and many-to-one. The complex relationship between learning data and learning indicators is the premise of data fusion. When measuring a learning indicator, two issues need to be considered: which type of data is the most effective one in measuring the indicator and whether there are any other types of data that contribute to more accurate measurements. Aligning the timeline of multimodal data is the key to data integration. In a word, the main characteristics of multimodal data analysis are characterized as multimodality of learning data, multi-dimension of learning indicators and diversity of analysis methods. Comprehensive consideration of the three-dimensional characteristics to improve the accuracy of analysis results is the direction of future research on multimodal data integration.

Keywords: Multimodal Learning Analytics; Types of Data; Learning Indicators; Data Fusion; Systematic Review