UNET與FPN相結合的遙感圖像語義分割

王 曦, 于 鳴,2*, 任洪娥,2*

(1. 東北林業大學 信息與計算機工程學院, 黑龍江 哈爾濱150040;2. 黑龍江省林業智能裝備工程研究中心, 黑龍江 哈爾濱 150040)

1 引 言

卷積神經網絡(Convolution Neural Networks,CNN)[1]以其局部權值共享的特殊結構以及良好的容錯能力、并行處理能力和自學習能力被廣泛應用于語義分割[2]、對象檢測[3]、人臉識別[4]、圖像分類[5]等諸多計算機視覺領域[6]。以圖像語義分割為例,Long J和Shelhamer E首次將CNN引入了圖像語義分割問題,提出了著名的FCN[7]結構。FCN將深度學習擴展到語義分割領域。FCN在提取特征方面與CNN基本一致。不同的是,FCN為每一個像素分配一個值,用于表示該像素屬于特定類別的概率。相比使用手工設計的特征描對圖像進行編碼,通過反卷積實現上采樣將CNN獲取的編碼恢復到原有圖像尺寸,采用端到端的訓練方式,簡化了語義分割問題過程,得到了更優的準確率。Ronneberger O和Fischer P等人在FCN[8]基礎上提出了UNET結構,使用了編碼器解碼器結構并加入了橫向連接,f反卷積使得從圖像特征編碼到最后的預測結果更加平滑,橫向連接為解碼器增加了來自淺層具有局部信息的特征,豐富了解碼器階段包含的信息,進一步提升了效果。Chen L C和Papandreou G提出了DeepLab V3模型,在模型中對空間金字塔池化模塊(ASPP)進一步改進,使用具有不同感受野的空洞卷積提取多尺度語義信息,通過1×1卷積進行整合,提升了模型整合多尺度信息的能力,將語義分割的效果帶上了新臺階。

UNET模型最早用于醫學影像分割,該模型以其簡潔的結構以及顯著的效果受到了國內外學者的關注。李忠智等人提出基于UNET的船舶檢測方法,通過在UNET中加入多變輸出融合策略算為基礎在模型中加入特征融合[9];周銳燁等人提出PI-UNET用于異質虹膜精確分割,使用深度可分離卷積替換傳統卷積對模型進行加速,在上采樣階段同時使用反卷積與二次先行插值,彌補因深度可分卷積帶來的精度問題[10];蔣宏達等人提出I-UNET用于皮膚病圖像分割,在UNET中加入Inception提升UNET對多尺度信息的捕捉能力[11]。本文將對UNET模型出現的問題進一步探究,通過兩種方式對其進行改進,提升模型的語義分割精度。

高分辨率遙感影像語義分割[12]問題是語義分割的一個重要分支。梁華等人[13]利用深度學習技術對航空對地小目標進行檢測。對遙感影像精確的分割以及對建設數字型、智慧型城市有著重要意義。語義分割是將圖像中屬于相同類別的像素聚類為一個區域,對圖像更加細致地了解[14]。本文在語義分割[15]基礎上,探究語義分割模型在遙感影像分割上的應用。針對分割過程中存在的圖像邊緣分割精細程度不佳的問題,本文提出了一種改進UNET模型,通過加入具備整合多尺度信息的FPN結構,豐富每一個像素點在分類時所需要的信息。同時使用能夠更好捕捉目標邊緣[16]的損失函數,緩解上述模型在目標邊緣分割不佳的問題。實驗證明,在加入上述兩種改動后,模型對目標邊緣的分割精細程度有所提升,得到了更優的分割效果。

2 研究技術與方法

UNET是通過反卷積與通道維度連接進行整合;反卷積上采樣與通道連接的優點在于可以得到更加平滑的結果,但是經過conv + relu的非線性變換,通過該層傳遞的淺層信息傳遞到下一層的量將會減少。我們希望每一層都可以像ASPP那樣盡可能多的掌握不同尺度語義信息,很顯然,UNET的方式不能滿足對圖像中目標邊緣附近區域精準分割。所以本文主要從以下兩個方面著手進行改進:

(1)通過在UNET中加入FPN結構,提升UNET整合多尺度語義信息的能力,豐富其像素點標簽分類所使用的特征中包含的信息。

(2)對損失函數進行改進,相比對每個點獨立進行預測的多分類交叉熵,本文使用了能夠更好地捕捉目標邊緣的邊界標簽松弛損失函數。

2.1 改進的UNET模型

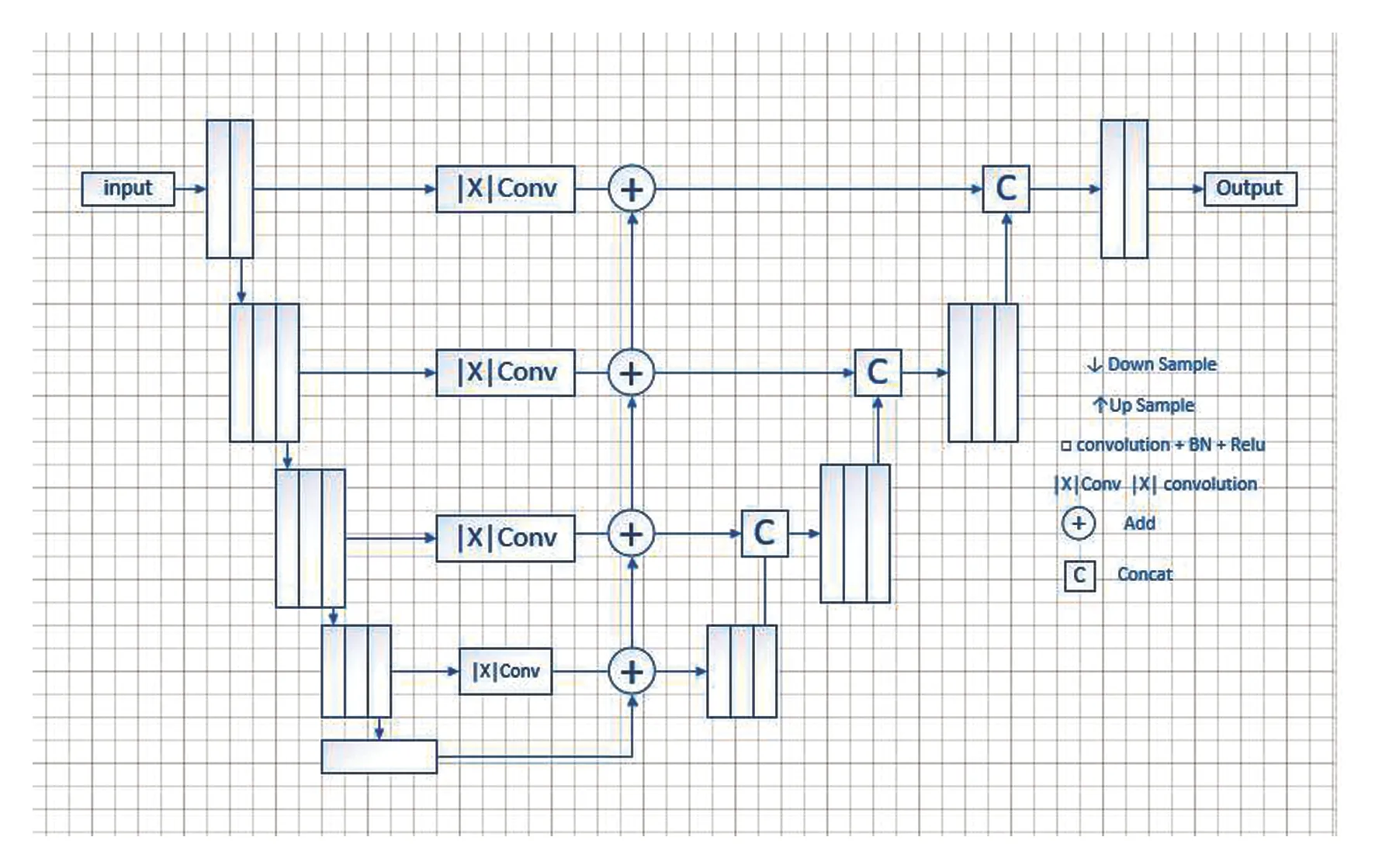

為提升UNET模型的分割效果,本文對UNET模型的整體結構進行了改進,在UNET結構中引入FPN結構,充分利用UNET編碼器中包含多尺度信息的優勢。

FPN結構又稱特征金字塔網絡,這是一種廣泛應用于目標檢測任務中的結構,FPN結構能有效整合來自編碼器部分的多尺度語義信息。FPN主要由自底向上流程、自頂向下流程和橫向連接3部分構成,如圖1所示。

圖1 FPN網絡結構Fig.1 Diagram of FPN network structure

自底向上流程即為卷積神經網絡在前向計算時提取具備不同尺度特征的過程。自頂向下流程即對前述所提取每步卷積特征進行上采樣處理,保證處理后的高層卷積特征維度與自底向上的低層特征維度相同。隨后將高級特征圖與橫向連接傳遞的低層特征圖對應元素進行相加,得到具備多尺度信息的融合特征。低層次特征由于經歷的卷積次數相對于高層特征較少,因此具有較多的紋理信息,而高層次特征因為經過多次卷積濾波,具有更高級的語義特征。經過對高層的特征上采樣至同等尺寸,與低層次特征進行相加,使用低層次特征包含的紋理和細節信息,進一步對高層特征做補充,豐富了融合后的特征圖所包含的信息。

UNET使用的反卷積上采樣可得到相對平滑的結構特征,但是經過卷積加非線性激活層的變換后,使原始特征無法得到較好的保留,所以在UNET中通過跳層連接傳入來自淺層的特征對原始特征進行彌補。圖像中每個像素點的準確分類要依靠來自不同尺度的語義信息,而UNET的跳層連接傳遞的特征較為單一。因此本文引入了FPN結構。此外FPN的上采樣方式為二次線性插值,相比反卷積操作,對原始特征保留更完整,加和方式特征整合保證了傳遞給解碼器的每一層都包含盡可能多的多尺度信息。對比FPN結構與UNET結構,發現二者具有相似性,FPN結構中的橫向連接可使用UNET中的橫向連接實現。這一特征為FPN結構擴展UNET模型提供了便利。充分利用UNET中結構的同時,極大地利用UNET模型中包含的不同尺度信息。在加入FPN結構后,UNET整體結構如圖2所示。

圖2 加入FPN結構后的UNET網絡結構Fig.2 Diagram of UNET network structure after joining FPN structure

FPN是通過二次線性插值和對應元素相加的方式進行整合;而UNET則通過反卷積與通道維度連接進行整合。由于二次線性插值是一個線性操作,對原始的淺層信息沒有更改,僅僅通過線性插值增加了特征圖的尺寸,對應元素相加的方式保證了傳遞給每個解碼器層的特征都是原始淺層特征加和的方式,避免了因反卷積導致的信息丟失,但是二次線性插值的缺點在于會引入噪聲,無法獲得平滑的結果,因此我們選擇在保留UNET的基礎上加入FPN結構。

2.2 BLR損失函數

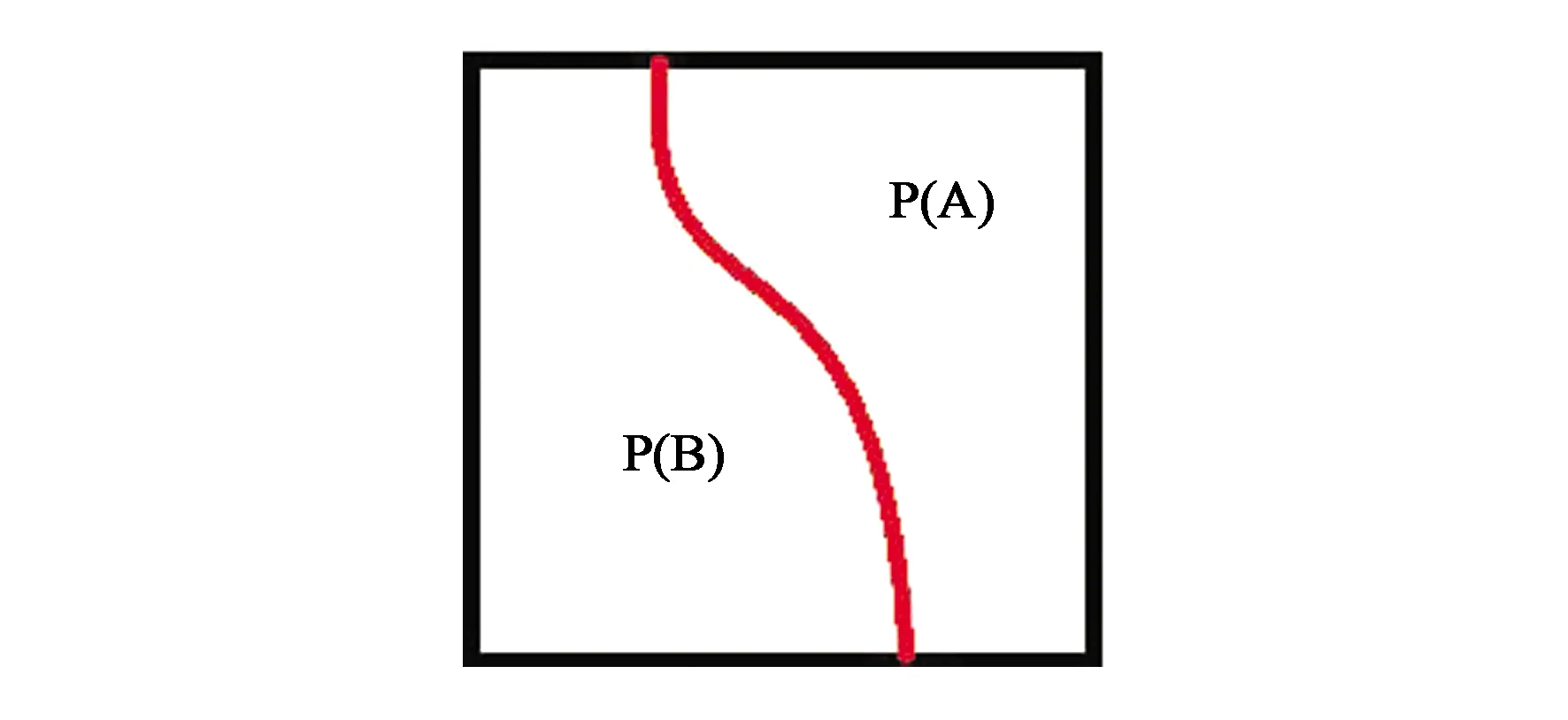

深度學習技術的加入快速推動了語義分割的發展,圖像中目標包含的大部分像素都能夠被準確分類,但對于邊緣部分的分割效果依然有限,探索這一問題的本質在于,深度學習技術的主要方法論是將認為加工得到的目標理解為在一種分布上采樣得到的結果,通過訓練方式使模型去逼近這種分布,我們無法做到完全準確的擬合,因此對于模型的預測就存在一些出入。此外對于目標邊緣上實為兩目標相交處,所以此處的像素點類別存在二義問題。針對這一問題,國內外學者的解決方法主要通過更高質量的標注數據和更加復雜的模型去提升分割效果。本文將從損失函數入手,對UNET模型進行改動,本文使用了能更好捕捉目標邊緣的邊界標簽松弛損失函數[15](Boundary Label Relaxation,BLR)來緩解這一問題帶來的影響。將邊界像素點定義為具有不同標記鄰居的任何像素,如圖3所示。

圖3 邊界像素點Fig.3 Border pixels

圖3中紅色曲線代表邊緣,邊緣的兩側標簽分別為A與B。為了產生更好邊緣的預測情況,可以選擇兩種策略,一種方式為直接對邊緣的形狀進行建模,但是圖像中包含的邊緣形狀各異,統一對邊緣進行建模比較復雜。為此本文選擇第二種方式,即對圖像邊緣兩側的區域進行最大似然估計,上文提到了邊緣像素點定義為具有不同標記鄰居的任何像素,因此只需要將邊緣兩側的區域進行最大似然估計,便可找到邊緣區域。又因邊緣兩側的標簽分布相互獨立,因此對兩側區域的概率描述可表示為:

P(A∪B)=P(A)+P(B)

(1)

對該項進行負對數似然估計,則有:

-log[P(A∪B)]=-log[P(A)+P(B)]

(2)

考慮目標邊緣具有多變性,為保證每一個目標邊緣都能得到理想的語義分割效果,將圖片切割成3×3大小的圖像塊。此時每個圖像塊上只包含較小部分邊緣或者不包含邊緣,降低了對整張圖像使用梯度下降法求解時的難度。整張圖片是由大小相同的圖像塊構成,因此對整張圖片的負對數似然估計為:

(3)

該函數即為上文提到的邊界標簽松弛(BLR)損失函數,其中M代表每張圖片中包含的圖像塊個數,Ni代表每個圖像塊,c代表圖像塊中包含的像素點。相比傳統的交叉熵損失函數,優化降低BLR損失函數在保證準確預測圖像中包含的每個點的類別標簽的同時,提升模型對目標邊緣的語義分割效果。在模型訓練中只需要使用梯度下降法對上式進行最小化,便可得到比較理想的效果。

2.3 數據集與數據處理

本文選擇了CAMVID數據集和“CCF衛星影像的AI分類與識別競賽”數據集。

(1)CAMVID數據集:該數據由劍橋大學收集整理和標注。數據集由一組道路街景圖像構成,其中包含367個訓練圖像和233個測試圖像(白天和黃昏場景)組成,分辨率為360×480。挑戰在于劃分11類,如道路、建筑物、汽車、行人、標志、電線桿、人行道等。

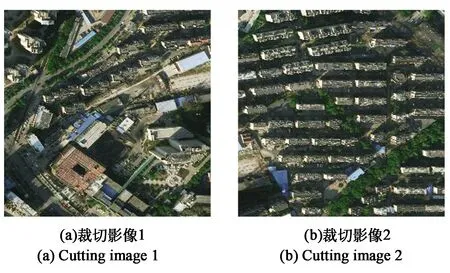

(2)“CCF衛星影像的AI分類與識別競賽”數據集:訓練集中包含5張尺寸為3 357×6 166的高清分辨率遙感圖片,部分影像如圖4所示。為了克服數據極其稀少的問題,選擇充分利用圖片具有的大尺寸高分辨率性質對數據集進行了擴充。首先從5張圖像中隨機選取4張,使用過采樣策略在訓練集上的每張圖片上隨機選點,因為原始圖像的像素為3 357×6 166,其中橫向像素為3 357個,縱向像素為6 166個,所以一共可以取到約為18×106個像素點。將每個隨機選中的點作為圖像塊中的左上角,分別從左上角的像素點向右和向下延伸256個像素點,這樣就得到一個以256個像素為長度切割出256×256的圖像塊,使用切割得到的圖像塊構成訓練集。將剩余的一張遙感圖像使用相同的采樣策略,并使用采樣得到的圖像塊作為驗證集。

圖4 CCF衛星影像分類與識別比賽中的裁切得到的影像Fig.4 AI classification and CCF satellite influenced part of the images in the competition

本文對數據集使用了數據增強策略,采用高斯平滑、隨機添加噪聲點、顏色抖動、圖像旋轉與縮放等操作對訓練集進行擴充,測試集與驗證集未做數據增強。

3 實驗與結果分析

3.1 訓練過程

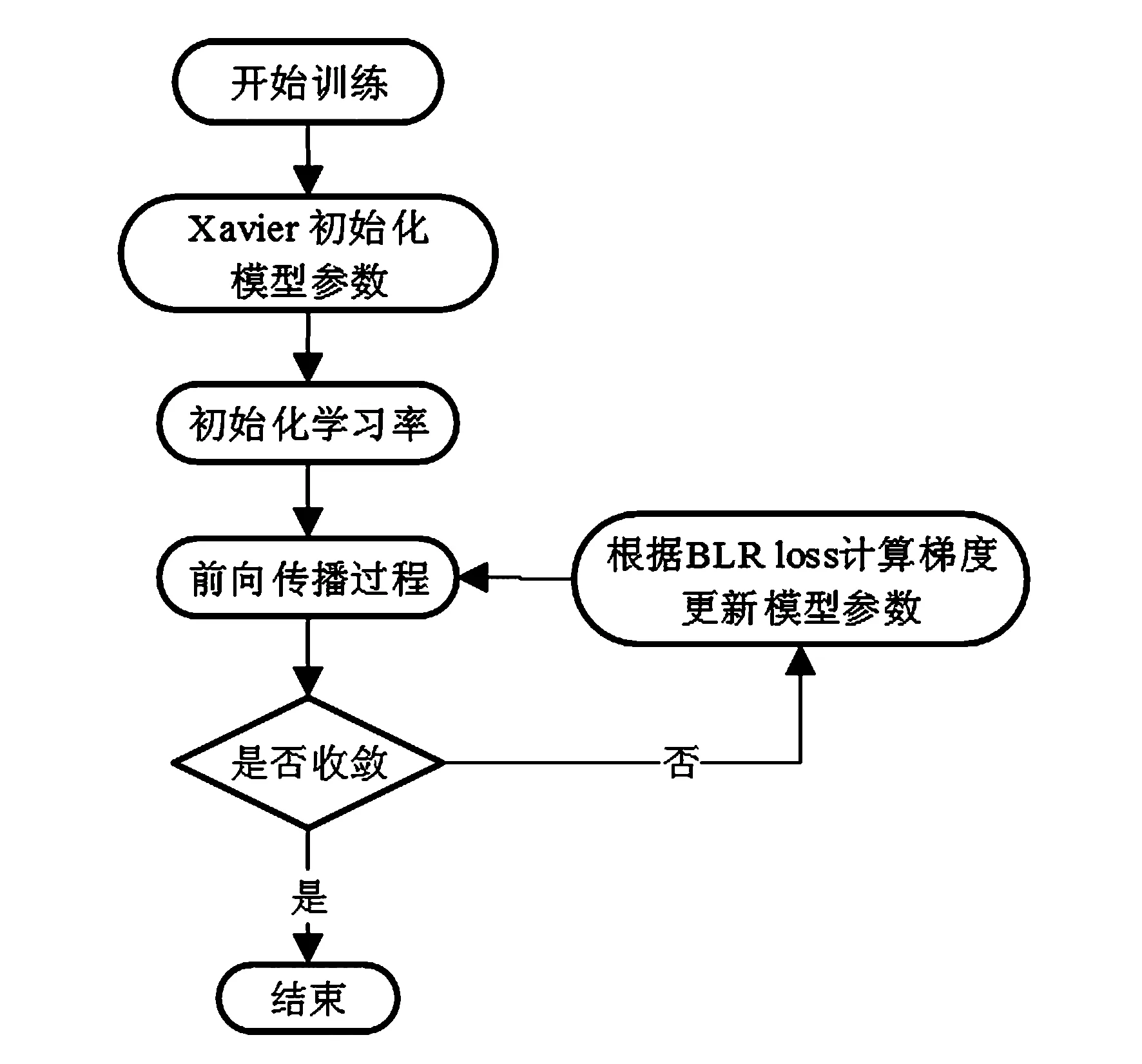

實驗在Ubuntu 16.0.4的環境下,使用Tesla v100GPU作為硬件環境。為了獲得更好的結果,使用了Xaiver方法對模型中包含的參數進行初始化。在優化算法上選擇了具備自適應調節步長能力的Adam方法,其中學習率初始值設置為0.002批(batch size),大小設置為16,共迭代了6 000次。模型訓練過程如圖5所示。

圖5 模型訓練過程Fig.5 Model training process

此外,為了防止模型出現過擬合,本文在模型中使用了批歸一化(Batch Norm),并且在訓練階段加入了系數為0.000 05的L2正則項,訓練階段所使用的損失函數如下:

(4)

在模型推理(inference)階段,將測試集中的圖像調整為相應尺寸,依次送入訓練好的改進UNET模型中,得到最終的預測結果。

3.2 對比實驗

本文方法在上述2個數據集上與FCN、SEGNET[17]、UNET、DeepLabV1[18]、DeepLabV2[19]以及目前較為先進的DeepLabV3進行了多組實驗以驗證其語義分割效果。使用了常用的像素精度(PA)和均交并比(MIOU)作為衡量標準:

(1)PA是最簡單的度量,為標記正確的像素占總像素的比例,數學表達如下:

(5)

(2)MIOU為語義分割的標準度量。均交并比計算模型預測得到的標注圖與人工標注圖的交集與并集之比。在每個類上計算IOU,之后取平均,其中Class Number為包含的類別。數學表達如下:

(6)

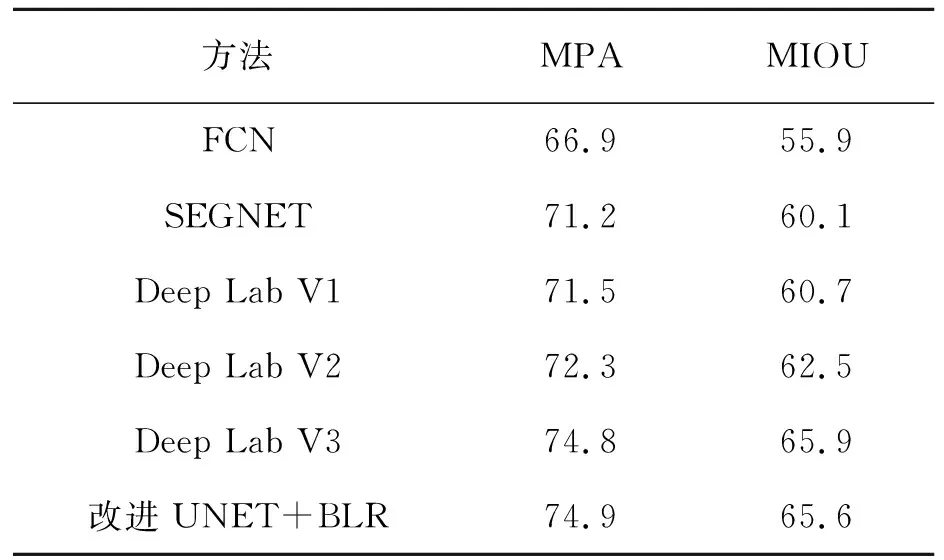

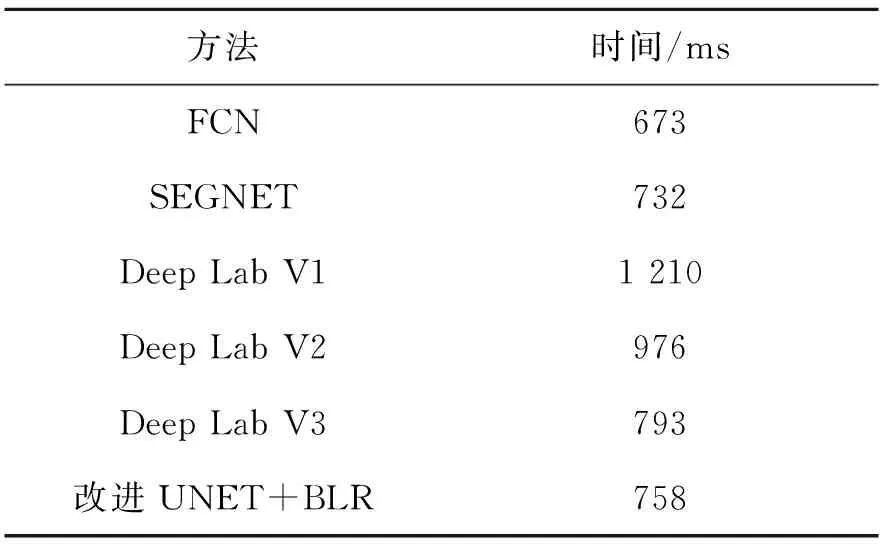

在CAMVID測試集上得到的分割結果如表1所示,不同模型耗時分析如表2所示。對比表1中的各數值,本文改進的模型具備了與DeppLabV3相近的能力。在平均像素精度和平均交并比上都明顯超越以往的FCN模型、SEGNET模型、DeepLabV1、DeepLabV2。對比表2各數值,本文改進后模型的消耗時間快于DeepLabV1、DeepLabV2和DeepLabV3。

表1 CAMVID結果對比(%)Tab.1 Comparison of CAMVID result(%)

表2 CAMVID不同模型耗時分析Tab.2 Time consuming analysis of different models of CAMVID

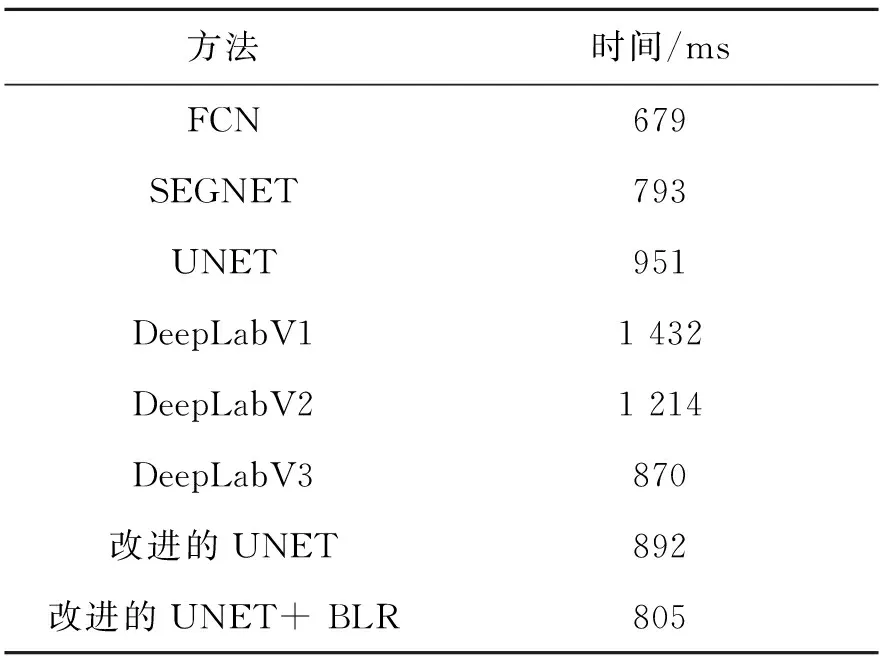

在CCF影像分類數據上的精度指標如表3所示,不同模型消耗時間如圖4所示。對比表3的各個數據可以清晰地觀察到在UNET中加入FPN結構后模型的平均像素精度和均交比都有提升,在引入BLR損失函數后模型的均交并比又一次得到了提升,得到了與DeepLabV3相接近的效果。對比表4的各個數據值,不同模型耗時同CAMVID測試集。

表3 CCF影像分類結果精確度(%)Tab.3 Classification result accuracy of CCF image(%)

表4 CCF影像不同模型耗時分析Tab.4 Time consuming analysis of different models of CCF image

在建立的兩個數據集上與其他先進方法的時間對比如表2和表4所示。由表可知,DeeplabV1模型耗時最長,造成這一現象的主要原因為條件隨機場的參數量大,同時推理速度慢。相比其他方法如FCN,SEGNET,改進的UNET+BLR速度稍遜一籌,原因在于改進UNET+BLR參數量增加,相比DeepLabV3,本文方法具有更快的速度,同時具有相似的效果。

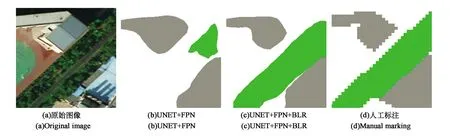

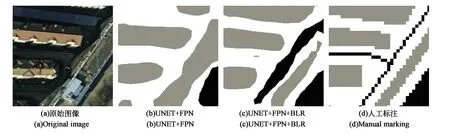

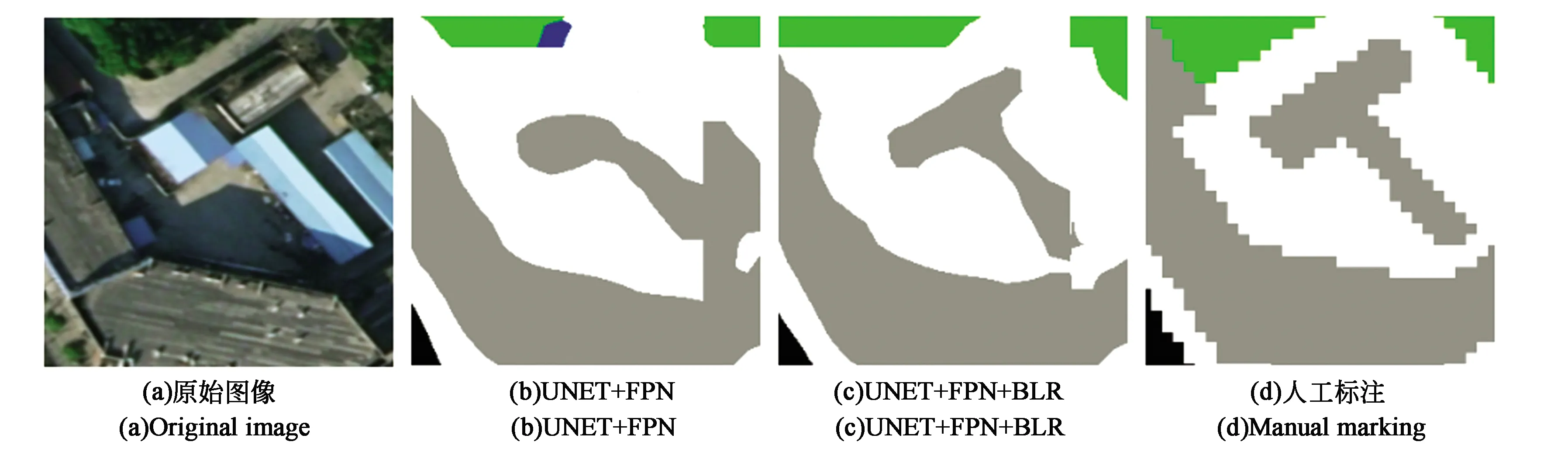

為了更加明顯地展示加入BLR損失函數帶來的交并比提升,本文將改進的UNET和加入BLR后的改進UNET分割結果進行了可視化,如圖6~9所示。圖6(a)為原始圖片,(b)為改進的UNET的預測結果,(c)為改進UENT+BLR的預測結果,(d)為人工標注的真實值。對比圖6(b)與圖6(c),注意到加入BLR損失函數后,UNET模型使得目標邊緣的分割結果得到了大幅度提升,緩解了原始UNET中對目標邊緣分割效果不佳的問題。同時整體分割結果相比于改進的UNET結構,分割結果效果更佳。實驗證明,在增加FPN結構和使用BLR損失函數的基礎上,相比于原始的UNET結構,本文方法不僅在均交并比和像素類別預測精度上有大幅度提升,同時使得目標邊界的預測結果得到了明顯改善。

圖6 CCF影像分割結果Fig.6 Segmentation results of CCF image

圖7 CCF影像分割結果1Fig.7 CCF affect segmentation results 1

圖8 CCF影像分割結果2Fig.8 CCF affect segmentation results 2

圖9 CCF影像分割結果3Fig.9 CCF affect segmentation results 3

4 結 論

本文對UNET模型在目標邊緣的語義分割精細度不夠理想方面做出改進,通過在UNET中加入FPN結構,提升UNET對多尺度語義信息的整合能力,同時引入能更好地捕捉目標邊緣的邊界標簽松弛損失函數BLR。在數據量較少的條件下,使用了將大尺度的遙感圖像分割為256×256的圖像塊,同時通過旋轉平移、添加高斯噪聲、高斯平滑、椒鹽噪聲等方式有效地擴充了數據量。實驗結果表明,改進的UNET模型在提升語義分割效果的同時,使得目標邊緣的分割效果也得到了大幅度改善。未來將嘗試RESNET等更加優秀的骨干網絡,或在模型中加入空洞卷積,獲得性能及速度的進一步提升。