基于多輸出網絡的無參考平面圖像質量評價研究

沈 暐, 林康立, 錢保軍, 龔有為,梁法其, 王曉虎, 劉 瀏

(1.中國聯合網絡通信有限公司 物聯網研究院,無錫214000;2.中國聯合網絡通信有限公司無錫市分公司,無錫214000;3.無錫市公安局 技術防范管理支隊,無錫214000)

0 引 言

近年來,隨著深度學習的興起,神經網絡廣泛地應用于圖像處理和計算機視覺等領域,特別是在圖像識別、分類的任務方面。深度學習模型需要大量訓練數據,且模型參數越多,需求量就越大。現有用于質量評價的圖像庫規模非常小,由于質量評價與圖像識別等任務不同,所以將深度神經網絡直接應用于質量評價有難度[1]。Kang等首次將卷積神經網絡應用于平面圖像質量評價,實現了端到端的無參考模型,將圖像分成多個不重疊的補丁,擴充了數據集,滿足訓練需求[2]。朱睿等針對JPEG2000圖像失真,構建了卷積神經網絡模型[3]。Cheng等結合圖像顯著性知識提出評價模型,認為圖像中的非顯著區域使卷積神經網絡預測誤差增大,故在將圖像分割成不重疊的小塊后,去除非顯著區域的小塊并為其分配權重,將顯著區域的小塊輸入卷積神經網絡預測體系,最后采用匯集策略得出圖像分數[4]。

深度卷積神經網絡在提取特征時,每一層特征的特點都是不同的。淺層網絡提取的是紋理、區域等細節特征,深層網絡提取的是輪廓、形狀和邊緣等結構特征。圖像失真類型眾多,評估不同類型的失真所需要的特征也不同。以往,深度網絡的最后一層特征用于分類、回歸等任務,而考慮到淺層和深層網絡特征對感知失真的影響,本文提出了一種基于多輸出卷積神經網絡的端到端無參考圖像質量評價模型。該模型設計了三個輸出,將淺層和深層特征分別回歸到主觀質量評分上,最后將三個輸出的平均分數作為最終質量得分。這種多輸出的網絡結構,綜合了三個學習機的結果,因此具備了集成學習的優點。實驗結果表明,本文方法與人類主觀評分具有較高的一致性。

1 多輸出卷積神經網絡算法設計

1.1 不同卷積層的特征分析

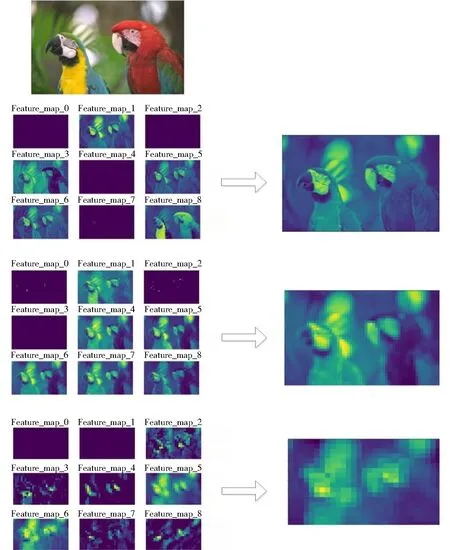

深度卷積神經網絡的優點是可以通過多層卷積自動提取特征,且不同卷積層提取的特征是不相同的。文獻[5]利用特征可視化技術,對不同卷積層的特征進行研究。可視化一幅圖像經過多次卷積后的特征圖如圖1所示,圖中左邊是每層卷積得到的特征圖,右邊是每一層的特征圖1∶1融合后得到的特征圖。圖1的第一行是Original image,第二行左側是Low-level feature maps,右側是Fused feature map,第三行是左側是Mid-level feature maps,右側是Fused feature map,第四行是左側是High-level feature maps,右側是Fused feature map。

可以看出,隨著層數的加深,卷積核提取的內容越來越抽象,保留的信息也越來越少,特征被不斷提取和壓縮,最終得到了比較高層次特征。因此,淺層網絡提取的是紋理、區域等細節特征,深層網絡提取的是輪廓、形狀和邊緣等關鍵結構特征。相對而言,層數越深,提取的特征越具有代表性。

傳統上,最后一層的特征已用于分類、回歸等任務。圖像失真類型種類很多,但大致可以分為結構失真(如模糊、JPEG等)和非結構失真(如各種噪聲),評價這些失真類型所需要的特征是不同的,有的甚至相互抵觸。分析結構失真主要需要輪廓、形狀和邊緣等結構特征(即深層網絡特征),而分析非結構失真則需要紋理、區域等細節特征(即淺層網絡特征)。本文提出的多輸出卷積神經網絡模型,利用不同卷積層提取不同特征,同時使用低層特征和高層抽象特征,正好適應了這種不同失真類型需要不同特征的要求。在噪聲類型較多的TID2013數據庫上的實驗結果進一步表明,使用淺層網絡特征會明顯改善噪聲失真的圖像質量評估效果。

1.2 多輸出卷積神經網絡模型

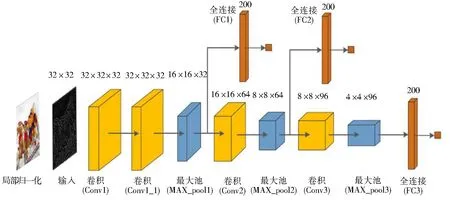

受到目標檢測網絡SSD[6]匯集多尺度特征的啟發,本文提出了一個端到端的多輸出卷積神經網絡模型,設計了三個輸出,將淺層特征和高層特征分別回歸到主觀質量評分上,最后平均多個輸出的分數作為最終質量得分,該網絡結構如圖2所示。網絡輸入的是經過預處理的32×32大小的無重疊圖像塊,卷積層采用5×5大小的卷積核,池化層采用最大池化來降低卷積層提取的特征圖維度,池化大小均為2×2。該網絡在結構上可以看作是三個卷積神經網絡簡單的拼接,因為它有三個全連接層分別用于回歸映射到主觀質量評分上。然而,該網絡不僅可以端到端進行訓練,而且將低層特征和高層特征聯系了起來。

圖1 不同卷積層的特征可視化Fig.1 Visualization of characteristics of different convolution layers

圖2 多輸出卷積神經網絡結構Fig.2 Structure of multi-output convolutional neural network

2 多輸出卷積神經網絡算法實現

2.1 圖像預處理

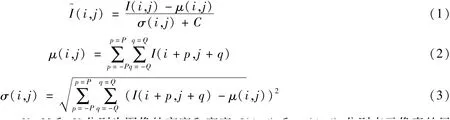

對所有訓練圖像和測試圖像進行局部歸一化,包括簡單的空間帶通操作和簡單的除法歸一化。該處理步驟參考文獻[2,7-8]。Ruderman發現對失真圖像進行局部歸一化后,其直方圖會趨于正態高斯分布,從而使網絡在亮度和對比度變化方面具有魯棒性[9]。Mittal等研究表明當圖像產生失真時,其局部歸一化后的統計特性也發生改變,且該改變是可預測的[8]。局部歸一化處理方法如下,假設圖像像素點(i,j)上的亮度值為I~(i,j),則局部歸一化公式為:

式中:i=1,2,…,M;j=1,2,…,N;M和N分別為圖像的高度和寬度;I(i,j)和μ(i,j)分別表示像素的局部均值和方差;C是常數,以防止分母為0;P和Q是歸一化窗口大小。文獻[8]表明,較小的歸一化窗口可以提高性能,所以選擇P=Q=3,使得窗口大小比圖像塊小得多。

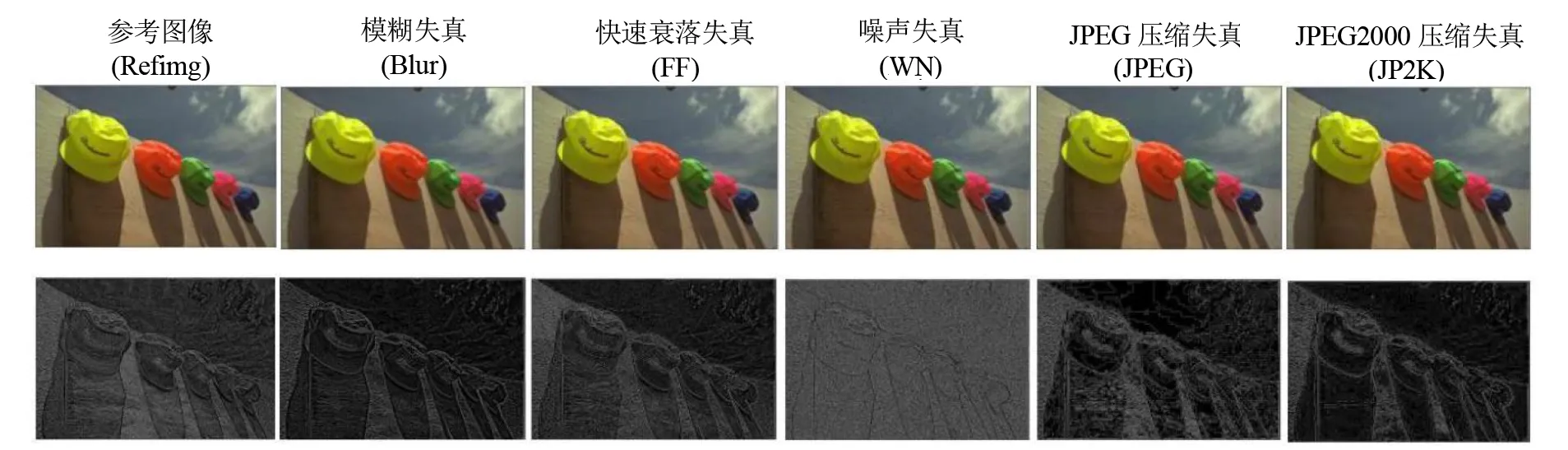

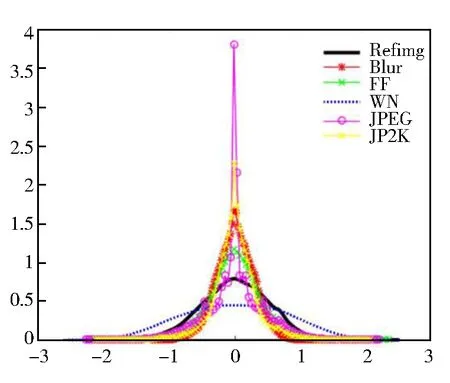

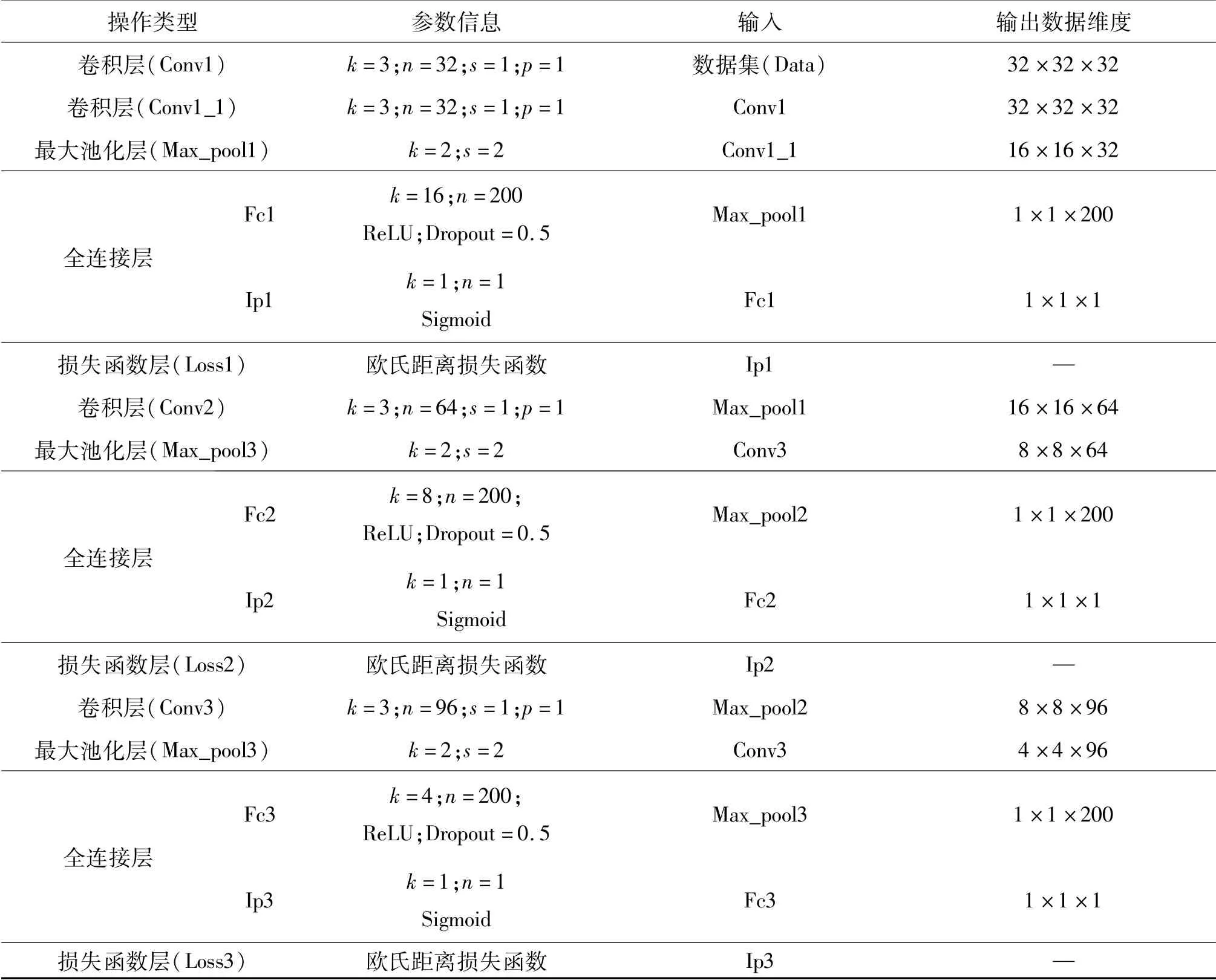

LIVE庫中的圖像局部歸一化后的概率密度圖如圖3和圖4所示。可以看出,對圖像進行局部歸一化后,其概率密度趨于正態高斯分布。不同類型或不同等級的失真所對應的概率密度分布是不相同的,模型通過自適應學習失真引起的不同統計分布來學習質量預測。

圖3 參考圖像和不同失真類型圖像的局部歸一化圖及其概率密度分布圖Fig.3 Local normalization map and probability density distribution of reference image and images with different distortion types

圖4 參考圖像和不同等級的Blur失真圖像局部歸一化圖及其概率密度分布圖Fig.4 Local normalization map and probability density distribution of reference image and Blur distortion images with different levels

2.2.1 網絡的調整與學習

網絡的訓練有兩個階段:前向傳播階段和反向傳播階段。

在第一階段中,首先初始化權重參數w和偏置b。輸入經過預處理的圖像塊,經過卷積層、池化層向前傳播逐層提取特征。計算公式為:式中:Zl為l層的輸出且為l+1層的輸入;ul+1為l+1層的輸出;f為ReLU激活函數;wl+1和bl+1分別為l+1層的權重和偏置。

在第二階段中,通過損失函數計算預測值與真實主觀評分之間的誤差。本文網絡采用的損失函數為歐氏距離損失函數,其定義為:

式中:E為損失值;Yn為預測值;yn為樣本標簽,即主觀評價分數;N表示圖片數。

由于本文的網絡有三個輸出,因此在每次池化后都會應用非線性回歸在池化層計算多個損失,如式(7)所示。然后將池化層的誤差通過反向傳播的方式直接傳遞給卷積層來更新權重,計算公式為:

2.2.2 網絡參數設置

從預處理的圖像中采樣32×32大小的非重疊圖像塊得到訓練數據。由于數據庫中的失真圖像都是均勻失真,所以每個圖像小塊的實際主觀評分都采用該圖像的主觀分數。在測試時,通過平均圖像塊的預測質量分數來計算圖像的質量得分。

本文采用Nesterov加速梯度下降的方法來優化損失函數[10],該方法可以使網絡快速收斂。為避免梯度消失問題,在兩個全連接層中使用ReLU激活函數。為防止過擬合,在全連接層中使用了Dropout技術[11],概率設置為0.5。

其他參數設置如下:動量(Momentum)設置為0.9,批量大小(Batchsize)設置為64,初始化學習率設置為0.01,重量衰減(Weight decay)設置為0.0005,學習率更新方式如下:

式中:base_Ir是初始化學習率;Iter為當前迭代次數;Gamma是學習速率變化因子,設置為0.000 1,指數power設置為0.75。

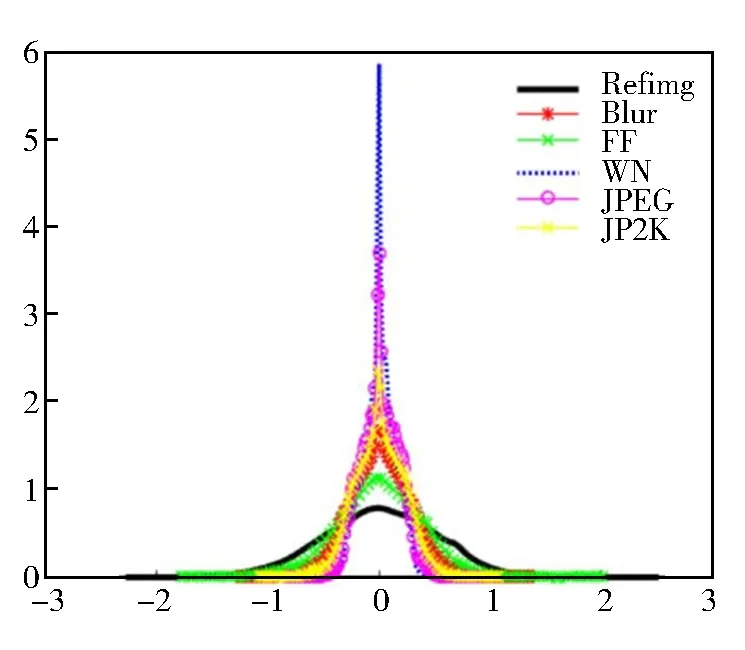

網絡每一層的參數如表1所示,輸入和輸出參數。其中:k代表卷積核大小或局部窗口大小;m為卷積核個數(通道數);s表示步長;p表示擴充邊緣大小。

3 實驗結果

3.1 實驗結果與分析

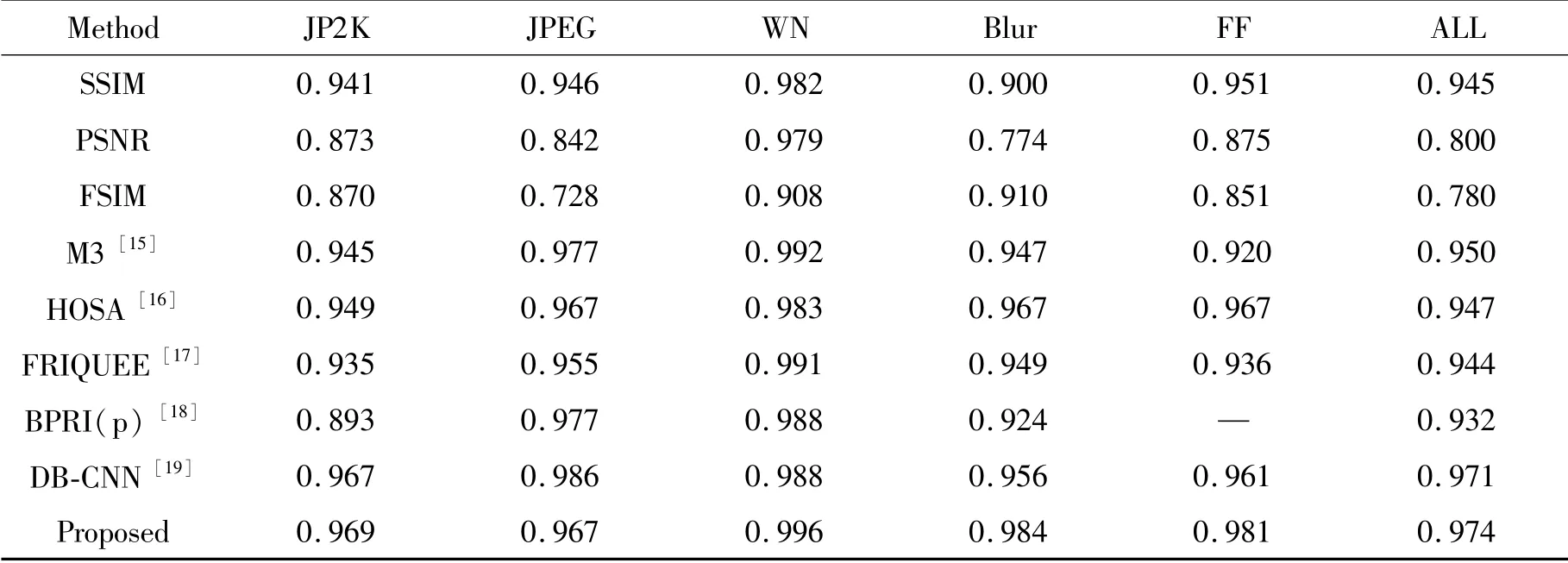

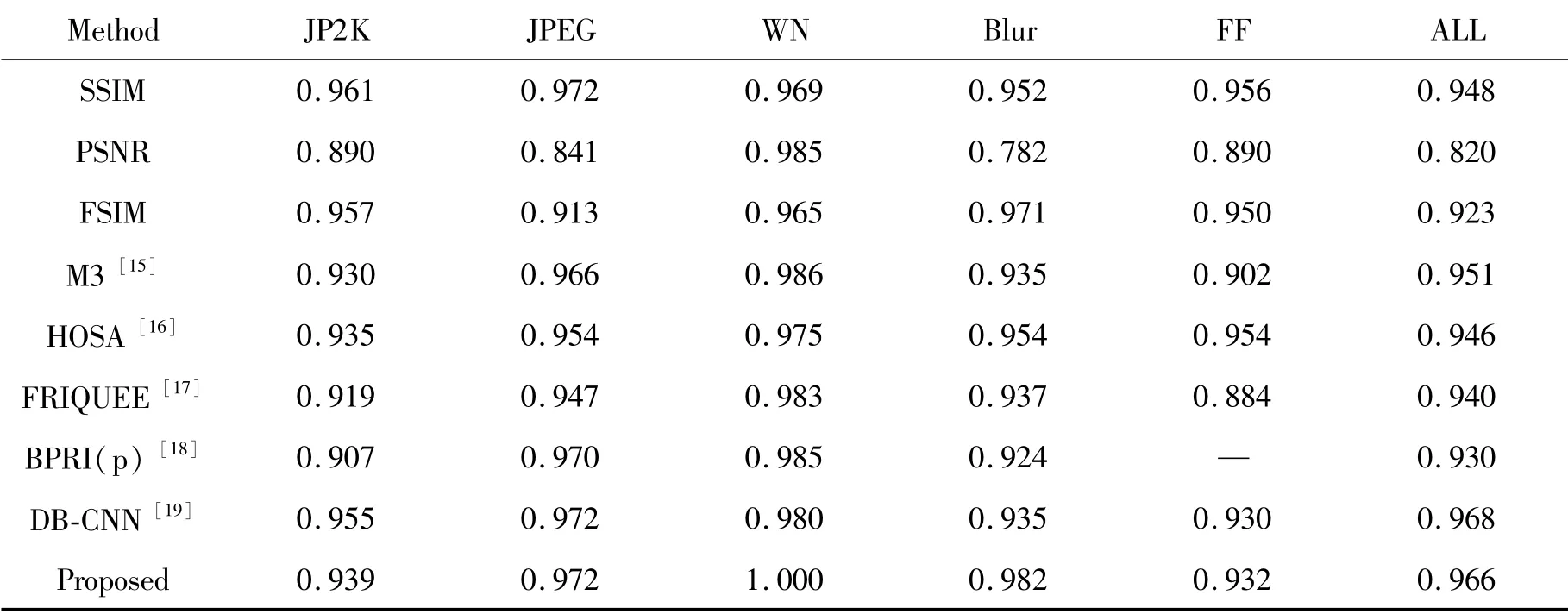

本文在LIVE圖像庫、TID2013圖像庫和LIVE MD圖像庫上進行了實驗。為了減小數據分布差異,將圖像數據庫中的標簽歸一化在(0~1)。每個圖像庫都被分為訓練集、驗證集和測試集三個數據集,分別占圖像庫中圖片數量的80%、10%和10%。這三個數據集中的數據相互獨立,互不重疊,保證了實驗的公平性。將LIVE圖像庫上的實驗結果與三種有效的全參考方法(SSIM[12]、PSNR[13]和FSIM[14])和五種近期的無參考方法(M3[15]、HOSA[16]、FRIQUEE[17]、BPRI(p)[18]和DB-CNN[19])進行比較,如表1所示。

表1 網絡結構參數Table 1 Network structure parameters

LIVE圖像庫上實驗獲得的評價指標如表2和表3所示。本文所提出的方法與對比方法存在競爭性。雖然在預測JP2K和FF失真時,本文方法得到的SROCC值低于全參考方法SSIM,但是在預測WN和Blur失真時,本文實驗結果極其接近真實值。在總體失真上,本文方法獲得了較為優異的結果。

表2 不同方法在LIVE圖像庫上獲得的PLCC值Table 2 PLCC values obtained by different methods in LIVE image library

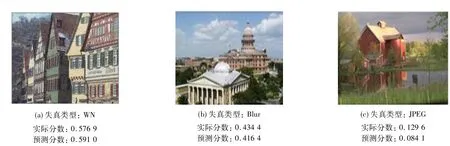

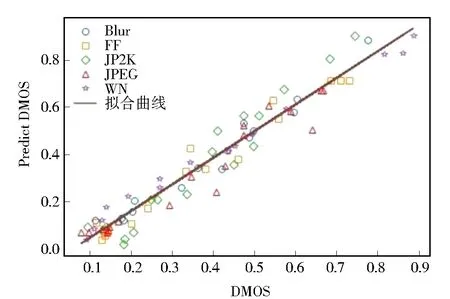

LIVE圖像庫中隨機抽取的三張失真圖像如圖5所示,其中標注了失真類型、預測分數與實際分數。可以看出,使用本文模型得出的預測分數非常接近人為打分。不同失真類型的預測值和DMOS的散點圖如圖6所示,其中橫坐標是圖像標簽,縱坐標是預測分數。可以看出,散點分布集中且呈線性分布,說明所提出的方法與人類主觀評分一致。

表3 不同方法在LIVE圖像庫上獲得的SROCC值Table 3 SROCC values obtained by different methods in LIVE image library

圖5 LIVE圖像庫中部分失真圖像的預測分數Fig.5 Prediction of partial distortion images in LIVE image library

圖6 LIVE圖像庫中的預測值與DMOS值的散點圖Fig.6 Scatter plots of predicted values and DMOSvalues in LIVE image library

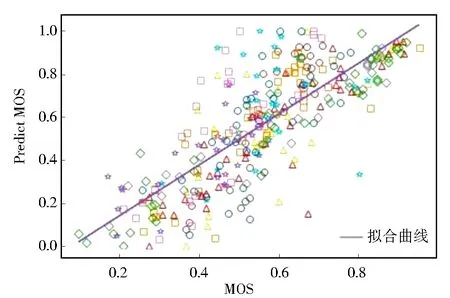

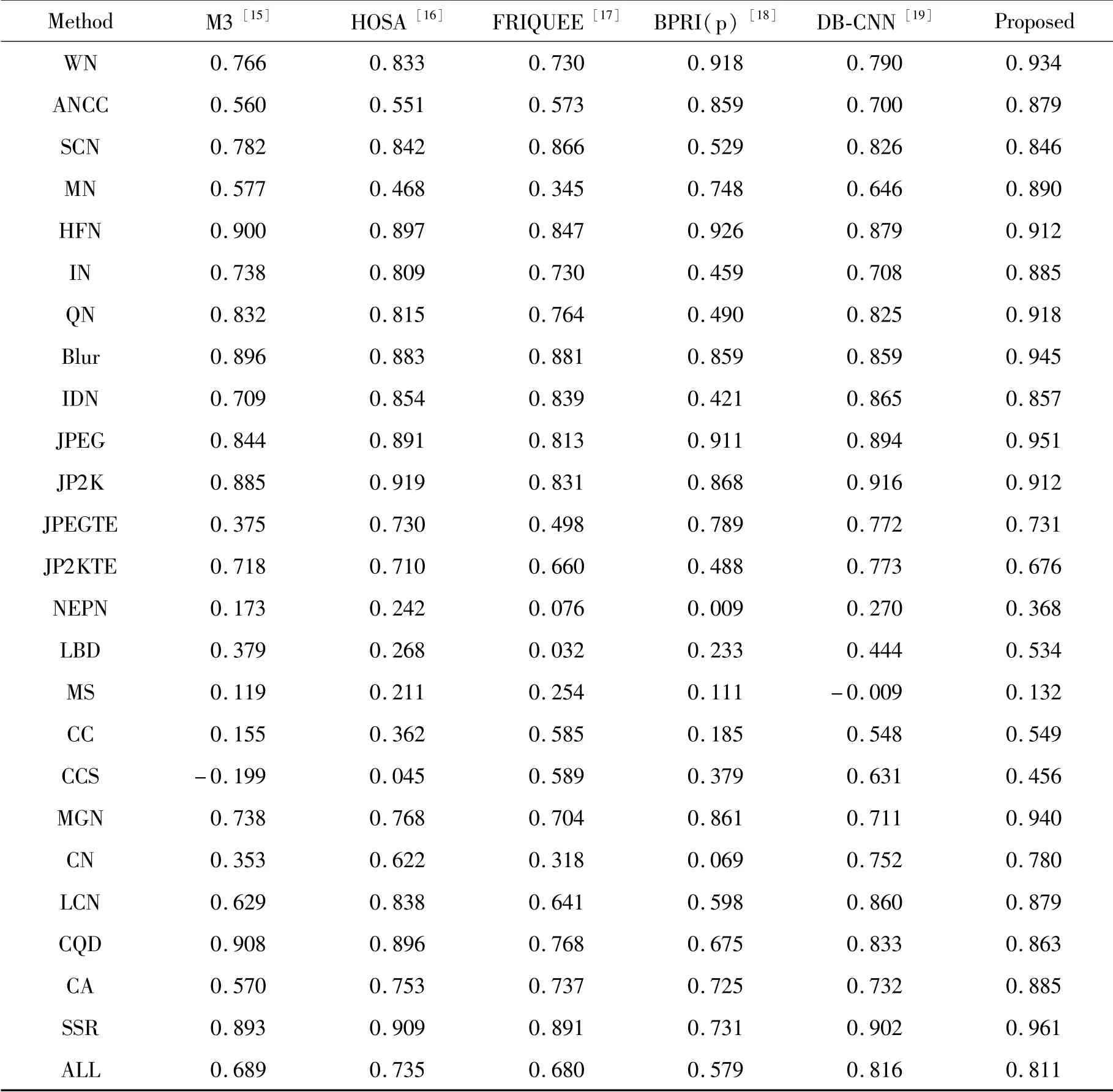

本文方法與對比方法在TID2013圖像庫上獲得的SROCC值如表4所示。TID2013圖像庫是最具挑戰性的合成數據庫。在總體失真上,本文方法略低于DB-CNN方法所獲得的結果,相差0.5%左右;然而大部分單失真類型上,本文方法獲得了優異的結果,表現出了對單失真預測的優越性能,尤其是對噪聲失真圖像的預測能力更強。在NEPN、LBD、CC、CCS和MS失真上,對比方法的SROCC值都在0.63以下。不同失真類型的預測值和MOS值的散點圖如圖7所示。可以看出,絕大多數散點圍繞在擬合曲線周圍,分布集中,說明本文模型具有良好的性能。

圖7 TID2013圖像庫中的預測值與MOS值的散點圖Fig.7 Scatter plots of predicted values and MOS values in TID2013 image library

表4 不同方法在TID2013圖像庫上獲得的SROCC值Table 4 SROCC values obtained by different methods in TID2013 image library

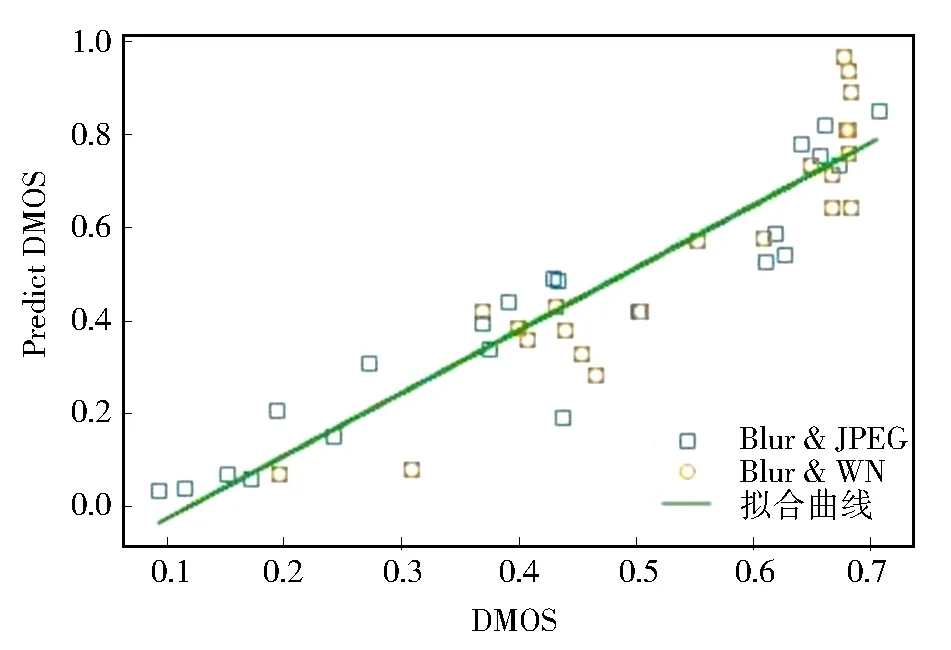

本文方法與對比方法在LIVEMD圖像庫上獲得的PLCC值和SROCC值如表5所示。LIVEMD庫上的預測值與DMOS值的散點圖如圖8所示。實驗數據表明,該方法在評價混合圖像上也展現了良好的性能,進一步證實了本文方法的有效性。

表5 不同方法在LIVEMD圖像庫上獲得的PLCC和SROCC值Table 5 PLCC and SROCC values obtained by different methods in LIVEMD image library

圖8 LIVEMD圖像庫上的預測值與DMOS值的散點圖Fig.8 Scatter plots of predicted values and DMOS values in LIVEMD image library

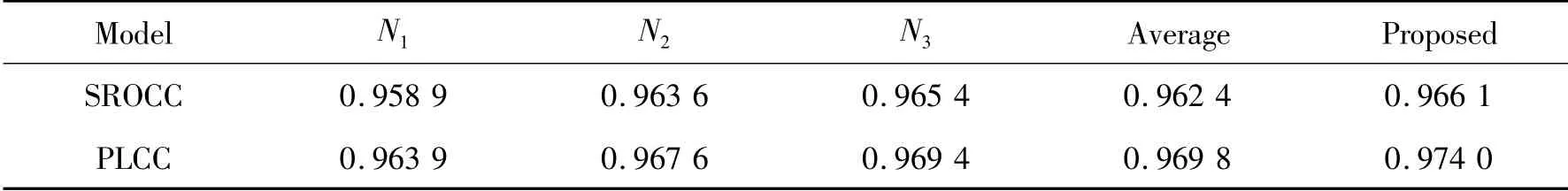

3.2 單輸出網絡的實驗對比

實驗使用了與本文模型相同的參數設置來訓練三個單獨的單輸出網絡。它們是三個簡單的卷積神經網絡,將其分別命名為N1、N2和N3。N1包括兩個卷積層、一個池化層和兩個全連接層;N2包括三個卷積層、兩個池化層和兩個全連接層;N3包括四個卷積層、三個池化層和兩個全連接層。不同方法在LIVE庫上的實驗結果如表6所示,其中“Average”的含義是每張圖像的質量得分為N1、N2和N3網絡的預測得分的平均值。可以看出,本文提出的多輸出模型提升了圖像質量評估的性能,優于多個單輸出網絡預測分數的平均值。原因是較深層的權重調整受到共享淺層的定向訓練的影響,反之亦然。實驗結果進一步證實了多輸出網絡的魯棒性。

表6 對比方法在LIVE圖像庫上獲得的結果Table 6 Results of comparison methods in LIVE image library

3.3 模型參數比較與分析

3.3.1 圖像塊大小的影響

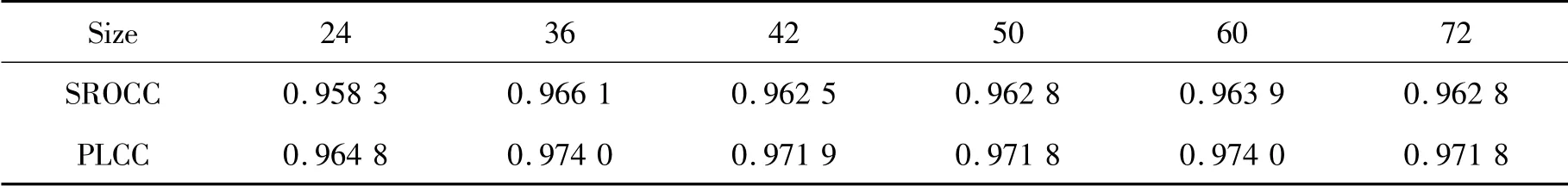

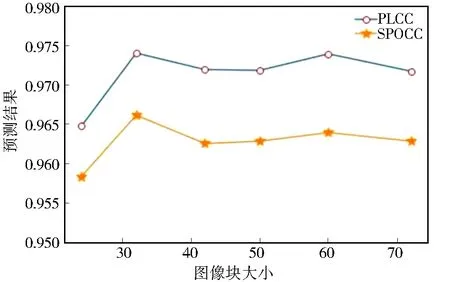

為了滿足網絡的訓練需求,本文采用非重疊采樣的數據增強方式擴充數據集。圖像的預測得分為每個圖像小塊預測分數的和的均值,所以圖像塊大小可能會對實驗結果產生影響。本文在訓練階段使用了6種大小的圖像塊。不同圖像塊大小在LIVE庫上的實驗結果如表7所示,最優結果在表格中顯示。為了直觀地顯示預測結果的趨勢,用折線圖予以展示。由表7和圖9的結果可知,圖像塊大小對實驗結果的影響并不是很大。雖然小尺寸的圖像塊能夠極大地增加數據量,但是其包含較少的失真特征信息,效果較差,例如24×24的圖像塊;而大尺寸的圖像塊會導致訓練參數增多,訓練時間加長。綜合考慮,選擇了36×36的圖像塊。

表7 不同大小的圖像塊在LIVE圖像塊上獲得的結果Table 7 Results of different size image blocks on LIVE image blocks

圖9 圖像塊大小和預測結果的關系圖Fig.9 Relationship between image block sizes and prediction results

3.3.2 卷積核大小的影響

卷積操作是通過卷積核作用于局部圖像提取圖像信息的一種局部操作。本文測試了卷積核大小對模型的影響,不同卷積核大小在LIVE庫上的實驗結果如表8所示,表格中的符號“/”表示模型未收斂。使用四種尺寸卷積核時,網絡訓練的損失曲線圖如圖10所示。可以看出,使用3×3、5×5和7×7大小的卷積核的模型均能夠達到收斂狀態;使用9×9大小的卷積核時,損失曲線上下振蕩,網絡不收斂。雖然卷積核尺寸越大,感受也越大,但是大卷積核在訓練時會導致參數增多,從而需要更多的樣本。考慮到這種在計算復雜性和性能之間的平衡,本文將卷積核大小定為5×5。

表8 不同卷積核大小在LIVE圖像庫上的結果Table 8 Results of different convolution kernel sizes in LIVE image library

圖10 使用不同大小卷積核模型的損失曲線Fig.10 Loss curves of convolution kernel models with different sizes

4 池化類型的影響

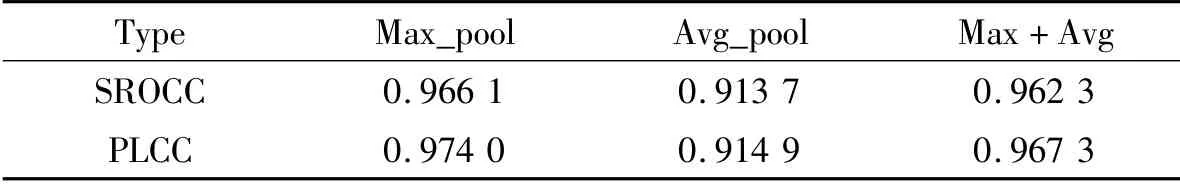

研究了兩種池化類型對模型的影響,即最大池化和均值池化。使用最大池化、均值池化和組合池化策略時模型的預測結果如表9所示。表格中,Max_pool表示最大池化,Avg_pool表示均值池化。最大池化能夠更多地保留圖像的紋理信息,而均值池化保留了更多的圖像背景信息[20]。由表中數據可知,使用均值池化效果較差,使用最大池化具有優勢,所以選擇采用最大池化。

表9 不同池化類型在LIVE圖像庫上獲得的結果Table 9 Results of different pooling types on LIVE image database

5 結 論

大多數基于深度學習的圖像質量評價工作使用單輸出的深度網絡。本文提出了一種基于卷積神經網絡的多輸出圖像質量評價模型,可以同時學習淺層特征和高層特征,分別回歸到主觀評分上,最后平均多個輸出的分數作為最終質量得分。這種多輸出模型的一種優勢是,兼顧了不同層卷積特征,具備了集成學習的特點,使模型的性能更加魯棒。實驗結果表明,本文模型具有優異的性能,與人類主觀感受保持較高的一致性。