基于卷積神經(jīng)網(wǎng)絡(luò)的智能抓取系統(tǒng)研究

韓毅 郭圓輝 王旭彬

摘要:改革開放以來,國(guó)內(nèi)工業(yè)蓬勃發(fā)展。時(shí)至今日,現(xiàn)代工業(yè)化進(jìn)程已經(jīng)成為未來工業(yè)發(fā)展的重中之重,而工業(yè)化中最為重要的環(huán)節(jié)即現(xiàn)代工業(yè)的智能化、自動(dòng)化。智能機(jī)器人可以高效地完成自動(dòng)抓取、搬運(yùn)等工作。筆者研究了基于卷積神經(jīng)網(wǎng)絡(luò)的智能抓取系統(tǒng),使其實(shí)現(xiàn)了目標(biāo)分類、目標(biāo)定位、目標(biāo)抓取等功能。首先對(duì)需要抓取的目標(biāo)使用卷積神經(jīng)網(wǎng)絡(luò)進(jìn)行訓(xùn)練,得到識(shí)別目標(biāo)位置與分類信息的卷積神經(jīng)網(wǎng)絡(luò)模型;然后利用張正友標(biāo)定法對(duì)深度相機(jī)進(jìn)行標(biāo)定,得到相機(jī)的內(nèi)參矩陣;隨后通過雙邊濾波對(duì)圖像進(jìn)行降噪處理,將處理后的圖像輸入預(yù)先訓(xùn)練的卷積神經(jīng)網(wǎng)絡(luò)模型,從卷積神經(jīng)網(wǎng)絡(luò)模型中得到目標(biāo)的位置信息與分類信息;然后通過相機(jī)的內(nèi)外參信息逆向求解得到機(jī)械臂需要抓取的位置坐標(biāo)信息;最后用機(jī)械臂完成抓取。在試驗(yàn)的過程中,使用了dobot與realsense d435i進(jìn)行驗(yàn)證。試驗(yàn)結(jié)果表明,該系統(tǒng)定位誤差較小,且有效地完成了目標(biāo)抓取任務(wù)。

關(guān)鍵詞:計(jì)算機(jī)視覺;卷積神經(jīng)網(wǎng)絡(luò);機(jī)械臂

中圖分類號(hào):TP391.41;TP242.2文獻(xiàn)標(biāo)識(shí)碼:A文章編號(hào):1003-5168(2021)35-0017-04

Study on Intelligent Grab System Based on Convolutional Neural Network

HAN YiGUO YuanhuiWANG Xubin(Department of Computer Science and Information Engineering, Anyang Institute of Technology, Anyang Henan 455000)

Abstract: Since the reform and opening up, domestic industrial construction has flourished. Today, today, the modern industrialization process has become the weight of the future industrial development. The most important part of in? dustrialization is the intelligent and automation of modern industries. And smart robots can efficiently complete auto? matic capture, handling, etc. This paper studies intelligent grabbing systems based on convolutional neural networks. Achieve job classification, target positioning, and goal. First, consolidation neural network training is used to identify the target position and classification information. The depth camera is then calibrated with the Zhang Zhengyou cali? bration method to obtain an interior matrix of the camera. The image is then documented by bilateral filtering, and the processed image inputs the pre-training convolutional neural network model. Classification information of the loca? tion information and the target of the target from the convolutional neural network model. Then, the position coordi? nate information of the robot arm needs to be grabbed by the internal and external information of the camera. Finally, use the robot arm to accomplish. During the experiment, dobot is used to verify the realsense d435i. The experimental results show that the positioning error is small, and the target’s grab task is completed.

Keywords: computer vision;convolutional neural network;robotic arm

在智能工業(yè)化飛速發(fā)展的今天,智能機(jī)器人在工業(yè)制造中充當(dāng)著重要角色,可以高效地替代人工,具有成本低、效率高等優(yōu)勢(shì)。但是在機(jī)器人的工作流程、施工方式、準(zhǔn)確性及效果等方面依然有許多研究難題待攻克。

對(duì)目前大部分工業(yè)制造而言,使用機(jī)器人對(duì)目標(biāo)進(jìn)行抓取時(shí)需要采用統(tǒng)一位置、統(tǒng)一移動(dòng)路線和統(tǒng)一抓取位置,然后按照預(yù)先準(zhǔn)備的路線進(jìn)行工作。該方案在實(shí)際應(yīng)用中存在較大的局限性,當(dāng)外界環(huán)境發(fā)生改變或?qū)ぜM(jìn)行更換時(shí),需要對(duì)系統(tǒng)進(jìn)行較大的修改,導(dǎo)致其維護(hù)成本較高。而戴健春等人提出的基于模板匹配的方法,雖然對(duì)工件的模板進(jìn)行提取和匹配[1-3],解決了傳統(tǒng)工業(yè)制造中固定路線、固定路徑的問題,但是在面對(duì)場(chǎng)景改變、物件更換等情況時(shí),會(huì)出現(xiàn)系統(tǒng)修改困難、模板替換復(fù)雜等問題。

基于深度學(xué)習(xí),將卷積神經(jīng)網(wǎng)絡(luò)技術(shù)應(yīng)用于機(jī)械臂的抓取中,實(shí)現(xiàn)了一種可以對(duì)目標(biāo)進(jìn)行分類和定位的智能機(jī)械臂分揀系統(tǒng),并通過實(shí)驗(yàn)驗(yàn)證了本方法的可行性。

1智能抓取系統(tǒng)

本設(shè)計(jì)的智能抓取系統(tǒng)由深度相機(jī)(realsense d435i)、機(jī)械臂(dobot magician)與PC機(jī)(具有深度學(xué)習(xí)環(huán)境的計(jì)算機(jī))組成,深度相機(jī)與機(jī)械臂實(shí)物分別如圖1、圖2所示。

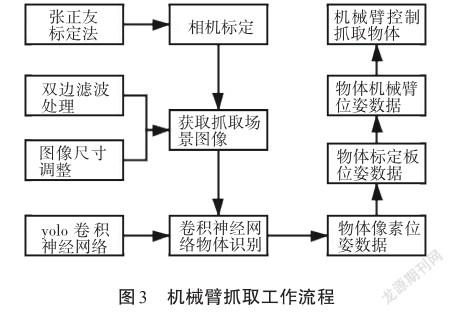

機(jī)械臂與深度相機(jī)都放置于工作臺(tái)上方,工作臺(tái)由三部分組成:抓取區(qū)域、深度攝像頭放置區(qū)與機(jī)械臂放置區(qū)域。其中抓取區(qū)域放置一個(gè)7格×9格的黑白標(biāo)定板,便于校正攝像頭畸變參數(shù);深度攝像頭使用支架固定于抓取區(qū)域正上方,負(fù)責(zé)采集抓取場(chǎng)景下的圖像數(shù)據(jù);機(jī)械臂負(fù)責(zé)完成對(duì)目標(biāo)的抓取。機(jī)械臂抓取時(shí),其工作流程如圖3所示。

首先進(jìn)行深度相機(jī)的標(biāo)定工作,使用攝像頭采集標(biāo)定板的數(shù)據(jù),隨后將這些圖像通過USB端口上傳至PC機(jī),PC機(jī)使用張正友標(biāo)定法對(duì)相機(jī)進(jìn)行標(biāo)定,并建立攝像機(jī)位姿數(shù)據(jù)與標(biāo)定板位置數(shù)據(jù)的模型[4]。然后使用深度相機(jī)采集抓取區(qū)域的圖像數(shù)據(jù),并將采集的圖像流上傳至PC機(jī),PC機(jī)通過使用中值濾波對(duì)相機(jī)圖像數(shù)據(jù)進(jìn)行調(diào)整。隨后將調(diào)整后的圖像信息輸入卷積神經(jīng)網(wǎng)絡(luò)模型,卷積神經(jīng)網(wǎng)絡(luò)模型輸出目標(biāo)在圖像中的位姿數(shù)據(jù),隨后根據(jù)通過標(biāo)定建立起的數(shù)學(xué)模型計(jì)算出目標(biāo)在標(biāo)定板的位姿數(shù)據(jù)。最后將標(biāo)定板的位姿數(shù)據(jù)轉(zhuǎn)換為機(jī)械臂抓取的位姿數(shù)據(jù),并控制機(jī)械臂完成抓取任務(wù)。

2卷積神經(jīng)網(wǎng)絡(luò)目標(biāo)識(shí)別

使用機(jī)械臂抓取不同顏色的立方體,首先要在場(chǎng)景下對(duì)目標(biāo)進(jìn)行識(shí)別,隨后根據(jù)目標(biāo)的像素位置計(jì)算出目標(biāo)的抓取位置。采用卷積神經(jīng)網(wǎng)絡(luò)對(duì)目標(biāo)進(jìn)行識(shí)別,首先需要進(jìn)行模型訓(xùn)練,隨后根據(jù)模型進(jìn)行目標(biāo)的識(shí)別與定位。圖像數(shù)據(jù)處理算法包含以下幾個(gè)步驟:①卷積神經(jīng)網(wǎng)絡(luò)模型的選擇;②數(shù)據(jù)集的標(biāo)定與處理;③卷積神經(jīng)網(wǎng)絡(luò)模型的訓(xùn)練與測(cè)試。

2.1卷積神經(jīng)網(wǎng)絡(luò)模型的選擇

目前使用卷積神經(jīng)網(wǎng)絡(luò)訓(xùn)練目標(biāo)識(shí)別模型的大致思路有兩種:one-stage方法與two-stage方法。其中twostage方法思想為:先生成候選框,隨后映射到全連接層進(jìn)行分類和回歸。而one-stage方法的思想為:放棄生成候選框的環(huán)節(jié),直接從主干網(wǎng)絡(luò)中獲取目標(biāo)的類別與位置信息。Two-stage方法的優(yōu)點(diǎn)是目標(biāo)識(shí)別準(zhǔn)確度較高,但其有一個(gè)明顯的弊端,即算法耗時(shí)較長(zhǎng)。而本實(shí)驗(yàn)中的抓取目標(biāo)僅為普通的方塊,因此one-stage方法足以精確地完成識(shí)別工作。此外,目標(biāo)識(shí)別環(huán)節(jié)耗時(shí)較長(zhǎng)會(huì)直接影響機(jī)械臂工作的連續(xù)性,因此one-stage方法更適用于本系統(tǒng)。YOLO算法是一個(gè)典型的one-stage方法。

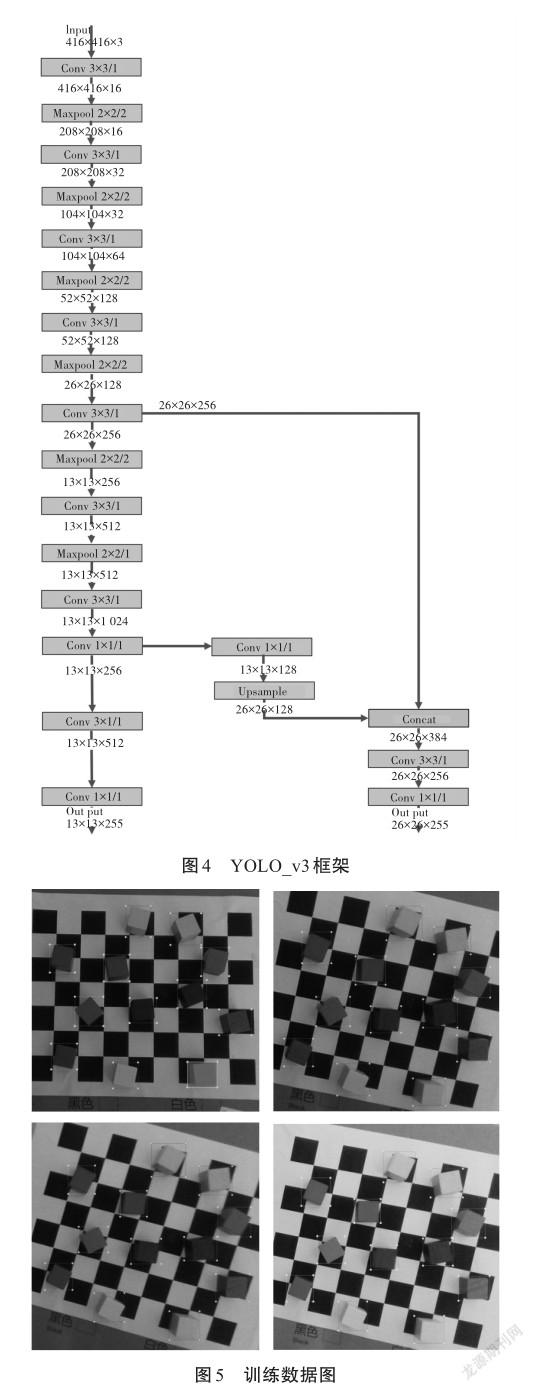

YOLO_v3框架如圖4所示,由相機(jī)采集的416 px×416 px×3 channel的RGB圖像作為網(wǎng)絡(luò)的輸入,輸出13×13×87與26×26×87的向量矩陣分別為YOLO_v3-tiny對(duì)目標(biāo)預(yù)測(cè)的分類信息與位置信息[5]。

2.2數(shù)據(jù)集的標(biāo)定與處理

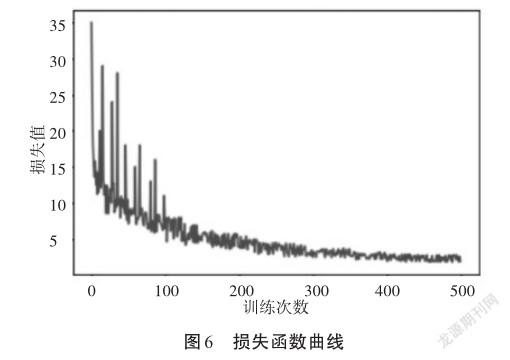

通過移動(dòng)攝像頭采集了一段時(shí)長(zhǎng)為10 min的RGBD視頻,視頻中分別有不同方向與距離下的目標(biāo)圖像數(shù)據(jù),按照每2 s為一步的步長(zhǎng)進(jìn)行裁剪,得到300張目標(biāo)圖像。隨后,對(duì)圖像進(jìn)行標(biāo)定,使用圖像標(biāo)注軟件LabelMe在圖像中標(biāo)記每個(gè)目標(biāo)的位置信息并存儲(chǔ)到訓(xùn)練數(shù)據(jù)中。隨后,將圖片調(diào)整至416 px×416 px。通過平移、旋轉(zhuǎn)、裁剪等操作對(duì)數(shù)據(jù)進(jìn)行增強(qiáng),得到900張訓(xùn)練數(shù)據(jù),部分訓(xùn)練數(shù)據(jù)如圖5所示。

2.3卷積神經(jīng)網(wǎng)絡(luò)模型的訓(xùn)練與測(cè)試

選取了80%的數(shù)據(jù)作為訓(xùn)練數(shù)據(jù),20%的數(shù)據(jù)作為測(cè)試數(shù)據(jù),批量大小為32,訓(xùn)練次數(shù)為500,選擇GTX2080 TI GPU進(jìn)行訓(xùn)練。得到的損失函數(shù)曲線如圖6所示。

從圖6的數(shù)據(jù)表現(xiàn)來看,隨著訓(xùn)練次數(shù)的增加,損失值已經(jīng)基本收斂。

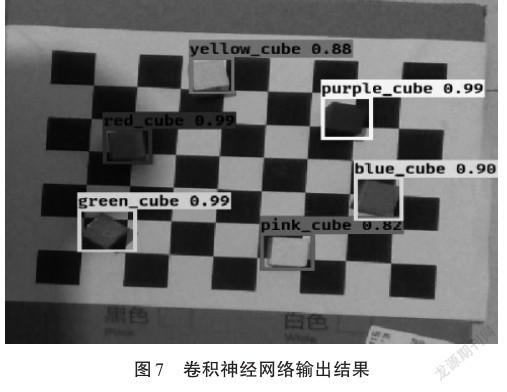

隨后,深度相機(jī)的圖像數(shù)據(jù)經(jīng)過雙邊濾波處理后作為卷積神經(jīng)網(wǎng)絡(luò)的輸入[6],經(jīng)過卷積神經(jīng)網(wǎng)絡(luò)后,得到目標(biāo)的位置信息以及分類數(shù)據(jù),將分類信息與位置繪制到圖像中,如圖7所示。

3試驗(yàn)結(jié)果

以四軸機(jī)械臂dobot magician作為取機(jī)械臂,以intel realsense d435i為抓取場(chǎng)景采集裝置,采用配置為Intel i78750H+GTX 1050TI的PC處理圖像數(shù)據(jù)。其中處理平臺(tái)操作系統(tǒng)為Windows 10,基于Python 3.7與tensorflow 1.14.0開發(fā)出基于以上設(shè)備的自主抓取程序。

3.1相機(jī)標(biāo)定實(shí)驗(yàn)

使用張正友標(biāo)定法對(duì)相機(jī)進(jìn)行內(nèi)參矩陣求解,然后通過OpenCV角點(diǎn)提取得到相機(jī)與棋盤格的部分坐標(biāo)信息,最后通過逆矩陣求解得到相機(jī)坐標(biāo)系與機(jī)械臂坐標(biāo)系之間的關(guān)系。

使用相機(jī)從不同方向拍攝棋盤格的圖像,然后使用OpenCV求出相機(jī)的內(nèi)參矩陣信息,相機(jī)采集的部分標(biāo)定板圖像如圖8所示。

依照相機(jī)標(biāo)定得到的內(nèi)參矩陣與外參矩陣,即可得到圖像與機(jī)械臂之間的點(diǎn)對(duì)點(diǎn)關(guān)系。

3.2目標(biāo)物體分類定位與抓取實(shí)驗(yàn)

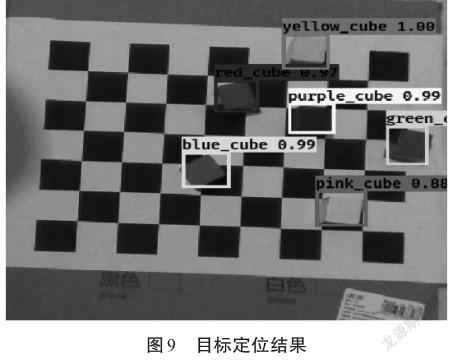

以不同顏色的物塊為定位目標(biāo),在不同場(chǎng)景下對(duì)物塊進(jìn)行分類、定位。以標(biāo)定框的中心為抓取中心坐標(biāo)原點(diǎn),然后根據(jù)深度攝像頭的深度距離,計(jì)算出實(shí)際地面高度并進(jìn)行轉(zhuǎn)換,得出目標(biāo)物體的世界坐標(biāo),為下一個(gè)實(shí)驗(yàn)中機(jī)械臂的抓取做準(zhǔn)備。定位的目標(biāo)結(jié)果如圖9所示。

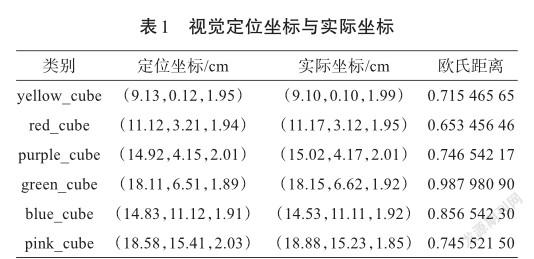

如圖9所示,共檢測(cè)出6個(gè)不同的目標(biāo)物體,將歐氏距離的大小作為評(píng)價(jià)指標(biāo),以棋盤格坐標(biāo)系為實(shí)際坐標(biāo)系,坐標(biāo)測(cè)量結(jié)果如表1所示。

通過表1數(shù)據(jù)可知,預(yù)測(cè)坐標(biāo)與實(shí)際坐標(biāo)的歐氏距離范圍為(0.653 456 46,0.987 980 90),精度良好。

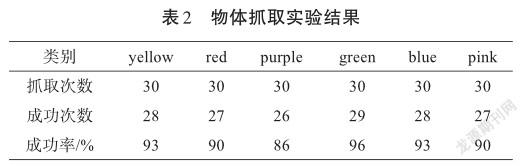

隨后通過PC機(jī)控制機(jī)械臂抓取目標(biāo)物體,每個(gè)物體共進(jìn)行了30次抓取測(cè)試,合計(jì)180次。在整個(gè)實(shí)驗(yàn)中,平均抓取成功率為91.33%,具體實(shí)驗(yàn)結(jié)果如表2所示。

4結(jié)語

在本系統(tǒng)設(shè)計(jì)中,將深度學(xué)習(xí)中的卷積神經(jīng)網(wǎng)絡(luò)技術(shù)引入機(jī)械臂的智能抓取中,通過卷積神經(jīng)網(wǎng)絡(luò)對(duì)待抓取物體進(jìn)行分類、定位等操作,隨后利用張正友標(biāo)定法求出相機(jī)的焦距、變換矩陣等信息,進(jìn)而求出圖像與機(jī)械臂的變換矩陣,實(shí)現(xiàn)了利用深度學(xué)習(xí)對(duì)物體的分類、定位、抓取。本方法相較于傳統(tǒng)方法中利用計(jì)算機(jī)視覺對(duì)物體進(jìn)行輪廓匹配的方法具有較大的改進(jìn),有效地解決了傳統(tǒng)方法中不同物體需要不同的匹配方法、計(jì)算量較大、編碼復(fù)雜等問題,對(duì)現(xiàn)代工業(yè)機(jī)械臂抓取、物體分類抓取等應(yīng)用具有重要意義。

參考文獻(xiàn):

[1]戴健春.基于RGB-D相機(jī)的工業(yè)機(jī)器人定位抓取技術(shù)與系統(tǒng)集成研究[D].重慶:重慶郵電大學(xué),2018:1-72.

[2]苗彭.基于視覺的機(jī)械臂工件抓取系統(tǒng)研究[D].天津:天津理工大學(xué),2019:1-64.

[3]姚啟才,汪地,廖茂生.基于機(jī)器視覺的機(jī)械臂智能抓取系統(tǒng)設(shè)計(jì)[J].計(jì)量與測(cè)試技術(shù),2020(10):28-33.

[4]ZHANG Z Y.A flexible new technique for camera calibration[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2000(11):1330-1334

[5]REDMON J,F(xiàn)ARHADI A.YOLOv3: An incremental improvement[EB/OL].(2018-04-08)[2021-10-28].https://arxiv.org/ abs/1804.02767.

[6]CHAUDHURY K N,SAGE D,UNSER M.Fast O(1) bilateral filtering using trigonometric range kernels[J].IEEE Transactions on Image Processing A Publication of the IEEE Signal Processing Society,2011(12):3376.