基于Yolov5的快速雙目立體視覺測距研究

張仲楠 霍煒 廉明 楊磊

摘要: ?針對傳統雙目測距方法存在的需要對攝像頭進行標定、立體匹配算法時間復雜度高等問題,本文主要對快速雙目立體視覺測距進行研究。給出了雙目測距原理,提出了一種基于Yolov5的目標檢測算法和徑向基函數神經網絡相結合的雙目測距方法,建立了基于徑向基函數神經網絡的距離預測模型,并采用神經網絡中的徑向基函數神經網絡進行距離預測。實驗結果表明,經過訓練的優化模型,能實時目標檢測、快速計算出目標距離,實時性大幅增加,預測距離的精度可達977%。同時,徑向基函數神經網絡與卷積神經網絡相結合的方法,在雙目測距中具有速度快、精度高的特點。該方法無需對攝像頭進行標定,充分利用目標檢測得到的信息,簡化圖像匹配算法。該研究對自主移動機器人和無人駕駛汽車具有重要意義。

關鍵詞: ?目標檢測; 雙目立體視覺; 深度學習; Yolov5

中圖分類號: TP391.41 ?文獻標識碼: A

2.2 Yolov5目標檢測與特征提取

Yolov5[16]相比于Yolov3[1718]和Yolov4[1920]具有更快的速度,占用更小的內存空間和更高的準確率。使用配置環境更簡單的PyTorch生態系統,在Colab notebook上運行Tesla P100,速度可達140 幀/s。本實驗選取滅差、面積比和類別標簽作為Yolov5模型的輸出特征。

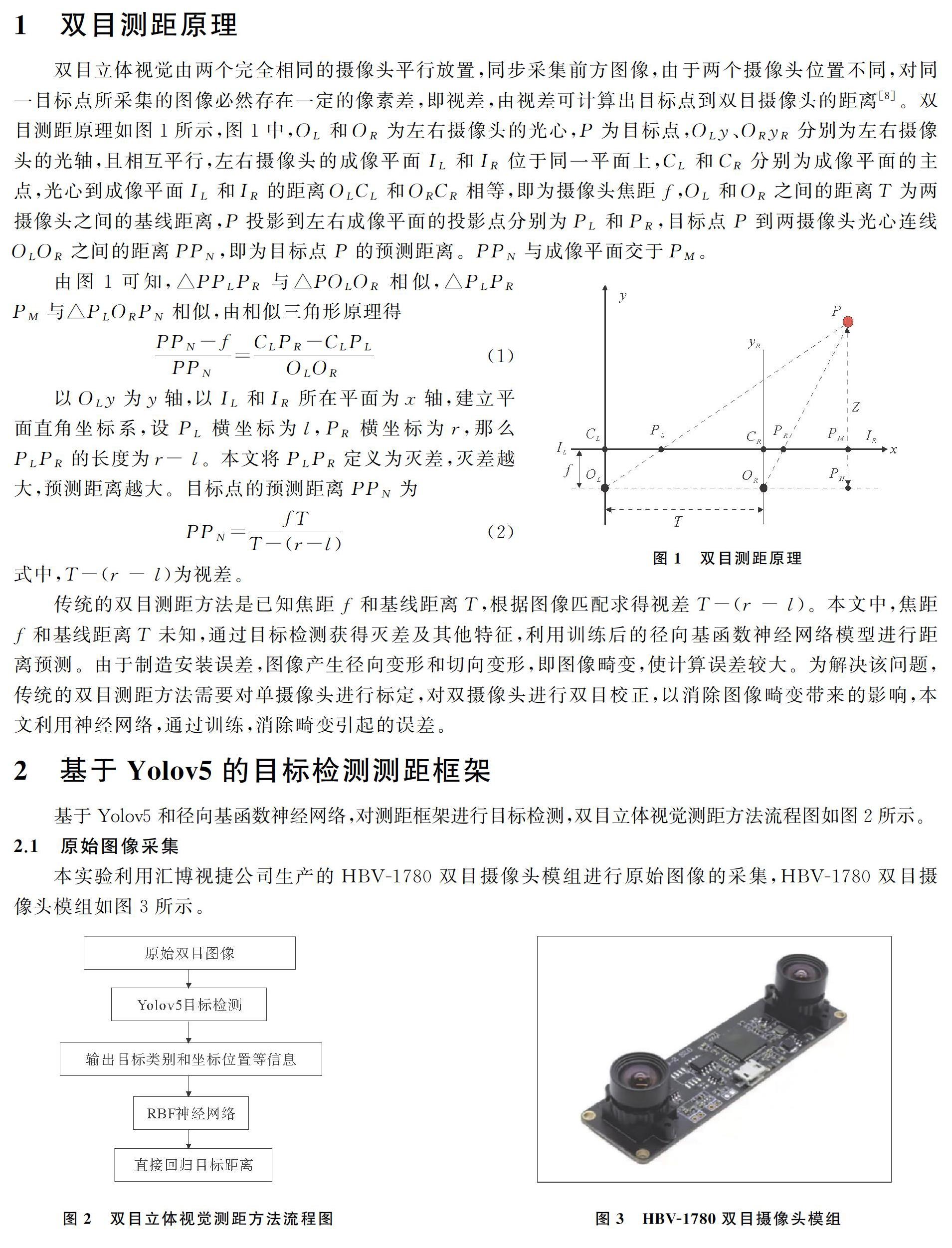

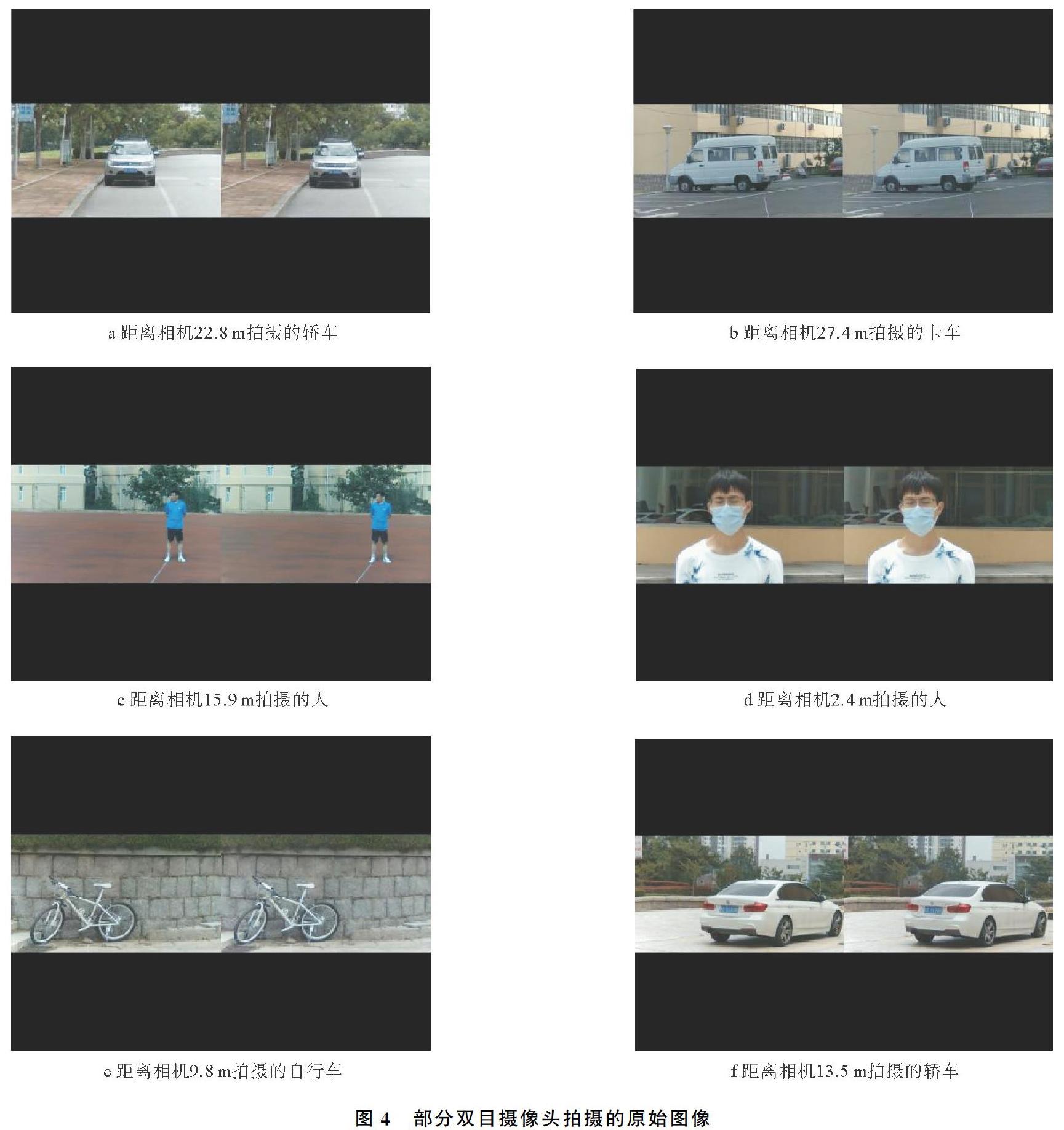

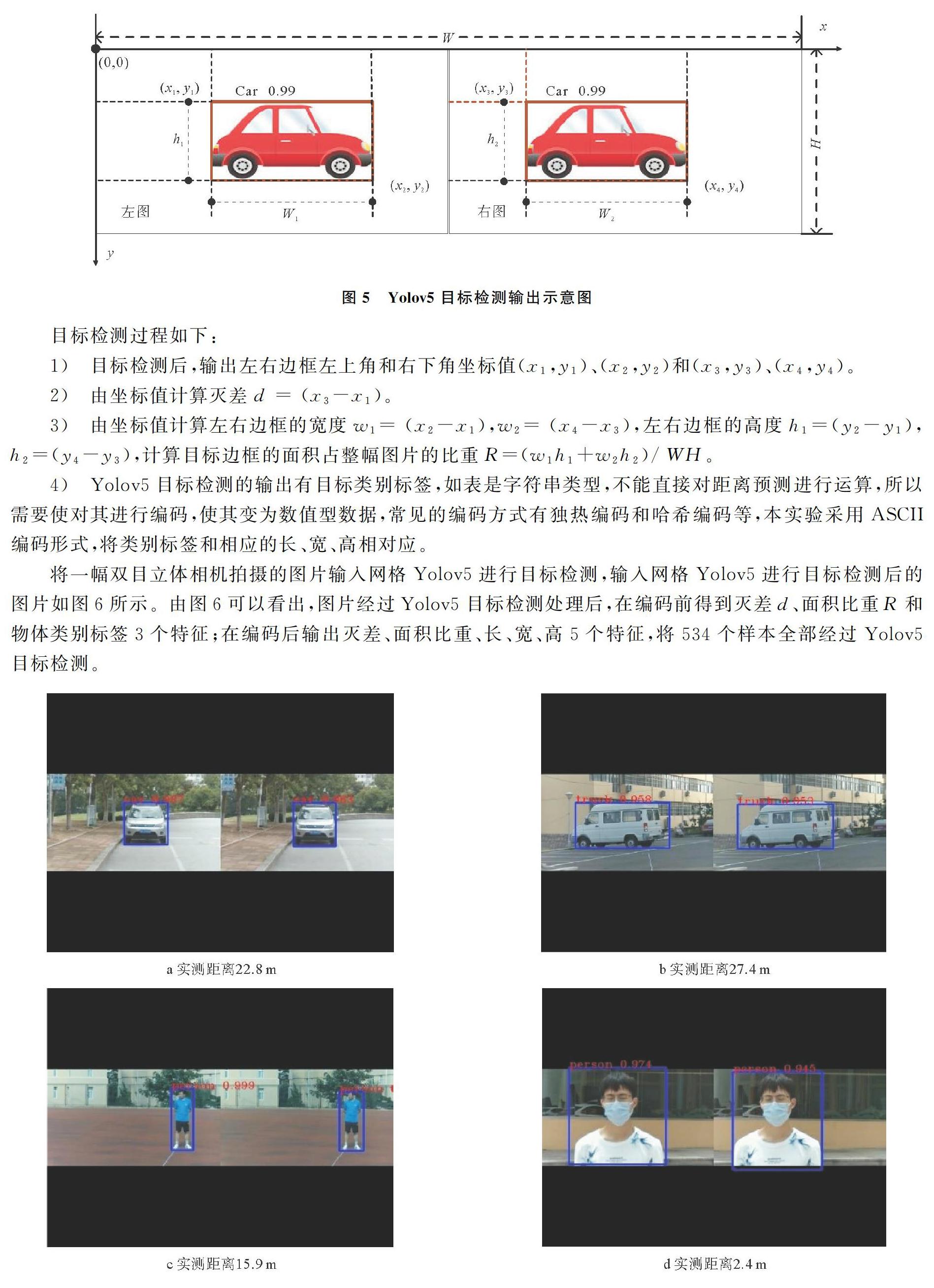

將雙目攝像頭獲得的圖像進行Yolov5處理,得到可視化圖像,并以圖片左上角為原點,水平向右為x軸正方向,豎直向下為y軸正方向,以像素為單位建立圖像坐標系。Yolov5目標檢測輸出示意圖如圖5所示。

3 基于徑向基函數神經網絡的距離預測模型

本實驗采用神經網絡中的徑向基函數神經網絡進行距離預測。將表1中得到的輸出特征作為徑向基函數網絡的輸入特征,其輸出特征是物體與相機的距離,已知滅差、面積比重、長、寬、高5個特征預測距離,這

本數據中選擇中心點(記憶樣本),利用聚類算法,得到中心點;二為監督學習,輸入樣本經過RBF徑向基神經網絡,將求得的預測距離與實際距離之間誤差進行權值調整。對全部534個樣本拆分成2個Batch,每個Batch有267個樣本,共訓練100個Epoch,對訓練過程可視化,損失函數與準確率隨迭代次數變化曲線如圖8所示。

由圖8可以看出,損失函數一直在減小,說明徑向基函數神經網絡已經很好的擬合了預測距離的非線性函數。同時,準確率在增大,并隨著訓練的Epoch的增大,逐漸趨近于100%。

4 實驗結果

本實驗將每個樣本的實際距離、預測距離和誤差進行對比,部分預測值與實際值對比結果如表2所示。

由此可以計算出,全部534個樣本的均方誤差為27%。在不同硬件平臺下,雙目測距方法的運行速度如表3所示。由表3可以看出,在型號為CPUi78550U的環境下,速度為21幀/s,使用1張英偉達顯卡RTX 1080Ti,其速度可實現43幀/s,該速度可以滿足實時性要求。

5 結束語

本文提出了一種基于Yolov5的目標檢測算法和徑向基函數神經網絡相結合的雙目測距方法。由于RBF徑向基函數神經網絡運算量較小,所以將Yolov5與RBF結合后的推理速度與Yolov5比相差不大,保證了實時性,同時,因為RBF徑向基函數神經網絡可以擬合任意復雜的非線性函數,所以預測距離的精度得以保證。由實驗數據可知,經過學習訓練之后,預測距離的準確程度與傳統的像素匹配方式預測距離相比,更加便捷,預測均方誤差僅為27%,實時性接近于Yolov5。本實驗存在的不足之處是采集的數據集全部為單個目標,即雙目攝像頭拍攝的場景中只有一個目標物體,對于多目標物體的場景測距問題解決方法與單目標物體場景類似,但對于多個物體的邊框匹配需要引入一些匹配算法,這也是本實驗今后深入研究的方向。

參考文獻:

[1] 孔令富, 李林, 張廣志. ?一種并聯機器人雙目主動視覺監測平臺避障方法的研究[J]. 燕山大學學報, 2009, 33(3): 189193.

[2] 曾德懷, 謝存禧, 張鐵, 等. 行走機器人的超聲波測距系統的研究[J]. 機械科學與技術, 2004, 23(5): 613616.

[3] 趙棟, 劉立人, 王吉明, 等. 基于光子數目比較的激光測距法[J]. 光學學報, 2006, 26(7): 10911096.

[4] 劉曉龍, 楊廣京, 羅楊宇, 等. 嵌入式移動機器人紅外路標定位模塊研究[J]. 計算機工程, 2013, 39(3): 203208.

[5] 劉科, 謝敬輝, 李卓, 等. 被動式光學測距誤差分析[J]. 光學技術, 2005, 31(4): 586587.

[6] 岳榮剛, 王少萍, 李凱, 等. 基于相似原理的新型雙目測距法[J]. 光電工程, 2008, 35(4): 6468.

[7] Li H G, Jin M, Zou L Y. A new binocular stereo visual servoing model[C]∥Workshop on Computational Intelligence and Industrial Application, 2008. PACIIA′08. PacificAsia. Wuhan, China: IEEE Computer Society, 2009.

[8] Marr D P T. Cooperative computation of stereo disparity[J]. Science, 1976, 194(4262): 283287.

[9] Veksler O. Stereo correspondence with compact windows via minimum ratio cycle[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence , 2002, 24(12): 16541660.

[10] Lowe D G. Distinctive image features from scaleinvariant keypoints[J]. International Journal of Computer Vision, 2004, 60(2): 91110.

[11] Etriby S, AlHamadi A, Michaelis B. Dense stereo correspondence with slanted surface using phasebased algorithm[C]∥IEEE International Symposium on Industrial Electronics. Vigo, Spain: IEEE, 2007: 18071814.

[12] Ryan T W, Gray R T, Hunt B R. Prediction of correlation errors in stereopair images[J]. Optical Engineering, 1980, 19(3): 312322.

[13] Klaus A, Sormann M, Karner K. Segmentbased stereo matching using belief propagation and a selfadapting dissimilarity measure[C]∥International Conference on Pattern Recognition. Graz, Austria: IEEE, 2006: 15.

[14] Wang L, Yang R G, Gong M L. Realtime stereo using approximated joint bilateral filtering and dynamic programming[J]. Journal of RealTime Image Processing, 2012, 9(3): 447461.

[15] Liu X Y, Li T H, Yu G H. Adaptive stereo matching algorithms for color stereo images[J]. Journal of Computer Applications, 2011, 31(1): 163166.

[16] Deng H F, Cheng J H, Liu T, et al. Research on iron surface crack detection algorithm based on improved YOLOv4 network[C]∥2nd International Conference on Artificial Intelligence and Computer Science. Hangzhou, China: Published under Licence by IOP Publishing Ltd, 2020: 2526.

[17] Tang C, Zhang G, Hu H G, et al. An improved YOLOv3 algorithm to detect molting in swimming crabs against a complex background[J]. Aquacultural Engineering, 2020, 91: 102115102124.

[18] Pang L, Liu H, Chen Y, et al. Realtime concealed object detection from passive millimeter wave images based on the YOLOv3 algorithm[J]. Sensors, 2020, 20(6): 16781693.

[19] Bochkovskiy A, Wang ChienYao, Mark Liao HongYuan. Yolov4: optimal speed and accuracy of object detection[C]∥Institute of Information Science Academia. Sinica, Taiwan: CVPR, 2020: 117.

[20] Chen W, Zhong X T, Zhang J. Optimization research and defect object detection of aeroengine blade boss based on Yolov4[C]∥2020 3rd International Conference on Modeling Simulation and Optimization Technologies and Applications. Beijing, China: Published under licence by IOP Publishing Ltd, 2021: 012076012084.