一種基于SIFT的照片檔案自動標注技術研究*

周文歡

(天津大學檔案館 天津 300072)

隨著數碼相機,手機等成像設備的普及和互聯網絡技術的飛速發展,現有的檔案信息量越來越大,信息的種類和形式也越來越豐富,尤其數字化(無紙)辦公產生大量電子文件,檔案中的照片檔案的數量成爆炸式的增長,同時大數據技術的產生也給照片檔案處理帶來了新的挑戰和機遇。目前每年檔案館歸檔入庫的照片檔案占相當比例,再加上館中庫存存檔的照片,其中絕大部分照片都不包含任何的標簽類別信息,如何對這些海量的照片進行檢索利用是一個很大的挑戰。如何自動的對大量的照片檔案進行類別標記以解決這一困難,進而提高照片檢索的準確率和效率,一直是研究人員所關注的熱點問題[1]。

本文的研究內容是針對圖像檢索的關鍵技術研究所遇到的問題展開的,研究的切入點是檔案中照片自動標注,在對圖像檢索中圖像自動標注算法進行了全面[2],深入的研究前提下,依據現有的理論基礎,對現有的特征和算法進行分析和總結,并提出了改進的特征和算法。

1 照片檔案標注技術的發展趨勢

照片檔案利用的核心在于照片檢索,檢索的任務是高效的管理和組織照片數據,以幫助用戶快速、準確、全面的從中找到感興趣的內容,其核心在于研究如何有效的利用檔案照片數據的文字、內容、語義信息學習訓練得到分類模型,再建立高效的索引,讓用戶在合理的時間內以較好的準確度找到所需要的照片,目前主要的照片標注方式有基于照片關鍵詞標注方式等

1.1 基于照片關鍵詞標注方式

照片關鍵詞標注是基于文本的照片檔案檢索的基礎,沿用傳統的文本檢索技術,通常用提供關鍵詞形式來查詢照片,或者是以類別等級目錄的方式呈現,用戶通過瀏覽查找特定類別下的照[3][4]。

1.1.1 具體實現方式

具體的實現過程中,首先分析照片所屬的主題、照片的文件名稱、環繞圖像的文字內容、照片的鏈接地址等,分析出這些文本的結果,推斷出照片的關鍵字,然后以照片相關的關鍵字建立文本索引[5]。

1.1.2 局限性

但隨著照片檔案的激增,采用照片關鍵詞標注這種基于文本的檢索方式已經不能滿足圖像檢索的要求,局限性越來越顯著,原因如下:由人工對圖像進行標注,不僅工作性質乏味枯燥,而且耗費大量人力物力,因此人工標注的速度已經不能適應快速增長的檔案照片數量[6];同時人們對于圖像含義的理解有著一定程度的主觀性,簡單幾個詞匯遠不能描述圖像所蘊含的豐富含義,同一個人在不同時間對相同圖像的認識的也不盡相同,所以人工標注具有相當的主觀性和不完整性[7]。

1.2 基于照片內容標注方式

為了解決基于文本的照片檢索所遇到的種種問題,上世紀90年代以來,基于內容的照片檢索成為了研究熱點,與基于文本的照片檢索不同,基于內容的照片檢索不再以文本信息為照片特征,而是以照片的視覺信息為特征來描述照片,所使用的特征包括顏色,紋理,形狀等特征。系統自動的從圖像庫中提取這些視覺特征,保存到數據庫中。當用戶提交一幅查詢照片時,系統首先提取查詢照片的特征,將這個特征拿到圖像特征數據庫中進行比對,找出與其特征相似的照片,并以相似度排序的方式返回。

基于內容的圖像檢索立足于圖像低層視覺特征:顏色、形狀、紋理、gabor、SIFT等特征,通過低層視覺的高維特征來表達一幅圖像,接著采用相似度算法計算查詢圖像與數據庫圖像的相似度。最后進行相似度排序返回給用戶,匹配過程常利用特征向量之間的距離函數來進行相似性度量,模仿人類的認知過程,得到數據庫的相似度排序。常用的距離度量公式有:Minkowsky距離、Manhattan距離、Euclidean距離、加權Euclidean距離、Chebyshev距離、Mahalanobis距離等距離范數,基于內容的圖像檢索系統一般包括圖像處理模塊、查詢模塊、對象庫、特征庫和知識庫。

這些基于內容對照片進行標注的方式,可以通過計算機自動化處理快速地處理大量照片,減少人工消耗,提升照片標注速度,適應快速增長的檔案照片數量,但這種方式在照片檢索利用時有很大的局限性,適用于以圖尋圖的模式,難以適用于以主題詞或關鍵詞進行照片查找,同時對于很多顏色相近的照片標注的準確性和穩定性也不高。

2 多示例多標簽照片檔案自動標注

雖然基于照片內容標注方式解決了人們在搜索圖像時過于依賴關鍵字標簽但不確定目標圖像類別和含義的問題,然而很多時候人們并不十分清楚的理解數字化的照片的低層視覺特征到高層的語義之間的映射關系。也就是 “語義鴻溝”(Semantic gap)問題。為了使照片檢索系統更加接近人對圖像的理解,事實上,人們判斷圖像的相似性并非僅僅建立在視覺特征的相似性上。更多的狀況下,用戶主要根據返回圖像的含義而不是顏色、紋理、形狀等物理特征來判別圖像滿足自己需要的程度。這些圖像的含義就是圖像的高層語義特征,它包含了人對圖像內容的理解,這種理解不是直接從圖像的視覺特征獲得的,需要融入人的經驗和知識。本文所研究的即是基于照片目標對象層次和區域的圖像高層語義特征的提取方法,從一幅圖像中通過圖像分割和目標識別的方法提取出高層語義特征,即圖像自動標注,使得計算機理解圖像的能力接近甚至達到人對圖像的理解水平。

照片因包含不同的目標物體而被標記為不同的類別標簽,但標簽與照片中目標物體之間的對應關系不明確,每幅照片所包含的目標物體的數量不盡相同,因此照片自動標注的是一種信息不對稱的多分類問題。多示例多標簽學習是一種有效解決這種信息不對稱分類問題的框架。圖像自動標注中多標簽多示例學習的目標是:通過機器學習算法從給定的數據集:(X1,Y1),...,(Xm,Ym)中得到一個函數映射fMIML使得:2X→2Υ,其中Xi為第i幅訓練圖像的示例Ii是第i幅圖像的示例數目。Yi為第i幅訓練圖像的標簽集合,Li是第i幅圖像的標簽數目,m為訓練樣本數目,對于待標記圖像XMNL,函數fMNL(Xtest)的值就是自動標注標簽。

2.1 特征的選取

多示例多標簽學習圖像自動標注方法中特征的選取是非常關鍵的步驟,圖像多示例的特點使得圖像全局特征不適合作為多示例多標簽學習的特征,通常選取圖像的局部特征作為示例特征。多示例多標簽照片檔案自動標注中圖像多示例特征的生成通常采用SBN的方法[12]。SBN方法提取的圖像特征計算速度快,維數較低等。同時它反映了圖像顏色局部變化特征,但由于降采樣導致的信息丟失,這種特征表示方式過于粗糙,而且SBN特征的效果并不是特別好,而且每一幅圖去固定示例的數目并不科學,很有可能一幅圖像里面只包含2個主要區域,同時SBN特征計算量大,訓練模型的時間長,并不是一種很好的多示例特征。為了解決模型訓練時間長的問題,結合多示例多學習自動標注問題所要求的特征的特點和圖像特征相關知識,提出了將歸一化分割的SIFT特征替代原有的SBN特征應用到照片標注中的新方法。

2.1.1 照片歸一化分割

首先簡單的介紹歸一化分割(Normalized Cuts)[13]圖像分割的方法,圖像分割是一種針對圖像的聚類技術,主要是按某種規則將圖像分割成多個具有相同特征的區域,比如灰度級相同,顏色相同,紋理相同等等。常用的分割方法有K-means聚類,Mean shift,EM algorithm,圖分割方法,各種方法所得到的效果不盡相同,歸一化分割方法屬于圖分割方法的一種。分割效果如下圖所示:

圖1 MSRC數據庫中一張圖像的分割效果

可以看到Normalized Cuts圖像分割的效果是令人滿意的,這種方法是基于圖的圖像分割方法,其中圖是由點以及點和點之間的邊構成的的結構,將圖結構運用于圖像分割的步驟是,首先將圖像像素點映射到特征空間,然后建立權重連接圖,最后把相似的點歸類為一個區域。

2.1.2 SIFT 特征提取

SIFT特征是圖像的局部特征,描述的是圖像關鍵區域的梯度直方圖分布情況,SIFT算法的實質就是從圖像中提取SIFT關鍵點的過程,算法[9]通過度空間的構建,尺度空間極值檢測,特征點精確定位,特征點方向確定,SIFT描述子生成五個主要步驟,通過采取David Lower[10]建議的每個特征點使用4*4共16個種子點進行描述,每個種子點有8個方向的向量信息,這樣最終形成128維的SIFT特征向量,如此高維度的特征向量進行MIMLBOOST&MIMLSVM等算法的實驗,必定是耗費相當長的時間,本文通過找到嵌入高維空間中的保持高維數據結構關系的低維空間投影的降維方法,將特征維數降到至少與SBN特征的維數相同,并且保證這種降維后的特征仍然具有相同的區分度,最后降維后的特征作為圖像的示例特征。

2.1.3 歸一化分割的SIFT提取步驟

綜上所述,歸一化分割的SIFT提取步驟,有著清晰的操作步驟和理論支持,并且保證分類準確度不低于傳統的SBN特征。其具體提取的SIFT特征步驟如下:

步驟1:統計數據集中的每一張圖像的標簽數目,并將此標簽數目設定為Ncut圖像分割的區域數目。

步驟2:運用Ncut算法對數據集中的圖像進行分割,保存分割的區域標記和坐標信息到一個與圖像長寬維數一致的矩陣中

步驟3:提取數據集中所有圖像的SIFT特征,使用空間投影的方法將SIFT特征從128維降至10維。

步驟4:將SIFT特征點的坐標位置與step2所得到的區域坐標比較,將SIFT特征點按區域聚類,由于SIFT特征是以方向和scale從大到小排序的,也就是排在前面的,擁有更加穩定的特征,這里只取每個區域選擇前三個SIFT特征,即一個標簽對應三個SIFT多示例。

2.2 多示例多標簽方法

圖像分類學習算法中最為重要的兩個過程是特征的提取和分類算法的選取,為了將前期提取的照片特征庫學習訓練成自動標注模型,在圖像自動標注的多示例多標簽學習任務中,問題的特點是一幅圖像包含多個區域目標,在多示例多標簽學習中稱為示例,同時一幅圖像又被標記為多個標簽,當一幅圖像被標記為一個標簽時,那么圖像必定包含一個以上與這個標簽相關的示例,或稱為此標簽的正樣本。相反當一幅圖像不被標記為這個標簽時,那么圖像所包含的所有示例都不與此標簽相關,或稱為此標簽的負樣本。

2.2.1 自動標注模型

為了解決多標簽和多示例的問題,采用Discriminative MIML Learning[11]方法迭代得到最終的最佳標簽分配和分類模型,Discriminative MIML Learning(DMIML)是google紐約研究院的Oksana Yakhnenko等提出的一種可以擴展到大量圖像數據的新方法,其提出的算法是線性模型,不需要去計算核矩陣。模型的最優參數可以通過隨機梯度下降的方法解一個無約束最優化問題很快的得到,同時可以避免在內存里存儲所有的數據,算法首先訓練一組可鑒別的多示例分類器,一個分類器對應可能的標簽詞匯表里的一個標簽,然后通過找到排序權重矩陣建立標簽之間的關系模型。

2.2.2 圖像自動標注框架

圖像自動標注是SBIR和CBIR中非常具有挑戰性,同時又非常重要的工作。它利用已標注的圖像作為訓練數據集,通過機器學習算法訓練得到圖像低層視覺特征與高層語義之間的關系模型,并使用此模型來標注新的未知圖像的語義。

詳細說明了基于該方法的圖像自動標注的主要流程步驟,流程圖如下圖2所示:

圖2 圖像自動標注框架

訓練模塊:首先根據訓練圖像的標簽數目,提取改進的SIFT示例特征,再通過DMIML多示例多標簽方法訓練自動標注的分類器模型。

標記模塊:提取待標記圖像的SIFT特征,利用訓練的自動標注分類模型對圖像的每個示例特征進行類別判斷,最終將此類別標簽作為圖像的預測標簽。

最后將預測的多標簽對檔案照片進行自動標注,以便檢索利用。

2.2.3 實驗驗證

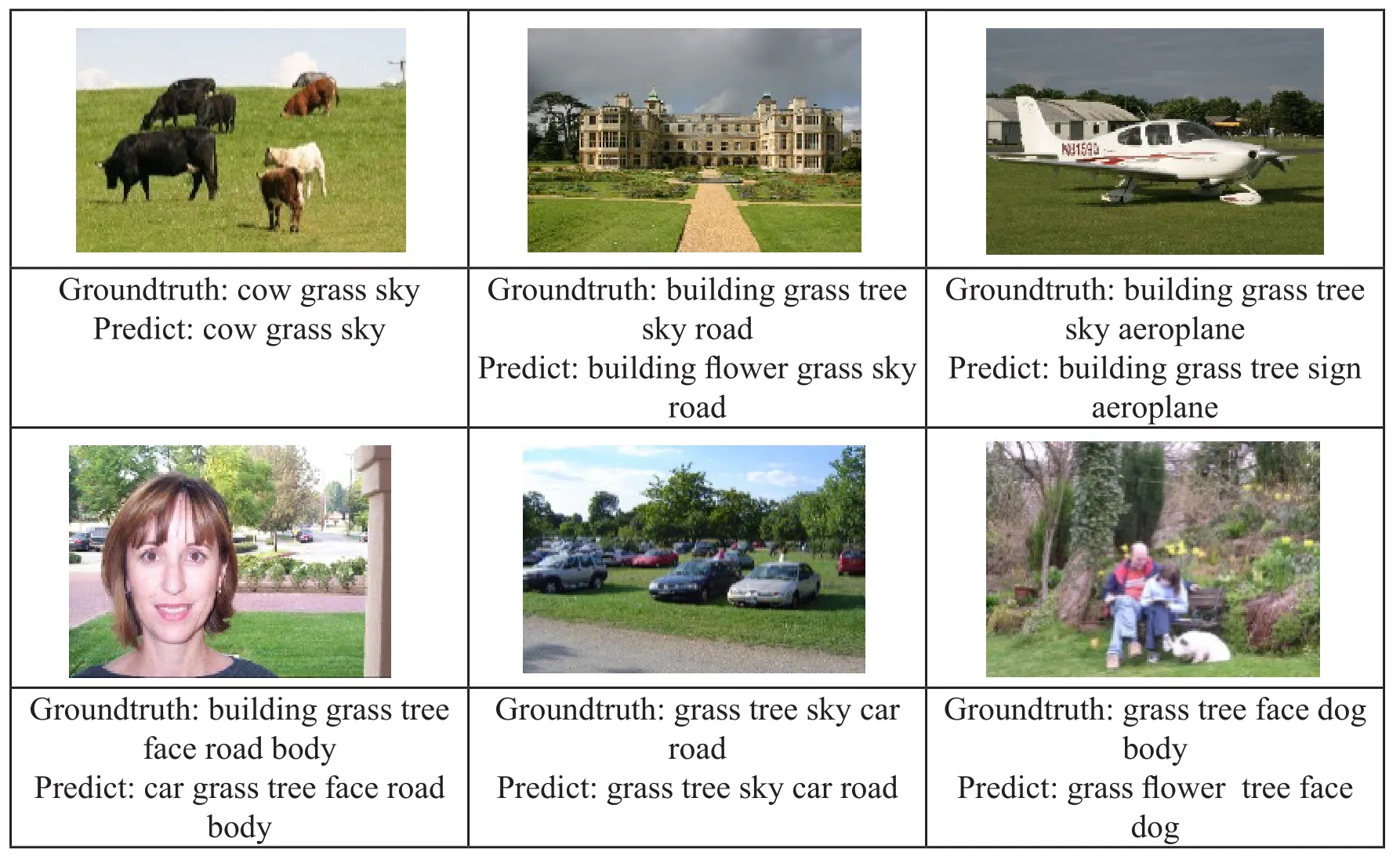

為了檔案照片的安全性,本次實驗采用的是文獻[12]的采用這組圖像數據集,該數據集包含2000張圖像,共5種類別標簽。圖像標簽預測結果和真實標簽的比較如下表1所示:

表1展示了本文提出的自動標注算法在測試數據集上的標注效果,可以看出每幅圖片中最主要的目標物體都被準確的標注出來,只有少數位置偏、在圖片中較小的次要目標出現漏標(表1中第二行第一、三列、第三行第一、三列出現此類情況),目標不明確導致錯誤標記(表1中第一行第二列、第二行第三列出現此類情況)。上述的兩類錯誤是主觀判斷,在可以接受的范圍之內,整體計算準確率在95%以上,并且優于根據與文獻[12]中采用的基于SBN特征的實驗方法準確率,同時這種準確率隨著訓練的樣本越多越來越高,通過上述實驗證明本文提出的特征提取算法和多標簽多示例算法都是行之有效的圖像自動標注方法。

表1 圖像標簽預測結果和真實標簽的比較

3 結論

本文主要介紹了照片檔案標注的關鍵技術,包括基于文本的照片檔案標注的相關技術,基于內容的照片檔案標注的相關技術,重點研究了基于語義檢索中圖像自動標注的問題。一幅圖像可能因為其中包含多個目標物體而被標記為多個標簽,同時標簽與目標物體的對應關系未知,根據圖像自動標注問題的這種特點,使用多示例多標簽學習方法來進行圖像自動標注。本文的主要工作包含以下兩個方面:

a)提出了一種檔案照片的多示例多標簽自動標注問題的示例特征,即首先將圖像進行分割,提取其中的目標物體的區域特征,在分析了傳統的SBN示例特征的優缺點的基礎上,提出了一種SIFT特征描述方法,以解決示例特征提取中每幅圖像示例數目固定,不能很好的描述真實的問題中每幅圖像所包含的目標物體的數目不同的問題,這種基于歸一化圖像分割的特征方法很好的解決了圖像目標分割特征表示的問題,該特征具有區分性強,數據量小等特點。

b)將圖像自動標注問題轉換成多示例多標簽問題,通過引入多示例多標簽學習,迭代得到最終的最佳標簽分配和自動標注的分類器模型,提出了一個完整有效的圖像自動標注流程和步驟,實驗證明該方法是一種有效的圖像自動標注方法。

本文提出的一種多示例多標簽照片檔案自動標注技術適用于大規模海里檔案照片的快速自動標注,對檔案照片的檢索利用有重要的促進作用。