基于通道分組注意力的無監督圖像風格轉換模型

孫銘一 孫劉杰 李佳昕

上海理工大學

出版印刷與藝術設計學院

上海 200093

0 引言

圖像風格轉換是近年來機器視覺領域的研究重點之一。根據圖像風格轉換模型在訓練中是否需要成對的數據,其可分為有監督學習和無監督學習。有監督學習需要成對的數據和人工對數據打標簽,導致時間成本過高。無監督學習不需要成對的數據,相較于有監督學習,其數據獲取更加簡單高效,普適性更高。根據一張輸入圖像是否能夠對應獲得多個輸出圖像,圖像風格轉換模型可分為單模態模型和多模態模型。在單模態模型中,一張輸入圖像只能獲得一張對應的輸出圖像,當輸入數據不成對時,其局限性便體現在模型的輸出結果不確定上。在多模態模型中,一張輸入圖像可以對應多張輸出圖像,因而多模態模型能夠很好地應對多圖像轉換任務,例如包裝平面設計[1]、文圖轉換等。

近年來有關多模態無監督圖像風格轉換的研究越來越多,這些研究都是基于生成對抗網絡[2](generative adversarial networks,GAN)。Choi Y.等[3]提出了人臉圖像多模態轉換模型StarGAN,Yu X. M.等[4]提出了SingleGAN。StarGAN使用星形生成網絡結構并在輸入中添加目標領域信息,再結合判別器的分類結構和循環重構一致性約束完成圖像翻譯工作。但是其欠缺對圖像重構損失的考慮,因而圖像風格轉換時某些固定屬性會發生變化,導致圖像質量下降。SingleGAN則采用類別便簽指導方法,在StarGAN的基礎之上對網絡結構作出改進。2018年,Huang X.等[5]提出的MUNIT和Lee H. Y.等[6]提出的DRIT,均是基于內容與風格分離編碼再交叉解碼的方法以獲得多樣的輸出。與DRIT不同的是,MUNIT采用自適應實例規范化算法(adaptive instance normalization,AdaIn)的風格特征參數[7]來融合內容特征,以實現圖像風格轉換。DRIT的轉換效果不如MUNIT,而MUNIT的轉換效果不如有監督的多模態模型BicycleGAN[8]。但有監督的多模態模型BicycleGAN需要成對的輸入數據,這增加了數據集的獲取難度,且模型體積龐大。

為了提高無監督模型的輸出圖像質量,解決局部偽影和局部特征丟失等問題,本課題組在MUNIT的基礎上,提出了基于通道分組注意力(channel-divided with attention,CDA)的無監督圖像風格轉換模型。在生成器部分,構建通道分組注意力殘差塊。在鑒別器部分,利用多分辨率尺度的全局鑒別器對輸出圖像進行不同分辨率尺度上的鑒別,利用局部鑒別器[9]對輸出圖像局部進行鑒別。

1 無監督圖像風格轉換模型

1.1 模型結構

本文所提的無監督圖像風格轉換模型的主要創新點如下:

1)采用通道分組注意力殘差塊構建生成器。CDA殘差塊主要包含通道分組和通道注意力機制(ef ficient channel attention,ECA)[10-11]兩個模塊。通道分組模塊能夠實現殘差塊內的跳躍連接,減少特征丟失;ECA模塊能夠自適應地調整特征圖通道權值,提高網絡對有效特征的關注度,并進一步減少模型參數量以及體積。

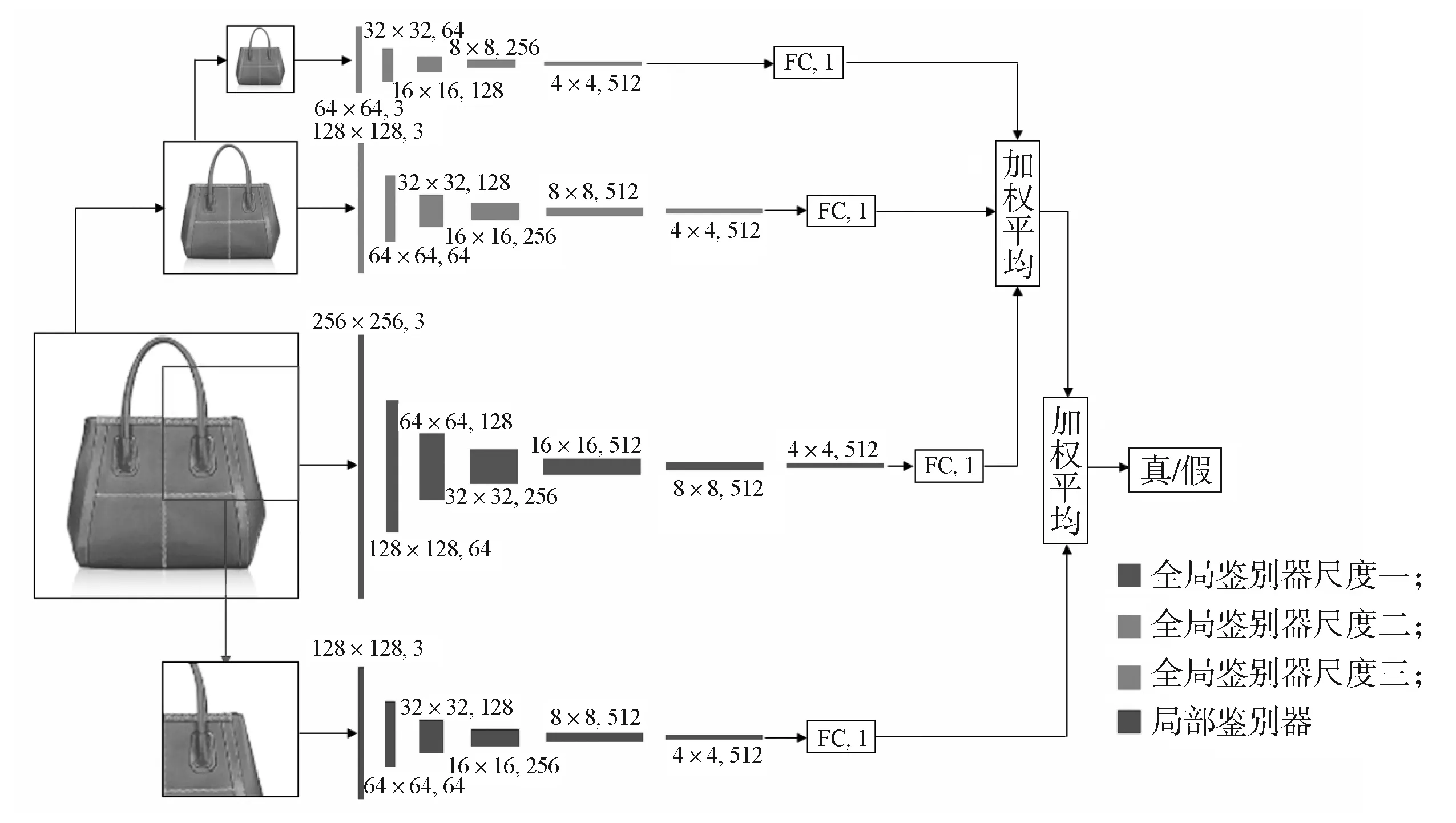

2)采用雙鑒別器結構構建鑒別器。多尺度全局鑒別器對輸出圖像在多分辨率尺度上進行聯級鑒別,以提高輸出圖像的結構連貫性與內容完整性;局部鑒別器對輸入圖像進行剪裁,即獲得1/4的圖像,以提高輸出圖像精度。

3)引入 NIMA(neural image assessment)[12]美學評分模型評價風格轉換圖像質量。NIMA模型對輸出圖像的真實性進行客觀評價,并從圖像美學的角度評估圖像風格是否美觀。將主觀評價結果參數化減少了人眼判斷的隨意性與主觀偏差,提高了評價過程的操作便捷性與公平性。

無監督圖像風格轉換模型的訓練網絡結構如圖1所示。測試時,本模型僅需輸入單張邊緣圖像或者實物圖像即可得到轉換后的風格圖像。

彩圖

在圖1中,無監督圖像風格轉換模型為對稱結構,包含兩個結構相同的生成器GA、GB,兩個結構相同的風格編碼器ESA、ESB,以及兩個結構相同的鑒別器DA、DB。鑒別器DA由多尺度全局鑒別器GD和局部鑒別器LD組成。輸入圖像A(實物圖像)與輸入圖像B(邊緣圖像)互為各自的風格圖像,均在生成器和風格編碼器完成圖像內容和風格的編碼,進而實現兩個生成器之間的交叉解碼,得到的輸出圖像再進入鑒別器進行鑒別以及前向反饋,最終完成整個訓練網絡的調整與優化。基于循環一致理論,無監督圖像風格轉換模型能實現實物圖像與邊緣圖像的互相轉換。現有的邊緣提取算法,如Canny算子、Sobel算子等,均能檢測出清晰完整的邊緣,因此本研究不是將圖像A到圖像AB(邊緣圖像)的風格轉換作為研究重點,而是將圖像B到圖像BA(實物圖像)的風格轉換作為研究重點。此轉換涉及的主要模塊有生成器GA、風格編碼器ESA、鑒別器DA,轉換過程可描述如下:

1.2 風格編碼器

風格編碼器保留了MUNIT中的方法,由兩個下采樣層、一個池化層以及一個全連接層組成。提取圖像的風格編碼后,多層感知器(multilayer perceptron,MLP)對其進行加工處理,以一維的AdaIN參數形式融合到生成器的解碼器中,與內容信息共同解碼,從而獲得新的風格圖像。 MLP是一種前向的全連接神經網絡結構,每一層的單個神經元均與下一層中的所有神經元連接。其中,AdaIN的工作機制是,給定一個內容圖像和一個風格圖像,通過調整輸入的內容圖像的均值和標準差來匹配輸入的風格圖像,從而實現圖像間的風格轉換。假設輸入的內容圖像為c,輸入的風格圖像為s,則AdaIN歸一化操作公式為

式中:μ(c)、μ(s)分別為內容圖像、風格圖像的均值;

σ(c)、σ(s)分別為內容圖像、風格圖像的標準差。

式(2)將內容圖像與風格圖像的均值和標準差對齊,即通過傳遞特征統計信息在特征空間進行風格轉換。以圖1中的風格編碼器ESA為例,在圖像風格轉換過程中,ESA對輸入圖像A進行編碼,提取其風格特征信息sA,

1.3 生成器

生成器為編碼器-解碼器結構,其中,編碼器由兩個下采樣層和4個通道分組注意力殘差塊CDA組成,解碼器由4個通道分組注意力殘差塊CDA和兩個上采樣層組成。編碼器和解碼器的主要構成模塊均為通道分組注意力殘差塊CDA,該殘差塊的構建主要參考了Gao S. H.等[13]提出的res2net。res2net能夠以更細的粒度來表示多尺度特征,同時增加了每個塊內網絡層的感受野,在目標檢測、語義分割等機器視覺任務中其有效性得到證實。

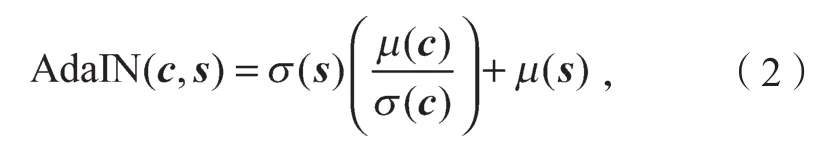

邊緣圖像中,邊緣在整張圖像中的占比遠小于空白部分,過大的感受野會使邊緣信息占比更少,導致網絡學習很多無效信息,使生成的圖像質量下降,出現偽影、空洞等現象。倘若縮小感受野,則會增加參數計算量,加重模型負擔。因此,本研究在不改變感受野大小的前提下,將殘差塊中basicblock模塊的第二層卷積層按照通道數n均分為兩個維度相同的網絡,一個為常規3×3卷積,另一個作為淺層信息,通過concat跳躍連接[14]與卷積后的特征圖進行拼接,重構n通道特征圖。在改進后的殘差塊末端引入ECA,構建通道分組注意力殘差塊結構,如圖2所示。

圖2 通道分組注意力殘差塊結構Fig. 2 Structure of CDA residual block

彩圖

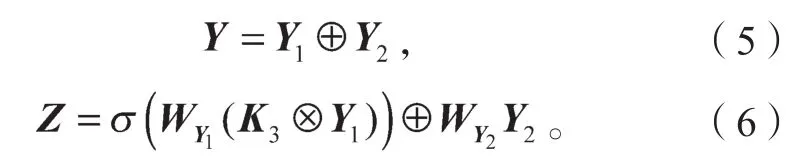

在圖2中,假設原始輸入數據為X,經過第一層卷積后輸出Y,

式中:W1、W2分別為第一層3×3卷積、第二層通道分組模塊的權重;

σ為Relu激活函數;

K3為3×3卷積核;

第二層卷積按照通道數均分為兩個網絡,分別得到n/2通道的特征圖Y1、Y2。Y1通過跳躍連接與Y2進行拼接,重構n通道特征圖Z,

殘差塊的輸出F滿足如下公式:

通道分組是通過將特征先拆分后融合的策略,使卷積網絡能更高效地處理邊緣特征。這既實現了邊緣特征的深度提取,又實現了淺層邊緣特征的重復利用,保留了更多的有效信息[13]。

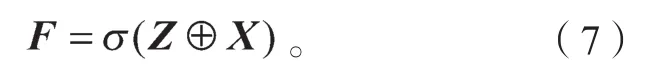

隨后,F作為ECA層的輸入數據,進一步完成各通道權重的自適應調整。ECA是由Wang Q. L.等提出,通過不降維且自適應地捕捉圖像各特征圖之間的跨通道交互,自適應地調整更新各特征圖通道的權值,并對各特征圖通道間的內部依賴關系進行建模,從而降低模型的復雜程度,提高網絡對于有效特征的關注能力。ECA結構如圖3所示。

圖3 ECA結構Fig. 3 Structure of ECA

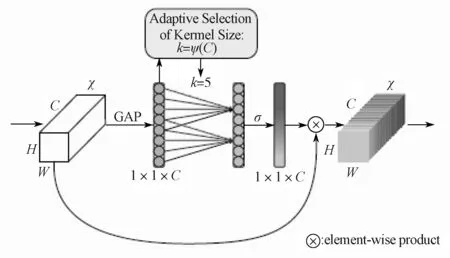

ECA去除了全連接層,在全局平均池化后通過一個可以權重共享的一維卷積對特征圖進行學習。該一維卷積涉及超參數k即一維卷積的卷積核尺寸,它代表了局部跨通道交互的覆蓋率。超參數k與輸入特征圖通道數C之間存在如下映射:

因此,k為

式(8)~(9)中γ和b為常量,γ=2,b=1。

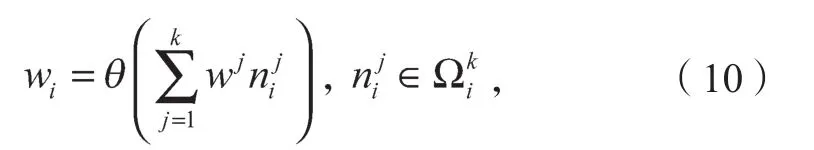

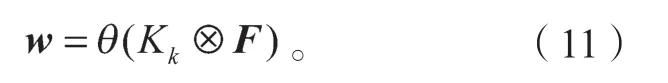

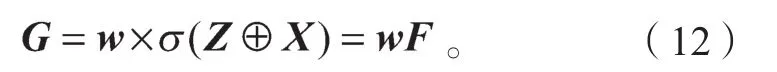

重構后的特征圖F可表示為集合{ni}(i=1,2,…,n),則在ECA層中,第i個通道的局部跨通道交互權重wi為

式中:θ為sigmoid函數;

wj為所有通道間共享的權重;為ni的k個相鄰通道的集合。

可視化通道特征通常表現出一定的局部周期性,因此,通過權重共享的方式捕獲局部的跨通道交互,既可以實現有效邊緣信息的提取與利用,又避免了捕捉跨所有通道交互所帶來的模型復雜度與計算量[10]。經過卷積核大小為k的一維卷積后,結合式(7),通道間的信息交互權重矩陣w為

式中Kk為k×k卷積。

通過權重矩陣w實現輸出特征圖各通道的權值自適應調整,以不降維方式捕獲更多有效邊緣信息,因此通道分組注意力殘差塊的最終輸出G為

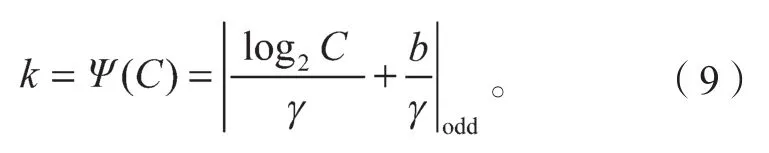

1.4 鑒別器

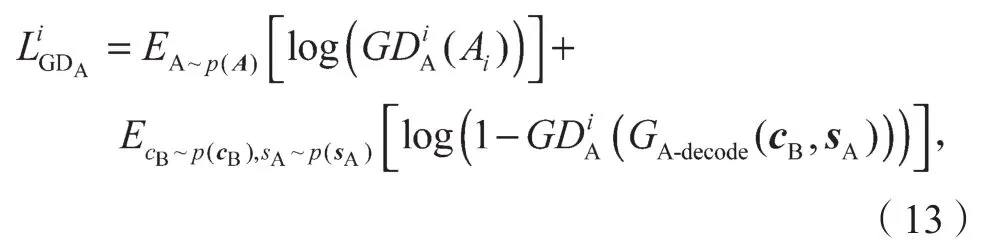

鑒別器由兩部分組成,分別是用于鑒別整張輸出圖像的多分辨率尺度全局鑒別器GDA以及用于鑒別剪裁后局部輸出圖像的局部鑒別器LDA。全局鑒別器GDA采用多尺度結構,即先對圖像BA進行多次降采樣操作,生成大小不同的圖像,再通過多分辨率尺度并聯鑒別,使輸出圖像的全局內容連貫和全局結構合理。全局鑒別器GDA包含3個不同的鑒別分辨率尺度,分別是256×256, 128×128, 64×64,每個尺度均輸出一個判斷值,隨后通過加權平均得出整個全局鑒別器的判斷值。局部鑒別器LDA為單尺度結構,其輸入為剪裁1/4的圖像BA后的圖像BAcut,大小為128×128。局部鑒別器LDA對局部圖像進行鑒別后輸出一個判斷值,隨后與全局鑒別器GDA的判斷值通過加權平均方式計算出鑒別器DA的最終判斷值。

全局鑒別器和局部鑒別器均采用PatchGAN[15]結構。PatchGAN是將圖像分成若干個70×70的小塊,每個小塊輸出一個判斷值,最終根據得到大小為m×m的矩陣計算判斷值。PatchGAN可以綜合考量整張圖像不同部分的影響,使得判斷結果更加準確。

式中:E為期望;

p(?)為圖像的分布;

GD(i=1, 2, 3)為全局鑒別器中3個不同尺度的鑒別器;

cB為圖像B的內容信息;

sA為圖像A的風格信息。

式中為各尺度全局鑒別器的權重系數。

式中Acut為剪裁1/4的圖像A后的圖像。

式中αCD、βLD分別為全局鑒別器、局部鑒別器的權重。

鑒別器的結構如圖4所示。

圖4 鑒別器的網絡結構Fig. 4 Network structure of discriminators

彩圖

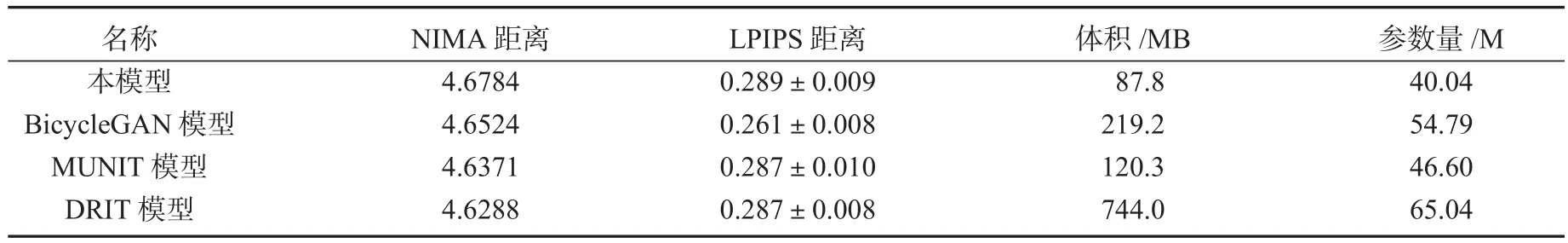

1.5 目標函數

無監督圖像風格轉換模型的總體目標函數為

如式(17)所示,目標函數包括4個部分。

2)源域圖像與重構源域圖像間的循環一致性損失LB′→B與LA′→A。

在生成器GA中,編碼器對輸入的邊緣圖像B進行編碼,提取其內容編碼cB,即

隨后,解碼器根據內容編碼cB以及圖像A的風格編碼sA,解碼獲得新的風格圖像BA,即

按照循環一致性理論,生成器獲得的風格圖像BA也能經編碼與解碼操作得到重構的輸入圖像B′。B′的重構過程如下:

式(21)~(22)中:cBA為風格圖像BA的內容編碼;

sB為輸入圖像B的風格編碼。

圖像B′與原始輸入圖像B之間的損失為

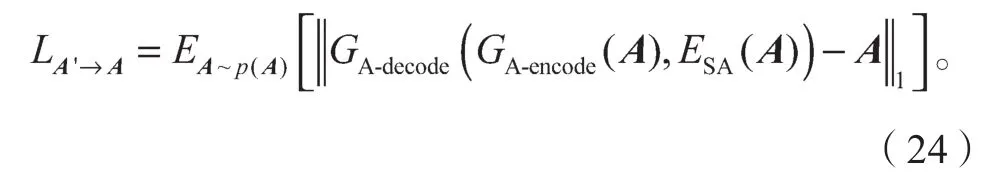

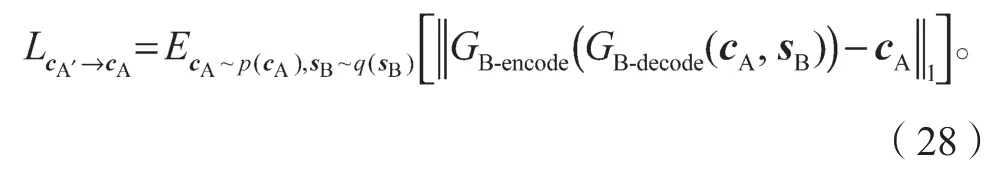

同理,圖像A與重構圖像A′之間的損失為

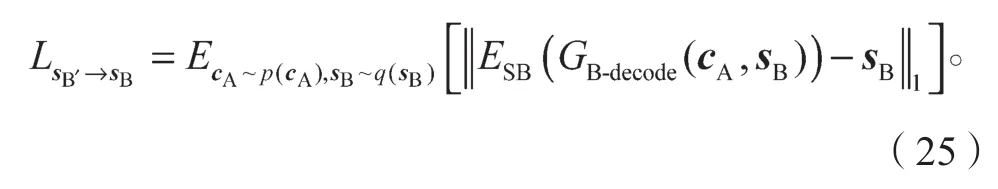

對重構圖像B′進行風格編碼,可得風格編碼sB′。sB′與sB(呈正態分布)之間損失應當滿足如下約束關系:

式中q(·)為風格編碼sB的分布。

同理,重構圖像A′的風格編碼sA′與風格編碼sA之間的損失函數為

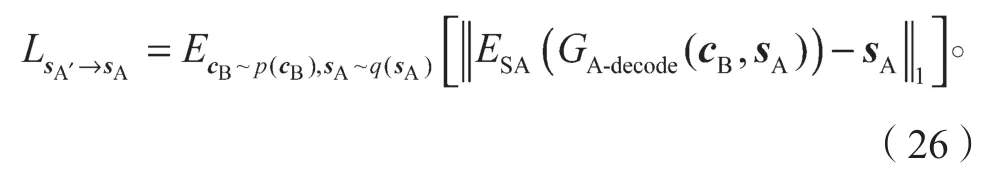

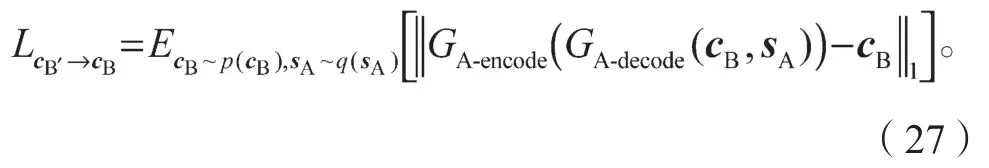

重構圖像B′的內容編碼cB′與輸入圖像B的內容編碼cB應該是一致的,則cB′與cB之間應當滿足如下約束關系:

重構圖像A′的內容編碼cA′與輸入圖像A的內容編碼cA之間的損失函數為

2 實驗

本實驗是在Linux18.04系統、Pytorch1.0平臺完成。訓練數據來自iGAN-project的手提包圖像集。輸入圖像和輸出圖像的大小均為256×256。為了驗證本文方法的有效性和優越性,用兩組不同的測試數據(數據來自iGAN-project和網絡)測試BicycleGAN模型[8]、MUNIT模型[5]、DRIT模型[6]與本模型,利用NIMA(neural image assessment)距離[11]、LPIPS(learned perceptual image patch similarity)距離[16]評價4種模型的輸出圖像質量,并比較模型的體積和參數量。MUNIT模型、DRIT模型和本模型均為無監督模型,輸入數據為邊緣圖像;BicycleGAN模型為有監督模型,輸入數據為一一對應的“邊緣+實物”圖像對。

2.1 評價指標

1)NIMA距離

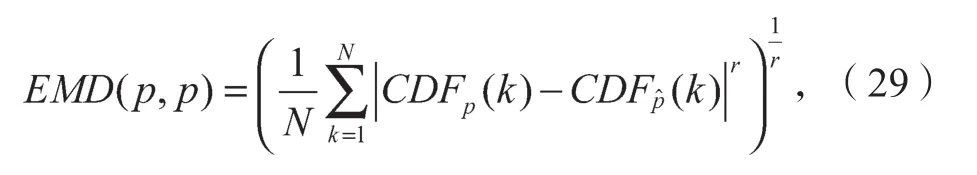

引入NIMA模型對4種模型的輸出結果進行真實性評價。NIMA模型是由谷歌于2017年提出的模擬人眼對圖片美觀度進行打分的模型,通過計算歸一化的EMD(Earth mover’s distance)距離(見式(29))對任意圖像生成評分直方圖,即給圖像進行1~10的預測評分。預測評分越高,代表圖像質量越高,圖像更加美觀。

式中:CDFp(k)為預測評分的概率累加值,而不是獨立的預測獲得每一個評分的概率;

當標簽中的評分越高,則累計概率越大。相比于人眼打分機制,NIMA模型可以避免人眼主觀性較高、觀測環境不統一、人眼樣本屬性不一致等因素帶來的偏差。

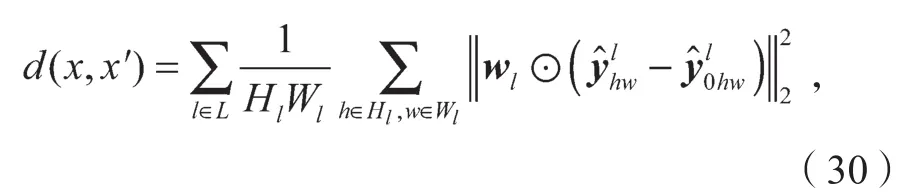

2)LPIPS距離

參考BicycleGAN、MUNIT,引入LPIPS距離對4種模型的輸出結果進行多樣性評價。LPIPS距離由圖像深度特征間的L2距離加權獲得。參考圖像x與失真圖像x′之間的距離為

⊙為矢量wl對通道進行縮放操作。

2.2 iGAN-project的手提包圖像測試實驗

從NIMA距離、LPIPS距離以及模型的體積和參數量方面,比較BicycleGAN模型、MUNIT模型、DRIT模型與本模型的優劣。測試數據來自iGAN-project的手提包圖像。

訓練本模型時,輸入圖像為手提包邊緣圖像B,圖像B經編碼器編碼內容信息后與實物圖像A的風格信息[17-18]共同解碼獲得輸出圖像BA,即不同風格的著色手提包圖像。部分實驗結果如圖5所示。

圖5 手提包風格轉換結果Fig. 5 Handbags’style conversion results

彩圖

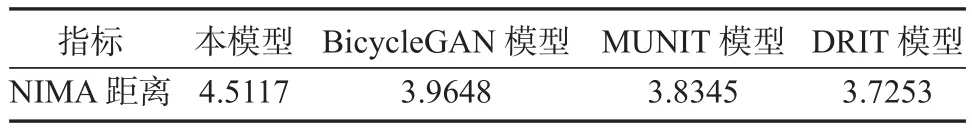

與BicycleGAN、MUNIT相似,測試實驗選取50張輸入圖像,每張輸入圖像隨機采樣獲得10張輸出圖像,計算500張輸出圖像的NIMA距離均值。對50張輸入圖像的每張圖像隨機采樣獲得38張輸出圖像,計算1900張輸出圖像的LPIPS距離均值。4種模型的實驗結果評價如表1所示。

表1 實驗結果評價Table 1 Evaluation of experimental results

由表1可知:從輸出圖像的美觀度來說,本文方法的NIMA值最高;從輸出結果的多樣性來說,本文方法與MUNIT和DRIT模型差不多,與BicycleGAN模型相比,本文方法的多樣性提升了約10%;從模型的體積與參數量來說,本文方法的模型體積最小,參數量最少。可見本文方法能夠以更小的模型體積、更少的模型參數量獲得更加美觀且多樣性的輸出結果。

2.3 紙質手提盒圖像測試實驗

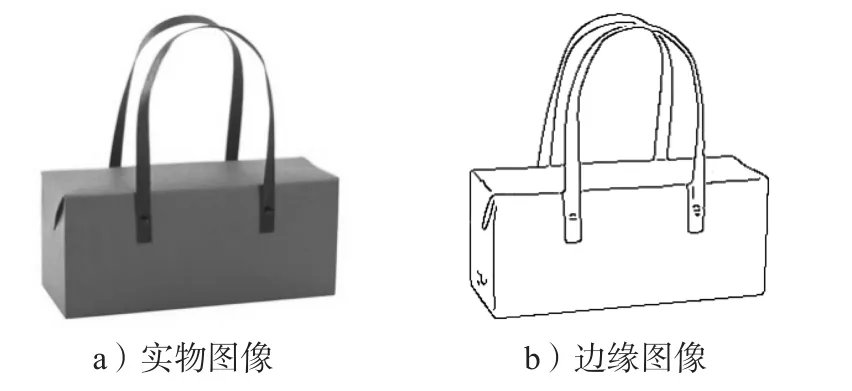

在包裝的外觀設計中,從設計草圖到設計稿的過程,同樣可以看作是一次圖像間的風格轉換。本實驗從網絡選取1張紙質手提盒圖像,生成測試數據集。按照實驗要求,先將圖像統一裁剪為256×256,再利用Canny算子提取圖像邊緣,通過反相操作,獲得白色背景的邊緣圖像(見圖6)。4種模型的實驗結果如圖7所示。

圖6 紙質手提盒實物圖與邊緣圖Fig. 6 Physical image and edge image of paper portable box

由圖7可知,BicycleGAN模型、MUNIT模型以及DRIT模型的輸出圖像在局部細節上如提手與紙盒的黏合處,均存在嚴重的偽影,導致輸出圖像的局部邊緣細節不清晰;BicycleGAN模型和DRIT模型的輸出結果還出現了著色不均現象,一定程度上影響了輸出圖像的美觀度;本模型的輸出圖像相對擁有更為清晰的局部細節,在提手與紙盒的黏合處并未出現肉眼可見的大面積偽影,并且圖像著色均勻,美觀度更高,整體觀感更佳。

圖7 紙質手提盒可視化結果對比Fig. 7 Comparison of visualization results of paper portable box

彩圖

對圖7中的輸出結果計算NIMA距離均值,結果如表2所示。

表2 4種模型的NIMA距離Table 2 NIMA distance of 4 models

由表2可知,與BicycleGAN模型、MUNIT模型以及DRIT模型相比,本模型在紙質手提盒的平面設計中表現最優,與圖7的可視化效果相吻合。

上述兩組實驗結果證明了本文所提的無監督圖像風格轉換模型在包裝產品平面設計遷移應用中的有效性。相較于icycleGAN模型、MUNIT模型以及DRIT模型,本模型不僅具有多樣性的輸出,而且能捕獲有效的圖像特征,增強圖像局部細節。

3 結論

針對多模態無監督圖像風格轉換模型MUNIT模型的輸出圖像真實性不高的問題,本文提出了一種基于通道分組注意力殘差塊的雙鑒別器無監督模型。首先,在生成器采用基于通道注意力的深度特征提取殘差塊CDA,CDA是編碼器與解碼器的重要組成模塊。CDA利用跳躍連接提高生成器部分對于淺層圖像信息的提取與利用,并通過ECA實現殘差塊通道權值的自適應調整,進一步提高網絡對有效特征信息的關注度。其次,采用并聯的多分辨率尺度全局鑒別器與局部鑒別器,重構相應的損失函數。局部鑒別器使生成圖像擁有清晰的局部細節,多分辨率尺度全局鑒別器提高生成圖像的全局內容連貫性與結構合理性,以更好地實現網絡優化,獲得更高質量的輸出圖像。實驗結果表明:本模型不僅擁有更小的模型體積,更少的參數量,且在輸出圖像的NIMA美觀度評價以及LPIPS多樣性評價中均取得了更高的得分。此外,在包裝類產品的平面設計遷移任務中,本模型也獲得了較高的NIMA美觀度得分,與BicycleGAN模型、MUNIT模型以及DRIT模型相比,本模型能夠獲得局部細節更加清晰、完整的輸出圖像,減少了偽影、特征丟失等問題的產生,進一步證明了本模型在圖像特征提取以及利用等方面的優越性,同時證明了將多模態無監督圖像風格轉換模型應用于包裝設計是可行的,多模態的輸出能夠為設計工作提供更多的設計思路。

在包裝類產品的平面設計中,盡管本模型相較于BicycleGAN模型和MUNIT模型,在輸出圖像質量上有一定的提高,但是輸出圖像還存有小面積的邊界模糊以及輕微的偽影,這將是后續研究需要解決的問題。此外,不同包裝類型產品相關數據的獲取,以及是否需要添加額外的特定約束條件來獲得更加真實有效的輸出等,也是后續研究方向。