基于GAN的ISAR圖像語義分割方法 *

杜 蘭, 呂國欣, 石 鈺

(西安電子科技大學雷達信號處理國家重點實驗室, 陜西西安 710071)

0 引言

逆合成孔徑雷達(Inverse Synthetic Aperture Radar,ISAR)成像技術是當前對海、陸、空觀測的重要方式,它作為一種能夠遠距離獲取非合作目標圖像的技術,在軍事領域起到了重要作用。隨著ISAR成像技術的不斷成熟,對ISAR圖像進行快速有效的自動解譯,獲得目標豐富的結構、姿態、尺寸等信息,受到了越來越廣泛的關注。ISAR圖像語義分割是ISAR圖像處理和解譯的重要技術支撐,語義分割指根據某種準則將圖像劃分為互不重疊的同質區域,并且給出不同區域中像素的語義類別,它能夠提取圖像中感興趣區域,為后續圖像識別與分類、場景解析、目標檢測等任務作預處理。傳統的語義分割方法利用像素的灰度、色彩、紋理等低級語義特征對像素進行分類,圖像分割精度有限[1]。隨著深度卷積神經網絡的快速發展,基于深度學習的語義分割方法成為語義分割的主流方法[2-3]。Long 等人[4]在2014年提出的全卷積網絡(Fully Convolutional Network,FCN)是首個端到端的深度語義分割模型,目前大多語義分割網絡都是基于 FCN 的編碼-解碼結構實現的。 FCN 通過對編碼過程中提取的特征圖進行雙線性插值上采樣將其恢復至輸入圖像尺寸,實現像素級分類。文獻[5]基于編碼-解碼結構,解碼器進行上采樣時利用編碼部分記錄的池化索引來恢復圖像的細節信息,提升分割精度。文獻[6]基于編碼-解碼結構,引入深度可分離空洞卷積在減少計算量的同時增大感受野,采用金字塔池化模塊獲取圖像多尺度上下文信息,提升圖像分割精度。傳統的深度語義分割模型通常采用交叉熵損失函數訓練模型對圖像中的每一個像素進行分類,使模型學習原始圖像像素到分割圖像像素的映射關系,因此需要非常精準的標注圖像來對模型進行訓練。ISAR圖像與光學圖像相比表征性差,圖像中散射點的不連續和強散射點存在的旁瓣效應,使得人工精準標注十分困難,傳統深度語義分割方法在訓練數據標注不精準的情況下無法保證分割性能穩健。

本文針對上述問題,提出了一種基于Pix2pixGAN[7]的ISAR圖像語義分割方法。本方法將GAN[8]的對抗思想引入ISAR圖像語義分割任務中,通過對抗學習使模型學習ISAR圖像分布到其語義分割圖像分布之間的映射,約束方式相比較于像素到像素的映射更加靈活,從而減弱模型對于精準標注的需求,提升語義標注不夠精準的情況下模型的穩健性。

1 基于Pix2pixGAN的ISAR圖像語義分割方法

1.1 基于Pix2pixGAN的ISAR圖像語義分割網絡

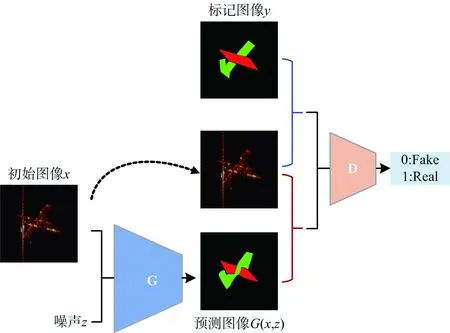

Pix2pixGAN是GAN的衍生模型之一,在圖像生成、圖像翻譯和圖像風格轉換等任務上具有十分出色的表現[7]。所提方法的網絡結構如圖1所示,我們定義ISAR圖像為x,其對應語義分割標簽圖像集為y,將ISAR圖像作為條件信息約束生成器G生成數據的方向,訓練生成器G以生成判別器D難以分辨的分割圖像,訓練判別器D以盡可能地分辨真假分割圖像,通過這種對抗訓練學習ISAR圖像到其分割圖像的映射關系G:(x,z)→y。本方法將ISAR圖像xi和噪聲向量z作為生成器G的輸入,輸出為生成的分割圖像G(xi,z);將ISAR圖像xi和生成的分割圖像G(xi,z)或ISAR圖像xi和真實的分割圖像yi作為圖像對輸入判別器D,輸出為判別器D判斷輸入圖像對為真實圖像的概率。采用交替迭代的方式訓練該網絡,首先固定生成器G,訓練判別器D使其盡可能地區分G(xi,z)與yi;然后固定判別器D,訓練生成器G使其生成的分割圖像G(xi,z)與真實分割圖像yi盡可能相似;循環上述交替迭代過程,當對抗達到平衡時,判別器D無法區分生成的分割圖像G(xi,z)和真實的分割圖像yi,也就是說生成器G能夠生成近似于真實分割圖像的分割結果。

圖1 基于Pix2pixGAN的ISAR圖像語義分割方法框架

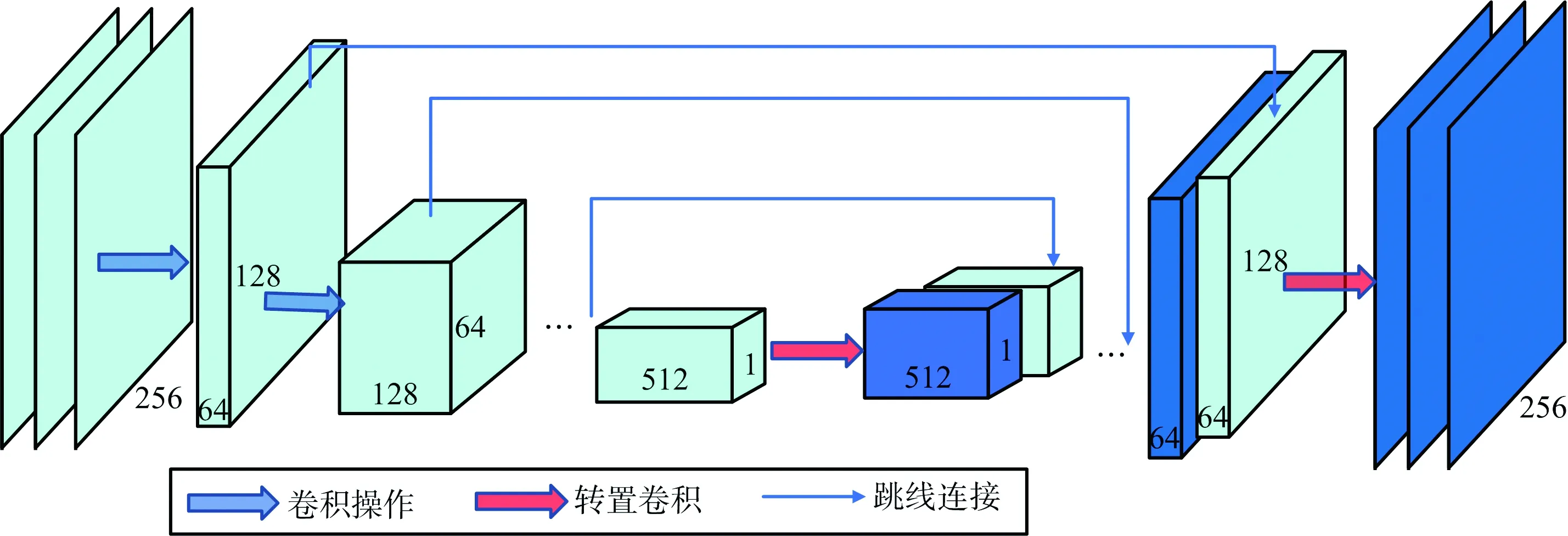

1.1.1 生成器網絡結構

編碼-解碼結構是語義分割任務中常用的網絡結構,首先使用編碼器對輸入圖像進行特征提取,再使用解碼器對特征圖進行上采樣,將特征圖尺寸恢復至輸入圖像分辨率大小進行像素級分類。本文的生成器如圖2所示,在編碼-解碼結構的基礎上引入跳線結構,在上采樣時引入編碼部分的信息,將解碼器每層特征與編碼器中對稱層的特征按通道拼接后再進行上采樣,避免直接對特征圖進行上采樣時丟失大量細節信息,通過融合編碼部分的底層特征來保證輸出圖像在細節上能夠有較好的表現。生成器網絡結構如圖2所示,編碼器由8個卷積層構成,對一張寬度、高度和通道數為256×256×3的圖像經過特征提取后輸出為512個大小為1×1的特征圖。解碼器由8個轉置卷積層組成,對512個大小為1×1的特征圖經過上采樣后輸出為一張寬度、高度和通道數為256×256×3的圖像。

圖2 生成器網絡結構示意圖

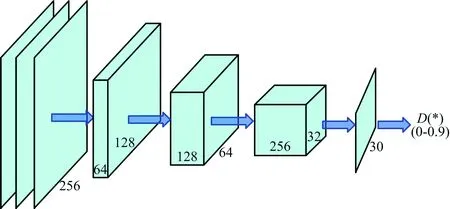

1.1.2 判別器網絡結構

本文采用馬爾科夫判別器來構建生成圖像的局部信息,進一步提升生成的語義分割圖像在細節上的表現。馬爾科夫判別器的結構如圖3所示,其為一個全卷積網絡,采用四層卷積層對輸入圖像進行特征提取,得到一張n×n的特征圖,網絡的輸出為一個n×n矩陣,其中矩陣中每一個結果對應輸入圖像中的一個感受野,即輸出矩陣為輸入圖像中n×n個Patch的判別結果,最終以輸出矩陣的均值判斷輸入圖像為生成圖像還是真實圖像。馬爾科夫判別器和生成器均是全卷積網絡,因此可以處理任意尺寸的圖像,增強了網絡的擴展性。

圖3 判別器網絡結構示意圖

1.2 損失函數

本文方法的損失函數由對抗損失和重構損失兩部分組成。對抗損失函數LCGAN(G,D)如式(1)所示:

LCGAN(G,D)=Ex,y[logD(x,y)]+

Ex,z[log(1-D(x,G(x,z)))]

(1)

其中,生成器G的目標是生成與真實分割圖像盡可能相似的圖像以最小化損失函數,判別器D的目標是盡可能區分生成的分割圖像與真實的分割圖像以最大化損失函數,該過程可表示為

(2)

為了進一步提升生成器的性能,減小生成的分割圖像與真實的分割圖像的差異,本文方法采用L1損失函數減少生成圖像的模糊程度,所以本方法使用L1損失函數構建生成的分割圖像的低頻部分,促使生成圖像在全局上更接近于真實圖像,L1重構損失如式(3)所示:

LL1(G)=Ex,y,z[‖y-G(x,z)‖1]

(3)

本文方法的目標函數可以表示為式(4)所示的形式:

(4)

式中,λ表示兩個損失函數的相對重要程度。

2 實驗結果與分析

2.1 實驗數據

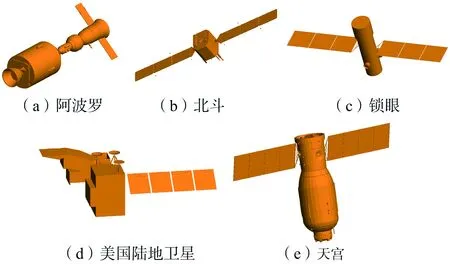

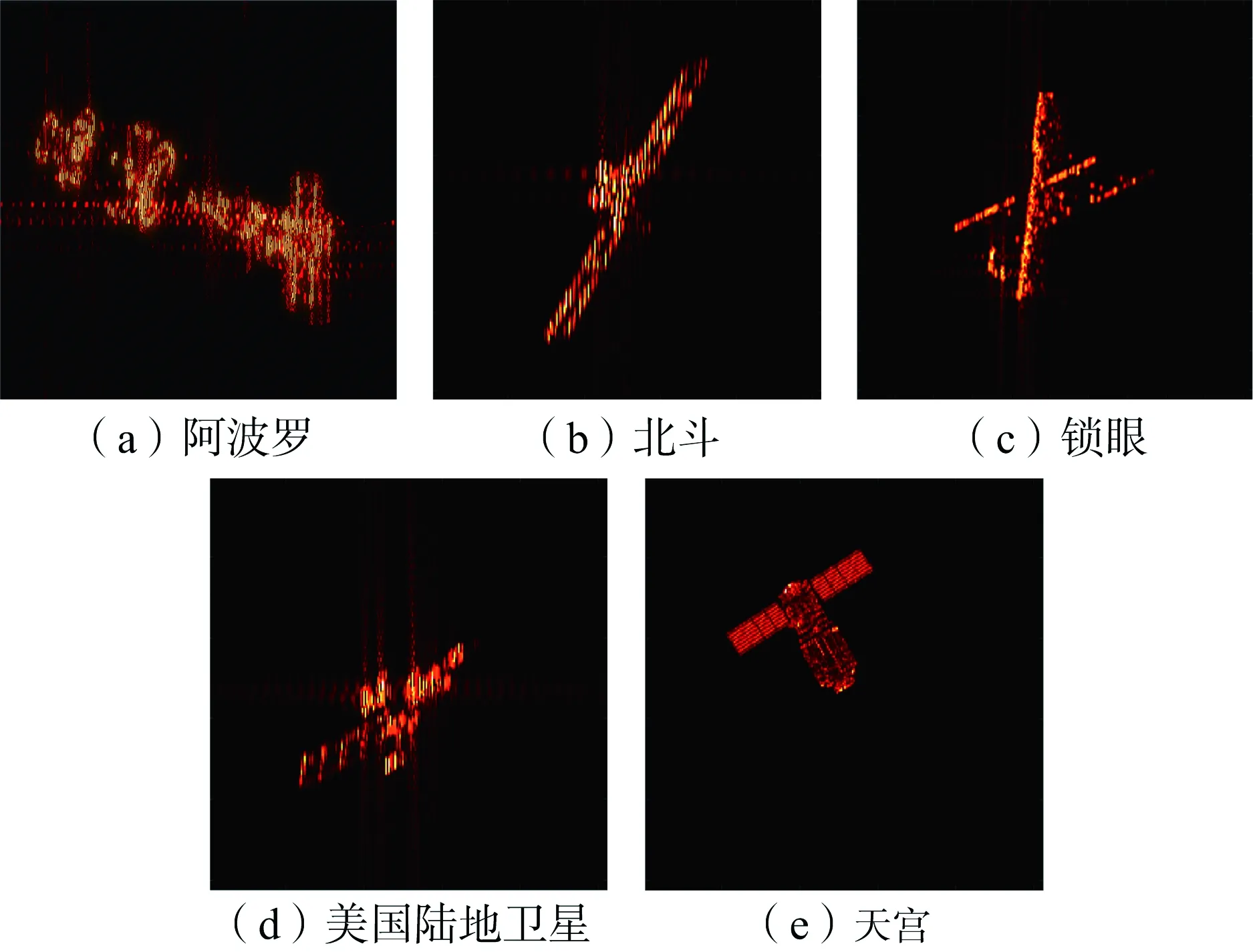

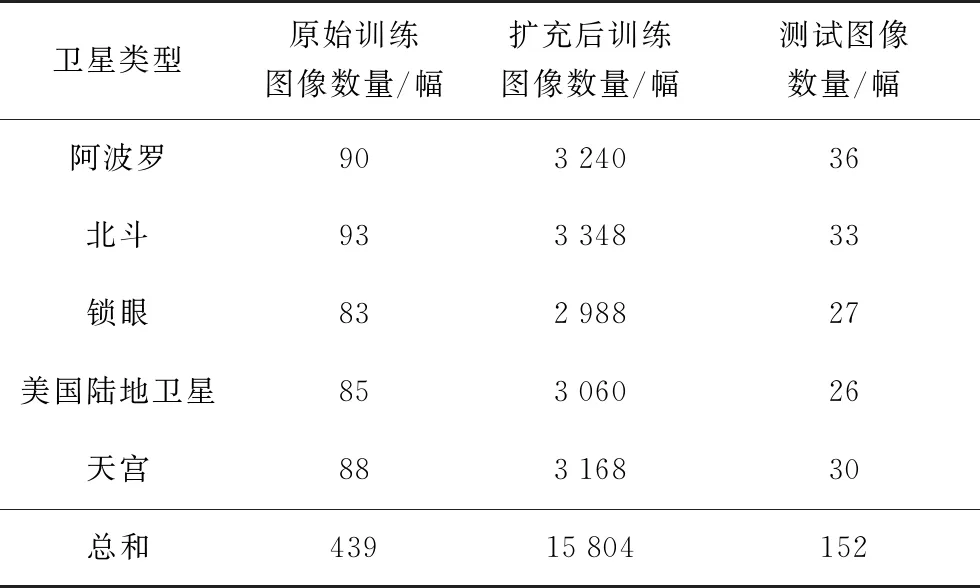

本文使用由電磁仿真軟件FEKO對衛星目標建模、再通過BP成像算法得到的衛星目標ISAR圖像數據集進行實驗。該數據集包含五類衛星目標,分別為阿波羅衛星、北斗衛星、鎖眼衛星、美國陸地衛星和天宮衛星,仿真CAD模型和其對應的ISAR圖像示例分別如圖4和圖5所示。為了滿足深度神經網絡對于訓練數據量的要求,我們對訓練數據集進行平移和鏡像操作,將訓練圖像數量擴充至原始數據量的36倍,五類衛星ISAR圖像數量如表1所示。

圖4 衛星CAD模型示意圖

圖5 衛星目標ISAR圖像示例

表1 五類衛星目標的樣本數信息

2.2 性能評價指標

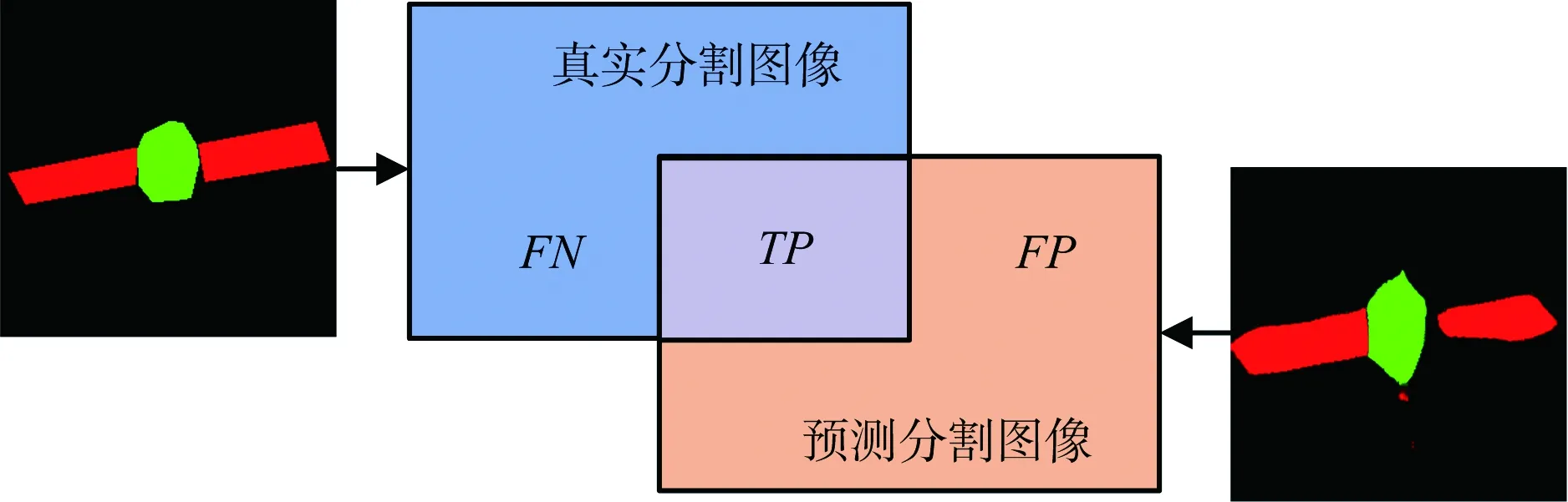

為了定量評估不同方法的分割性能,本文采用語義分割標準衡量準則——平均交并比(Mean Intersection over Union,MIoU)作為定量評判的準則,MIoU為預測結果與真實結果之間的交集與并集之比,計算示意圖如圖6所示。

圖6 計算MIoU示意圖

圖6中,TP表示預測分割圖像與真實分割圖像分類一致的像素數,FP表示真實分割圖像中除去TP以外的像素數,FN表示預測分割圖像中除去TP以外的像素數。

計算公式如下:

(5)

式中,M表示圖像總數。

2.3 實驗結果分析

1) 語義分割性能比較分析

圖7給出了本文方法對不同衛星目標的分割結果,圖中第一、二、三列分別為ISAR圖像、分割圖像和標簽,第四列和第五列分別為從分割圖像提取到的衛星太陽能帆板和主體,并且經過邊緣細化、空洞填充等形態學操作后的結果。結果表明,對于不同類型衛星目標的ISAR圖像,本文方法均能夠取得較好的分割結果,經過掩膜分割后得到完整的太陽能帆板和主體。由圖可知,本文的方法在太陽能帆板與主體粘連處能夠實現精細的分割,在細節上有較好的表現,這表明本文方法中生成器和判別器的結構能夠提升語義分割的細節表現,精細的語義分割結果能夠為后續解譯工作奠定良好的基礎。

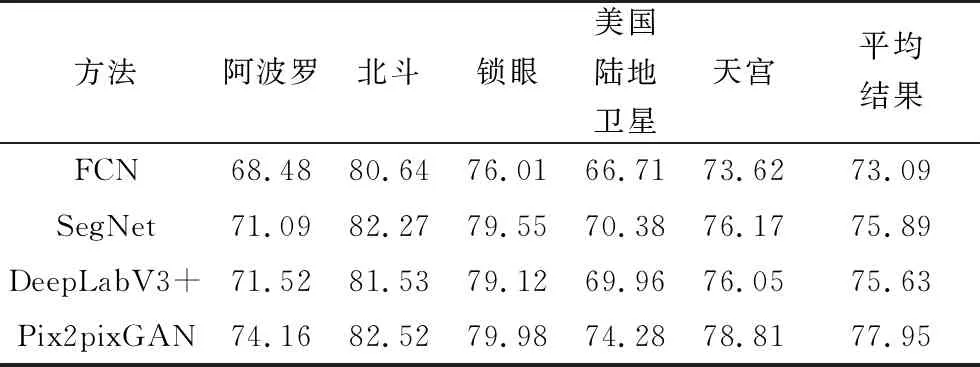

為了評估本文方法與現有的深度語義分割方法性能,表2給出了不同語義分割方法對于每類衛星的MIoU結果以及五類衛星MIoU的平均結果。由表2可以看出,在ISAR圖像標簽不夠精準的情況下,本文方法依然取得了較好的分割精度,且對于不同衛星目標的分割性能穩定,說明模型具有較好的魯棒性。由于ISAR圖像人工標注無法保證語義標簽的精確性,這種情況下MIoU定量評估結果并不能完全說明本文方法在分割精度上一定最優,但是足以說明其具有較好的分割性能。

圖7 本文方法的衛星ISAR圖像分割結果示例(紅色:太陽能板;綠色:主體)

表2 不同語義分割方法的MIoU %

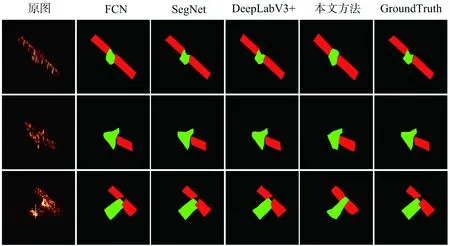

圖8給出了本文方法與三種傳統深度語義分割方法在語義標簽不夠精準的情況下訓練數據的分割結果示例。對照圖8中的原圖和Ground Truth可以看出,第一行至第三行的GroundTruth中均存在太陽能板和主體標注不完整的問題(主體標注明顯不完整),第一、二行的GroundTruth中太陽能板和主體之間存在不同程度的斷裂。其他三種對比方法的分割結果存在與GroundTruth相同的問題,分割結果不夠準確;相比于對比方法的分割結果,本文方法的結果對GroundTruth的擬合度較低,但通過對照原圖和本文方法的結果可以看出,本文方法能夠比較完整地分割出主體和太陽能板,且太陽能板和主體間的連續性較好,沒有明顯斷裂的情況。圖8的結果說明在語義標注不夠精準的情況下,其他對比的語義分割方法學習到的結果非常接近標注、也不夠精準,而本文方法仍然能夠準確地、完整地將目標的太陽能板和主體分割出來。這是因為所對比的語義分割方法采用交叉熵損失函數學習像素到像素之間語義類別的映射,此類方法對于語義標注的精度要求較高,在標注圖像不精準的情況下會使得模型學到一些錯誤信息,導致分割結果不夠精準;而GAN的對抗學習思想能夠訓練模型學習數據分布到分布之間的映射,它能夠通過生成器與判別器的對抗博弈過程探究數據的分布情況,即使標注本身存在誤差,由于約束方式相比較于像素到像素之間的語義類別映射更加靈活,不會對每個像素的預測誤差進行懲罰,因而可以減弱模型對于精準標注的需求,使模型具有較好的泛化性。因此,在語義標簽不夠精準的情況下本文方法的語義分割性能更加穩健。

圖8 語義標注不精準情況下不同分割方法的訓練結果示例(紅色:太陽能板;綠色:主體)

2) 不同模型空間、時間復雜度分析

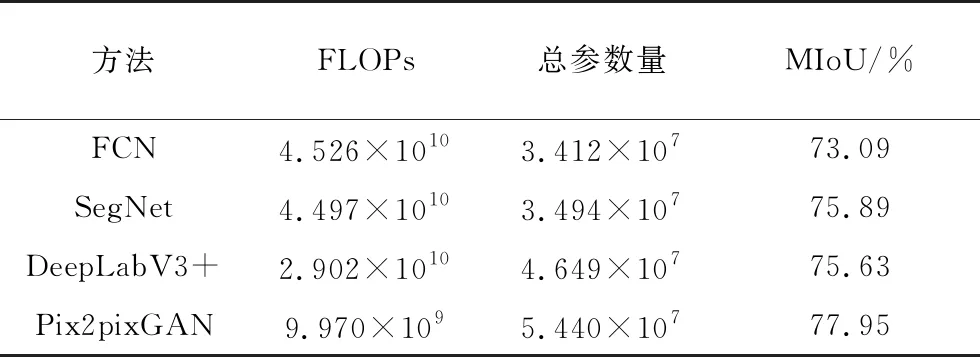

為了分析本文方法與現有語義分割方法的模型復雜度與運算效率,表3計算了用于衡量不同模型時間復雜度和空間復雜度的浮點運算次數(Floating-point Operations, FLOPs)和總參數量,由于CNN 的FLOPs和參數量主要集中在卷積層、反卷積層和全連接層,其余層的FLOPs和參數量相比于卷積層、反卷積層和全連接層非常少,可以忽略,又由于所提方法和對比方法均未含有全連接層,因此我們分析時間和空間復雜度時僅考慮了卷積層和反卷積層。

時間復雜度與模型的FLOPs成正相關,計算公式如下式所示:

(6)

式中,K為卷積核與反卷積核的尺寸,C為卷積與反卷積通道數,D為卷積層的層數,N為反卷積層的層數,Mout,l為第l卷積層輸出的特征圖尺寸,Min,n為第n反卷積層輸入的特征圖尺寸。

空間復雜度與模型的總參數量成正相關,計算公式如下式所示:

(7)

式中,K為卷積核與反卷積核的尺寸,C為卷積與反卷積通道數,D為卷積層與反卷積層的總層數。

表3 不同模型總參數量、FLOPs和MIoU

由表3可以看出,FCN[3]和SegNet[4]具有較高的FLOPs, 這是因為FCN和SegNet均用普通的卷積組堆疊構成深層編碼-解碼結構,并且使用步長為1的卷積核使得輸出特征圖尺寸較大;Deep-LabV3+[5]模型中使用深度可分離卷積減少了計算量;本文方法采用步長為2的卷積核進行下采樣使得輸出特征圖尺寸大大減小,因此具有最低的FLOPs;然而,本文方法使用跳線連接保持編碼器細節信息的同時使得解碼器部分的卷積通道數倍增,因此具有較高的參數量,如何進一步優化模型的空間復雜度,減少模型參數量是下一步需要探索的方向。

3 結束語

本文針對ISAR圖像語義分割問題,提出了一種基于Pix2pixGAN的ISAR圖像語義分割方法,該方法采用對抗學習思想學習ISAR圖像分布到其語義分割圖像分布的映射關系,同時通過構建分割圖像的局部信息和全局信息來保證語義分割的精度。實驗結果證明,本文方法能夠對ISAR圖像取得較好的語義分割結果,且在語義標注不夠精準的情況下模型更穩健。然而,本文方法的網絡存在較高時間復雜度的問題,如何進一步優化模型的時間復雜度是下一步需要探索的方向。