面向高光譜遙感圖像分類的連續(xù)空間依賴增強(qiáng)型空—譜卷積神經(jīng)網(wǎng)絡(luò)

周 子 涵,倪 歡,馬 林 飛

(南京信息工程大學(xué)遙感與測(cè)繪工程學(xué)院,江蘇 南京 210044)

0 引言

高光譜遙感圖像分類旨在利用其豐富的空—譜信息為每個(gè)像元分配一個(gè)地表覆被類型[1],可為自然資源調(diào)查提供支撐[2]。但由于高維度特征和訓(xùn)練樣本匱乏問題,使高光譜圖像分類仍存在局限[3,4]。傳統(tǒng)高光譜圖像分類研究引入經(jīng)典機(jī)器學(xué)習(xí)方法[5](如支持向量機(jī)[6]和隨機(jī)森林[7]等),但這種依賴于人工設(shè)計(jì)特征的分類方法很難取得較高的分類精度[8,9],且難以應(yīng)對(duì)少量樣本支持下的高維度特征[10,11]。卷積神經(jīng)網(wǎng)絡(luò)(Convolutional Neural Network,CNN)[12]可實(shí)現(xiàn)特征維度的快速變換,并有效改善高層次語義的表達(dá)能力[13],已應(yīng)用于高光譜遙感圖像分類研究[14]中。其中,DFFN(Deep Feature Fusion Network)[15]和MSKNet(Multibranch Selective Kernel Networks)[16]等二維CNN框架僅挖掘了高光譜圖像的光譜特征,未能充分利用其中蘊(yùn)含的空—譜信息。近年提出了各具特色的三維CNN網(wǎng)絡(luò)結(jié)構(gòu)[17]以解決上述問題,如SSRN(Supervised Spectral-spatial Residual Network)[18]、FDSSC(Fast Dense Spectral-Spatial Convolution)[19]、DPyResNet(Deep Pyramidal Residual Network)[20]和A2S2K-ResNet(Attention-Based Adaptive Spectral-Spatial Kernel ResNet)[21]。其中,具有代表性的A2S2K-ResNet采用卷積核選擇思想[22],詳細(xì)探討卷積核尺寸對(duì)特征表達(dá)的重要性,通過設(shè)計(jì)一種為波段間關(guān)系建模的模塊EFR(Efficient Feature Recalibration),充分發(fā)揮高光譜圖像的高維度優(yōu)勢(shì),對(duì)基于三維CNN的殘差網(wǎng)絡(luò)(ResNet)[23]進(jìn)行改進(jìn),以增強(qiáng)空—譜聯(lián)合特征的提取能力。A2S2K-ResNet的精度雖然較高,但其引入的卷積核選擇思想類似于不同預(yù)設(shè)卷積核特征的加權(quán)求和,在訓(xùn)練過程中不能完全自適應(yīng)選擇卷積核,且該過程預(yù)先定義的兩個(gè)卷積核尺寸(3×3×7和1×1×7),并未充分增大或細(xì)化CNN的感受野;其次,雖然該過程引入注意力機(jī)制輔助概括語義,但其采用均值池化方式提取一維注意力向量,再經(jīng)過卷積變換形成權(quán)值以增強(qiáng)卷積特征,不足以充分表達(dá)圖像空間依賴關(guān)系,導(dǎo)致分類結(jié)果存在噪聲。鑒于此,本文提出一種連續(xù)空間依賴增強(qiáng)(Continuously Spatial Dependency Enhancement,CSDE)模塊,替代A2S2K-ResNet中的卷積核選擇過程,以彌補(bǔ)A2S2K-ResNet在以上理論方面的不足,并改善分類結(jié)果。

1 研究方法

1.1 A2S2K-ResNet

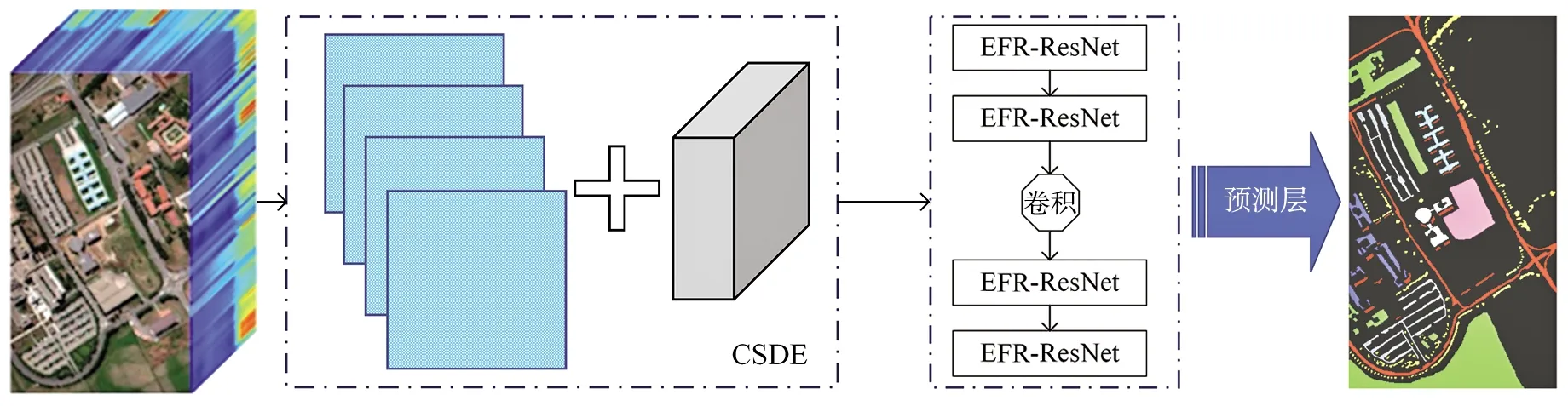

A2S2K-ResNet[21]的整體網(wǎng)絡(luò)框架由1個(gè)基于注意力機(jī)制的自適應(yīng)空—譜核模塊(A2S2K)和4個(gè)嵌入EFR的三維ResNet模塊(EFR-ResNet)構(gòu)成,利用1個(gè)由池化層和全連接層相結(jié)合的預(yù)測(cè)層,實(shí)現(xiàn)從特征到類別的預(yù)測(cè)。

(1)

(2)

[za,zb]=softmax([za,zb])

(3)

(4)

三維ResNet多用于高光譜圖像處理,其經(jīng)過多組卷積層、歸一化層、ReLU激活層處理后,通過殘差連接的方式增強(qiáng)輸入特征的表達(dá)能力[24]。EFR-ResNet將EFR過程融入三維ResNet中,利用3組卷積層(圖1)使三維ResNet更有效地建立波段相關(guān)性。假設(shè)EFR的輸入是F∈RB×Cin×S×S×C,則EFR用于捕捉F在Cin維度各波段間的相關(guān)性。EFR首先通過三維均值池化操作壓縮F,生成s∈RB×Cin×1×1×1,然后在Cin維度對(duì)s的各波段進(jìn)行線性變換(式(5)),最后將ω與F進(jìn)行逐像素相乘,以增強(qiáng)F的波段相關(guān)性。在兩個(gè)ERF-ResNet執(zhí)行完成后,引入兩個(gè)三維卷積層,在不同維度上實(shí)現(xiàn)卷積,以增強(qiáng)卷積特征的表達(dá)能力。

圖1 EFR-ResNet框架示意Fig.1 Framework of EFR-ResNet

(5)

1.2 連續(xù)空間依賴增強(qiáng)(CSDE)模塊

當(dāng)前A2S2K使用的自適應(yīng)加權(quán)機(jī)制(式(4))是對(duì)兩個(gè)卷積特征圖譜進(jìn)行整體加權(quán),對(duì)感受野的擴(kuò)充作用有限。為增大CNN的感受野并顧及細(xì)節(jié)特征,本文提出CSDE模塊(圖2)以替換A2S2K模塊,該模塊采用自注意力矩陣為圖像塊整體空間依賴關(guān)系建模,并進(jìn)行逐像素加權(quán)。

圖2 面向高光譜遙感圖像的連續(xù)空間依賴增強(qiáng)(CSDE)模塊Fig.2 Continuously spatial dependency enhancement (CSDE) module for hyperspectral imagery

(6)

(7)

(8)

(9)

式中:Conv3×3×7(·)和Conv1×1×7(·)分別為具有3×3×7和1×1×7卷積核的三維CNN層;EFR(·)為式(5)所示的EFR;Conv3×3為具有3×3卷積核的二維CNN層。

(10)

(11)

(12)

1.3 本文方法網(wǎng)絡(luò)結(jié)構(gòu)

圖3 本文方法整體網(wǎng)絡(luò)結(jié)構(gòu)示意Fig.3 Overall network architecture of the proposed method

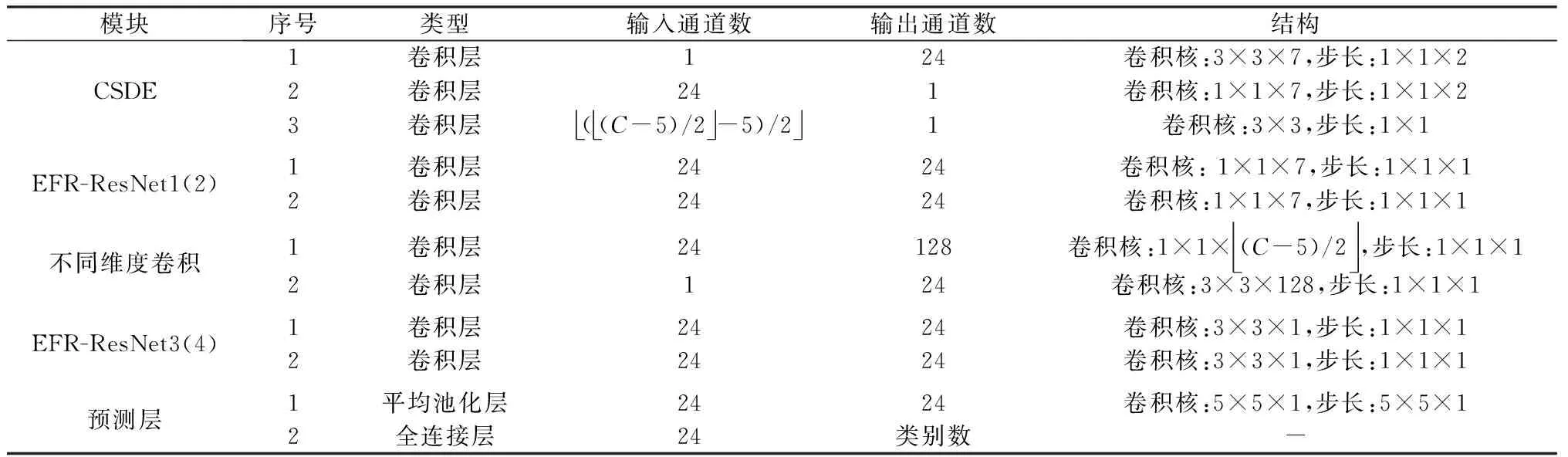

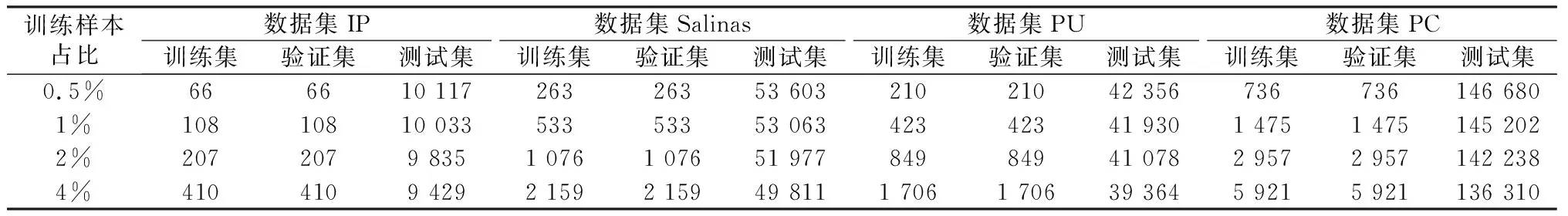

表1 本文方法各卷積層、池化層、全連接層參數(shù)和結(jié)構(gòu)詳情Table 1 Parameters and structure information of the convolutional,pooling and fully-connected layers in the proposed method

2 實(shí)驗(yàn)

本文方法采用Python語言并結(jié)合PyTorch,引入高光譜研究領(lǐng)域廣泛使用的4組標(biāo)準(zhǔn)測(cè)試數(shù)據(jù)集(Indian Pines(IP)、Salinas、Pavia University(PU)和Pavia Centre(PC))對(duì)本文方法和A2S2K-ResNet進(jìn)行性能評(píng)估,并采用整體精度(OA)、平均精度(AA)和Kappa系數(shù)(K)對(duì)兩種方法進(jìn)行精度對(duì)比。其中,OA表示全部正確分類的像素比例,AA表示各類別正確分類像素比例的平均值。

2.1 實(shí)驗(yàn)配置

本文方法與A2S2K-ResNet方法的實(shí)驗(yàn)配置[21]相同:在訓(xùn)練過程中采用Adam優(yōu)化方法,學(xué)習(xí)率初始值設(shè)置為0.01,衰減策略采用文獻(xiàn)[25]方法,Batch大小設(shè)置為16;為分析模型穩(wěn)定性,在每組數(shù)據(jù)集上訓(xùn)練5次,根據(jù)每次訓(xùn)練完成得到的模型獲取分類結(jié)果,并統(tǒng)計(jì)分類結(jié)果精度的標(biāo)準(zhǔn)差。

為充分驗(yàn)證本文方法性能,將整體樣本劃分為互不相交的訓(xùn)練集、驗(yàn)證集和測(cè)試集,并設(shè)置訓(xùn)練集和驗(yàn)證集樣本數(shù)量相等。其中,訓(xùn)練集用于模型訓(xùn)練,測(cè)試集用于測(cè)試模型分類精度,驗(yàn)證集在訓(xùn)練過程中實(shí)時(shí)計(jì)算當(dāng)前模型的損失函數(shù)和驗(yàn)證精度,以選擇模型。因訓(xùn)練樣本數(shù)量直接影響模型的預(yù)測(cè)精度,本文限定訓(xùn)練樣本數(shù)量占比分別為0.5%、1%、2%和4%,進(jìn)而確定4組數(shù)據(jù)集訓(xùn)練集、驗(yàn)證集和測(cè)試集樣本數(shù)量(表2)。訓(xùn)練集樣本和測(cè)試集樣本數(shù)量均以像素為單位,以當(dāng)前像素為中心在9×9窗口內(nèi)的像素值參與當(dāng)前訓(xùn)練樣本的特征計(jì)算,不參與損失函數(shù)計(jì)算、后向傳播和模型參數(shù)優(yōu)化過程;在預(yù)測(cè)過程中,同樣以每個(gè)待預(yù)測(cè)的像素為中心,將其9×9窗口內(nèi)的像素值輸入訓(xùn)練好的模型中進(jìn)行特征計(jì)算(窗口內(nèi)的所有像素均不包含類別信息),再根據(jù)深度學(xué)習(xí)模型的預(yù)測(cè)層實(shí)現(xiàn)該像素類別的預(yù)測(cè)。

表2 4組數(shù)據(jù)集訓(xùn)練集、驗(yàn)證集和測(cè)試集樣本數(shù)量Table 2 Details of the training,validation and testing samples for the four datasets

2.2 模型訓(xùn)練

為檢驗(yàn)本文實(shí)驗(yàn)訓(xùn)練過程的有效性,計(jì)算訓(xùn)練集和驗(yàn)證集隨循環(huán)訓(xùn)練不斷推進(jìn)的訓(xùn)練損失、驗(yàn)證損失和精度(OA、AA和K)(圖4),訓(xùn)練過程的循環(huán)次數(shù)限定為200次,圖4中每點(diǎn)均對(duì)應(yīng)每次循環(huán)后整個(gè)訓(xùn)練集的損失和精度,以及當(dāng)前模型作用于驗(yàn)證集上的損失和精度。限于篇幅,這里僅列舉IP數(shù)據(jù)集取4%訓(xùn)練樣本時(shí)的情況。

圖4 模型訓(xùn)練過程的損失、訓(xùn)練精度和驗(yàn)證精度Fig.4 Loss,training and validation accuracy values in the training procedure of the proposed method

由圖4a可知,驗(yàn)證集和訓(xùn)練集的損失變化規(guī)律類似,即前幾次訓(xùn)練循環(huán)大幅減小了損失值,當(dāng)循環(huán)次數(shù)達(dá)到30次時(shí),損失趨于平穩(wěn),在后續(xù)循環(huán)中,訓(xùn)練損失和驗(yàn)證損失緩慢減小。由圖4b-圖4d可知,訓(xùn)練精度和驗(yàn)證精度的變化趨勢(shì)相同,雖然驗(yàn)證精度略低于訓(xùn)練精度,但二者均超過0.95,因此,該訓(xùn)練過程不存在訓(xùn)練精度高而驗(yàn)證精度未達(dá)到任務(wù)需求的過擬合問題,模型訓(xùn)練有效。

3 實(shí)驗(yàn)結(jié)果分析

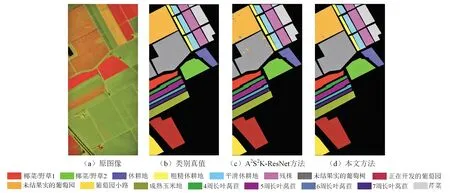

3.1 可視化分析

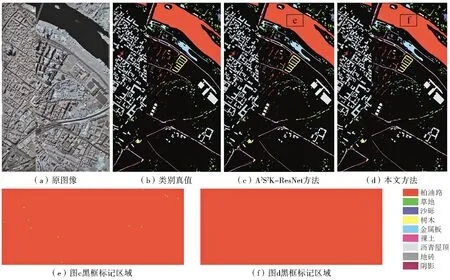

考慮到分類結(jié)果規(guī)律相同,本文只列舉2%訓(xùn)練樣本情況下的分類結(jié)果(圖5-圖7彩圖見附錄1,圖8彩圖見附錄2)。可以看出,IP數(shù)據(jù)集分辨率較低,類別多(16個(gè)),類間樣本數(shù)量差異大,在2%訓(xùn)練樣本下,其包含的9個(gè)類別的訓(xùn)練樣本量極少,導(dǎo)致A2S2K-ResNet分類結(jié)果存在大量噪聲(圖5c),而本文方法增強(qiáng)了空間依賴信息,有效抑制了噪聲(圖5d);與IP數(shù)據(jù)集類似,在Salinas數(shù)據(jù)集上本文方法也有效抑制了噪聲,且比A2S2K-ResNet的誤判現(xiàn)象少(圖6d左上角);PU和PC數(shù)據(jù)集樣本數(shù)量較多、類別較少(9個(gè)),兩種方法分類結(jié)果接近,但A2S2K-ResNet方法誤分類現(xiàn)象更多,如在圖8e和圖8f標(biāo)記區(qū)域,其分類結(jié)果存在單個(gè)像素形式的誤判點(diǎn),本文方法則不存在該問題。整體而言,本文方法優(yōu)于A2S2K-ResNet。

圖5 數(shù)據(jù)集IP的實(shí)驗(yàn)結(jié)果及可視化對(duì)比Fig.5 Experimental results and visual comparison of the IP dataset

圖6 數(shù)據(jù)集Salinas的實(shí)驗(yàn)結(jié)果及可視化對(duì)比Fig.6 Experimental results and visual comparison of the Salinas dataset

圖7 數(shù)據(jù)集PU的實(shí)驗(yàn)結(jié)果及可視化對(duì)比Fig.7 Experimental results and visual comparison of the PU dataset

圖8 數(shù)據(jù)集PC的實(shí)驗(yàn)結(jié)果及可視化對(duì)比Fig.8 Experimental results and visual comparison of the PC dataset

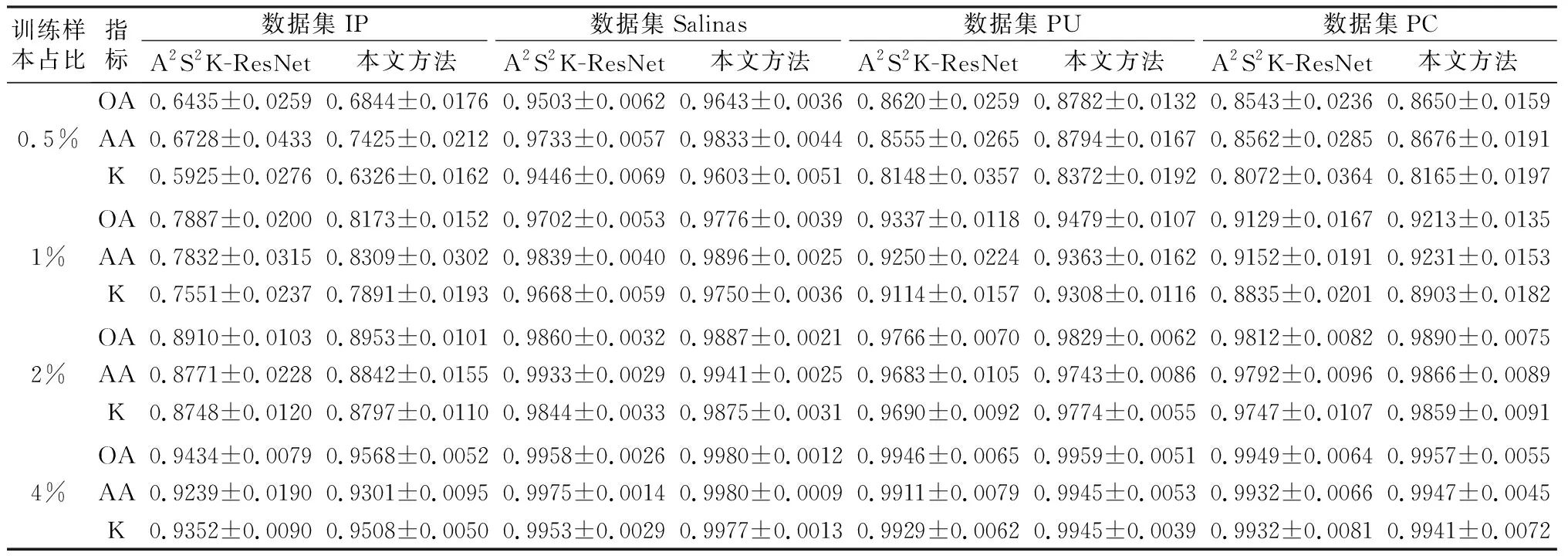

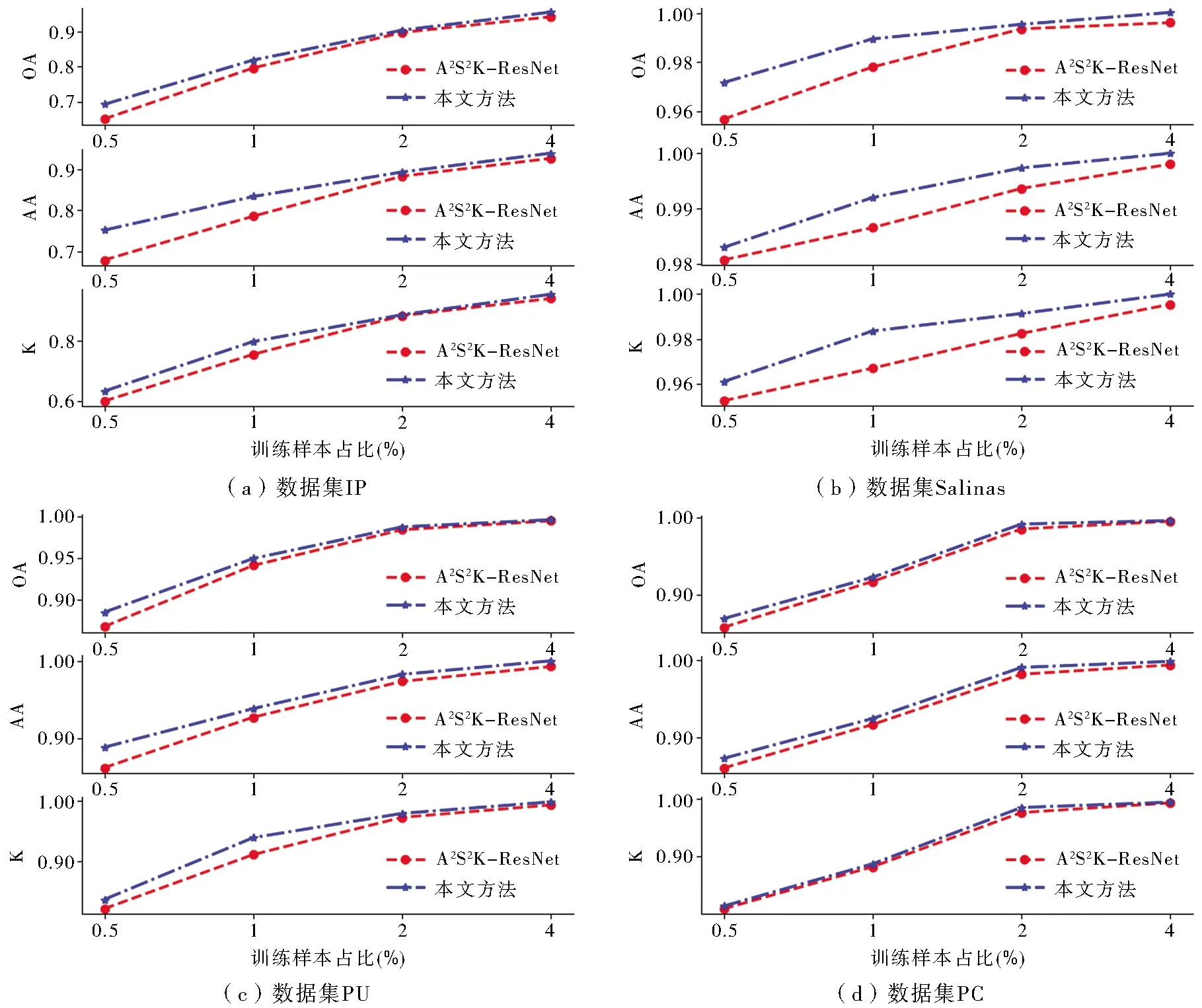

3.2 定量化分析

由表3可知,在取0.5%、1%、2%和4%訓(xùn)練樣本情況下,本文方法于4組數(shù)據(jù)集上均取得了比A2S2K-ResNet更高的分類精度和較低的分類精度標(biāo)準(zhǔn)差,表明本文方法性能較穩(wěn)定。如圖9所示,隨著訓(xùn)練樣本數(shù)量增加,兩種方法的OA、AA、K值均呈上升趨勢(shì)且逐漸接近,在訓(xùn)練樣本占比達(dá)到4%時(shí),兩種方法的分類精度均較高,在數(shù)據(jù)集Salinas、PU和PC上,OA、AA、K值均超過0.99,但在數(shù)據(jù)集IP上,精度偏低,這與圖5中的可視化結(jié)果相吻合。當(dāng)訓(xùn)練樣本數(shù)量極少時(shí)(0.5%),兩種方法的分類精度下降明顯,尤其是在數(shù)據(jù)集IP上,A2S2K-ResNet的K值低于0.6,而本文方法降幅較小,優(yōu)于A2S2K-ResNet。

表3 4組數(shù)據(jù)集測(cè)試精度(精度均值±標(biāo)準(zhǔn)差)對(duì)比分析Table 3 Comparison analysis on the testing accuracy (mean value±standard deviation) of the four datasets

3.3 空間一致性后處理的影響分析

本文采用3×3窗口對(duì)兩種方法的分類結(jié)果進(jìn)行空間一致性后處理(圖10),以消除分類結(jié)果中的噪聲。對(duì)比圖9的初始分類結(jié)果可以看出,空間一致性后處理均提高了兩種方法的分類精度,但兩種方法的精度差異未發(fā)生明顯變化,本文方法分類結(jié)果依然更佳,進(jìn)一步證實(shí)了本文方法的優(yōu)越性。

圖9 分類結(jié)果精度對(duì)比Fig.9 Comparison of the accuracy values of classification results

圖10 分類結(jié)果經(jīng)空間一致性處理后的精度對(duì)比分析Fig.10 Comparison analysis on the accuracy of results processed by the spatial consistency post-processing

3.4 綜合性能評(píng)價(jià)

FLOPs(the number of floating-point operations)是衡量深度學(xué)習(xí)模型計(jì)算復(fù)雜度的指標(biāo),其值越大,說明模型計(jì)算復(fù)雜度越高。對(duì)兩種方法的參數(shù)量和計(jì)算復(fù)雜度進(jìn)行統(tǒng)計(jì):本文方法的參數(shù)量為0.371 M,與A2S2K-ResNet并無差別;但在并行輸入16個(gè)大小為9×9×204的圖像塊(窗口)時(shí),A2S2K-ResNet的FLOPs值為2.807 G,本文方法的FLOPs值為2.768 G,在不斷擴(kuò)大輸入圖像塊大小時(shí),該差異更突出。因此,相比A2S2K-ResNet,本文方法在未增加參數(shù)量的前提下可提高分類精度,降低計(jì)算復(fù)雜度。

4 結(jié)論

A2S2K-ResNet作為一種面向高光譜遙感圖像的深度學(xué)習(xí)分類方法,具有精度高、速度快等優(yōu)點(diǎn),但其A2S2K不能有效優(yōu)化CNN感受野,進(jìn)而影響分類結(jié)果。本文提出的面向高光譜圖像的連續(xù)空間依賴增強(qiáng)(CSDE)模塊,可有效建立圖像空間依賴關(guān)系,消除人為選定預(yù)設(shè)感受野尺寸帶來的不確定因素。引入4組高光譜遙感圖像標(biāo)準(zhǔn)分類測(cè)試數(shù)據(jù)集進(jìn)行實(shí)驗(yàn),并結(jié)合國際通用的3種精度評(píng)價(jià)指標(biāo)進(jìn)行方法驗(yàn)證和對(duì)比分析。可視化對(duì)比分析表明,本文方法有效抑制了A2S2K-ResNet分類結(jié)果中存在的噪聲,減少了分類誤判現(xiàn)象;定量化對(duì)比分析表明,本文方法的分類性能更穩(wěn)定,且隨著訓(xùn)練樣本數(shù)量遞減,優(yōu)勢(shì)逐漸增大。此外,兩種方法參數(shù)量和計(jì)算復(fù)雜度的統(tǒng)計(jì)結(jié)果顯示,相比A2S2K-ResNet,本文方法在未增加參數(shù)量的前提下降低了模型計(jì)算復(fù)雜度。

本文方法雖然解決了A2S2K-ResNet潛在的部分問題,但仍具備改進(jìn)空間,如CSDE模塊僅考慮了當(dāng)前像素周圍鄰近區(qū)域的連續(xù)空間依賴關(guān)系,未能將其拓展到整個(gè)圖像空間,未來將在不增加計(jì)算復(fù)雜度的前提下解決該問題;同時(shí),將聚焦極少訓(xùn)練樣本支持下的高光譜圖像分類任務(wù),以全面提升高光譜圖像分類模型的實(shí)用性。