一種基于卷積神經網絡的人群密度識別算法

楊博涵

摘要:近年來,人群密度的識別成為模式識別領域的熱點問題,基于這個問題,該文提出一種基于卷積神經網絡的算法,首先將數據集中的Ground-Truth數據轉化為人群密度圖,然后將生成的密度圖送入神經網絡中進行訓練,得到人群密度數據。該文創新點在于采用多尺度卷積神經網絡,使用多種尺度的卷積核來適應不同尺度的人頭大小。通過利用具有不同尺寸接收領域的過濾器,從而可以識別各種分辨率的人群圖像和數據。

關鍵詞:人工智能;卷積神經網絡;人群密度識別

中圖分類號:TP3 ? ? ? ?文獻標識碼:A

文章編號:1009-3044(2022)02-0082-02

1 概述

近年來,隨著城市化程度的加深,人群聚集的程度越來越高。一方面,隨著大型商超、地鐵站等人群聚集場所的增多,發生人群踩踏的概率越來越高;另一方面,在疫情的影響下,有必要對一些封閉場所的人群密度進行控制,防止出現大規模聚集性疫情。在人力資源日漸緊張的當下,依托于城市天網工程,利用攝像頭對人群密度進行監測是最好的選擇。

根據之前的成果,最廣泛使用的人群統計方法是基于特征的回歸[1],這種方法的主要步驟是(1)分割前景;(2)從前景提取各種特征,例如人群遮罩的區域、邊緣計數或紋理特征;(3)利用回歸函數來估計人群計數。線性或分段線性函數是相對簡單的模型,性能良好。其他更先進/有效的方法有嶺回歸[2](RR)、高斯過程回歸(GPR)、神經網絡(NN)[3]。

在目標檢測中使用較多的神經網絡是卷積神經網絡,卷積神經網絡采用一個固定尺寸的卷積核來遍歷圖片,對整張圖片進行卷積操作后可以自動化地提取圖片中不同尺寸的特征,之后可以利用多次池化、卷積等操作,對圖片中的特征進行自動歸納,從而檢測圖片的特征。卷積神經網絡具有原理簡單,相關資源成熟的特點,故本文基于密度圖和卷積神經網絡提出了一種具有多尺度檢測功能的卷積神經網絡。在多尺度卷積神經網絡中,用濾波器大小為1 × 1的卷積層來代替全連通層。因此,模型的輸入圖像可以是任意大小以避免失真。網絡的直接輸出是對人群密度的估計,從中得出總人數。

2 用于人群計數的多尺度神經網絡

2.1 用于人群計數的密度圖的生成

人群計數有兩種途徑,第一種途徑是直接輸入人群圖像和標簽數據,然后對人群數進行預測;第二種途徑是輸入人群的密度圖,之后積分得到人頭數量。生成密度圖是較好的辦法,因為密度圖可以保留更多的信息,如圖像的空間分布,如果一個小區域的密度比其他區域高得多,這可能表明那里發生了異常情況。

2.2 通過高斯核生成密度圖

如果在[xi]位置存在一個人頭,可以用[δ]函數來表示為[δx-xi],而一個包含[N]個頭像的圖像可以表示為:

[Hx=i=1Nδx-xi]

為了將這個圖像轉化為一個連續的函數,可以將這個函數與高 斯核[ Gσ]進行卷積[4],得到密度函數。

[Fx=Hx*Gσ]

此外還有一個問題,在使用二維高斯核時,需要設定高斯核大小用以表示估計的人頭大小。然而,在實踐中,由于許多情況下的遮擋,幾乎不可能準確地獲得頭部的大小,并且也很難找到頭部大小和密度圖之間的潛在關系。有趣的是,在擁擠的場景中頭部的大小通常與兩個相鄰人的中心之間的距離有關。作為折衷,對于那些擁擠場景的密度圖,建議根據每個人到其鄰居的平均距離,數據自適應地確定每個人的擴散參數。即對于一個人頭的最近的[k]個人頭的距離記作[{di1,di2,...,dik}],且有:

[di=1kj=1kdij]

高斯核的選擇應該取決于[di],即:

[Fx=Hx*Gσi,σi=βdi]

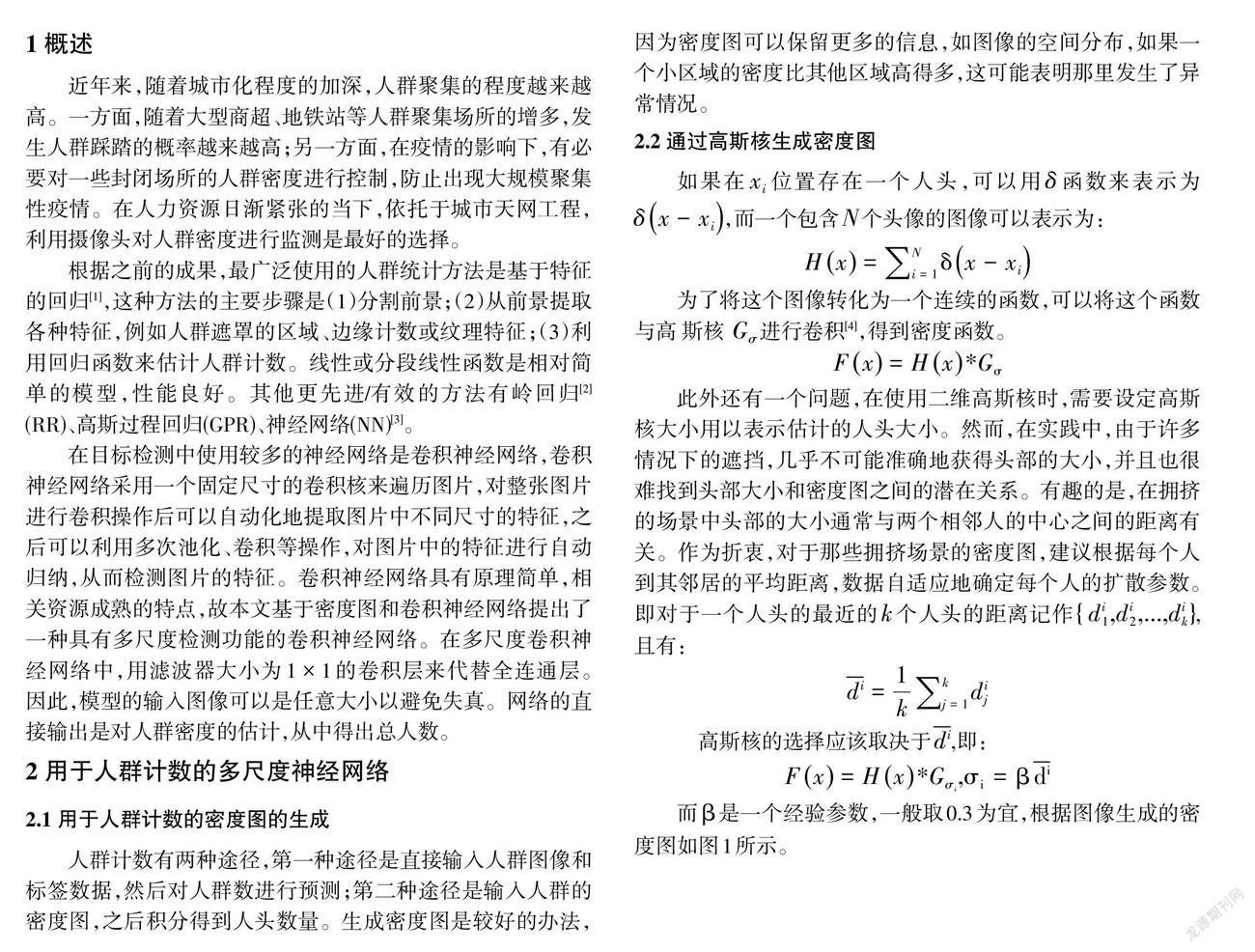

而[β]是一個經驗參數,一般取0.3為宜,根據圖像生成的密度圖如圖1所示。

2.3 使用密度圖的多尺度卷積神經網絡

由于透視失真,圖像通常包含大小非常不同的頭部,因此具有相同大小感受野的過濾器不太可能捕捉不同尺度下的人群密度特征。因此,更自然的是使用具有不同大小的局部感受野的濾波器來學習從原始像素到密度圖的映射。在MCNN中,對于每一列使用不同大小的過濾器來模擬對應于不同比例的頭部的密度圖。例如,具有較大感受野的過濾器對于模擬對應于較大頭部的密度圖更有用。

這種用于密度估計的MCNN模型的一個優點是,濾波器被學習來對不同尺寸的頭部的密度圖進行建模。因此,如果模型是在包含非常不同尺寸的頭部的大數據集上訓練的,那么模型可以容易地適應(或轉移)到另一個人群頭部具有一些特定尺寸的數據集。如果目標域只包含幾個訓練樣本,可以簡單地在MCNN中的每一列中固定前幾個層,并且只微調最后幾個卷積層。在這種情況下,微調最后幾層有兩個優點。首先,通過固定前幾層,可以保留在源域中學習的知識,并且通過微調最后幾層,可以使模型適應目標域。因此,源域和目標域的知識可以整合,有助于提高準確性。其次,與微調整個網絡相比,微調最后幾層大大降低了計算復雜度。

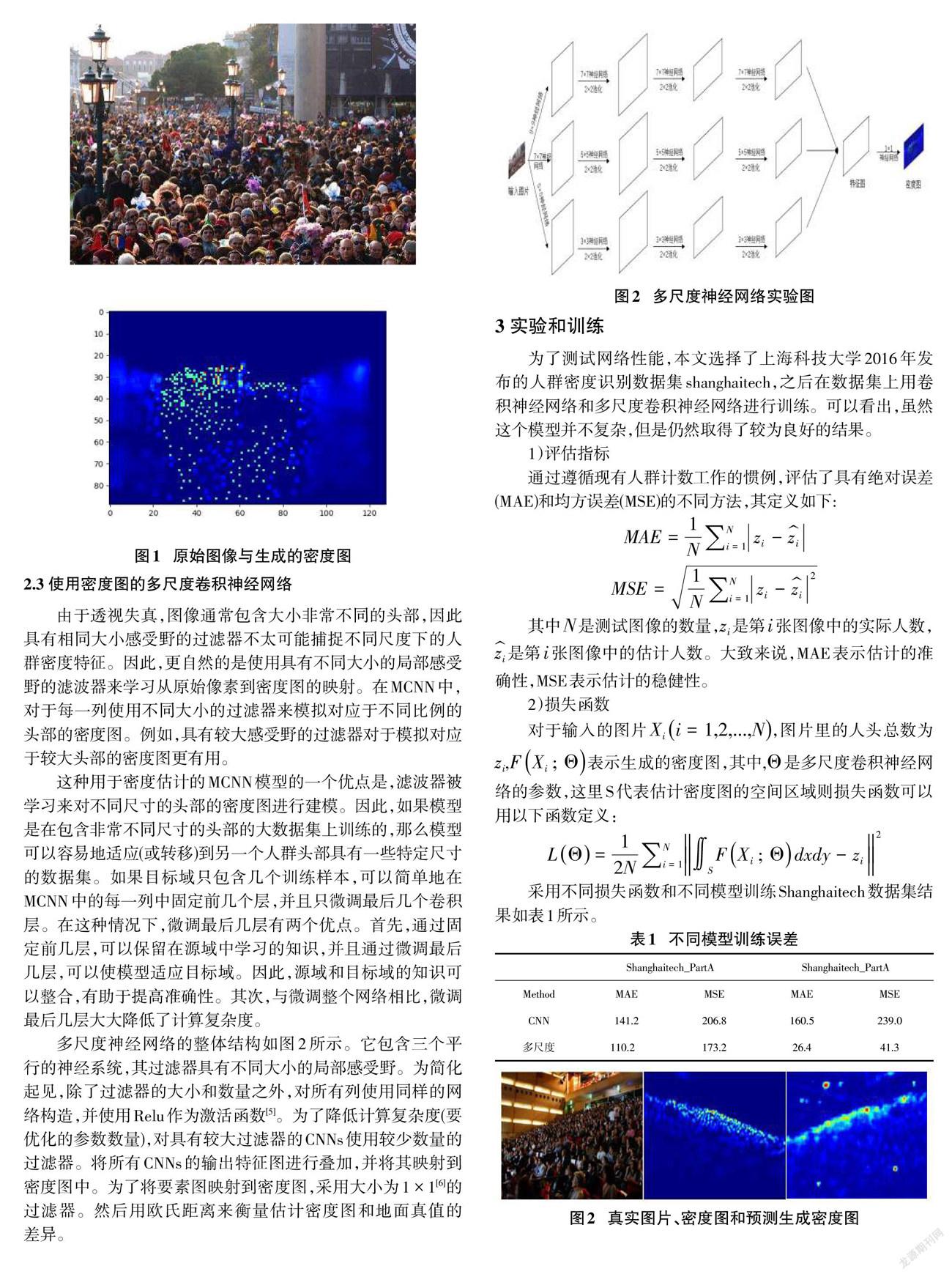

多尺度神經網絡的整體結構如圖2所示。它包含三個平行的神經系統,其過濾器具有不同大小的局部感受野。為簡化起見,除了過濾器的大小和數量之外,對所有列使用同樣的網絡構造,并使用Relu作為激活函數[5]。為了降低計算復雜度(要優化的參數數量),對具有較大過濾器的CNNs使用較少數量的過濾器。將所有CNNs的輸出特征圖進行疊加,并將其映射到密度圖中。為了將要素圖映射到密度圖,采用大小為1 × 1[6]的過濾器。然后用歐氏距離來衡量估計密度圖和地面真值的差異。

3 實驗和訓練

為了測試網絡性能,本文選擇了上海科技大學2016年發布的人群密度識別數據集shanghaitech,之后在數據集上用卷積神經網絡和多尺度卷積神經網絡進行訓練。可以看出,雖然這個模型并不復雜,但是仍然取得了較為良好的結果。

1)評估指標

通過遵循現有人群計數工作的慣例,評估了具有絕對誤差(MAE)和均方誤差(MSE)的不同方法,其定義如下:

[MAE=1Ni=1Nzi-zi]

[MSE=1Ni=1Nzi-zi2]

其中[N]是測試圖像的數量,[zi]是第[i]張圖像中的實際人數,[zi]是第[i]張圖像中的估計人數。大致來說,MAE表示估計的準確性,MSE表示估計的穩健性。

2)損失函數

對于輸入的圖片[Xii=1,2,...,N],圖片里的人頭總數為[zi],[FXi;Θ]表示生成的密度圖,其中,[Θ]是多尺度卷積神經網絡的參數,這里S代表估計密度圖的空間區域則損失函數可以用以下函數定義:

[LΘ=12Ni=1NSFXi;Θdxdy-zi2]

采用不同損失函數和不同模型訓練Shanghaitech數據集結果如表1所示。

4 結論

本文提出了一種新的卷積神經網絡模型,利用人群密度圖提供的信息和由多個不同大小的卷積核形成的多尺度神經網絡對密集人群進行預測,它可以從幾乎任何角度準確地估計單個圖像中的人群數量。此外,在源域上訓練的模型可以通過只微調訓練模型的最后幾層而容易地轉移到目標域,這證明了所提出的模型的良好的可推廣性。

但本文結果也有不足,由于時間和能力所限,沒有嘗試和其他的如Local Binary Pattern(LBP)、Ridge Regression(RR)等基于回歸的傳統方法進行比較,在數據集上,密度識別領域還有類似UCF_CC_50數據集,UCSD數據集等,并未將模型在這些數據集上進行訓練,不能直接比較模型和其他已有模型的優劣,可以在后面進行改進。

參考文獻:

[1] Chan A B,Liang Z S John,Vasconcelos N.Privacy preserving crowd monitoring:Counting people without people models or tracking[C]//2008 IEEE Conference on Computer Vision and Pattern Recognition.June 23-28,2008,Anchorage,AK,USA.IEEE,2008:1-7.

[2] Chen K,Loy C C,Gong S G,et al.Feature mining for localised crowd counting[C]//Procedings of the British Machine Vision Conference 2012.Surrey.British Machine Vision Association,2012.

[3] Marana A N,Costa L F,Lotufo R A,et al.On the efficacy of texture analysis for crowd monitoring[C]//Proceedings SIBGRAPI'98.International Symposium on Computer Graphics,Image Processing,and Vision (Cat.No.98EX237).October 20-23,1998,Rio de Janeiro,Brazil.IEEE,1998:354-361.

[4] Lempitsky V, Zisserman A. Learning to count objects in images[J].Advance in Neural Information Processing Systems, 2010:1324–1332.

[5] Zeiler M D, Ranzato M, Monga R, et al. On rectified linear units for speech processing[J].ICASSP, IEEE, 2013: 3517–3521 .

[6] Long J,Shelhamer E,Darrell T.Fully convolutional networks for semantic segmentation[C]//2015 IEEE Conference on Computer Vision and Pattern Recognition (CVPR).June 7-12,2015,Boston,MA,USA.IEEE,2015:3431-3440.

【通聯編輯:代影】

2390501705261