基于全局感知機制的地面紅外目標檢測方法

趙曉楓, 徐葉斌,*, 吳 飛, 牛家輝, 蔡 偉, 張志利

(1. 火箭軍工程大學導彈工程學院, 陜西 西安 710025;. 兵器發射理論與技術國家重點學科實驗室, 陜西 西安 710025)

0 引 言

紅外輻射是物體的固有屬性,當物體溫度高于絕對零度時,就會向外輻射熱量,因此可以對目標的紅外特征進行全天時的探測與識別。當前根據物體的紅外特征對目標進行準確且實時的檢測,已成為軍事偵察、視頻檢測、偽裝防護等領域重點關注的問題。

基于傳統方法的紅外目標檢測,主要應用在空基小目標的偵察和預警,以單幀紅外目標檢測和多幀紅外目標檢測(又稱序列紅外目標檢測)為主。近年來,深度學習的興起,產生了基于卷積神經網絡(convolutional neural networks,CNN)的目標檢測方法,這類方法通過直接構造卷積神經網絡對圖像特征進行提取、分類和目標預測,提升了檢測精度和檢測速度,降低了誤檢和漏檢率。基于CNN的目標檢測算法主要分為區域CNN(region-CNN, R-CNN)、Fast R-CNN、Faster R-CNN、Mask R-CNN、Cascade R-CNN等基于候選區域的兩階段目標檢測算法和SSD(single shot multibox detector)、RetinaNet、YOLO等基于回歸的一階段目標檢測方法。兩階段的目標檢測算法先將圖像輸入主干網絡進行特征提取,選出待檢測區域,再進行目標分類和預測框回歸對目標進行檢測。該類算法在增加網絡計算復雜度和犧牲速度的前提下,使目標檢測模型保持較好的檢測精度,但實時性較差。以YOLO為代表的一階段目標檢測算法則是通過遍歷將預測框與真實框相關聯,利用IOU(intersection over union)機制將相關度量化并使用最大值抑制機制抑制關聯度不高的預測框,采用該類目標檢測算法對目標進行檢測時,減少了候選區域提取過程,能夠滿足較多場景下實時檢測的需求,被廣泛應用。

將基于CNN的目標檢測算法應用到紅外目標的檢測中,降低誤檢和漏檢率,已經成為紅外探測領域的研究熱點。苗壯等提出了一種基于關鍵點的快速紅外目標檢測算法,通過壓縮模型尺寸,提高了對紅外小目標的檢測速度。吳雙忱等提出了基于全CNN的紅外小目標檢測算法,該算法實現了在復雜背景下對低信噪比且存在運動模糊目標的檢測。劉俊明等提出了基于全CNN和視覺顯著性的紅外小目標檢測,并引入注意力機制實現對空基復雜環境下的紅外小目標檢測。Dong等將視覺注意力機制應用到了海面紅外目標的檢測,明顯降低了虛警率。Du等通過重新設計錨框,減小噪聲的影響,針對空中目標進行檢測。梁杰等通過網絡特征層的合并和引入中心損失函數對YOLOv2算法進行改進,實現對煙幕遮擋的目標進行檢測,提高制導精度。Hu等通過融合多尺度特征和局部二進制紋理分析的方法,對入侵的紅外小目標進行檢測。Zhao等將YOLOv3與雙向特征融合的多尺度特征融合方式相結合,增強信息的重利用,實現對地面背景下的紅外目標進行檢測。

本文針對復雜地面背景下干擾因素多,目標檢測易受影響的問題,通過多尺度池化對網絡最后一層輸出特征進行池化處理,并使用跳躍連接將池化前和池化后的特征融合,增強特征的重利用,從而增加模型的全局信息感知能力,減小環境背景對目標檢測任務的干擾;以平滑標簽的方式降低單目標置信度,提出平滑焦點損失函數(soft focal loss,S-FL)。從而避免對圖像內其他目標造成忽視,產生漏檢誤檢的情況,同時優化地面復雜環境對目標檢測產生的干擾。最終構造了基于全局感知機制的Infrared-YOLO紅外目標檢測方法,提高了對地面背景下紅外目標的檢測精度,并實現了實時檢測。

1 基于全局感知機制的目標檢測模型

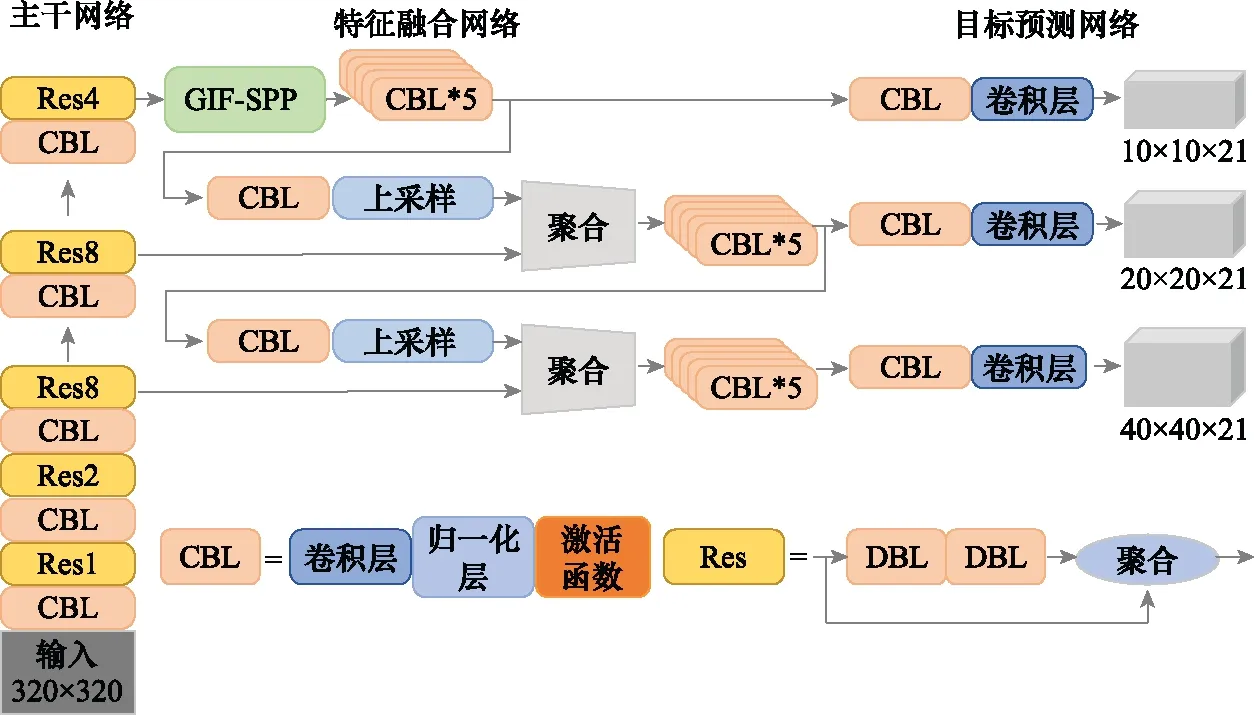

基于全局感知機制的目標檢測模型如圖1所示,包含骨干網絡、特征融合網絡和目標預測網絡3個部分。輸入圖片首先在骨干網絡中進行下采樣操作,降低特征圖大小,提取不同層次特征,并將最后一層輸出使用全局感知模塊進行全局池化。再使用特征融合網絡進行不同尺度特征的融合,實現低維空間信息和高維語義信息的互補。最后,將融合后的特征圖作為目標預測網絡的輸入,進行目標分類和邊界框的回歸,完成目標的檢測。

圖1 Infrared-YOLO網絡結構Fig.1 Network structure of Infrared-YOLO

1.1 全局信息融合的金字塔池化模塊

圖2是部分紅外圖像和可見光圖像的對比圖,從圖中可以看到,地面背景下可見光圖像比紅外圖像具有更多的細節特征和紋理特征。對于地面背景下的紅外車輛目標而言,可見光圖像下目標特征比較明顯。而紅外圖像中目標特征被背景特征淹沒的情況,也存在背景特征與目標特征相似度較高,極易混淆的情況。因此,增加了對目標進行準確分類和定位的難度,出現漏檢和誤檢等情況,導致檢測精度不高。

圖2 可見光圖像與紅外圖像對比Fig.2 Comparison of visible light image and infrared image

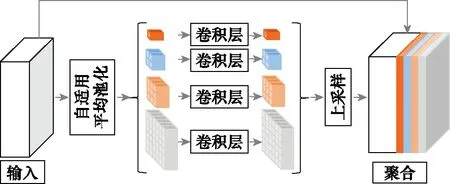

為了提高模型對圖像的整體感受域,減少背景和目標的誤判,設計了具有全局信息融合的金字塔池化模塊(spatial pyramid pooling module for global information fusion,GIF-SPP),如圖3所示。全局信息融合的金字塔池化模塊以主干網絡最后一個卷積層產生的特征圖作為輸入,考慮到最后一層特征圖經過主干網絡32倍下采樣后,為10×10大小的高維特征,特征信息較多,使用以區域最大值作為代表信息的最大池化機制會導致部分信息丟失。因此,使用以平均值作為區域代表信息,且能夠對輸入圖像進行動態池化,產生特定大小輸出的自適應平均池化操作對輸入特征進行處理,減少重要信息的丟失,同時提升模型訓練的穩定性。

圖3 全局信息融合的金字塔池化模塊Fig.3 Pyramid pooling module for global information fusion

將輸入特征圖劃分為1×1、2×2、4×4、6×6共4個子區域進行平均池化。其中1×1子區域為第一層,在整個特征圖上執行最粗略層次的池化操作,生成一個池化后的特征。藍色為第二層,將特征圖分割成2×2的子區域進行平均池化。其余層依次類推,將特征映射分割到不同的子區域并形成不同尺度的池化表示,灰色為最后一層,將特征圖劃分為6×6的子區域,執行最細層次的平均池化。經過不同尺度的池化,不同級別的輸出形成多種尺度的特征映射。對不同層次池化特征,使用1×1的卷積進行通道和維度調整,再經過上采樣以雙線性差值的方式將尺度調整到原始特征圖大小。再使原始特征與池化后的特征通過跳躍連接的方式完成特征融合,最終形成了具有原始特征信息和池化后信息的融合輸出,使模型具有更強的全局感知能力。

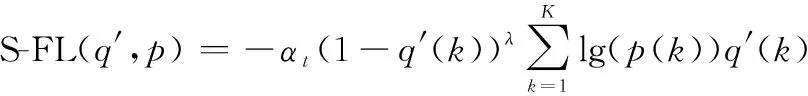

1.2 S-FL

交叉熵是香農信息論中的重要概念,主要用于度量兩個概率分布間的差異性信息,在神經網絡中將其作為損失函數結合反向傳播對模型進行優化。交叉熵損失函數會將所有樣本的損失都進行求和計算,這樣會帶來兩個問題:一是簡單易分類樣本的損失很低,但大量損失計算累加到一起,對小樣本產生抑制作用,無法提取有效特征;二是在計算過程中,會激勵概率較大的類,結合反向傳播,使得模型對大樣本過度自信,對小樣本關注不足,導致泛化能力變差,降低模型的自適應能力。針對傳統交叉熵損失函數存在的問題,焦點損失函數通過增加聚焦參數,對大樣本的損失積累進行抑制,關注小樣本目標,促使模型擁有更好的平衡能力。

針對紅外圖像的車輛目標檢測任務中,存在背景特征與車輛特征相似度較高,以及紅外圖像中車輛目標被路面特征淹沒,而導致誤檢、漏檢和檢測置信度不高的問題。本文將類別標記轉換成獨熱向量形式,并將獨熱向量中置信度為1的項衰減,生成平滑標簽。平滑后待檢測目標的置信度降低,其他相鄰目標獲得更多被檢測機會。獨熱向量的標簽平滑定義如下:

′()=(1-),+()

(1)

式中:為衰減因子;為類別數;()為一個概率分布,此處采用均勻分布。,定義為

(2)

最終,得到本文提出的S-FL,定義如下:

(3)

式中:

(4)

()為類別概率;′()為經平滑后的指定類別;為聚焦參數,可以平滑地調整簡單樣本的權重;=20,=025,=2,=01。

2 實驗結果與分析

2.1 紅外數據集的構建

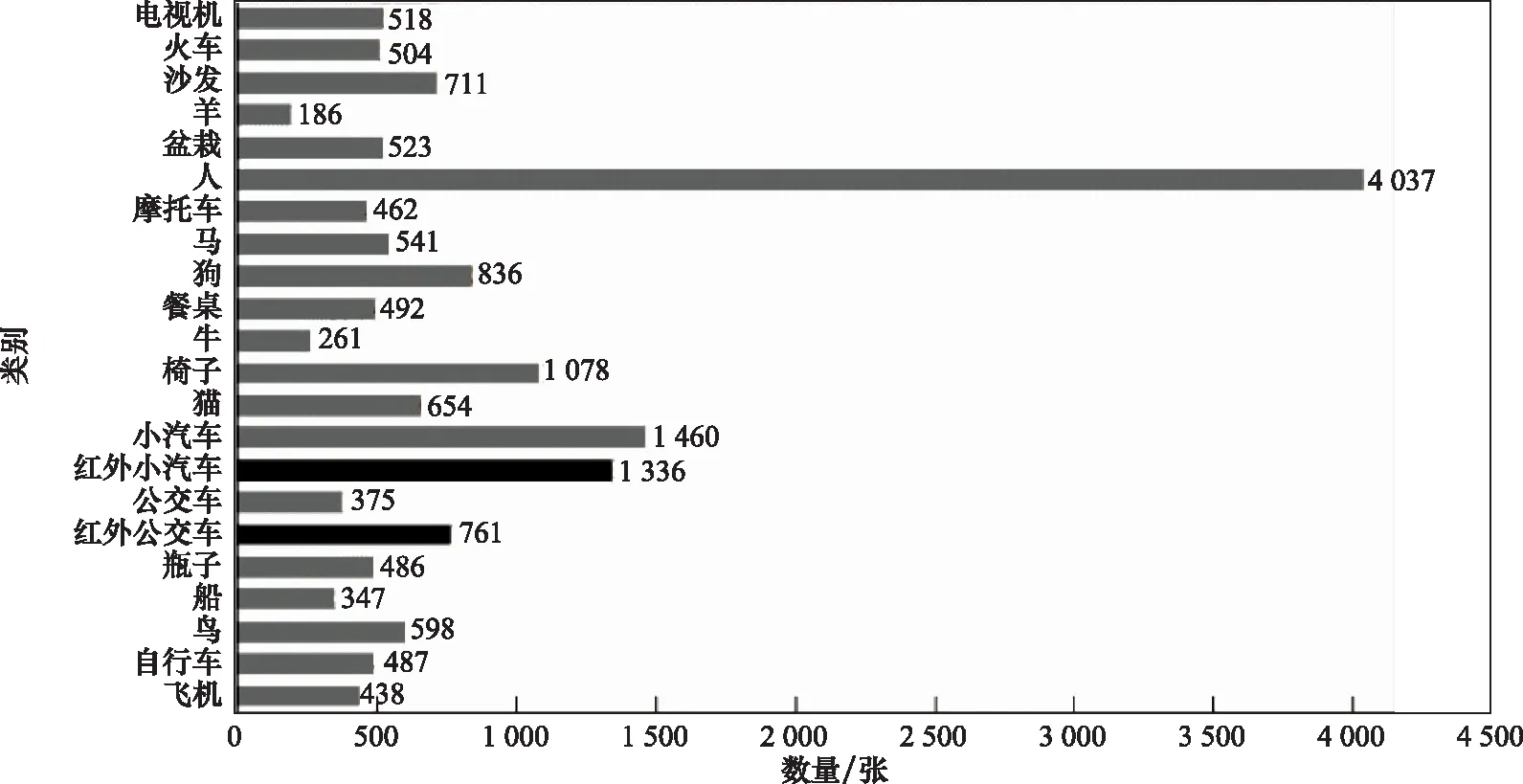

當前,紅外圖像的公開數據集較難獲得,為了對提出的基于全局感知機制的紅外目標檢測模型進行訓練和評估。本課題組使用光譜范圍為75~14 μm的紅外成像儀在不同時段、不同背景、不同氣候條件下拍攝公交車和小汽車的紅外圖像。通過圖像增強制成大小為320×320的待標注圖像集,使用Labeling完成圖像的標注,生成含有車輛位置和真實框寬高信息的xml文件,最終制成包含公交車圖像761張、小汽車圖像1 336 張的Infrared-VOC320紅外數據集,并將訓練集、驗證集、測試集按7∶1∶2劃分。

為了驗證紅外數據集的科學性和合理性,與公開的標準可見光數據集PASCAL VOC2007中各類樣本數量進行對比。如圖4所示,其中黑色為Infrared-VOC320數據集中目標類別和數量,灰色為PASCAL VOC2007數據集中目標類別和數量。從圖4中可以看出,Infrared-VOC320數據集中小汽車和公交車的數量分別為1 336 張和761張,而PASCAL VOC2007數據集中數量少于761張圖像的有16類,表明Infrared-VOC320數據集中小汽車和公交車的數量可以用來進行目標檢測模型的訓練和評估。

圖4 數據集數量關系對比圖Fig.4 Comparison of data set quantity relationship

2.2 評價指標與訓練參數

為了評估本文改進算法的性能,從準確率、檢測速度、平均檢測精度(average precision, AP)和AP均值(mean AP, mAP)出發,對本文改進的算法和幾種主流算法進行對比。同時引入空間復雜度、模型參數進行消融實驗,探究各模塊對改進模型的作用。

基于Infrared-VOC320數據集對Infrared-YOLO模型進行訓練時,初始學習率為0.01,在迭代至第30次、第60次和第90次時分別縮小10倍,Batch size設為48,共迭代100次,完成模型的訓練。文中實驗平臺使用系統為Linux18.04,CPU為Inter Core i9-9900K CPU @3.60 GHz,GPU為Nvidia P6000,24 GB,在pytorch1.7.1框架下采用CUDA11.0和cudnn8.0.4.30進行加速訓練。

2.3 基于Infrared-VOC320數據集的對比實驗

基于Infrared-VOC320數據集的不同目標檢測算法實驗結果如表1所示,Infrared-YOLO目標檢測算法針對紅外目標檢測的mAP達到80.1個百分點,在一階段目標檢測算法中,比YOLOv3高出4.4個百分點,比SSD300高出9.7個百分點。通常一個具有實時性的模型,需要達到每秒30 FPS以上,本文檢測模型檢測速度達到56.4 FPS,能夠滿足實時檢測的需求。同時比二階段目標檢測網絡Faster R-CNN高出4.5個百分點,檢測速度是其8倍。上述實驗證明Infrared-YOLO保持實時檢測速度的同時提升了針對地面紅外目標檢測的平均精度。

表1 基于Infrared-VOC320數據集的不同目標檢測算法實驗結果

2.4 基于Infrared-VOC數據集的消融實驗

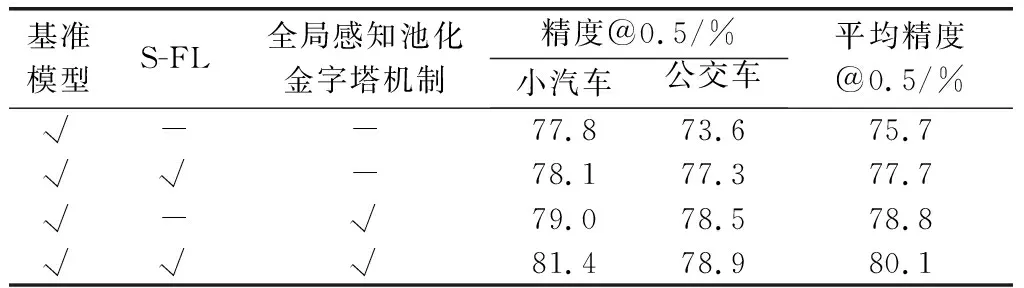

為了理解Infrared-YOLO中各改進模塊對檢測效果的影響,表2是逐步增加相關改進模塊的消融實驗,圖5是訓練過程損失函數曲線圖。從表2中可以看到,YOLOv3目標檢測模型的mAP為75.7個百分點,AP差值為4.2個百分點,基準模型結合平滑焦點損失后,mAP提升至77.7個百分點,AP間差值縮小至0.8個百分點,表明本文設計的平滑焦點函數具有關注難分樣本的能力,并且提升了對目標的平均檢測精度。基準模型結合GIF-SPP模塊后,mAP提升了3.1個百分點,類間差值減小到0.5個百分點,驗證了全局信息融合的金字塔池化模塊通過不同尺度的池化,增大了模型的感受野,提高了尺度不變性,并且能夠與原始特征進行特征信息的互相補充,有利于檢測網絡對全局信息的感知,提升了檢測精度,此外全局感知模塊還能夠緩解樣本的不平衡。最終Infrared-YOLO的mAP達到80.1個百分點,結合圖5和表2可以看出,通過損失函數和特征表征兩個方面的優化,能夠提升模型的檢測精度和數據集平衡能力,加速模型收斂。

圖5 損失函數曲線對比Fig.5 Comparison of loss function curve

表2 基于Infrared-VOC320的消融實驗

為了更進一步比較全局信息融合的空間金字塔池化模塊與SPP模塊對于模型檢測精度提升的程度,進行關于這兩種模塊的消融實驗。使用原始YOLOv3為基準模型,在相同位置使用不同的池化模塊進行對比實驗,對比實驗結果如表3所示。通過表3中的數據可以發現,SPP模塊通過5×5、9×9、13×13這3個尺度對最后一層的特征輸出執行最大池化操作,增大了模型的感受野,與YOLOv3模型相比,mAP提升了0.8%,空間復雜度比基準模型提高了0.8,參數量幾乎保持不變;使用全局信息融合金字塔池化模塊的Infrared-YOLO目標檢測模型,mAP比基準模型提升了3.1個百分點,參數量減少了20.4個百分點,空間復雜度增加了17.3個百分點。通過對比發現,本文中所使用的全局信息融合的金字塔池化模塊雖然增加了空間復雜度,需要更多的顯存對模型進行訓練,但GIF-SPP使用較小的池化子區域和全卷積對池化特征進行連接,減少了模型的參數量,有利于模型后期的遷移和部署。

表3 SPP與GIF-SPP的對比實驗

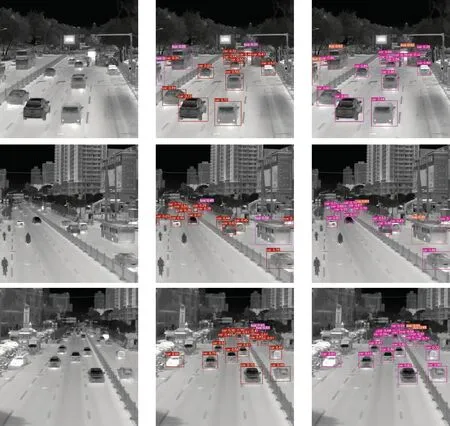

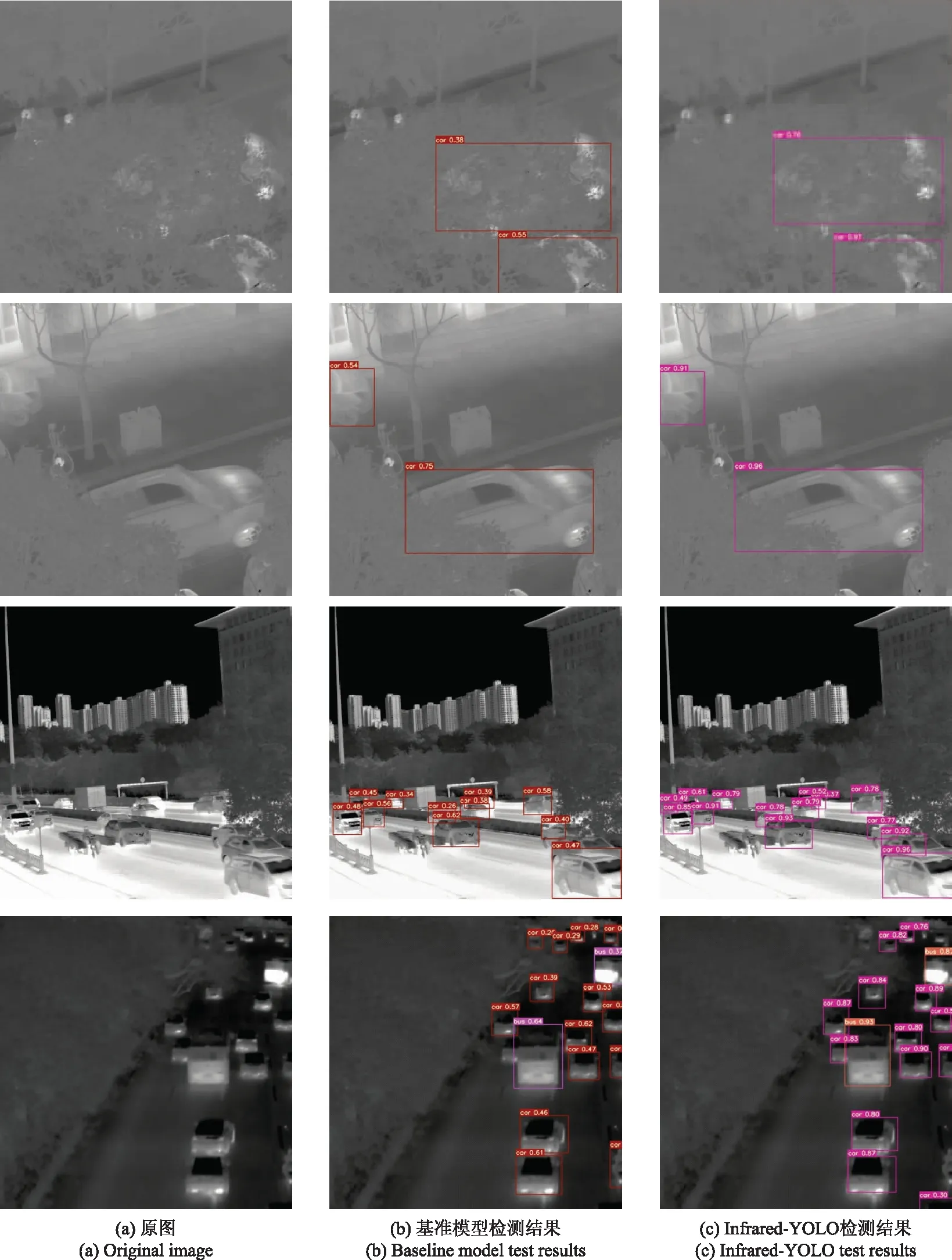

圖6是Infrared-YOLO和YOLOv3在Infrared-VOC測試集中對目標的檢測結果。在第1、2、3行中,單張圖片內具有多個目標的情況,改進后檢測模型的置信度明顯高于原始的YOLOv3算法;對于第4、5行圖片中,背景對目標干擾較嚴重場景下,改進后的目標檢測模型依舊能夠對目標進行較好的檢測;對于第6、7行圖片中遠處相對較小的目標,原始YOLOv3算法存在因目標的相互遮擋產生漏檢和將樹蔭當作目標造成誤檢的情況。檢測結果對比表明,改進后的Infrared-YOLO目標檢測模型能夠有效提升紅外目標檢測的測置信度,優化了地面紅外目標受背景干擾導致的誤檢和漏檢問題。

圖6 Infrared-VOC320測試集上對目標的檢測結果對比Fig.6 Detection results comparison of targets on the Infrared-VOC320 dataset

3 結 論

本文提出的基于全局感知機制的紅外目標檢測模型通過全局信息融合的空間金字塔池化模塊,增強網絡對所提取特征的全局聯系,再結合S-FL降低單一目標置信度,有效優化了地面背景下紅外車輛目標檢測準確率不高、易漏檢誤檢的問題。在Infrared-VOC320數據集上平均檢測精度達到80.1%,與當前主流的幾種目標檢測模型相比表現出較好的檢測性能。基于全局感知機制的目標檢測模型對地面紅外目標的檢測具有較高檢測精度的同時實現了實時的檢測性能,對軍事偵察、偽裝防護等地面復雜背景下的紅外目標檢測研究有著較好的借鑒意義。