基于多傳感器融合的無(wú)人機(jī)可降落區(qū)域識(shí)別方法研究

劉飛 單佳瑤 熊彬宇 方正 楊正權(quán)

摘要:當(dāng)無(wú)人機(jī)遇到電量低、丟失遙控信號(hào)、失去GPS信號(hào)、天氣突變等需要迅速降落的緊急情況時(shí),依靠機(jī)載的傳感器實(shí)現(xiàn)無(wú)人機(jī)自主降落到安全區(qū)域顯得非常重要。為保證無(wú)人機(jī)在遇到緊急情況或者收到降落指令后,能夠自動(dòng)識(shí)別安全的降落區(qū)域,實(shí)現(xiàn)安全自主降落,本文提出一種基于多傳感器融合和深度學(xué)習(xí)網(wǎng)絡(luò)框架的無(wú)人機(jī)可降落區(qū)域識(shí)別方法。首先,使用基于無(wú)人機(jī)機(jī)載圖像信息搜索安全降落區(qū)域;然后利用孿生網(wǎng)絡(luò)對(duì)安全降落區(qū)域進(jìn)行跟蹤。當(dāng)無(wú)人機(jī)降落到一定高度時(shí),利用機(jī)載激光雷達(dá)進(jìn)行近地面環(huán)境實(shí)時(shí)建模與語(yǔ)義分割,確定安全的可降落區(qū)域;最后,通過(guò)實(shí)時(shí)建立的可降落區(qū)域點(diǎn)云模型,計(jì)算出精確的可降落區(qū)域位姿信息,供飛控系統(tǒng)實(shí)時(shí)著陸控制使用。在仿真環(huán)境和實(shí)際環(huán)境中的試驗(yàn)研究表明,基于多傳感器融合的方法對(duì)可降落區(qū)域的識(shí)別準(zhǔn)確率達(dá)到90%,位置識(shí)別的誤差為5cm,著陸過(guò)程地形高程估計(jì)誤差為2cm,能夠滿足無(wú)人機(jī)自主安全著陸的要求。通過(guò)對(duì)可降落區(qū)域識(shí)別方法的研究,實(shí)現(xiàn)無(wú)人機(jī)對(duì)下方可降落區(qū)域的識(shí)別,進(jìn)而引導(dǎo)無(wú)人機(jī)實(shí)現(xiàn)安全自主著陸。

關(guān)鍵詞:自主泊降;深度學(xué)習(xí);多傳感器融合;三維激光雷達(dá);語(yǔ)義分割

中圖分類號(hào):TP391.4文獻(xiàn)標(biāo)識(shí)碼:ADOI:10.19452/j.issn1007-5453.2022.04.004

基金項(xiàng)目:航空科學(xué)基金(20184123011,201941050001)

無(wú)人機(jī)的自主降落問(wèn)題是其安全飛行最重要的問(wèn)題之一,而無(wú)人機(jī)對(duì)可降落區(qū)域的精確識(shí)別是解決這一問(wèn)題的關(guān)鍵。在過(guò)去的十幾年里,有大量研究者[1-2]開(kāi)展了該領(lǐng)域的研究。按照使用傳感器的區(qū)別,這些研究可以分為三類:基于單目相機(jī)的著陸區(qū)域識(shí)別、基于雙目相機(jī)的著陸區(qū)域識(shí)別和基于三維激光雷達(dá)的著陸區(qū)域識(shí)別。

基于單目相機(jī)的著陸區(qū)域識(shí)別方法總體上可以分為兩種思路。一種是C. S. Sharp[3]、S. Bosch[4]和Y. Cheng[5]等通過(guò)無(wú)人機(jī)搭載的相機(jī)傳感器拍攝得到無(wú)人機(jī)所在位置下方地面環(huán)境的單幀圖像信息,然后利用自身搭載的處理器根據(jù)單幀圖像序列確定該地位置是否可用于著陸,實(shí)現(xiàn)可降落區(qū)域的識(shí)別;另一種是A. Johnson[6]、V. R. Desaraju[7]和C. Forster[8]等利用運(yùn)動(dòng)的單目相機(jī)得到的圖像數(shù)據(jù)通過(guò)動(dòng)態(tài)立體視覺(jué)算法建立密集的三維環(huán)境地形點(diǎn)云地圖,然后計(jì)算著陸區(qū)域,實(shí)現(xiàn)可降落區(qū)域的識(shí)別。 C. Theodore[9]、M. Meingast[10]、M. Garg[11]和M. Mittal[12]等利用基于雙目相機(jī)的著陸區(qū)域識(shí)別往往可以直接通過(guò)雙目相機(jī)的外參數(shù)據(jù)和雙目圖像的差別估計(jì)地面圖像的深度信息,然后根據(jù)深度信息判斷著陸區(qū)域,最終實(shí)現(xiàn)無(wú)人機(jī)可降落區(qū)域的識(shí)別。S. Scherer[13]和D. Maturana[14]等利用基于激光雷達(dá)的著陸區(qū)域識(shí)別方法往往首先利用激光雷達(dá)建立較稠密的三維點(diǎn)云地圖,然后再?gòu)娜S點(diǎn)云地圖中識(shí)別著陸區(qū)域,最終實(shí)現(xiàn)無(wú)人機(jī)可降落區(qū)域的識(shí)別。

近年來(lái),隨著無(wú)人機(jī)技術(shù)與產(chǎn)業(yè)在國(guó)內(nèi)的發(fā)展,國(guó)內(nèi)對(duì)于無(wú)人機(jī)著陸區(qū)域識(shí)別的研究也越來(lái)越多。南京航空航天大學(xué)韓家明等[15]提出了一種基于視覺(jué)的無(wú)人機(jī)著陸標(biāo)識(shí)的檢測(cè)方法;復(fù)旦大學(xué)李睿康等[16]提出了一種針對(duì)旋翼無(wú)人機(jī)在無(wú)準(zhǔn)備的崎嶇地表上的自主安全著陸系統(tǒng)。西北工業(yè)大學(xué)李靖等[17]提出了一種基于視覺(jué)的無(wú)人機(jī)著陸地標(biāo)實(shí)時(shí)檢測(cè)跟蹤方法。

由上文可知,針對(duì)無(wú)人機(jī)可降落區(qū)域識(shí)別的研究往往只通過(guò)單一的傳感器來(lái)完成,這些方法雖然在某些特定的場(chǎng)景下有不錯(cuò)的表現(xiàn),但在一些更復(fù)雜的場(chǎng)景或光照較差的情況下很難準(zhǔn)確且穩(wěn)定地完成可降落區(qū)域的識(shí)別。因此,本文提出一種基于多傳感器融合的無(wú)人機(jī)可降落區(qū)域識(shí)別方法,充分利用相機(jī)所拍攝圖像的色彩信息和激光雷達(dá)的深度信息,通過(guò)無(wú)人機(jī)搭載的處理器實(shí)現(xiàn)對(duì)其下方可降落區(qū)域的識(shí)別與跟蹤,引導(dǎo)無(wú)人機(jī)實(shí)現(xiàn)安全自主著陸。

1系統(tǒng)架構(gòu)

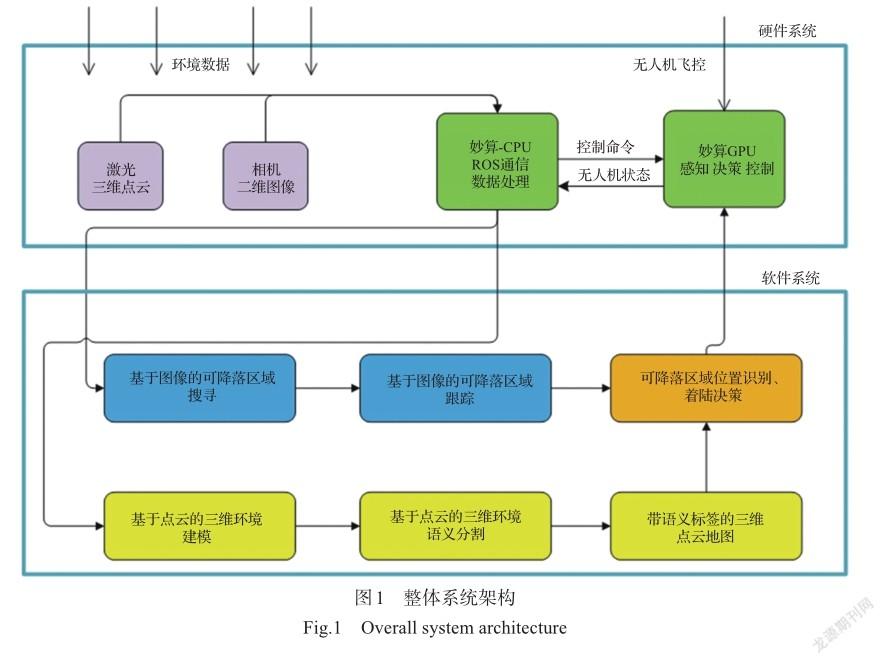

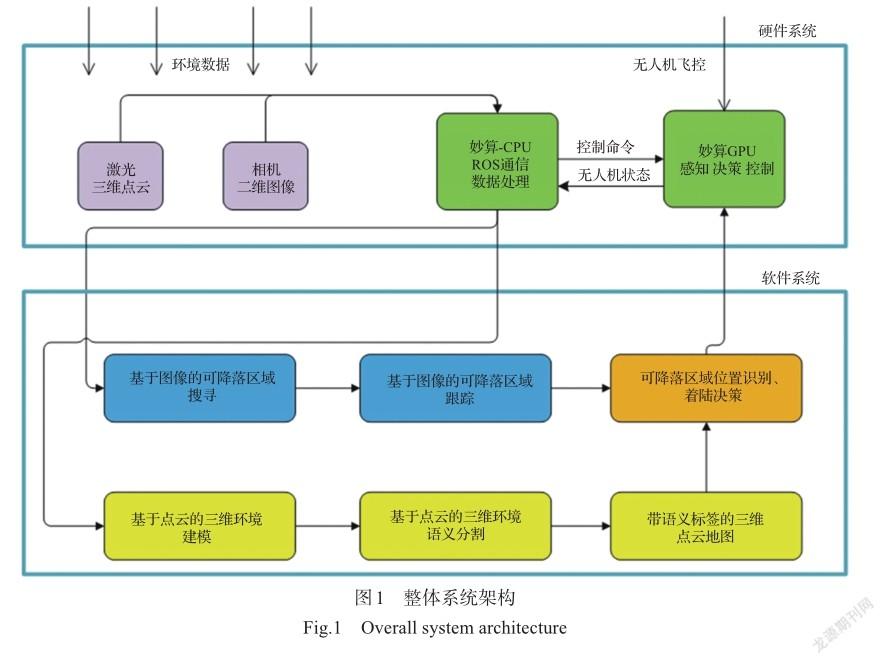

無(wú)人機(jī)想要實(shí)現(xiàn)自主降落,必須具有自主的環(huán)境感知能力,從而能夠?qū)崿F(xiàn)在復(fù)雜環(huán)境中的地形識(shí)別與建模,自主選擇適合著陸面,在降落過(guò)程中自主避開(kāi)障礙物并實(shí)現(xiàn)特定著落面的精準(zhǔn)降落。針對(duì)這一問(wèn)題,本文提出一種基于三維激光和視覺(jué)融合的無(wú)人機(jī)自主著陸地形識(shí)別及著陸點(diǎn)識(shí)別的方法,使得無(wú)人機(jī)能夠在遇到緊急情況下或者收到降落指令后,利用基于多傳感器實(shí)現(xiàn)低空多維信息建模和基于深度學(xué)習(xí)實(shí)現(xiàn)語(yǔ)義層次地形信息分類,自主識(shí)別安全的停機(jī)區(qū)域,實(shí)現(xiàn)安全自主降落。整體系統(tǒng)架構(gòu)如圖1所示,圖中軟件系統(tǒng)中的藍(lán)色部分代表可降落區(qū)域識(shí)別與跟蹤模塊,黃色部分代表低空三維環(huán)境的建模模塊,橘黃色部分代表著陸決策模塊。

1.1系統(tǒng)硬件

該系統(tǒng)主要由DJI Matrix600 Pro無(wú)人機(jī)平臺(tái)、Manifold2-C和Manifold2-G機(jī)載處理器、RoboSense Bpearl三維激光雷達(dá)、RealSense D435i和RealSense T265相機(jī)等傳感器組成。

DJI Matrix600 Pro無(wú)人機(jī)平臺(tái)具備很高的擴(kuò)展性,可以部署各類外加機(jī)載處理器和傳感器,其標(biāo)配有高精度GPS、LightBridge2視頻傳輸模塊。該系統(tǒng)在這些硬件的基礎(chǔ)上面添加了Robosense Bpearl三維激光雷達(dá)作為地形數(shù)據(jù)庫(kù)的獲取模塊,RealSense D435i相機(jī)作為可降落區(qū)域的識(shí)別模塊,RealSense T265相機(jī)作為無(wú)人機(jī)姿態(tài)估計(jì)的輔助模塊,Manifold2-C作為無(wú)人機(jī)上面的運(yùn)算系統(tǒng)和飛控系統(tǒng)的中間處理單元模塊,主要處理三維激光雷達(dá)點(diǎn)云數(shù)據(jù)和無(wú)人機(jī)飛行控制數(shù)據(jù),Manifold2-G作為無(wú)人機(jī)上面可降落區(qū)域的識(shí)別和跟蹤的處理單元。

1.2系統(tǒng)軟件

系統(tǒng)軟件方法主要由基于圖像的可降落區(qū)域搜索與跟蹤、基于點(diǎn)云的三維環(huán)境建模、基于點(diǎn)云的三維環(huán)境語(yǔ)義分割、實(shí)時(shí)落點(diǎn)搜索。各個(gè)模塊實(shí)現(xiàn)的細(xì)節(jié)詳見(jiàn)第2節(jié)。

2系統(tǒng)實(shí)現(xiàn)

2.1基于圖像的可降落區(qū)域搜索

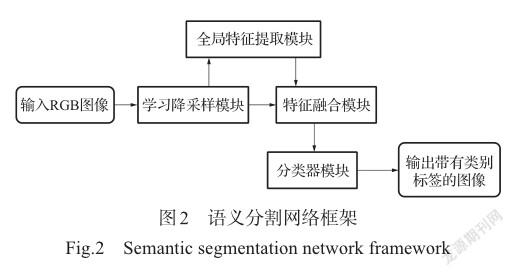

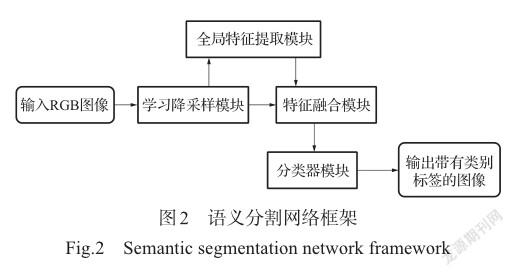

圖像語(yǔ)義分割能夠?qū)⑾鄼C(jī)傳感器拍攝圖片或者視頻流的每一個(gè)像素點(diǎn)都打上對(duì)應(yīng)的類別標(biāo)簽,這樣就可以知道圖片或者視頻流中可降落區(qū)域的位置,為下一步對(duì)可降落目標(biāo)區(qū)域的跟蹤提供一個(gè)初步的識(shí)別。由于本文提出的方法需要在移動(dòng)計(jì)算平臺(tái)上對(duì)輸入的圖像進(jìn)行實(shí)時(shí)處理,因此首先需要考慮語(yǔ)義分割網(wǎng)絡(luò)的實(shí)時(shí)性。在本文中,我們基于快速圖像語(yǔ)義分割方法fast_scnn[18]搭建了適合本系統(tǒng)快速語(yǔ)義分割方法,并設(shè)計(jì)了其網(wǎng)絡(luò)框架,該網(wǎng)絡(luò)由4個(gè)模塊組成,其結(jié)構(gòu)模型如圖2所示。

第一個(gè)模塊為學(xué)習(xí)降采樣模塊,其目的是提取圖像低層次的特征。第二個(gè)模塊為全局特征提取模塊,其目的在于捕獲圖像分割所需的全局環(huán)境信息。第三個(gè)模塊是特征融合模塊,其目的是將學(xué)習(xí)降采樣模塊得到的特征和全局提取到的特征直接相加。第四個(gè)模塊是分類器模塊,其目的是將得到的特征張量輸出具有標(biāo)簽的圖片。通過(guò)這4個(gè)模塊就可以將輸入的圖片標(biāo)注上對(duì)應(yīng)的類別標(biāo)簽,最終得到無(wú)人機(jī)的可降落區(qū)域,為后續(xù)引導(dǎo)無(wú)人機(jī)自主降落創(chuàng)造基礎(chǔ)條件。

為了實(shí)現(xiàn)對(duì)無(wú)人機(jī)下方可降落區(qū)域的識(shí)別,基于圖像的語(yǔ)義分割方法在航空語(yǔ)義數(shù)據(jù)集Aeroscapes進(jìn)行模型的訓(xùn)練,訓(xùn)練之后的模型識(shí)別精度可以達(dá)到80.6%,速度在dji Manifold2-G上面可以達(dá)到10FPS,滿足無(wú)人機(jī)對(duì)下方可降落區(qū)域識(shí)別的要求。

2.2基于圖像的可降落區(qū)域跟蹤

基于圖像的可降落區(qū)域跟蹤,主要任務(wù)是將上一步通過(guò)可降落區(qū)域搜尋算法得到的可降落區(qū)域,作為初始的跟蹤目標(biāo),進(jìn)而在后續(xù)的連續(xù)的圖像幀中,通過(guò)找到圖像中與初始區(qū)域的相似度最大的區(qū)域,作為后續(xù)幀中的可降落區(qū)域。

在本文中,可降落區(qū)域搜尋算法的輸出作為可降落區(qū)域跟蹤算法的輸入,用4個(gè)坐標(biāo)(x,y,w,h)來(lái)表示一個(gè)矩形框。其中,x, y表示矩形框的中心點(diǎn)像素坐標(biāo);w,h表示的是矩形框的寬和長(zhǎng)。該矩形框中包含的即是要跟蹤降落的區(qū)域。此部分算法輸出是無(wú)人機(jī)飛行控制量,表現(xiàn)形式是通過(guò)坐標(biāo)差(目標(biāo)像素坐標(biāo)-實(shí)際像素坐標(biāo))進(jìn)行映射得到的無(wú)人機(jī)飛行的目標(biāo)控制量。

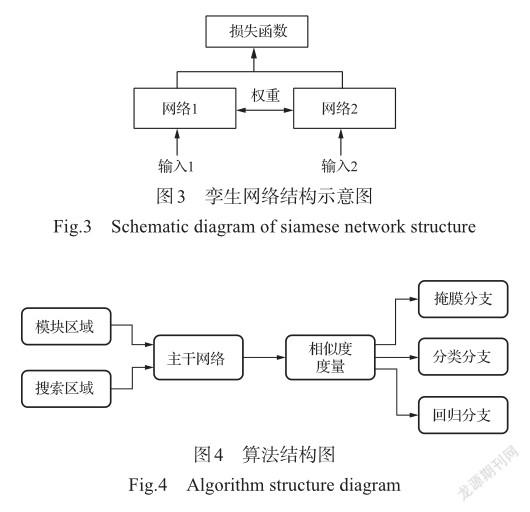

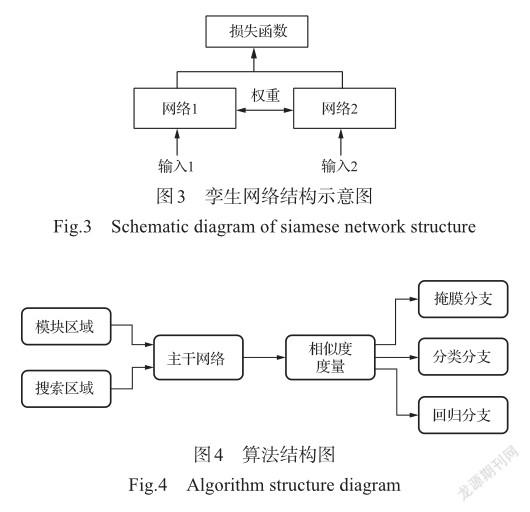

考慮到機(jī)載端搭載的處理器性能以及整個(gè)識(shí)別算法對(duì)深度學(xué)習(xí)算力的需求,跟蹤部分的算法應(yīng)該盡可能地輕量化,所以為了能夠在保證實(shí)時(shí)性的同時(shí)擁有較高的準(zhǔn)確性,本文基于siammask[19]網(wǎng)絡(luò)結(jié)構(gòu)搭建了適合本系統(tǒng)的孿生網(wǎng)絡(luò)結(jié)構(gòu)進(jìn)行圖像目標(biāo)跟蹤,基于圖像的可降落區(qū)域跟蹤算法使用孿生網(wǎng)絡(luò)(Siamese Network)作為整體網(wǎng)絡(luò)的基本架構(gòu)。孿生網(wǎng)絡(luò)也可以叫作“連體的神經(jīng)網(wǎng)絡(luò)”,其網(wǎng)絡(luò)結(jié)構(gòu)由兩個(gè)相同的分支組成,如圖3所示。兩分支分別接受不同的輸入,而后經(jīng)過(guò)相同的特征提取網(wǎng)絡(luò),從而提取高維的圖像特征。在提取特征時(shí),兩分支的網(wǎng)絡(luò)是共享權(quán)值的。然后,兩分支得到的高維特征可以通過(guò)與真值數(shù)據(jù)構(gòu)建損失(loss),可以損失最小化的方式來(lái)訓(xùn)練網(wǎng)絡(luò),使得網(wǎng)絡(luò)可以學(xué)習(xí)兩個(gè)分支最相似的特征。整體的算法結(jié)構(gòu)如圖4所示。

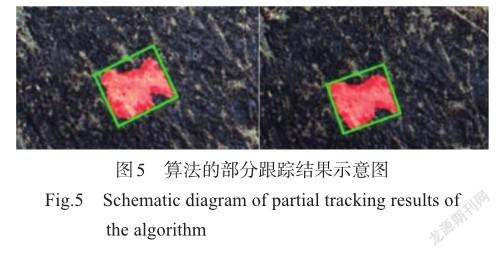

該算法在1660Ti的GPU上運(yùn)行可以達(dá)到50ft/s(≈15.24nm/s)左右,實(shí)時(shí)性足以滿足需求。除此之外,該算法還對(duì)跟蹤的目標(biāo)區(qū)域進(jìn)行了前景和背景的分割,最終的輸出結(jié)果通過(guò)掩膜(mask)的形式呈現(xiàn),矩形框通過(guò)掩膜進(jìn)行旋轉(zhuǎn)矩形擬合得到,對(duì)于項(xiàng)目中存在的可降落區(qū)域幾何形狀可能不規(guī)則的情況有較好的表現(xiàn)。圖5是該算法在俯視地形數(shù)據(jù)集上的部分輸出結(jié)果,其中紅色區(qū)域是要跟蹤的平面區(qū)域,可以看到該算法可以很好地得到不規(guī)則區(qū)域的外包矩形框,精準(zhǔn)程度大大提高。

由于目標(biāo)跟蹤算法更傾向于對(duì)兩幀之間的目標(biāo)進(jìn)行相似度的匹配,所以其模型訓(xùn)練好后具有很強(qiáng)的泛化能力,所以通用的目標(biāo)跟蹤數(shù)據(jù)集就可以滿足無(wú)人機(jī)對(duì)可降落區(qū)域跟蹤的需求。本文提出的目標(biāo)跟蹤算法在VOT2016數(shù)據(jù)集和VOT2018數(shù)據(jù)集上的結(jié)果見(jiàn)表1。其中,平均重疊期望(EAO)指對(duì)每個(gè)跟蹤器在一個(gè)短時(shí)圖像序列上的非重置重疊的期望值,是VOT評(píng)估跟蹤算法精度的最重要指標(biāo)。準(zhǔn)確率(Accuracy)指跟蹤器在單個(gè)測(cè)試序列下的平均重疊率(兩矩形框相交部分面積除以兩矩形相并部分面積)。魯棒性(robustness)指單個(gè)測(cè)試序列下的跟蹤器失敗次數(shù),當(dāng)重復(fù)率為0時(shí)即可判定為失敗。算法的運(yùn)行速率為56FPS。

2.3基于點(diǎn)云的三維環(huán)境建模

對(duì)于無(wú)人機(jī)系統(tǒng)來(lái)說(shuō),對(duì)所處周圍環(huán)境進(jìn)行感知和建模至關(guān)重要,沒(méi)有周圍環(huán)境的信息,就無(wú)法進(jìn)行后續(xù)的智能決策。在本文中,需要實(shí)現(xiàn)無(wú)人機(jī)的自主著陸,這首先就需要無(wú)人機(jī)系統(tǒng)對(duì)飛行中的周圍環(huán)境進(jìn)行感知,給予無(wú)人機(jī)相關(guān)環(huán)境物理信息,使得無(wú)人機(jī)對(duì)環(huán)境進(jìn)行判斷,找到可降落區(qū)域,完成自主降落。由于無(wú)人機(jī)需要準(zhǔn)確的空間信息,需要建立精確的三維地圖,因此我們采用激光雷達(dá)作為主要傳感器,建立環(huán)境的三維激光點(diǎn)云地圖,使得無(wú)人機(jī)獲得準(zhǔn)確的周圍環(huán)境信息,從而執(zhí)行后續(xù)任務(wù)。

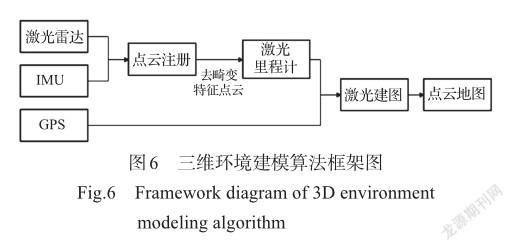

在本文的激光建圖算法中,基于LOAM[20]使用激光雷達(dá)獲取環(huán)境信息,并且結(jié)合慣性測(cè)量組件(IMU)進(jìn)行測(cè)量,以提高自身運(yùn)動(dòng)估計(jì)的精度,從而建立精確的環(huán)境地圖。首先,對(duì)激光點(diǎn)云數(shù)據(jù)進(jìn)行處理,結(jié)合IMU數(shù)據(jù)消除點(diǎn)云存在的運(yùn)動(dòng)畸變,并且提取點(diǎn)云中的特征點(diǎn)集,得到環(huán)境的主要特征描述。而后,基于特征點(diǎn)云估計(jì)無(wú)人機(jī)的運(yùn)動(dòng)姿態(tài),得到運(yùn)動(dòng)里程計(jì)。考慮到無(wú)人機(jī)著陸環(huán)境為室外空曠區(qū)域,周圍環(huán)境中可能缺乏足夠的環(huán)境特征,使得僅使用激光雷達(dá)進(jìn)行運(yùn)動(dòng)估計(jì)會(huì)存在失敗的情況。為此,算法中考慮結(jié)合GPS數(shù)據(jù)提供無(wú)人機(jī)運(yùn)動(dòng)的空間位置信息,給無(wú)人機(jī)運(yùn)動(dòng)姿態(tài)的估計(jì)增加位置約束,從而增強(qiáng)無(wú)人機(jī)運(yùn)動(dòng)估計(jì)的魯棒性,提高運(yùn)動(dòng)估計(jì)的精度。最后,對(duì)無(wú)人機(jī)位姿進(jìn)行點(diǎn)云拼接,同時(shí)將激光點(diǎn)云和地圖點(diǎn)云進(jìn)行匹配,優(yōu)化無(wú)人機(jī)的狀態(tài)估計(jì),建立一致的點(diǎn)云地圖。三維環(huán)境建模算法框架如圖6所示。

2.4基于點(diǎn)云的三維環(huán)境分割

基于二維圖像的語(yǔ)義分割的方法往往難以準(zhǔn)確地估計(jì)出被識(shí)別對(duì)象的三維空間位置。對(duì)于無(wú)人機(jī)來(lái)說(shuō),若想更穩(wěn)定、更安全地完成降落任務(wù),就需要獲取周圍環(huán)境的三維信息,實(shí)時(shí)準(zhǔn)確地理解周圍場(chǎng)景的三維語(yǔ)義信息。因此,需要實(shí)現(xiàn)三維點(diǎn)云的語(yǔ)義分割,本文通過(guò)傳感器標(biāo)定得到的相機(jī)與激光雷達(dá)之間的變換矩陣將激光雷達(dá)的點(diǎn)云數(shù)據(jù)投影到相機(jī)坐標(biāo)系中,再通過(guò)相機(jī)的內(nèi)參坐標(biāo)系投影到相機(jī)的圖像坐標(biāo)系中。由于我們已經(jīng)獲得了帶逐像素語(yǔ)義類別標(biāo)簽相機(jī)圖像,此時(shí)通過(guò)最近鄰搜索法搜索投影到相機(jī)圖像坐標(biāo)系的點(diǎn)云中每個(gè)點(diǎn)最近的圖像像素,圖像像素對(duì)應(yīng)的語(yǔ)義類別標(biāo)簽就是該點(diǎn)的語(yǔ)義標(biāo)簽。最后,將點(diǎn)云轉(zhuǎn)化回激光雷達(dá)坐標(biāo)系就得到了帶語(yǔ)義標(biāo)簽的點(diǎn)云數(shù)據(jù)。

2.5實(shí)時(shí)落點(diǎn)搜索

通過(guò)對(duì)點(diǎn)云的語(yǔ)義標(biāo)簽進(jìn)行篩選,可以得到候選的降落區(qū)域,但考慮到語(yǔ)義特征提取的魯棒性等因素,該候選降落區(qū)域中并非所有區(qū)域都可以作為無(wú)人機(jī)的可降落區(qū)域。為了確保算法選擇著陸區(qū)域的正確性與穩(wěn)定性,本文提出的方法在語(yǔ)義特征的基礎(chǔ)上加入點(diǎn)云的幾何特征作為約束項(xiàng),以實(shí)現(xiàn)對(duì)可降落區(qū)域的精確檢測(cè)與識(shí)別。

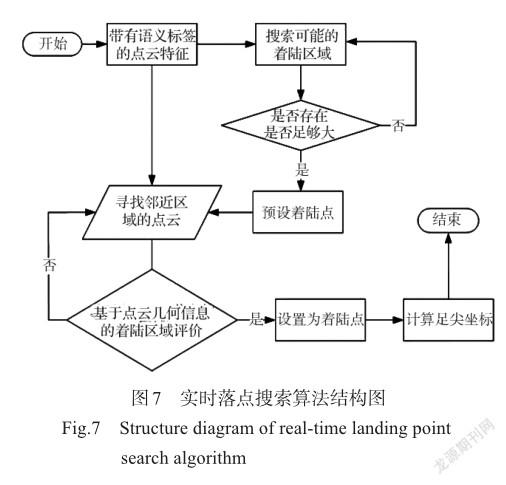

實(shí)時(shí)落點(diǎn)搜索算法結(jié)構(gòu)如圖7所示,首先搜索帶語(yǔ)義標(biāo)簽的點(diǎn)云地圖中地面的地形,選擇最適合著陸的地形所在區(qū)域作為可能著陸區(qū)域,并提取該區(qū)域?qū)?yīng)的點(diǎn)云。根據(jù)無(wú)人機(jī)在不同地形環(huán)境中著陸的難易程度,地形的優(yōu)先順序通常為鋪裝地面、硬質(zhì)土地、草地與沙地。考慮到實(shí)際可著陸環(huán)境中可能存在斜坡、凸起、凹陷等地形,這些地形往往不利于無(wú)人機(jī)進(jìn)行自主著陸,而上述基于深度學(xué)習(xí)的方法難以準(zhǔn)確、穩(wěn)定地識(shí)別這些地形信息。因此,我們?cè)诶命c(diǎn)云的幾何特征作為約束項(xiàng)選擇最合適的著陸點(diǎn)。

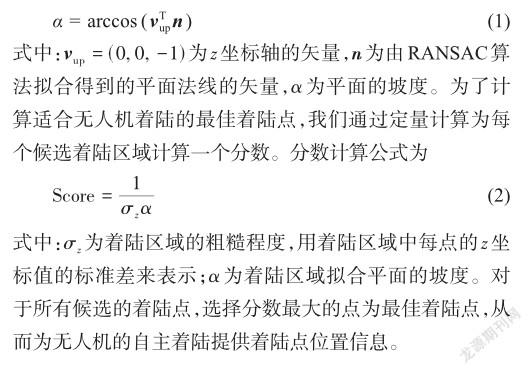

利用0.05m的體素網(wǎng)格對(duì)點(diǎn)云進(jìn)行下采樣,得到稀疏的可能著陸區(qū)域點(diǎn)云地圖。假設(shè)無(wú)人機(jī)最終的著陸區(qū)域?yàn)榫匦危Ⅻc(diǎn)云中的每個(gè)點(diǎn)設(shè)為可能的無(wú)人機(jī)候選著陸區(qū)域的中心點(diǎn)。對(duì)于每一個(gè)可能中心點(diǎn),提取該點(diǎn)在原始點(diǎn)云中對(duì)應(yīng)的近鄰點(diǎn)云。該點(diǎn)云可以反映候選著陸區(qū)域的地形。采用幾何方法來(lái)計(jì)算這部分點(diǎn)云的屬性來(lái)估計(jì)候選著陸區(qū)域的地形。首先,統(tǒng)計(jì)點(diǎn)云中點(diǎn)的數(shù)目,若點(diǎn)云數(shù)目不夠則說(shuō)明這部分區(qū)域沒(méi)有被充分檢測(cè)到或存在水面等不適合著陸的地形,不適合作為著陸區(qū)域;然后,計(jì)算點(diǎn)云中每點(diǎn)的z坐標(biāo)值的標(biāo)準(zhǔn)差,若標(biāo)準(zhǔn)差過(guò)大則說(shuō)明候選著陸區(qū)域可能為傾斜面或存在凹凸不平的情況,同樣不適合作為著陸區(qū)域。最后,為了進(jìn)一步確定候選著陸區(qū)域是否為水平面,嘗試使用RANSAC算法從點(diǎn)云中擬合平面,若無(wú)法擬合出平面或擬合出的平面坡度過(guò)大,則說(shuō)明候選著陸區(qū)域不適合作為著陸區(qū)域。采用平面法線與z坐標(biāo)軸的夾角來(lái)計(jì)算平面的坡度,即

3仿真、試驗(yàn)及分析

3.1 Gazebo仿真試驗(yàn)

利用Gazebo仿真工具搭建虛擬三維場(chǎng)景及具備虛擬傳感器的虛擬無(wú)人機(jī),結(jié)合無(wú)人機(jī)飛行模擬器構(gòu)建仿真環(huán)境,以驗(yàn)證系統(tǒng)各環(huán)節(jié)的有效性,進(jìn)而使用真實(shí)的無(wú)人機(jī)對(duì)整個(gè)系統(tǒng)的方法進(jìn)行驗(yàn)證。

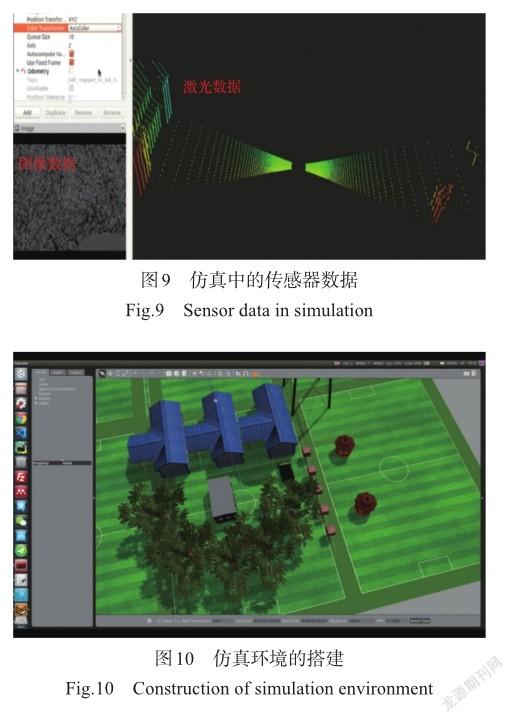

在模擬傳感器數(shù)據(jù)方面,Gazebo中可以實(shí)現(xiàn)常見(jiàn)的傳感器導(dǎo)入,其中包括模型的導(dǎo)入以及傳感器數(shù)據(jù)的仿真。在本文中我們使用了相機(jī)以及激光雷達(dá),所以在Gazebo中也對(duì)這兩種傳感器進(jìn)行了搭建。仿真環(huán)境中的傳感器如圖8所示,對(duì)應(yīng)的傳感器數(shù)據(jù)可以在rviz中實(shí)時(shí)查看,如圖9所示。并搭建相應(yīng)的仿真環(huán)境,如圖10所示。

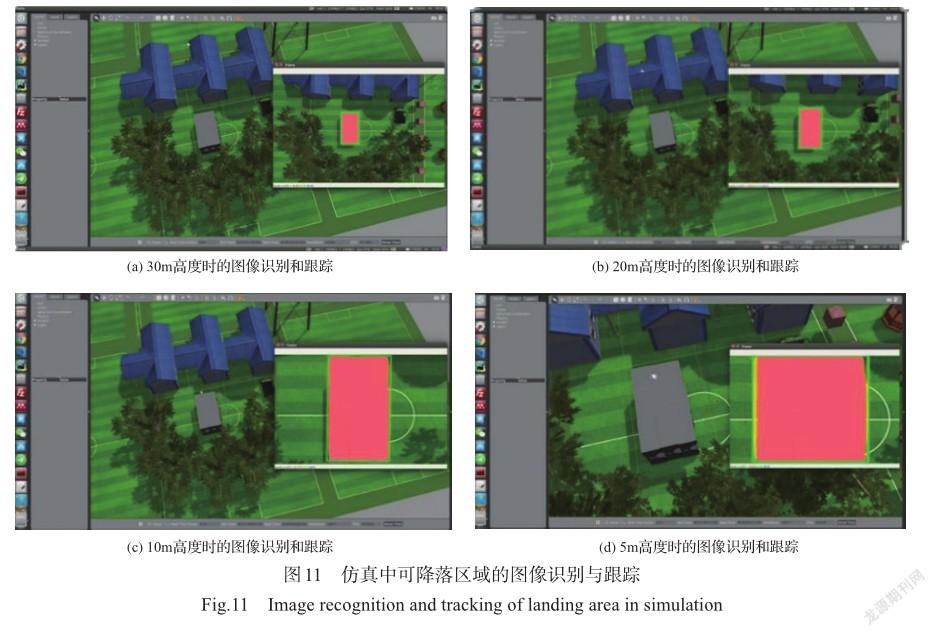

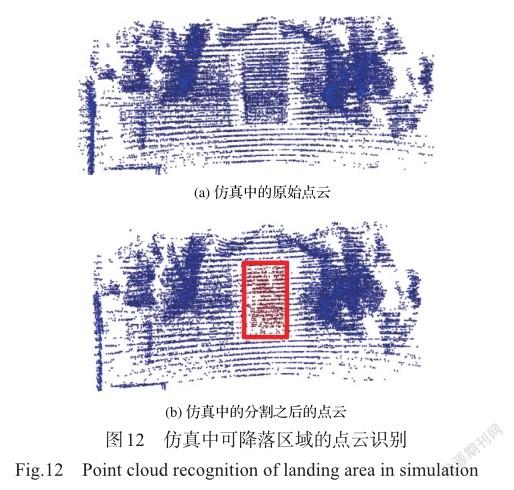

仿真環(huán)境搭建完成之后,便可以對(duì)本文提出的算法進(jìn)行仿真環(huán)境下的定性測(cè)試。圖11展示無(wú)人機(jī)從高空中到低空降落過(guò)程中對(duì)可降落區(qū)域進(jìn)行基于圖像的語(yǔ)義分割和跟蹤的測(cè)試試驗(yàn)結(jié)果。圖12(a)展示了無(wú)人機(jī)在下降的過(guò)程中,對(duì)下方區(qū)域進(jìn)行基于點(diǎn)云的三維環(huán)境建模的結(jié)果,圖12(b)展示了在建立的三維點(diǎn)云地圖上融合圖像的語(yǔ)義分割信息得到的基于三維點(diǎn)云語(yǔ)義分割的結(jié)果。在進(jìn)行仿真測(cè)試的過(guò)程中,無(wú)人機(jī)可以實(shí)時(shí)得到可降落區(qū)域的識(shí)別和跟蹤結(jié)果,能夠引導(dǎo)無(wú)人機(jī)實(shí)現(xiàn)自主泊降。

3.2真實(shí)場(chǎng)景測(cè)試

整體算法在仿真環(huán)境中驗(yàn)證后,在實(shí)際的無(wú)人機(jī)從高空到低空的環(huán)境中進(jìn)行測(cè)試,實(shí)際搭載識(shí)別系統(tǒng)的無(wú)人機(jī)如圖13所示。本文分別做了基于圖像的可降落區(qū)域搜尋、基于圖像的可降落區(qū)域跟蹤、基于點(diǎn)云的三維環(huán)境建模、基于點(diǎn)云三維環(huán)境的分割試驗(yàn)。

3.2.1基于可降落區(qū)域搜尋與跟蹤

針對(duì)圖像的可降落區(qū)域搜尋,我們?cè)贛600 Pro無(wú)人機(jī)上做了實(shí)際環(huán)境的測(cè)試,無(wú)人機(jī)對(duì)可降落區(qū)域進(jìn)行實(shí)時(shí)語(yǔ)義分割,識(shí)別出可降落區(qū)域,并把可降落區(qū)域?qū)?yīng)的像素坐標(biāo)發(fā)給基于點(diǎn)云的三維環(huán)境語(yǔ)義分割模塊,方便后續(xù)將圖像的語(yǔ)義分割后的結(jié)果通過(guò)圖像和激光雷達(dá)的外參矩陣得到每個(gè)三維激光點(diǎn)的類別信息。

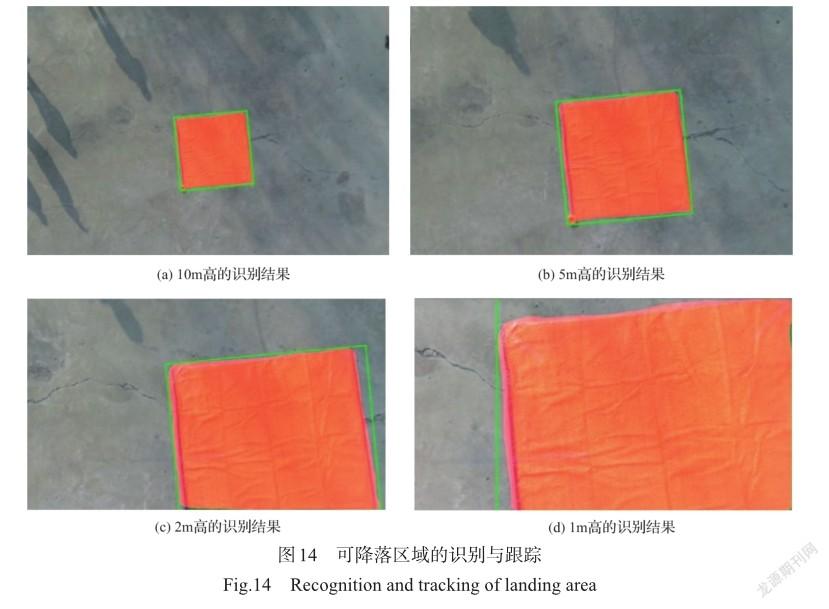

依據(jù)無(wú)人機(jī)高空對(duì)圖像語(yǔ)義分割的結(jié)果,對(duì)可降落區(qū)域?qū)崿F(xiàn)基于圖像的目標(biāo)跟蹤,使無(wú)人機(jī)由高空緩慢降落到低空。基于圖像的可降落區(qū)域識(shí)別與跟蹤的結(jié)果如圖14所示。由圖可以看出,該系統(tǒng)能夠很好地跟蹤可降落區(qū)域。

3.2.2基于點(diǎn)云的三維環(huán)境建模

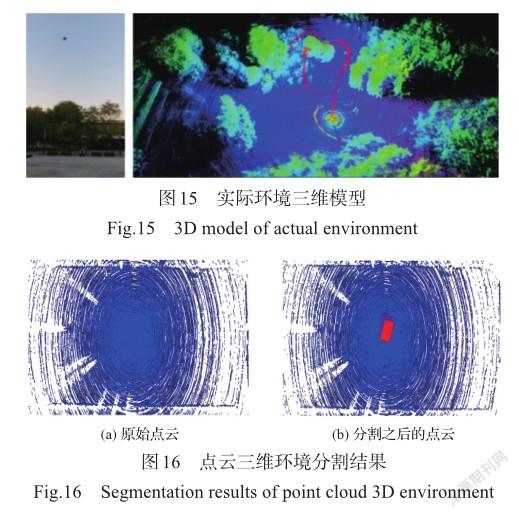

針對(duì)點(diǎn)云的三維環(huán)境建模,在M600 Pro無(wú)人機(jī)上通過(guò)實(shí)際環(huán)境數(shù)據(jù)的采集,對(duì)采集的激光雷達(dá)點(diǎn)云數(shù)據(jù)做出處理后建立實(shí)際環(huán)境的三維模型,實(shí)際環(huán)境三維模型如圖15所示。

3.2.3基于點(diǎn)云的三維環(huán)境分割

基于著陸區(qū)域三維語(yǔ)義環(huán)境模型的著陸地點(diǎn)精確識(shí)別結(jié)果如圖16所示。從圖中信息可知,著陸區(qū)域檢測(cè)與識(shí)別算法給出了著陸區(qū)域的位置(紅色部分),該著陸區(qū)域位于預(yù)設(shè)的適合著陸區(qū)域,坡度為3.4°,粗糙度為0.29,符合無(wú)人機(jī)對(duì)著陸地點(diǎn)的要求。

由此可知,本文提出的算法在真實(shí)環(huán)境中同樣可以根據(jù)著陸區(qū)域的三維語(yǔ)義環(huán)境模型實(shí)現(xiàn)著陸地點(diǎn)的精確識(shí)別。

4結(jié)束語(yǔ)

本文針對(duì)傳統(tǒng)的無(wú)人機(jī)著陸點(diǎn)識(shí)別方法中存在的只利用相機(jī)或激光雷達(dá)等單一傳感器的數(shù)據(jù)進(jìn)行識(shí)別導(dǎo)致的準(zhǔn)確率較低、適用范圍較窄且魯棒性較差的問(wèn)題,提出一種融合多傳感器的無(wú)人機(jī)著陸區(qū)域檢測(cè)與識(shí)別方法,在很大程度上擺脫了單一傳感器數(shù)據(jù)為自主著陸系統(tǒng)提供的信息不足、數(shù)據(jù)不準(zhǔn)的問(wèn)題。首先,通過(guò)對(duì)相機(jī)拍攝的圖像數(shù)據(jù)語(yǔ)義分割,以確定可能的降落區(qū)域大致位置;然后,通過(guò)圖像跟蹤算法持續(xù)跟蹤該區(qū)域并引導(dǎo)無(wú)人機(jī)飛向該可能的降落區(qū)域,然后對(duì)激光雷達(dá)、IMU和相機(jī)等傳感器的數(shù)據(jù)進(jìn)行融合得到降落區(qū)域的精確三維位置信息。我們還將點(diǎn)云語(yǔ)義特征與利用傳統(tǒng)幾何方法提取的點(diǎn)云特征相結(jié)合,以進(jìn)一步提高算法的準(zhǔn)確性與魯棒性,實(shí)現(xiàn)對(duì)無(wú)人機(jī)著陸區(qū)域的精確魯棒識(shí)別。

參考文獻(xiàn)

[1]姜延歡,楊永軍,李新良,等.智能無(wú)人系統(tǒng)環(huán)境感知計(jì)量評(píng)價(jià)研究[J].航空科學(xué)技術(shù), 2020, 31(12):80-85. Jiang Yanhuan,Yang Yongjun,Li Xinliang,et al. Research on environmental perception metrology and evaluation technology of intelligent unmanned system[J]. Aeronautical Science & Technology,2020,31(12):80-85.(in Chinese)

[2]夏路,王琳,梁穎茜.基于PNP的多尺度目標(biāo)視覺(jué)智能輔助降落系統(tǒng)[J].航空科學(xué)技術(shù),2020,31(10):21-29. Xia Lu,Wang Lin,Liang Yingxi. PNP-based multi-scale target visionintelligent-assistedlandingsystem[J]. Aeronautical Science & Technology,2020,31(10):21-29.(in Chinese)

[3]Sharp C S, Shakernia O, Sastry S S. A vision system for landing an unmanned aerial vehicle[C]// IEEE International Conference on Robotics andAutomation. IEEE, 2001.

[4]Bosch S, Lacroix S, Caballero F. Autonomous detection of safe landing areas for an UAV from monocular images[C]// 2006 IEEE/RSJ International Conference on Intelligent Robots and Systems. IEEE, 2006: 5522-5527.

[5]Cheng Y. Real-time surface slope estimation by homography alignmentforspacecraftsafelanding[C]//2010IEEE International Conference on Robotics and Automation. IEEE, 2010: 2280-2286.

[6]Johnson A, Montgomery J, Matthies L. Vision guided landing ofanautonomoushelicopterinhazardousterrain[C]// Proceedings of the 2005 IEEE International Conference on Robotics andAutomation. IEEE, 2005: 3966-3971.

[7]Desaraju V R, Michael N, Humenberger M, et al. Vision-based landing site evaluation and informed optimal trajectory generation toward autonomous rooftop landing[J]. Autonomous Robots, 2015, 39(3): 445-463.

[8]Forster C, Faessler M, Fontana F, et al. Continuous on-board monocular-vision-basedelevationmappingappliedto autonomous landing of micro aerial vehicles[C]// 2015 IEEE International Conference on Robotics and Automation (ICRA). IEEE, 2015: 111-118.

[9]Theodore C, Rowley D, Ansar A, et al. Flight trials of a rotorcraft unmanned aerial vehicle landing autonomously at unprepared sites[C]// Annual Forum Proceedings-American Helicopter Society, 2006.

[10]Meingast M, Geyer C, Sastry S. Vision based terrain recovery for landing unmanned aerial vehicles[C]// 2004 43rd IEEE Conference on Decision and Control (CDC) (IEEE Cat. No. 04CH37601). IEEE, 2004.

[11]Garg M, Kumar A, Sujit P B. Terrain-based landing site selection and path planning for fixed-wing UAVs[C]// 2015 International Conference on Unmanned Aircraft Systems(ICUAS). IEEE, 2015: 246-251.

[12]Mittal M, Valada A, Burgard W. Vision-based autonomous landing in catastrophe-struck environments[J]. Robotics, 2018.

[13]Scherer S, Chamberlain L, Singh S. Autonomous landing at unprepared sites by a full-scale helicopter[J]. Robotics and Autonomous Systems, 2012, 60(12): 1545-1562.

[14]Maturana D, Scherer S. 3D convolutional neural networks for landing zone detection from lidar[C]//2015 IEEE international conference on robotics and automation (ICRA). IEEE, 2015: 3471-3478.

[15]韓家明,楊忠,陳聰,等.無(wú)人機(jī)視覺(jué)導(dǎo)航著陸標(biāo)識(shí)檢測(cè)與分割方法[J].應(yīng)用科技,2020,47(4):1-7. Han Jiaming, Yang Zhong, Chen Cong, et al. Detection and segmentation method of UAV visual navigation landing mark[J]. Applied Science and Technology, 2020, 47(4):1-7.(in Chinese)

[16]李睿康,黃奇?zhèn)ィT輝,等.崎嶇地表上的旋翼無(wú)人機(jī)自主安全降落系統(tǒng)[J].機(jī)器人,2020,42(4):416-426. Li Ruikang, Huang Qiwei, Feng Hui, et al. Autonomous safe landing system of rotary-wing UAV on rugged surface[J]. Robot, 2020, 42(4): 416-426.(in Chinese)

[17]李靖,馬曉東,陳懷民,等.無(wú)人機(jī)視覺(jué)導(dǎo)航著陸地標(biāo)實(shí)時(shí)檢測(cè)跟蹤方法[J].西北工業(yè)大學(xué)學(xué)報(bào),2018,36(2):294-301. Li Jing, Ma Xiaodong, Chen Huaimin, et al. Real-time detection and tracking method of UAV visual navigation landmark[J]. Journal of Northwestern Polytechnical University, 2018, 36(2): 294-301.(in Chinese)

[18]Poudel R P, Liwicki S, Cipolla R. Fast-scnn: fast semantic segmentationnetwork[C]//ProceedingsoftheIEEE/CVF Conference on Computer Vision and Pattern Recognition, 2019.

[19]Wang Q, Zhang L, Bertinetto L, et al. Fast online object trackingandsegmentation:aunifyingapproach[C]// Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, 2019.

[20]Zhang J, Sanjh S. LOAM: Lidar odometry and mapping in realtime[C]//Robotics: Science and Systems Conference, 2014.

Research on the Identification Method of UAV Landing Area Based on Multi-sensor Fusion

Liu Fei1,Shan Jiayao1,Xiong Binyu1,F(xiàn)ang Zheng1,Yang Zhengquan2

1. Northeastern University,Shenyang 110819,China

2. China Aircraft Strength Institute,Xian 710065,China

Abstract: When the UAV encounters the emergency situation of low power, loss of remote control signal, loss of GPS signal, sudden weather change and so on, it is very important to rely on the airborne sensor to achieve the autonomous landing of the UAV to the safe area. In order to ensure that the UAV can automatically identify the safe landing area and realize the safe and autonomous landing in an emergency situation or after receiving landing instructions, we propose a method for the UAV landing area identification based on multi-sensor fusion and deep learning network framework. Firstly, the safe landing area is searched based on the airborne image information of the UAV. Then the safe landing area is tracked using twin networks. When the UAV lands to a certain altitude, airborne liDAR is used to conduct real-time modeling and semantic segmentation of the near-surface environment to determine the safe landing area. Finally, the accurate position and pose information of the landing area is calculated by the realtime landing area point cloud model, which can be used for real-time landing control of the flight control system. Experimental studies in simulation environment and actual environment show that the identification accuracy of landing area based on multi-sensor fusion method reaches 90%, the error of position identification is 5cm, and the estimation error of terrain elevation during landing is 2cm, which can meet the requirements of autonomous safe landing of the UAV. Through the research on the identification method of landing area, the UAV can recognize the landing area below, and then guide the UAV to achieve safe autonomous landing.

Key Words: autonomous landing; deep learning; multi-sensor fusion; 3D lidar; semantic segmentation