基于深度強化學習的轉發效能感知流量調度算法

沙宗軒,霍如,2,孫闖,汪碩,黃韜

(1.北京工業大學信息學部,北京 100124;2.網絡通信與安全紫金山實驗室,江蘇 南京 211111;3.清華大學自動化系,北京 100084;4.北京郵電大學網絡與交換國家重點實驗室,北京 100876)

0 引言

互聯網日益成為人們生產生活中不可或缺的基礎設施,隨著網絡應用和服務的進一步發展,對網絡數據流實施有效的監測管理愈發重要,研究人員提出了多種類型的流量工程(TE,traffic engineering)技術以完成網絡優化任務。流量工程,或稱流量管理,是指針對網絡中數據流的行為進行動態的分析預測和有目的的管理[1]。在20 世紀80 年代的異步傳輸模式(ATM,asynchronous transfer mode)網絡中,擁塞最小化是TE 最常見的目標之一[2]。到了20 世紀90 年代,IP 網絡逐漸成為主流,TE 常用于路由優化;有研究結合ATM 和IP 的優點提出了多協議標簽交換(MPLS,multiprotocol label switching)技術。與傳統IP 路由方式相比,MPLS 不需要在每一跳都分析IP 報文頭,節約了處理時間。但隨著網絡需求的不斷變化,以IP 為網絡層的體系架構存在擴展性差、缺乏安全機制、不具備虛擬化特征等問題使其難以持續發展[3]。

軟件定義網絡(SDN,software defined network)將數據平面與控制平面分離,為有效解決上述問題提供了思路。一方面,SDN 控制器具有全局視野,可實現靈活控制流量、降低網絡運營成本以及促進網絡創新[4-5]。該架構目前已廣泛部署在Google、微軟、Facebook 等公司的內網建設中。例如,Google 希望通過SDN 使資源利用率提升20%~30%,同時優化網絡傳輸性能。另一方面,不同廠商的設備使用統一的編程接口,可以提供充分的開放性。

近年來,SDN 與深度強化學習(DRL,deep reinforcement learning)算法的結合引起了人們的廣泛關注。DRL 是由深度學習(DL,deep learning)[6]與強化學習(RL,reinforcement learning)融合產生的智能決策工具[7]。憑借深度模型強大的表示能力,與傳統RL 算法相比,DRL 在處理具有連續狀態空間及動作空間的復雜問題時具有更好的性能,已被證明是一種可行有效的復雜系統自主控制解決方案。利用DRL 的優勢解決動態網絡下的流量調度問題正成為領域內的熱點[8-9]。

提高網絡資源利用率和改善數據傳輸性能對保障網絡服務質量具有重要意義。Hartman 等[10]指出在資源受限的網絡環境中輸出具有最大流量的鏈路集是NP 完全問題。目前解決此問題廣泛使用兩類算法:開路最短路徑優先(OSPF,open shortest path first)算法和負載均衡(LB,load balance)算法,將流量分配到最短路徑或考慮負載均衡的傳輸路徑上。流量調度算法通常會面臨以下挑戰。

1)根據網絡環境變化快速調整策略。由于大量用戶請求的網絡服務種類繁多,使網絡環境快速變化。在復雜動態的網絡環境中,傳統基于規則的啟發式算法適應性較差。各種約束條件也增加了啟發式流量調度算法的求解效率。這就要求流量調度算法必須高效,能夠快速根據網絡環境及時調整輸出策略[11-12]。

2)調度算法需考慮多維因素的影響。基于RL的流量調度算法可以適應動態變化的網絡環境。在目前的研究中,相關算法常常根據跳數、鏈路時延及擁塞情況等因素產生流量調度方案。而SDN 架構中數據包端到端的完整傳輸時間還包含流量調度策略生成時間和數據包在交換機的轉發時延等,傳統方法考慮因素不足,也導致在復雜網絡環境中流量調度的性能不是最優[13-14]。

3)模型收斂慢且優化目標單一。在一些利用RL 算法解決網絡流量調度的研究中,由于訓練初期缺乏知識,智能體在接近隨機策略的控制下輸出動作,從環境獲得的正反饋低,導致模型訓練速度慢。且由于優化目標單一,使模型在某一性能方面表現較為突出,而整體網絡的其他指標不穩定[15]。

為此,本文針對SDN 架構下的流量調度問題,綜合考慮了交換機狀態,如流表項數量、設備負載率及連接主機數量等因素對其轉發效能的影響,進而影響端到端數據傳輸時延,提出了一種轉發效能感知流量調度(FEATS,forwarding efficiency aware traffic scheduling)算法。FEATS 算法通過神經網絡對設備的轉發效能進行估計,并利用DRL 結合該估計值和網絡狀態信息產生流量調度策略。具體來說,本文的主要貢獻介紹如下。

1)針對考慮交換機轉發效能的SDN 流量調度問題,設計了基于DL 的轉發效能估計模塊,通過采集交換機狀態數據,對其轉發效能進行準確估計,為控制器輸出傳輸時延更低的流量調度方案提供依據。

2)提出了FEATS 算法,該算法在考慮SDN架構中交換機轉發效能對數據傳輸時延影響的基礎上,進一步結合流量需求及當前網絡狀態,實現對數據流更合理的自動化控制與調度。

3)設計了專家樣本產生模塊,利用在同屬性同參數的平行虛擬網絡環境中運行具有不同優化目標的流量調度算法,如OSPF 和LB 算法,產生專家樣本注入經驗池。從經驗池中提取樣本引導模型訓練,一方面可以加速模型初期的訓練速度,另一方面可以使模型吸取不同優化目標的專家樣本中包含的經驗,優化模型多方面的性能。

1 相關工作

傳統基于規則的流量調度算法需要對網絡環境和流量請求進行建模,這種方式在網絡環境動態變化時暴露出適應性差的缺點[16]。因此,基于機器學習的算法成為流量調度領域的主要工具,其中利用DRL 的自主學習機制,通過構建智能體與環境交互采集狀態數據,在觀察到的網絡狀態的基礎上,根據策略產生一系列行動,即可實現智能化的流量調度[17]。目前,對于討論如何在SDN 中進行流量調度相關工作的主要目標集中在降低傳輸時延和平衡鏈路負載兩方面,對這兩方面的研究概括如下。

1.1 降低傳輸時延

網絡用戶追求更低的數據傳輸時延,以獲得更高的體驗質量。Huang 等[13]認為對數據流的控制是優化用戶體驗質量(QoE,quality of experience)的關鍵問題,其首先利用DRL 動態分配網絡資源來實現QoE 驅動的無模型流量調度,利用SDN 控制器具有網絡的全局視圖以獲取環境狀態,輸出數據流路徑和明確的帶寬分配。其次,利用QoE 作為獎勵參數,但頻繁地與用戶進行交互是不現實的,這會使來自用戶的真實QoE 數據反饋周期變長,因此,采用多層神經網絡捕獲特征,將網絡和應用指標映射到平均意見評分(MOS,mean opinion score)。利用該模型,可以根據數據流狀態快速得到MOS 值,支持流量調度模型的訓練。Huang 等[13]進一步利用 DDPG(deep deterministic policy gradient)算法將SDN中的數據分流問題構建為一個深度強化學習模型,該模型將QoS 指標作為獎勵函數用于訓練神經網絡訓練,以優化QoS 性能。

Zhang 等[18]提出了一種時延優化的多播樹封裝問題,即交付時延最小化多播樹封裝(DDMMTP,delivery delay minimized multicast tree packing)。該問題的目標是根據可用網絡資源,在網絡帶寬和最大源?目的時延約束下,最小化平均傳輸時延。通過利用批量多播樹封裝算法并根據需要調整現有多播路徑的網絡容錯容量改進算法來近似求解,提出一種基于可用網絡資源的源?目的時延改進算法,以進一步減少傳輸時延。

Wu 等[19]提出了一種多信道重分配和流量控制框架,通過在神經網絡中增加 LSTM(long short-term memory)層來提取信道的時序信息,將每個信道的預測流量負載作為鏈路的狀態信息之一,結合丟包率、時延、吞吐量等數據,由多智能體DRL 模型根據局部狀態選擇決策,從而實現最大化吞吐量、最小化丟包率和時延。

Saha 等[20]針對通用拓撲提出了一種QoS 感知的流規則聚合方案,該方案考慮了網絡應用的不同QoS 需求和交換機的流規則容量,自適應聚合流規則。實驗結果顯示,該方案能夠減少22%的平均端到端傳輸時延。

在復雜的SDN 中,往往存在多個控制器應對請求。合理的控制器分配方法可以最小化數據流設置時延,進而影響數據平面性能。Filali 等[21]將控制器的分配問題表述為基于請求數量的一對多匹配博弈,并使控制器在滿足最小資源利用率和容量約束的前提下實現負載均衡,以最小化控制平面的響應時間。Savas 等[22]考慮了網絡故障后需要多個階段恢復交換機和控制器之間的控制路徑的問題,提出了一種多級控制路徑恢復方法。Wang 等[23]結合隨機固定水平控制框架,提出了一種結合匹配理論和聯盟博弈的控制器分配方法,降低控制器響應時間。Bera 等[24]提出動態控制器分配方案,考慮了特定的流量需求,利用FlowVisor 模型,構建了一個虛擬平臺,作為SDN 架構的控制面和數據面之間的管理器,使用動態穩定匹配機制,通過定義偏好列表以最小化數據流設置時延和相關控制開銷。Bouzidi 等[25]動態計算控制器的最優數量,確定它們的最優位置,同時將交換機集劃分為集群,利用DRL 解決分配控制器的優化問題。Lin 等[26]提出了最小化控制器選擇機制,保證控制器的區域覆蓋率,并利用改進的多目標人工蜂群算法,根據實時流量判斷需要打開哪個控制器進行數據傳輸,大幅降低了傳輸時延。

1.2 平衡鏈路負載

對于網絡管理者來說,在滿足用戶需求的前提下,還需要考慮鏈路負載均衡,保證網絡性能長期穩定。Zhang 等[11-12]考慮網絡中由于頻繁重路由帶來的負面影響,提出了一種針對SDN 流量調度的強化學習方法,該方法可自動選擇流量矩陣中的關鍵數據流,通過有選擇地重路由少數關鍵流量,以平衡網絡的鏈路利用率。

Huang 等[14]針對SDN 和遺留設備共存的混合環境給路由策略帶來挑戰的問題,提出一種QoS 優化的近似最優流量控制方法,利用DRL 輸出多路可拆分路由的流量分流比,在鏈路利用率方面取得了顯著改善。

Zhang 等[15]提出了使用DL 進行網絡內容感知以及使用DRL 進行流量調度的方法。作者認為SDN 提供對流的控制粒度,但不是對內容的適當抽象,如帶寬要求很小的圖片和帶寬要求很大的視頻可能具有相同的源地址和目的地址、相同的端口ID 和傳輸協議。因此,提取網絡傳輸內容的屬性是合理分配帶寬等網絡資源的關鍵,在SDN架構中,沒有深度數據包檢測,控制器很難獲取內容屬性。通過DL 模型建立起帶寬需求和內容屬性的關聯性,將對帶寬的預測輸入基于DRL 的流量調度模塊,輸出數據流的傳輸路徑。該方法在網絡吞吐量、帶寬利用率和負載平衡方面顯著提高了網絡性能。

Maity 等[27]針對防止控制器過載和優化分配流量的問題,根據馬爾可夫預測器對設備移動性的預測結果,實現了流量感知的規則緩存機制和主控制器分配方案,降低了23.08%控制流量峰值強度。

以上方法針對不同的優化目標,利用深度模型強大的特征表達能力和強化學習的自主學習機制,可不需要精確的環境建模,為數據流請求實時計算調度方案。然而,隨著流表項數量、設備負載率和連接主機數等因素變化,SDN 交換機具有不同的轉發效能,進而影響數據傳輸。因此,將SDN 交換機的轉發效能作為影響數據傳輸的重要因素,同時考慮多維優化目標,才能夠輸出更合理的流量調度策略。

2 轉發效能感知流量調度算法

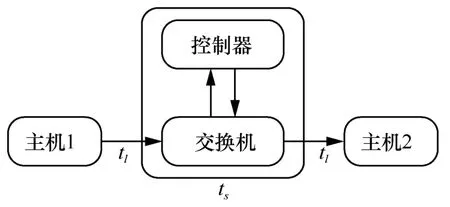

基于OpenFlow 協議的SDN 端到端的數據傳輸模型如圖1 所示。

圖1 基于OpenFlow 協議的SDN 端到端的數據傳輸模型

當主機1 向主機2 發送的數據流經過交換機時,交換機將數據包的匹配域與自身保存的流表項進行對比。如果有匹配流表項,根據對應動作執行;如果沒有匹配流表項,交換機和控制器交互PACKET_IN 和PACKET_OUT 消息,數據流首個報文由交換機發送至控制器,控制器在接收到報文后,根據轉發策略產生數據轉發路徑,并發送到路徑上的各個交換機安裝更新規則。因此,端到端的數據傳輸時延可表示為

其中,tl為鏈路傳輸時延,L為鏈路集合,ts為交換機轉發時延,S為交換機集合。數據傳輸時延T為鏈路傳輸時延和交換機轉發時延的總和,且ts與交換機狀態緊密相關。

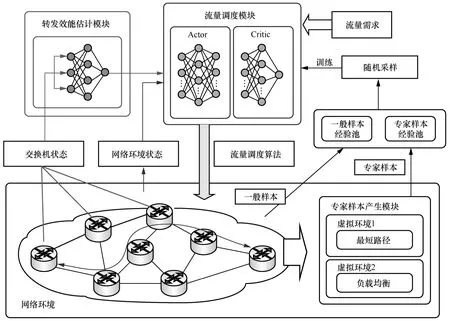

本文除了考慮網絡資源和鏈路狀態等因素外,還綜合考慮了SDN 交換機的轉發效能對數據傳輸效率的影響,結合深度學習和深度強化學習的特點,提出了FEATS 算法求解該問題。FEATS 算法的整體架構如圖2 所示。首先,對于SDN 流量調度問題,定義網絡拓撲為無向圖Graph=(N,E),N為節點集合,E為鏈路集合,從源節點src 到目的節點dst 的鏈路為esrc,dst,?esrc,dst∈E。接下來,將對算法中的核心模塊和算法流程進行闡述。

圖2 FEATS 算法的整體架構

2.1 轉發效能估計模塊

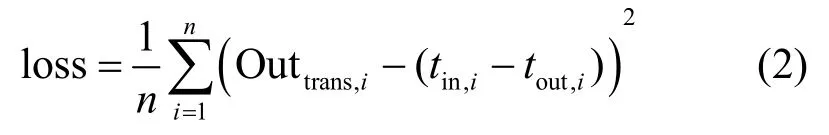

由于SDN 交換機的轉發效能與其本身的性能及實時狀態有關,且這種映射關系很難通過數學多項式精確表達。因此本文設計了一種基于深度學習的SDN 交換機轉發效能估計模塊。該模塊的輸入向量Intrans=[entriesi,tablei,hostesi,lri,rfi]為SDN 交換機狀態參數,其中,entries 為流表項數量,table 為流表數量,hostes 為連接主機數,lr 為設備負載率,rf 為出入口流量。模塊的輸出向量為Outtrans,表示模塊預測數據包從進入交換機到輸出的完整時延,其中包含了流表項的匹配時間,以及當接收新數據流時交換機與控制器的交互時間。模塊主要由一個3 層sequential神經網絡實現。該神經網絡第一層包含5 個神經元,用于接收輸入向量;第二層為全連接層,分別包含64 個神經元,與第一層全連接,激活函數為ReLU;最后一層包含一個神經元,輸出對交換機轉發時延的估計值。模型以均方誤差(MSE,mean square error)作為損失函數,表示為

其中,n為樣本數量,Outtrans,i為模型輸出估計值,tin,i和tout,i分別為數據包進出交換機的時刻。隨著最小化損失函數通過反向傳播更新模型參數,模型估計的轉發時延與真實值逐漸接近。

2.2 流量調度模塊

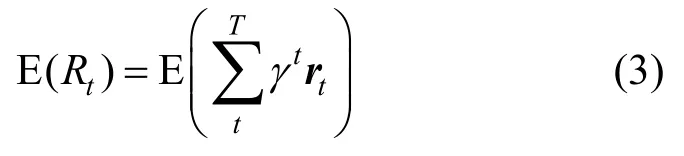

為了解決動態復雜環境下的流量調度問題,本節將引入基于深度強化學習的流量調度算法。在一個典型的強化學習模型中,智能體與環境交互,利用狀態(state)、策略(policy)、動作(action)和獎勵(reward)逐步實現優化目標。定義智能體的狀態空間為S,動作空間為A。具體來說,在每個時間步t,智能體首先觀察當前狀態st∈S,結合自身策略π產生對應動作at∈A,通過執行該動作實現智能體與環境的互動,獲得獎勵rt并同時觀察到下一個狀態st+1。通過構建四元組

其中,T為迭代上限,t為當前時間步,γ∈[0,1]為折扣因子,γ越大表示算法越重視長期的累計獎勵,γ越小則反之。在本文的研究場景中,狀態、動作和獎勵的具體含義如下所示。

狀態(state)。狀態是指在時刻t時,SDN 交換機的轉發效能Outtrans、鏈路的傳輸時延dt、丟包率lt和網絡抖動jt,用向量st表示,即st=[Outtrans,dt,lt,jt]。若令拓撲中交換機數量為m,源節點src 和目的節點dst 間可用的鏈路數為e,則st為3e+m維向量。

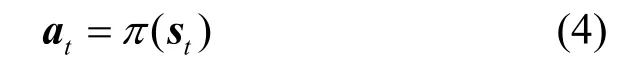

動作(action)。動作是指智能體根據策略π和狀態st生成的流量調度方案,即數據流最優的轉發路徑,動作向量可表示為策略π和狀態st的函數,如式(4)所示。at=[e1,e2,…,el]用于表示輸出的可用傳輸路徑。

獎勵(reward)。獎勵是指環境針對智能體的行為做出的反饋,用于表示所執行動作的好壞,同時也體現了模型訓練的目標。流量調度模塊中獎勵函數定義為

其中,U表示當前網絡環境下各鏈路利用率的矩陣,D表示對應流量需求的傳輸時延矩陣,Dsrc,dst表示從源節點src 到目的節點dst 的特定數據流的傳輸時延。算法的目標是使獎勵最大化,即使當前網絡中的最大鏈路利用率和端到端傳輸時延盡可能小。

深度強化學習是深度學習和強化學習結合的產物。傳統的強化學習算法分為基于策略的算法和基于價值的算法,而將2 種方法結合起來就是Actor-Critic 算法。該算法由Actor 和Critic 這2 個神經網絡組成,Actor 網絡負責生成動作并和環境交互,產生四元組

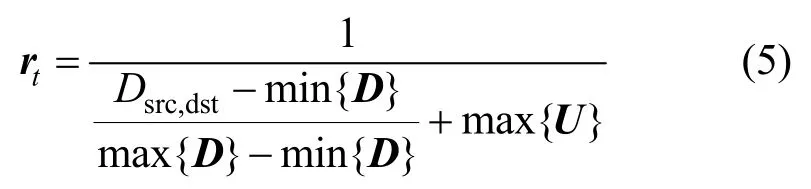

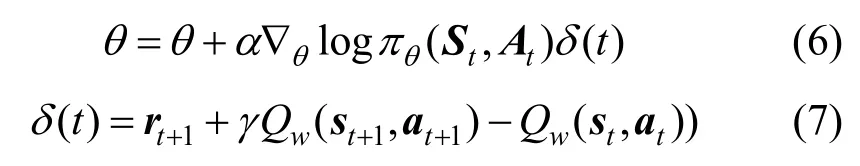

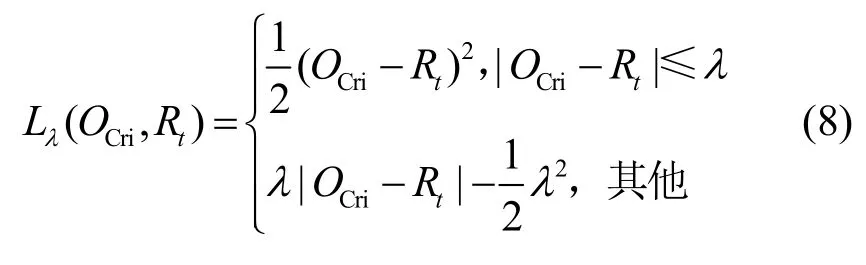

具體來說,此模塊中的Actor 網絡由3 層構成,分別包含3e+m、128 和e個神經元,其中,e和m分別為源節點src 和目的節點dst 間可用的鏈路數和拓撲中包含的交換機數。第一層3e+m神經元數量與DRL 狀態向量st=[Outtrans,dt,lt,jt]的維度對應。模塊后兩層為全連接層,激活函數分別為ReLU 和softmax。Critic 網絡由3 層構成,分別包含e、128和一個神經元,后兩層為全連接層,激活函數使用ReLU,損失函數為Huber。令Actor 網絡的參數為θ,Critic 網絡的參數為w,則Actor 網絡的參數更新計算式為

其中,?θlogπθ(St,At)是策略梯度的分值函數,α是學習率,δ(t)是TD-error,γ是折扣率。Critic 網絡使用Huber 損失函數作為參數w的梯度更新,該損失函數為

其中,λ為超參數,當|Ocri–Rt|≤λ時,損失函數等價為MSE;反之則等價于平均絕對誤差(MAE,mean absolute error),該方法同時具備MSE 和MAE這2 種損失函數的優點,能夠降低奇異點數據對擬合效果的影響。

2.3 專家樣本產生模塊

本文提出的FEATS 算法中的流量調度模塊是基于DRL 實現的。在復雜環境下,面臨獎勵稀疏的問題,即模型在訓練初期執行隨機策略,難以學習到有效的知識,導致模型訓練時間增加。

FEATS 算法設計了專家樣本產生模塊,即構建和網絡拓撲具有相同結構、參數和狀態的并行虛擬環境。令初始網絡拓撲為Graph=(N,E),則平行網絡拓撲=Graph=(N,E)。在中運行最短路徑和負載均衡算法,生成具有相同格式的

其中,at是控制器利用最短路徑和負載均衡算法的策略πex,根據當前狀態st產生的流量調度方案。

將專家樣本和由智能體與環境交互產生的一般樣本分別放入專家樣本經驗池和一般樣本經驗池中,利用隨機采樣方法從上述2 個經驗池中抽取樣本組成mini-batch 用于模型訓練。通過控制隨機采樣因子逐漸遞減,實現mini-batch 中專家樣本數量隨著訓練過程逐漸降低。該模塊的主要作用介紹如下。1)在訓練初期,利用更多的專家樣本引導模型訓練,一方面,可加速模型在訓練初期的學習速度。由于RL 智能體在訓練初期由于缺乏知識,自身策略接近于隨機策略,輸出的動作無法從環境中獲得足夠的正反饋,因此僅靠智能體與環境交互產生的樣本進行訓練的效率較低。另一方面,專家樣本也可輔助模型學習到專家樣本中的知識,實現多目標優化。2)在訓練后期,即在智能體學習到了專家樣本的知識后,降低專家樣本在mini-batch 中的比例,發揮RL 算法在環境中探索的能力,增加智能體學習到綜合性能高于單一性能優秀的專家樣本知識的概率,實現FEATS 算法的優化目標。

3 算法設計與實現

為了解決上述流量調度問題,本文提出FEATS算法,首先使用基于DL 的轉發效能估計模塊預測SDN 交換機轉發時延,之后將該估計值作為輸入變量傳遞給基于DRL 的流量調度模塊,使控制器輸出的最優決策受到該估計值的影響。

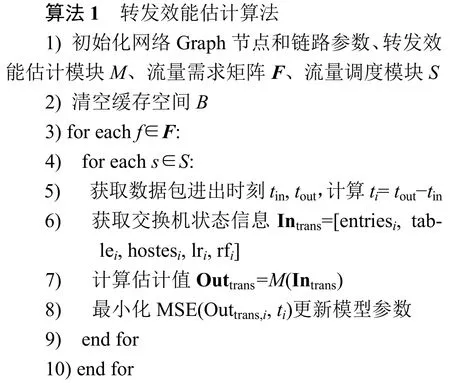

3.1 交換機轉發效能估計

在FEATS 中,利用DL 強大的表示能力擬合交換機的轉發效能和多維狀態數據之間映射關系。轉發效能估計算法的訓練流程如算法1 所示。

隨著對流量需求的執行,可以獲取數據流傳輸路徑上交換機的狀態信息及轉發時延,根據模塊輸出估計結果,通過最小化損失函數調整模型參數以提升預測準確度。

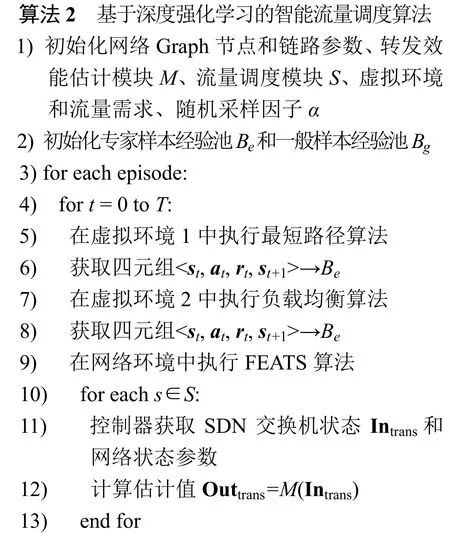

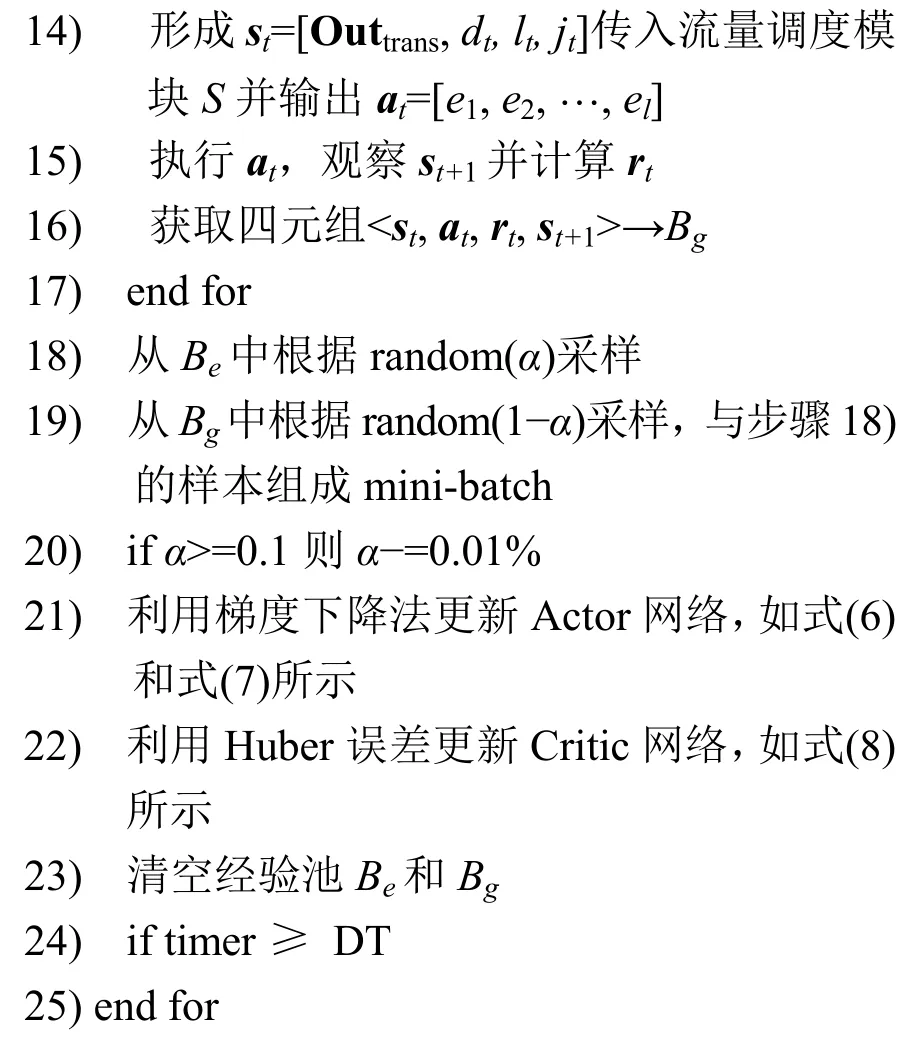

3.2 轉發效能感知流量調度

在估計交換機轉發效能后,FEATS 根據該估計值和當前網絡狀態,針對流量需求產生對應的調度策略。基于深度強化學習的智能流量調度算法流程如算法2 所示。定義當前的訓練時長為timer,模型訓練時間上限為DT,一次迭代內最大時間步上限為T。定義random(α)為隨機采樣方法,隨機采樣因子α∈(0,1),表示以α為概率抽取樣本。

FEATS 在同參數同狀態的虛擬環境中運行最短路徑和負載均衡算法,由此產生專家樣本及其自身與環境交互產生的數據共同組成訓練集,在隨機因子α的作用下從中采樣。隨著α逐漸降低,算法抽取到專家樣本的概率減小,即專家樣本在訓練初期對模型的影響大,不僅可以加速訓練速度,也可使模型學習到專家樣本中的知識,而在訓練后期更強調模型自身對環境的“探索”。模型根據交換機狀態預測數據包經過該設備轉發時產生的時延,輸出綜合考慮傳輸時延和網絡負載均衡的流量調度方案。

4 仿真分析

為了驗證FEATS 算法的性能,本節通過實驗仿真將其與迪杰斯特拉(Dijkstra)算法、輪詢(Round Robin)調度算法及加權最小連接(Weighted Least Connection)調度算法的評價指標對比。

1)Dijkstra 算法是OSPF 協議的核心算法,使用廣度優先搜索解決賦權有向圖或者無向圖的單源最短路徑問題。

2)Round Robin 是一種以輪詢方式將負載請求分配給設備的負載均衡調度算法。

3)Weighted Least Connection 可為設備賦值權重,算法通過連接數和權重調整設備被輪詢到的概率,以實現更平均的負載均衡。

本節實驗利用Mininet 和Python 構建實驗環境及采集數據,使用Ryu 作為SDN 控制器,通過Iperf工具產生數據流。FEATS 模型采用Keras 實現,Keras 是一種基于Tensorflow 的高階API。服務器硬件配置及軟件版本如表1 所示。

表1 服務器硬件配置及軟件版本

本文從SNDLib 獲取GEANT 網絡拓撲和流量需求,該拓撲具有22 個節點及72 條鏈路。初始化實驗參數,隨機采樣因子α=0.9,各節點根據高斯分布隨機產生流表項及流表數量,設置最小傳輸時延為1 ms,最大傳輸時延為200 ms。

4.1 算法評價指標

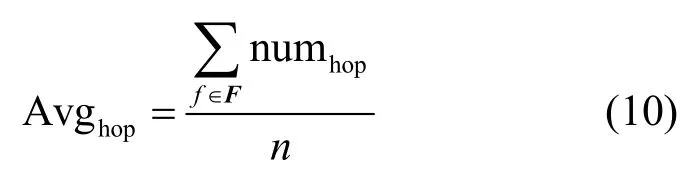

本文提出的FEATS 算法由于考慮了設備轉發效能,并且由最短路徑和負載均衡算法產生的專家樣本訓練,可輸出綜合考慮了網絡負載均衡的最短傳輸時延的流量調度方案。因此,實驗部分針對以下評價指標進行對比分析。令F為流量需求矩陣,f∈F為單個流量需求命令,n為流量需求命令的數量,L為全部交換機負載率矩陣,lr∈L為交換機負載率,m為交換機數量。

平均跳數為

其中,numhop為完成流量需要跳轉的設備數量,每經過一臺交換機,numhop加1。

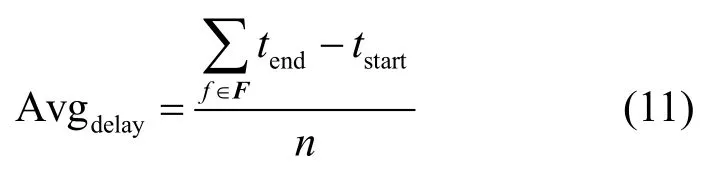

平均傳輸時延為

其中,tend和tstart分別為數據包從發送端發出和到目的端接收的時刻。

最大負載率為

其中,max 函數為獲取L中的最大值,即計算各算法在執行流量需求的過程中全部交換機的負載率最大值。

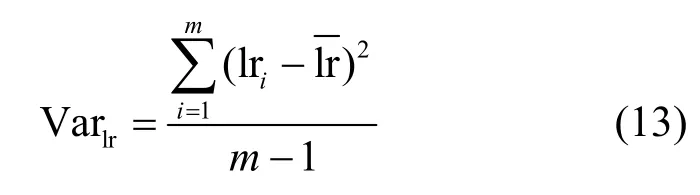

負載率方差為

式(13)用于計算各算法在執行流量需求的過程中各交換機負載率方差的最大值。該指標越大,表示各交換機之間負載率的差異越大,反之則表示負載率越均衡。

4.2 專家樣本產生模塊支持模型訓練效果分析

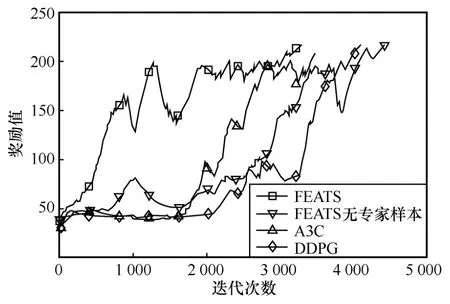

FEATS 算法中設計了專家樣本產生模塊,在同結構同參數的虛擬環境中,利用成熟的算法產生專家樣本,幫助算法學習到對應方面的知識,加速模型在訓練初期的訓練效率。本節實驗通過控制有無專家樣本產生模塊參與訓練,驗證該模塊對模型訓練的影響。無專家樣本模塊支持的FEATS 算法在實驗中用“FEATS 無專家樣本”表示。同時,本節實驗還與同屬 Actor-Critic 架構的 A3C(asynchronous advantage actor-critic)和DDPG(deep deterministic policy gradient)算法進行了更廣泛的分析對比。在實驗環境中部署上述4 種算法,分別進行20 次實驗,收集模型從環境中獲取的累計獎勵值。平均獎勵值對比結果如圖3 所示。

圖3 平均獎勵值對比結果

從圖3 可以看出,FEATS 算法的訓練效率高于FEATS 無專家樣本、A3C 和DDPG 算法的情況。FEATS、A3C 和DDPG 都是基于DRL 的算法,在復雜環境中同樣面臨獎勵稀疏的問題,表現為模型訓練的前中期很難獲得有效的正反饋,使獎勵值難以擴展至環境的大部分狀態。圖3 中的結果顯示,FEATS 無專家樣本、A3C 和DDPG 算法在第1~2 000 次迭代期間獲取的獎勵值在較低水平浮動,說明模型輸出的動作難以獲得環境給予的正反饋,導致模型在前中期訓練效率低,并分別在迭代4 439 次、3 485 次、4 101 次后收斂。對于有專家樣本支持的情況,由成熟的算法產生的動作在訓練初期就可以獲得較高的獎勵值,縮短了FEATS 在沒有足夠知識的情況下盲目探索的過程,使模型在迭代3 295 次后完成訓練。DDPG 具有經驗回放功能,但訓練樣本來自自身與環境交互,相當于FEATS 算法中的一般樣本,其功能更多是為了打破數據相關性,在訓練初期對加速模型收斂的影響不大。A3C 通過異步方式執行多個Actor 進行學習,并行的方式對加速模型訓練起到了一定的積極效果,但在初期依然難以獲得正反饋。本節實驗證明了專家樣本產生模塊使FEATS 模型訓練效率提升了25.78%。

4.3 數據傳輸性能對比分析

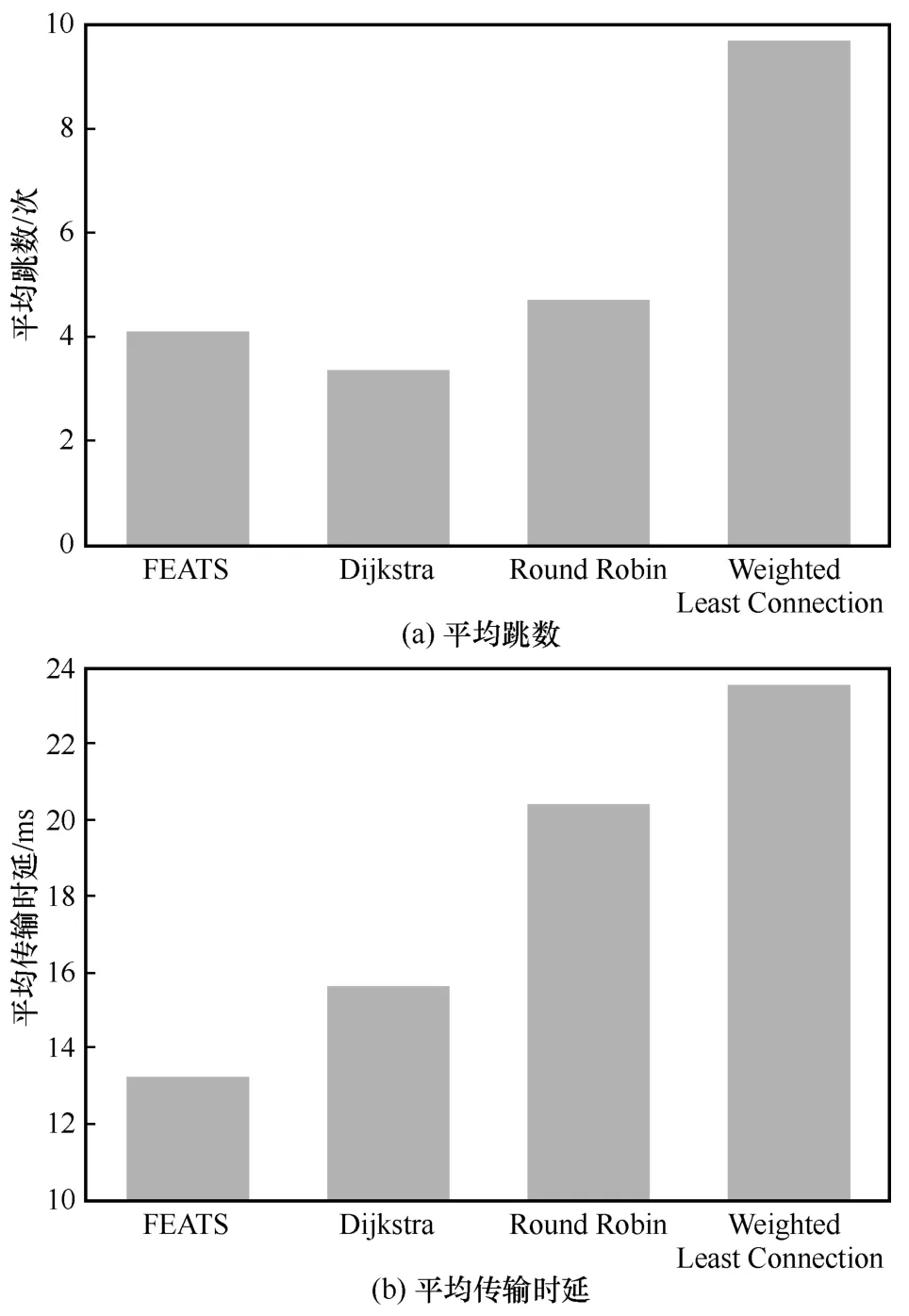

路由跳數和數據傳輸時延是評價數據傳輸性能的重要指標。本節實驗在GEANT 拓撲中執行流量需求指令,記錄各算法完成流量需求的平均跳數和平均傳輸時延,實驗結果如圖4 所示。

圖4 數據傳輸性能對比

圖4(a)顯示出Dijkstra 作為一種最短路徑算法,在平均跳數方面取得了最好的性能,為3.77;負載均衡算法Round Robin 和Weighted Least Connection的平均跳數分別為4.72 和9.75。在平均傳輸時延方面,如圖4(b)所示,Dijkstra 為15.61 ms,Round Robin和Weighted Least Connection 分別為20.38 ms 和23.56 ms。

本文提出的FEATS 算法的平均跳數為4.13,平均傳輸時延為13.22 ms,較Dijkstra 算法分別增加了9.55%及降低了15.31%,呈現出跳數高、傳輸時延低的結果。這是因為在數據轉發過程中,交換機具有不同數量的流表項和連接主機數以及不同程度的負載等因素,使其轉發效能呈現較大差異。FEATS 算法的轉發效能估計模塊預測的轉發時延最小值為0.9 ms,最大值為9.3 ms。因此,存在在跳數最少的數據傳輸路徑上某些交換機的轉發時延較高的情況。FEATS 算法可以有效感知交換機的轉發效能,在預測到交換機的轉發時延較高時,選擇跳數多但交換機可以更快完成數據轉發的路徑,從而實現更低的傳輸時延。

4.4 負載均衡性能對比分析

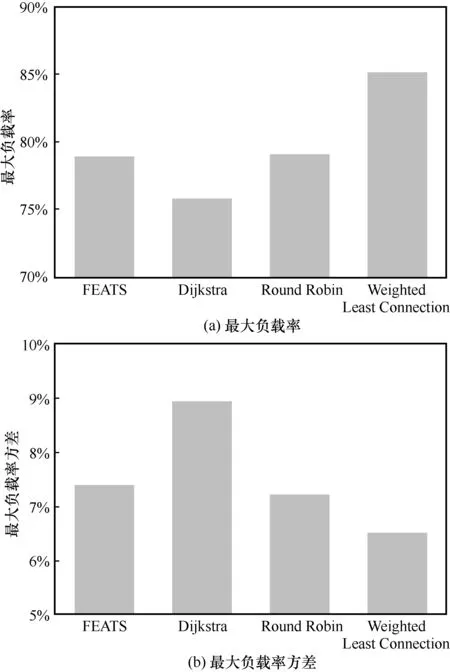

最短路徑算法往往僅考慮數據傳輸效率,導致不同重要程度的鏈路和節點之間負載率差距較大,不利于網絡整體性能和穩定性。各算法執行流量需求指令時,交換機的負載均衡性能對比如圖5 所示。

圖5(a)顯示了FEATS、Dijkstra、Round Robin和Weighted Least Connection 的最大負載率分別為78.92%、75.73%、79.07%和85.14%。其中,Dijkstra算法的最大負載率最低,主要原因是該算法的目標為經過數量最少的交換機完成數據傳輸,因此在執行相同的流量需求時,全部交換機的負載率總和最低。Round Robin 和Weighted Least Connection 需要考慮負載均衡,輸出的傳輸路徑通常要比Dijkstra算法的更長,導致網絡整體的負載率有所增加。

在負載均衡方面,如圖5(b)所示,負載率方差反映了交換機負載率的差異性。FEATS、Dijkstra、Round Robin 和Weighted Least Connection 的最大負載率方差分別為7.39%、8.93%、7.21%和6.51%。Dijkstra 算法雖然產生最短傳輸路徑,但輸出的路徑可能頻繁經過在網絡拓撲中占據重要位置的節點,而邊界節點常處于閑置或低負載狀態,造成節點負載率差距較大,在圖5(b)中表現為最大負載率方差最大。Round Robin 按順序調度流量,起到了負載均衡的作用,其最大負載率方差與Dijkstra 相比有顯著的降低。Weighted Least Connection 算法由于存在加權系數,使流量可以更均勻地調度到低負載的交換機,實現各設備之間負載率更均衡,因此其最大負載率方差最低。FEATS 算法在負載均衡方面取得了和Round Robin 算法接近的水平。由于在訓練過程中,模型有利用負載均衡算法產生的樣本參與訓練,且rt與最大負載率緊密相關,因此,產生的決策也具備較好的負載均衡效果。

圖5 負載均衡性能對比

綜合以上結果分析,本文提出的FEATS 算法可以根據交換機狀態有效估計交換機轉發時延,并基于轉發時延規劃更合理的數據傳輸路徑。通過利用專家樣本縮短了25.78%的訓練時間,并且實現了在具備一定負載均衡效果的基礎上平均降低15.31%的端到端傳輸時延。

5 結束語

在SDN 架構中,流表項數量、設備負載率及連接主機數量增加,會導致SDN 交換機的轉發效能降低,進而影響端到端數據傳輸時延。本文提出的FEATS 算法利用DL 的強大表示能力,建立起SDN 交換機的多維狀態數據與轉發效能之間的映射關系,并根據轉發效能、網絡狀態和流量需求輸出兼顧最低時延和網絡負載均衡的流量調度策略。實驗表明,FEATS 算法的專家樣本產生模塊可提升25.78%的模型訓練效率。同時,由于FEATS算法可以有效評估交換機轉發效能,端到端傳輸時延比Dijkstra 算法降低15.31%,負載均衡性能與Round Robin 算法接近。說明FEATS 算法學習到了最短路徑和負載均衡專家樣本的知識,并在自身獎勵函數的引導下可以輸出綜合考慮了傳輸時延和網絡負載均衡的流量調度方案。FEATS 算法對解決SDN 的流量調度問題、提升網絡性能有一定的實用價值。

需要注意的是,FEATS 算法在實驗環境下驗證了有效性。在實際場景中,交換機轉發效能還會額外受到硬件性能和狀態等多種因素的影響,在針對實際場景調整模型輸入維度后,可更好地滿足實際使用需求。