基于改進U-Net的肝臟MRI分割方法

汪慎文, 周 瑤

(河北地質大學 信息工程學院, 石家莊 050031; 河北地質大學 人工智能與機器學習研究室, 石家莊 050031; 河北地質大學 新零售聯合研究院, 石家莊 050031)

磁共振成像(magnetic resonance imaging, MRI)是斷層成像的一種, 其利用磁共振現象從人體中獲得電磁信號, 并重建人體信息, 磁共振成像是臨床疾病篩查和診斷的重要工具, 廣泛應用于肝臟組織的病癥檢查中. 但由于肝臟與周圍組織的灰度值極相近以及個體的差異性, 因此導致精準分割肝臟成為難點.

深度學習具有自動從數據中學習深層次和鑒別性特征的能力, 目前已在醫學圖像分割領域廣泛應用, 其性能較傳統圖像分割方法有顯著提升[1]. 在語義分割場景中, 深度學習利用圖像的深層次特征, 對圖像的像素點進行分類, 從而實現圖像分割. 傳統的深度網絡模型如AlexNet[2],VGGNet等要求輸入固定大小的圖片, 并且該類模型計算代價較高. 為解決上述問題, Long等[3]提出了全卷積神經網絡(fully convolutional network, FCN), 將全連接層換成卷積層, 使得該網絡可用于稠密估計任務, 并實現端到端的訓練. 但由于FCN網絡針對單個像素進行識別分割, 在訓練過程中忽略了空間相關性, 使分割結果存在不精確的問題[4]. Rommeberger等[5]提出了一種U型網絡模型, 該網絡模型基于編解碼的結構, 已廣泛應用于各種醫學影像分割任務中, 性能良好. 劉清清等[6]將半監督學習引入到肝臟圖像分割中, 提出了一種基于3D scSE-UNet的肝臟CT圖像半監督學習分割方法, 該方法使用自訓練的半監督學習框架, 將包含改進的并行空間、 通道特征壓縮和激勵模塊的3D scSE-UNet作為分割網絡. scSE-block可從圖像空間和特征通道兩方面自動學習圖像的有效特征, 抑制無用冗余特征, 更好地保留圖像邊緣信息. 同時在自訓練過程中加入全連接條件隨機場, 對分割網絡產生的偽標簽進行邊緣細化, 提升偽標簽的精確度. 實驗結果表明, 這種半監督學習分割方法可在僅使用少量標注數據的情況下, 取得與全監督分割方法相同的分割效果, 有效減輕肝臟CT(computed tomography)圖像分割對專家標注數據的依賴. 劉蕊等[7]從多維度的角度出發, 構建了一種多維度特征提取網絡模型. 宋陽等[8]針對現有分割網絡在肝臟區域的全局信息和局部信息處理上存在的不足, 設計了一種融合更多局部特征的循環密集連接網絡的分割方法, 該方法將循環密集連接模塊和局部特征補充模塊整合為編碼過程的學習單元, 使編碼單元融合深層次全局信息和更多尺度的局部特征信息. 閆諳等[9]針對卷積神經網絡在對圖像中每個像素點分類過程中未使用周圍像素點類別信息, 易導致小目標漏檢和邊界分割模糊的問題, 提出了一種條件能量對抗網絡用于肝臟和肝腫瘤分割, 實驗結果表明, 該方法不僅實現了肝臟和肝臟腫瘤的自動分割, 還充分利用相鄰像素點之間的相似性提高了肝臟邊界的分割精度, 有效緩解了小目標漏檢的問題. 亢潔等[10]針對卷積神經網絡分割肝臟邊界較模糊的影像數據時易丟失位置信息, 導致分割精度較低的問題, 提出了一種基于分水嶺修正與U-Net模型相結合的肝臟圖像自動分割算法. 但U-Net結構存在模型中連續的標準卷積和池化操作導致部分空間上下文信息丟失的問題, 因此, 本文提出一種融合多尺度[11]卷積模塊和空間通道注意力模塊的U-Net分割方法, 用于MRI中肝臟的分割. 該方法在網絡的編碼階段用多尺度模塊代替標準卷積提取豐富特征, 同時在整個網絡模型引入空間和改進的通道注意力模塊用于賦予各特征不同的權重值, 從而篩選更重要的特征, 同時保留了原跳躍連接用于特征融合. 實驗結果表明, 該算法在肝臟數據集上的分割效果優于U-Net, 有效改善了分割結果中圖像信息丟失和小目標分割效果較差的問題.

1 改進的U-Net分割方法

1.1 U-Net結構

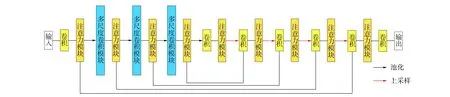

U-Net結構如圖1所示. 由圖1可見, 網絡分為左、 右兩部分, 左邊是壓縮過程, 即編碼階段, 右邊是擴張路徑, 即解碼階段. 其中, 編碼階段遵循典型的卷積網絡結構, 由兩個重復的3×3卷積核組成, 且均使用ReLU激活函數和一個用于下采樣的步長為2的2×2最大池化層, 在每個下采樣步驟中, 特征通道數量都加倍. 在擴張路徑中, 每步都包含對特征圖進行上采樣, 用2×2的卷積核進行卷積運算, 以減少一半的特征通道數量, 然后級聯收縮路徑中相應裁剪后的特征圖, 再用兩個3×3的卷積核進行卷積運算, 且均使用ReLU激活函數. 由于在每次卷積操作中邊界像素都存在缺失問題, 因此有必要對特征圖進行裁剪. 在最后一層, 利用1×1的卷積核進行卷積運算, 將每個64維的特征向量映射到網絡的輸出層. U-Net在編碼階段通過卷積和下采樣降低圖像尺寸, 提取一些淺層的特征信息; 而解碼階段通過卷積和上采樣獲取一些深層次的特征. 中間通過疊加的方式, 將編碼階段獲得的特征圖與解碼階段獲得的特征圖疊加在一起, 結合深層次和淺層次的特征, 細化圖像, 最后根據得到的特征圖進行預測分割.

圖1 U-Net結構Fig.1 U-Net structure

1.2 整體網絡結構

在實驗過程中發現, U-net提取的語義信息不夠豐富, 原因是來自下采樣階段和上采樣階段的特征圖在語義上并不具有相似性, 當網絡進行訓練時, 直接向解碼階段傳遞高分辨率的特征圖將導致分割結果在語義上的不一致性, 不僅使分割結果變差, 而且會增加小目標分割難度. 針對上述問題, 本文提出在特征提取階段用多尺度卷積(Inception)模塊替代原來的兩個 3×3 卷積, 同時引入空間和通道注意力(spatial and channel squeeze & excitation, SCSE)模塊為特征賦予權重值, 使網絡可提取到更豐富和有意義的特征, 改進的網絡結構如圖2所示.

圖2 改進的U-Net結構Fig.2 Improved U-Net structure

由圖2可見: 輸入到網絡的圖像在第一層編碼階段先進行卷積操作提取特征, 然后經過注意力模塊沿通道和空間分別重新校準特征圖, 最后對特征圖進行池化操作, 以減小圖像尺寸、 增大感受野; 第二層編碼將池化后的特征圖輸入多尺度卷積模塊提取特征, 再經過改進后注意力模塊沿通道和空間分別重新校準特征圖, 最后進行池化操作增大感受野; 第三層和第四層編碼與第二層操作相同, 只是通道數擴大, 再進行一次卷積操作并經注意力模塊輸出特征圖到解碼階段. 在每層解碼階段依次進行上采樣操作、 卷積操作和SCSE模塊操作, 特征圖進行上采樣操作后與編碼階段注意力模塊輸出的特征圖進行通道疊加, 最后經過1×1卷積輸出預測值.

1.3 多尺度卷積模塊

圖3 Inception模塊結構Fig.3 Module structure of Inception

Inception[12]模塊結構如圖3所示. 由圖3可見, 該結構有4個分支: 第一個分支是1×1卷積; 第二個分支先進行1×1卷積再接一個3×3卷積; 第三個分支先進行1×1 卷積再接一個5×5卷積; 第四個分支先進行一個3×3的池化操作再接一個1×1卷積. Inception模塊主要有兩個功能: 1) 使用1×1的卷積進行升降維; 2) 在多個尺寸上同時進行卷積再拼接. 圖3中有多個1×1卷積塊, 其作用是首先在相同尺寸的感受野中疊加更多的卷積, 能提取到更豐富的特征, 從而實現不同通道之間的信息交互和融合; 其次, 使用1×1卷積可降維并減小參數量.

多尺度卷積模塊的推理過程如下:

其中f表示輸入的特征圖,Mij表示第i個分支的j×j卷積運算,θij表示第i個分支的j×j卷積運算的卷積核參數,P表示池化操作, ⊕表示特征拼接操作,Fi表示第i個分支的運算結果,g表示整個Inception模塊的輸出結果.

1.4 空間和通道注意力模塊

圖4 空間和通道注意力模塊Fig.4 Spatial and channel attention modules

空間和通道注意力模塊由兩部分組成, 一部分用于壓縮通道從而達到激勵空間的目的; 另一部分用于壓縮空間達到激勵通道的目的, 其結構如圖4所示.由圖4可見, 空間和通道注意力模塊分為兩部分: 上部分為空間注意力, 下部分為通道注意力.空間注意力通過一個1×1卷積操作使特征圖在通道上進行壓縮, 例如輸入通道數為64, 則輸出通道數即為1, 然后將輸出的特征圖輸入到Sigmoid函數中, Sigmoid函數將特征圖中的所有特征值規范化為[0,1]內的值, 得到的即為空間特征權重. 將空間特征權重與輸入特征圖進行相乘操作后輸出校準后的特征圖.

空間注意力推理過程如下:

其中f表示輸入特征圖,M表示1×1卷積,θ表示卷積運算的卷積核參數,f1,f2,f3分別表示卷積運算、 Sigmoid函數運算和乘運算的輸出.

目前的通道注意力由兩個線性層構建通道的權重, 但通過簡單疊加兩個線性層的通道權重學習方式并未考慮通道與通道之間的相關性, 因此本文進行改進. 如圖4所示, 在通道注意力分支, 本文用一個多頭注意力層替換兩個線性層. 多頭注意力最初用于自然語言處理領域, 由多個自注意力組成, 自注意力通過權重矩陣計算變量與變量之間的相關性. 本文通過多頭注意力計算通道與通道之間的相關性, 在此基礎上為每個通道生成一個權重.

本文多頭注意力計算過程如下:

步驟1) 輸入壓縮后的特征圖M;

步驟4) 多頭注意力為MHA=Concat(head1,…,headh)Wo, 其中h表示多頭注意力的頭數,Wo為權重矩陣.

整個通道注意力的校準過程如下: 首先, 將輸入的特征圖進行全局平均池化, 該操作使每個通道上的特征圖壓縮為一個數值, 圖中特征圖的維度將由[C,H,W]變為[C,1,1], 壓縮后的特征圖進行層歸一化輸入到多頭注意力層生成通道權重; 再經過一個激活函數(Sigmoid)把權重歸一化, 輸出結果即為每個通道的權重; 然后將權重值與輸入的特征圖進行相乘操作; 最后輸出的即為在每個通道上校準特征值后的特征圖, 從而達到激勵通道的作用.

通道注意力推理過程如下:

其中ck(i,j)表示第k個通道的i行和j列的特征值,vk表示對每個通道的特征值求和以后求平均值, 即全局平均池化,V表示所有通道全局平均池化后的特征值集合,l1表示層歸一化, MHA表示多頭注意力,l表示生成的通道權重,G表示經激活函數Sigmoid處理后的l與特征圖f相乘操作的輸出結果.最后將式(8)與式(12)輸出的特征圖逐通道相加便可得到經SCSE模塊重新校準后的特征圖.

2 實驗結果與分析

實驗硬件環境: Intel(R) Core(TM) i7-10750H CPU@ 2.60 GHz, 內存16 GB DDR4, NVIDIA GTX1650Ti 4 GB獨立顯卡; 軟件環境: 深度學習框架為Pytorch, 開發環境為PyCharm, 編程語言為Python 3.8.

2.1 數據集

實驗數據集采用2019年IEEE國際生物醫學影像研討會發布的數據集CHAOS, 該數據集包括脾臟、 肝臟、 左腎和右腎等4個器官的MRI圖像和真實的肝臟標注. 先對數據集進行數據擴充, 包括圖像旋轉、 圖像左右互換和圖像放大縮小, 將訓練集數據量擴充至1 500.

2.2 網絡編譯及評價指標

網絡模型采用交叉熵損失函數[13]. 優化器選擇Adam, 其實現簡單, 計算高效, 參數的更新不受梯度的伸縮變換影響, 同時可自動調整學習率, 適用于大規模的數據及參數的場景.

為評價網絡的分割性能, 本文選用召回率、 精確度和Dice系數3個評價指標:

召回率=(Rgt∩Rpred)/Rgt,

(13)

精確度=(Rgt∩Rpred)/Rpred,

(14)

Dice=2|Rgt∩Rpred|/(Rpred+Rgt),

(15)

其中Rgt表示標注的分割結果,Rpred表示預測的分割結果.召回率衡量真實背景中的陽性體素部分, 即分割實驗中能分割感興趣區域的能力及能分割出多少肝臟; 精確度衡量分割實驗中真正肝臟在分割結果中的占比; Dice系數衡量分割結果和標注結果的重疊部分, Dice值越高表示網絡分割能力越強, 其最大值為1.

2.3 實驗結果

2.3.1 改進SCSE模塊的有效性

為驗證改進后的SCSE模塊對肝臟分割性能的影響, 本文以U-Net為基礎模型, 將文獻[14]中的SCSE模塊與本文改進后的SCSE模塊分別應用到U-Net上, 然后評價兩個模塊的分割性能, 實驗結果列于表1. 由表1可見, 改進后SCSE模塊的召回率、 精確度和Dice系數分別為0.864,0.920,0.886, 較原SCSE模塊分別提高0.5%,0.8%,1.2%. 因此, 改進后的SCSE模塊提高了肝臟的分割精度, 驗證了改進的SCSE模塊的有效性.

表1 不同模塊的評價指標對比

2.3.2 整體網絡結構的有效性

圖5為整體網絡結構改進前后部分分割結果的對比, 其中第一行是輸入網絡的腹腔原圖, 第二行是根據肝臟標注提取的肝臟掩膜, 第三行是U-Net的分割結果, 第四行是本文改進的U-Net的分割結果. 由圖5可見: U-Net在分割中丟失了部分肝臟信息, 部分肝臟沒有被分割出來, 且部分將把背景分割為肝臟; 而本文的網絡模型較好地分割出肝臟組織, 錯分割和丟失肝臟組織的情況較少, 較好地改善了U-Net的小目標分割難的問題, 改進的分割網絡能較好地分割出小肝臟組織.

圖5 U-Net改進前后部分分割結果對比Fig.5 Comparison of partial segmentation results before and after U-Net improvement

為驗證本文改進U-Net模型的特征提取能力, 對模型提取的特征進行可視化, 如圖6所示. 由圖6可見, 改進的U-Net分割出的肝臟更完整. 圖7為肝臟圖像在U-Net模型上第二層卷積提取的特征可視化結果, 每個通道的特征都表示為一張圖像. 圖8為肝臟圖像在改進U-Net模型上第二層Inception和SCSE組合模塊提取的特征可視化結果. 根據圖6中專家標注的肝臟標簽可知這張圖像中肝臟位于靠左的位置, 在圖7中U-Net模型上第二層卷積提取的特征中有多個通道的肝臟真實位置的特征丟失, 只有少部分通道的肝臟特征被提取到, 因此傳遞到后面網絡結構的肝臟特征也較少, 從而導致肝臟分割不準確; 而在圖8中本文提出的組合特征提取模塊對于肝臟真實位置的特征提取較多, 因此可傳遞到后面網絡結構更多的肝臟特征, 從而提高肝臟分割的精度. 因此, 網絡模型提取特征的質量影響肝臟分割的結果, 表明本文改進的U-Net網絡模型可提取到較多的有意義特征.

圖6 用于測試的肝臟圖像Fig.6 Liver images used for testing

圖7 U-Net提取的肝臟特征Fig.7 Liver features extracted by U-Net

圖8 改進U-Net提取的肝臟特征Fig.8 Liver features extracted by improved U-Net

表2列出了不同網絡模型的分割指標對比結果. 由表2可見, 改進后的網絡模型相比U-Net在召回率、 精確度和Dice系數3個評價指標上得分均有提高, 改進后網絡模型的召回率、 精確度和Dice系數分別為0.881,0.928,0.896, 較改進前U-Net分別提高5.4%,6.1%,6.7%. 而Attention U-Net在迭代次數相同的情況下達到的分割效果較差, 這是因為該網絡的參數量較大, 短時間內很難收斂, 因此本文提出的網絡模型提高了肝臟MRI的分割精度.

表2 不同網絡模型的評價指標對比

綜上所述, 本文針對U-Net分割過程中局部信息丟失的問題提出了一種基于U-Net的特征提取方法, 該方法將多尺度卷積模塊和空間通道注意力模塊相結合作為特征的提取結構. 多尺度卷積模塊的多個卷積和池化分支可充分提取多維度的特征, 而空間和改進后的通道注意力模塊對提取到的多維度特征進行權重校準, 使重要的特征得到更多關注. 測試集的分割結果表明, 改進后的網絡模型有效改善了U-Net局部信息丟失問題和小肝臟組織分割困難的問題, 提高了肝臟MRI的分割精度.