無人機集群協同搜索跟蹤任務規劃方法

張曉杰, 鄭紀彬, 蘇 濤, 劉宏偉, 高 琦

(1. 西安電子科技大學雷達信號處理國家重點實驗室, 陜西西安 710071;2. 陜西長嶺電子科技有限責任公司, 陜西寶雞 721006)

0 引言

在科學研究和實際應用中,由于在成本、靈活性和機動性能方面的優勢,無人機受到了越來越多的關注。隨著通信與控制技術的發展,無人機集群可以取代單機無人機,帶來分工協作、集群智能化等諸多優勢。無人機集群規模較大,需要高效的決策指揮無人機執行任務。然而,在復雜動態環境中,傳統的任務規劃方法很難使大規模無人機集群發揮出執行任務的優勢。因此,對無人機集群的高效動態任務規劃的需求與日俱增。

真實的戰場環境普遍具有動態和不確定的特征。目前,分布式優化方法的研究已獲得較大進展,較多有效方法被提出,可以較好解決真實戰場環境的任務分配問題,然而從無人機集群的成本和可靠性方面來說,分布式無人機集群難以在危險多變的戰場環境中大規模部署,且分布式優化算法難以求得全局最優解。因此,可有效應對動態戰場環境且能求得全局最優解的集中式優化算法是較優的選擇。

針對集中式無人機集群任務規劃建模,文獻[10]構建了約束滿足問題(Constraint Satisfaction Problem, CSP)模型,文獻[11-12]在CSP基礎上以無人機集群的執行任務成本、飛行時間、危險性和數量作為目標函數和以傳感器類型、任務順序和各項時間等作為約束,構建了適合解決靜態場景下的無人機集群面對已知確定目標的任務規劃模型。第二代非支配排序算法及在其基礎上開發的算法可以很好地解決CSP。然而,真實戰場環境的動態性導致優化問題的目標函數和約束具有動態性,CSP模型難以應對動態優化問題。為有效應對動態戰場環境,動態多目標優化問題(Dynamic Multiobjective Optimization Problems, DMOPs)模型被廣泛研究,該模型適合目標函數隨時間變化的場景。針對該模型,較多的動態多目標進化算法(DMOEA)已經被提出,例如,基于多樣性增強、基于種群預測和基于記憶機制等動態多目標進化算法。然而,DMOPs僅適配目標函數時變而約束不變的動態場景優化問題,無法適應于動態約束的情況。文獻[25]構建了動態約束多目標優化問題(Dynamic Constrained Multiobjective Optimization Problems, DCMOPs)模型,并提出了動態約束多目標進化算法(Dynamic Constrained MOEA, DC-MOEA)。該模型的目標函數和約束都具有時變性,在有效應對時變目標函數的基礎上,所提算法引入了自適應懲罰函數機制,合理利用有價值的不可行個體,得以應對動態約束導致的個體進入不可行區域的問題,從而加快種群收斂并求得最優解。

然而,動態環境發生變化還會導致數量的改變,這是更為棘手的難題。目標函數數量的變化將會改變目標函數域的維度,進而使帕累托前沿面發生擴張或收縮,上述動態優化算法很難處理此種類型變化。針對該問題,文獻[26]構建了目標函數數量可變的動態多目標優化問題模型,該模型可較好地匹配目標函數數量發生變化的優化問題,提出的動態雙檔案進化算法(Dynamic Two-Archive EA, DTAEA)在目標函數發生變化時,可重新構建收斂性種群和多樣性種群,適應目標域的維度變化,同時維持加速種群收斂。相關研究證明該算法也可同時應對時變目標函數的問題。然而,該算法僅能有效應對目標函數的動態變化,未考慮約束時變和數量動態變化對求解優化問題的影響,導致在環境發生動態變化時,大量先前可行解進入不可行區域,可行解不足,影響優化問題求解速度。

針對以上問題,為有效應對無人機集群協同搜索跟蹤的動態場景,本文構建了動態多約束多目標優化問題(Dynamic Multiconstraint Multiobjective Optimization Problems, DMCM-OPs),該模型適用于目標函數與約束的數量動態變化且時變的復雜場景。為有效求解DMCMOPs,本文提出了基于動態自適應懲罰的動態約束雙檔案進化算法(Dynamic Constraint Two-Archive EA, DCTAEA),該算法同時維持兩個種群,平衡種群多樣性和收斂性,同時,在收斂性種群更新時引入自適應懲罰函數機制,整合不可行個體的目標函數值和違反約束的懲罰值獲得修正目標函數值,并作為不可行個體的選擇依據。根據可行個體所占比率動態調整不可行解的約束違反值和目標函數值在修正的目標函數值中所占比重,使得有價值不可行個體獲得競爭機會,促使種群進入可行區域并向帕累托前沿面收斂。仿真結果證明,相比第二代非支配排序遺傳算法(NSGA-II)的動態版本、基于分解的多目標進化算法(MOEA/D)、約束雙檔案進化算法(CTAEA)和動態雙檔案進化算法(DTAEA),本文所提算法能更加有效地解決動態多約束多目標優化問題,實現動態環境下的無人機集群高效任務規劃。

1 物理場景描述

1.1 無人機描述

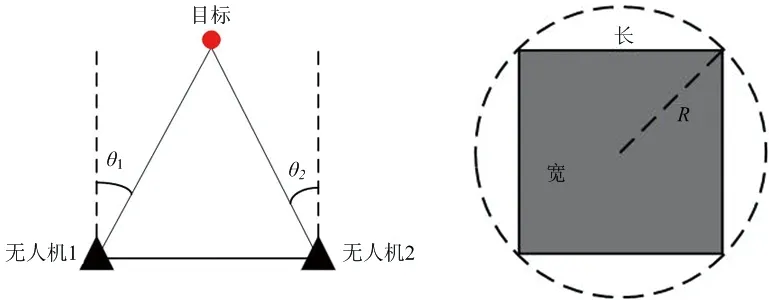

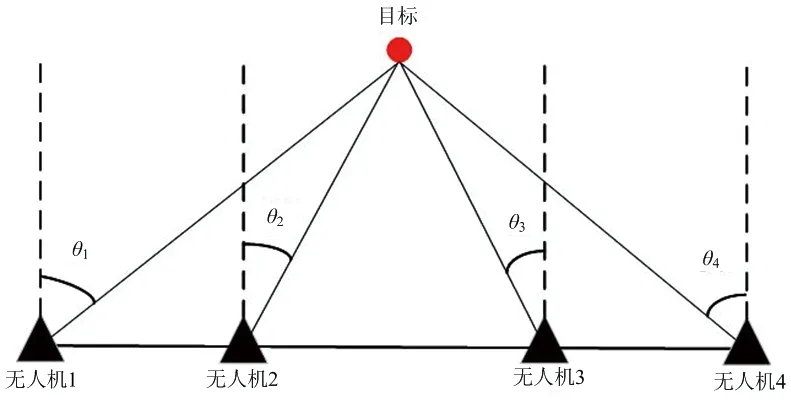

考慮到戰場環境的復雜性和危險性,以及無人機負載重量和自身攜帶的電池能量的限制,無人機裝備被動偵察系統,采用測向交叉定位方式對目標進行定位。無人機搜索編隊由兩架無人機組成,通過被動測向交叉定位方法粗略地確定目標位置,如圖1(a)所示。搜索編隊的有效探測范圍可以看作半徑為的圓,如圖1(b)所示,在此范圍內的目標可以被無人機搜索編隊發現。為了簡化場景模型,我們把搜索編隊的有效探測范圍視為半徑為的圓的內接正方形。此外,目標跟蹤需要更精確的定位精度,且面臨危險性變高,設置無人機跟蹤編隊由4架無人機組成,如圖2所示。

(a) 搜索編隊交叉定位示意圖 (b) 無人機編隊探測范圍示意圖圖1 無人機編隊定位示意圖

圖2 跟蹤編隊交叉定位示意圖

為方便無人機集群協同搜索跟蹤任務規劃方法設計,本文作出以下假設:

1) 集群中無人機是同構的并且每架無人機都能通過編隊執行搜索和跟蹤任務;

2) 無人機能以固定速度飛行或盤旋在空中,飛行和盤旋狀態可以在可忽略的極短時間內轉換,且具有相同飛行自持力;

3) 中央控制站覆蓋的通信覆蓋范圍以及與無人機集群的通信帶寬可以滿足任務要求;

4) 在無人機搜索或跟蹤編隊到達某個有效探測范圍的中心,并懸停一定時間,則表示對該范圍內的目標進行有效搜索和跟蹤任務。

1.2 離散任務區域描述

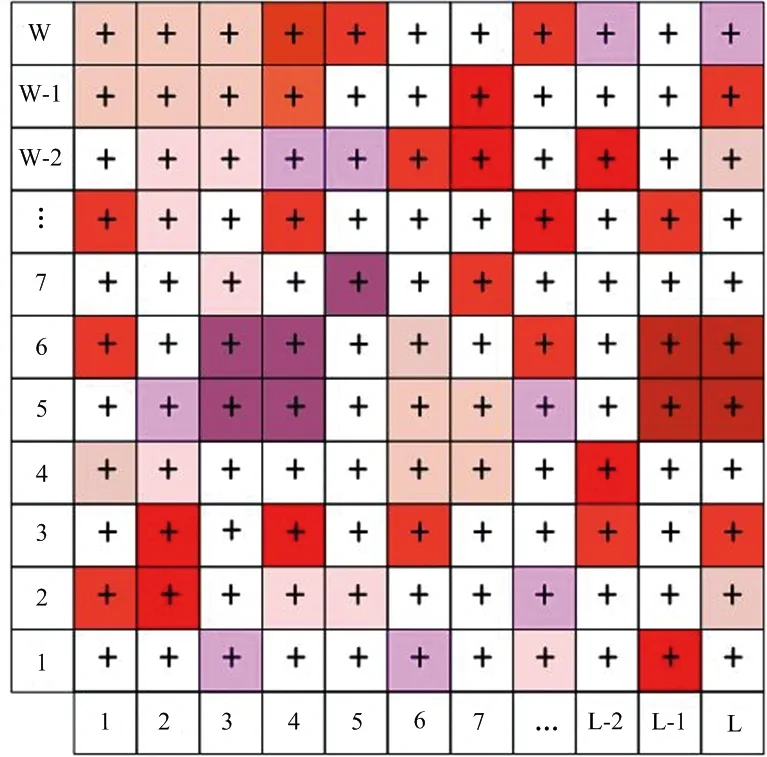

真實戰場環境為三維空間區域,但是無人機的運動可以解耦為二維平面和垂直方向上的運動。因此,本文使用水平方向的二維平面來描述戰場環境。任務區域被建模為由*=個正方形網格區域構成的戰場整體,戰場環境網格化如圖3所示。每個正方形網格區域代表無人機搜索跟蹤編隊的有效探測范圍。因此,有個搜索任務要執行。無人機的運動可以視為網格離散中心之間的運動。

圖3 戰場離散網格區域及其初始化威脅示意圖

由回報函數的啟發,本文提出威脅度函數的概念。在無人機集群執行任務前,預警機或衛星可以提供戰場的先驗信息,根據先驗信息,計算出每個網格區域的初始威脅度和威脅度變化函數。網格區域的顏色越深代表該網格區域威脅值越大。

戰場網格區域在時刻的威脅函數和所有網格在時刻總威脅值函數表達式分別為

(1)

(2)

(3)

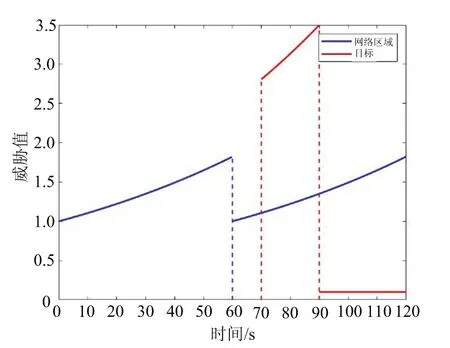

式中,表示目標的威脅值的初始化因子,表示目標的威脅等級相關參數,表示跟蹤編隊對目標建立跟蹤后該目標的常數威脅值。圖4表示網格區域和發現目標威脅度隨時間的變化情況。其中藍色線條表示某網格區域在第60 s被無人機搜索編隊搜索完畢,根據公式(2),該區域的威脅值降低,而隨著搜索編隊離開,威脅值上升。紅色線條表示在70 s時刻發現的目標并在90 s時刻跟蹤編隊開始對該目標進行跟蹤的威脅值變化情況。

圖4 網格區域和目標威脅度隨時間變化示意圖

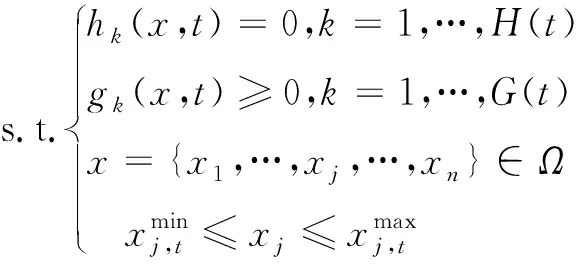

1.3 協同搜索跟蹤規劃描述

戰場場景時刻發生動態變化,戰場場景所構建的戰場離散網格區域威脅值函數是時變的,無人機集群在執行戰場覆蓋搜索任務的過程中隨時會發現不可預測的目標,使無人機集群的任務性質發生改變。由下述2.2、2.3和2.4節可知,上述兩大動態變化因素,導致任務規劃問題的目標函數和約束發生動態變化,進而使得已求得的任務規劃方案在動態變化后的場景中不再是最優解,無人機集群不能高效執行任務。

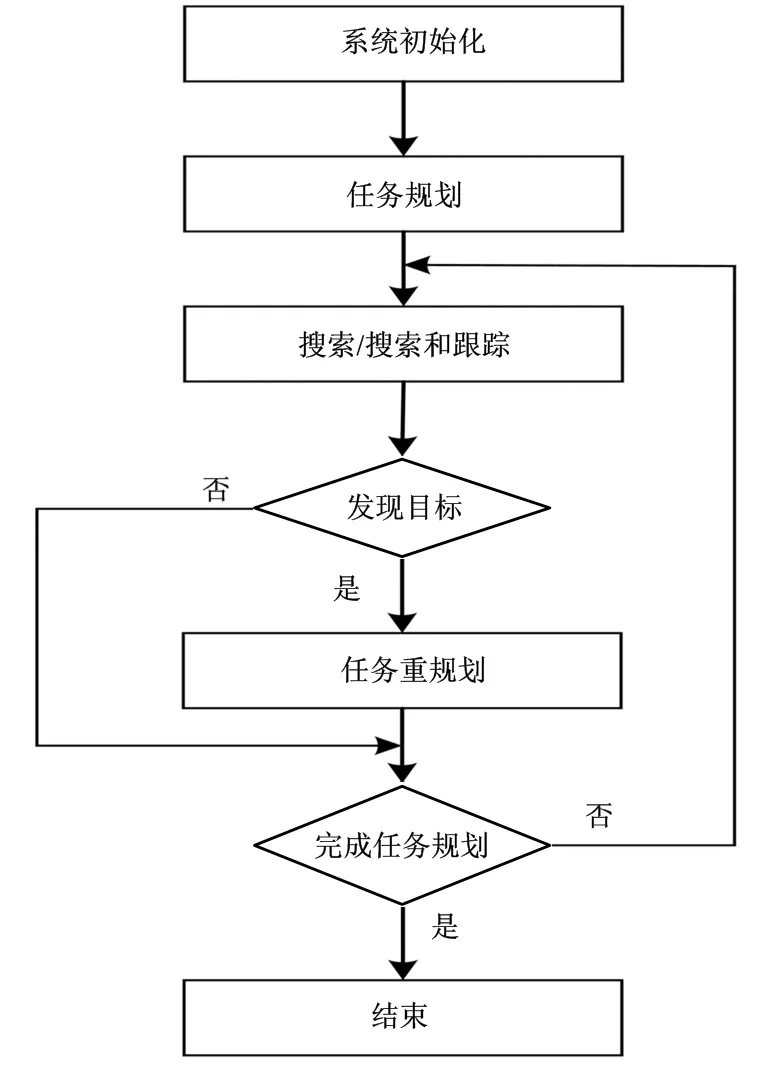

針對上述問題,本文提出了無人機集群協同跟蹤搜索任務規劃方法,流程圖如圖5所示。無人機集群按照初始任務規劃方案執行戰場覆蓋搜索任務,一旦戰場環境發生變化,則需要求解新的任務規劃方案。該方法的難點在于建立符合真實戰場環境的動態任務規劃問題模型,以及快速求解最優任務規劃方案。因此,下文將對符合戰場要求的復雜動態優化問題模型和動態優化問題求解算法展開研究。

圖5 協同搜索跟蹤規劃流程圖

2 協同搜索跟蹤任務規劃模型

真實的戰場環境普遍具有動態和不確定的特征,時刻變化的網格區域威脅值函數和發現的威脅目標導致構建的任務規劃優化問題模型的目標函數和約束時變且數量變化。然而,CSP、DMOPs、DCMOPs和目標函數可變的動態多目標優化問題等模型不適用于目標函數和約束時變且數量變化的復雜場景。對此,本節構建了DMCMOPs模型,可以有效應對動態戰場環境任務規劃所面臨的目標函數與約束時變且數量變化的難題。下文將詳細闡述構成該優化問題模型的決策變量、目標函數和約束。

2.1 任務規劃問題的決策變量

決策變量是優化問題中與目標函數和約束有關的變量。在無人機集群協同搜索跟蹤任務規劃問題中,決策變量決定了無人機編隊執行哪些任務和執行任務的順序,而決策變量的變化影響了任務規劃方案的優劣。本文提取的兩個決策變量如下所示:

1) 任務分配變量:以兩架無人機組成的搜索無人機編隊作為基本單位,此變量表示為*維的二進制矩陣。當且僅當分配向量[,]=1時,任務被分配給了無人機編隊。

2) 任務執行順序變量:定義了每個無人機編隊執行所分配任務的順序。如果集合{1,2,3,4}是分配給編隊執行的任務,則定義Γ={1,3,4,2}表示編隊執行任務集合{1,2,3,4}的順序。

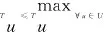

2.2 規劃問題的目標函數

最優規劃方案通過同時優化一組相互沖突的目標函數構成的帕累托最優解驅動。復雜優化問題的目標函數不是唯一的,根據無人機集群協同搜索任務規劃問題設置3個評價任務規劃方案優劣的目標函數。

1) 戰場所有網格區域在任務規劃執行期間的最小威脅值定義為

(4)

式中,和分別為執行任務規劃起始時刻和結束時刻。

2) 最短飛行時間 規劃執行結束的無人機最短飛行時間:

min

(5)

3) 最短建立跟蹤時間 從發現目標到對該目標建立跟蹤的最短時間:

(6)

2.3 規劃問題的約束

約束是從現實問題提取的必須滿足的條件,同時也決定了任務規劃方案是否可行。根據實際問題,本文提取了4個戰場和無人機約束條件。

1) 避免碰撞約束 考慮無人機編隊之間的安全距離以避免編隊之間相互碰撞,編隊內的無人機相互之間可視為始終保持安全距離:

()>,=1,…,;≠

(7)

2) 威脅值約束 常數,max表示所能接受的網格區域威脅值上限要求:

(,)≤,max,∈

(8)

3) 飛行時間約束 無人機滿足執行完任務安全返回的飛行時間限制:

(9)

4) 已發現的目標威脅值約束 常數表示所能容忍的已發現的目標的威脅值上限。目標在時刻的威脅值(,)應小于常數,公式表示如下:

(,)≤,∈

(10)

2.4 搜索跟蹤動態任務規劃問題數學表征

根據1節和2節所述,在發現目標前,無人機集群需要對戰場網格區域進行戰場覆蓋式搜索,此時建立的優化問題數學表征:

min

s.t.()>,=1,…,;≠

,≤,max,∈

(11)

一旦無人機集群搜索編隊發現目標,則無人機集群的任務性質發生變化,即從純粹的戰場覆蓋式搜索轉為在戰場覆蓋式搜索和對已發現目標進行精確跟蹤。無人機集群任務性質的轉變導致優化問題數學表征動態調整。無人機集群協同搜索跟蹤任務規劃的優化問題數學表征為

min

s.t. d()>,=1,…,;≠

,≤,max,∈

target,≤,∈

(12)

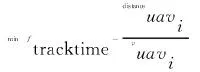

相較于單純的搜索任務規劃優化問題數學表征式(11),優化問題數學表征式(12)增加了目標函數公式(6)與約束函數式(10)。其中目標函數式(6)目的在于促使無人機集群盡快對已發現的目標建立跟蹤,約束式(10)可以將已發現目標的威脅值限定在安全范圍內。由公式(11)到公式(12)的變化本質是DMCMOPs,如下式所示:

min(,)=((,),…,(,),…,()(,))

(13)

式中(,)和(,)分別為等式約束和不等式約束,()表示目標函數的數量,()和()表示等式約束和不等式約束的數量。

相比CSP、DMOPs、DCMOPs和目標函數可變的動態多目標優化問題模型,公式(13)構建的DMCMOPs模型目標函數和約束發生時變且數量變化。然而,現有算法解決DMCMOP時存在難以應對該模型的復雜動態變化的難題,對此,下一節將提出一種針對目標函數和約束發生時變且數量變化的優化問題的動態優化算法。

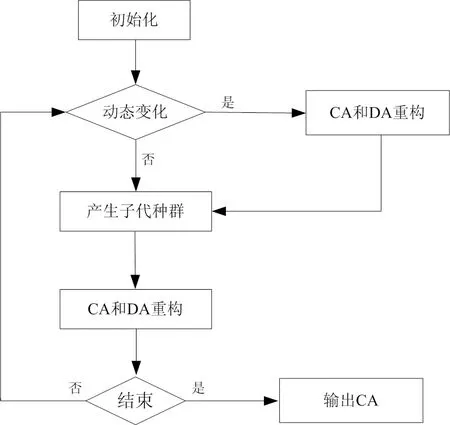

3 動態約束雙檔案進化算法

DMCMOPs模型的目標函數和約束具有時變且數量變化的動態特征,針對目標函數的動態變化,文獻[26]提出了DTAEA,然而該方法很難同時應對目標函數和約束的動態變化。目標函數和約束同時發生動態變化時,不僅會導致目標函數域維度和種群收斂性、多樣性的變化,還會使大量種群個體落入不可行區域,導致可行個體數量不足,影響種群收斂。本節針對DMCMOPs模型求解難題,提出了一種基于動態自適應懲罰機制的動態雙檔案進化算法(DCTAEA),該算法核心部分在于維護兩個相互協作檔案,即CA和DA,CA起主要作用,在CA更新過程中,當可行性個體不足時,通過引入的動態自適應懲罰機制整合不可行個體的目標函數值和違反約束的懲罰值獲得修正目標函數值,根據可行個體所占比率動態調整不可行解的約束違反值和目標函數值在修正的目標函數值中所占比重,使得有價值不可行個體獲得競爭機會,促使種群進入可行區域并向帕累托前沿面收斂;DA增強種群多樣性,更新過程中探索CA未開發區域。算法流程圖如圖6所示,當環境發生變化時,CA和DA重新構建種群,改變目標域的維度,使得種群更快地適應新環境。環境未發生改變時,直接產生CA和DA子代種群,CA和DA在每次迭代過程中更新各自種群。重復上述過程直到種群收斂獲得最優解。

圖6 DCTAEA流程圖

在公式(13)所示的優化問題模型中,目標函數發生動態變化,導致目標函數域的維度改變,采用文獻[26,32]的方法重構種群,改變目標域維度,加快適應新環境。重構的CA和DA產生子代種群后通過迭代更新使種群收斂, CA和DA的側重點不同。因此本節將分別闡述CA和DA的更新方法。

3.1 CA的更新方法

DTAEA很難應對DMCMOPs模型的約束發生動態變化導致的大量種群個體落入不可行區域的問題。可行個體數量的不足影響了種群的進化,本小節在DTAEA的CA更新方法中引入動態自適應懲罰機制,整合不可行個體的目標函數值和違反約束的懲罰值獲得修正的目標函數值,并作為不可行個體的選擇依據,充分利用有價值的不可行個體,促使種群進入可行區域并向帕累托前沿面收斂。

CA和子代種群的個體數量都為,結合形成個體數量為2*的種群。由于DMCMOPs模型約束的動態變化,導致部分動態變化前的可行解變為不可行解,CA種群部分個體進入不可行區域,中可行個體的集合記為種群,此時數量往往小于,可行個體數量的不足嚴重影響CA的收斂。針對約束動態變化導致可行個體數量的不足影響種群收斂的問題,本小節在CA的更新中引入動態自適應懲罰機制,通過自適應整合歸一化目標函數和歸一化約束違反值獲得不可行解的修正目標函數。動態自適應懲罰機制取決于解的價值(即該解的目標函數值和約束違反值的大小)和種群中可行性解的比率。種群中可行性解的比率較低時,不可行解的約束違反值所占權重較大,約束違反值對不可行解的選擇起較大作用。種群中可行性解的比率較高時,則目標函數值對不可行解的選擇起較大作用。在DMCMOPs發生動態變化時,自適應懲罰機制為具有小目標函數值和小約束違反值的有價值解提供較大參與進化競爭的可能性,進而充分利用可行解和有價值的不可行解共同探索最優解。

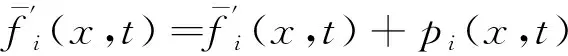

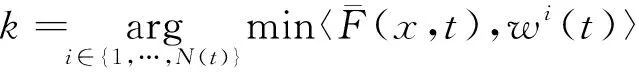

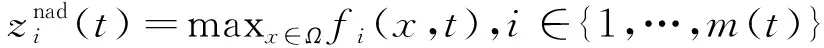

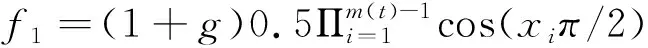

不可行解的第維度歸一化修正目標函數值如下式所示:

(14)

其中,第維目標函數的自適應懲罰值為

(15)

(16)

式中,(,)和(,)分別為不等式約束和等式約束的約束違反值。

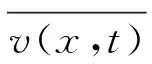

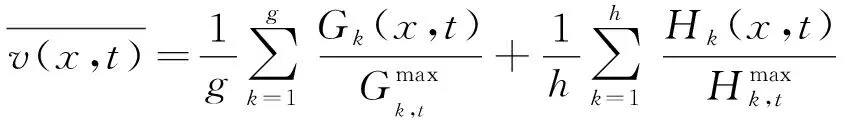

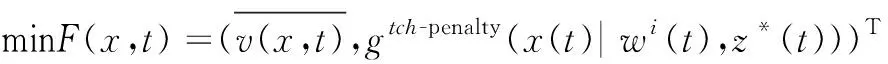

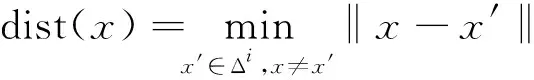

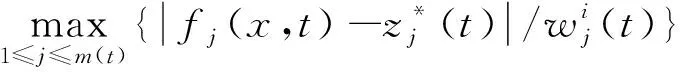

為了挑選有價值的不可行解,需要建立優化問題作為選擇標準。依據不可行個體的歸一化約束違反值和切比雪夫分解函數值建立二維目標優化問題如下式:

(17)

式中,

-penalty(()|(),())=

(18)

優化問題的目標函數和約束發生動態變化后,隨著CA的更新次數增加,中可行個體數量也隨之增加,可行個體數量不再小于。如果CA更新時中個體數量等于則CA更新完畢,如果中個體數量大于,參照文獻[25,30],執行以下操作。

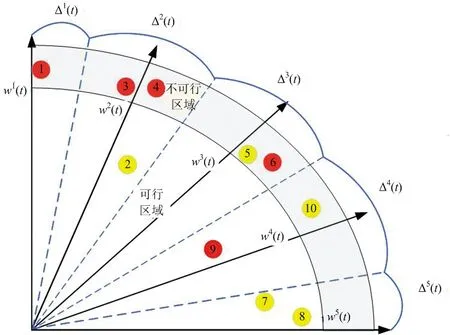

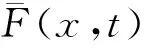

根據文獻[26,33]生成一組均勻分布的權重向量(),如下式所示:

()={(),…,()()}

(19)

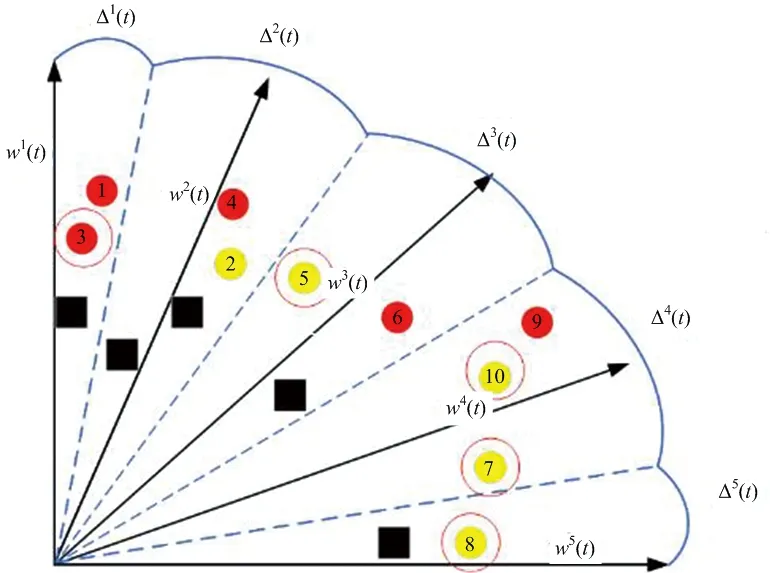

權重向量()將目標空間劃分為()個子空間。圖7表示二維目標函數空間的子空間劃分和CA個體的分布示意圖。圖中CA (圖7黃色個體)和子代種群(圖7紅色個體) 組成種群,在可行空區域的個體集合組成種群。每個子空間由唯一的權重向量代表,子空間Δ(),∈{1,…,()}如下式所示:

Δ()={(,)∈R()|〈(,),〉≤〈(,),〉}

(20)

式中,∈{1,…,()},〈(,),()〉表示(,)與和原點之間連線的垂直距離。

圖7 二維目標函數空間的子空間劃分和CA個體的分布示意圖

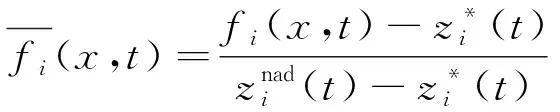

CA和子代的所有個體按照子空間分區,個體與唯一的子區域相關聯,其所在的子區域為

(21)

(,)=((,),…,()(,))

(22)

并且,

(23)

式中,()為目標域各維度估計的最小值,表示如下:

(24)

式中,

(25)

()為目標域各維度的最大值,表示如下:

(26)

式中,

(27)

計算每個子空間的個體密度。根據公式(19)~(21) 計算出子空間存在的可行個體數量,得到個體密度最大的子空間Δ。個體之間的相互距離越近,擁擠度越大,種群的多樣性也越差。為了提高種群多樣性,需要從密度最高子空間中選出相互距離最近的個體集合。計算子空間Δ里個體之間的相互距離:

(28)

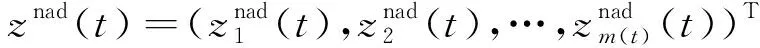

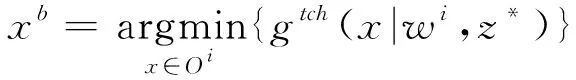

相互距離最小的個體存入中,下一步根據切比雪夫分解方法計算最劣個體并舍棄直至種群個體數量等于。最劣個體表示如下:

(29)

其中,

(()|(),())=

(30)

優化問題的目標函數和約束發生動態變化后,可行解的數量不足,影響種群收斂。引入動態自適應懲罰機制,充分利用了有價值的具有合適目標函數值和低約束違反值的解,促進不可行解向可行區域移動,加速CA種群收斂。

3.2 DA的更新方法

DA作為CA的輔助角色,不考慮約束導致的個體是否可行。DA 的作用是探索 CA 尚未開發空間,提高了可行區域內 CA 的種群多樣性,并且有助于跳過局部最優或局部不可行區域。本小節參照文獻[26,30], 給出DA的更新步驟。

同CA的更新機制類似,首先將DA與子代種群結合組成種群,然后依次探索每個子空間,找到最優個體。最優個體定義為:將更新的CA作為參考集,在第(1≤≤)次迭代中,如果子空間Δ已經存在個及以上的CA個體或中沒有與當前正在研究的子空間相關的解,則在此迭代期間不再探索該子空間并直接移動到下一個子空間。否則,將選擇與當前探索的子空間相關的中的最佳非支配解,將其視為在新形成的 DA 中的一員。其中,當前子空間的最佳解定義為

(31)

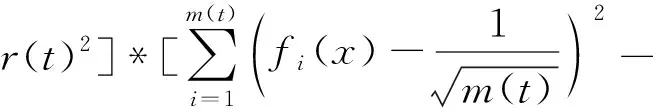

圖8表示DA更新過程中的目標域空間CA和DA的父代子代個體分布。其中黃色和紅色個體分別為DA種群的父代和子代,黑色方塊代表CA種群的個體。在第一次迭代期間,空間Δ到Δ和Δ都存在CA個體,所以直接跳過,對空間Δ,依據公式(23),選擇個體7作為最優解劃入CA。在第二次迭代期間,空間Δ存在CA的兩個個體,所以依然跳過該空間,其余空間分別選擇個體3,5,10,8作為最優個體劃入DA。此時DA數量種群達到要求,DA更新完畢。

圖8 二維目標函數空間的子空間劃分和CA及DA個體的分布示意圖

以上是本文所提DCTAEA,本文算法針對目標函數和約束的動態變化,通過重建CA和DA種群,增加種群多樣性,快速適應新的環境。在CA的更新過程中引入動態自適應懲罰機制,整合不可行個體的目標函數值和違反約束的懲罰者獲得修正的目標函數值,充分利用有價值的不可行個體,促使不可行個體向可行區域移動,有利于加快CA收斂,解決了動態約束導致的種群可行個體不足導致的種群難以收斂問題。DA在更新時輔助增強多樣性,探索CA未開發的空間,有助于獲得最優解。

4 實驗設置與結果分析

本文所提算法在解決目標函數和約束時變且數量變化的優化問題能更快適應動態變化,加快種群收斂,獲得Pareto前沿面。在發生目標函數和約束的動態變化時,通過CA和DA種群重建增強多樣性。在CA的更新過程中,引入動態自適應懲罰機制,整合不可行個體的目標函數值和違反約束的懲罰者獲得修正的目標函數值,充分利用有價值的不可行個體,促使不可行個體向可行區域移動,有利于加快種群收斂,求得最優解。本文通過比較所提算法與4種對比算法求解基準測試問題的結果對比證明了所提算法的有效性和優越性。本節將介紹基準測試問題、性能指標以及仿真結果對比分析。

4.1 基準測試問題

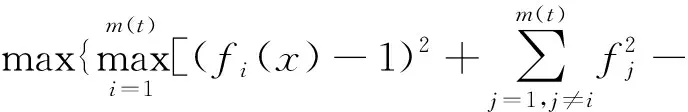

為了測試所提算法的有效性和優越性,選取了類型Ⅱ約束測試問題C2-DTLZ2的約束和F2型動態多目標函數測試問題結合組成的基準測試問題DC2-F2,該測試問題同實際問題相似。其中,類型Ⅱ約束表示如下:

()]}

(32)

F2目標函數表示如下:

(sin(()-+1π2))()=(1+)sin(π2)

(33)

式中,()表示約束和目標函數在時刻的數量。

4.2 性能指標

在本小節中,介紹了反向世代距離(IGD),和平均反向世代距離(MIGD),可以同時衡量算法所得的Pareto最優解集的收斂性和多樣性。

(34)

由公式(34)可知,所得Pareto最優前沿的IGD值越小,該解集越靠近真實前沿、分布越均勻。

4.3 仿真結果分析

為了驗證本文提出的DCTAEA針對DMCMOPs的有效性和優越性,將DCTAEA與以下4種優化算法進行對比:

1) NSGA-II:第二代非支配排序遺傳算法;

2) MOEA/D:一種基于分解的多目標進化算法;

3) CTAEA:用于約束多目標優化的雙檔案進化算法;

4) D-TAEA:動態雙檔案進化算法。

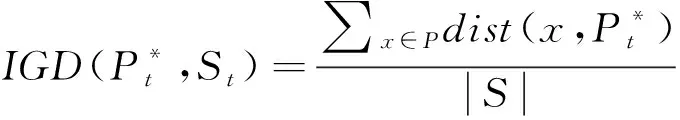

考慮DMCMOPs面臨的主要問題為目標函數和約束的時變和數量變化問題,而時變性已在公式(32)~(33)體現,只需設置目標函數和約束數量()的變化:

(35)

上式表示優化問題以=1時刻為初始,種群經過300次的迭代進化后,依次經歷4次動態變化。動態變化的頻率由參數決定,=25表示種群每進化25代,環境發生一次動態變化。設置種群的個體數量為300,每個算法獨立運行31次,求得反向時代距離的平均值,獲得種群在整個動態變化過程中的IGD軌跡。

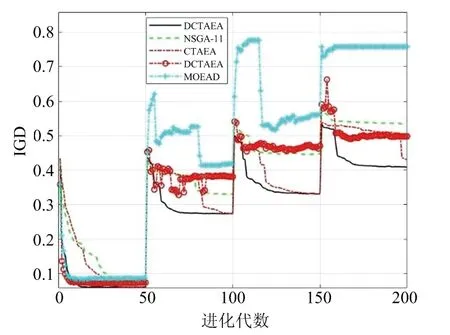

本文提出的DCTAEA及其4種對比算法在=25時求解DMCMOPs獲得IGD軌跡如圖9所示。從圖中可以看出,本文所提算法DCTAEA 在大部分時間都顯示出最佳性能,能在每次動態變化后經過種群進化獲得最小的IGD值,并且其IGD動態變化軌跡最平緩,在每次種群進化過程中IGD保持持續變小趨勢,不會發生劇烈變化。所提算法通過動態自適應懲罰機制可以更好地同時應對目標函數和約束時變及數量的變化,因此相比僅針對目標函數動態變化的D-TAEA顯示出較大優勢。同時,由于CTAEA不能隨著變化對CA和DA重構,所以其應對優化問題目標函數和約束的時變及數量動態變化反應較慢。而NSGA-II和MOEA/D作為普通優化問題求解算法,沒有動態應對機制,求解DMCMOPs效果較差。這意味著本文所提算法能有效應對動態優化問題的目標函數和約束時變且數量變化帶來的影響,特別是引入的動態自適應懲罰機制使得算法增強了應對約束的動態變化的能力,在求解DMCMOPs時能快速收斂,求得的帕累托前沿面更加靠近真實的帕累托前沿面。此外,注意到在第一次動態變化發生后,DCTAEA 的優勢并不明顯,這是因為此時目標函數數量較少,其他算法也具有較快收斂速度。然而,隨著目標函數的增多,DCTAEA優勢逐漸顯現。

圖9 τt=25時整個進化過程IGD的軌跡

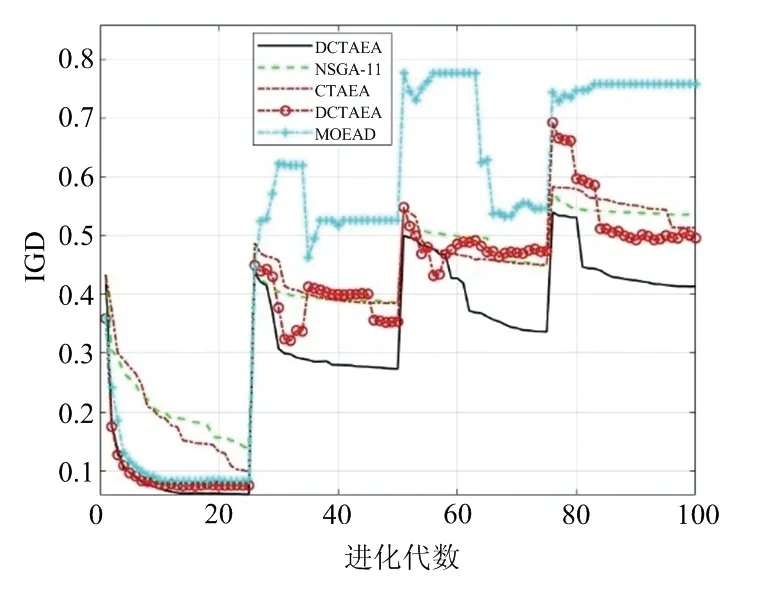

圖10和圖11也顯示了所提算法相對其他算法的有效性和優越性。然而,可以發現D-TAEA經過一定的進化步數能達到和所提算法相同的IGD指標值,DCTAEA不再獲得全程優勢。這是因為隨著增大,即優化問題發生動態變化的間隔增大,算法有更加充足的時間應對變化。但是本文所提算法依然具有收斂速度最快的優勢,從而能更好地應對DMCMOPs。

圖10 τt=50時整個進化過程IGD的軌跡

圖11 τt=100時整個進化過程IGD的軌跡

5 結束語

為了提高無人機集群在復雜動態環境下的執行協同搜索跟蹤任務的效率,克服傳統優化問題模型面對目標函數和約束存在復雜動態變化不適用的難題,本文構建了目標函數和約束時變且數量變化的動態優化問題模型。為了求解該問題,提出了基于動態自適應懲罰機制的動態約束雙檔案進化算法所提算法可以隨著環境變化自適應重建種群,加快種群適應新的環境,引入自適應懲罰函數機制,整合不可行個體的目標函數值和違反約束的懲罰值獲得修正的目標函數值,動態調整不可行解的約束違反值和目標函數的比重,實現有價值不可行解的利用,促使種群進入可行區域并向帕累托前沿面收斂。仿真結果表明,與第二代非支配排序遺傳算法的動態版本、基于分解的多目標進化算法、約束雙檔案進化算法和動態雙檔案進化算法相比,本文所提算法具有優越性,能使種群在新的環境下更快收斂。