基于RSKP-UNet模型的苗族服飾圖案分割研究

張博源, 黃成泉, 王 琴, 萬林江, 周麗華

(貴州民族大學(xué) a.數(shù)據(jù)科學(xué)與信息工程學(xué)院; b.工程技術(shù)人才實(shí)踐訓(xùn)練中心,貴陽 550025)

少數(shù)民族是中華民族的重要組成部分,并且在其發(fā)展歷程中開創(chuàng)出各自的文化底蘊(yùn)。少數(shù)民族服飾是少數(shù)民族特有的文化符號(hào)之一,而少數(shù)民族服飾圖案是少數(shù)民族人民心血和智慧的結(jié)晶,這些圖案元素代表了他們對(duì)民族文化的認(rèn)同和美好愿望的期許,更是象征其文化的傳承和延伸。但是受現(xiàn)代流行文化的沖擊,少數(shù)民族服飾文化逐漸式微,研究少數(shù)民族服飾圖案對(duì)研究少數(shù)民族的歷史變遷和文化特性有著重大意義。少數(shù)民族服飾圖案分割作為研究少數(shù)民族服飾文化的首要工作,是其重中之重,而少數(shù)民族服飾圖案有色彩艷麗、元素復(fù)雜、紋飾多樣等特點(diǎn)。因此,對(duì)少數(shù)民族服飾圖案分割存在較大難度,目前對(duì)少數(shù)民族服飾圖案分割的特征進(jìn)行抽離、分類、識(shí)別和保存方面的研究還很少。

自VGG模型的提出,隨著計(jì)算機(jī)算力的快速提升,近年來基于深度學(xué)習(xí)的研究方法在醫(yī)學(xué)、自動(dòng)駕駛、人工智能等領(lǐng)域取得重大突破,尤其在圖像分類、目標(biāo)檢測(cè)、圖像分割等計(jì)算機(jī)視覺任務(wù)中收獲頗豐。2015年,SHELHAMER等[1]提出全卷積神經(jīng)網(wǎng)絡(luò)模型實(shí)現(xiàn)圖像語義分割,越來越多的基于深度學(xué)習(xí)的圖像分割模型被提出。比較經(jīng)典的基于深度學(xué)習(xí)的分割模型有U-Net模型[2]、FusionNet模型、Deeplabv3+模型[3]及Attention-UNet模型等,這些研究方法目前通常被用于研究醫(yī)學(xué)圖像、自然圖像及合成圖像等,而諸如Mask Transfiner模型、Swin Transformer模型[4]及SETR[5]模型等,通常只適合應(yīng)用在大規(guī)模圖像數(shù)據(jù)集。在少數(shù)民族服飾分割研究領(lǐng)域,覃琴等[6]提出一種基于漸進(jìn)式注意力學(xué)習(xí)的多尺度深度學(xué)習(xí)模型用于苗族服飾圖像語義分割研究,并且取得了不錯(cuò)的研究成果,但是不能實(shí)現(xiàn)對(duì)苗族服飾圖案的細(xì)節(jié)分割。趙海英等[7]針對(duì)傳統(tǒng)服飾圖像提出一種基于卷積注意力特征的殘差期望最大化注意力語義分割網(wǎng)絡(luò)模型,實(shí)現(xiàn)了對(duì)傳統(tǒng)民族服飾圖案的語義分割,具有較強(qiáng)的借鑒意義。馮潤(rùn)等[8]提出一種基于模糊擬合圖像驅(qū)動(dòng)的苗族服飾圖像分割算法,能夠?qū)崿F(xiàn)對(duì)苗族服飾圖案較為精細(xì)的分割,并且分割效果不錯(cuò)。

針對(duì)以上問題,為保護(hù)少數(shù)民族服飾文化的傳遞,同時(shí)為了增加對(duì)少數(shù)民族服飾文化的研究為目的,本文以苗族服飾圖案分割為研究目標(biāo)。苗族服飾圖案通常具有如下特點(diǎn):1) 大多苗族服飾圖案的內(nèi)容豐富奇妙,多以山川、鳥獸、花卉為主體,同時(shí)穿插各種自然圖騰、線條、紋飾,因此苗族服飾圖案通常極為復(fù)雜,遍布各種元素內(nèi)容。2) 設(shè)計(jì)上美觀巧思、大膽前衛(wèi),同時(shí)色彩搭配考究。苗族服飾圖案的構(gòu)圖布局變幻莫測(cè),苗族服飾圖案上的內(nèi)容常以對(duì)稱式、環(huán)繞式、左右式、中心式為主。而在色彩使用上多是鮮艷明亮為主,同時(shí)搭配上冷色調(diào)的背景,從而使各元素內(nèi)容主次分明,錯(cuò)落有致。因此苗族服飾圖案同時(shí)兼具構(gòu)圖多樣,色彩豐富的特點(diǎn)。3) 苗族服飾通常工藝復(fù)雜,一種工藝一般包含多種工序,現(xiàn)有蠟染、刺繡、織花等工藝,在紡織時(shí),有時(shí)數(shù)種工藝交替使用,因此苗族服飾圖案大多風(fēng)格迥異,不盡相同,無特定規(guī)律可循。結(jié)合上述苗族服飾圖案的特點(diǎn),苗族服飾圖案分割具有較大的挑戰(zhàn)性,于是本文提出了一種融合U-Net模型和注意力機(jī)制的RSKP-UNet(Residual Selective-Kernel Parallel U-Net)模型用于苗族服飾圖案分割研究,并且引入了一種基于IoU的損失函數(shù)[9],利用馮潤(rùn)等[8]的研究成果制作苗族服飾圖案人工數(shù)據(jù)集,然后使用提出的模型在數(shù)據(jù)集上進(jìn)行訓(xùn)練和驗(yàn)證。

1 算法原理

1.1 RSKP-UNet模型

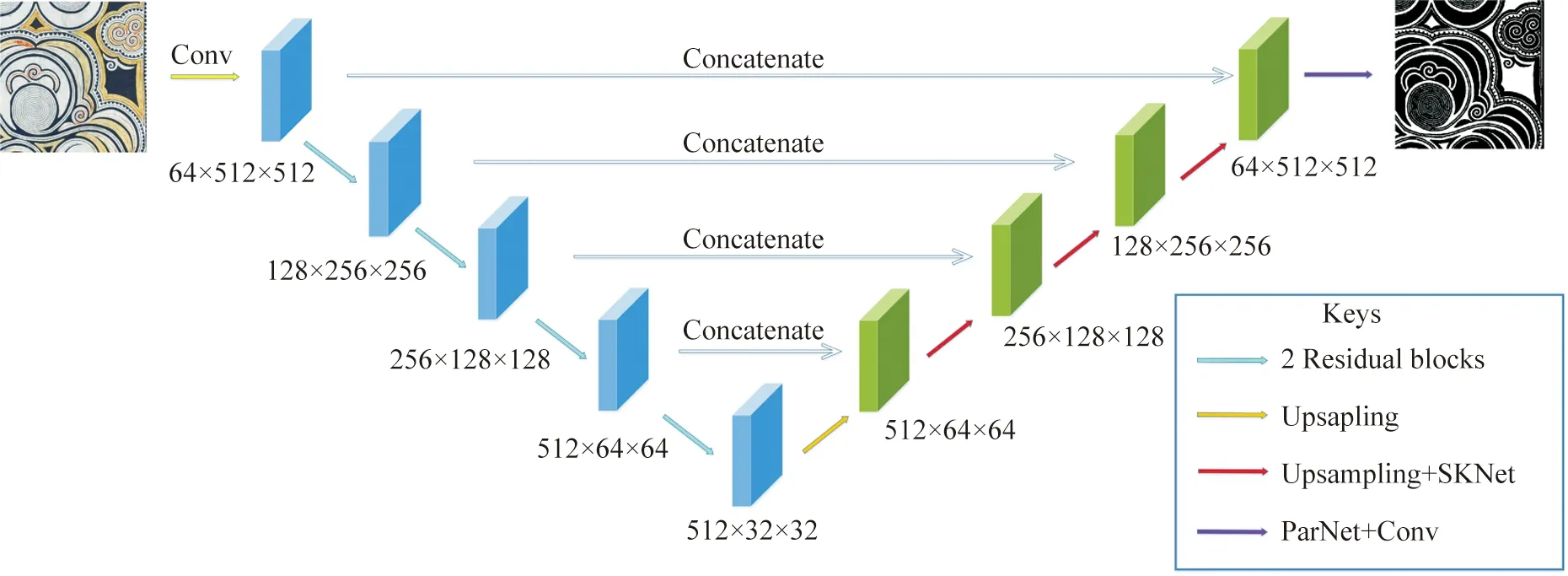

U-Net模型作為醫(yī)學(xué)領(lǐng)域最常用的圖像分割模型,存在模型輕量化的優(yōu)點(diǎn),方便進(jìn)行部署,可以針對(duì)特定的任務(wù)進(jìn)行改進(jìn),并且該模型能夠在小規(guī)模圖像數(shù)據(jù)集上進(jìn)行訓(xùn)練,仍然可以獲得不錯(cuò)的圖像分割效果。于是本文在U-Net模型基礎(chǔ)上對(duì)其進(jìn)行適當(dāng)改進(jìn),然后提出了針對(duì)苗族服飾圖案分割研究的RSKP-UNet模型。基于RSKP-UNet的苗族服飾圖案分割模型如圖1所示。

圖1 RSKP-UNet模型的整體網(wǎng)絡(luò)結(jié)構(gòu)Fig.1 Overall network structure of the RSKP-UNet model

U-Net模型整體上可以分為兩個(gè)部分,分別是編碼器部分和解碼器部分,編碼器部分的作用是用于對(duì)輸入的圖像進(jìn)行特征提取,以此逐步獲得高階語義信息,解碼器部分的作用是進(jìn)行跨尺度的特征融合并輸出預(yù)測(cè)的結(jié)果。本文首先改進(jìn)的地方是在U-Net模型的編碼器,U-Net模型中除了第一個(gè)卷積塊,將編碼器中用于下采樣的卷積塊替換為ResNet模型[10]中的Residual模塊組,每個(gè)Residual模塊組包含兩個(gè)Residual模塊,第一個(gè)Residual模塊用于下采樣獲取高階語義信息,第二個(gè)Residual模塊起到加快特征傳遞和防止模型過擬合的作用。然后,改進(jìn)的地方是在U-Net模型的解碼器,在解碼器部分中的前三次拼接后加入SKNet(Selective Kernel Networks)模型[11]中的SKNet模塊,SKNet模塊的作用是抑制上采樣過程中產(chǎn)生的特征圖中的不相關(guān)的特征信息,在第四次拼接后加入ParNet((Parallel Networks)模型中的ParNet模塊,ParNet模塊能夠增加模型的特征表達(dá)能力,使模型具有更多的非線性能力,同時(shí)具備多尺度的特征融合能力,ParNet模塊具有防止模型過擬合的作用。

1.2 Residual模塊

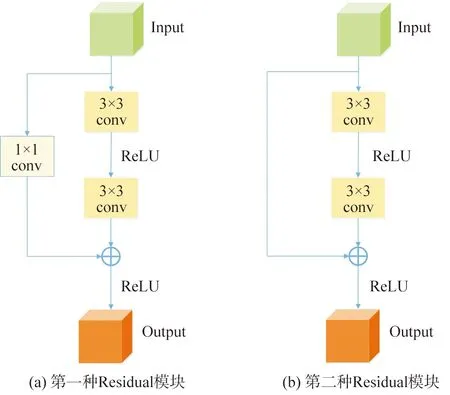

本文在編碼器部分用兩個(gè)Residual模塊組成的Residual模塊組去替換U-Net模型的每一次下采樣,Residual模塊是在ResNet模型中提出來的,本文使用的Residual模塊有兩種結(jié)構(gòu),每次同時(shí)使用兩個(gè)Residual模塊,并且每次先使用如圖2(a)所示的Residual模塊,再使用如圖2(b)所示的Residual模塊。第一種Residual模塊的操作是將輸入的特征圖進(jìn)行不同的卷積操作后再進(jìn)行融合,其中由于第一個(gè)3×3的卷積核的移動(dòng)步長(zhǎng)為2,而第二個(gè)3×3的卷積核的移動(dòng)步長(zhǎng)為1,因此實(shí)現(xiàn)了下采樣捕獲特征的作用。由于苗族服飾圖案內(nèi)容復(fù)雜多樣、色彩豐富、紋理細(xì)密、細(xì)節(jié)較多的特點(diǎn),Residual模塊可以更好地提取這些特征,并且進(jìn)行特征傳遞,減少在下采樣過程中苗族服飾圖案細(xì)節(jié)內(nèi)容的丟失。

圖2 ResNet中的兩種Residual模塊的網(wǎng)絡(luò)結(jié)構(gòu)Fig.2 Network structure of the two Residual modules in ResNet

第二種Residual模塊的操作是將輸入的特征圖進(jìn)行卷積操作后再與輸入進(jìn)行融合,由于兩個(gè)3×3的卷積核的移動(dòng)步長(zhǎng)都為1,所以不改變輸入特征圖的分辨率大小,同時(shí)不改變輸入特征圖的通道數(shù)。由于苗族服飾圖案的特征較多,此Residual模塊的作用是防止模型過擬合,以此提高模型的泛化能力,使模型可以有效地學(xué)習(xí)苗族服飾圖案的各種特征,從而準(zhǔn)確地進(jìn)行苗族服飾圖案的分割。

1.3 SKNet模塊

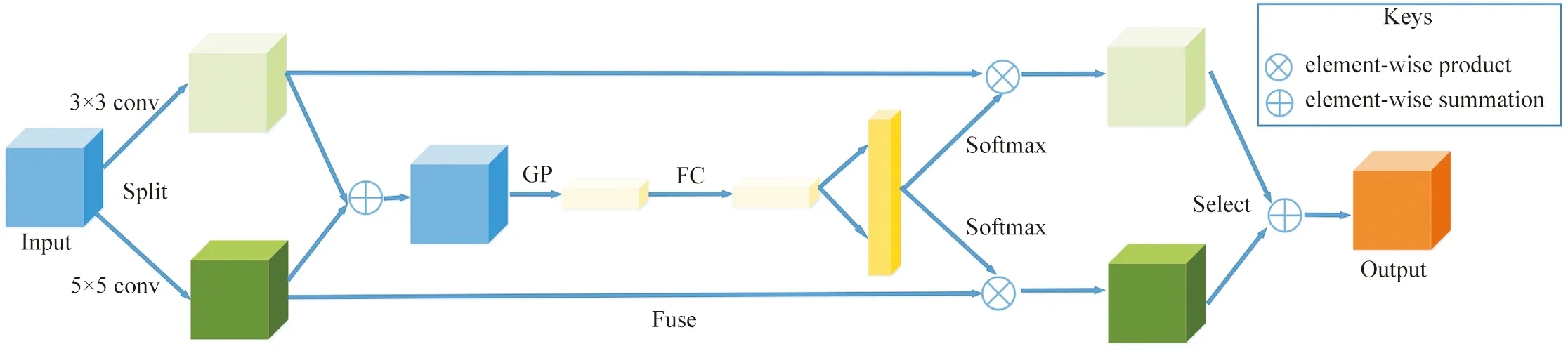

SKNet模塊由三部分組成,分別是Split、Fuse和Select。Split部分是用不同的卷積核從多尺度學(xué)習(xí)特征圖的特征,由于苗族服飾圖案的分辨率較高,不同的卷積核可以讓模型具有不同的感受野,從而使模型對(duì)苗族服飾圖案有從細(xì)節(jié)到整體結(jié)構(gòu)的特征學(xué)習(xí)。Fuse部分是從不同的卷積核獲得的特征圖進(jìn)行通道注意力操作,從而可以讓模型賦予更重要的特征圖有更高的通道權(quán)重,降低不重要特征圖的通道權(quán)重,從而減少模型對(duì)苗族服飾圖案的錯(cuò)誤分割。Select部分是將不同的卷積核的特征映射進(jìn)行再聚合,使模型可以獲得帶有權(quán)重系數(shù)的特征圖,增強(qiáng)模型的特征表達(dá)。SKNet模塊的結(jié)構(gòu)如圖3所示。

圖3 SKNet模塊的網(wǎng)絡(luò)結(jié)構(gòu)Fig.3 Network structure of the SKNet module

本文之所以在上采樣后加入SKNet模塊,是因?yàn)榻獯a器中的上采樣過程會(huì)產(chǎn)生不相關(guān)的特征信息,而通過拼接的方式進(jìn)行特征融合,可以降低不相關(guān)特征信息對(duì)后續(xù)輸出分割結(jié)果的影響。但是無法實(shí)現(xiàn)精細(xì)度的分割,而苗族服飾圖案的細(xì)節(jié)內(nèi)容較多,SKNet模塊可以使模型在上采樣后恢復(fù)一定的苗族服飾圖案細(xì)節(jié)。

1.4 ParNet模塊

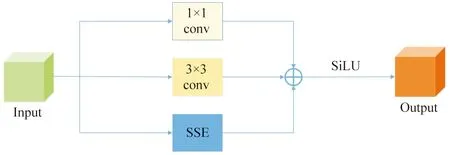

ParNet模塊的結(jié)構(gòu)可以分為三部分,分別是SSE(Skip-Squeeze-Excitation)及兩個(gè)不同的卷積核,其中SSE部分包含了全局平均池化操作和sigmoid激活函數(shù)。將SSE與兩個(gè)不同的卷積核的卷積結(jié)果進(jìn)行融合,再通過SiLU激活函數(shù)。由于在模型輸出預(yù)測(cè)的分割結(jié)果前,已經(jīng)在前三次拼接后加入SKNet模塊,SKNet模塊從多尺度卷積下進(jìn)行特征學(xué)習(xí),為防止模型過擬合,并且為模型增加更多的非線性能力,因此在最后一次拼接后加入ParNet模塊。ParNet模塊的結(jié)構(gòu)如圖4所示。

圖4 ParNet模塊的網(wǎng)絡(luò)結(jié)構(gòu)Fig.4 Network structure of the ParNet module

2 基于Lovász-hinge的苗族服飾圖案分割損失函數(shù)

圖像分割領(lǐng)域最常用的損失函數(shù)是BCE(Binary Cross Entropy)損失函數(shù),其主要是對(duì)每個(gè)類別進(jìn)行平等的評(píng)估,因此更容易學(xué)習(xí)分類占比更高的樣本,而難以解決樣本類別不均衡的問題。BCE損失函數(shù)的公式如下:

(1)

式中:N為圖像像素點(diǎn)的個(gè)數(shù),n為每次訓(xùn)練的次數(shù),xn為損失函數(shù)訓(xùn)練的自變量,yn為梯度變化的因變量。

由于苗族服飾圖案的復(fù)雜性,苗族服飾圖案中分割目標(biāo)像素通常遠(yuǎn)多于背景像素,因此苗族服飾圖案數(shù)據(jù)集一般存在樣本類別不均衡的問題,所以BCE損失函數(shù)不再適用。針對(duì)這樣的問題,本文使用Lovász-hinge損失函數(shù)對(duì)苗族服飾圖案進(jìn)行分割計(jì)算,Lovász-hinge損失函數(shù)是一種基于IoU的損失函數(shù)[9],可以通過對(duì)IoU優(yōu)化進(jìn)行損失計(jì)算。IoU也被稱作Jaccard指數(shù),其計(jì)算公式如下:

(2)

而Jaccard loss的公式為:

(3)

由于Jaccard loss只能夠進(jìn)行離散情況下的損失計(jì)算,但是神經(jīng)網(wǎng)絡(luò)的預(yù)測(cè)輸出是連續(xù)的,所以式(3)無法進(jìn)行求導(dǎo)計(jì)算,如果不能求導(dǎo)就不能進(jìn)行參數(shù)更新,因此Jaccard loss不可以直接加在神經(jīng)網(wǎng)絡(luò)中。由于Jaccard loss是子模函數(shù),所以可以對(duì)其進(jìn)行Lovász extension[12-14]從而變得連續(xù)可導(dǎo),而Jaccard loss經(jīng)過Lovász extension后就成為了Lovász-hinge損失函數(shù),從而可以解決上述問題。

3 結(jié)果及分析

3.1 實(shí)驗(yàn)流程

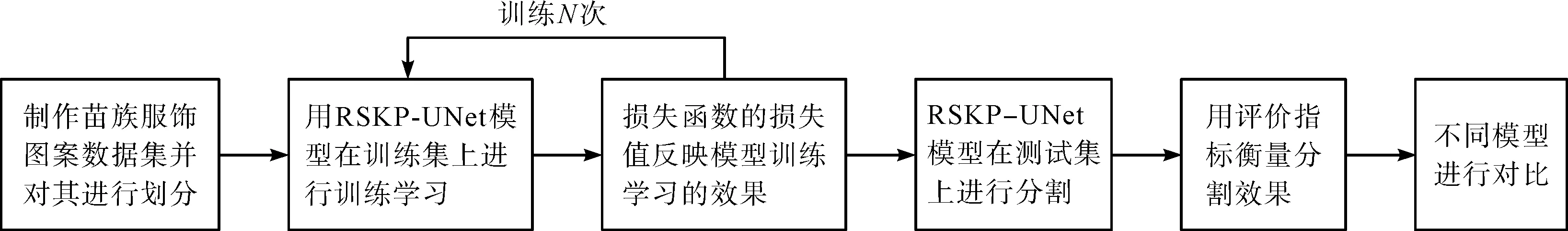

首先,制作苗族服飾圖案數(shù)據(jù)集,并將數(shù)據(jù)集劃分為訓(xùn)練集和測(cè)試集;然后,在搭建好的實(shí)驗(yàn)平臺(tái)上,用本文提出的模型在訓(xùn)練集上進(jìn)行訓(xùn)練學(xué)習(xí),再用訓(xùn)練好的模型在測(cè)試集上進(jìn)行分割;最后,用本文提出的模型與其他分割模型進(jìn)行實(shí)驗(yàn)對(duì)比,用評(píng)價(jià)指標(biāo)衡量分割效果。整個(gè)實(shí)驗(yàn)的流程如圖5所示。

圖5 實(shí)驗(yàn)的流程Fig.5 Process of the experiment

3.2 數(shù)據(jù)集及制作

本文的苗族服飾圖案數(shù)據(jù)集的原始圖像來源于北京服裝學(xué)院民族服飾博物館,在其網(wǎng)站上采集原始彩色圖像,通過裁剪的方式獲得240幅原始圖像(Original image),并將每幅圖像調(diào)整為分辨率512×512像素,通過馮潤(rùn)等[8]的研究成果制作苗族服飾圖案數(shù)據(jù)集的人工標(biāo)簽(Label),從而實(shí)現(xiàn)了整個(gè)數(shù)據(jù)集的制作。將數(shù)據(jù)集按照9︰1的比例劃分為訓(xùn)練集和測(cè)試集。

3.3 實(shí)驗(yàn)環(huán)境

本文的實(shí)驗(yàn)環(huán)境基于深度學(xué)習(xí)框架Pytorch結(jié)合Python編程語言進(jìn)行搭建。計(jì)算機(jī)的配置如下:操作系統(tǒng)為Ubuntu 16.04,系統(tǒng)內(nèi)存為16 GB,CPU為Intel Core i7-7700K@4.2 GHz,GPU為NVIDIA GeForce GTX 1080,顯存為8 G。本文實(shí)驗(yàn)用Adam優(yōu)化器進(jìn)行網(wǎng)絡(luò)優(yōu)化,網(wǎng)絡(luò)初始學(xué)習(xí)率設(shè)置為0.000 1,Deeplabv3+模型的批量大小為2,其余模型的批量大小均為1,模型訓(xùn)練的迭代次數(shù)為15次。

3.4 評(píng)價(jià)指標(biāo)

本文為了有效地對(duì)提出的模型進(jìn)行評(píng)估,引入5種評(píng)價(jià)指標(biāo),分別是Dice系數(shù)、IoU、精確率(Precision)、召回率(Recall)及準(zhǔn)確度(Accuracy),從而實(shí)現(xiàn)對(duì)客觀實(shí)驗(yàn)的真實(shí)評(píng)價(jià)。在圖像分割任務(wù)中,分割的樣本可以分為四個(gè)類別,真陽性(TP)代表的是分類正確的正樣本;真陰性(TN)代表的是分類正確的負(fù)樣本;假陽性(FP)表示的是被錯(cuò)誤分類為正樣本的負(fù)樣本;假陰性(FN)代表的是被錯(cuò)誤分類為負(fù)樣本的正樣本。5種評(píng)價(jià)指標(biāo)的公式如下:

(4)

(5)

(6)

(7)

(8)

3.5 不同損失函數(shù)的苗族服飾圖案分割結(jié)果對(duì)比

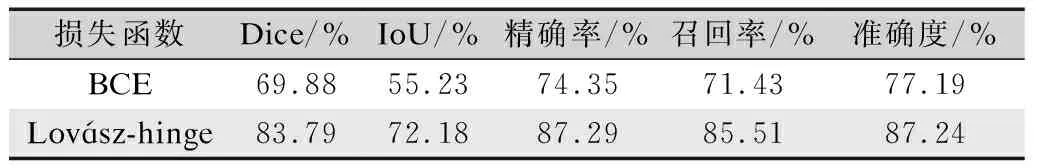

為了驗(yàn)證本文引入的針對(duì)苗族服飾圖案分割的損失函數(shù)的有效性,分別用BCE損失函數(shù)和Lovász-hinge損失函數(shù)進(jìn)行性能對(duì)比實(shí)驗(yàn),同時(shí)為了避免是本文提出的模型對(duì)實(shí)驗(yàn)結(jié)果造成的影響,對(duì)比實(shí)驗(yàn)用U-Net模型,如表1所示。

表1 U-Net模型在不同損失函數(shù)下的分割性能對(duì)比Tab.1 Comparison of segmentation performance of U-Net modelby different loss functions

在U-Net分割模型下,只替換損失函數(shù),保證實(shí)驗(yàn)的其他各項(xiàng)參數(shù)一致,可見Lovász-hinge損失函數(shù)的各項(xiàng)指標(biāo)均優(yōu)于BCE損失函數(shù),并且有了較大提升。針對(duì)苗族服飾圖案的特點(diǎn),Lovász-hinge損失函數(shù)能夠有效地應(yīng)用于苗族服飾圖案分割。

3.6 不同分割模型的苗族服飾圖案分割性能對(duì)比

本文選用了幾種經(jīng)典的主流分割模型與本文提出的模型進(jìn)行了對(duì)比。苗族服飾圖案大體涵蓋3種不同的風(fēng)格,每種風(fēng)格挑選3張圖像,于是從測(cè)試集中挑選了共計(jì)9張圖像進(jìn)行展示,如圖6所示。第一列為苗族服飾圖案的原始圖像;第二列為苗族服飾圖案的人工標(biāo)簽;第三列為U-Net分割模型的分割結(jié)果;第四列為Attention-UNet分割模型的分割結(jié)果;第五列為Deeplabv3+分割模型的分割結(jié)果;第六列為FusionNet分割模型的分割結(jié)果;最后一列是本文提出的分割模型的分割結(jié)果。

圖6 不同模型的苗族服飾圖案分割結(jié)果對(duì)比Fig.6 Comparison of segmentation results of Miao costume patterns with different models

第一種苗族服飾圖案的原始圖像的風(fēng)格總體呈現(xiàn)色彩豐富度較高,但是飽和度較低的特點(diǎn),如圖6(a)所示的三張?jiān)紙D像,因此分割存在一定的挑戰(zhàn)性。其中Deeplabv3+和Attention-UNet的分割結(jié)果最差,Deeplabv3+分割模型幾乎不能完成基本的分割任務(wù),而本文提出的模型相比其他分割模型,分割圖案的輪廓清晰,錯(cuò)分的情況也少于其他模型,這得益于本文提出的模型中的SKNet模塊,能夠?qū)W⒂趯W(xué)習(xí)原始圖像的特征信息,起到注意力機(jī)制的注意力作用。第二種苗族服飾圖案的原始圖像的風(fēng)格總體呈現(xiàn)色彩對(duì)比度高,圖案單一重復(fù),同時(shí)構(gòu)圖具有對(duì)稱性的特點(diǎn),如圖6(b)所示的三張?jiān)紙D像,因此分割難度不大,幾乎所有的分割模型都能較好地完成分割任務(wù)。本文提出的模型相比于其他分割模型,優(yōu)勢(shì)在于能夠表現(xiàn)出更多的圖案細(xì)節(jié),因此漏分的情況較少,所以與標(biāo)簽更加接近,這同樣得益于本文提出的模型,在實(shí)現(xiàn)基本的分割任務(wù)的同時(shí),充分還原苗族服飾圖案的細(xì)節(jié)內(nèi)容。第三種苗族服飾圖案的原始圖像的風(fēng)格總體呈現(xiàn)圖案內(nèi)容多,圖案的細(xì)膩程度高,如圖6(c)所示的三張?jiān)紙D像,因此分割的難度比較高。同時(shí)與圖6(b)的三張?jiān)紙D像相比,苗族服飾圖案存在樣本類別不均衡的情況,而本文引入的Lovász-hinge損失函數(shù)可有效地解決這一問題。在其他分割模型分割效果均不佳的情況下,本文提出的模型表現(xiàn)出了不錯(cuò)的分割結(jié)果,本文提出的模型充分地提取了圖案的特征信息并增強(qiáng)了圖案的細(xì)節(jié)表達(dá),因此分割結(jié)果中錯(cuò)分和漏分的像素很少,細(xì)節(jié)的還原度高,而其余模型的分割結(jié)果中明顯存在或多或少的錯(cuò)分和漏分情況。

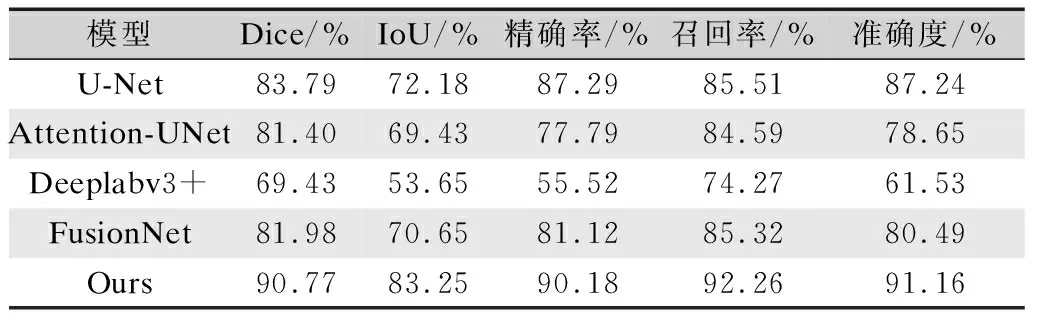

綜上所述,從實(shí)驗(yàn)分割效果來看,本文提出的分割模型在苗族服飾圖案的分割效果優(yōu)于其余幾種分割模型,但是仍然需要從指標(biāo)層面定量分析不同實(shí)驗(yàn)的分割結(jié)果,如表2所示。

表2 不同模型的苗族服飾圖案分割性能對(duì)比Tab.2 Comparison of image segmentation performance ofMiao costume patterns with different models

從表2的實(shí)驗(yàn)結(jié)果顯示,Deeplabv3+的分割指標(biāo)最差,與圖6的分割結(jié)果表現(xiàn)基本一致,而本文提出的模型在分割指標(biāo)上均好于其他模型,其Dice系數(shù)達(dá)到了90.77%,IoU達(dá)到了83.25%,精確率達(dá)到了90.18%,召回率達(dá)到了92.26%,準(zhǔn)確度達(dá)到了91.16%。相比于基準(zhǔn)模型U-Net模型,在Dice系數(shù)、IoU、精確率、召回率及準(zhǔn)確度等指標(biāo)上分別提升了6.98%、11.07%、2.89%、6.75%及3.92%,因此從主觀和客觀兩方面的實(shí)驗(yàn)結(jié)果表明,本文提出的模型優(yōu)于其余4種模型。

4 結(jié) 論

苗族服飾作為苗族的文化符號(hào)之一,實(shí)現(xiàn)苗族服飾圖案的分割對(duì)研究苗族文化有著重大現(xiàn)實(shí)意義。為了解決苗族服飾圖案存在的樣本類別不均衡的問題,本文引入了Lovász-hinge損失函數(shù);為了提高苗族服飾圖案的分割精度,本文提出了一種基于RSKP-UNet的苗族服飾圖案分割模型。RSKP-UNet模型在U-Net模型上做了適當(dāng)改進(jìn),在U-Net模型的編碼器部分加入了Residual模塊,增加模型的特征提取能力,在解碼器部分融合了SKNet模塊和ParNet模塊,增加了多尺度特征融合后的特征表達(dá)能力,同時(shí)抑制冗余特征信息對(duì)分割的影響。實(shí)驗(yàn)結(jié)果表明,本文引入的Lovász-hinge損失函數(shù)顯著的提升了分割性能,提出的RSKP-UNet模型在指標(biāo)上整體均優(yōu)于其他4種對(duì)比分割模型。相比于基準(zhǔn)模型U-Net,Dice系數(shù)提升了6.98%,IoU提升了11.07%,精確率提升了2.89%,召回率提升了6.75%,準(zhǔn)確度提升了3.92%,所以本文提出的RSKP-UNet模型能夠較好地解決苗族服飾圖案分割問題,且分割精度較高。因此,本文提出的分割算法通過對(duì)苗族服飾圖案的分割,實(shí)現(xiàn)了對(duì)苗族服飾圖案的元素內(nèi)容的提取,可以通過這樣的方式構(gòu)建苗族服飾圖案數(shù)據(jù)庫,從而幫助設(shè)計(jì)師及相關(guān)研究學(xué)者和組織機(jī)構(gòu)提供研究基礎(chǔ),同樣本文也為其他少數(shù)民族服飾圖案分割研究提供了參考。

《絲綢》官網(wǎng)下載

中國(guó)知網(wǎng)下載