基于改進U-Net的視網膜血管分割方法研究

郭 峰,黃文博,燕 楊

(長春師范大學計算機科學與技術學院,吉林 長春 130032)

0 引言

眼底視網膜血管是人體唯一可以用肉眼直接觀察到的血管,借助先進醫學設備可以采集較為清晰且分辨率較高的彩色視網膜圖像。眼底圖像具有分布不均勻、血管結構高度復雜等問題,醫生在依據眼底圖像給病人診治時,僅憑肉眼無法對患者的病癥程度做出精確診斷。因此研究一種高效、精準的視網膜血管圖像自動檢測分割算法愈發重要,對輔助診斷各種眼科疾病具有重要意義與價值。

目前國內外研究人員提出了很多視網膜血管分割方面的解決方案,按照研究方法的不同,可大致劃分為無監督學習與有監督學習兩大類。無監督學習無需借助公共數據庫提供的標簽數據,與有監督學習算法相比,其優勢在于可以挖掘圖像數據中的特征信息及概率分布。早期CHAUDHURI等[1]提出基于匹配濾波器的方法,結合高斯濾波器對圖像濾波,綜合血管寬度、方向及曲線等因素對視網膜血管進行分析,但是該方法容易受到病變區域像素影響,從而降低血管分割的準確性。YAN等[2]基于厚血管和薄血管之間不平衡以及特性方面的差異,提出了一種網絡模型。該模型分三階段運行,首先分割厚血管,然后分割薄血管,最后將兩次的分割結果結合,從而有效地提取薄血管的特征信息,提升了模型整體的分割精度。FAN等[3]采用分層摳圖的方法實現血管與背景之間的劃分,先用區域特征的方法將圖像劃分為血管與非血管,接著使用分層圖像摳圖模型對視網膜血管進一步區分,不僅整體方法的計算時間較少,而且分割的準確率也優于多數無監督學習的分割方法。

在血管分割方面,一般監督學習方法比無監督學習方法有著更好的分割效果,監督學習方法將眼科專家標記好的血管數據樣本作為訓練集,根據訓練后得到的數據對血管與非血管像素進行分類判斷。如RICCI等[4]

采用支持向量機(Support Vector Machines,SVM)的方法并結合直線檢測器對輸入樣本圖像的像素進行分類,該方法的優點是算法實現較為簡單,并且具有較好的魯棒性,對比相對較少的樣本信息就可以提取血管的圖像特征。朱承璋等[5]在隨機森林模型的基礎上融入了多特征融合算法,從輸入圖片提取出包含二三維特征向量的灰度共生矩陣,構建特征矩陣對像素點進行分類處理,提高了血管分割的連續性和準確性。包含K近鄰[6]、AdaBoost在內的多種分類器已經成功應用在視網膜血管分割領域。

隨著圖像分割技術的快速發展,深度學習逐漸在圖像處理領域展現了自身優勢,卷積神經網絡(Convolutional Neural Networks,CNN)[7]開始應用于醫學圖像的研究。2015年,LONG等[8]在CNN模型的基礎上提出全卷積神經網絡(Fully Connected Neural Network,FCN),由此進入語義分割圖像的階段。FCN與其他模型的不同之處在于它可以處理任何尺寸大小的圖像,通過反卷積對卷積層的特征圖信息進行采樣預測,提升了算法的魯棒性和精確性。模型的缺點是FCN把像素看作獨立的個體而忽略了空間關系,上采樣過程中采樣結果不夠平滑精細,對于圖像中細節部分處理達不到精細水準。RONNEBERGER等[9]提出包含編碼與解碼結構的U-Net網絡,網絡模型的整體框架是由四次下采樣結合四次上采樣[10]串聯起來形成的U型結構。編碼器部分收集好的微小血管信息通過跳躍連接傳輸到解碼器部分,這樣在回傳的信息中既包括解碼器的語義信息,也包括從同層編碼器提取的特征信息,因此獲得了更加全面的信息,得到了質量更好且更加精準的圖像分割性能。

1 網絡模型

1.1 網絡結構與方法

U-Net作為當下熱門的醫學圖像的研究方法之一,有著獨特的編碼-解碼結構,通過四次下采樣與四次上采樣,加上激活函數的輔助作用完成對圖像的分割。雖然U-Net模型取得了較好的性能,但在視網膜血管分割方面仍存在不足之處。例如,在進行卷積操作時,由于卷積核的感受野范圍較小不能充分地提取血管特征,從而使微小血管識別不敏感,降低了整體的分割精度;在進行采樣操作時會產生梯度消失的問題,網絡模型的深度越大對模型的整體性能影響越大。

為解決上述問題,在U-Net模型的基礎上引入可變形卷積模塊[11](Deformable Convolutional Networks,DCN)和循環殘差卷積模塊[12](Recurrent Residual Convolutional Neural Network,RRCNN)對視網膜圖像特征進行優化,增強對血管特征信息的提取,模型的結構如圖1所示。視網膜血管分割中最難處理的就是微小血管,本文提出將卷積層替換成可變形卷積模塊來解決卷積操作時感受野不足的問題,增強卷積核對微小血管的分割敏感度。引入循環殘差卷積模塊,其殘差網絡可以有效地解決梯度[13]消失問題,處理噪聲問題增強模型對血管特征信息的提取,結合U-Net自身的編解碼結構,達到較好的血管分割效果。

圖1 模型結構

1.2 可變形卷積模塊

與傳統卷積相比,可變形卷積實質是在采樣過程中在圖像位置上增加了一個偏移量,卷積核的采樣位置是可變的,卷積核在執行過程中擴展到更大范圍。改變采樣位置的方法是需要先計算及預測圖像中哪些位置需要進行采樣,然后特征圖在經過卷積操作后生成特征矩陣,其作用是控制卷積核上的采樣點如何移動及變化,可變形卷積模塊如圖2所示。通過卷積操作后帶偏移值的坐標值來確定像素點,通過雙線性差值[14]計算得到新的特征圖直接作為卷積層的輸出并作為下一卷積層的新輸入。

圖2 可變形卷積模塊

下面給出雙線性差值的計算公式。

已知A11,A21,A12,A22,P的坐標及其像素值,計算x方向的單線性插值:

(1)

(2)

計算y方向的單線性插值:

(3)

綜合x方向與y方向的雙線性插值的結果:

(4)

在可變形卷積中通過雙線性插值計算偏移量并設定好采樣位置,其中偏移量是根據卷積層產生的特征圖演變而來,由此可知,可變形卷積能夠適應任意尺度、形狀、方向的特征圖像。

1.3 循環殘差卷積模塊

循環殘差卷積模塊中的殘差網絡有效解決了梯度消失問題,需要進行多次相同的卷積操作,從一定程度上提升分割的性能,循環卷積基本單元結構如圖3所示。

圖3 循環卷積基本單元結構

(5)

計算在標準的激活函數中經過循環殘差卷積層處理后的特征輸出:

(6)

其中,F(x1,w1)表示來自輸出第n層循環卷積單元,F(x1,w1)的輸出分別用于模型的下采樣層與上采樣層。計算循環卷積模塊中的輸出xn+1:

xn+1=x1+F(x1,w1),

(7)

其中,x1表示循環卷積模塊的輸入樣本,xn+1樣本直接作為下一循環卷積模塊上采樣層的輸入。

2 實驗結果與分析

2.1 數據集及數據擴充

本文實驗選用公開數據集DRIVE,圖像來自荷蘭的糖尿病視網膜病變篩查項目。數據集分為訓練集和測試集兩部分,各有20張不同的彩色眼底圖像,均為經驗豐富的眼科專家醫生手動分割的血管圖像。由于DRIVE數據集的圖像較少,為了增加訓練時的數據樣本數量,并且防止出現過擬合現象,對原始數據集圖像進行分塊處理,劃分為48×48像素的子塊,接著從處理后的圖像子塊中隨機抽取作為訓練塊,并使用部分訓練樣本作為驗證數據。

2.2 圖像預處理

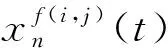

深度神經網絡已經可以有效處理原始的視網膜圖像數據,但為了突出更多的微小血管特征,提高血管分割的準確性,選擇對眼底圖像進行預處理操作。通過對比,選取血管對比度最高的綠色單通道灰色圖像,接著對灰色圖像進行歸一化與自適應直方圖均衡化處理,增強血管特征的對比度,最后對圖像引入伽馬校正來減少噪聲,并且提高圖像的整體細節特征。每一步預處理后的圖像如圖4所示,通過對比可以看出,預處理后的圖像血管特征與對比度更加突出,將對分割性能的提升有較大作用。

圖4 預處理結果

2.3 評價標準

為了全面客觀地對比分析本文算法的性能,采用準確性(Accuracy,ACC)、敏感性(Sensitivity,SE)、特異性(Specificity,SP)與ROC曲線下的面積(AUC)等重要指標作為衡量標準。

(8)

(9)

(10)

AUC=P(PTP>PFP).

(11)

其中,TP(真陽性)表示正確分類為血管的像素數量;FP(假陽性)表示錯誤分類為血管的像素數量;FN(假陰性)表示錯誤分類為非血管的像素數量;TN(真陰性)表示正確預測為非血管的像素數量;AUC值是預測正樣本排在負樣本前的分類概率,其值域區間為[0,1],數值越接近1,算法的分割性能越好。

2.4 實驗結果對比分析

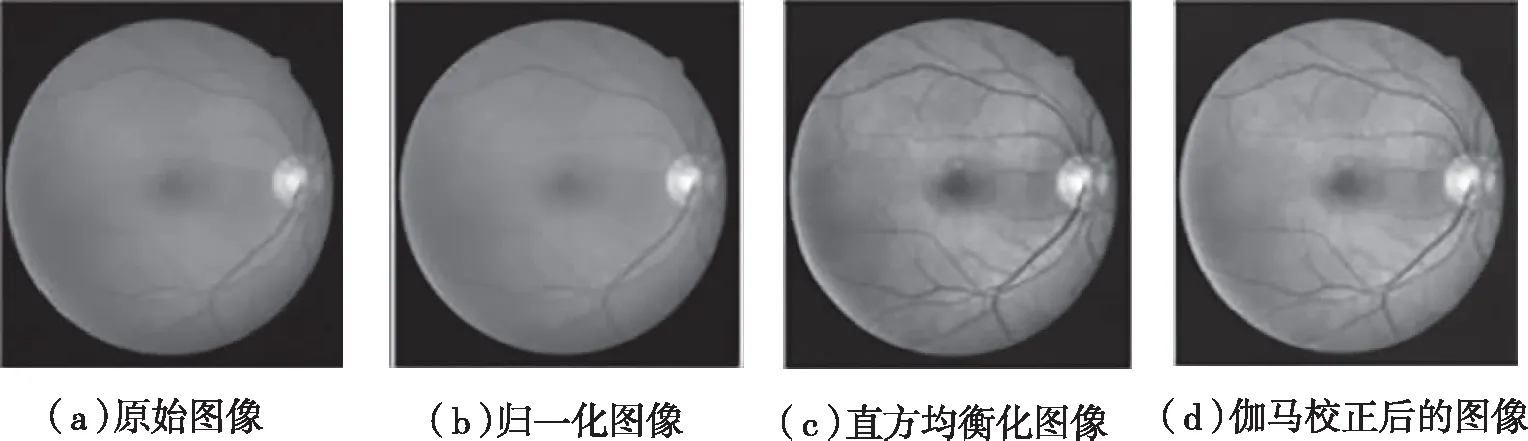

本文算法的分割結果如圖5所示。對比本文實驗結果圖與專家手動分割的標準圖,兩者的血管特征信息基本一致,可以分割出血管末端的微小血管分支,可以看出運用本文算法得到較好的視網膜血管分割效果。

(a)原始圖像

(b)預處理圖

(c)專家手動分割標準圖

(d)實驗結果圖圖5 實驗結果對比圖

在U-Net模型引入可變形卷積和循環殘差卷積模塊后,模型性能得到明顯提升,為了系統地評估算法性能,將本文實驗結果與目前主流的較為先進的算法[15-17]進行對比,結果如表1所示。本文方法結果均高于原始的U-Net方法結果,并且敏感性達到79.63%,準確性達到95.59%,AUC值達到了97.89%,均高于其他文獻的方法(表1)。其中特異性數值略低于Residual U-Net模型,可能是在多次卷積后圖形特征細節發生輕微變化,圖像產生少量的噪聲造成模型的特異性值降低。綜合對比可知,本文方法的分割效果較好,證明改進模型后,模型性能得到了提升,改進了視網膜血管分割的效果。

表1 在DRIVE數據集上本文方法和其他方法的對比

3 結語

針對視網膜圖像中微小血管難以精確分割的問題,本文以U-Net為基礎模型提出一種基于可變形卷積和循環殘差卷積模塊的視網膜血管分割算法。將傳統的卷積層替換成可變形卷積層,可以提高卷積核的感受野范圍,更好地捕捉血管特征信息。在網絡上采樣過程中加入循環殘差卷積模塊,有助于訓練深層網絡架構。循環殘差卷積層更好地提升了對血管特征的提取效果,有效地解決梯度消失的問題,有利于更完整地提取微小血管的特征信息,減少噪聲的干擾,從而提升模型的分割效果。通過DRIVE數據集上大量實驗數據的對比,充分證明了本文算法在視網膜血管分割方面體現出較大的優勢。