基于卷積神經(jīng)網(wǎng)絡的車輛分類與檢測技術研究

解丹 陳立潮 曹玲玲 張艷麗

關鍵詞:卷積神經(jīng)網(wǎng)絡;車輛分類;車輛檢測;深度學習

中圖分類號:TP391 文獻標識碼:A

1引言(Introduction)

隨著以深度學習為代表的人工智能技術的發(fā)展,越來越多的領域開始應用深度學習技術。基于深度學習的車輛分類與檢測是當前智慧交通領域的研究熱點,其在智能交通系統(tǒng)中處于基礎地位,對車輛跟蹤、交通管控、無人駕駛等的發(fā)展具有重要意義。深度學習主要涉及卷積神經(jīng)網(wǎng)絡(Convolutional Neural Network,CNN)、自編碼神經(jīng)網(wǎng)絡、深度置信網(wǎng)絡,其中CNN的發(fā)展最為迅速。隨著CNN的發(fā)展,其在車輛分類的應用被不斷優(yōu)化,例如對LeNet[1]、AlexNet[2]、VGG、GoogLeNet等模型的應用。在車輛檢測中對CNN的應用大致分為兩類:一類是一階段檢測方法,也稱為區(qū)域提議方法;另一類是兩階段檢測方法,也稱為無區(qū)域提議方法。本文以CNN的發(fā)展為主線,介紹并分析基于LeNet、AlexNet等CNN的車輛分類方法、基于R-CNN及YOLO系列的車輛檢測方法及用于評估這些方法的數(shù)據(jù)集,并對未來的研究方向進行展望。

2基于CNN的車輛分類(Vehicle classification basedon CNN)

車輛分類是對圖像中車輛的種類進行劃分。傳統(tǒng)的車輛分類方法是通過方向梯度直方圖、尺度不變特征轉(zhuǎn)換等方法提取車輛特征,并將特征輸入支持向量機、迭代器等分類器中,實現(xiàn)對車輛進行分類。這些機器學習方法在提取車輛特征時大多依賴研究人員的專業(yè)知識和經(jīng)驗,受主觀因素影響較大,并且難以適應天氣、光線、角度等的變化,泛化能力較差。隨著車輛數(shù)量增多,車輛類型也逐步增多,依靠機器學習提取車輛特征,無法較好地對車輛進行分類。深度學習中CNN訓練時具有更多的數(shù)據(jù)及參數(shù),因而其模型特征表達能力更強,性能優(yōu)于機器學習。

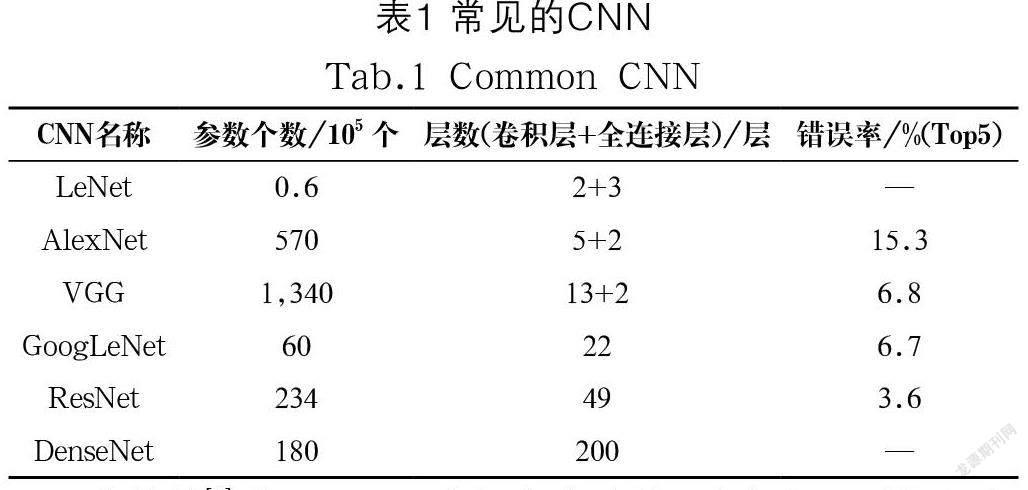

常見的CNN如表1所示,其中LeNet為最早發(fā)布的CNN,由兩個卷積層和三個全連接層組成,主要用于手寫數(shù)字的識別。LeNet雖然在小數(shù)據(jù)集上取得了較好的效果,但是在大量真實數(shù)據(jù)中的應用效果還有待研究。計算機硬件的發(fā)展,使得訓練大數(shù)據(jù)成為可能。2012年,KRIZHEVSKY等[2]在GPU上運行深度CNN,實現(xiàn)了卷積運算的快速操作,該網(wǎng)絡被稱為AlexNet。AlexNet和LeNet類似,但AlexNet比LeNet層數(shù)更多,它由五個卷積層和三個全連接層組成。隨著AlexNet在訓練大數(shù)據(jù)集上的成功,CNN開始逐漸成為研究熱點。SIMONYAN等[3]提出了VGG網(wǎng)絡,SZEGEDY等[4]提出了GoogLeNet。網(wǎng)絡越來越深的發(fā)展趨勢,使得人們開始思考如何使新添加的網(wǎng)絡層更有效地提升網(wǎng)絡性能。2016 年HE等[5]提出了殘差網(wǎng)絡(ResNet),之后HUANG等[6]對ResNet進行改進提出了稠密連接網(wǎng)絡(DenseNet)。隨著CNN的發(fā)展,其越來越多地被應用于車輛分類領域。

曹林等[7]對LeNet-5進行改進以學習車輛的雷達視頻信號特征,從而對大小車型進行分類,為交通場景下車型識別的研究提供了新思路。馬傳香等[8]對AlexNet進行改進,提出一種maxout加dropout的六層CNN用于區(qū)分空車和重車,模型對34,220 張圖像進行測試,結果顯示分類的準確度、敏感度都有較大的提高。張超[9]將VGG-16的網(wǎng)絡結構進行改進,減少全連接層的個數(shù)及改變池化層的大小和性質(zhì),在保持對車輛特征提取能力的基礎上,提升了網(wǎng)絡速度。劉澤康等[10]將GoogLeNet應用于車輛檢測,發(fā)現(xiàn)GoogLeNet需要較長的訓練時間才能達到較好的分類精度。余燁等[11]對ResNet進行改進,提出基于殘差網(wǎng)絡特征重用的深度卷積神經(jīng)網(wǎng)絡模型FR-ResNet用于車輛型號的精細分類,該模型引入多尺度輸入和特征圖權重學習策略,能防止網(wǎng)絡過深而陷入局部最優(yōu)。陳立潮等[12]針對細粒度車輛分類準確率低及深度學習不能較好地關注車輛鑒別性部件特征的問題,在DenseNet中引入處理層和獨立組件增強部件信息和高位特征的提取,在斯坦福大學的Stanford Cars數(shù)據(jù)集上獲得95%的準確率,但此方法重點關注局部鑒別性部件信息,對車輛全局特征的提取能力仍有待提高。

可以看出,車輛的分類包括對車輛的車型大小、車輛的類型、車輛的承重等進行分類,針對不同的分類目標可以采用不同的模型。在改進網(wǎng)絡模型時,可以改進網(wǎng)絡結構、網(wǎng)絡參數(shù)或引入其他有利于模型學習的策略。此外,車輛所在的場景對于車輛的分類也有很大的影響,場景越復雜,對車輛分類算法的要求越高。

3基于CNN的車輛檢測(Vehicle detection based on CNN)

車輛檢測包含車輛識別及定位,是智能交通系統(tǒng)中重要的一部分。在城市交通擁堵路段,車流量大、車輛之間相互遮擋嚴重,交通環(huán)境復雜,對車輛檢測提出了更高的要求。CNN未出現(xiàn)之前,對車輛的檢測主要有背景差分法、幀差法、光流法等,這些方法存在可移植性差、魯棒性差及速度慢的問題。隨著GUP并行技術和CNN的發(fā)展,以CNN為基礎的目標檢測算法成為主流。2014 年,GIRSHICK等[13]提出了R-CNN用于目標檢測,實現(xiàn)了使用少量標注數(shù)據(jù)訓練高質(zhì)量模型,但該模型占用的內(nèi)存較大、效率較低。為了提高R-CNN的效率,GIRSHICK等又提出了Fast R-CNN[14]、Faster R-CNN[15],使模型能更好地應用于實時檢測。基于R-CNN的目標檢測屬于兩階段檢測,其首先生成目標候選區(qū),然后對候選區(qū)的目標分類和定位。此外,YOLO、SSD、RetinaNet等為一階段檢測,它們將單個神經(jīng)網(wǎng)絡用于整張圖像,并對目標的類別和邊界框進行回歸,檢測速度較快。其中,YOLO算法發(fā)展最快,至今已發(fā)展至YOLOv5。2016 年REDMON等提出了YOLOv1[16],將目標檢測問題處理為分類回歸問題。為實現(xiàn)更好、更快的檢測,2017 年REDMON等又提出YOLOv2[17]、2018 年進一步提出YOLOv3[18]。2020 年BOCHKOVSKIY等融合深度學習的多種優(yōu)勢改進YOLOv3,提出YOLOv4[19]。為提高網(wǎng)絡的多尺度檢測能力,曾凱等[20]對YOLOv5進行研究。隨著目標檢測算法的發(fā)展,各種算法根據(jù)車輛目標檢測的特點進行改進并得到實際應用。

劉杰[21]采用R-CNN對常見的車輛事故場景及車身關鍵部位進行訓練,并結合空間輔助定位檢測事故車輛,本質(zhì)上是對特殊場景的車輛進行檢測。張琦等[22]改進Fast R-CNN,在原網(wǎng)絡上引入內(nèi)置的子網(wǎng)絡和尺度感知加權層,實現(xiàn)不同空間尺度的車輛檢測。王林等[23]針對遠近場景中車輛尺寸存在較大差異造成Faster R-CNN誤檢、漏檢的問題,在訓練Faster R-CNN時引入多尺度訓練策略,針對數(shù)據(jù)集中目標區(qū)域遠小于背景區(qū)域、負樣本空間大的問題,在訓練時引入難負樣本挖掘的策略,兩個策略的引入,使Faster R-CNN在檢測KITTI數(shù)據(jù)集的精確度提高了約8%,但該模型訓練時對硬件的要求較高。LU等[24]對三個公共航空影像數(shù)據(jù)集進行處理,集成一個適合YOLO訓練的航空影像數(shù)據(jù)集,使訓練好的YOLO模型能更好地檢測小目標、旋轉(zhuǎn)目標及緊湊目標車輛;張成標等[25]將DenseNet、多尺度層引入YOLOv2,并設計Kelu激活函數(shù)檢測不同形態(tài)的車輛,提高了車輛檢測的準確率和精度;張富凱等[26]改進YOLOv3,提出單階段深度神經(jīng)網(wǎng)絡(DF-YOLOv3),將DenseNet的特征圖與多尺度預測網(wǎng)絡的特征圖融合,得到更豐富的車輛特征,以較好地檢測不同尺度的車輛目標。為解決車輛檢測中的錯檢、漏檢問題,於積榮等[27]將YOLOv4的主干網(wǎng)絡替換為CBAM-DenseNet-BC,SPPNet替換為ASPPNet,并引入CBAM模塊,張漪等[28]將注意力機制SE模塊引入YOLOv5,并使用了Focal Loss焦點損失,經(jīng)過改進的YOLOv5可以較好地檢測遮擋車輛和小目標車輛。

對車輛檢測的研究致力于解決對不同尺度車輛的檢測以及錯檢、漏檢問題。針對不同尺度車輛的檢測,大多是在原網(wǎng)絡上增加不同大小的卷積層,從而得到不同大小的特征圖。對錯檢、漏檢問題的解決大多采用引入優(yōu)勢策略或加深網(wǎng)絡層數(shù)的方法。除此之外,車輛檢測的難點除了車輛尺度、車輛類型的問題,還有車輛所在的場景問題,以及對特殊天氣的車輛檢測,仍然有待深入研究。

4車輛分類與檢測質(zhì)量評估數(shù)據(jù)集(Qualityassessment dataset of vehicle classification anddetection)

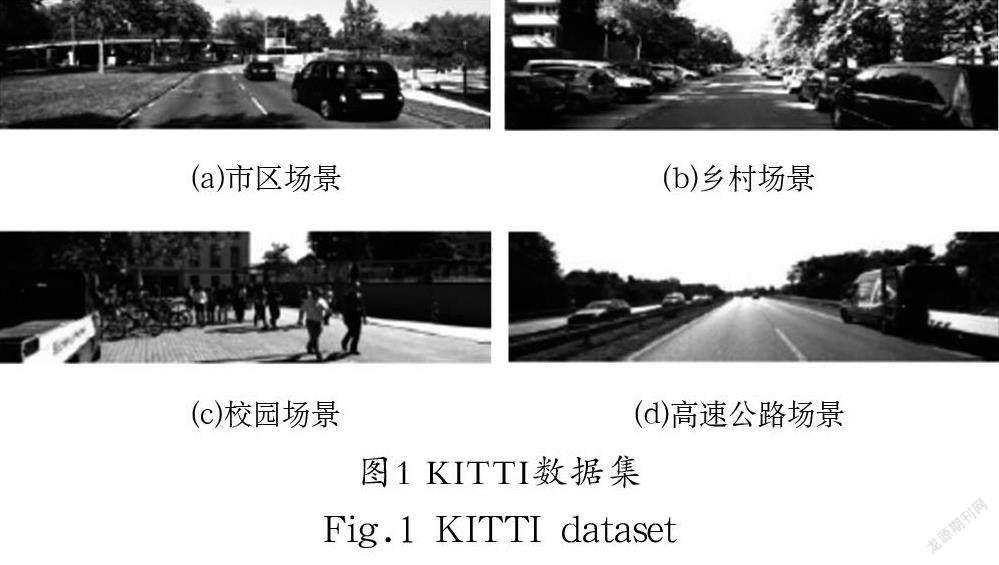

4.1 KITTI數(shù)據(jù)集

KITTI數(shù)據(jù)集由德國卡爾斯魯厄理工學院及豐田美國技術研究院制作,可通過http://www.cvlibs.net/datasets/kitti網(wǎng)址下載,主要用于車輛的檢測與跟蹤。該數(shù)據(jù)集中有激光雷達數(shù)據(jù)、標注數(shù)據(jù)、圖像數(shù)據(jù)及標定校準數(shù)據(jù)。其中,圖像的分辨率為1392×512,包括市區(qū)、鄉(xiāng)村、校園及高速公路等真實場景,如圖1所示。數(shù)據(jù)集的標注采用激光雷達坐標系,共有Car(小汽車)、Van(廂式貨車)、Truck(卡車)、Pedestrian(行人)、Person(sitting)(坐著的人)、Cyclist(騎自行車的人)、Tram(有軌電車)和Misc(其他)八類,有各種程度的遮擋及截斷。

4.2 BIT-Vehicle數(shù)據(jù)集

BIT-Vehicle數(shù)據(jù)集由北京理工大學制作,主要用于車輛的分類與檢測,來源于http://iitlab.bit.edu.cn/mcislab/vehicledb/網(wǎng)站。該數(shù)據(jù)集中有9,850 張車輛圖像,來自兩個不同地方的攝像機,圖像的分辨率分別為1600 ×1200和1920×1080,包含光照條件、尺度、車輛顏色和視角的變化。部分數(shù)據(jù)集如圖2所示,車輛被分為Bus(公共汽車)、Microbus(中型客車)、Minivan(小型貨車)、Sedan(轎車)、SUV(越野車)、Truck(卡車)五類,每類車輛的數(shù)量分別為558輛、883輛、476輛、5,922 輛、1,392輛、822輛,共有10,053輛車。

4.3 Stanford Cars數(shù)據(jù)集

Stanford Cars數(shù)據(jù)集由斯坦福大學整理,可通過http://ai.stanford.edu/~jkrause/cars/car_dataset.html下載,主要用于車輛的細粒度分類。該數(shù)據(jù)集的類別主要根據(jù)汽車的牌子、車型及年份進行劃分,共包含16,185張圖像,圖像中的車輛共有196 類,如圖3所示。數(shù)據(jù)集劃分為訓練集和測試集,訓練集中有8,144 張圖像,測試集中有8,041 張圖像,在訓練集和測試集中每個類別的數(shù)量大致相同。

4.4 UA-DETRAC數(shù)據(jù)集

UA-DETRAC數(shù)據(jù)集來源于http://detrac-db.rit.albany.edu/,主要拍攝于北京和天津的道路、過街天橋等24 個不同的地點,存在多云、夜間、晴天和雨天四種天氣狀況,視頻每秒25 幀,每幀圖像的分辨率為960×540,如圖4所示。該數(shù)據(jù)集中手動標注了8,250 輛車輛,共有121萬標記的對象外框。車輛分為轎車、公共汽車、廂式貨車和其他四類。此數(shù)據(jù)集主要用于多目標檢測和多目標跟蹤的訓練和測試。

5 結論(Conclusion)

車輛分類與檢測對于智能交通系統(tǒng)的發(fā)展極為重要。隨著GPU并行技術的發(fā)展及數(shù)據(jù)量的成倍增長,深度學習得到了極好的發(fā)展。在深度學習中CNN的表現(xiàn)較好,CNN在車輛分類和檢測中具有許多的應用,在車輛分類中有LeNet、AlexNet、VGG、GoogLeNet等模型的應用,在檢測中有R-CNN、YOLO等模型的應用。這些模型的效果常在KITTI、BIT-Vehicle、Stanford Cars、UA-DETRAC等數(shù)據(jù)集上進行測試。如今,車輛分類和檢測模型在這些數(shù)據(jù)集上的測試效果有了極大的提高,但對于特殊天氣、特殊場景的車輛分類和檢測仍有待深入研究。

作者簡介:

解丹(1994-),女,碩士,助教.研究領域:軟件開發(fā),圖像處理與模式識別.

陳立潮(1961-),男,博士,教授.研究領域:圖像處理與模式識別.

曹玲玲(1983-),女,碩士,講師.研究領域:大數(shù)據(jù)與人工智能.

張艷麗(1983-),女,碩士,講師.研究領域:人工智能與圖像處理.